광학 문자 인식 기술을 활용한 점자 변환 시스템의 설계 및 구현

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

시각은 인간이 주변 환경과 상호작용하는 데 필요한 정보의 대부분을 포함하고 있다. 이러한 이유로 시각장애인의 경우 비장애인과 비교했을 때 정보 접근 측면에서 많은 한계를 가진다. 본 논문은 시각장애인의 정보 접근성 향상을 위하여 이미지로 제공되는 문자를 추출 및 점자로 번역하여 실시간 구현이 가능한 시스템을 제안한다. 제안하는 시스템은 광학문자인식 기술인 EasyOCR과 한글 인식 모델을 통해 텍스트를 인식하고 음소를 분리한 후 디지털화한다. 하드웨어로 구현된 시스템은 릴레이와 솔레노이드 기반의 브라유 체계로 동작하여 시각장애인이 촉각을 이용하여 출력된 점자를 인식할 수 있도록 한다. 이는 시각장애인의 정보 접근 장벽을 낮춰 다양한 측면에서 비장애인과 동등한 기회를 받을 수 있도록 하며, 그들의 능동적인 사회 활동을 끌어낼 수 있다.

Abstract

Vision contains the majority of the information necessary for humans to interact with their surrounding environment. For these reasons, visually impaired individuals face significant limitations in terms of information access compared to non-visually impaired individuals. This paper proposes a system to enhance information accessibility for the visually impaired by extracting and translating text from images into Braille, enabling real-time implementation. The proposed system utilizes optical character recognition technology, specifically EasyOCR, and a Korean language recognition model to recognize and digitize text after separating phonemes. The hardware-implemented system operates through a relay and solenoid-based Braille system, allowing individuals with visual impairments to recognize the outputted Braille using tactile senses. This approach aims to reduce barriers to information access for the visually impaired, providing them with equal opportunities in various aspects compared to sighted individuals and fostering their active participation in society.

Keywords:

Braille Display, Optical Character Recognition, Visually Impaired, Braille, EasyOCR키워드:

점자 디스플레이, 광학문자인식, 시각장애인, 점자Ⅰ. 서 론

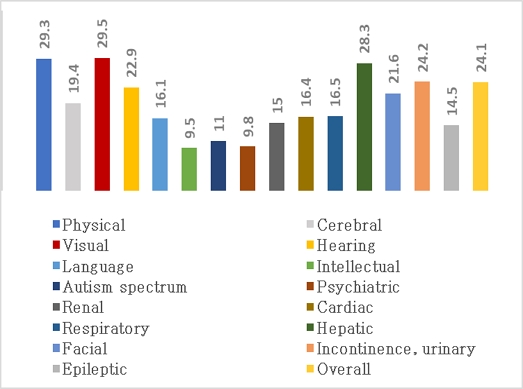

우리나라의 경우 보건복지부에서 3년에 한 번씩 전체 장애인의 실태조사를 진행하는데 가장 최근에 실시된 2020년 장애인 실태조사에 따르면 2020년도 전국 장애인 추정 수는 262.3만 명이다. 이 중 외부 활동이나 일상생활이 어려워 집에 머물며 살아가는 장애인을 재가 장애인으로 분류하여 따로 조사한 결과, 전체 재가 장애인을 장애 유형별로 구분했을 때 시각장애인은 약 25.2만 명으로 지체장애인과 청각장애인을 이어 그 수가 많았다. 또한 장애가 2개 이상인 중복 장애 유형을 고려하여 조사한 장애 유형별 장애인 추정 수를 보면 시각장애 인구는 308천 명으로 앞선 결과와 동일하게 지체장애인과 청각장애인을 이어 세 번째로 많은 것으로 조사되었다. 이는 시각장애인의 분포 정도가 국내 장애인 범주에서 많은 부분을 차지하고 있음을 의미하며 다른 장애와 중복되어 시각장애가 있는 인구도 많음을 시사한다. 국가와 자치 단체는 제도를 활용하여 장애인들이 고립되지 않도록 사회로 그들을 끌어내기 위한 다양한 제도를 시행하고 있는데 그 대표적인 예로는 취업 장애인 수를 증가시키는 정책이 있다. 하지만 장애인을 고용하는 기업의 수가 적을 뿐만 아니라 제공되는 직무와 혜택도 제한적이라는 문제점이 제기된다. 보건복지부의 2020년도 취업장애인의 임금 수준은 188만 원으로 보고되었는데 이는 통계청에서 2020년 8월에 발표한 경제활동인구 조사 결과 국내 전체 임금근로자 월평균 임금인 268만 원의 70%에 불과한 수준이며, 이 중 시각장애인은 191만 원의 임금으로 측정되어 다른 장애 직군보다 낮은 임금이 책정되었다. 또한, 그림 1과 같이 시각장애인의 29.5%가 장애 등록 후 국가나 사회로부터 지원을 전혀 받지 못하고 있다고 답변하였는데 이는 15개의 장애 분류군 중 가장 높은 비율이었다. 이 결과를 통해 시각장애인이 다른 장애인에 비해 사회적 활동에 많은 어려움을 겪고 있음을 짐작할 수 있다.

여러 장애 분류군 중 유난히 시각장애인의 사회 활동 만족도가 낮았던 이유는 인간의 감각 기관 활용과 관련된다. 인간은 대부분의 일상적인 생활을 시각 정보에 의존하여 수행한다. 시각은 인간의 다양한 외적 자극 중 가장 빠르게 받아들여지며 주변 환경과 상호작용하는 데 필요한 정보 대부분을 포함하고 있어, 인간의 어떤 감각 기관보다 많은 양의 정보를 받아들이는 감각이라고 볼 수 있다[1],[2]. 시각은 단순하게 사물, 지형, 색상을 시각적으로 인지하는 것부터 주변 환경을 습득하여 분석하는 과정을 통해 외부 환경을 이해하는 복잡한 과정까지 관여한다. 때문에, 인간이 자유롭게 외부 자극을 받아들이고 대응하기 위해서는 시각적인 정보가 충분히 제공되어야 한다. 시각장애인의 경우, 이러한 측면에서 비장애인과 비교했을 때 정보 접근성이 매우 떨어지며 다른 장애인들과 비교했을 때도 많은 양의 정보를 활용하지 못하는 것으로 판단할 수 있다[3]. 따라서, 시각장애인들의 제한적인 경제 활동 및 사회생활을 완화하기 위해서 효과적인 보조 기술들이 보급되어야 한다.

시각장애인들은 시각을 통해 얻지 못하는 정보를 청각과 촉각에 의존하여 얻는다[4]. 다양한 방식 중 가장 보편화되며 쉽게 접근할 수 있는 것은 점자책이 있다. 하지만 한국장애인단체총연맹에 따르면 2021년 기준 전체 출판되는 책 중 점자로 출간하는 비율은 0.2%에 불과한 것으로 나타났으며, 일반 도서에 비해 점자 도서가 5배 이상 높은 가격으로 판매되는 것으로 알려졌다. 점자 도서는 일반 도서보다 제작하는데 더 큰 비용과 시간이 드는 데 비해 그 수요가 적어서 수와 종류가 부족하다. 각 시/도별 점자도서관에서는 일반 도서를 직접 컴퓨터에 입력하고 이를 점자로 번역하는 봉사활동을 진행하는 것을 통해 부족한 점자 도서 보급률을 높이는 지방자치 제도를 시행 중이나, 여전히 점자 도서 제작과 보급은 제한적이다. 이런 상황에서 최근 들어 대두되고 있는 문제는 우리 사회가 디지털 혁신 시대를 맞이하여 기존에 출판되고 있던 종이책이 e북과 같은 전자 형태로 출판되면서 시각장애인들의 정보 접근 장벽이 더 높아지는 것이다[5],[6]. 디지털 스마트 시대에 맞추어 장애인용 책을 전자책으로 바꾸자는 목소리도 있었으나, 장애인용 전자책이 출시되어도 정보를 활용하기 위해서 기기를 사용하는 방법에 대해 우선 학습해야 한다는 점에서 즉각적인 효과를 기대하기가 어렵다. 또한, 모든 정보가 디지털화됨에 따라 개인정보 유출과 같은 이차적인 문제 상황에 대응하는 방법에 대한 고민도 필요하다는 단점이 존재한다[6].

모든 책이 전자화되거나 점자로 출판될 수 없다는 현실을 고려하면, 종이에 인쇄된 글자를 직접 만져서 즉각적으로 확인할 수 있는 점자로 바꿔주는 방법이 가장 효과적이라 할 수 있다. 때문에, 다양한 기술을 융합한 점자 시스템이 시각장애인을 위해 보조 기기로 개발되고 있다. 점자 시스템의 개발 방향은 단순하게 문자를 인식하고 인식한 결과대로 점자를 도출하는 것부터 인공지능(AI; artificial intelligence)을 활용하여 오류와 결함을 기기 차원에서 먼저 감지하여 정보의 정확도를 높이는 것까지 다양하다. 인공지능은 사회와 산업뿐만 아니라 인간 삶의 깊숙한 곳까지 큰 변화를 불러왔다. 자율주행 차량, 의료 진단, 금융 분야 등 다양한 IT 기기에 인공지능 기술이 활용되어 인간의 생활에 적용되고 있으며 이는 시각장애인을 위한 보조 기기 시스템에도 활용되며 그 결과 보조 기구는 과거와 비교했을 때 큰 변화를 맞이했다[7]. 이전까지는 서비스를 이용하기 위해서 직관적인 별도의 과정이 필요했다[8]. 그 예로는 보행을 위한 점자 보도블록, 시각장애인의 특성을 분석하여 특별하게 제작된 길 안내 지도, 공공시설 활용을 위한 NFC 시스템 등이 있다. 이와 같은 보조 기기들은 시각이 아닌 다른 감각으로 정보를 전달하기 위해서 사전에 조치가 필요하여 효율성이 다소 떨어진다는 단점이 있다. 하지만 인공지능의 인식 기술을 활용하면 기존 보조 기기의 단점을 효과적으로 해소할 수 있는데[9], 대체로 카메라를 활용하여 정보를 인식하는 방식으로 사용된다[10]. 시각장애인의 외부 활동과 일상생활을 보조하기 위한 인공지능 기술의 개발은 표 1과 같이 인식 보조, 쇼핑 보조, 이동성 보조, 학습 보조로 나눌 수 있다. 이를 기반으로 활용할 수 있는 기술을 보면 특별한 것은 아니지만 일상생활의 편의성과 삶의 만족도 증진을 위해서 필수적으로 얻어야 하는 정보들이 대부분이다. 때문에, 인공지능의 인식 기술을 통해 시각장애인들의 정보 접근성을 높이는 것은 혁신과 발전을 이끌고 인간의 불편함을 줄이며 새로운 기회와 경험을 제공한다는 기술의 궁극적인 목적을 다하는 것이라 할 수 있다.

본 논문을 통해 책의 이미지 속 글자를 추출하여 점자로 번역하고, 이를 물리적인 점자 형태로 실시간 구현이 가능한 시스템을 제안한다. 문자를 인식하고 추출하는 과정에는 인공지능을 통해 학습을 진행한 언어 모델을 활용하며, 최종적으로 개발된 점자 소프트웨어 시스템을 하드웨어에 연결하여 시각장애인이 물리적으로 점자를 인식할 수 있도록 한다. 논문의 구성은 2장에서는 시각장애인을 위해 개발되어 현재 활용되고 있는 보조 기술에 대해 분석한다. 3장은 본론으로 본 논문이 제안하는 시스템을 설명하며 이 내용은 소프트웨어 시스템과 하드웨어 시스템으로 구성된다. 마지막으로 4장과 5장에서는 차례로 시스템 동작 실험 결과와 논문의 결론을 기술한다.

Ⅱ. 관련 연구

시각장애인은 시각을 통해 얻을 수 있는 외부 정보를 촉각에 의존하여 얻으며, 촉각을 통해 얻지 못한 부가적인 내용은 청각을 통해 이해한다[11]. 이에 따라 현재 보조 기구의 개발 및 상용화는 시각장애인의 고유한 감각 활용 특성을 고려하여 주로 촉각에 초점을 맞추고 있으며 추가로 청각적 요소의 활용이 보조되는 방향으로 진행된다.

2-1 점자 디스플레이

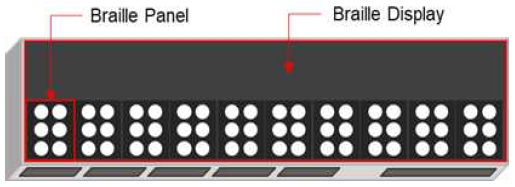

점자 디스플레이는 정보를 점자로 변환해 주는 기술로, 시각장애인이 촉각을 통해 정보를 읽을 수 있도록 도와주는 장치이다[12]. 점자 디스플레이는 점자를 느낄 수 있도록 일련의 작은 돌기 또는 점자를 만들어 낼 수 있어, 시각장애인은 점자로 구현된 책, 문서, 뉴스 기사 등 다양한 문자 정보를 얻을 수 있다. 디스플레이는 다양한 형태로 구현될 수 있는데 크게 점자 인쇄물 디스플레이와 디지털 점자 디스플레이로 구분된다. 기존에는 점자 인쇄물 디스플레이를 구현하여 점자 인쇄물을 사용하거나 특수한 인쇄기로 점자를 빈 문서에 인쇄하도록 하는 기술이 연구되었다. 이러한 방식은 얼마나 정교하게 많은 양을 점자로 인쇄할 수 있느냐에 중점을 두고 연구되고 있는데 기존의 점자 인쇄물을 사용하는 방식과 크게 다르지 않아 현재는 디지털로 점자를 구현하는 연구로 기술이 확장되고 있다. 디지털 점자 디스플레이는 일반적으로 브라유 점자 체계로 동작한다. 점자 디스플레이는 대체로 그림 2와 같은 형태로 구성되며 점자 패널과 점자 디스플레이로 구분된다. 점자 패널은 가로와 세로로 점자를 배열하여 각 글자를 형성하며, 시각장애인은 패널의 점자를 손가락으로 느끼면서 정보를 읽고 해독한다. 해당 디스플레이는 일반적으로 휴대성이 뛰어나고 배터리로 구동되기 때문에 시각장애인의 정보 접근성이 뛰어나다는 장점이 있다. 또한, USB나 블루투스를 지원하는 기기의 경우 컴퓨터나 스마트폰과 같은 전자기기와 연결하여 다양한 문서를 읽고 작성할 수 있어 높은 접속성을 가지고 있다.

2-2 TTS (text–to-speech)

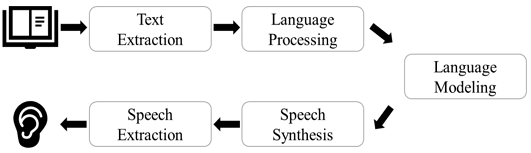

TTS는 텍스트를 음성으로 변환하는 기술로, 현재는 인공지능과 음성 합성 기술의 발달로 다양하게 응용되고 있으며 시각장애인의 보조 기구에도 활용되고 있다[12],[13]. TTS 시스템의 작동 원리는 그림 3과 같은 흐름도로 설명할 수 있다. 시스템은 먼저 텍스트의 입력을 받거나 이미지로부터 텍스트를 추출하여 기기가 음성으로 변환할 내용을 결정한다. 이후 입력된 텍스트 값은 언어 처리 과정을 거치는데 이 단계에서 시스템은 텍스트의 문장 구조, 단어의 발음 및 억양, 그리고 언어적 특성을 분석하여 언어 모델이 추출한 텍스트를 자연스러운 형태로 변환되도록 한다. 이후, 처리된 언어는 컴퓨터가 읽을 수 있는 음성 출력으로 변환된다. 언어 처리된 텍스트는 언어 모델로 전달되어 음성 합성에 활용되는데, 이 과정에서 언어 모델은 텍스트를 다양한 언어적 패턴과 문법적 규칙에 기반을 두어 사용자가 문장을 이해하도록 하는데 사용되며 인공지능을 활용하면 문장 구조를 파악하고 단어 간의 관계를 반복적으로 학습하여 문장의 완성도를 높일 수 있다[9]. 최종적으로, 언어 모델을 거쳐 생성된 텍스트는 음성 합성 엔진으로 전달되어 음성화되는데 이 단계에서는 디지털화된 음성 데이터가 이해하기 쉽고 자연스러운 음성으로 도출되는 것이 중요하다. TTS 시스템은 청각으로 정보를 전달하므로 정보에 대한 이해가 빠르다는 장점이 있고 미리 녹음된 음성 샘플을 사용하여 자동으로 음성을 생성하기 때문에 많은 양의 텍스트를 변환할 수 있다[12]. 또한, 기존에 문제가 되고 있었던 시각장애인의 디지털 접근성을 증대시키는 데 긍정적인 역할을 하고 있으며 시각장애인에게 정보 접근의 평등성과 인터넷 사용의 자유를 제공하는 것을 통해 장애인들의 사회 참여와 외부 활동을 끌어내는 것에 도움이 된다.

Ⅲ. 본 론

3-1 점자 구현 시스템의 소프트웨어 구성

본 논문에서 제안하는 시스템은 입력되는 책의 이미지에서 글자를 추출하여 점자로 번역하고, 이를 실시간으로 물리적인 점자 형태로 구현한다. 이를 위해서는 카메라가 인식한 이미지에서 텍스트를 정확하게 추출하고 추출된 텍스트를 기반으로 올바른 점자를 구현할 수 있는 언어 모델이 필요하다.

광학문자인식(OCR; optical character recognition)은 이미지 파일에 존재하는 텍스트를 기계가 이해할 수 있는 텍스트 데이터 형태로 변환하는 기술로, 이는 자료를 취급하는 모든 분야에서 아날로그 기록문서의 디지털화에 필수적인 기술이다. 현재 실생활에서 이용되고 있는 분야로는 신분증 촬영, 자동차 번호판 인식, 우편물 분류 등이 있고, 이미지 내부에서 필요한 텍스트 정보를 추출한다는 점에서 본 연구에서 활용할 수 있다. OCR 엔진의 작동 구조는 크게 문자 검출 방식과 문자 인식 방식으로 구분할 수 있다. 문자 검출 방식은 이미지에 존재하는 문자의 위치를 찾는 비전 기술로, 그림 4와 같이 문자 주변에 사각형 상자로 영역을 지정하거나 문자열의 연결성을 파악하여 단어와 문자 라인을 검출한다. 문자 인식 방식은 검출된 문자가 어떤 문자인지 판별하고, 이를 텍스트 형태의 데이터로 변환하는 인공지능 모델을 의미한다. 전자기기 앱이나 한글, 워드, pdf 파일에서 문자를 인식하는 방식이 대표적인 예이며, 글자 인식 방식은 개별 글자를 인식하는 방식과 단어 단위를 인식하는 방식으로 구분할 수 있다.

Example of text detection through OCR engine* The figure contains Korean characters to explain the process which converts Korean character of input image into Korean text data using OCR engine as an example.

기본적으로 한글을 인식하고 오픈소스로 제공하는 OCR 엔진은 Tesseract OCR과 EasyOCR이 있다. Tesseract OCR은 2000년대 초반에 개발되어 현재는 구글에서 개발하고 관리하고 있다. 꾸준히 업데이트되고 있으나, CPU로만 사용 가능하고 한글 인식 성능이 낮다는 단점이 있다. EasyOCR은 2020년에 개발된 신생 엔진으로 CPU, CUDA 가속을 이용한 GPU 지원이 가능하며 Tesseract OCR과 비교했을 때 한글 인식 성능이 좋다는 장점이 있다. 또한, Python을 기반으로 쉽게 이미지 내 텍스트 검출이 가능하고 딥러닝 기술을 활용하고 있어 높은 텍스트 인식 정확도를 보인다. 본 논문에서 한글 인식 학습모델로 사용한 OCR 엔진은 EasyOCR이며 프로그램에서 자체적으로 제공하는 튜토리얼을 기반으로 학습을 진행하여 개발된 한글 인식모델을 통해 텍스트를 추출한다. OCR 엔진을 사용한 점자 시스템은 기존의 전자기기와 연결하여 사용하는 점자 디스플레이와 달리, 한글 인식모델을 기반으로 하는 것이 가장 큰 차이점이다. 이는 한글 인식모델의 성능 개발에 따라 문자를 인식하는 정확도와 활용성의 향상될 수 있음을 의미하며 개발된 언어 모델을 통해 다양한 언어를 하나의 디바이스로 점자화할 수 있으므로 높은 범용성을 가진다.

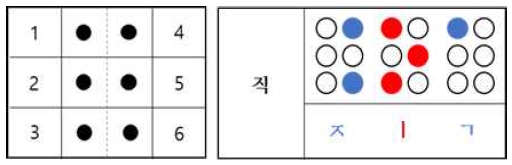

이미지에서 추출한 텍스트를 하드웨어 시스템으로 구현하기 위해서는 추출된 텍스트를 한글 점자 체제에 맞게 분리하여 디지털화하는 과정이 필요하다. 한글 점자는 한 글자를 6개의 점(가로 2개, 세로 3개)으로 표현하는데 이 점들이 초성, 중성, 종성으로 이루어져 하나의 글자를 이루며 그림 5의 왼쪽과 같이 왼쪽 위에서 아래로 각 1점, 2점, 3점이며 오른쪽 위부터 아래로 각 4점, 5점, 6점이 된다. 점자 한 칸을 형성하는 6개의 점으로 만들어 낼 수 있는 점형의 수는 64종류이며, 점이 하나도 찍히지 않는 경우를 제외하고 총 63개의 점형을 이용하여 점자를 표기한다. 점자를 디지털화할 때는 점형이 사용된 경우를 1로 두고 사용되지 않은 경우를 0으로 고려하여 구현할 수 있다. 이때 하나의 점형은 1bit로 표현할 수 있고, 6bit를 가지는 정보 표현 방식을 사용할 수 있다.

(left) 6-point braille system, (right) examples of Korean braille composition* The figure contains Korean characters to explain Korean braille composition as an example.

한글은 기본적으로 모아쓰기 방식을 사용하는데, 이는 초성, 중성, 종성이 하나로 결합하여 음절을 형성하는 형태이다. 초성에 올 수 있는 음소의 종류는 ‘ㄱ’~‘ㅎ’까지이고 중성에 올 수 있는 음소의 종류는 ‘ㅏ’~‘ㅣ’이다. 또한 종성까지 추가되면 그 수가 증가하게 되어 63종류의 점형으로는 6점식 점자 체계를 표현할 수 없다. 따라서, 한글의 경우 약어를 사용하며 초성과 중성, 종성을 하나씩 점자로 표현하는 풀어쓰기 방식을 사용한다. 하지만 이 방식은 초성, 중성, 종성을 각 점형과 대응하여 나타내는 형태로 음절 단위의 구별을 어렵게 만든다. 예를 들어 ‘각’이라는 단어의 경우 초성의 ‘ㄱ’과 종성의 ‘ㄱ’이 같은 음소에 대응된다. 이와 같은 문제를 해결하기 위해 점자에서는 초성과 종성을 다르게 표현하며, 이는 음절의 중심인 모음 표기에 상단의 점과 하단의 점 중에 한 개 이상을 반드시 포함하는 형태로 이루어져야 한다. 따라서, 그림 5의 오른쪽과 같이 ‘직’이라는 글자를 고려해 볼 때, 초성인 ‘ㅈ’은 4-6점, 중성 ‘ㅣ’는 1-3-5점, 종성 ‘ㄱ’은 1점으로 읽어지며 이는, 디지털화될 때 ㆍ을 사용해 bit 단위로 표현할 수 있다.

한글을 디지털 환경에서 초성, 중성, 종성으로 분리하는 방식은 한글의 유니코드를 활용하는 방식이다. 한글 코드의 시작은 44032부터 시작하여 55199에 끝난다. 이는 각 음소의 단위를 번호로 부여한 것이 아닌 단일 글자에 대해서 번호를 부여하는 형태로 나타나는데, 이를 표현하는 방식은 ‘ㄱ’의 코드로 예를 들었을 때 ((초성)*21)+종성+0xAC00)이며 초성, 중성, 종성은 아래와 같이 구성된다.

| (1) |

이와 같은 방법으로 텍스트를 유니코드로 분리하는 방식을 사용하게 되면, 기존 한글의 모아쓰기 방식을 점자 체계와 맞게 풀어쓰기 방식으로 변경할 수 있다.

3-2 점자 구현 시스템의 하드웨어 구성

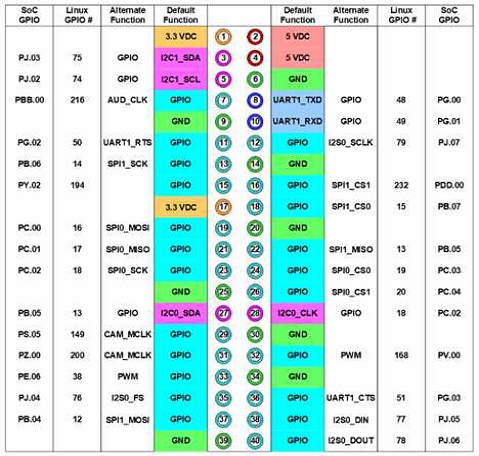

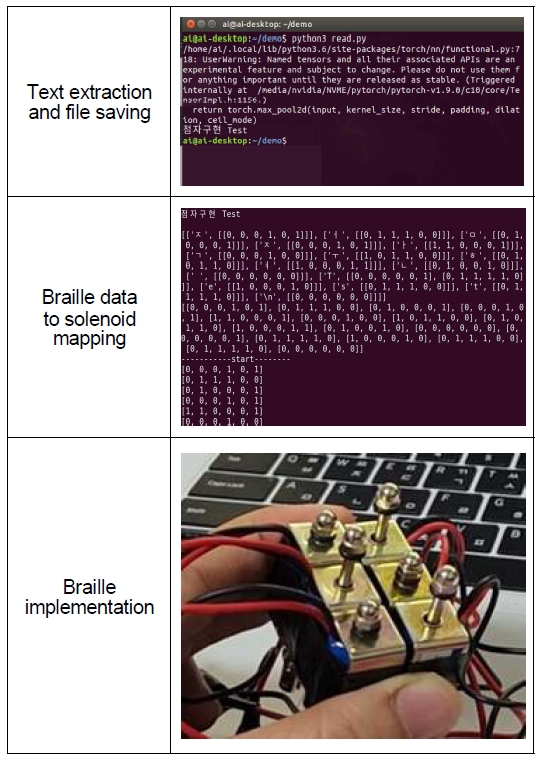

Jetson Nano를 통해 디지털화된 이미지 속 텍스트를 하드웨어 점자로 구현했다. Jetson Nano에서 문자열을 형태소로 분리하고 이를 GPIO 핀을 통해 모터에 할당하여 작동하도록 하는 방식이다. 그림 6은 사용한 Jetson Nano GPIO의 layout이며 Jetson expansion header tool에서 통신 방법을 선택하여 연결하면 실제 하드웨어 점자 시스템으로 구현할 수 있다.

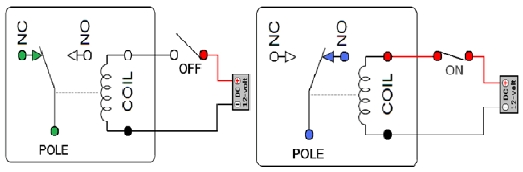

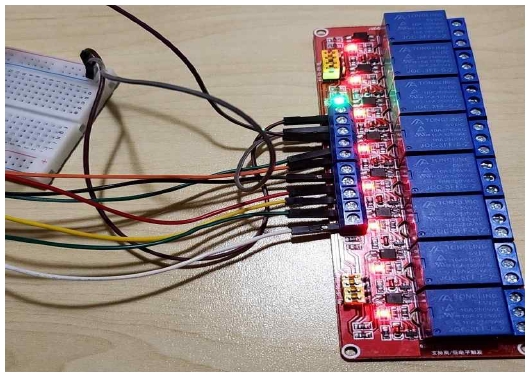

6점식 점자 체계를 구현하기 위해서 솔레노이드를 사용했으며 점자 한 칸을 구성하는 6개의 데이터를 제어하기 위해 릴레이를 사용한 결과, 점자 기판 하나를 구현하는 데에는 8채널 릴레이 1개와 솔레노이드 6개가 필요하다. 이 중 릴레이는 off 상태와 on 상태 두 가지로 구분되며, 동작 원리는 그림 7과 같다. 그림 7의 왼쪽과 같이 릴레이가 off 상태일 때에는 접점이 떨어지게 되어, 소자가 되고 그림 7의 오른쪽과 같이 on 상태에서는 코일에 전원이 투입되면 접점이 붙어, 여지가 된다. 이러한 릴레이의 접점 유무에 따른 특성 변화를 활용하면 점자 6개의 데이터를 각각 독립적으로 제어할 수 있으며 구성된 릴레이의 작동 모습은 그림 8과 같다.

물리적으로 점자와 같이 구현하기 위해 활용한 솔레노이드는 길고 가늘게 만들어진 도체를 원통형으로 감아 만든 것으로 에너지 변환장치로 사용한다. 에너지는 전기에너지에서 자기에너지로 변환되며 솔레노이드에 전류를 흘려보내면 솔레노이드 내부에 자기장 에너지가 형성된다. 이때 변환되는 솔레노이드의 힘은 전류의 크기와 일정 길이당 감은 도체의 횟수에 비례한다. 이러한 특성을 이용해 개발된 것에는 솔레노이드 밸브가 있는데 이는 솔레노이드에서 발생한 자기장의 힘을 이용하여 운동할 수 있다. 특히, 전기 신호를 통해 원격으로 움직임을 제어할 수 있어 본 연구의 점자 구현에 적합하다. 솔레노이드 밸브는 기본적으로 자기장을 발생시키는 솔레노이드 본체 부분과 움직임이 제어되는 밸브 몸체로 구성되며 제어 방식에 따라 크게 스풀(spool)과 포핏(poppet)으로 구분된다. 포핏은 밸브 제어부와 밸브 시트가 직각 방향으로 만나며 밸브 제어부가 솔레노이드 자기장의 힘으로 상하 운동을 하며 밸브 시트를 움직인다. 이러한 움직임이 시각장애인들이 촉감을 통해 즉각적으로 인지할 수 있는 점자로 구현된다.

Ⅳ. 실험결과

4-1 점자 구현 소프트웨어 시스템 구현 결과

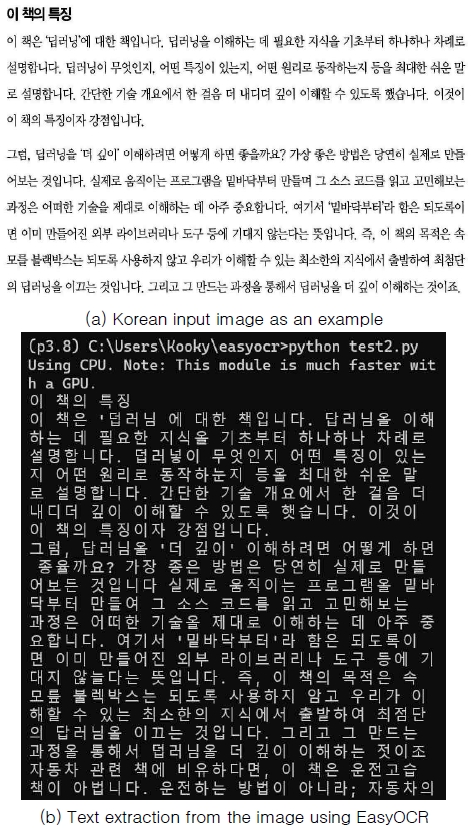

본 논문에서 한글 인식 학습모델로 사용한 OCR 엔진은 EasyOCR이며 프로그램에서 자체적으로 제공하는 튜토리얼을 기반으로 학습을 진행하여 개발된 한글 인식모델을 통해 텍스트를 추출한 결과는 그림 9의 (b)와 같다. 그림 9의 (a)와 같이 문자의 형태와 크기가 일정하게 정형화된 이미지 데이터를 사용하면 한글 인식의 정확도가 높아지는 것을 확인할 수 있다.

Ⅴ. 결 론

본 논문은 시각장애인을 위한 점자 변환 시스템을 설계하고 구현하였다. 이미지에서 추출된 텍스트를 분석한 결과 높은 인식률을 보였고, 문자가 정형화된 이미지일 경우 그 정확도는 더 높아질 수 있다. 또한 문자 인식 모델의 학습이 누적될수록 활용도가 높아진다는 장점이 있다. 하드웨어로 구현된 시스템은 고전압의 솔레노이드가 장시간 작동할 때 발열 문제가 다소 발견되었다. 이는 저전압 솔레노이드를 통해 어느 정도 해결할 수 있지만, 결과적으로 발열은 데이터 전달 문제가 아닌 기판을 표시하는 솔레노이드의 고전압으로 인한 문제이므로 솔레노이드 동작 방식인 전자기 유도에 관한 추가적인 후속 연구를 통해 발열 문제를 해결할 수 있다.

본 논문에서 제안하는 시스템은 시각장애인이 촉각을 활용하여 즉각적으로 활용할 수 있으며 소프트웨어와 연동하여 많은 양의 정보에 접근할 수 있다는 장점이 있다. 이 시스템은 시각장애인들의 정보 접근성을 향상하고 교육, 업무, 문화생활 등 다양한 측면에서 시각장애인이 비장애인과 동등한 기회를 받을 수 있게 하며, 시각장애인의 능동적이며 독립적인 활동에 기여할 수 있다.

Acknowledgments

이 논문은 전남대학교 학술연구비(과제번호: 2022-2588) 지원에 의하여 연구되었음.

References

-

S. Shoval, J. Borenstein, and Y. Koren, “The NavBelt-A Computerized Travel Aid for the Blind Based on Mobile Robotics Technology,” IEEE Transactions on Biomedical Engineering, Vol. 45, No. 11, pp. 1376-1386, November 1998.

[https://doi.org/10.1109/10.725334]

- S. Kang and S.-W. Lee, “Wearable Machine Vision Technologies for the Visually Impaired,” Korean Journal of Brain Science and Technology, Vol. 1, No. 1, pp. 127-137, June 2001.

-

T. Ahmed, R. Hoyle, K. Connelly, D. Crandall, and A. Kapadia, “Privacy Concerns and Behaviors of People with Visual Impairments,” in Proceedings of the 33rd Annual ACM Conference on Human Factors in Computing Systems (CHI ’15), Seoul, pp. 3523-3532, April 2015.

[https://doi.org/10.1145/2702123.2702334]

-

S. Shoval, J. Borenstein, and Y. Koren, “Auditory Guidance with the Navbelt-A Computerized Travel Aid for the Blind,” IEEE Transactions on Systems, Man, and Cybernetics, Part C (Applications and Reviews), Vol. 28, No. 3, pp. 459-467, August 1998.

[https://doi.org/10.1109/5326.704589]

-

Y. Ok and J. Lee, “Implementing Image Insertion Function of Voice-Based Report Generator Application for the Visually Impaired,” Journal of Digital Contents Society, Vol. 24, No. 4, pp. 671-677, April 2023.

[https://doi.org/10.9728/dcs.2023.24.4.671]

-

M. Rim, Y. Gil, and G. Jeon, “The Implementation Directions and an Analysis of Assistive Devices and Alternative Formats to Improve Accessibility for Disabled People,” The Journal of the Korea Contents Association, Vol. 15, No. 7, pp. 664-673, July 2015.

[https://doi.org/10.5392/JKCA.2015.15.07.664]

-

A. L. Fraga, X. Yu, W.-J. Yi, and J. Saniie, “Indoor Navigation System for Visually Impaired People Using Computer Vision,” in Proceedings of 2022 IEEE International Conference on Electro Information Technology (eIT), Mankato: MN, pp. 257-260, May 2022.

[https://doi.org/10.1109/eIT53891.2022.9813919]

-

S.-Y. Bae, “Research Trends on Related to Artificial Intelligence for the Visually Impaired: Focused on Domestic and Foreign Research in 1993-2020,” The Journal of the Korea Contents Association, Vol. 20, No. 10, pp. 688-701, October 2020.

[https://doi.org/10.5392/JKCA.2020.20.10.688]

-

S.-R. Lee, H.-K. Shin, S.-A. An, and K. Yu, “Development of Voice Assistant Apps for Low Vision People Based on Artificial Intelligence,” Journal of Digital Contents Society, Vol. 21, No. 2, pp. 277-284, February 2020.

[https://doi.org/10.9728/dcs.2020.21.2.277]

-

J. Kwon and Y. S. Lee, “Artificial Intelligence for Persons with Disabilities,” The Journal of Korea Elementary Education, Vol. 31, pp. S187-S202, August 2020.

[https://doi.org/10.20972/kjee.31..202008.187]

-

S. Zanchi, L. F. Cuturi, G. Sandini, and M. Gori, “Evaluation of a Motion Platform Combined with an Acoustic Virtual Reality Tool: A Spatial Orientation Test in Sighted and Visually Impaired People,” in Proceedings of the 43rd Annual International Conference of the IEEE Engineering in Medicine & Biology Society (EMBC), Online, pp. 6078-6081, November 2021.

[https://doi.org/10.1109/EMBC46164.2021.9630867]

-

S. Jang, D. Hwang, S. Kang, E. Kim, J. Park, K. Jang, and J. Yoo, “Design and Implementation of a Navigation System for Visually Impaired Persons,” The Journal of the Korea Contents Association, Vol. 12, No. 1, pp. 38-47, January 2012.

[https://doi.org/10.5392/JKCA.2012.12.01.038]

-

S. Park, J. Park, H. Ryu, H. Lee, and K.-M. Lee, “Situation Awareness Auxiliary IoT Device and Pedestrian Navigation Service Application for Visually Impaired Persons,” Journal of Digital Contents Society, Vol. 21, No. 2, pp. 269-275, February 2020.

[https://doi.org/10.9728/dcs.2020.21.2.269]

저자소개

2021년~현 재: 전남대학교 컴퓨터정보통신공학과 학사과정

※관심분야:자연어 처리, 머신러닝, DevOps

2021년~현 재: 전남대학교 컴퓨터정보통신공학과 학사과정

※관심분야:머신러닝

2023년:전남대학교 컴퓨터정보통신공학과 (공학사)

2023년~현 재: 전남대학교 ICT융합시스템공학과 석사과정

※관심분야:SoC 시스템 설계 및 테스트 반도체 보안 설계

2011년:인하대학교 전자공학 (공학사)

2015년:연세대학교 전기전자공학 (공학석사)

2020년:연세대학교 전기전자공학 (공학박사)

2011년~2015년: Teradyne SoC Test Division 선임연구원

2020년~2021년: 삼성전자 Test & System Package 책임연구원

2021년~현 재: 전남대학교 컴퓨터정보통신공학과 조교수

※관심분야:VLSI/SoC 설계 및 테스트, 메모리 테스트 기술, 보안 설계 방법론 등