실내 바닥면 포인트 클라우드를 이용한 AI 기반 3D 공간구조 추정 기술

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 논문에서는 RGB-D 카메라를 이용해 실세계 실내 공간을 스캔하여 포인트 클라우드로 구성된 가상공간을 구축한다. 포인트 클라우드는 분산되고 노이즈가 많은 특성이 있어 (포인트 클라우드를 이용하여) 실세계와 유사한 가상공간을 재구성하는 것은 어려운 일이며 매우 도전적인 과제이다. 우리는 CNN 모델을 기반으로 3차원 공간의 구조를 추정하여 모델링 하는 효율적인 방법을 제안한다. 3차원 재구성 알고리즘을 기반으로 RGB-D 이미지 통해 실내 포인트 클라우드를 생성하고, 바닥면 데이터를 추출한다. 바닥면 포인트 클라우드 데이터는 2차원 바이너리 영상으로 투영 변환되고, CNN 모델을 이용해 바닥면의 코너를 탐지한다. 이를 기반으로 실내 공간의 3차원 공간구조를 추정하고 모델링 한다. 향후 본 연구는 효율적으로 실세계와 유사한 메타버스 공간을 구축하는 데에 기여할 것이다.

Abstract

In this paper, we construct a virtual space composed of point clouds by scanning real-world indoor spaces using RGB-D cameras. Point clouds have distributed and noisy properties, making it difficult and a very challenging task to reconstruct a virtual space similar to the real world (using point clouds). We propose an efficient method for estimating and modeling the structure of 3D space based on CNN model. Based on the 3D reconstruction algorithm, an indoor point cloud is created through RGB-D images and floor data is extracted. Floor point cloud data is projected and converted into 2D binary images, and corners of floor is detected using CNN model. Based on this, the 3D spatial structure of the indoor space is estimated and modeled. In the future, this study will contribute to efficiently establishing a metaverse space similar to the real world.

Keywords:

3D reconstruction, Spatial Structure Estimation, Digital Twin, Coner Detection, Metaverse키워드:

3D 재구성, 공간구조 추정, 디지털 트윈, 코너 탐지, 메타버스Ⅰ. 서 론

코로나19 사태로 인한 비대면 활동의 증가로 경제, 사회, 문화 등 우리 삶의 전반적인 부분에서 현실과 가상이 모두 공존할 수 있는 3차원 가상공간 메타버스에 대한 관심도가 증가하고 있다. 사용자들이 메타버스 환경에 쉽게 몰입하기 위해서는 현실감 있는 3차원 가상공간을 모델링 하는 것은 매우 중요하다. 일반적으로 3차원 가상공간 모델링은 3D 저작 소프트웨어(Maya, 3D Max, Sketch-up 등)를 활용한다. 이는 시간 및 많은 비용이 소모되며 디자이너의 역량에 따라 품질 차이가 많은 단점이 존재한다.

최근에는 수작업이 아닌 카메라를 통해 촬영된 영상들로부터 3차원 공간을 재구성하고 모델링하는 연구가 활발히 진행되고 있다. 이는 영상들의 호모그래피를 이용해 깊이 정보를 추정하고, 이를 기반으로 3차원 포인트 클라우드를 추출한다.

이렇게 얻어진 포인트 클라우드는 텍스쳐와 3차원 좌표정보를 갖고 있으므로 3차원 실세계 공간의 복잡한 정보(텍스쳐, 조명, 재질 등)가 그대로 적용된 사실적인 가상공간을 자동화하여 구축할 수 있는 장점이 있다.

하지만 포인트 클라우드는 추출과정에서 분산되고 노이즈가 많은 특성이 존재하며 촬영되지 않은 부분의 정보 소실이 발생한다. 특히 실내 공간을 표현하는 포인트 클라우드는 복잡하고 다양한 객체에 대한 정보를 담고 있으며 이러한 정보들은 바닥면, 벽면을 폐색한다. 이로 인해 3D 저작도구를 활용한 추가적인 후처리 작업이 필요하다. 그럼에도 불구하고 실세계를 그대로 옮길 수 있는 큰 장점으로 인해 꾸준히 연구가 진행되고 있다.

본 연구는 RGB-D 카메라를 이용해 촬영된 실내 공간을 3차원 재구성하기 위한 효과적인 방법을 제안한다. 실내 공간에는 다양한 객체가 함께 존재한다. 이로 인해 폐색된 영역이 생길 수밖에 없으며, 카메라로 정밀하게 촬영(스캔)하더라도 소실되는 부분이 발생한다. 소실된 정보는 추출된 포인트 클라우드에도 그대로 반영되며 3차원 재구성할 때 공간이 발생한다는 문제점이 있다. 우리는 실내 공간의 3차원 재구성을 위해 바닥면에 초점을 맞추어 접근하고자 한다.

실세계의 건축물을 모델링 할 때 바닥면 정보는 매우 중요한 단서이다. 바닥면은 사실상 도면과 일치하며 이를 아는 것은 공간 전체의 구조를 아는 것과 같다. 특히 바닥면의 코너 부분은 건축 구조물(벽, 천장 등)을 연결하는 역할을 하며, 건물을 모델링할 때 기반이 된다.

본 연구에서는 RGB-D 카메라로부터 실내 공간 전체의 3차원 포인트 클라우드를 생성하고, 바닥면 포인트 클라우드를 추출하여 이를 영상으로 변환한다. 바닥면 영상으로부터 CNN 모델을 기반으로 바닥면의 코너 정보를 탐지하고 3차원 공간의 구조를 추정한다. 이를 통해 3차원 실내 공간을 효율적으로 모델링 하는 방법을 제시한다.

Ⅱ. 관련 연구

범용적 장비인 RGB-D 카메라의 출현으로 고품질의 가상공간을 구축하고 구조를 추정하는 연구가 활발히 진행되고 있다. 3차원 재구성에 관한 연구는 RGB-D 카메라의 노이즈 및 다양한 객체 등으로 인해 고품질의 실내 공간을 재구성하는 것은 어려운 문제이며 해결해야 할 과제이다[1]-[5].

Sungjoon Choi. et al의 연구에서는 RGB-D 이미지 시퀀스에서 프레임 단위의 포인트 클라우드를 추출하여 기하학적 정렬을 통해 고품질의 실내 장면 재구성에 대한 접근 방식을 제안하였다. RGB-D 이미지 시퀀스를 K-프레임 세그먼트로 분할하고, RGB-D Odometry를 사용하여 카메라 궤적을 추정한다. 최종적으로 Loop-Closure를 식별하고, ICP를 사용하여 3차원 재구성 파이프라인을 개발하였다[6].

Chris Harris. et al, David G.Lowe의 연구는 전통적인 RGB 이미지에서 코너를 탐지하는 전통적인 알고리즘이다[7], [8]. Chris Harris. et al의 연구에서는 픽셀 단위로 이동시켰을 때, 모든 방향으로 영상의 변화가 큰 픽셀을 코너로 탐지한다. David G.Lowe의 연구에서는 Chris Harris. et al 연구가 영상의 크기 변화에 민감한 문제를 해결하기 위하여 크기 및 회전에 강인한 코너 점을 탐지한다.

위와 같은 연구들은 노이즈가 존재할 경우 정확한 코너를 탐지하지 못한다는 단점이 있다. 포인트 클라우드의 경우 많은 노이즈가 존재하기 때문에 우리는 CNN 모델을 통해 이와 같은 문제를 해결했다.

R. Schnabel. et al 연구에서는 분산되고 노이즈가 많은 포인트 클라우드에서 평면을 추출하는 방법을 제안하였다. 무작위 샘플링을 기반으로 하며 구, 실린더, 원뿔 등을 감지한다[9].

Ruifan Cai. et al, Eric Turner. et al, Shayan Nikoohemat. et al, Kourosh Khoshelham et al, Hao Fang. et al 의 연구에서는 실내 공간 포인트 클라우드에서의 바닥면 정보를 추출하고 2차원 그래프 형식으로 분할하여 공간의 구조를 추정하는 방법을 제안하였다[10]-[14].

위에서 언급한 방법은 대규모 선형 세그먼트는 작은 슈퍼복셀(super-voxel)을 대량으로 생성하므로 계산 및 저장 비용이 증가한다. 따라서 우리는 바닥면 포인트 클라우드를 바이너리 이미지로 투영 변환하고, CNN 모델을 기반으로 코너를 탐지하여 연산량을 줄였다.

Ⅲ. 실내 공간구조 추정 프로세스

3-1 프로세스 개요

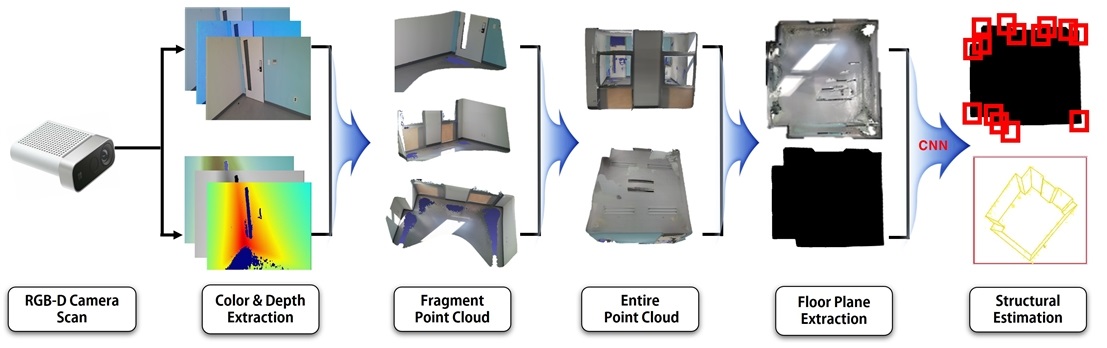

[그림 1]은 본 논문에서 제안한 실내 공간 구조를 추정하기 위한 전체적인 프로세스를 보여준다. RGB-D 카메라를 이용해 실세계 실내 공간을 촬영(스캔)했다.

이를 통해 연속적인 장면의 Color와 Depth 이미지를 추출하였고, 이를 통해 프레임 단위의 부분 포인트 클라우드를 생성했다. 3차원 재구성 알고리즘을 기반으로 부분 포인트 클라우드의 정합(Registration)을 통해 포인트 클라우드로 이루어진 통합된 가상 실내 공간을 구축하였다.

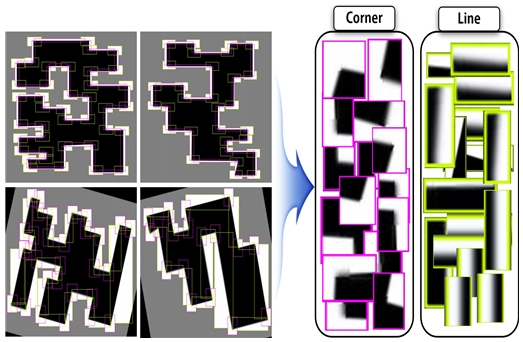

우리는 바닥면의 코너를 탐지하기 위해 두 가지 레이블(코너, 선)로 분류된 2차원 바이너리 평면도 이미지 약 2,000장을 CNN 모델을 통해 학습시켰으며, 데이터 증강 기법(Flip, Rotate, Sheer 등)을 활용하여 학습 데이터의 신뢰성을 높였다. [그림 2]는 우리가 구축한 학습 데이터 예시이다.

통합된 실내 공간의 포인트 클라우드는 촬영 시 발생하는 노이즈가 있어 이를 제거하고 사용한다. 우리는 통합 데이터로부터 바닥면에 해당하는 포인트 클라우드를 추출하고 이를 2차원 바이너리 이미지로 투영 변환한다. 이진화된 바닥 이미지를 [그림 2]를 통해 학습한 CNN 모델을 이용하여 코너를 탐지하고 실내 3차원 공간구조를 추정하였다.

3-2 가상 실내 공간 구축

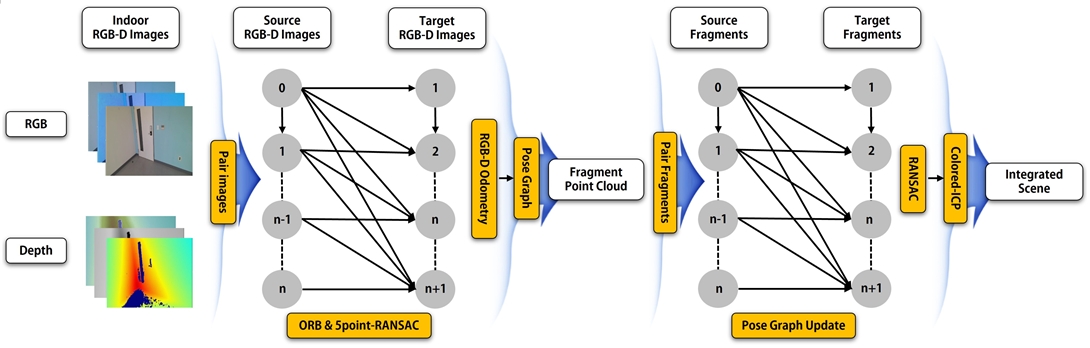

[그림 3]은 Color와 Depth 이미지를 활용하여 가상 실내 공간을 구축하는 과정을 도식화한 것이다. 본 논문에서는 RGB-D 카메라를 통해 추출한 Color와 Depth 이미지 개수 k가 입력으로 주어지면 n개(본 실험에서는 N=100으로 고정)의 프레임 단위로 나눠 m개의 부분 포인트 클라우드를 추출하였다.

Color와 Depth 이미지 쌍의 연속적인 집합에서 n개의 프레임 간의 ORB 특징점 매칭 알고리즘을 수행했다. 이를 통해 연속적인 프레임에서의 특징점을 일치시키고 5-Point RANSAC을 수행하여 대략적인 이전 프레임 사이에 정렬을 추정하였다. 이를 기반으로 RGB-D Odometry를 계산하여 m개의 부분 포인트 클라우드에 대한 카메라 궤적을 추적하고, 다방향 정합을 위한 포즈 그래프를 구축하였다.

Loop Closing과 같은 문제가 발생할 경우 에러가 누적된 모든 노드와 엣지 정보를 통해 에러가 최소화되도록 모든 노드의 위치를 최적화하는 과정을 수행했다. 포즈 그래프 최적화에 대한 손실 함수를 수식 (1)로 표현할 수 있다. xi와xj는 현재 그래프에서 노드의 위치 정보이며, 이를 통해 두 노드 사이의 상대적인 위치를 구할 수 있다.

두 노드 사이의 다음 프레임 노드의 위치 값(관측값)과 이전 프레임 노드의 위치 값(예측값)의 차이를 eij(xi, xj)로 정의한다. Ωij 는 i번째 노드와 j번째 노드의 정보 행렬을 의미하며, 손실 함수의 합을 가장 작게 할 수 있는 노드(x*)의 집합을 추출한다.

| (1) |

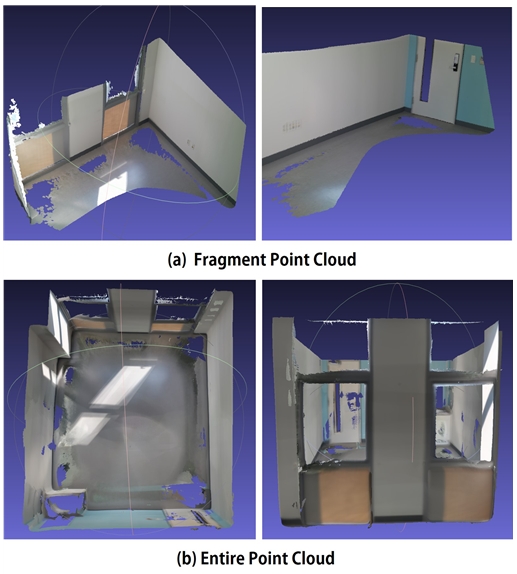

이를 통해 일정한 크기의 복셀과 RGB 정보를 포함한 부분 포인트 클라우드를 추출했다. [그림 4(a)]은 추출 결과를 보여준다. [그림 4(a)]에서 생성한 부분 포인트 클라우드와 포즈 그래프를 기반으로 실내 공간의 전체 포인트 클라우드를 추출하였다. 부분 포인트 클라우드 간의 RGB-D Odometry를 통해 대략적인 정렬을 추정하고, RANSAC(Radom Sample Consensus)알고리즘을 사용하여 전역 공간에 등록하였다.

이를 기반으로 비슷한 색상정보와 위치 정보를 가진 부분 포인트 클라우드를 정합시키고, 연속적인 부분 포인트 클라우드 시퀀스에서 다음 시퀀스 간의 연결 관계를 탐지하여 정합하기 위한 강체 변환을 계산한다. 본 연구에서는 Colored-ICP(Iterative Closest Point) 알고리즘을 사용하여 색상정보를 이용해 포인트 클라우드들 사이의 연결 관계를 정확하고 빠르게 탐지했다[15]. [그림 4(b)]는 부분 포인트 클라우드의 정합을 통해 전체 포인트 클라우드를 추출한 결과이다.

3-3 바닥면 코너 탐지

본 연구에서는 실내 공간 바닥면의 코너를 탐지하여 공간의 구조를 추정한다. 따라서 우리는 실내 공간 전체포인트 클라우드에서 바닥면 포인트 클라우드를 추출하고 이를 Ortho 투영을 통해 2차원 바이너리 이미지로 변환하였다.

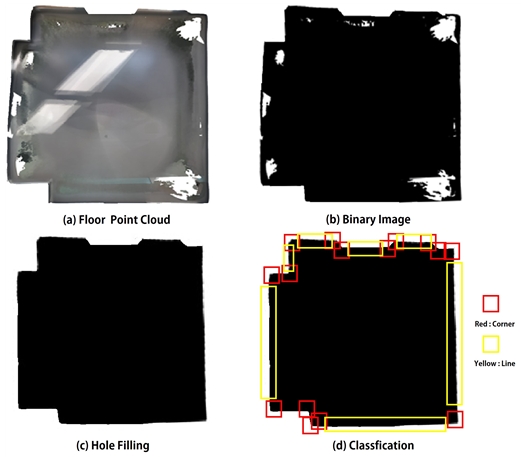

RANSAC 알고리즘을 사용하여 바닥면에 해당하는 포인트 클라우드를 추출하였으며, 이때 발생하는 이상치 값(바닥면에 해당하는 평면이 아닌 경우)을 임곗값 조정을 통해 제거하였다. [그림 5(a)]는 실내 공간 전체포인트 클라우드에서 바닥면을 추출한 결과를 보여준다. [그림 5(b)]는 바닥면 포인트 클라우드를 2차원 바이너리 이미지로 변환 결과를 보여준다. 해당 이미지의 경우 RGB-D 카메라의 노이즈 및 객체에 의한 폐색으로 포인트 클라우드가 소실되어 2차원 바이너리 이미지로 변환하였을 때 픽셀값 또한 소실된다.

Corner Detection Result : Floor Point Cloud, (b) Binary Image, (c) Restored Image, (d) Corner, Line Classification

이를 해결하기 위해 우리는 Hole Filling 알고리즘을 통해 소실되는 영역을 복원하고 이를 CNN 모델을 통해 두 가지 레이블(코너, 선)로 분류했다. [그림 5(c)], [그림 5(d)]는 소실되는 영역을 복원하고, CNN 모델을 통해 코너를 탐지한 결과이다.

Ⅳ. 실험 결과

본 논문에서는 기존의 코너 탐지 알고리즘과 CNN 모델을 활용하여 바닥면의 코너를 탐지한 결과를 비교하였다. 바닥면 포인트 클라우드는 노이즈가 존재하며, 이로 인해 바이너리 이미지로 변환했을 때 이미지의 경계에 해당하는 픽셀값이 불규칙하다. 기존의 코너 탐지 알고리즘(Harris Corner, SIFT 등)은 이미지의 경계에 해당하는 픽셀값 또한 코너로 탐지하여 바닥면의 정확한 코너를 탐지할 수 없다.

이러한 문제를 해결하기 위해 우리는 CNN 모델을 기반으로 노이즈가 있는 바닥면 이미지에서도 정확한 코너를 탐지하여 기존 코너 탐지 알고리즘보다 높은 정확도를 얻었다. CNN 모델을 통해 [그림 2]에서 구축한 바닥면 바이너리 이미지를 학습시켰으며, 학습 환경은 “Intel(R) Core(TM) i7-10,700K CPU @ 3.80GHz 3.79 GHz” 프로세서와 “NVIDIA GeForce RTX 3090” GPU를 사용했다.

[그림 6]은 기존의 코너 탐지 알고리즘과 CNN 모델을 통해 [그림 6(a)]의 코너를 탐지하여 비교한 결과이다. [그림 6(b)], [그림 6(c)]는 Harris Corner, SIFT 알고리즘을 사용했다. 해당 결과 이미지의 경계에 해당하는 불규칙한 픽셀값이 코너로 탐지되는 것을 볼 수 있다. [그림 6(d)]는 CNN 모델을 통해 불규칙한 픽셀에서도 정확한 코너를 탐지한 결과를 보여준다.

Corner Detection Results Comparison: (a) Binary Image, (b) Harris Corner, (c) SIFT, (d) CNN-based Detection

우리는 CNN 모델의 성능을 평가하기 위해서 F1-Score, 정밀도, 재현율 값을 사용했다. F1-Score는 재현율과 정밀도의 조화평균을 뜻하고 수식 (2)로 표현할 수 있다. 이를 통해 추출한 성능 지표는 [표 1]과 같다.

| (2) |

이 세 가지 평가 지표가 높을수록 해당 바닥면의 코너를 정확하게 탐지했음을 의미한다.

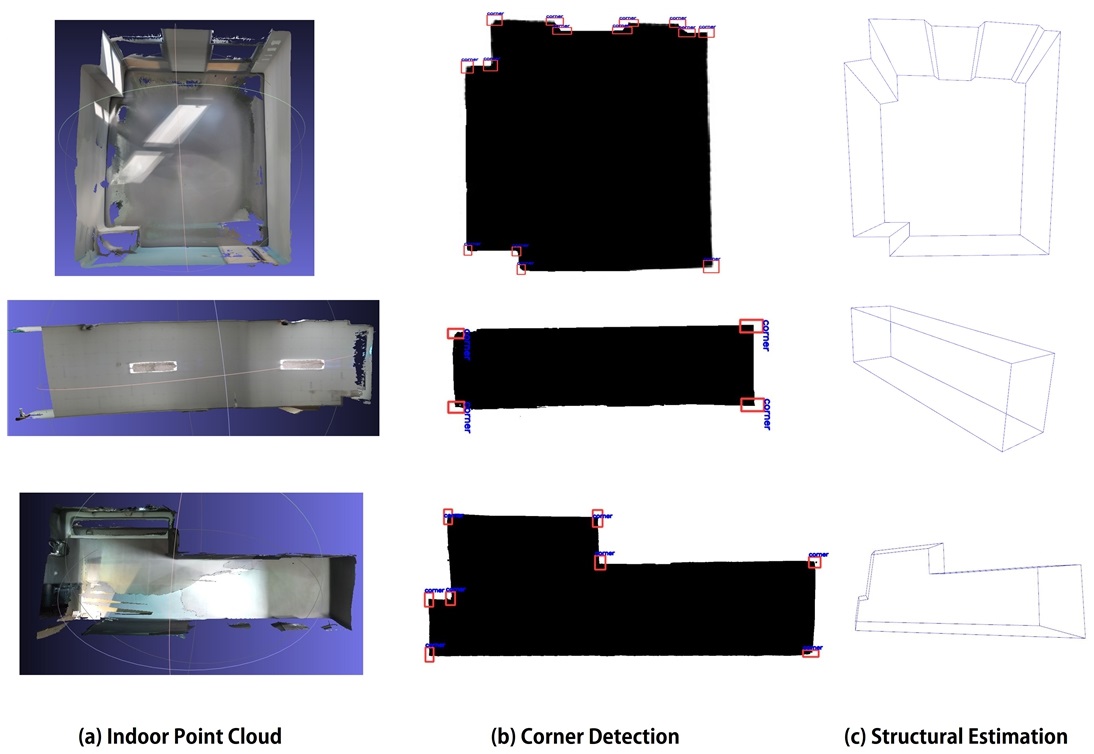

우리의 CNN 모델은 정밀도 90%, 재현율 85%, F1-Score 87%로 바닥면의 코너를 탐지하는 데 있어 높은 분류 성능을 보여준다. [그림 7]은 두 개의 가상 실내 공간을 구축하여 기존의 코너 탐지 알고리즘보다 정확도가 높은 CNN 모델을 기반으로 바닥면의 코너를 탐지하고 최종적으로 공간의 구조를 시각화한 결과이다.

Indoor Space Structure Estimation Results : (a) Indoor Point Cloud, (b) Corner Detection, (c) Structure Estimation

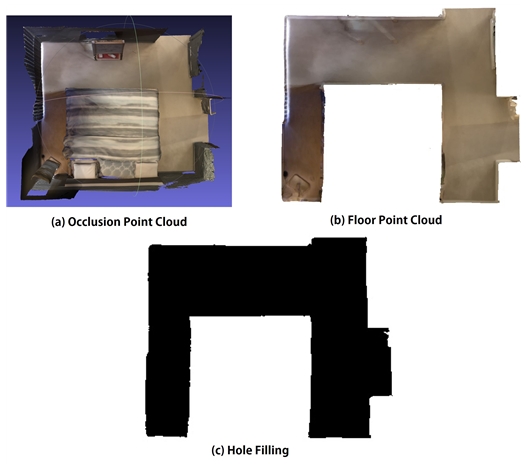

[그림 8]의 경우 본 논문에서의 대표적인 실패 사례를 보여준다. [그림 8(a)]는 포인트 클라우드로 이루어진 실내 공간에서 침대 객체가 바닥면의 경계 부분을 폐색하고 있는 것을 볼 수 있다. 이와 같은 경우 침대 객체 영역에 해당하는 포인트 클라우드가 소실되어 바닥면에 대한 정확한 정보를 얻을 수 없다. [그림 8(b)]는 RANSAC 알고리즘을 통해 바닥면을 추출한 결과를 보여준다. 특히 바닥면의 경계에 해당하는 포인트 클라우드가 소실될 시 이를 바이너리 이미지로 투영 변환을 수행하면 소실된 영역의 픽셀을 복원할 수 없다.

기존의 Hole Filling 알고리즘의 경우 닫혀있는 픽셀 영역에 해당하는 부분만 복원하는 한계점이 존재한다. [그림 8(c)]는 바이너리 이미지로 변환하고 Hole Filling 알고리즘을 수행한 결과이다. 이러한 한계점을 해결하기 위해 소실되는 영역을 탐지하고 이를 복원하는 알고리즘 개발이 필요하다.

Ⅴ. 결 론

본 논문에서는 RGB-D 카메라를 통해 실세계의 실내 공간을 스캔하여 얻은 연속된 Color와 Depth 이미지를 기반으로 3차원 재구성 알고리즘을 사용하여 포인트 클라우드로 이루어진 가상 실내 공간을 구축하였다. 우리는 실내 공간의 바닥면 데이터를 추출하고, 코너 정보를 통해 공간의 구조를 추정했다. 평면도 바이너리 이미지를 두 가지 레이블(코너, 선)로 분류하고, CNN 모델을 통해 학습시켰다. 실내 공간의 바닥면 포인트 클라우드를 바이너리 이미지로 투영 변환하고, 소실되는 영역을 복원하고 CNN 모델을 기반으로 복원된 이미지의 코너를 탐지하였다.

우리의 결과는 노이즈에 민감한 기존의 코너 탐지 알고리즘보다 높은 정확도를 얻었으며, 코너로 인식된 바운딩 박스의 중심 좌표 기준으로 수직 벽을 세워 실내 공간 구조를 시각화하였다. 실세계와 유사한 메타버스 공간을 모델링하기 위한 기존의 방식들은 시간 및 많은 비용이 소모되는 문제점이 존재한다. 위와 같은 문제를 해결하기 위해 본 연구에서는 실내 공간의 구조를 추정하여 이를 기반으로 모델링하는 방법을 제안했으며, 실세계와 유사한 메타버스 공간을 모델링 하는 데 있어 사용자의 편의성이 커질 것이라 예상된다.

하지만 본 연구에서는 바닥면의 가장자리 부분을 폐색하는 객체가 존재하지 않는 실내 공간에서 테스트를 진행하였으며, 객체가 바닥면의 가장자리를 폐색할 경우 정확한 실내 공간의 구조를 추정하기가 어렵다. 기존의 Hole Filling 알고리즘은 닫힌 영역에 해당하는 픽셀만 복원이 가능하다는 문제점이 존재하며, 객체를 제거했을 때 생기는 소실되는 포인트 클라우드 영역을 탐지하고 이를 복원하는 연구가 필요하다.

향후 3D 객체 인식 딥러닝 모델을 통해 실내 공간에 존재하는 객체 포인트 클라우드를 인식 및 제거하고, 소실되는 영역을 탐지한 뒤 GAN을 활용하여 이를 복원하는 연구를 진행할 것이다. 향후 연구를 통해 강건하게 공간의 구조를 추정할 수 있는 모델을 개발할 수 있으며, 메타버스 공간을 제작하는 데 적극적으로 활용될 수 있다.

Acknowledgments

이 논문은 2020년도 정부(과학기술정보통신부)의 재원으로 정보통신기획평가원의 지원과 (No.2020000103, 가상공간구성을 위한 5G 기반 3D 공간 스캔 디바이스 기술 개발, 기여율 : 50%) 문화체육관광부 및 한국콘텐츠진흥원의 2021년 문화콘텐츠 R&D 전문인력 양성(문화기술 선도 대학원) 사업으로 수행되었음 (과제명 : 버추얼 프로덕션 기반 콘텐츠 제작 기술 R&D 전문인력 양성, 과제번호 : R2021040044, 기여율 : 50%)

References

-

Y. Furukawa, B. Curless, S. M. Seitz and R. Szeliski, “Reconstructing building interiors from images,” 2009 IEEE 12th International Conference on Computer Vision, Japan: Kyoto, pp. 80-87, 2010.

[https://doi.org/10.1109/ICCV.2009.5459145]

-

Henry P, Krainin M, Herbst E, Ren X, Fox D, “RGB-D mapping: Using Kinect-style depth cameras for dense 3D modeling of indoor environments,” The International Journal of Robotics Research, Vol. 31, No. 5, pp. 647-663, 2012.

[https://doi.org/10.1177/0278364911434148]

-

Xiao, Jianxiong, and Yasutaka Furukawa, “Reconstructing the world’s museums,” International journal of computer vision, Vol. 110, No. 3, pp. 243-258, 2014.

[https://doi.org/10.1007/s11263-014-0711-y]

-

T. Jin, J. Zhuang, J. Xiao, K. Song, Y. Cui and S. Lao, “High precision indoor model contour extraction algorithm based on geometric information,” 2021 IEEE 3rd International Conference on Frontiers Technology of Information and Computer (ICFTIC), USA: Greenville, pp. 188-193, 2021

[https://doi.org/10.1109/ICFTIC54370.2021.9647159]

-

Stekovic, S., Rad, M., Fraundorfer, F., & Lepetit, V., “Montefloor: Extending mcts for reconstructing accurate large-scale floor plans,” In Proceedings of the IEEE/CVF International Conference on Computer Vision, pp. 16034-16043, 2021

[https://doi.org/10.1109/ICCV48922.2021.01573]

-

Sungjoon Choi, Q. -Y. Zhou and V. Koltun, “Robust reconstruction of indoor scenes,” 2015 IEEE Conference on Computer Vision and Pattern Recognition, USA: Boston, pp. 5556-5565, 2015.

[https://doi.org/10.1109/CVPR.2015.7299195]

-

Harris, Chris, and Mike Stephens, “A combined corner and edge detector,” Proceedings of the Alvey Vision Conference, UK: Manchester, pp. 147-152, 1988.

[https://doi.org/10.5244/C.2.23]

-

Lowe DG, “Distinctive Image Features from Scale-Invariant Keypoints,” International Journal of Computer Vision, Vol. 60, No. 2, pp. 91-110, 2004.

[https://doi.org/10.1023/B:VISI.0000029664.99615.94]

-

Schnabel R, Wahl R, Klein R, “Efficient RANSAC for point‐cloud shape detection,” Computer graphics forum, Vol. 26, No. 2, pp. 214-226, 2007.

[https://doi.org/10.1111/j.1467-8659.2007.01016.x]

-

Cai R, Li H, Xie J, Jin X, “Accurate floorplan reconstruction using geometric priors”, Computers & Graphics, Vol. 102, No. 2, pp. 360-369, 2022.

[https://doi.org/10.1016/j.cag.2021.10.011]

- E. Turner and A. Zakhor, “Floor plan generation and room labeling of indoor environments from laser range data,” 2014 International Conference on Computer Graphics Theory and Applications, Portugal: Lisbon, pp. 1-12, 2014.

-

Nikoohemat, S., Diakité, A. A., Zlatanova, S., & Vosselman, G., “Indoor 3D reconstruction from point clouds for optimal routing in complex buildings to support disaster management,” Automation in construction, Vol. 113, No. 4, pp. 103109, 2020.

[https://doi.org/10.1016/j.autcon.2020.103109]

-

Tran, Ha, and Kourosh Khoshelham, “Procedural reconstruction of 3D indoor models from lidar data using reversible jump Markov Chain Monte Carlo,” Remote Sensing, Vol. 12, No. 5, pp. 838, 2020

[https://doi.org/10.3390/rs12050838]

-

Fang, Hao, Florent Lafarge, Cihui Pan, and Hui Huang, “Floorplan generation from 3D point clouds: A space partitioning approach,” ISPRS Journal of Photogrammetry and Remote Sensing, Vol. 175, No. 5, pp. 44-55, 2021.

[https://doi.org/10.1016/j.isprsjprs.2021.02.012]

-

J. Park, Q. -Y. Zhou and V. Koltun, “Colored Point Cloud Registration Revisited,” 2017 IEEE International Conference on Computer Vision, Italy: Venice, pp. 143-152, 2017.

[https://doi.org/10.1109/ICCV.2017.25]

저자소개

2014년 : 성결대학교 미디어소프트웨어학과 (공학사)

2014년~현 재: 중앙대학교 첨단영상대학원 영상학과 석사과정

※관심분야 : 3차원 재구성(3D Reconstruction), XR(Exten ded Reality), 딥러닝(Deep Learning), 머신러닝(Machine Learning), 등

2002년 : 중앙대학교 기계설계학과 학사

2004년 : 중앙대학교 첨단영상대학원 컴퓨터 특수효과 영상 석사

2012년 : 중앙대학교 첨단영상대학원 예술공학 박사

2012년 2월~2018년 11월: 덱스터 스튜디오 디지털 휴먼 & VR 연구소장

2019년 3월~현 재: 중앙대학교 예술공학대학 부교수

※관심분야 : 가상존재(Virtual Beings), 확장현실(eXtended Reality,특수효과(VFX), 실감미디어(Immersive Media)

1998년 : 중앙대학교 컴퓨터공학과 학사

2000년 : 중앙대학교 첨단영상대학원 영상공학과 영상공학석사

2010년 : 중앙대학교 첨단영상대학원 영상공학과 영상공학박사

2011년~2013년: 프랑스 리옹 1대학, LIRIS 연구소, Post-Doc

2013년~2016년: 한국전자통신연구원, 선임연구원

2016년~2019년: 성결대학교 미디어소프트웨어학부 조교수

2019년~현 재: 중앙대학교 예술공학대학 컴퓨터예술학부 부교수

※관심분야:컴퓨터그래픽스(Computer Graphics), 비사실적렌더링(Non-Photorealistic Rendering), 가상/증강현실(Virtucal Reality/Augmented Reality),게임 기술(Game Technology)