인공지능에 기반한 저시력인을 위한 음성 지원 앱의 개발

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

스마트폰은 시각장애인들에게 단순한 통신수단으로서의 의미를 넘어 신체적 제약을 극복할 수 있는 유용한 도구로 인식되고 있다. 터치스크린 기반의 스마트폰이 시각장애인에게 이와 같은 의미가 된 것은 최근 급격히 발전한 인공지능 기술 덕분이라고 할 수 있다. 본 연구에서는 시각장애인, 특히 저시력인에게 온라인 및 오프라인 정보 접근성을 제공하기 위한 앱 솔루션을 제안한다. 모든 서비스의 구동과 결과 전달 인터페이스는 음성기반이며 사전 및 지식 검색이 가능하고 주변 물체를 파악하여 알려주는 이미지 캡셔닝 기능과 작은 글씨를 읽어 주는 OCR 기능 등을 탑재한다. 실시간 검색 순위 정보를 전할 때, 그에 대한 네티즌의 반응도 함께 전달한다. 이 앱은 저시력인 뿐 아니라 시력이 약한 노인분들과 안과 질환에서 회복 중인 환자 등에게도 활용될 수 있다.

Abstract

Smartphones are perceived as a useful tool for people who are blind to overcome physical constraints beyond their meaning as a simple means of communication. Touchscreen-based smartphones have become such a meaning thanks to artificial intelligence technologies which have recently developed rapidly. In this study, we propose an application solution for providing online and offline information access to the visually impaired, especially those with low vision. The interface for driving all services and delivering results is voice-based, with dictionaries and knowledge retrieval, image captioning to identify nearby objects, and OCR to read small text. When delivering real-time search ranking information, netizens respond to it as well. This app can be used not only for low vision but also for elderly people who have low vision and patients recovering from eye diseases.

Keywords:

AI based Apps, Apps for Low Vision People, Image Captioning, Sentimental Analysis, Web Crawling키워드:

인공지능 기반 앱, 저시력인용 앱, 이미지 캡셔닝, 감성 분석, 웹 크롤링Ⅰ. 서 론

보건복지부 2018년 12월 31자 통계에 따르면 등록된 시각장애인 25만명이 넘으며, 이중 70-80%가 사물을 조금 구별할 정도의 저시력인이라고 한다. 시력 장애를 가진 사람들이 스마트폰을 이용하는 것에는 매우 어려움이 있음에도 오히려 신체 기능의 보조뿐 아니라 이동 장애의 극복으로 그들의 네트워크 형성에 도움을 주는 등, 이들에게는 스마트폰이 통신수단 그 이상의 의미라는 연구 결과들이 있다 [1][2]. 저시력인의 경우에는 약간의 도움으로 충분히 주변 정보를 알 수 있으므로 이들을 위한 애플리케이션은 완전히 앞을 보지 못하는 시력장애인을 위한 애플리케이션과는 차별화된 목적을 갖는다. 본 연구에서는 저시력인에게 온라인 및 오프라인 정보 접근성을 제공하기 위한 앱 솔루션을 제안한다. 기본적으로 모든 응용의 구동은 음성으로 가능하고 결과도 음성으로 전달받는다. 온라인 정보는 인공지능 기반 뉴스 검색, 정보 및 지식 검색이 가능하며 오프라인 정보로는 주변 사물에 대해 파악하여 알려주는 기능과 작은 글씨의 설명 등을 읽어 주는 기능을 제공한다.

인공지능 기술의 발전은 시각장애인을 위한 시스템 개발의 패러다임에 큰 변화를 가져왔다. 불과 몇 년 전까지만 해도 시각장애인을 위한 서비스가 가능하기 위해서는 별도의 장비나 조치가 필요했다. 보행을 위해 점자 보도블록이 필요하고, 시각장애인의 효과적인 보행을 지원할 수 있는 길안내 지도의 구성을 시각장애인의 특징을 분석하여 따로 만들어야 하고 [3], 도서관 공공시설 등의 이용을 위해서는 휴대폰에 NFC를 장착하고 이를 지원하는 서비스가 제공되어야 하며 [4] 점자 서비스가 제공되지 않으면 텍스트를 읽을 수 없었다. 시각장애인을 위한 컴퓨터 기술이 상용화될 만큼 발전하지 못했던 주된 원인 중의 하나는 이미지를 인식하고 이해하는 인공지능 기술의 한계였다고 할 수 있는데, 딥러닝의 등장으로 이 분야의 획기적인 발전을 맞이하면서 시각장애인을 위한 애플리케이션이 다수 등장하게 된 것이다. 최근 소개되는 시각장애인용 애플리케이션들은 기존의 시각장애인 지원 방식과는 달리 단지 눈의 역할을 대신할 수 있는 소프트웨어를 이용하는 방식으로 일반인과 동일한 수준의 서비스를 제공한다. 본 연구에서도 이미지 캡셔닝, 자연언어, 감성 분석 등의 인공지능 기술들을 활용하여 저시력 장애인을 위한 다양한 서비스를 제공하는 앱을 구현한다. 또한 웹과도 연동하여 일반 컴퓨터를 사용한 프로파일까지 포함한 사용자 맞춤형 서비스가 제공될 수 있도록 제안한다.

본 논문의 구성은 다음과 같다. 2장에서는 본 연구와 관련된 기존 문헌과 자료들을 살펴보고, 3장에서는 저시력인을 위한 음성 지원 시스템의 개요와 구성 요소 각 부분의 기능을 설명한다. 4장에서는 해당 시스템의 실제 구현과 테스트 결과를 보여주며 5장에서는 결론과 기대 효과 및 향후 과제로 논문을 마무리한다.

Ⅱ. 관련 연구

스마트폰의 선두 주자인 애플은 2007년 1월 아이폰을 출시한 지 6개월 만에 VoiceOver라는 기능을 운영체제에 탑재하여 시각장애인들도 스마트폰을 사용할 수 있는 길을 열어 놓는다 [5]. 안드로이드 폰의 TalkBack과도 같은 기능의 VoiceOver는 주로 텍스트를 읽어 주는 음성 서비스이며 이미지에 대한 기능은 갖추고 있지 않다. 주변 환경과 물체를 인식하여 알려 주는 서비스를 위해 “Be my eyes”라는 앱은 시각장애인이 도움이 필요할 때 바로 가입된 자원봉사자와 화상통화를 연결시켜주는 단순한 서비스를 제공하며 이와 유사한 기능을 하는 한글 버전으로는 서울시에서 추진한 엔젤아이즈라는 앱이 있는데 취지에 공감한 자원봉사자의 수는 백만 명에 이르지만 정작 수혜자가 되어야 할 시각장애인들은 불편을 호소하고 있다 [6]. 가장 큰 이유는 장애인을 위한 접근성 배려 부족을 들고 있다. 정작 회원가입을 위해서 거쳐야 하는 절차조차 이메일 인증이라던가, 마이크 및 카메라 접근 권한 설정 등 시각장애인들이 하기에 간단치 않다는 문제점이 있다. 이 서비스들은 최근 개발된 인공지능 기술들을 백분 활용하고 있지 못한 반면, 인공지능 기술들을 활용한 서비스들이 선보이고 있다.

구글 룩아웃은 사용자 주변 사물이나 글자 등을 소리로 알려주는 앱이다. 스마트폰 카메라를 사용자가 목걸이로 착용하거나 셔츠 앞에 달고 다니면 사물을 인식해서 음성을 통해 정보를 알려 준다. 책을 읽어 주거나 요리 레시피를 음성으로 안내해 주기도 하며 휠체어로만 이동할 수 있는 장소인지 파악하는 기능도 제공된다. 꾸준한 딥러닝 학습을 통해 구현된 기술이다[7].

릴루미노는 저시력 장애인들의 TV 시청과 영화감상, 개인용 컴퓨터 및 스마트폰 사용 등에 도움을 주기 위해 삼성에서 개발한 앱이다. 특히 이 앱은 삼성의 기어VR과 연동하여 사용하도록 되어 있으며 이 기능이 탑재된 시력 보조기구도 개발 중이라고 알려져 있다[8]. LG유플러스가 시각장애인 음성안내 앱 '설리번+'는 시각장애인의 정보 접근성을 향상하기 위해 만들어졌다. 인공지능(AI) 기술을 활용한 음성안내 앱으로 스마트폰의 카메라를 통해 인식한 정보를 이용자에게 알려준다. 시각 정보를 정확히 제공하기 위해 인식된 이미지와 주요 단어 사이의 관계를 파악해서 문장을 만들어 주는 이미지 캡셔닝 기술이 적용됐다 [9]. 불과 몇 년 전에 개발된 앱들이 수요자의 외면을 받던 것과는 달리, 인공지능 기술을 탑재한 최근 서비스들은 유용성을 인정받으며 이용률이 빠르게 확대되고 있다 [10]. 이들의 가장 기본적인 서비스는 텍스트를 읽어 주는 문자 인식, 얼굴 인식, 주변 물체를 모사해 주는 이미지 캡셔닝 등이 있으며 최근에는 특정 서비스로의 확대로 시도되고 있다 [11].

본 논문에서는 저시력인들을 위한 기본적인 기능인 STT, TTS 등의 음성 지원, 이미지 캡셔닝, OCR 이외에 웹과 연동하여 사용자 프로파일을 학습하여 사용자에 맞는 뉴스 등의 검색 결과를 읽어 주는 기능을 제안하고 이들 기능을 편리하게 사용하기 위한 간편한 UI 방법을 제안한다. 또한 검색한 정보들에 대한 감성 분석 결과 기능을 추가하여 검색 한 번에 충분한 정보를 획득할 수 있도록 기능을 차별화하였다.

Ⅲ. 저시력인을 위한 음성지원 앱

3-1 시스템 개요

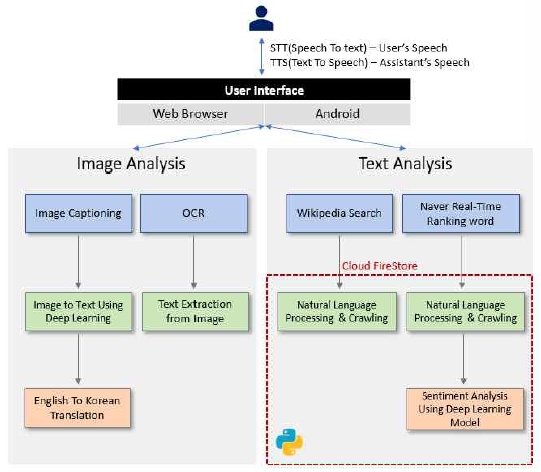

전체 시스템의 구성도는 그림 1과 같다. 시각이 불편한 사용자를 도와주는 앱으로 음성을 기반으로 상호작용을 할 수 있도록 음성인식 기술 STT(Speech To Text)과 텍스트를 음성으로 바꾸는 TTS(Text To Speech)기술을 사용한다. 사용자의 특정 발화로 카메라를 구동하여 주변 환경 이미지를 텍스트화하거나 검색어에 대한 결과를 안내하는 서비스를 제공하고 모든 서비스는 음성이나 간단한 터치 동작만으로 상호 작용할 수 있다.

이미지 검색 서비스는 2가지 기능이 있다. 첫 번째는 사용자가 ‘이게 뭐야?’라고 발화(發話)하면, 이미지를 분석하여 텍스트화하고 영어 텍스트를 한국어 번역을 통해 한국어 결과로 변경한 텍스트 반환한다. 두 번째는 사용자가 ‘글자 읽어줘’라고 발화하면 이미지 내의 텍스트를 인식하여 OCR(Optical Character Recognition) 기능을 이용해 문자열 추출 후 텍스트를 반환 후 사용자에게 안내한다.

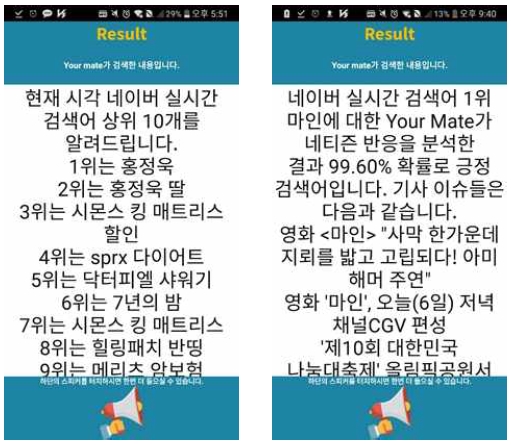

텍스트 검색 서비스일 경우 3가지 기능이 있다. 사용자가 ‘ㅇㅇ 검색해 줘’라고 이야기한다면, 문장의 명사를 추출한 뒤 첫 번째로 추출된 명사로 정보 검색을 진행한다. 위키피디아 백과사전 사이트에서 추출된 명사의 정보 검색 결과를 크롤링하여 텍스트를 반환한다. 또는 사용자가 ‘실시간’이라고 이야기한다면, 네이버 실시간 순위를 1위부터 10위까지 크롤링하여 반환된 결과를 사용자에게 안내한다. 또한 사용자가 ‘실시간 ㅇ위’라고 이야기한다면, 해당 키워드에 대한 뉴스 기사 헤드라인과 네티즌 실시간 반응을 크롤링하여 반응이 긍정인지 부정인지 감성분석한 결과를 받아 텍스트로 반환한다. 반환된 모든 텍스트 결과들은 텍스트를 음성으로 바꾸는 TTS 기술로 음성 전환하여 사용자에게 알려준다.

3-2 이미지 분석

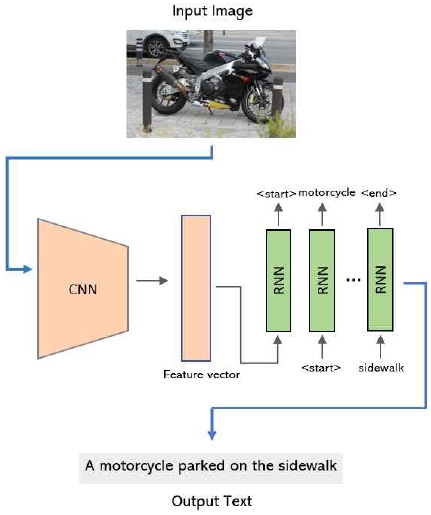

이미지 분석 기능으로는 이미지 캡셔닝과 OCR 기능을 제공한다. 이미지 캡셔닝(Image Captioning)은 이미지의 캡션을 달아주는 일, 즉 이미지를 보고 어떤 이미지인지 언어로 설명하는 작업이다. 이미지 분류를 목적으로 사전 훈련된 CNN의 마지막 은닉층 단(last hidden layer)을 RNN 계열 모델의 입력으로 연결하여 인코더-디코더 방식으로 문장을 만들어내는 형식의 구조이다 (그림 2)[15]. 본 연구에서는 해당 구조로 개발된 Microsoft Azure Computer Vision API를 사용하여 해당 기능을 수행한다.

이미지 캡셔닝 접근방식은 크게 ‘하향식(Top-Down Approach)’과 ‘상향식(Bottom-Up Approach)’으로 구분된다. 하향식 접근방식에서는 이미지를 통째로 시스템에 통과시켜서 얻은 ‘요점’을 언어로 변환하는 반면 상향식 접근방식에서는 이미지의 다양한 부분들로부터 단어들을 도출해내고, 이를 결합하여 문장을 얻어낸다. 현재 가장 많이 쓰이고 있는 접근방식은 하향식인데, 그 이유는 Recurrent Neural Network(RNN)를 이용하여 각 매개변수를 훈련 데이터로부터 학습시킬 수 있으며, 이 방식의 성능이 가장 좋다고 평가받기 때문이다. 하지만, 이러한 하향식 접근방식의 단점은 이미지의 세세한 부분들에 집중하는 것이 상대적으로 어렵다는 점이다. 반면 상향식 접근방식은 이미지의 모든 부분으로부터 하나씩 뽑아낸 단어들을 조합하기 때문에 세부에까지 신경을 써줄 수 있다[15]. 본 연구에서는 이미지 캡셔닝의 목적이 사용자에게 안내하기 위한 것이므로 사진의 세세한 부분까지 분석하는 것이 중요하여 상향식 접근방식이 기본이 된 Microsoft Azure Computer Vision API를 사용하여 해당 기능을 수행한다.

OCR(Optical Character Recognition)은 광학 문자 인식이라는 뜻이다. 사람이 쓰거나 기계로 인쇄한 문자를 이미지 스캐너로 획득하여 기계가 읽을 수 있는 문자로 변환하는 것이다. 이미지 스캔으로 얻을 수 있는 문서의 활자 영상을 컴퓨터가 편집 가능한 문자 코드 등의 형식으로 변환하는 소프트웨어로써 다음과 같이 동작한다. 우선 입력 이미지의 특징점을 추출하고 그 특징점을 데이터베이스 검색을 통해 특징점이 비슷한 문자들과의 템플레이트 매칭 기법을 사용하여 저장된 이미지와 특징점과의 오차가 가장 적은 문자를 선택하게 된다. 본 연구에서는 Google Vision API를 사용하여 OCR 기능 구현 환경을 구축하였는데 1. 텍스트를 포함한 이미지를 클라우드 스토리지에 업로드하고, (이때 이미지에 포함된 텍스트는 어떤 언어이든 상관없다) 2. Vision API를 이용하여 텍스트를 추출하고, 3. Translation API로 텍스트를 번역하여, 4. 번역된 텍스트를 클라우드 스토리지에 저장한다.

3-3 자연어 처리 및 분석

텍스트 분석 요청은 위키백과와 네이버를 이용하였으며 사용자가 요구한 송수신을 하기 위해 'Cloud Fire Store'라는 실시간 데이터베이스를 사용하였다. 사용자 측에서 요청이 들어오면, Firebase의 Cloud Fire Store에 요청한 명령을 담는 필드와 요청 여부를 담는 필드 값이 변경된다. Cloud Fire Store 리스너가 실행되고 있던 서버가 상태 변화를 감지하고 해당 요청을 수행하여 결과 필드에 결과 텍스트를 담는다. 안드로이드 측 리스너가 결과 필드의 값이 바뀜을 감지하고 결과 필드의 값을 가져와 텍스트를 출력하는 흐름이다.

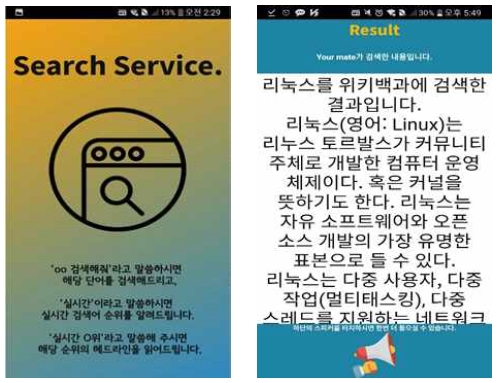

사용자가 시작 화면에서 ‘Search Service’ 탭을 클릭하거나 ‘검색’이라고 이야기하면 자동으로 검색 화면이 열리면서 웹 데이터 크롤링 기능이 준비된다. 크롤링을 위해서 Python BeautifulSoup 라이브러리를 이용한다. BeautifulSoup 라이브러리는 HTML과 XML 문서로부터 다양한 형식의 데이터 필드를 추출해 주는 파이썬 라이브러리로 간단한 코드로 정확성과 속도를 보장한다. ‘ㅇㅇ검색해줘’라고 발화하면 문장의 명사를 추출한 뒤 첫 번째로 추출된 명사를 검색어로 하고 검색어에 대한 정보를 위키피디아에서 BeautifulSoup 라이브러리를 이용하여 크롤링한다. 크롤링한 내용을 데이터베이스에서 가져와 사용자에게 전달하고 음성으로 안내한다.

검색 화면에서 사용자가 ‘실시간’이라고 이야기하면 실시간 검색어 1위부터 10위까지의 내용을 크롤링한 후 데이터베이스에 저장하고 그 내용을 사용자에게 음성으로 안내한다.

만약 ‘실시간 ㅇ위’라고 이야기하면 해당 실시간 검색 키워드에 대한 머리기사 3개와 네티즌 반응을 감성 분석을 통해 키워드에 대한 네티즌 반응을 긍정/부정으로 추가로 안내한다. 실시간 검색 순위는 네이버를 이용하였으며 네이버 실시간 검색어 키워드에 대한 ‘실시간 검색’ 탭에서 인기 글을 수집하여 학습된 모델의 입력으로 넣고 출력으로 긍정/부정의 확률을 가져왔다.

감성 분석이란 어떤 주제에 대한 주관적인 인상, 감정, 태도, 개인의 의견을 텍스트로부터 뽑아내는 분석을 말한다. 본 연구에서는 ‘Never sentiment movie corpus’ 데이터(총 30만개의 영화 리뷰 데이터)[12]로 Python의 KoNLPy라이브러리[13]를 이용해서 형태소 분석 및 품사 태깅을 진행하고 알파벳과 공백은 제거하는 등 데이터 전처리 과정을 거쳤다. 후에 3개의 은닉층을 가지는 다층 퍼셉트론 모델을 이용하여 지도 학습으로 긍정/부정 분류를 진행하였다.

Ⅳ. 시스템 구현 및 테스트

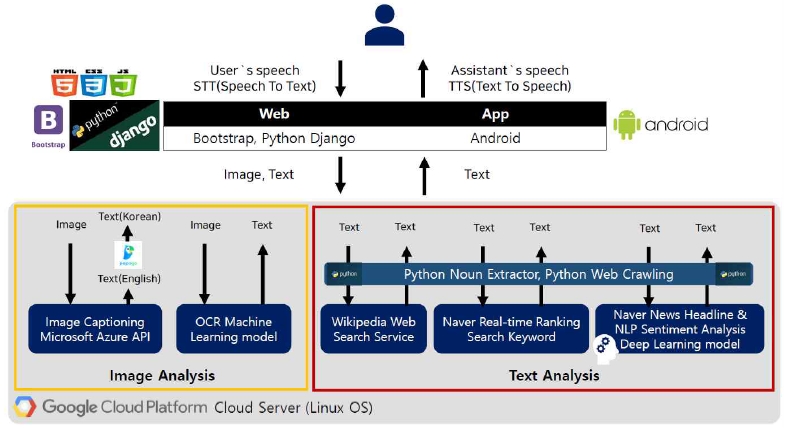

‘Your mate!’라는 이름으로 구현된 시스템은 앞 장에서 설명한 바와 같이 크게 이미지와 텍스트 처리 부분으로 나뉘며 안드로이드 애플리케이션과 웹을 통해 이용할 수 있다. 그림 3은 그 세부 구현 방법을 한눈에 보여준다. 시스템이 시작되면 사용자의 음성을 텍스트로 바꿔주어 특정 발화인지 확인 후 카메라 구동하거나 웹 검색을 한다. 클라우드 서버(Google Cloud Platform(GCP) Linux 환경)로 이미지 혹은 텍스트 전송 후, 각 요구사항에 맞는 알고리즘 적용 후 클라이언트로 결과 전송한다.

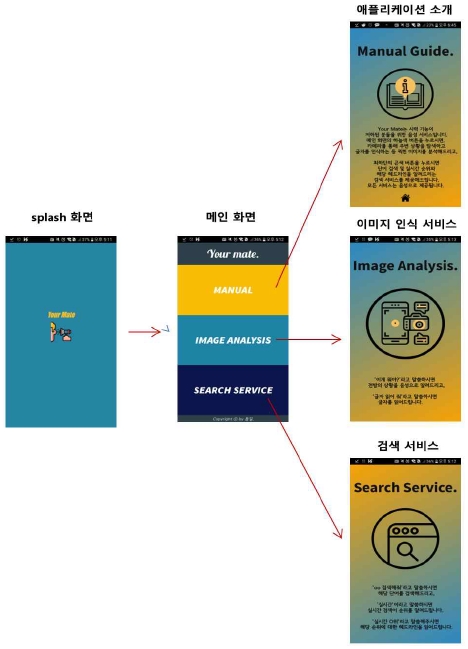

앱을 실행하면 스플래시 화면이 끝나고 그림 4와 같이 메인 화면에서 3가지 서비스 메뉴가 나타난다. 앱의 사용자 인터페이스는 저시력 장애인을 위해 3가지 인터페이스 방식을 제공한다: 터치스크린, 음성인식, 세이킹(shaking). 우선 메인 화면에서는 특정 단어를 발화하거나 버튼을 터치하여 원하는 서비스로 이동할 수 있으며 모든 상태에서 셰이킹을 하면 홈으로 돌아간다. 터치 인터페이스는 저시력인에게 적합하다고 알려진 강한 대비(contrast)의 큰 탭을 이용하였다 [14]. 메인 메뉴는 세 가지로 구성되었다. 앱의 사용법을 안내해 주는 Manual 탭(‘사용법’이라고 발화), 이미지 관련 서비스를 시작하는 Image Analysis 탭(‘이미지인식’이라고 발화), Search Service 탭(‘검색’이라고 발화) 이며 터치나 해당 단어의 발화로 그림 4와 같이 3가지 화면으로 이동한다.

사용자가 사용법을 알고 싶을 땐 ‘사용법’이라고 발화하거나 최상단의 Manual의 탭을 클릭하면 음성으로 애플리케이션의 소개 및 사용법을 알려준다. Shacking 하거나 하단의 홈버튼을 누르면 다시 메인 화면으로 돌아간다.

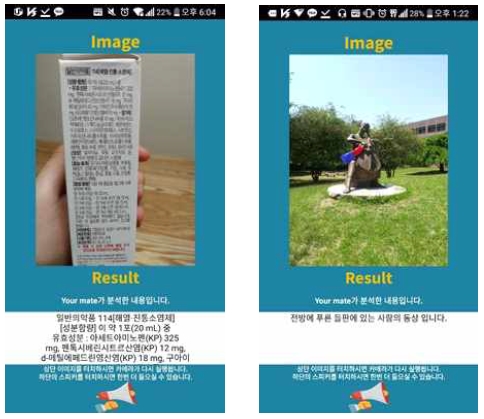

사용자가 이미지 인식(Image Captioning 또는 OCR) 기능을 이용하고 싶을 땐 ‘Image Analysis’ 탭을 클릭하거나 ‘이미지 인식’을 발화하면 이미지 인식 화면으로 이동한다. 여기서 사용자가 ‘글자 읽어줘’라고 발화하면 카메라가 자동 실행되며 그림 5와 같이 OCR 기능이 작동된다. 촬영된 사진에서 글자를 디지털 데이터로 변환하여 사용자에게 다시 음성으로 안내해 준다. 커스텀 카메라를 이용해 자동 초점을 기본적으로 설정하고 화면을 아무 곳이나 터치를 해도 사진이 찍히도록 구현하였기 때문에 시력 기능이 저하된 사용자가 쉽게 사용할 수 있다.

사용자가 이미지 인식 화면에서 ‘이게 뭐야?’라고 이야기하면 촬영된 사진의 특징을 분석하여 전방의 상황을 문장으로 생성하는 이미지 캡셔닝 기능을 수행한다.

이미지 분석을 바탕으로 영어로 생성된 문장을 네이버 Papago API를 이용하여 한국어로 번역하여 사용자에게 음성으로 안내해 줌으로써 주변 환경에 대한 정보를 제공한다. 중앙의 이미지를 누르면 다시 카메라 화면으로 이동하고, 하단의 확성기 버튼을 누르면 다시 문장을 읽어 준다. 셰이킹하면 초기화면으로 이동한다.

사용자가 메인 화면에서 ‘검색’이라고 발화하거나 최하단의 Search Service 탭을 클릭하면 그림 6 왼쪽의 검색 서비스를 제공하는 페이지로 이동한다. 여기서 사용자가 ‘ㅇㅇ검색해줘’, ‘실시간’, ‘실시간 ᄋ위’라고 발화시 각각 다른 정보를 제공하게 된다. 크롤링은 Python으로 진행하였고 Request와 BeautifulSoup 라이브러리를 이용하였다.

‘ㅇㅇ검색해줘’라고 발화 시, 해당 검색어에 대한 위키백과의 검색 결과를 그림 6 우측 그림과 같이 제공하고 음성으로 읽어 준다. ‘실시간’ 발화 시, 그림 7 좌측 그림과 같이 네이버 실시간 검색어 10위까지의 정보를 제공한다. ‘실시간 ᄋ위’라고 발화시, 그림 7 우측 그림과 같이 해당 순위에 대한 머리기사 3개와 네티즌 감성분석(실시간 반응이 있을 경우) 결과를 텍스트와 음성으로 안내한다.

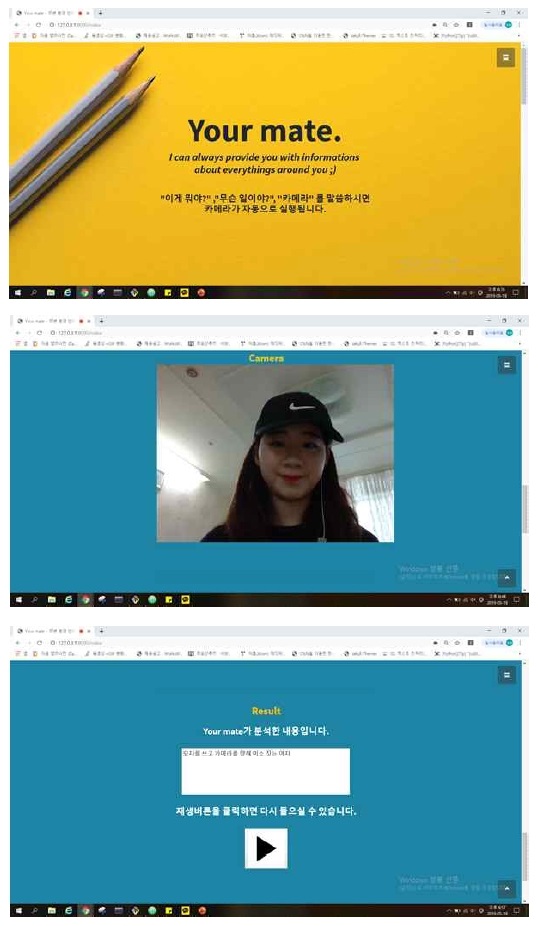

그림 8은 웹 버전의 서비스 예시로 홈페이지 모습과 모자 쓴 학생 이미지에 대해 이미지 캡셔닝이 실행된 결과를 보여준다. 웹에서도 앱의 경우와 같은 서비스가 제공될 수 있으며 사용자에 대한 데이터를 효과적으로 수집하여 사용자 맞춤형 서비스를 제공할 수 있도록 한다.

Ⅴ. 결론

본 연구에서는 저시력인의 정보 접근을 위한 앱 솔루션을 개발하였다. 기본적으로 STT, TTS 등의 음성 지원, 정보 및 지식 검색, 주변 사물에 대해 파악하여 알려주는 이미지 캡셔닝 기능, 작은 글씨의 설명 등을 읽어 주는 OCR 기능 등 시각장애인을 위한 앱이 갖는 기능들 이외에 본 연구에서는 딥러닝을 이용한 감성분석을 활용한 서비스를 제안하였다. 사용자가 검색한 결과에 대한 네티즌들의 실시간 반응을 감성분석하여 검색 결과와 함께 읽어 주는 기능으로 정보 접근성의 어려움을 보완해 줄 수 있도록 하였다. 저시력인을 위해 터치스크린, 음성인식, 세이킹 등의 3가지 인터페이스 방식을 제공하여 앱 사용의 편의를 도모하였으며 이는 저시력인 뿐 아니라 시력이 약한 노인분들과 안과 질환에서 회복 중인 환자도 사용할 수 있어 그 응용 범위가 넓다고 하겠다.

현재는 일반 네티즌의 반응에 대한 감성을 분석한 결과를 이용하지만 앞으로는 웹과 연동하여 사용자 프로파일을 학습하면 사용자 맞춤형 검색 결과를 제공할 수 있을 것이다.

Acknowledgments

본 연구는 2018년도 덕성여자대학교 교내연구비 지원에 의해 수행되었다.

참고문헌

- J. Kim et al., “The effects of blind users' smart phone use on social capital and psychological well-being”, Korean Broadcasting Journal Vol. 27, No. 2, pp 157-185, 2013.

- Effects of Smartphone Use on the Visually Impaired Life, ABLENEWS [Internet] Available: https://www.ablenews.co.kr/News/NewsContent.aspx?CategoryCode=0006&NewsCode=000620160219131807582601, .

- C. Oh et al., “A study on Pedestrian Navigation Aids Map for Blind People”, National Geographic Society Journal Vol. 46 No. 2, ppb201-212, 2012.

- K. Bae and S. Kwak, “A Study of Developing the Ubiquitous Library for the Improvement of Information Accessability of the Blind”, Korean Library and Information Science Journal Vol. 37, No. 2, pp 273-290, 2006.

- C. Praderio, Here's the brilliant way blind people use touchscreen devices like smartphones, Insider [Internet] Available: https://www.insider.com/how-blind-people–use-smartphones-2017-2, .

- K. Chun, Apps that help the visually impaired, users are ‘inconvenient Sisa Journal [Internet] Available: http://www.sisajournal-e.com/news/articleView.html?idxno=183295, .

- Google LookOut, 2018 Google IO developer conference, [Internet] Available: https://events.google.com/io2018/, .

- VR Vision aid applications Relumino, [Internet] Available: https://www.samsungrelumino.com/timeline, .

- Sullivan+, [Internet] Available: https://www.mysullivan.org/app/history, .

- Large enterprise development disabled support app, effectiveness OK [Internet] Available: http://aieconomic.co.kr/news/view/231, .

- Raghad Alali, “A Case Study of Visually Impaired Individuals’ Preferences of the Availability of Braille Clothing Labels in Shopping and Selection of Apparel”, Master degree thesis, BALL STATE UNIVERSITY, INDIANA, 2017.

- Naver sentiment movie corpus [Internet] Available: https://github.com/e9t/nsmc/, .

- KoNLPy [Internet] Available: http://konlpy.org/en/latest/, .

- A. Zafar, “How to design mobile app experiences for the visually impaired”, Inside Design, 2017.

- Quanzeng You, Hailin Jin, Zhaowen Wang, Chen Fang, and Jiebo Luo, “Image Captioning with Semantic Attention”, in Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pp. 4651-4659, 2016.

저자소개

2015년~현 재: 덕성여자대학교 정보통계학과 재학

※관심분야: 인공지능, 빅데이터 분석

2015년~현 재: 덕성여자대학교 정보통계학과 재학

※관심분야: 인공지능, 음성합성 및 인식

2015년~현 재: 덕성여자대학교 철학과 재학

※관심분야: 인공지능, 안드로이드응용 개발

1986년: 서울대학교 제어계측공학과 공학사.

1988년: 서울대학교 제어계측공학과 공학 석사.

1995년: University of Southern California 컴퓨터학과 공학박사

1996년~현 재: 덕성여자대학교 컴퓨터학과 교수

※관심분야: 인공지능, 지식기반시스템과 딥러닝