상담 및 심리치료에서 대규모 언어 모델(LLM)의 적용: 기회와 한계 및 윤리적 고려 사항

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 상담 및 심리치료 분야에서 대규모 언어 모델(LLM)의 도입과 적용에 관한 선행 연구, 실제 사례, 가상 예시를 종합하여 LLM의 활용 방안, 한계 및 보완 사항, 윤리적 고려 사항을 논의하였다. 연구 결과, LLM은 대면 상담의 보조도구로 내담자의 자가 치료와 심리교육을 지원하고, 수련생 교육 및 훈련에서 가상 사례 실습과 상담 대화록 검토에 활용될 잠재력을 지닌 것으로 나타났다. 또한 상담 과정 및 성과 분석, 연구용 가상 사례 생성 등 다양한 연구 방법론 설계에도 기여할 것으로 기대되었다. 한편, LLM의 한계를 보완하기 위해 상담자의 전문적 피드백과 평가, 윤리적 지침의 마련이 필수적임을 강조하였다. 이에 따라 본 연구는 상담자가 LLM의 효과적인 활용을 위해 기술적 이해를 갖추고, 윤리적 지침을 수립하며, 전문가로서 주도적이고 협력적으로 참여할 필요가 있음을 제언하였다.

Abstract

This study reviewed existing research, real-world cases, and hypothetical examples related to the introduction and application of Large Language Models (LLMs) in counseling and psychotherapy. This research outlined effective strategies for applying LLMs, identified their limitations and areas for improvement, and addressed ethical considerations. The results demonstrate that LLMs can serve as supportive tools in face-to-face counseling to promote client self-help and psychoeducation, enhancing education and training through virtual case simulations and transcript reviews. Additionally, the findings suggest that LLMs can improve research methodologies by analyzing counseling processes and outcomes, as well as generating research-oriented vignettes. The findings emphasize that professional feedback and evaluation from counselors, along with the establishment of ethical guidelines, are essential for addressing LLMs’ limitations. Based on these findings, the study suggests that counselors should acquire a technical understanding, develop ethical guidelines, and actively engage and collaborate as experts in the implementation of LLMs.

Keywords:

Counseling and Psychotherapy, Large Language Models, Artificial Intelligence, Role of Counselors, Ethical Considerations키워드:

상담 및 심리치료, 대규모 언어 모델, 인공지능, 상담자 역할, 윤리적 고려 사항Ⅰ. 서 론

최근 생성형 AI 모델(Generative AI)은 인공지능(AI) 연구 커뮤니티와 일반 대중 모두의 주목을 받고 있다. 2017년 도입된 대규모 언어 모델(Large Language Model: LLM)은 다양한 언어 기반 작업을 처리할 수 있는 능력을 갖추었으며[1], 특히 OpenAI의 GPT(Generative Pre-trained Transformer) 시리즈로 대표되는 LLM은 인간과 유사한 언어적 반응을 생성하는 인공지능 모델로 자리 잡았다[2]. 2023년 발표된 GPT-4는 미국 변호사 시험과 대학입학시험에서 상위 10%에 해당하는 성과를 기록했으며, 이미지 처리 능력도 갖추면서 다양한 형태의 자료 생성이 가능해졌다[3].

LLM의 발전은 심리학을 비롯한 정신건강 분야에 상당한 파급력을 미칠 것으로 예상된다. LLM의 도입은 치료적 개입의 향상, 행정 업무의 자동화, 실무 수련 방식의 변화, 연구방법론의 혁신 등 다양한 영역에서 변화를 가져올 수 있다[4]. 특히 상담 및 심리치료는 언어를 매개로 한 전문적 상호작용이 이루어지는 분야이기에, LLM의 적용 가능성은 더욱 주목할 만하다. 특히 LLM이 대중에게 친숙한 형태로 제공되면서(예. ChatGPT), 대중이 이를 활용해 심리상담을 시도하는 사례가 나타나고 있다[5]. 이러한 움직임은 정신건강 서비스의 수요 증가에 비해 공급이 부족한 문제, 즉 서비스 갭을 해결할 수 있는 방안으로 인공지능 기술의 발전이 주목받고 있는 맥락과 일치한다.

LLM의 발전은 다양한 직업 및 직무 환경에 영향을 미치고 있으며[2],[6], 상담 및 심리치료 분야도 예외는 아니다. 이에 따라 상담자의 전문가 정체성을 새롭게 정의하고, LLM의 활용이 상담 실무, 교육, 연구를 증강(augmentation) 또는 자동화(automation)할 수 있는지에 대한 논의가 활발히 이루어지고 있다[2],[6]. 이제 LLM 기술의 적용 찬반을 넘어, 그 활용에 따른 잠재적 위험을 최소화하면서 실무와 연구, 교육에 효과적으로 통합할 방안을 모색할 시점이다[6].

해외 연구에서는 인공지능이 상담 및 심리치료 분야에 미친 영향을 고찰한 주제 범위 문헌 연구들(scoping review)이 보고되었다[7]-[10]. 해당 연구들은 상담 및 심리치료 분야에 관한 인공지능 도입의 현황을 파악할 수 있게 도왔으나 주로 컴퓨터 과학 분야에서 수행되었고, 연구 방법론 특성상 주제에 관한 간결한 요약에 초점이 있었다. 또한 이 문헌 연구들은 2023년 이전에 수행되어 LLM과 관련된 최신 논의는 반영되지 않았다.

최근에는 LLM의 도입이 상담 및 심리치료에 미치는 영향을 다룬 연구가 심리학 등의 정신건강 분야에서 보고되기 시작했다. Schueller와 Morris[11]는 LLM을 비롯한 생성형 AI가 임상적인 개입에 다양한 유용성을 제공할 수 있다고 평가하면서도, 실무와 연구에서 고려해야 할 윤리적 문제를 지적하였다. Stade 등[2]은 상담 및 심리치료에서 LLM의 단계적 적용 가능성을 제시하며, 상담자와 내담자, 연구자 등 다양한 역할에서의 활용 가능성을 예측했다. Demszky 등[6]은 LLM이 측정, 실험, 및 실무 등 심리학 전반에 걸쳐 유용한 도구가 될 수 있음을 강조하면서, 편향, 해석 가능성의 어려움, 결과 변산성 등 윤리적·기술적 한계를 경계해야 한다고 언급하였다. Ke 등[12]은 LLM이 인지, 상담 및 임상, 교육, 사회 심리학 등 다양한 심리학 분과에서 인간의 인지와 행동을 모사하는 도구로 활용되며, 문헌 검토, 가설 생성, 실험 설계, 데이터 분석 등에서 혁신적인 역할을 할 수 있음을 논의하였다. 한편 사생활 보호, 윤리적 문제에 대한 신중한 고려가 필요함을 지적하였다.

선행 연구를 종합하면, LLM 도입으로 인해 상담 및 심리치료 분야에서 상담자 역할과 직무에 큰 변화가 예상되며, 이에 대응하기 위한 상담자의 역량과 윤리적 기준이 필요하다는 공통점이 도출된다. 그러나 기존 연구들은 LLM이 상담 및 심리치료에 미칠 가능성을 간단히 전망하는 데 그치거나[11], 심리학 분야 전반에 대한 포괄적인 적용을 개괄하면서 하위 전공 수준의 부분적 검토에 국한되었고[12], 일부 연구들[2],[6]은 상담 및 심리치료에 특화된 LLM의 적용 가능성을 실무, 교육 및 연구 영역에 걸쳐 논의했으나, LLM 도입과 이해에 집중하면서 구체적인 활용 사례와 경험적 연구는 다루지 않았다는 한계점이 있다. 무엇보다 모든 연구가 해외에서 이루어졌기 때문에, 상담 및 심리치료에서 LLM 도입의 영향을 분석한 국내 연구는 매우 부족하다. 국내 연구에서는 주로 LLM 도입 이전의 인공지능에 관한 연구를 수행했는데, 상담 및 심리치료에서 인공지능을 활용하기 위한 기술과 프로그램을 개관하거나[13], 인공지능, 머신러닝, 딥러닝 등의 기본 개념을 탐구하며[14], 상담자 훈련에 인공지능을 적용하는 방안과 사례를 소개했다[15]. 또한, LLM 도입 이전의 대화형 인공지능(챗봇) 개발 및 효과성 검증 연구도 다수 이루어졌다[16]-[18]. 이를 통해 기술 변화에 대한 상담자의 인식과 태도, 그리고 향후 요구될 상담자의 역할과 역량을 추론할 수 있었다. 그러나 기존 연구는 대부분 규칙 기반 챗봇 활용과 상담자 대체 가능성에 초점을 맞추고 있으며, LLM 도입 이후 상담자의 인식 및 역할 변화에 관한 논의는 미비하다. 따라서 LLM 도입에 따른 상담자 직무 증강, 전문적이고 윤리적인 유의 사항, 상담자 고유 영역의 재발견, 타 분야와의 협업 가능성 등을 더욱 폭넓게 탐색할 필요가 있다.

이를 위해 본 연구는 상담 및 심리치료에서 LLM의 도입에 관한 선행 연구, 실제 사례, 가상 예시 등을 종합하여 상담 및 심리치료의 관점에서 LLM의 효과적 활용 방안과 한계 및 보완 사항, 그리고 윤리적 고려 사항을 제시하고자 한다.

Ⅱ. LLM에 대한 개념적 이해

LLM의 도입과 활용을 논하기 위해서는 먼저 생성형 AI와 자연어처리(Natural Language Processing: NLP)에 대한 이해가 필요하다. 생성형 AI는 다양한 형태의 데이터를 생성하는 인공지능 기술을 의미하며, 여기에는 텍스트, 이미지, 음성 등이 포함된다. 자연어처리는 인간의 언어를 해석하고 처리하는 기술로, 인간과 컴퓨터 간의 상호작용을 돕는 중요한 도구이다[19]. NLP 기술의 발전은 심리학자들이 언어와 관련된 직무들을 개발 및 통합하는 데 도움이 되었다[6].

많은 연구들이 상담 및 심리치료 분야에서 NLP 기술이 어떻게 활용될 수 있는지를 검증하였다. 특히 대화형 AI 챗봇의 상담 효과와 상담자 역할 대체 가능성을 논의하는 연구가 주를 이루었다[18]. 그러나 기존의 NLP는 주로 특정 직무에 맞춘 상대적으로 작은 규모의 데이터 세트를 학습시키는 방식으로 구현되었고, 이에 따라 상담 및 심리치료의 유연한 맥락에 맞지 않는 기술적 한계가 있었다. 예를 들어, 규칙 기반 학습을 통해 구현한 상담자 챗봇은 대화의 맥락적 이해를 수반하기 어려워 개인의 고유성을 고려하지 못하거나, 예상치 못한 내담자 반응을 이해하고 대응하는 데 한계가 있었다[2].

그러나 컴퓨터 기술 발달에 따른 비용 절감으로 인해 대규모 언어 데이터를 범용적으로 사전 학습하고, 특정 맥락에 맞춰 조정 및 활용 가능한 대규모 언어 모델(LLM)이 언어 처리의 기본적인 모델(foundational model)로 등장하면서, 주어진 텍스트에 대한 자연어를 처리하는 활용 패러다임을 재정립시켰다[20]. 특히 2017년, LLM에 자기-주의 메커니즘을 토대로 하는 트랜스포머 아키텍처가 도입됨으로써 처리 속도 향상, 모델 확장성 증대, 고차원적 의미 표현 등 다양한 방면으로 진화하게 되었다[21].

LLM은 기본적으로 주어진 입력값을 기준으로 다음 단어, 문장 또는 맥락을 예측하는 방식을 활용한다. 기존 NLP가 단어를 맥락 내 고정된 의미로 가정했던 방식(bag-of-words)을 활용했다면, LLM은 대규모 언어 데이터 세트를 통해 문맥을 고려하여 단어의 의미를 근사화하고, 이를 통해 단어의 다의성과 문맥에 따른 의미 변화를 처리할 수 있다[6].

프롬프트(prompt)는 LLM을 사용할 때 모델이 텍스트를 생성하거나 작업을 수행하기 위해 제공하는 입력 데이터이다. 프롬프트는 질문, 문장 시작 부분 또는 특정 지침일 수 있으며, 모델은 이를 기반으로 이어지는 텍스트를 생성한다.

미세 조정(fine-tuning)은 사전 학습된 LLM을 특정 작업이나 도메인에 맞춰 추가로 훈련하는 과정이다. 이를 통해 모델은 특정 데이터 세트와 관련된 미묘한 패턴과 문맥을 학습하게 되어, 더 정확하고 적절한 응답을 생성할 수 있게 된다.

최근 경량 대규모 언어 모델(small large language model: sLLM)이 LLM에 비견하여 주목받고 있는데, sLLM은 상대적으로 적은 파라미터를 가진 모델을 의미하며, 특정 분야나 목적에 맞춰 훈련된 모델을 지칭한다. 이러한 sLLM은 특정 업무나 도메인에 특화되어 빠르고 효율적인 언어 처리를 제공할 수 있다.

Ⅲ. 상담 및 심리치료에서 LLM의 적용

3-1 LLM의 도입: 기회와 위협

LLM의 도입과 끊임없는 발전은 직업 시장에 광범위한 영향을 미쳤다[1]. 2023년 미국심리학회가 실시한 대규모 조사에 따르면, 38%의 노동자가 인공지능으로 인해 자신의 업무가 무용지물이 될까 염려하고 있다[22]. 상담 및 심리치료 분야에서도 LLM을 비롯한 인공지능의 도입은 국내 상담자에게 기회이자 위협으로 인식되고 있다. 기회로 간주하는 의견 중에는 인공지능 기술이 상담 및 수퍼비전 수행에 도움을 줄 수 있다는 점이 있으며[23], 실제로 42%의 상담자가 NLP를 활용한 상담 녹취록 프로그램을 사용한 적이 있다는 결과가 이를 뒷받침한다[24]. 반면, 인공지능 기술의 발전(예. 챗봇 도입)이 기존 상담 인력의 일자리를 위협할 가능성도 보고되었다[18],[23].

그럼에도 불구하고, 다수의 연구[11],[18],[23]에서는 LLM을 비롯한 인공지능 기술이 상담자라는 인간 존재와 그에 따른 핵심역량을 대체할 수 없을 것이라고 예상하였다. 그러나 상담자는 상담과 인공지능 기술의 발전을 구분하여 인식하기보다, 인공지능을 이해하고 전략적으로 활용할 필요가 있다[25]. 그리고 상담자는 LLM의 도입이 상담 서비스 수준을 향상시키는지, 윤리적으로 적절한지 전문가 정체성에 입각하여 신중하게 고려해야 한다. 다시 말해, 상담자는 LLM의 도입을 전문적인 기회로 최대한 활용하기 위해 다양한 적용 사례를 검토하고, 직무 환경 및 상담자의 고유 가치를 위협하지 않도록 역할과 역량 발달에 주의를 기울여야 한다.

3-2 상담자의 직무 지원

LLM을 상담 및 심리치료에 적용하는 그림을 상상할 때, 우리가 주목해야 할 LLM의 강점은 LLM이 다양한 분야에서 구성 요소로 활용될 수 있다는 데에 있다[1]. 즉 LLM은 특정한 과업, 직무, 또는 역할을 수행하기 위해 도입될 수 있으며, 목적에 따라 다른 기술과 통합되어 새로운 기능을 수행할 수도 있다. 예를 들어, LLM은 상담 및 심리치료 분야에 특화된 워크플로우(특정 작업 및 프로세스 완료를 위해 필요한 일련의 단계와 절차)를 개발함으로써[1], 상담자가 자신의 핵심 업무에 집중할 수 있도록 도울 수도 있다.

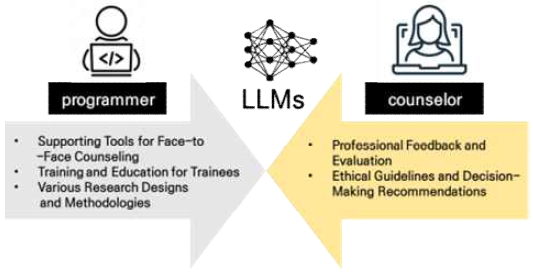

상담 및 심리치료 분야에 LLM 도입에 따른 상담자의 역할 변화나 실무·수련 및 연구의 증강 또는 자동화 가능성에 대한 논의가 시작되었다[2],[6],[11],[12]. 선행 연구들을 종합하면, 상담자들은 LLM을 도입함으로써 다음과 같은 기술적 특성을 활용하여 상담 관련 직무 수행에 도움을 받을 수 있으며, 이와 관련된 한계도 인식할 수 있다. 그림 1의 왼쪽은 상담자의 직무에 도움이 될 것으로 예상되는 사항들을 도식화한 것이다.

상담자는 LLM을 도입한 어플리케이션을 내담자가 스스로 사용할 수 있는 보조도구로 장려하여, 내담자들이 회기(session) 사이에 상담 내용을 효과적으로 적용하도록 도울 수 있다. 본 연구는 LLM에 인지행동치료(Cognitive Behavior Therapy: CBT) 프레임워크를 적용하는 예시를 통해 이러한 사례들을 구체적으로 설명하고자 한다.

CBT는 Beck 등에 의해 발전된 상담 및 심리치료 이론으로, 상담의 협력적 관계를 토대로 내담자의 인지 변화에 초점을 맞추어 상담을 진행한다[26]. CBT의 인지매개가설은 내담자의 감정 및 행동이 선행 사건의 직접적인 결과이기보다 그 사건을 해석하는 내담자의 인지 도식이 작용한 결과라고 본다. 상담자는 내담자와 협력적 관계 속에서 내담자의 인지 도식에 자리 잡은 자동적 사고, 핵심 신념, 인지적 왜곡 등을 발견하고 수정할 수 있도록 돕는데, 이때 상담자는 소크라테스식 질문법 등의 기법을 통해 내담자가 스스로 진실을 발견할 수 있도록 돕고, 대안적인 인지, 정서 및 행동을 경험하게 하도록 회기 사이에 과제를 부여한다. CBT는 근거 기반 치료로서, 내담자의 상담 과정 및 평가를 객관적으로 평가하고자 하는 특성이 있고, CBT로 인한 효과는 다수의 연구에서 과학적으로 검증되었다[26].

• 보조적인 상담 및 심리교육을 제공하는 LLM

내담자는 상담 회기 외에도 자신의 상담 주제와 관련된 어려움을 CBT에 특화된 LLM 기반 챗봇을 통해 논의하고, 이에 관한 심리교육을 받을 수 있으며, 상담자는 이러한 내용을 다음 회기에서 다룰 수 있다. 실제로, 한 연구[27]에서는 심리학 포럼 내용을 데이터세트로 사용하고, 인지행동치료의 핵심 원칙을 반영한 프롬프트를 ChatGPT에 학습시킨 후, 전문가 피드백을 통해 미세 조정하여 CBT-LLM을 개발하였다. 이 CBT-LLM은 내담자 경험 타당화 및 공감 반응, 핵심 신념 발견, 자기성찰 유도, 적응적 전략 제공, 내담자 독려 등의 원칙을 바탕으로 내담자와 대화를 나눌 수 있게 설계되었다. 이 LLM을 상담 및 심리치료 전공자들이 평가한 결과, 이는 CBT 프레임워크에 적합하며 심리적으로 유용한 대화를 구성한 것으로 나타났다[27]. 다만, CBT-LLM 연구[27]에서는 CBT의 주요 요소인 인지 왜곡에 대한 전문가의 ‘잘 정의된’ 주석이 사전에 적용되지 못한 점이 프로그램 효과성에 영향을 미쳤을 가능성이 있다고 지적되었다.

• 내담자의 과제 수행을 돕는 LLM

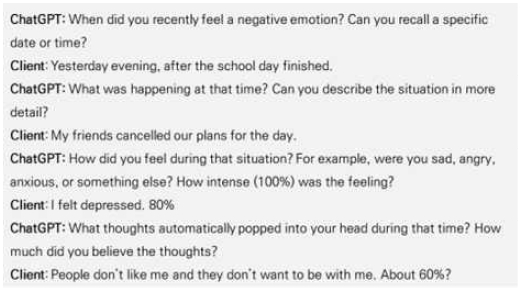

상담자는 내담자에게 LLM을 이용한 과제를 수행하도록 권할 수 있다. 즉 내담자는 상담자와 합의한 과제(예. 자동적 사고 워크시트)를 해당 어플리케이션(예. 챗봇)에 입력하여 과제를 수행할 수 있다[2]. 예를 들어, 내담자가 일상에서 경험한 부정적인 사건과 그 결과를 기록하면(예. ‘사람들이 약속을 취소했고[사건]’, ‘나는 우울해졌다[감정 또는 행동적 결과]’), 챗봇은 이를 기반으로 그 감정의 강도와 내담자가 당시 자동적으로 떠올린 사고 또는 심상이 무엇인지 묻는다. 이에 내담자가 응답하면(예. ‘사람들은 나와 함께 하는 걸 싫어해’), 챗봇은 해당 자동적 사고의 믿음 정도, 이 사고를 지지하거나 반박하는 증거, 대안적 사고와 그에 따른 감정 및 행동 변화 등을 대화 형식으로 묻고 답하여 과제를 완성할 수 있도록 돕는다. 그림 2에서 이러한 예시를 확인할 수 있다.

• 한계 및 보완 사항

CBT의 프레임워크를 기반으로 LLM의 워크플로우를 개발하더라도, 해당 모델이 상담자 주도의 CBT를 완전히 대체할 수 없다. 따라서 문제 설정, 개발, 적용 및 평가의 전 과정에서 도메인 지식을 지닌 상담자의 지속적인 모니터링이 필요하다. 이때의 ‘도메인 지식’은 특정 조건(예. 이론적 지향-CBT)에 따라 세분화되고 전문화될 수 있다. 예를 들어, 해당 CBT-LLM[27]을 사후 평가한 전공자들이 CBT 관련 전문성을 충분히 습득했는지 확인하기 어려운 점 또한 해당 연구의 한계로 지적될 수 있다. 따라서 향후 특정 이론에 특화된 LLM을 활용하기 위해서는 해당 이론의 충분한 이론과 실무 경험을 갖춘 전문가의 협력이 필요할 것이다.

또한 내담자를 직접 만나는 상담자가 CBT에 특화된 LLM을 대면상담의 보조도구(예. 심리교육, 과제)로 활용할 경우, 상담자는 이후 상담 회기에서 내담자와 해당 상호작용을 검토하고 다루어야 할 것이다. 이는 CBT의 핵심 원리 중 하나인 협력적 경험주의에 기반한 것으로, 협력적 경험주의는 상담자와 내담자가 함께 내담자의 경험을 탐구하고 해석하는 과정을 통해 치료적 변화를 끌어내는 접근법이다[26]. 따라서 LLM과의 상호작용에서 내담자가 경험한 내용을 가지고 상담자와 함께 새로운 통찰을 도출하는 과정이 필수적이다. 이 과정이 생략될 경우, LLM의 개입은 단순한 정보 공유에 그치는 한계를 가질 수 있다.

최근 인공지능과 테크놀로지를 활용한 상담자 교육 프로그램이 점차 개발되고 있다[15]. 특히, LLM을 활용한 프로그램은 생성된 가상 사례나 실제 상담 자료를 바탕으로 상담수련생의 상담 및 심리치료 기술 (skill) 향상을 지원할 수 있다.

• 가상 사례 실습을 돕는 LLM

LLM은 수련생을 위해 가상의 상황을 설정하고, 내담자에게 특정 개입을 수행하는 연습을 가능하게 한다. 이 연습은 실제 내담자를 대상으로 하지 않기 때문에 내담자의 안전과 복지를 위협하지 않아 윤리적일 수 있다. 예를 들어, CBT를 훈련하는 수련생은 LLM을 통해 내담자가 보고하는 내용에서 그가 지닌 비합리적 신념들을 재평가하는 가상의 치료적 대화를 진행할 수 있다[6].

또한 수련생은 CBT와 같은 특정 이론을 익히기 전에, 기초적인 마이크로스킬(예. 공감, 반영, 경청, 타당화, 재진술, 요약 등)을 배워야 한다. 한 연구[28]에서는 ChatGPT를 활용하여 이러한 스킬을 연습할 수 있는 시나리오를 개발하였다. 연구자는 총 10개의 가상 내담자 사례를 프롬프트로 제공하였고, ChatGPT가 내담자 역할을 수행하도록 하였다. ChatGPT가 연기한 내담자의 반응은 진정성, 일관성, 적절한 감정 표현, 문화적 민감성, 공감, 자기 인식 측면에서 긍정적인 평가를 받았다. 그러나 과도하게 이상적인 반응을 보이거나, 비언어적 반응을 확인할 수 없는 한계도 드러났다[28].

• 실제 사례를 검토할 수 있도록 돕는 LLM

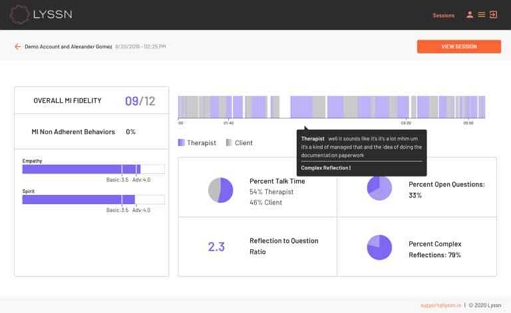

LLM은 수련생이 진행한 실제 상담 대화록을 분석하여 그들이 수행한 상담의 성과를 평가하는 기능도 제공한다. 대표적인 예로는 미국의 소프트웨어 Lyssn이 있다. Lyssn은 상담 및 심리치료 훈련을 지원하기 위해 개발된 기술 플랫폼으로, 화상 상담 세션을 기록하고 분석하며, 상담 전문가들의 주석을 통해 모델을 미세 조정하여 상담 대화의 질을 평가한다. 그림 3에서 Lyssn의 사례 분석 보고서의 예시를 확인할 수 있다. 예를 들어, Lyssn은 상담자의 일관성, 공감, 반영적 경청 등의 요소를 자동으로 분석하여 수련생에게 정량적인 피드백을 제공한다[29]. 이러한 피드백은 수련생을 지도감독하는 수퍼바이저가 상담 사례를 더욱 구체적으로 지도하고 논의하는 데 중요한 자료로 활용될 수 있다. 한 연구에 따르면[30], Lyssn을 활용한 수련생과 수퍼바이저 모두 상담 기술을 익히고 상담 과정에 집중하는 데 이 플랫폼이 유용했음을 밝혔지만, 동시에 녹화 및 녹취에 대한 부담과 우려를 나타내기도 하였다.

• 한계 및 보완 사항

LLM을 활용한 수련 지원 프로그램은 다음과 같은 한계를 지닌다. 첫째, 상담자 수련의 효과 측면에서 LLM의 기능으로 설명할 수 없는 부분이 존재한다. 예를 들어, ChatGPT를 활용한 수련생의 상담 실습은 전반적인 상담 기술 연습에 도움이 되었으나, 정서나 공감을 깊이 있게 다루지 못하고 비언어적 요인을 식별하기 어려운 점과 맥락적 이해가 부족하며 인간 모니터링이 필수적이라는 점이 공통적인 한계로 지적되었다[31]. Lyssn과 같은 정량적인 성과 지표를 제공하는 경우도 마찬가지이다. 이러한 프로그램이 제공하는 성과 지표의 수치를 해석하는 것은 여전히 인간의 몫이다. 또한, 이론적 지향을 떠나 모든 상담 및 심리치료는 계량화된 지표로는 측정하기 어려운 관계 및 과정 기반 요인들이 존재하며, 이러한 요인들은 치료적으로 매우 강력한 성과 변인들로서 수련생들이 습득해야 하는 중요한 부분이다.

둘째, 상담은 본질적으로 민감한 개인정보가 교환되는 과정이므로, 실제 상담 자료를 기반으로 한 LLM의 활용에서 내담자의 개인정보 보안과 사생활 보호에 대한 한계를 완전히 극복할 수 없다. 상담 과정에서는 비밀 보장과 사생활 보호의 기본 원칙을 준수하며, 상담의 과정과 이득, 한계에 대해 내담자에게 ‘충분히 설명된 사전 동의(informed consent)’를 받아야 한다. 따라서 상담에서 기록된 정보의 활용 범위에 대해 상담자와 플랫폼 양측에서 충분히 설명하였는지 확인해야 하며, 인공지능 및 개인정보 윤리에 대한 비판적 성찰이 지속적으로 필요하다.

LLM을 활용하면 상담 성과에 영향을 주는 변수들, 예를 들어 매개변수(mediator)와 조절변수(moderator)를 다양한 방식으로 검증할 수 있다. 매개변수는 독립변수(예. 내담자의 정서적 경험)가 종속변수(예. 내담자의 심리적 성장)로 향하는 과정이 ‘어떻게’ 또는 ‘왜’ 이루어졌는지를 설명하며, 조절 변수는 독립변수가 종속변수로 향하는 과정을 ‘언제’ 또는 ‘어디서’ 강화하거나 약화시켰는지를 설명한다. LLM의 적용은 선행 연구에서 검증된 치료적 이론과 구성 개념에 기반하여 상담 과정과 성과를 실제 자료를 통해 더 정확하게 측정하고 평가할 기회를 제공한다.

• 담화 분석을 통한 상담 과정 및 성과 분석

한 연구[32]에서는 NLP를 활용하여 실제 상담 과정에 보고된 내담자의 발화 내용에서 감정을 자동으로 식별하는 모델을 개발하였고, 내담자가 보고한 부정적인 감정과 모델이 탐지한 감정이 일치할수록 상담 성과가 더 좋다는 결과를 도출하였다. 이는 정서적 경험과 언어적 표현의 일치가 심리적 회복에 기여한다는 정서적 일치성(emotional coherence) 개념을 입증한 것이다. 비록 이 연구는 LLM을 사용하지 않았으나, 상담 및 심리치료에 특화된 LLM을 도입하면 상담자나 내담자의 자기 보고 및 타인 관찰을 통한 추론을 넘어서, 대규모 실제 자료를 통한 세밀한 추적과 정교한 측정이 가능할 수 있겠다.

• 벤치마크 구현을 통한 심리 측정 및 실험용 사례 생성

또 다른 연구[33]에서는 대규모 데이터세트를 활용하여 성격, 가치관, 정서, 마음 이론, 동기, 인지와 같은 대표적인 심리적 차원을 구축하고, 이를 바탕으로 LLM이 각 심리적 속성을 평가하도록 하였다. 예를 들어, LLM은 성격 5요인 중 ‘외향성’에 관련된 단어, 문장 및 가상 사례 프롬프트를 바탕으로 ‘외향성’을 평가할 수 있었다. 이러한 벤치마크 구현은 LLM이 학습한 심리적 속성에 기반하여 ‘외향성’을 반영하는 새로운 가상 사례를 생성할 수 있음을 의미한다. 이는 연구자가 심리적 속성을 자기 보고 또는 타인 보고 설문지를 통해 횡단적으로 연구하는 것 외에도, LLM을 활용하여 실험적 검증을 수행할 가능성을 시사한다[6].

• 한계 및 보완 사항

그러나 LLM을 활용한 연구는 LLM의 내부 작동 방식에 대한 이해 부족이라는 한계를 가질 수 있다[6]. 예를 들어, LLM이 내담자의 발화를 분석하여 ‘불안’이라는 감정을 도출하는 과정은 복잡하고 불투명하여, 연구자는 LLM이 어떤 근거와 논리로 ‘불안’이라는 결론에 도달했는지 명확히 파악하기 어렵다[6]. LLM이 상담 과정의 ‘블랙박스’ 일부를 밝히는 데 도움을 줄 수는 있지만, LLM 자체는 여전히 ‘미지의 영역’으로 남아 있다.

역설적으로, LLM을 활용한 연구는 LLM의 한계를 드러내고 상담 및 심리치료의 본질적 영역을 명확히 규명하는 데 기여할 수 있다. 예를 들어, LLM이 측정한 대화록 속 ‘공감’이 실제 상담 관계에서 느껴지는 공감과 동일하다고 가정할 수 있을까? 또는, 상담 관계의 ‘진정성’을 언어나 음성 데이터만으로 정확히 측정할 수 있을까? 이러한 문제의식이 반영되듯, 앞서 소개한 두 연구는 언어(문자)에만 의존하여 심리학적 결과를 도출했다는 점[32]과 대화에서의 역동적이고 상호작용적인 측면을 포함시키지 못했다는 점[33]을 각 연구의 한계로 지적하였다. 상담 및 심리치료는 단순한 정보 처리를 넘어 인간의 복잡한 심리와 관계를 다루는 영역이므로, LLM으로 완전히 대체하기 어려운 고유한 가치를 지닌다. 이러한 논의는 상담 및 심리치료의 고유성에 관한 후속 연구 문제로 이어질 수 있다.

3-3 전문가로서의 상담자 역할

LLM의 도입이 상담 및 심리치료 분야에 가져올 수 있는 다양한 장점에도 불구하고, 상담자라는 전문가가 반드시 수행해야 하는 역할에 대해 논의할 필요가 있다. 특히, LLM의 활용이 증가함에 따라 발생할 수 있는 전문적 및 윤리적 문제를 해결하고 상담의 본질적 가치를 유지하기 위해, 상담자는 LLM 개발 및 활용 과정에서 맡을 수 있는 전문적 역량과 책임을 검토해야 한다. 그림 1의 오른쪽은 상담자가 전문가로서 지원할 수 있는 역할과 관련 사항들을 도식화한 것이다.

상담자는 LLM이 적용된 프로그램의 전문 지식과 경험, 즉 도메인 지식이 부족한 부분을 관리(human-in-the-loop)함으로써 프로그램의 지속적인 개선을 도울 수 있다. 다시 말해, 상담자는 LLM을 활용한 프로그램 개발, 조정, 활용의 전 과정에서 해당 프로그램이 더욱 정확한 기능을 수행할 수 있도록 피드백을 제공하고 적절한 평가를 수행할 수 있다.

첫째, 상담자는 도메인 지식이 있는 전문가로서 LLM이 제공하고자 하는 요구 사항 및 문제를 정의하고 식별하는 데 도움을 줄 수 있다. 예를 들어, 데이터 세트를 구축하거나 프롬프트를 디자인하는 과정에서 특정 상담 기법이나 심리적 이론을 LLM이 잘 이해하도록 지원할 수 있다.

둘째, 상담자는 개발된 LLM 모델을 조정하는 과정(프롬프트 엔지니어링 및 미세 조정 단계)에서 전문가로서 주석을 제공할 수 있다. 상담자는 LLM이 학습한 대중적인 언어 자료에서 처리하기 어려운 특정 영역(예. 부모-자녀 상호작용)이나 구성개념(예. 스트레스 대처 전략)에 대해 주석을 달아 모델이 해당 데이터의 맥락과 의미를 더 잘 이해하도록 할 수 있다[6].

셋째, 상담자는 인간 피드백을 통한 강화 학습(Reinforcement Learning from Human Feedback: RLHF)에 기여할 수 있다. 예를 들어, 상담자가 제공한 피드백을 통해 LLM이 이론적이거나 상담 기술적으로 적절한 반응을 생성하도록 개선할 수 있으며, 이를 통해 모델의 성능을 지속적으로 향상시킬 수 있다.

상담자는 AI 활용에 있어 윤리적 적절성을 판단할 수 있는 전문가로서, 윤리적 쟁점을 확인하고 관련 논의 및 의사결정에 적극 참여해야 한다[19],[25]. 따라서 상담자는 LLM의 활용에 있어 전문적이고 윤리적인 측면을 고려하고, 관련 지침을 제시할 수 있어야 한다. 급증하는 기술 발전에 따라 인공지능 윤리에 관한 전반적인 지침이 마련되고 있지만 (예. 유럽연합, 세계보건기구), 이러한 지침은 매우 범용적이다. 상담 및 심리치료는 전문가의 직업윤리가 필수적으로 수반되므로, 이 분야에서의 윤리적 태도와 행위는 더욱 중요하다. 따라서 상담자는 LLM 활용에서 윤리적 문제(예. 사전 동의, 사생활 보호 및 비밀 보장, 위기 대응 등)를 고려하고 해결하는 데 도움을 줄 수 있으며, 구체적인 사례는 다음과 같다.

먼저, LLM이 상담 및 심리치료 분야에 활용될 때, 상담자뿐만 아니라 관련 기관과 개발자 모두가 내담자의 복지와 안녕을 최우선으로 고려해야 한다. 예를 들어, 사전 동의는 상담에 참여하기 전에 내담자에게 상담자와 상담 과정에 대한 중요한 정보를 충분히 제공하고, 상담의 본질, 예상되는 결과 및 어려움에 관해 설명한 후 내담자의 동의를 받는 과정으로[34], 내담자의 권리와 상담자의 책임을 존중하는 상담 윤리의 기본 원칙이다. 내담자를 지원하는 상담자 및 관련 기관은 사전 동의 과정을 통해 내담자에게 LLM 사용의 이득, 위험성, 한계를 명확히 설명해야 한다. 만약 LLM의 사용이 치료적 이득보다 손실이 클 경우, 상담자는 합의 또는 전문가의 판단에 따라 대체 방안을 제시할 수 있어야 한다.

또한, LLM을 포함한 기술을 활용할 때는 내담자의 사생활 보호와 비밀 보장을 철저히 유념해야 한다. 특히, 내담자의 개인정보와 상담 자료가 어떻게 활용되고 보안 처리되는지, 그 범위와 한계를 투명하게 밝혀야 한다. 최근 AI 관련 정보 윤리[35]-[36]는 빅데이터나 AI 시스템을 통해 개인정보를 활용함으로써 정보처리자(예. 기업, 연구기관)나 제3자(예. 서비스 제공업체)가 이익을 추구할 수 있지만, 이러한 이익이 개인정보 보호가 필요한 데이터 주체(예. 내담자)의 권리보다 우선할 수 없다고 강조하고 있다. 따라서 내담자의 자료에 접근할 수 있는 LLM 관련 종사자들은 개인정보 보호에 대한 명확한 관리 책임을 가져야 한다.

한편, 비밀 보장은 예외적으로 파기될 수 있다. 특히 내담자의 위기 상황이 그 대표적인 예이다. LLM을 활용한 상담 챗봇이 상담자의 역할을 보조하는 것을 넘어 대체하게 될 경우, 위기 상황 문제는 더욱 신중하게 다루어져야 한다. 예를 들어, 상담 챗봇이 내담자의 자살 사고나 행동 가능성을 탐지할 경우, 프로그램의 대처 수준과 역량이 위기관리에서 핵심 요소가 된다. 이때, 위기 상황의 정도에 따라 인공지능이 과도하게 자율적으로 개입하거나(예. 위기가 아닌 상황에서와 동일하게 대화를 지속함), 소극적으로 대처하는 경우(예. 자살 예방 연락처만 일방적으로 공유하고 내담자의 후속 조치를 확인하지 않은 채 상담을 종료함) 모두 비윤리적일 수 있다. 따라서 LLM은 위기 상황에 대한 역할 범위를 명확히 설정하고, 내담자의 안전을 보장하기 위한 위기 프로토콜을 마련해야 한다.

Ⅳ. 결 론

본 연구는 상담 및 심리치료 분야에 LLM(대규모 언어 모델)을 도입함으로써 예상되는 변화와 논의 사항을 제시하였다. LLM에 대한 기본 이해를 바탕으로, 상담 및 심리치료에서의 적용을 기회와 한계의 양면에서 분석하였다. LLM 도입의 기회를 최대화하고 위협을 최소화하기 위해, 이에 관한 가능성과 한계를 검토한 결과는 다음과 같다. LLM은 상담자의 직무를 지원하는 데 있어 첫째, 대면 상담의 보조 도구로 활용될 수 있으며, 둘째, 수련생의 상담 기술 훈련 및 교육에 기여할 수 있고, 셋째, 다양한 연구 설계와 방법론을 가능하게 한다. 이러한 도입에 따라 상담자는 도메인 전문가로서 고유의 역할을 수행할 수 있다. 즉, 상담자는 LLM의 도입 및 활용 전 과정에서 전문적인 피드백과 평가를 제공하며, 윤리적 지침과 의사결정에 대한 제언을 할 수 있다.

기존 연구는 주로 컴퓨터 과학 분야에서 LLM 개발자의 관점이나 LLM 도입 이전 단계의 인공지능 기술에 집중되어 있었고, 상담 및 심리치료 분야에서 LLM의 적용 사례, 직무 변화, 예상되는 한계와 보완 사항에 대한 구체적인 분석은 부족하였으며, 특히 국내에서는 관련 연구가 드물었다. 따라서 본 연구는 선행 연구와 적용 사례를 바탕으로 LLM 도입에 따른 상담자의 직무 환경 변화, 필요 역량, 그리고 윤리적 고려 사항을 분석한 초기 연구로서 중요한 의의를 지닌다.

그러나 본 연구는 문헌 연구와 사례들을 종합하여 검토하는 데에 중점을 두었기 때문에, LLM 도입과 관련된 주제별 심층 분석과 이를 뒷받침하는 경험적 자료가 필요하다. 또한, LLM 기술이 매우 빠른 속도로 발전하고 있어 이러한 기술 발전이 상담 및 심리치료에 미치는 새로운 영향을 지속적으로 검토할 필요가 있다. 마지막으로, 본 연구는 상담 및 심리치료 종사자의 관점에서만 서술되었다는 한계가 있다. 다양한 관점을 통합한 연구가 향후 중요한 주제가 될 것으로 보이며, 이러한 다학제적 접근은 LLM의 효과적인 활용과 관련된 실제 문제를 해결하는 데 기여할 수 있을 것이다.

LLM의 도입은 상담 및 심리치료 분야에 실무, 교육, 연구 등 다양한 변화를 가져올 것으로 예상된다. 이러한 변화는 상담자의 직무와 역할 변화, 역량 발달, 윤리적 고려 사항에 대한 논의를 촉구할 것이다. LLM의 도입은 상담 및 심리치료의 효율성을 향상시키고 새로운 기회를 제공할 수 있지만, 동시에 윤리적 문제와 기술적 한계를 해결하기 위한 상담자 및 유관 인력의 협력적인 노력이 필요하다. 이를 통해 상담 및 심리치료 분야에서 LLM의 잠재력을 최대한으로 활용하면서도 윤리적 기준 내에서 기술과 인간 중심의 접근이 조화를 이루는 방향으로 나아가기를 기대한다.

References

-

T. Eloundou, S. Manning, P. Mishkin, and D. Rock, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models,” arXiv:2303.1013, , March 2023.

[https://doi.org/10.48550/arxiv.2303.10130]

-

E. C. Stade, S. W. Stirman, L. H. Ungar, C. L. Boland, H. A. Schwartz, D. B. Yaden, ... and J. C. Eichstaedt, “Large Language Models Could Change the Future of Behavioral Healthcare: A Proposal for Responsible Development and Evaluation,” npj Mental Health Research, Vol. 3, No. 1, 12, April 2024.

[https://doi.org/10.1038/s44184-024-00056-z]

-

OpenAI, “GPT-4 Technical Report,” arXiv:2303.08774, , March 2023.

[https://doi.org/10.48550/arXiv.2303.08774]

- American Psychological Association. AI is Changing Every Aspect of Psychology. Here’s What to Watch for [Internet]. Available: https://www.apa.org/monitor/2023/07/psychology-embracing-ai, .

- BBC News Korea. MZ Generations Seeking Mental Health Counseling from AI Chatbots [Internet]. Available: https://www.bbc.com/korean/articles/c4nylqd7p7wo, .

-

D. Demszky, D. Yang, D. Yeager, C. J. Bryan, M. Clapper, S. Chandhok, ... and J. W. Pennebaker, “Using Large Language Models in Psychology,” Nature Reviews Psychology, Vol. 2, pp. 688-701, November 2023.

[https://doi.org/10.1038/s44159-023-00241-5]

-

K. Aafjes-van Doorn, C. Kamsteeg, J. Bate, and M. Aafjes, “A Scoping Review of Machine Learning in Psychotherapy Research,” Psychotherapy Research, Vol. 31, No. 1, pp. 92-116, January 2021.

[https://doi.org/10.1080/10503307.2020.1808729]

-

A. A. Abd-alrazaq, M. Alajlani, A. A. Alalwan, B. M. Bewick, P. Gardner, and M. Househ, “An Overview of the Features of Chatbots in Mental Health: A Scoping Review,” International Journal of Medical Informatics, Vol. 132, 103978, December 2019.

[https://doi.org/10.1016/j.ijmedinf.2019.103978]

-

A. Ahmed, M. Agus, M. Alzubaidi, S. Aziz, A. Abd-Alrazaq, A. Giannicchi, and M. Househ, “Overview of the Role of Big Data in Mental Health: A Scoping Review,” Computer Methods and Programs in Biomedicine Update, Vol. 2, 100076, 2022.

[https://doi.org/10.1016/j.cmpbup.2022.100076]

-

A. Ardimen, D. Dasril, R. Tas’adi, R. Yulitri, D. S. Ramadhani, and D. Rozalina, “Systematic Review Research on Artificial Intelligence in the Counseling Profession,” AIP Conference Proceedings, Vol. 2805, No. 1, 070005, August 2023.

[https://doi.org/10.1063/5.0148809]

-

S. M. Schueller and R. R. Morris, “Clinical Science and Practice in the Age of Large Language Models and Generative Artificial Intelligence,” Journal of Consulting and Clinical Psychology, Vol. 91, No. 10, pp. 559-561, 2023.

[https://doi.org/10.1037/ccp0000848]

-

L. Ke, S. Tong, P. Cheng, and K. Peng, “Exploring the Frontiers of LLMs in Psychological Applications: A Comprehensive Review,” arXiv:2401.01519, , January 2024.

[https://doi.org/10.48550/arXiv.2401.01519]

-

D. Kim, M. K. Cho, and H. Shin, “The Application of Artificial Intelligence Technology in Counseling and Psychotherapy: Recent Foreign Cases,” The Korean Journal of Counseling and Psychotherapy, Vol. 32, No. 2, pp. 821-847, May 2020.

[https://doi.org/10.23844/kjcp.2020.05.32.2.821]

-

Y. Chung, Y. Shin, J. Baek, and S. Yoo, “A Study on Deep Learning Techniques Used in Artificial Intelligence-Based Psychological Counseling Services,” Journal of Learner-Centered Curriculum and Instruction, Vol. 24, No. 3, pp. 109-131, February 2024.

[https://doi.org/10.22251/jlcci.2024.24.3.109]

-

M.-H. Hwang, S.-K. Yoo, I. Jung, and J. You, “Exploration of the Application of Technology in Counselor Training,” Korean Journal of Counseling, Vol. 24, No. 3, pp. 1-28, June 2023.

[https://doi.org/10.15703/kjc.24.3.202306.1]

-

A. Lee, H. C. Kim, M. C. Cha, and Y. G. Ji, “A Study on the Client Experience Using Chatbot Based on Counseling Theory,” Journal of the Ergonomics Society of Korea, Vol. 38, No. 3, pp. 161-175, June 2019.

[https://doi.org/10.5143/JESK.2019.38.3.161]

-

J.-W. Lee, H. Yang, and J.-G. Kim, “Developing Scenario for Implementation of Counseling Chatbot and Verifying Usefulness,” Journal of the Korea Contents Association, Vol. 19, No. 4, pp. 12-29, April 2019.

[https://doi.org/10.5392/JKCA.2019.19.04.012]

-

G. Jang and Y. Seo, “The Counselors’ Perceptions of Psychological Counseling Chatbots,” Korean Journal of Counseling, Vol. 23, No. 6, pp. 17-48, December 2022.

[https://doi.org/10.15703/kjc.23.6.202212.17]

- D. D. Luxton, Artificial Intelligence in Behavioral and Mental Health Care, H. Shin and E. Kim, trans. Seoul: Parkyoung Story, 2020.

-

J. Kaddour, J. Harris, M. Mozes, H. Bradley, R. Raileanu, and R. McHardy, “Challenges and Applications of Large Language Models,” arXiv:2307.10169, , July 2023.

[https://doi.org/10.48550/arXiv.2307.10169]

-

A. Vaswani, N. Shazeer, N. Parmar, J. Uszkoreit, L. Jones, A. N. Gomez, ... and I. Polosukhin, “Attention Is All You Need,” arXiv:1706.03762v5, , December 2017.

[https://doi.org/10.48550/arXiv.1706.03762]

- American Psychological Association. 2023 Work in America Survey: Artificial Intelligence, Monitoring Technology, and Psychological Well-Being [Internet]. Available: https://www.apa.org/pubs/reports/work-in-america/2023-work-america-ai-monitoring, .

-

H. Y. An, S. Y. Rhie, Y. S. Seo, and S. J. An, “Members’ Perceptions of the Korean Counseling Psychological Association’s Current Status and Development Plan Ⅱ: Results of Focus Group Interviews and SWOT Analysis,” The Korean Journal of Counseling and Psychotherapy, Vol. 31, No. 4, pp. 1407-1439, November 2019.

[https://doi.org/10.23844/kjcp.2019.11.31.4.1407]

- S. Kang, J. Lee, and S. Park, Ethical Practices of Non Face-to-Face Counseling and Digital Media Among Counselors: Focusing on Members of the Korean Counseling Psychological Association, In Press.

- M. Hwang, Technology and Future of Counseling, Seoul: Haak-ee-shee-seup, 2021.

- J. Kwon, Cognitive Behavioral Therapy: Principles and Techniques, Seoul: Hakjisa, 2020.

-

H. Na, “CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-Based Mental Health Question Answering,” arXiv:2403.16008, , March 2024.

[https://doi.org/10.48550/arXiv.2403.16008]

-

R. K. Maurya, “A Qualitative Content Analysis of ChatGPT’s Client Simulation Role-Play for Practising Counselling Skills,” Counselling and Psychotherapy Research, Vol. 24, No. 2, pp. 614-630, June 2024.

[https://doi.org/10.1002/capr.12699]

- Lyssn. Does Lyssn Use Generative AI? [Internet]. Available: https://www.lyssn.io/does-lyssn-use-generative-ai/, .

-

K. M. Peavy, A. Klipsch, C. S. Soma, B. Pace, Z. E. Imel, M. J. Tanana, ... and D. C. Atkins, “Improving the Quality of Counseling and Clinical Supervision in Opioid Treatment Programs: How Can Technology Help?,” Addiction Science & Clinical Practice, Vol. 19, 8, 2024.

[https://doi.org/10.1186/s13722-024-00435-z]

-

A. O. Ajlouni, A. S. Almahaireh, and F. A.-A. Whaba, “Students’ Perception of Using ChatGPT in Counseling and Mental Health Education: The Benefits and Challenges,” International Journal of Emerging Technologies in Learning, Vol. 18, No. 20, pp. 199-218, October 2023.

[https://doi.org/10.3991/ijet.v18i20.42075]

-

D. Atzil-Slonim, A. Eliassaf, N. Warikoo, A. Paz, S. Haimovitz, T. Mayer, and I. Gurevych, “Leveraging Natural Language Processing to Study Emotional Coherence in Psychotherapy,” Psychotherapy, Vol. 61, No. 1, pp. 82-92, 2024.

[https://doi.org/10.1037/pst0000517]

-

Y. Li, Y. Huang, H. Wang, X. Zhang, J. Zou, and L. Sun, “Quantifying AI Psychology: A Psychometrics Benchmark for Large Language Models,” arXiv:2406.17675, , June 2024.

[https://doi.org/10.48550/arXiv.2406.17675]

- G. Corey, M. S. Corey, and C. Corey, Issues and Ethics in the Helping Professions, 11th ed. Pacific Grove, CA: Brooks/Cole, 2024.

- European Parliament and Council of the European Union, Regulation (EU) 2016/679 of the European Parliament and of the Council of 27 April 2016 on the Protection of Natural Persons with regard to the Processing of Personal Data and on the Free Movement of Such Data, and Repealing Directive 95/46/EC (General Data Protection Regulation), Author, Brussels, Belgium, May 2016.

- Information Commissioner’s Office, Big Data, Artificial Intelligence, Machine Learning and Data Protection, Author, Cheshire, UK, September 2017.

저자소개

2015년:가톨릭대학교 심리학과 상담심리전공 (문학석사)

2022년:가톨릭대학교 심리학과 상담심리전공 (문학박사)

2023년~2023년: University of Denver 박사후연구원

2020년~현 재: ㈜상담사그룹서로오롯 대표상담사 및 이사

2022년~현 재: 가톨릭대학교 상담심리대학원 강사

2024년~현 재: 연세대학교 교육대학원 강사

※관심분야:변화하는 시대에 따른 상담자 윤리, 다문화 사회정의 상담 교육, 다문화 지향