GAN 및 React Native 기반의 웹툰 스타일 이미지 편집 애플리케이션 개발

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

기존 이미지 편집 모바일 애플리케이션(application) 시장에서는 사진에 필터링을 적용하여 웹툰 풍의 이미지를 구현하는 애플리케이션은 많았으나, 직접 사진을 기반으로 웹툰을 제작할 수 있는 애플리케이션은 없었다. 본 논문에서는 다양한 이미지 편집 기능을 제공하면서 동시에 SNS 플랫폼과 통합된 웹툰 스타일 이미지 편집 애플리케이션을 제안한다. 제안하는 애플리케이션은 딥러닝 기술을 활용하여 매년 폭발적으로 성장하는 웹툰 시장의 콘텐츠와 지적 재산권을 기반으로 새로운 디지털 콘텐츠를 생성한다. 더불어, 사용자들은 자신만의 웹툰 콘텐츠를 생산하고 SNS 플랫폼에서 쉽고 재밌게 공유하는 기회를 얻는다.

Abstract

In the existing image-editing mobile application market, there are several applications that implement webtoon-style images by applying filtering to photos, but there are no applications that can directly produce webtoons based on photos. In this study, we propose a webtoon-style image-editing application integrated with the Social Network Service (SNS) platform while providing various image-editing functions. The proposed application utilizes deep-learning technology to create new digital content based on content and intellectual property rights in the webtoon market, which grows significantly every year. In addition, users have the opportunity to create their own webtoon content and easily share it on SNS platforms for enjoyment.

Keywords:

Deep Learning, Face Synthesis, Generative Adversarial Network, React Native, Webtoon키워드:

딥러닝, 얼굴 합성, 생성적 적대 신경망, 리액트 네이티브, 웹툰Ⅰ. 서 론

한국문화콘텐츠진흥원의 “2022년 웹툰 사업체 실태조사”에 따르면 2020년 국내 웹툰 시장 규모는 약 1조 538억원으로 사상 처음으로 매출 규모 1조원을 돌파하였고, 웹툰 산업의 매출 규모는 매년 30% 이상의 증가율을 기록하며 콘텐츠 산업 중에서도 가장 가파른 성장세를 보이고 있다[1]. 2021년 웹툰 플랫폼의 총매출 추정액은 8,241억으로, 이는 2020년 대비 58.8% 성장하였고, 웹툰 플랫폼들의 총 매출 추정금액은 2022년 기준 약 1조 5660억원으로, 이는 2020년의 1조 538억 대비 48.6% 성장하여, 웹툰 시장에 대한 관심이 점차 높아지고 있다[2]. 나스미디어의 ‘2021 인터넷 이용자 조사 보고서’에 따르면 인터넷 이용자 중 78.7%가 Social Networking Service (SNS) 이용자이며, 10대부터 60대까지 높은 SNS 이용률을 보인다[3]. 또한, 정보통신정책연구원의 STAT Report에 따르면, SNS 이용률이 2019년 47.7%, 2020년 52.4%, 2021년 55.1%로 꾸준히 증가하는 것을 확인할 수 있다[4]. 따라서, 성장률이 높아 밝은 전망을 보이는 두 디지털 분야인 SNS와 웹툰이 결합한다면 큰 시너지가 일어날 것으로 예상할 수 있지만, 웹툰과 SNS를 접목한 플랫폼의 사례는 웹툰 제작의 진입장벽으로 인해 존재하지 않았다. 또한, 누구나 손쉽게 만들 수 있는 사진 기록물을 웹툰으로 변환하여 공유할 수 있는 SNS 역시 존재하지 않았다. 기존 시장에서는 다양한 사진을 웹툰 화풍으로 변환시켜주는 애플리케이션 사례가 존재하였으나, 웹툰화가 아닌 웹툰 화풍으로의 변환이라는 한계가 있었다. 본 논문에서는 생성적 적대 신경망(GAN; Generative adversarial network)을 이용하여 사진을 웹툰화 하였고, 이를 직접 모바일 애플리케이션을 통한 사진 편집 기반 웹툰 플랫폼을 직접 구현하여 웹툰의 Intellectual property (IP)를 재생산하는 디지털 콘텐츠를 개발하였다.

II절에서는 등장 배경 및 기존 사례에 대해서 조사한다. III절에서는 GAN의 이론적 배경 및 이미지 편집 모델을 소개하고, 해당 애플리케이션으로의 응용 방법을 제시한다. IV절에서는 애플리케이션 설계 및 구현 과정에 대해 소개하고, 웹툰 기반 SNS 플랫폼으로의 구현 과정을 제시한다. V절에서는 결론 및 기대효과를 서술한다.

Ⅱ. 선행 연구 분석

본 장에서는 기존 시장에 존재하는 사진을 웹툰 풍으로 변환시켜주는 서비스, 사진과 관련된 웹툰, 사진 편집 사례 등을 소개하고, GAN을 기반으로 한 이미지 편집 기술들의 업계 동향 및 전망에 대하여 서술한다.

2-1 이미지 편집 애플리케이션

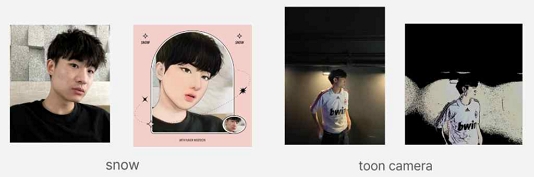

기존 시장에서는 Snow와 같은 애플리케이션 사례들에서 웹툰 풍 이미지 필터 기능을 제공하거나, Clip studio와 같은 전문적인 프로그램에서 만화 기능을 제공하는 형태로 구현되어 있다. Snow는 여신강림이라는 웹툰의 이미지 필터를 제공하고 있고, Clip studio는 컴퓨터, 태블릿, 스마트폰으로 일러스트, 만화, 애니메이션 등을 제작하는데 필요한 다수의 기능을 제공하고 있다. 다른 예시로 Toon camera와 ToonMe가 있다. Toon camera는 이미지를 만화로 변환하는 애플리케이션으로, 30가지 이상의 만화 효과를 제공하며, 각 효과는 선의 두께, 색상, 음영, 스타일 등 다양한 설정을 조정할 수 있다. ToonMe는 인공지능을 기반으로 이미지를 웹툰 풍으로 바꿔주는 애플리케이션으로, 이미지의 얼굴을 웹툰 캐릭터로 변환하는 웹툰 효과, 웹툰 캐릭터의 스타일을 선택할 수 있는 스타일, 이미지 색상 선택, 이미지 필터 적용 스티커를 추가할 수 있는 기능을 제공하지만, 이미지의 배경을 바꾸는 기능은 제공하지 않는다. 그림 1에서 여신강림 웹툰의 이미지 필터 처리된 Snow의 사례와 이미지를 만화로 변환한 Toon camera의 사례를 확인할 수 있다.

하지만 위의 사례들은 모두 공통적으로 논문의 주제와 같이 SNS 형태로 서로의 창작물을 공유하는 사례는 현재까지 존재하지 않았으며, 업계 웹툰과 자신들의 서비스를 결합하여 웹툰을 만들거나, 사진을 찍을 때, 웹툰 풍으로 보이도록 바꾸는 효과만을 제공하고 있다는 차이점을 보인다. 그러나, 서론에서 소개한 것과 같이 웹툰 시장 규모는 매년 30% 이상의 성장률을 보이며, SNS 분야 역시 매년 이용률이 증가하고 있으므로, 새로운 디지털 콘텐츠의 분야를 열 수 있다는 가능성이 있다.

2-2 GAN 기반 이미지 편집

이미지 편집을 구현하기 위해 GAN이 많이 사용되고 있고, 다음과 같은 사례들을 소개한다. 이미지 편집 애플리케이션의 사례로는 통합형 취업 사진을 생성하는 애플리케이션[5]이 있다. 이 애플리케이션의 경우 starGAN-V2[6]를 이용하여 헤어스타일과 정장, 인상을 합성한 얼굴 이미지를 생성하고 보정 및 배경을 합성할 수 있다. 웹툰의 배경 이미지를 생성하는 사례도 있었는데[7], 공개된 배경 이미지를 학습 데이터로 이용하고 카툰(Cartoon) 스타일 이미지 생성에 효과적인 CartoonGAN[8]과 부드러운 그림체와 정확한 색 변환 등의 특징으로 애니메이션 스타일에 특화된 AnimeGAN[9]을 같이 사용하였다. 비슷하게, 벽지 인테리어의 시뮬레이션을 제공하는 사례가 있었고[10], CycleGAN[11]을 사용하여 다양한 모양의 벽지가 사용된 인테리어 이미지 데이터를 기반으로 모델을 학습하여, 사용자에게 짧은 시간 내에 벽지 인테리어 시뮬레이션을 제공하였다. GAN을 이용해 한복을 디자인한 사례도 있었는데[12], 윤곽 이미지로부터 한복 이미지를 생성하는 스타일 전이(Style transfer)[13] 방법을 통해 윤곽 이미지에서 새로운 디자인의 한복이미지를 생성하였다. 생성된 한복 디자인은 기본적인 디자인뿐만 아니라 새로운 무늬나 색의 변화가 있는 옷고름도 가질 수 있었다. 게임 업계에서는 2D 애니메이션 배경을 생성하기 위해 GAN을 사용하고 있었고[14], 마찬가지로 스타일 전이 모델을 사용하여 이미지 생성 시 제작자가 화풍과 구성 요소를 직접 편집할 수 있도록 하는 프레임워크를 제공하였다.

본 논문에서 구현한 모바일 애플리케이션은 이미지를 특정 화풍의 이미지로 변환하기 위해 기술적으로 GAN이 사용되었고, GAN을 통하여 이미지 편집 모델을 구현하였다. GAN에 관한 내용은 III절에서 자세히 소개한다.

Ⅲ. GAN의 이론적 배경 및 이미지 편집 모델 적용

이미지를 웹툰 풍으로 변환하는 최선의 필터링 결과를 위하여 다양한 연구를 진행하였고, 다양한 GAN 모델들에 대하여 최적의 결과를 얻을 수 있었다. 이를 통해, 웹툰에 나오는 것과 같은 화풍의 사진 필터 기능에 대하여 백엔드 프로그램 구조를 작성하였다.

3-1 GAN의 이론적 배경

GAN은 미분 가능 생성자에 기초한 생성 모형화 접근 방식의 인공지능 모델이다[15]. 두 신경망을 기반으로 하여 판별자망(Discriminator network)은 훈련 집합에서의 표본과 생성 집합에서의 표본을 구분하며, 생성자망(Generator network)은 표본을 생성하여 표본과 구분되지 못하는 표본을 생성하는 것을 목표로 한다.

본 논문의 프로젝트에서는 다양한 GAN 모델 중에서 AnimeGAN[9]을 사용하였다. AnimeGAN은 기존 다른 필터링 GAN들의 문제점이었던 원본의 이미지 대신 원본 이미지들의 내용으로 대체된다는 문제점을 해결한 모델로, 실제 사용의 경우 https://github.com/TachibanaYoshino/AnimeGAN에서 모델을 확인하여 직접 사용할 수 있다.

AnimeGAN과 비슷한 모델로는 ComixGAN[16]과 CartoonGAN[8]이 있다. ComixGAN은 AnimeGAN과 동일한 판별자 구조를 가지고 있으며, Common Objects in Context (COCO) 데이터셋과 약 1000개의 만화 장면을 추출하여 학습시켰다. CartoonGAN의 경우, ComixGAN과 같은 신경망 구조와 손실 함수를 가졌으나 ComixGAN과 다르게 4,573개의 만화 이미지와 4,212개의 짧은 만화 동영상을 학습하였다. 그러나 ComixGAN은 원본 이미지의 색상을 쉽게 덮어씌우는 문제가 있었고, CartoonGAN은 원본 이미지의 색상을 저하시키는 문제가 존재하여 본 논문에서는 AnimeGAN 모델을 채택하였다. 또한, AnimeGAN의 파라미터 수는 CartoonGAN 및 ComixGAN의 파라미터 수인 12,253,152에 비해 큰 폭으로 낮은 3,956,096개이며, 모델 크기 역시 CartoonGAN 및 ComixGAN의 모델 사이즈인 46.74M에 비해 15.09M으로 약 3배 적으며, 필터링 시간 역시 CartoonGAN 및 ComixGAN은 이미지당 추론 시간이 51ms/image인 것에 비해 43ms/image로, 비교적 빠르게 필터링 할 수 있었다[9]. 따라서 최종 모델로 AnimeGAN 모델을 선택하였다.

3-2 GAN을 통한 이미지 편집 모델 적용

본 논문에서 GAN은 필터링 모델을 이용하여 사진을 웹툰 풍으로 만들기 위하여 사용하였다. 본 절에서는 GAN을 이용하여 프로젝트 상에서 필터링 모델을 학습시키고, 실제 프로젝트 내부에 적용시킨 과정을 서술한다.

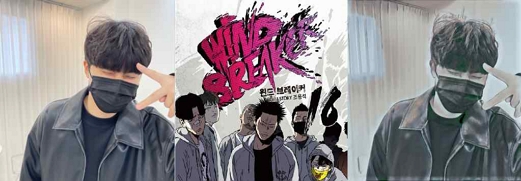

프로젝트 상에서 사용할 인공 신경망 모델을 선정한다. 해당 과정에서는 신경망 모델에 사용할 사전 학습된 모델(pre-trained model)이 제공될 시에, 전이 학습(transfer learning)을 진행할 수 있다. 프로젝트 상에서는 AnimeGAN 파이토치 이식 버전의 지브리 스타일로 사전 학습된 모델을 사용하였다. 그림 2에서, AnimeGAN을 통하여 사진이 웹툰 풍으로 생성이 된 것을 확인할 수 있다.

프로젝트 상에서 사용된 모델에는 다양한 이미지를 이용하여 모델을 학습하였다. 전처리 과정으로 이미지의 불필요한 부분들을 우선 제거하였고, 이미지의 크기를 모델에서 요구하는 이미지 크기로 변환한 후 학습을 진행하였다. 이미지의 경우, 파이썬 기반으로 크롤링 프로그램을 작성하여, 웹툰의 이미지를 수집하였다. 크롤링한 이미지는 이후 전처리하였고, 전처리된 이미지를 바탕으로 프로젝트 모델의 학습을 진행하였다. 학습에는 학습률(Learning rate)과 같은 다양한 하이퍼파라미터들이 존재하며, 해당 파라미터들을 판단 하에 적절히 수정하여 최적의 모델을 얻는다.

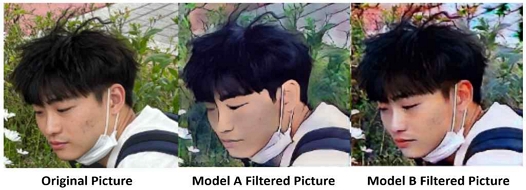

학습이 완료된 모델의 경우 직접 확인을 통해 학습 중 주기적으로 체크포인트를 만들었고, 체크포인트 별 테스트 결과를 저장 후 원본과 비교하여 과적합이나 과소적합을 확인하였다. 실제 서비스 적용이 가능하다고 판단된 모델을 최종 모델로 선정하였고, 모델 실행 이후 필터링이 적용된 사진을 Firebase에 전송하였다. 그림 3은 필터링을 적용한 이후의 사진이다. 하이퍼파라미터를 조절하여 좀 더 웹툰 풍의 그림이 생성하도록 모델을 학습하였다. 애플리케이션 내부에서는 모델을 사용자가 선택하여, 서로 다른 웹툰의 이미지를 합성시킨 Model A나 Model B와 같은 서로 다른 웹툰 풍으로 필터링 된 이미지를 이용하여 웹툰을 만들 수 있다.

본 논문에서 구현한 GAN 기반의 이미지 편집 모델을 사용해볼 수 있도록 데모페이지를 제작하였고, 활용법 및 코드의 경우 Github의 위키 페이지에서 확인이 가능하다.

Ⅳ. 모바일 애플리케이션 설계 및 구현

본 절에서는 해당 프로그램의 설계 및 구현 과정을 서술한다.

4-1 모바일 애플리케이션 구현

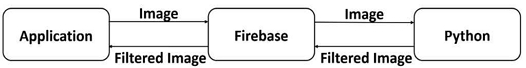

구현한 프로그램의 구조는 그림 4와 같이 애플리케이션 클라이언트, 파이어베이스 데이터베이스, 그리고 파이썬 서버, 3개의 구조로 이루어진다. 애플리케이션 클라이언트는 사용자와의 상호작용을 담당한다. 사용자가 이미지 웹툰 풍 필터링을 선택하면 애플리케이션 클라이언트에서 파이어베이스 데이터베이스로 해당 이미지가 전송된다. 파이썬 서버는 이를 자동으로 감지해, GAN 모델을 통하여 해당 이미지에 필터를 적용시킨다. 필터가 적용된 이미지는 다시 파이어베이스 데이터베이스를 거쳐 애플리케이션 클라이언트로 전송한다. 이후 사용자는 애플리케이션 클라이언트에서 필터가 적용된 자신의 사진을 확인할 수 있으며, 해당 사진을 이용하여 이미지를 제작할 수 있다.

필터링을 진행하기 위해 임시적으로 파이어베이스 데이터베이스에 저장되어 있던 원본 이미지는 효율적인 용량 관리를 위해 필터링 작업이 완료된 이후 데이터베이스에서 삭제한다. 파이어베이스 데이터베이스에는 필터링 작업을 위한 이미지 뿐 아니라 유저 정보, 유저 간 팔로우 기록, 편집이 완료된 최종 이미지 등 애플리케이션을 동작하기 위한 모든 데이터들이 저장된다.

4-2 웹툰 스타일 이미지 편집 애플리케이션 개발 결과

본 논문에서 구현한 모바일 애플리케이션의 클라이언트는 페이스북이 개발한 모바일 애플리케이션 프레임워크인 리액트 네이티브(react-native)를 기반으로 크로스-플랫폼 애플리케이션 형태로 개발하였다. 크로스-플랫폼 애플리케이션이란 하나의 개발 언어로 안드로이드와 Internetwork Operating System (iOS)에서 모두 사용할 수 있는 애플리케이션 형태를 말한다. 본 애플리케이션은 사용자 수가 중요한 SNS 플랫폼으로, 안드로이드와 iOS 두 가지 다른 운영체제를 사용하는 사용자를 모두 수용하는 것이 중요하다. 따라서 본 애플리케이션을 크로스-플랫폼 형태로 개발함으로써 각 운영체제용 네이티브 애플리케이션을 별도로 개발하는 것보다 시간적 효율성을 높일 수 있었다. 리액트 네이티브는 웹을 기반으로 한 프레임워크이지만 기존의 웹을 기반으로 한 애플리케이션과는 다르게 각 운영체제의 네이티브 User Interface (UI) 컴포넌트를 사용할 수 있어 보다 최적화된 사용자 경험을 제공한다.

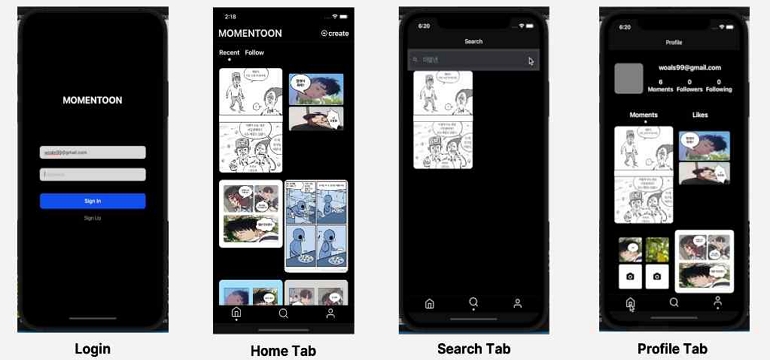

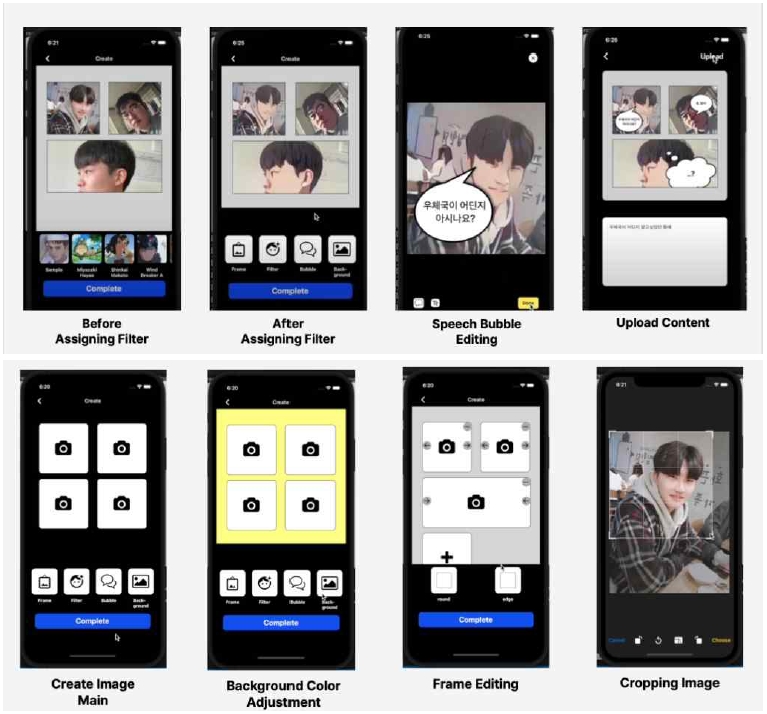

해당 프로젝트의 주 기능 중 하나인 웹툰 기반의 SNS 플랫폼 기능으로는 그림 5와 같이, 로그인 및 검색, 프로필 기능을 구현하였으며, 전체적인 인터페이스는 인스타그램과 비슷하다. 사용자는 모바일 애플리케이션을 통해 웹툰 스타일 이미지를 생성하고, 다른 유저가 생성한 이미지들과 프로필을 조회할 수 있으며, 유저 간 팔로우 역시 가능하다.

해당 프로젝트의 다른 핵심 기능인 사진 기반의 웹툰 제작 기능의 구현은 그림 6과 같다. 사용자는 웹툰의 컷 크기를 원하는 대로 설정이 가능하고, 사용하고자 하는 사진을 선택하게 되면 해당 사진은 파이어베이스와 연동된 프로그램을 이용하여 필터링 후 사용자에게 돌아온다. 또한, 사용자는 말풍선을 넣는 효과를 원하는 위치에 설정할 수 있고, 제작 중인 웹툰의 배경색 역시 원하는 색으로 설정할 수 있다. 사용자의 변경사항으로 인한 결과를 즉각적으로 확인할 수 있고, 웹툰의 완성도를 높이면서 원하는 형태의 웹툰을 만들 수 있다. 이러한 UI 및 User Experience (UX) 구조를 채용함으로서 벤 슈나이더만의 황금률 규칙을 충족할 수 있는데[17], 그 중에서 유용한 피드백 규칙과 권한 부여 규칙이 해당할 수 있다. 즉각적으로 사용자의 취향에 맞게 원하는 대로 바꿔지는 사용자만의 만화를 통해서 유용한 피드백 규칙을 충족할 수 있고, 이는 사용자가 만족감과 성취감을 얻게 한다. 자신의 사진을 기반으로 웹툰을 생성하고 완성도를 높일 수 있기 때문에 권한 부여 규칙 또한 충족할 수 있고, 이는 사용자들에게 웹툰을 만들고자 하는 동기부여를 제공할 수 있다. UI/UX 디자인 요소는 사용자들의 만족도와 연관이 되어 있다는 연구[18] 역시 존재하므로, 많은 사용자들이 요구되는 SNS 플랫폼에게 있어 결코 무시할 수 없는 요소들 중 하나이다.

V. 결 론

본 논문에서는 해당 모바일 애플리케이션을 구현함으로써 현재까지 구현되지 않았던 주제인 웹툰과 SNS를 결합한 플랫폼의 가능성을 확인하였다. 본 플랫폼이 상용화된다면 사용자는 사진을 웹툰 형식으로 재창작하는 새로운 경험을 할 수 있다. 웹툰 이해관계자의 경우에도 다양한 웹툰과의 협업을 통하여 필터링 모델을 만든 후, 웹툰의 화풍을 적용하는 필터링 모델을 만들어 원본 웹툰을 홍보할 수 있다.

본 애플리케이션은 주 기능으로 시중의 웹툰 콘텐츠 이미지 필터를 제공하기 때문에 웹툰 저작권자와의 라이선스 계약이 필수적이다. 웹툰 필터 추가 시 해당 웹툰의 저작권자에게 필터 추가 비용을 받을 수도 있지만, 인기 웹툰의 경우 라이선스 계약을 위해 역으로 저작권자에게 막대한 비용을 지불 할 수 있다는 위험요소도 고려해야 한다. 또한, 일부러 인체비율을 뭉개는 형태인 캐리커처 형식이나 데포르메 및 웹툰 상에서 가능한 다양한 비현실적인 연출과 같은 과장된 요소들의 경우 현실의 사진으로는 물리적으로 연출이 불가능하다는 한계가 있다. 따라서 사용자가 직접 창작한 만화로만 게시물을 공유할 수 있는 방식은 본 애플리케이션만의 개성으로 부각될 수 있으나, 더욱 다양한 형식의 게시물을 공유할 수 있는 기존 SNS 플랫폼에 비해 다양성이 부족하다는 한계는 존재한다.

본 애플리케이션은 유저가 직접 이미지 콘텐츠를 창작하고 자유롭게 공유할 수 있어 SNS 상에서 자연스럽게 서비스를 홍보하고 신규 유저를 유입시킬 수 있다는 장점이 있다. 유입된 유저들을 지속적으로 붙잡기 위해서 초기에 최대한 많은 웹툰과 라이선스를 맺어 점유율을 확보하고, 웹툰 형태의 이미지를 공유하는 SNS 플랫폼의 독특한 아이덴티티를 확립해 충성고객을 확보할 수 있다.

향후 연구로는 GAN 모델 뿐만 아니라 Stable Diffusion[19]과 같은 다른 이미지 생성 딥러닝 모델을 사용해 이미지 필터 성능 향상을 시도할 수 있으며, 작성된 웹툰을 기반으로 검색이 용이하도록 키워드를 생성해 주거나, 자동으로 추천해 주는 시스템을 개발할 수 있다. 또한, 백엔드 구조를 변경하여 웹 사이트 형태로 아키텍처를 구성하여 직접적인 SNS 형태가 가능하도록 할 수 있다.

https://github.com/Momentoon에서, 해당 논문에서 구현한 코드와 사용법을 확인할 수 있다.

Acknowledgments

이 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. RS-2022-00166875).

이 논문(보고서)은 2023년도 가천대학교 교내연구비 지원에 의한 결과임(GCU-202300670001).

References

- S. H. Lim, H. Y. Kim, S. J. Park, and S. H. Jung, 2022 Webtoon Business Survey, Korea Creative Content Agency, Naju, KOCCA 22-19, p. 9, December 2022.

- S. H. Lim, H. Y. Kim, S. J. Park, and S. H. Jung, 2022 Webtoon Business Survey, Korea Creative Content Agency, Naju, KOCCA 22-19, p. 141, December 2022.

- Nas Media. 2021 Internet User Report NPR [Internet]. Available: https://www.nasmedia.co.kr/NPR/2021/, .

- KISDI(Korea Information Society Development Institute). Social Network Service(SNS) Usage Behavior by Generation [Internet]. Available: https://www.kisdi.re.kr/report/view.do?key=m2101113025790&masterId=4333447&arrMasterId=4333447&artId=659156, .

-

J.-Y. Kang, S.-H. Kim, S.-Y. Kim, and K.-M. Lee, “Application to Generate a Consolidated ID Photo for Resume Using Deep Learning,” Journal of Digital Contents Society, Vol. 22, No. 12, pp. 1951-1958, December 2021.

[https://doi.org/10.9728/dcs.2021.22.12.1951]

-

Y. Choi, Y. Uh, J. Yoo, and J.-W. Ha, “StarGAN v2: Diverse Image Synthesis for Multiple Domains,” in Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle: WA, pp. 8185-8194, June 2020.

[https://doi.org/10.1109/CVPR42600.2020.00821]

-

J.-K. Lee, J.-G. Kim, J.-I. Ahn, J.-Y. Lim, and K.-A. Cha, “Generation and Analysis of Webtoon Background Images Using GAN,” Journal of Korea Multimedia Society, Vol. 26, No. 8, pp. 1075-1085, August 2023.

[https://doi.org/10.9717/kmms.2023.26.8.1075]

-

Y. Chen, Y.-K. Lai, and Y.-J. Liu, “CartoonGAN: Generative Adversarial Networks for Photo Cartoonization,” in Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City: UT, pp. 9465-9474, June 2018.

[https://doi.org/10.1109/CVPR.2018.00986]

-

J. Chen, G. Liu, and X. Chen, “AnimeGAN: A Novel Lightweight GAN for Photo Animation,” in Proceedings of the 11st International Symposium on Intelligence Computation and Applications (ISICA 2019), Guangzhou, China, pp. 242-256, November 2019.

[https://doi.org/10.1007/978-981-15-5577-0_18]

-

S.-H. Kim, Y.-H. Kim, and S.-Y. Kim, “A Cycle GAN-Based Wallpaper Image Transformation Method for Interior Simulation,” Journal of the Korea Institute of Electronic Communication Sciences, Vol. 18, No. 2, pp. 349-354, April 2023.

[https://doi.org/10.13067/JKIECS.2023.18.2.349]

-

J.-Y. Zhu, T. Park, P. Isola, and A. A. Efros, “Unpaired Image-to-Image Translation Using Cycle-Consistent Adversarial Networks,” in Proceedings of IEEE International Conference on Computer Vision (ICCV), Venice, Italy, pp. 2242-2251, October 2017.

[https://doi.org/10.1109/ICCV.2017.244]

- Y. Jeong, K. C. Kim, and C.-B. Sohn, “A Hanbok Design Using Generative Adversarial Network,” Design Research, Vol. 4, No. 3, pp. 22-29, September 2019.

-

L. A. Gatys, A. S. Ecker, and M. Bethge, “Image Style Transfer Using Convolutional Neural Networks,” in Proceedings of IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas: NV, pp. 2414-2423, June 2016.

[https://doi.org/10.1109/CVPR.2016.265]

-

J. S. Byun, S.-M. Song, E.-K. Hwang, S.-W. Park, and J.-W. Kim, “A Framework for Efficient 2D Animation Background Generation Using GAN-Based Artificial Intelligence in Game Development,” Journal of the Korea Contents Association, Vol. 23, No. 8, pp. 10-18, August 2023.

[https://doi.org/10.5392/JKCA.2023.23.08.010]

- I. Goodfellow, Y. Bengio, and A. Courville, Deep Learning, Cambridge, MA: MIT Press, p. 779, 2016.

-

M. Pęśko, A. Svystun, P. Andruszkiewicz, P. Rokita, and T. Trzciński, “Comixify: Transform Video into a Comics,” Fundamenta Informaticae, Vol. 168, No. 2-4, pp. 311-333, September 2019.

[https://doi.org/10.3233/FI-2019-1834]

- University of Maryland. The Eight Golden Rules of Interface Design [Internet]. Available: https://www.cs.umd.edu/users/ben/goldenrules.html, .

- D. H. Yun, A Study on the Effects of UX Design on a Mobile Platform to Users -Focused on SNS Applications-, Master’s Thesis, Hanyang University, Seoul, August 2019.

-

R. Rombach, A. Blattmann, D. Lorenz, P. Esser, and B. Ommer, “High-Resolution Image Synthesis With Latent Diffusion Models,” in Proceedings of IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans: LA, pp. 10674-10685, June 2022.

[https://doi.org/10.1109/CVPR52688.2022.01042]

저자소개

2018년~현 재: 가천대학교 인공지능·소프트웨어학과 소프트웨어전공 학사과정

2018년~현 재: 가천대학교 인공지능·소프트웨어학과 소프트웨어전공 학사과정

2018년~현 재: 가천대학교 인공지능·소프트웨어학과 소프트웨어전공 학사과정

2013년:포항공과대학교 산업경영공학과 (공학사)

2019년:서울대학교 산업공학과 (공학박사)

2019년~2022년: 에프앤가이드 전임연구원

2022년~2023년: 한양대학교 산업공학과 조교수

2023년~현 재: 가천대학교 AI소프트웨어학부 조교수

※관심분야:데이터 사이언스, 금융공학