머신러닝을 이용한 거북목 심각도 측정

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

거북목 증후군은 한국의 사무직 종사자의 대다수가 가벼운 수준 이상을 겪고 있는 대표적인 증후군이다. 책과 컴퓨터를 많이 보게 됨에 따라 10대 청소년의 거북목 증후군 비율 또한 늘어나고 있는 상황이다. 이에 따라 병원에서의 대면 방문 진단을 하게 되면 비용이나 시간이 소요된다. 이에 대한 편리성을 개선하고자 즉석으로 거북목에 대한 심각도를 측정할 수 있는 거북목 증후군 측정 프로그램을 제안한다. 제안한 방법은 직접 찍은 사용자의 측면 이미지를 바탕으로 Yolov3의 Object detection을 바탕으로 이미지의 사람 수를 계산한다. Open pose 라이브러리의 MP2 모델과 COCO 모델을 사용하여 관절의 좌표를 검출한다. 검출한 관절 좌표 중 3개의 Point에 대한 좌표를 통해 제2 cos법칙을 적용하여 목의 각도를 구한다. 세분화한 심각도 기준에 의해 산출한 목의 각도에 대해 심각도를 사용자에게 제공한다.

Abstract

Turtle neck syndrome is a representative syndrome from which the majority of office workers in Korea suffer, displaying more than mild symptoms. As more books and computers are being read, the rate of turtle neck syndrome among teenagers is also increasing. However, face-to-face diagnoses made at a hospital, incur cost and time. To address this inconvenience, we propose a turtle neck syndrome measurement program that can instantly measure the severity of turtle neck from a side image of the user. Joint coordinates are detected using the MP2 and COCO models of the OpenPose library. Among the detected joint coordinates, the angle of the neck is obtained by applying the second cos law to the coordinates of the three points that are easy to calculate. The severity of the neck angle calculated by the subdivided severity criteria is then provided to the user.

Keywords:

Turtle Neck Syndrome, Open Pose, Object Detection, Angle Calculation, Severity Measurement키워드:

거북목 증후군, 오픈 포즈, 객체 인식, 각도 계산, 심각도 측정Ⅰ. 서 론

최근 남녀노소의 컴퓨터 사용량이 높아짐에 따라, 거북목 증후군을 겪는 사람들이 비약적으로 증가하고 있다. 거북목 증후군을 예방하기 위해서는 자신의 생활 습관을 통한 교정이 필요한데, 생활 습관 교정을 위해서 자신의 거북목의 심한 정도를 인식할 필요가 있고, 이에 따라 교정 방식을 달리 진행해야 한다. 하지만 거북목의 심한 정도를 파악하기 위해 드는 시간적, 금전적 비용이 발생하므로, 일반 사용자들이 이를 직접적으로 확인하기가 쉽지 않다.

이를 해결하기 위해 해당 프로그램에서는 사용자로부터 사진을 직접 전달받아 즉각적인 측정 결과를 알려준다. 가장 먼저 사용자로부터 전달받은 측면 사진을 이용하여 사진의 사람의 수를 계산한다. 방향에 따라 자세히 분석을 진행하여 Pointing을 추출한다. 추출한 Pointing을 바탕으로 전달받은 사용자의 정보에 대한 목의 각도를 계산함으로써, 해당 사용자 거북목 심각성을 판단하여 결과를 출력한다. 이를 통하여 사용자는 자신의 목 건강에 대한 체크를 어려움 없이 간편하게 측정할 수 있다.

Ⅱ. 관련연구

사람의 위치를 정확하게 단정하기 위하여 Detection 방법중 하나인 Yolo V3 [1] 를 이용한다. Yolo 는 타 Detection method 와 다르게, Object를 할당하는 과정에서 단 하나의 Anchor box를 할당한다. 따라서 가장 정확성이 높은 Object에 대하여 Overlap이 적게 찾아낸다. Yolo의 model은 Backbon에 Residual block과 Darknet에 통합한 Darknet 53을 사용하고 있다. 또한 Yolo v3는 물체를 3가지 종류의 크기의 output을 도출할 수 있도록 FPN을 사용하여 네트워크의 설계를 진행한다. Yolo v3의 loss를 계산하기 위해서는 Anchor boxes와, Ground truth을 이용한다. Anchor boxes는 pre-define된 object를 탐지하기 위해 존재하는 box이며, 크기에 따라 small, medium 그리고 box로 구성된다. 이는 coco에 대한 clustering으로 9개의 anchor을 구성하였다고 할 수 있다. Ground truth는 detection에서 정답에 해당하는 annotation 정보를 parsing하여 원하는 방식대로 class와 location을 가져올 수 있도록 한다. Anchor box와, Ground truth를 바탕으로 loss를 계산하여 classification과 location regression을 진행한다.

OpenPose[2]는 Human Pose Estimation의 한 분야로 사진 정보를 이용하여 사람의 관절 및 자세한 정보의 위치를 정확하게 예측하는 것이다. OpenPose는 신체의 특징점 (관절) 을 추론한 뒤에, 해당 점들을 이어 그림을 표시해주는 방식으로 진행된다. 이 중에 우리가 사용한 것은 출력되는 관절의 개수가 15개인 MPII를 사용한다.

OpenPose의 딥러닝 네트워크로는 VGG-19를 사용한다. 따라서 이미지가 VGG-19로 들어간 뒤에, Convolution Layer와 Pooling Layer을 거쳐 특징맵(Feature Map)을 생성한다. 특징맵을 이용하여 관절을 예측하며, Branch2에서 해당 관절에 연결되어있는 사람을 예측한다.

최신 Openpose 기술의 동향은 아래와 같다. 첫 번째로 다중 사용자 포즈 추정을 위한 단일 패스를 이용한 OmniPose[3] 을 제안했다. 해당 방법은 폭포수 모듈을 사용하는 아키텍처이고 멀티 스케일 피처 추출기에서 가우시안 히트맵 변조를 통해서 스케일 및 조인트 위치에 대한 정보를 통해 성능을 개선했다. 다른 연구로는 폐색이 있는 혼잡한 장면에서 발생하는 문제를 해결하기위해서 다중 인스턴스 포즈 네트워크를 제안했다[4]. 여러 2D 포즈 인스턴스를 예측할 수 있다. 이는 주어진 경계 상자내에서 멀티 인스턴스에 대해서 적응적으로 변조할 수 있는 기능을 포함하고 있다. 고해상도를 학습하는 HRFormer[5] 연구가 있다. 이는 저해상도 표현을 생성하고 높은 메모리와 계산 비용을 다중 해상도 병렬 설계를 활용한 연구이다. 다른 연구로는 크기를 효율적으로 사용하여 풍부한 저수준 공간 정보를 유지하고 정확한 키 포인트를 위치하기 위해서 어텐션 메커니즘인 PRM[6] 방법을 제안했다. 제안방법은 출력 기능에서 로컬 및 글로벌 표현를 통해서 키포인트 위치를 더욱 세분화한다. 다른 연구로는 포즈 주청 작업을 위한 간단한 구조의 잠재력을 밝히기 위해서는 이전 연구에서는 별로 없었다. 따라서 모델 구조의 단순성, 모델 크기의 확장성, 학습 방법의 유연성, 모델 간 지식의 이전 가능성 등 다양한 측면에서 포즈 추정을 위해서 연구를 진행했다[7]. 기존 인간 포즈 추정은 관점 동등성 부족을 겪는 다는 문제에대해서 보여주었다. 이는 학습 시간에 보이지 않는 관점을 처리할 때 실패하거나 제대로 수행되지 않는 경향이 있다. 이를 개선하기 위해서 스케일 불변, 변환 불변 또는 최대 풀링과 같은 회전 불변 연산에 대해서 의존한다. 그러나 위와 같은 방법을 적용함에 도 불구하고 일반성이 개선이 되지 않는다. 따라서 [8]에서는 위 문제를 해결하기 위해서 빠른 변분 베이지안 캡슐 라우팅을 갖춘 새로운 캡슐 오토인코더 네트워크를 제안했다. 이는 각 조인트를 캡슐 엔티티로 모델링하고 라우팅 알고리즘과 결합한 방법이다.

3D에서 인간포즈 연구에 대해서 설명한다. 3D 인간 포즈 추정은 인공지능의 근본적인 문제이고 AR/VR, HCI 및 로봇 공학에 다양하게 적용된다. 기존 포인트 클라우드에서 인간 포즈 추정은 여전히 수작업 기반 포인트 클라우드로 인한 노이즈가 많이 존재한다. 위 문제를 개선하기위해서 샘플링 및 단일 프레임 기반 방법을 제안했다[9]. 다른 3D 인간 포즈 연구에서는 기존 하향식 방법은 인간의 감지와 분리되어 연구자가 핵심 문제에 집중할 수 있기 때문에 3D 인간 포즈 및 모양 추정 분야를 지배한다. 그러나 크롭핑은 처음부터 위치 정보를 버리기 때문에 원래 카메라 좌표계에서 전역 회전을 정확하게 예측할 수 없다. 이를 개선하기 위해서 위치 정보를 전체 프레임으로 전달하는 방법을 제안했다[10]. 다른 연구에서는 비디오에서 3D 인간 추정의 큰 발전에도 불구하고 하나의 3D 포즈를 생성하기 위한 대표 표현을 학습하기 위해 중복된 2D 포즈 정보를 최대한 활용하는 것은 여전히 해결되지 않았다. 이를 해결하기위해서 2D 관절 위치의 긴 연속적인 정보를 단일 3D 포즈로 간단하고 효과적으로 들어 올리는 방법을 제안했다[11]. 이는 2D 포즈 시퀀스의 장거리 종속 성을 모델링하기 위함이다. 다른 연구에서는 여러 대의 카메라에서 사람의 자세를 추정하는 것은 아직 연구개발이 되어지지 않았다. 높은 정밀도와 최소한의 대기 시간 오버헤드로 작업을 수행하는 방법을 제안한다[12]. 제안하는 방법은 다중 뷰에서의 폐색으로 인한 관절 위치 불확실성을 고려하며 훈련을 위해 2D 키 포인트 데이터만 필요하다. 다른 연구에서는 이미지에 대한 카메라 매개변수 정보가 부족하기 때문에 3D 인간 포즈 및 모양 추정방법은 약한 관점 투영, 크고 일정한 초점 거리 및 제로 카메라 회전과 같은 몇가지 단순화된 가정을 진행한다. 이러한 가정은 3D 모양과 포즈에서 오류를 발생하는 것을 양적으로 질적으로 보여준다. 이를 경감하기 위해서 단일 이미지에서 원근 카메라를 추정하고 이를 사용하여 3D 인체를 보다 정확하게 재구성하는 방법을 제안했다[13]. 다른 연구에서는 단안 비디오에서 3D 관절 위치 및 방향 예측 작업을 진행하고자 한다. 먼저 포즈 추정 알고리즘을 사용하여 2D 관절 위치를 추론한다. 그리고 신체 자세, 모양 및 카메라 매개변수의 초기 예측을 추정한다. 그런 다음 이러한 초기 매개변수를 수신하는 알고리즘을 고수하고 모델에서 추론된 3D 관절이 2D 관절 위치에 맞도록 최적화한다. 해당 방법은 2D 이미지 평면에 대한 3D 관련의 사영 단계를 포함한다[14]. 다른 연구에서는 임의의 수의 카메라에서 보이는 여러 사람의 3D 포즈 추정 및 추적 작업을 고려한다. 이때 여러 개인의 3D 신체 관절 재구성 및 공간과 시간의 연관성에 대해 동시에 추론하는 새로운 하향식 접근 방법을 제안한다. 핵심은 단일 또는 다중 카메라 뷰에서 집계된 공통 복셀화된 기능 공간에서 작동하는 새로운 시공간 방법이다[15].

Ⅲ. 제안 방법

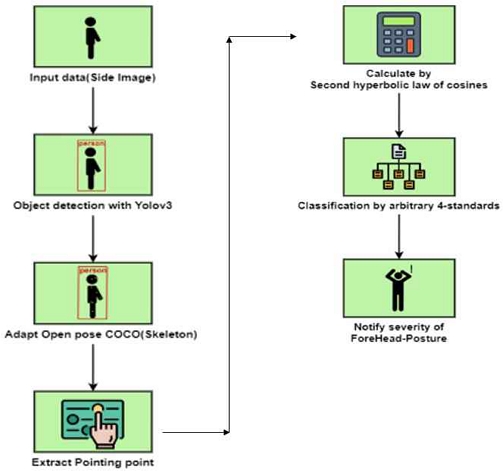

그림1은 물체검출을 통해 사람을 검출하고 검출된 영상에서 스켈레톤을 추출한다. 추출한 특징 값을 이용하여 거북복의 각도를 계산하게 된다. 맨 처음에 Detection을 진행하여 사람인지 또 다른 물체인지를 탐지한다. 기존에 경우 Detection을 진행하여 사용자를 Box 모양에 따라 정교하게 잘라내고, 이를 바탕으로 Open pose로 데이터를 전달하는 방식을 구상하였다. 하지만 해당 방법은 주변에 방해되는 요소가 덜하여 정교하게 Skeleton Point를 추출할 수 있다. 사용자 주변의 공간을 종합적으로 판단하여 해당 부분의 Point를 탐지하기 때문에 Detection을 진행했다.

Detection은 총 2가지 방법으로 진행했다. 기존에 존재하는 Weight file을 사용하는 방법인 Yolov3이며, 두 번째는 우리가 직접 수집한 데이터를 이용하여 직접 레이블링을 진행하고 이를 학습시키는 방식을 사용했다. 두 가지 방법으로 다 진행하여 정확도를 확인해 보았을 때, Yolov3가 더욱 우수했다. 해당 이유로는 수집한 데이터의 배경이 대부분 어두워 밝은 배경에 대한 판별 능력이 떨어졌으며, 사람 주변의 여백이 더욱 많았다.

거북목을 측정하기 위해서는 목의 각도의 계산이 필수적인데, 목의 각도를 계산하기 위해서는 척추와 얼굴 쪽으로의 연결선이 존재해야 한다. 따라서 얼굴과 몸통으로 Pointing을 생성할 수 있는 Open pose를 사용한다. Open pose는 2가지 방식으로 진행했다. 첫 번째 방법은 MP2를 사용하였으며, 두 번째 방법으로는 COCO를 사용했다. MP2의 Skeleton의 정확성이 훨씬 떨어졌으며, 목 위의 자세한 Point가 필요한데 몸의 관절 쪽에 더 집중이 되어 COCO를 사용하여 Pointing을 진행한다.

Open pose를 이용하여 추출한 Point들을 바탕으로 각도를 계산해 주어야 한다. 해당 각도를 계산하기 위해서는 두가지를 고려해야 한다. 사용자의 우측에 대한 사진인지 또는 좌측에 대한 사진인지를 판단해야 한다. 좌측 또는 우측으로 서 있을 때 Open pose에 검출되는 가장 큰 차이점은 팔의 점들이다. 좌측 방향인 경우 좌측 어깨, 팔꿈치, 팔에 해당하는 5, 6, 7번 Point가 검출이 되며, 우측 방향인 경우 우측 어깨, 팔꿈치, 팔에 해당하는 2, 3 그리고 4번 Point가 검출되어 해당 기준을 바탕으로 사용자의 방향성을 판단할 수 있다. 두 번째로는 어떠한 Point로 각도를 계산할지 정해야 한다. 결정한 Point의 경우 해당 방향의 이마, 목, 해당 방향의 골반을 기준으로 하여 각도를 계산한다.

각도 계산은 제2 cos 법칙을 사용하여 삼각형을 이용한 cos 값을 계산하여 각도를 측정한다. 기본적으로 목의 각도가 90° 이상이기에 cos 값은 음수가 나오며, 표1과 같이 180°를 기준으로 15° 단위로 심각성을 나누며 심각과 매우심각은 거북목 증후군이 진행된 상태로 판단한다.

Ⅳ. 실험 결과

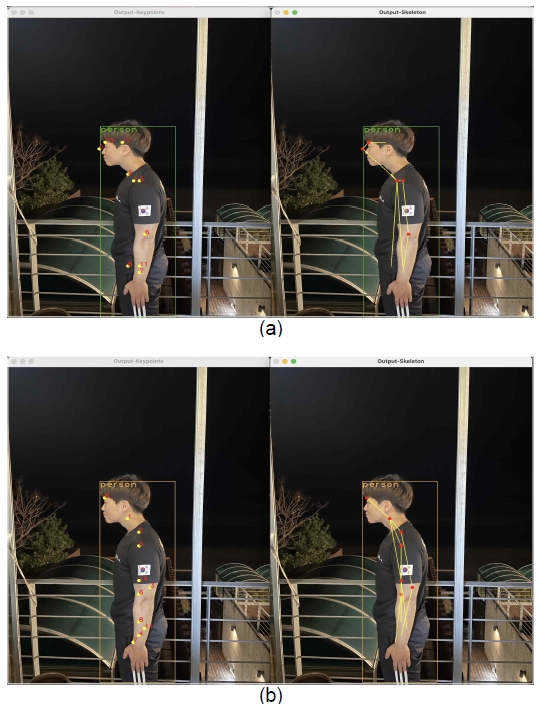

그림 2는 Open Pose model 중 COCO와 MPII를 사용하여 각 관절의 특징점을 추출한 모습이다. COCO의 경우 관절을 총 18개 얻을 수 있으며, MPII는 15개의 관절을 얻을 수 있다. 다양한 데이터들에 대해 해당 모델들을 비교군으로 설정하여 각도 계산 수행 결과, MPII 모델이 각도 산출에 더 효율적이므로 COCO 모델 대신 해당 모델로 선정하여 진행하였다.

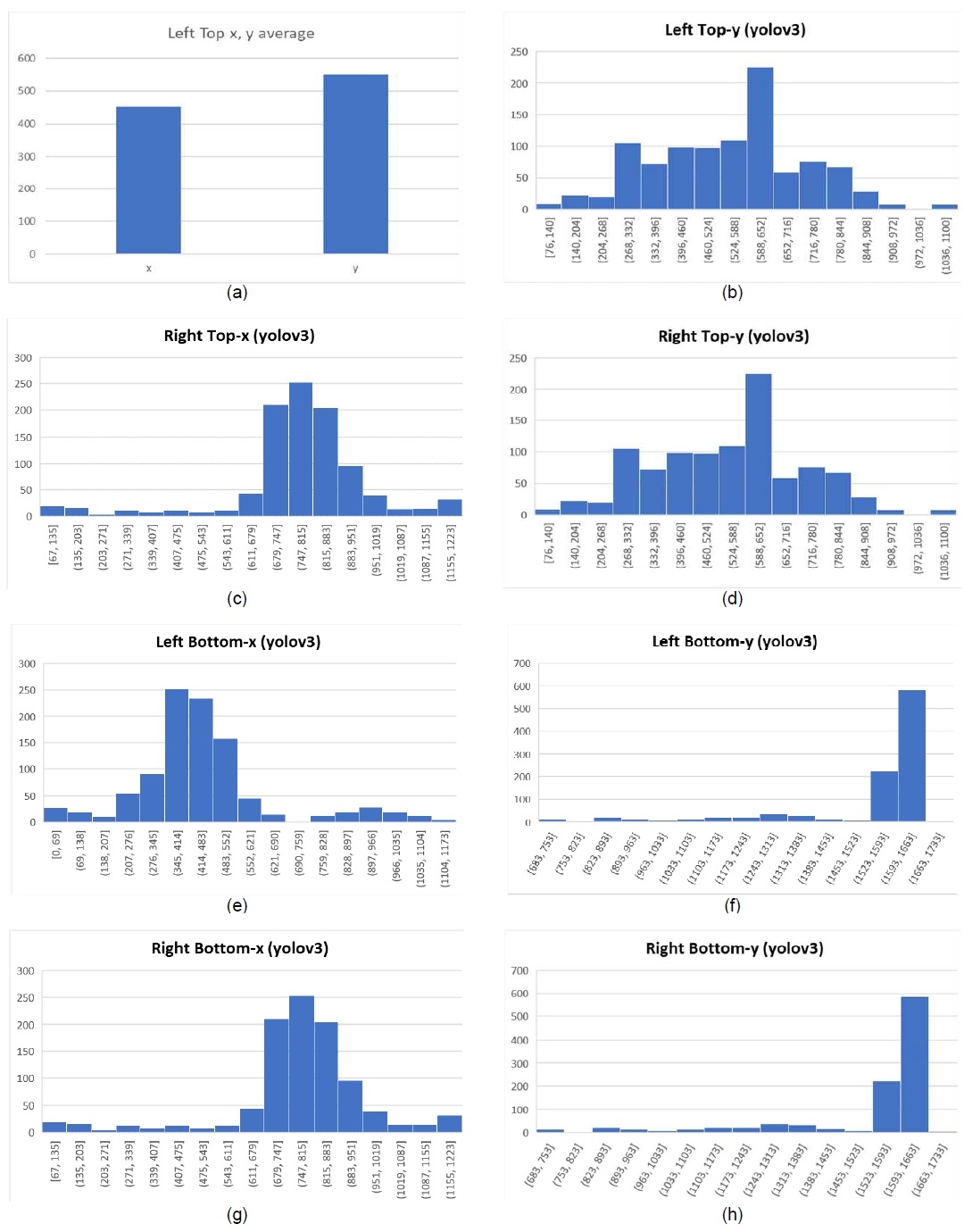

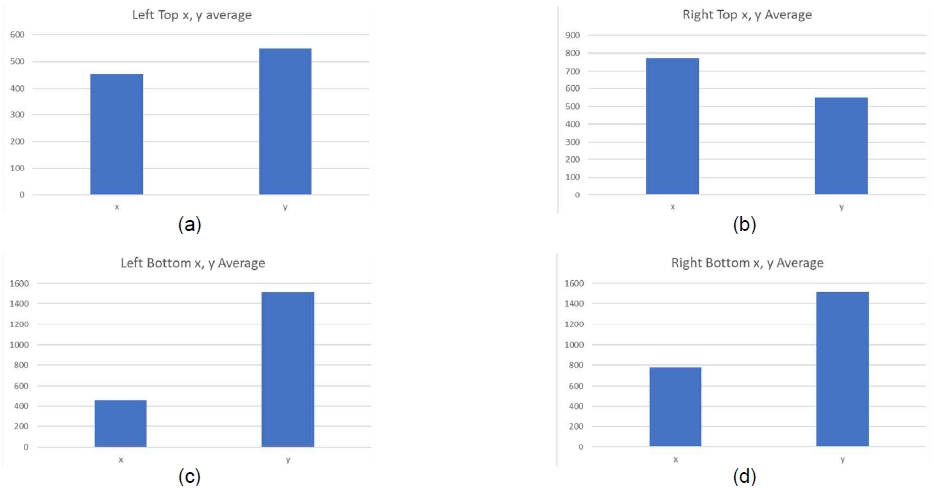

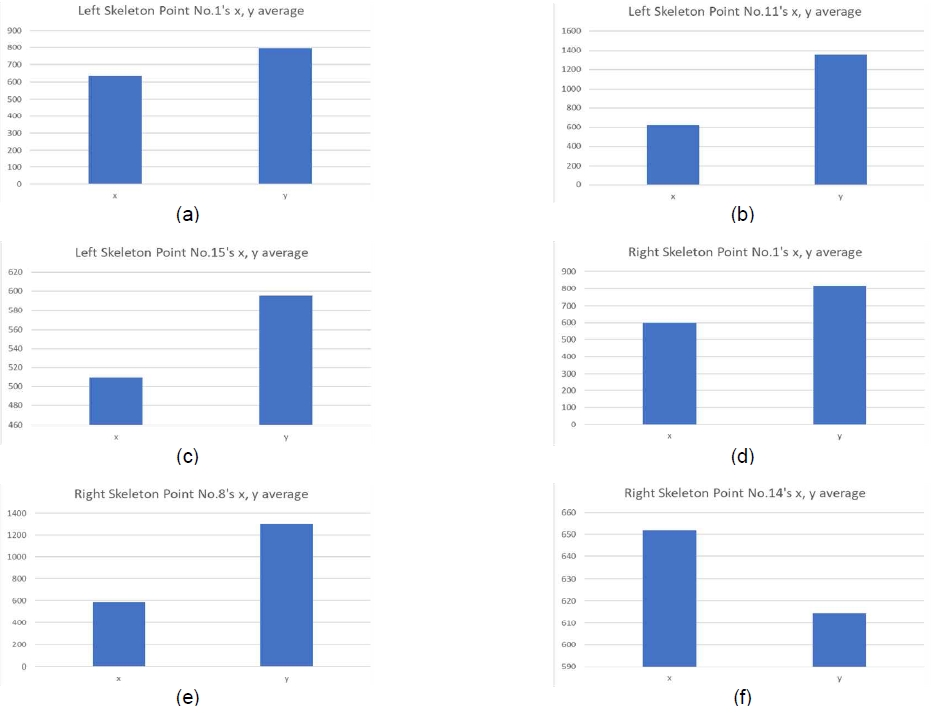

카메라 정면에 사람이 있는 경우에만 데이터를 촬영을 진행했다. 그리고 획득한 데이터의 분포를 분석 확인하기 위해서 획득된 값에 대한 히스토그램 분석을 진행했다. 이를 시각화 분석하기 위해서 그림 3-5는 분석 결과이다. 그림 3은 Yolov3을 이용하여 Object detection 진행 후 검출한 객체들의 x, y 좌표에 대한 전체 분포에 대한 히스토그램을 통해 분석이다. 그림 4는 Yolov3을 이용하여 Object detection 진행 후 검출한 객체들의 x, y 좌표에 대한 평균값에 대한 히스토그램을 통해 분석이다. 그림 5는 COCO 모델을 적용 후 얻은 좌측 및 우측 Skeleton point의 x, y 평균값에 대한 빈도수 분석이다. 그림 3은 직접 수집한 1000장의 측면 사진에 대해 Yolov3 라이브러리로 Object detection을 진행하였을 때 얻은 객체의 x, y 좌표에 대한 분포 히스토그램이다. 얻은 객체들은 모두 이미지들에 대해 하나만 탐지된 객체이다. 그림 4는 그림 3에서 각 좌표들의 분포에 대한 평균값 히스토그램이다. 본론에서의 내용과 같이 최종 선정한 관절 검출 모델인 COCO를 적용하여 얻은 Skeleton point에서 목 각도 계산을 위해 선정한 좌측 Point 3개와 우측 Point 3개에 대한 x, y 좌표의 평균 분포 히스토그램이다. 그림 5는 좌측으로 계산이 필요한 객체의 경우 1번, 11번 그리고 15번 Point의 x, y 좌표값으로 목의 각도를 계산하였으며, 우측으로 계산이 필요한 객체의 경우 1번, 8번 그리고 14번 Point의 x, y 좌표값으로 목의 각도를 계산하여 심각도 판단을 진행하였다.

Histogram of x and y coordinates of objects detected after object detection using Yolov3 (a) left_top_x, (b) left_top_y, (c) right_top_x, (d) right_top_y, (e) left_bottom_x, (f) left_bottom_y, (g) right_bottom_x, (h) right_bottom_y

Average value histogram of x and y coordinates of objects detected after object detection using Yolov3 (a) left_top_x_y_average, (b) right_top_x_y_average, (c) left_bottom_x_y_average, (d) right_bottom_x_y_average

Average x, y values of the left and right Skeleton points obtained after applying the COCO model, (a) 1 point on the left, (b) 11 points on the left, (c) 15 points on the left, (d) 1 point on the right, (e)8 points on the right, (f) right 14 points

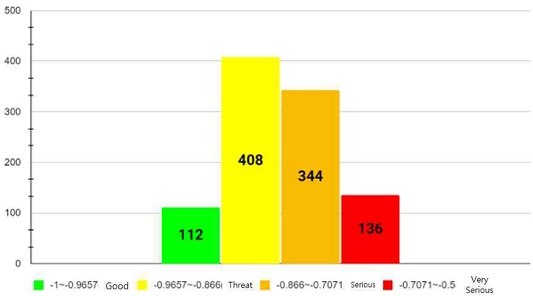

그림 6은 에러 이미지를 제외(한 이미지 안에 2명 이상이 존재하는 경우)하고 이미지 1000장에 대해 심각도 분류 알고리즘 적용 후 양호, 위험, 심각, 매우 심각 분류에 대한 인원 분포표이다.

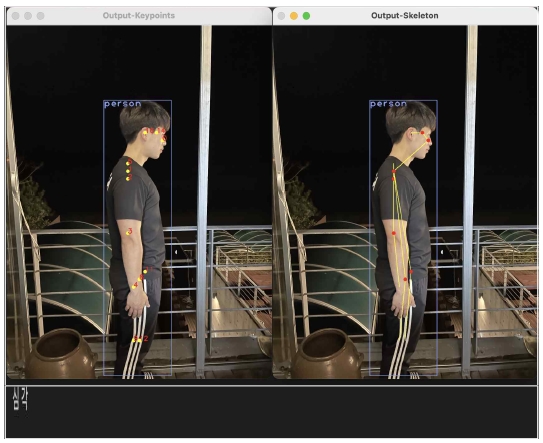

그림 7은 최종 결과 이미지이다. 사진 촬영 후 사용자에게 심각도를 제공한다. 사용자의 Skeleton point에 제2 cos 법칙을 적용하여 -0.733(소수점 넷째 자리에서 반올림)이라는 결과값을 얻을 수 있었으며, 이는 150°~135°(-0.866 ~ -0.7071) 범주에 해당하므로 “심각”으로 분류되어 Console 창을 통해 사용자에게 거북목 증후군 심각도를 제공하는 것을 확인할 수 있다. 이와 같이 사용자로 하여금 이미지와 프로그램을 작동할 수 있는 환경만 구축함으로써 시간과 비용이 소모되는, 병원에서의 대면 진단보다 효율적인 진단 방법을 제공할 수 있다.

V. 결론

현대 사회로 들어서면서 컴퓨터와 스마트폰을 보는 시간이 비약적으로 증가했다. 하지만 사용자들의 대부분은 올바르지 않은 상태로 해당 기기를 사용하고 있다. 해당 시간이 길어지면서 자연스럽게 거북목 증후군에 노출이 될 수밖에 없으며, 본인의 자세가 정상인지 확인이 필요한 사람들이 많다.

해당 프로그램을 통해 사용자들이 집에서도 편하게 거북목을 측정할 수 있고 이에 대한 심각성을 판단할 수 있다. 사용자들이 즉각적으로 심각성을 판단할 수 있으므로 목 건강의 심각성을 일깨워 줌으로써 더욱 악화되는 상황을 막을 수 있다. 또한 목 건강의 올바른 방향성을 확립할 수 있다.

Acknowledgments

본 연구는 과학기술정보통신부 및 정보통신기획평가원의 SW중심대학지원사업의 연구결과로 수행되었음(2017-0-00096).

References

-

J. Redmon and A. Farhadi, “Yolov3: An Incremental Imporvement,” arXiv, 2018.

[https://doi.org/10.48550/arXiv.1804.02767]

-

Z. Cao, G. Hidalgo, T. Simon, S. Wei, and Y. Sheikh, “OpenPose: Realtime Multi-Person 2D Pose Estimation Using Part Affinity Fields,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 43, pp. 172-186, 2021.

[https://doi.org/10.1109/TPAMI.2019.2929257]

-

B. Artacho and A. Savakis, “OmniPose : A Multi-Scale Framework for Multi-Person Pose Estimation,” arXiv, 2021.

[https://doi.org/10.48550/arXiv.2103.10180]

- R. Khirodkar, V. Chari, A. Agrawal, and A. Tyagi, “Multi-Instance Pose Networks : Rethinking Top-Down Pose Estimation,” in Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pp. 3122-3131, 2021.

-

Y. Yuan, R. Fu, L. Huang, W. Lin, C. Zhang, X. Chen, and J. Wang, “HRFormer: High-Reolution Transformer for Dense Prediction,” arXiv, 2021.

[https://doi.org/10.48550/arXiv.2110.09408]

- Y. Cai, Z. Wang, Z. Luo, B. Yin, A. Du, H. Wang, X. ... and J. Sun, “Learning Delicate Local Representation for Multi-Person Pose Estimation,” in Proceedings of Computer Vision – ECCV 2020, pp. 455-482, August 2020.

-

Y. Xu, J. Zhang, Q. Zhang, and D. Tao, “ViTPose: Simple Vision Transformer Baselines for Human Pose Estimation,” arXiv, 2022.

[https://doi.org/10.48550/arXiv.2204.12484]

- N. Garau, N. Bisagno, P. Brodka, and N. Conci, “DECA:Deep Viewpoint-Equivariant Human Pose Estimation Using Capsule Autoencoders,” in Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pp. 11677-11686, 2021.

- Z. Zhang, L. Hu, X. Deng, and S. Xia, “Sequential 3D Human Pose Estimation Using Adaptive Point Cloud Sampling Stratgy,” in Proceedings of IJCAI, pp. 1330-1337, 2021.

- Z. LI, J. Liu, Z. Zhang, S. Xu, and Y. Yan, “CLIFF: Carrying Location Information in Full Frames into Human Pose and Shape Estiamtion,” in Proceedings of Computer Vision – ECCV 2022, pp. 590-606, 2022.

-

W. Li, H. Liu, R. Ding, M. Liu, P. Wang, and W. Yang, “Exploiting Temporal Contexts with Strided Transformer for 3D Human Pose Estimation,” IEEE Transactions on Multimedia, January 2022.

[https://doi.org/10.1109/TMM.2022.3141231]

- B. Usman, A. Tagliasacchi, K. Saenko, and A. Sud, “MetaPose:Fast 3D Pose from Multipkle Views without 3D Supervision,” in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp. 6759-6770, 2022.

- M. Kocabas, C.-H. Huang, J. Tesch, L. Muller, O. Hillliges, and M. J. Black, “SPEC: Seeing People in the Wild with an Estimated Camera,” in Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pp. 11035-11045, 2021.

- I. Kissos, L. Fritz, M. Goldman, O. Meir, E. Oks, and M. Kliger, “Beyond Weak Perspective for Monocular 3D Human Pose Estimation,” in Proceedings of Computer Vision – ECCV 2020, pp. 541-554, 2020.

- N. D. Reddy, L. Guigues, L. Pischulini, J. Eledath, and S. G. Narasimhan, “TesseTrack: End-to-End Learnable Multi-Person Articulated 3D Pose Tracking,” in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pp. 15190-15200, 2021.

저자소개

2019년:광운대학교 컴퓨터정보공학부 학부과정

※관심분야:딥러닝

2019년:광운대학교 컴퓨터정보공학부 학부과정

※관심분야:딥러닝

2018년:한성대학교 전자정보공학과(공학사)

2020년:한성대학교 전자정보공학과(공학석사)

2021년~현 재: 한성대학교 기초교양학부 시간강사

2022년~현 재: 몰팩바이오 CTO

※관심분야:딥러닝