인공지능 기반 시선 추적 기법을 활용한 모바일 커머스 사용자 시선 데이터 분석

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구에서는 별도의 시선 추적용 전용 하드웨어 장비 없이 일반적인 모바일 기기와 인공지능으로 시선 추적이 가능한 기술을 기반으로 모바일 커머스 이용 과정에서 사용자의 시선 데이터를 수집하여 관심 영역별로 분석하고, 그 결과를 소비자 분석을 위한 정량적인 지표와 직관적인 정보 시각화로 나타낼 수 있음을 증명하기 위한 구현 사례와 실험 결과를 제시한다. 제안하는 방법은 시선 데이터 전처리, 주시 특성에 따른 구분 과정, 응시한 지점들의 관심 영역별 통계 처리, 정보 시각화 과정으로 구성된다. 제안하는 방법은 고가의 전용 하드웨어 장비의 구입, 설치, 착용이 필수적인 기존 방법에 비해 저렴한 비용으로 접근 가능하며 일반적인 스마트폰이나 태블릿을 보유한 다수의 사용자가 시간과 공간의 제약 없이 자연스럽게 모바일커머스 환경을 이용하는 과정 중에서 필요한 정보를 추출할 수 있다. 따라서 기존에는 불가능했던 수준의 대규모 구매 과정에 대해 보다 구체적인 시선 정보 기반 데이터를 수집하고 분석할 수 있는 차별성을 제공한다.

Abstract

In this study, we implemented a system where the user gaze data were collected while they engaged in mobile commerce, and these data were analyzed based on the area of interest. The system is based on a technology that enables gaze tracking with general mobile devices and artificial intelligence without dedicated hardware for eye tracking. We conducted experiments to prove that the results can be expressed as quantitative indicators for consumer analysis and intuitive information visualization. The proposed method involves pre-processing of gaze data, classification according to the gaze characteristics, processing of interest-specific regions of gazed points, and information dimension. In addition, the proposed method is accessible at a low cost compared with existing methods, which require purchasing, installation, and use of expensive hardware. The proposed method allows a large number of users with general smartphones or tablets to use the mobile commerce environment naturally without time and space limitations in gathering target information. In conclusion, our method can collect and analyze more specific gaze information-based data for large-scale purchasing processes that are previously impossible.

Keywords:

Mobile Commerce, Gaze Data, Area of Interest, Analysis, Personalized Service키워드:

모바일커머스, 시선 데이터, 관심영역, 분석, 개인화 서비스Ⅰ. 서 론

전자상거래와 스마트 기기의 보급이 확산됨에 따라 온라인 쇼핑은 우리 생활에 밀접하게 자리 잡게 되었다. 최근에는 코로나 19의 영향으로 온라인 소비가 빠른 속도로 증가하면서 전자상거래 시장은 높은 성장률을 보인 바 있다.

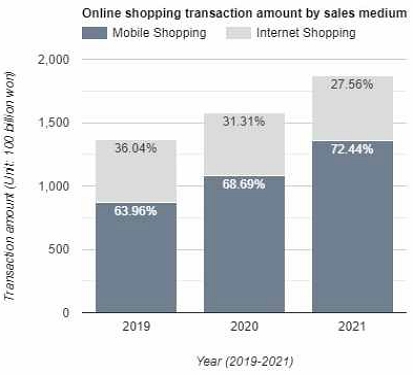

그림 1[1]에서는 코로나 19의 확산 전후인 2019년부터 2021년까지의 온라인 쇼핑 거래액 변화 양상을 제시한다. 이 기간동안 온라인 쇼핑 거래 금액은 꾸준히 증가세를 보이고 있음을 확인할 수 있다. 여기서 주목해야 할 점은 인터넷 쇼핑 대비 모바일 쇼핑의 비율이 2019년에 1.8배, 2020년에는 2.2배 그리고, 2021년에는 2.6배로 점점 그 비율이 증가하고 있다는 것이다. 즉, 모바일 기기로 이루어진 전자 상거래를 통칭하는 모바일 커머스 시장은 꾸준히 확장되고 있다.

모바일 커머스의 주요 특징 중 하나는 개인화이다. 개인의 특성이나 특정 사용자 집단의 니즈를 반영한 제품/서비스를 빠르게 제공하기 위해 공급자는 고객의 특성을 파악하는 방법으로 고객을 유형화시켜 맞춤 서비스를 제공하기 위해 노력하고 있다[2]. 특히 모바일 기기는 개인에 대한 여러 데이터 수집에 용이하기 때문에 사용자 중심 서비스를 제공하기에 최적의 환경이라 할 수 있다.

소비자 구매 패턴에 대한 분석에는 주로 구매 이력을 사용한다. 즉 사용자가 결제한 결과를 통해 그 패턴을 분석하는 것이다. 하지만 일반적으로 결제까지의 과정은 사람마다 다르며, 그 과정 속 사용자가 고민한 항목들은 구매로 이어지지 않는 경우 분석에 반영되지 않는다. 하지만 마케터 관점에서 이 고민의 과정은 파악되지 않은 중요한 정보를 담고 있다고 할 수 있다.

일반적으로 지금까지 파악되지 않았던 이 ‘고민의 과정’은 외적으로는 주로 시선의 흐름으로 나타난다고 할 수 있다.

다시 말해 사용자들은 자신이 관심이 있는 대상에 시선을 두게 마련이고 이러한 가정 하에 사용자의 고민의 과정이 시선의 흐름에 반영되었다고 가정하는 것이다. 따라서 시선의 흐름은 사용자 구매 패턴 분석을 위한 유의미한 평가 지표로 사용될 수 있을 것이다.

지금까지 사용자를 대상으로 한 시선 추적 연구는 고가의 전용 장비가 필수적이라는 한계 때문에 보다 현실 상황에 가까운 사용자 실험을 수행하기에는 어려운 환경이었다.

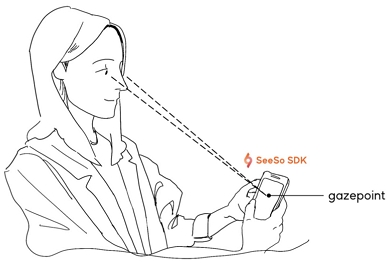

본 논문에서 제안하는 방법론에서는 기존의 시선 추적 연구의 한계를 극복하기 위해서 모바일 기기의 전면 카메라 등과 같은 일반적인 RGB 카메라만으로도 시선 추적이 가능한 VisualCamp사의 SeeSo SDK[3]를 사용한다(그림 2). 이러한 기술적 특징 덕분에 개발자 또는 연구자 입장에서는 비용적인 측면에서의 부담이 감소하고 사용자 입장에서는 고글이나 HMD(Head Mount Display), 또는 적외선 조명 및 적외선 카메라와 같은 부수적인 장비의 착용 없이 자연스러운 모바일 기기 환경 또는 PC 사용 환경에서 다른 간섭 없이 원래의 의도(예. 쇼핑)를 수행하면서 시선을 추적할 수 있다. 이러한 시선 추적을 기초로 본 논문에서 논의하는 방법론을 통해 사용자의 구매 과정에서의 시선 데이터를 수집하고 관심영역(AOI; area of interest) 별로 분석하는 과정을 수행함으로써 소비자 구매 패턴 분석을 위한 정량적인 지표를 제안하고자 한다.

1-1 관련 연구

개인화의 대표적인 현상으로 현대의 스마트폰이 활성화됨에 따라 스마트폰에 내재된 여러 센서를 통해 사용자 개인 패턴을 밀접하게 파악하는 것이 가능하게 되었고, 이를 기반으로 개인화 서비스가 강화되고 있다. 이러한 환경에서 사람들의 행위 패턴 학습을 바탕으로 사용자에게 필요한 서비스를 미리 제공하는 지능형 개인화 서비스를 위해 강인한 파티클 필터 기반의 사용자 경로 예측 연구가 제안되었다[4].

개인화 서비스를 위해서 기업은 사용자의 데이터, 구매, 등급 및 다른 사용자와의 관계를 상세히 분석해 사용자에게 맞춤형 추천을 제공하기도 한다. 개인 맞춤형 추천시스템을 위한 기법인 협업 필터링, 행렬 요인화, 딥러닝의 성능을 비교 및 분석한 연구에서는 분석을 위한 원 데이터(Raw data)로 쇼핑몰 상품 구매 후기 데이터 세트가 적용되었다[5].

또한 개인화 서비스에 대한 중요도-실행도 분석(IPA)을 통해 개인화와 관련된 기능 중 ‘모바일앱을 나의 취향에 맞게 꾸밀 수 있는 기능’이 중요도에 비해 실행도가 낮아 마케팅 노력을 집중해야 한다는 결론이 도출되었다. 따라서 이용자 중심의 사용 환경을 구축하면 편의성 증대뿐 아니라 애플리케이션에서 개인화 서비스에 대한 만족도가 높아진다는 결론이 도출되었다[6].

일반적인 데이터 분석 방법으로는 사용자의 리뷰와 같은 텍스트 데이터를 기반으로 한 텍스트 마이닝 분석과, 사용자의 클릭 수나 조회 수와 같이 사용자의 행동을 정량적인 데이터로 수집한 분석 등이 있다[7].

또한 모바일 어플리케이션 서비스를 평가하기 위해 사용자 리뷰 데이터를 활용해 각 카테고리별 토픽들을 산출하여 중요도를 확인하는 연구도 발표되었는데 모바일 애플리케이션에 대한 사용자들의 사용 만족도가 높아질 것이라는 예상하였다[8].

또 다른 연구에서는 애플리케이션 사용성 테스트를 위해 사용자의 클릭 수를 히트맵으로 나타내어 애플리케이션 디자인에 대한 개선안을 도출하였다[9].

그리고 구독자 수 및 조회 수, likes/dislikes 수, 댓글 수 등과 같은 영상의 카테고리별 특성 분석을 통한 각 콘텐츠에 대한 사용자의 반응을 분석하는 연구도 진행되었다. 이러한 관점은 구독자의 반응성을 통해 기업들의 운영 방안과 다양한 공공분야에서도 유용하게 활용될 수 있음을 언급하였다. 이렇듯 개인화 서비스를 제공하고 애플리케이션에 대한 만족도를 분석 및 평가하기 위한 데이터 분석 연구들이 많이 진행되고 있다[10].

그러나 텍스트 데이터나 사용자의 행동을 기반으로 한 데이터는 사용자의 관심을 간접적으로 보여준다는 한계가 있다[11]. 그리고 리뷰 데이터를 이용하여 평가 척도를 정하는 것은 본질적으로 전문가들의 평가에 영향을 받기 때문에 주관적일 수밖에 없다. 이를 보완하기 위해서는 사용자의 관심과 욕구를 반영할 수 있어야 한다[7].

전용 시선 추적 장치(Eye Tracker)를 사용하여 사용자의 시선에 대한 데이터를 수집하고 이를 활용한 연구들도 활발히 진행되고 있다.

소비자 분석 관련 연구에서는 제품을 원하는 소비자의 유형을 파악하여 그들이 원하는 점을 연구·분석하여 소비자 맞춤형 디자인을 이행하기 위해 소비자 유형 분석 과정에서의 측정 시스템 중 하나로 안구측정시스템을 이용한 사례가 발표되었다[12].

이외에도 정교화 가능성 모델이 소셜네트워크 마케팅에서도 적용이 가능한지를 확인하기 위해 연구를 진행하였다[13]. 이때 시선 추적 장치를 사용한 측정 방법을 중심으로 소비자 태도가 중심경로와 주변경로를 통하여 형성되는지 실험했다.

또한 시선 추적 장치를 이용해 상업 시설 등의 공간 이미지에 대한 선택적 시각탐색에 대한 연구도 발표되었다[14]. 이 연구에서는 시선 추적 장치로 시각적 주의 집중이 일어날 때, 도발적이거나 흥미를 끄는 세부 특징이 탐지되어 초점을 맺는 과정에서 일어나는 시각 고정을 수집하였다. 이를 활용하여 소비자의 공간 탐색 과정에서의 주시 특성을 객관적으로 분석하였다. 또한 시선 추적 장치를 이용해서 수집한 눈의 움직임을 통해 얻은 시선 데이터로 단지 사용자가 의식적으로 보이는 것을 보는 것이 아니라, 보고 싶은 것을 확인하는 연구도 발표된 바 있다[15].

이렇게 시선추적은 사용자 연구, 사용자 인터페이스 설계, 사용자 경험 설계 및 기타 일상적인 애플리케이션 및 제품에서 점진적으로 사용되고 있다. 이에 따라 여러 연구들의 시선 추적 시스템의 사용을 검토하고 인지 부하를 측정하기 위한 시선 관련 잠재적 지표들과 그 중요성에 대해 논의된 바 있다[16].

앞서 논의한 기존의 대부분의 시선 추적 장치 기반 연구는 고가의 전용 하드웨어 장비가 필수적으로 적용되어 연구의 접근성은 물론, 피실험자 또는 참여 사용자의 수에 한계가 있었다. 본 연구에서는 이러한 고가의 전용 하드웨어 장비를 사용하지 않고 인공지능 기술을 기반으로 스마트폰, 태블릿, PC용 웹캠 등 일반적인 RGB 카메라만으로도 시선 추적이 가능한 VisualCamp사의 SeeSo SDK[3]를 이용해서 소비자들이 번거로운 하드웨어 시선 추적 기기를 착용하거나 설치할 필요 없이 모바일 기기를 이용해서 음료 주문을 하는 자연스러운 사용 환경에서 구매 전과정에서의 사용자의 시선 추적을 수행한다. 이러한 방식은 하드웨어 기반 시선 추적 장비에 비해 매우 저렴한 비용으로 실험이 가능하고 피실험자의 심리적 부담감도 적기 때문에 비용 및 심리적인 측면에서의 접근 장벽이 낮다. 따라서 고가의 하드웨어 기반 시선 추적 장치 한 대로 한 번에 한 명씩 실험을 수행하지 않고 스마트폰 또는 태블릿, 웹캠 설치 PC를 보유한 사용자라면 시간과 공간의 제약 없이 실험에 참여할 수 있으며 수집된 데이터는 클라우드 환경에서 안전하게 암호화되어 필요한 사람들에게 익명성을 유지하면서 공유될 수 있다는 장점이 있다.

이러한 인공지능 기술 기반 소프트웨어 방식의 시선 추적 기능은 주로 외형 기반 시선 추적(appearance based gaze estimation) 기법으로 수행된다[17]. 외형 기반 시선 추적 기술은 적외선 카메라나 적외선 조명, 웨어러블 장비 등 특별한 하드웨어 없이 일반적인 RGB 카메라를 이용해서 사용자의 얼굴을 실시간으로 포착하고 인공지능 기술로 사용자가 바라보고 있는 지점을 지속적으로 추정한다[18]. 최근 이러한 시선 추적 연구는 카메라를 직접 바라보는 사용자 한 명에 대한 시선 추적을 넘어서 카메라에 촬영된 여러 사람들의 시선 정보까지 획득하는 연구로 발전되고 있다[19].

Ⅱ. 본 론

2-1 시스템 개요

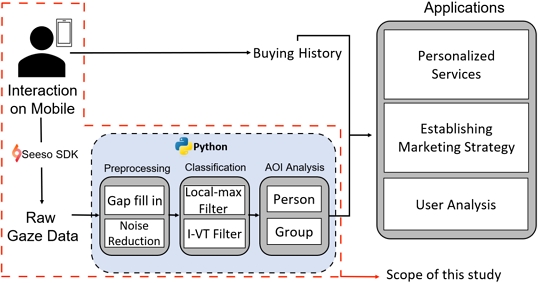

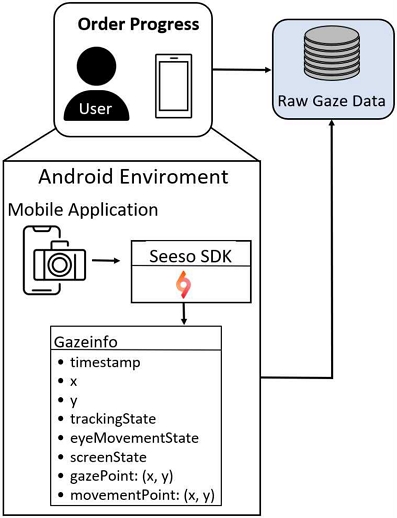

그림 3에서는 본 연구에서 구현된 시스템 개요를 제시한다. 사용자가 모바일 기기로 온라인 쇼핑 사이트를 이용하는 동안 모바일 개발 환경(본 연구의 실험에서는 Android 개발 환경)에서 SeeSo SDK로 구현한 시선 추적 기능은 처리 전 시선 정보(raw gaze data)를 출력하고 이후 분석을 수행하기 위한 모듈로 전달된다. 처리 전 시선 정보 형식은 그림 4에서 확인할 수 있다.

전달된 처리 전 시선 정보는 Python 언어로 구현된 사전 처리(preprocessing), 분류(classification), 관심 영역 분석(AOI analysis) 모듈을 거치게 된다.

이와는 독립적으로 사용자의 구매 이력(buying history)이 별도로 저장되어 앞서 설명한 모듈에서 처리된 시선 정보에서 추출된 정보와 결합되어 개인화된 서비스 제공, 마케팅 전략을 위한 근거 자료, 사용자 분석 등에서 응용할 수 있다.

2-2 데이터 전처리(preprocessing)

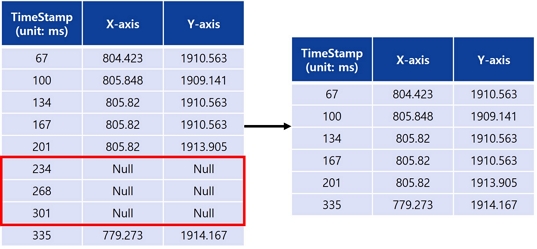

SeeSo SDK로 수집한 데이터는 전면 카메라만을 이용한다. 따라서 사용자가 화면 밖을 쳐다볼 경우나 눈을 깜빡일 경우, 카메라가 흔들렸을 경우 등의 상황에서는 일부 부정확한 데이터들이 수집된다. 따라서, 데이터를 분류하기 전에 이러한 부정확한 데이터로 인한 영향을 최소화하기위해 전처리를 수행한다. 먼저 데이터의 결측값을 제거(gap-fill, 그림 5)한 뒤 이후에 노이즈 감소 작업(noise reduction)을 수행함으로 데이터의 특징은 보존하면서 데이터의 품질을 개선한다.

노이즈 감소 작업은 고정된 크기의 윈도우를 움직이면서 시선들을 윈도우 내의 시선들의 경향성을 기반으로 조정한다. 조정하는 방식에는 중앙값(median) 방식과 평균(mean) 방식이 있는데, 중앙값 방식이 눈 깜빡임과 같은 이상치를 잘 조정하면서도 기존 시선들의 특성을 유지하므로 본 연구에서는 중앙값 방식을 사용하였다. 노이즈 감소 작업은 특히 데이터가 전체적으로 잡음이 많이 포함되어 있는 경우에 사용하며 선택적으로 기능을 해제할 수 있도록 설계하였다.

2-3 데이터 분류(classification)

수집한 시선 데이터는 시선 좌표들로 이루어져 있으며, 각 시선 좌표는 x좌표와 y좌표, timestamp 등으로 구성된다(그림 4). 전처리가 끝난 시선 데이터의 시선 좌표는 안구의 해부학적인 움직임에 기초하여 Fixation과 Saccade[20]로 구분한다. Fixation은 사용자가 의식하여 보고 있는 지점을 의미하며 비교적 가까운 거리에서 클러스터를 형성한 시선 좌표들의 집합이다. 반대로 Saccade는 시선이 빠르게 이동하는 경로로 거리가 먼 시선 좌표들의 집합으로 정의된다. 시선 좌표의 위치값으로 얻은 이동거리를 통해 안구의 각속도를 구할 수 있다. 이 값이 임계값보다 작을 경우 Fixation, 반대의 경우 Saccade로 구분할 수 있다.

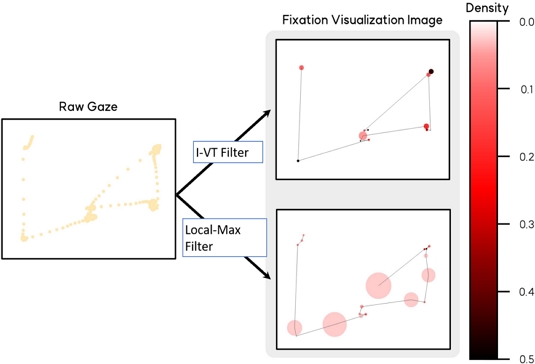

그러나 단순히 각속도만을 가지고 Fixation/Saccade로 구분할 경우 각각 시선 좌표의 특성만이 반영되고 시선 흐름의 맥락을 고려하지 못한다. 따라서 본 연구에서는 I-VT 필터나 Local Max 필터를 사용하여 전체적인 시선의 흐름을 반영하여 분류하였다. 그림 6에서는 두 가지 필터를 처리 전 시선 좌표에 적용한 결과를 제시한다.

카메라와 SeeSo SDK를 통해 주기적으로 수집되는 2차원 평면 상의 시선 위치를 시선 좌표(gaze)라고 한다. 이 시선 좌표는 외형 기반 시선 추적 알고리즘이 적용된 SeeSo SDK가 카메라를 통해 촬영한 사용자의 얼굴 이미지를 기반으로 사전에 학습된 인공지능신경망을 기반으로 현재 사용자가 보고 있는 화면 상의 위치를 추정한 결과이다.

이 시선 좌표들을 특성에 따라 분류하면 크게 Fixation과 Saccade로 나눌 수 있다. Fixation은 일정 시간 특정 위치에 서로 가까이 분포되어 클러스터를 형성한 시선 좌표들의 집합이다. Fixation은 사람의 시선이 특정 지점에 고정될 때 나타난다. 반면에 Saccade는 순간적으로 위치가 크게 변화하는 시선 좌표를 말한다. 즉, 무언가를 읽거나 살피기 위하여 시선이 빠르게 움직일 때 나타난다.

이 외에도 눈의 움직임에 따른 다른 분류들도 존재하지만 본 연구에서는 관심 영역에 대해 사용자가 주목한 정도를 통해 지표로 나타내는 것이 목적이므로 이 두 가지 분류만 사용한다.

그러나 Fixation과 Saccade로 나누는 이러한 접근 방법은 전통적인 해부학 또는 의학적인 방법[20]이며 SeeSo SDK와 같은 소프트웨어적인 시선 추적 또는 전용 하드웨어 장비를 사용하는 시선 추적 방식에서도 시간에 따른 시선 좌표만 얻을 수 있을 뿐, 필연적으로 Fixation과 Saccade로 구분되지는 않는다. 따라서 시선 추적 기능에서 출력된 일련의 시선 좌표들을 Fixation과 Saccade로 구분하기 위해서는 별도의 필터가 필요하다.

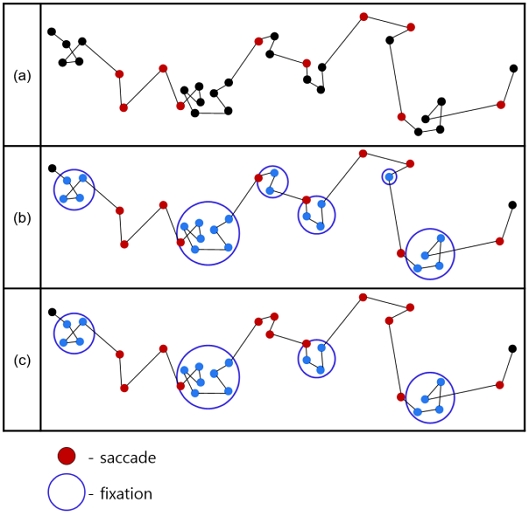

I-VT 필터는 하드웨어 기반 시선 추적 장치를 주력으로 하는 업체인 Tobii Technology에서 개발한 시선 분류 알고리즘이다[21]. 먼저, 안구의 각속도를 기준으로 적정 임계값을 통해 시선 좌표를 Fixation과 Saccade로 구분한다(그림 7의 (a)). 이후에 두 단계의 필터링 과정을 거친다.

첫 번째로, 두 Fixation 사이에 짧은 Saccade가 존재하고 해당 Fixation간의 각도 차이가 작을 경우, Saccade를 Fixation으로 간주한다. 따라서 각도 차가 작은 두 Fixation과 그 사이의 Saccade를 하나의 Fixation으로 간주한다. 이 과정을 merge fixation이라고 한다(그림 7의 (b)).

다음으로, Saccade 사이의 작은 Fixation이 존재할 경우, 해당 Fixation을 Saccade로 취급한다. 이러한 과정을 discard short fixation이라 한다(그림 7의 (c)).

이 두 과정을 통해 시선의 맥락을 고려하여 Fixation과 Saccade로 분류할 수 있다. 그러나 I-VT 필터는 초기에 각속도로 Fixation과 Saccade로 구분한 뒤, 이후의 값들을 조정하는 방식이다. 따라서 임계값을 잘 설정하는 것이 중요하다. 그러나 사용자들의 시선 움직임의 특성이 모두 동일하지 않으므로 적절한 임계값을 찾기는 어렵다. 이러한 단점을 극복하기 위해 Local Max 필터를 사용한다.

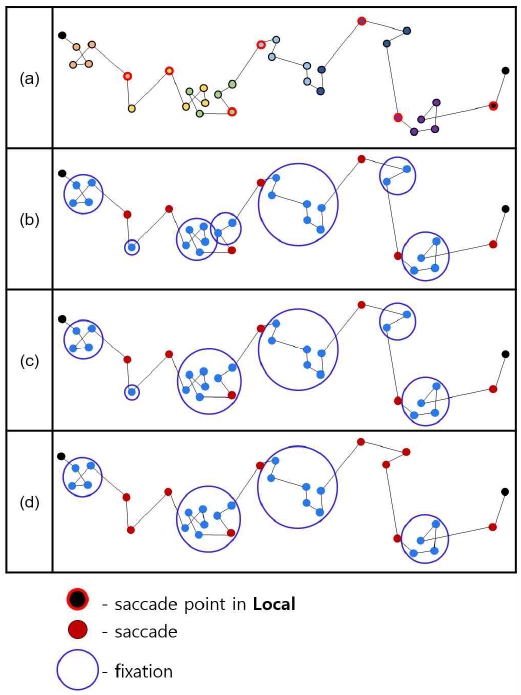

Local Max 필터[22]도 마찬가지로 안구의 각속도를 이용한다. 그러나 명칭에서처럼, 시선 좌표를 윈도우 크기를 기준으로 지역 단위로 묶는다. 이후 안구의 각속도가 가장 큰 시선 좌표를 Saccade라고 판단한다. 이후에는 I-VT 필터에서와 동일한 과정을 거친다(그림 8). Local Max 필터를 사용하면 사용자별로 적합한 각속도를 찾지 않더라도, 거의 모든 경우에서 시선의 경향성에 따라 Fixation과 Saccade를 분류할 수 있다. 단, 무조건 각 지역마다 Fixation과 Saccade로 구분하기 때문에 더 작은 단위에 많은 Fixation과 Saccade로 분류된다. Local Max 필터는 I-VT 필터에 비해 상대적으로 Saccade에 비해 Fixation이 두드러지는 특징을 갖는다.

본 연구의 목표인 관심 영역별 시선 데이터 분석을 위해서는 사용자의 시선의 이동 경로보다는 정확히 어떤 지점들을 바라보았는지가 중요하다. 따라서 본 연구에서는 Local Max 필터를 사용하여 시선 데이터를 시선 좌표들의 그룹인 Fixation과 Saccade로 분류하였다.

2-4 관심 영역 분석(AOI analysis)

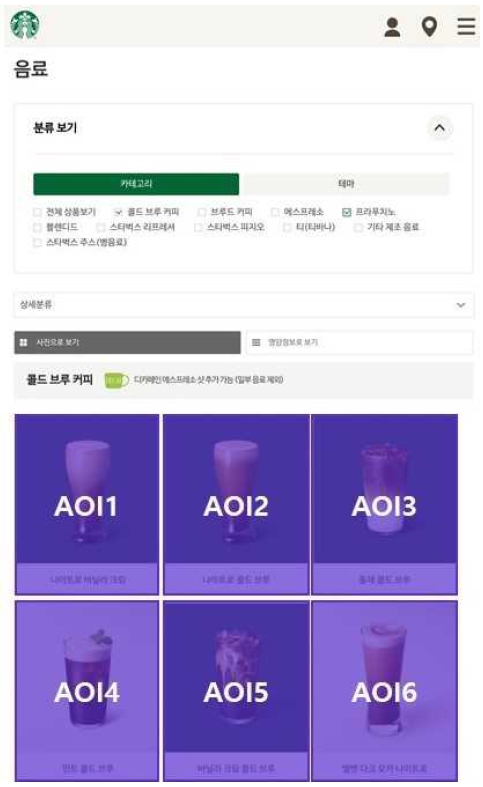

사용자가 응시한 지점인 Fixation을 중심으로 관심 영역별로 분석하였다. 데이터 수집 단계에서 언급했듯, 특정 카페의 음료 메뉴를 대상으로 시선을 수집하였다. 따라서 본 연구에서의 관심 영역(AOI, Area of Interest)는 페이지 속 음료 이미지와 이름을 하나로 그림 9와 같이 설정하였다.

Fixation은 일부 시선 좌표들의 집합이다. 해당 시선 좌표들의 x좌표들과 y좌표들의 평균을 Fixation의 중심 좌표로 설정한다. 관심 영역에 중심 좌표가 속할 경우 해당 Fixation을 관심 영역 내에 존재한다고 가정하였다.

사용자 한 명의 시선 데이터의 시선 좌표와 필터를 적용해 얻은 Fixation을 평가하기 위해 각 관심 영역별로 표 1[15]과 같은 평가 지표들을 설정하였다. 또한 개별 AOI뿐 아니라 사용자 한 명의 전체적인 경향을 확인하고자 표 2[15]와 같이 평가 지표를 설정하였다. 이 두 가지의 평가 지표를 통해 사용자별 시선 데이터를 정량적으로 분석할 수 있다.

각 메뉴들에 표 1에서 제시한 지표들을 연관지어 Fixation들의 개수나 시선들의 총 시간 등을 통해 사용자의 관심도를 확인할 수 있다. 이를 단순히 관심 영역에 대한 개인의 선호도를 확인할 수 있을 뿐 아니라, 개인의 선호도들을 토대로 각 관심 영역별 특징을 분석할 수 있다. 예를 들면, 표 1의 Metric 중에서 최초 방문(First time)을 이용해 사용자의 이목을 끄는 메뉴나 재방문(Revisit)을 이용해 사용자들이 많이 고민한 메뉴 등등이 있다. 또한 전체 시선들 중 관심영역에 포함되는 비율(Count ratio)로도 전체 메뉴 중에서 해당 메뉴의 시선 점유율도 확인 가능하다. 한 메뉴를 얼마나 집중적으로 쳐다봤는지에 대해서는 관심 영역에 존재하는 시선들 중 사용자가 의식해서 바라본 것을 의미하는 Fixation으로 분류된 비율로 확인 가능하다.

표2는 평균값을 통해 전체 메뉴들의 경향을 확인할 수 있을 뿐만 아니라 메뉴 화면에 대한 사용자의 경험을 확인할 수 있다. 예를 들면 초당 Fixation의 생성률(Fixation rate)이나 각 관심영역의 평균 시선 체류 시간(Average of AOI’s duration)을 통해, 사용자가 메뉴 선택의 과정에서 시선이 방황하고 있는지 확인 가능하다. 따라서 이 지표들은 메뉴 선택 화면의 UI/UX에 대한 평가로도 이어질 수 있다. 또 전체적으로 시선이 지나간 관심영역들의 기록(History)도 확인 가능하다. 본 연구에서는 이와 같은 정량적인 지표를 기반으로 관심 영역을 평가한다.

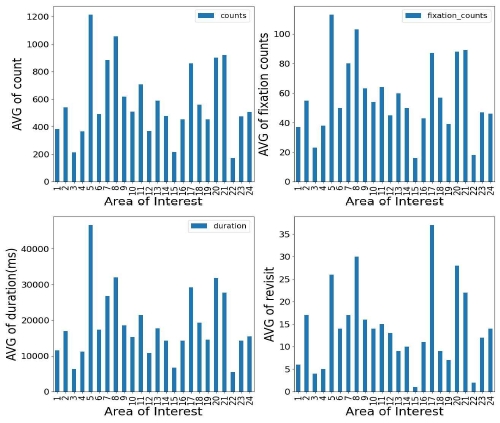

관심 영역별로 모든 사용자를 평가한 결과에 대한 평균을 구하면 개인에 대한 평가뿐 아니라 전체적인 통계도 확인할 수 있다. 또한, 전체적으로 사용자들의 시선의 양상이 어떤지를 gaze plot과 heatmap을 통해 확인할 수 있다.

Ⅲ. 실험 및 결과 시각화

3-1 실험 방법

앞서 논의한 시스템은 상업 사이트를 포함한 여러 인터넷 사이트 또는 애플리케이션 환경에서 사용자들이 관심을 가지고 보는 항목들을 시선 정보를 통해 추적하고 그 결과를 시각화하며 통계 정보를 제공할 수 있도록 설계되었다. 사이트 관리자 또는 서비스 설계자는 시각화된 정보를 통해 직관적으로 소비자들이 관심을 많이 두는 상품을 확인하고, 객관적으로 화면 디자인의 개선을 위한 아이디어 및 통계적 근거를 활용할 수 있다.

제안하는 시스템이 이러한 목적을 달성하는지 그 유용성을 검증하기 위해서 실제 사용자들이 모바일 환경에서 널리 사용하는 상품 주문 사이트 환경을 대상으로 사용자 한 명의 개인 데이터와 여러 사용자들의 그룹 데이터에 대해서 분석을 진행하였다.

제안하는 시스템을 실험하기 위한 대상으로 S 프랜차이즈 홈페이지의 음료 메뉴 화면(그림 9)을 선정하였다. 이 홈페이지는 전형적인 모바일 음료 주문 홈페이지 디자인으로 구성되어 있으며 일정 간격으로 음료의 사진과 이름이 나열되어 있어 관심 영역(AOI)를 쉽게 파악할 수 있다는 특징이 있다. 이 페이지에서 사용자의 시선 데이터를 수집하고 분석하기 위해 앞서 논의한 시스템을 구축하고 실험을 수행하였다.

실험에서는 제안하는 시스템을 모바일 환경에 구현한 후 이 모바일 기기에서 일반적인 사용 방식을 따라 사용자가 메뉴를 선택하는 동안 정해진 시간 동안 메뉴를 볼 때, 일정한 시간 간격으로 데이터를 수집하였다.

앞서 설명한 실험에는 총 20명이 참여하였다. 실험에 참가한 피실험자들은 일반 직장인 12명과 대학 재학 중인 20대 초 중반 8명으로 남자 10명(50%), 여자 10명(50%)으로 구성되었다. 본 연구는 쇼핑몰과 같은 상업 사이트에서 시선 추적 기술의 활용에 대한 아이디어를 구현하고 실증하기 위한 목적으로 수행되었기 때문에 피실험자들은 모두 시선 추적 SDK 개발 회사 내 개발자 및 마케터(12명)와 대학생 인턴(8명)을 대상으로 하였으며 실험의 목적과 시스템의 특성을 인지한 상태에서 실험에 자발적으로 참여하여 자연스러운 방식으로 원하는 음료를 선택하도록 요청하였다.

3-2 실험 결과

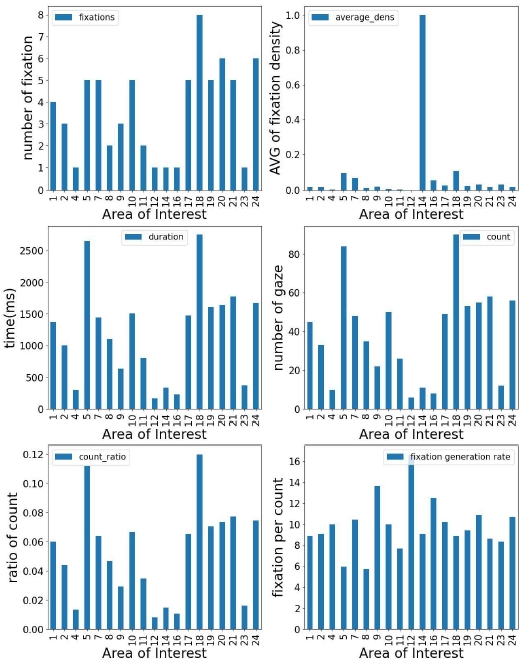

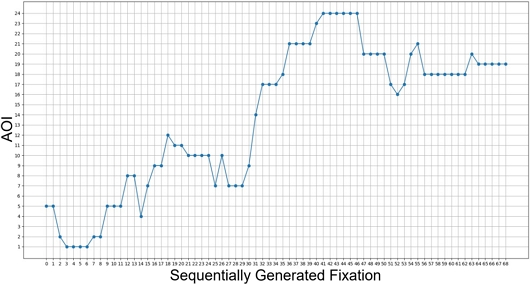

그림 10은 표 1에서 제시한 8개 지표들 중 6개(fixations, average density, duration, count, count ratio, fixation generation rate)를 바탕으로 평가한 결과를 시간에 따른 막대 그래프로 시각화하였다. 특히, 그림 11에서는 사용자 한 명이 시간의 흐름(가로축)에 따라 번호로 표시된 각 관심 영역(세로축)들 중 어느 곳을 보고 있는지 확인할 수 있다. 예를 들어 이 피실험자는 실험 시작과 함께 처음에는 5번을 보고 있다가 시선을 1번으로 이동시켜서 3~6초 정도 바라보고 있었다는 사실을 확인할 수 있다. 사이트 관리자 또는 상품 기획자는 이 그래프를 통해서 사용자가 가장 오래 바라보고 있는 상품(그림 11에서는 23번 AOI에 해당되는 상품)을 보다 구체적으로 확인할 수 있다.

그림 11은 데이터 통계화 및 정량화를 위해서 유용한 방법이지만, 직관 별로 얻은 시선 데이터들이 실제 화면의 어디에 위치하는지 등을 확인하고자 표 1로 평가한 결과를 표 3에 제시한 바와 같이 이미지들로 시각화할 수 있다. 이 중 Fixation Heatmap과 Fixation Density Visualization을 그림 12에서 확인할 수 있다.

Heatmap의 경우에는 사용자가 주의 깊게 살펴본 영역을 한눈에 확인할 수 있다. Fixation Density의 경우에는 Fixation의 분포를 확인할 수 있다. 이때 반지름은 Fixation의 중심과 가까운 80% 범위의 시선 좌표들을 포함하도록 설정하였다. 또한 Fixation의 density의 정도에 따라 색을 다르게 하여 직관적으로 확인 가능하다.

Ⅳ. 결 론

본 논문에서는 시선 데이터를 직접 분석함으로써 일반적으로 정성적인 지표로 사용하는 시선 추적을 객관적인 정량적인 지표로 나타낼 수 있음을 제시하였다. 또한 그래프나 실제 이미지 위에 시선을 가공하여 나타내는 등의 시각화를 진행하였다. 또한 소비자 구매 패턴 분석에서 소비자의 고민 과정을 시선 추적을 통해 반영하고자 하는 실험을 수행하였다. 이 실험에서는 사용자가 메뉴를 고르는 일련의 과정에서 추적한 시선 데이터를 가공하고 여러 지표들로 평가하는 과정을 수행하였다. 그 결과 사용자가 특히 주목한 항목들에 대해 시선 추적을 통한 보다 객관적인 근거를 바탕으로 제시할 수 있었다. 또한 사이트 관리자나 구매 담당자가 직관적으로 정보를 파악할 수 있도록 평가 결과들을 시각화하였다. 이 연구에서 분석한 것과 실제 구매 결과를 함께 분석한다면 더 유의미한 결과를 도출할 수 있을 것이다.

모바일 커머스 시장은 지금까지 급격한 성장률을 보였고 이후에도 계속해서 빠른 속도로 성장할 것으로 보인다. 본 연구에서 수행한 사용자 시선 분석을 해당 시장에 접목시킨다면 사용자가 매체를 이용하는 보다 세부적인 과정에 대한 분석이 가능하다. 이를 통해 사용자별로 분석하여 개인화된 서비스를 맞춤 제공할 수 있다. 또한 모바일 커머스에서 중요한 요소 중 하나이고 사용자 경험 제공에 중요한 UI/UX를 구성할 때 분석 결과를 반영하여 업체의 마케팅적인 부분을 보완할 수 있다. 본 연구의 내용은 패션, 식품 등 다양한 분야의 플랫폼에도 적용 가능할 것으로 기대한다.

현재 연구에서는 각 관심영역(AOI; area of interest) 들이 별도의 구분 없이 모두 같은 중요도로 분석에 반영되어 있다. 또한 지표들 중 일부는 비슷한 의미를 내포하기 때문에 추가적인 후속 연구가 필요하며 후속 연구에서는 각 관심영역(AOI; area of interest)별 특징에 따라 카테고리를 나누어 분석하면 더 세분화된 분석을 수행함으로써 보다 더 유의미한 결과를 도출할 수 있을 것으로 예상한다. 또한 지금 연구에서 사용하는 지표들 외의 사용자의 특성이나 전체적인 경향성을 더욱 뚜렷하게 나타내는 다른 지표들을 추가로 고려할 수 있을 것이다.

그러나 본 논문에서 제시된 방법은 기술적으로는 별다른 장비 없이 모바일 환경에서 쉽게 설치해서 대규모 사용자 정보를 수집, 분석할 수 있으나 개인정보보호와 관련된 사용자의 사전 동의 등과 같은 보완이 필요하며 동시에 소비자의 자발적인 참여를 이끌어 낼 수 있는 보조적인 인센티브에 대한 연구도 필요할 것으로 판단된다.

Acknowledgments

본 연구는 한국연구재단을 통해 과학기술정보통신부의 기초연구사업으로부터 지원받아 수행되었습니다(no. 2021R1A4A5028907).

References

- Statistics Korea. Online Shopping Trend Survey: Transaction Amount by Sales Medium/Product Group of Online Shopping Mall [Internet]. Available: https://kosis.kr/statHtml/statHtml.do?orgId=101&tblId=DT_1KE10071&conn_path=I3, .

- J. Y. Kang, Y. M. Kim, J. W. Shin, S. J. Jung, and M. H. Yoon, “User Diary Record-based User Segmentation Methodology Proposal: Case of User Segmentation in m-Commerce,” in Proceedings of HCI KOREA 2020 Academic Conference, Gangwon, pp. 772-776, February 2020.

- Visual Camp. SeeSo SDK [Internet]. Available: https://visual.camp/, .

- H. J. Baek and Y. T. Park, “Robust Particle Filter Based Route Inference for Intelligent Personal Assistants on Smartphones,” Journal of KISSE, Vol. 42, No. 2, pp. 190-202, Feburary 2015.

-

J. D. Oh and H. Y. Oh, “A Comparative Analysis of Personalized Recommended Model Performance Using Online Shopping Mall Data,” Journal of the Korea Institute of Information and Communication Engineering (JKIICE), Vol. 26, No. 9, pp. 1293-1304, September 2022.

[https://doi.org/10.6109/jkiice.2022.26.9.1293]

-

J. W. Kang and Y. Namkung, “The Effect of Perceived Risk, Perceived Usefulness, and Perceived Ease of Use for Coffee Brand Mobile Apps on Trust and Continuance Intention: Applying Privacy-Calculus Theory and a Technology Acceptance Model,” Journal of Tourism Sciences, Vol. 41, No. 4, pp. 79-94, April 2017.

[https://doi.org/10.17086/JTS.2017.41.4.79.94]

-

G. Y. Kim and K. J. Park, “A Data-driven Approach to Categorization of Mobile Applications and Analysis of Application Attributes Affecting User Evaluation,” Journal of the Korean Institute of Industrial Engineers, Vol. 46, No. 2, pp. 156-163, April 2020.

[https://doi.org/10.7232/JKIIE.2020.46.2.156]

-

B. G. Lee and C. H. Son, “Improving Evaluation Metric of Mobile Application Service with User Review Data,” Journal of Korea Academia-Industrial Cooperation Society (JKAIS), Vol. 21, No. 1, pp. 380-386, January 2020.

[https://doi.org/10.5762/KAIS.2020.21.1.380]

- D. S. Kim, H. D. Noh, S. H. Oh, J. H. Choi, and Y. R. Lee, “User-participating Running Program Service Design Incorporating AI - Focusing on Personal Health and Contextual Data Analysis,” in Proceedings of HCI KOREA 2022 Academic Conference, Online, pp. 727-730, Feburary 2022.

-

J. W. Jeong, J. Y. Lee, and C. S. Leem, “An Analysis of Characteristics and User Reactivity by Video Categories on YouTube,” Journal of Digital Contents Society, Vol. 20, No. 12, pp. 2573-2582, December 2019.

[https://doi.org/10.9728/dcs.2019.20.12.2573]

-

J. K. Kim, Y. R. Seo, Y. D. Heo, and G. S. Noh, “Realtime Analysis on the Pattern of Restaurant Users using SNS Information,” Journal of Korean Institute of Intelligent Systems, Vol. 29, No. 6, pp. 458-463, December 2019.

[https://doi.org/10.5391/JKIIS.2019.29.6.458]

-

J. S. Jang, “A Study on Methodology of Analysis of Product Design Required in the Ubiquitous Age,” Journal of Digital Design (KDDA), Vol. 8, No. 1, pp. 423-433, January 2008.

[https://doi.org/10.17280/jdd.2008.8.1.040]

- T. Y. Kim and D. H. Shin, “Feasibility Study of Elaboration Likelihood Model(ELM) on Interactive Marketing Communication : Through Measures Using the Eye-tracker and Surveys with the Twitter,” in Proceedings of HCI KOREA 2012 Academic Conference, Gangwon, pp. 954-956, January 2012.

-

S. M. Park and J. H. Kim, “Basic Study on Selective Visual Search by Eyetracking - Image Around the Department Store Space -,” The Journal of the Korea Institute of Interior Design, Vol. 24, No. 2, pp. 125-133, April 2015.

[https://doi.org/10.14774/JKIID.2015.24.2.125]

-

J. H. Kim and G. Y. Choi, “Visual-perception of Different Images at the Identical Interior-space - Through Sensibility Evaluation and Eye-tracking Test -,” The Journal of the Korea Institute of Interior Design, Vol. 27, No. 4, pp. 48-56, August 2018.

[https://doi.org/10.14774/JKIID.2018.27.4.048]

- A. W. Joseph and R. Murugesh, “Potential Eye Tracking Metrics and Indicators To Measure Cognitive Load in Human-Computer Interaction Research,” Journal of Scientific Research, Vol. 64, No. 1, pp. 168-175, January 2020.

-

E. Lindén, J. Sjöstrand, and A. Proutiere, “Learning To Personalize in Appearance-based Gaze Tracking,” in Proceeding of the 2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW), Seoul, pp. 1140-1148, October 2019.

[https://doi.org/10.1109/ICCVW.2019.00145]

-

K. Krafka, A. Khosla, P. Kellnhofer, H. Kannan, S. Bhandarkar, W. Matusik, and A. Torralba, “Eye Tracking for Everyone,” in Proceeding of the 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas: NV, pp. 2176-2184.

[https://doi.org/10.1109/CVPR.2016.239]

-

M. Zhang, Y. Liu, and F. Lu, “GazeOnce: Real-time Multi-person Gaze Estimation,” in Proceeding of the 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans: LA, pp. 4187-4196, June 2022.

[https://doi.org/10.1109/CVPR52688.2022.00416]

- J. S. Kim, “Physiology of Eye Movements,” Annals of Clinical Neurophysiology, Vol. 1, No. 2, pp. 173-181, November 1999.

- Tobii Technology. The Tobii I-VT Fixation Filter Algorithm Description [Internet]. Available: http://www.vinis.co.kr/ivt_filter.pdf, .

-

M. Wulder, K. O. Niemann, and D. G. Goodenough, “Local Maximum Filtering for the Extraction of Tree Locations and Basal Area from High Spatial Resolution Imagery,” Remote Sensing of Environment, Vol. 73, No. 1, pp. 103-114, July 2000.

[https://doi.org/10.1016/S0034-4257(00)00101-2]

저자소개

2020년~현 재: 덕성여자대학교 사이버보안전공 학사 과정

※관심분야:데이터 분석, 인공지능

2020년~현 재: 덕성여자대학교 사이버보안전공 학사 과정

※관심분야:데이터 분석, 인공지능

1997년:서울대 전기공학부 (공학사)

1999년:서울대 전기공학부 대학원 (공학 석사, 반도체 물리 전공)

2006년:서울대 전기컴퓨터공학부 대학원 (공학박사, 컴퓨터 그래픽스 전공)

2018년~현 재: 덕성여자대학교 공과대학 사이버보안/IT미디어공학과 부교수

2013년~2017년: 덕성여자대학교 정보미디어대학 디지털미디어학과 조교수

2006년~2013년: 고려대학교 연구교수

※관심분야:컴퓨터그래픽스, 인공지능, 수치해석, 3차원 모델링