시각장애인을 위한 음성 보고서 생성기의 이미지 삽입 기능 구현

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

코로나19의 영향으로 비대면 플랫폼 사용 빈도가 폭증하는 방향으로 사회적 환경이 변화하고 있지만, 이러한 변화는 오히려 장애인에게는 온라인 접근의 취약성을 야기한다. 특히 시각장애인은 학습 측면에서 시각 자료의 중요성이 강조되는 소프트웨어 접근에 어려움을 겪고 있다. 이에 시각장애인을 위한 음성 보고서 생성 시스템이 개발되었지만, 보고서에 시각 자료를 삽입하는 기능은 지원되고 있지 않다. 따라서 본 논문에서는 이미지 삽입 기능을 구현하여 기존 시각장애인용 음성 보고서 작성 시스템을 고도화시키는 것을 목표로 하였다. 사용자가 원하는 이미지를 음성으로 검색하면 해당 이미지에 대한 캡션을 생성하고, 사용자는 생성된 캡션을 음성으로 듣고 원하는 이미지를 선택하여 보고서에 삽입할 수 있게 하였다. 실험 결과, 시각장애인들도 큰 오버헤드 없이 원하는 이미지를 보고서에 삽입할 수 있음을 확인하였다.

Abstract

The COVID-19 pandemic has caused the social environment to change, resulting in a surge in the frequency of non-face-to-face platform use. However, the changing social environment has led to challenges in online access for the differently abled. In particular, the visually impaired face difficulties in accessing software, and this emphasizes the importance of visual materials in learning. A voice report generation system for the visually impaired has been developed to address the aforementioned issue; however, the system does not support the insertion of visual data into reports. Therefore, this study aims to upgrade the existing voice report generation system for the visually impaired by implementing an image insertion function. When the user searches for a desired image by voice, a caption is generated for the image, allowing the user to listen to the generated caption by voice, select the desired image, and insert the image into the report. The experimental results confirmed that the visually impaired can insert the desired image into the report without much overhead.

Keywords:

Visually impaired, Voice recognition, Mobile computing, Speech-based report, Image insertion키워드:

시각장애인, 음성 인식, 모바일 컴퓨팅, 음성 보고서, 이미지 삽입Ⅰ. 서 론

코로나19로 언택트 시대가 도래함에 따라 교육 및 업무 시설 등에서의 온라인 활용이 증가하였다. Zoom 또는 Google Meet 프로그램을 활용한 수업과 회의 증가, 온라인 쇼핑 및 결제와 같은 비대면 경제 성장 등의 비접촉 및 비대면 플랫폼의 고도화로 사회적 환경이 변화하고 있다. 이러한 변화는 언어적 상호작용이 수월하며 효과적으로 과업을 수행할 수 있는 반면[1], 장애인에게는 온라인 접근의 취약성을 야기한다.

각 대학에서는 장애 학생 지원센터를 운영하며 교육 환경 개선 및 학습 지원을 위해 노력을 기울여 왔다[2]. 하지만 '대학 장애 학생 교육권 실태조사 보고서'(2021)에 따르면 급격한 비대면화의 확산으로 학습권 침해를 경험한 응답자는 30.9%에 이른다. 특히 장애 학생은 소프트웨어 접근성에 한계를 가지는데, 그 중 시각장애를 가진 학생은 접촉이 차단되고 시각적 자료의 비중이 많아진 언택트 시대 속에서 소프트웨어 접근에 현저한 어려움에 직면해 있다.

이를 해결하기 위해 선행 연구를 조사한 결과, [3]은 시각장애인을 위한 음성 보고서 생성 시스템을 통해 음성 보고서 생성기에 제목, 문단, 챕터 등을 보고서에 삽입하고 삭제, 추가, 수정할 수 있는 기능을 구현하였다. 하지만 시각 자료가 정보 전달력과 보고서의 질을 향상시킴에도 불구하고 보고서에 시각 자료를 삽입하는 기능은 지원되고 있지 않다.

따라서 본 논문에서는 선행 연구를 기반으로 이미지 삽입 기능을 구현하여 시각장애인을 위한 음성 보고서 생성 시스템을 고도화 하였다.

• 시각장애인은 음성으로 삽입하고자 하는 이미지를 설명한다.

• 시각장애인은 검색된 이미지의 캡션을 듣고 보고서에 삽입할 이미지를 선택할 수 있도록 한다.

Ⅱ. 관련 연구

본 논문의 주 기능이 이미지 삽입이 가능한 음성 보고서 생성기인 것을 감안하여 이와 관련된 기존하는 음성 문서 편집기에 대해 설명하고, 본 논문에서 제안하는 시스템과 비교하여 이들이 가지는 한계점을 설명한다.

2-1 기존 음성 기반 보고서 서비스

음성을 인식하여 텍스트로 변환시키는 Speech-to-Text 기술을 활용한 다양한 서비스가 등장함에 따라 시각장애인을 위한 문서 편집기도 계속해서 구현되고 있다. 따라서 이번 절에서는 현존하는 음성 기반 문서 편집기와 메모 기능을 가진 서비스에 대해 알아본다.

Braina는 Brainasoft에서 제공하는 Windows PC용 지능형 개인 비서로, 전 세계 100개 이상의 언어를 지원하는 소프트웨어이다[4]. 특히 받아쓰기 모드에서는 MS Word, Google Docs 등의 소프트웨어에 음성을 텍스트로 변환하여 작성할 수 있다. 악센트를 인식하고 웹 검색을 지원한다는 특징이 있지만, 텍스트 외의 이미지나 도표 등은 삽입할 수 없다. 또한, 보고서 작성을 위해서는 받아쓰기 모드를 활용해야 하는데, 이는 1년에 79달러라는 비용을 지불해야 하므로 사용자 입장에서는 부담을 느낄 수 있다는 단점이 있다.

네이버 클로바 노트는 AI 기술을 활용한 음성 기록 관리 서비스로, 음성 녹음을 업로드하면 자동으로 텍스트로 변환하여 노트를 만들어 준다[5]. 미팅이나 회의 등 중요한 내용을 모두 기록 및 정리하기 어려운 상황에서 많이 사용하며, 생성된 노트는 다시 음성으로 들을 수 있다. 검색을 통해 원하는 내용이 기록된 부분을 찾을 수 있고, 자동으로 내용을 요약해주는 기능까지 제공한다. 하지만 시각장애인을 위해 구현된 서비스가 아니기 때문에, 비시각장애인에 비해 사용하기 어렵다는 단점이 있다.

VTR4VI는 본 논문의 선행 연구인 ‘Implementation of Voice-Based Report Generator Application for Visually Impaired’에서 개발한 음성 보고서 생성 모바일 어플리케이션으로, 상기 2가지 서비스의 한계점을 해결하여 시각장애인이 독립적으로 음성 명령과 내용을 통해 보고서 생성을 할 수 있도록 한다[3]. ‘파일 편집하기’ 기능을 제공하여 작성한 보고서를 단어 단위로 수정하고, 작성한 내용을 확인할 수 있다. 또한, 보조 기기를 사용하여 앱을 작동하여 시각장애인이 보다 효율적으로 앱을 사용할 수 있는 것이 특징이다. 하지만 이미지 삽입이 불가능하다는 단점이 있다.

2-2 기존 서비스의 한계

위에서 살펴본 Braina와 네이버 클로바 노트는 시각장애인이 사용하는데 어려움이 존재한다. 이를 해결하기 위해 선행 연구에서 제안한 VTR4VI는 시각장애인용 모바일 서비스이기 때문에 사용하기에 편리하고 텍스트만이 아닌 표까지 삽입이 가능하다는 장점이 있다. 하지만, 정보 전달력에 도움이 되는 시각 자료는 삽입이 불가능하다는 점에서 아쉬움이 존재한다.

따라서 본 논문에서는 이를 고도화시켜 음성으로 이미지를 검색하고, 해당 이미지에서 생성된 캡션을 듣고 사용자가 직접 원하는 이미지를 선택하여 보고서에 삽입할 수 있는 기능을 구현하였다.

Ⅲ. 음성 기반 이미지 삽입 기능의 설계 및 구현

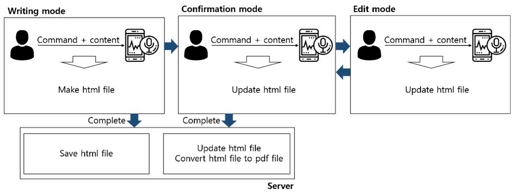

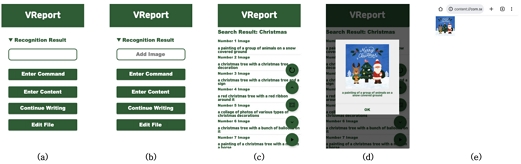

음성 기반 이미지 삽입 기능이 구현된 (이하 VReport)는 선행 연구에서 구현한 VTR4VI를 고도화시킨 모바일 어플리케이션이다. 선행 연구인 VTR4VI의 기능은 제목, 문단, 챕터 등을 보고서에 삽입하고 삭제, 추가, 수정 기능으로, 그림 1과 같은 과정으로 동작한다. VReport는 VTR4VI에 음성으로 검색한 이미지에 대한 캡션을 듣고 보고서에 이미지를 삽입하는 기능을 더하였다.

그림 2는 VReport의 주 목적인 ‘이미지 삽입’ 실행 화면이다. 메인 화면인 그림 2(a)의 ‘명령 입력’을 통해 “그림 추가” 명령을 입력하고, ‘내용 입력’을 통해 삽입하고자 하는 이미지에 대한 내용을 입력할 수 있다.

Screenshots of the VReport application: (a) main, (b) “Add Image” command recognition, (c) image crawling & captioning results, (d) image checking function, (e) image insertion into report

또한, 시각장애인이 모바일 기기를 조작할 수 있도록 도와주는 블루투스 리모컨인 보조 기기를 함께 사용한다.

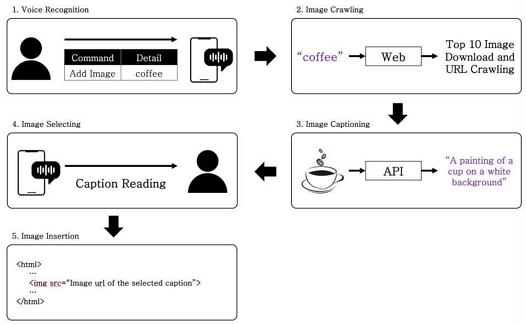

3-1 VReport의 이미지 삽입

이미지 삽입은 그림 3과 같이 음성으로 ‘이미지 크롤링 -> 이미지 캡션 생성 -> 캡션을 듣고 이미지 선택 -> 보고서에 삽입’하는 과정으로 진행된다. “그림 추가” 명령은 html의 ‘img’ 태그로 변환되며, 다음으로 입력하는 내용은 삽입을 위한 준비 과정을 거친 후 ‘src’ 속성에 URL로 삽입된다.

이미지 삽입을 위한 명령과 내용을 인식하는 단계로, 그림 2(a)의 메인 화면에서 진행한다. 보고서 작성 도중 그림을 추가하고 싶은 시점에 “그림 추가” 명령을 음성으로 입력하고, 원하는 이미지에 대한 설명을 입력하면, 구글 speech API가 그 음성을 텍스트로 변환한다. 본 단계에서는 “그림 추가” 명령이 제대로 인식되었는지 여부를 소리 알림으로 알려준다.

음성으로 입력한 내용을 구글에 검색하여 크롤링하는 단계로, 웹 브라우저를 자동화하는 도구인 Selenium에서 제안하는 브라우저를 구동하고 조작하는 WebDriver 라이브러리를 활용하여 이미지 크롤러를 구현하였다[6]. 구현한 크롤러는 서버로 전송된 내용을 구글에서 검색하고, 검색 결과 이미지 중 상위 10개를 크롤링하여 이미지와 URL을 저장한다.

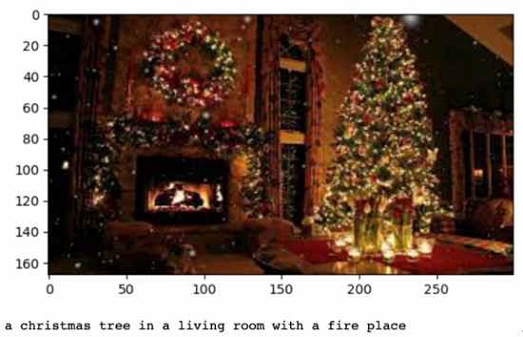

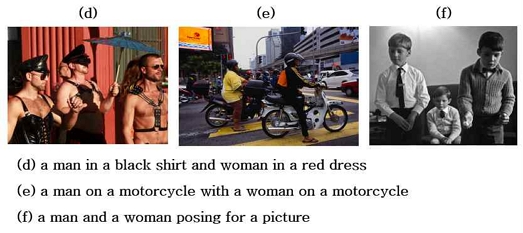

크롤링한 이미지에 대한 캡션을 생성하는 단계로, Txtai에서 제공하는 Image Caption Pipeline Processing Framework[7]를 사용하여 이미지의 캡션을 생성한다. 그림 4는 Framework를 사용하여 이미지 캡션을 정상적으로 생성하는 것을 보이고 있다. 이렇게 생성된 캡션과 ‘단계 2’에서 저장한 이미지의 URL을 클라이언트로 전송하여 다음 단계인 ‘단계 4’를 진행할 수 있도록 한다.

사용자가 캡션을 듣고 원하는 이미지를 선택하는 단계로, 그림 2(c)에 해당한다. 서버에서 받은 캡션을 리스트뷰로 띄운다. 리스트뷰의 아이템이 선택되면 안드로이드에 내장된 TTS(Text-to-Speech) 기능을 사용하여 선택된 아이템의 캡션을 읽어준다. 추가로, 시각장애인의 정의와 판정 기준[8]에 따라 이미지를 어느 정도 식별할 수 있는 사용자 또는 비시각장애인 사용자가 캡션에 해당하는 이미지를 확인하려는 경우도 존재할 수 있다.

이러한 상황을 대비하여 캡션을 선택하고 ‘이미지 확인’ 버튼을 클릭하면 그림 2(d)와 같이 이미지와 캡션이 삽입된 팝업 창이 뜨고, 이를 통해 이미지를 확인할 수 있다. 마지막으로 사용자는 캡션을 듣고 원하는 캡션을 선택할 수 있고, ‘삽입’ 버튼을 보조 기기로 클릭하면 ‘단계 5’로 넘어간다.

선택한 이미지를 보고서에 삽입하는 단계이다. ‘단계 4’에서 선택한 캡션에 해당하는 이미지의 URL을 html 형식의 보고서에 ‘img’ 태그 내 ‘src’ 속성에 삽입한다. 최종적으로 그림 2(e)와 같이 보고서에 삽입된 것을 확인할 수 있다.

Ⅳ. 사용성 평가

본 장에서는 VReport의 주 목적인 음성 기반 이미지 삽입 기능의 편의성과 효율성을 검증한다. 평가는 Blind 여부에 따른 시스템 사용 시간 차이를 실험하여 시각장애인이 사용하기에 적합한 시스템인지를 평가하는 방식으로 수행하였다.

4-1 참여자

평가는 Blind 여부를 기준으로 수행되기 때문에 비장애인이 눈을 가렸을 때와 가리지 않았을 때로 구분하여 수행한다. 사용성 평가에 참여한 참가자는 보고서 작성 작업을 많이 수행하는 20~30대의 학생 또는 직장인 10인으로 구성하였다.

4-2 실험 설정

평가를 수행하기 전, 모든 참가자에게 본 시스템과 보조 기기에 대해 적응할 시간과 시스템에 대한 교육을 충분히 제공한다. Blind와 Non-Blind의 두 상황 모두 동일한 시나리오에 대해 보조 기기를 이용하여 동일한 조건으로 진행한다. 시나리오는 표 1과 같다.

파일 생성부터 제목 작성, 문단 작성, 이미지 삽입까지 완성하는 데 소요된 시간을 측정하는데, 원활한 결과 통계를 위해 해당 작업에 대해 입력하는 내용의 단어 수를 제한하였다. 또한, 실험이 모두 종료된 후 Blind 여부에 따른 만족도를 설문으로 측정하여 본 시스템의 유용성과 편의성을 평가한다.

4-3 사용성 평가 결과 분석

앞서 설정한 참가자와 실험 기준을 토대로 사용성 평가를 수행하여 시스템의 효율성과 편의성을 판단한다. 판단의 첫 번째 기준은 시나리오 수행 시간, 두 번째 기준은 설문으로 측정된 사용자의 만족도이다.

Blind와 Non-Blind 경우의 수행 시간 차이가 짧을수록 시각장애인도 비장애인과 유사한 성능을 내며 보고서를 작성할 수 있다는 의미이다.

따라서 첫 번째 기준에서는 표본들의 이질성을 확인할 수 있는 T-검정 방법을 사용한다, 이를 통해 Blind 여부에 따른 수행 시간의 평균이 통계적으로 유의한가를 판단한다[9].

두 번째 기준에서는 참가자가 직접 응답한 설문 결과를 바탕으로 시각장애인이 사용하기에 적합한 시스템인지, 이미지 삽입 기능이 편리한지를 판단한다.

표 2는 사용성 평가를 수행한 결과를 평균한 것으로, 이를 이용하여 결과를 분석한다.

• 이미지 삽입 작업에 대한 사용성 평가 결과 분석

본 사용성 평가는 Blind의 여부가 기준이기 때문에, 이미지 삽입 작업에 대한 Blind 수행 시간과 Non-Blind 수행 시간을 비교하였다. 이미지 삽입을 수행하기 위하여 Blind의 경우 평균 117.4초가 소요되었고, Non-Blind의 경우 평균 107.9초가 소요되었다.

두 경우에 대한 T-검정을 수행한 결과, P-Value가 0.11로 알파 값인 0.05를 초과하므로 통계적으로 유의하지 않다는 것을 확인하였다.

• 전체 작업에 대한 사용성 평가 결과 분석

다음으로 파일 생성부터 제목 작성, 문단 작성, 이미지 삽입까지 전체 작업에 대한 Blind 수행 시간과 Non-Blind 수행 시간을 비교하였다. 전체 작업을 수행하기 위하여 Blind의 경우 평균 167.8초가 소요되었고, Non-Blind의 경우 평균 150.3초가 소요되었다. 두 경우에 대한 T-검정을 수행한 결과, P-Value가 0.07로 알파 값인 0.05를 초과하므로 통계적으로 유의하지 않다는 것을 확인하였다.

따라서 VReport를 수행할 때 Blind 여부는 통계적으로 유의미한 차이를 나타내지 않으므로, 시각장애인 또한 본 시스템을 수행하기에 적합하며, 비장애인이 수행할 때와 유사한 성능을 낼 수 있다.

표 3은 사용성 평가 이후 수행한 만족도 설문 결과를 나타낸 것으로, 이를 이용하여 시스템의 적합도와 편의성을 판단한다. 설문은 0 (매우 불만족) ~ 5 (매우 만족)의 척도로 진행하였다.

보고서 작성에 대한 만족도, 이미지 삽입 기능에 대한 만족도, 전반적인 시스템에 대한 만족도 모두 4.5점 이상으로 평균적으로 만족도가 높은 것을 확인할 수 있다. 또한, 사용자들은 본 시스템에 대해 “Want to search for more images”, “Voice recognition is not enough”, “Too bad I couldn’t insert images such as charts and graphs”와 같은 피드백을 제공하였다.

Ⅴ. 성능 평가

본 시스템에서는 음성으로 검색된 이미지들 중에서 사용자가 원하는 이미지를 선택하여 삽입하도록 하기 위해 이미지 캡션을 음성으로 읽어준다. 이 과정에서 Txtai에서 제공하는 Image Caption Pipeline Processing Framework를 사용하여 검색된 이미지에 대해 캡션을 생성하는 작업이 수행된다.

해당 Framework의 이미지 캡션 생성 및 정확도 비교를 위해 MS COCO 데이터 셋을 사용한다. 데이터 셋에서 랜덤으로 선정된 5,000개의 이미지와 각 이미지에 제공되는 5개의 annotation을 사용하였다.

5-1 이미지 캡션 생성 평가

평가는 MS COCO에서 제공하는 캡션과 본 시스템에서 생성하는 캡션의 유사도를 비교하여 성능을 측정하는데, BLEU(Bilingual Evaluation Understudy) 점수를 사용하여 평가를 진행한다[10]. BLEU 점수는 0~1 사이의 수로 점수를 나타낸다. 점수가 1에 가까울수록 유사도가 높은 것이다. 점수를 100점 만점으로 환산하였을 때, 점수의 해석 기준은 표 4와 같다[11].

5-2 성능 평가 결과 분석

앞서 기술한 방식과 기준으로 이미지 캡션의 성능 평가를 수행하여 정확도를 판단한다. 성능 평가를 수행하여 측정된 BLEU 점수를 100점 만점으로 환산하였을 때, 70.62점이 산출되었다. 평균 70.62점은 50점 이상이므로 일반적으로 적절하고 우수한 유사도를 지닌다고 판단된다.

우수한 유사도를 지닌다고 해석되는 50점에서 대략 20점이 높은 점수가 산출된, 본 시스템에서 사용하는 프레임워크는 캡션이 잘 생성되고, 이미지를 사용자에게 잘 전달하는 것을 확인할 수 있다.

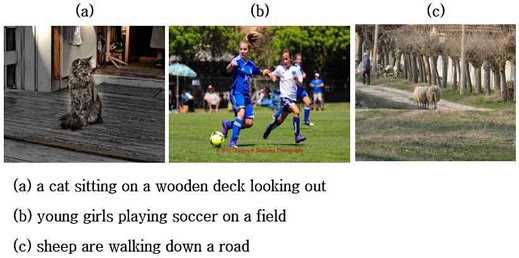

그림 5는 유사도가 매우 높은 예시이고, 그림 6은 유사도가 다소 떨어지는 예시이다. 그림 5를 보면 캡션 생성이 매우 잘 되는 것을 확인할 수 있다. 반면, 그림 6은 유사도가 낮은 예시 세 가지를 나타낸 것이지만 캡션 생성이 아주 엉망은 아닌 것으로 보아, 본 시스템에서 사용한 Framework의 성능이 매우 우수한 것을 알 수 있다.

Ⅵ. 결 론

급격한 비대면 사회의 확산으로 시각 자료 및 소프트웨어의 활용도가 높아지면서 시각장애인의 접근성 문제가 대두되고 있다. 따라서 본 논문에서는 이를 해결하기 위해 시각장애인이 음성으로 보고서를 작성할 수 있는 기존 시스템을 고도화시켜, 이미지 삽입 기능을 구현하였다. 시스템에 대해 사용성 평가와 이미지 캡션 생성 성능 평가를 진행하여 효율성과 편의성, 캡션 생성의 정확도를 검증하였다. 결론적으로 시각장애인이 사용하기에 적합한 시스템이라고 판단되었다.

향후 연구에서는 본 시스템에서 제공하지 않는 도표 이미지를 삽입하는 기능을 개발하고자 한다. 또한, 실제 시각장애인을 대상으로 사용성 평가를 시행함으로써 시스템의 실질적인 개선점을 파악하고자 한다.

Acknowledgments

이 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2022R1F1A1063408).

이 성과는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No.2022H1D8A3037394).

본 연구는 과학기술정보통신부 및 정보통신기획평가원의 SW중심대학지원사업의 연구결과로 수행되었음(2022-0-01087).

References

-

M. J. Park, S. R. Choi, J. Y. Yang, and Y. H. Shin, “A Comparative Study on Computer-Supported Collaborative Learning(CSCL) Support Tools in the Informal Learning Envrironments within Non-face-to-face Work Seetings,” The Journal of Digital Contents Society, Vol. 23, No. 9, pp. 1723-1735, September 2022.

[https://doi.org/10.9728/dcs.2022.23.9.1723]

-

W. Lee, J. H. Lee, and H. N. Lee, “A Study on the Relationship between the Disability Identity of Students with Disabilities and their Adjustment to College: Moderation Effect of Perceived Social Support,” Special Education Research, Vol. 10, No. 3, pp. 245-268, October 2011.

[https://doi.org/10.18541/ser.2011.10.10.3.245]

-

J. Choi, Y. Song, J. Lee, “Implementation of Voice-Based Report Generator Application for Visually Impaired,” Electronics, Vol. 11, No. 12, 1847, June 2022.

[https://doi.org/10.3390/electronics11121847]

- Braina [Internet]. Available: https://www.brainasoft.com/braina/, .

- Naver Clova Note [Internet]. Available: https://clovanote.naver.com/, .

- Selenium [Internet]. Available: https://www.selenium.dev/, .

- Txtai Image Caption Framework [Internet]. Available: https://neuml.github.io/txtai/pipeline/image/caption/, .

- Korea Blind Association [Internet]. Available: http://www.kbuwel.or.kr/Blind/What, .

-

M. Y. Heo and C. W. Lim, “A minimum combination t-test method for testing differences in population means based on a group of samples of size one,” The Korean Journal of Applied Statistics, Vol. 30, No. 2, pp. 301-309, April 2017.

[https://doi.org/10.5351/KJAS.2017.30.2.301]

-

K. Papineni, S. Roukos, T. Ward, and W.-J. Zhu, “BLEU: a method for automatic evaluation of machine translation,” in Proceedings of the 40th Annual Meeting on Association for Computational Linguistics, Pennsylvania, PA, pp. 311-318, July 2002.

[https://doi.org/10.3115/1073083.1073135]

- A. Laive, “Evaluating the Output of Machine Translation Systems,” in Proceedings of the 9th Conference of the Association for Machine Translation in the Americas: Tutorials, Denver, CO, October 2011.

저자소개

2019년 ~ 현재: 숙명여자대학교 IT공학전공 (학사)

※관심분야 : 임베디드 시스템, 모바일 시스템 등

1990년 : 서울대학교 컴퓨터공학과 (학사)

1992년 : 서울대학교 컴퓨터공학과 대학원 (석사)

1996년 : 서울대학교 컴퓨터공학과 대학원 (박사)

1996년~1998년: 현대전자 정보시스템사업본부 과장

1999년~1999년: 현대정보기술 책임연구원

1999년~2002년: 한림대학교 정보통신공학부 조교수

2002년~2003년: 광운대학교 컴퓨터공학부 조교수

2003년~2004년: 아이닉스 소프트(주) 개발이사

2004년~현 재: 숙명여자대학교 IT공학전공교수

2008년 : 뉴욕주립대 스토니브룩 Research Scholar

2012년~2013년: 숙명여자대학교 지식정보처장

2012년~2018년: NAVER 주식회사 사외이사

2014년~2019년: 한국정보과학회 컴퓨팅의 실제 논문지 편집위원장

2020년: 한국정보과학회 총무부회장

2020년~2022년: 숙명여자대학교 공과대학장

2022년~현 재: 숙명여자대학교 소프트웨어중심대학사업단장

※관심분야 : Mobile System Software, Storage Systems, Computational Finance, Cluster Computing, Parallel and Distributed Operating Systems, and Embedded System Software