공간에서 사용자 움직임 감지를 위한 융합 연구

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구에서는 공간내에서 사용자의 인지정보를 취득하기 위한 방법에 대한 연구를 진행하고자한다. 이를 위해서 사용자 인식을 위한 카메라와 초음파 센서를 이용하여 연구를 진행하였다. 공간에서의 사용자 인지 정보에 따른 정보전달을 위한 기술 적용에 관한 연구를 진행한다. 이를 위해서 센서에 대한 분석과 테스트를 기반으로 공간에서 초음파 센서를 이용하여 사용자의 상대적인 위치를 분석하고 영상 기반의 센서를 이용하여 사용자의 움직임에 반응하는 상호작용에 대한 실험 환경 구성과 테스트를 진행하였다. 이를 통하여 사용자와 가상의 캐릭터의 상호작용을 확인할 수 있고, 이러한 작업을 통해서 도출된 정보들을 이용하여 공간 안에서 사용자에게 직관적이고 정확한 상호작용 작업을 진행한다.

Abstract

In this study, as a method of acquiring the user's cognitive information in space, a study using a camera that recognizes the user and an ultrasound-based sensor is to be conducted. Everything that responds to the user's behavior in the space is defined as interaction, and research is conducted on the application of technology for information delivery according to the user's cognitive information in the space. To this end, based on the analysis and testing of the sensor, the relative position of the user was analyzed using an ultrasonic sensor in the space, and the experimental environment configuration and test for the interaction in response to the user's movement were conducted using an image-based sensor. Through this, the interaction of the virtual character can be checked, and intuitive and accurate interaction work is performed for the user in the space by using the information derived through this work.

Keywords:

Interaction, non-contact, IoT(Internet of Things), Sensor, Physical computing키워드:

상호작용, 비접촉, 사물인터넷, 센서, 피지컬컴퓨팅Ⅰ. 서 론

현대의 사회는 다양한 컴퓨팅 기술과 다양한 학문 간의 결합이 이루어지는 미디어 융합의 시대라고 볼 수 있다. 이러한 변화는 기술 중심의 사회에서 개개인에게 맞는 인간의 다양성을 존중하는 시대로 변화하고 있다. 기술이 기술로만 존재하는 시대는 지나가고 예술과 역사, 문화 등 다양한 부분들이 접목되면서 우리 주변의 다양한 공간에서 설치되고, 표현되고 있는 것이다. 특히 사용자가 정보의 전달만을 받던 방식에서 벗어나 개개인에 맞는 정보 전달을 통하여 다양한 방식을 만들어 내고 연구되고 있다. 이를 위한 다양한 방법이 연구되고 있는데 사람의 인지정보를 취득하기 위한 감지기와 같은 장치들을 이용한 방법이 널리 사용되고 있는 추세이다.

사물인터넷 기반의 장치에만 머무르는 것이 아닌 네트워크 환경까지 고려되는 환경으로 발전하면서 더욱 발전되고 있다. 이러한 발전은 교육 분야, 게임분야, 전시분야 등 체험을 통한 양방향적인 정보전달을 통한 발전을 이루어내고 있다. 우리 주변에 존재하는 아날로그 정보를 감지기를 이용하여 디지털 정보로 취득 후 변화하여 원하는 목적에 맞게 가공되어 사용되는 것이다. 특히 이러한 감지기를 이용하여 사용자를 분석하고 다양한 결과를 보여주는 것은 사용자들이 몰입 감을 가지는 중요한 요소로 볼 수 있다. 일반적으로 많이 사용되는 상호작용 방법은 비접촉 감지기를 이용한 방법과 접촉 감지기를 이용한 방법으로 크게 나눌 수 있다. 비접촉 방법은 카메라를 이용한 영상분석 방법이나 초음파 감지기에 의한 거리나 움직임 감지 등이 있다. 접촉 방법은 스마트폰의 터치나 터치스크린을 이용한 무인안내기, 사용자가 특정 위치에 올라서게 되면 감지하는 압력 감지기를 이용한 방법 등을 예로 들을 수 있다[1].

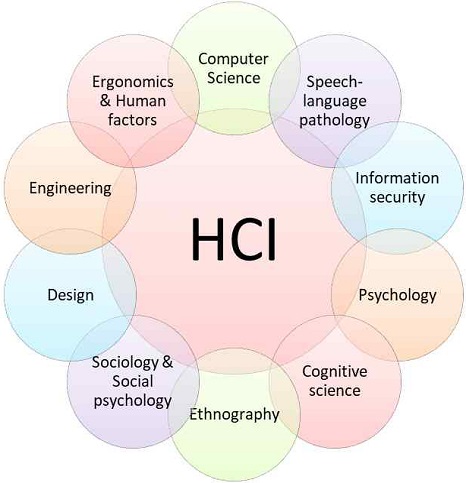

사용자의 정보를 분석하기 위해 상호작용 기술에 대한 내용을 알아야한다. 상호작용의 연구는 HCI(Human-computer interaction)라는 하나의 학문 형태로 정의 발전되고 있다. 그림 1에서 확인하면 우리 주변에 다양한 산업 또는 기술들과 밀접한 관계를 가지고 있다[2]. 상호작용은 사람과 기술기반의 장치들과의 연동을 통한 결과를 만들어 낸다. 특히 이러한 연동이 일어나기 위해서는 특정 공간이나 영역에서 이루어지게 되는데 이러한 공간에서의 인지부분이 매우 중요한 요소라고 볼 수 있는 것이다. 공간 안에서 다양한 체험을 통해 기기와 사용자간의 양방향 소통이 가능하다. 이런 양방향 소통은 사용자가 공간에서 인지하는 상황과 정보를 통해 다양한 생각과 상상을 하게 하면서 다양한 결과를 나타낸다. 이러한 부분은 정보전달이나 오락 등 목적에 따른 정보 전달의 매우 좋은 도구로 사용된다. 우리는 이러한 상호작용 기술을 이용하여 공간에서 사용자의 인지정보를 검출하기 위한 방식에 대한 내용을 확인하고자 한다[3][4].

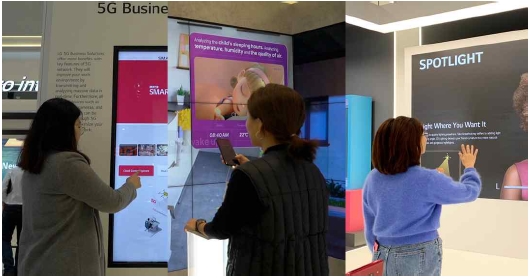

그림 2는 일반적으로 사용되는 감지기와 같은 기기들을 이용한 상호작용 방식을 보여준다. 공간 안에서 (a)와 같이 사용자가 터치스크린과 같은 접촉형 감지기를 이용하는 방식과 (b)와 같이 스마트폰과 같이 잡고 컨트롤 할 수 있는 장치를 이용하여 상호작용하는 방식, 그리고 (c)와 같이 비접촉 감지기 형태인 카메라를 이용하여 영상정보를 이용하고 추가적으로 감지기의 정보를 더해 정밀한 상호작용을 할 수 있도록 하는 방식 이다[5]. (c)와 같이 영상과 감지기 정보의 복합정인 방법은 공간에서 사용자들이 거부감 없이 쉽게 접하게 되는 방식으로 현재 박물관이나 미술관에서 작품과 함께 많이 시도되고 있는 부분이다. 사용자의 움직임 정보를 다각도로 취득하고 분석해서 공간의 특성에 맞는 소리나 영상, 이미지 등 다양하게 표현된다[6]. 터미널이나 백화점과 같이 사람들이 모이는 다양한 공간에서 센싱을 통한 특정 정보 취득 및 전달이나, 사람의 움직임 정보나 이동하는 영역에 대한 센싱을 통하여 정보전달하는 것이다. 우리 주변에는 다양한 감지기들 특히 카메라 장비들이 안전을 위해 설치되어 사용자의 행동분석 및 문제 발생 시 확인 등 광범위하게 사용되고 있다.

공간은 고정되어 있는 특정한 영역을 의미한다. 이러한 공간은 우리가 살아가는 장소로서 상호 연관성을 가지기 때문에 공간은 독립적으로 존재하지 않고 인지라고 하는 자극을 수용하고, 저장하며, 인출하는 과정으로 우리에게 다가온다. 공간에서 인지를 위한 도구로는 다양한 하드웨어를 이용한 센싱작업이 필요하고 이는 감지기와 네트워크가 융합된 형태의 사물인터넷이라는 분야로 정의될 수 있다. 우리가 살아가는데 필수적인 정보통신기술(ICT)의 차세대 핵심으로 꼽히는 사물 인터넷(Internet of Thing: IoT)은 하나로 묶어있는 초연결사회의 기반 기술이며, 네트워크를 기반으로 사물간 정보 전달을 진행한다. 사물인터넷이라는 용어는 공간 안에서 다양한 디바이스들을 이용 식별, 센싱, 작동 능력을 진행하는 다양하고 광범위한 의미를 가지고 있다. 이러한 사물인터넷 서비스는 사물과 사물, 사물과 사람, 사람과 사람과의 다양한 연결을 통해 상호 소통하고 상호작용 하는 형태를 가지고 여러 가지 가치를 창출하게 된다. 이러한 가치 중에 사람 또는 시스템 상에 유익한 정보를 제공하고 도와주는 것을 사물인터넷 서비스라고 말할 수 있다. 이러한 변화를 가져온 사물인터넷은 빅데이터와 인공지능 등 다양한 학문과 융합되어 새로운 형태의 가치를 창출하고 있으며 실제 데이터를 기반으로 정보 전달을 통한 다양한 형태로 발전 제공되고 있다[7]. 오늘날 사물인터넷은 제품 기반의 다양한 활동을 통하여 데이터를 수집하고 정보를 생산하고 있다. 이러한 과정을 통하여 사용자 중심의 맞춤형 방식의 서비스를 제공하고 이를 발전시켜 사물 인터넷 기술은 사람과 사물간의 활발한 네트워킹으로 사용자에게 정보를 종합하여 편리하게 제공하는 형태로 발전하게 될 것이다.

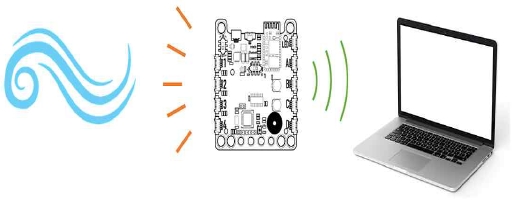

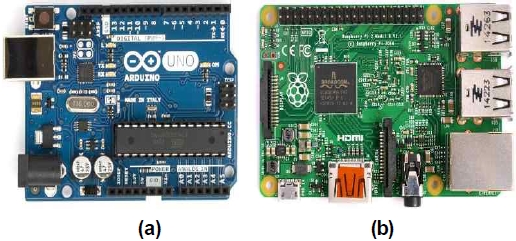

피지컬 컴퓨팅(Pysical computing)은 디지털 기술 및 장치를 이용해서 정보를 입력받고 여러 장치를 통해 현실로 결과를 출력해주는 컴퓨팅 기법을 의미한다. 피지컬 컴퓨팅은 우리가 살아가는 현실 속 데이터를 디지털 형태로 변환하여 컴퓨터와 같은 디지털 기기에서 사용하는 형태로 처리한 후, 그 결과를 출력장치를 이용하여 표현하는 것을 의미한다. 그림3을 보면 크게 3부분으로 나누어 볼 수 있는데 왼쪽에 우리가 살아가는 실세계에서 일어나는 현상을 가운데 부분의 감지기와 같은 하드웨어를 통해서 정보를 디지털화해서 오른쪽에 컴퓨터와 같은 디지털 장치로 전송하여 원하는 동작을 실행하는 것이다. 이를 간단하게 정의하자면 컴퓨터와 우리가 살아가는 환경의 데이터를 통하여 상호작용하는 것이다. 이러한 피지컬 컴퓨팅은 보통 하드웨어(감지기와 엑츄레이터)를 이용해서 아날로그로 구성된 현실세계와 디지털 세계가 서로 상호작용(interaction)하는 시스템을 말한다. 현재 많이 사용되는 피지컬 컴퓨팅의 도구는 아두이노(Arduino)와 라즈베리 파이(Raspberry Pi)를 예로 들 수 있다[8][9].

아두이노란 간단하게 말해보면 아주 작은 소형 컴퓨터라고 볼 수 있다. 여기에는 아트멜사의 AVR이라는 8Bit 마이크로컨트롤러가 들어가 있는데 이것은 우리주변의 전광판, 세탁기, 에어컨 등 전자제어가 필요한 기기에서서 제어를 담당하는 컨트롤러이다. 아두이노는 쉽게 개발 환경을 만들 수 있다. 모듈형태의 부품들과 코딩을 통하여 비교적 쉽게 작동 할 수 있다. 이를 이용하여 우리 주변의 다양한 환경을 감지기와 네트워크 모듈을 이용하여 정보를 취합하고 이를 기반으로 여러 가지 명령을 할 수 있는 것이다. 예를 들어, 문에 감지기를 달아서 입장하는 사람의 수를 세고, 일정 인원이 들어오면 문을 닫는 장치를 만들 수 있습니다. 또 현재의 온도를 측정하여 특정 공간에 정장하고, 무선을 이용하여 방에 등을 켜고 끄는 장치도 만들 수 있다.

라즈베리 파이는 키보드와 마우스, 모니터를 연결하여 네트워크에 연결하고 프로그래밍을 할 수 있는 컴퓨터라고 볼 수 있다. 라즈베리 파이의 운영체제는 리눅스 기반의 라즈비안(Raspbian)으로 아두이노는 컴퓨터에서 프로그램된 코드를 받아서 제어하는 역할이지만 라즈베리 파이는 직접 프로그래밍과 운영을 할 수 있는 점이 틀리다. 라즈베리파이는 주로 일반사용자들 중심으로 인터넷, 영상재생, 웹서버, FTP서버, 기기컨트롤을 중점으로 사용한다. 이중 마지막에 언급한 기기컨트롤 부분이 아두이노에서 주로 사용하는 역할이다. 피지컬 컴퓨팅의 장점은 다음과 같이 생각해 볼 수 있다. 쉽고 편리한 통합개발 환경을 구축할 수 있고, 다양한 부품을 쉽게 구매 사용이 가능하고 부피가 작으며, 많은 사용자들이 소스코드와 제작 과정이 공개하여 제작 및 변형이 용이하다. 그리고 부품 및 방식이 공개되어서 보조 장치를 이용해 각종 모터, 센서, 주변기기 제어가 용이며 확장성이 뛰어나고 신속한 업데이트가 가능하다. 하지만 부품들의 동작원리를 이해하지 못하면 사용할 수 있는 기능이 제한적이며, 소형화된 성능과 메모리 부족 등 하드웨어 적인 한계와 이를 확장해야하는 단점이 존재 한다.

본 연구에서는 공간에서 사용자가 행동하는 요소에 반응하는 모든 것을 상호작용이라고 정의하고, 공간에서의 사용자 인지 정보에 따른 정보전달을 위한 기술 적용에 관한 연구를 진행하고자 한다. 사용자의 인지 정보 취득을 위한 방식은 크게 2가지로 나눌 수 있는데, 접촉형 감지기를 사용하는 방법과 비접촉 감지기를 사용하는 방식이다. 접촉형 감지기는 공간에서 설치 및 유지보수가 용이하지 않기 때문에 우리는 비접촉 형태의 감지기를 활용하여 연구를 진행하고자 한다. 이를 통해서 공간에서 사용자의 인지 정보를 취득 분석하여 상호작용을 하기 위한 판단의 지표로 사용하고자 한다.

Ⅱ. 본 론

2-1 상호작용 연구

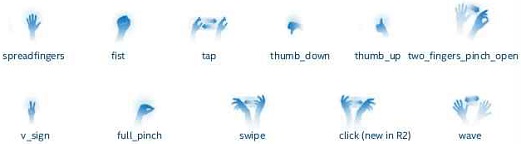

영상 기반의 상호작용 방법은 카메라를 이용한 장치를 주로 사용한다. 영상을 취득 분석하여 공간과 상황에 맞는 데이터를 분석하여 상황을 판단하는 방법이다. 공간에서 카메라의 위치에 대응되는 사용자 또는 변화에 대하여 상호작용을 진행하며, 터치와 같은 접촉에 의해서 이루어지지는 않는다. 하지만 움직임의 추적과 분석, 깊이에 대한 이해 등 사람의 눈과 같은 시각을 확보하기 어려운 부분이 존재하기 때문에 다수의 카메라를 이용하거나 눈에 보이지 않는 적외선 신호를 이용한 복합적인 구성을 통하여 이를 보완한다. 상호작용은 다양하게 사용되고 있는데 그림5는 사용자의 다양한 신체의 움직임에 영상이나 기기가 반응하는 것을 보여주고 있다.

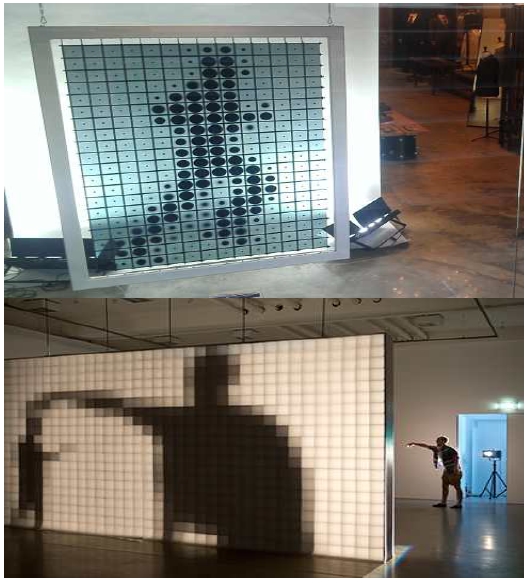

그림 6은 네덜란드의 로테르담 파스시네마 광장에 설치된 미디어아트로 지나가는 사람들을 카메라 추적 장치를 이용하여 감지하고 그림자를 벽에 투사하면서 동시에 다양한 인물 사진이 나타나게 되는 상호작용이며, 아래의 사진은 미국의 LA의 멧 로프트 건물의 파사드이다. 건물과 LED 타일이 연동되면서 사람들의 움직임을 센서로 인지하고 실시간으로 건물에 패턴이 보이는 상호작용을 하게 된다. 이러한 작업들을 통하여 사용자에게 흥미를 유발하고 참여를 유도한다. 위에서 살펴본 상호작용의 사례들에서 카메라 기반의 동작인식 기술은 공간에서 사용자의 움직임과 같은 동작을 감지하여 영상 및 빛, 소리 등의 다양한 방법으로 보여준다. 사용자들은 주변에서 보이고 들려지는 미디어의 형태로 느끼면서 상호작용을 체험하게 된다. 이러한 작업은 사용자에게 친근하고 직관적으로 접근하고 소비되게 된다. 이를 통하여 기술의 어려움 보다는 미디어를 통하여 친근하게 정보를 전달할 수 있는 장점을 가지게 된다.

2-2 영상 기반의 동작 인식

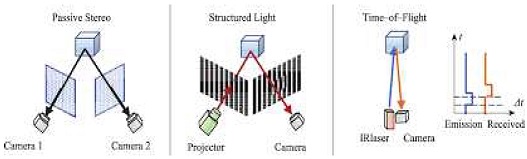

영상 기반의 동작인식은 카메라를 이용하여 사용자의 움직임을 알아내고 추적하여 그 정보를 검출하는 작업을 의미한다. 이렇게 알아낸 영상 정보를 기반으로 컴퓨터를 이용해 원하는 작업을 진행할 수 있다. 이러한 작업은 화면을 터치하거나 아날로그적인 장치들을 움직이는 작업 등처럼 물리적인 접촉을 하지 않고 인터랙션 작업을 할 수 있다. 이러한 작업을 기반으로 첨단산업, 예술, 의료, 교육 등과 같이 여러 분야에서 광범위하게 적용해서 활용할 수 있다. 카메라 영상을 기반으로 움직임을 찾아내고 추적하는 작업을 진행하기 위해서는 깊이정보가 기반이 되는데 콘텐츠제작, 예술 작품 구현과 같이 목적에 따라서 다양한 결과물을 보여주고 있다. 이러한 깊이정보를 측정하는 기술은 그림 7과 같이 3가지로 나누어 볼 수 있는데 스테레오스코프 비전(Stereoscopic Vision), 구조광 패턴(Structured Light Pattern), TOF(Time of Flight) 방식 이다[10]-[12].

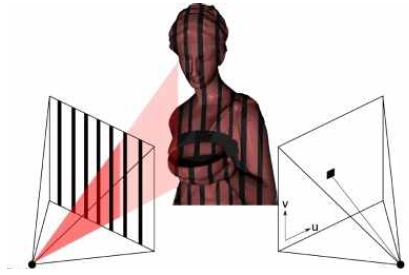

그림 8은 구조광 패턴 방식을 설명하고 있다. 구조광 패턴 방식은 찾아내고자 하는 물체에 그림 왼쪽과 같이 정해진 패턴을 뿌려주고, 이 패턴의 변화를 영상으로 분석하여 대상의 깊이 정보를 추출하는 방식이다. 구조광 패턴 방식의 3D 센서는 마이크로소프트사의 Kinect 제품에 적용되었는데, 이 제품은 μm 단위의 높은 정밀도로 측정이 가능하지만 높은 가격과 느린 속도 그리고 측정거리가 짧다.

인텔사에서 개발한 리얼센스 시리즈는 키넥트와 같이 구조광 패턴 방식을 기반으로 적외선을 이용해서 사물을 인지하는 감지기다[13]. 리얼센스 카메라는 메인 카메라와 적외선 프로젝터, 적외선 카메라로 구성되어 있다. 원리는 적외선을 이용하여 사물의 형태와 거리를 감지하여 이를 기반으로 3D 데이터를 추출하고 영상 촬영된 2D 이미지를 이용해서 물체의 입체적인 이미지를 보여준다.

Ⅲ. 상호작용 시스템

상호작용 시스템을 테스트하기 위해서 우리는 Intel Core i7-7700, GTX1060 기반의 컴퓨터에 시스템을 구성하였다. 여기에 상호작용 시스템을 구성하는데 있어서 영상 기반의 센서를 이용하는 부분과 공간에서의 위치를 특정하기 위한 센서의 사용으로 두 가지 장비를 연결하여 구성하었다. 이는 영상센서만으로 거리를 정확히 분석하는데 어려움이 있는 부분과 거리만으로 사용자의 모션을 추적하기 어려운 단점들을 보완하기 위해서 두 가지 센서를 함께 사용하게 되었다.

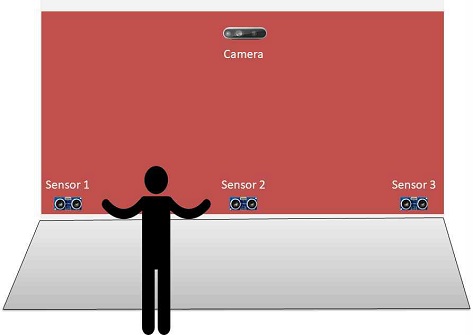

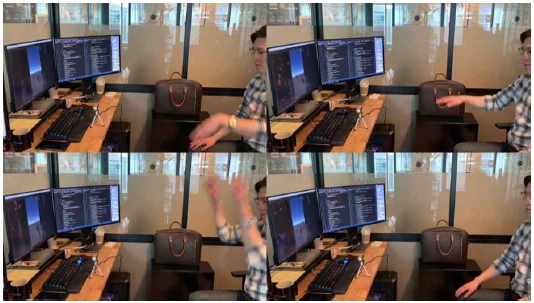

영상 기반의 카메라 감지기 감지는 모션센서인 인텔사의 리얼센스를 시용하고자 한다. 리얼센스는 공간에 설치가 용이하고 다양한 움직임을 센싱할 수 있는 장비라고 판단되었기 때문에 다양한 장비 중에서 선택하여 사용하였다. 리얼센스의 여러 카메라 모델 중에서 D435 모델을 선정하였는데 이 모델은 카메라가 확보할 수 있는 시야각이 다른 모델에 비해 넓고, 측정 거리도 넓어서 다양한 환경에서 사용이 용이하다. 특히 손과 손가락의 위치 정보를 취득하기 위해서 총 22개의 점으로 인식하고 이를 기반으로 손과 손가락을 추적한다. 이를 통해서 사용자의 움직임 정보를 확인하기 위한 손의 제스처 인식을 위한 검출도 정확하게 가능하다. 조금 더 구체적으로 살펴보면 손가락을 말아서 주먹을 쥐고, 손바닥을 편 상태와 손의 움직임을 이용하여 좌우의 움직임 동작을 분석하여 제스처를 감지한다. 이러한 동작을 이용해서 우리는 움직임 감지 시스템을 그림 9와 같은 환경에서 테스트를 진행하였다.

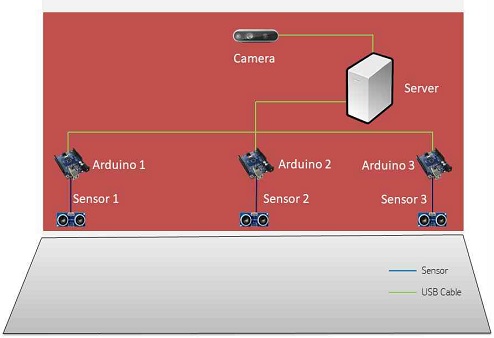

테스트 공간 안에서 카메라는 공간에서의 사용자의 신체 움직임 감지(제스처)와 이동 동선 추적과 관련된 부분을 담당하게 된다. 그리고 아두이노를 이용한 감지기는 공간에서의 거리 추적을 통한 정확한 위치 추정과 공간 조명 제어 부분을 담당한다. 그림 10은 움직임 감지 시스템을 구성하기 위한 하드웨어 구성을 나타내고 있다. 공간에서의 정확한 데이터를 얻기 위해서 다수의 감지기를 사용하게 되는데 이에 공간의 크기에 따라 추가 확장이 용이하다.

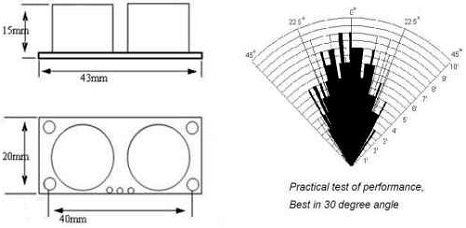

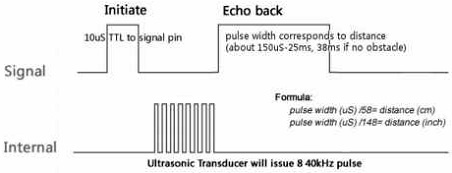

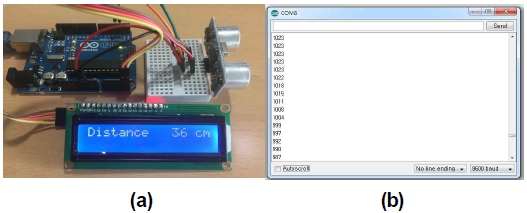

공간에서 사용자 동선의 정확한 위치를 검출하기 위해서 그림 11과 같은 초음파 센서(HC-SR04)를 사용해서 정확한 사용자의 위치 값을 찾아내기 위한 작업을 진행하였다. 이 감지기는 전방 2cm ~ 400cm의 15도까지 정확하게 측정이 가능한 감지기로 공간에서 다양한 위치에 적용 사용자 위치의 거리를 알아내게 된다. 그림 12와 같은 시그널 신호를 통해서 거리 값을 측정하게 되는데 초음파센서의 Trigger 입력을 통해서 10[us]의 펄스를 입력받게 되면, 초음파센서에서는 40[kHz]의 초음파를 8번 연속해서 발생하게 된다. 이때 발생되는 초음파에 의해 나타나는 Echo 출력을 High로 설정해서 보내게 되고, 반사된 초음파를 수신하면 Echo 출력을 Low로 설정하는 과정을 통해서 Echo 출력의 펄스 폭(pulse width)을 주계산하여 거리를 구하게 된다. 그림 13의 (a)와 같이 아두이노를 이용하여 초음파 감지기를 이용하여 거리를 계산하고 이를 디스플레이 패널을 통하여 확인할 수 있는 장치를 제작하여 측정 및 테스트를 진행하였다. 거리 정보의 변화는 (b)와 같이 시리얼 모니터를 통하여 확인할 수 있고 관련 데이터를 저장하여 사용자의 특정 위치에서의 움직임 변화를 추적할 수 있다.

사용자의 공간 이동 및 상호작용 시스템은 크게 3단계로 테스트가 진행되었다. 그림 13을 보면 1차 단계에서 감지기를 이용한 대상의 거리 측정을 위한 실험을 진행하면서 초음파 특성에 따른 대상의 정확한 위치 검출에 대한 테스트를 진행하였다. 2차 단계는 카메라 감지기를 통한 대상의 움직임 추적 및 손동작에 의한 제스처 인식에 대한 테스트를 진행하였다. 그림 14와 같이 사용자의 정보를 카메라 감지기를 통해 입력받아 (a)와 같이 몸의 움직임 검출을 위한 관절 표현작업과 (b)와 같이 신체에서 특정 부위를 찾아내는 작업을 진행하였다. 실험에서는 특정 부위를 제스처 인식을 위한 손의 부분으로 진행하였다. 이렇게 테스트된 2가지 정보를 취합하여 특정 공간에서 사용자가 이동하는 동선에 대한 추적과 정해진 위치에서의 제스처에 대한 테스트를 진행하였다.

영상을 이용하는 카메라는 주변 환경의 변화에 민감하게 반응하는데 이는 빛의 변화에 민감하게 반응하기 때문이다. 그림 15와 같이 이러한 부분을 고려하여 공간에서 테스트가 필요하다. 공간에서 사용자의 움직임에 따른 그림자나 빛의 간섭을 통해서 간섭이 존재하는 부분을 확인하였다. 이러한 부분에 민감하게 반응하지 않도록 예외처리를 하면서 오류를 줄이는 작업을 진행하였다. 사용자가 물체와 겹치거나 동선에 따른 반사에 대한 부분도 예외 처리를 진행하였다. 이러한 부분을 환경에 맞게 적용하여 환경에 최적화 하는 작업을 진행하였다.

정해진 위치에서의 사용자의 손을 이용한 제스처 인식은 여러 가지 형태로 정의할 수 있는데 그림 16과 같이 제스처에 대한 정의를 내린다. 카메라 감지기를 이용하여 손의 다양한 형태를 인식하는 과정과 손의 상하좌우 방향의 움직임을 분류하여 제스처로 분류한다. 정확도를 높이고 오류를 막기 위해서 손의 움직임에 대한 기준이 필요한데 이 부분은 신체의 각 관절의 정보를 이용해서 보완하였다. 사용자의 몸통을 기준으로 잡고 손의 움직임에 따른 이동 추적을 통하여 정확한 동작 인식을 하고자 하였다.

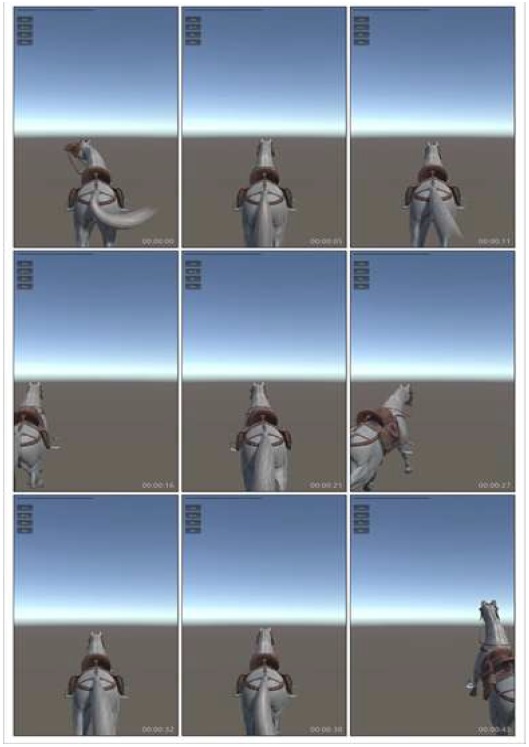

그림 17은 카메라 센서를 이용한 관절의 정보와 손의 움직임을 이용해서 상호작용 테스트를 진행하는 이미지이다. 테스트를 위해서 3D 캐릭터를 이용하여 사용자의 손의 움직임에 반응 테스트를 진행하였다. 리얼센스의 검출 영역이 내인 30~50cm 거리 안에서 손의 움직임을 추적 판별하였다. 이러한 상호작용에 반응해서 3D 캐릭터가 모션에 따라서 좌우로의 이동 및 점프의 세 단계의 움직임과 거리센서를 통하여 가상의 공간에서의 이동하여 목표지점까지 도달하는 방식의 규칙으로 테스트 진행되었다. 또한 직관적인 모션 방법으로 손의 좌우 이동과 위로 올리는 동작을 구분하여 동작인식을 진행하였다. 이를 통하여 시작 지점에서 목표지점까지 이동하는 거리와 동작을 이용하여 테스트를 진행하였다. 그림 18은 테스트 진행에 따른 영상 변화를 이미지로 나타낸 것이다. 거리에 따른 이동과 좌우 및 점프에 대한 테스트 결과를 나타낸다. 테스트를 위한 거리의 구분은 10cm, 30cm, 50cm 거리를 기준으로 디스플레이에 다가서는 사용자의 거리 이동과 움직임을 통해 상호작용을 진행하기 위해서 구현되었다. 테스트에 참여한 사용자들은 움직임을 통하여 영상의 캐릭터가 반응하는 것에 흥미를 가지고 테스트를 진행하였다. 하지만 테스트를 진행하는 과정에서 거리에 따른 센서의 추적은 잘 되었으나 카메라 영상을 통한 부분에 있어서 빛에 의한 간섭 때문에 사용자를 인식하는 부분에 대한 문제점이 발견되었고, 이는 센서의 설치 환경이 중요한 요인으로 발생하였다. 그래서 우리는 빛에 의한 간섭이 적은 유리 재질에 의한 반사, 공간의 마감재에 반사가 최소화되는 공간을 테스트 공간으로 선정하고 센서를 실험하는 환경도 가메라가 빛의 산사를 받지 않게 설치하였다. 이는 카메라를 이용한 테스트에 있어서 빛에 대한 본질적인 문제의 해결이 어렵기 때문에 목적에 맞는 주변 환경을 구성하는 부분이 매우 중요한 요소라는 것을 확인하는 결과를 나타내었다.

Ⅳ. 결 론

현대인들이 살아가는 지금의 사회는 눈부신 속도로 변화하는 사회이다. 새로운 기술의 발전과 다양한 학문들의 교류를 통하여 경계가 사라지면서 서로 배우고 융합하려는 현상이 나타난다. 기술에 예술이 융합되고, 문화에 기술이 적용되면서 다양하게 연구되고 표현되는 것이다. 이렇게 다양한 매체들을 통하여 사용자에게 친근하고 쉽게 다가가면서 어렵지 않게 새로운 지식을 알게 되고, 재미를 느끼면서 사용하게 되는 것이다. 여기에서 중요한 부분을 차지하는 것이 사용자의 정보를 인지하고 이를 디지털화하여 사용할 수 있게 도와주는 상호작용 기술이라고 할 수 있는데, 이는 개개인에 따른 적절한 정보를 전달하기 때문이라고 생각된다. 기술이라고 어렵게만 느껴지던 것, 예술이라고 알아야 보는 거라고 느껴지던 것 등 고정관념에 머무르지 않고 쉽게 다가서고 즐기는 형태로 시작되기 때문에 널리 사용되는 것이다. 특히 기술의 발전에 따른 다양한 장치들의 소형화와 네트워크를 통한 데이터 전송 부분 등이 중요한 역할을 하는 것이다.

이번 연구에서는 공간에서 사용자의 인지 정보를 취득하기 위한 방법으로 사용자를 인식하는 카메라와 사물인터넷 기반의 감지기들을 이용하는 연구를 진행하였다. 공간에서 다양하게 설치되어있는 기기들을 활용하여 사용자가 느끼는 시각, 청각의 형태로 표현하고 보여주는 것, 더 나아가서는 다양한 장치들을 활용하여 오감을 통한 정보 전달을 할 수 있을 것이다. 이는 미디어에 익숙한 현대인들에게는 쉽고 유익하게 정보를 전달하는 방식으로 변화할 것이다. 또한 상호작용성에 대한 연구를 통하여 단방향 적인 정보 전달의 표현에만 머무르지 않고 카메라와 감지기 등 다양한 매개체를 활용하여 콘텐츠를 전달하는 것은 더욱 효과적인 방법이 될 것이다. 이는 단방향 적인 전달방식의 기술이나 정보를 얻게 되는 수동적이며 주입식 방식에서 벗어나 사용자에게 차별화된 정보를 전달 할 수 있는 상호작용 기술을 통해 발전되고 있다. 특히, 기술의 발전을 통해 소형화되는 비 접촉식 동작인식 감지 기기들인 리얼센스와 사물 인터넷 기반 장비가 이러한 대중화에 앞장서고 있다. 현재도 그렇고 앞으로는 더욱 비 접촉 형태의 기술을 통해 사용자와 원하는 대상과의 상호작용하는 방식은 지속적으로 사용될 대표적인 방식이라고 볼 수 있다. 이러한 기술들이 우리 생활에서 다양하게 적용되고 있기 때문에 앞으로 연구를 통해 다양한 장소와 공간에 적용 가능할 것으로 기대된다.

Acknowledgments

본 연구는 세명대학교의 2020학년도 교내연구비 지원에 의해 수행되었음.

References

-

J. Gubbi, R. Buyya, S. Marusic, & M. Palaniswami, "Internet of Things (IoT): A vision, architectural elements, and future directions." Future generation computer systems, Vol. 29, No. 7, pp. 1645-1660, Sep. 2013.

[https://doi.org/10.1016/j.future.2013.01.010]

-

A. Jaimes & N. Sebe, "Multimodal human–computer interaction: A survey." Computer vision and image understanding, Vol. 108, No. 1-2, pp. 116-134, Oct.-Nov. 2007

[https://doi.org/10.1016/j.cviu.2006.10.019]

- W. Haslem, "teamLab Borderless: Bridging Borders in Simulated Ecologies." MAST: The Journal of Media Arts Study and Theory, Vol. 1, No. 2, pp.242-263, 2020.

-

P. Campos, A. Dória & M. Sousa, "Interactivity for museums: Designing and comparing sensor-based installations." In IFIP Conference on Human-Computer Interaction, pp. 612-615, Springer, Berlin, Heidelberg. Aug. 2009.

[https://doi.org/10.1007/978-3-642-03655-2_68]

- L. W. Toh, W. Chao & Y. S. Chen, "An interactive conducting system using kinect." In 2013 IEEE International Conference on Multimedia and Expo (ICME) pp. 1-6, San Jose, CA, USA. July. 2013

- S. Mann and W. P. Rosalind, "Digital Art by teamLab." Proceedings of the 2018 International Joint Workshop on Multimedia Artworks Analysis and Attractiveness Computing in Multimedia, pp. 1-1 June 2018.

-

M. Chiang & T. Zhang, "Fog and IoT: An overview of research opportunities." IEEE Internet of Things Journal, Vol. 3, No. 6, pp. 854-864, Dec. 2016.

[https://doi.org/10.1109/JIOT.2016.2584538]

-

Y. A. Badamasi, "The working principle of an Arduino." In 2014 11th international conference on electronics, computer and computation(ICECCO), pp. 1-4. Sep. 2014

[https://doi.org/10.1109/ICECCO.2014.6997578]

- J. D. Brock, R. F. Bruce & M. E. Cameron, "Changing the world with a Raspberry Pi." Journal of Computing Sciences in Colleges, Vol. 29, No. 2, pp. 151-153, Dec. 2013

- D. A. Forsyth and J. Ponce, "Computer vision: a modern approach,". Prentice Hall Professional Technical Reference, 2002.

-

H. Sarbolandi, L. Damien and K. Andreas, "Kinect range sensing: Structured-light versus Time-of-Flight Kinect.," Computer vision and image understanding, Vol. 139, pp. 1-20, 2015

[https://doi.org/10.1016/j.cviu.2015.05.006]

-

M. Xu & H. Hua "Co-axial depth sensor with an extended depth range for AR/VR applications." Virtual Reality & Intelligent Hardware, Vol. 2, No. 1, pp. 1-11, Feb. 2020

[https://doi.org/10.1016/j.vrih.2019.10.004]

-

L. Keselman, J. I. Woodfill, A. Grunnet-Jepsen & A. Bhowmik, "Intel realsense stereoscopic depth cameras." In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, pp. 1-10 2017.

[https://doi.org/10.1109/CVPRW.2017.167]

저자소개

2007년: 중앙대학교 첨단영상대학원(공학석사)

2013년: 중앙대학교 첨단영상대학원(공학박사)

2007년~2014년: 세명대학교 전기공학과&전자공학과 강사

2010년~2015년: 남서울대학교 멀티미디어학과 강사

2013년~2013년: 강남대학교 컴퓨터미디어정보공학부 강사

2014년~2017년: (주)미디어앤아트 기술운영팀장

2017년~현 재: 애니프레임(주) 솔루션본부 부장

관심분야 : 영상처리, 증강현실, 상호작용, 모션그래픽, 3D 맵핑, 미디어파사드 등

1986년 중앙대학교 전자공학과 졸업(공학석사)

1995년 중앙대학교 전자공학과 졸업(공학박사)

1986년~1987년: 현대전자

1987년~1991년: 금성통신

1995년~현 재: 세명대학교 전기공학과 교수

관심분야 : 영상신호처리, 컴퓨터비전, 수리형태학, 메타버스, 증강현실 등