장수말벌 이미지 퓨전 전처리를 통한 딥러닝 영상인식

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

이미지 퓨전은 여러 장의 이미지에서 모든 중요한 정보를 모아 한 장의 이미지로 만드는 것이다. 한 장의 이미지에는 소스 이미지보다 더 많은 정보를 내재하고 정확하게 만들어져야 한다. 객체의 추적이나 인식을 위해 양질의 이미지를 취득하는 것은 매우 중요하다. 이를 위해, 취득된 이미지를 이미지 퓨전을 통해 합성이나 보상하여 개선된 이미지를 만들어내는 작업이 요구된다. 본 논문에서는 장수말벌의 인식률을 높이기 위해서 취득된 이미지의 퓨전 및 인식 응용 방법에 대하여 제시하고자한다. 장수말벌 이미지에서 임의 영역 블러링된 소스 이미지를 생성하고, 주성분분석 기반 이미지 퓨전으로 통해 합성하였으며, RMSE, PFE, MAE, CORR, SNR, PSNR를 통해 이미지 퓨전 성능을 측정한다. 또한, 심층 합성곱 신경망 기반인 AlexNet을 이용하여, 퓨전 이미지에 대한 인식 스코어와 분류 정확도를 제시한다.

Abstract

The image fusion process is defined as gathering all the important information from multiple images to a single image. This single image is more informative and accurate than any single source image, and it consists of all the necessary information. It is important to acquire a high quality image for tracking and recognizing object. So, it is required to create a refined image by synthesizing or compensating the acquired image through image fusion. In this paper, we would like to present a fusion and recognition application method of the acquired image in order to increase the recognition rate of Vespa mandarinia. Generating a random area blurred source image in a Vespa mandarinia image, and synthesized through the PCA(principal component analysis) based image fusion, and measures the image fusion performance through RMSE, PFE, MAE, CORR, SNR, PSNR. In addition, using the AlexNet based on the DCNN(Deep Convolutional Neural Networks), it presents the recognition score and classification accuracy for the fused image.

Keywords:

Vespa mandarinia, Image Fusion, AlexNet, DCNN(Deep Convolutional Neural Networks)키워드:

장수말벌, 이미지 퓨전, 심층 합성곱 신경망Ⅰ. 서 론

사물 인터넷(IoT)과 농업분야의 비전 데이터 기반 딥러닝 기술을 활용한 스마트팜 기술은 큰 발전을 이루고 있으며[1], 특히 심층 합성곱 신경망(DCNN; deep convolutional neural networks) 기반의 다양한 알고리즘의 등장과 함께, 영상 인식 및 분류의 정확도는 매우 높은 수준이다 [2].

양봉(beekeeping)은 벌을 기르는 분야로, 양봉에 영향을 끼치는 매개변수가 다양하여(온도, 습도, 분봉, 말벌, 진드기 등) 관리가 어렵고 스마트팜 기술을 도입하기가 까다롭다[3]. 양봉가에게 봉군 유지의 가장 큰 장애는 말벌류의 공격이다[4]. 말벌 중에서도 집단공격형을 가진 장수말벌 (Vespa mandarinia)로 부터의 피해가 전체 말벌 피해의 88.5%에 이르는 것으로 보고되고 있다[5].

양봉장에 접근하는 장수말벌을 효과적으로 방제하기 위해서는, 정지 상태가 아닌 비행 중에 추적, 인식하는 것이 필요하다. 그러나 말벌의 영상을 양질의 이미지로서 취득하는 것은 말벌의 비행형태, 카메라의 촬영 각도 및 날씨, 말벌을 부분적으로 가리는 잡음이나 장애물 그리고 느린 셔터스피드에 따른 블러링 등의 영향으로 인해 양질의 이미지 취득이 쉽지 않다. 따라서 취득된 이미지를 합성이나 보상 즉, 퓨전을 통해서 개선된 이미지를 만들어내는 작업이 필수적인 요소가 된다.

이미지 퓨전을 할 때 기준 이미지(reference image)가 없는 경우도 많지만, 장수말벌은 기준 이미지가 있는 경우로, 인식을 하려는 여러 이미지 소스 간의 합성이나 기준 이미지와의 합성을 통해 입력 이미지의 품질을 높이는 것이 가능하다.

본 연구에서는 다양한 형태의 잡음 또는 번짐(blur)이 있는 말벌의 이미지 소소를 주성분 분석(PCA; principal component analysis) 기반 이미지 퓨전(fusion)을 통해 기준 이미지와 합성하여 이미지 소스의 품질을 개선한다. 그리고 개선된 퓨전 이미지를 심층 합성곱 신경망 기반의 인식 알고리즘의 입력으로 사용하여 심층 합성곱 신경망의 스코어 변화나 분류 인식률의 차이가 있었는지를 평가한다.

2장에서는 주성분분석 기반 이미지 퓨전과 이미지 퓨전 성능을 측정하는 기준에 대해서 설명하고, 3장에서는 이미지 퓨전을 수행하고 측정된 성능 지표를 살펴보며, 4장에서는 AlexNet을 이용한 분류 실험을 통해 인식 스코어와 분류 정확도 제시하고, 5장에서 실험결과 제시 및 결론을 맺는다.

Ⅱ. 이미지 퓨전과 DCNN

2-1 픽셀 수준 이미지 퓨전(image fusion)

픽셀 수준 이미지 퓨전은 하나 이상의 소스 이미지를 합성하여 개선된 이미지를 생성하는 알고리즘으로, 목표로 하는 대상을 검출, 인식하고 식별하는데 도움을 주는 기법이다. 퓨전된 이미지는, 적용 대상에 따라 달라질 수는 있으나, 소스 이미지의 관련 정보가 대부분 보존되도록 하는 것이 요구된다. 관계없는 부분이나 잡음을 최대한 제거하거나 줄이는 것이 중요하다[6].

이미지 퓨전을 효과적으로 수행하기 위해 그레이 이미지로 변환하고 픽셀 단위 평균을 구해 적용하게 된다. 이미지 퓨전을 처리하는 방법은 전체 이미지를 사용하여 퓨전하는 방법과, 이미지를 블록으로 분해하고 퓨전하는 방법이 있다[7]. 후자의 방법은 블록 크기나 임계치 조정이 까다로운 면이 있으므로, 본 논문에서는 전체 이미지를 대상으로 PCA(주성분 분석)를 구해 퓨전하는 방법을 적용한다.

주성분 분석은 고유치(eigen value)를 이용하여 상관 변수를 주성분(PC)이라는 비상관 변수로 분해한다. 고유치(λ)와 고유벡터(Vi)는 (식 1)로 구해진다[8].

| (1) |

단, i = 1,2,...,d이고 Vi는 cov(X)의 고유벡터이다.

PCA기반 이미지 퓨전은 (식 2)와 같이 제1주성분(PC1)과 제2주성분(PC2)을 이미지 소스1(I1)과 이미지 소스2(I2)에 각각 곱하여 구한다.

| (2) |

2-2 이미지 퓨전 성능 측정 기준

이미지 퓨전의 성능 및 오차를 측정하기 위해 다음의 측정 기준을 사용한다.

RMSE는 기준 이미지(Ir)와 퓨전 이미지(If)의 차이가 없을 때는 0에 가까운 값이 되고, 픽셀 차이가 클 때 증가한다(식 3)[9].

| (3) |

PFE는 기준 이미지(Ir)와 퓨전 이미지(If)의 norm 차이를 구할 때 사용하며, 차이가 없을수록 0에 가까운 값이 되고, 픽셀 차이가 클 때 증가한다(식 4)[9].

| (4) |

2-3 DCNN(Deep Convolutional Neural Networks)

이미지 퓨전으로 통해 개선된 이미지를 객체의 분류와 관련된 합성곱 신경망의 입력으로 사용하여 인식성능을 평가하고자 한다. 평가 대상 합성곱 신경망으로는 최근 ILSVRC(ImageNet Large-Scale Visual Recognition Challenge)[11]에서 좋은 인식성능을 보인 AlexNet[12]을 사용하였으며 이미지 퓨전 수준에 따른 AlexNet의 인식 정확도 및 인식 스코어를 비교하여 이미지 퓨전에 따른 AlexNet의 성능 변화를 평가하고자 한다.

AlexNet은 8개 계층으로 구성된 컨벌루션 신경망이다[12]. ImageNet 데이터베이스의 1백만 개가 넘는 영상에 대해 훈련된 신경망의 사전 훈련된 모델을 불러올 수 있다. 사전 훈련된 신경망은 영상을 키보드, 마우스, 연필, 각종 동물 등 1,000가지 사물 범주로 분류할 수 있다[2]. 본 논문에서는 5종류의 클래스를 분류할 수 있도록 신경망을 변경하여 사용하였다. 신경망의 영상 입력 크기는 227 × 227 픽셀이다.

전이 학습은 딥러닝 응용 분야에서 널리 사용되는 기법으로, 사전 훈련된 신경망을 새로운 작업을 학습하기 위한 출발점으로 사용할 수 있다. 전이 학습으로 신경망을 미세 조정하는 것은, 무작위로 초기화된 가중치를 사용하여 신경망을 처음부터 훈련시키는 것보다 일반적으로 훨씬 더 빠르고 용이하다. 학습된 특징을 보다 적은 개수의 훈련 영상을 사용하여 새로운 작업으로 빠르게 전이할 수 있다.

본 논문에서는 여러 전이학습 방법 중에서 AlexNet을 사용하여 분류 정확도 및 인식 스코어를 구하며, 이를 위해 Matlab Deep Learning Toolbox를 활용하였다[13]. AlexNet에서 학습된 모델을 전이학습을 통해 확장하여 말벌 데이터를 입력 소스로 사용하고 출력 층의 구조를 5종류의 말벌 이미지 소스에 따른 분류에 적합하도록 변경하여 사용하였다. 학습에 사용한 데이터는 “동해안청정꿀벌영농협협동조합”에서 받은 장수말벌 사진 중에서 선별된 장수말벌 사진을 사용하여 소스 이미지를 생성하였으며, 훈련과 테스트 비율은 7:3으로 설정하였다.

Ⅲ. 이미지 퓨전과 성능 측정

이미지 퓨전을 위한 실험 환경은 CPU i5, RAM 8GB, Windows10 64bit 컴퓨터에서 CUDA v10.1, Cudnn v10.1, NVIDIA TITAN X(Pascal) GPU와 Matlab R2018b를 사용하였다.

3-1 소스 이미지 퓨전

장수말벌 소스 이미지 퓨전에 사용될 기준이미지를 선별하여 그림1에 나타내었다. 기준 이미지와의 합성을 통해 소스 이미지의 품질을 높이게 되고 퓨전 이미지와의 오차율을 계산하는데 사용된다.

기준이미지를 바탕으로 블러된 소스 이미지를 작성한다. 소스 이미지는 훼손된 이미지의 수준에 따른 퓨전과 인식 정확도를 살펴보기 위하여, 직경 12픽셀 가우시안 마스크를 사용하여, 좌우 블러된 이미지, 4분의 1영역만 블러된 이미지 그리고 8분의 1영역만 블러된 이미지로 구분하여 준비한다.

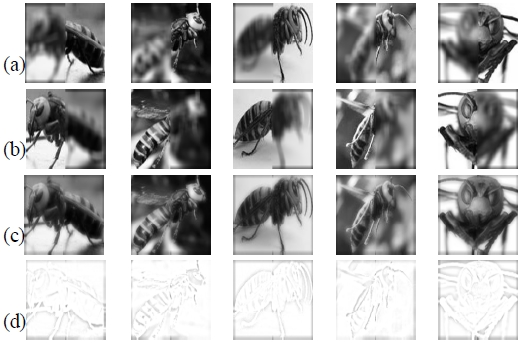

그림2는 5종류의 기준 이미지에 대하여 좌우 블러된 이미지와 퓨전이미지 그리고 퓨전이미지와 기준이미지의 차이를 나타내는 에러 이미지를 제시하였다. 그림3은 동일한 기준 이미지에 대하여 4분의 1영역만 블러된 이미지와 퓨전이미지를, 그림4는 동일한 기준 이미지에 대하여 8분의 1영역만 블러된 이미지와 퓨전이미지를 보여준다.

(a) 1st Quarter Blurred, (b) 2nd Quarter Blurred, (c) 3rd Quarter Blurred, (d) 4th Quarter Blurred, (e) Fused Image

3-2 이미지 퓨전 성능 측정

표 1은 그림2에 대하여 이미지 퓨전 성능을 측정한 결과를 보여준다. 5가지 이미지 소스(Ii)의 PCA기반 이미지퓨전을 수행하고 성능을 측정한 값으로, 이미지 소스(Ii)와 퓨전후(If)의 성능 및 오차를 변화를 보여준다.

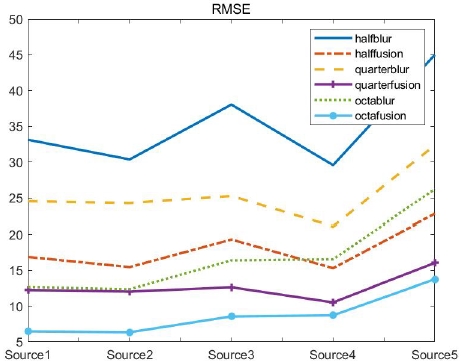

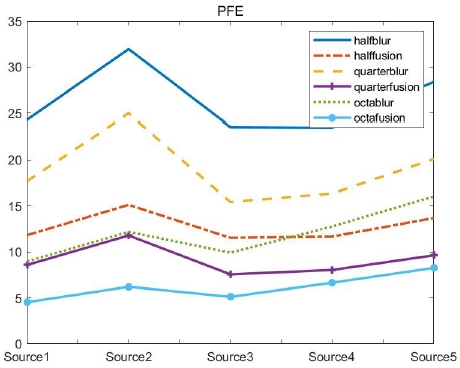

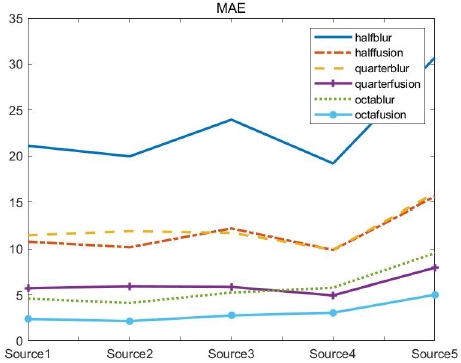

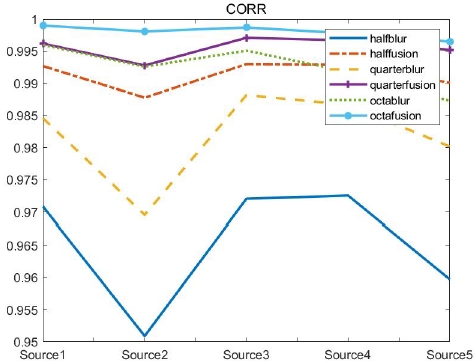

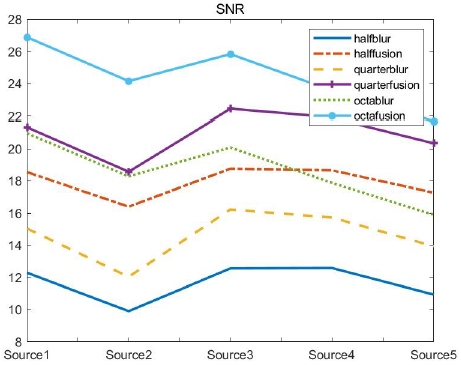

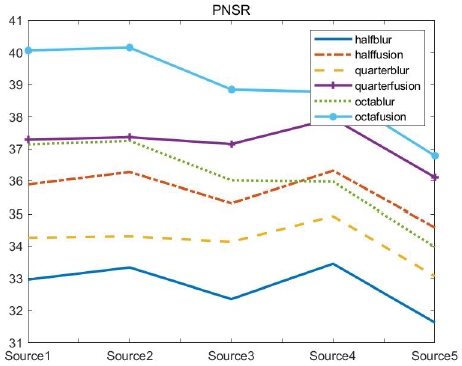

그림5에서 부터 그림 10까지는 그림2, 그림3 그리고 그림4의 이미지 소스에서, RMSE, PFE, MAE, CORR, SNR, PSNR 각각을, 퓨전 수행전 이미지 소스(Ii)와 퓨전 수행후 이미지(If)에 대한 성능 및 오차를 도식화하여 제시한 것이다. 이미지 소스간의 편차는 있으나, 공통적으로 5가지 이미지 소스에 대해 RMSE, PFE, MAE는 퓨전후에 오차가 감소하였고, CORR은 상관도가 높아졌으며, SNR, PSNR은 값이 증가하여 퓨전 효과가 있는 것으로 판단된다.

Ⅳ. AlexNet 분류 실험

소스 이미지 퓨전으로 통해 개선된 이미지를 AlexNet의 입력으로 사용하여 인식 스코어 및 분류 정확도를 비교하여 이미지 퓨전에 따른 분류 성능 변화를 평가한다.

AlexNet에서 사용된 하이퍼파라메타는 표 2와 같다.

4-1 AlexNet 인식 스코어

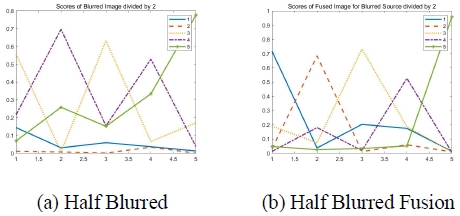

그림11은 좌우 50%로 블러링한 소스 이미지에 대한 AlexNet 인식 스코어를 퓨전하기전(a)과 퓨전후(b)로 나타낸 것이고, 표 3에 인식 스코어를 제시하였다. 퓨전하기전에는 인식 스코어가 I1 0.3284, I3 0.0149와 같이 다른 이미지에 비해 상대적으로 낮은 경우가 있어 인식이 잘 되고 있지 않음을 보여준다. 퓨전한 경우에는 I2의 경우 0.4530에서 0.9812(I2f)로 인식 스코어가 높아진 것을 알 수 있으나, I4의 경우 0.4548에서 0.1674(I4f )로 낮아진 경우도 있음을 알 수 있다.

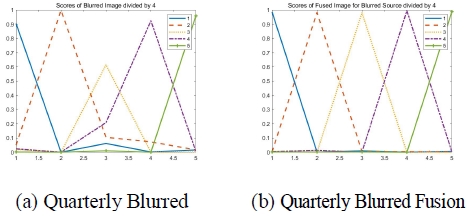

그림12는 4분의 1로 블러링한 소스 이미지에 대한 AlexNet 인식 스코어를 퓨전하기전(a)과 퓨전후(b)로 나타낸 것이다. 퓨전하기전에는 인식 스코어가 대체로 높고 일부 낮은 경우가 있으나, 퓨전한 경우에는 인식 스코어가 모두 높아진 것을 알 수 있다.

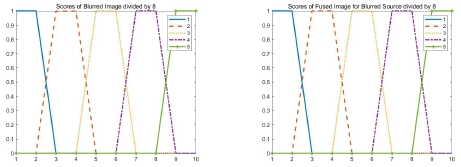

그림13은 8분의 1로 블러링한 소스 이미지에 대한 AlexNet 인식 스코어를 퓨전하기전(a)과 퓨전후(b)로 나타낸 것이다. 퓨전 전후 모두 인식 스코어 모두 매우 높게 나타남을 알 수 있다. 8분의 1 정도의 훼손이나 블러링은 이미지 퓨전에 관계없이 인식 스코어가 높게 나타나는데 이는 AlexNet의 성능에 기인한 것으로 판단된다.

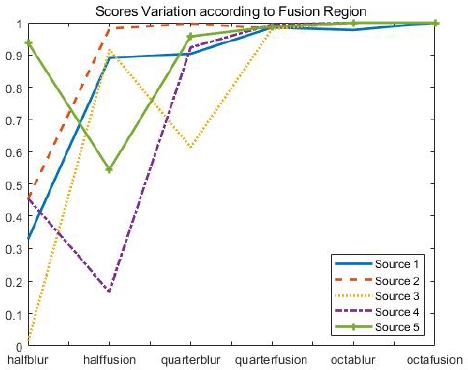

4-2 AlexNet 분류 정확도

그림14는 블러 이미지 영역에 따른 인식 스코어 변화를 나타낸 것이다. 블러링한 소스 퓨전 이미지를 AlexNet에 사용한 경우, 블러 영역이 큰 경우에는 인식 스코어 오류가 발생하는 경우가 있으나, 블러 영역이 작아질수록 인식 스코어가 높게 나타나는 것으로 볼 수 있으며, AlexNet의 인식 스코어는 좌우 블러된 경우를 제외하고, 대부분의 퓨전 데이터 세트에서 90% 이상의 인식 스코어를 보이고 있으므로, 이미지 소스의 퓨전을 통해 AlexNet의 분류 정확도는 표 4과 같이 우수한 분류 성능을 기대할 수 있다.

Ⅴ. 결론

객체의 추적이나 인식을 위해 양질의 이미지를 취득하는 것은 매우 중요하다. 이를 위해, 취득된 이미지를 이미지 퓨전을 통해 합성이나 보상하여 개선된 이미지를 만들어내는 작업이 요구된다.

장수말벌 기준 이미지로부터 임의 영역 블러링된 소스 이미지를 만들고 이미지 퓨전 성능을 측정하기 위하여 RMSE, PFE, MAE, CORR, SNR, PSNR를 측정하였고, 측정 결과를 통해 퓨전 수행후 이미지에 기준이미지와의 오차가 줄어든 것을 확인하였다. 또한, 심층 합성곱 신경망(DCNN; deep convolutional neural networks) 기반인 AlexNet의 입력으로 퓨전 이미지를 사용함에 따라 인식 스코어가 개선되고 있음을 제시하였고, AlexNet의 분류 정확도도 우수한 결과를 보이는 것으로 확인하였다.

References

-

J. Muangprathub, "IoT and agriculture data analysis for smart farm," Computers and Electronics in Agriculture, Vol.156 pp.467-474, January, 2019.

[https://doi.org/10.1016/j.compag.2018.12.011]

- Krizhevsky, Alex, Ilya Sutskever, and Geoffrey E. Hinton. "ImageNet Classification with Deep Convolutional Neural Networks," Advances in neural information processing systems, 2012.

-

K. Kwon, "Forecast of Bee Swarming using Data Fusion and LSTM", Journal of Digital Contents Society, Vol. 20, pp. 1-6, 2019

[https://doi.org/10.9728/dcs.2019.20.1.1]

- C. Jung, "Spatial Expansion of an Invasive Hornet", Vespa velutina nigrithorax Buysson (Hymenoptera: Vespidae) Vol.27 pp.87-93, 2012.

- Y. D. Chang, "Species and visiting patterns of wasps (Hymenoptera: Vespoidea) in apiary", Journal of Apic, Vol.8 pp.22-28, 1993.

- Manyika, J., "Data fusion and sensor management:A decentralized information.Theoretic approach", Ellis Horwood Series, 1994.

- Mitchell, H. B., "Multi-sensor data fusion", Berlin: Springer, 2007.

- M. A. Turk and A. P. Pentland, "Face Recognition Using Eigenfaces", in IEEE CVPR, pp.586-591, 1991.

-

VPS Naidu, Girija G. and J.R. Raol, "Evaluation of data association and fusion algorithms for tracking in the presence of measurement loss", AIAA Conference on Navigation, Guidance and Control, Austin, USA, 11-14, August 2003.

[https://doi.org/10.2514/6.2003-5733]

- Gonzalo R. Arce, "Nonlinear Signal Processing . A statistical approach", Wiley-Interscience Inc., Publication, USA, 2005.

-

Russakovsky, O., Deng, J., Su, H., et al. "ImageNet Large Scale Visual Recognition Challenge." International Journal of Computer Vision (IJCV). Vol.115, Issue 3, pp.211–252, 2015.

[https://doi.org/10.1007/s11263-015-0816-y]

- Krizhevsky, Alex, Ilya Sutskever, and Geoffrey E. Hinton. "ImageNet Classification with Deep Convolutional Neural Networks." Advances in neural information processing systems, 2012.

- The MathWorks, "AlexNet convolutional neural network", https://kr.mathworks.com/help/deeplearning/ref/alexnet.html, , 2020.

저자소개

1993년 : 강원대학교 컴퓨터과학과(학사)

1995년 : 강원대학교 대학원 컴퓨터과학과(석사)

2000년 : 강원대학교 대학원 컴퓨터과학과(박사)

1998년 ~ 2002년: 동원대학 인터넷정보과 교수

2002년~ 현 재: 강원대학교 정보통신공학과 교수

※관심분야:사물 인터넷 (IoT), 인공지능 응용

1984년 : 서울대학교 계산통계학과(학사)

1986년 : 서울대학교 대학원 계산통계학과(석사)

2000년 : 강원대학교 대학원 컴퓨터과학과(박사)

1986년 ~ 1994년: LG전자 컴퓨터연구소

1994년 ~ 1999년: 한국디지털(주)

2004년 ~ 현 재: 강릉원주대학교 컴퓨터공학과 교수

※관심분야:무선 통신 (Wireless Networks), 센서 네트워크 (Sensor Networks), 임베디드 시스템 (Embedded Systems), 사물 인터넷 (IoT)