라이트 필드 영상 장치에서의 개선된 마스킹 기반 디모자이킹 방법

Copyright ⓒ 2019 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 논문은 라이트 필드 카메라에 대한 디모자이킹 방법을 제안한다. 라이트 필드 영상은 렌즈 배열을 사용하기 때문에 기존의 영상과 다른 구조를 갖는다. 최근에는 라이트 필드 영상의 구조적 특징에 기반한 디모자이킹 방법이 연구되었다. 하지만 라이트 필드 영상은 렌즈 배열로 인해 빈 공간이 생긴다. 기존의 디모자이킹 방법은 이러한 렌즈 배열의 패턴을 고려하지 않고 누락된 색상을 보간하기 때문에 보간된 영상의 화질을 저하시킨다. 따라서 본 논문에서는 렌즈 배열의 패턴을 고려하여 영상의 화질을 개선한다. 실험 결과는 제안하는 방법의 성능이 객관적, 주관적으로 기존의 디모자이킹 방법보다 우수함을 보인다.

Abstract

This paper describes a demosaicking method for a light field camera. Since the light field imaging uses a lens array, it has a different structure from the conventional imaging. Recently, demosaicking methods based on the structural features of light field images have been studied. However, empty spaces exit between the lenses in light field imaging, which generate a lens array pattern. The existing demosaicking method interpolates missing colors without considering the lens array pattern, so that the image quality of demosaicking in light field imaging is degraded. In this paper, the image quality is improved by taking the lens array pattern into account. Experimental results show that the performance of the proposed method is superior to the existing demosaicking methods in terms of image quality, objectively and subjectively.

Keywords:

Demosaicking, Interpolation, Light field camera, Light field demosaicking, Light field interpolation키워드:

디모자이킹, 보간법, 라이트 필드 카메라, 라이트 필드 디모자이킹, 라이트 필드 보간법Ⅰ. 서 론

3D 산업 분야는 다른 분야에 비하여 신생분야임에도 그 산업 규모가 상당히 크고 매우 빠르게 증가하고 있으며 영화 및 애니메이션, TV, 게임, 제조, 의료 등 많은 곳에서 이용된다. 특히, 가상현실 (VR; visual reality)과 증강현실 (AR; augmented reality)을 활용한 기술의 발달은 3D 산업에 대한 사용자의 요구와 각종 수요는 지속적으로 증가하고 있다. 따라서 3D 영상 시스템에서의 첫 단계인 3차원 영상의 획득과 처리 관련 기술은 3D 영상 시스템에서 기초 기술로서 그 중요도가 매우 높고 또한 지속적인 연구가 수행되었다 [1]-[11].

3차원 영상 기술은 착용방식으로 구분하며 안경식 방식과 무안경식 방식으로 나눈다. 안경식 방식은 현재 상용화된 기술로 영상 획득 방식이 간단하다는 장점이 있지만 특수 안경을 착용해야 한다는 불편함과 장시간 관측시 눈의 피로감을 유발하고 어지러움이 발생되는 문제점이 있다[2]-[8].

무안경식 방식은 특수 안경을 추가로 착용하지 않아도 된다는 장점을 가지며 그 중 렌즈 배열을 사용하는 집적 영상 방식은 1908년 G. Lippmann에 의해 처음 제안된 기술로 백색광을 사용하여 3차원 물체의 정보를 기록하고 재생 가능하다[11]. 집적 영상 기술은 실제 체적형 3D영상을 제공함으로써 영상을 관측할 때 사용자의 시각적 피로감이 없고 수직, 수평 시차와 연속적인 시점을 제공한다는 점에서 차세대 3차원 영상 기술로 인정받고 있다.

3D영상 취득 장치 중에서 라이트 필드 카메라는 렌즈 배열을 통해 단일 센서로 다시점 영상을 획득하는 방식이다[12], [13]. 따라서 일반적으로 높은 해상도의 이미지 센서를 사용하여도 결과 영상의 해상도는 현저히 낮다. 영상의 화질은 영상 시스템에서 성능을 좌우하는 매우 중요한 요소이기 때문에 영상의 화질을 개선하기 위한 연구는 필수적이다.

라이트 필드 카메라는 일반 카메라와 같이 단일 이미지 센서를 통해 색채 영상을 획득하는 방법인 컬러 필터 배열 (CFA; color filter array)를 사용하기 때문에 디모자이킹 방법으로 색채 영상을 재구성해야 한다[14]. 일반 카메라에서 취득된 CFA 데이터로부터 해상도가 증강된 색채 영상을 얻기 위한 기술은 오랫동안 많은 연구가 진행되어왔다 [15]-[23]. 선형 보간법과 같은 간단하면서도 하드웨어에 적합한 방법 [15], [18], 에지 방향성을 이용한 방법[16]-[18], 색채 평면간 상관성을 이용한 방법[19]-[21], 반복적인 (iteration) 보간법[22], 주파수 영역에서의 보간법[23] 등이 있다.

라이트 필드 카메라의 원본 영상은 일반적인 영상과 다른 구조로 구성되어있다. 따라서 디모자이킹 방법도 일반적인 카메라 센서에서 사용되는 방법보다는 보다 효율적인 방법이 필요하다. 라이트 필드 카메라의 원본 영상은 렌즈 배열을 통해 다시점 영상이기 때문에 최근, 라이트 필드 영상의 특징을 이용한 새로운 디모자이킹 방법에 대한 연구가 진행되었다[24]-[31].

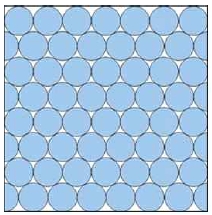

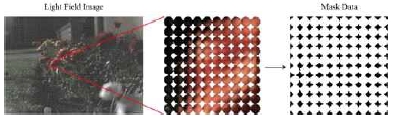

하지만 대부분의 방법들은 라이트 필드 영상에서 가장 두드러지는 특징인 원형 렌즈 배열로 인해 생기는 빈 공간에 대한 정보를 간과하였다. 라이트 필드 카메라는 카메라 안에 렌즈 배열이 위치하기 때문에 마이크로 단위의 렌즈로 이루어져 있다. 작은 크기의 렌즈는 사각형 모양보다 원형의 모양이 물리적인 정밀도가 높다. 따라서 그림 1과 같이, 라이트 필드 카메라는 원형의 마이크로 렌즈를 사용한다. 또한 라이트 필드 카메라의 렌즈는 이미지 센서의 면적 활용도를 높여 최대한 많은 양의 정보를 담기 위해 벌집 모양의 배열을 갖는다. 이러한 렌즈 배열의 특성 때문에 그림 1과 같이 렌즈와 렌즈 사이에는 빈 공간이 생긴다. 따라서 최근에는 라이트 필드 영상의 구조적 특징인 원형 렌즈 배열로 인해 생기는 빈 공간에 대한 정보를 디모자이킹 방법에 활용한 방법이 시도되었다[29]-[31].

본 논문에서는 렌즈와 렌즈 사이의 빈 공간에 대한 정보를 Hamilton-Adams (HA) 방법 [18]에 적용시킨 마스크 정보 기반 디모자이킹 방법이다. 마스크 정보 기반 디모자이킹 방법을 본 연구진의 선행 연구에서 G 평면에 적용하여 기술의 가능성을 보였다[30], [31]. 본 논문에서는 G 평면에 대한 성능 개선뿐 아니라 R/B 평면에도 빈 공간 정보를 적용한 디모자이킹 기술을 제안한다.

본 논문의 구성은 다음과 같다. 2장에서는 라이트 필드 기술에 대한 설명과 라이트 필드 카메라에 대한 설명, 라이트 필드 원본 영상에 대한 설명을 한다. 3장에서는 기존 디모자이킹 방법에 대한 설명을 하고 4장에서는 라이트 필드 원본 영상의 화질을 개선하기 위한 마스크 정보 기반 디모자이킹 방법을 개선한 디모자이킹 방법을 제안한다. 5장에서는 제안하는 방법의 성능의 우위를 증명하기 위한 실험을 진행하고 마지막으로 6장에서는 본 논문에 대한 결론을 맺는다.

Ⅱ. 라이트 필드 기술 개요

2-1 라이트 필드 기술

라이트 필드는 공간상의 모든 점을 통해 모든 방향으로 흐르는 빛의 양을 나타내는 일종의 장 (field)이다. 공간상의 한 점을 통과하는 빛의 세기 정보는 plenoptic 함수로 표현할 수 있다[32]-[34].

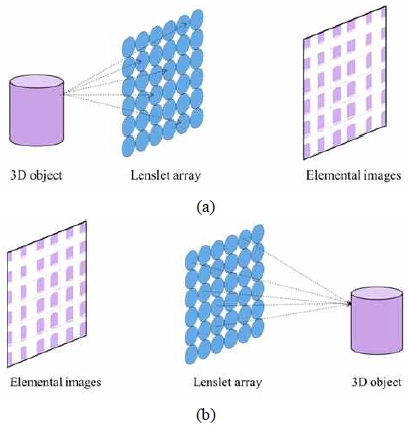

렌즈 배열을 이용한 라이트 필드 기술은 일반적으로 그림 2와 같이 픽업 과정과 디스플레이 과정으로 나뉜다. 픽업 과정은 그림 2 (a)와 같이 3차원 물체 앞에 렌즈 배열을 배치하여 카메라를 통해 렌즈의 영상을 촬영한다. 촬영된 영상은 요소 영상 배열 (elemental image array)라 한다. 요소 영상 배열은 3차원 물체에 대하여 각각의 작은 렌즈를 통해 얻은 작은 영상들의 조합이다. 이때 하나의 렌즈를 통하여 얻은 작은 영상 하나를 요소 영상이라 한다. 렌즈 배열을 통해 취득한 요소 영상 배열은 그림 2 (b)와 같은 디스플레이 과정을 통해 다시 3차원 물체 영상으로 복원된다. 픽업 과정과 디스플레이 과정 모두 광학적 방법과 컴퓨터적 방법으로 가능하지만 광학적 디스플레이 과정은 렌즈 배열의 다양한 수차 문제 및 픽업 장치와의 동일성 확보 문제 등 광학적 한계점을 갖기 때문에 화질 개선이 쉽지 않고 시스템화하기 어렵다. 하지만 컴퓨터적 디스플레이 방법인 CIIR (computational integral imaging reconstruction) 방법[35]-[42]은 광학적 문제점을 전혀 갖지 않고 화질 개선과 다양한 기술에도 쉽게 활용 가능하기 때문에 CIIR 방법을 통한 디스플레이 방법이 일반적이다.

2-2 라이트 필드 카메라

피사체의 위치에 따라 심도가 달라지기 때문에 한 초점에 대한 영상만 획득하는 기존의 카메라와 달리 라이트 필드 카메라는 재초점 기능으로 피사계 심도 (DOF; depth of focus)를 확장 가능한 장점을 가지며 차세대 카메라로써 주목받고 있다.

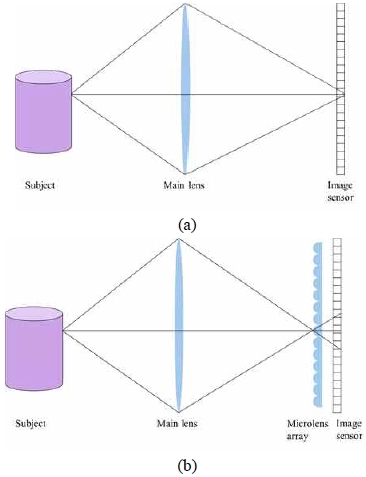

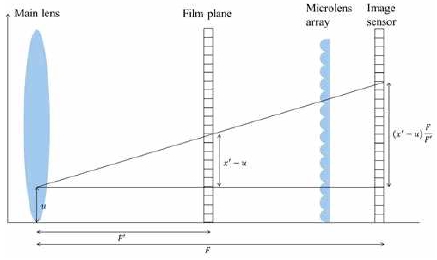

라이트 필드 카메라는 마이크로 렌즈 배열 기반의 집적 영상 기술을 접목한 카메라이다. 라이트 필드 카메라는 그림 3과 같이 일반 카메라와 달리 메인 렌즈와 이미지 센서 사이에 마이크로 렌즈 배열이 배치된 구조이다. 라이트 필드 카메라는 빛의 세기 정보를 표현할 수 있는 4D 라이트 필드 함수[33], [34]가 적용된다. Adelson과 Bergen은 빛이 통과하는 점의 3차원 위치 (Vx, Vy, Vz), 빛의 진행 방향 (θ,Φ), 색상에 따른 빛의 파장 (λ), 빛의 세기의 시간적인 변화 (t)를 이용하여 빛의 세기를 구할 수 있는 식 (1)과 같은 7D plenoptic 함수를 제안하였다.

| (1) |

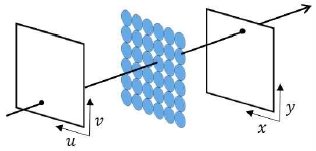

하지만 7D plenoptic 함수를 구하기 위해서는 실제 측정 데이터가 필요하기 때문에 실질적으로 값을 구하기에 어려움이 따른다. 따라서 7D plenoptic 함수를 간소화하여 4개의 매개변수를 이용한 4D 라이트 필수 함수가 제안되었다. 4D 라이트 필드 함수는 그림 4와 같이 2개의 평면 사이에 존재하는 빛의 세기 정보를 표현하고 다음 식 (2)와 같다.

| (2) |

라이트 필드 카메라에 적용된 4D plenoptic 함수는 메인 렌즈를 평면 (u,υ)라 하고 이미지 센서를 평면 (x,y)라 한다. 3차원 물체에서 반사된 빛은 메인 렌즈 평면 (u,υ)을 지나고 마이크로 렌즈 배열에 의한 방향성 광선을 이미지 센서 평면 (x,y)에 투영한다. 물체의 한 점에서 여러 방향으로 분산되는 빛들이 메인 렌즈에 의해 한 곳으로 모아지고 모아진 빛을 마이크로 렌즈 배열이 다시 빛의 방향에 따라 분리하여 이미지 센서에 저장된다. 즉, 메인 렌즈에 의해 생성된 이미지가 마이크로 렌즈 배열을 통과하여 요소 영상을 생성한다. 따라서 메인 렌즈에 의해 생성된 이미지와 요소 영상을 통해 시차 (disparity)를 알 수 있고 이를 활용하여 물체의 깊이 정보를 파악한다. 이를 통해 재초점 기능이 구현 가능하며 집적 영상 기술을 적용하여 3차원 영상으로 복원된다.

라이트 필드 카메라의 재초점 기술은 그림 5와 같다. 얻고 싶은 초점의 위치를 초점면 (film plane)이라 한다. 이미지 센서 평면 (x,y)에서의 영상의 밝기 값은 (x,y)에 도달한 빛의 양이기 때문에 임의의 평면인 초점면 (x′,y′)에서의 영상의 밝기 값은 (x′,y′)에 도달하는 빛의 양으로 4D 라이트 필드 함수에 의해 계산된다. 메인 렌즈의 평면 (u,υ)으로부터 이미지 센서 평면 (x,y)에 저장된 라이트 필드 데이터를 4D 라이트 필드 함수인 L(x,y,u,υ) 에 활용하여 임의의 초점면 (x′,y′)에서의 영상의 밝기 값은 다음과 같다.

| (3) |

E(x′,y′)는 임의의 초점면에 대한 빛의 양을 나타내고 α = F′/F이다.

라이트 필드 카메라는 마이크로 단위의 원형 렌즈를 벌집 모양으로 배치시킨 렌즈 배열을 사용하기 때문에 라이트 필드 카메라의 원본 영상은 기존의 영상과 다른 구조를 갖기때문에 본 논문에서 사용하는 Lytro사의 Illum 카메라의 영상에 대한 설명은 필수적이다.

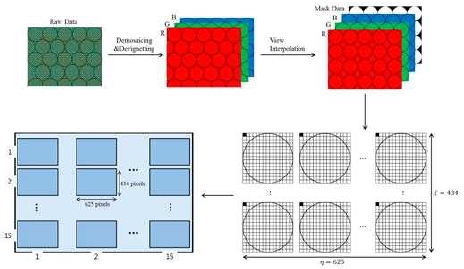

라이트 필드 카메라는 단일 센서 만을 이용하여 색채 영상을 획득하기 위해 단일 센서 위에 GRBG 형태의 CFA를 부착하였다. 원본 영상의 총 해상도는 7728×5368로 하나의 화소 정보는 10비트로 구성되어있고 확장자는 LPR이다. 라이트 필드 카메라의 원본 영상은 그림 6과 같은 보정 과정을 통해 기존의 영상과 같은 형태의 영상으로 복원된다. 이 과정의 주요 결과물은 마이크로 렌즈의 사각형 격자에 해당하는 재구성된 라이트 필드이다. 각각의 마이크로 렌즈는 15×15 가지의 방향에서 오는 빛을 포착하고 사각형 격자는 625×434 개의 마이크로 렌즈로 구성된다.

Ⅲ. 기존 연구

3-1 Hamilton-Adams Method

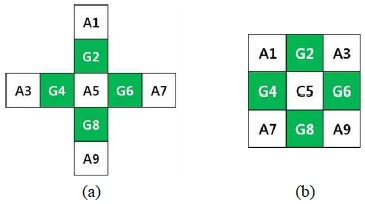

HA 방법[18]은 간단하고 효율적인 연산을 사용하여 복잡도가 낮고 화질 또한 크게 개선시킨 디모자이킹 방법이다. 주변 화소에 대한 고주파를 감지하여 화소의 방향을 예측하며 평면간의 높은 상관도를 이용한다. 동일 평면의 화소 정보의 저주파 성분과 다른 평면의 화소 정보의 고주파 성분 모두를 포함하여 값을 결정하기 때문에 예측 값이 비교적 정확하다. HA 방법은 CFA에 대한 디모자이킹 방법이므로 G 평면과 R/B 평면에 대한 복원 방법이 다르다. 그림 7과 같이 먼저 정보량이 많은 G 평면을 복원한 후, 복원된 G 평면을 활용하여 R/B 평면을 복원한다.

G 평면은 그림 7 (a)와 같이 오점형 형태를 가지고 있기 때문에 수직 방향과 수평 방향으로 예측하여 보간한다. 먼저 수직, 수평에 대한 그래디언트 (gradient)를 계산하여 그래디언트 값이 작은 방향으로 보간한다. 예를 들어 그림 7 (a)에서 A5 위치의 보간값은 다음 식 (4) 또는 식 (5)가 된다. 식 (4)는 수평 방향으로 보간될 때의 보간 값이고 식 (5)는 수직 방향으로 보간될 때의 보간 값이다.

| (4) |

| (5) |

R/B 평면은 그림 7 (b)와 같이 2×2 크기의 반복되는 블록에서 하나의 화소만이 해당 색상의 정보를 갖고 있다. 그러므로 나머지 세 위치의 화소 값에 대한 복원이 필요하며 앞서 완전히 복원된 G 평면의 화소 정보를 이용한다. 그림 7 (b)의 A2와 같이 복원할 화소와 같은 색상 정보가 좌우에 존재하는 경우에는 식 (6)과 같이 복원을 진행하고 A4와 같이 상하에 존재하는 경우에는 식 (7)과 같이 복원한다.

| (6) |

| (7) |

마지막으로 대각선과 역대각선 위치에 같은 색상 화소의 정보가 존재하는 C5 위치는 G 평면을 복원하는 과정과 유사하다. 대각선과 역대간선 방향에 대한 그래디언트 값을 계산하고 해당 방향에 따라 복원 값을 결정한다. 식 (8)은 대각선 방향으로 복원될 경우이고 식 (9)는 역대각선 방향으로 복원되는 경우이다.

| (8) |

| (9) |

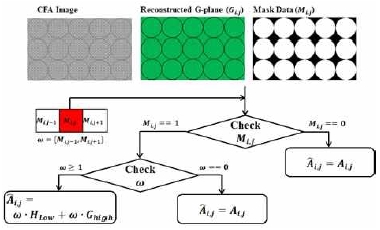

3-2 마스크 정보 기반 디모자이킹 방법

마스크 정보 기반 디모자이킹 방법[30]은 렌즈 사이에 생기는 빈 공간에 대한 정보를 마스크 정보라 칭하고 이를 활용한 방법이다. G 평면에서만 빈 공간에 대한 정보를 이용하고 R/B 평면은 HA 방법으로 복원한다. 마스크 정보는 그림 8과 같이 라이트 필드 영상에서 추출 가능하다.

G 평면의 복원 과정에서 사용되는 화소는 그림 7 (a)와 같으며 세 가지 경우로 나누어진다. 먼저, 복원할 화소와 복원에 필요한 8개의 주변 화소 모두 마스크 안에 존재하는 경우에는 HA 방법으로 보간한다. 또한 복원할 화소가 마스크 안에 존재하지 않을 경우에는 빈 공간에 해당하므로 연산 처리 없이 배경색으로 보간한다. 마지막으로 복원될 화소는 마스크 안에 존재하지만 주변 화소 중 일부는 마스크 안에 존재하지 않는 경우이다. 이 경우 마스크 안에 있는 화소만을 사용하여 보간한다. 식 (10)은 이 경우의 계산식으로 마스크 정보는 M으로 표기하며 해당 화소가 마스크 안에 존재하는 경우에는 1, 그렇지 않을 경우에는 0의 값을 가진다. 식 (10)은 그림 7 (a)의 A5 위치에 대한 복원이다.

| (10) |

Ⅳ. 제안하는 방법

본 논문은 마스크 정보 기반 디모자이킹 방법을 개선하여 R/B 평면 복원 과정에도 빈 공간에 대한 정보를 활용한 디모자이킹 방법을 제안한다. 기존의 라이트 필드 영상에 대한 디모자이킹 방법은 정보를 담고 있지 않은 빈 공간에 해당하는 화소를 포함하여 영상을 보간하기 때문에 화질 열화가 생긴다. 마스크 정보 기반 디모자이킹 방법도 영상의 50%를 해당하는 R/B 평면에 대해서는 마스크 정보를 활용하지 않았기 때문에 영상의 화질이 떨어지게 된다. 따라서 제안된 방법은 영상의 화질을 저하시키는 마스크 정보를 배재하여 불필요한 연산 과정을 줄이고 정확도를 높인다.

제안하는 방법은 마스크 정보를 기반으로 한 디모자이킹 방법을 통해 복원된 G 평면을 활용하여 R/B 평면의 복원을 진행한다. R/B 평면은 누락된 색상 정보는 마스크 안에 존재하는 화소만을 사용하여 복원할 화소와 색상이 같은 화소의 저주파 성분과 완벽히 복원된 G 평면의 고주파 성분을 사용하여 복원된다. 또한 모든 보간 과정은 보간될 화소가 마스크 안에 존재할 경우에만 실행되고 마스크 안에 존재하지 않을 경우에는 빈 공간이기 때문에 배경색으로 복원한다.

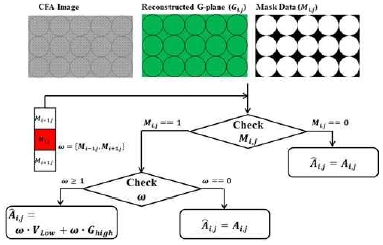

R/B 평면의 복원은 HA 방법의 R/B 평면 복원 과정과 같이 세 가지 경우로 나누어진다. 먼저, 첫 번째 경우는 복원할 화소의 좌우 위치에 복원할 색상 평면의 화소 정보가 존재하는 경우이다. 이 경우에는 복원할 화소가 마스크 정보 안에 존재하는지 여부를 파악하고 마스크 안에 존재할 경우 2개의 주변 화소 또한 정보를 가진 화소인지 확인한다. 복원할 화소는 마스크 안에 존재하지만 복원에 사용될 2개의 주변 화소 모두 마스크 밖에 존재할 경우에는 복원을 진행하지 않는다. 식 (11)는 그림 7(b)에서 A2 화소를 복원하는 과정에 대한 계산식이고 그림 9는 첫 번째 경우의 복원 과정 흐름도이다.

| (11) |

두 번째는 보간될 화소의 상하에 복원할 색상과 같은 색상의 화소가 존재하는 경우이다. 이때, 첫 번째 경우와 같이 복원에 사용되는 주변 화소가 모두 마스크 영역 밖이면 복원을 진행하지 않는다. 다음 식 (12)는 그림 7(b)에서 A4 색상 화소를 복원하는 식이며 그림 10은 복원 과정의 흐름도이다.

| (12) |

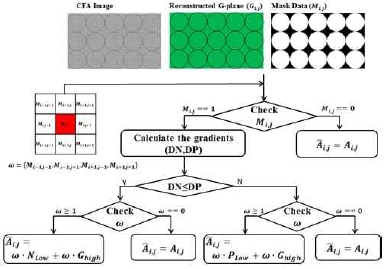

마지막으로는 복원할 화소의 대각선 네 방향으로 복원할 색상 평면의 화소 정보가 존재하는 경우이며 복원 과정의 흐름도는 그림 11과 같다. 모든 경우와 마찬가지로 복원될 화소가 마스크 안에 없는 경우와 복원에 사용될 2개의 주변 화소가 마스크 밖에 있을 경우에는 복원을 진행하지 않는다. 복원할 화소가 마스크 안에 존재할 경우에는 대각선 방향과 역대각선 방향의 두 가지 경우가 있기 때문에 방향성을 고려하여 복원해야한다. 따라서 복원할 화소의 누락된 색상 정보는 각 방향에 대한 그래디언트를 계산하고 값을 비교하여 해당하는 방향으로 보간한다. 예를 들어 그림 7(b)의 A5 색상 화소를 복원하는 경우 대각선과 역대각선 방향에 대한 그래디언트 계산식은 다음과 같다.

| (13) |

| (14) |

A5 색상은 DN과 DP 값의 비교를 통해 해당하는 방향으로 복원되며 대각선 방향으로 복원하는 경우에는 식 (15)로 계산되고 역대각선 방향으로 복원하는 경우에는 식 (16)으로 계산된다.

| (15) |

| (16) |

Ⅴ. 실험 및 결과

제안된 방법을 주관적, 객관적으로 평가하기 위해 기존의 방법과 비교 실험을 수행하였다. 실험을 통해 빈 공간인 배경색에 따라 기존 방법의 실험 결과가 달라지는 것을 알 수 있었다. 실험 영상이 전체적으로 어둡기 때문에 배경색이 흰색일 경우보다 검정색일 경우 실험 결과가 좋다. 주변 화소 값을 통해 누락된 색상 정보를 보간하기 때문에 영상의 전체적인 색감과 빈 공간에 해당하는 배경색의 연관성이 디모자이킹 과정에 영향을 미치기 때문이다. 따라서 본 논문에서는 배경색을 흰색과 검정색의 중간인 회색으로 하여 실험을 진행하였다. 라이트 필드 카메라 영상의 마스크 정보는 원본 영상에서 추출하여 디모자이킹 과정에 반영한다.

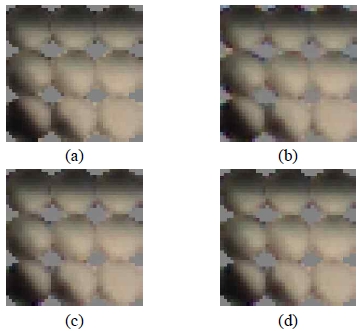

실험 영상은 그림 12와 같으며 Stanford 대학에서 제공하는 Lytro 사의 Illum 카메라로 찍은 원본 영상이고 크기는 7650×5250이다. 비교 수행할 기존 방법으로는 HA 방법과 마스크 기반 디모자이킹 방법을 사용하였다. 객관적 성능 측정 방법으로 컬러 최대 신호 대 잡음비 (CPSNR; color peak signal-to-noise ratio)를 이용한다. 표 1은 각 방법의 결과에 대한 CPSNR 수치를 나타낸다. 제안된 방법은 마스크 기반 디모자이킹 방법과 비교하여 평균적으로 1.03 dB 개선되었고 영상에 따라 최대 2.75 dB 개선됨을 보여준다. 결과에서 알 수 있듯이 제안하는 방법은 다른 디모자이킹 방법과 객관적 수치 비교에 있어서 우위에 있음을 알 수 있다.

다음으로 실험 결과에 대한 영상은 그림 13과 같다. 실험 결과 영상은 영상의 일부분을 확대한 것으로 제안하는 방법은 마스크 영역 가장자리에 지퍼링 현상이 전혀 없다. 또한 정보를 갖고 있지 않은 마스크 영역은 디모자이킹 과정에 반영하지 않으므로 가장자리 부분에서의 색상 보간이 다른 방법들보다 정확하고 마스크 영역을 그대로 보존하는 것을 알 수 있다. 위의 실험 결과에 따라 제안하는 방법의 객관적, 주관적 화질의 우수함을 알 수 있다.

Ⅵ. 결 론

본 논문에서는 마스크 정보 기반 디모자이킹 방법을 개선한 방법을 제안하였다. 원형의 렌즈 형태 때문에 생기는 빈 공간은 영상의 정보를 담고 있지 않기 때문에 영상 처리시 성능을 저하시킨다. 따라서 불필요한 정보를 가진 마스크 정보를 디모자이킹 과정에서 제거한다. 제안된 방법의 성능을 평가하기 위하여 기존의 디모자이킹 방법과 CPSNR을 비교하여 객관적 성능 평가를 하였고 결과 영상을 통해 주관적 성능 향상도 보였다.

Acknowledgments

This research was supported by a 2017 Research Grant from Sangmyung University.

References

- K. Yuasa, K. Okoshi, H. Kondo, H. Ichige, and T. kofuji, Three dimensional display, U.S. Patent No. 6,252,624, 26), Jun., (2001.

-

W. Rollmann, "Zwei neue streoskopische methoden", Annalen der Physik, 166, p186-187, (1853).

[https://doi.org/10.1002/andp.18531660914]

- R. Zone, Stereoscopic Cinema and the Origins of 3-D Film, 1838-1952, The University Press of Kentucky, p64-66, (2007).

- Land, H. Edwin, Polarizing optical system, U.S. Patent No. 2,099,694, 23), Nov., (1937.

- T. L. Turner, and R. F Hellbaum, "LC shutter glasses provide 3-D display for simulated flight", Information Display Magazine, 2, p22-24, (1986).

- G. Oster, “Optical art”, Applied Optics, 4, p1359-1369, (1965).

- A. Berthier, “Images stéréoscopiques de grand format”, Le Cosmos, 34, p205-210, (1896).

-

F. E. Ives, "A novel stereogram", Journal of the Franklin Institute, 153, p51-52, (1902).

[https://doi.org/10.1016/s0016-0032(02)90195-x]

-

N. Dodgson, “Autostereoscopic 3D displays”, Computer, 38(8), p31-36, (2005).

[https://doi.org/10.1109/mc.2005.252]

-

D. Gabor, “A new microscopic principle”, Nature, 161, p777-778, (1948).

[https://doi.org/10.1038/161777a0]

- G. Lippmann, "La photographic intergrale", Computes-Rendus. Acad. Sci, 146, p446-451, (1908).

-

E. H. Adelson, and J. Y. A. Wang, "Single lens stereo with a plenoptic camera.", IEEE Transactions on Pattern Analysis & Machine Intelligence, 14(2), p99-106, (1992).

[https://doi.org/10.1109/34.121783]

- R. Ng, M. Levoy, M. Brédif, G. Duval, M. Horowitz, and P. Hanrahan, "Light field photography with a hand-held plenoptic camera", Computer Science Technical Report, p1-11, (2005).

- R. Lukac, Single-sensor imaging: methods and applications for digital cameras, CRC Press, (2009).

-

J. S. J. Li, and S. Randhawa, "Color filter array demosaicking using high-order interpolation techniques with a weighted median filter for sharp color edge preservation", IEEE Trans. Image Process, 18(9), p1946-1957, Sep.), (2009.

[https://doi.org/10.1109/tip.2009.2022291]

-

D. Menon, S. Andriani, and G. Calvagno, "Demosaicing with directional filtering and a posteriori decision", IEEE Trans. Image Process, 16(1), p132-141, (2007).

[https://doi.org/10.1109/tip.2006.884928]

-

R. Lukac, K. N. Plataniotis, D. Hatzinakos, and M. Aleksic, "A novel cost effective demosaicing approach", IEEE Transactions on Consumer Electronics, 50(1), p256-261, (2004).

[https://doi.org/10.1109/tce.2004.1277871]

- J. E. Adams, and J. F. Hamilton, Adaptive color plane interpolation in single sensor color electronic camera, U.S. Patent No. 5,652,621, 29), Jul., (1997.

-

K.-H. Chung, and Y.-H. Chan, "Color demosaicing using variance of color differences", IEEE Trans. Image Process, 15(10), p2944-2955, (2006).

[https://doi.org/10.1109/tip.2006.877521]

-

R. Lukac, and K. N. Plataniotis, "Normalized color-ratio modeling for CFA interpolation", IEEE Transactions on Consumer Electronics, 50(2), p737-745, (2004).

[https://doi.org/10.1109/tce.2004.1309456]

-

B. K. Gunturk, Y. Altunbask, and R. M. Mersereau, "Color plane interpolation using alternating projections", IEEE Trans. Image Process, 11(9), p997-1013, (2002).

[https://doi.org/10.1109/tip.2002.801121]

- X. Li, "Demosaicing by successive approximations", IEEE Trans. Image Process, 14(2), p267-278, (2005).

-

E. Dubois, “Frequency-domain methods for demosaicking of bayer-sampled color images”, IEEE Signal Processing Letters, 12, p847-850, (2005).

[https://doi.org/10.1109/lsp.2005.859503]

- S. Xu, Z. L. Zhou, and N. Devaney, “Multi-view image restoration from plenoptic raw images”, In Asian Conference on Computer Vision, Springer. p3-15, (2014).

- X. Huang, and O. Cossairt, “Dictionary learning based color demosaicing for plenoptic cameras”, In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, p449-454, (2014).

- M. Seifi, N. Sabater, V. Drazic, and P. Perez, “Disparity-guided demosaicking of light field images”, In Image Processing (ICIP), 2014 IEEE International Conference on, p5482-5486, (2014).

-

Z. Yu, J. Yu, A. Lumsdaine, and T. Georgiev, “An analysis of color demosaicing in plenoptic cameras”, In Computer Vision and Pattern Recognition (CVPR), 2012 IEEE Conference on, p901-908, IEEE, (2012).

[https://doi.org/10.1109/cvpr.2012.6247764]

-

A. Levin, and F. Durand, “Linear view synthesis using a dimensionality gap light field prior”, In Computer Vision and Pattern Recognition (CVPR), 2010 IEEE Conference on, p1831-1838, IEEE, (2010).

[https://doi.org/10.1109/cvpr.2010.5539854]

- P. David, M. Le Pendu, and C. Guillemot, “White Lenslet Image Guided Demosaicing for Plenoptic Cameras”, In MMSP 2017-IEEE 19th International Workshop on Multimedia Signal Processing, (2017).

- H. Cho, and H. Yoo, “Masking Based Demosaicking for Image Enhancement Using Plenoptic Camera”, International Journal of Applied Engineering Research, 13(1), p273-276, (2018).

- H. Cho, J. Bae, H. Jung, E. Oh, and H. Yoo, “Improvement on Demosaicking in Plenoptic Cameras by Use of Masking Information”, ICVIP 2018 Proceedings of the International Conference on Video and Image Processing. ACM, HK2-0037, 2018 to appear.

- E. H. Adelson, and J. R. Bergen, "The plenoptic function and the elements of early vision", Computational Models of Visual Process, p3-20, (1991).

- M. Levoy, and P. Hanrahan, "Light field rendering", Proceedings of the 23rd annual conference on Computer graphics and interactive techniques. ACM, p31-42, (1996).

- S. J. Gortler, R. Grzeszcdzuk, R. Szeliski, and M. F. Cohen, "The lumigraph", Proceedings of the 23rd annual conference on Computer graphics and interactive techniques. ACM, p43-54, (1996).

-

H. Arimoto, and B. Javidi, “Integral three-dimensional imaging with digital reconstruction”, Optics Letter, 26, p157-159, (2001).

[https://doi.org/10.1364/ol.26.000157]

-

S.-H. Hong, J.-S. Jang, and B. Javidi, "Three-dimensional volumetric object reconstruction using computational integral imaging", Optics Express, 12, p483-491, (2004).

[https://doi.org/10.1364/opex.12.000483]

- J.-S. Park, D.-C. Hwang, D.-H. Shin, and E.-S. Kim, "Resolution-enhanced computational integral imaging reconstruction using intermediate-view reconstruction technique", Optics Engineering, 45, p17004, (2006).

-

H. Yoo, and D.-H Shin, “Improved analysis on the signal property of computational integral imaging system”, Optics Express, 15, p14107-14114, (2007).

[https://doi.org/10.1364/oe.15.014107]

-

H. Yoo, "Artifact analysis and image enhancement in three dimensional computational integral imaging using smooth windowing technique", OSA Optics Letters, 36(12), 15), Jun., (2011.

[https://doi.org/10.1364/ol.36.002107]

-

H. Yoo, "Axially moving a lenslet array for high-resolution 3D images in computational integral imaging", OSA Optics Express, 21(7), p8876-8887, 3), Apr, (2013.

[https://doi.org/10.1364/oe.21.008873]

-

Y. Lee, and H. Yoo, "Three-dimensional visualization of objects in scattering medium using integral imaging and spectral analysis", Elsevier Optics and Lasers in Engineering, 77(2), p31-38, Feb.), (2016.

[https://doi.org/10.1016/j.optlaseng.2015.07.007]

-

H. Yoo, and J.-Y. Jang, "Intermediate elemental image reconstruction for refocused three-dimensional images in integral imaging by convolution with δ-function sequences", Elsevier Optics and Lasers in Engineering, 97, p93-99, Oct.), (2017.

[https://doi.org/10.1016/j.optlaseng.2017.04.015]

저자소개

2016년 : 상명대학교 (이학학사)

2016년~현 재: 상명대학교 대학원 컴퓨터과학과 석사

※관심분야: 영상처리(Imaging Processing),

집적 영상(Integral Imaging)

1999년 : 한양대학교 대학원 (공학석사)

2003년 : 한양대학교 대학원 (공학박사)

2003~2005 : 삼성전자 무선사업부 책임연구원

2005~2008 : 동서대학교 컴퓨터정보공학부 조교수

2008~2012 : 상명대학교 디지털미디어학부 조교수

2012~2017 : 상명대학교 미디어소프트웨어학과 부교수

2017~현재 : 상명대학교 융합전자공학과 정교수

1997.2.26. : 제3회 삼성전자 휴먼테크 논문상 대회 입상

2003~2005 : 삼성전자 위성DMB 폰, 지상파DMB 폰 개발 및 양산

※관심분야: 영상처리(Imaging Processing), 3차원 집적 영상 처리(3D Integral Imaging)