가상 펫 시뮬레이션을 위한 혼합 현실 환경에서의 핸드트래킹 및 음성 인식 기반 상호작용 연구

Copyright ⓒ 2025 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

혼합 현실(Mixed Reality, MR) 기술을 활용한 가상 펫 시뮬레이션은 사용자 몰입감과 상호작용을 극대화하는 데 중요한 가능성을 제시한다. 기존의 가상 펫 시뮬레이션은 주로 모바일 기기나 컴퓨터를 기반으로 하여 가상과 현실 간의 괴리로 몰입감이 제한되었다. 이를 해결하기 위해 음성 인식 모델과 문장 유사도 분석을 결합하여 사용자의 다양한 명령어를 처리하고, 제스처를 활용한 직관적인 상호작용 방식을 설계하였다. 이러한 디자인은 사용자가 가상 펫과 대화하거나 물리적 행동을 통해 더욱 자연스럽게 상호작용할 수 있도록 돕는다. 연구 결과, MR 기술을 활용한 새로운 상호작용 방식은 가상 펫과의 정서적 교감을 증대시키고 사용자 몰입감을 향상시키는 데 효과적이었다. 이는 MR 기술이 사용자와 가상 요소 간의 자연스러운 교감을 구현하고, 디지털 환경에서의 정서적 상호작용 설계에 기여함을 보여준다.

Abstract

Mixed reality (MR) technology in virtual pet simulations present significant potential for maximizing user immersion and interaction. Traditional virtual pet simulations, primarily based on mobile devices or computers, face limitations in immersion due to the disconnect between virtual and real worlds. To address this issue, a design that combines a speech recognition model with sentence similarity analysis to process diverse user commands and employs gesture-based intuitive interaction methods was developed. This design allows users to naturally interact with virtual pets through conversations and physical actions. The results demonstrate that the new interaction method leveraging MR technology enhances emotional bonding with virtual pets and improves user immersion. This highlights MR technology’s ability to facilitate seamless interaction between users and virtual elements, contributing to the design of emotionally engaging digital environments.

Keywords:

Mixed Reality, Virtual Pet Simulation, Interaction, Voice Recognition, Hand Tracking키워드:

혼합 현실, 가상 펫 시뮬레이션, 상호작용, 음성 인식, 핸드 트래킹Ⅰ. 서 론

최근 가상 현실(VR), 증강 현실(AR) 기술의 발전으로 혼합 현실(MR) 기술이 주목받고 있다. 혼합 현실은 VR과 AR의 장점을 결합하여 현실 세계와 가상 세계를 융합해 상호작용할 수 있는 환경을 제공한다. 이러한 기술은 다양한 산업 분야에서 사용될 수 있으며, 특히 사용자 몰입감을 극대화하는데 탁월한 성과를 보인다. 가상 현실 기술이 사용자를 완전히 가상의 공간으로 몰입시켰다면, 혼합 현실은 사용자가 현실과 가상을 자연스럽게 넘나들며 상호작용할 수 있는 경험을 제공한다. 이러한 점에서 MR은 교육, 엔터테인먼트, 헬스케어와 같은 다양한 분야에서 새로운 가능성을 제시하고 있다[1].

그중에서도 가상 펫 시뮬레이션은 MR 기술의 중요한 응용 사례 중 하나로, 사용자에게 가상의 반려동물과 상호작용하는 독특한 경험을 제공한다. 현대 사회에서는 1인 가구의 증가와 반려동물에 대한 관심이 높아지면서, 실제로 반려동물을 키우기 어려운 환경에 있는 사람들에게 가상 펫은 대안이 될 수 있다. 그러나 기존의 가상 펫 시뮬레이션은 주로 모바일 기기나 컴퓨터에서 제공되었으며, 이러한 디바이스 기반의 가상 환경은 사용자가 경험하는 몰입감이 제한적이라는 한계가 있었다. 특히, 가상 세계와 현실 세계 사이의 괴리감이 크기 때문에, 이는 사용자가 가상 환경에서의 경험을 실제로 느끼기 어렵게 만든다. 예를 들어, 현실에서는 물리적 감각과 시각적 피드백이 일치하지만, 가상 환경에서는 이러한 피드백이 불완전하거나 부재하여 몰입감을 저하시킨다. 이는 사용자가 현실과 가상 환경 사이의 경계를 인지하게 하며, 결과적으로 가상 펫과의 상호작용에서 정서적 교감을 제한하는 주요 요인 중 하나다. 그와 반대로 MR 기술은 현실 세계와 가상 세계를 연결하여 사용자의 몰입감과 상호작용을 증진시키는 데 탁월한 효과를 보이고 있다. MR 기술은 의료 및 교육 분야에서도 사용자 몰입감과 심리적 안정감을 높이는 데 효과적임을 입증했으며, 이는 가상 펫 시뮬레이션과 같은 정서적 교감을 유도하는 시스템에도 유사하게 적용될 수 있다[2].

반려동물과의 상호작용은 정서적 안정과 스트레스 완화 등에 긍정적인 영향을 미치는 것으로 알려져 있다[3]. 따라서 이러한 경험을 가상 환경에서 최대한 현실감 있게 제공하는 것은 사용자들의 정신적 복지 향상에도 기여할 수 있다. 이는 특히 사회적 고립이나 알러지 등의 이유로 실제 반려동물을 키우기 어려운 사람들에게 중요한 의미를 갖는다. 이러한 필요성에 따라 MR 기술을 활용한 가상 펫 시뮬레이션은 사용자에게 현실과 가상이 융합된 새로운 형태의 교감 경험을 제공할 수 있는 잠재력이 있다.

MR 기술은 사용자와 가상 펫 간의 상호작용을 다양한 입력 방식을 통해 강화할 수 있다. 음성 인식, 제스처 인식, 핸드 트래킹과 같은 기술을 결합하여 사용자와 가상 펫 간의 상호작용을 보다 자연스럽고 몰입감 있게 만들어준다[4]. 예를 들어, 사용자가 자신의 실제 환경에서 가상의 펫과 놀거나 돌보는 경험은 MR 기술의 발전에 따라 더욱 현실감 있게 구현될 수 있다. 본 연구는 이러한 배경에서 MR 환경에서 음성 인식과 핸드 트래킹 기술을 결합한 가상 펫 시뮬레이션을 구현하고, 이를 통해 사용자의 몰입감과 상호작용 효과를 극대화하는 방안을 모색하고자 한다[5].

특히, 기존의 가상 펫 시뮬레이션에서는 핸드 트래킹을 통한 상호작용이 허공에서 손을 휘젓는 느낌을 주어 몰입감이 제한적이었다[6]. 이러한 문제를 해결하기 위해 본 연구에서는 음성 인식 기반의 대화형 상호작용과 함께 사용자가 가상 펫과 보다 직관적으로 교감할 수 있는 방안을 제안한다. 키보드, 마우스, 터치스크린과 같은 입력 장치는 가상환경에서 사용자 상호작용의 자연스러움과 직관성이 제한된다[7]. 때문에 보다 몰입적이고 사용자 친화적인 인터페이스를 위해 실제 세계의 동작을 밀접하게 모방한 제스처 및 음성 인식 상호작용은 인지적 부하를 줄이고 사용자의 현장감을 올려준다[8],[9]. 따라서 음성 명령을 통해 가상 펫과 대화할 수 있도록 하고, 핸드 트래킹을 통해 물리적 제스처를 감지함으로써 사용자와 가상 펫 간의 교감이 자연스럽게 이루어지도록 설계하였다. 이러한 새로운 상호작용 방식은 사용자에게 가상의 펫과의 몰입감을 극대화하고, MR 환경에서의 상호작용의 잠재력을 극대화할 수 있는 가능성을 보여준다[10].

Ⅱ. 이론적 배경 및 사례 분석

2-1 핸드 트래킹

가상 현실(VR) 및 증강 현실(AR) 시스템에서 사용자와 가상 환경 간의 상호작용을 구현하기 위한 필수 기술 중 하나는 핸드 트래킹이다. 핸드 트래킹 기술은 사용자의 손 동작을 실시간으로 추적하여 가상 환경에서의 상호작용을 가능하게 한다. 기존의 컨트롤러 기반 상호작용과 달리, 핸드 트래킹은 물리적 입력 장치 없이 손의 움직임만으로 다양한 인터페이스를 조작할 수 있다는 점에서 차별화 된다.

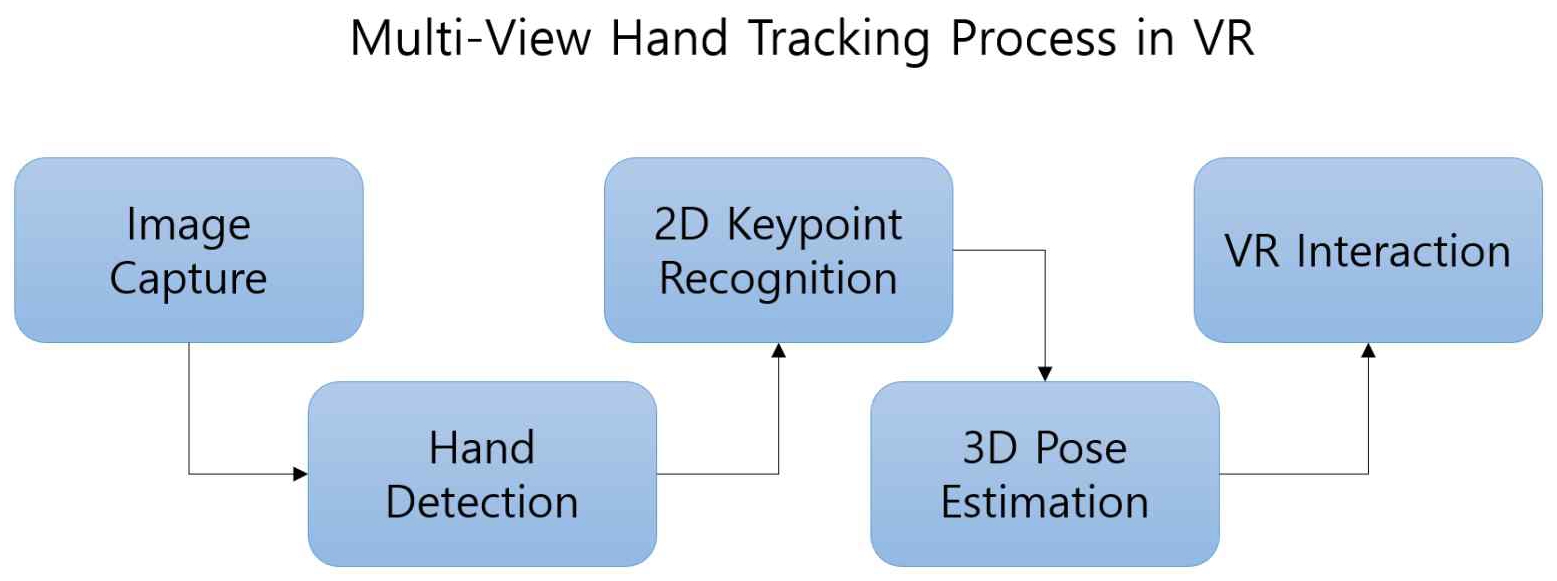

핸드 트래킹은 기본적으로 컴퓨터 비전 기술을 기반으로 하며, VR 헤드셋에 내장된 다중 시야각(FOV) 카메라를 통해 사용자의 손 이미지를 획득한다. 이를 통해 손의 관절 위치를 추정하고, 각 관절의 움직임을 바탕으로 손의 3D 포즈를 계산한다. 대표적인 핸드 트래킹 기술로는 MediaPipe Hands가 있으며, 이는 실시간으로 사용자의 손의 위치를 추적하여 21개의 3D 랜드마크를 정확히 식별할 수 있다.

핸드 트래킹 기술은 크게 다음의 두 가지 단계로 나뉜다. 첫째, 이미지 입력 및 손 검출 단계에서는 카메라가 촬영한 이미지를 분석하여 손의 위치를 인식한다. 이 과정에서는 CNN(Convolutional Neural Network)과 같은 딥러닝 알고리즘이 사용되며, 손의 윤곽과 주요 관절 위치를 감지하여 2D 키포인트를 생성한다. 둘째, 3D 포즈 추정 단계에서는 다중 시야각 이미지나 단일 시야각 이미지를 바탕으로 손의 3D 공간 내 위치와 자세를 추정한다. 이 과정에서 루트-상대(root-relative) 포즈 예측을 사용하여 손의 움직임을 추적하며, 이를 통해 손가락의 각 관절과 손목의 정확한 3D 좌표가 결정된다[11].

실시간으로 손을 추적하는 핸드 트래킹 기술은 주로 가상 현실(VR) 및 증강 현실(AR) 시스템에서 사용되며, 특히 사용자 몰입감을 극대화하기 위한 중요한 기술로 자리잡고 있다. 최근에는 핸드 트래킹의 정확성과 속도를 향상시키기 위한 다양한 알고리즘이 개발되고 있으며, 사용자의 제스처를 보다 정확하게 인식하기 위해 딥러닝 기반의 포즈 추정 기술이 적용되고 있다.

핸드 트래킹 기술의 발전은 사용자와 가상 객체 간의 상호작용 방식을 혁신적으로 변화시키고 있다. 예를 들어, Meta Quest와 같은 최신 VR 장치들은 핸드 트래킹을 활용한 컨트롤러 없는 상호작용을 구현하여 사용자가 손만으로 메뉴를 탐색하거나 가상 객체를 조작할 수 있게 하였다. 또한, 이러한 기술은 사용자에게 직관적이고 자연스러운 상호작용을 제공함으로써 VR/AR 환경에서의 몰입감을 극대화하는 역할을 하고 있다.

2-2 음성 인식

음성 인식을 통해 사용자는 손이나 별도의 입력 장치를 사용하지 않고도 음성 명령을 통해 자연스럽게 시스템을 조작할 수 있어 상호작용의 몰입감과 직관성을 높인다. OpenAI의 Whisper 모델은 다양한 언어와 억양을 정확히 인식할 수 있는 최신 음성 인식 모델로, MR 환경에서의 음성 기반 상호작용 구현에 적합한 성능을 보인다.

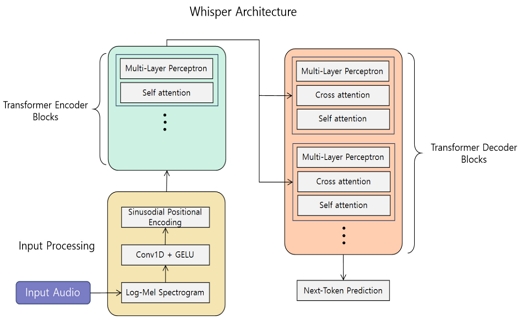

Whisper 모델은 Transformer 아키텍처를 기반으로 하며, 대규모 멀티모달 데이터셋을 활용해 학습된 다중 언어 음성 인식 시스템이다. Whisper는 전 세계의 다양한 언어, 억양, 소음 환경을 포함한 약 68만 시간 이상의 음성 데이터를 통해 훈련되었으며, 이로 인해 Whisper는 높은 정확성과 함께 다양한 상황에 적응할 수 있는 능력을 갖추게 되었다(OpenAI, 2022).

Whisper 모델은 크게 두 가지 주요 단계로 동작한다. 첫째, 음성 신호를 특징 벡터로 변환하는 전처리 과정이 이루어진다. 이 단계에서 음성 데이터를 시간-주파수 영역으로 변환하고, 이를 Transformer 기반 네트워크에 입력한다. 둘째, Transformer는 입력 데이터를 처리하여 음성의 텍스트 전사 결과를 생성하며, 이 과정에서 모델은 다양한 언어 간의 문맥과 의미를 학습한 결과를 반영한다[12].

Whisper 모델의 적용은 단순한 음성 명령 처리에 국한되지 않으며, 다국어 환경에서의 자연스러운 상호작용, 실시간 자막 제공, 그리고 혼합 현실 환경에서의 대화형 인터페이스 구현 등 다양한 응용 가능성을 제공한다. 이러한 특성은 MR 기반의 가상 펫 시뮬레이션과 같은 응용 분야에서 사용자 경험의 몰입감과 상호작용 효율성을 높일 수 있다.

2-3 문장 유사도

문장 유사도는 자연어 처리(NLP) 분야에서 두 문장 간의 의미적 유사성을 정량화하는 기법으로, 사용자와 시스템 간의 상호작용을 향상시키기 위해 다양하게 사용된다. 특히, 본 프로젝트에서 혼합 현실 환경에서의 사용자 명령어의 정확한 해석은 가상 펫과의 자연스러운 상호작용을 구현하는데 핵심적인 역할을 한다.

본 연구에서는 사용자 음성 명령어의 의미를 이해하고, 가상 펫의 행동을 결정하기 위해 all-MiniLM-L6-v2 모델을 활용하였다. 이 모델은 Sentence Transformers 라이브러리에서 제공하는 경량화된 문장 임베딩 모델로, 높은 성능과 효율성을 자랑한다. all-MiniLM-L6-v2는 MiniLMv2 아키텍처를 기반으로 설계되었으며, 1억 개 이상의 문장 쌍으로 학습된 모델이다. 이 모델은 입력된 문장을 384차원의 밀집 벡터 공간으로 매핑하여 문장 간의 의미적 유사성을 계산할 수 있도록 설계되었다[13].

문장 유사도를 분석하는 과정은 크게 세 과정을 가진다. 첫 번째는 음성 인식을 통한 사용자의 음성을 텍스트로 변환한 후, 이를 벡터 임베딩으로 변환한다. 두 번째로 미리 정의된 명령어와 대응하는 벡터와 비교하여 코사인 유사도를 계산한다. 마지막으로 유사도가 높은 명령어를 선택하여 가상 펫의 행동을 결정한다.

이 방식을 통해 가상 펫은 사용자의 음성 명령의 문맥적 의미를 파악하고, 유연한 상호작용을 가능하게 해준다. 예를 들어 “앉아”라는 명령과 “자리에 앉아”라는 명령은 다른 문장을 가지지만, 유사도가 높은 것으로 분석되어 동일한 반응을 유도할 수 있다.

2-4 선행연구 및 이론적 배경을 통한 분석

가상 펫 시뮬레이션과 혼합 현실 기술에 대한 선행연구들은 사용자 몰입감과 상호작용의 증진에 중점을 두고 있다. 정서적 상호작용의 중요성을 강조한 연구에 따르면[3], 반려동물과의 상호작용은 정서적 안정과 스트레스 완화에 긍정적인 영향을 미치며, 이러한 경험은 가상 환경에서도 유사하게 적용될 수 있다.

혼합 현실 기술은 현실과 가상의 경계를 허물어 사용자가 몰입감을 느끼며 상호작용할 수 있는 환경을 제공한다는 점에서 주목받고 있으며, 교육, 헬스케어, 엔터테인먼트 등 다양한 분야에서 활용되고 있다. 특히 음성 인식과 자연어 처리 기술은 사용자가 직관적으로 시스템과 상호작용할 수 있는 중요한 수단으로, 사용자의 심리적 안정감과 몰입감을 높이는 데 기여할 수 있다.

기존 연구에서는 음성 인식과 제스처 인식 기술을 개별적으로 활용하는 사례가 주를 이루었으며, 이를 융합하여 사용자의 상호작용 경험을 더욱 자연스럽고 정서적으로 풍부하게 만드는 방안에 대한 논의는 비교적 제한적이었다[9],[10]. 혼합 현실 환경에서 음성과 제스처를 결합한 상호작용 방식은 몰입감과 상호작용의 질을 향상시키는 데 효과적임을 다양한 연구가 시사하고 있다[7],[8].

이를 종합하면, 혼합 현실 기술은 사용자와 가상 요소 간의 경계를 최소화하여 몰입감을 극대화하고, 정서적 상호작용의 자연스러움을 강화하는 데 중요한 역할을 한다. 음성과 제스처를 결합한 설계는 사용자가 보다 직관적이고 인간적인 방식으로 가상 환경과 교감할 수 있는 가능성을 열어준다. 이와 같은 연구 배경은 가상 펫 시뮬레이션에서 사용자의 감정적 몰입과 행동적 자연스러움을 동시에 구현할 수 있는 효과적인 접근 방법을 제시한다.

2-5 가상 펫 게임의 사례

가상 펫 게임은 사용자와의 상호작용과 몰입감을 중심으로 지속적인 발전을 이루어왔다. 초기에는 단순한 인터페이스와 기능을 제공하던 가상 펫 게임이 현재는 로보틱스, 증강 현실(AR), 혼합 현실(MR) 등 첨단 기술을 도입하며 사용자 경험을 혁신적으로 변화시키고 있다. 과거부터 현재까지 가상 펫 장르로써 대표적인 사례들을 기술의 발전과 함께 분석하여 이들의 특징과 개선 방향을 도출하고, 이를 기반으로 본 연구에서의 인터랙션 설계 방향성을 제안하고자 하였다.

• Tamagotchi (1996)

가상 펫 붐의 시작을 알린 가장 대표적인 제품이다. 소형 키 체인 형태의 장치에 LCD 화면과 세 개의 버튼이 있어, 가상의 애완동물을 먹이고, 청소하고, 놀아주는 기본적인 상호작용을 제공했다. 가상 애완동물의 상태는 시간에 따라 변하며, 적절한 돌봄을 받지 못하면 죽을 수도 있다. Tamagotchi는 사용자가 일상생활에서 지속적으로 관리해야 하는 동반자 개념을 도입하여 디지털 엔터테이먼트에 새로운 차원을 추가했다. 이는 개인의 책임감을 높이고, 디지털 애완동물에 대한 애착을 형성하게 했다. 다마고치의 인기는 미국 일부 학교에서의 다마고치 반입 금지, 생명 윤리 논쟁 등 여러 사회현상을 초래하기도 하였다[14].

• Nintendogs (2005)

Nintendogs는 닌텐도 DS의 터치스크린과 음성 인식을 활용하여 사용자와 강아지 간의 상호작용을 강화했다. 강아지를 쓰다듬거나 음성 명령을 통해 훈련하며, 각 강아지는 고유의 성격을 가지고 있어 개인화된 경험을 제공한다. 닌텐도 DS 라는 기기의 특성을 가장 잘 살린 게임이라 평가받았고, 강아지에게 내리는 모든 명령을 프로그램상에서 버튼을 누르지 않고 직접 말로 할 수 있기에 다마고치류 프로그램을 뛰어넘는 몰입감을 부여했다. 그러나 특정 기기에 의존하는 점과 반복적인 플레이 구조가 한계로 지적된다.

• EyePet (2009)

EyePet은 PlayStation Eye 카메라를 사용하여 사용자의 거실을 가상 펫의 놀이 공간으로 만들었다. 사용자는 자신의 손과 다양한 물리적 객체를 사용하여 가상 펫과 직접 상호작용할 수 있다. EyePet은 증강 현실 기술을 활용하여 가상의 동물을 플레이어와 실제 생활 공간에 통합시키는 것이 특징이다. 이를 통해 플레이어는 마치 집 안에 실제로 작은 동물이 있는 것처럼 느낄 수 있다. 당시에는 혁신적인 상호작용과 엔터테인먼트 경험을 제공했으며, 가상 반려동물과의 상호작용을 새로운 차원으로 끌어올렸다. 하지만 당시 기술적 한계로 핸드 트래킹의 정확성이 부족하고 허공에서 상호작용하는 느낌이 몰입감을 저하시켰다.

• Pokemon Go (2016)

스마트폰이 대중화되며, 증강 현실을 활용한 대표적인 모바일 게임의 사례이다. 이 게임은 포켓몬 프렌차이즈를 기반으로 하며, GPS와 증강 현실 기술을 결합하여 실제 세계에서 포켓몬을 찾고, 잡고, 훈련시키고, 싸우게 하는 혁신적인 게임 플레이를 제공했다. 포켓몬을 하나의 가상의 펫으로써의 관점을 보면 상호작용과 돌봄에 초점을 맞출 수 있다. 이러한 접근 방식은 포켓몬을 단순한 캐릭터나 수집 대상이 아니라, 사용자가 돌보며, 키우며, 교감할 수 있는 가상의 반려동물로 여길 수 있다. 또한 플레이어 간의 협력과 경쟁을 장려하며, 커뮤니티 이벤트를 통해 사람들이 모이고 소통하는 계기를 마련했다. 무엇보다도 증강 현실 기술을 대중에게 널리 알리는 데 기여했으며 이후 AR을 활용한 다양한 어플리케이션과 게임 개발에 영감을 주었다[15].

• Neko Atsume Purrfect Kitty Collector (2023)

Neko Atsume Purrfect Kitty Collector는 Meta Quest3의 혼합 현실 기능을 활용하여 새로운 기술적 접근 방식을 취한 게임이다. 이 게임은 가상의 애완 동물을 사용자의 실제 방 안에서 체험할 수 있게 하여 가상 세계와 실제 세계를 매끄럽게 통합한다. 사용자는 가상 고양이와 놀거나, 배를 쓰다듬거나 하여 새로운 플랫폼을 활용한 훨씬 몰입감 있고 상호작용적인 경험을 제공한다. 하지만 제한적인 콘텐츠 양과 핸드 트래킹 상호작용시 허공을 만지는 듯한 상호작용은 사용자에게 몰입감을 저하시키는 단점들도 존재했다.

기존 가상 펫 게임 사례 분석을 기반으로, 몰입감을 높이는 상호작용 방식을 구현하는 데 초점을 맞춘다. 가상 펫 게임은 초기 Tamagotchi의 단순한 인터페이스에서 출발하여 사용자의 책임감을 강조하며 정서적 교감을 유도하는 데 성공했다. 이러한 기초를 바탕으로, 정서적 교감을 증대시키기 위해 현대 기술을 결합한 상호작용 방식을 설계한다.

Nintendogs는 터치스크린과 음성 인식을 통해 사용자와 가상 펫 간의 몰입감을 높인 대표적인 사례다. 이와 유사한 음성 인식 기반 상호작용을 도입하되, 문장 유사도 기술을 활용하여 사용자의 다양한 표현 방식에도 정확히 반응할 수 있도록 설계한다. 예를 들어, 사용자가 “앉아”라고 명령하든, “거기에 앉아봐” 혹은 “이리 와서 앉으렴”이라고 말하더라도, 문장 유사도를 기반으로 가상 펫은 이를 동일한 명령으로 인식하고 적절히 반응할 수 있다. 이는 사용자가 명령을 보다 자연스럽고 자유롭게 표현할 수 있도록 하며, 가상 펫과의 상호작용에서 현실감을 더욱 강화한다. 이를 통해 사용자는 단순히 정해진 명령어를 외우고 따라하는 것이 아니라, 실제 반려동물과 대화하듯 가상 펫과 교감할 수 있는 환경을 구현한다.

EyePet와 Neko Atsume Purrfect Kitty Collector는 사용자가 손짓을 통해 가상 펫과 상호작용하도록 설계되었으나, 허공에서의 상호작용이 몰입감을 저하시킨다는 한계가 있었다. 따라서 이러한 문제를 극복하기 위해 핸드 트래킹과 음성 인식을 결합한 상호작용 방식을 제안한다. 이 상호작용 방식은 음성을 통해 가상 펫과 대화하며, 동시에 손짓과 같은 제스처를 활용해 가상 펫과 물리적인 교감을 제공함으로써 사용자 몰입감을 높인다. 예를 들어, 사용자가 음성으로 가상 펫을 부르면서 손짓으로 특정 행동을 지시하면, 가상 펫이 이에 반응하도록 설계한다. 이러한 접근은 실제 반려동물과의 교감 방식을 가상 환경에서 재현하며, 사용자가 가상 펫과 더 자연스럽고 직관적으로 상호작용할 수 있도록 돕는다.

Pokemon Go는 사용자 간의 협력과 커뮤니티를 강조하며 AR 기술을 활용해 가상 세계와 현실을 매끄럽게 연결한 사례다. 이러한 성공 요인을 참고하여, 현실 환경에서 사용자와 가상 펫 간의 정서적 교감을 극대화할 수 있는 MR 기술 기반 상호작용을 설계한다. 특히, 문장 유사도와 음성 인식 기술을 활용한 대화형 상호작용은 사용자가 음성을 통해 가상 펫과 교감하는 경험을 제공하며, 이는 실제 반려동물과의 상호작용 방식을 모델링한 것이다. 또한, 핸드 트래킹을 통한 상호작용은 사용자가 손짓과 같은 직관적인 제스처를 통해 가상 펫과의 물리적 교감을 느낄 수 있도록 한다.

본 연구의 상호작용 설계는 기존 가상 펫 게임의 성공 요인을 확장하고, 여전히 개선이 필요한 문제점을 보완함으로써 사용자 몰입감을 극대화하는 데 중점을 둔다. 이를 통해 가상 펫과의 자연스러운 상호작용을 기반으로 정서적 교감을 증대시키고, 가상 펫 시뮬레이션의 사용자 경험을 한 단계 향상시킬 것이다.

III. 게임 설계 및 구현

3-1 상호작용 디자인

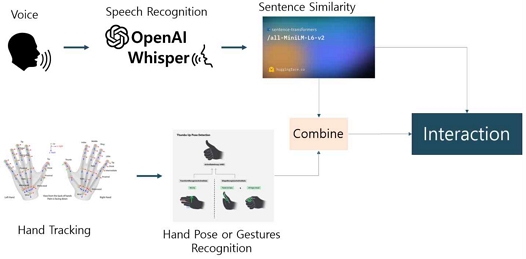

혼합 현실 환경에서 가상 펫과의 몰입감 높은 상호작용을 구현하기 위해 두 가지 상호작용 디자인을 제안한다. 음성 인식 및 문장 유사도를 활용한 상호작용과 핸드 트래킹을 이용한 포즈 및 제스처 기반 상호작용이다. 이 두 방식을 결합하여 사용자가 자연스럽고 직관적으로 가상 펫과 교감할 수 있도록 그림 8과 같이 설계하였다.

음성 인식 기반 상호작용은 사용자의 음성을 텍스트로 변환한 후, 문장 유사도를 분석하여 적절한 반응을 결정한다. 이를 통해 사용자가 다양한 표현 방식으로 명령을 내리더라도 가상 펫이 이를 정확히 이해하고 반응할 수 있다. 설계 방식은 Whisper 모델을 사용하여 사용자의 음성을 텍스트 데이터로 변환한 후, 변환된 텍스트를 all-MiniLM-L6-v2 문장 유사율 모델을 활용해 문장 임베딩으로 변환한다. 사전에 정의된 명령어 데이터와 유사도를 계산하여 가장 유사한 명령어를 선택한다. 유사도가 특정 임계값을 초과하면 해당 명령에 따른 상호작용이 발동한다. 예를 들어, 사용자가 “반가워”를 말하면 문장 유사도 분석을 통해 “안녕”이라는 명령어와 일치도를 확인한다. 유사도가 임계값을 초과하면 가상 펫은 인사하는 상호작용을 수행한다. 이러한 설계는 사용자가 “안녕하세요”와 같은 존댓말을 포함한 유사한 표현을 사용하더라도 동일한 명령으로 처리할 수 있도록 한다.

핸드 트래킹 기술만을 사용하여 상호작용을 할 경우, 제스처가 무분별하게 인식될 위험이 있다. 이를 보완하기 위해 음성 인식과 핸드 트래킹을 결합한 상호작용 방식을 제안한다. 가장 먼저 음성 명령을 먼저 인식하는 것은 첫 번째 디자인과 동일하다. 하지만 해당 음성 명령이 핸드 포즈 혹은 제스처를 동반해야만 하는 상호작용일 경우, 이를 결합한다. 예를 들어, 사용자가 가상 펫에게 “저기 있는 물건좀 가져와줘”라고 말하면서 특정 오브젝트를 가리키는 동작을 하면, 가상 펫은 해당 물체로 이동해 가져오는 행동을 수행한다.

3-2 콘텐츠 설계

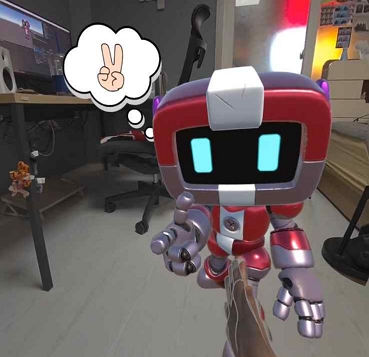

본 프로젝트에서는 가상 펫을 현실의 동물이 아닌 가상의 귀여운 로봇, 이름은 IDA로 설정하였다. 이는 기존 가상 펫 게임 사례 분석에서 밝혀진 바와 같이, 가상 펫이 반드시 실존하는 동물이 아니더라도 사용자와 정서적 교감을 형성할 수 있다는 점과, 가상의 존재가 상호작용의 폭을 넓혀줄 수 있다는 점을 고려한 것이다. IDA는 혼합 현실 환경에서 사용자의 방을 자유롭게 다닐 수 있도록 설계되어, 현실과 가상이 자연스럽게 융합된 상호작용 경험을 제공한다.

IDA는 에너지, 스트레스, 호감도와 같은 상태 변수를 기반으로 한 State 시스템을 갖추고 있다. 이 변수들은 IDA의 행동에 직접적으로 영향을 미치며, 그림 9과 같은 조건에 따라 IDA의 상태가 나뉜다. 이와 같은 상태 변화는 IDA의 행동 속도 및 상태를 직관적으로 나타내며, 플레이어와의 교감과 몰입감을 강화해준다.

사용자 경험을 향상시키고 몰입할 수 있도록 사용자 인터페이스와 시각적 피드백 요소를 설계하였다. 이를 위해 크게 튜토리얼 UI, 인포메이션 UI, 파티클 이모지 등을 추가하였다. 튜토리얼 UI는 처음 사용자들이 IDA의 기능과 사용법을 쉽게 이해할 수 있도록 도와준다. 인포메이션 UI는 IDA의 상태 및 현재 상황을 실시간으로 제공하여, 사용자가 상호작용에 필요한 정보를 쉽게 확인할 수 있다. 파티클 이모지는 IDA의 감정 상태를 시각적으로 표현하기 위해 파티클 이모지 효과를 사용한다. 예를들어, 행복한 상태에서는 하트 이모지가 표시된다.

3-3 구현 환경

본 프로젝트는 Window 11 환경에서 Unity Engine 2022.3.20.f1 버전으로 주 개발을 진행하였다. HMD(Head-Mounted Display)는 Meta Quest 3 모델을 사용하였으며, 사용자 음성 명령과 핸드 트래킹을 인식하는 주요 디스플레이 장치로 활용되었다. 또한, 상호작용 구현 과정에서 일반 PC와 Meta Quest 3 간 네트워크 연결은 Wi-Fi를 통해 이루어졌다.

3-4 구현 내용

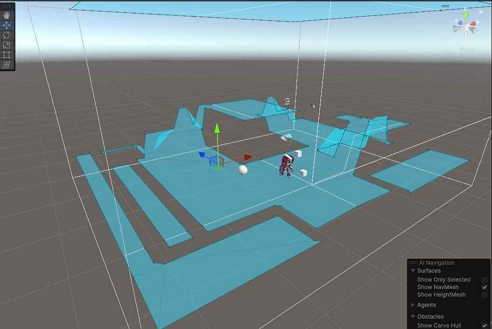

게임의 주인공인 IDA의 모델링 및 기타 오브젝트들의 모델링은 유니티 에셋스토어[16]-[17]을 사용하였다. 주요 기능으로는 가상 펫 IDA와 사용자의 자연스러운 상호작용을 위한 기반으로써 Unity에 내장되어 있는 NavMesh 컴포넌트를 활용해 Pass Finding을 구현하였다. 사용자의 Room Model을 불러온 후, 런타임 중 NavMesh를 베이크하여 그림 10과 같은 표면들을 감지하여 IDA가 움직일 수 있는 공간을 생성한다. 기본적으로 사용자의 왼손의 특정 핸드 포즈를 취하면 그림 11과 같은 다양한 정보가 들어있는 UI를 확인할 수 있도록 하였다. 하단부의 Flat UI는 반댓손을 이용해 스크롤하거나 클릭할 수 있다. Flat UI에는 IDA의 State뿐 아니라 자신의 핸드 포즈가 잘 작동하는지, 튜토리얼 팁, 상호작용 Info등을 스크롤을 통해 확인할 수 있다.

IDA 시스템은 상태 기반 설계와 사용자 상호작용 조건을 결합하여 구현되었다. IDA는 에너지, 스트레스, 호감도와 같은 상태 변수를 가지고 있으며, 사용자의 상호작용에 따라 실시간으로 변화하는 상태를 기반으로 적절한 행동을 수행한다. 음성 명령은 Meta Quest 3의 내장 마이크를 통해 감지되며, Whisper 모델(OpenAI)을 사용하여 텍스트로 변환된 후 Sentence Transformers 기반의 all-MiniLM-L6-v2 모델을 통해 문장 유사도가 분석된다. 이를 통해 사용자의 명령을 이해하고, 가장 적합한 반응을 결정한다. 또한, Meta Quest 3에 내장된 다중 시야각 카메라와 MediaPipe Hands 라이브러리를 활용하여 실시간으로 사용자의 손 포즈를 추적하며, 음성 명령과 결합된 핸드 포즈 데이터를 기반으로 행동을 결정한다. 예를 들어, 사용자가 “이 물건 가져와”라고 말하며 특정 오브젝트를 가리키는 동작을 수행하면, IDA는 해당 물체로 이동하여 가져오는 동작을 수행한다. 동시에 Unity 엔진과 NavMesh 컴포넌트를 통해 사용자의 공간에서 자유로운 이동과 실시간 상호작용을 지원한다.

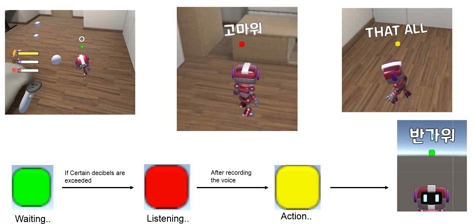

음성 명령은 한국어와 영어가 동시에 작동할 수 있도록 세팅하였다. 상호작용이 시작할땐 가장 먼저 Meta Quest3의 내장 마이크를 통해 음성이 감지되었을 때 발생한다. 그림 12에서 보는 것 과 같이 IDA의 머리 위엔 사용자의 음성이 분석되고 있는지에 대한 정보로써 조그만한 박스가 있다. 박스가 초록색 상태일 땐 음성 상호작용을 기다리고 있는 상태이고, 특정 데시벨이 넘어가면 사용자가 말을 하고 있다고 판단해 음성을 녹화한다. 녹화하는 상태일 때는 빨간색 상태로 변하게 된다. 음성이 모두 녹화되고 사용자의 음성이 텍스트로 변환하고 이를 문장 유사율 모델을 거쳐 IDA의 행동이 결정되면 박스는 노란색으로 변하게 된다. 노란색일 때는 상호작용이 진행중인 상태를 의미한다.

Sentence similarity analysis process after speech recognition*This in-game image is originally written in Korean.

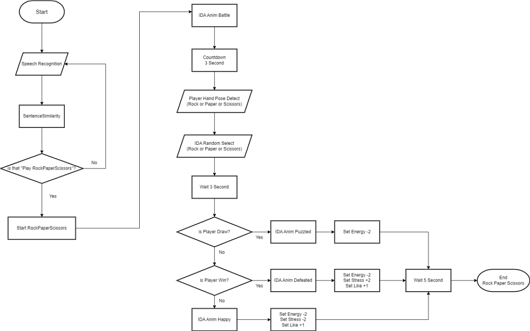

두 가지 인터랙션 디자인을 모두 활용한 가위바위보의 플로우 차트는 그림 13과 같다. 가위바위보 상호작용을 하기 위해서 우선 “가위바위보 하자” 혹은 “Play Rock Paper Scissors”라는 문장이 설정되어 있는데 이와 유사한 문장을 음성 인식하여 텍스트로 넘어가게 되면 가위바위보 게임을 진행하게 된다. 게임이 시작되면 IDA가 무엇을 낼지 고민하는 시간이 3초 주어진다. 시간이 지난 후 무엇으로 낼지 결정한 IDA는 애니메이션이 변경되면서, 대화형 UI를 통해 카운트 다운을 3초간 센다. 사용자는 이 때 핸드 트래킹을 통해 가위, 바위, 보 셋 중 하나의 포즈를 취한다. 만약 세 개의 포즈 중 해당되는 포즈가 없다면 무승부 처리가 된다. 그 후 결과를 인지하는 시간을 주기 위해 3초간 대기하게 된다. 결과에 따라 IDA는 승패에 따른 애니메이션과 결과가 출력된다.

Ⅳ. 결 론

지금까지 혼합 현실 환경에서 가상 펫과의 상호작용을 통해 사용자 몰입감을 극대화하기 위한 설계를 제안하고 이를 구현하였다. 기존 가상 펫 게임의 사례 분석을 바탕으로, 음성 인식과 문장 유사도 분석, 핸드 트래킹 기술을 결합하여 사용자와 가상 펫 간의 자연스럽고 직관적인 상호작용을 구현하였다.

연구의 주요 결과는 다음과 같다. 첫째, 음성 인식 및 문장 유사도를 활용하여 다양한 표현 방식의 사용자 명령에도 유연하게 반응할 수 있는 시스템을 개발하였다. 이는 기존 명령어 기반 상호작용의 한계를 극복하며, 사용자가 가상 펫과 보다 자연스럽게 교감할 수 있도록 하였다. 둘째, 핸드 트래킹 기술을 적용하여 제스처와 같은 물리적 동작을 통해 상호작용을 확장하였다. 음성 명령과 제스처를 결합한 상호작용 방식은 사용자 경험의 몰입감을 한층 더 높이는 데 기여하였다. 셋째, IDA의 상태(State) 시스템을 통해 사용자의 행동과 가상 펫의 반응이 유기적으로 연결되도록 설계하여 상호작용의 역동성을 강화하였다.

본 연구는 가상 펫 시뮬레이션의 몰입감을 높이는 상호작용 방식을 제시하며, 혼합 현실 기술의 응용 가능성을 확대하였다. 특히, 실제 반려동물과의 상호작용에서 느껴지는 정서적 교감을 가상 환경에서 효과적으로 재현함으로써, 가상 펫의 기능적 및 감정적 역할을 동시에 수행할 수 있음을 확인하였다.

그럼에도 불구하고, 몇 가지 아쉬운 점이 존재한다. 첫째, 하드웨어의 한계로 인해 더 정교한 음성 인식 모델을 적용하지 못하였으며, 이로 인해 일부 상호작용의 정확성과 정밀도가 제한되었다. 둘째, 사례 분석 과정에서도 지적된 햅틱 피드백의 부재 문제를 극복하지 못해, 사용자가 허공을 만지는 듯한 몰입감 저하가 여전히 존재한다. 셋째, 본 연구의 설계가 사용자 몰입감에 미치는 효과를 체계적으로 검증하지 못했다는 점도 한계로 작용한다. 이러한 부분은 향후 실험과 사용자 피드백을 통해 개선될 여지가 있다.

본 연구는 가상 펫 시뮬레이션에서 몰입감을 높이고 상호작용 방식을 설계하는 데 있어 새로운 가능성을 탐구하였으며, 혼합 현실 기술을 활용한 정서적 교감 및 상호작용 확장의 방향성을 제시하였다. 이러한 결과는 향후 다양한 응용 분야에서 혼합 현실 기술의 활용 범위를 넓히는 데 기여할 수 있을 것으로 기대된다.

Acknowledgments

본 연구는 과학기술정보통신부 및 정보통신기획평가원의 정보통신방송혁신인재양성(메타버스융합대학원)사업 연구 결과로 수행되었습니다(IITP-2024-RS-2024-00425383).

References

-

D. Kanschik, R. R. Bruno, G. Wolff, M. Kelm, and C. Jung, “Virtual and Augmented Reality in Intensive Care Medicine: A Systematic Review,” Annals of Intensive Care, Vol. 13, No. 1, 81, September 2023.

[https://doi.org/10.1186/s13613-023-01176-z]

-

J. Gerup, C. B. Soerensen, and P. Dieckmann, “Augmented Reality and Mixed Reality for Healthcare Education beyond Surgery: An Integrative Review,” International Journal of Medical Education, Vol. 11, pp. 1-18, January 2020.

[https://doi.org/10.5116/ijme.5e01.eb1a]

-

H. Herzog, “The Impact of Pets on Human Health and Psychological Well-Being: Fact, Fiction, or Hypothesis?,” Current Directions in Psychological Science, Vol. 20, No. 4, pp. 236-239, August 2011.

[https://doi.org/10.1177/0963721411415220]

-

H. Na and S.-Y. Dong, “Mixed-Reality-Based Human-Animal Interaction can Relieve Mental Stress,” Frontiers in Veterinary Science, Vol. 10, 1102937, March 2023.

[https://doi.org/10.3389/fvets.2023.1102937]

-

D. Kim and D. Jo, “Exploring the Effects of Passive Haptic Factors When Interacting with a Virtual Pet in Immersive VR Environment,” Journal of the Korea Computer Graphics Society, Vol. 30, No. 3, pp. 125-132, July 2024.

[https://doi.org/10.15701/kcgs.2024.30.3.125]

-

J. Zhang, T. Chen, W. Gong, J. Liu, and J. Chen, “Exploring Data Input Problems in Mixed Reality Environments: Proposal and Evaluation of Natural Interaction Techniques,” Future Internet, Vol. 16, No. 5, 150, May 2024.

[https://doi.org/10.3390/fi16050150]

-

K. Fang and J. Wang, “Interactive Design with Gesture and Voice Recognition in Virtual Teaching Environments,” IEEE Access, Vol. 12, pp. 4213-4224, January 2024.

[https://doi.org/10.1109/ACCESS.2023.3348846]

-

Z. Wang, H. Wang, H. Yu, and F. Lu, “Interaction with Gaze, Gesture, and Speech in a Flexibly Configurable Augmented Reality System,” IEEE Transactions on Human-Machine Systems, Vol. 51, No. 5, pp. 524-534, October 2021.

[https://doi.org/10.1109/THMS.2021.3097973]

-

N. Nooruddin, R. Dembani, and N. Maitlo, “HGR: Hand-Gesture-Recognition Based Text Input Method for AR/VR Wearable Devices,” in Proceedings of 2020 IEEE International Conference on Systems, Man, and Cybernetics (SMC), Toronto, Canada, pp. 744-751, October 2020.

[https://doi.org/10.1109/SMC42975.2020.9283348]

-

Y. Li, J. Huang, F. Tian, H.-A. Wang, and G.-Z. Dai, “Gesture Interaction in Virtual Reality,” Virtual Reality & Intelligent Hardware, Vol. 1, No. 1, pp. 84-112, February 2019.

[https://doi.org/10.3724/SP.J.2096-5796.2018.0006]

-

X. Liu, Y. Zhang, and X. Tong, “V-Hands: Touchscreen-based Hand Tracking for Remote Whiteboard Interaction,” arXiv:2409.13347, , September 2024.

[https://doi.org/10.48550/arXiv.2409.13347]

-

A. Radford, J. W. Kim, T. Xu, G. Brockman, C. McLeavey, and I. Sutskever, “Robust Speech Recognition via Large-Scale Weak Supervision,” in Proceedings of the 40th International Conference on Machine Learning (ICML ’23), Honolulu: HI, pp. 28492-28518, July 2023.

[https://doi.org/10.48550/arXiv.2212.04356]

-

W. Wang, H. Bao, S. Huang, L. Dong, and F. Wei, “MiniLMv2: Multi-Head Self-Attention Relation Distillation for Compressing Pretrained Transformers,” in Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (ACL-IJCNLP 2021), Online, pp. 2140-2151, August 2021.

[https://doi.org/10.18653/v1/2021.findings-acl.188]

- Mental Floss. A Brief History of the Tamagotchi [Internet]. Available: https://www.mentalfloss.com/article/642373/tamagotchi-history, .

- Aju News. What is the Secret and Prospect of Success of Pokemon Go Analyzed by the Software Policy Institute? [Internet]. Available: https://www.ajunews.com/view/20160727092601188, .

- Unity Asset Store. Jammo Character, Mix and Jam [Internet]. Available: https://assetstore.unity.com/packages/3d/characters/jammo-character-mix-and-jam-158456, .

- Unity Asset Store. Low Poly RPG Fantasy Weapons Lite, JustCreate [Internet]. Available: https://assetstore.unity.com/packages/3d/props/weapons/low-poly-rpg-fantasy-weapons-lite-226554, .

저자소개

2018년~현 재: 경희대학교 소프트웨어 융합학과 재학

※관심분야:메타버스, 기능성 게임

2002년:University of Dundee (UK), Electronic Imaging, BA (Honours)

2004년:University of Dundee (UK), Electronic Imaging, MSc (이학석사)

2010년:University of Dundee (UK), Electronic Imaging, (게임학), PhD (이학박사)

2004년~2007년: University of Dundee, Lecturer

2007년~2010년: KAIST 엔터테인먼트 공학연구소, 연구원 (기능성 게임랩)

2010년~2012년: KAIST 문화기술대학원, Digital Art & Entertainment Track 초빙교수 (게임)

2012년~2013년: 서울대학교 차세대융합기술연구원, 게임융합미디어연구센터 센터장

2013년~2024년: 경희대학교 디지털콘텐츠학과 교수

2024년~현 재: 경희대학교 일반대학원 메타버스 학과 교수

※관심분야:기능성 게임, 게임화, 게임문화, VR/AR 콘텐츠