디지털 배경 합성에서 가우시안 스플래팅을 활용한 카메라 시차 표현 방법 연구

Copyright ⓒ 2025 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 ‘SIGGRAPH 2023’에서 발표된 3D 재구성 기술인 ‘가우시안 스플래팅’ 과정에서 생성된 3D 모델을 활용하여 디지털 배경 합성에서의 카메라 시차 효과 표현 방법을 제안한다. 이에, 드론 촬영 데이터를 기반으로 3D 배경 에셋을 생성하고, 깊이 정보를 활용한 카메라 초점 조절 방법을 제시하였다. 결과적으로 기존의 2D 합성 방식으로는 표현하기 어려웠던 카메라 시차 효과를 구현하여, 현실 기반 고품질 3D 배경 합성이 가능함을 확인했다. 본 연구는 가우시안 스플래팅을 통한 디지털 합성의 가능성을 제시함으로써 향후, 버추얼 스튜디오의 LED Wall를 활용한 실시간 배경 합성 및 카메라 시차 효과 구현, 가우시안 스플래팅 3D 에셋의 라이브러리화 등 VFX 산업 전반에 걸쳐 작업 효율성을 높이는 데 기여할 것이다.

Abstract

This study proposes a method to represent the parallax effect of cameras in digital background compositing using 3D models generated through "Gaussian Splatting," a 3D reconstruction technique introduced at SIGGRAPH 2023. To achieve this, 3D background assets were created from drone footage, and a technique for adjusting camera focus based on depth information was introduced. The study successfully implemented a parallax effect, which is challenging to achieve with conventional 2D compositing methods, demonstrating the feasibility of high-quality, reality-based 3D background compositing. By showcasing the potential of digital compositing through Gaussian Splatting, this research aims to improve work efficiency in the VFX industry, including real-time background compositing, camera parallax effect implementation using LED walls in virtual studios, and the development of libraries for Gaussian Splatting 3D assets.

Keywords:

Visual Effects, Digital Compositing, 3D Reconstruction, Radiance Field, Gaussian Splatting키워드:

시각 효과, 디지털 합성, 3차원 재구성, 래디언스 필드, 가우시안 스플래팅Ⅰ. 연구의 필요성 및 목적

AI와 접목된 컴퓨터 비전(Computer Vision)과 현실 기반 3D 재구성 기술이 급속도로 발전함에 따라, VFX(Visual effects) 및 디지털 합성(Digital Compositing) 파이프라인의 새로운 혁신을 이끌어내고 있다. 다양한 절차에 따라 진행되는 VFX 파이프라인에서의 배경 합성은 크게 두 가지 방법으로 구분할 수 있다. 첫째, 실시간 디지털 합성(Real-Time Digital Compositing)은 LED Wall, 실시간 렌더링 소프트웨어, 촬영 및 조명 장비 등의 첨단 기술을 활용하여 촬영 현장에서 디지털 환경과 물리적 장면을 통합하는 방법이다. 이에, 시간과 인력 비용을 절감할 수 있는 잠재력이 크며, 실시간 피드백을 통해 효율적인 의사 결정이 가능하여 고품질의 결과물을 신속하게 도출할 수 있다. 둘째, 컴퓨터 소프트웨어를 활용한 디지털 합성은 시각 효과 작업에서 주로 사용되고 있으며, 작업량이 많은 콘텐츠나 소규모 스튜디오에서 비교적 용이하게 접근할 수 있는 옵션으로 평가된다. 디지털 합성은 2개 이상의 이미지나 영상 소스를 결합해 시각적으로 일관된 최종 결과물을 제작하는 과정이다[1]. 이 기술은 영화, 드라마, 광고 등의 콘텐츠에서 폭넓게 활용되고 있다. 특히, 디지털 배경 합성의 핵심 과정은 알파 채널(Alpha Channel)을 생성하여 이미지의 투명도를 조절하는 것이며, 각 영상 또는 이미지의 일부를 투명하게 처리하여 다른 이미지와 자연스럽게 겹쳐 보이게 할 수 있다[2]. 이러한 기법은 주로 촬영이 어려운 장소를 배경으로 설정하거나, 촬영지 간 물리적 거리로 인해 발생하는 장비 운송 비용 및 인건비를 절감하기 위해 활용된다. 더불어, 촬영 후 배경을 교체하거나 수정할 수 있는 유연성을 제공하여 작업 효율성을 높이는 데 기여한다.

배경 합성에서 중요한 기술적 과제 중 하나는 카메라 움직임에 따른 시차(Parallax) 효과를 자연스럽게 표현하는 것이다. 시차 효과는 관찰자의 시점 변화에 따라 배경에서 보이는 건물, 나무 등의 다양한 오브젝트 간의 상대적 위치 변화로 인해 발생하는 시각적 현상으로[3], 영상의 깊이감과 현실감을 부여하는 데 중요한 요소이다. 2D 환경에서는 배경에서 보이는 각 오브젝트의 ‘앞, 뒤 깊이 축’ 차이를 조절하여 기본적인 시차 효과를 구현할 수 있으나, 카메라 움직임에 따른 오브젝트의 외형 변화나 복잡한 3D 구조의 표현에는 한계가 존재한다. 이 문제를 해결하기 위해서는 2D 배경이 아닌 현실 기반 3D 배경 합성이 요구된다. 이를 위해 실제 환경을 3D 모델로 변환하는 3D 재구성 기술이 필요하며[4], 이는 포인트 클라우드(Point Cloud) 및 메시(Mesh) 생성 등 기존 제작 방식보다 간소화된 3D 모델 제작 파이프라인을 제공한다[5]. 대표적인 방법으로는, 여러 각도에서 촬영한 2D 이미지를 인풋 데이터로 활용하여 3D 장면을 생성하는 ‘포토그래메트리(Photogrammetry)’[6], 신경망을 활용한 3D 재구성 기술인 ‘NeRF: Neural Radiance Fields’[7], 그리고 ‘SIGGRAPH 2023’에서 발표되어 최근 주목받고 있는 ‘가우시안 스플래팅(Gaussian Splatting)’은 다양한 각도에서 촬영된 이미지를 인풋 데이터로 사용하며, 다수의 가우시안 분포(Gaussian Distribution)를 활용하여 물체나 환경의 표면을 구현함으로써 렌더링 과정에서 현실 기반의 3D 모델을 생성하는 기술이다[8]. 이는 기존 3D 재구성 기술보다 데이터를 효과적으로 압축하면서 고품질을 유지하고, 복잡한 장면에서도 사실적 결과를 제공한다[8]. 아울러, 동적 장면의 캡쳐 및 렌더링하는 기술인 ‘4D 가우시안 스플래팅’이나[9], 신경망(Neural Network)을 활용한 ‘가우시안 스플래팅 결과물의 재조명(Re-lighting) 구현’ 연구 등이 활발히 진행되고 있다[10]. 향후, 이러한 기술들은 VFX 및 합성 파이프라인과 접목하여 다양한 방법론 연구의 가능성을 제공할 것이다.

본 연구의 목적은 기존 VFX 디지털 합성 파이프라인에 가우시안 스플래팅 3D 모델 구현 기술을 접목하여 새로운 방법론을 제시하는 데 있다. 구체적으로, 가우시안 스플래팅을 활용하여 카메라 움직임에 따른 시차 효과를 구현하는 방법을 모색하고, 이를 통해 기존 2D 합성 방식으로는 표현하기 어려운 복잡한 시각 효과의 실현 가능성을 탐구하고자 한다. 아울러, 가우시안 스플래팅 과정에서 생성되는 깊이 정보(Depth Map)[8]를 활용한 카메라 초점 조절 방법을 효과적으로 표현할 수 있는 방법론을 제안한다. 고품질의 가우시안 스플래팅 3D 배경의 활용성을 논의함으로써 나아가, 실시간 디지털 배경 합성에서의 적용 가능성을 제시하고자 한다.

이에, 본 연구는 학술적인 측면에서 ‘가우시안 스플래팅을 활용한 VFX 파이프라인’의 기초 연구가 될 것이며, 디지털 합성 소프트웨어 내의 가우시안 스플래팅 플러그인 개발과 같은 새로운 연구 주제를 제시할 것이다. 산업적인 측면에서는 첫째, 현실 기반 3D 디지털 합성이나 입체적인 카메라 초점 표현이 요구되는 콘텐츠에서 활용되어, 더욱 현실적인 시각적 경험을 제공할 것이다. 둘째, 가우시안 스플래팅 3D 에셋을 버추얼 스튜디오 내 LED Wall 배경으로써의 활용 가능성을 제시할 것이다. 세 번째로 고품질의 가우시안 스플래팅 과정으로 생성된 실사 기반 3D 모델을 라이브러리화하여 필요로 소스를 쉽게 불러와 작업할 수 있는 기틀이 마련될 것이며, 결과적으로 VFX 산업의 발전을 도모할 것으로 기대한다.

Ⅱ. 연구 방법 및 범위

본 연구는 디지털 배경 합성에서 가우시안 스플래팅을 활용한 카메라 시차 표현 방법을 구성하기에 앞서, 먼저 문헌 연구를 통해 가우시안 스플래팅과 기존 디지털 합성의 개념 및 파이프라인을 이론적으로 고찰한다. 아울러, 가우시안 스플래팅 과정에서 생성되는 아티팩트(Artifacts)를 최소화하기 위한 연구 환경을 구축했다[8]. 이에, DJI사의 ‘Air 3’ 드론을 활용했으며, 시차 효과가 발생하는 카메라 무브먼트 샷으로 한정하여 인풋 데이터를 확보하였다. 이후, 본 논문에서는 구성한 시차 표현 방법 파이프라인에 따라 가우시안 스플래팅 3D 모델 생성 및 배경 합성 과정에 대해 알아보며, 구체적으로 가우시안 스플래팅 과정에서 생성된 아티팩트 제거 방법, 깊이 정보를 활용한 카메라 초점 표현 방법을 소개한다. 이어서 연구 결과에서는, 최종적으로 합성된 장면에서 배경 내에 있는 오브젝트 외형을 특징점으로 하여 카메라 시차 변화가 효율적으로 이루어졌는지 도출한다. 이에, 시간의 흐름에 따라 점차 변화되는 오브젝트의 외형을 확인하고 배경에 존재하는 오브젝트 간의 상대적 움직임을 추적하여, 시차 효과가 가장 잘 나타나는 영역을 식별한다. 또한, 2D 합성과 비교하여 가우시안 스플래팅 기반 3D 배경 합성 및 시차 표현의 타당성을 검토한다. 마지막으로 결론에서는 본 연구의 기대효과와 한계점에 대해 논의하고, 더 나아가 LED Wall 배경으로써의 활용법과 현실 기반 3D 모델의 라이브러리화를 통해, VFX 산업에서 효과적으로 활용할 수 있는 방안과 관련된 연구의 확장 가능성을 제시한다.

Ⅲ. 이론적 배경

3-1 가우시안 스플래팅(Gaussian Splatting)

SIGGRAPH 2023에 발표된 가우시안 스플래팅은 3D 데이터의 압축 및 시각적 재구성을 위한 최신 기술 중 하나로 특히, 복잡한 장면에서 높은 품질의 렌더링을 제공하는데 주목받고 있으며, 3D 데이터를 효율적으로 표현하기 위해 고안된 방법이다[8]. 이 기술은 기존의 포인트 클라우드나 메시 기반의 3D 데이터 표현 방식과 비교하여 다양한 장점을 포함한다. 기존의 각 포인트 데이터는 고정된 좌표와 색상 정보를 포함하고 있지만, 가우시안 스플래팅의 각 포인트는 위치나 색상뿐만 아니라 크기, 방향, 그리고 가우시안 커브의 형태를 정의하는 다양한 매개변수를 포함한다[8]. 이에, 여러 3D 데이터 포인트를 가우시안 분포로 모델링하는 과정이 수행되며, 단순한 점의 집합이 아니라 연속적인 형태를 나타낼 수 있게 되고 이러한 가우시안 형태의 중첩을 통해 부드럽고 자연스러운 3D 장면을 렌더링할 수 있다[8].

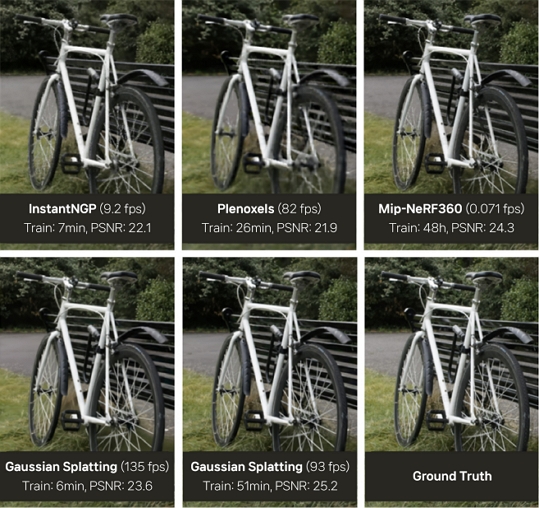

가우시안 스플래팅은 이미지 처리 및 컴퓨터 비전 기술에서 기원했으며, 가우시안 분포는 이미지 스무딩(Image Smoothing)[11] 및 경계 검출(Edge Detection)[12] 등에서 핵심적 역할을 해왔다. 이러한 수학적 특성은 3D 데이터의 표현에 적용되어 고품질의 3D 장면을 적은 데이터로도 효과적으로 표현할 수 있게 되었다. 가우시안 스플래팅을 포함한 3D 재구성은 2D 이미지 데이터를 기반으로 하여 3D 모델로 변환하는 기술이며[4], 역사 유산 보존, 영상 콘텐츠, 가상 및 증강현실(VR, AR) 등의 다양한 분야에서 중요한 역할을 한다. 초기 연구는 광장(light field) 및 기본적인 3D 재구성 중심으로 이루어졌으나, 복잡한 장면과 조명 조건을 처리하는 데 한계가 있었다[4]. 이후, ‘포토그래메트리’에서 사용되는 기술인 SfM(Structure-from-Motion)과 다중 뷰 스테레오 알고리즘(Multi-View Stereo) 기술의 발전으로 더욱 정교한 3D 재구성이 가능해졌으나, 복잡한 장면 생성에는 한계가 있었다[5]. 이를 해결하기 위해 등장한 ‘NeRF’는 딥러닝을 이용해 공간 좌표를 색상과 밀도로 매핑(Mapping)하여 사실적 장면을 생성하지만, 긴 학습 시간이 요구되며 암묵적(implicit)인 특성으로 인해 수정이 어렵다는 한계가 존재한다[4]. 이를 위해 도입된 ‘가우시안 스플래팅’은 수백만 개의 가우시안을 활용해 명시적(explicit) 표현 방식과 병렬 처리를 통해 효율적인 계산 및 렌더링이 가능하다[4]. 기존 NeRF가 복잡한 볼륨 광선 추적(Ray-Marching)에 의존하는 반면, 가우시안 스플래팅은 가우시안을 이미지 평면에 직접 투사하여 불필요한 계산을 줄이고 실시간 렌더링이 가능하도록 한다[4]. 최초로 발표된 가우시안 스플래팅 논문에 따르면 그림 1과 같이 가우시안 스플래팅(Gaussian Splatting)은 기존의 3D 재구성 기술보다 렌더링 속도가 각 93fps, 135fps로 높게 기록됐으며, 원본 이미지와 비교하여 품질 정도를 나타내는 정량적 지표인 ‘PSNR’가 비교적 높게 기록되었다.[8] 특히, 기술 검토 논문에서는 가우시안 스플래팅 기반 모델인 ‘Gaussian-SLAM’은 NeRF 기반 모델인 ‘Point-SLAM’ 대비 약 578배 빠른 렌더링 속도를 달성하였다고 언급했다[4]. 따라서, 고품질 이미지를 생성할 뿐만 아니라 동시에 높은 처리 효율을 유지하며 디지털 합성의 3D 배경으로 활용하기에 적합한 기술임을 제시한다. 또한, 복잡한 조명, 오브젝트가 포함된 장면에서도 유연한 처리 능력을 제공하며[4], 앞으로의 VFX 제작 파이프라인 연구 및 산업 분야에서 중요한 역할을 할 잠재력을 지니고 있다.

3-2 디지털 합성의 개념 및 기존 파이프라인

디지털 합성은 이미지 또는 영상 소스를 결합하여 하나의 통합된 장면을 제작하는 과정으로[1], VFX 제작 파이프라인에서 최종적인 결과물을 도출하는 작업이다. 디지털 합성은 1997년 ‘Sony Pictures Imageworks’사가 출시한 ‘Shake’라는 소프트웨어를 통해 본격적으로 도입되었으며, 디지털 합성 소프트웨어는 VFX 파이프라인에서 필수적인 요소로 자리 잡아 공상과학(Sci-Fi)이나 판타지와 같은 스토리텔링 수요의 증가로 인해 더욱 중요한 역할을 수행하고 있다[13]. 아울러, 디지털 합성은 실사 촬영 후 편집 과정에서 발견된 촬영 오류를 수정하는 데 기여하며, 추가로 렌더링 장비와의 결합을 통해 제작 및 렌더링 소요 시간을 단축하여 VFX 작업의 유연성을 높이고 비용 절감 효과를 가져오는 데 기여한다. 최근에는 디지털 합성을 위해 다양한 기술과 소프트웨어가 활용되며, 작업 방식에 따라 크게 두 가지로 구분된다. 첫째, 레이어(Layer) 방식의 합성은 2D 및 3D 소스를 레이어 형태로 겹쳐 표현함으로써 복합적인 장면의 구현이 가능하다. 이 방식은 직관적인 사용자 인터페이스(UI)를 제공하며, 개별 레이어의 독립적인 설정이 용이하다. 둘째, 노드(Node) 방식의 합성은 각 소스를 계층적으로 병합함으로써 최종 결과물을 생성한다. 이 방식은 각 노드를 통해 장면의 정밀한 제어가 가능하며 이에 따른 확장성을 제공한다.

디지털 합성에서 주로 활용되는 기법은 다음과 같다. 첫째, 각 레이어의 투명도를 조절하여 자연스럽게 중첩되어 보이는 표현을 위한 ‘알파 블렌딩(Alpha Blending)’은 주로 두 개 이상의 이미지를 합성할 때 사용한다[14]. 둘째, 이미지의 특정 밝기 영역을 추출 및 제거하거나 그린 또는 블루 스크린 장면에서 특정 색상을 제거하여 빈 영역을 생성하는 ‘키잉(Keying)’[1]은, 해당 영역에 다른 소스를 합성할 수 있도록 하는 기초 작업으로, 영화나 드라마 등의 제작에서 널리 활용되며, 인물이나 오브젝트를 다른 배경에 자연스럽게 합성하는 데 사용된다. 셋째, 복잡한 배경이나 상상 속의 풍경을 제작한 뒤 이를 다른 이미지나 영상 소스와 결합하는 ‘매트 페인팅(Matte Painting)’은 전통적인 회화 기법에서 유래하였으며, 현대 VFX에서는 디지털 도구를 활용하여 정밀하게 제작된다[15]. 마지막으로, 특정 오브젝트나 인물을 배경과 분리하는 기법인 ‘로토스코핑(Rotoscoping)’은 복잡한 오브젝트나 움직임이 포함된 장면에서 주로 사용한다[1].

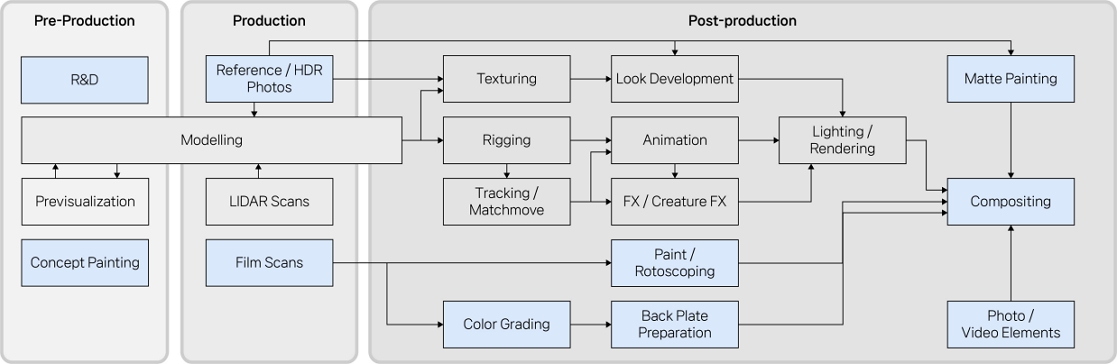

디지털 배경 합성은 그림 2에 제시된 VFX 제작 파이프라인을 따른다. 아울러, 실제 제작에서는 다수의 작업이 병렬적으로 수행되며[16], 파이프라인은 다음과 같이 구분된다. 첫째, VFX 합성 장면의 기획 단계인 ‘Pre-Production’에서는 제작 견적 책정, 크로마키 촬영, 매트 페인팅 및 합성 방식 등을 계획한다[16]. 둘째, ‘Production’ 단계에서는 계획한 장면을 촬영하거나 필요한 2D 및 3D 에셋을 수집하고 매트 페인팅을 위한 3D 모델링(Modeling), 텍스처링(Texturing), 라이팅(Lighting) 등의 작업을 수행한다[16]. 셋째, ‘Post-Production’ 단계에서는 디지털 합성 소프트웨어의 ‘환경 설정 패널’을 통해 원본 플레이트와의 동일한 해상도 및 포맷으로 작업 환경을 설정하고, 합성 장면의 기준이 되는 원본 플레이트를 불러와 노이즈 제거 작업을 수행한 후, 키잉 작업을 위해 크로마키의 특정 색상을 제거하거나 로토스코핑을 통해 필요한 요소를 분리한다[17]. 그리고 작업 영역에 각 소스를 병합하고 장면의 시각적 일관성을 위해 배경의 위치, 밝기, 색상 등을 조절하여 최종 결과물을 구현한다[16]. 이후, 마지막 단계에서는 최종 합성된 샷들의 보정 작업(Digital Intermediate), 사운드 믹싱(Sound Mixing) 등을 수행한다.

Ⅳ. 가우시안 스플래팅 활용 카메라 시차 표현 방법

4-1 개요

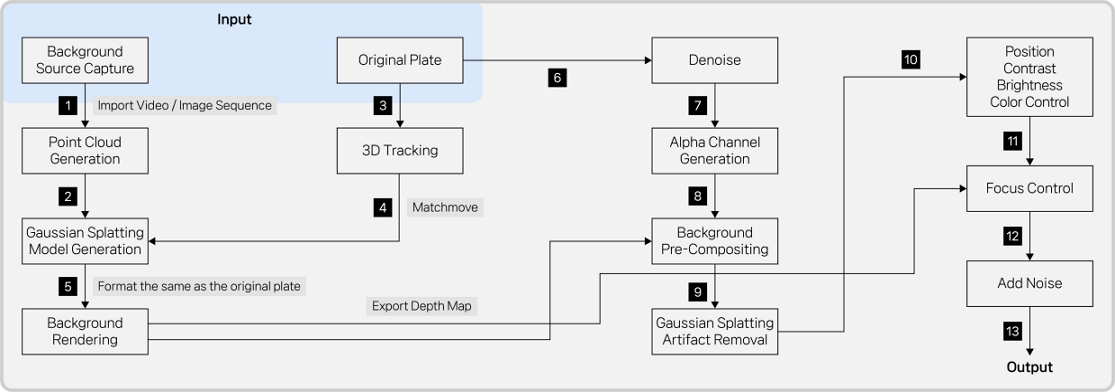

디지털 배경 합성에서 가우시안 스플래팅을 활용한 카메라 시차 표현 방법 파이프라인은 그림 3과 같다. 파이프라인의 인풋 데이터는 색상, 위치 등의 기준이 되는 원본 플레이트와, 배경 소스 촬영본으로 구분한다. 배경 소스는 3D 재구성 소프트웨어를 활용하여 불러온 뒤, 학습(Training) 과정을 거쳐 포인트 클라우드 및 3D 배경 모델을 생성한다. 이후, 원본의 카메라 움직임과 일치하도록 매치무브 작업을 수행한다. 그다음, 기존의 밑 작업 과정에 따라 노이즈 제거 및 알파 채널 생성 작업을 진행한다. 이어서, 가우시안 스플래팅 3D 배경에 존재하는 아티팩트를 제거하고, 원본과의 시각적 일관성을 확보하기 위해 위치, 밝기, 색상 등을 조절하는 작업이 이루어진다. 추가로, 카메라 초점 조절이 필요한 경우 기존의 도구를 사용하거나, 깊이 정보를 활용하여 입체적인 초점 조절을 수행한다. 마지막으로, 제거했던 노이즈를 다시 추가한 뒤 최종 렌더링을 진행한다.

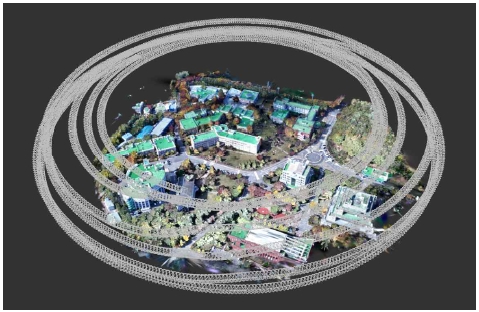

4-2 원본 플레이트 및 배경 소스 촬영

본 파이프라인에서는 원본 플레이트 및 배경 소스가 포함된 인풋 데이터를 확보하기 위해 DJI사의 ‘Air 3’ 드론을 사용하였다. 이는 고품질 항공 촬영에 적합한 장비로, 본 연구의 목적에 부합하는 효과적인 영상 데이터 취득이 가능하며, 특히, ‘ActiveTrack 360°’ 기능을 통해 피사체를 자동으로 추적함으로써 다양한 고도와 각도에서 유연한 촬영이 가능하다. 드론 촬영은 기존의 지상 촬영 방식과 달리, 다양한 시점에서의 촬영이 가능하고 카메라 움직임에 따른 시차 현상의 효과적인 구현이 가능하다는 이점을 제공하며, 불필요한 카메라 이동을 최소화할 수 있어 다음 장의 그림 4에서 제시된 바와 같이, 가우시안 스플래팅 배경 생성 과정에서 균일한 영상 데이터를 효율적으로 확보할 수 있다. 또한, 고품질의 3D 결과물을 생성하기 위해 3D 재구성 소프트웨어의 캡쳐 가이드라인(표 1)을 참고하여 촬영을 진행하였다. 아울러, 시차 효과가 발생하는 카메라 무브먼트 중 특정 유형에 한정하여 촬영 및 연구가 이루어졌다. 이러한 유형에는 상하로 수직 이동하는 ‘Pedestal Shot’, 좌우로 수평 이동하는 ‘Side to Side Tracking Shot’, 카메라가 피사체를 향해 앞으로 이동하는 ‘Dolly in Shot’, 그리고 카메라가 피사체를 중심으로 곡선을 그리며 이동하는 ‘Arc Shot’을 포함한다.

4-3 3D 배경 생성 및 매치무브

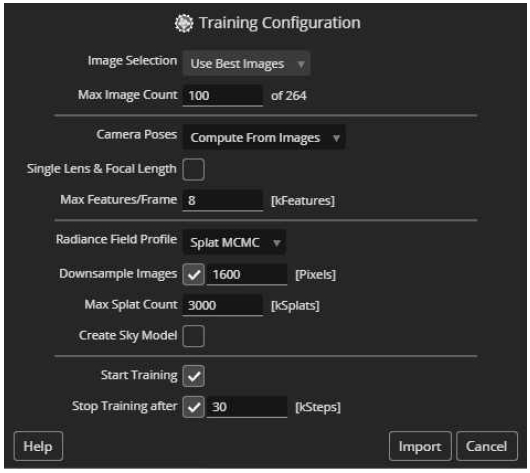

3D 배경 생성을 위해 드론 촬영본을 가우시안 스플래팅 소프트웨어로 불러오면 다양한 환경 설정이 가능하다(그림 5). ‘Training Configuration’ 패널에 제시된 각 설정 옵션은 학습 과정에서 데이터 처리, 특징 추출 및 모델링의 정확도에 영향을 미치며, 사용자는 프로젝트의 요구 사항에 따라 이를 조정할 수 있다. 특히 결과물의 품질에 중요한 영향을 미치는 주요 설정은 다음과 같다. 첫째, 각 이미지에서 추출할 최대 특징점의 수를 설정하는 ‘Max Features/Frame’ 옵션은 이미지의 주요 정보를 포함하며, 값이 높을수록 더 많은 3D 포인트가 생성된다[18]. 둘째, 이미지의 샘플링 정도를 결정하는 ‘Downsample Images’ 옵션은 합성 장면의 해상도를 고려하여 설정한다[18]. 마지막으로, ‘Max Splat Count’ 옵션은 이미지의 디테일에 직결되며, 디테일이 부족할 경우 해당 값을 증가시켜 고품질의 결과물을 얻을 수 있다[18].

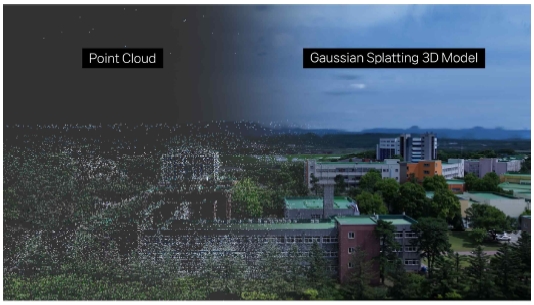

환경 설정 후, 공간 내에 여러 지점을 수집한 데이터를 기반으로 위치, 색상 등의 정보가 포함된 포인트 클라우드를 생성하고[8], 가우시안 스플래팅 과정에 따라 포인트들을 ‘가우시안 분포’라는 수학적 함수로 모델링하여(그림 6) 각 지점을 부드럽게 확장함으로써 기존의 불규칙하고 복잡한 데이터가 연속적인 표면으로 변환되고, 3D 배경의 형상이 명확하게 드러난다[8]. 한편, 원본 플레이트 영상의 3D 추적(3D Tracking)을 통해 위치 데이터 추출 후, 3D 배경에 적용하여 매치무브(Match-Move)를 수행한다. 그리고 3D 배경 데이터의 최적화를 위해 원본 플레이트 영상과 동일한 해상도 및 포맷으로 설정하여 이미지 시퀀스(Image Sequences)로 렌더링한다.

4-4 합성 및 아티팩트 제거

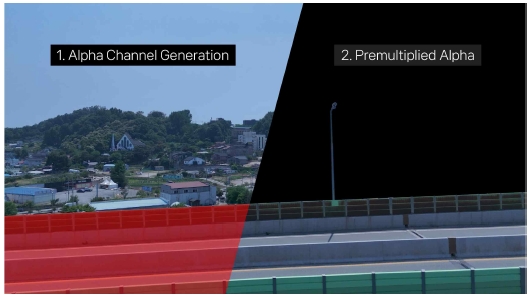

디지털 합성은 ‘노이즈가 제거된 원본 플레이트 영상’과 ‘노이즈 영상’으로 각각 분리하여 독립적으로 작업을 수행한다. 이에, 뺄셈(Minus) 연산 도구를 활용하여 다양한 숫자 값으로 구성된 ‘원본 플레이트 영상의 색상 데이터’에서 ‘노이즈가 제거된 영상의 색상 데이터’를 감산하여 노이즈 영상을 추출한다. 다음으로, 그림 7의 1번 항목 이미지와 같이 특정 영역에 알파 채널을 추가하기 위해 키잉 또는 로토스코핑 도구를 활용하여 고가 차도, 차량 등 작업 영역을 제외한 부분을 지정한다. 아울러, 작업 소요 시간 단축을 위해 각 오브젝트의 움직임에 맞추어 알파 영역이 함께 움직일 수 있도록 원본 플레이트 영상의 추적(Tracking) 및 매치무브 수행 후 작업을 진행할 수도 있다. 이후, ‘원본 플레이트 영상의 색상 데이터’와 ‘0’과 ‘1’ 사이에 있는 값으로 구성된 ‘알파 채널 데이터’를 곱하는 연산을 수행한다[1]. 결과적으로 그림 7의 2번 항목 이미지와 같이, 알파 채널 값이 ‘0’인 부분은 완전히 투명해지고, ‘1’인 부분은 원래 색상을 유지하며 배경이 합성될 수 있는 영역을 생성한다[1]. 또한, 레이어 기반 디지털 합성에서는 곱셈 연산을 직접 수행할 필요가 없으며, 알파 채널이 포함된 원본 플레이트 영상 레이어 항목 아래에 배경 레이어를 추가함으로써 병합 과정이 진행된다.

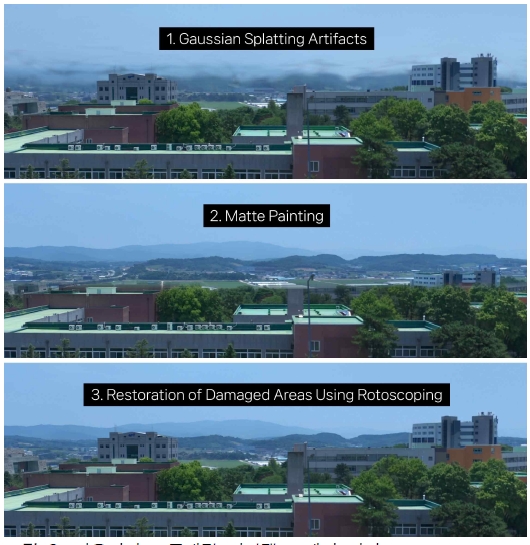

이후, 그림 8의 1번 항목 이미지와 같이 렌더링 된 배경에서 보이는, ‘가우시안 스플래팅 과정에서 생성된 아티팩트’ 제거 작업을 수행한다. 먼저, 실제 드론 촬영본의 특정 프레임을 고정한 후, 합성된 가우시안 스플래팅 배경의 위치와 최대한 일치하도록 조절하고, 그림 8의 2번 항목 이미지와 같이 아티팩트 부분을 마스킹(Masking)한다. 이후, 가우시안 스플래팅 배경의 움직임과 일치시키기 위한 ‘Match Move’ 작업을 진행한다. 이 작업은 카메라 기준, 원경으로 멀어질수록 시차 효과가 최소화됨으로써 2D 환경에서도 자연스럽게 표현될 수 있다. 다음으로, 로토스코핑을 통해 건물, 산, 나무 등 손상된 영역을 복원한다. 이후, 원본 플레이트를 기준으로 배경의 밝기, 색상 등을 조절하여 일관된 결과물을 얻기 위한 작업을 수행한다. 마지막으로, 이전에 제거한 원본 노이즈를 다시 추가하는 작업이 이루어진다. 이 과정에서 작업 영역에 해당하는 부분에는 기존 고가 차도 뒤의 모습이 남아있으므로 새로운 노이즈를 추가한 뒤, 해당 영역을 마스킹한다.

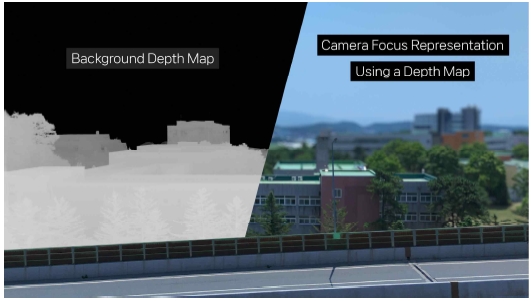

4-5 뎁스맵 활용 카메라 초점 표현

‘Depth Map’은 이미지나 영상의 픽셀(Pixel)과 카메라와의 거리를 나타내는 깊이 정보를 담고 있다[1]. 이를 통해 카메라 초점 표현이 가능하며, 다음과 같은 절차에 따라 작업을 진행한다. 우선, 채널 추가 도구를 사용하여 합성된 배경에 ‘Depth Channel’을 추가한다. 그리고 카메라의 심도 효과를 시뮬레이션하는 도구를 사용하여 예컨대 그림 9와 같이, 초점이 맞춰진 맨 앞의 건물은 선명하게 표현되며, 원경으로 멀어질수록 흐려지는 효과를 적용할 수 있다. 추가로, 초점이 맞지 않는 영역의 흐림 정도를 조절하는 작업을 수행한다. 또한, 기존의 카메라 초점 조절 도구를 활용하여 작업을 진행할 수도 있으나, 깊이 정보를 고려하지 않고 배경 전체 영역에 흐림 효과가 적용되므로, 초점 영역을 세분화하여 입체적으로 표현하기 어렵다. 결과적으로 깊이 정보 기반의 카메라 초점 조절은 복잡한 3D 장면을 다룰 때 유용하며, 기존의 초점 조절 도구보다 시각적 완성도가 향상될 수 있다.

Ⅴ. 연구 결과

각 행은 특정한 촬영 기법을 나타내고, 열은 타임라인에 따른 각 장면을 나타낸다(그림 10). 2D 환경에서 합성된 ‘Pedestal Shot’과 ‘Side to Side Tracking Shot’은 오브젝트의 외형 변화 없이 상하좌우로만 이동하며, ‘Dolly In Shot’은 카메라가 건물에 가까워지는 모습이 아닌 점차 확대되는 모습만을 보여준다. 그리고 ‘Arc Shot’은 2D 이미지의 평면적인 변화만을 보여주며, 결과적으로 공간 내의 각 오브젝트가 갖고 있는 입체감 표현이 어렵다. 따라서 더욱 개선된 표현 방법으로, 가우시안 스플래팅으로 구현된 3D 배경에서는 카메라 시차 효과에 따른 다양한 오브젝트의 외형 변화를 확인할 수 있다. ‘Pedestal Shot’과 ‘Dolly In Shot’은 시간의 흐름에 따라 주요 특징점인 건물의 옥상 영역이 점차 넓어지는 모습을 보여준다. 그리고 ‘Side to Side Tracking Shot’과 ‘Arc Shot’에서는 옥상의 외형 변화와 함께, 시간이 지남에 따라 각 건물 및 나무들의 시차가 발생한다.

Ⅵ. 결 론

본 연구에서는 디지털 배경 합성에서 가우시안 스플래팅을 활용한 카메라 시차 표현 방법을 제안했다. 여러 각도에서 촬영된 실사 배경 이미지들을 바탕으로 환경 및 오브젝트의 표면을 효율적으로 재구성하여, 카메라의 움직임에 따른 시차 효과를 고도화할 수 있음을 확인했다. 또한, 가우시안 스플래팅 과정에서 활용되는 깊이 정보[8]를 기반으로 하여 더욱 입체적인 카메라 초점 표현이 가능함을 확인했다. 아울러, 본 연구를 위해 다양한 소프트웨어를 활용하였다. 이에 따른 비효율성과 번거로움이 초래되었으며, 범용적으로 사용할 수 있는 소프트웨어나 플러그인 개발이 필요함을 인식하였다. 예컨대, 디지털 합성 소프트웨어 내에 가우시안 스플래팅 모델 뷰어 및 수정이 가능한 플러그인을 개발함으로써, 제작 기간, 품질적인 측면에서 더욱 개선된 3D 오브젝트 합성 파이프라인을 확립하는 데에 기여할 것이다. 이를 통해 소프트웨어 사용자들은 3D 배경 합성 과정에서 카메라 시차 효과를 더욱 직관적으로 구현할 수 있을 것이다.

아울러, 본 연구에서 제안한 방법에는 한계점이 존재한다. 첫째, 연구 결과에 따르면 동적인 장면을 구현하는 데 있어 기술적 제약이 있다. 따라서, ‘4D 가우시안 스플래팅’이나 ‘생성형 AI’ 등의 기술을 활용하여, 움직이는 오브젝트와 환경을 재구성하기 위한 방법론 연구가 필요하다. 둘째, 가우시안 스플래팅을 통해 생성된 3D 배경은 원본 플레이트 영상과의 시각적 일관성을 위해 추가적인 작업이 요구된다. 따라서, 디지털 합성에서 빛과 그림자의 방향을 일치시키기 위한 재조명(Re-lighting) 구현 방법이나, 색상 매칭(Color Matching) 작업의 효율적 수행 방안에 대한 추가 연구가 필요하다.

마지막으로 본 연구의 기대효과는 다음과 같다. 첫째, 가우시안 스플래팅은 복잡한 기하학 데이터를 메시 형태로 변환하는 것이 아닌, 각 포인트의 영향을 주변에 넓게 퍼트리는 방식이므로 실시간 렌더링에 유리한 기술이다. 따라서, 버추얼 스튜디오의 LED Wall을 활용한 실시간 합성에서도 현실 기반 배경과 함께 카메라의 움직임에 따른 시차 효과를 자연스럽게 구현할 수 있을 것으로 기대한다. 둘째, 가우시안 스플래팅 3D 모델을 라이브러리화한다면, 각 프로젝트에서 필요로 하는 3D 자원을 손쉽게 사용할 수 있는 환경이 마련될 것이다. 이에 따라, VFX 작업 소요 시간 및 비용 절감이 가능해질 것으로 기대한다. 결과적으로, VFX 산업 전반에 걸쳐 작업 효율성을 높이는 데 중요한 역할을 할 것이다.

Acknowledgments

본 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2024년 문화체육관광 연구개발사업으로 수행되었음(과제명 : 생성형 AI 및 클라우드 기반 콘텐츠 제작 R&D 인재 양성, 과제번호 : RS-2024-00352578 기여율 : 100%)

References

- S. Wright, Digital Compositing for Film and Video, 3rd ed., Burlington, MA: Focal Press, 2010.

-

T. Porter and T. Duff, “Compositing Digital Images,” ACM SIGGRAPH Computer Graphics, Vol. 18, No. 3, pp. 253-259, July 1984.

[https://doi.org/10.1145/964965.808606]

-

E. J. Gibson, J. J. Gibson, O. W. Smith, and H. Flock, “Motion Parallax as a Determinant of Perceived Depth,” Journal of Experimental Psychology, Vol. 58, No. 1, pp. 40-51, July 1959.

[https://doi.org/10.1037/h0043883]

-

G. Chen and W. Wang, “A Survey on 3D Gaussian Splatting,” arXiv:2401.03890v1, , January 2024.

[https://doi.org/10.48550/arXiv.2401.03890]

-

E.-K. Stathopoulou, M. Welponer, and F. Remondino, “Open-Source Image-Based 3D Reconstruction Pipelines: Review, Comparison and Evaluation,” The International Archives of the Photogrammetry, Remote Sensing and Spatial Information Sciences, Vol. XLII-2/W17, pp. 331-338, December 2019.

[https://doi.org/10.5194/isprs-archives-XLII-2-W17-331-2019]

-

W. Linder, Digital Photogrammetry: A Practical Course, 4th ed. Berlin, Germany: Springer, 2016.

[https://doi.org/10.1007/978-3-662-50463-5]

-

B. Mildenhall, P. P. Srinivasan, M. Tancik, J. T. Barron, R. Ramamoorthi, and R. Ng, “NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis,” in Proceedings of the 16th European Conference on Computer Vision (ECCV 2020), Glasgow, UK, pp. 405-421, August 2020.

[https://doi.org/10.1007/978-3-030-58452-8_24]

-

B. Kerbl, G. Kopanas, T. Leimkühler, and G. Drettakis, “3D Gaussian Splatting for Real-Time Radiance Field Rendering,” ACM Transactions on Graphics, Vol. 42, No. 4, 139, August 2023.

[https://doi.org/10.1145/3592433]

-

G. Wu, T. Yi, J. Fang, L. Xie, X. Zhang, W. Wei, ... and X. Wang, “4D Gaussian Splatting for Real-Time Dynamic Scene Rendering,” in Proceedings of 2024 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle: WA, pp. 20310-20320, June 2024.

[https://doi.org/10.1109/CVPR52733.2024.01920]

-

Y. Poirier-Ginter, A. Gauthier, J. Phillip, J.-F. Lalonde, and G. Drettakis, “A Diffusion Approach to Radiance Field Relighting Using Multi-Illumination Synthesis,” Computer Graphics Forum, Vol. 43, No. 4, e15147, July 2024.

[https://doi.org/10.1111/cgf.15147]

-

M. K. Chung, “Gaussian Kernel Smoothing,” arXiv:2007.09539, , July 2012.

[https://doi.org/10.48550/arXiv.2007.09539]

-

L. Assirati, N. R. Silva, L. Berton, A. A. Lopes, and O. M. Bruno, “Performing Edge Detection by Difference of Gaussians Using q-Gaussian Kernels,” Journal of Physics: Conference Series, Vol. 490, 012020, 2014.

[https://doi.org/10.1088/1742-6596/490/1/012020]

- A. Ostasheva, Digital Compositing in the VFX Pipeline, Bachelor’s Thesis, Tampere University of Applied Sciences, Tampere, Finland, May 2015.

- A. R. Smith, Alpha and the History of Digital Compositing, Microsoft Corporation, Redmond, WA, Technical Memo 7, August 1995.

-

R. Hamus-Vallée, “Le Matte Painting ou la Quête de l’Illusion Parfaite,” Hybrid, No. 2, 2015.

[https://doi.org/10.4000/hybrid.1228]

- M. Dempwolf Holm, The Structuring of a VFX Pipeline: The Structure, Reasoning and Choices, Bachelor’s Thesis, Luleå University of Technology, Skellefteå, Sweden, 2018.

- Jawset Visual Computing. Postshot User Guide / Capturing Guidelines [Internet]. Available: https://www.jawset.com/docs/d/Postshot+User+Guide/Capturing+Guidelines, .

- Jawset Visual Computing. Postshot User Guide / Training Configuration [Internet]. Available: https://www.jawset.com/docs/d/Postshot+User+Guide/Interface/Training+Configuration, .

저자소개

2021년:홍익대학교 조형대학 영상·애니메이션 전공(미술학사)

2021년~2023년: (주)아이오에프엑스 제작팀

2024년~현 재: 중앙대학교 첨단영상대학원 영상학과 석사과정

※관심분야:시각 효과(Visual Effect), 디지털 합성(Digital Compositing), 3차원 재구성(3D Reconstruction), 가우시안 스플래팅(Gaussian Splatting)

2002년:중앙대학교 기계설계학과 학사

2004년:중앙대학교 첨단영상대학원 컴퓨터 특수효과 영상 석사

2012년:중앙대학교 첨단영상대학원 예술공학 박사

2012년~2018년: 덱스터 스튜디오 디지털 휴먼 & VR 연구소장

2019년~현 재: 중앙대학교 예술공학대학 부교수

※관심분야:가상존재(Virtual Beings), 확장현실(eXtended Reality), 시각효과(VFX), 실감 미디어(Immersive Media)