공간형 실감콘텐츠를 위한 공간과 상호작용 기반 비주얼 가이드 설계 및 구현

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

공간형 콘텐츠를 위한 증강현실 기기의 성능이 우수해지고 있으나, 제한된 시야각으로 인한 사용자 경험 저하 문제를 여전히 갖고 있다. 이를 보완하기 위해 선행 연구를 통해 공간형 실감 콘텐츠를 위한 가이드를 조사 및 분류하였다. 이를 바탕으로 공간과 상호작용의 특성을 고려한 3가지 비주얼 가이드를 도출하였다. 도출된 가이드는 사용자의 객체 인지와 탐색을 목표로 한다. 단일 화살표 가이드는 화살표를 통한 직관적인 방향 지시, 라인 가이드는 점선을 이용한 명확한 위치 안내, 미니맵 가이드는 전체적인 공간 파악을 통한 사용자의 공간 이동과 객체 찾기를 돕는다. 이러한 가이드를 대표적인 공간형 단말기기인 홀로렌즈를 대상으로 공간형 콘텐츠에 구현 및 적용하였다. 제안한 가이드의 실제 적용을 통한 각 효과의 확인과 공간형 실감 콘텐츠의 사용자 경험을 향상 시키는 데 효과적일 것으로 사료된다. 공간형 실감 콘텐츠가 확대되고 있는 현시점에 본 연구를 통해 제안한 가이드 방식은 공간형 실감 콘텐츠의 효과적인 설계와 활용에 중요한 역할을 할 것으로 기대한다.

Abstract

Augmented Reality (AR) head-mounted display (HMD) devices are improving in performance, but still face user experience degradation due to limited field of view (FoV). To address this, previous studies were examined and classified to investigate guides for spatial immersive content. Based on this, three visual guides were derived, considering the characteristics of space and interaction. The derived guides aim to aid users' object perception and exploration. The single arrow guide provides intuitive directional instruction through arrows, the line guide offers clear location guidance using dotted lines, and the mini-map guide assists users in moving through space and finding objects by providing an overall spatial understanding. These guides were implemented and applied to spatial content targeting HoloLens, a representative spatial terminal device. It is expected that confirming the effects of each guide through practical application of the proposed guides will be effective in enhancing the user experience of spatial immersive content. At this point, where spatial immersive content is expanding, the guide methods proposed through this study are expected to play an important role in the effective design and utilization of spatial immersive content.

Keywords:

Spatial Computing, Spatial Cognitive, Augmented Reality, Immersive Content, Interaction키워드:

공간 컴퓨팅, 공간 인지, 증강현실, 실감 콘텐츠, 상호작용Ⅰ. 서 론

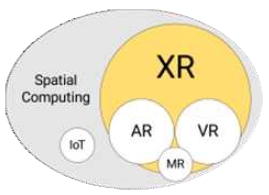

공간 컴퓨팅(Spatial computing) 기술은 착용형 확장현실(XR; extended reality) 기기의 발전과 더불어 가파르게 성장하고 있다. 대표적인 착용형 가상현실(VR; virtual reality) 기기인 메타(Meta) 사의 메타 퀘스트(Meta Quest (구 Oculus Quest)) 시리즈의 대중화와 애플(Apple) 사의 애플 비전 프로(Apple Vision Pro) 등 대형 IT 기업들의 확장현실 및 혼합현실(MR; mixed reality) 로의 진출이 확장되면서 공간 컴퓨팅 분야 연구와 콘텐츠산업이 활발해지고 있다. 가상현실 기기의 콘텐츠는 메타 스토어(Meta Store) 에서 제공하는[1] 엔터테인먼트 목적의[2] 다양한 콘텐츠 체험이 가능하지만[3-4], 증강현실의 엔터테인먼트의 활용[5]은 주로 모바일 환경에서 이루어지고 있다. 포켓몬 GO (Pokémon GO)는 증강현실을 활용한 엔터테인먼트용 콘텐츠로 게임 분야에서의 증강현실 활용의 성공적인 사례이다. 또한 스냅챗(Snapchat)과 인스타그램(Instagram), 틱톡(TikTok)과 같은 많은 SNS(Social Network Service)에서 증강현실 기술의 활용을 볼 수 있다. 사용자가 직접 만든 ‘필터’는 보정 등의 용도로 시작하여, 이후 얼굴 인식 기술과 증강현실 기술이 접목된 다양한 형태의 ‘뷰티 필터’, ‘애니메이션 필터’ 등으로 발전되었다[6]. 소셜 미디어의 필터 시장의 확장은 증강현실의 엔터테인먼트 분야의 활용을 잘 보여준다. 사용자들 간의 필터 공유와 전용 상점의 등장이 대표적인 사례로 들 수 있다.

하지만 앞서 분석하였듯, 현재 공간형 컴퓨팅을 위한 증강현실 기술은 모바일 콘텐츠 분야에서 한정적으로 활용되고 있다[7]. 모바일 증강현실은 평균 5~6인치 안의 평면 화면을 통해 콘텐츠를 경험해야 하며 이는 현실 공간과 실시간으로 상호작용을 할 수 있는 증강현실 기술의 제한적 경험이라 할 수 있다[8]. 착용형 디스플레이(HMD; head mounted display) 형태의 공간형 증강현실 기기는 모바일 환경에 비해 자유로운 두 손 조작으로 증강된 객체-사용자-공간 이 세 가지 요소 간의 용이한 상호작용이 가능하다. 대표적인 착용형 증강현실 기기로 마이크로소프트(Microsoft) 사의 홀로렌즈(HoloLens) 와 매직 리프(Magic Leap) 사의 매직 리프 시리즈가 있다. 이 두 기기 모두 실제 세계 위에 가상 정보를 덧씌우는 방식의 광학 투과형 방식(OST; optical see through) 을 통해 콘텐츠를 증강한다[9]. OST 방식의 HMD (OST-HMD; optical see through-head mounted display)는 가상현실 기기에서 빈번하게 사용되는 비디오 투과형(VST; video see through) 방식보다 현저히 좁은 시야각이라는 제약이 존재하는데, 이는 사람의 시야각보다 1/6 에 불과한 수준이다[10],[11]. 좁은 시야각으로 인한 제약은 사용자의 객체 인지력을 떨어뜨리며, 이는 결과적으로 사용자 경험에 부정적 요인으로 작용한다.

OST-HMD 기반 공간형 실감 콘텐츠에서 발생하는 사용자 경험의 부정적 요인을 보완하기 위해, 사용자의 객체 인지를 돕는 비주얼 가이드의 개발 및 적용이 요구된다. 이러한 비주얼 가이드는 제한된 시야각 내에서도 객체를 인지하고 원활한 상호작용을 할 수 있도록 돕는 역할을 한다. 그러나 효과적인 비주얼 가이드를 개발하기 위해 체계적인 접근이 필요하다.

본 연구에서는 선행 연구를 통해 가상 및 증강현실 환경에서의 객체 인지를 위한 시각 가이드 방법을 조사하였다. 이를 중심으로 대표적인 가이드 방식을 구분 및 도출하였으며, 이후 분류된 가이드 방식 중 대표적인 공간형 증강현실 단말인 홀로렌즈의 기술적 특성과 제약을 고려하여 가장 적합한 세 가지 비주얼 가이드를 선정하였다. 선정된 가이드로는 단일 화살표 가이드, 라인 가이드, 미니맵 가이드로, 각각의 특성을 반영하여 공간형 실감 콘텐츠에 적용한다.

위와 같은 과정으로 제안된 가이드들은 사용자의 객체 인지와 탐색을 돕는 것을 목표로 하였으며, 선행 연구를 통해 분류한 가이드의 특성에 맞게 설계하였다. 단일 화살표 가이드는 3차원 화살표를 통한 직관적인 방향 지시를 제공하여 사용자가 목표 객체의 위치를 신속히 파악하도록 돕는다. 화살표의 방향에 따라 사용자의 머리 회전을 통한 탐색을 독려하였다. 라인 가이드는 점선을 이용해 객체의 명확한 위치를 안내한다. 이 방식은 사용자의 현재 위치에서 목표 객체까지의 최단 경로를 시각화하여 제시한다. 미니맵 가이드는 전체적인 공간 파악을 통한 객체 찾기에 중점을 둔다. 사용자와 객체의 실시간 위치를 미니맵에 반영하여 사용자 자신 주변의 환경을 종합적으로 이해하는 데 도움을 준다.

본 연구의 구성은 다음과 같다. 제 Ⅱ장에서는 공간 컴퓨팅의 개념과 이와 연결된 증강현실 콘텐츠의 특징을 설명하고 선행 연구된 가상 및 증강현실 환경에서의 가이드 방법을 분석한다. 제 Ⅲ장에서는 선행 연구를 토대로 분류된 가이드 방식 중 현재 홀로렌즈로 구현할 수 있는 방식을 선정하고 구체적인 설계과정을 서술한다. 제 Ⅳ장에서는 개발된 비주얼 가이드를 기존의 콘텐츠에 적용하고 그 효과에 대한 내용을 서술한다. 마지막으로 제 Ⅴ장에서는 향후 연구와 함께 본 연구의 결론을 맺는다.

Ⅱ. 공간 컴퓨팅과 비주얼 가이드에 관한 선행연구

2-1 공간 컴퓨팅과 증강현실

공간 컴퓨팅(Spatial Computing)은 사용자를 둘러싼 바닥, 벽, 천장과 가구의 부피 및 위치와 같은 환경적 조건이 콘텐츠에 실시간으로 반영 및 상호작용을 하는 컴퓨팅 환경을 말한다. 공간 콘텐츠는 공간 컴퓨팅 개념을 반영한 콘텐츠로, 증강현실, 확장현실, 사물 인터넷(IoT; internet of things) 등 다양한 기술을 활용하여 구성 및 설계된다. 공간 컴퓨팅에 관한 선행 연구는 물리적인 환경과 디지털 환경의 실시간 상호작용을 중심으로 이루어졌다. 이 가운데, 증강현실은 공간 컴퓨팅 콘텐츠 설계에 사용되는 주요 기술 중 하나로, 물리적 환경 위에 가상 정보를 실시간으로 합성하여 밀접한 상호작용을 가능하게 하여 사용자에게 향상된 콘텐츠 경험을 제공하는 기술이다[12].

증강현실에 관한 연구는 평면 공간을 대상으로 시작하여 공간 컴퓨팅 개념의 도입과 함께 3차원 공간으로 확장되어 가고 있다[13]. 또한 증강현실은 전시 환경, 교육시설, 제조, 의료 등 다양한 분야에서 실질적으로 활용되기도 한다[14]. Hornacek 등은 산업현장에서 효율적인 작업을 위해 증강현실을 활용한 시스템을 제안하였다. 공장 바닥에 원하는 크기로 작업 지침을 증강하여 작업을 지시하는 이 시스템은 기존에 고정된 평면 모니터를 통한 작업 지시 방식보다 효율적인 작업 수행이 가능한 것을 확인할 수 있었다[15]. Rupprecht 등 또한 산업현장의 지원을 위해 증강현실 기술을 활용한 시스템을 개발하였다. 조립 작업 과정을 작업자와 실시간 상호작용으로 안내하는 시스템으로, 항공기 제작과 같이 높은 숙련도가 필요한 작업유형 또한 개개인의 역량과 상관없이 효과적으로 작업 지시를 전달할 수 있는 점을 도출하였다[16]. 한편, Hammady와 Ma는 박물관에서의 활용을 위한 시스템을 제안하였다. 박물관 내부의 다양한 장소에서 관람객과 실시간으로 상호작용이 가능한 프로토타입 가이드를 설계하여 공간 환경에서의 직관적인 제스처 설계의 중요성을 강조하기도 하였다[17].

공간형 컴퓨팅의 발달과 다양한 분야의 활용이 높아지고 있음에도 공간을 효과적으로 활용하고 공간 이동과 상호작용을 돕기 위한 연구가 매우 부족하다. 특히 현실 기반으로 한 공간형 혼합현실 단말기기는 상대적으로 시야각이 40° 이하로 개발되고 있어 시야에서 벗어나는 가상 객체와의 상호작용 및 인지가 매우 어렵다[18]. 더욱이 현실 공간에서 공간적 특성과 절차적 작업을 수행해야 하는 상황 등 공간 활용이 필요한 콘텐츠를 위해서는 공간과 객체를 고려한 효율적인 가이드 방식이 요구된다.

2-2 객체 인지와 비주얼 가이드

공간 컴퓨팅 기기의 제한된 시야각은 증강현실 기반의 공간 콘텐츠 경험 시, 제공된 콘텐츠를 인지하는 데에 장애요인으로 작용하며 이는 부정적인 사용자 경험을 초래한다. 기기적 한계로 인한 제약 요건을 보완하기 위해서 증강현실 기반의 공간 콘텐츠를 개발할 때는 증강된 객체의 인지를 돕는 비주얼 가이드 연구가 병행되어야 할 필요가 있다. 제한된 시야각을 보완하고 사용자의 객체 인지 향상을 위한 가이드 연구는 증강현실 분야와 함께 가상현실 분야에서도 활발하게 이루어졌다. Lu 등은 홀로렌즈를 사용하여 증강된 정보의 접근성을 높이기 위한 비주얼 가이드를 제안하였다. ‘화살표’, ‘Wedge’ 등 시각적 표식을 활용해 사용자의 주의를 객체로 유도하는 방식으로 사용자 실험을 통해 제안한 가이드가 증강현실 환경에서 정보 탐색을 효율적으로 돕는 것을 확인하였다[19]. 또한 Yamazaki 등은 가상현실의 슈팅 게임을 위한 가이드 방법을 제안했다. ‘Moving window’, ‘Rotation’, ‘3D Radar’라는 세 가지의 가이드 방법으로, 사용자 실험 결과 세 방식의 가이드 모두 목표 객체를 빠르고 정확하게 찾는 데 효율적인 것을 확인할 수 있었다[20]. 한편, Kim 등은 증강현실을 활용한 실내 내비게이션 시스템을 제안하며 높은 위치 인식 성공률을 확인하기도 하였다[21].

이처럼 선행 연구에서 제안한 객체 인지를 위한 비주얼 가이드는 데스크톱 기반의 3D 게임 속, 캐릭터의 행동을 유도하는 시각 가이드와 유사한 모습을 보인다. 표 3은 선행 연구에서 제안한 비주얼 가이드와 3D 게임에서의 가이드 방법을 특징에 따라 분류한 내용이다. 혼합현실에서 연구되고 있는 가이드는 단일 화살표 가이드 (Single Arrow Guides), 라인 가이드 (Line Guides), 미니맵 가이드 (Minimap Guides) 및 이동점 마커 가이드 (Waypoint Marker Guides) 로 구분해 볼 수 있다.

Ⅲ. 공간 컴퓨팅 경험을 위한 비주얼 가이드

3-1 공간 컴퓨팅에서의 상호작용 공간 개념

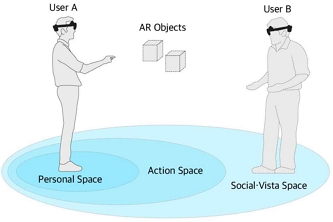

공간 컴퓨팅에서 실감형 콘텐츠를 위해 상호작용을 기준으로 공간을 구분하는 것은 중요하다. 이를 위해 제럴드의 공간개념을 활용한다[22]. 제럴드는 공간을 개인 공간 (Personal Space), 행동 공간 (Action Space), 전망 공간 (Vista Space) 로 구분하였다. 개인 공간은 팔을 뻗으면 닿을 수 있는 범위로, 이동하지 않아도 객체와의 거리가 가까워 직관적인 상호작용이 가능한 공간이다. 행동 공간은 2m부터 20m까지의 범위이며 적은 이동을 통해 객체와 상호작용이 가능한 공간이다. 그리고 전망 공간은 20m 이상의 범위로 즉각적인 상호작용이 불가능하거나 상호작용이 가능한 객체가 존재하지 않는 공간으로 분류한다(그림 2).

3-2 공간형 실감콘텐츠를 위한 비주얼 가이드 설계

공간 기반의 상호작용 개념을 바탕으로 한 공간형 실감 콘텐츠를 위한 비주얼 가이드를 표 3의 4가지 유형 중, 공간 컴퓨팅 단말기기의 특성을 고려하여 3가지로 선정하였다. 적합하지 않은 가이드로는 ‘Waypoint Marker Guides’로 목표물에 마커가 고정되어 안내하는 방식을 통해 목표물이 시야(데스크톱 환경에서는 모니터 화면) 밖으로 벗어나더라도 안내 마커는 화면의 가장자리에 유지되어 목표물을 지속해서 표시하는 방식의 가이드이다. 데스크톱 환경의 경우 스크린과 사용자의 눈동자 사이가 20cm 이상 떨어져 있어 전체 화면을 쉽게 파악할 수 있지만, OST-HMD의 경우 사용자의 시야를 덮는 방식으로 스크린을 투과하는 것과 좁은 시야각으로 인해 주변 시야를 통한 정보 전달 (객체 증강) 이 불가능한 상황이 발생한다. 따라서 본 연구에서 다루는 가이드에서 제외하였다. 이 결과 공간형 실감 콘텐츠를 위한 가이드는 단일 화살표 가이드, 라인 가이드, 미니맵 가이드로, 공간 컴퓨팅을 위한 비주얼 가이드로 구성된다.

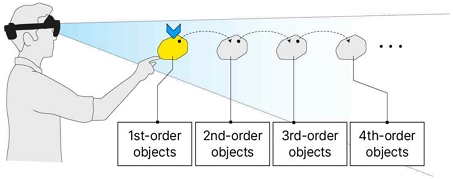

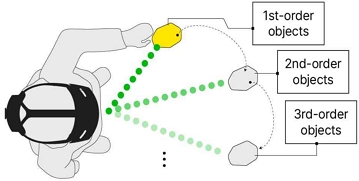

단일 화살표 가이드는 사용자의 시야 중앙에 있는 화살표가 목표 객체를 안내하는 방식의 비주얼 가이드이다. 콘텐츠 체험 과정에서 낯설고 복잡한 공간 탐색 시, 명확한 방향 지시가 중요한 점이 강조되는 방식이다[25]. 그림 3과 같이 시야 중앙의 화살표가 목표 객체를 가리키며 사용자의 시선을 유도한다. 목표 객체를 안내하는 화살표는 사용자의 머리 회전 각도와 목표 객체 간의 거리에 따라 동적으로 변화하는 특징을 가졌다. 목표 객체와 사용자의 거리가 20cm 이상 떨어져 있을 경우, 화살표의 위치는 사용자와 가깝게 그리고 큰 크기로 나타난다. 반면, 목표 객체와 사용자의 거리가 20cm 이하로 가까워질 때 화살표의 크기는 작게 줄어들며, 사용자보다 목표 객체에 가까이 위치하여 목표 객체를 명확히 가리킨다. 그림 4와 같이 단일 화살표 안내를 통해 사용자가 목표 객체를 발견하고 핸드 제스처로 객체와 상호 작용하게 되면 화살표는 다음 객체를 가리키며 모든 객체를 순차적으로 안내하는 과정을 가진다.

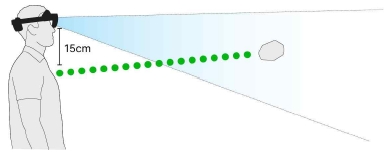

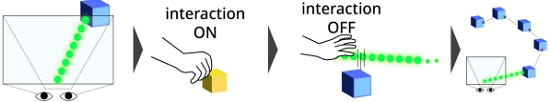

라인 가이드는 사용자와 객체 사이를 점선으로 연결하여 안내하는 방식의 비주얼 가이드이다. 선을 통한 가이드 방식은 경로 안내에서 명확성을 보여주며, 사용자의 공간 인식을 강화하는 데 도움을 준다[26]. 또한, 이동 경로를 통한 안내이므로 이동 중에 발생할 수 있는 물리적 장애물과의 충돌을 최소화할 수 있다는 장점이 존재한다[27]. 특히 라인 형태의 가이드 방식은 구조가 복잡한 실내 공간이나 넓은 장소에서 빠르게 목적지에 도달하는 경로 안내에 자주 활용되는 방식으로 유용하다.

그림 5, 6과 같이 사용자가 착용한 홀로렌즈로부터 15cm 하단에서 시작하는 초록색의 점선이 목표 객체와 이어져 위치를 안내한다. 사용자의 앞, 뒤 그리고 좌, 우의 이동과 상체를 낮추는 경우와 같은 상, 하의 변화에 따라 라인 가이드의 시작 지점을 실시간으로 반영한다는 특징이 있다. 또한, 라인의 시작 지점이 사용자 시선보다 하단으로 설정하여 주변 시야 (Peripheral Vision) 보다 중앙 시야 (Center Vision) 를 활용한 유도를 사용했다[28]. 이를 통해 라인 안내선에 대한 가시성을 높였으며 밝은 형광 녹색으로 표현하여 시선 유도를 유발하여 공간에서 이동을 안내한다.

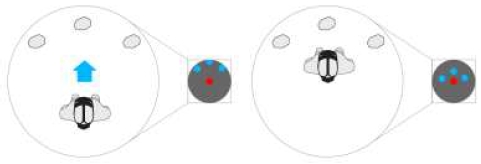

미니맵 가이드는 우측 하단의 미니맵이 사용자와 객체의 위치를 포괄적으로 명시하여 안내하는 방식이다. 미니맵 가이드는 3D 게임에서 캐릭터의 이동 안내를 위해 자주 사용되는 가이드 방식으로 기존의 디지털 내비게이션 시스템에 익숙한게이머들에게 적합하다는 특징이 있다[29]. 이 방식은 사용자에게 전체적인 공간 파악을 용이하게 하여 공간 내의 다양한 지점으로의 탐색을 유도하는 것에 효과적인 방식이다.

그림 7, 8과 같이 미니맵 안의 빨간색 점은 사용자를, 파란색 점은 객체를 가리킨다. 사용자의 위치는 미니맵의 중앙에 고정되어 나타나며 사용자의 이동에 미니맵 안의 객체 노출 범위가 갱신되면서 공간에서의 이동 가이드를 제공한다. 미니맵은 공간적 가시성을 높일 수 있도록 캐릭터와 같은 계층에 미니맵을 위치시키고, XR 기기의 가상 카메라와 객체 간의 거리를 주어 맵을 구성하였으며, 공간형 콘텐츠에서 보조적인 역할로 작동하기 위해 시야의 가장자리에 위치한다.

Ⅳ. 공간형 실감콘텐츠를 위한 가이드 적용

4-1 비주얼 가이드 적용 콘텐츠

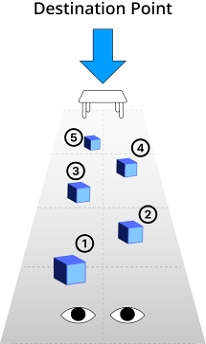

본 연구에서 제안하는 세 가지의 비주얼 가이드의 효과를 검증하기 위해 착용형 증강현실 기반 공간형 실감 콘텐츠인 AR 돌탑 콘텐츠에 적용하였다[30]. AR 돌탑 콘텐츠는 ‘돌 찾기’, ‘돌 잡기’, ‘돌 쌓기’ 순서로 체험이 진행되는데 ‘돌 찾기’와 ‘돌 쌓기’ 단계에서 신속한 AR 돌 객체를 탐색하는 과정에서 공간 가이드가 필요하다. AR 돌탑 콘텐츠에서는 주변 공간에 5개의 AR 돌이 놓여 있으며 ‘돌 찾기’와 ‘돌 쌓기’를 위한 탐색 과정에 사용자의 인지적 특성, 공간적 이동 특성을 파악할 수 있으며. 결과적으로 비주얼 가이드로 인한 사용자의 피로도를 경감하고 돌탑을 쌓는 것에 집중하는 데 도움을 주는지 확인할 수 있다.

제안한 비주얼 가이드는 가장 최근의 공간형 단말기기인 HoloLens 2를 대상으로 개발되었으며 Unity 2023.8f1 (LTS) 환경에서 MRTK 2 (Mixed Reality Toolkit 2)를 활용하여 개발되었다.

그림 9, 10, 11은 구현된 세 가지 가이드의 모습이다. 그림 9, 10과 같이 단일 화살표 가이드와 라인 가이드는 공통적으로 (좌) 목표 객체를 각각의 가이드가 안내하고, (우) 핸드 제스처를 통한 상호작용이 일어나면 객체의 색상이 노란색으로 변화하는 모습을 확인할 수 있다. 그림 9의 우측 이미지와 같이 객체를 놓게 되면 각 가이드는 다음 순서의 객체를 안내한다. 그림 11과 같이 미니맵 가이드의 경우 (좌) 정면의 미니맵과 객체의 위치를 비교하며 위치를 파악한다. (우) 미니맵에 표시된 위치의 근처로 접근하여 객체를 찾는 순서로 가이드가 제공된다.

4-2 비주얼 가이드 평가 계획

제 3장에서 설계 및 구현한 세 가지의 비주얼 가이드를 착용형 증강현실 기반 공간형 실감 콘텐츠인 돌탑 쌓기라는 과제를 주어 사용자 평가를 진행할 예정이다. 사용자의 과제 수행도를 객관적이고 수치화된 방식으로 평가하기 위한 정량적 측정에서 활용하는 측정 지표는 다음과 같다. 먼저 각 가이드에 대한 과제 완료 시간을 비교하여 가이드의 효율성과 사용자의 수행 향상도를 파악하고자 한다. 그리고 사용자의 이동 경로를 측정하여 가이드와 객체 배치의 차이가 이동 경로 변화에 미치는 영향을 비교하고자 한다. 추가로 사용자의 시선 데이터를 추적하여 목표 객체에 시선이 닿는 시간을 측정한다. 이를 통해 가이드별로 목표 객체의 시선 유도 효과를 비교하고, 사용자 개개인의 주관적 경험을 수집하고 가이드 체험의 심층적인 탐색을 위해 정성적 측정할 예정이다.

정량적인 측정뿐 외에 정성적인 특성으로 NASA-TLX, 가이드의 유용성 및 개인별 선호도 조사를 수행할 예정이다. 정신적 요구(Mental Demand), 신체적 요구(Physical Demand), 시간적 요구(Temporal Demand) 수행도(Performance), 노력(Effort), 좌절감(Frustration)의 6가지 하위 척도로 구성된 NASA-TLX (NASA Task Load Index)[31] 평가 항목을 활용하여 가이드 수행의 작업 부하(작업량)를 측정한다. 또한 각 가이드의 유용성(Usefulness), 사용 용이성(Ease of Use), 학습 용이성(Ease of Learning), 만족도(Satisfaction)를 측정하기 위해 USE 평가[32] 항목을 활용한다. 마지막으로 사용자 개개인의 선호도 조사를 통해 객관적 데이터에서 보여지는 효율성과 실질적 체험 과정을 통해 결정된 선호를 비교하여 다른 수치로 나타나게 하는 원인 요인을 파악할 예정이다(표 5).

Ⅴ. 결 론

본 연구는 공간형 실감 콘텐츠에 대한 공간적 경험 향상을 위한 비주얼 가이드를 제안하였다. 특히 OST-HMD 기반의 증강현실 기기의 제한된 시야각으로 인한 사용자 경험의 저하 문제를 보완하기 위해 단일 화살표 가이드, 라인 가이드, 미니맵 가이드를 도출하였다. 제안된 가이드들은 사용자의 객체 인지와 탐색을 돕는 것을 목표로 하였으며, 선생 연구를 통해 분류한 가이드의 특성에 맞게 설계하였다. 단일 화살표 가이드는 화살표를 통한 직관적인 방향 지시, 라인 가이드는 점선을 이용한 명확한 위치 안내, 미니맵 가이드는 전체적인 공간 파악을 통한 객체 찾기에 중점을 두었다. 도출된 비주얼 가이드는 대표적인 공간형 단말기기인 홀로렌즈를 대상으로 한 공간형 콘텐츠에 구현 및 적용하였다.

향후 사용자 평가를 통해 각 가이드의 효과를 정량적, 정성적으로 측정할 예정이다. 과제 완료 시간, 이동 경로, 시선 추적 데이터 등 객관적 지표와 작업량 측정, 사용성 평가, 선호도 조사 등 사용자의 주관적 경험을 종합적으로 분석할 계획이다. 또한 사용자 평가 결과를 바탕으로 각 가이드의 장단점을 분석하고, 이를 토대로 다양한 상황을 고려한 공간 컴퓨팅 경험을 위한 가이드 방식의 특성을 분석할 예정이다.

본 연구는 착용형 증강현실 기기의 제한된 시야각 문제가 공간 컴퓨팅 경험을 저해하는 요인임에 집중하여 실질적인 방안을 제시하였다는 점에서 의의가 있다. 제안한 비주얼 가이드는 사용자의 공간 인지와 객체 탐색 경험을 개선하여 공간 컴퓨팅 경험을 향상 시키는데 기여할 것으로 기대된다.

Acknowledgments

본 연구는 전남대학교 문화전문대학원 최인영의 석사논문(공간형 증강현실 콘텐츠를 위한 비주얼 가이드 구현 및 평가)을 바탕으로 작성되었음.

References

- Meta Store. Apps and Games. [Internet]. Available: https://www.meta.com/experiences/?utm_source=exp_hub_nav&utm_medium=self_referral, .

-

A. Chavan and S. Kakade, “Virtual Reality: Pioneering the Future of Immersive Experiences,” International Journal of Scientific Research in Engineering and Management, Vol. 8, No. 4, April 2024.

[https://doi.org/10.55041/ijsrem30286]

-

K. Stecuła, “Virtual Reality Applications Market Analysis—On the Example of Steam Digital Platform,” Informatics, Vol. 9, No. 4, 100, December 2022.

[https://doi.org/10.3390/informatics9040100]

-

T.-G. Kim and W.-S. Jang, “Analysis of Presence and Immersion Elements of VR Game,” Journal of the Korea Entertainment Industry Association, Vol. 13, No. 8, pp. 69-76, December 2019.

[https://doi.org/10.21184/jkeia.2019.12.13.8.69]

-

J.-H. Kim, “Analysis of Global Virtual, Augmented Reality Contents States,” Journal of Korea Game Society, Vol. 17, No. 4, pp. 7-15, August 2017.

[https://doi.org/10.7583/JKGS.2017.17.4.7]

-

J.-B. Kang and S.-W. Lee, “Visual Effects and Image Type Analysis of AR Based Selfie Applications,” The Korean Journal of Animation, Vol. 14, No. 3, pp. 153-167, September 2018.

[https://doi.org/10.51467/ASKO.2018.09.14.3.153]

-

C. Bermejo and P. Hui, “A Survey on Haptic Technologies for Mobile Augmented Reality,” ACM Computing Surveys, Vol. 54, No. 9, 184, December 2022.

[https://doi.org/10.1145/3465396]

-

T. Siriborvornratanakul, “Enhancing User Experiences of Mobile-Based Augmented Reality via Spatial Augmented Reality: Designs and Architectures of Projector-Camera Devices,” Advances in Multimedia, April 2018.

[https://doi.org/10.1155/2018/8194726]

- J.-H. Kim, H. Kim, and D. Jo, “Exploring Scale and Color Difference among MR Devices for Improved MR Experience,” in Proceedings of KCGS 2018, Yeosu, pp. 97-98, July 2018.

-

B. C. Kress and W. J. Cummings, “Optical Architecture of HoloLens Mixed Reality Headset,” in Proceedings of SPIE Digital Optical Technologies 2017, Munich, Germany, pp. 124-133, 26, June 2017.

[https://doi.org/10.1117/12.2270017]

-

L.-H. Lee, T. Braud, S. Hosio, and P. Hui, “Towards Augmented Reality Driven Human-City Interaction: Current Research on Mobile Headsets and Future Challenges,” ACM Computing Surveys, Vol. 54, No. 8, 165, November 2022.

[https://doi.org/10.1145/3467963]

- ResearchGate. Augmented Reality Theory and Applications [Internet]. Available: https://www.researchgate.net/profile/Mohd-Shahrizal-Sunar/publication/280722116_Advances_in_Computer_Graphics_and_Virtual_Environment_Vol_2/links/55c2cd0c08aebc967defe5ba/Advances-in-Computer-Graphics-and-Virtual-Environment-Vol-2.pdf#page=96, .

-

K. R. Curtis, “Unveiling Magic Leap 2’s Advanced AR Platform and Revolutionary Optics,” in Proceedings of SPIE AR, VR, MR Industry Talks 2022, San Francisco: CA, 119320P, January 2022.

[https://doi.org/10.1117/12.2632495]

-

H. Javaheri, J. Lehmann, K. Altmeyer, L. M. Müller, R. Brünken, and P. Lukowicz, “Design of Augmented Reality Based Environment to Promote Spatial Imagination for Mathematics Education in Elementary School,” in Proceedings of the 2022 ACM International Joint Conference on Pervasive and Ubiquitous Computing and the 2022 ACM International Symposium on Wearable Computers (UbiComp/ISWC ’22 Adjunct), Cambridge, UK, pp. 274-277, September 2022.

[https://doi.org/10.1145/3544793.3560380]

-

M. Hornacek, H. Küffner-McCauley, M. Trimmel, P. Rupprecht, and S. Schlund, “A Spatial AR System for Wide-Area Axis-Aligned Metric Augmentation of Planar Scenes,” CIRP Journal of Manufacturing Science and Technology, Vol. 37, pp. 219-226, May 2022.

[https://doi.org/10.1016/j.cirpj.2022.01.011]

-

P. Rupprecht, H. Kueffner-McCauley, M. Trimmel, and S. Schlund, “Adaptive Spatial Augmented Reality for Industrial Site Assembly,” Procedia CIRP, Vol. 104, pp. 405-410, 2021.

[https://doi.org/10.1016/j.procir.2021.11.068]

-

R. Hammady, M. Ma, and C. Strathearn, “User Experience Design for Mixed Reality: A Case Study of Hololens in Museum,” International Journal of Technology Marketing, Vol. 13, No. 3/4, pp. 354-375, 2019.

[https://doi.org/10.1504/IJTMKT.2019.104600]

-

L.-H. Lee, T. Braud, S. Hosio, and P. Hui, “Towards Augmented Reality Driven Human-City Interaction: Current Research on Mobile Headsets and Future Challenges,” ACM Computing Surveys, Vol. 54, No. 8, 165, November 2022.

[https://doi.org/10.1145/3467963]

-

F. Lu, S. Davari, L. Lisle, Y. Li, and D. A. Bowman, “Glanceable AR: Evaluating Information Access Methods for Head-Worn Augmented Reality,” in Proceedings of 2020 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Atlanta: GA, pp. 930-939, March 2020.

[https://doi.org/10.1109/VR46266.2020.00113]

-

Y. Yamazaki and S. Hasegawa, “Providing 3D Guidance and Improving the Music-Listening Experience in Virtual Reality Shooting Games Using Musical Vibrotactile Feedback,” in Proceedings of 2023 IEEE Conference Virtual Reality and 3D User Interfaces (VR), Shanghai, China, pp. 276-285, March 2023.

[https://doi.org/10.1109/VR55154.2023.00043]

-

J. Kim and H. Jun, “Vision-Based Location Positioning Using Augmented Reality for Indoor Navigation,” IEEE Transactions on Consumer Electronics, Vol. 54, No. 3, pp. 954-962, August 2008.

[https://doi.org/10.1109/TCE.2008.4637573]

- J. Jerald, The VR Book: Human-Centered Design for Virtual Reality, E. H. Go, trans. Seoul: Acorn Publishing, 2019.

-

H. Lynam, E. Folmer, and S. Dascalu, “HARIN: HoloLens Augmented Reality Indoor Navigation,” in Proceedings of the 9th International Conference on Applied Computing & Information Technology (ACIT ’22), Online, pp. 30-35, May 2022.

[https://doi.org/10.1145/3543895.3543938]

-

S. Freitag, B. Weyers, and T. W. Kuhlen, “Interactive Exploration Assistance for Immersive Virtual Environments Based on Object Visibility and Viewpoint Quality,” in Proceedings of 2018 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Tuebingen/Reutlingen, Germany, pp. 355-362, March 2018.

[https://doi.org/10.1109/VR.2018.8447553]

-

X. Wei, X. Shi, and L. Wang, “Label Guidance Based Object Locating in Virtual Reality,” in Proceedings of 2022 IEEE International Symposium on Mixed and Augmented Reality (ISMAR), Singapore, Singapore, pp. 441-449, October 2022.

[https://doi.org/10.1109/ISMAR55827.2022.00060]

- R. Tang, A Mixed Reality Solution for Indoor Navigation, Master’s Thesis, Vrije Universiteit Brussel, Ixelles, Belgium, 2018

-

P. Herbers and M. König, “Indoor Localization for Augmented Reality Devices Using BIM, Point Clouds, and Template Matching,” Applied Sciences, Vol. 9, No. 20, 4260, October 2019.

[https://doi.org/10.3390/app9204260]

-

X. Sun and A. Varshney, “Investigating Perception Time in the Far Peripheral Vision for Virtual and Augmented Reality,” in Proceedings of the 15th ACM Symposium on Applied Perception (SAP ’18), Vancouver, Canada, 13, August 2018.

[https://doi.org/10.1145/3225153.3225160]

-

B. Liu, L. Ding, S. Wang, and L. Meng, “Designing Mixed Reality-Based Indoor Navigation for User Studies,” KN - Journal of Cartography and Geographic Information, Vol. 72, No. 2, pp. 129-138, June 2022.

[https://doi.org/10.1007/s42489-022-00108-4]

-

I. Choi, H. Jeong, and C. Shin, “A Study on Wearable Augmented Reality-Based Experiential Content: Focusing on AR Stone Tower Content,” Smart Media Journal, Vol. 13, No. 4, pp. 114-123, April 2024.

[https://doi.org/10.30693/SMJ.2024.13.4.114]

- A. C. Trujillo, Evaluation of Electronic Formats of the NASA Task Load Index, NASA Langley Research Center, Hampton: VA, NASA/TM-2011-217166, August 2011.

- ResearchGate. Measuring Usability with the Use Questionnaire [Internet]. Available: https://www.researchgate.net/profile/Arnold-Lund/publication/230786746_Measuring_Usability_with_the_USE_Questionnaire/links/56e5a90e08ae98445c21561c/Measuring-Usability-with-the-USE-Questionnaire.pdf, .

저자소개

2020년:조선대학교 디자인공학과(학사)

2022년~2024년: 전남대학교 문화전문대학원 미디어콘텐츠•컬처테크전공(석사)

2024년~현 재: 전남대학교 문화학과 박사과정

※관심분야:AR, MR, 공간인지, 사용자 경험, 상호작용 등

2002년:부경대학교 제어계측공학과(학사)

2004년:Hiroshima University 로봇공학과(공학석사)

2009년:Osaka University 기계공학과(공학박사)

2010년~2013년: (주)삼성중공업 산업기술연구소 책임연구원

2014년~2019년: Osaka University 의학계연구과 부교수

2019년~현 재: 전남대학교 AI융합대학 인공지능학부 교수

※관심분야:헬스케어, 지능로봇, IoT시스템 등

2014년:광주과학기술원 정보통신공학과(공학석사)

2018년:광주과학기술원 전기전자컴퓨터공학부(공학박사)

2018년~2020년: 현대모비스 데이터사이언스팀 책임

2020년~현 재: 전남대학교 AI융합대학 인공지능학부 교수

※관심분야:컴퓨터비전, 딥러닝, 스마트팩토리 등

2004년:숭실대학교 컴퓨터학부(학사)

2006년:광주과학기술원 정보통신공학과(공학석사)

2010년:광주과학기술원 정보통신공학과(공학박사)

2010년~2012년: 카네기멜론대학 HCI Institute 박사후연구원

2013년~2018년: 한국전자기술연구원 VR/AR연구센터 책임연구원

2018년~2019년: 문화체육관광부/한국콘텐츠진흥원 문화기술PD

2019년~현 재: 전남대학교 문화전문대학원 미디어콘텐츠컬처테크전공 교수

2020년~현 재: 전남대학교 문화기술연구소장

※관심분야:AR/VR/XR, 문화기술, 인간-컴퓨터 상호작용 등