확장현실 환경에서 사실적인 아바타 생성을 위한 사용자의 컨트롤러와 팔꿈치 기반 조정 기법

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

최근 비전 프로의 출시로 인해 VR, AR, 공간컴퓨팅이 뜨거운 관심을 받고 있다. 이로 인해 많은 사용자가 VR 콘텐츠의 이용이 증가하는 추세이다. VR은 국내, 외 문화 콘텐츠, 산업, 건축, 제조, 의료, 게임 등, 다양한 분야에 적용되어 활용되고 있다. 이를 이용하기 위한 선행 조건이 존재하는 데 바로 가상의 아바타를 만들어 실제 사용자와 연동하는 작업이다. 실 사용자는 가상의 아바타가 되어 콘텐츠들을 이용한다. 이에 따라 실제 나 자신을 베이스로 한 가상의 아바타는 사용자의 가상 현실 몰입감을 높이는데 중요한 요소가 되었다. VR 솔루션을 이용함에 있어 가상의 아바타와 나 자신의 신체 사이즈와 최대한 유사한 아바타를 만드는 것은 솔루션의 이용에 있어 사용자에게 자연스러운 경험을 제공할 것이다. 또한 사용자가 느낄 수 있는 어색함을 최대한 줄이며 집중도를 최대한 높일 수 있을 것이다. 이를 위해 본 논문에서는 VR기기의 컨트롤러만으로 사용자와 가상의 아바타간의 팔꿈치를 최대한 비슷한 위치로 조정하는 방법을 제안하고자 한다.

Abstract

The recent release of Vision Pro has brought significant attention to virtual reality (VR), augmented reality (AR), and spatial computing, leading to a surge in VR content usage among many users. VR is being applied and utilized in various fields including cultural content, industry, architecture, manufacturing, healthcare, and gaming both domestically and internationally. A prerequisite for utilizing these technologies is creating virtual avatars that interact with real users. Users transform into virtual avatars, allowing them to interact directly with the content. Therefore, creating a virtual avatar based on the actual user has become a crucial factor in enhancing the user's immersion in VR. When using VR content, creating an avatar that closely matches the user's physical size provides a more natural experience for the user. This reduces any potential awkwardness and maximizes user concentration. Thus, this study proposes a method to adjust the elbow position between the user and the virtual avatar as closely as possible using only the VR device's controller.

Keywords:

Avatar, Size Adjustment, Virtual Reality, User, Elbow키워드:

아바타, 사이즈 조정, 가상현실, 사용자, 팔꿈치Ⅰ. 서 론

최근 애플의 비전 프로의 출시로 VR/AR에 대한 관심도가 높아졌으며 VR을 활용한 많은 솔루션들이 있다. 이런 솔루션들에는 산업 현장에서 쓸 수 있는 산업용 시뮬레이션 솔루션, VR 게임, 가상의 환경을 구성하는 Virtual Platform까지 다양하게 이용되고 있다. 이런 VR 솔루션에서 가장 중요한 것은 사용자에게 더욱 사실적인 몰입감을 주어 현실적인 경험을 제공하는 것이다. 특히 사용자들이 직접적으로 가상의 아바타가 되어 움직이고 객체와 상호작용을 한다면 사용자가 느끼는 몰입감은 굉장히 중요한 요소로 바뀐다. 몰입감에 따라 사용자의 집중도와 흥미도가 결정되기 때문이다[1].

사용자 몰입감을 높일 수 있는 방법에는 여러 가지가 있지만 본 연구에서 중점적으로 다룰 것은 가상 아바타의 크기이다. 실 사용자와 가상 아바타간의 신체 사이즈의 차이는 사용자의 몰입감을 높이는 데 매우 중요한 요소이며, 사용자의 멀미에도 영향을 미친다[2],[3]. VR 솔루션의 몰입감을 높이기 위해서는 사용자와 가상 아바타 간의 신체 조정이 필수적이다[4]. 가상 환경에서 팔을 뻗거나 굽힐 때 가상 아바타의 사이즈가 실제 사용자의 사이즈와 달라 현실과 다른 느낌을 주면 괴리감을 느끼게 된다. 이는 VR 솔루션의 몰입감을 떨어뜨리는 결과를 초래한다. 가상 아바타는 사용자가 직접 조작하고 상호작용하는 주요 객체로, 이를 통해 가상의 물체를 잡고, 조작하며, 다른 사람들과 다양한 신체적 표현과 제스처로 상호작용할 수 있다. 가상의 아바타와 사용자의 신체 사이즈를 조정하면 다양한 상호작용에서 몰입감을 높일 수 있다. 따라서, 본 연구에서는 VR 기기의 컨트롤러를 이용하여 사용자와 가상 아바타 간의 팔꿈치 위치를 정확히 조정하는 방법을 모색하고자 한다. 이 방법의 사용에 따라 사용자가 어떤 각도로 팔을 굽혀도 팔꿈치의 위치를 특정할 수 있게 구상하였으며, 이를 통해 VR의 아바타를 사용해야 하는 모든 솔루션에 적용하여 사용자의 몰입감을 높이고 VR 멀미를 줄이는 데 중요한 기초자료가 되길 바란다.

Ⅱ. 본 론

2-1 관련 기술 및 연구

실제 사용자와 가상의 캐릭터 간 크기를 조정하는 방법에는 여러 가지가 있다.

첫째, 사용자가 여러 센서를 몸에 부착하여 신체 사이즈를 측정하고 그 사이즈를 가상의 캐릭터와 매핑시키는 방법이 있다. 이 방법은 높은 정확도를 가지지만 시간과 비용이 많이 든다.

둘째, 현재 Meta Quest3와 Pro에 포함되어 있는 기능인 카메라로 사용자의 신체를 스캔하고 영상처리를 활용하여 사용자와 유사한 가상의 캐릭터를 생성하는 방법인 Body Traking이 있다[5]. 비슷한 방식으로 스캐너와 다수의 사진을 이용하여 3D 아바타 모델을 생성하는 방법과[6] 3D 스캐너 모바일 앱을 활용하여 제작하는 방법 또한 존재한다[7]. 그러나 이 방법은 개인의 프라이버시 문제와 두꺼운 옷을 입고 있을 때 정확한 신체 사이즈와 관절을 특정하기 어려운 문제가 있다.

셋째, 여러 가상 아바타 생성 도구를 활용하여 가상 아바타를 만드는 방법이 있다. 하지만 이 방법은 시간이 많이 소요된다.

넷째 컨트롤러를 사용하여 자신의 신체 사이즈를 측정하여 그 측정값을 토대로 가상의 아바타를 생성하는 방법이 있다[8]. 이는 간편하지만 그럼에도 시간이 들고 팔꿈치와 같은 관절은 측정하는 것이 불가능하다.

사용자들이 가상의 아바타를 커스터마이징을 통해 꾸미는 과정은 자기표현[9]으로 의미를 부여한다. 캐릭터 디자인이 사용자 경험과 게임의 인기에 긍정적인 영향을 미친다[10]. 이처럼 사용자는 캐릭터 커스터마이징에 많은 시간을 쏟을 이유가 충분하다 반면 VR 솔루션 상에서 실제 사용자의 사이즈에 맞게 조정하는 작업에는 많은 시간을 쓰는 것을 원치 않는다. 가상의 아바타와 사용자 간의 사이즈 조정 및 관절 특정 작업이 제대로 이루어지지 않으면 VR 솔루션의 몰입도가 떨어질 수 있으나, 이 과정이 길기 때문이다. 하지만 캐릭터의 사이즈 조정 작업은 VR멀미감에도 영향을 준다.

기존의 연구와 상용기술들의 가상 아바타 조정의 정확성은 높다. 다만 앞서 언급한 시간과 비용문제, 개인의 프라이버시 등의 문제들을 야기하기 때문에 쉽게 사용하기가 힘들다.

본 연구는 이러한 문제를 해결하기 위해, 실제 사용자의 팔꿈치 관절을 가상 캐릭터에 정확히 특정하는 방법을 고안하였다. 이 방법은 VR 기기의 컨트롤러를 사용하여 팔꿈치의 위치를 특정함으로써 사용자와 가상의 아바타 간의 사이즈 차이를 줄이고 몰입감을 높이는 것을 목표로 한다.

2-2 팔꿈치 IK 위치 특정을 위한 기하적 알고리즘

본 연구에서는 팔꿈치의 IK(역운동학)를 찾기 위한 기하학적 방법을 고안하였다. 아이디어의 출발은 직각삼각형에서 시작한다.

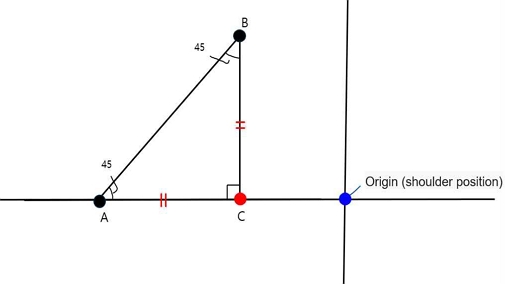

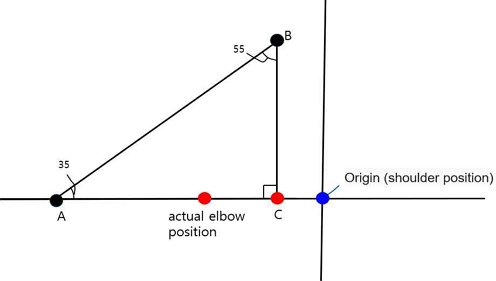

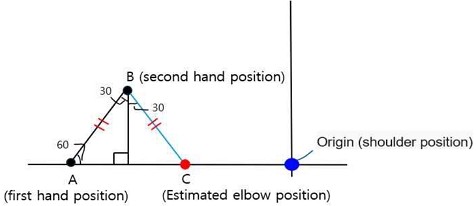

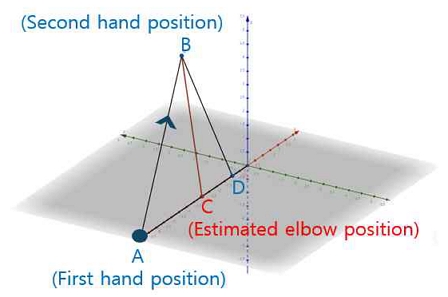

그림 1과 같이 사용자가 팔을 쭉 뻗은 컨트롤러의 A 지점과 팔을 L자로 만든 B 지점을 알면 A와 B가 만나는 직각삼각형에서의 지점 C가 팔꿈치의 위치라고 특정하는 아이디어에서 출발하였다. 이 아이디어는 팔꿈치의 위치를 특정 할 순 있었지만 언급한 특정한 상황에서만 동작한다. 사용자가 예외적인 상황, 예를 들어 팔을 L자가 아닌 안으로 굽히거나 혹은 바깥으로 펼친다면 팔꿈치의 위치 C가 잘못된 점을 가지게 되므로 그림 3과 같은 잘못된 팔꿈치의 위치를 찾는 문제가 생긴다.

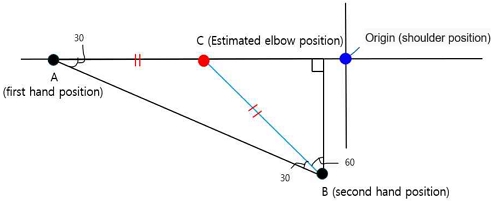

이 문제를 해결하기 위해 개선한 아이디어가 기하적 방법을 이용한 팔꿈치 위치 특정 알고리즘이다. 이 알고리즘은 AC와 BC의 거리는 팔꿈치부터 컨트롤러까지의 거리이기 때문에 같다고 가정한다. 따라서 각 A의 각도 값은 각 B의 각도 값과 같기 때문에 이등변 삼각형이 되며 각 ABC를 각 BAC와 같은 값으로 하면 사용자가 팔을 더 굽혀도, 덜 굽혀도 팔꿈치의 위치를 특정할 수 있다. 다음에서 이 알고리즘의 자세한 설계 내용을 설명한다.

2-3 알고리즘 설계

먼저 사용자가 팔을 길게 뻗은 상태에서 컨트롤러의 위치 값 A를 기록한다. 다음으로 팔을 굽혔을 때의 컨트롤러 위치 값 B를 기록한다.

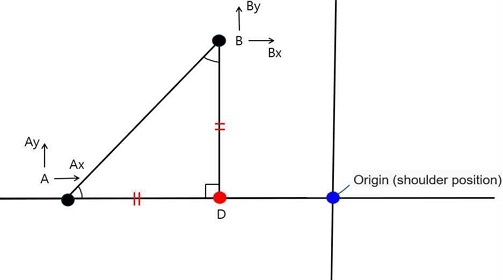

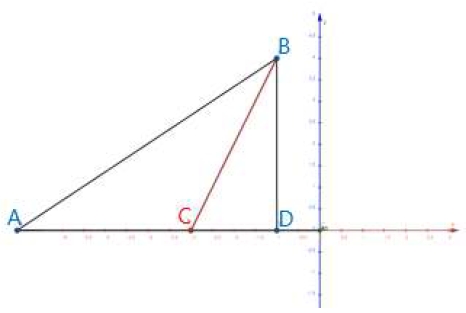

그림 3에서 점 A에서 Ax방향(어깨의 방향)으로 가상의 선을 긋는다. 그 후 점 B에서 -By방향으로 가상의 선을 긋는다. 점 A의 선과 점 B의 선이 만나는 지점을 D라고 가정한다. 연결된 삼각형 ABD는 점 D의 각도가 90인 직각삼각형을 이룬다. 여기서 가상의 점 C(팔꿈치의 위치)에서 A까지의 거리와 B까지의 거리는 같으므로

ΔABC는 인 이등변 삼각형이 되고 A의 각도와 B의 각도는 같다.

ΔABD에서 A의 각도는 물리엔진의 측정값으로 빠르게 도출할 수 있다. 각도는 나타낼 수 있으므로

점 B를 의 값만큼 회전을 시킨 후 회전시킨 점 B의 –By방향으로 가상의 선을 그어 Ax의 선과 만나는 지점이 점 C, 즉 팔꿈치의 위치라고 나타낼 수 있다.

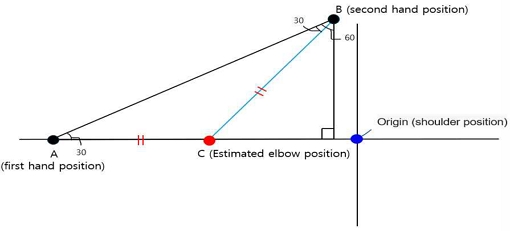

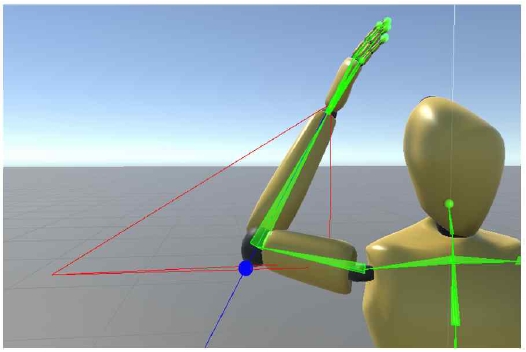

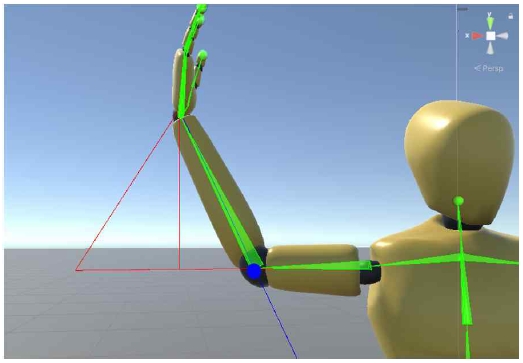

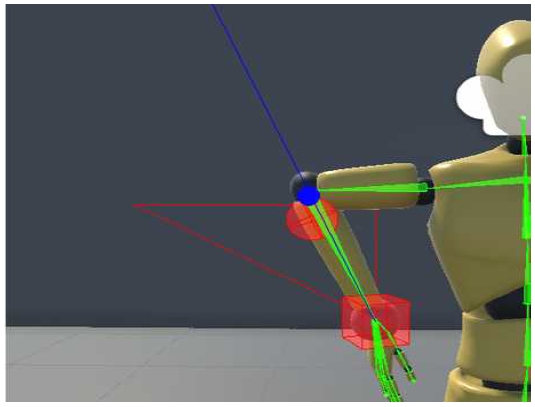

이 과정은 그림 4, 그림 5, 그림 6에 시각적으로 설명되어 있다.

또한 A의 각이 둔각이 되는 과정도 IK의 위치를 그림 5와 같이 특정할 수 있다.

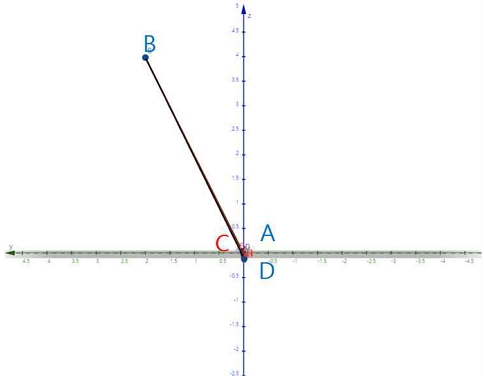

그림 4, 그림 5, 그림 6에서 두 번째 손의 위치를 어떤 방향으로 향해도 팔꿈치의 위치를 특정하는 가상의 선이 팔과 어깨의 방향을 항하기 때문에 사용자의 팔꿈치의 위치를 항상 특정할 수 있다. 위의 그림들은 3차원 공간상에서의 적용이 아닌 2차원 좌표계에서의 그림이다. 이를 3차원 공간상에서 적용한 모습은 그림 7에서부터 볼 수 있다.

그림 7, 그림 8, 그림 9처럼 점 B에서 -By 방향으로 내리는 가상의 선(Ray)을 X축의 방향(어깨와 팔의 방향) 으로 내리면 사용자가 두 번째 vertex를 어떤 지점을 지정하더라도 점 C(팔꿈치) 의 위치가 특정된다. 이러한 알고리즘을 통해 사용자가 팔꿈치 조정 작업 진행 시 의도치 못한 지점으로 팔을 굽히더라고 최대한 팔꿈치의 위치를 특정할 수 있는 방법으로 고안하였다.

Ⅲ. 구 현

3-1 장비 및 소프트웨어

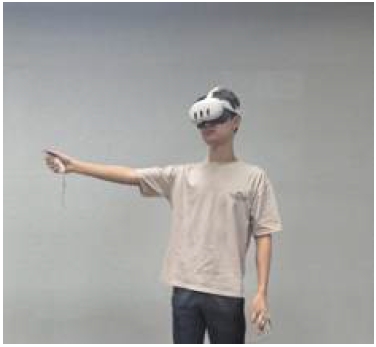

본 연구에서 사용된 장비 및 소프트웨어는 VR 디바이스중 가장 대중적으로 사용되는 Meta Quest3 를 사용하였으며 사용된 소프트웨어로는 게임엔진인 Unity를 사용하였다.

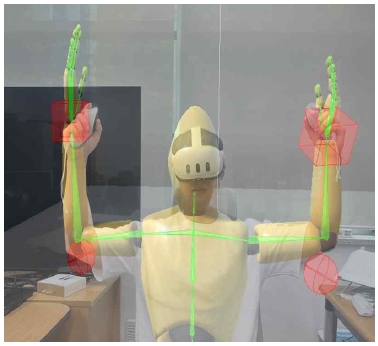

연구에 사용된 가상의 캐릭터와 배경은 Unity Asset Store에서 지원하는 무료 Asset을 이용하여 구현하였다(그림 10).

3-2 가상 환경 구축

사용자와 가상의 아바타간 행동 동기화를 하기 위해 Unity에서 제공하는 XR Interaction Toolkit 2.5.2[11]를 사용하였으며, Animation Rigging을 통해 가상 아바타의 IK와 FK[12], 다리 움직임 애니메이션을 구현하였다[13]. 또한 사용자의 움직임에 맞춰 움직이는 가상 아바타를 구현하기 위하여 Unity의 Animation Rigging을 사용하여 아바타에게 IK와 FK를 부여하여 동작의 자연스러움을 구현하였다[14].

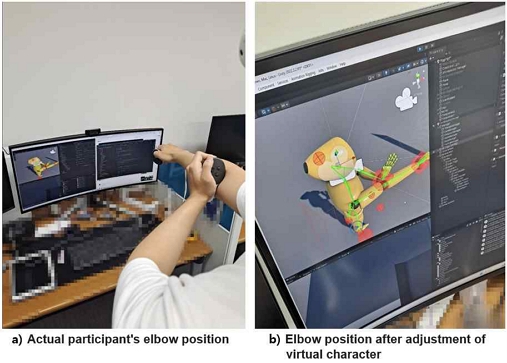

처음은 사용자가 팔을 쭉 뻗은 상태에서의 손(컨트롤러)의 위치를 특정한다. 그 후 팔을 굽혀 다음 사용자의 두 번째 손(컨트롤러)의 위치를 특정한다. 이 과정을 거치면 제안한 알고리즘을 적용할 수 있는 조건인 두 점을 찾았기 때문에 팔꿈치의 위치를 특정할 수 있다. 본 알고리즘을 활용하여 팔꿈치의 위치를 특정한다. 실제 Unity에서 아바타의 팔꿈치를 찾는 과정을 시각화 한다면 그림 11, 그림 12, 그림 13과 같다.

조정 작업이 끝난 후 앞의 포털을 타고 다음 가상 체험 공간으로 넘어간다. 체험 공간을 돌아다니며 가상 아바타와 사용자간의 팔을 움직이며 어느 정도의 괴리감이 느껴지는지 판단하기 위하여 알고리즘에 의해 도출된 팔꿈치의 위치부터 어깨까지의 거리값과 기존 아바타의 팔꿈치부터 어깨까지의 거리값을 비교하여 그 차이만큼 아바타의 팔 Scale값에 곱해주면 사이즈의 조정 작업이 완료된다.

Ⅳ. 실험 방법

본 연구에서는 가상공간 상의 1이 현실 길이의 1M 라는 가정을 세운 후 VR 경험이 있는 학부생 5인(남성 5명)을 대상으로 측정을 진행하였다. 결과를 도출하기 위하여 정규분포상 중앙 극한 정리(Cental Limit Theorem)에 따라 의미있는 결과를 얻기위한 충분히 큰 시도 횟수인 30번의 시도 후 나온 평균값으로 결과 분석을 진행하고자 한다.

제안한 알고리즘이 VR 사용자의 팔꿈치를 정확히 특정하는지 평가하기 위하여 처음 사용자는 오른쪽 팔의 팔꿈치를 조정하기 위해 왼쪽 컨트롤러를 이용하여 자신의 컨트롤러를 쥔 손과 어깨까지의 거리

| (1) |

를 측정한 후 팔꿈치와 어깨까지의 거리

| (2) |

를 측정한다. 그 후 제안한 알고리즘의 방식으로 오른 쪽 팔을 쭉 뻗은 상태에서 가상 공간상 사용자의 손과 가상 아바타의 리깅이 적용된 어깨 위치까지의 거리

| (3) |

를 측정하고, 팔을 굽힌 후 위치를 특정하여 알고리즘에 의해 도출된 팔꿈치의 위치

| (4) |

를 기록한다. 측정한 컨트롤러를 이용하여 측정한 팔의 길이와 Unity 공간상에서 측정한 아바타의 팔의 길이는 서로 다를 것이다. 이 간격을 맞춰주기 위하여 (3) - (1)을 하고, 여기서 나온 값을 (4)의 값에 빼준다. 이 값을

| (5) |

라고 할 때 (5) - (3)을 하면 현실에서 측정한 사용자의 팔꿈치부터 어깨까지의 거리와 Unity상에서 측정한 팔꿈치와 어깨까지의 거리의 오차 값이 도출된다. 표 1은 이 과정을 30번 반복한 후 나온 오차 값의 평균을 계산한 것이다. 이 평균으로 현실 사용자의 팔꿈치의 위치와 알고리즘으로 도출된 팔꿈치의 위치를 비교분석 할 수 있다.

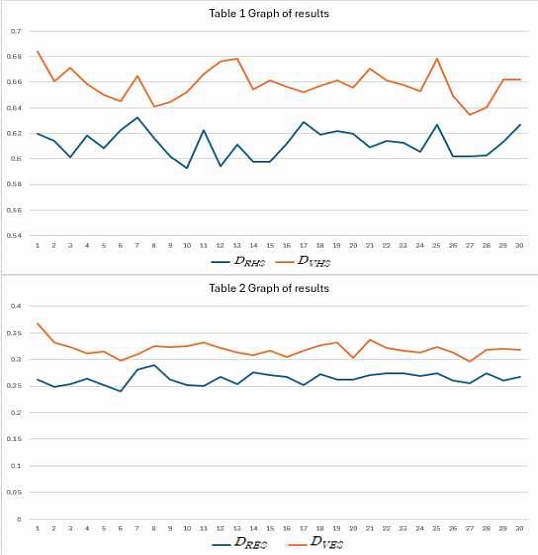

Distance from the user's hand to the shoulder in real life and distance from the hand to the shoulder in virtual space

측정한 5개의 데이터를 토대로 분석을 진행한 결과 오차율이 작게 나타난 것을 확인할 수 있었다. 5개의 측정 데이터 중 하나를 뽑아 표로 나타내면 표 1, 표 2와 같다.

The distance from the user's elbow to the shoulder in real life and the distance from the elbow to the shoulder in virtual space

위 그림 15를 보면 측정한 값 사이의 차이가 많이 나는 것을 확인할 수 있다.

V. 결 론

측정값 분석 결과 DRHS의 평균값은 0.612161, DVHS의 평균값은 0.65862, DRES의 평균값은 0.263756, DVES의 평균값은 0.319381의 결과값이 도출되었다. 이를 통해 현실에서 측정한 사용자의 팔꿈치부터 어깨까지의 거리와 Unity상에서 측정한 팔꿈치와 어깨까지의 거리의 값을 맞추기 위해 계산을 진행하였다.

| (6) |

| (7) |

| (8) |

결과적으로, 현실의 사용자가 측정한 팔꿈치와 어깨까지의 거리와 가상 공간상에서 알고리즘에 의해 특정된 팔꿈치와 어깨까지의 거리의 오차 값이 0.009166317 즉 0.9cm의 차이가 나는 것으로 나타났다. 이 오차는 컨트롤러의 위치 측정 지점의 정확성 문제를 포함할 수 있다. 이러한 점을 감안할 때, 0.9cm의 오차는 충분히 발생할 수 있는 값이라고 생각한다.

그러나 본 연구는 주관적인 측정 값을 기준으로 분석되었음을 인지해야한다. 실제 사용자의 팔길이 측정 값의 경우 Unity 게임엔진의 도움을 받아 거리의 값을 정확한 값을 도출하였으나 측정은 사람이 진행했다 라는 한계를 내포한다. 또한 본 연구에서 구현된 아바타 팔꿈치 조정은 알고리즘의 검증을 하기 위하여 개발 되었기에 다양한 VR 솔루션에 적용하여 정확한 조정 작업을 거치기 위해서는 추가적인 연구와 실험을 진행해야한다.

Ⅵ. 향후 연구 방향

본 연구에서는 VR 환경에서의 현실감있고 몰입감 있는 경험을 제공해주기 위하여 실제 사용자와 가상의 아바타간의 팔꿈치 관절을 조정해주는 기하적 알고리즘을 제안하였다. 정해진 로직에 따르지 않고 다양한 각도에서도 팔꿈치 관절의 위치를 특정 할 수 있도록 알고리즘을 고안하였으며, 이를 통해 보다 정확하게 팔꿈치 관절을 특정 할 수 있도록 하였다.

이 캐릭터 팔 관절 조정 알고리즘이 최근 가파르게 성장하는 XR 분야의 시장에서 가상의 아바타를 사용해야 하는 다양한 솔루션과 산업 솔루션에 적용되어 사용자의 몰입감을 높여줌과 동시에 사용자-아바타 간 사이즈 조절에 많은 시간과 비용을 할애할 일을 줄일 수 있을 것이라 기대하는 바이다.

추후 다양한 VR 콘텐츠 경험이 있는 다수의 사용자들을 모집하여 몰입감에 대해 실증을 할 것이고, 팔꿈치 관절 위치 검증과 정확도 평가를 위해 추가적인 센서를 통하여 실제 팔꿈치 위치를 특정하고 비교하여 또한 특정된 팔꿈치 위치와 실제 팔꿈치 위치 사이의 거리를 계산하여 오차를 측정하며 보다 범용적인 다양한 상황에서 적용 가능 하도록 개선하는 연구를 진행하고자 한다. 또한 본 연구에서의 제한을 고려하여, 실제 사용자와 캐릭터의 사이즈에 대한 보다 범용적인 상황에서 사용 가능한 종합적인 캐릭터 사이즈 조정 방법의 연구를 진행할 것이다.

Acknowledgments

본 연구는 중소벤처기업의 기술개발사업 지원에 의한 연구임[과제번호: RS-2022-00164806]

References

-

B. G. Witmer and M. J. Singer, “Measuring Presence in Virtual Environments: A Presence Questionnaire,” Presence, Vol. 7, No. 3, pp. 225-240, June 1998.

[https://doi.org/10.1162/105474698565686]

-

N. Döllinger, E. Wolf, D. Mal, S. Wenninger, M. Botsch, M. E. Latoschik, and C. Wienrich, “Resize Me! Exploring the User Experience of Embodied Realistic Modulatable Avatars for Body Image Intervention in Virtual Reality,” Frontiers in Virtual Reality, Vol. 3, 935449, October 2022.

[https://doi.org/10.3389/frvir.2022.935449]

-

P. Caserman, A. Garcia-Agundez, and S. Göbel. “A Survey of Full-Body Motion Reconstruction in Immersive Virtual Reality Applications,” IEEE Transactions on Visualization and Computer Graphics, Vol. 26, No. 10, pp. 3089-3108, October 2019.

[https://doi.org/10.1109/TVCG.2019.2912607]

- N. Berdic, D. Dragan, S. Mihic, and Z. Anisic, “Creation and Usage of 3D Full Body Avatars,” Annals of the Faculty of Engineering Hunedoara, Vol. 15, No. 1, pp. 29-34, February 2017.

- VRelity. BIG Quest 3 Update Brings Full Body Tracking & VRLegs! [Internet]. Available: https://www.youtube.com/watch?v=8ymIchKMBDs&t=350s

-

R. Fribourg, F. Argelaguet, L. Hoyet, and A. Lécuyer, “Studying the Sense of Embodiment in VR Shared Experiences,” in Proceedings of 2018 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Germany: Reutlingen, pp. 273-280, March 2018.

[https://doi.org/10.1109/VR.2018.8448293]

-

L.-G. Lee, “A Study on Metahuman Avatar Production Technique Using 3D Scanner Mobile App,” Journal of Digital Contents Society, Vol. 24, No. 2, pp. 379-384, February 2023.

[https://doi.org/10.9728/dcs.2023.24.2.379]

-

S. Pujades, B. Mohler, A. Thaler, J. Tesch, N. Mahmood, N. Hesse, ... and M. J. Black, “The Virtual Caliper: Rapid Creation of Metrically Accurate Avatars from 3D Measurements,” in Proceedings of IEEE Transactions on Visualization and Computer Graphics, Vol. 25, No. 5, pp. 1887-1897, May 2019.

[https://doi.org/10.1109/TVCG.2019.2898748]

-

L. O’Brien and J. Murnane, “An Investigation into How Avatar Appearance Can Affect Interactions in a Virtual World,” International Journal of Social and Humanistic Computing, Vol. 1, No. 2, pp.192-202, January 2009.

[https://doi.org/10.1504/IJSHC.2009.031007]

- M.-Y. Kim, “The Study of People Character Design Shown in Domestic Online Game,” Illustration Forum, Vol. 7, No. 13, pp. 71-94, January 2006.

- Unity Documentation. XR Interaction Toolkit-Unity Manual [Internet]. Available:https://docs.unity3d.com/kr/2019.4/Manual/com.unity.xr.interaction.toolkit.html

- Unity. Animation Rigging-Unity Manual [Internet]. Available: https://docs.unity3d.com/kr/Packages/com.unity.animation.rigging@0.2/manual/index.html

- Unity. Creating Procedural Walk Movement | Prototype Series [Internet]. Available: https://www.youtube.com/watch/acMK93A-FSY

- (Unity) - Character Animation Rigging 1, Hand IK Settings [Internet]. Available: https://www.youtube.com/watch?v=er9BNPrZTGE&t=1490s

저자소개

2020년~현 재: 금오공과대학교 컴퓨터소프트웨어공학과 학부과정

※관심분야:메타버스(Metaverse), 디지털 트윈(Digital Twin), 디지털 휴먼(Digital Human) 등

2022년~현 재: 금오공과대학교 컴퓨터소프트웨어공학과 학부과정

※관심분야:메타버스(Metaverse), 확장현실(Extended Reality), 인간컴퓨터상호작용(Human Computer Interaction) 등

2009년:한국과학기술원 대학원 (공학석사)

2014년:서울대학교 대학원 (이학박사)

2008년~2008년: 한국전자통신연구원(ETRI)

2014년~2018년: University of Pittsburgh(미국)

2019년~2023년: 한국생산기술연구원(KITECH)

2024년~현 재: 국립금오공과대학교 컴퓨터소프트웨어공학과 교수

※관심분야:패턴인식(Pattern Recognition), 인공지능(Artificial Intelligence), 영상처리(Image Processing) 등

2012년:고려대학교 (공학사)

2018년:고려대학교 대학원 (공학박사)

2018년~2019년: 고려대학교

2019년~2023년: 한국전자기술연구원(KETI)

2024년~현 재: 국립금오공과대학교 컴퓨터소프트웨어공학과 교수

※관심분야:확장현실(Extended Reality), 메타버스(Metaverse), 인간컴퓨터상호작용(Human Computer Interaction) 등