설명인터페이스(XUI)를 활용한 업무용 XAI 챗봇의 효과성 연구: 사용자의 마음 지각, 서비스 흥미, 직무 효능감을 중심으로

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 업무 환경에서 설명가능한 인공지능(XAI)을 활용한 챗봇이 사용자의 직무 효능감에 미치는 영향을 설명인터페이스(XUI)의 역할과 효과성을 중심으로 검증한다. XUI 원칙을 적용한 XAI 기반 챗봇과 전통적인 AI 챗봇의 효과를 비교한 결과, XAI 챗봇이 AI 챗봇에 비해 마음 지각, 서비스 흥미, 직무 효능감 등 주요 변수에서 유의미하게 높은 성과를 보였다. 특히, XAI 챗봇 그룹에서는 마음 지각과 직무 효능감 간의 서비스 흥미의 매개 역할이 유의미하게 나타났으며, 이러한 결과는 XAI 챗봇 그룹에서만 관찰되었다. 연구의 결과는 AI 시스템의 투명성과 설명 가능성이 사용자 만족도와 성과 향상에 중요함을 나타내며, 업무 환경에서 XAI를 실용적으로 구현할 수 있는 인터페이스 디자인에 유용한 통찰을 제공한다.

Abstract

This study investigates the impact of chatbots utilizing eXplainable Artificial Intelligence (XAI) on job efficacy within workplace environments, with a particular focus on the role and effectiveness of eXtensible User Interfaces (XUIs). In comparing XAI-based chatbots, which adhere to XUI principles, with traditional AI chatbots, XAI chatbots significantly outperformed their traditional counterparts in key metrics such as perceived understanding, service interest, and job efficacy. Notably, in the XAI chatbot group, service interest was a significant mediator between perceived understanding and job efficacy, a relationship not observed in the AI chatbot group. These findings highlight the importance of transparency and explainability in AI systems for enhancing user satisfaction and performance. The insights provided by this study are valuable for the practical implementation of XAI in workplace settings.

Keywords:

Explainable AI, Extensible User Interfaces, Job Efficacy, Mind Perception, Service Interest키워드:

설명 가능한 인공지능, 설명인터페이스, 직무 효능감, 마음 지각, 서비스 흥미Ⅰ. 서 론

생성형 인공지능(Gen AI; Generative AI)의 등장으로 그동안 인간의 고유한 영역이라고 알려져 왔던 지능과 기술의 경계가 흐릿해지고 있다. 향후 2~10년간 혁신적 이점을 제공할 잠재력을 가진 기술을 평가하는 가트너의 2023년 Hype Cycle for Emerging Technologies 보고서에 따르면 생성형 인공지능이 앞으로 전 세계 경제 생산성에 연간 최대 4조 4천억 달러의 가치를 더할 것으로 보인다. 이는 전체 60~70%의 업무를 자동화할 수 있는 영향력으로, 향후 근로자를 위해 인공지능 기술을 활용한 새로운 비즈니스 프로세스의 개발과 재검토가 필요하다는 것을 시사한다. 이러한 흐름에 따라 다양한 산업 분야에서 생성형 AI를 개인의 생산 능력을 향상하기 위한 도구로 받아들이는 접근이 중요해지고 있다. AI와 인간의 지능 중 1개를 선택하기보다 AI를 인간의 지능을 강화하는 수단으로 바라보는 관점이 강조되고 있다[1]. 이처럼 AI의 효과성이 입증되며 업무상의 비용 절감 및 격차 최소화 등의 장점이 강조되었다. 하지만 자율성의 한계와 알고리즘 편향성으로 인한 오류 등의 부작용이 문제점으로 떠오르기 시작했다[2]. 이를 해결하기 위해 2019년 경제협력개발기구(OECD ; Organisation for Economic Co- operation and Development)는 인공지능원칙을 발표하며 사용자가 인공지능의 결정을 이해할 수 있도록 투명하고 공개적인 설명을 제공하는 ‘투명성과 설명 가능성’의 원칙을 강조한 바 있다.

이에 따라 설명 가능한 인공지능(XAI ; Explainable AI)의 연구 필요성이 나타나며 사용자에게 결정 과정과 오류 원인 등을 근거로 제시하여 합리적인 의사결정 지원 방법을 모색하고 있다. 관련 연구에서는 XAI가 사용자의 신뢰성과 만족감을 향상한다는 것이 입증되고 있는데, 구체적인 연구 방향을 살펴보면 크게 ‘설명 모델(Explainable Model) 생성’과 ‘설명인터페이스(XUI ; Explainable User Interface)’로 나뉜다[3]. 하지만 국내 연구에서는 설명 모델의 개발에 비해 XUI의 개발에 관한 연구는 미미한 실정이다.

따라서 본 연구에서는 HCI의 관점에서 사용자 인터페이스 개발이 기술의 상용화 과정에서 중요하다는 점을 고려하여[4] XUI 디자인 원칙 및 활용 방안에 대해 실증적으로 분석하고자 한다. 특히 업무 환경에서 XAI의 효과성을 높일 수 있는 챗봇 서비스에서의 활용 방안을 검증하고자 한다. XAI분야에서 사용자와의 상호작용이 중요해지면서 협업을 위한 대화형 인터페이스의 중요성이 커지고 있기 때문이다. 실제 협업 컴퓨터 모델의 상호작용 품질을 개선하기 위해 XAI의 접근 방식을 제시하는 과정에서 감정, 효과성, 명시성 등의 인터페이스 규칙을 적용할 때 사용자 경험에 긍정적인 영향을 준다는 것을 밝힌 바 있다[5]. 또한 XUI를 활용하여 인간과 인공지능의 상호작용이 촉진되고, 사용자가 인공지능의 동작을 더 잘 이해하고 통제할 수 있을 때 기술에 대한 신뢰도가 높아진다는 것을 알 수 있다[6].

비즈니스 환경에서 XUI를 활용한 서비스가 인공지능 결정 과정에서 사용자들이 통찰력을 얻고 정보에 근거한 의사결정을 내릴 수 있다는 기존 연구에 따라[7], 본 연구에서는 XUI을 활용한 업무지원 챗봇이 기존 챗봇 대비 업무 환경에서의 성과를 향상할 수 있는지 확인해보고자 한다. 특히 업무 성과 향상의 주요 변인으로 알려진 사용자의 직무 효능감과 관련된 심리적 요인인 마음 지각과 서비스 흥미의 관계를 분석하고자 한다. 이러한 연구 목적에 따라 다음과 같은 연구가설을 설정하였다. 설정한 가설의 검증을 통해 업무용 XAI 챗봇의 효과성을 구조적으로 확인할 뿐만 아니라 구체적인 XUI 적용 방안을 제안하며, 기업의 AI 도입이 활성화되고 있는 시점에 활용성 높은 기초자료를 제공할 수 있을 것이다.

연구가설 1. 업무지원 인공지능 챗봇(AI/XAI)에 대한 사용자의 마음 지각과 서비스 흥미 수준이 높아지면 직무 효능감이 향상될 것이다.

연구가설 2. 업무 환경에서 XUI를 활용한 XAI 챗봇은 기본 AI 챗봇보다 사용자의 직무 효능감에 영향을 주는 마음 지각과 서비스 흥미 수준이 높게 나타날 것이다.

연구가설 3. 업무지원 인공지능 챗봇(AI/XAI)과의 업무 수행 경험에서 느끼는 마음 지각은 서비스 흥미를 매개하여 직무 효능감에 정적인 영향을 미치며, 가설 1에 따라 각 챗봇의 유형에 따라 매개 수준에 차이가 나타날 것이다.

Ⅱ. 이론적 배경

2-1 설명 가능한 인공지능(XAI)과 설명인터페이스(XUI)

설명 가능한 인공지능이란 인간이 아닌 인공지능이 설명을 도출하며, 사용자가 AI의 동작과 최종 결과를 올바르게 이해하고 해석할 수 있도록 알고리즘 결과물의 생성 과정을 설명하는 기술을 의미한다[8]. 이러한 XAI의 설계 방식을 살펴보면 크게 사후 설명(post-hoc explanation) 디자인과 투명한(Transparent) 디자인으로 나눠볼 수 있다[9]. 사후 설명 디자인은 알고리즘의 작동 이유를 설명하는 기술로서 블랙박스와 같은 복잡한 딥러닝에서 중요하게 사용된다. 복잡한 인공지능의 내부적인 논리를 이해하지 않더라도 이유를 제시할 수 있다는 점에서 활용성이 높으며 실제 비즈니스 환경에서 투명성을 요구하는 머신러닝을 구축하는데 활용될 수 있다[10]. 투명한(Transparent) 디자인은 인공지능이 내부적으로 어떻게 작동했는지를 설명하는 방법으로, 사용자가 모델의 구조와 알고리즘에 쉽게 접근하고 이해할 수 있도록 공개한다. 이는 모델 안의 요인을 직접 분석할 수 있다는 장점이 있지만, 개발 과정이 복잡하여 개발 시간과 비용이 증가하고, 과도하게 최적화된 모델로 일반화 능력이 저하될 수 있다는 문제점이 존재한다[11].

비즈니스 환경에서 자주 활용되는 대화형 인공지능에는 사후 설명 디자인이 더 적합할 수 있는데, 사용자 대화에서 요구되는 응답이나 추천의 근거 등을 실시간으로 설명에 추가할 수 있는 유연성이 있기 때문이다. 이러한 사후 설명 디자인의 유연성은 업무 환경에서 사용자 경험을 개선하는데 크게 기여할 수 있다고 밝혀진 바 있다[12]. 따라서 본 연구에서는 자연어, 시각화 등을 사용하는 대화형 인터페이스에 적합한 사후 설명 접근 방식을 활용하고자 하였으며 업무 환경의 특수성을 고려하여 다양한 사용자 집단의 경험을 고려한 구체적인 설명인터페이스(XUI)의 디자인 원칙을 설정하고자 하였다.

이때 XAI의 인터페이스를 의미하는 XUI는 다양한 산업 내의 주 요구사항인 시스템의 투명성과 책임성을 충족시키며 사용자가 더 나은 결정을 내릴 수 있도록 돕는 역할을 한다. 단순한 정보전달뿐 아니라, 분석 결과의 설득력과 효율성 등을 통해 만족도를 높여 사용자 경험을 최적화하는 데 효과적이다[8]. 특히 의료와 금융, 법률 시스템 등 중요한 의사결정을 돕는 서비스 도메인에서 활용되며 주목받고 있다.

XUI를 디자인할 때 고려하는 사용자 경험은 ‘보편적 사용자 경험 수준’, ‘우수한 설명 도구 수준’, ‘고유한 XAI 사용자 경험 수준’으로 나눠볼 수 있는데[8], Chromik과 Butz은 XUI가 인간 중심의 상호작용을 촉진하는 데 중점을 두어야 한다고 주장하며 위 수준을 고려한 주요 4가지의 설계 원칙을 설명한 바 있다[13]. 각 원칙은 다양한 사용자그룹의 요구를 어떻게 충족시킬지를 고려하여 인간중심의 접근 방식을 강조하였고, 상호작용성과 이해 가능성 측면에서 높은 활용도를 보인다는 평가를 받는다[14]. 따라서 본 설계 원칙을 검증했던 Lei의 의견에 따라 자연스러움 원칙에 대한 정의를 ‘자연어 사용을 통한 논리적이고 정확한 설명 제공’으로 수정하여 활용하고자 한다[8]. 본 연구에서는 적용하고자 하는 XUI의 디자인 원칙은 자연스러움(Naturalness), 반응성(Responsiveness), 유연성(Flexibility), 민감성(Sensitivity)이며, 각 정의는 표 1과 같다.

2-2 마음 지각과 서비스 흥미의 관계

마음 지각은 실제로 관찰할 수 없는 타인의 상태와 마음에 대한 예측적인 평가로서, 타인의 행동을 이해하기 위해 정신론적 설명을 활용하는 인간의 특성을 반영해 외부적인 단서와 지각자의 경험으로 작동하는 시뮬레이션이라고 볼 수 있다. AI에 대한 마음 지각 개념은 로봇의 사회적인 기능이 인공지능의 효능을 높이는 데 주요한 영향을 준다는 것이 밝혀지며 관심을 받게 되었다[15]. 마음 지각은 실제로 타인의 감정, 인지, 의도를 예측하는 능력으로 의사소통과 대인관계, 협업에 긍정적인 영향을 주는 것으로 알려져 있다[16]. 특히 근로 환경에서 조직 구성원이 AI의 상태를 어떻게 인지하고 해석하는가는 업무 수행의 성과에 많은 영향을 미치는데, 사람들은 기존의 인지과정에 따라 AI에 인간적 특성을 부여하고 사회적인 관습을 따르기를 기대하는 특성이 있기 때문이다.

관련 선행연구에 따르면 마음 지각 수준은 인간과 AI 간의 업무 협력을 강화하고 조직 내의 AI 기술이 통합되는 과정을 촉진하여 인공지능과 친밀한 관계를 맺고 그들의 능력이나 판단을 더 신뢰하게 되는 것을 알 수 있다[17]. 이러한 점에서 사용자가 AI의 마음을 인식할수록 친밀함을 느끼며 서비스의 관심 및 흥미 또한 높아질 것이라 가정해볼 수 있다. 여기서 흥미란 특정 대상에 몰두하고 있는 상태를 의미하며, 대상에게 이끌려 관심을 가지는 감정으로서 행동의 에너지를 상승시키는 역할을 한다. 실제로 사용자가 인간과 유사하게 행동하거나 반응하는 AI에 대해 더 강한 개인적인 연결을 느껴 서비스에 대한 흥미가 증가하는 것을 알 수 있다[18]. 따라서 본 연구에서는 업무 환경이라는 구체적인 조건 내에서 업무지원 AI 챗봇에 대한 사용자의 마음 지각 수준이 높아졌을 때, 해당 서비스에 대한 흥미가 높아지는지를 검증해보고자 한다.

2-3 서비스 흥미와 직무 효능감의 관계

직무 효능감이란 자기효능감이 업무를 수행하는 특정 상황에서 발휘되는 한 부분이다. 자기효능감은 자신이 원하는 결과를 얻는 방법으로 특정 행동을 성공적으로 수행할 수 있다는 자기 능력에 대한 자신감이라고 정의된다[19]. 자기효능감이 생성되는 원천적인 요인에는 성취 경험이 있으며 인지적 동기적, 정서적, 선택적 과정이 상호작용하며 자신의 평가를 인식하게 된다. 이러한 맥락에서 직무 효능감은, Bandura의 사회인지 이론에 따라 자기효능감을 특정 업무 상황에 맞춘 개념이라고 할 수 있다. 즉 개인이 맡은 직무와 관련된 업무를 성공적으로 수행하고 조직화할 수 있는 자기 능력에 대한 믿음과 판단이다.

선행연구에 따르면 조직 구성원의 직무 효능감이 높게 나타날 때 자발적으로 높은 수준의 목표에 집중할 수 있도록 하여 업무 몰입이 향상된다. 자신의 직무에 흥미를 느낄수록 높은 수준의 수행 능력을 보이게 되는 것이다[20]. 이때 흥미는 개인의 자발적인 탐색 활동을 이끄는 정서적인 상태이며 내적 동기의 한 측면이라고 볼 수 있는데[18], 이는 업무 환경에서 구성원의 효율성을 높인다는 점에서 조직 성과의 향상을 위한 필수적인 요소라고 볼 수 있다. 특히 학습 상황에서 중요하게 작용하는 심리적 요인으로서, 특정 서비스에 대한 흥미는 사용자의 행동 의도와 태도에 직접적인 영향을 미치는 요인으로 알려져 왔다.

실제로 인공지능을 도입한 업무 환경에서 인공지능 서비스에 긍정적인 관심을 가지고 이를 기회로 인식할수록 직무 효능감이 더 높은 것으로 보고된 바 있다. 또한 이러한 기회 인식과 직무 효능감 사이에서 AI 기술에 관한 관심과 흥미가 중요한 조절 역할을 한다는 것이 발견되었다[21]. 또한 가상 업무 환경에서의 AI 서비스 효과성을 살펴본 연구에 따르면 AI 서비스에 대해 긍정적인 인식이 직무 효능감을 직접적으로 향상할 뿐 아니라 직무 만족도를 통해 간접적인 영향력을 미치는 것으로 밝혀졌다[22].

이러한 연구 결과를 종합하여 조직 구성원이 업무지원 서비스로서의 인공지능 챗봇에 대해 느끼는 서비스 흥미가 자신의 직무에 몰입하게 하고 높은 수준의 업무를 성공적으로 수행할 수 있다는 믿음인 직무 효능감에 긍정적인 영향을 미칠 것이라 가정해볼 수 있을 것이다.

2-4 마음 지각과 직무 효능감의 관계에서 서비스 흥미의 매개효과

앞서 설명된 것처럼 마음 지각 척도가 높은 경우 사용자는 인공지능 시스템을 더 인간적으로 느끼며 시스템에 대한 흥미와 만족도가 증가하는 것으로 보고되고 있다. 더 나아가 흥미는 사용자의 인지된 유용성과 사용 용이성을 높이며, 최종적으로 사용자의 태도 및 행동 의도에 긍정적인 영향을 미친다는 것을 알 수 있다[21].

또한 흥미의 중요성에 대해 강조한 John Dewey에 따르면 흥미란 어떤 대상이나 활동 영역에서 사람이 추구하는 감정적이고 심적인 태도이며, 내부로부터 자발적으로 생성되어 외부 대상과의 연결을 촉진한다. 즉 서비스에 대한 흥미가 높아지면 해당 서비스를 활용하는 직무 수행과정에서 즐거움을 느끼고 효능감을 높게 지각할 수 있다[23]. 또한 지각된 유희성 측면에서의 흥미가 서비스의 수용 태도와 사용 의도를 향상하는 데 중요한 역할을 하는 것으로 밝혀진 바 있다[24].

즉 조직이 AI를 도입할 때 조직 구성원들이 새로운 기술에 흥미를 느낄 수 있도록 정보를 제공하고 지속적인 참여를 촉진한다면 직무 효능감의 이점을 극대화할 수 있는 것이다. 이러한 선행연구 내용을 기반으로 업무지원 인공지능 챗봇에 대한 마음 지각이 높은 사람이 서비스와의 상호작용에서 더 큰 만족과 흥미를 지각하고, 궁극적으로 직무 효능감을 증진할 것이라 가정해볼 수 있을 것이다.

Ⅲ. 연구 방법

3-1 자료수집 및 연구 대상

본 연구는 XAI의 사후 설명 디자인을 기반으로 설계된 XUI를 적용한 업무지원 챗봇이 사용자의 마음 지각과 서비스 흥미, 직무 효능감에 미치는 영향과 그 관계를 분석하고자 한다. 이에 실험 진행일을 기점으로 하여 근로기준법상 근로자에 해당하는 자를 대상으로 하였으며, 2024년 5월 8일부터 10일까지 총 3일 동안 직장인 커뮤니티를 활용하여 온라인 설문조사를 진행하였다. 참여자는 AI 챗봇과 XAI 챗봇 조건에 무작위 할당하였다. 실험 과제를 수행한 내용을 기준으로 불성실하거나 오류가 발생한 것으로 판단되는 경우를 제외한 총 136부의 유효한 응답지가 최종적으로 분석에 활용되었다. 참가자 중 62명이 기본 AI를 활용한 챗봇 조건, 74명이 XUI를 활용한 XAI 챗봇 조건에 할당되었으며 동질성 검사를 실시한 결과 두 집단 간 차이가 없는 것으로 확인되었다.

표 3은 데이터 분석에 활용된 연구 대상자 전체를 인구통계학적인 특성에 따라 분석한 기술통계 결과이다. 먼저 남성이 47명(34.6%), 여성이 86명(63.7%)이었으며 기타가 3명(2.2%)으로 나타났다. 연령대는 30대 이상 40대 미만이 82명(60.3%)으로 가장 많았고 20대 이상 30대 미만이 42명(30.9%), 40대 이상 50대 미만이 12명(8.8%)으로 50대 이상의 참가자는 없는 것으로 확인되었다. 최종학력은 대학교 졸업 이상이 118명(86.8%)로 대다수를 차지하였고, 직무 분야는 경영/사무지원이 74명(54.4%). 기술/엔지니어링이 29명(21.3%), 금융/회계가 11명(8.1%) 순으로 나타났다. 근로 경력은 3년이상 5년 미만이 61명(44.9%)로 가장 많았고 5년 이상 7년 미만이 53명(39.0%)로 뒤를 이었다. 추가적으로 AI 챗봇에 대한 경험이 있는 경우가 127명(93.4%)로 나타나 대부분의 참가자들이 AI 챗봇에 대한 이해도가 높은 것으로 확인되었다.

3-2 실험 방법

본 연구의 주된 목적은 업무 환경에서 활용되는 대화형 AI 챗봇의 XUI 특성이 사용자의 마음 지각과 흥미, 최종적으로 직무 효능감에 미치는 영향을 탐색하는 데 있다. 이를 위해 실험 참여자에게 가상의 업무 환경을 시나리오를 제시하고자 XAI를 적극적으로 활용하고 있는 업무 환경 및 직무 분야에 대해 살펴보았다. 그 결과 대규모 마케팅 데이터를 처리하는 데 있어 XAI의 효과성이 다수 입증된 것을 알 수 있었는데, Shercliff에 따르면 마케팅 매니저들에게 XAI의 설명력이 신뢰 구축에 긍정적인 영향을 미치며, 실제 업무에의 활용성이 높은 것으로 나타났다[25]. 또한 마케팅 업무에서의 AI 응용은 투명한 의사결정과 예측 정확도를 높이고 업무 이해도를 높일 수 있다는 것이 밝혀진 바 있다[26].

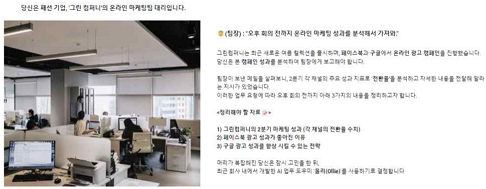

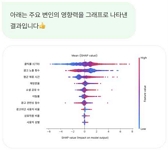

이러한 선행연구에 따라서 본 실험의 시나리오에서는 가상의 패션 기업 ‘그린 컴퍼니’를 설정하였고 참가자에게는 ‘온라인 마케팅팀 직원’이라는 특정 역할을 부여하였다. 해당 팀에서는 페이스북과 구글을 활용한 온라인 광고 캠페인을 진행하고 있으며, 이와 관련된 데이터를 활용하여 업무를 수행하도록 했다. 이때 참가자가 부여된 역할에 몰입할 수 있도록 상사로부터 전달받은 과제를 정해진 시간 안에 해결하고, 업무 보고를 진행해야 하는 특수한 상황을 구성하였다. 이러한 시나리오에 따라 참가자는 실험에서 제공하는 업무지원 챗봇과 협력하며 부여받은 과제를 수행하게 된다. 챗봇과의 대화 주제로는 ‘그린 컴퍼니의 2분기 마케팅 성과 분석’, ‘페이스북 광고 성과가 좋아진 이유 탐색’, ‘구글 광고 성과를 개선할 수 있는 전략 모색’ 등이 있다. 이때 가상으로 설계된 업무지원 챗봇과 위 주제와 관련된 업무 내용을 자유롭게 탐색하고 대화를 진행할 수 있으며, 표 2에 제시된 시나리오 과제를 수행하게 된다. 실험 과정에서 참가자에게 제공된 구체적인 시나리오 화면은 그림 1과 같다.

본 연구에서는 AI와 XAI을 활용한 인터페이스의 사용 맥락을 반영하고자, 업무 환경에서의 사용 목적을 가정한 가상 인공지능 에이전트인 챗봇 ‘올리(Ollie)’의 프로토타입을 설계하였다. 올리의 디자인에는 현재 대화형 에이전트의 유형 중, 업무 환경에서 빠른 결과를 도출할 수 있도록 사용자 패턴을 예측하는 시각 중심 유형(Visual Cetric Style)을 활용하였다[27].

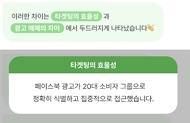

대화 시나리오는 주요 5가지 주제에 따라 총 36개의 경로를 구성하여, 참여자의 선택에 따라 다양한 상호작용이 가능하도록 구성했다. 프로토타입 내 인터페이스와 인터랙션 방식은 실제 서비스인 SK Telecom의 ‘에이닷(A-Dot)’과 카카오의 ‘카카오톡’ 등을 참고하여 제작되었다. 앞서 살펴본 설명인터페이스의 디자인 원칙에 따라 자연스러움과 반응성, 유연성, 민감성의 4가지 측면에서 기본 AI 챗봇과 응답 내용 및 UI에 차이점을 두었으며 각 모델의 응답 예시 및 XUI의 활용 방안에 대한 자세한 내용은 표 4와 표 5에서 확인할 수 있다.

이때 XUI의 디자인 원칙을 정의하고자 했던 Spinn의 연구를 살펴보면 XAI의 설명은 단순히 기능적인 측면을 넘어 사용자 경험의 핵심 부분으로 자리 잡아야 한다고 설명한 바 있다[28]. 이때 확률 표현 방법이 의사결정 과정에서의 사용자 신뢰에 큰 영향을 미친다는 것을 밝혔는데, 다양한 연구를 통해 XAI의 SHAP(Shapley Additive Explanations)를 활용한 그래프 시각화 자료가 AI 모델의 결정에 대한 사용자의 이해와 신뢰를 높인다는 것을 알 수 있다[29]. 따라서 본 연구에서는 SHAP 값을 활용해 마케팅 지표를 분석한 시각화 자료를 챗봇에 활용하여 참여자들이 느끼는 XAI의 설명력을 강화하고자 하였다.

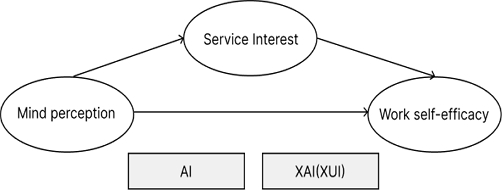

3-3 연구모형

선행연구와 이론적 논의에 따라 업무지원 서비스로서의 XAI 챗봇이 사용자의 직무 효능감을 높일 수 있는지 검증하고자 한다. 선행연구를 기반으로 마음 지각을 독립변인, 서비스 흥미를 매개변인으로 설정하여 세 변인 간의 관계를 분석해보고자 그림2와 같은 연구모형을 설계하였다. 이때 기본 AI 챗봇 조건과 XAI 챗봇 조건으로 나누어, 두 집단 간 연구모형에서 나타나는 차이를 살펴보고자 한다.

3-4 측정 도구

본 연구에서 마음 지각이란 ‘대상의 의도, 생각, 감정 등을 이해하고 예측하는 능력’으로 정의하였다. 이는 인간의 사회적 상호작용에서 중요한 역할을 하는 개념으로, 인공지능 서비스에 대한 사용자의 마음 지각 수준을 측정하기 위해 Kozak의 논문을 참고하였다. 특히 인공지능 직원의 평가를 진행한 선행연구를 참고하여[30] 의도와 인지, 감정 별 2개의 문항을 발췌하여 사용하였다. 총 6문항으로 구성되었으며 모든 문항은 Likert 5점 척도를 사용하였다. 신뢰도 분석 결과 Cronbach's α 값은 .729으로 확인되었다.

본 연구에서 서비스 흥미는 ‘특정 서비스에 대해 사용자가 가지는 관심과 호감도’로 정의된다. 이는 사람들에게 도움과 서비스를 제공하는 로봇과의 상호작용에서 사용자가 느끼는 경험 척도의 일부로 로봇과 사용자의 신뢰를 중점으로 살펴본 Van Pinxteren의 연구를 참고하였다. 서비스 경험 척도 중 흥미의 개념을 나타내는 일부 항목을 수정하여 사용하였다[31]. 총 6개의 문항으로 구성되어 있으며, Likert 5점 척도를 사용하였다. Cronbach's α 값은 .743으로 확인되었다.

본 연구에서 직무 효능감은 ‘자신의 직무를 성공적으로 해낼 것이라는 자기 능력에 대한 신념과 판단’으로 정의된다. 이는 자신의 업무 수행 능력에 대한 신뢰를 나타내며, 직무 효능감이 높을수록 업무 성과와 만족도가 높아지는 것을 알 수 있다. 직무 효능감을 측정하기 위해 Riggs et al.의 척도를 번안한 임은정의 연구를 참고하였다[32]. 전체 척도 중 본 연구에 적절한 5문항을 수정 후 사용하였으며 측정 문항은 Likert 5점 척도를 사용하였다. 신뢰도 측정 과정에서 문항 4번을 제외한 총 4개의 문항을 사용하였다. Cronbach's α 값은 .683으로 확인되었다.

Ⅳ. 연구 결과

먼저 마음 지각과 서비스 흥미, 직무 효능감 간의 관계를 알아보고자 SPSS 27.0을 사용하여 기술통계 및 상관관계 분석을 실시하였다. 이때 서비스 흥미의 매개효과 분석을 위해 Baron과 Kenny가 제안한 위계적 회귀분석을 실시하였으며, 매개효과의 유의성 검증을 위해 Hayes가 제안한 방법에 따라 SPSS Process Macro의 부트스트랩(Bootstrap) 검증을 실시하였다. 이때 모델4를 활용하였으며 표본 수는 5,000, 신뢰 구간은 98%로 설정하였다. 자세한 내용은 다음과 같다.

4-1 기술통계 및 상관관계

본 연구의 주요 변수의 기술통계 결과 및 특징은 다음과 같다. 먼저 AI 챗봇 집단의 결과를 살펴보면 마음 지각의 하위변인 평균은 의도 지각이 3.9(SD=.764), 인지 지각이 4.10(SD=.635), 감정지각이 3.84(SD=.977)로 나타났다. 서비스 흥미는 4.10(SD=.559), 직무 효능감은 3.85 (SD=.643)으로 확인되었다. 각 변수의 왜도는 절대값 3미만, 첨도는 절대값 8을 초과하지 않았다는 점에서 정규성에 위배되지 않는 것으로 확인되었다. 다음으로 XAI 챗봇 집단을 살펴보면 의도 지각이 4.30(SD=.502), 인지 지각이 4.38(SD=.495), 감정지각이 4.23(SD=.764)로 나타났다. 다음으로 서비스 흥미는 4.34(SD=.508), 직무 효능감은 4.27(SD=.517)로 나타났다. 본 집단 또한 왜도와 첨도의 정규성에 문제가 없는 것으로 나타났다. 각 변수의 내적 일관성 검증 결과, Cronbach's α 계수를 살펴보면 직무 효능감이 0.7보다 작은 것으로 나타났으나, 0.6 이상이면 신뢰도가 수용 가능한 것으로 판단되어 분석을 진행하였다.

각 집단별 변인의 상관관계를 살펴본 결과는 표 7와 같다. 1을 중심으로 하단의 결과는 AI 챗봇 집단이며 상단은 XAI의 결과이다. 마음 지각의 3가지 하위변인과 서비스 흥미, 직무 효능감은 모두 유의미한 정적 상관관계를 보였는데 AI 챗봇 집단에서는 마음 지각 중 의도 지각과 서비스 흥미가 가장 높은 정적 상관(r=.714, p<.01)을 보였으며 XAI 챗봇 집단에서는 마음 지각 중 의도 지각과 직무 효능감이 가장 높은 정적 상관(r=.691, p<.01)을 보인 것으로 확인되었다.

4-2 집단 간 분석

앞서 설정한 연구 문제1에 따라, 챗봇의 설계 조건에 따른 주요 변수 간 평균값의 차이가 통계적으로 유의미한지 검증하고자 독립표본 t검정을 실시하였다. 그 결과 마음 지각의 하위변인인 의도 지각(t=-3.61, p<.001), 인지 지각(t=-2.82, p<.01), 감정 지각(t=-2.75, p<.01)에서 모두 유의미한 차이를 보였다. 서비스 흥미(t=-3.52, p<.01)와 직무 효능감(t=-4.18, p<.001)을 살펴본 결과에서도 두 집단 간의 유의미한 차이가 확인되었으며, 모든 주요 변수에서 XAI 챗봇 조건이 더 높은 평균값을 보이는 것으로 확인되었다.

4-3 매개효과 분석

AI 챗봇을 사용한 집단에서 마음 지각이 서비스 흥미와 직무 효능감의 관계를 분석해본 결과, 마음 지각과 서비스 흥미의 직접 효과는 유의미한 것으로 나타났다. 구체적으로 살펴보면 마음 지각이 서비스 흥미로 가는 회귀모형은(F=143.518, p<.001) 통계적으로 유의미하며, 마음 지각과 서비스 흥미가 직무 효능감으로 가는 회귀모형 또한(F=25.837, p<.001) 유의하게 확인되었다. 회귀모형의 설명력은 마음 지각이 서비스 흥미로 가는 모형이 70.5%(adjR2=70.0%)이며 마음 지각 및 서비스 흥미가 직무 효능감으로 가는 모형은 46.7%(adjR2 =44.9%)로 나타났다. Durbin-Watson 통계량은 1.773으로 2에 근사한 값을 보여 잔차의 독립성 가정에 문제가 없는 것으로 확인되었으며 분산팽창지수(VIF;Variance Inflation Factor)도 10 미만으로 다중공선성 문제도 발생하지 않았다.

하지만 마음 지각이 매개 변수인 서비스 흥미에 미치는 영향(β=.840, p<.001)과 종속 변수인 직무 효능감에 미치는 영향(β=.423, p<.05)이 유의미한 것과 달리 매개 변수인 서비스 흥미가 종속 변수인 직무 효능감에 미치는 영향(β=0.288, p = 0.105)은 유의하지 않은 것으로 나타났다. 이러한 회귀분석 결과를 바탕으로 부트스트랩을 통한 간접 효과를 검증한 결과 신뢰 구간 안에 0을 포함하여 매개 역할이 유의미하지 않은 것으로 나타났다.

XAI 챗봇을 사용한 집단을 대상으로 분석한 결과, 마음 지각이 서비스 흥미와 직무 효능감에 미치는 직접 효과 또한 유의미한 것으로 확인되었다. 자세히 살펴보면 마음 지각이 서비스 흥미로 가는 회귀모형은 F=58.038, p<.001로 통계적으로 유의미하며, 마음 지각과 서비스 흥미가 직무 효능감으로 가는 회귀모형 또한 F=47.081, p<.001로 나타나 유의미한 것으로 확인되었다. 회귀모형의 설명력을 보면 마음 지각이 서비스 흥미로 가는 모형이 44.6%(adjR2= 43.9%)이며, 마음 지각 및 서비스 흥미가 직무 효능감으로 가는 모형은 57.0% (adjR2=55.8%)로 나타났다. Durbin-Watson 통계량은 2.165로 2에 근사한 값을 보여 잔차의 독립성 가정에 문제가 없는 것으로 확인되었으며, 분산 팽창지수도 10 미만으로 다중공선성 문제 또한 발생하지 않았다.

회귀분석 결과, 마음 지각이 매개 변수인 서비스 흥미에 미치는 영향(β=0.668, p<.001)과 종속 변수인 직무 효능감에 미치는 영향(β=0.475, p<.001)은 유의미한 것으로 나타났고, 매개 변수인 서비스 흥미가 종속 변수인 직무 효능감에 미치는 영향 (β=0.350, p<.001)도 유의미한 것으로 나타났다. 이러한 회귀분석 결과를 바탕으로 부트스트랩을 통한 간접 효과의 유의성을 검증한 결과, 신뢰 구간 안에 0을 포함하지 않아 서비스 흥미의 매개 역할이 유의미한 것으로 확인되었다.

Ⅴ. 결론 및 논의

본 연구는 설명 인터페이스가 적용된 XAI 챗봇이 업무 환경에서 사용자의 마음 지각, 서비스 흥미, 직무 효능감에 미치는 영향을 실증적으로 분석하고 서비스 흥미의 매개효과를 검증하였다. 먼저 업무 지원 인공지능 챗봇(AI/XAI)에 대한 사용자의 마음 지각이 서비스 흥미와 직무 효능감에 긍정적인 영향을 미치는 것으로 나타나 가설 1이 지지되었다. 이는 사용자와 AI와의 원활한 상호작용이 서비스 흥미뿐만 아니라 업무에 대한 자신감에 긍정적인 영향을 미친다는 것을 의미한다. 다음으로 XAI 챗봇 집단이 모든 변수에서 더 높은 평균값을 나타내었고, 두 집단 간의 차이는 통계적으로 유의미하여 가설 2가 지지 되었다. 이는 인간과 AI의 협업을 촉진하고 사용자 경험을 개선하는 데 있어 XAI의 투명성과 설명 가능성이 긍정적인 영향을 주는 것으로 해석된다. 마지막으로 매개효과를 검증한 결과, XAI 챗봇 집단에서의 서비스 흥미 매개효과만 유의미하게 나타나 가설 3이 부분적으로만 검증되었다. 이는 XUI와 설명 가능성이 사용자의 인지적 및 정서적 반응에 중요한 역할을 한다는 것을 강조한다. 종합적으로 XAI는 더 높은 수준의 마음 지각과 서비스 흥미를 유발하여, 직무 효능감을 더욱 크게 향상하는 것으로 나타났다. 이러한 결과는 비즈니스 환경에서 XAI 기술이 조직 구성원의 직무 만족도와 효능감을 극대화할 수 있음을 시사하여 AI 도입을 고려하는 기업에 중요한 기초 자료를 제공한다.

먼저, XAI의 투명성과 설명 가능성이 사용자 만족도와 직무 효능감에 긍정적인 영향을 미치는 만큼, 기업용 AI 시스템 설계 시 설명력을 높이는 기능을 적극 도입할 수 있다. 이는 AI의 의사 결정 과정에 대한 이해를 높여 사용자 신뢰와 업무 몰입을 강화하고, 새로운 기술을 적극 활용하는 데 도움이 될 것이다. 또한, 대화형 AI를 설계할 때 사용자의 자연스러움(Naturalness), 반응성(Responsiveness), 유연성(Flexibility), 민감성(Sensitivity)을 고려하는 XUI 원칙을 반영하여 조직 구성원과 AI 간의 원활한 상호작용을 촉진하는 기능적, 시각적 요소를 제공할 수 있다. 이러한 도입 방향성은 AI 시스템의 투명성과 설명 가능성을 강조하는 윤리적 AI 사용 및 관련 법적 규제의 목적과 부합하며, 실무적 적용에 유용하게 활용될 수 있다. 또한, XAI 활용에 중요한 요인인 서비스 흥미를 강화하기 위해 AI 상호작용 데이터를 기반으로 직원들의 요구와 피드백을 반영한 맞춤 솔루션을 개발할 수 있다. 이를 통해 기업용 AI 시스템의 지속적인 개선과 최적화를 도모할 수 있으며, 직원들의 흥미를 높여 업무 성과와 만족도를 높이는 도입 전략을 수립할 수 있을 것이다[20].

이러한 연구 함의점을 도출했음에도, 본 연구에는 몇 가지 한계점이 있다. 첫째, 마음 지각, 서비스 흥미, 직무 효능감 외의 다른 심리적 요인이나 외부 요인을 충분히 고려하지 못했다. 선행 연구를 통해 중요 변수를 선택했음에도 이러한 변수는 AI와 인간의 협업 관계에서 직무 효능감의 향상을 설명하기에 여전히 제한적일 수 있다. 둘째, 실험 환경에서 연구를 진행하였기 때문에, 장기간에 걸쳐 진행되는 업무 협업의 특성을 정확하게 분석하지 못했다는 한계가 있다. 마지막으로, 실험을 위해 가상 설계된 챗봇을 활용하여 실제 XAI의 기술적 구현 및 성능 차이를 충분히 반영하지 못했다. 따라서 후속 연구에서는 종단적 연구 설계를 도입하여 업무 환경에서 시간에 따른 협업 양상의 변화와 장기적인 효과를 분석하고, 다양한 사용자의 심리적 요인과 외부 요인을 종합적으로 고려해볼 수 있을 것이다. 또한 현장 연구와 다양한 XAI 기술 및 알고리즘을 활용한 서비스 개발을 통해 어떤 기술적 요소가 XUI와 더불어 사용자 경험에 주요한 영향을 미치는지 명확히 파악해볼 수 있을 것이다. 이와 같은 한계점을 보완한다면 다양한 비즈니스 환경에서 XAI 챗봇의 실무적 적용 가능성을 높일 수 있을 것으로 기대한다.

Acknowledgments

이 논문은 2023년도 연세대학교 연구비의 지원을 받아 수행된 것임(2023-22-0430).

References

- H. J. Wilson and P. R. Daugherty, “Collaborative Intelligence: Humans and AI are Joining Forces,” Harvard Business Review, July-August 2018.

-

D. Leslie, Understanding Artificial Intelligence Ethics and Safety: A Guide for the Responsible Design and Implementation of AI Systems in the Public Sector, The Alan Turing Institute, London, UK, June 2019.

[https://doi.org/10.5281/zenodo.3240529]

- Editorial Department of IRS Global. (2022). Trends in Explainable Artificial Intelligence (XAI) Technology and Market Prospects of the Data Industry [Internet]. Available: https://www.irsglobal.com/goods/85445, .

-

P. K. Chilana, A. J. Ko, and J. Wobbrock, “From User-Centered to Adoption-Centered Design: A Case Study of an HCI Research Innovation Becoming a Product,” in Proceedings of the 33rd Annual ACM Conference on Human Factors in Computing Systems (CHI ’15), Seoul, pp. 1749-1758, April 2015.

[https://doi.org/10.1145/2702123.2702412]

- M. P. Clemens, “The Three E’s of Explainability in Collaborative Computational Co-Creativity: Emotionality, Effectiveness, and Explicitness,” in Proceeding of the ICCBR Doctoral Consortium, pp. 4-9, July 2022. https://iccbr2022.loria.fr/files/2022/09/ICCBR_DC_Preliminary_Proceedings.pdf#page=4

- J. R. G. Varela, Interface Design for Human-guided Explainable AI, Master’s Thesis, Faculdade de Engenharia da Universidade do Porto, Porto, Portugal, July 2022.

- D. Schlackl, UX Improvements in Intelligent User Interfaces through AI Deployment: Design and Evaluation of Human-Centered Explainable AI Concepts, Master’s Thesis, Technische Hochschule Ingolstadt, Ingolstadt, Germany, June 2021.

-

D. Lei, Y. He, and J. Zeng, “What is the Focus of XAI in UI Design? Prioritizing UI Design Principles for Enhancing XAI User Experience,” in Proceedings of the 5th International Conference on Artificial Intelligence in HCI, Washington, DC, pp. 219-237, June-July 2024.

[https://doi.org/10.1007/978-3-031-60606-9_13]

-

B. Mittelstadt, C. Russell, and S. Wachter, “Explaining Explanations in AI,” in Proceedings of the Conference on Fairness, Accountability, and Transparency, New York: NY, pp. 279-288, November 2018.

[https://doi.org/10.1145/3287560.3287574]

-

N. Gill, P. Hall, K. Montgomery, and N. Schmidt, “A Responsible Machine Learning Workflow with Focus on Interpretable Models, Post-Hoc Explanation, and Discrimination Testing,” Information, Vol. 11, No. 3, 137, February 2020.

[https://doi.org/10.3390/info11030137]

-

T.-T.-H. Le, A. T. Prihatno, Y. E. Oktian, H. Kang, and H. Kim, “Exploring Local Explanation of Practical Industrial AI Applications: A Systematic Literature Review,” Applied Sciences, Vol. 13, No. 9, 5809, May 2023.

[https://doi.org/10.3390/app13095809]

-

A. Kumar, S. Dikshit, and V. H. C. Albuquerque, “Explainable Artificial Intelligence for Sarcasm Detection in Dialogues,” Wireless Communications and Mobile Computing, Vol. 2021, No. 1, 2939334, 2021.

[https://doi.org/10.1155/2021/2939334]

-

M. Chromik and A. Butz, “Human-XAI Interaction: A Review and Design Principles for Explanation User Interfaces,” in Proceedings of the 18th IFIP TC 13 International Conference on Human-Computer Interaction (INTERACT 2021), Bari, Italy, pp. 619-640, August-September 2021.

[https://doi.org/10.1007/978-3-030-85616-8_36]

-

T. Herrmann, “Promoting Human Competences by Appropriate Modes of Interaction for Human-centered-AI,” in Proceedings of the International Conference on Human-Computer Interaction, Cham: Springer International Publishing, pp. 35-50, May 2022.

[https://doi.org/10.1007/978-3-031-05643-7_3]

-

X. Wang and E. G. Krumhuber, “Mind Perception of Robots Varies with Their Economic versus Social Function,” Frontiers in Psychology, Vol. 9, 1230, July 2018.

[https://doi.org/10.3389/fpsyg.2018.01230]

-

A. Baimel, R. L. Severson, A. S. Baron, and S. A. J. Birch, “Enhancing “Theory of Mind” Through Behavioral Synchrony,” Frontiers in Psychology, Vol. 6, 870, June 2015.

[https://doi.org/10.3389/fpsyg.2015.00870]

-

A. D. Young, and A. E. Monroe, “Autonomous Morals: Inferences of Mind Predict Acceptance of AI Behavior in Sacrificial Moral Dilemmas,” Journal of Experimental Social Psychology, Vol. 85, 103870, November 2019.

[https://doi.org/10.1016/j.jesp.2019.103870]

-

E. Uysal, S. Alavi, and V. Bezençon, “Trojan Horse or Useful Helper? A Relationship Perspective on Artificial Intelligence Assistants with Humanlike Features,” Journal of the Academy of Marketing Science, Vol. 50, No. 6, pp. 1153-1175, November 2022.

[https://doi.org/10.1007/s11747-022-00856-9]

-

A. Bandura and N. E. Adams, “Analysis of Self-Efficacy Theory of Behavioral Change,” Cognitive Therapy and Research, Vol. 1, No. 4, pp. 287-310, December 1977.

[https://doi.org/10.1007/BF01663995]

-

K. Na-Nan and E. Sanamthong, “Self-Efficacy and Employee Job Performance: Mediating Effects of Perceived Workplace Support, Motivation to Transfer and Transfer of Training,” International Journal of Quality & Reliability Management, Vol. 37, No. 1, pp. 1-17, 2020.

[https://doi.org/10.1108/IJQRM-01-2019-0013]

-

J. Xu, X. Zhang, H. Li, C. Yoo, and Y. Pan, “Is Everyone an Artist? A Study on User Experience of AI-Based Painting System,” Applied Sciences, Vol. 13, No. 11, 6496, May 2023.

[https://doi.org/10.3390/app13116496]

-

E. S. Park, S.-B. Yang, and A. Park, “The Impact of Autonomous Virtual Work Environments on Job Satisfaction and Organizational Effectiveness,” Asia Pacific Journal of Information Systems, Vol. 33, No. 4, pp. 1043-1057, December 2023.

[https://doi.org/10.14329/apjis.2023.33.4.1043]

-

J. R. Hackman and G. R. Oldham, “Motivation through the Design of Work: Test of a Theory,” Organizational Behavior and Human Performance, Vol. 16, No. 2, pp. 250-279, August 1976.

[https://doi.org/10.1016/0030-5073(76)90016-7]

-

R. Rauniar, G. Rawski, J. Yang, and B. Johnson, “Technology Acceptance Model (TAM) and Social Media Usage: An Empirical Study on Facebook,” Journal of Enterprise Information Management, Vol. 27, No. 1, pp. 6-30, 2014.

[https://doi.org/10.1108/JEIM-04-2012-0011]

- Explainable AI (XAI): The Key to Building Trust and Preparing for a New Era of Automation [Internet]. Available: https://www.rtinsights.com/explainable-ai-xaithe-key-to-building-trust-and-preparing-for-a-new-era-ofautomation/, .

-

L. Yu and Y. Li, “Artificial Intelligence Decision-Making Transparency and Employees’ Trust: The Parallel Multiple Mediating Effect of Effectiveness and Discomfort,” Behavioral Sciences, Vol. 12, No. 5, 127, April 2022.

[https://doi.org/10.3390/bs12050127]

-

R. J. Moore and R. Arar, Conversational UX Design: An Introduction, in Studies in Conversational UX Design, Cham, Switzerland: Springer, ch. 1, pp. 1-16, 2018.

[https://doi.org/10.1007/978-3-319-95579-7_1]

- E. Spinn, Probability Expressions in AI Decision Support: Impacts on Human+AI Team Performance, Master’s Thesis, Technological University Dublin, Dublin, Ireland, June 2023.

-

M. R. Islam, M. U. Ahmed, S. Barua, and S. Begum, “A Systematic Review of Explainable Artificial Intelligence in Terms of Different Application Domains and Tasks,” Applied Sciences, Vol. 12, No. 3, 1353, January 2022.

[https://doi.org/10.3390/app12031353]

- H. M. Lee, Evaluation of Anthropomorphized Artificial Intelligence Employees Based on Users’ Perception of Mind: Focusing on the Visualization and Contextual Effects of AI Employees, Master’s Thesis, Sogang University, Seoul, February 2024.

-

M. M. E. van Pinxteren, R. W. H. Wetzels, J. Rüger, M. Pluymaekers, and M. Wetzels, “Trust in Humanoid Robots: Implications for Services Marketing,” Journal of Services Marketing, Vol. 33, No. 4, pp. 507-518, September 2019.

[https://doi.org/10.1108/JSM-01-2018-0045]

-

M. L. Riggs, J. Warka, B. Babasa, R. Betancourt, and S. Hooker, “Development and Validation of Self-Efficacy and Outcome Expectancy Scales for Job-Related Applications,” Educational and Psychological Measurement, Vol. 54, No. 3, pp. 793-802, 1994.

[https://doi.org/10.1177/0013164494054003026]

저자소개

2021년:고려대학교 교육대학원(교육학 석사 - 상담심리교육)

2024년~현 재: 연세대학교 정보대학원 UX트랙 석사과정

※관심분야:대화형 인공지능(Conversational AI), 사용자 경험(User Experience), 인터랙션 디자인 (Interaction Design)

2012년:서울대학교(영어영문학, 경제학 학사)

2019년:서울대학교 융합과학기술대학원(공학박사–HCI)

2019년~2019년: 서울대학교 융합과학기술대학원 연수연구원

2019년~2020년: 카네기멜론대학교(Carnegie Mellon University) HCII 박사후연구원

2022년~현 재: 연세대학교 정보대학원 UX트랙 교수

※관심분야:인공지능(Artificial Intelligence), 인간컴퓨터 상호작용(Human Computer Interaction), 사용자 경험(User Experience)