UAV 영상 데이터 기반의 객체인식 연구동향 분석

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

건설분야에서 드론을 활용한 객체인식은 도전적인 주제이다. 드론을 활용하여 취득된 데이터는 상대적으로 높은 고도에서 촬영됨으로 인해 촬영각도의 제한된 범주에서 객체의 정보를 획득한다는 점에서 일반적으로 객체인식에 활용되는 이미지와 다른 특성을 갖추고 있다. 이러한 드론 데이터의 특성은 일반 이미지를 통해 학습된 객체인식 모델에 적용 및 활용될 경우에 제약요소로 작용된다. 따라서 객체인식에 드론데이터가 활용될 수 있도록 하기 위해 드론의 데이터 특성에 적합하게 객체인식 성능을 높일 수 있는 방법이 필요하다.본 연구는 드론을 활용한 객체인식의 활용성을 높이기 위한 방법을 탐구하기 위해 딥러닝 기반의 연구사업과 문헌을 분석한다. 주요 목적은 드론 데이터셋을 활용하여 건설 분야에서 객체인식률을 향상시키기 위함이다. 통상적인 데이터 전처리와 YOLO, FRCNN 등의 모델의 활용방법이 드론데이터셋과 함께 활용될 경우 객체인식 성능을 향상시키기 위한 조건과 요구조건들을 탐구한다. 다수의 연구사례를 통해 초해상화 방법을 통해 상대적으로 해상도가 낮고 객체의 특징추출이 어려운 드론 데이터셋을 보완할 수 있음을 확인함으로써 객체인식률을 개선할 수 있는 방법을 제안한다.

Abstract

Utilizing drones for object detection presents a challenge in the construction field. Drones capture data from relatively high altitudes, resulting in images with a limited range of viewing angles for object formation, unlike the typical images used for object detection. These drone data characteristics impose constraints on the application and utilization of object detection models trained on general images. Therefore, methods tailored for drone data characteristics are required to enhance object detection performance. This study analyzed deep learning-based research projects and reviewed the literature to explore methods for enhancing the utility of drone-based object detection. The primary objective was to improve object detection rates in the construction industry by leveraging drone datasets. We investigated the conditions and requirements for enhancing object detection performance, applying typical data preprocessing to drone datasets and models such as you only look once (YOLO) and faster region-convolutional neural network (FRCNN). Additionally, we supplemented the datasets with low resolution images, to address challenging object feature extraction.

Keywords:

UAV, Object Detection, Super Resolution, IoU, Confidence Score키워드:

무인항공기, 객체인식, 초해상화, 바운딩박스 일치율, 신뢰도 점수Ⅰ. 서 론

드론은 도시환경을 감시하거나 예상치 못한 재난상황에 신속하게 대응하는 방법을 찾기 위한 수단으로 활용되고 있다. 특정 지장물에 부착된 “고정형” CCTV(Closed Circuit Television)나 사람을 통해 데이터 취득이 어려운 곳의 현황을 파악하거나 감시할 때에 활용된다. 지역 환경 감시 및 모니터링에 관한 기술과 연구들은 고정형 CCTV와 이동형 드론을 혼합 운영함으로써 관제의 효율성을 극대화하고자 노력을 하고 있다.

건설분야에서 드론을 활용한 객체인식은 도전적인 주제이다. 드론을 활용하여 취득된 데이터는 상대적으로 높은 고도에서 촬영됨으로 인해 촬영각도의 제한된 범주에서 객체의 정보를 획득한다는 점에서 일반적으로 객체인식에 활용되는 이미지와 다른 특성을 갖추고 있다. 이러한 드론 데이터의 특성은 일반 이미지를 통해 학습된 객체인식 모델에 적용 및 활용될 경우에 제약요소로 작용된다[1]-[3],[5]. 따라서 객체인식에 드론데이터가 활용될 수 있도록 하기 위해 드론의 데이터 특성에 적합하게 객체인식 성능을 높일 수 있는 방법이 필요하다.

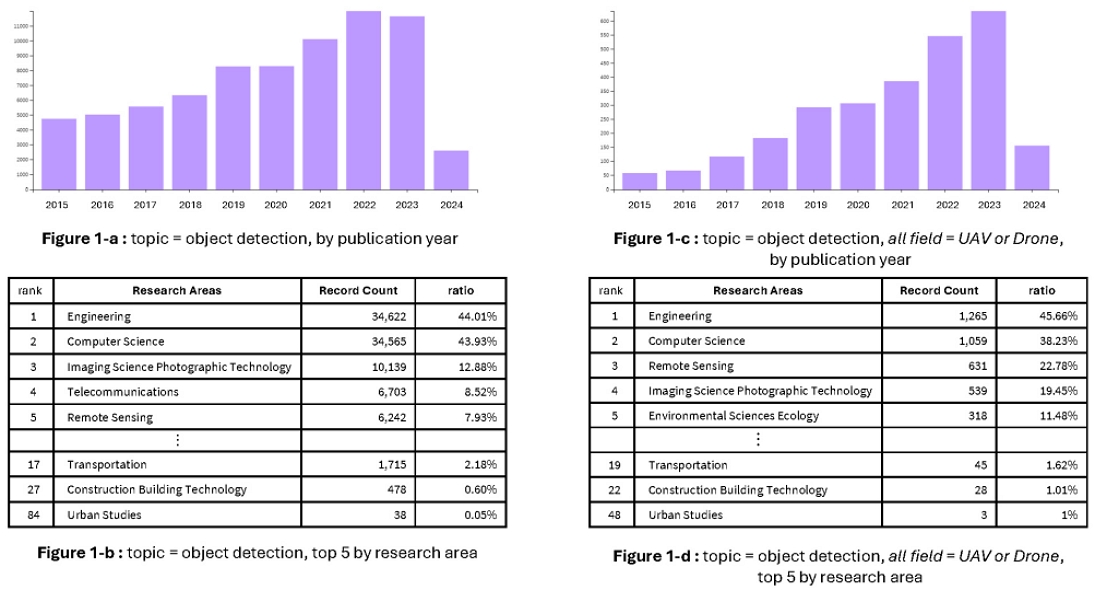

근래 10년(2015-2024) 간의 연구흐름을 Web of Science[3]를 통해 객체인식(Object detection) 연구의 흐름을 살펴보았다(그림 1, 좌측 위 Bar chart). 객체 인식 방법에 대한 연구들이 증가하고 있는데, 의학, 생물학 분야를 넘어서서 건설, 엔지니어링 분야로 확대되고 있음을 확인할 수 있다(그림 1, 좌측 아래 표).

엔지니어링(Engineering) 분야에서 전체의 44.01%를 차지할 정도로 높은 수준의 연구들이 진행되고 있었으며, 건설시공 기술(Construction building technology)(0.6%), 교통(Transportation)(2.14%)과 같은 유사분야를 포함하면 그 수가 더 많다. 얼굴을 감지하는 알고리즘으로 시작되어 좀 더 큰 규모의 객체를 다루는 기계, 도시환경 등의 분야로 확대되고 있음을 알 수 있다.

드론 및 UAV(Unmanned Aerial Vehicle, 혹은 무인항공기)와 관련된 객체인식 연구는 마찬가지로 10년간 연구의 수가 증가하였다(그림 1, 우측 위 Bar chart). 건설시공분야의 경우 전체 연구의 약 1%의 비율을 차지하였으나 꾸준한 증가세를 보임을 확인할 수 있었다(그림 1, 우측 아래 표). 이는 건설 분야에서 드론 데이터를 활용한 객체탐지 연구는 여전히 도전적인 영역임을 뜻한다.

본 논문의 목적은 드론영상을 기반으로 한 객체인식의 성능을 효과적으로 향상시키기 위한 기술개발의 방향을 제안하는 것이다. 드론 데이터의 특성에 적합하게 기술개발 방향을 제안하기 위해 건설분야에서 드론의 역할과 제약조건들을 탐구함으로써 객체인식 기술의 개선방법을 분석하고자 한다.

본 논문의 구성방법은 한 가지 연구가설과 관련되어 있다.

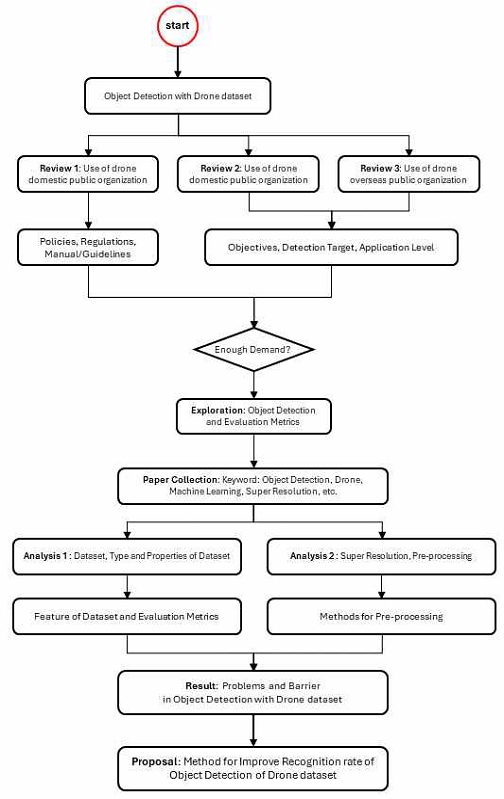

소형 객체와 같이 객체인식에 오류가 생기는 경우, 객체의 정보가 부족하기 때문에 인식률이 낮다. 이에 컨텍스트 정보를 정확하게 주게 될 경우 인식의 성공률에 도움이 될 것으로 예상된다. 앞서서 드론데이터셋을 활용한 객체인식 연구의 시기적절성 탐구한 후, 소형객체 인식을 위한 데이터셋 및 모델의 조건을 탐구한다. 현재까지 컨텍스트 정보를 주기 위한 방법 중 가장 간단한 기술인 “초해상화”를 활용한 기술수준들을 파악함으로써 드론데이터셋을 활용한 객체인식의 기술방향을 제안하고자 한다. 연구 프레임워크는 다음과 같이 구성된다.

- • 사례조사: 국내 공공 드론사업 현황(Review 1, Review 2, Review 3)

- • 문헌 조사 및 탐구: 객체인식 모델개발 현황(Exploration)

- • 성과지표 분석: 드론데이터셋 활용 사례 선정, 객체인식 방법 및 성능 평가지표 분석(Paper collection, Analysis 1, Analysis 2)

- • 제안: 드론데이터 기반 객체인식 기술개발 방향 제안(Proposal)

첫째, 드론을 활용하는 공공 프로젝트들을 탐구한다. 본 연구를 통해 향후 개발하고자 하는 것은 국토정보와 관련된 공공데이터와 병합하여 활용될 수 있는 공공 서비스이다. 건설분야에서 드론의 역할과 제약조건들을 조사하기 위해 공공사업의 현황을 파악한다. 현재 드론데이터 기반의 기술은 당장 민간 시장에 적용하기 어려운 특징이 있다. 민간 기업의 참여유도에 한계가 있는 영역이므로 제한적으로 공공프로젝트(사업)를 통해 직접 서비스되고 있다. 공공사업은 시장수요를 늘리고 추후 민간사업으로 확대가 가능한 잠재성 있는 수요라는 점에서 중요한 사례이다. 드론을 활용하고 있는 공공기관 사례를 조사하고 활용목적과 단계를 분석함으로써 드론기반 객체인식 기술이 적용되기 적합한 분야를 파악하고자 한다.

둘째, 일반적으로 객체인식 성능을 평가하는 데 사용되는 지표를 조사한다. 객체인식 기술을 개발하기 위해서는 여러 과정을 거쳐야 하는데, 객체인식 개발 사례를 통해 데이터 수집 및 전처리, 학습 방법, 성능 평가 지표, 결과 분석, 그리고 하이퍼파라미터 튜닝 등을 조사함으로써 드론 데이터셋을 활용한 객체인식 모델 개발의 기본 조건을 탐구한다.

셋째, 객체인식의 성과를 평가할 수 있게 하는 지표를 탐구한다. 이 평가지표들을 본 논문에서 인식률 지표(Object recognition rate)라 지칭하기로 한다. 이 인식률 지표는 드론데이터를 활용한 객체인식 기술들의 성능을 정량적으로 평가·비교하기 위해 필요한 기준이다. 문헌을 통해 통용되고 있는 지표들을 드론데이터에 적용했을 경우, 지표의 개선이 필요한 부분을 명확하게 하기 위한 것이다.

Ⅱ. 국내 공공 드론사업 현황

2-1 드론관련 정책 및 운영방향

건설분야에서 드론 활용은 꾸준히 관심이 증가하여 정부부처 및 유관기관의 협조 및 노력으로 연결되고 있다. 특히 법률, 시행령, 시행규칙과 같이 강제성을 지니는 것 외에도 지침(가이드) 등의 구성에 영향을 미치고 있다. 예를 들어 국토교통부 소관 법령은 드론 활용의 촉진 및 기반 조성에 관한 법률, 항공안전법, 항공사업법, 공항시설법, 항공, 철도 사고조사에 관한 법률 등이 있다. 이 외에 타부처 소관의 법령, 공공기관별 세부 운영방안, 지자체별 보유 인프라에 맞게 구성된 규칙, 매뉴얼 등이 있다.

최근 공공기관에서 드론 운영의 활성화, 안전성 등을 이유로 법적 제도를 효율화하고 있다(표 1). 현재 국내의 드론 규정은 항공법에서 무인 항공기에 관한 규정이 있으며, 드론 조정과 관련하여 전파법을 통해 규제하고 있다. 표 1의 내용은 폭넓게 규정된 법적 근거보다는 공공기관의 업무와 드론활용의 목적에 맞게 세부적으로 적용하고자 하는 제도적 장치를 의미한다. 각 공공기관에서 제정 및 개정한 법령 및 규칙은 드론활용 업무, 작전 및 임무 등이 수행될 수 있도록 지원하기 위한 것이다. 이외에 지침은 소속기관에 도입된 드론이 안전하고 효율적으로 관리, 운용되도록 하기 위해 필요한 사항들을 규정한 것이다.

2-2 공공사업의 객체인식 관련 기술현황

공공분야에서 드론은 건설, 생활환경의 모니터링, 환경정보의 수집 및 관측, 농약살포와 같은 방제, 실종자 수색 등과 같이 다양하게 활용되고 있다. 공공분야의 드론활용 사례는 현장업무 수행과 관련하여 공공서비스를 제공하는 기관을 대상으로 한다. 아래 조사된 기관들은 정부 정책의 시행, 국가 안전 및 보안, 공공 서비스 제공, 각종 허가 및 인가 업무, 사회 문제 해결 등 다양한 분야의 공공 서비스를 제공하고 행정 업무를 수행하는 곳이다.

총 30개의 공공기관을 대상으로 객체인식 기술을 조사하였다(표 2)[6]. 이 사례들은 크게 생태계, 사람, 시설물, 재난 이하 네 가지로 구분될 수 있다. 이 네 가지로 구분하는 이유는 객체인식을 통해 다루는 대상의 특성에 따라 기술의 적용방법에 차이가 있기 때문이다.

- • 생태계(자연 환경):

- 대상: 동식물, 식물, 자연 환경 요소

- 적용 분야: 환경 보전, 생태계 모니터링, 자연 자원 관리 - • 시설물(인프라 및 건축물):

- 대상: 건물, 도로, 다리, 교량, 발전소, 공장 등의 인프라 및 시설물

- 적용 분야: 도로 및 교량 상태 모니터링, 시설물 유지보수, 안전 및 보안 관리 - • 사람:

- 대상: 인간, 인간의 행동 및 동작

- 적용 분야: 보안, 교통, 의료, 엔터테인먼트, 로봇 공학 - • 재난 및 재해:

- 대상: 자연재해(지진, 홍수, 산사태), 인간에 의한 재해(화재, 폭발, 사고)

- 적용 분야: 재해 예방, 신속 대응, 피해 현황 파악

생태계 관련 객체인식은 다양한 동식물군의 변화와 패턴을 감지함으로써 자연 보전활동에 기여한다. 이에 비해 시설물 관련 객체인식은 인건물, 도로 상태, 교량 구조 등을 감지하고 이상을 식별하여 유지보수 작업이나 안전관리에 활용한다.

사람 관련 객체인식은 얼굴인식부터 자세추적, 행동인식 등을 통해 범죄예방, 보행자 감지 등에 활용되며 두 가지 분류에 비해 독특하게 사생활 보호와 같이 윤리적인 문제가 고려되어야 하는 특성이 있다. 재난 및 재해는 신속하게 이상현상과 사례를 추출해내는 것이 관건이다.

객체인식은 목적과 기술측면에서 차이가 있다. 총 30개의 사례는 생태계(2), 시설물(10), 사람(12), 재난·재해(6)로 구분된다. 시설물을 인식하는 경우, 각각의 적용 내용 상세에서 확인한 결과, 목적이 ‘안전진단’인 경우를 제외하면 육안에 의존하는 서비스이다. 이와 달리 사람을 인식하는 경우, 교도소 순찰, 재난현장, 실종자 수색, 안전을 위한 순찰 등과 같이 AI를 활용한 객체탐지가 적극적으로 활용되어야 하는 서비스가 주를 이뤘다. 특히 ‘감시’를 목적으로 하는 경우는 침입자, 거주자, 주민여부를 인식하는 것이 중요하기 때문에 시나리오 기반의 로직이 별도로 필요할 것으로 판단된다.

III. 객체인식 관련 평가지표 및 영향 요소 분석

3-1 객체인식 관련 지표조사

드론 영상들 중에서 사선, 수직으로 촬영된 것을 대상으로 한다. 객체 인식 기술의 향상 여부는 객체 인식률 지표를 활용한다. 인식률 중에서 객체 인식의 성공 여부를 평가하는 기준은 몇 가지가 있다.

인식률(Object recognition rate)은 학습모델이 이전에 경험한 사물을 친숙한 것으로 인지하고 경험했던 기억을 토대로 결과값을 유추해내는 능력을 측정하는 척도이다. 이 지표에는 대표적으로 Confusion matrix 기반 성능지표(정확도/정밀도/재현율/f1score 등)가 있으며, 이외에도 Time(객체 탐지에 걸린 시간), IoU(Intersection over Union)가 활용되기도 한다[4].

객체의 위치와 분류 정확도의 낮은 상관관계는 모델이 정확한 추론을 하는 데에 부정적인 영향을 미친다[6]. 보행자와 같이 작은 객체에 대한 정확한 인지를 하기 위해서 보행자로 유형을 정확하게 분류하는 것뿐만 아니라 정확한 객체의 영역을 표기할 수 있어야 한다.

객체의 위치와 관련된 IoU와 분류 정확도와 관련된 confidence score는 객체인식에 중요한 역할을 한다[7]. IoU(Intersectioin over Union)는 예측 바운딩 박스와 실제 바운딩 박스의 합집합 영역 넓이와 교집합 영역 넓이의 비율로 계산된다. 이 값은 0(겹치는 부분이 없음)에서 1(완전히 겹침) 사이의 값을 가지게 되며, 이 값이 특정 임계값보다 높은 경우에 객체 탐지 결과를 True로 평가하는 mAP(mean Average Precision) 평가지표의 여러 종류가 존재한다.

mAP는 특정 임계값(Threshold)에서 계산된 특정 클래스들의 평균 정밀도(AP, Average Precision)의 평균값인데, 정밀도(Precision)는 모델이 올바르게 감지한 객체 수를 모델이 감지한 전체 객체 수로 나눈 값이다. 예를 들어, AP50은 IoU 값이 0.5 이상인 경우를 True로 평가하며, 데이터셋에서 특정 클래스 중 IoU 값을 0.5 이상으로 탐지한 비율(%)이 AP 값에 해당한다. 그리고 mAP50은 모든 클래스의 AP50 값을 평균 낸 값이다.

위 평가 지표 중 객체 인식 선행연구들에서 주로 활용되는 평가 지표는 mAP 등의 정밀도 기반 평가지표이며, 주로 선행연구에 비해 벤치마크 데이터셋에서 mAP 개선 정도를 결과로 제시한다. 전체 클래스가 아닌 특정 클래스에서의 AP 값 개선을 명시한 경우도 있으며[8], IoU의 경우 객체 탐지 모델에서 손실 함수로 활용되기 때문에, 이를 보완하기 위한 선행 연구[9]도 존재한다.

3-2 드론의 객체 인식 성능에 대한 영향 요소 분석

객체 인식 연구 사례를 통해 본 결과, 객체 인식의 학습, 테스트, 검증에 활용된 데이터셋은 다음과 같다(표 3).

사례 조사 결과에 따르면, 객체인식 모델의 학습과 평가를 위해 다양한 데이터셋이 사용되었다. 아래 표 내용은 일반적인 객체 인식에 활용되는 데이터셋과 드론 혹은 인공위성에서 촬영된 데이터셋을 포함한다.

건설 분야에서는 주로 건물, 건설 장비, 안전 장비, 인원 등을 인식하고 분류하기 위해 이러한 데이터셋이 활용되었다. 실제 건설 현장에서 발생하는 다양한 상황과 객체를 포함한 데이터셋을 사용하는 것이 이상적이나, 실제 데이터셋을 구하는 것은 어려운 경우가 많아 다양한 데이터셋을 혼합하여 활용하는 경향이 있다. 또한 건설 분야의 경우, 현장에 대한 데이터셋을 직접 구축하거나[10]-[12] COCO(오픈 데이터셋중 하나, Common Objects in Context)와 같이 사람, 차량 등이 포함된 기존 데이터셋에 건설 현장의 이미지를 포함하여 학습시켜 건설 현장 객체인식 성능을 개선시켰다[13].

그러나 앞선 서론에서 연구 동향 파악을 통해 확인했듯, 건설 관련 분야에서의 드론 데이터셋 활용 객체 인식 연구는 미흡한 편이며, 특히 초해상화 등의 데이터셋 증강 방법을 활용한 경우는 거의 없다.

이에 본 연구에서는 드론 및 위성 이미지 데이터셋을 활용한 객체 탐지 선행연구들에서 객체 인식률을 향상시키기 위해 수행한 내용들을 위주로 조사 및 분석을 수행하였다.

연구사례를 통한 객체인식 향상 방법(데이터, 모델 활용 및 응용방법)은 다음과 같다(표 4).

드론에서 촬영된 데이터셋인 VisDrone 데이터셋을 학습시킴으로써 Object Detection 모델을 실행한 경우, 주로 mAP(mean Average Precision, 여러 클래스에 대한 AP의 평균값으로 정밀도와 재현율 간의 관계를 나타냄)를 인식률 개선의 지표로 활용하였다[14]-[16]. mAP의 지표는 IoU(Intersection over Union, 예측된 경계 상자와 실제 경계 상자 간의 오버랩을 측정하는 지표) 값에 따라 mAP50, mAP75, mAP90, mAP50:95 등이 사용되었다. 그리고 특정 클래스에 대한 평균 탐지 정밀도(Average Precision)를 명시한 연구도 있다[8].

드론 데이터셋을 활용한 객체 탐지 선행연구들의 경우, 훈련 이미지를 증대시키거나[16],[17], 특징 피라미드 네트워크(Feature Pyramid Network) 또는 모듈을 추가하거나 수정하는 방식으로 성능을 개선[8],[15],[16],[19]시키기 위한 방법에 대한 것이다.

이외에도 선행연구들에서는 객체 탐지 성능 개선을 위해 YOLO(객체인식 모델 중 하나, You Only Live Once의 약자)모델의 헤드를 작은 객체 탐지를 위해 수정하거나[15],[16],[18], 모델을 파인튜닝하고[20], 손실 함수를 수정하였다[8],[18]. Liu 등의 연구는 드론 촬영 데이터셋에서의 작은 물체 탐지 성능 향상을 위해작은 객체의 표현이 약한 점에 착안하여 CSKD(Cross-Scale Knowledge Distillation) 기법을 통해 이미지 확대한 것과 동일한 효과를 얻었다. 이는 고해상도의 이미지를 제공하는 것과 같이 세부정보를 더 잘 이해하게 되는 방법이다[8].

또한 Wang 등의 경우 YOLOX(오브젝트 검출에 강력한 성능을 보이는 앵커-프리 버전의 YOLO모델)의 손실함수를 IoU에서 SIoU(Scaled Intersection over Union, 기존의 IoU metric을 개선한 것으로 주로 모델이 예측한 경계 상자의 정확도를 평가하는 데에 활용됨)로 대체하였는데, 이는 훈련 속도를 높이고 추론의 정확도를 향상시키기 위함이다[20]. Liu 등은 사람과 같이 작은 객체의 경우 IoU 임계값 증가에 영향을 받아 AP가 많이 감소함을 확인하였다[8].

이 객체탐지(Object detection)기술과 초해상화(Super resolution)를 동시에 활용하여 인식률을 높이는 경우도 있었다. 객체탐지 모델을 변경없이 사용하고 초해상화의 모델을 보완하는 경우와 객체탐지 모델과 초해상화 모델을 동시에 보완하여 객체 탐지 성능을 향상시킨 경우로 나눌 수 있다.

전자의 경우 초해상화 모델의 제안과 활용으로 나뉜다. “제안”의 경우는 개선된 초해상화 모델을 제안하고 기존의 초해상화 모델들과 비교함으로써 성능개선을 검증한 연구들이다[21],[22]. “활용”의 경우는 기존의 초해상화 모델을 유지하고 탐지하고자 하는 객체를 보유하고 있는 공개데이터셋을 학습시킴으로써 초해상화 모델의 성능을 개선한 경우이다[23],[24].

이 연구들은 초해상화 모델 자체의 성능을 개선한 후 객체탐지 시 mAP[22], AP50 및 F1 값에서의 향상이 있었음을 확인하였다[21]. 초해상화 모델은 유지하고 mAP[22] 혹은 정밀도-재현율 그래프 상에서의 객체탐지 성능값을 향상시키기도 하였다[24]. 특히 Courtrai 등은 여러객체가 혼재되어 있는 데이터셋을 학습한 초해상화 모델보다 특정 객체의 데이터셋을 학습한 모델의 정밀도 및 재현도가 높음을 확인하였다[24].

후자의 경우 객체탐지 모델의 수정과 초해상화 활용을 동시에 수행하는 경우를 의미한다. Hui 등은 모델의 세부조정(Fine tuning)과 최적화함수의 변경(Modification of the optimization function)을 통해 객체 탐지 성능을 높이고 데이터 증강을 위해 초해상화 방법을 활용하였다[18].

Zhang 등은 객체탐지 모델에서 인식을 담당하는 핵심기능이나 부분을 수정함으로써 학습하는 과정에 초해상화 모듈을 추가하였다[25]. Xing 등은 물체 탐지를 위해 앵커를 작게 설정한 후 GAN 기반 초해상화의 성능을 개선시켰다[17].

위의 세 선행연구 모두 mAP 값에서의 개선을 확인하였으며, 특히 Hui 등의 연구에서는 데이터 증강, 특징 추출, 새로운 앵커 회귀 방법 제안 등을 통해 기본 YOLOv7 모델의 mAP를 개선시킨 바 있다[20].

결론적으로 선행연구 조사 결과, 드론 데이터셋을 활용한 객체 탐지 연구들의 경우 주로 mAP를 평가지표로 활용하고, 객체 탐지 성능 향상을 위해 객체탐지 모델의 구조를 수정하였음을 확인하였다. 또한 초해상화 모델을 활용 시 특정 객체에 적합하게 개선된 초해상화 모델을 활용하거나 기존 초해상화 모델의 학습방법을 추가함으로써 객체 탐지 성능을 개선하였다.

통상적으로 활용되고 있는 학습모델을 유지하면서 탐지하고자 하는 객체에 맞추어 데이터셋을 구축하거나 모델을 세부적으로 조정하는 방법 모두 객체인식률에 긍정적인 영향을 미침을 확인하였다. 특히 인식률이 낮은 작은 객체에 대한 성능을 확보하기 위해 초해상화를 활용함으로써 객체 탐지 성능이 어느 정도 확보될 수 있음을 알 수 있었다.

초해상화를 활용한 객체인식률을 향상시키기 위한 방법은 다음 두 가지 요소로 구성될 수 있다.

첫째, 객체인식을 평가할 수 있는 척도를 드론 데이터셋에 적용한다. 일반적으로 객체인식에 활용되어 온 인식성공에 대한 평가방법이 드론데이터셋에 적합하게 재조정될 필요가 있다. 드론 데이터셋은 해상도와 시야각이 넓은 특징이 있어서 일반적인 데이터셋(예 - COCO)과는 데이터 특성도 다르기 때문에 IoU 임계값을 조정하는 과정에서 차이가 있을 것으로 예상된다. 또한 드론촬영 데이터는 빛과 날씨, 장애물 등의 주변 컨텍스트가 보행자 인식에 영향을 미칠 것으로 보인다.

둘째, 드론 데이터셋 내에서 보행자와 같은 소형객체의 바운딩박스(Bounding box)가 정확하게 인식되었는지, 객체분류에 대한 확신도는 높은지 등을 평가함으로써 학습모델과 데이터셋을 개선한다.

VI 결 론

객체인식에 드론영상을 적용했을 때 활용성을 확보하기 위한 노력이 필요하다. 무선 통신을 활용하여 드론의 활동영역을 확장하는 연구가 있는가 하면, 최적의 에너지와 궤도 설정계획, 보안 및 개인정보 보호 문제에 관한 연구들이 진행 중이다. 본 연구에서 드론의 활용성을 기기 자체보다는 기기를 통해 획득되는 데이터에 집중한다. 드론을 통해 확보한 데이터가 잘 활용될 수 있도록 하는 처리작업에 도움을 주기 위한 것이다.

드론데이터셋을 통해 건설 객체들(건물, 건설 장비, 안전 장비, 인원 등)을 정확하게 인식하기 위해 드론데이터셋을 전처리, 학습하는 과정이 필수적이다. 예를 들어 VisDrone 데이터셋을 사용하여 객체인식 모델을 학습하고 성능을 개선하기 위해 YOLO, FRCNN 등의 모델을 기반으로 작은 객체의 인식 성능을 향상시키기 위해 객체를 평가하는 공식이나 영역을 산출하는 방법을 제안할 수 있다. 또한 일반이미지에 비해 해상도가 낮은 이미지들을 초해상화를 통해 전처리함으로써 인식률을 개선할 수 있다. 객체영역을 탐지하고 분류할 수 있는 기준과 초해상화 모델을 드론데이터셋에 적합하게 개선함으로써 객체인식률을 개선할 수 있음을 확인하였다.

드론 데이터셋을 최대한 활용하여 객체인식 모델의 성능을 향상시키고 건설 분야에서의 유용성을 높이기 위한 방법 중 하나로 초해상화 활용방법을 제안하였다. 고해상도 이미지를 활용하는 통상적인 객체인식 방법에 비해, 저해상도 이미지만으로 객체인식을 신속하게 수행할 수 있게 한다는 측면에서 차별화될 수 있다. 향후 환경 감시 및 모니터링에 관한 기술과 연구들은 고정형 CCTV와 이동형 드론을 혼합 운영함으로써 관제의 효율성을 극대화할 수 있다.

References

-

Z. Xu, M. Liu, C. Zhu, F. Zhou, and X.-C. Yin, “Feature Implicit Enhancement via Super-Resolution for Small Object Detection,” in Proceedings of the 6th Chinese Conference on Pattern Recognition and Computer Vision, Xiamen: China, pp. 133-145, October 2023.

[https://doi.org/10.1007/978-981-99-8555-5_11]

-

M. Bhusnoor, J. Patel, A. Mehta, S. Sainkar, D. Patel, and N. Mehendale, “Investigating the Impact of Distance on Object Detection Accuracy in Unmanned Aerial Vehicle Systems Using MobileNetV3,” TechRxiv, September 2023.

[https://doi.org/10.36227/techrxiv.24155598.v1]

- Claruvate. Web of Science Search [Internet] Available: https://www.webofscience.com/wos/woscc/basic-search, .

-

H.-K. Jung and G.-S. Choi, “Improved YOLOv5: Efficient Object Detection Using Drone Images under Various Conditions,” Applied Sciences, Vol. 12, No. 14, 7255, July 2022.

[https://doi.org/10.3390/app12147255]

-

D. Nam and S. Yeom, “Moving Vehicle Detection and Drone Velocity Estimation with a Moving Drone,” International Journal of Fuzzy Logic and Intelligent Systems, Vol. 20, No. 1, pp. 43-51, March 2020.

[https://doi.org/10.5391/IJFIS.2020.20.1.43]

- Drone Information Portal. Case Study on the Use of Drone in Public Sector [Internet]. Available: https://www.droneportal.or.kr/subList/20000000066, .

- S. Wu, X. Li, and X. Wang, “IoU-Aware Single-Stage Object Detector for Accurate Localization,” Image and Vision Computing, Vol. 97, 103911, May 2020.

-

Y. Liu, F. Yang, and P. Hu, “Small-Object Detection in UAV-Captured Images via Multi-Branch Parallel Feature Pyramid Networks,” IEEE Access, Vol. 8, pp. 145740-145750, August 2020.

[https://doi.org/10.1109/ACCESS.2020.3014910]

-

K. Su, L. Cao, B. Zhao, N. Li, D. Wu, and X. Han, “N-IoU: Better IoU-Based Bounding Box Regression Loss for Object Detection,” Neural Computing and Applications, Vol. 36, pp. 3049-3063, November 2023.

[https://doi.org/10.1007/s00521-023-09133-4]

-

K. Lee, S. Kang, and Y. Shin, “A Study on the Application of Object Detection Method in Construction Site through Real Case Analysis,” Journal of the Society of Disaster Information, Vol. 18, No. 2, pp. 269-279, June 2022.

[https://doi.org/10.15683/KOSDI.2022.6.30.269]

-

Y.-W. Cho, K.-S. Kang, B.-S. Son, and H.-G. Ryu, “Extraction of Workers and Heavy Equipment and Muliti-Object Tracking using Surveillance System in Construction Sites,” Journal of the Korea Institute of Building Construction, Vol. 21, No. 5, pp. 397-408, October 2021.

[https://doi.org/10.5345/JKIBC.2021.21.5.397]

-

M. Park, D. Q. Tran, J. Bak, and S. Park, “Small and Overlapping Worker Detection at Construction Sites,” Automation in Construction, Vol. 151, 104856, July 2023.

[https://doi.org/10.1016/j.autcon.2023.104856]

-

S. Kim, S. H. Hong, H. Kim, M. Lee, and S. Hwang, “Small Object Detection (SOD) System for Comprehensive Construction Site Safety Monitoring,” Automation in Construction, Vol. 156, 105103, December 2023.

[https://doi.org/10.1016/j.autcon.2023.105103]

-

B.-Y. Liu, H.-X. Chen, Z. Huang, X. Liu, and Y.-Z. Yang, “ZoomInNet: A Novel Small Object Detector in Drone Images with Cross-Scale Knowledge Distillation,” Remote Sensing, Vol. 13, No. 6, 1198, March 2021.

[https://doi.org/10.3390/rs13061198]

-

Z. Zhang, “Drone-YOLO: An Efficient Neural Network Method for Target Detection in Drone Images,” Drones, Vol. 7, No. 8, 526, August 2023.

[https://doi.org/10.3390/drones7080526]

-

J. Zhou, T. Su, K. Li, and J. Dai, “Small Target-YOLOv5: Enhancing the Algorithm for Small Object Detection in Drone Aerial Imagery Based on YOLOv5,” Sensors, Vol. 24, No. 1, 134, December 2023.

[https://doi.org/10.3390/s24010134]

-

C. Xing, X. Liang, and Z. Bao, “A Small Object Detection Solution by Using Super-Resolution Recovery,” in Proceedings of the 2019 IEEE 7th International Conference on Computer Science and Network Technology (ICCSNT), Dalian: China, pp. 313-316, October 2019.

[https://doi.org/10.1109/ICCSNT47585.2019.8962422]

-

G. Wang, Y. Chen, P. An, H. Hong, J. Hu, and T. Huang, “UAV-YOLOv8: A Small-Object-Detection Model Based on Improved YOLOv8 for UAV Aerial Photography Scenarios,” Sensors, Vol. 23, No. 16, 7190, August 2023.

[https://doi.org/10.3390/s23167190]

-

Y. Yang, “Drone-View Object Detection Based on the Improved YOLOv5,” in Proceedings of the 2022 IEEE International Conference on Electrical Engineering, Big Data and Algorithms (EEBDA), Changchun: China, pp. 612-617, February 2022.

[https://doi.org/10.1109/EEBDA53927.2022.9744741]

-

Y. Hui, J. Wang, and B. Li, “DSAA-YOLO: UAV Remote Sensing Small Target Recognition Algorithm for YOLOV7 Based on Dense Residual Super-Resolution and Anchor Frame Adaptive Regression Strategy,” Journal of King Saud University - Computer and Information Sciences, Vol. 36, No. 1, 101863, January 2024.

[https://doi.org/10.1016/j.jksuci.2023.101863]

-

J. Mu, S. Li, Z. Liu, and Y. Zhou, “Integration of Gradient Guidance and Edge Enhancement into Super-Resolution for Small Object Detection in Aerial Images,” IET Image Processing, Vol. 15, No. 13, pp. 3037-3052, June 2021.

[https://doi.org/10.1049/ipr2.12288]

-

Y. Wang, S. M. A. Bashir, M. Khan, Q. Ullah, R. Wang, Y. Song, ... and Y. Niu, “Remote Sensing Image Super-Resolution and Object Detection: Benchmark and State of the Art,” Expert Systems with Applications, Vol. 197, 116793, July 2022.

[https://doi.org/10.1016/j.eswa.2022.116793]

-

J. Shermeyer and A. V. Etten, “The Effects of Super-Resolution on Object Detection Performance in Satellite Imagery,” in Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) Workshops, Long Beach: CA, pp. 5951-5960, June 2019.

[https://doi.org/10.48550/arXiv.1812.04098]

-

L. Courtrai, M.-T. Pham, C. Friguet, and S. Lefèvre, “Small Object Detection from Remote Sensing Images with the Help of Object-Focused Super-Resolution Using Wasserstein GANs,” in Proceedings of IGARSS 2020 - 2020 IEEE International Geoscience and Remote Sensing Symposium, Waikoloa: HI, pp. 260-263, September-October 2020.

[https://doi.org/10.1109/IGARSS39084.2020.9323236]

-

J. Zhang, J. Lei, W. Xie, Z. Fang, Y. Li, and Q. Du, “SuperYOLO: Super Resolution Assisted Object Detection in Multimodal Remote Sensing Imagery,” IEEE Transactions on Geoscience and Remote Sensing, Vol. 61, 5605415, March 2023.

[https://doi.org/10.1109/TGRS.2023.3258666]

저자소개

2011년:성균관대학교 공과대학 건축학과(건축설계)

2013년:성균관대학교 일반대학원 석사(디지털컴퓨팅, BIM)

2018년:성균관대학교 일반대학원 박사(디지털컴퓨팅, BIM)

2018년~2019년: 성균관대학교 박사후연구원

2019년~2023년: 한국건설기술연구원 박사후연구원

2023년~현 재: 한국BIM학회 연구소 연구원

※관심분야:딥러닝(Deep Learning), 해상도변환, 공간정보, 건설절차, 블록체인, BIM(Building Information Modeling) 전략 등

2022년:성균관대학교 공과대학 건축학과(공학학사)

2023년:성균관대학교 일반대학원 글로벌스마트시티융합전공(공학석사)

2023년~현 재: 성균관대학교 일반대학원 글로벌스마트시티융합전공 박사과정

※관심분야:BIM, 인공지능(AI), CAAD(Computational Aided Architectural Design) 등