개별화 맞춤형 학습을 지원하는 AI 챗봇 기반 플랫폼 분석

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

연구의 목적은 개별화 맞춤형 학습을 지원하는 챗봇 시스템 기반 플랫폼을 이해하고 그 품질을 평가·검토하여, 챗봇 활용 시 개별화 학습을 효과적으로 지원하는 교수·학습에 관한 시사점을 제안하는 것이다. 이를 위해 국내에서 활용되고 있는 AI 챗봇 기반 교육용 플랫폼 5개(솔미챗, Speak AI 튜터, AI 헬피, 키위챗, 클래스팅 젤로)를 분석대상으로 선정하여, 교육적 효율성을 기준으로 한 챗봇의 품질 측정을 위한 4가지 요소(Teaching, Humanity, Affect, Accessibility)를 개별화 맞춤형 학습의 관점에서 어떻게 반영하고 있는지 분석하였다. 그 결과, 각 플랫폼에서 구현하고 있는 챗봇 품질 요소별 특징은 다양했지만, Teaching, Humanity, Affect, Accessibility의 요소를 바탕으로 학습자가 자율적으로 질문하며 스스로 답을 찾아가는 과정에서 학습할 수 있도록 설계된 것으로 분석되었다. 본 연구의 의의는 챗봇 품질 평가모델을 바탕으로 개별화 맞춤형 학습을 지원하는 AI 챗봇에 대한 이해와 평가를 구체화했다는 점에서 찾을 수 있다.

Abstract

The purpose of this study is to understand a chatbot system-based platform that supports individualized learning, evaluate and review its quality, and suggest implications for teaching and learning that effectively support individualized learning when using chatbots. To this end, we select five platforms(Solmi Chat, Speak AI Tutor, AI Helpy, Kiwi Chat, and Classting Zelo) and analyze how four elements(Teaching, Humanity, Affect, and Accessibility) for measuring the quality of chatbots are reflected from the perspective of individualized learning. The results of this study show that the chatbots are designed so that learners can learn by asking questions and find answers on their own based on the elements of Teaching, Humanity, Affect, and Accessibility. This study is significant because it specifies the understanding and evaluation of AI chatbots to support individualized and customized learning based on a chatbot quality evaluation model.

Keywords:

Artificial Intelligence, Chatbot, Personalized Learning, AI-Based Educational Platform, Edutech키워드:

인공지능, 챗봇, 개별화 학습, AI 기반 교육 플랫폼, 에듀테크Ⅰ. 서 론

최근 Open AI가 개발한 대화 전문 인공지능 챗봇인 ChatGPT(Generated Pre-trained Transformer)는 단순한 질의응답에서 나아가 과제, 논문작성, 번역, 보고서 등의 작업에 이르기까지 다양한 영역에서 훨씬 발전된 능력을 보여주고 있다. 더욱 발전된 AI는 다양한 교수학습 활동을 지원하고 교육 주체 간 상호작용을 도와 교육 성과를 높이는 데 긍정적인 역할을 할 것이다[1]. 교육을 위한 AI의 활용은 학습을 정교하게 이해하고 지원하기 위한 도구로 AI가 활용되는 것을 의미한다[2]. 교육 현장에서 AI의 활용은 학생의 출결 기록, 시간표 관리, 학습 관리 등의 관리 측면과 교사의 교수활동 지원, 자동 채점 및 평가, 수준별 학습 지도를 위한 수업 보조의 역할, 개별 학생의 맞춤화된 학습 지원을 위한 챗봇에 적용될 수 있다[3].

챗봇은 문자나 음성을 사용하여 학습자와 상호작용하며 학습을 지원하는 컴퓨터 프로그램이다[4]. 이러한 AI 챗봇 기술을 교육에 활용한다면 개인화된 학습경험을 촉진하고 향상하는 하나의 방안이 될 수 있다[4]. 챗봇 사용은 학습 상황과 관련하여 다양한 학습 콘텐츠의 통합, 교육 정보에의 신속한 접근, 동기 부여 및 참여, 여러 사용자의 동시 접근 가능성, 즉각적인 지원 및 피드백을 기대할 수 있고[5], 학생 상호작용 요소를 개선함과 동시에 자동화를 통해 교수자를 지원할 수 있다[6]. AI 챗봇을 활용하여 학습자는 개별적 학습 지원, 즉각적 응답, 자연스러운 상호작용 등의 도움을 받을 수 있고, 이는 교수자의 개별적 1대1 지도를 대체하는 것으로 볼 수 있다[7]. 즉, AI 챗봇은 교수자의 교수활동, 학습 코칭에 구체적인 학습 지원 도구의 형태로 관여하여 학습자의 개인과외 교수자의 역할을 하는 것이다.

그러나 AI 챗봇의 교육적 활용은 몇 가지 측면에서 한계가 있다. 챗봇을 사용하는 학습자가 챗봇 경험에 익숙하지 않거나[5], 챗봇의 기능과 품질 측면에서 학습 촉진 메커니즘이 열악할 수 있다[4]. 또한 플랫폼의 정책 및 사용 지침에 따른 학습적 사용에 제한이 있을 수 있다[8]. 따라서 AI 챗봇을 학습 장면에서 활용할 때 어떤 기능이 추가되거나 개선될 필요가 있는지 면밀한 검토가 필요하다[10]. 특히, 학습 촉진 차원에서 다양한 주제에 관한 적절하고 명확한 학습 정보를 제공해야 하는 기능과 품질에 대한 지속적인 관리가 중요하다[4],[10].

이러한 맥락에서 Smutny와 Schreiberova[4]는 기술의 발달에 따른 교육용 챗봇 및 지능형 대화 에이전트의 품질을 평가하기 위한 품질평가 속성과 기준을 제안하였다. 품질 문제 및 속성에 대한 문헌 검토[10]를 바탕으로 AHP(Analytic Hieracrchy Process) 기반 방법을 활용했으며, AHP와 적절한 품질 속성을 연계하여 교육용 챗봇 품질평가 범주를 4가지 요소(Teaching, Humanity, Affect, Accessibility)로 제시하였다. 챗봇과의 대화 과정에서 학습자의 질문 의도를 정확하게 파악하고 학습적 맥락을 반영하여 유머 등이 포함된 자연스러운 대화가 가능해야 하고, 학습자의 학습적 호기심이나 정서를 파악하여 즉각적으로 반응하며, 이러한 특징들을 바탕으로 학습자에게 개별화된 학습을 지원할 필요가 있다. 교육용 챗봇의 품질 측정은 기술적 기준이 아닌 교육적 효율성이 기준이 되어야 하며[11], 챗봇이 교수자의 보조역할을 하면서 학습자에게 시공간의 제약이 없는 학습을 제공하고 다양한 환경의 학습자에게 효과적인 학습을 지원하는지에 대한 평가와 관리가 필요하다[12].

최근 교육 현장에서는 AI 챗봇에 적용된 기술, 교육적 특징과 교수·학습 지원 도구로서의 활용 가능성을 탐색하는 연구들이 지속되고 있다[7],[13]-[21]. 이들은 교육에 적용할 수 있는 챗봇에 대한 탐색과 교수자가 활용할 수 있는 방안을 제안하였으므로 AI 챗봇을 활용한 개별화 맞춤형 학습에 대한 실천적 시사점을 제공하였다는 점에서 의의가 있다. 그러나 각 교과목의 특성에 기반한 교육적 적용에 대한 탐색과 교수학습 도구로의 효과적인 활용에 대한 부분에 초점을 맞췄으며, 개별화 학습을 효과적으로 지원하는 챗봇 기능에 대한 이해와 평가를 검토하는 데까지는 이르지 못하였다는 한계가 있다. 또한, Smutny와 Schreiberova[4]가 제안한 챗봇 평가 속성의 관점에서 보면, 학습 주제에 따른 보조적 교육도구로서 효과적인 활용 방법을 탐색한 교수·학습 방안은 기술의 발달에 따른 교육용 챗봇 및 지능형 대화 에이전트의 품질과 개별화 맞춤형 학습에 필요한 요소를 제대로 고려하지 못하였을 가능성을 시사한다. 이에 본 연구에서는 개별화 맞춤형 학습을 지원하는 챗봇 시스템 기반 플랫폼을 평가·검토하고, 챗봇 활용 시 개별화 학습을 효과적으로 지원하는 교수·학습에 관한 시사점을 제안하고자 한다.

Ⅱ. 이론적 배경

2-1 챗봇(Chatbot)의 이해와 교육적 활용

챗봇은 채팅과 로봇의 합성어로 인간과 유사하게 상호작용 할 수 있는 인공지능 기반 대화형 소프트웨어이다[22],[23]. 특히 인터넷 환경을 통해 인간 사용자와의 대화를 시뮬레이션하도록 설계된 컴퓨터 프로그램으로 정의된다[24]. 챗봇의 모태는 1950년, 컴퓨터 프로그램의 대화 능력을 실험하였던 ‘튜링 테스트’인 것으로 보고 있으며[25], 1980년대에 이르러 챗봇 영역에 인공지능이 처음 사용되었다[24]. 챗봇이라는 용어는 1991년에 처음 언급되었는데, 이후 1995년 최초의 온라인 챗봇인 ‘ALICE’가 개발되면서 관련 기술의 발전을 불러일으킨 바 있다[26]. 최근에는 인공지능 챗봇이 지속적인 성장을 이루어 오면서 스마트폰이나 전용 홈 스피커에 내장되어 디지털 음성으로 대화하기도 하고, 자동화 기기, 캘린더 등의 작업을 처리할 수 있는 역할 또한 수행하고 있다[24].

챗봇의 유형은 크게 두 가지 방식으로 분류할 수 있다[15]. 첫째, 특정한 목적을 가지고 개발되었는지, 아니면 인간과 유사한 대화 상대자로서 개발되었는지에 따라 목적형과 비목적형으로 구분한다. 둘째, 인간과 유사한 대화가 가능한지와 단순한 응답에 한정되어 반응하는지에 따라 대화형과 단순응답형으로 구분한다. 나아가, 박정아와 이향[27]의 연구에서는 챗봇을 구조(규칙 기반/인공지능 기반), 플랫폼(텍스트 기반/보이스 기반), 목적(범용/전문)에 따라 분류하였다.

챗봇은 개발 구조를 중심으로 세 가지 모델로 구분하기도 하며, 응답 방식을 기준으로 규칙 기반 모델(Rule-based models), 검색 기반 모델(Retrieval-based model), 생성 기반 모델(Generative-based models)로 구분한다[24]. 규칙 기반 모델은 개발자가 입력한 대화의 패턴에 따라 답변을 출력하는 모델로, 사용자가 입력한 내용을 규칙의 패턴과 일치시키고 알고리즘에 따라 미리 정의된 답변을 선택하는 방식이다[28]. 따라서 규칙이 포함된 데이터베이스가 광범위할수록 사용자의 질문에 더 잘 답변할 수 있다. 이는 개발자의 패턴을 기반으로 입력된 지식을 선택하고 활용하기 때문에 그 외의 답변은 생성하기 어렵고, 답변이 다소 반복적이라는 단점을 갖는다[24]. 검색 기반 모델은 자연어 처리(NLP: Natural Language Processing)를 사용하는 방식으로, 사용자가 입력한 내용에서 콘텐츠를 추출하고 대화를 통해 학습할 수 있다[29]. 이는 대화의 전체적인 맥락을 고려할 수 있기 때문에 사용자 입력에 대해 미리 정의된 응답이 존재하지 않아도 답변이 가능하다는 장점이 있으나, 광범위한 훈련 과정이 필요하며 부적절한 데이터가 포함될 경우 문제가 발생할 수 있다[24]. 생성 기반 모델은 대규모의 데이터를 딥러닝 기술로 분석함으로써 자연어 이해(NLU: Natural Language Understanding)를 통한 새로운 답변을 더 잘 생성하는 방식으로 알려져 있는데[29], 그 대표적인 사례로 ChatGPT를 들 수 있다. 최근 몇 년간 상용화된 챗봇은 대부분 검색 기반 챗봇이거나 검색모델과 생성모델을 결합한 하이브리드 방식이며, 관련 연구에서 딥러닝 알고리즘을 적용하여 챗봇을 구현하기 위한 움직임이 활발히 진행되고 있다[29].

챗봇은 언제 어디서나 사용자와의 소통이 가능하고, 대화의 정보를 기록함으로써 사용자 자체에 대한 분석을 통해 개인별 맞춤형 서비스를 가능하게 한다는 점에서 교육적 활용 가능성이 높다[30]. 특히 최근 교육환경에서도 인공지능의 사용이 빠르게 확대되면서, 언어, 수학, 과학, 코딩 등의 다양한 분야에서 챗봇 시스템을 활용하는 경우가 증가하고 있다[5],[28].

교육에 챗봇 기술을 활용하는 것은 하나의 교육용 에이전트(Pedagogicla Agent)로서 보다 개인화된 학습경험을 촉진하고 향상시키기 위한 주요 접근방식 중 하나로 간주되어 왔다[4],[9]. Okonkwo와 Ade-Ibijola[5]에 따르면 교육 분야에서의 챗봇 사용은 다양한 콘텐츠의 통합, 교육 정보에의 신속한 접근, 동기 부여 및 참여, 여러 사용자의 동시 접근 가능성, 즉각적인 지원 및 피드백을 기대할 수 있는 것으로 나타났다. Dsouza 등[6]은 챗봇이 학생 상호작용 요소를 개선함과 동시에 자동화를 통해 교수자를 지원하는 방안으로도 작용할 수 있다고 밝혔다. 즉 교육환경 내 챗봇 기술의 활용은 학습요소 간 연결성과 효율성을 높이고, 상호작용의 불확실성을 줄여 현재의 교육 기관이 필요로 하는 집중적이고 개인화된 온라인 학습환경을 제공할 수 있다[31].

그러나 현재의 챗봇 시스템은 윤리적 쟁점이나 학습자의 인식 문제, 정서 관련 프로그래밍, 감독 및 유지 관리의 문제 또한 수반하고 있다[5]. 챗봇 시스템의 활용을 위해 수집된 데이터와 개인정보를 관리하는 방법에 따라 교육적 상황에서의 챗봇 활용 경험에 관한 학습자의 인식이 변화할 수 있다[8]. 특히 챗봇은 대화를 토대로 하는 시스템이므로 대화의 내용을 이해하고 대화 중에 사용되는 학습자의 사회적, 정서적 요구를 파악할 수 있어야 한다[8],[9]. 교육환경에 최적화된 활용을 위해서는 챗봇을 사용하는 학습자가 혼란을 느끼지 않도록 다양한 주제에 대해 최신의 명확한 정보를 제공해야 하며, 중요한 데이터가 누락되지 않도록 지속적인 관리가 필요하다[5].

2-2 교육용 챗봇의 품질 평가

기술의 발달이 학습자의 요구와 관심에 따른 맞춤화 교육을 가능하게 하는 개별화 학습을 가속화시키고 있다. 또한, 기술의 적극적 활용은 전통적 학습환경에서 실현하기 어려웠던 추가적 지원이 가능하고 효과적 학습으로 이어지도록 한다[32]. 이러한 맥락에서 챗봇을 유용한 교수·학습 도구로 보고, 학습자 특성과 학습환경을 고려한 교육용 챗봇을 개발하기 위한 연구가 시작되고 있다. 특히, 대화형 인공지능 챗봇이 높은 정확도와 유창성을 보이면서 다양한 교육 현장에서 이를 활용한 학습에 관심을 기울이고 있다[13].

챗봇 기반 학습은 인지적 측면에서 정확한 용어와 어휘력 신장, 문법 습득에 효과적이며, 학업성취를 유의미하게 향상시켰다[19],[33]. 정의적 측면에서는 챗봇이 정의적 여과막(Effective Filter)을 낮춰, 학생들이 틀리는 것에 대한 불안과 부담을 줄이는 동시에 편안함과 자신감을 주었다[14],[34]. 이는 학습자의 적극적인 참여와 흥미를 높였을 뿐 아니라, 학습적 상호작용의 양적, 질적 증가로 이어졌다[20],[33]. 교육용 챗봇을 활용한 학습은 챗봇이 제공하는 기술적 특징이 학습 목표 및 학습자의 특성과 효과적으로 접목되도록 설계해야 한다[7]. 학습 목표-학습자-챗봇의 세 가지 측면을 종합적으로 고려하여 설계한다면, 개별화 학습을 가능하게 하고 자기주도적 학습을 촉진할 수 있다[17]. 학습자가 챗봇과 개별적으로 대화하면서 학습이 진행된다는 특징을 활용해, 학습자의 수준과 요구, 관심에 따라 서로 다른 학습내용을 다루고 진행하는 개별화 맞춤형 학습이 이루어지고 있다[16],[21].

초기 챗봇의 평가는 컴퓨터가 충분히 지능적이라고 판단할 수 있는 튜링 테스트(Turing Test)를 통과하는 것이었다[10],[35]. 튜링 테스트는 1950년 영국의 수학자 앨런 튜링이 제안한 테스트로 인간의 대화를 모방한 기계와 대화를 하는 인간이 기계를 인간이라고 판단하는 경우 기계가 지능을 가졌다고 판단하는 테스트이다[25]. 기술의 발달과 Chat-GPT의 등장으로 인공지능이 대중화되면서 교육용 챗봇의 역할에 대한 관심이 증가하게 되었다[1]. Smutny와 Schreiberova[4]는 기술의 발달에 따른 교육용 챗봇 및 지능형 대화 에이전트의 품질을 평가하기 위한 품질 평가 속성을 표 1과 같이 제안하였다.

품질 문제 및 속성에 대한 문헌 검토[10]를 바탕으로 AHP(Analytic Hieracrchy Process) 기반 방법을 활용했으며, AHP와 적절한 품질 속성을 연계하여 교육용 챗봇 품질 평가 범주를 Teaching, Humanity, Affect, Accessibility(교육, 학습자, 영향, 접근성)으로 도출하였다. 교육 범주의 품질 속성은 챗봇이 학습자의 질문에 학습 주제와 관련된 내용이 포함된 자료를 정확하게 전달하고, 질문에 즉시 반응하며, 학습자에게 퀴즈를 내고 점수를 안내하는지 보는 것으로 전체 범주 중 가장 중요한 범주로 제시하였다. 이와 같이 교육의 주목적인 챗봇의 품질 측정은 기술적 기준이 아닌 교육적 효율성이 기준이 되어야 하며[11] 챗봇이 교수자의 보조역할을 수행하면 학습자에게 시공간의 제약이 없는 학습을 제공하고, 다양한 환경의 학습자에게 학습 지원을 할 수 있다[12]. 인간성 범주의 품질 속성은 학습자의 질문을 정확하게 파악하여 맥락을 찾아 인간과 대화하는 듯이 답변하는지를 보는 것으로 제시하였다. 정서 범주의 품질 속성은 챗봇이 학습자의 이름을 사용해 개인화할 수 있고 대화에 이미지와 유머를 섞어 자연스러운 대화를 유도하는지를 보는 것으로 제시하였다. 접근성 범주의 품질 속성은 학습자의 질문을 파악하지 못한 경우에 대한 반응을 제공하고 학습자의 질문에서 학습자의 기분을 파악하고 반응하는 것으로 제안하였다. 이와 같이 챗봇이 사람과 같은 말투를 사용하고 챗봇만의 태도와 개성을 가지게 되면 자연스러운 대화가 가능하고, 이는 대화를 더욱 즐겁게 구성함으로써 학습자가 대화에 몰입할 수 있게 된다[4].

Ⅲ. 연구 방법

3-1 분석 기준

본 연구는 국내에서 활용되고 있는 챗봇 기반 교육용 플랫폼들이 개별화 맞춤형 학습을 위한 요소들을 반영하고 있는지 분석하였다. 이를 위해 Radziwill과 Benton[10]가 제안한 챗봇 시스템 평가 요소(Teaching, Humanity, Affect, Accessibility)를 기초로 하여 표 2와 같이 분석기준을 마련하였다. Teaching, Humanity, Affect, Accessibility 범주에 포함된 평가 속성을 준용하되, 학습자의 개별화 맞춤형 학습을 지원하는 관점에서 분석기준이 되도록 조정하였다. 선정된 챗봇들은 모두 질문에 응답을 해주는 챗봇으로 퀴즈나 시험의 점수를 채점해 주는 기능은 없었다. 따라서 Teaching 범주의 품질 속성 두 가지(피드백 및 Q&A 제공, 목표 설정 및 학습 진행 상황 모니터링)을 통합하여, 학습자의 질문에 즉각적인 피드백을 제공하거나 학습 진행 상황을 점검하는지의 내용을 분석 기준으로 정리하였다. 각 플랫폼의 교육용 챗봇을 개별화 맞춤형 학습을 위한 요소들을 반영한 세부 기준을 포함하고 있는지를 분석하였다.

3-2 분석 대상

분석 대상은 교육 콘텐츠를 제공하는 플랫폼 중 자유로운 대화가 가능한 생성형 챗봇이 있는 5개의(솔미챗, Speak AI 튜터, AI 헬피, 키위챗, 클래스팅 젤로)플랫폼으로 선정하였다. 솔미챗은 인천광역시북부지원교육청에서 지원하는 ‘2023 북부 창의공감 수학캠프’에서 활용되었으며[36], Speak AI 튜터는 언어 학습에 효과적인 음성인식 기반 대화를 지원했다[37]. AI 헬피는 한국과학창의재단에서 주관하는 2023 온라인 코딩파티에서 사용되었으며[38], 키위챗은 키위티에 연동 되어있는 챗봇으로 교육부 주관 제19회 에듀테크 우수기업 콘테스트 우수 제품으로 선정되어 공교육 현장에서의 활용성을 인증받았다. 클래스팅 젤로는 클래스팅 AI 플랫폼에 포함된 챗봇으로 실제 많은 공교육에서 활용되고 있다[39]. 선정한 플랫폼을 학습 주체로 구분하면, 솔미챗, Speak AI 튜터, AI 헬피, 키위챗은 학습자(학생)가 학습 주체이며, 클래스팅 젤로는 교수자를 위한 챗봇이다. 학습 주제를 중심으로 보면, 솔미챗은 수학, Speak AI 튜터는 영어회화, AI 헬피는 코딩, 키위챗은 글쓰기, 클래스팅 젤로는 교수학습이다.

3-3 분석 절차

연구자 3명이 선정된 5개의 플랫폼 내 AI 챗봇 기능을 직접 탐색하는 것을 기본으로 하고, 학습 시나리오에 따라 질문하고 챗봇의 응답을 확인하며 분석 기준에 따라 구체적으로 검토·분석하였다. 학습 시나리오는 챗봇 활용 학습 상황을 반영하고 개별화 맞춤형 학습을 지원하는 관점을 고려하여 구성하였다. 이를 위해 Ramandanis와 Xinogalos[40]가 교육용 챗봇의 기능과 관련해 수행한 체계적 문헌고찰 내용을 참고하여 표 3과 같이 학습 시나리오를 마련하였다.

구체적으로, 교육용 챗봇은 학습자가 가장 많이 질문하는 교육 주제에 대해 응답할 수 있어야 하며 학습 내용을 세분화하여 제시할 필요가 있으므로 A-1과 A-2의 질문을 통해 이를 확인하고자 하였다[41]. 또한 챗봇이 학습자의 요구와 관련된 연습문제나 교육 자료를 제공할 때 학습 효과에 긍정적 영향을 미친다는 연구결과에 따라 A-3의 질문을 포함하였다[42]. 챗봇의 기능은 학습자의 개인적 특성 및 현재의 학습 역량에 맞게 답변을 조정할 수 있어야 하므로 B-1, B-2, B-3의 시나리오를 구성하였고[43], 챗봇이 학습자의 질문을 이해하기 어렵거나 응답을 할 수 없을 때 적절한 후속 질문을 생성하여 다양한 대화의 맥락에 적응할 수 있어야 한다는 연구결과에 따라 A-4 및 B-4의 질문을 포함하였다[44].

또한 각 플랫폼의 특징과 기능에 따라 Teaching, Humanity, Affect, Accessibility 범주에 포함된 평가 속성과 관련한 추가적인 검토도 이루어졌다. 분석 결과의 타당성을 확보하기 위해 세 명의 연구자가 분석 과정에 참여했다. 연구자들은 추가적인 확인이 필요한 경우에는 해당 플랫폼의 사용자 매뉴얼, 관련 연구, 기사 등을 참고하여 분석하였다. 세 연구자는 하나의 플랫폼을 함께 분석하며 기준에 대한 합의를 하고, 남은 4개의 플랫폼은 각자 개별적으로 분석한 후 결과를 비교하였다. 분석 결과에 대한 신뢰도 확보를 위해 연구자 3명이 5개의 플랫폼 내 AI 챗봇의 기능과 품질을 최대 5점의 점수를 부여해 각각 평가하였다. 측정자 간 신뢰도 분석을 위해 SPSS를 사용하여 급내상관계수(Intra class correlation)를 도출하였다. 급내상관계수 평균 측도 값은 0.957(95CI=0.928-0.976), p<0.001로 나타났다.

Ⅳ. 연구 결과

4-1 솔미챗

AI 수학 챗봇 솔미챗은 수학 생성 엔진과 결합시켜 만든 GPT3.5 기반 챗봇이다. 수학 개념뿐만 아니라 주위의 사물이나 일상에 대해 질문하더라도 이와 연관된 수학 개념을 찾아주고, 교과서 수준의 수학 문제와 정답·풀이를 즉시 생성해 준다. 이를 통해 학습자는 수학과 일상생활이 어떻게 연관되어 있는지를 AI튜터 ‘솔미’와 친구처럼 소통하며 스스로 깨우칠 수 있다. 현재 중학교와 고등학교 수준에 맞춰 한국어 및 영어로 서비스를 제공하고 있다. 솔미챗 AI 챗봇을 활용할 경우, 교과 순서만을 따라가던 기존의 수학 학습 방식에서 벗어나 학습자가 질문한 내용에 따라 이를 수학과 연결시켜 스스로 수학에 대한 이해를 높여주는 동시에 맞춤형으로 개별화 학습을 돕는다.

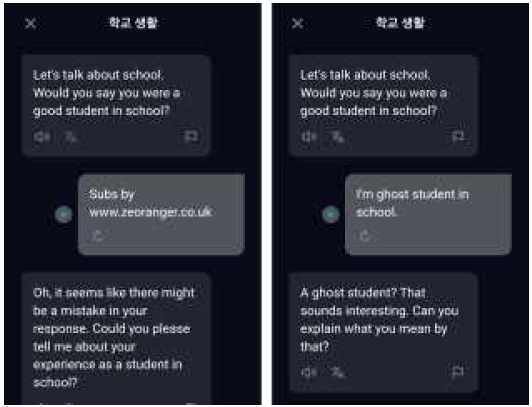

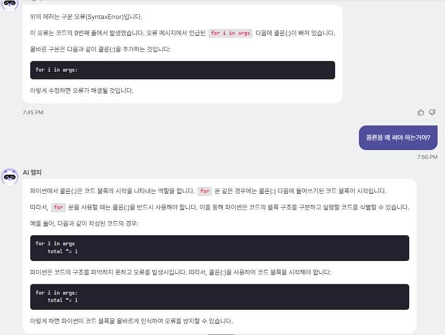

솔미챗에서 찾아볼 수 있는 Teaching 요소는 학습자가 질문한 학습 주제에 대한 수학적 개념과 함께 핵심적인 문제풀이 방법을 제시하는 동시에, 관련 연습문제를 풀어볼 수 있도록 그림 1과 같이 네 가지 문제의 링크를 제시하고 있었다(T1, 평균 점수: 3.67). 학습 시나리오(A-1)에 따라 대화를 시작하면서 ‘소인수분해에 대해 알고 싶어.’라고 질문하자, 소인수분해의 기본 개념과 방법을 설명한 후 구체적인 수를 들어 소인수분해의 풀이 절차를 단계적으로 제시해 주었다. 이어 소인수분해를 연습할 수 있는 문제들의 링크도 함께 제공함으로써 학습 진행을 돕는 모습이었다. 이처럼 학습자의 질문에 즉각적인 피드백과 정보를 시각화하여 제공하고 있었으나(T2, 평균 점수: 4.33), 학습 진행 상황에 대한 점검은 어려우며 단순히 질문에 대한 적절한 학습내용을 체계적으로 제시하고 있는 모습을 보였다.

Examples of learning content recommendations in solmichat's conversations(T1)*This in-platform image is originally written in Korean.

솔미챗의 Humanity 요소는 학습자의 질문과 주제를 정확하게 파악하고 이를 수학과 관련된 개념으로 연결하고 학습할 주제를 자연스럽고 설득력 있게 대화하였다(H1, 평균 점수: 3.00). 또한, 학습자가 궁금할 수 있는 특정 질문에 대해서도 학습자와의 대화 맥락을 파악하여 대화하려는 모습을 확인할 수 있었다(H2, 평균 점수: 3.00). 학습 시나리오(A-2)에 따라 ‘소인수분해를 이해하는 데 도움이 될 수 있는 학습방법이나 전략을 추천해줘.’라고 질문하자, ‘먼저 소수의 개념을 확실히 이해하고, 다양한 수의 소인수분해 과정을 연습해 보며 규칙을 파악한 후, 교과서나 인터넷에서 응용문제를 찾아 풀어보세요.’라고 답변하였다. 이는 학습자의 질문을 정확하게 이해한 후 유용한 답을 논리적으로 제공하려는 모습으로 볼 수 있다. 그러나 솔미챗의 대화는 다소 분절적인 부분이 있었다. 대화가 이어지는 느낌보다는 학습자가 질문하고 솔미챗이 답변하는 질의응답식에 가깝고, 답변을 제시하는 패턴도 답과 관련된 수학 문제 콘텐츠(링크) 제시가 동일하였다. 이러한 부분은 Humanity 요소가 다소 단순하게 적용되었음을 의미하며, 인간과 대화하는 복잡하고 입체적인 대화의 맥락이 적용되었다고 보기는 어렵다.

솔미챗에서 두드러지는 Affect 요소는 학습 시나리오(A-3)에 따른 학습자의 다소 엉뚱한 질문에도 그림 1처럼 수학과 관련된 학습 주제를 연결하여 제시해 주며, 이를 통해 학습자의 흥미를 자극하며 학습을 유도하고 있었다. 이는 학습자 맞춤형으로 개별화 학습을 돕는 것은 물론 수학에 대한 재미와 몰입도를 촉진할 수 있을 것이다(AF2, 평균 점수: 5.00). 자연스러운 대화가 이어지긴 했으나, 학습자의 이름을 불러주는 등의 대화는 부족하였다(AF1, 평균 점수: 1.00).

솔미챗의 Accessibility 요소와 관련해서 학습자의 정서를 파악하고 적절하게 반응해 주는 모습을 확인하였다. 학습 시나리오(B-1)에 따라 ‘수학을 잘하고 싶은데, 공부를 열심히 해도 시험 점수가 잘 나오지 않아 속상해.’ 라고 하자, ‘시험 점수가 잘 나오지 않아 어렵고 속상한 상황이시군요.’라며 공감의 반응을 보였다(AC2, 평균 점수: 3.00). 이어 수학은 단계적인 학문이므로 이전에 배운 내용을 충분히 복습한 후, 많은 유형의 문제를 풀어보면서 차근차근 학습하는 것이 좋다는 전략을 제시해주었다. 마지막으로, ‘수학은 연습과 노력을 통해 향상될 수 있는 과목이므로 힘들어도 포기하지 않고 계속 노력한다면 반드시 좋은 결과를 얻을 수 있을 거라 믿습니다. 파이팅!’이라며 응원의 반응도 포함하고 있었다. 그러나 학습자의 질문 의미와 의도 파악이 안 되는 경우 적절하게 반응하는 장면을 확인할 수 없었다. 수학 개념이 아닌 일상에 대해 질문을 하더라도 이와 연관된 수학 개념과 수학 문제를 알려주는 점이 장점이긴 하나, 학습자의 질문 의미와 의도에 대한 세심한 이해는 부족한 것으로 보여진다. 따라서 학습자의 질문 의미와 의도가 파악되지 않았을 때, ‘다시 질문해주세요.’와 같은 반응은 확인하기 어려웠다(AC1, 평균 점수: 1.00).

4-2 Speak AI 튜터

Speak AI 튜터는 사용자의 음성을 인식해 이해하고 AI의 답변을 음성으로 제공하는 GPT4.0 기반 영어 회화 학습 챗봇이다. 무료 버전으로는 한 가지의 상황에서만 대화 할 수 있다. 유료 버전은 실제 상황에서 자주 쓰이는 상황의 롤플레이와 정해진 주제별로 자유로운 대화가 가능하며 더 나아가 나의 역할, AI의 역할, 대화 상황을 설정해 다양한 상황을 설정해 대화할 수 있다. 이를 통해 학습자는 원하는 상황에 사용할 수 있는 적절한 영어 표현을 학습할 수 있다. Speak의 콘텐츠 등급은 전체이용가를 대상으로 하고 있으며, 4개의 영어 수준별 코스를 제공해 사용자가 자신의 영어 수준을 선택해 학습을 진행할 수 있다. Speak AI 챗봇은 AI가 먼저 학습자에게 주제를 던지며 대답을 유도하고, 학습자의 답변을 분석해 더 자연스러운 표현을 제공하여 영어회화에 대한 이해를 높여준다.

Speak AI 튜터가 제공하는 Teaching 요소는 학습자가 대답한 영어 문장에 대한 문법 개념과 함께, 자연스러운 표현에 대한 피드백을 즉각적으로 제시하고 각 상황에 미션을 지정해 목표에 달성했는지 진행 상황을 제시하고 있었다(T2, 평균 점수: 4.33). 이를 통해 학습자는 자신의 답변에 대한 피드백을 즉각적으로 확인하고 다시 대답할 수 있어 반복적인 학습이 가능했다. 답변에 대한 학습 정보를 제공하고 있으나 학습 정보를 자체적으로 가지고 있어 외부 자료에 대한 웹 페이지나 링크 제공은 지원하지 않았다.(T1, 평균 점수: 1.00)

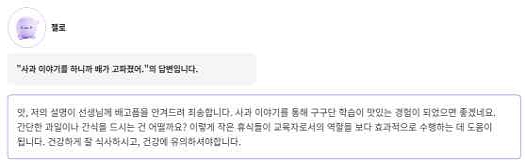

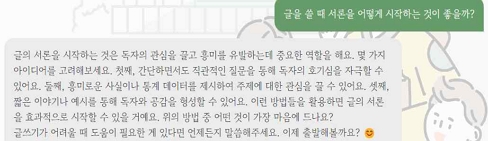

Speak AI 튜터의 Humanity 요소는 학습자의 답변을 정확하게 파악해 정해진 주제에 맞춰 상황에 맞는 질문으로 연결해 대화가 주제에서 벗어나지 않도록 자연스럽게 대화하는 것이었다. 대화의 주제인 ‘샌프란시스코에 있는 친구의 파티 초대에서 만난 새 친구 사귀기’에서 주제를 정확하게 파악해 주어진 역할에 맞게 대화를 이끌어 가며 자연스럽고 설득력 있게 대화를 진행하였다(H1, 평균 점수: 5.00). 예를 들어 ‘Hi, I’m Robin! Are you Amy’s friend?’과 같이 파티에 초대한 가상의 친구 이름을 Amy로 지정하여 질문을 제시하였다. 또한 학습자가 서로의 출신을 이야기하는 과정에서 출신 나라에 대한 질문을 이어나가며 ‘새로운 친구 만들기’ 대화의 상황적 맥락을 파악하고 이어나가려는 모습을 확인할 수 있었다(H2, 평균 점수: 4.33). 사용자가 선택한 주제에서 대화가 벗어나는 경우 원래의 주제로 다시 돌아오는 답변을 추가적으로 제공하여 대화가 이어지고 있다는 느낌을 받을 수 있었다. 이는 Humanity 요소가 잘 적용되었음을 의미하며, GPT4.0의 적용으로 인해 복잡하고 입체적인 대화의 맥락이 적용되었다고 볼 수 있다. 그러나 모든 대화에서 Humanity 요소가 잘 적용되지는 않았다. 그림 2와 같이 샌프란시스코에 와본 적이 있냐는 질문에 방문한 적 없다는 답변을 하자 샌프란시스코에 얼마나 오래 살았냐는 질문을 하는 것을 확인했다.

Examples of affect moments in speak AI tutor's conversations(AF1)*This in-platform image is originally written in Korean.

Speak AI 튜터의 Affect 요소는 그림 2와 같이 학습자의 이름을 불러주는 대화는 가능하였으나, 대화가 어느 정도 진행된 후에는 이름을 기억하지 못했다. Speak AI 튜터의 상황을 설정하는 특징에 따라 학습자와 AI의 역할이 계속해서 바뀌고 대화를 새로 시작해 같은 질문을 하는 경우에도 다른 대답을 하는 것을 통해 새로운 대화창을 여는 경우 기존의 대화 정보를 기억하지 않는 것을 확인할 수 있었다. 자연스러운 대화는 가능하지만(AF1, 평균 점수: 3.00) 학습자의 정보를 기억하는 대화는 확인하기 어려웠다. 학습자와의 대화에서 농담이나 유머는 확인할 수 없었으나 ‘oh!’, ‘That’s great!’ 등의 감탄사를 넣어 학습자와의 자연스러운 대화를 유도하고 있음을 확인했다(AF2, 평균 점수: 3.67).

Speak AI 튜터의 Accessibility 요소와 관련해서 학습자의 답변의 의미와 의도 파악이 안 되는 경우에도 적절하게 반응하는 것을 확인할 수 있었다. 그림 3처럼 학교생활 주제의 대화에서 학교에서 좋은 학생이냐는 질문에 ‘ghost student’라는 데이터에 없는 단어를 사용하자 단어의 의미에 대해 질문하는 모습을 보였다(AC1, 평균 점수: 4.33). 학습 시나리오(A-3)에 근거하여 그림 3과 같이 대화의 맥락과 관계없는 대답을 하는 경우 단어의 의미에 대해 질문을 하거나, 이전 질문의 의도를 상세히 재설명하는 모습을 보였다. 또 학습자의 정서를 파악해 적절한 반응을 보여주었다(AC2, 평균 점수: 3.00). 예를 들어, 학교생활 주제의 대화에서 학습 시나리오(B-1)에 따라 ‘과제가 많아.’ 라고 고민을 이야기하자, 본인이 학교에 다닐 때도 과제가 많았다는 이야기를 하며 공감하는 모습을 보였다.

4-3 AI 헬피

AI 헬피는 코드의 오류를 찾아내고 수정을 도와 코딩 학습을 보조하는 챗봇으로 GPT-3을 기반으로 제작되었다. 별도의 프로그램을 설치하지 않고 엘리스 플랫폼 내에서 사용할 수 있는 챗봇으로 학습자가 플랫폼 내에서 코드를 작성하고 코드 작성을 실수해 학습이 중단되는 것을 최소화 할 수 있게 도와준다. 그러나 제공되는 답변에 대한 학습 정보는 해당 플랫폼을 이용하는 사용자들을 통해 얻어 분석하거나 컴퓨터 과학 및 프로그래밍에 대한 보편적인 개념을 통해 제공하는 것으로 자료에 대한 링크 또는 출처는 따로 지원하지 않았다.(T1, 평균 점수: 1.00)

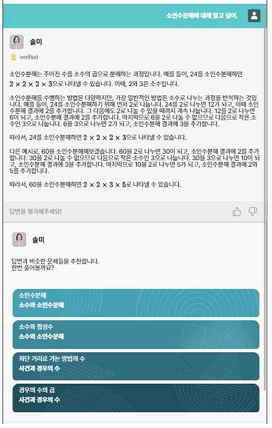

AI 헬피의 Humanity 요소는 학습자의 질문을 정확하게 파악하고 이를 기존 질문에 연결해 추가 답변의 예시를 설명해 대화가 자연스럽게 이어지도록 하였다(H1, 평균 점수: 5.00). 학습 시나리오(A-2)에 따라 그림 4와 같이 AI의 답변에 대한 추가 질문을 한 경우 다음 답변에서 이전에 설명한 내용을 예시로 사용해 설명하는 것을 확인했다. 또 대화의 맥락을 파악하려는 모습을 확인했다(H2, 평균 점수: 3.00). 코드 작성 시 자주 하는 실수에 대해 이야기하자 습관 형성하기, 코드 자동 작성 기능 사용하기, 다른 사람에게 코드 리뷰를 요청하기 등의 해결책을 제시하며 학습자의 질문에 대한 맥락을 이해하고 대답하는 모습을 확인하였다. 그러나 지식 전달 부분을 제외한 고민 등의 답변에는 솔미챗과 같이 대화가 다소 분절되었다. 학습자의 질문에 대한 대답만 제공되어 Humannity 요소가 단순하게 적용되어 인간과 같은 입체적인 대화는 불가능했다.

Examples of natural conversations in AI helpy's conversations(AC1)*This in-platform image is originally written in Korean.

AI 헬피의 Affect 요소는 Speak AI 튜터와 같이 학습자의 이름을 알려주는 질문을 할 때는 이름을 기억하고 불러줄 수 있으나, 다른 질문을 한 후에는 사용자의 이름을 기억하지 못했다(AF1, 평균 점수: 3.00) 또 학습자의 질문에 대한 정답만을 말하며 다소 사무적인 말투를 사용해 Affect 요소는 확인하기 어려웠다(AF2, 평균 점수: 1.00).

AI 헬피의 Accessibility 요소와 관련해서 학습자의 질문이 코딩과 관련이 있는 경우에 의미와 의도 감지를 위한 적절한 반응이 있었다. 예를 들어, 점심 메뉴를 고르는 코드를 만들어 달라는 요청에는 코드를 만들기 위한 음식의 종류 등의 특정 조건을 제시해 달라는 답변을 확인했다(AC1, 평균 점수: 3.00). 또 솔미챗과 같이 학습자의 정서를 파악하고 반응하는 것을 확인했다. 구체적인 방법 제시는 없었으나 학습자의 상황을 공감하고, 응원하는 반응을 볼 수 있었다(AC2, 평균 점수: 3.00).

4-4 키위챗

AI 글쓰기 챗봇 키위챗은 GPT 기반 질문형 챗봇으로, 질문을 통해 학습자의 글쓰기 이후 학습 활동을 지원한다. 학습자가 특정 주제로 100자 이상의 글을 작성하여 대화를 신청하면, 키위챗은 해당 글의 제목과 내용을 토대로 전반적인 짜임새를 분석하며 학습자의 주장과 생각을 파악한다. 이를 통해 글에서 강조되는 부분이나 특징적인 장점을 정리하여 언급해 준 후, 글을 읽은 독자의 관점에서 간략한 감상도 제시해 준다. 키위챗의 가장 큰 특성은 학습자가 질문을 제시하기 이전에 학습자의 글을 읽고 관련된 질문을 먼저 생성해낸다는 것이다. 학습자의 글에서 사고의 확장을 유도할 수 있는 부분을 분석하고 선별하여 학습자에게 질문하는데, 이에 대해 학습자가 답변을 제시하면 간단한 공감이나 추가적인 의견과 함께 학습자의 답변에서 발견된 또 다른 질문 요소를 분석하여 맥락에 적합한 새로운 질문을 제시한다. 현재 키위챗은 특정 대상을 간략히 소개하는 설명문에서부터 주장과 근거의 구조에 따라 논리적으로 전개되는 설득문에 이르기까지 다양한 종류의 글을 분석하여 질문을 생성할 수 있으며, 학습자의 연령 및 학년에 제한 없이 각 학습자에게 맞는 질문을 생성하여 개별화 학습을 유도한다. 키위챗을 활용할 경우 챗봇과의 대화, 즉 챗봇의 질문에 답변해나가는 과정을 통해 학습자 스스로 자신의 글을 성찰할 수 있고, 기존 글의 내용에서 나아가 보다 다양한 방향으로 사고를 확장할 수 있다. 특히 학습자 개개인이 직접 작성한 글을 바탕으로 여러 가지 질문을 생성하고, 학습자가 제시하는 답변의 수준에 맞게 대화를 이어나간다는 점에서 개별화 학습 또한 가능하다.

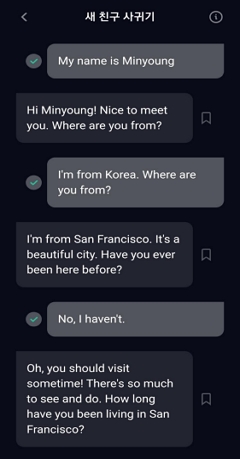

키위챗에서 발견할 수 있는 Teaching 요소는 학습자의 글에 대해 상세하면서도 즉각적인 피드백을 제공함으로써 학습자의 사고 확장을 자극하는 모습이었다(T2, 평균 점수: 5.00). 학습 시나리오(A-2)에 따라 그림 5와 같은 질문을 제시하자, 서론 작성 시 활용할 수 있는 세부 전략을 상세히 설명해주고 학습자에게 유용하다고 생각되는 방법을 질문하는 등의 즉각적인 피드백을 제공하였다. 다만, 전체적인 학습 진행 상황을 점검해주거나(T2, 평균 점수: 5.00) 학습자의 질문과 관련하여 추가적인 문서 및 웹 페이지 자료를 제공해주는 등의 요소는 부족하였다(T1, 평균 점수: 1.00).

Examples of detailed feedback in KeewiChat's conversations(T2)*This in-platform image is originally written in Korean.

키위챗의 Humanity 요소는 학습자가 작성한 글의 주제를 정확하게 파악하여 해석하고, 자연스러운 질문 및 화제 제시를 통해 설득력 있는 대화를 이어나갔다(H1, 평균 점수: 4.33). 학습 시나리오(A-1)에 따라 생체인식 기술 활용 시 고려해야 할 요소에 대해 질문하자, ‘기술의 정확성과 신뢰성, 개인정보 보호 등의 윤리적인 측면을 중요하게 고려해야 해요.’라며 세부주제에 대한 답변도 설득력 있게 제시하는 모습이었다. 이어 학습 시나리오(A-2)에 따라 ‘다른 주제로 글을 쓸 때도 활용할 수 있는 결론 작성 방법이나 좋은 전략을 소개해줘.’라고 하자 주장을 간결하게 요약하기, 강조할 수 있는 관련 예시나 실제 사례를 함께 제시하기 등 일반적인 글쓰기 상황에서 쉽게 적용 가능한 전략을 소개함으로써 대화의 맥락을 유연하게 파악하였다(H2, 평균 점수: 5.00).

키위챗의 Affect 요소와 관련하여 비록 농담이나 유머 요소를 발견할 수는 없었으나, 글을 비롯한 질문과 답변에서 파악할 수 있는 학습자의 수준에 맞게 전반적으로 어색하지 않은 대화를 이끌어갔다(AF2, 평균 점수: 3.00). 키위챗은 질문형 챗봇이라는 특성상 학습자의 답변에 지속적인 질문을 제시하는 과정에서 자칫 대화보다는 분절적인 질의응답 형식으로 진행될 가능성이 있는데, 이를 방지하고자 학습자의 답변에 적절한 공감이나 유사한 화제를 먼저 제시한 후 자연스럽게 새로운 질문을 이어가는 모습이었다. 다만 학습자의 이름을 불러주는 등의 요소는 미흡하였다(AF1, 평균 점수: 1.00).

키위챗에서 두드러지는 Accessibility 요소는 학습자가 제시한 질문의 의도가 명확히 드러나지 않는 경우 재질문을 요청하여 대화의 맥락을 잡아가는 모습이었다(AC1, 평균 점수: 5.00). 학습 시나리오(A-3)에 따라 기존 대화의 흐롬을 고려하지 않은 질문을 제시하자 ‘다시 질문해주세요.’라는 반응을 보였다. 이는 학습자와의 대화를 맥락에 맞게 이끌어가려는 모습으로 해석할 수 있다. 또한, 학습 시나리오(B-1)에 따라 ‘글을 잘 쓰고 싶은데, 내 주장을 뒷받침할 수 있는 논리적 근거를 어떻게 찾을 수 있을까?’라고 이야기하자 ‘글을 잘 쓰기 위해서는 주장에 대한 근거를 명확하고 논리적으로 제시하는 것이 중요하죠. 고민이 이해가 가요.’라며 학습자의 정서를 적절히 파악한 반응을 보였다(AC2, 평균 점수: 5.00). 관련된 해결방안으로 신뢰성 높은 학술 논문이나 보고서 찾아보기, 다양한 관점을 고려해보고 반론에도 대비해보기 등 세부 전략 또한 자연스럽게 제시하면서 학습자의 고민 해결에 적절한 도움을 주고자 하는 모습이었다. 별도의 정서적 표현을 사용하지 않았음에도 직전 대화의 내용과 전반적인 맥락을 반영하여 학습자의 신호에 반응하고 공감할 수 있다는 것은 키위챗의 강점 중 하나로 파악된다.

4-5 클래스팅 젤로

AI 질의응답 챗봇 클래스팅 젤로는 GPT 3.5 기반의 교수자 전용 챗봇이다. 교육 및 학습과 관련된 정보를 효과적으로 제공할 수 있는 프롬프트 엔지니어링이 탑재되어 자연어를 처리하고 적절한 답변을 생성하는 시스템이다. 클래스팅 젤로는 AI 보조교사로서 인간 교육자의 시간과 비용을 절약해주고, 적용이나 평가와 같은 보다 높은 수준의 교육에 집중할 수 있게 돕는다. 교수자가 특정 교과나 학습 주제에 관한 질문을 제시하면, 질문의 요지와 의도를 파악하여 문제 해결을 위한 여러 방안을 답변으로 제시한다. 전체 학습자를 대상으로 적용할 수 있는 수업방법이나 콘텐츠는 물론 학습내용 이해에 어려움을 겪는 학생, 학습에 집중하지 않고 산만한 행동을 보이는 학생 등 다양한 학습자 특성이 공존하는 교육적 상황에서 효과적으로 활용 가능한 전략 또한 맞춤형으로 추천해준다. 클래스팅 젤로의 답변 내용에 대해 추가적인 질문을 제시하면 연관된 사례를 들어 보다 상세한 피드백을 생성해내는 것도 가능하다. 교수자는 클래스팅 젤로가 제시한 각 답변 아래의 배너를 활용하여 답변의 내용을 즉시 클래스 게시글로 업로드할 수도 있다. 현재 클래스팅 젤로는 미취학 아동 교육 기관부터 유치원, 초·중·고등학교, 대학 및 학원, 이외 특정 기관에 소속되지 않는 기타 교육적 모임 등에 이르기까지 교육과 관련된 클래스를 운영할 수 있는 모든 경우에서 접근 가능하나, 챗봇과의 대화는 클래스를 개설한 관리자(교수자)에 한해 사용할 수 있다. 교수자 또한 변화하는 사회와 교육환경 속에서 다양한 교육방법 및 효과적인 교수전략을 지속적으로 학습하는 ‘학습자’ 라는 관점에서, 클래스팅 젤로를 활용할 경우 현업에 필요한 교육적 역량과 요구되는 문제해결 방안을 적시에 학습하여 적용할 수 있다. 특히 교수자 개인의 상황이나 환경, 필요로 하는 지식과 정보, 의문과 어려움 등을 개별적으로 파악하여 맞춤형 답변을 생성한다는 점에서 효율적인 개별화 학습에 기여할 수 있다.

클래스팅 젤로에서 찾을 수 있는 Teaching 요소는 교수자가 질문한 학습 콘텐츠의 구체적인 명칭과 관련 자료에 대해 여러 애플리케이션 리스트와 추가적인 학술자료 링크를 명확히 제시하고 있었다(T1, 평균 점수: 5.00). 교수자의 질문에 즉각적인 피드백을 제공하면서도 연관된 정보를 체계적으로 정리하여 제시함으로써 교수자의 이해를 돕고 있었으나(T2, 평균 점수: 3.67), 학습 진행 상황을 점검해주는 요소는 찾아볼 수 없었다.

클래스팅 젤로의 Humanity 요소는 교수자의 질문과 주제를 정확하게 해석하여 설득력 있는 정보를 바탕으로 자연스러운 답변을 제시하였다(H1, 평균 점수: 5.00). 특히 이어지는 대화의 맥락을 염두에 두고 교수자의 질문을 해석함으로써 보다 다양하고 구체적인 해결책을 제공하려는 모습도 볼 수 있었다(H2, 평균 점수: 5.00). 학습 시나리오(A-1)에 따라 ‘초등학교 2학년에게 적합한 수학 구구단 단원 수행평가 과제를 추천해줘.’라고 질문한 후, 학습 시나리오(A-2, B-1)에 따라 특별히 구구단 암기에 흥미를 느끼지 못하는 학생의 지도 방안에 대한 고민을 이야기하였다. 이에 대해 클래스팅 젤로는 첫 번째 질문의 답변 내용과는 차별화된, 다양한 교육적 접근법을 사용하여 특정 학생의 흥미를 유발하고 적극적인 참여를 유도할 수 있는 다섯 가지 전략(게임을 이용한 학습, 시각적 도구 사용, 스토리텔링, 피드백과 격려, 개별화된 지도)을 제시해주었다. 이는 클래스팅 젤로가 교수자와의 대화 맥락을 적합하게 파악하여 세부 전략의 이해를 자연스럽게 유도한다고 볼 수 있다.

클래스팅 젤로에서 발견한 Affect 요소는 전반적인 대화에서 어색함이 적었으며 특히 대화에서 확인한 교육적 맥락에 따라 적합한 유머를 활용하여 답변하는 모습을 보였다(AF2, 평균 점수: 5.00). 수학 교과를 주제로 먼저 대화를 주고받은 후에 ‘재미있는 이야기 해줘.’라고 다소 맥락에 어긋나는 요청을 하였는데, ‘수학을 가르치시니 수학에 관한 재미있는 이야기를 들려 드릴게요.’라며 자연스러운 유머를 활용한 이야기를 제시하면서도 어색하지 않게 본래의 맥락을 잡아가면서 대화로의 몰입을 유도하는 모습이었다. 다만 교수자의 이름을 불러주는 등의 요소는 발견하기 어려웠다.

클래스팅 젤로에서 두드러지는 Accessibility 요소는 그림 6과 같이 교수자의 정서를 적절히 파악하고 공감의 반응을 보여주었다(AC2, 평균 점수: 3.00). 직전의 대화 내용에서 클래스팅 젤로가 제시하였던 ‘사과를 활용한 구구단 학습법’에 대해 질의응답을 주고받다가 학습 시나리오(나-3)에 의거하여 그림 6처럼 다소 엉뚱한 이야기를 제시하였는데, 문장을 통해 현재 정서를 파악하여 반응한 후 교수자의 역할과도 자연스럽게 연결하여 해결방안을 논리적으로 제시해주는 모습이었다. 또한 클래스팅 젤로가 제공한 또 다른 답변에 대해 단순한 추임새만 제시하자, ‘죄송합니다. 제가 어떤 도움을 드릴 수 있는지 좀 더 구체적으로 말씀해 주시겠어요?’라며 재질문함으로써 교수자의 의도와 의미를 파악하기 위해 세심한 반응을 덧붙이고 있었다(AC1, 평균 점수: 3.00). 이는 교수자의 요구에 최적화된 정보를 제공하고, 대화 중 정서를 적절히 파악하여 공감함으로써 대화의 질을 더욱 높이고자 하는 긍정적 요소로 해석할 수 있다.

4-6 종합 결과

표 4는 챗봇 시스템 평가 속성을 기초로 개별화 맞춤형 학습요소에 따라 앞서 분석한 내용을 요약하였고, 그 결과를 종합하면 다음과 같다.

첫째, 각 플랫폼의 챗봇은 Teaching 요소가 반영되어, 학습자의 질문에 즉각적인 피드백을 제공하고 개별 학습자의 맞춤화된 학습 지원이 이루어지고 있었다. 모든 플랫폼의 챗봇은 학습자가 자신의 학습 요구와 수준에 맞는 다양한 질문을 하면 그에 맞는 학습에 도움이 되는 피드백을 제공하면서 개별화 학습을 지원하는 모습을 보였다. 그러나 학습자가 질문한 학습 주제가 포함된 관련 링크 및 학습 콘텐츠를 추천하거나 챗봇과 대화 과정에서 학습의 진행 상황을 점검하는 학습 지원은 다소 부족한 것으로 분석되었다.

둘째, 각 플랫폼의 챗봇은 Humanity 요소가 반영되어, 주제별 토론 및 특정 질문에 대한 답변 등을 통해 개별화 학습을 지원하고 있었다. 학습자의 질문과 주제를 정확하게 파악하고 그에 맞는 주제별 토론이 가능하였으며, 나아가 앞선 질문에 연결하여 추가 답변을 하는 등 자연스럽고 설득력 있는 대화를 통해 학습이 진행되었다. 한편, 솔미챗과 AI 헬피의 경우에는 학습 주제 및 지식 제공과 같은 대화가 아닌 고민이나 자유로운 특정 질문에 대한 답변에는 대화가 다소 분절되는 모습을 보이며 인간과 같은 입체적인 대화는 아직 부족했다.

셋째, 각 플랫폼의 챗봇은 Affect 요소가 반영되어, 전반적으로 정서적 안정감을 느끼며 자연스러운 대화가 가능했다. 학습자에 맞춰 대화에 어색함은 적었으나, 학습자의 이름을 말하는 부분에 대해서는 일회성이거나 장기적으로 기억하는 모습은 찾기 어려웠다. 그리고 농담이나 유머를 포함한 대화를 통해 재미와 몰입도를 촉진하는 부분에 대해서도 부족함을 보였다. 부족하지만 챗봇이 농담과 유머를 섞어가며 대화하고 능청스러운 의사소통을 시도하는 모습을 확인할 수 있었다. 솔미챗은 엉뚱한 질문에도 자연스럽게 대화를 이어가며 수학 관련 학습 주제로 연결하는 모습에 강점이 있었으며, 클래스팅 젤로는 자연스러운 유머를 활용하는 등 어색하지 않게 본래의 맥락을 잡아갔다.

넷째, 각 플랫폼의 챗봇은 Accessibility 요소가 반영되어, 의미와 의도를 감지하거나 학습자의 사회적 신호에 적절하게 반응했다. 솔미챗을 제외하고 나머지 4개의 챗봇은 질문의 의도를 파악하기 위해 ‘다시 질문해주세요.’와 같은 반응을 보였다. 또한 모든 플랫폼에서 학습자의 정서를 파악하고 반응하였다. 특히, 키위챗에서는 별도의 정서적 표현을 사용하지 않았음에도 대화의 전반적인 맥락을 파악하여 학습자의 신호에 반응하고 공감하는 대화를 이끌어 갔다.

한편, 각 플랫폼의 챗봇이 가진 강점을 개별화 맞춤형 학습요소의 분석기준으로 선정하여 정리하면 다음과 같다. 솔미챗의 강점은 학습자가 질문한 학습 주제가 포함된 수학 연습문제 링크를 제시하며(T1), 엉뚱한 질문에도 학습 주제와 연결하여 자연스러운 대화를 이어가며 수학에 대한 재미를 촉진하는 것이다(AF2). Speak AI 튜터의 강점은 학습자의 영어 문장에 대한 피드백을 즉각적으로 제시하고 각 상황에 미션을 지정해 목표에 달성했는지 진행 상황을 점검하며(T2), 학습자와의 대화가 주제에서 벗어나지 않는 것이다(H1). AI 헬피는 학습자의 기존 질문에 연결해 추가 답변의 예시를 설명하는 대화가 자연스럽고(H1), 학습자의 대화에서 의미와 의도 감지를 위한 적절한 반응과 질문으로 학습을 촉진하는 강점이 있었다(AC1). 키위챗은 학습자의 특정 질문에도 전체적인 대화의 맥락을 명확하게 파악하여 유연한 반응하는 모습을 보이며(H2), 전반적인 정서를 파악하여 적극적으로 대화하려는 강점이 있다(AC2). 마지막으로, 클래스팅 젤로는 교수자를 위한 챗봇으로 교수자가 질문한 학습 콘텐츠의 구체적인 명칭과 관련 자료에 대해 참고 링크를 명확히 제시해 주며(T1), 이어지는 대화의 맥락을 염두에 두고 질문을 해석하는 강점이 있었다(H2).

Ⅴ. 결론 및 제언

본 연구에서 교육용 플랫폼의 챗봇 시스템을 분석한 결과, 각 플랫폼의 챗봇은 Teaching, Humanity, Affect, Accessibility의 요소를 바탕으로 학습자가 자율적으로 질문하며 스스로 답을 찾아가는 과정에서 학습할 수 있도록 설계된 것으로 분석되었다. 각 플랫폼의 교육용 챗봇에서 분석할 수 있었던 Teaching, Humanity, Affect, Accessibility 품질 속성을 바탕으로 챗봇 활용 시 개별화 맞춤형 학습을 효과적으로 지원하는 교수·학습에 관련하여 다음과 같은 시사점을 도출하였다.

첫째, 본 연구에서 분석한 플랫폼의 AI 챗봇에서 Teaching 요소를 분석한 결과, 공통적으로 학습자의 질문에 즉각적인 피드백을 제공하고 있었으나(T2), 학습 콘텐츠 추천이나(T1) 학습 진행 상황에 대한 점검 요소(T2)는 모든 플랫폼에서 제공되는 것은 아니었다. 학습 콘텐츠 추천은 솔미챗과 클래스팅 젤로만 제시하고 있었으며, 솔미챗은 수학 연습문제 링크를 제공하고 클래스팅 젤로는 관련 애플리케이션 리스트와 추가적인 학술자료 링크를 제공하였다. 이처럼 추천된 학습 콘텐츠나 추가 학습 활동에서 학습자는 자신의 수준이나 선호에 따라 다양하고 개별화된 학습 활동을 수행하는 기회를 제공받고, 이는 개별화 학습을 효과적으로 촉진시킬 수 있다[21]. 한편, 학습 진행 상황에 대한 점검 기능은 Speak AI 튜터와 키위챗에서만 확인할 수 있었다. 학습자들이 학습 관련 개념을 형성하려면, 자신의 선개념을 먼저 구체적으로 드러내고 학습하고자 하는 이론이나 사례 등을 통해 선개념을 수정해나가는 과정이 필요하다[45]. 하지만 학습자들은 교수자나 다른 학습자들에게 자신의 의견을 드러내고 소통하는 과정에서 부담과 불안을 느낄 수 있는데, 이를 챗봇으로 극복할 수 있다. 챗봇을 이용해 선개념을 진단하고 생각을 발전시킬 수 있는 기회를 제공할 수 있으며, 적절한 스캐폴딩을 제공해 준다면 학습의 효과를 긍정적으로 기대할 수 있다[17]. 따라서 교육용 챗봇이 Teaching 요소를 적극적으로 반영하여 즉각적인 피드백을 넘어서 적절한 학습 콘텐츠의 추천과 학습 진행 상황에 대한 모니터링이 가능하다면, 학습자의 자기조절학습에 긍정적인 영향을 줄 것이다.

둘째, 본 연구에서 분석한 플랫폼의 AI 챗봇에서 Humanity 요소를 분석한 결과, 주제별 토론(H1)과 특정 질문에 대한 답변(H2)을 통해 개별화 학습을 지원하고 있었다. 주제별 토론(H1)과 관련해서는 학습자의 질문과 주제를 정확하게 파악하고 그에 맞는 주제별 토론이 원활하게 이어졌다. 반면 특정 질문에 대한 답변(H2)의 경우, 솔미챗과 AI 헬피는 자유로운 특정 질문에 대한 답변에 대화가 다소 분절되는 모습을 보이며 인간과 같은 입체적인 대화는 아직 부족했다. 따라서 학습 배경, 학습 목표 등에 따라 챗봇의 활용 범위를 적절하게 설계하는 것이 필요하며, 챗봇 기술을 다양한 학습의 목적과 가치에 부합되게 활용할 수 있는 실천적인 노력이 필요하다.

셋째, 본 연구에서 분석한 플랫폼의 AI 챗봇에서 Affect 요소를 분석한 결과, 전반적으로 자연스러운 대화 과정에서 정서적 안정감을 느낄 수 있도록 학습을 지원하고 있었다. 대화에 큰 어색함은 없었으나, 학습자의 이름을 외우고 표현하는 정서적인 요소나 농담이나 유머를 포함한 대화가 두드러지지는 않았다. 솔미챗은 엉뚱한 질문에도 자연스럽게 대화를 이어가며 수학 관련 학습 주제로 연결하였고, 클래스팅 젤로는 자연스러운 유머를 활용하여 어색하지 않게 본래의 학습 맥락을 되찾아 대화를 이어갔다. 재미나 흥미에는 내재적인 흥미와 상황적인 흥미가 있을 수 있으며, AI 챗봇과 대화하는 경우 학습 내용에 흥미를 느낄 수도 있으나 챗봇과 대화한다는 상황에 흥미를 느낄 수도 있다. 학습 흥미가 높게 나타나면 학습 참여도가 높고 학업성취에 긍정적으로 작용한다[46]. 여러 선행 연구에서 AI 챗봇을 활용한 학습에서 학습자의 흥미를 높였음이 드러났다[47],[48]. 다시 말하면, AI 챗봇이 학습자의 이름을 말하며 자연스럽게 대화하고 유머를 포함한 대화까지 고도화된다면, 학습자의 내재적, 상황적 흥미를 모두 자극하고 결과적으로 학업성취도 및 학습몰입과 같은 교육효과가 있을 것이다.

넷째, 본 연구에서 분석한 플랫폼의 AI 챗봇에서 Accessibility 요소를 분석한 결과, 의미와 의도를 감지하거나(AC1) 학습자의 사회적 신호에 적절하게 반응하며(AC2) 개별화 학습을 지원하고 있었다. 대부분의 챗봇은 질문의 의도를 파악하기 위해 ‘다시 질문해주세요.’와 같은 반응을 보였으며, 모든 플랫폼에서 학습자의 정서를 파악하고 반응하였다. 학습자는 교수자가 학습자가 이해할 때까지 충분히 설명해 주는 것을 원한다[49]. 따라서 AI 챗봇과의 대화를 통해 학습자는 부담 없이 원하는 만큼 반복해서 피드백을 받을 수 있으므로 학습 몰입과 참여에 긍정적인 영향을 주며[1], 이를 고려한 교육용 챗봇을 설계하는 것이 중요하다는 것을 시사한다.

앞서 논의한 사항을 바탕으로 개별화 맞춤형 학습을 지원하는 AI 챗봇 활용 교수·학습에 관한 논의를 종합해보면, 각 요소에서 분석된 챗봇의 품질 특징은 독립적 요소로 분리하여 평가하기보다는 상호 간에 연계되는 관계이자 학습을 촉진하는 대화라는 종합적인 시각에서 평가할 필요가 있다[4]. 따라서 학습을 위한 챗봇과의 대화라는 총체적인 관점에서 Teaching, Humanity, Affect, Accessibility의 요소 간에 연계성을 이해하고 AI 챗봇을 활용한다면, 학습자 주도의 개별화 맞춤형 학습을 실현하는 본질에 더 가까워질 것이다. 본 연구는 챗봇 품질 평가모델의 4가지 요소(Teaching, Humanity, Affect, Accessibility)를 바탕으로 개별화 맞춤형 학습을 지원하는 AI 챗봇에 대한 이해와 평가를 구체화했다는 점에서 의의를 찾을 수 있다. 본 연구를 바탕으로 AI 챗봇의 교육적 품질에 관한 지속적인 평가와 관리를 기대하며, 이후 학습 주제, 구체적인 교육 활용 방안, 다양한 교육적 상황 등에 따라 고도화된 챗봇 시스템 평가 모형이 제안될 필요가 있다.

References

- E. Park, “Meta-Analysis on the Effect of English Education Programs Using AI Chatbots on Language Education Effectiveness,” Journal of the Korea English Education Society, Vol. 22, No. 3, pp. 113-132, August 2023.

- UCL Discovery. Intelligence Unleashed: An Argument for AI in Education [Internet]. Available: https://discovery.ucl.ac.uk/id/eprint/1475756/, .

- W. Holmes, M. Bialik, and C. Fadel, Artificial Intelligence in Education, in Data Ethics: Building Trust : How Digital Technologies Can Serve Humanity, Geneva, Switzerland: Globethics Publications, ch. 42, pp. 621-653, 2023.

-

P. Smutny and P. Schreiberova, “Chatbots for Learning: A Review of Educational Chatbots for the Facebook Messenger,” Computers & Education, Vol. 151, 103862, July 2020.

[https://doi.org/10.1016/j.compedu.2020.103862]

-

C. W. Okonkwo and A. Ade-Ibijola, “Chatbots Applications in Education: A Systematic Review,” Computers & Education: Artificial Intelligence, Vol. 2, 100033, 2021.

[https://doi.org/10.1016/j.caeai.2021.100033]

-

R. Dsouza, S. Sahu, R. Patil, and D. R. Kalbande, “Chat with Bots Intelligently: A Critical Review & Analysis,” in Proceedings of 2019 International Conference on Advances in Computing, Communication and Control (ICAC3), Mumbai, India, pp. 1-6, December 2019.

[https://doi.org/10.1109/ICAC347590.2019.9036844]

- H. J. Kim, S. Yoo, and E. Kim, “AI Chatbot Design and Development Model for Classroom Instruction: Designing Learning Conversations,” Brain, Digital, & Learning, Vol. 10, No. 3, pp. 535-545, December 2020.

-

M. Huang, X. Zhu, and J. Gao, “Challenges in Building Intelligent Open-Domain Dialog Systems,” ACM Transactions on Information Systems, Vol. 38, No. 3, 21, April 2020.

[https://doi.org/10.1145/3383123]

- S. Cunningham-Nelson, W. Boles, L. Trouton, and E. Margerison, “A Review of Chatbots in Education: Practical Steps Forward,” in Proceedings of the 30th Annual Conference for the Australasian Association for Engineering Education (AAEE 2019), Brisbane, Australia, pp. 299-306, December 2019.

-

N. Radziwill and M. Benton, “Evaluating Quality of Chatbots and Intelligent Conversational Agents,” arXiv:1704.04579, , April 2017.

[https://doi.org/10.48550/arXiv.1704.04579]

-

M. Ivanović, A. K. Milićević, V. Aleksić, B. Bratić, and M. Mandić, “Experiences and Perspectives of Technology-Enhanced Learning and Teaching in Higher Education - Serbian Case,” Procedia Computer Science, Vol. 126, pp. 1351-1359, 2018.

[https://doi.org/10.1016/j.procs.2018.08.086]

-

J. Q. Pérez, T. Daradoumis, and J. M. M. Puig, “Rediscovering the Use of Chatbots in Education: A Systematic Literature Review,” Computer Applications in Engineering Education, Vol. 28, No. 6, pp. 1549-1565, November 2020.

[https://doi.org/10.1002/cae.22326]

-

H. M. Kim, “Exploring the Potential Application of a Conversational AI Chatbot in Korean Language Education -An Interaction Analysis between Advanced Learners and ChatGPT-,” The Studies of Korean Language and Literature, No. 76, pp. 261-292, May 2023.

[https://doi.org/10.15711/WR.76.0.9]

- D. K. Shin, “Exploring the Feasibility of AI Chatbots as a Tool for Improving Learners’ Writing Competence of English,” Korean Journal of Teacher Education, Vol. 35, No. 1, pp. 41-55, January 2019.

-

H. Yang, H. Kim, D. Shin, and J. H. Lee, “A Study on Adopting AI-Based Chatbot in Elementary English-Speaking Classes,” Multimedia-Assisted Language Learning, Vol. 22, No. 4, pp. 184-205, December 2019.

[https://doi.org/10.15702/mall.2019.22.4.184]

-

D. Lee, “A Study for the Development of an English Learning Chatbot System Based on Artificial Intelligence,” Secondary English Education, Vol. 11, No. 1, pp. 45-68, February 2018.

[https://doi.org/10.20487/kasee.11.1.201802.45]

-

J. Chang, J. Park, and J. Park, “An Analysis on the Trends of Education Research related to ‘Artificial Intelligence Chatbot’ in Korea: Focusing on Implications for Use in Science Education,” Journal of Learner-Centered Curriculum and Instruction, Vol. 21, No. 13, pp. 729-743, July 2021.

[https://doi.org/10.22251/jlcci.2021.21.13.729]

-

M. Cha, and H. Im, “A Study on University Professors’ Perception on Educational Applicability of ChatGPT in English Classes,” Culture & Convergence, Vol. 45, No. 5, pp. 109-118, May 2023.

[https://doi.org/10.33645/cnc.2023.05.45.05.109]

-

S.-W. Choi, and J.-H. Nam, “The Use of AI Chatbot as An Assistant Tool for SW Education,” Journal of the Korea Institute Of Information and Communication Engineering, Vol. 23, No. 12, pp. 1693-1699, December 2019.

[https://doi.org/10.6109/jkiice.2019.23.12.1693]

-

S. Y. Chu and D. G. Min, “A Study of Using Task-Based Artificial Intelligence(AI) Chatbot for Further Interaction in English and the Analysis of Students’ Production,” Primary English Education, Vol. 25, No. 2, pp. 27-52, June 2019.

[https://doi.org/10.25231/pee.2019.25.2.27]

-

S.-H. Hong, T. Yoon, S. Lee, and E. J. Oh, “An Analysis of Using Dialogue-Based Chatbot in Elementary English Education,” The Journal of Korea Elementary Education, Vol. 31, No. Supplement, pp. S31-S55, January 2021.

[https://doi.org/10.20972/kjee.31..202101.31]

-

A. Park, S. B. Lee, and J. Song, “Application of AI Based Chatbot Technology in the Industry,” Journal of the Korea Society of Computer and Information, Vol. 25, No. 7, pp. 17-25, July 2020.

[https://doi.org/10.9708/jksci.2020.25.07.017]

-

J. H. Jeon, S. Y. Lee, and H. S. Choe, “Beyond ChatGPT: A Conceptual Framework and Systematic Review of Speech-Recognition Chatbots for Language Learning,” Computers & Education, Vol. 206, 104898, December 2023.

[https://doi.org/10.1016/j.compedu.2023.104898]

-

E. Adamopoulou, and L. Moussiades, “Chatbots: History, Technology, and Applications,” Machine Learning with Applications, Vol. 2, 100006, December 2020.

[https://doi.org/10.1016/j.mlwa.2020.100006]

- A. M. Turing, Computing Machinery and Intelligence, in Parsing the Turing Test, Dordrecht, Netherlands: Springer, ch. 3, pp. 23-65, 2009.

- R. S. Wallace, The Anatomy of A.L.I.C.E, in Parsing the Turing Test, Dordrecht, Netherlands: Springer, ch. 13, pp. 181-210, 2009.

-

J. Park and H. Lee, “AI Chatbot Builders Utilizaion Plan to Develop AI Chatbots for Korean Language Education,” Teaching Korean as a Foreign Language, Vol. 63, pp. 51-91, November 2021.

[https://doi.org/10.21716/TKFL.63.3]

-

G.-J. Hwang and C.-Y. Chang, “A Review of Opportunities and Challenges of Chatbots in Education,” Interactive Learning Environments, Vol. 31, No. 7, pp. 4099-4112, 2023.

[https://doi.org/10.1080/10494820.2021.1952615]

- S. K. Kim, M. C. Shin, and J. Y. Kang, “Introduction to Chatbot Technology and Case Analysis,” KICS Information & Communication Magazine - Open Lecture Series, Vol. 35, No. 2, pp. 21-28, November 2018.

-

H. Cha, “A Development Study of User-Friendly Design Guidelines for Chatbot Tutor,” The Journal of Korean Association of Computer Education, Vol. 26, No. 5, pp. 79-92, September 2023.

[https://doi.org/10.32431/kace.2023.26.5.007]

-

S. Ondáš, M. Pleva, and D. Hládek, “How Chatbots Can Be Involved in the Education Process,” in Proceedings of the 17th International Conference on Emerging eLearning Technologies and Applications (ICETA), Starý Smokovec, Slovakia, pp. 575-580, November 2019.

[https://doi.org/10.1109/ICETA48886.2019.9040095]

-

S. Kim and M. K. Cho, “AI-Based Educational Platform Analysis Supporting Personalized Mathematics Learning,” Communications of Mathematical Education, Vol. 36, No. 3, pp. 417-438, September 2022.

[https://doi.org/10.7468/jksmee.2022.36.3.417]

-

M. Park and Y. B. Yoon, “How Well Do Elementary School English Textbooks Address Pronunciation?,” Primary English Education, Vol. 25, No. 2, pp. 155-179, June 2019.

[https://doi.org/10.25231/pee.2019.25.2.155]

- Korea Institute for Curriculum and Evaluation, Concept and Use of Artificial Intelligence (AI) in School Education, Author, Jincheon, ORM 2020-21-3, June 2020.

-

A. P. Saygin, I. Cicekli, and V. Akman, “Turing Test: 50 Years Later,” Minds and Machines, Vol. 10, pp. 463-518, November 2000.

[https://doi.org/10.1023/A:1011288000451]

- Incheon Bukbu Office of Education. Plan for the 2023 Northern Creative Math Camp [Internet]. Available: https://bukbu.ice.go.kr/bbs/data/view.do?menu_idx=235&bbs_mst_idx=BM0000000167&data_idx=BD0000039205, .

-

J. Jeon, S. Lee, and S. Choi, “A Systematic Review of Research on Speech-Recognition Chatbots for Language Learning: Implications for Future Directions in the Era of Large Language Models,” Interactive Learning Environments, 2023.

[https://doi.org/10.1080/10494820.2023.2204343]

- Korea Foundation for the Advancement of Science and Creativity. Online Coding Party [Internet]. Available: https://www.kofac.re.kr/brd/board/539/L/CATEGORY/940/menu/936?brdCodeField=CATEGORY&brdCodeValue=940, .

- J. H. Joo, B. K. Kim, A. R. Kim, Y. J. Im, S. B. Im, Y. J. Lee, and J. H. Park, Possibilities and Challenges of Individualized AI education: Focusing on the Case of the ‘AI Tutor Pickup School’ Operation, Seoul Education Research & Information Institute, Seoul, SERII 2022-77, pp. 47-97, December 2012.

-

D. Ramandanis and S. Xinogalos, “Investigating the Support Provided by Chatbots to Educational Institutions and Their Students: A Systematic Literature Review,” Multimodal Technologies and Interaction, Vol. 7, No. 11, 103, November 2023.

[https://doi.org/10.3390/mti7110103]

-

W. M. A. F. Wan Hamzah, I. Ismail, M. K. Yusof, S. I. Mohd Saany, and A. Yacob, “Using Learning Analytics to Explore Responses from Student Conversations with Chatbot for Education,” International Journal of Engineering Pedagogy, Vol. 11, No. 6, pp. 70-84, December 2021.

[https://doi.org/10.3991/ijep.v11i6.23475]

-

A. T. Neumann, T. Arndt, L. Köbis, R. Meissner, A. Martin, P. de Lange, ... and H.-W. Wollersheim, “Chatbots as a Tool to Scale Mentoring Processes: Individually Supporting Self-Study in Higher Education,” Frontiers in Artificial Intelligence, Vol. 4, 668220, May 2021.

[https://doi.org/10.3389/frai.2021.668220]

-

C. S. González-González, V. Muñoz-Cruz, P. A. Toledo-Delgado, and E. Nacimiento-García, “Personalized Gamification for Learning: A Reactive Chatbot Architecture Proposal,” Sensors, Vol. 23, No. 1, 545, January 2023.

[https://doi.org/10.3390/s23010545]

-

E. Ericsson, S. S. Hashemi, and J. Lundin, “Fun and Frustrating: Students’ Perspectives on Practising Speaking English with Virtual Humans,” Cogent Education, Vol. 10, No. 1, 2170088, 2023.

[https://doi.org/10.1080/2331186X.2023.2170088]

-

M. T. H. Chi, N. De Leeuw, M.-H. Chiu, and C. Lavancher, “Eliciting Self-Explanations Improves Understanding,” Cognitive Science, Vol. 18, No. 3, pp. 439-477, July-September 1994.

[https://doi.org/10.1016/0364-0213(94)90016-7]

- P. R. Pintrich and D. H. Schunk, Motivation in Education: Theory, Research, and Applications, 2nd ed. Upper Saddle River, NJ: Prentice Hall.

-

N.-Y. Kim, “A Study on Chatbots for Developing Korean College Students’ English Listening and Reading Skills,” Journal of Digital Convergence, Vol. 16, No. 8, pp. 19-26, August 2018.

[https://doi.org/10.14400/JDC.2018.16.8.019]

- J. H. Jang and J. R. Kim, Effect of Elementary English Speaking Class Using AI PengTalk, Journal of the Elementary Education Society, No. 37, pp. 37-55, August 2022.

-

J. Yu and J. Byun, “A Case Study of EFL Learners and ESL Instructor’s Responses to Corrective Feedback in English Immersion Environment,” Journal of the Korea English Education Society, Vol. 18, No. 2, pp. 143-160, May 2019.

[https://doi.org/10.18649/jkees.2019.18.2.143]

저자소개

2021년:한양대학교 대학원(교육공학 석사)

2023년~현 재: 한양대학교 대학원 교육공학과 박사과정

※관심분야:교수설계, 이러닝(E-learning), AI 리터러시, 학습생태계

2022년:한국공학대학교(미디어디자인공학과 학사)

2023년~현 재: 한양대학교 대학원 교육공학과 석사과정

※관심분야:이러닝(E-learning), 컴퓨터기반 협력학습(CSCL)

2022년:동아대학교(교육학과 학사)

2023년~현 재: 한양대학교 대학원 교육공학과 석사과정

※관심분야:HRD, 이러닝(E-learning)

1993년:플로리다주립대학교 대학원(교육공학 박사)

1991년:한양대학교 대학원(교육공학 석사)

2001년~현 재: 한양대학교 사범대학 교육공학과 교수

※관심분야:지식생태학

2018년:한양대학교 대학원(교육공학 박사)

2019년~2021년: 단국대학교 교양교육대학 코딩교과

2021년~현 재: 한양대학교 사범대학 교육공학과

※관심분야:이러닝(E-learning), 컴퓨터기반 협력학습(CSCL), 교수설계(Instructional Design), AI 리터러시