실시간 사족보행 동물 캐릭터 리그 시스템 개발

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 영화, 애니메이션뿐만 아니라 게임, 가상현실(VR), 증강현실(AR) 등 다양한 실감형 콘텐츠에서 사족보행 동물 캐릭터를 효율적으로 활용하기 위한 실시간 캐릭터 리그를 제안한다. 본 연구에서 제안하는 시스템은 영화 제작 파이프라인과 실시간 콘텐츠 제작 파이프라인을 효과적으로 통합하는 접근 방식을 취한다. 이는 ‘메타휴먼’이 가진 개념과 동일하며, 사족보행 동물 캐릭터의 제작과정을 하나로 결합하고 데이터를 공유하는 형태로 구현했다. 본 연구는 산업 동향에 맞춘 사족보행 동물 제작 가이드를 제공함으로써, 동물 캐릭터를 포함한 실감형 콘텐츠의 기획, 연출 및 기술 개발 등 콘텐츠 제작의 다양한 분야에 실질적으로 기여할 것으로 기대된다.

Abstract

This paper proposes a real-time character rig system for efficiently utilizing quadruped animal characters in various immersive content types, including film, animation, games, virtual reality (VR), and augmented reality (AR). The proposed system effectively integrates the film production and real-time content creation pipelines. This approach mirrors the concept of “MetaHuman,” combining the production process of quadruped animal characters into a unified workflow and facilitating data sharing. We developed a program executable in Maya, which automatically generates a character rig system when a user inputs a model. This study provides a quadruped animal production guide aligned with industry trends and is expected to make a substantial contribution to various aspects of content creation, including planning, direction, and technical development of immersive content featuring animal characters.

Keywords:

Quadruped Animal, Character Rig System, Procedural Rigging, Real-time, Artificial Intelligence키워드:

사족보행 동물, 캐릭터 리그 시스템, 절차적 리깅, 실시간성, 인공지능Ⅰ. 서 론

메타버스(Metaverse)의 등장과 함께 영화, 애니메이션, 게임뿐만 아니라 가상현실(Virtual Reality, 이하 VR), 증강현실(Augmented Reality, 이하 AR) 등 실감형 콘텐츠 산업이 급속도로 성장하고 있으며, 이에 따라 캐릭터 제작과 기술 개발에 대한 수요가 증가하고 있다. 글로벌 시장조사업체인 이머전 리서치(Emergen Research)는 버추얼 휴먼(Virtual Human)이 차지하는 시장규모가 2020년 100억 달러(약 12조 7,500억 원)부터 연평균 36.4%씩 성장을 거듭하여 2030년에는 5,275억 달러(약 700조 원)에 다다를 것으로 전망했다[1].

실시간 콘텐츠 시장이 발전함에 따라 캐릭터 제작 시장의 패러다임에도 변화가 요구되고 있다. 영화와 애니메이션 분야에서 사용되어왔던 고품질·고비용의 캐릭터 리그 시스템은 이제 실시간 콘텐츠에 적용될 가능성을 모색하고 있다. 이러한 변화를 주도하고 있는 것은 해외 메이저 스튜디오들이며, 그중에서도 월트 디즈니 애니메이션 스튜디오(Walt Disney Animation Studios)와 드림웍스 애니메이션(Dreamworks Animation)은 이를 연구하고 있는 주요 기업으로 주목받고 있다[2]-[4]. 실시간 게임엔진의 선두주자인 유니티(Unity)와 에픽게임즈(Epic Games)도 이들과 유사한 행보를 보여주고 있다. 유니티의 경우, 최근 웨타 디지털(Weta Digital)과 지바 다이나믹스(Ziva Dynamics)를 인수하면서 영화 시각효과(Visual Effects, 이하 VFX)에서만 사용되었던 고품질의 3차원 가상 캐릭터 제작 기술을 실시간 콘텐츠에도 적용하려는 계획을 발표했다[5]. 에픽게임즈에서 2021년 발표한 메타휴먼(MetaHuman)은 현재 실시간 콘텐츠 분야에서 디지털 휴먼(Digital Human) 제작의 표준으로 여겨지며[6],[7], 비단 사람뿐만 아니라 다른 이족보행 캐릭터를 제작하는 핵심 자료로 사용되고 있다. 이러한 산업 동향은 실시간을 고려한 가상 캐릭터 제작 기술의 중요성이 부각 되고 있음을 보여준다.

한편, 디지털 휴먼이 등장하기 이전부터 동물 캐릭터는 오랫동안 소비자들에게 호기심과 친근감을 불러일으키며 다양한 콘텐츠에서 인기 있는 배우로 등장했다. 특히 사족보행 동물로 표현되는 캐릭터들은 지금까지 영화와 애니메이션 산업에서 중요한 위치를 차지해 왔으며, 이러한 사족보행 동물 캐릭터들의 사실적인 묘사에 대한 수요는 지속될 것으로 예상 된다[8]. 사족보행 동물 캐릭터 제작과 관련하여 진행되었던 선행연구를 유형화해 보면, 페이셜 리그(Facial Rig) 및 모션 표현[9]-[11], 바디 리그(Body Rig) 및 모션 표현[9],[12]-[17], 머슬(Muscle), 헤어(Hair), 퍼(Fur) 등 캐릭터 이펙트(Character Effects)와 시뮬레이션 관련 연구[9],[18]-[20], 파이프라인 자동화 및 최적화 연구[9],[20]-[23], AI 활용 연구[24],[25] 등이 연구 주제로 다루어졌다. 실감형 콘텐츠 산업 시장의 성장과 함께 실시간 캐릭터 제작의 기술 수요가 높아지면서 디지털 휴먼과 이족보행 캐릭터 제작 연구에 대한 관심이 증폭되고 있는 반면에, 실시간 기반의 사족보행 동물 표현을 위한 연구 성과는 정성적∙ 정량적으로 미흡한 상황이다.

이에 본 연구에서는 영화, 애니메이션뿐만 아니라 게임, VR, AR 등 실감형 콘텐츠에서도 높은 품질의 동물 캐릭터를 효과적으로 활용할 수 있도록 하는 실시간 기반의 사족보행 동물 캐릭터 리그 시스템을 제안한다. 본 연구에서 제시하는 시스템은 영화 제작과 실시간 콘텐츠 제작의 파이프라인을 효과적으로 결합하는 접근법을 적용한다. 이에, 제안된 시스템은 언리얼 엔진의 메타휴먼 프레임워크를 참조하여 개발되었으며, 기본적으로 사용자가 주어진 동물의 메시(Mesh)에 뼈의 위치를 지정하면 일련의 캐릭터 리그를 생성하는 절차적 리깅(Procedural Rigging) 방식을 따른다.

동물과 인간의 상호 작용은 스토리텔링의 깊이를 더하며, 실감형 콘텐츠 내 동물 캐릭터의 실감 나는 묘사는 관객이 몰입감을 느낄 수 있도록 하기 위한 필수적인 요소이다. 그러나 현재 VR, AR과 같은 실감형 콘텐츠 산업에서는 고품질의 실시간 사족보행 동물 캐릭터 리그 도입이 미비한 상황이다. 따라서 본 연구는 제안하는 실시간 기반의 사족보행 동물 캐릭터 리그 시스템을 통해, 실감형 콘텐츠 내에서도 높은 품질의 동물 캐릭터를 활용하는 데 도움을 줄 수 있을 것이다. 학술적 측면에서, 본 논문은 이론적 고찰을 통해 사족보행 동물 캐릭터 리깅에 대한 학문적 기반으로 활용될 수 있으며, 실감형 콘텐츠에서 활용 가능한 사족보행 동물 리그 시스템을 제안함으로써 실시간 캐릭터 리그 관련 연구 방향을 제시할 수 있을 것이다. 한편, 산업 동향을 반영한 사족보행 동물 제작 가이드를 제시함으로써, 실무적 측면에서 본 연구의 결과는 동물 캐릭터가 등장하는 실감형 콘텐츠의 기획 및 연출, 기술 개발 등 콘텐츠 제작 분야 전반에 기여할 것으로 기대한다.

Ⅱ. 관련 연구

2-1 절차적 리깅

캐릭터 리그(Character Rig)는 3차원 컴퓨터 애니메이션 분야의 핵심 구성요소로, 3차원 가상 캐릭터 모델의 디지털 골격을 나타낸다[21]. 캐릭터 리그의 개념은 실제 생물학적 시스템에 비유할 수 있다. 예컨대 특정 생물체의 움직임이 그의 뼈와 관절에 의해 조절되는 것과 유사하게, 캐릭터 리그는 캐릭터의 실제적인 움직임과 관절의 구동을 가이드하는 기본 구조 역할을 한다. 캐릭터 리그는 상호 연결된 조인트(Joint), 디포머(Deformer), 컨트롤(Control) 등으로 구성되며, 이들은 일련의 시스템에 의해 최종적으로 3차원 캐릭터 모델에 매핑(Mapping)된다[2],[9]. 따라서, 캐릭터 리그는 3차원 가상 캐릭터의 모든 움직임을 정의하고 제어하기 위한 프레임워크로 해석될 수 있다.

캐릭터 리깅은 뼈와 관절을 만들어 캐릭터의 동작 시스템을 구성하는 작업이다. 테크니컬 디렉터(Technical Director, 이하 TD) 또는 리거(Rigger)는 캐릭터의 몸 각 부분에 해당하는 뼈를 만들고, 이를 연결하여 자연스러운 움직임이 가능하도록 캐릭터 리그를 설계한다. 대부분의 캐릭터 리그는 스켈레탈 모션 시스템(Skeletal Motion System)과 디포메이션 시스템(Deformation System)의 두 가지 주요 구성요소로 이루어진다[9](그림 1). 스켈레탈 모션 시스템은 포즈를 지정하는 입력 파라미터를 뼈와 관절로 구성된 캐릭터의 스켈레톤 구성에 매핑하는 역할을 담당한다. 다음으로, 디포메이션 시스템이 스켈레톤 구성을 최종 메시의 지오메트리(Geometry)에 매핑한다. 디포메이션 시스템은 캐릭터의 피부가 움직이는 방식을 결정하고 근육의 부풀어 오름, 피부 주름과 같은 효과를 구동하는 역할을 한다.

사족보행 동물 캐릭터를 수동으로 리깅하는 것은 프로젝트 내 모든 캐릭터에 대해 진행하기에 매우 비효율적인 프로세스이다. 이는 캐릭터 제작에 불필요하게 많은 시간을 소모하여 결과적으로 파이프라인을 운영하는 데 있어 여러 문제를 발생시킨다[26],[27]. 반면, 절차적 기법을 사용하여 사족보행 캐릭터 리그를 자동으로 생성할 경우, 스켈레탈 모션 시스템 및 디포메이션 시스템을 구축하는 데 소모되는 시간을 단축할 수 있다. 따라서 캐릭터 리그 시스템을 자동화 및 모듈화하는 것은 캐릭터 제작 파이프라인에서 필수적이다. 또한, 캐릭터 리그는 엔드유저(End User)인 애니메이터의 입장을 고려하여 조작방식이 일관되고, 인터랙션 결과를 예측가능하며, 가볍게 사용할 수 있도록 제작되어야 한다<표 1>. 캐릭터 리그의 제어를 위한 컨트롤러는 3차원 뷰포트(3D Viewport) 또는 그래픽 사용자 인터페이스(Graphical User Interface, GUI)의 형태로 제공된다. 애니메이터는 이를 통해 조인트, 로케이터(Locator), 스플라인 커브(Spline Curve) 등을 선택하여 캐릭터의 움직임을 생성할 수 있다.

2-2 실시간 캐릭터 리그와 인공지능

게임이나 VR, AR과 같은 인터랙티브 애플리케이션에서 구동할 수 있는 캐릭터 리그는 일반적으로 설계 과정에서 컴퓨팅 계산 비용의 제약을 받는다. 이러한 유형의 캐릭터 리그는 실시간 인터랙션을 위해 가능한 한 빠른 연산이 이루어져야 하므로, 캐릭터 리그가 가진 디테일 수준이 높지 않아야 하기 때문이다. 이에 게임, VR, AR 분야에서 캐릭터 리그를 조인트와 블렌드쉐입(Blendshape)만으로 구성하는 것은 실시간 캐릭터의 움직임을 효과적으로 표현하기 위한 대표적인 방법이다. 조인트는 디포메이션 시스템에서 가장 가벼운 연산을 수행하지만, 다른 디포머를 사용했을 때보다 디테일이나 자유로운 표현에 한계가 있다. 반면, 영화 VFX 및 애니메이션에서 사용되는 캐릭터 리그는 시스템 연산량의 제약을 거의 받지 않기 때문에 디포메이션을 더욱 세밀하게 설계할 수 있다. 하지만 영화나 애니메이션용 캐릭터 리그는 시스템이 복잡하고 계산량이 많아 실시간 콘텐츠에 사용하기에 적합하지 않다.

캐릭터 제작과 관련한 컴퓨터 그래픽스(Computer Graphics, 이하 CG) 기술 수준과 업계 흐름의 변화는 인공지능(Artificial Intelligence, 이하 AI) 기술이 도입되면서부터 본격적으로 가속화되었다. 최근 몇 년간 발표되고 있는 VFX 및 CG 관련 연구와 제작사례들을 살펴보면, 머신러닝(Machine Learning)과 딥러닝(Deep Learning)을 이용하여 과거에 대처하지 못했던 문제를 해결하거나 성능을 고도화하는 연구가 증가하고 있다[28],[29]. 특히, 최근 AI가 콘텐츠 프로덕션에 활용되기 시작하면서 학계에서는 실시간 캐릭터 리그 설계 시 AI를 통해 근사치를 학습하는 데이터 기반의 접근 방식을 제안하고 있다(표 2). Bailey 외 그의 연구팀[2],[4]은 캐릭터 리그의 디포메이션 시스템에서 발생하는 메시의 비선형 부분을 근사화하기 위해 다층 퍼셉트론(MLP; multi-layer perceptron)과 합성 곱 신경망(CNN; convolutional neural network) 개념을 도입하였다. Radzihovsky와 그의 연구팀이 개발한 Face Baker[3]는 딥러닝을 기반으로 3차원 캐릭터의 버텍스(Vertex) 기반 디포메이션 정보를 학습시켜 새로운 애니메이션 입력에 대해 3차원 모델의 스킨 웨이트(Skin Weight)를 예측한다. 한편, 실시간 게임엔진에서도 AI가 접목된 캐릭터 제작 솔루션을 적극적으로 도입하고 있다. 언리얼 엔진은 VFX 분야에서만 주로 사용되었던 정교하고 복잡한 디포메이션을 실시간 언리얼 엔진 내 캐릭터 표현에서도 활용하기 위해 머신러닝 디포머(ML Deformer; machine learning deformer)를 도입하였다[30]. 머신러닝 디포머가 언리얼 엔진에 플러그인 형태로 통합되어 있어, 아티스트들은 해당 기술에 더 쉽게 접근하여 활용할 수 있다. 이러한 구성은 아티스트들로 하여금 복잡한 프로그래밍 또는 기술적인 세부 사항을 깊이 이해하지 않고도 머신러닝 기반의 고급 디포메이션 기능을 사용할 수 있게 해준다는 장점이 있다. 이는 작업 효율성을 높이고, 시각적으로 더 풍부하고 정교한 결과물을 손쉽게 생성할 수 있게 한다.

2-3 메타휴먼

콘텐츠 르네상스의 시대에 아티스트와 스튜디오가 직면한 과제 중 하나는 영화, 애니메이션, 게임 및 기타 디지털 매체에 활용 가능한 실사의 캐릭터를 개발하는 데에 너무 많은 시간이 소요된다는 점이다. 현대 소비자의 기준에 충족하는 캐릭터의 제작을 위해 필요한 수많은 제작단계와 전문 지식을 고려할 경우 이러한 문제점은 더욱 두드러진다. 하지만 2021년 2월, 에픽게임즈의 디지털 휴먼 기술 개발팀인 쓰리래터럴(3Lateral)이 메타휴먼 크리에이터(MetaHuman Creator)를 출시하면서, 캐릭터 제작 시장에는 큰 변화가 일어났다[31].

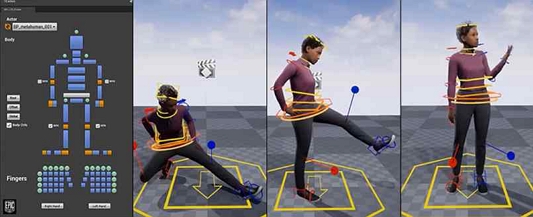

메타휴먼 크리에이터는 머신러닝과 실시간 렌더링(Real-time Rendering) 등의 최첨단 기술을 사용하여 영화, 애니메이션, 버추얼 프로덕션(Virtual Production) 및 기타 디지털 미디어에 사용할 실사 캐릭터를 제작하는 프로세스를 간소화한 클라우드 기반 플랫폼이다. 기존의 디지털 휴먼과 달리 메타휴먼은 사전 데이터를 기반으로 쉽고 빠르게 제작될 수 있으며, 높은 그래픽 품질을 가지고 있어 차세대 디지털 휴먼의 대명사로 여겨지고 있다[6]. 또한, 메타휴먼 캐릭터에는 페이셜 리그, 바디 컨트롤 리그, 고품질의 머티리얼(Material)이 내장되어 있으며, 최종 결과물은 익스포트(export)하여 언리얼 엔진 프로젝트 또는 해당 포맷을 지원하는 다른 애플리케이션에서 사용할 수 있다(그림 2). 따라서 파이프라인 자동화의 관점에서 볼 때 메타휴먼 크리에이터의 도입은 캐릭터 제작 기법의 획기적인 도약을 의미한다.

Ⅲ. 실시간 캐릭터 리그 시스템의 제안

3-1 시스템 개요

영화 VFX 수준의 고품질 리그를 사용하는 데는 여러 가지 어려움이 존재한다. 이러한 리그는 비용이 많이 드는 디포메이션 계산을 요구하며, 예컨대 마야와 같은 특정 소프트웨어 환경에 최적화되어 있는 캐릭터 리그의 경우 다른 외부 환경이나 소프트웨어 플랫폼으로 이식할 수 없다. 또한, 고도로 복잡한 리그의 유지 관리는 기술적으로 어려우므로 새로운 프로젝트에 재사용하기 까다롭다. 이런 복잡성은 리그의 적응성을 제한할 뿐만 아니라, 다양한 제작 파이프라인에 효과적으로 통합하기 위한 시간과 자원 투자를 증가시킨다.

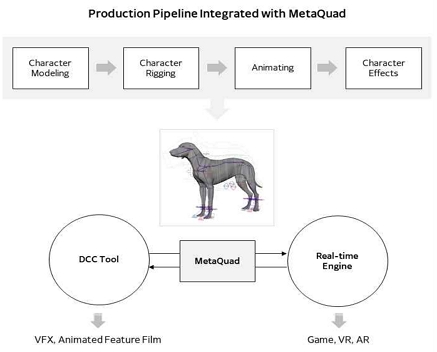

본 연구에서 제안하는 시스템은 영화 제작 파이프라인과 실시간 콘텐츠 제작 파이프라인을 효과적으로 통합하는 접근 방식을 취한다. 이는 ‘메타휴먼’이 가진 개념과 동일하며, 사족보행 동물 캐릭터의 제작과정을 하나로 결합하고 데이터를 공유하는 형태로 구현함으로써, 효율적인 실시간 캐릭터 리그 관리가 가능하게 하는 시스템을 의미한다(그림 3). 이는 개발 과정에서 시간과 자원을 절약하는 동시에, 영화 VFX 캐릭터의 품질과 현실감을 유지하면서 실시간 콘텐츠 제작의 다양한 요구 사항을 충족시킬 수 있다. 이를 통해 제작자들은 더 빠르고 효율적으로 사족보행 동물 캐릭터를 제작할 수 있으며, 다른 플랫폼에서의 적용이 용이하게 된다. 본 연구는 실시간 캐릭터 리그 시스템 개발 과정에서 ‘메타휴먼’의 개념이나 데이터 형식을 다수 참고하였다. 따라서, 이하의 본문에서는 용어 사용의 편의를 위해 해당 연구에서 제안하는 실시간 사족보행 동물 캐릭터 리그 시스템을 '메타쿼드(MetaQuad)'라고 지칭한다.

본 연구에서는 다양한 사족보행 동물 중에서 개과(Canine) 동물 캐릭터를 사용해 연구를 진행한다. 개과 동물은 일상생활 속에서 인간과 밀접한 관계를 맺으며 교감을 나누는 대표적인 동물이기 때문에, 이들을 중심으로 한 이야기는 관람객들에게 있어 높은 공감대와 몰입감을 제공할 수 있다. 따라서, 개과 동물을 기준으로 진행되는 해당 연구는 VR, AR 등 실감형 콘텐츠 제작에 있어 활용가치가 높으며, 제작, 개발뿐만 아니라 기획, 연출 등 다양한 측면에서 유용한 인사이트를 제공할 것으로 기대된다. 또한, 개과 동물을 시작으로, 향후 다른 사족보행 동물 캐릭터도 손쉽게 표현할 수 있을 것이다.

선행연구와 산업 동향을 반영하여, 제안된 메타쿼드는 표 3의 세 가지 주요관점에 따라 설계된다. 첫 번째는 ‘동물 해부학 및 행동학 관점’으로, 이는 동물 캐릭터의 사실적인 외모와 움직임의 표현과 관련이 있다. 다음으로, ‘제작 파이프라인 관점’에서는 절차적 기법, 모듈화, 자동화를 통한 효율성 강화에 초점을 둔다. 마지막으로, ‘사용자 경험 관점’은 애니메이터 등의 아티스트가 쉽게 이해하고 접근할 수 있는 UI의 설계에 중점을 둔다. 상술한 세 가지 관점은 메타쿼드의 효과적인 설계와 사용에 대한 포괄적인 접근을 제공한다.

3-2 연구 캐릭터 모델 선정

메타쿼드는 주로 영화 VFX에서 볼 수 있는 고품질 캐릭터 제작 기술을 게임, VR, AR과 같은 실시간 기반의 콘텐츠에 적용하기 위해 제안된 실시간 캐릭터 리그 시스템이다. 메타쿼드는 사실적인 외모와 움직임의 표현을 중시하며, ‘개 모델이 실제 동물의 모습을 얼마나 정확하게 재현하고 있는가?’, ‘개 캐릭터의 움직임이 얼마나 실감 나게 표현되고 있는가?’와 같은 요소들이 주요 관건이 된다. 이는 VFX나 애니메이션 분야의 고품질 프로덕션과 마찬가지로 여전히 모델러(Modeler), 애니메이터 등과 같은 아티스트의 작업에 의존할 수밖에 없다.

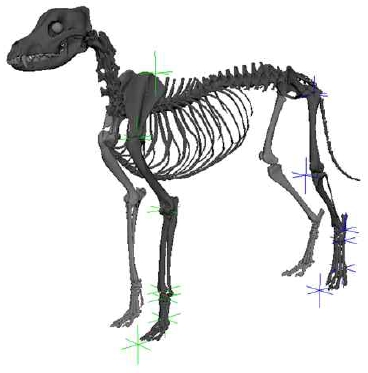

이에 본 연구는 실제 동물에 가깝게 제작된 개과 동물 모델을 활용하여 수행되었으며, 이 중 그레이하운드(Greyhound) 종을 제작 대상으로 선택했다. 모델은 뼈, 근육, 피부로 나뉘어 모델링 되어있어 해부학 레이어로 구분하여 메타쿼드 시스템을 설계할 수 있다(그림 4). 그레이하운드는 개과 동물중에서도 팔다리가 길며 운동량이 많아 근육이 잘 발달된 특징을 가지고 있어, 실시간 캐릭터 리그의 연구대상으로서 디포메이션을 표현하기에 적합하다. 이를 통해 메타쿼드 시스템을 활용하여 실시간 콘텐츠에서 고품질의 동물 캐릭터를 구현할 경우, 정성적인 측면에서 평가하기에 용이하다. 한편, 개과 동물의 앞다리와 뒷다리는 해부학적으로 다른 구조로 되어 있기 때문에, 각각에 맞는 형태로 스켈레톤과 리그 시스템을 디자인해야 한다. 예컨대, 개과 동물의 앞다리와 뒷다리의 무릎이 접히는 방향은 서로 반대이며, 앞발에는 발가락이 5개, 뒷발에는 발가락이 4개 존재한다.

3-3 캐릭터 리그 시스템 설계

다양한 제작 도구와 환경이 혼합된 상황에서 반복작업의 자동화와 모듈화는 생산성과 데이터 관리의 효율성을 향상시킨다. 특히, 최근 콘텐츠 시장 전반에 빠르게 도입되고 있는 게임엔진을 중심으로 운영되는 제작 파이프라인에 주목할 필요가 있으며, 실시간성을 확보하기 위해 최적화 방식에 대해 고민해야 한다.

본 연구에서는 메타휴먼의 데이터 형식을 기반으로 메타쿼드를 구성했다. 메타쿼드의 데이터 구조는 다음의 세 가지 주요 부분으로 구성된다: 지오메트리, 모션 시스템, 디포메이션 시스템. 캐릭터의 외형을 구성하는 뼈, 근육, 피부 등의 3차원 실사 모델이 지오메트리 부분에 해당한다. 모션 시스템에는 사용자가 캐릭터의 포즈를 입력하는 데 사용하는 컨트롤러와 스켈레톤의 움직임을 나타내는 IK(Inverse Kinematics), FK(Forward Kinematics), Stretch 기능이 포함된다. IK는 각 관절의 최종 위치를 기반으로 전체 뼈대의 움직임을 계산하는 방식으로, 캐릭터의 발(Foot)과 같은 신체의 끝부분을 조작할 때 자연스러운 움직임을 생성하는 데 효과적이다. 반대로, FK는 관절의 계층적 구조를 따라 움직임을 생성하는 방식으로, 연속적인 움직임을 구현하는 데 유용하다. Stretch는 캐릭터의 관절이나 뼈대가 물리적 한계를 넘어서 늘어나거나 줄어들 수 있게 해주며, 이는 동적인 애니메이션을 가능하게 한다. 디포메이션 시스템은 캐릭터의 피부나 근육과 같은 비골격적 구조의 움직임을 제어하는 역할을 한다. 특히, 스킨웨이트 정보는 메타쿼드 내에서 하나의 버텍스가 여러 조인트의 영향을 얼마나 받을지를 결정하는 수치로, 캐릭터의 각 신체부위가 어떻게 변형되고 움직일지 결정하는 중요한 역할을 한다. 따라서 적절한 스킨 웨이트 설정은 캐릭터의 움직임을 정확하고 섬세하게 표현하는 데 필수적인 요소로, 실시간 캐릭터 리그 시스템에서 효과적인 디포메이션을 구현하는 데 기여한다. 한편 조인트만으로 디포메이션을 표현하는 것은 시뮬레이션이나 다른 여러 가지 디포머를 사용했을 경우와 비교했을 때 품질 차이가 크게 발생한다. 우리는 머신러닝 디포머를 활용함으로써, 디지털 콘텐츠 제작(Digital Content Creation, 이하 DCC)툴에서 구현한 정교한 플레시 시뮬레이션(Flesh Simulation)을 실시간 엔진에서 표현하고자 하였다.

3-4 메타쿼드 생성 프로그램 구현

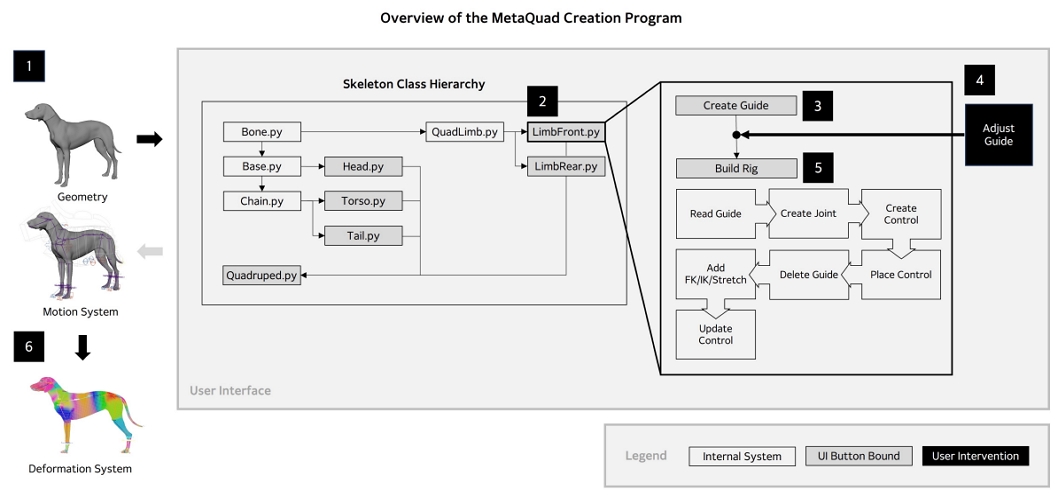

본 연구는 제안된 메타쿼드를 자동으로 생성하는 프로그램을 개발하기 위해 파이썬(Python) 라이브러리와 오토데스크 마야 소프트웨어의 파이썬 라이브러리를 사용하였다. 연구자는 사족보행 동물 캐릭터의 신체 구조를 얼굴, 몸통, 앞다리, 뒷다리, 꼬리의 다섯 부분으로 나누었으며 각각의 신체 구조에 대하여 절차적 리깅이 가능하도록 구성했다. 이 시스템은 생성 프로그램 내에서 클래스로 구분되어 있으며, 클래스의 모듈화 특성을 반영하여 설계되었다. 부모 클래스와 자식 클래스 간의 관계를 바탕으로 하는 이러한 설계 방식은 각 클래스가 독립적인 기능을 수행하면서도 전체 시스템 내에서 상호 작용할 수 있도록 함으로써, 시스템의 유연성과 확장성을 높여준다. 또한, 모듈화된 구조는 리그 시스템의 복잡성을 관리하고, 유지 및 보수를 용이하게 하는 데 중요한 역할을 한다. 그림 5는 메타쿼드 생성 프로그램에 내장된 클래스의 구조를 보여준다. 한편, 컨트롤러 생성 및 Constrain 적용 등 모션 시스템에 해당하는 범위는 자동화 구현을 완료하였으나, 정교한 표현을 위해 조인트와 지오메트리 사이의 상호 작용을 정의하는 스키닝 등 디포메이션 시스템에 대해서는 아직 사용자의 개입이 필요할 것으로 보인다.

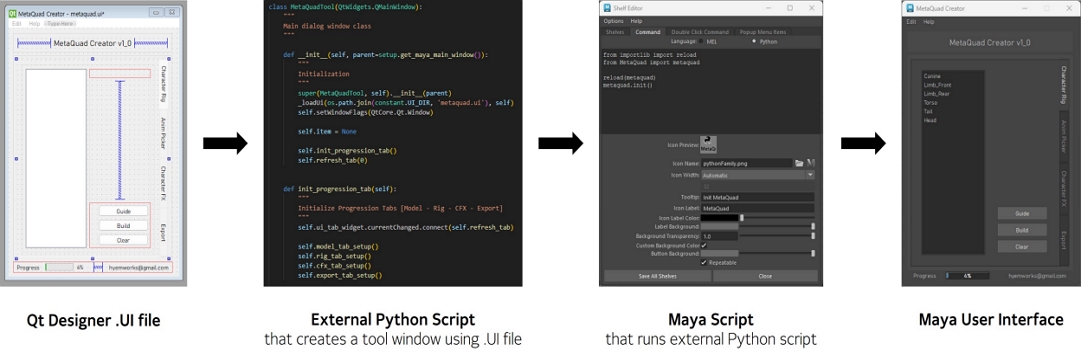

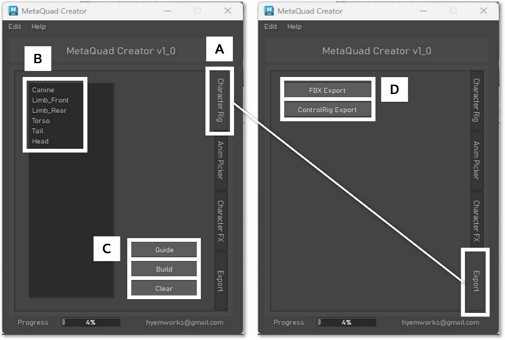

한편, 메타쿼드 생성 프로그램을 아티스트 등의 사용자가 사용하기 간편하게 하도록 사용자 인터페이스(User Interface, 이하 UI)를 개발했다. 마야에서의 메타쿼드 생성 프로그램의 UI는 그림 5와 같으며, 사용자는 ‘UI Button Bound’에 해당하는 버튼을 누름으로써 각각의 기능에 접근할 수 있다. 우리는 QtDesigner를 사용해 UI의 시각적 요소를 디자인하였으며, PyQt를 통해 마야 내부 기능과 통합을 진행했다. 우리는 오토데스크 마야의 Shelf 창에 프로그램 실행 버튼을 추가하였다. 해당 버튼은 외부의 파이썬 모듈이 UI 확장자 파일을 읽어와 마야 내부에서 사용자 창을 생성하는 함수를 호출하여 작동한다. 상술한 바와 같이, 마야 내에서 PyQt를 기반으로 프로그램이 동작하는 방식을 정리하면 그림 6과 같다. 우리가 메타쿼드 생성 프로그램에서 구현한 기능은 캐릭터 리그 시스템을 자동으로 생성하고, 언리얼 엔진으로 익스포트하는 부분에 해당한다. 그림 7에서 보면, 본 연구에서 개발한 메타쿼드 생성 프로그램은 크게 네 가지의 카테고리로 나누어져 있다.: ‘Character Rig’, ‘Anim Picker’, ‘Character FX’, ‘Export’. 이번 논문에서는 ‘Character Rig’와 ‘Export’ 부분만을 다뤘다.

3-5 사용자 인터페이스

본 절에서는 그림 7의 UI를 기준으로 메타쿼드 생성 프로그램의 활용방법에 대해 설명한다. [A]는 앞서 언급한, 카테고리를 선택할 수 있는 부분이다. ‘Character Rig’ 카테고리로 들어가면 사용자는 [B] 부분에서 생성하고자 하는 캐릭터 리그의 모듈을 선택할 수 있다. 위에서부터, ‘Canine’, ‘Limb_Front’, ‘Limb_Rear’, ‘Torso’, ‘Tail’, ‘Head’는 각각 개과 동물 전체 리그, 앞다리 리그, 뒷다리 리그, 몸통 리그, 꼬리 리그, 머리 리그를 생성할 수 있는 모듈이다. 원하는 모듈을 선택하고 나서, [C]의 ‘Guide’ 버튼을 누르면 해당하는 모듈의 가이드 로케이터가 생성된다. 원하는 위치에, 예컨대 뼈 모델을 기반으로 로케이터의 위치를 배치해줄 수 있다. ‘Clear’는 생성한 가이드 로케이터를 지우고 싶을 때 사용하는 버튼이다. 그림 8은 [B]에서 ‘Limb_Front’와 ‘Limb_Rear’를 선택한 후 [C]에서 ‘Guide’를 선택해 캐릭터의 앞다리와 뒷다리 가이드 로케이터를 생성한 모습이다.

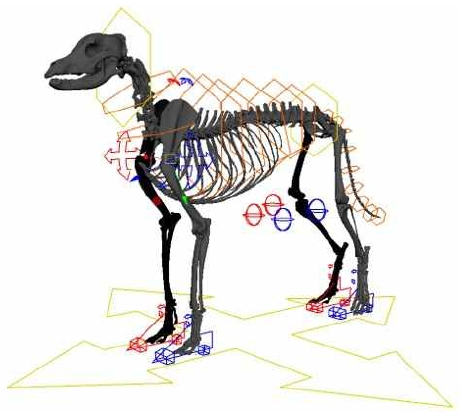

가이드 생성 후 원하는 상태에서 [C]의 ‘Build’ 버튼을 누르면 모션 시스템이 자동으로 생성된다. ‘Canine’ 모듈을 선택한 상태에서 ‘Build’ 버튼을 누른 결과물은 그림 9와 같다. [A]의 ‘Export’ 탭에서는 해당 파일은 실시간 엔진의 적합한 형식으로 변환하는 기능을 제공한다. [D]의 ‘FBX Export’ 버튼을 통해 사용자는 동물 캐릭터의 스켈레톤과 지오메트리, 디포메이션 시스템 정보를 FBX 파일 형식으로 저장할 수 있다. ‘Control Rig Export’ 버튼을 누르면 모션 시스템을 다른 언리얼 엔진 상에서 호환되는 컨트롤 리그로 재생성해주는 파이썬 스크립트를 추출할 수 있다. 해당 스크립트를 언리얼 엔진에서 실행하면 자동으로 컨트롤 리그가 구축된다.

Ⅳ. 결 론

동물 캐릭터는 디지털 휴먼이 등장하기 이전부터 영화, 애니메이션, 게임 등 다양한 콘텐츠에 등장하며 사람들에게 사랑을 받아왔다. 최근 실감형 콘텐츠 제작의 급부상으로 실시간을 기반으로 구동되는 캐릭터 리그에 대한 관심이 증가하였고, 특히 메타휴먼의 등장은 업계에 반향을 일으키며 캐릭터 제작 기술의 수준을 현저히 상승시켰다. 메타휴먼은 게임 및 영화 산업에서 가상 인간의 모습을 실제와 같이 표현하기 위한 중요한 도구로 자리 잡았다. 메타휴먼 크리에이터는 아티스트가 인간의 외형, 표정, 그리고 움직임을 다양한 측면에서 커스터마이징 할 수 있는 강력한 기능을 제공한다. 메타휴먼 DNA는 메타휴먼의 얼굴과 몸의 움직임에 관련된 모든 요소와 수치가 정의된 데이터다[32]. DNA 보정(Calibration)을 통해, 아티스트는 캐릭터 얼굴의 세부적인 특징이나 신체의 비율 등을 손쉽게 조정할 수 있다.

메타휴먼과 더불어 사족보행 동물 캐릭터에 대해서도 실시간 환경에서 활용 가능한 표준화된 실시간 캐릭터 리그의 필요성이 대두되고 있다. 이에 본 연구에서는 실시간 콘텐츠 산업의 확장과 AI 기술의 도입이라는 시대의 흐름을 반영하여, 게임엔진에서도 극사실적인 사족보행 동물 캐릭터를 활용하기 위한 사족보행 동물 캐릭터 리그의 형식을 제안하고, 이를 생성하기 위한 프로그램을 개발했다. 우리는 영화와 실시간 콘텐츠 각각의 제작 파이프라인을 효과적으로 통합함으로써, 캐릭터 리그의 개발 비용을 줄이고 여러 플랫폼 간 적응성을 확보하고자 하였다.

본 연구의 향후 목표는, 메타휴먼이 보유하고 있는 캐릭터 제작 관련 고급 기술을 사족보행 동물 캐릭터 상황에 적용하여, 실시간 환경에서의 움직임과 형태를 영화 품질 수준으로 구현하는 것이다. 이를 위해, 메타휴먼과 같이 특정 파라미터를 조절하여 사족보행 동물의 모델링된 메시를 수정하고, 이에 맞는 애니메이션과 물리적 특성을 부여하는 방법을 연구하고 개발할 계획이다. 한편, 이러한 접근은 인간형 캐릭터뿐만 아니라 사족보행 동물 캐릭터에도 DNA 보정 기술을 활용하는 새로운 가능성을 탐색하는 것으로, 영화 및 실시간 콘텐츠 분야에서 다양한 사족보행 동물을 표현하는 데 혁신적인 변화를 끌어낼 수 있을 것이다.

Acknowledgments

본 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2021년 문화콘텐츠 R&D 전문인력 양성(문화기술 선도 대학원) 사업으로 수행되었음(과제명 : 버추얼 프로덕션 기반 콘텐츠 제작 기술 R&D 전문인력 양성, 과제번호 : R2021040044 기여율 : 40%)

References

- Digital Human Avatar Market, By Product Type (Interactive Digital Human Avatar and Non-Interactive Digital Human Avatar), By Industry Verticals (Gaming, Retail, IT & Telecommunications, Education, and Others), and By Region Forecast to 2032, Emergen Research, Report ER_00897, July 2023.

-

S. W. Bailey, D. Otte, P. Dilorenzo, and J. F. O'Brien, Fast and Deep Deformation Approximations, ACM Transactions on Graphics, Vol. 37, No. 4, pp. 1-12, July 2018.

[https://doi.org/10.1145/3197517.3201300]

-

S. Radzihovsky, F. de Goes, and M. Meyer. “FaceBaker: Baking Character Facial Rigs with Machine Learning,” in Proceedings of Special Interest Group on Computer Graphics and Interactive Techniques Conference Talks (SIGGRAPH ’20 Talks), New York, NY, August 2020.

[https://doi.org/10.1145/3388767.3407340]

-

S. W. Bailey, D. Omens, P. DiLorenzo, and J. F. O’Brien. 2020. Fast and Deep Facial Deformations. ACM Transactions on Graphics, Vol. 39, No. 4, Article 94, July 2020.

[https://doi.org/10.1145/3386569.3392397]

- Unity Blog. Welcome, Wētā Digital! [Internet]. Available: https://blog.unity.com/news/welcome-weta-digital

-

M. S. Oh, G. H. Han, and Y. H. Seo, “A Study on the Production Techniques of Digital Humans and Metahuman for Metaverse,” Design Research, Vol. 6, No. 3, pp. 133-142, 2021.

[https://doi.org/10.46248/kidrs.2021.3.133]

- Unreal Summit Online 2022. Metahuman-based Virtual Character Creation: Focusing on Actual Development Cases [Internet]. Available: https://www.youtube.com/watch?v=UWQOsOOU4Ho

-

L. Skrba, L. Reveret, F. Hétroy, M.-P. Cani, and C. O'Sullivan, “Animating Quadrupeds: Methods and Applications,” Computer Graphics Forum, Vol. 28, No. 6, pp. 1541-1560, September 2008.

[https://doi.org/10.1111/j.1467-8659.2008.01312.x]

-

T. McLaughlin, L. Cutler, and D. Coleman, “Character Rigging, Deformations, and Simulations in Film and Game Production,” in Proceedings of ACM SIGGRAPH 2011 Courses (SIGGRAPH '11), New York, NY, Article 5, pp. 1-18, 2011.

[https://doi.org/10.1145/2037636.2037641]

- C. Y. Choi and K. D. Choi, “Production Technology and Method of Rig System for Facial Capture of Digital Creatures - Focusing on Facial Capture of Digital Gorilla in <Mr. Go>,” The Korean Journal of Animation, Vol. 8, No. 2, pp. 60-78, 2012.

-

A. Diego and L. Bonisolli, “The Animation of Togo: Achieving Hyper Realism for 11 CG Dogs,” in Proceedings of ACM SIGGRAPH 2020 Talks (SIGGRAPH '20), New York, NY, Article 53, pp. 1-2.

[https://doi.org/10.1145/3388767.3408944]

- J. W. Song, M. Yu, J. H. Kim, J. S. Yang, and J. Noh, “A Study on Optical Motion Capture Process of Quadruped Animals and Motion Retargeting Pipeline of Quadruped Characters,” The Korean Journal of Animation, Vol. 11, No. 5, pp. 162-179, 2015.

-

A. Bhatti, Z. Bhatti, S. A. Memon, and A. Waqas, “A Purposed Model for Quadruped Footprint Generation,” in Proceedings of 2020 3rd International Conference on Computing, Mathematics and Engineering Technologies (iCoMET), Sukkur, Pakistan, pp. 1-5, 2020.

[https://doi.org/10.1109/iCoMET48670.2020.9074144]

- M. S. Fischer and K. E. Lilje, Dogs in Motion, The Pet Book Publishing Company Ltd, 2011.

- W. Heo, Research on Realistic Four-Footed Animal Animation Motion Expression, Master's Thesis, The Graduate School of Advanced Imaging Science, Multimedia & Film, Chung-Ang University, Seoul, 2019.

- S. Hong, “Spine Rigging of 3D Animal Character Animation,” The Treatise on the Plastic Media, Vol. 17, No. 3, pp. 269-278, August 2014.

- L. Skrba, L. Reveret, F. Hétroy, M.-P. Cani, and C. O'Sullivan, “Quadruped Animation,” in Proceedings of Eurographics' 2008-29th Annual Conference of the European Association for Computer Graphics, pp. 7-23, April 2008.

- T. K. Yoo, Noble Incremental Approach for Making Furry Creature in Visual Effect Production, Ph.D. Dissertation, The Graduate School of Advanced Imaging Science, Multimedia & Film, Chung-Ang University, Seoul, 2012.

- K. R. Grier, A Tool for Creating Expressive Control Over Fur and Feather, Master’s Thesis, Texas A&M University, 2019.

- Digital Idea, Development of Collision/Wrap Deformer for Realistic Motion Expression of Muscle, Fat and Skin of Digital Creatureproducing in Movie CG Field, Korea Creative Content Agency(KOCCA), 2018.

-

Z. Bhati, A. Shah, A. Waqas, and H. A. M. Malik, “Template Based Procedural Rigging of Quadrupeds with Custom Manipulators,” in Proceedings of International Conference on Advanced Computer Science Applications and Technologies, Kuching, Malaysia, pp. 259-264, 2013.

[https://doi.org/10.1109/ACSAT.2013.58]

-

J. Y. Baek, “A Study of Use of Auto Rigging Tool to Increase Effectiveness of 3D Animation Production,” Cartoon and Animation Studies, Vol. 49, pp. 247-265, 2017.

[https://doi.org/10.7230/KOSCAS.2017.49.247]

- J. Hudson, Creature Generation using Genetic Algorithms and Auto-Rigging, Master’s Thesis, Bournemouth University, 2013.

-

Y.-S. Luo, J. H. Soeseno, T. P.-C. Chen, and W.-C. Chen, “CARL: Controllable Agent with Reinforcement Learning for Quadruped Locomotion,” in Proceedings of ACM Transactions on Graphics (TOG), Vol. 39, No. 4, pp. 1-10, August 2020.

[https://doi.org/10.1145/3386569.3392433]

-

H. Zhang, S. Starke, T. Komura, and J. Saito, “Mode-adaptive Neural Networks for Quadruped Motion Control,” in Proceedings of ACM Transactions on Graphics (TOG), Vol. 37, No. 4, pp. 1-11, 2018.

[https://doi.org/10.1145/3197517.3201366]

-

I. Baran and J. Popoović, “Automatic Rigging and Animation of 3D Characters,” in Proceedings of ACM Transactions on Graphics, Vol. 26, No. 3, pp. 72-es, July 2007.

[https://doi.org/10.1145/1276377.1276467]

-

Z. Bhatti and A. Shah, “Widget Based Automated Rigging of Bipedal Character with Custom Manipulators,” in Proceedings of the 11th ACM Siggraph International Conference on Virtual-Reality Continuum and Its Applications in Industry, pp. 337-340, December 2012.

[https://doi.org/10.1145/2407516.2407593]

-

T. K. Yoo, “Film Production Using Artificial Intelligence with a Focus on Visual Effects,” Journal of the Korea Entertainment Industry Association, Vol. 15, No. 1, pp. 53-62, January 2021.

[https://doi.org/10.21184/jkeia.2021.1.15.1.53]

- The Hollywood Reporter, From Deepfakes to Facial Capture: How Artificial Intelligence Is Already Change Hollywood [Internet]. Available: https://www.hollywoodreporter.com/lists/how-artificial-intelligence-is-changing-hollywood-1293429/2020.5.13, .

- Unreal Engine Documentation. How to use the Machine Learning Deformer [Internet]. Availale: https://docs.unrealengine.com/5.1/en-US/how-to-use-the-machine-learning-deformer-in-unreal-engine/

- 3Lateral. Metahuman Creator [Internet]. Available: https://www.3lateral.com/news/metahuman-creator-launched.html

- Unreal Engine Blog. New MetaHuman Release Brings Easier Sharing and DNA Calibration [Internet]. Available: https://www.unrealengine.com/en-US/blog/new-metahuman-release-brings-easier-sharing-and-dna-calibration

저자소개

2022년:중앙대학교 예술공학부(공학사)

2022년~현 재: 중앙대학교 첨단영상대학원 영상학과 석사과정

※관심분야:디지털 크리처(Digital Creature), 시각효과 파이프라인(VFX Pipeline), 컴퓨터 그래픽스(Computer Graphics), 확장현실(eXtended Reality)

2002년:중앙대학교 기계설계학과 학사

2004년:중앙대학교 첨단영상대학원 컴퓨터 특수효과 영상 석사

2012년:중앙대학교 첨단영상대학원 예술공학 박사

2012년~2018년: 덱스터 스튜디오 디지털 휴먼 & VR 연구소장

2019년~현 재: 중앙대학교 예술공학대학 부교수

※관심분야:가상존재(Virtual Beings), 확장현실(eXtended Reality), 시각효과(VFX), 실감 미디어(Immersive Media)