Walk-In-Place 시행 시 의도치 않은 사용자 위치 이동에 영향을 미치는 요인 탐구

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

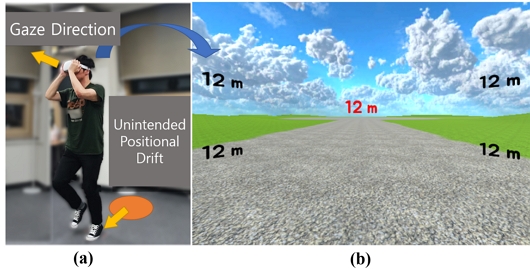

WIP (walk-in-place)는 제자리걸음을 통해서 사용자가 가상 공간을 탐색하는 기법이다. WIP는 넓은 가상공간을 탐색하는 데에 작은 실제 공간만을 필요로 한다는 장점이 있지만, 종종 사용자가 의도하지 않은 실제 공간상의 위치이동을 발생시키는 문제가 있다. 본 연구에서는 이러한 의도치 않은 위치이동이 사용자의 시선 방향과 가상현실 HMD (head mounted display)의 치우친 무게중심과 관련이 있는지 조사하였다. 이를 위해 WIP를 이용해 가상 공원을 조깅하는 콘텐츠를 제작하였고, HMD의 무게 중심을 이동시킬 수 있는 장치를 제작하였다. 첫 번째 실험에서는 다섯 가지의 시선 방향 조건을, 두 번째 실험에서는 두 가지의 HMD 무게 중심 조건을 비교하였다. 각각 9명과 15명이 참여한 두 실험은 모두 피험자 내 설계로 진행되었다. 실험결과, 시선 방향과 무게중심의 통계적으로 유의미한 효과는 발견하지 못하였다. 하지만 모든 조건에서 전방 방향 위치 이동이 발생했으며 포물선 형태의 궤적은 관찰되지 않았다. 또한, WIP 걸음 수와 이동 거리 사이에 강한 상관관계를 발견 할 수 있었다. 본 논문에서는 실험 결과를 고찰하고, 향후 연구방향에 대해 제시한다.

Abstract

Walk-In-Place (WIP) is a technique for exploring virtual environments (VEs) via in-place walking-like gestures. One advantage of WIP is that it only requires a small physical space to navigate vast VEs. However, it often causes users’ unintended positional drift (UPD) in the real world. This study investigates whether such UPDs are related to the users’ gaze direction and the biased weight distribution of the VR head-mounted display (HMD). To achieve this, a VR jogging simulation exploiting WIP was created, and an attachment capable of shifting the center of the mass of HMD was devised. A total of five gaze direction conditions were compared in the first experiment, and two HMD weight center conditions were examined in the second. Both used the within-subjects design, and each experiment had nine and 15 participants, respectively. The results did not reveal statistically significant effects of either gaze direction or weight center on UPD. However, forward UPD occurred in all conditions, and no parabolic trajectories were observed. Moreover, a strong correlation was observed between the number of WIP steps and the magnitude of UPD. We discuss the results and propose future research directions.

Keywords:

Virtual Reality, Walk-In-Place, Unintended Positional Drift, Gaze Direction, HMD’s Centroid키워드:

가상현실, 의도치 않은 위치 이동, 시선 방향, HMD 무게중심Ⅰ. 서 론

독립형 (standalone) 가상현실 (VR; virtual reality) 헤드셋의 등장과, 이후 발생한 코로나19 감염병 유행은 VR에 대한 대중의 관심을 불러일으켰다. 특히 격리조치로 인한 실외활동 제약은 소셜 VR과 VR 피트니스 앱의 개발로 이어졌다. 엔데믹 (endemic) 선언 이후 메타버스로 비롯하는 소셜 VR에 대한 수요는 줄어들었지만, 높아진 VR기술에 대한 이해는 스마트공장, 원격의료, 교육, 훈련, 운동 등 다양한 분야에 VR을 접목시키려는 시도로 이어지고 있다[1]-[3]. 뿐만 아니라 최근 애플은 몰입형 (immersive) VR과 비디오투과방식 (VST; video see-through) 혼합현실 (MR; mixed reality) 경험을 제공하는 Apple Vision Pro를 공개하며 일상적 VR경험을 제공하려는 자사의 비전을 제시하였다[4].

몰입형 VR 사용자는 증강현실 (AR; augmented reality)이나 MR과는 달리 실제공간이 아닌 가상공간만을 보게 된다. 일반적으로 HMD (head mounted display)를 통해서 가상공간을 경험하게 되며, 이때 가상공간은 사용자가 위치한 실제공간과 전혀 다른 구조와 크기를 가질 수 있다. 이러한 차이는 가상공간 이동기법에 대한 연구로 이어졌으며, 이는 3DUI (3d user interfaces)에서 VR 내비게이션(navigation)이라는 연구 분야를 형성하였다[5]. VR 내비게이션은 가상공간과 실제공간의 외형적 차이뿐만 아니라 사용자의 신체기능, VR콘텐츠의 특성 등을 고려해야 하기 때문에 하나의 기법으로 수렴되기는 어렵다. 그럼에도 실재감 (presence) 증대와 VR멀미 저감은 내비게이션 기법 연구의 공통된 목표로 볼 수 있다.

실재감 증대와 멀미 저감의 관점에서 제자리걸음 (WIP; walk-in-place) 기반 내비게이션 기법은 협소한 실제공간에서 넓은 가상공간을 탐색하는데 적합한 기술이다. WIP는 제자리에서 걷거나 가볍게 뛰는 등의 보행동작을 통해 가상공간에서 이동하는 기법으로, 조향에는 사용자의 시선, 얼굴 방향, 또는 몸통 방향 등이 활용된다[6]-[8]. 현실에서와 같이 보행동작을 통해 이동하기 때문에 WIP는 부자연스러운 동작이나 버튼입력 기반 기법에 비해 높은 실재감을 유도할 수 있으며, 체성감각과 HMD를 통한 시각자극 사이 불일치를 줄여 멀미저감 효과도 있다. 또한 제자리 걷기나 뛰기 같은 신체활동을 요구한다는 점에서 VR 피트니스에도 적합하다. 예를 들어 좁은 방안에 있는 사용자도 WIP를 통해 광활한 해변을 조깅하는 경험을 할 수 있을 것이다.

하지만, WIP가 사용자의 실제 위치이동을 필요로 하지 않음에도 불구하고, 종종 의도치 않은 위치이동 (UPD; unintended positional drift)이 발생한다. 몰입형 VR 사용자는 차폐된 HMD로 인해 이러한 UPD를 인지하기 어려우며, 지정된 장소를 벗어나 주변 사물이나 벽에 부딪히는 등의 안전문제를 유발할 수도 있다. 또한 가벼운 충돌이더라도 가상공간에서의 실재감을 저해하는 요소로 작용할 수 있다. VR HMD 제조사들은 이러한 연유로 사용자가 플레이 영역 경계에 접근하면 VR공간에서 경계막을 시각화하고 있으나, 이러한 방식은 실재감은 물론 콘텐츠에 몰입을 저해하는 요소로 작용할 수 있다.

이렇듯, UPD가 VR 콘텐츠에 대한 사용자 경험에 중대한 영향을 미칠 수 있음에도 불구하고, 아직까지 UPD에 대한 연구는 찾아보기 어렵다. UPD를 줄이기 위해 시각효과나 햅틱 피드백 같은 명시적인 방법[7],[9]을 사용하는 것은 안전측면에서 유효할 수 있으나 몰입감과 실재감을 떨어뜨릴 수 있다. RDW (redirected walking)[10]과 같이 사용자가 감지하기 힘든 미묘한 변화를 통해 UPD를 제어하는 것이 바람직해 보인다. 이에 본 연구에서는 인간의 보행과 연관된 요인 중 제어 가능한 요인으로 시선방향과 머리의 무게중심을 선정하였고, 실험을 통해 각 요인이 UPD의 방향과 크기에 주는 영향을 확인하고자 한다.

이후 본 논문은 다음과 같이 구성된다. 2장에서 VR 내비게이션 기법을 개괄하고, UPD와 인간의 보행운동 관련 이전 연구를 소개한다. 3장과 4장에서는 각각 시선방향과 머리의 무게중심이 UPD에 미치는 영향을 조사한 실험과 그 결과를 기술하고, 5장에서 두 실험의 결과를 논의한다. 6장에서는 결론과 본 연구의 한계를 서술하고, 향후 연구 방향을 제시한다.

Ⅱ. 이전 연구

UPD는 몸동작을 수반하는 WIP와 같은 VR 내비게이션 기법에서 사용자의 실제공간상의 위치가 의도하지 않은 방향으로 표류하는 현상을 지칭힌다. Nilsson 등[11]에 의해 처음 소개되었으며, VR 내비게이션 기법 중 일부에서 발생하는 현상으로 아직까지 많은 연구가 수행되지는 않았다. 본 장에서는 UPD와 직간접적으로 관련된 이전 연구를 소개한다.

VR 내비게이션은 사용자 인터페이스를 통해 가상공간을 이동하는 기술이다. 크기가 제한된 실제공간에서 넓은 가상공간을 이동하기 위해 RDW[10], Teleportation[12], WIP[13],[14] 등 다양한 기법들이 제안되어왔다. 이러한 내비게이션 기법들은 하지의 움직임을 수반하는 기법과 그렇지 않은 기법으로 분류할 수 있으며, UPD는 일반적으로 전자에서 발생한다. 방향키로 이동하거나 목표 지점을 지정해 순간 이동하는 등의 기법은 하지의 움직임을 필요로 하지 않아 UPD가 발생할 가능성이 낮지만, 시각과 체성감각의 불일치로 멀미를 일으키거나 실제와 너무 동떨어진 경험으로 인해 실재감이 떨어질 수 있다[15]. 반면 사용자의 실공간상 보행을 가상공간에 반영하면서 변위나 회전 등을 미세하게 증감시키는 RDW는 감각 불일치를 저감시키고 실제와 유사한 경험을 제공한다는 장점이 있지만, 최소 6m x 6m의 큰 공간을 필요로 한다[16]. WIP는 제자리걸음으로 보행 동작을 수행함으로써 적절한 실재감을 제공해주고, 좁은 실내에서도 넓은 가상공간을 경험할 수 있도록 해준다[6],[7]. 하지만 이러한 보행 동작을 수반하는 RDW와 WIP에서는 종종 UPD가 발생하는 것으로 보고되었다[11],[17].

일부 연구자들은 이러한 UPD를 최소화하기 위한 방법을 제안하였다. 이러한 방법들은 크게 명시적 방법과 묵시적 방법으로 구분해 볼 수 있다. 명시적 방법에는 WIP에서 하지를 이용한 보행 동작 대신 팔을 젓거나, 발을 바닥에 붙인 채 뒤꿈치를 번갈아 드는 등의 대체 동작을 사용하는 방법이 있고[18], 지정된 장소를 벗어나면 소리의 크기나 화면의 밝기에 변화를 주거나 햅틱 피드백을 제공하여 사용자 스스로 위치를 조율하도록 하는 방법 등이 있다[9],[19]. 묵시적 방법으로는 사용자가 인지하지 못하도록 HMD 화면에 미묘한 이동을 가함으로써 회전을 과장시키거나 감소시키고, 가상 보행 속도를 조작하여 사용자의 위치를 변화시키는 방식 등이 제안되었다[10],[20].

아직까지 명확한 발생 기제가 밝혀지지는 않았지만, UPD는 인간의 다중감각통합과 그에 따른 자세와 보행의 조절에서 기인하는 것으로 추정된다. VR공간에서 이동하게 되면 HMD를 통한 시각 정보와 신체의 움직임을 통해 발생하는 자기 수용 감각 (proprioception), 그리고 신체의 균형을 인지하는 전정 감각 (vestibular sense) 사이의 불일치가 발생하는데, 인간은 무의식적으로 이러한 불일치를 보상하려 한다 [21]. 이러한 과정에서 시각이 다른 감각보다 우세한 경향이 있는데[22], 이는 HMD를 통해 들어오는 가상의 시각 자극에 맞춰 자세나 보행의 조절이 발생할 수 있음을 의미한다 [23]. 일반적으로 사람은 시각적 단서가 있는 방향으로 시선을 재조정하며[24], 목표 위치를 바라보며 해당 방향으로 나아간다[25]. 이러한 시선과 보행 조절 행동은 VR환경에서도 유효하다[26],[27]. 한편, 이러한 보행 조절 행동에는 머리의 무게중심 또한 영향을 미치는 것으로 알려졌다[28]. 머리 무게중심의 이동은 균형을 잡기위한 근육의 조율을 야기하며, 이는 보행 동작의 변형으로 이어진다[29]-[31]. WIP에서 UPD는 이러한 감각 불일치의 보상과 HMD 착용으로 인한 자세 보정 등 복합적인 요인의 작용으로 발생하는 것으로 보인다.

본 연구는 VR콘텐츠가 제공하는 몰입감과 실재감을 저해하지 않으면서 WIP에서 발생하는 UPD의 방향과 크기를 제어할 수 있는 요인을 찾는데 목적이 있다. 후보 요인으로서 시선 방향과 HMD의 무게중심을 선정하였고, 해당 요인들이 실제 보행이 아닌 제자리에서 가볍게 뛰는 WIP기법에서 UPD에 어떠한 영향을 주는지 실험을 통해 확인하고자 한다.

Ⅲ. 실험 1: 시선 방향의 영향

3-1 실험 환경

본 실험을 위해 WIP를 이용해 가상 공원을 조깅하는 VR 콘텐츠를 제작하였다. Unity 2020.3.0f1 게임엔진을 사용하여 무한히 전진할 수 있는 환경을 구성하였으며, VR-Step 에셋을 이용해 WIP를 구현하였다. 해당 에셋은 Oculus Quest 2 HMD의 3차원 위치 정보를 이용해 걸음을 검출하는 방식을 사용하며, 검출된 걸음 당 이동 거리는 0.8 m로 설정하였다. 사용자의 걸음이 검출되면 가상 공원의 길을 따라 전방으로 이동하며, 고개 방향을 통한 진행 방향 전환은 비활성화 시켰다. 사용자의 시선 방향을 제어하기 위해 5개의 지정된 위치에 주기적으로 이동 거리 정보가 표시되도록 하였으며 해당 정보를 2초간 응시하면 화면에서 사라지도록 구현하였다. 응시 여부 판단은 이동 거리 표시에 사용된 텍스트박스와 HMD 전방 방향으로의 광선투사(raycasting)를 통한 충돌 검출로 구현하였다. 5개의 정보 표시 위치는 정면 방향과 정면에서 상하로 20도 좌우로 35도 오프셋을 갖는 네 방향을 사용하였다. 실험을 위해 3 m x 4 m 크기의 공간을 준비하였으며, 참가자의 안전을 위해 사전에 장애물을 실험 공간 내에서 모두 제거하였다.

3-2 실험 방법

본 실험은 피험자 내 설계를 사용하였다. 각 실험 참가자는 5가지 시선 방향(중앙, 좌상, 좌하, 우상, 우하)에 대한 조건을 모두 경험하며, 순서는 라틴 방진 설계를 통해 무선화 하였다.

실험은 참가자가 실험에 대해 안내를 받고 참가동의서에 서명을 하는 것으로부터 시작되었다. 참가자는 VR과 조깅에 대한 친숙도와 SSQ (simulator sickness questionnaire)[32]를 포함하는 사전설문지를 작성한 후, 실험자의 안내를 받아 시작 위치로 이동하였다. 이후 본 실험에 사용된 WIP 보행 방법에 대한 설명을 듣고, HMD 착용 후 1회 연습 세션을 진행하였으며 이어서 각기 다른 위치에 이동 거리 정보가 표시되는 5개의 세션을 진행하였다. 세션 사이에는 SSQ 작성 시간을 포함하여 2분간의 휴식을 갖도록 하였다. 각 세션은 110초간 진행 되었다. 세션이 시작된 후 10초 뒤에 ‘시작’ 음성안내와 함게 WIP 통해 100초간 가상공원을 달린 후 ‘종료’ 음성안내와 함께 멈췄다. 시선 방향에 대한 조건에서는 매 20초 마다 종소리와 함께 지정된 위치에 이동 거리 정보를 표시하여 참가자가 해당 정보를 2초간 응시하도록 하였다. 참가자는 화면에 이동 거리가 표시되지 않는 동안은 정면을 응시하도록 요청 받았다. 위의 과정을 반복하여 5가지 조건을 모두 경험한 후 실험을 종료하였다.

각 세션이 진행되는 동안 HMD의 트래커 (tracker) 값을 이용해 참가자의 머리 위치 (position)와 방향 (orientation) 정보를 20 ms마다 기록하였으며, 세션 시작 후 10초 위치와 70초 위치를 이용해 1분간의 UPD를 측정하였다. 측정된 UPD는 각 세션의 시작점에서 측정된 참가자의 정면 방향을 y축 방향으로 한 전후방향 UPD와 참가자의 우측 방향을 x축 방향으로 한 좌우방향 UPD로 분해하였다. 또한 절댓값을 취해 UPD의 크기도 계산하였다.

3-3 참가자

참가자들은 지역 대학교 내 온라인 광고를 통해 모집되었으며, 총 9명 (남성 6명, 여성 3명)으로 구성되었다. 평균 나이는 28.3세였으며, 표준편차는 5.81이었다. 참가자 중 6명은 이전에 VR HMD를 사용했던 경험이 있었다.

3-4 실험 결과

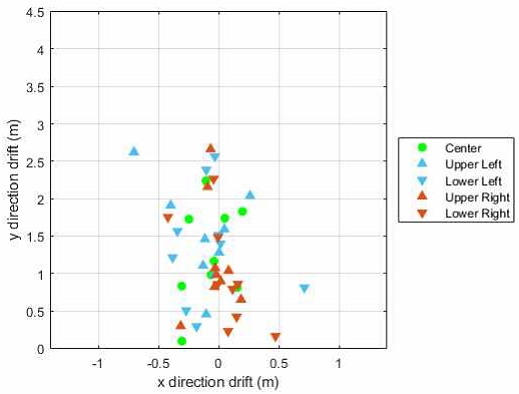

그림 2는 모든 참가자의 세션별 UPD를 산점도로 보여준다. 유도된 시선 방향은 마커의 모양과 색상으로 구별하였다. 파란색은 이동 거리 정보가 좌측 방향에 나타났음을 의미하고 빨간색은 우측 방향에 나타났음을 의미한다. 또한 위쪽 방향일 경우에는 삼각형, 아래쪽 방향일 경우에는 역삼각형으로 표시하였다. 화면 중앙에 정보가 표시됐을 때의 UPD는 연두색 원으로 표시하였다. 산점도는 모든 조건에서 전방 방향으로의 위치 이동이 발생했음을 보여준다. 또한 점들의 x축 상의 분포는 UPD가 좌측으로 편향되어 있음을 보여준다. 하지만 5% 유의수준으로 일원 반복측정 분산분석 (one-way repeated measures ANOVA)을 수행한 결과, 전후 방향 UPD (F=0.567, p=0.688), 좌우 방향 UPD (F=0.388, p=0.816), 그리고 UPD 크기 (F=0.558, p=0.694)에서 시선방향 조건 사이에 통계적으로 유의미한 차이를 발견하지 못하였다. 표 1은 시선 방향 별 UPD 결과를 요약한다. 좌우 방향은 lateral, 전후 방향은 vertical, 그리고 크기는 absolute로 표기하였다. 참가자들은 시각 정보가 오른쪽에 표시될 때 왼쪽(좌측 상단, 좌측 하단)에 비해 UPD가 더 적게 발생하는 경향이 있었다. SSQ에 대하여도 5% 유의수준으로 일원 반복측정 분산분석을 수행한 결과 5가지 조건 간에 통계적으로 유의미한 차이가 없었다 (F=0.775, p=0.548).

Ⅳ. 실험 2: 머리 무게중심의 영향

4-1 실험 환경

본 실험에서는 실험 1에서 개발된 WIP를 통한 VR 조깅 콘텐츠를 동일하게 사용하였다. 실험 1과 동일하게 WIP의 검출된 걸음 당 이동 거리는 0.8 m로, 진행 방향 전환은 비활성화로 설정하였다. 전방 UPD가 크게 발생했던 실험 1의 결과를 고려하여 실험 공간 크기는 4 m x 7 m로 준비하였다. 실험 1에서 사용자 시선 방향을 제어하기 위해 사용했던 이동 거리 정보는 비활성화 하였다. 본 실험의 독립변수인 머리 무게중심을 조절하기 위해 Oculus Quest 2의 기본 스트랩을 엘리트 스트랩으로 변경하였고, 머리 뒤쪽 고정 장치에 무게 추를 달 수 있는 상자를 설치하였다 (그림 3 참조). 스트랩을 제외한 HMD의 무게는 503 g이었고, 스트랩의 무게 179 g과 착용 시 피로감을 고려하여 40 g의 무게 추 4개를 상자에 넣어 머리 무게중심을 보정하였다. 무게중심 비보정 조건에서는 상자에서 추만 제거하였다. 상자 속에는 추 고정 장치를 설치하여 WIP 동작에서도 추가 움직이지 않도록 하였다.

4-2 실험 방법

실험 1과 마찬가지로 본 실험도 피험자 내 설계를 사용하였다. 참가자는 무게중심이 보정된 조건 (balanced)과 비보정 조건 (unbalanced)을 모두 경험하였으며, 순서는 역균형화로 무선화 하였다. 두 조건 모두에서 고정 스트랩에 상자를 부착하여 참가자가 경험하는 조건을 인지하지 못하도록 하였다. 실험 1과 동일한 방식으로 실험을 진행하였으며, 참가자는 연습 세션과 실험 조건 별 1 회차 씩 총 3번 WIP를 이용한 VR조깅 콘텐츠를 경험하였다. 사전 사후 설문지에 각각 우세측 (handedness) 측정 문항[33]과 경험한 두 조건 사이에 HMD 무게차이를 인지했는지 여부를 묻는 문항을 추가하였다. 각 세션 종료 후 SSQ를 측정하였으며, 실험 1과 마찬가지로 20 ms마다 HMD 위치 (position)와 방향 (orientation) 값을 저장하여 이를 이용해 1분간의 UPD 크기, 좌우방향 UPD, 전후방향 UPD를 계산하였다.

4-3 참가자

실험 참가자들은 지역 대학교 내 온라인 광고를 통해 모집되었으며, 총 15명 (남성 8명, 여성 7명)으로 구성되었다. 평균 나이는 24.47세였으며, 표준편차는 2.36이었다. 참가자 중 13명은 이전에 VR HMD를 사용했던 경험이 있었다. 모집 공고에서 왼손잡이의 참여를 독려하였고, 우세측 측정결과 우측 우세자 8명, 좌측 우세자 7명이 실험에 참가하였다.

4-4 실험 결과

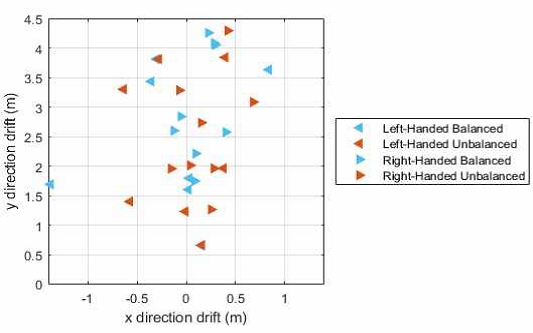

그림 5는 모든 참가자들의 실험 조건별 UPD를 산점도로 보여준다. 무게중심이 보정된 조건은 파란색, 보정되지 않은 조건은 빨간색으로 표시하였다. 또한 참가자의 우세 손에 따라 왼손잡이는 왼쪽 방향 삼각형, 오른손잡이는 오른쪽 방향 삼각형 마커를 사용하였다. 실험 1과 마찬가지로 두 조건 모두에서 전방 방향으로의 위치 이동이 관찰된 반면 x축 상 UPD분포의 치우침은 보이지 않았다. 실험 조건이 UPD에 미치는 영향을 확인하기 위해 5%의 유의수준으로 대응표본 t검정을 UPD 크기 (t=-2.013, p=0.063), 전후 UPD (t=-1.815, p=0.091), 좌우 UPD (t=0.399, p=0.696)에 각각 수행하였지만, 두 조건 간 통계적으로 유의미한 차이는 발견하지 못하였다. 다만, 무게중심의 전방 쏠림이 완화되면 더 적은 UPD가 발생할 것이라는 기대와는 달리 무게중심이 보정된 조건에서 전후 방향 UPD가 더 큰 경향을 볼 수 있었다. 결과는 표 2에 요약되었다. SSQ에서도 조건 간에 유의미한 차이는 없었다 (F=0.94, p=0.341).

Ⅴ. 논 의

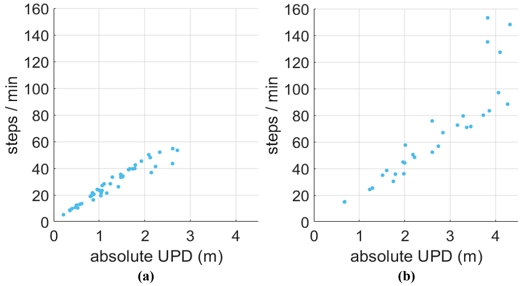

본 논문의 두 실험을 통해서는 시선 방향과 머리 무게중심이 UPD의 크기와 방향에 주는 직접적인 영향을 확인할 수는 없었다. 하지만 실험을 통해 UPD에 대한 몇 가지 흥미로운 결과를 얻을 수 있었다. 우선, 두 실험 모두에서 실험 조건에 상관없이 항상 전방 방향 UPD가 발생하였다. 본 연구에서는 가볍게 조깅하는 동작을 통한 WIP를 사용하였는데, 이는 전정기관에서 상하 움직임으로 인식 되었을 것이다. 반면 HMD를 통해 들어오는 시각 정보는 한 걸음 당 0.8 m씩 앞으로 향하는 정보가 들어와 감각 불일치를 일으켰을 것이다. 시각 우세를 가정하면, 이를 보정하기 위해서 전정 기관에서 앞으로가고 있다는 감각 정보를 생성해야 하는데 이를 위해 사용자가 미세하게 전방 UPD를 발생시킨 것으로 추측된다. 흥미로운 사실은 이때 한 걸음 당 UPD의 크기가 참가자나 실험 조건에 상관없이 4.6 cm로 거의 동일하다는 점이다 (그림 5 참조). 그림 5(b) 우측 상단에 보이는 평균에서 크게 벗어난 참가자 2명의 데이터를 제외하고 두 실험 데이터를 합쳐 계산한 피어슨 상관계수 분석 결과, 분당 걸음 수와 UPD의 크기는 강한 상관관계 (r=0.976, p<0.001)를 보였다. 이는 UPD의 크기가 신장이나 보폭 같은 개인차에 의한 것이 아니라 어떠한 공통 요인에 의해 결정됨의 내포하며, 두 실험의 설계를 고려해볼 때 그 요인은 가상공간에서의 이동속도임을 추정해 볼 수 있다.

(a) Steps per minute vs. absolute UPD in experiment 1 (b) Steps per minute vs. absolute UPD in experiment 2

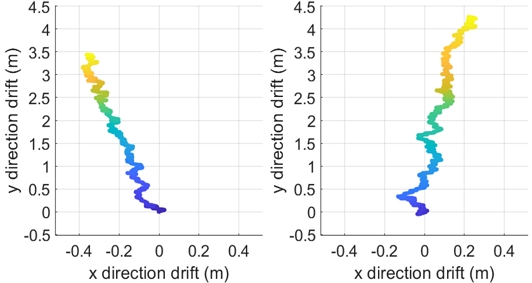

실험에서 관찰된 또 다른 흥미로운 결과는 UPD의 방향이 한번 결정되면 그쪽 방향으로 계속해서 표류한다는 점이다. 그림 6은 관찰된 UPD 궤적의 예시이다. 짙은 파란색에서 옅은 노란색으로 마커 색에 변화를 줘 시간의 흐름을 나타내었다. 큰 틀에서 보면 UPD는 대부분 전방으로 표류하는 궤적을 그린다. 하지만 왼쪽 또는 오른쪽으로 틀어지는 궤적의 경우 그 방향이 유지되었다. 포물선 형태의 궤적은 관찰되지 않았다. 왼손잡이와 오른손잡이 참가자 수 불일치로 통계 분석을 진행하지는 않았지만, 두 실험에서 UPD의 x축 상 분포의 차이는 이러한 UPD의 방향에 우세측의 영향이 있었을 가능성을 시사한다. 우세측으로 인한 또는 다른 요인으로 인한 신체의 좌우 불균형은 한쪽 방향으로 지속적인 틀어짐을 발생시킬 수 있다. 하지만 곡선 궤적이 관찰되지 않은 점은 이러한 틀어짐을 억제하는 요인이 있음을 암시한다. 2장에서 살펴본 사람의 시선 행동과 보행 방향 조정에서 그 단서를 찾을 수 있다. 각 세션의 시작 전, 사용자가 바로서서 향하는 방향으로 가상공간의 정면 방향을 조정하였다. 이 방향은 세션이 진행되는 동안 실제공간의 한 방향으로 고정되어, 의식적이든 무의식적이든 참가자는 이 방향을 이용해 몸의 회전을 보정했을 수 있다.

이러한 결과들이 WIP에서 발생하는 UPD에 대한 이해를 높이는데 기여함에도 불구하고, 본 연구에는 몇 가지 한계점이 존재한다. 우선, 실험 1에서 20초 마다 2초간 지정 방향으로 시선을 유지하도록 하는 것이 보행 조정을 통한 UPD 제어에 충분하지 않았을 수 있다. 또한 HMD 전방 방향 광선 투사를 통한 응시 검출은 실제 시선 방향과 차이가 있을 수 있다. 예를 들어 눈은 되도록 진행 방향을 응시하면서 고개를 돌려 텍스트박스를 제거 했을 가능성이 있다. 충돌 검출에 사용된 바운딩 박스의 면적 또한 오차에 기여하였을 것이다. 즉, 어떤 참가자는 바운딩 박스의 왼쪽 아래 모서리 방향을 응시한 반면 다른 참가자는 오른쪽 위 모서리를 응시했을 수 있다. 한편, 실험 2에서 모든 참가자들은 두 조건 사이 HMD 무게중심 변화를 인지하지 못했다고 답하였다. 이는 추가된 추의 무게가 HMD 사용성에 문제를 야기하지 않았다는 긍정적 해석과 함께, 어쩌면 충분한 무게중심 이동을 일으키지 못했을 수도 있다는 우려스러운 해석도 가능하다. 무엇보다 본 논문에 제시된 두 실험 모두 샘플 사이즈가 적어 통계분석을 통해 유의미한 결론을 내리는데 한계가 있었다.

Ⅵ. 결론 및 향후 연구

본 논문에서는 WIP 기반 VR 내비게이션에서 UPD의 크기와 방향에 영향을 미치는 요인에 대해 탐구하였다. 문헌조사를 통해 사용자 시선의 방향과 머리 무게중심이라는 요인을 선정하였고, 실험을 위해 WIP를 통해 가상공간에서 조깅을 하는 몰입형 VR 콘텐츠를 구현하였다. 첫 번째 실험에서는 사용자의 시선 방향을 5가지 방향으로 유도하여 시선 방향에 따른 UPD의 크기와 방향의 변화를 조사하였고, 두 번째 실험에서는 전방으로 편중된 HMD의 무게중심을 보정하여, 무게중심의 차이에 따른 UPD에 변화에 대해 조사하였다. 각각 9명과 15명이 참가한 두 실험의 결과는 사용자의 시선 방향과 UPD 그리고 머리 무게중심의 변화와 UPD 사이에 통계적으로 유의미한 상관관계를 밝히지는 못하였다. 하지만 모든 실험 조건에서 전방 방향 UPD가 발생하는 것과 포물선 형태의 UPD 궤적이 관찰되지 않는 것을 발견할 수 있었다. 또한 걸음 속도와 UPD의 크기 사이에 강한 상관관계가 있음을 보였으며, 실험 조건이나 참가자에 상관없이 한 걸음 당 약 4.6 cm의 UPD가 발생함을 발견하였다.

향후 연구로는 우선 시선 추적 (eye tracking)을 통해 보다 정교한 시선 방향과 UPD와의 상관관계 분석 실험을 수행할 계획이다. 그 과정에서 이동시 발생하는 UPD와 시선에 따른 UPD를 명확히 구별할 수 있는 실험 설계가 필요해 보인다. 또한 본 연구를 통해 발견한 UPD에 대한 가상공간에서의 진행 방향 그리고 속도의 영향을 추가로 조사해 보고자 한다.

Acknowledgments

본 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 연구비(No. 2022R1A4A5028840)와 2020학년도 부산대학교 신임교수연구 정착금 지원으로 이루어졌음.

References

-

V. C. C. Quispe, J. C. C. Aguinaga, L. G. D. Huaco, and J. T. Cruz, “DENTORACULUS - A Gamified Virtual Reality Experience for Dental Morphology Learning,” 2023 IEEE Conference on Virtual Reality and 3D User Interfaces Abstracts and Workshops (VRW), Shanghai, pp. 1007-1008, March 2023.

[https://doi.org/10.1109/VRW58643.2023.00349]

-

Y. Yu, B. He, G. Yu, and F. Zhong, “Research on Fear Mental Resilience Training Based on Virtual Reality and Dynamic Decision Fusion,” 2023 International Conference on Pattern Recognition, Machine Vision and Intelligent Algorithms (PRMVIA), Beihai, pp. 236-244, March 2023.

[https://doi.org/10.1109/PRMVIA58252.2023.00045]

-

S. Gupta, V. Dehankar, V. Nagpure, D. Vyas, and P. K. Joshi, “Shoulder Rehabilitation Using Virtual Physiotherapy System,” 2023 International Conference on Sustainable Computing and Smart Systems (ICSCSS), Coimbatore, pp. 763-769, June 2023.

[https://doi.org/10.1109/ICSCSS57650.2023.10169624]

- Apple. Vision Pro [Internet]. Avaliable: https://www.apple.com/kr/newsroom/2023/06/introducing-apple-vision-pro/

- J. J. LaViola Jr., E. Kruijff, R. P. McMahan, D. A. Bowman, and I. Poupyrev, 3D User Interfaces: Theory and Practice, Addison-Wesley Professional, 2nd ed., 2017.

-

C. H. Park, K. H. Jang, and J. S. Lee, “Walking-in-Place for VR Navigation Independent of Gaze Direction Using a Waist-Worn Inertial Measurement Unit,” 2018 IEEE International Symposium on Mixed and Augmented Reality Adjunct (ISMAR-Adjunct), Munich, pp. 254-257, October 2018.

[https://doi.org/10.1109/ISMAR-Adjunct.2018.00079]

-

B. Williams, M. McCaleb, C. Strachan, and Y. Zheng, “Torso versus Gaze Direction to Navigate a VE by Walking in Place,” in Proceedings of the ACM Symposium on Applied Perception (SAP '13), New York: NY, pp. 67-70, August 2013.

[https://doi.org/10.1145/2492494.2492512]

-

J. N. Templeman, P. S. Denbrook, and L. E. Sibert, “Virtual Locomotion: Walking in Place through Virtual Environments,” Presence, Vol. 8, No. 6, pp. 598-617, December 1999.

[https://doi.org/10.1162/105474699566512]

-

N. C. Nilsson, S. Serafin, and R. Nordahl, “A Comparison of Different Methods for Reducing the Unintended Positional Drift Accompanying Walking-in-Place Locomotion,” in Proceedings of 2014 IEEE Symposium on 3D User Interfaces (3DUI), Minneapolis: MN, pp. 103-110, March 2014.

[https://doi.org/10.1109/3DUI.2014.6798850]

-

F. Steinicke, G. Bruder, J. Jerald, H. Frenz, and M. Lappe, “Estimation of Detection Thresholds for Redirected Walking Techniques,” IEEE Transactions on Visualization and Computer Graphics, Vol. 16, No. 1, pp. 17-27, Janaury-February 2010.

[https://doi.org/10.1109/TVCG.2009.62]

-

N. C. Nilsson, S. Serafin, and R. Nordahl, “Unintended Positional Drift and Its Potential Solutions,” in Proceedings of 2013 IEEE Virtual Reality (VR), Lake Buena Vista: FL, pp. 121-122, March 2013.

[https://doi.org/10.1109/VR.2013.6549392]

-

J. Bhandari, P. MacNeilage, and E. Folmer, “Teleportation without Spatial Disorientation Using Optical Flow Cues,” in Proceedings of Graphics Interface Conference 2018, Toronto, Canada, pp. 153-158, May 2018.

[https://doi.org/10.20380/GI2018.22]

-

N. C. Nilsson, S. Serafin, and R. Nordahl, “Establishing the Range of Perceptually Natural Visual Walking Speeds for Virtual Walking-in-Place Locomotion,” IEEE Transactions on Visualization and Computer Graphics, Vol. 20, No. 4, pp. 569-578, April 2014.

[https://doi.org/10.1109/TVCG.2014.21]

-

S. Tregillus and E. Folmer, “VR-STEP: Walking-in-Place Using Inertial Sensing for Hands Free Navigation in Mobile VR Environments,” in Proceedings of the 2016 CHI Conference on Human Factors in Computing Systems (CHI ’16), San Jose: CA, pp. 1250-1255, May 2016.

[https://doi.org/10.1145/2858036.2858084]

-

B. Sarupuri, S. Hoermann, F. Steinicke, and R. W. Lindeman, “Triggerwalking: A Biomechanically-Inspired Locomotion User Interface for Efficient Realistic Virtual Walking,” in Proceedings of the 5th Symposium on Spatial User Interaction (SUI ’17), Brighton, UK, pp. 138-147, October 2017.

[https://doi.org/10.1145/3131277.3132177]

-

M. Azmandian, T. Grechkin, M. Bolas, and E. Suma, “Physical Space Requirements for Redirected Walking: How Size and Shape Affect Performance,” in Proceedings of the 25th International Conference on Artificial Reality and Telexistence and 20th Eurographics Symposium on Virtual Environments (ICAT-EGVE ’15), Kyoto, Japan, pp. 93-100, October 2015.

[https://doi.org/10.2312/egve.20151315]

-

N. C. Nilsson, S. Serafin, F. Steinicke, and R. Nordahl, “Natural Walking in Virtual Reality: A Review,” Computers in Entertainment, Vol. 16, No. 2, pp. 1-22, April 2018.

[https://doi.org/10.1145/3180658]

-

N. C. Nilsson, S. Serafin, M. H. Laursen, K. S. Pedersen, E. Sikström, and R. Nordahl, “Tapping-in-Place: Increasing the Naturalness of Immersive Walking-in-Place Locomotion through Novel Gestural Input,” in Proceedings of 2013 IEEE Symposium on 3D User Interfaces (3DUI), Orlando: FL, pp. 31-38, March 2013.

[https://doi.org/10.1109/3DUI.2013.6550193]

-

G. Cirio, M. Marchal, T. Regia-Corte, and A. Lécuyer, “The Magic Barrier Tape: A Novel Metaphor for Infinite Navigation in Virtual Worlds with a Restricted Walking Workspace,” in Proceedings of the 16th ACM Symposium on Virtual Reality Software and Technology (VRST ’09), Kyoto, Japan, pp. 155-162, November 2009.

[https://doi.org/10.1145/1643928.1643965]

-

B. Williams, G. Narasimham, T. P. McNamara, T. H. Carr, J. J. Rieser, and B. Bodenheimer, “Updating Orientation in Large Virtual Environments Using Scaled Translational Gain,” in Proceedings of the 3rd Symposium on Applied Perception in Graphics and Visualization (APGV ’06), Boston: MA, pp. 21-28. July 2006.

[https://doi.org/10.1145/1140491.1140495]

-

T. Van Onsem, J. Struye, X. C. Perez, J. Famaey, and F. Lemic, “Toward Full-Immersive Multiuser Virtual Reality with Redirected Walking,” IEEE Access, Vol. 11, pp. 24722-24736, March 2023.

[https://doi.org/10.1109/ACCESS.2023.3255006]

-

J. Dichgans and T. Brandt, Visual-Vestibular Interaction: Effects on Self-Motion Perception and Postural Control, in Perception (Handbook of Sensory Physiology Volume 8), Berlin/Heidelberg, Germany: Springer, pp. 755-804, 1978.

[https://doi.org/10.1007/978-3-642-46354-9_25]

-

M. T. Robert, L. Ballaz, and M. Lemay, “The Effect of Viewing a Virtual Environment through a Head-Mounted Display on Balance,” Gait & Posture, Vol. 48, pp. 261-266, July 2016.

[https://doi.org/10.1016/j.gaitpost.2016.06.010]

-

M. A. Hollands, A. E. Patla, and J. N. Vickers, ““Look Where You’re Going!”: Gaze Behaviour Associated with Maintaining and Changing the Direction of Locomotion,” Experimental Brain Research, Vol. 143, No. 2, pp. 221-230, March 2002.

[https://doi.org/10.1007/s00221-001-0983-7]

-

W. H. Warren Jr., B. A. Kay, W. D. Zosh, A. P. Duchon, and S. Sahuc, “Optic Flow is Used to Control Human Walking,” Nature Neuroscience, Vol. 4, pp. 213-216, February 2001.

[https://doi.org/10.1038/84054]

-

T. Foulsham, A. Kingstone, and G. Underwood, “Turning the World Around: Patterns in Saccade Direction Vary with Picture Orientation,” Vision Research, Vol. 48, No. 17, pp. 1777-1790, August 2008.

[https://doi.org/10.1016/j.visres.2008.05.018]

-

M. N. Sreenivasa, I. Frissen, J. L. Souman, and M. O. Ernst, “Walking Along Curved Paths of Different Angles: The Relationship Between Head and Trunk Turning,” Experimental Brain Research, Vol. 191, No. 3, pp. 313-320, November 2008.

[https://doi.org/10.1007/s00221-008-1525-3]

-

C. Patten, F. B. Horak, and D. E. Krebs, “Head and Body Center of Gravity Control Strategies: Adaptations Following Vestibular Rehabilitation,” Acta Oto-Laryngologica, Vol. 123, No. 1, pp. 32-40, 2003.

[https://doi.org/10.1080/003655402000028036]

- W. R. Bussone, Linear and Angular Head Accelerations in Daily Life, Master’s Thesis, Virginia Polytechnic Institute and State University, Blacksburg, VA, 2005.

-

B. C. Duggar, “The Center of Gravity of the Human Body,” Human Factors: The Journal of the Human Factors and Ergonomics Society, Vol. 4, No. 3, pp. 131-148, June 1962.

[https://doi.org/10.1177/001872086200400303]

-

R. L. Cromwell, “Movement Strategies for Head Stabilization during Incline Walking,” Gait & Posture, Vol. 17, No. 3, pp. 246-253, June 2003.

[https://doi.org/10.1016/S0966-6362(02)00094-2]

-

R. S. Kennedy, N. E. Lane, K. S. Berbaum, and M. G. Lilienthal, “Simulator Sickness Questionnaire: An Enhanced Method for Quantifying Simulator Sickness,” The International Journal of Aviation Psychology, Vol. 3, No. 3, pp. 203-220, 1993.

[https://doi.org/10.1207/s15327108ijap0303_3]

-

S. Coren, “The Lateral Preference Inventory for Measurement of Handedness, Footedness, Eyedness, and Earedness: Norms for Young Adults,” Bulletin of the Psychonomic Society, Vol. 31, No. 1, pp. 1-3, January 1993.

[https://doi.org/10.3758/BF03334122]

2022년:동의대학교 (공학사)

2022년~2023년: 부산대학교 정보융합공학과 석사과정

2023년~현 재: 부산대학교 정보융합공학과 석박통합과정

※관심분야:가상현실(Virtual Reality), 메타버스(Metaverse), 휴먼컴퓨터인터랙션 등

2009년:고려대학교 대학원 (공학석사)

2019년:센트럴플로리다대학교 대학원 (공학박사-가상현실)

2019년~2020년: 한국과학기술연구원

2020년~현 재: 부산대학교 정보컴퓨터공학부 조교수

※관심분야:가상현실(Virtual Reality), 증강현실(Augmented Reality), 가상인간(Virtual Human) 등