3D 공간캡처 기술 기반의 메타버스 제작 파이프라인 연구

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 3D 공간 캡처 기술을 이용하여 초 실감형 메타버스에 사용될 가상공간을 효과적으로 생산하기 위한 제작 파이프라인을 제안한다. 가상공간 제작과 관련한 기존의 연구는 핵심 요소 기술의 개발과 하드웨어 사용에만 초점을 맞춘 경우가 많았다. 우리는 고도화 차원에만 치우치지 않고 실제 생산과정에 상용화할 수 있도록 최신 공학 기술을 결합하고 최적화하고자 한다. 기존의 에셋 제작과 장면 렌더링 기법을 기반으로 3차원 재구성과 교차 편광 촬영기법을 도입하여 자동화한다. 제시된 방법은 생산 시간 및 비용 절감과 같은 비용 효율성뿐만 아니라 일부 작업공정의 자동화에 따른 생산성 및 소프트웨어 가용성을 고려한다. 향후 가상공간 생산의 안정성을 높이고 기술력을 보완하여 차세대 메타버스의 인프라와 기술발전에 기여할 것이다.

Abstract

In this study, we proposed a production pipeline to effectively create virtual spaces for use in a highly immersive metaverse using 3D space capture technology. Previous research on virtual space production has focused primarily on the development of core technologies and the use of hardware. We aimed to combine and optimize the latest engineering technologies to make the production process commercially viable, and not merely focused on advancing them. We introduced automation using 3D reconstruction and cross-polarization photography technology based on existing asset creation and scene rendering techniques. The proposed method considers cost-effectiveness, that is, reducing the production time and costs, as well as productivity and software availability resulting from the automation of some of the work processes. In the future, the proposed pipeline will contribute to the infrastructure and technological development of the next-generation metaverse by enhancing the stability of virtual space production and supplementing technological capabilities.

Keywords:

Metaverse, Pipeline, 3D Reconstruction, Cross Polarization Photography Technique키워드:

메타버스, 파이프라인, 3차원 재구성, 교차 편광 촬영기법Ⅰ. 서 론

4차 산업혁명의 도래와 함께 최근 코로나바이러스(COVID-19)의 여파로 온라인·비대면 환경에서의 일상생활이 지속됨에 따라, 모든 산업 영역에서 디지털 전환이 급속도로 이루어지고 있다. 이에 가상 현실(Virtual Reality, 이하 VR), 증강 현실(Augmented Reality, 이하 AR), 혼합 현실(Mixed Reality, 이하 MR), 빅데이터(Big Data), 인공지능(Artificial Intelligence, 이하 AI) 등의 기술의 확산뿐만 아니라 기술 간 융합 현상이 발생하고 있으며, 가상세계 속 다양한 분야에서 여러 개념이 생겨나고 있다. 그 중 정치, 경제, 사회, 문화, 엔터테인먼트 등 우리 생활 전반에 걸친 변화 흐름 속에서 크게 주목받는 개념이 하나 있는데, 바로 ‘메타버스(Metaverse)’이다. 메타버스는 인터넷을 포함하는 물리적 공간과 이와 연결된 가상공간의 융합에 의해 만들어진 가상공존세계(Virtual Shared Space)를 의미한다[1].

메타버스는 가상과 현실이 상호작용을 이루며 공진화하고, 그 속에서 사회·경제·문화 활동이 발생하면서 경제적 가치를 창출한다[2]. 예컨대, 2020년 4월 ‘포트나이트(Fortnite)’ 콘서트장에서 미국의 유명 래퍼 트래비스 스콧(Travis Scott)의 공연이 진행되었는데, 당시 약 1,230만 명이 동시에 접속했으며 공연 관련 수익이 2,000만 달러로 집계되었다[3]. 국내의 경우, 2021년 9월 '제페토(ZEPETO)'에서 이루어진 YG 엔터테인먼트의 걸그룹 블랙핑크(BLACKPINK)의 팬 사인회에는 약 4,600만 명의 팬이 몰렸으며, 이후 제페토는 소프트뱅크, 미래에셋캐피탈, 네이버 웹툰과 여러 엔터테인먼트사들로부터 2,200억 원 규모의 투자를 유치하는 데 성공했다[4]. 메타버스 시장의 전체 규모는 2021년에 약 307억 달러(약 34조원)로 측정되었으나, 2024년에는 3천억 달러(약 336조원), 그리고 2030년에는 무려 15조달러(약 1경 8646조원)까지 확장될 것이라고 예측되고 있다[5],[6].

최근 메타버스 시장이 점차 다양한 산업에 확산 및 적용됨에 따라, 가상세계의 공간을 현실 세계와 가까운 수준으로 구현하고자 하는 움직임이 커지고 있다. 2022년 1월 라스베이거스(Las Vegas) 컨벤션센터 센트럴 홀에서 열린 CES(Consumer Electronics Show) 2022에서 롯데정보통신은 현재 애니메이션 기반의 메타버스가 가진 한계를 지적하며, 실사를 기반으로 현장감과 몰입감을 증폭시킨 초 실감형 메타버스 서비스를 준비 중이라고 밝혔다[7]. 메타버스 제작의 대표 주자 중 하나로 일컬어지는 에픽게임즈(Epic Games) 사의 경우 언리얼 엔진 5(Unreal Engine 5, 이하 UE5)를 출시함과 동시에, 많은 수의 폴리곤(Polygon)을 가진 3D 모델의 실시간 렌더링(Real-time Rendering)을 지원하는 나나이트(Nanite) 기능을 선보였다[8]. 엔비디아(NVIDIA)는 시각효과(Visual Effects, 이하 VFX) 분야에서만 사용되었던 USD(Universal Scene Description, 이하 USD)의 기능을 건축, 산업용 디지털 트윈(Digital Twin), 엔지니어링(Engineering), 로보틱스(Robotics) 등의 산업까지 확장하며 메타버스 활성화를 가속화 할 것이라고 전했다[9]. USD는 픽사(Pixar)에서 개발한 소프트웨어 플랫폼으로, 수많은 데이터가 포함된 대규모의 장면(Scene)을 다수의 사용자가 효과적으로 동시에 작업할 수 있게 한다[10],[11].

3D 컴퓨터 그래픽스(3D Computer Graphics, 이하 3D CG) 관련 학계에서도 실사의 디지털 공간을 생성하기 위한 다양한 연구들이 시도되고 있다. 메타버스 공간 제작과 관련된 선행연구를 살펴보면, 포토그래메트리(Photogrammetry) 및 스캐닝(Scanning) 기술 기반의 3차원 공간 모델링[12]-[16], AI 기반의 3차원 공간 모델링[17],[18], 고품질의 텍스처 제작 기법[19]-[23], 대규모 3차원 장면 최적화[8],[11], [24]-[26] 등이 연구 주제로 다루어졌다. 하지만 여전히 대부분의 연구에서 물체나 공간의 투박한 메시(Mesh)와 컬러 맵 데이터를 획득하는 데에만 그쳤으며, 결과적으로 실제 프로덕션 과정에서 사용 가능한 정도의 3D 에셋(Asset)을 제작하지 못하였다. 특히 최근, 메타버스와 관련한 수요 증가로 인해 여전히 가상공간 제작 파이프라인의 정립뿐만 아니라 비용 절감 및 파이프라인 최적화와 관련된 추가적인 연구도 필수적으로 요구되는 상황이다. 반면에 이와 관련된 연구 성과는 다른 주제에 비해 부족하며, 기존의 연구가 3D CG 및 관련 소프트웨어의 개발 등 기술 고도화에 초점을 맞춰 진행됨에 따라 가상공간 구현기술들이 실제 제작과정에 효과적으로 적용되지 못하는 한계를 가졌다. 예컨대, 대부분의 연구에서 정확한 3차원 공간 데이터를 얻기 위해 RGB-D 카메라나 공간 스캐너 등 높은 비용의 고급 촬영 장비를 사용한다. 그러나 이러한 장비들은 일반적으로 지나치게 큰 데이터를 생성해내고 메시와 UV 맵에도 문제가 있어, 실제 사용을 위해서는 아티스트 노동집약적 형태의 작업이 수반된다. 또한, 실제 제작공정에 새로운 기술을 도입하고자 하는 경우, 모델러(Modeller)와 같은 제작자는 현실적으로 3D CG 공학 기술이 작동되는 원리를 완벽하게 이해하고 사용할 수 없으므로 그들의 입장을 고려한 적절한 해결책을 강구해야 한다.

이에 본 연구는 3D 공간캡처 기술을 활용하여 메타버스에 사용될 포토리얼리즘(Photorealism)의 가상공간을 효과적으로 생산 및 구현할 수 있는 제작 파이프라인을 제안한다. 본 연구는 기존의 3D 에셋(Asset) 제작기법 및 장면 렌더링 방식을 기반으로, 높은 품질을 가진 실사의 가상공간 제작하기 위해 3차원 재구성(3D Reconstruction)과 교차편광 촬영기법(Cross-Polarization Photography Technique)을 도입한다. 이를 통해 초 실감형 메타버스 콘텐츠에 활용할 수 있는 실사의 고품질 데이터를 획득하고 처리하는 일련의 작업을 하나의 통합된 컴퓨터 그래픽스 제작과정으로 설계 및 구현하고 각 작업 단계를 자동화한다. 이는 기존 연구에서의 제작 방식보다 아티스트의 작업 시간을 단축할 수 있으며, 결과적으로 3차원 장면의 품질 향상뿐만 아니라 전반적인 에셋 제작공정에서의 생산성 및 효율성 증대와 비용 절감에도 실질적인 도움을 줄 수 있을 것이다.

문헌 연구를 통해 메타버스 공간 제작에 요구되는 요소 기술들을 검토함으로써, 학술적 측면에서 이는 추후 관련 연구에서 메타버스 콘텐츠의 개발 방향성에 대한 통찰력을 제공할 것이다. 한편 실무적 측면에서 본 연구의 결과는 3D 공간캡처 기술을 도입한 가상공간 제작 파이프라인의 정립을 통해, 지금까지 기존의 메타버스 플랫폼이 보여주었던 애니메이션 기반의 그래픽 스타일이 아닌 현실 세계에 가까운 모습의 가상공간 구현을 가능하게 하는 새로운 방식의 작업 프로세스를 제안할 수 있다. 본 연구는 실사 기반의 메타버스 콘텐츠 발전 방향성에 대한 시사점을 제공함으로써 미래 사회 플랫폼으로서의 메타버스 활성화에 기여할 것으로 기대한다.

Ⅱ. 연구방법 및 연구범위

본 연구는 초 실감형 메타버스를 위한 실사 기반의 가상공간 제작 파이프라인을 구성하기에 앞서, 먼저 문헌 연구를 통해 메타버스와 본 연구에 사용되는 핵심 기술인 3차원 재구성및 교차편광 촬영기법의 개념과 특성에 대해 이론적으로 고찰한다. 또한, 3차원 재구성 기술과 교차 편광 촬영기법을 활용한 콘텐츠 제작 사례에 대해 알아보며, 선행연구 자료로서 본 연구에 활용할 수 있는가에 대한 타당성을 검토한다.

기존 연구에서 통상적으로 사용되는 RGB-D 카메라나 공간 스캐너 등의 촬영 장비는 사용하기 간편하다는 장점이 있으나, 높은 성능의 센서가 탑재될수록 더욱 높은 구매 가격이 책정되며, 장비의 큰 규모로 인해 설치에 있어 공간상의 제약이 존재하는 등 여러 측면에서 한계가 존재한다[14](표 2). 이에 본 연구자는 현실 공간의 데이터를 획득하기 위한 촬영 장비로 애플 사(Apple Inc.)의 아이폰 13 프로(iPhone 13 Pro) 버전 모델[27]을 사용한다(표 1). 애플은 2020년 아이폰 12 제품 출시 이래로 아이폰 프로 버전 이상의 모델에 라이다(Light Detection And Ranging, 이하 LiDAR) 센서를 탑재하고 있다. 아이폰은 기존에 진행되었던 선행연구에서 사용된 RGB-D 카메라나 드론(Drone), 공간 스캔 장비보다 비용적 측면에서의 접근성이 좋으며 휴대가 간편하다. 또한, 해당 기기에 탑재된 LiDAR 센서를 기반으로 작동하는 모바일 앱(Mobile Application)을 활용하여 손쉽게 스캔 데이터를 획득할 수 있다는 이점을 가진다.

게임이나 영화를 위한 일반적인 3D 에셋 작업공정은 다음과 같은 과정으로 이루어진다[28]. 먼저, 수백만 개의 폴리곤(Polygon)으로 구성되어 있는 하이폴리 메시(High-Poly Mesh)를 로우폴리 메시(Low-Poly Mesh)로 변환하기 위해 리토폴로지(Retopology) 작업을 진행한다. 리토폴로지는 고해상도 메시를 기반으로 단순화된 형태의 생산 준비가 된 사각형(Quad)의 메시를 생성하는 프로세스를 의미한다[29]. 다음으로, 로우폴리 메시에 UV맵을 펼치고, 텍스처 베이킹(Texture Baking)의 과정을 통해 하이폴리 메시가 가진 디테일한 텍스처를 로우폴리 메시의 UV맵으로 옮긴다. 마지막으로 로우폴리 메시에 PBR(Physically Based Rendering, 이하 PBR) 재질의 머테리얼(Material)을 만들어 적용하면 콘텐츠 제작에 사용 가능한 품질의 3D 에셋이 완성된다.

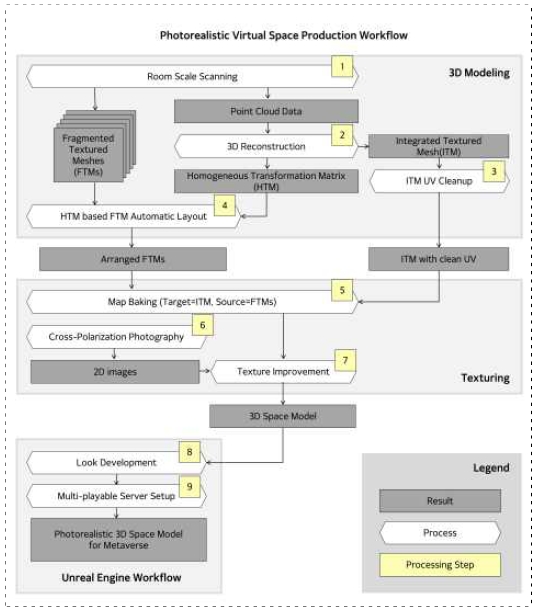

앞서 상술한 기존의 3D 에셋 작업방식을 기반으로, 본 연구는 3차원 재구성 기술과 교차편광 촬영기법을 하나의 제작공정으로 결합하여 사실적인 가상공간의 구축을 위한 방법론을 제시한다. 그림 1은 본 연구의 흐름도를 나타낸다. 이는 크게 포토리얼리즘의 가상공간 제작과 언리얼 엔진을 이용한 추가 작업의 두 과정으로 구분할 수 있으며, 전자에 3차원 공간 모델링과 텍스처 제작이 포함된다. 제작과정에서는 본 연구가 제시한 제작 파이프라인에 포함된 단계별 활용 개념, 조작방법, 주의사항 등에 대해 살펴본다. 본 연구의 가상공간 제작 파이프라인은 관련된 선행 연구의 작업공정을 참고하여[12],[19], 비용적 측면에서의 효율성, 자동화에 따른 생산성 등을 고려한 형태로 설계되었다. 본 연구에서 제시한 파이프라인은 작업 과정의 각 단계를 독립적으로 수행 가능한 형태이기 때문에, 결과적으로 이는 메타버스 제작과 관련한 후속 연구에서 유연성과 확장성을 제공할 것이다.

Ⅲ. 이론적 고찰

3-1 메타버스

메타버스는 초월이란 뜻의 ‘메타(Meta)’와 우주란 뜻의 ‘유니버스(Universe)’의 합성어로, 단어 자체는 미국의 공상과학 소설가인 닐 스티븐슨(Neal Stephenson)이 1992년 발표한 SF소설 <스노 크래시(Snow Crash)>에서 유래했다[1]. 최근 다시 화제가 된 것은 2020년 10월 그래픽카드 제조사 엔비디아의 설립자이자 최고 경영자인 젠슨 황이 ‘GPU 기술 컨퍼런스(GPU Technology Conference, 이하 GTC) 2020’의 기조연설에서 ‘메타버스 시대가 오고 있다’고 선언하면서부터이다[30]. 이후에 메타버스는 시대가 주목하는 키워드로 떠올랐다.

미국의 비영리 연구단체인 미래가속화연구재단(Acceleration Studies Foundation, 이하 ASF)의 주관으로 2006년 5월에 메타버스 로드맵 서밋(Metaverse Roadmap Summit)이 개최되었으며, 2007년에 ‘메타버스 로드맵(Metaverse Roadpmap, 이하 MVR)’ 보고서[31]를 통해 메타버스 개념과 전망에 대한 행사 토론 내용이 발표되었다. 여기서 ASF는 메타버스를 증강현실(AR), 라이프로깅(Life-logging), 거울 세계(Mirror Worlds), 가상 세계(Virtual Worlds)의 4가지 유형으로 나누었다. ASF는 각각의 유형들이 서로 구분되기보다는 융복합되는 형태로 발전할 것이라고 전망하면서, 메타버스를 ‘가상적으로 확장된 물리적 현실(Virtually-Enhanced Physical Reality)’과 ‘물리적으로 영구화된 가상공간(Physically-Persistent Virtual Space)’의 융합으로 정의하였다[32].

국내외 기업들의 메타버스 콘텐츠 및 플랫폼 개발 경쟁이 치열한 가운데, 최근 초 실감형 콘텐츠 기술 중심의 개발 업체들이 주목을 받고 있다. 이는 메타버스가 경제활동을 포함한 다양한 일상생활을 영위할 수 있는 '또 다른 세계'로 인정받기 위해서 현실감과 몰입감이 확보된 실사의 가상공간을 구현하는 일이 보다 중요해졌음을 보여준다[33]. 지금까지 메타버스 산업을 이끌어왔던 제페토나 로블록스(Roblox)와 같은 애니메이션 기반의 메타버스 플랫폼은 청소년 등 낮은 연령대의 사용자들을 대상으로 놀이 공간의 역할을 수행해왔다. 이에 기존의 메타버스가 실제로 현실 세계와 동등한 비중을 가지는 또 다른 세계로서 기능할 수 있을지에 대하여 의문이 제기되고 있다. 한편, 메타(Meta), 애플(Apple), 마이크로소프트(Microsoft) 등 세계적인 기업들은 이미 VR, AR, MR, AI 등의 최첨단 기술을 활용하여 초 실감형 콘텐츠와 가상공간을 신속하고 안정적으로 구현하기 위해 다양한 연구를 진행하고 있다. 국내의 경우, CES 2023에서 롯데정보통신과 자회사인 칼리버스(CALIVERSE)가 공개한 VR 및 PC 기반의 실감형 메타버스는 극대화된 현실감을 보여주며 '버추얼 스토어(Virtual Store)'와 '버추얼 시어터(Virtual Theater)', '버추얼 공연' 등의 실감형 콘텐츠를 선보였다[34].

3-2 3차원 재구성

3차원 재구성은 포토그래메트리(Photogrammetry)의 일종으로, 2차원 이미지의 집합으로부터 물체의 3차원 표현(3D Representation)을 나타내는 컴퓨터 모델을 생성하는 프로세스를 의미한다[35]. 3차원 재구성 소프트웨어는 지오메트리(Geometry)를 재구성하기 위해 카메라 정보를 기반으로 입력된 사진이 가지고 있는 픽셀(Pixel)의 3차원 월드 포지션을 복구한 다음, 충분한 유사성을 나타내는 공간적 픽셀 그룹(Spatial Group of Pixels)이 존재하면 포인트 클라우드(Point Cloud)를 생성한다[36]. 정리하면, 3차원 재구성의 원리는 다양한 위치에서 촬영한 여러 장의 이미지를 비교 및 분석한 결과물을 가지고 3차원 포인트 클라우드 볼륨(3D Point Cloud Volumes)을 추정하여 3차원 메시를 생성하는 것이라고 할 수 있다[37]. 앞서 상술한 내용은 해당 소프트웨어의 사용자가 정확한 3차원 데이터를 얻기 위해서 유사한 픽셀이 중첩되는 충분한 양의 이미지를 입력하는 것이 얼마나 중요한지 보여준다. 이는 다시 말해서 3차원 재구성 소프트웨어가 픽셀 간의 공간적 유사성을 충분히 계산해내지 못하면 좋은 결과물의 메시와 텍스처를 얻기 어렵다는 것을 의미한다. 이에 사용자들은 더욱 정밀한 포인트 클라우드를 얻기 위해 이미지 획득과정에서 LiDAR 센서 또는 RGB-D 카메라를 활용한다.

현재 업계에서 가장 많이 사용되는 3차원 재구성 기술 기반의 소프트웨어에는 Capturing Reality 사의 ‘Reality Capture', Agisoft 사의 ‘Metashape’ 등이 있으며, 해당 소프트웨어들은 모두 PC를 기반으로 작동된다. 한편, 최근 애플 사가 아이폰 프로 및 아이패드 프로 모델에 LiDAR 센서를 탑재하기 시작하면서, 업계에서는 해당 모바일 기기 기반의 3차원 재구성 소프트웨어를 개발하고자 하는 시도가 증가하고 있다. '3D Scanner App'은 Laan Labs 사에서 개발한 iOS 기반의 모바일 어플리케이션(Application, 이하 앱)으로, 아이폰의 카메라와 함께 LiDAR 센서를 사용하여 물체나 공간의 사실적인 3차원 메시를 생성한다[38]. 3D Scanner App은 사용자에게 메시 이외에도 3차원 재구성 과정에서 발생하는 다양한 종류의 데이터를 제공하는데, 표 3은 이를 정리한 내용이다.

LiDAR와 같은 고분해능 센서가 포함된 스캔 장비는 높은 구매 비용을 요구하는 반면, 아이폰은 비교적으로 접근성이 용이하기 때문에 관련 연구를 진행하는 데 있어 활용적 측면에서의 잠재가치가 매우 높다고 할 수 있다. 하지만 여전히 아이폰 앱을 활용한 3차원 재구성도 기존 연구와 마찬가지로 지나치게 큰 데이터를 생성해내거나 UV 맵에 문제가 발생하는 등 한계점이 존재한다. 또한, 모바일 기기의 특성상 넓은 공간에 대한 3차원 재구성 연산을 한 번에 수행할 수 없기에, 여러 차례에 걸쳐 획득한 메시들을 하나로 통합해주는 과정이 필요하다.

Open3D는 3차원 컴퓨터 비전(Computer Vision)과 데이터 프로세싱(Data Processing)을 위해 소프트웨어 개발을 지원하는 오픈소스 라이브러리(Open Source Library)이다[24]. Open3D는 포인트 클라우드, 메시 및 복셀(Voxel) 그리드 등의 3차원 데이터 처리를 위해 ICP 정합(Iterative Closest Point Registration)과 같은 여러 알고리즘과 시각화 도구를 제공하며, 개발자는 이러한 Open3D의 기능을 활용하여 대규모의 장면 작업을 위한 3차원 재구성 워크플로우를 구성 및 조작할 수 있다. 여러 그룹의 3차원 포인트 클라우드를 하나의 포인트 클라우드 볼륨으로 합치는 과정에서 정합 연산에 동차 변환행렬(Homogeneous Transformation Matrix, 이하 HTM)이 사용되는데, 개발자는 HTM을 추출하여 다른 3차원 데이터의 행렬 연산에 활용할 수 있다.

3-3 교차 편광 촬영기법

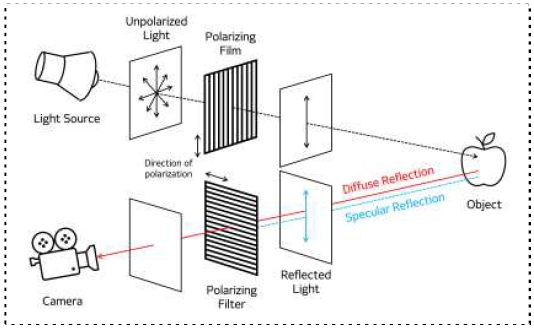

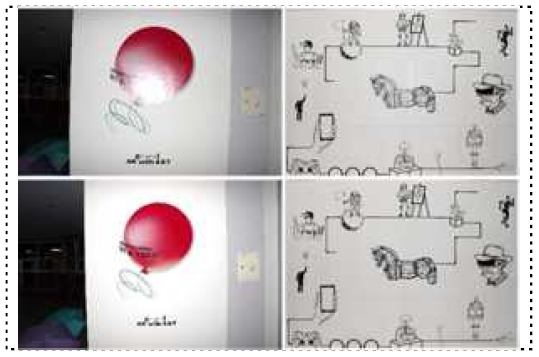

교차 편광 촬영기법은 본래 의학 분야에서 많이 활용하던 개념으로, 기존의 일반 촬영기법을 사용할 경우 나타나는 물체 표면의 빛 반사로 인한 텍스처의 품질 저하 문제를 교차 편광(Cross-Polarization) 원리를 활용함으로써 개선 및 극복한 촬영 방식이다[39],[40]. 일반적인 촬영 방식의 경우, 디지털 카메라를 통해 촬영할 때 피사체의 표면에서 발생하는 정반사(Specular Reflection)에 의해 색상 정보에 오차가 발생하게 된다. 한편, 교차 편광 촬영은 조명과 피사체 사이에 편광 필름을 설치하고 카메라에 편광 필터를 장착한 후 진행한다. 편광(Polarization)은 특정한 방향으로만 진동하며 나아가는 빛을 뜻하는데, 편광 필름을 이용하면 조명 등의 광원으로부터 편광을 구분해낼 수 있다. 이때 편광은 카메라 렌즈의 편광 필터의 부착 방향에 따라 평행 편광(Parallel Polarization)과 교차 편광(Cross Polarization)으로 구분되며, 이 중 교차 편광은 편광 필름과 편광 필터의 편광 방향이 서로 90°를 이루도록 부착하여 획득한다[40]. 그림 2와 같이 교차 편광 원리를 이용하여 촬영을 진행하면 광원에서 나오는 빛의 파장을 제한함과 동시에 물체 표면의 정반사 광을 제거함으로써, 결과적으로 피사체가 가지고 있는 실제 색상 정보에 가까운 텍스처를 얻을 수 있게 된다.

최근 영화 CG(Computer Graphic)뿐만 아니라 게임 등의 콘텐츠 내에서 사용되는 실사 풍의 3D 캐릭터를 제작하기 위해, 실제 모델의 얼굴을 촬영한 사진을 캐릭터의 텍스처로 활용하는 경우가 많다. 하지만 사진의 결과물을 3D 모델의 텍스처로 사용하기 위해서는 인물 얼굴에 표현된 하이라이트 등의 광원을 아티스트의 수작업을 통해 직접 제거하는 과정이 요구된다. 한편 수작업으로 진행되는 사진 후보정은 많은 시간과 비용이 소모되기에, 최근 많은 디지털 콘텐츠 제작 회사에서는 처음부터 광원이 제거된 사진을 획득할 수 있는 교차 편광 촬영기법을 도입하고 있다. 2018년 넥슨 개발자 컨퍼런스(Nexon Developer Conference, 이하 NDC)에서 넥슨(Nexon)은 게임 내 실사 풍 캐릭터의 텍스처 용 소스 이미지를 얻기 위해 사용한 교차 편광 촬영기법에 대해 발표했다[22]. 넥슨은 교차 편광 촬영을 위해 피사체의 전방에 편광 필름을 사용한 메인 조명을 설치하고 카메라에는 편광 필터를 장착하여 정반사가 일어나는 빛을 거르는 작업을 수행했다. 이때 카메라 렌즈에 부착된 편광 필터는 회전이 가능하므로, 촬영자가 직접 빛이 교차하는 지점을 찾아 편광의 방향을 조절할 수 있다. 또한, 넥슨은 피사체의 양 사이드에 보조 조명을 배치함으로써 피사체인 인물의 얼굴 주변이 어두워지는 것을 방지하고자 하였다. 한편, 에픽게임즈 사의 언리얼 엔진도 교차 편광 원리를 이용한 촬영기법을 공식 문서를 통해 소개하였으며, 추가로 촬영 대상이 벽, 바닥, 잎사귀 등과 같이 상대적으로 평평한 사물의 경우에는 카메라 플래시만으로 광원을 제공해도 충분하다고 언급했다[23].

Ⅳ. 제작과정

4-1 실내공간 스캔(Room Scale Scanning)

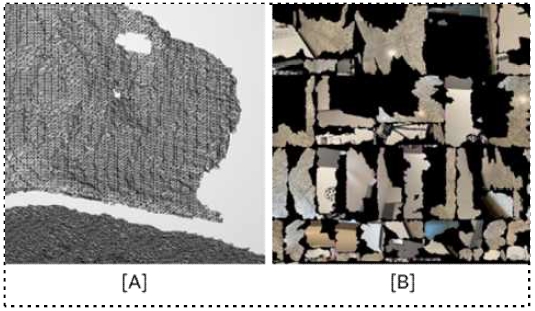

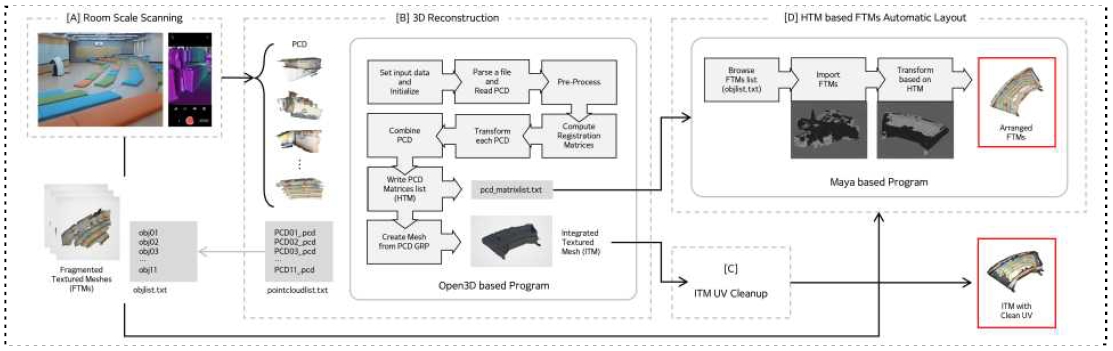

실사 기반의 가상공간을 구축하기 위해서는 실제 공간에 대한 3차원 데이터를 획득하는 과정이 선행되어야 한다. 본 연구에서는 실내공간의 스캔 작업을 위해 아이폰 13 프로 버전 모델을 기반으로 작동하는 모바일 앱인 3D Scanner App을 사용하였으며, 기본적으로 LiDAR Advanced 모드에서 표 4와 같이 설정한 상태로 진행하되 각 공간의 특성에 따라 적절히 값을 변경해주었다. 아이폰은 타 공간 스캐너 대비 비용, 설치문제 등 여러 측면에서의 접근성이 뛰어나지만, 모바일 기기라는 하드웨어의 특성상 넓은 공간의 데이터를 한 번에 획득하기는 어렵기에, 이 점을 고려하여 전체 공간을 위치에 따라 크게 4개의 구역으로 나눈 뒤 각각의 구역에서 여러 번에 걸쳐 스캔작업을 수행하였다. 하지만, 앱에서 제공하는 3차원 재구성 기술울 통해 생성된 3차원 모델은 표면에 구멍이나 노이즈가 존재하는 등 투박한 형태의 메시를 가진다(그림 3[A]). 텍스처는 상대적으로 높은 품질을 보이기는 하나, 여전히 디테일과 선명도 등에서 보완이 필요하다. 특히 UV 맵의 경우는 표준 UV 레이아웃(UV Layout) 방식을 따르지 않고 카메라 프로젝션(Projection) 방법을 통해 생성되기 때문에, 그림 3[B]와 같이 분해되어 한데 섞인 듯한 이미지를 나타낸다. 따라서, 앱을 통해 3차원 재구성된 메시와 텍스처는 콘텐츠 제작에 사용되기 전 추가적인 보정 단계가 필수적으로 요구된다. 이에 따라 일반적인 3차원 에셋 제작의 경우, 해당 과정에 아티스트의 노동집약적인 작업이 수반된다.

본 연구는 앞서 상술한 메시와 텍스처의 문제점을 보완하기 위해 3차원 재구성 기술을 제공하는 오픈소스 라이브러리인 Open3D와 마야 프로그램의 자체 기능을 활용함으로써, 아티스트의 노동력에 의존했던 일련의 작업과정을 자동화했다. 이를 위하여 연구자는 앱으로부터 포인트 클라우드 데이터(Point Cloud Data, 이하 PCD)와 텍스처가 포함된 메시(Fragmented Textured Meshes, 이하 FTMs)의 두 가지 형태로 데이터를 추출했다. 전자의 경우, 실내공간 스캔 과정에서 여러 번에 걸쳐 획득한 3차원 데이터를 포인트 클라우드를 기반으로 하나의 메시로 정합하기 위해 사용했다. 후자의 경우는 앱에서 제공하는 고품질의 이미지 소스를 이후, 마야의 기능을 거쳐 정제된 메시와 UV 맵의 텍스처를 생성하는 데 활용했다. 본 연구에서는 포인트 클라우드와 메시의 파일 형식을 각각 "PCD"와 "OBJ"(Wavefront Object File)로 설정하여 진행했으며, 각 데이터를 핸들링하여 실내공간에 대하여 3차원 모델링을 진행한 프로세스는 그림 4를 따른다.

4-2 3차원 재구성(3D Reconstruction)

실내공간 스캔 단계에서 획득한 포인트 클라우드에 대하여 Open3D 라이브러리를 통해 하나의 정교한 3차원 메시로 정합하는 과정을 진행했다. 그림 4[B]는 연구자가 3차원 재구성 작업 및 추후 단계에서 필요한 데이터의 획득을 위해 Open3D를 활용하여 개발한 프로세스를 나타낸다. 먼저, 프로그램 사용자는 공간적으로 인접한 영역이 존재하는 순서대로 PCD를 나열한 뒤 각각의 PCD 파일명을 하나의 텍스트로 작성하여 프로젝트 내 지정된 경로에 저장한다. 이때, 후반 작업을 위해 공간 스캔 과정에서 도출했던 FTMs 파일명도 해당 순서에 따라 하나의 텍스트로 저장해놓아야 한다. 프로그램을 실행하면, 시스템은 앞서 작성한 PCD 정보 파일을 기준으로 PCD를 차례대로 읽어 다운샘플링과 FPFH(Fast Point Feature Histogram) 특징점 계산 등의 전처리 작업을 수행한다. 다음으로, 인접한 영역 순서대로 배치된 PCD에 대해 차례대로 정합을 수행하여 하나의 PCD로 통합한다. 한편, 이때 정합 연산에 사용되는 HTM은 별도의 파일로 저장한다. 마지막으로, 하나로 통합된 PCD는 메시로 변환되어 프로그램 사용자가 지정한 PC의 경로 내에 저장된다. Open3D는 시각화 도구를 제공하고 있어 해당 프로그램이 수행하는 일련의 과정들을 사용자가 점검할 수 있게 한다.

4-3 통합된 메시의 UV 클린업(ITM UV Cleanup)

Open 3D 기반의 프로그램을 통해 하나로 정합한 메시는 마야 프로그램의 자체 기능을 사용하여 UV를 정리했다. 모델러들은 일반적으로 UV 맵을 수동으로 펼치는 솔루션을 선택하는데, 이러한 수동식 언래핑(Unwrapping)은 자동화 방법을 사용하는 것에 비해 선행연구(안용, 2021)에서 설명한 UV 언래핑의 기본원칙을 준수함에 따라 더 나은 결과를 가져올 수 있다. 메시의 UV 파라미터를 효율적으로 자동 획득하는 방법론은 CG 분야의 주요 연구 주제 중 하나로 여러 연구에서 상응하는 방법을 제시하였으나, 여전히 상용화된 우수한 자동화 방법은 나오지 않은 상태이다.

4-4 동차 변환행렬을 기반으로 메시 자동 레이아웃(HTM based FTM Automatic Layout)

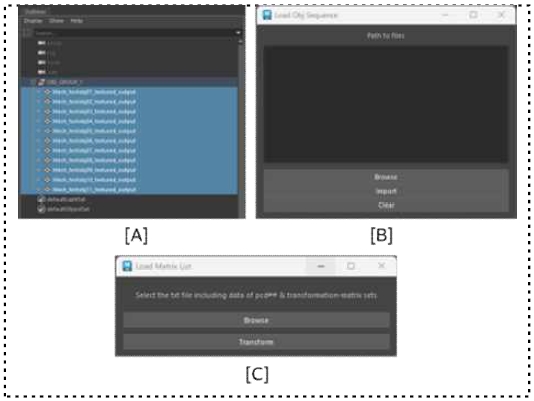

연구자는 마야 파이썬(Maya Python)에서 제공하는 마야 math 라이브러리를 활용하여, 본래 아티스트가 진행해야 하는 3차원 모델 배치(Layout) 작업의 일부를 자동화하였다(그림 4[D]). 이를 위해 그림 4[B]의 결과물인 포인트 클라우드에 대한 HTM을 그림 4[A]의 결과물인 FTMs에 연산함으로써 하나의 메시로 자동 배치(Automatic Layout)하였다. 연구자는 상술한 마야의 기능을 모델러 등의 아티스트가 쉽게 접근하여 활용할 수 있도록 간단한 사용자 인터페이스를 제작하였으며, 모습은 그림 5와 같다. 그림 5[A]는 앞서 아이폰 앱을 통해 획득한 FTMs를 마야로 읽어 오기 위한 프로그램이다. Browse와 Import 버튼을 통해 FTMs의 OBJ 파일명이 나열된 텍스트 파일을 선택하면 해당하는 메시들을 자동으로 불러올 수 있다(그림 5[B]). 그림 5[C]는 앞서 HTM과 그에 상응하는 메시에 대한 정보, 그리고 마야 math의 Transform 함수를 사용해서 FTMs를 하나의 메시로 자동 배치할 수 있도록 개발한 프로그램이다.

4-5 맵 베이킹(Map Baking)

마야에서는 디퓨즈 맵(Diffuse Map), 노멀 맵(Normal Map) 및 그 밖의 다른 유형의 맵을 하이폴리 메시에서 로우폴리 메시로 전송할 수 있는 맵 전송(Map Transfer) 기능을 제공하며, 이를 통해 사용자는 맵 베이킹 작업을 수행할 수 있다. 맵 전송 기능을 사용하려면, 먼저 텍스처 맵이 포함된 하이폴리 메시와 정제된 UV맵을 가진 로우폴리 메시를 준비해 월드 상에 교차시켜 놓아야 한다. 다음으로 하이폴리 메시를 소스 오브젝트(Source Object)로, 로우폴리 메시를 타깃 오브젝트(Target Object)로 설정한 다음, 생성하고자 하는 맵의 유형을 지정한 상태로 함수를 실행하면 하이폴리의 텍스처 맵을 갖는 로우폴리 메시를 획득할 수 있다. 한편, 마야의 맵 전송 함수는 일회성 프로세스이기 때문에 고해상도 메시 또는 텍스처 맵에 대한 변경 사항을 베이크된 맵에 추가로 자동 반영해주지 않는다. 따라서 사용자는 이미 베이크된 맵을 새롭게 업데이트하고자 할 경우, 맵 베이킹 과정을 처음부터 다시 수행해야 한다는 점을 유의해야 한다.

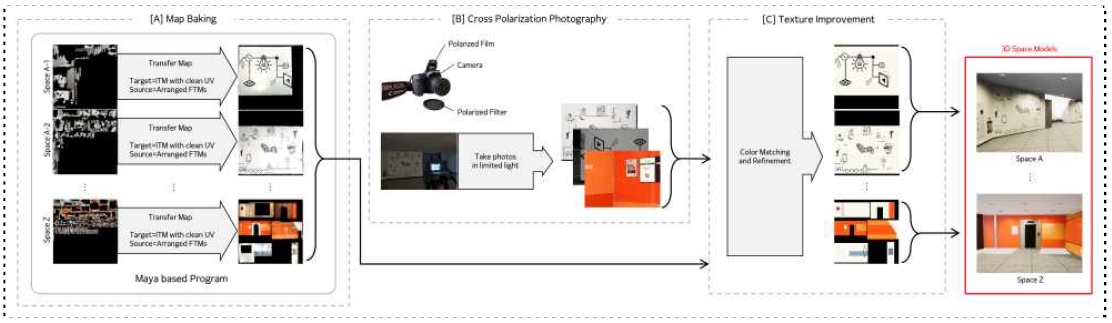

연구자는 상술한 마야의 기능을 본 연구의 맵 베이킹 작업에 활용하였으며(그림 6[A]), 이전 단계들과 마찬가지로 파이썬 스크립트를 통해 해당 작업을 자동화하였다. 이처럼 본 연구는 3차원 재구성, 메시 자동 배치, 그리고 맵 베이킹 과정까지의 일련의 작업공정을 프로그램화하여 아티스트의 노동시간을 최소화시킴으로써, 결과적으로 전체 작업을 효율적으로 수행할 수 있도록 하였다.

4-6 교차 편광 촬영(Cross Polarization Photography)

본 연구에서는 고품질의 텍스처를 얻기 위해 추가적인 이미지 소스 획득과정에 교차 편광 촬영기법을 도입하였다(그림 6[B]). 이때 Canon 90D 카메라 렌즈에 HOYA 사의 UX CPL(Circular Polarizer/Linear) Filter 58mm 제품의 편광 필터를 부착하여 사용하였다. 연구자는 소스 이미지 촬영을 밤에만 진행하고 카메라에 달린 플래시만을 조명으로 사용하는 등 불필요한 광원을 제한하였다. 또한, 추가로 카메라 플래시에 편광 필름을 부착해 타깃이 되는 공간 또는 오브젝트의 표면으로 입사하는 빛의 편광을 제어하였다. 또한, 이와 동시에 충분한 광량 확보를 위해 조리개 값을 6, 셔터스피드를 1/60로 설정하였으며 카메라 삼각대를 동원하여 촬영하였다. 그림 7을 통해, 교차 편광 촬영기법을 적용한 경우와 아닌 경우의 소스 이미지 품질 차이를 확인할 수 있다.

4-7 텍스처 개선(Texture Improvement)

교차 편광 촬영기법의 도입을 통해 획득한 고품질의 소스 이미지는 Adobe 사의 Photoshop 프로그램에서 색상을 균일한 수준의 데이터로 재조정하는 컬러 매칭(Color Matching) 작업을 거쳤다. 다음으로 맵 베이킹 과정을 통해 새롭게 도출한 텍스처 이미지를 기준으로, 교차편광 촬영으로 획득한 소스 이미지를 해당 텍스처 맵에 추가적으로 보정하는 작업을 진행하였다(그림 6[C]). 이때 실제 장소가 가지고 있는 공간적 특성에 따라, 바닥이나 천장의 타일 등과 같이 유사한 패턴이 반복되는 경우 UV 관련 노드에서 반복되는 형태로 설정해주었다. 해당 기능은 마야의 경우 place2dTexture 노드의 RepeatUV 속성에서, 언리얼 엔진의 경우 TexCoord 노드의 UTiling, VTiling 속성에서 설정할 수 있다.

4-8 룩 디벨롭먼트(Look Development)

룩 디벨롭먼트는 영화, 애니메이션 등을 제작할 때 제작자의 의도에 맞춰 관객에게 보이게 될 영상의 스타일을 결정하고 개선 및 구현해 나가는 과정으로, 흔히 줄여서 룩뎁(Look Dev)이라고 표현한다[41]. 연구자는 제작 파이프라인 내에서 3차원 모델링과 텍스처링 단계를 거쳐 도출한 3차원 공간 에셋을 가지고 언리얼 게임엔진 내에서 룩뎁 작업을 진행했다. 가상공간의 룩을 개선하기 위해서, 연구팀은 언리얼 엔진에서 자체적으로 제공하는 기본 머티리얼의 쉐이더(Shader) 그래프를 재사용하거나, 공간적 특성에 맞추어 머티리얼이 필요로 하는 질감, 스타일, 무드(Mood) 등에 대한 속성을 조정한 후에 활용하는 방식을 택하였다. 라이팅(Lighting)의 경우, 언리얼 엔진이 제공하는 포인트 라이트(Point Light), 스팟 라이트(Spot Light), 렉트 라이트(Rect Light)와 볼류메트릭 포그(Volumetric Fog) 등을 혼합해서 사용하여 실사 기반의 가상공간이 가지는 그래픽의 품질을 높이고자 하였다. 또한, 볼륨 액터나 1인칭·3인칭 플레이어의 카메라의 포스트 프로세싱(Post-Processing)에서 제공하는 피사계 심도(Depth of Field, 이하 DOF)와 모션 블러(Motion Blur) 등의 효과를 적절히 활용하여 더욱 높은 실재감을 나타내는 룩을 만들었다.

4-9 멀티플레이가 가능한 서버 탑재(Multi-playable Server Setup)

메타버스는 게임이나 영화에 국한되었던 가상 현실의 개념을 일상생활 속에서 구현하는 미래 사회 플랫폼이므로, 다수의 사용자가 실시간으로 동시접속 가능한 서버가 필수적으로 요구된다. 멀티플레이어 서버를 통해 사용자들은 다른 장소의 사용자들과 실시간으로 상호작용하며, 가상세계 속에서 사회, 경제, 엔터테인먼트, 문화 활동에 참여할 수 있다. 연구자는 포톤 클라우드(Photon Cloud)[42] 플러그인을 통해 언리얼 엔진 프로젝트에 포톤 클라우드 서버를 탑재하여, 플레이어 간에 실시간 상호작용이 가능하도록 하였다. 포톤 클라우드는 게임엔진에 사용되는 실시간 멀티플레이어 게임 서버이자 호스팅 서비스로, 개발자는 언리얼 엔진에서 제공하는 비주얼 스크립팅 시스템인 블루프린트(Blueprint) 기능을 활용하여포톤 클라우드 서버 상에서 사용자가 경험할 수 있는 다양한 멀티플레이 기능을 구현할 수 있다.

언리얼 엔진에서 포톤 클라우드 서버를 구축하는 방법은 다음과 같다. 첫째, 언리얼 마켓플레이스(Marketplace)의 포톤 서버를 프로젝트의 플러그인으로 추가한다. 둘째, 프로젝트 세팅에서 포톤 구성(Configuration) 항목에 App ID를 입력한다. App ID는 포톤 엔진(Photon Engine) 사이트에서 회원 가입을 한 사용자에 한하여 각각의 고유번호로 지급된다. 셋째, 포톤 클라우드 서비스가 블루프린트로 제공되는 액터를 프로젝트 레벨 상에 배치 또는 적용한다. 이때 관련된 플레이어 액터나 게임 스테이트(Game State)를 하나의 게임 모드(Game Mode)로 관리하면 프로젝트를 관리하는 데에 용이하다. 넷째, 포톤에서 제공하는 블루프린트 노드를 사용하여 플레이어 데이터 관리와 룸 가입(Join Room), 룸 만들기(Create Room) 등의 기능을 구현할 수 있다. 또 OnJoinedRoom, OnPlayerLeftRoom 및 OnCustomEvent와 같이 포톤 클라우드 상에서 발생하는 이벤트를 관리하는 이벤트 핸들러(Event Handler)를 설정하여 플레이어 상호작용에 대한 게임 로직을 처리할 수 있다.

Ⅴ. 연구 결과

본 연구에서는 일반적으로 사용되는 3차원 에셋 및 장면 생성 방법을 기반으로 3차원 재구성 기술과 교차 편광 촬영기법을 결합하여, 실사의 가상공간을 효과적으로 제작할 수 있는 파이프라인을 제안한다. 이에 먼저 문헌 연구를 통해 연구자가 고안한 방법의 실현 가능성과 활용 기술의 타당성을 검증하였다. 3차원 모델링 작업은 Open3D 라이브러리와 마야 내장 함수 등을 사용해 기능을 구현했으며, 텍스처 제작의 경우 교차 편광 촬영을 통해 반사 성분을 최소화함으로써 후반 작업 없이 사용할 수 있는 높은 품질의 텍스처를 획득한 후 공간 메시의 UV 맵 텍스처에 반영하였다. 앞서 상술한 일련의 과정은 파이썬 스크립트를 통해 자동화하였으며, 이를 통해 도출한 3차원 공간 모델은 그래픽 렌더링 품질의 개선을 위해 언리얼 엔진 상에서 머티리얼 적용, 라이팅, 포스트 프로세싱 등의 작업을 진행해주었다. 또한, 레벨이 완성된 언리얼 프로젝트에 멀티플레이 기능을 추가하기 위해 포톤 클라우드 서버를 탑재하여, 다수의 사용자가 가상공간에 접속하여 활동할 수 있도록 가상 환경을 조성했다. 아래의 그림 8은 본 연구에서 제안한 작업공정에 따라 구현한 가상공간을 언리얼 엔진의 시네마틱 카메라(Cinematic Camera)를 통해 촬영한 모습이다.

한편, 본 연구는 연구자가 제시한 파이프라인이 메타버스 및 실감형 콘텐츠 제작 산업에 실제로 적용되기 이전에 제작 솔루션의 활용 가능성을 진단했다는 한계를 지니고 있다. 따라서 이번 연구에서는 제작 파이프라인 연구 결과에 따른 정량적 차원에서의 실질적인 비용 효용성 효과를 산출하지 못했다. 또한, 연구자가 제안한 파이프라인의 최종 성능은 최초의 3차원 공간 스캔의 품질에 영향을 받는다는 제약이 존재한다. 연구팀이 Open3D 라이브러리 및 마야 파이썬을 기반으로 개발한 자동화 프로그램의 경우, 입력되는 포인트 클라우드 데이터가 가지고 있는 유사성을 기반으로 정합이 이루어진다. 때문에, 해당 작업공정의 결과물은 스캐너 및 카메라에서 획득되는 공간 데이터의 품질과 데이터 처리 과정, 프로그램 사용자의 데이터 선별 정확성에 대해 높은 의존도를 가진다. 공간 3차원 모델 생성 외에 UV 및 텍스처 제작에 관해서도 여전히 해결해야 할 과제들이 존재한다. 아직 UV 클린업 과정은 자동식이 아닌 수동식 언래핑 방식을 따르고 있으며, 이는 현재 포토그래메트리 기술이 메시의 UV를 생성하는 방식인 카메라 프로젝션 방법에서 기인한 결과이다. 향후에는 본 연구에서 활용했던 기술뿐만 아니라 다른 공학 기술들도 제작 파이프라인에 도입될 것을 고려하여, 추후 연구를 통해 가상공간 제작의 안정성을 높이고 요소 기술력을 보완할 필요성이 있다.

Ⅵ. 결 론

연구팀이 개발한 제작 파이프라인을 통해 도출된 결과물은 이전의 가상공간 제작 사례보다 더욱 자연스럽고 사실적인 외관을 보여준다. 나아가 해당 결과물은 온라인상에서 접속 가능한 형태의 시스템으로 구현되었으며, 이를 통해 연구팀은 메타버스 플랫폼으로서 초 실감형 가상공간이 가지고 있는 잠재성을 확인했다. 과거의 가상공간 제작연구는 대부분 포토그래메트리 및 3차원 재구성 등의 주요 기술 개발과 하드웨어 사용에 초점을 맞추어 진행되었다. 반면 본 연구에서는 최신 공학 기술을 고도화할 뿐만 아니라 해당 기술들을 실제 제작공정에서 상용화할 수 있도록 결합 및 최적화하고자 하였다.

본 연구의 가상공간 제작 파이프라인은 통상적인 3차원 에셋 제작 방식과 선행연구를 참고하여 설계되었으며, 제작 기간 단축과 소모 비용 절감 등 경제적 효율성뿐만 아니라 일부 작업공정 자동화에 따른 생산성과 소프트웨어 활용의 유연성까지 확보하였다. 또한, 연구팀이 제안한 제작 파이프라인은 전체 작업 과정에 대하여 각각의 단계별로 독립적인 수행이 가능하도록 구성되어 있다. 이러한 구조는 후속 연구의 방향성에 따라 세부 작업의 유연한 조작이 가능하게 하여 또 다른 공학 기술을 접목하는 데 있어 확장성을 제공할 것이다. 본 연구의 결과가 차세대 메타버스와 관련한 인프라 구축 및 기술발전 과정에 기여할 수 있기를 기대하는 바이다.

Acknowledgments

이 논문은 2023년도 중앙대학교 연구 장학 기금 지원에 의한 것입니다.

References

- J. H. Yoen and K. E. Kim, The Outlook and Innovation Strategy for the Metaverse Virtual World Ecosystem, STEPI, Sejong, STEPI Insight Vol. 284, pp. 1-53, December 2021.

- S. H. Lee and S. Y. Han, Metaverse Begins: Top 5 Issues and Prospects, Software Policy & Research Institute(SPRi), Gyeonggi, Issue Report IS-116, April 2021.

- Next Economy. Distributor, Gets into ‘Metaverse’ [Internet]. Available: http://www.nexteconomy.co.kr/news/articleView.html?idxno=14635, .

- ZDNET Korea. Naver ZEPETO, Attracts 220 Billion Won in Investment [Internet]. Available: https://zdnet.co.kr/view/?no=20211130232353, .

- Yeongnam Ilbo. [Tech Investor] Metaverse and Platform Industry Prospects...Will the Generation Change? [Internet]. Available: https://www.yeongnam.com/web/view.php?key=20210413001432368, .

- AI Times. Metaverse’s Future, Mixed Prospects [Internet]. Available: http://www.aitimes.com/news/articleView.html?idxno=147529, .

- Segye Ilbo. Maximizing Realism with Photorealism... Pushing the Boundaries of the Metaverse [Internet]. Available: https://m.segye.com/view/20220213508130, .

- Unreal Engine. Nanite Virtualized Geometry in Unreal Engine [Internet]. Available: https://docs.unrealengine.com/5.0/en-US/nanite-virtualized-geometry-in-unreal-engine/, .

- e4ds News. NVIDIA, Expands USD To Accelerate Metaverse and AI [Internet]. Available: https://www.e4ds.com/sub_view.asp?ch=2&t=0&idx=15288, .

-

M. A. Bolstad, “Large-scale Cinematic Visualization Using Universal Scene Description,” in Proceeding of 2019 IEEE 9th Symposium on Large Data Analysis and Visualization (LDAV), Vancouver, Canada, pp. 1-2, October 2019.

[https://doi.org/10.1109/LDAV48142.2019.8944362]

-

A. Baillet, E. Murphy, O. Dunn, and M. Gao, “Forging a New Animation Pipeline with USD,” in Proceeding of ACM SIGGRAPH 2018 Talks, Vancouver, Canada, pp. 1-2, August 2018.

[https://doi.org/10.1145/3214745.3214779]

-

Y. Yan, “Reconstruction of Photo-realistic 3D Assets for Actual Objects Combining Photogrammetry and Computer Graphics,” The Journal of the Korea Contents Association, Vol. 21, No. 1, pp. 147-161, January 2021.

[https://doi.org/10.5392/JKCA.2021.21.01.147]

- J. M. Park, “The 3D Garden Modeling Using Photogrammetry Technology,” Journal of Industrial Science Researches, Vol. 37, No. 2, pp. 1-9, February 2020.

- J. H. Jeon, H. K. Lim, and C. W. Kim, “Research on Dynamic 3D Modeling Based on Photogrammetry for Objective Perspective,” The Journal of the Korean Institute of Communication Sciences, Vol. 36, No. 12, pp. 38-44, November 2019.

-

J. S. Lee and I. G. Lee, “The 3D Modeling Data Production Method Using Drones Photographic Scanning Technology,” Journal of the Korea Institute of Information and Communication Engineering, Vol. 22, No. 6, pp. 874-880, June 2018.

[https://doi.org/10.6109/jkiice.2018.22.6.874]

-

J. M. Park, “Comparison of Virtual 3D Tree Modelling Using Photogrammetry Software and Laser Scanning Technology,” Journal of the Korea Institute of Information and Communication Engineering, Vol. 24, No. 2, pp. 304-310, February 2020.

[https://doi.org/10.6109/jkiice.2020.24.2.304]

-

J. S. Yoo, T. K. Yoo, and S. H. Seo, “AI-based 3D Spatial Structure Estimation Using Indoor Floor Point Cloud,” Journal of Digital Contents Society, Vol. 23, No. 6, pp. 1013-1020, June 2022.

[https://doi.org/10.9728/dcs.2022.23.6.1013]

-

K. H. Bae, “Development of Detection and In-painting in 3D Object Texturing Occlusion Area for Digital Twin Construction,” Journal of Korea Academia-Industrial Cooperation Society, Vol. 23, No. 10, pp. 683-689, October 2022.

[https://doi.org/10.5762/KAIS.2022.23.10.683]

-

G. J. Verhoeven, “Computer Graphics Meets Image Fusion: The Power of Texture Baking to Simultaneously Visualise 3D Surface Features and Colour,” in Proceeding of the 26th International CIPA Symposium, Ottawa, Canada, pp. 295-302, August 2017.

[https://doi.org/10.5194/isprs-annals-IV-2-W2-295-2017]

-

Z. D. Hou and K. H. Kim, “Study on the Creation of Realistic 3D Models of Building Glass Through the Combination of Photogrammetry and Image Editing Software,” Journal of Digital Contents Society, Vol. 22, No. 10, pp. 1551-1558, October 2021.

[https://doi.org/10.9728/dcs.2021.22.10.1551]

-

X. Wang, K. Yu, C. Dong, and C. C. Loy, “Recovering Realistic Texture in Image Super-resolution by Deep Spatial Feature Transform,” in Proceeding of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City: UT, pp. 606-615, June 2018.

[https://doi.org/10.48550/arXiv.1804.02815]

- NDC 2018. [NDC] The Magic of Disappearing Light in Photography - Shooting High-quality Character Texture Sources with Light Removed Using Cross Polarization Photography Techniques [Internet]. Available: https://www.youtube.com/watch?v=F9Q0mX3LY0w, .

- Unreal Engine. Taking Better Photos for Textures [Internet]. Available: https://docs.unrealengine.com/udk/Three/TakingBetterPhotosForTextures.html, .

-

Q. Y. Zhou, J. S. Park, and V. Koltun, “Open3D: A Modern Library for 3D Data Processing,” arXiv:1801.09847, , January 2018.

[https://doi.org/10.48550/arXiv.1801.09847]

-

G. H. Jin and S. R. Ha, “Texture Image Generation Technique Considering Storage Optimization of 3D-Spatial Data,” Journal of Digital Contents Society, Vol. 15, No. 4, pp. 457-464, August 2014.

[https://doi.org/10.9728/dcs.2014.15.4.457]

-

J. Zhang, Z. Wan, and J. Liao, “Adaptive Joint Optimization for 3D Reconstruction with Differentiable Rendering,” IEEE Transactions on Visualization and Computer Graphics, Vol. 29, No. 6, pp. 3039-3051, February 2022.

[https://doi.org/10.1109/TVCG.2022.3148245]

- Apple. iPhone 13 Pro [Internet]. Available: https://www.apple.com/am/iphone-13-pro/, .

-

A. Chopine, 3D Art Essentials: The Fundamentals of 3D Modeling, Texturing, and Animation, New York, NY: Focal Press, 2011.

[https://doi.org/10.4324/9780240814728]

-

Y. Yan, “The Study to Improve Re-topology Efficiency Between Analyzing Software and Making Examples of Different Types of 3D Models,” The Journal of Korea Contents Association, Vol. 20, No. 6, pp. 9-25, June 2020.

[https://doi.org/10.5392/JKCA.2020.20.06.009]

- The Hankyoreh. Metaverse, See If It Will Be ‘Post-internet’ after COVID [Internet]. Available: https://www.hani.co.kr/arti/economy/economy_general/1006235.html#csidxd6dfb30cfc0dfcaad25a73fd9d8d35a, .

- J. Smart, J. Cassico, and J. Paffendorf, “A Cross-industry Public Foresight Project,” Metaverse Roadmap Overview, 2007.

- S. Y. Han, Current Status and Prospects of Metaverse Platform, STEPI, Sejong, Future Horizon, Vol. 49, pp. 19-24, June 2021.

- IPO News. Hyper-realistic Tech Companies Leading the Way in Preoccupation with Metaverse [Internet]. Available: https://contents.premium.naver.com/ipo4u/iponews/contents/220421142334525Nt, .

- Donga Ilbo. [CES 2023] Rave Reviews for Lotte's Hyper-immersive Metaverse: ‘It Sets a New Standard’ [Internet]. Available: https://www.donga.com/news/It/article/all/20230106/117321727/1, .

- Nature. 3-D Reconstruction [Internet]. Available: https://www.nature.com/subjects/3d-reconstruction, .

- S. Lachambre, S. Lagarde, and C. Jover, Unity Photogrammetry Workflow, Unity Technologies, San Francisco: CA, Rapport Technique, pp. 1-97, July 2017.

-

S. Foster and D. Halbstein, Integrating 3D Modeling, Photogrammetry and Design, London, UK: Springer, pp. 1-103, 2014.

[https://doi.org/10.1007/978-1-4471-6329-9_1]

- 3D Scanner App. Website [Internet]. Available: https://3dscannerapp.com/, .

- Inven. [NDC 2018] “Character is All About Photography” Texture Making Through Cross-polarization Photography [Internet]. Available: https://www.inven.co.kr/webzine/news/?news=198337, .

- E. J. Kim, Development of Polarization Dental Imaging Modality and its Clinical Feasibility Study: Selection of Color for Tooth Restoration, Distribution of Dental Plaque and Evaluation of Teeth Whitening, Master’s Thesis, Yonsei University, Seoul, February 2012.

-

Y. M. Lee, “Study for 3D Look Development Process,” The Journal of the Korea Contents Association, Vol. 20, No. 1, pp. 392-402, January 2020.

[https://doi.org/10.5392/JKCA.2020.20.01.392]

- Photon Engine. Website [Internet]. Available: https://www.photonengine.com, .

저자소개

2022년:중앙대학교 예술공학부(공학사)

2022년~현 재: 중앙대학교 첨단영상대학원 영상학과 석사과정

※관심분야:디지털 휴먼(Digital Human), 시각효과 파이프라인(VFX Pipeline), 컴퓨터 그래픽스(Computer Graphics), 확장현실(eXtended Reality)

2002년:중앙대학교 기계설계학과 학사

2004년:중앙대학교 첨단영상대학원컴퓨터 특수효과 영상 석사

2012년:중앙대학교 첨단영상대학원 예술공학 박사

2012년~2018년: 덱스터 스튜디오 디지털 휴먼 & VR 연구소장

2019년~현 재: 중앙대학교 예술공학대학 부교수

※관심분야:가상존재(Virtual Beings), 확장현실(eXtended Reality), 시각효과(VFX), 실감 미디어(Immersive Media)