KLSG : 한국어 기반 대용량 음성 행동 데이터셋

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

음성과 행동은 사람의 의사소통에 매우 중요한 요소로 이들 사이의 특성을 파악하는 연구는 오랜 연구 주제이다. 양질의 음성 기반 행동 데이터는 연구적으로 그리고 산업적으로 다양한 활용성을 갖고 있다. 하지만 이 데이터는 주로 영어 언어에 국한되며 크기와 모달의 종류에 한계가 있다. 이에 본 연구는 761시간 분량의 한국어 기반 대용량 음성 행동 데이터셋(KLSG)을 수집하여 제안한다. 본 데이터셋은 발화자의 음성과 동작을 촬영하고 수집한 데이터를 동기화하였다. 또한 다시점 영상, 전사, 발화 감정 등 다양한 멀티 모달 데이터를 함께 제공한다. KLSG의 유효성을 파악하기 위해 선행 연구를 활용해 벤치마크 데이터와 비교 평가 진행하였다. 결과적으로 데이터의 특성은 비슷하며 한국인의 음성과 행동 특성을 포함함을 확인하였다.

Abstract

As speech and motion play a essential role in communication, studying co-speech gesture is a long-standing research topic. High-quality audio and gesture data are desired in both research and industry fields. However, only English-based audios are available and types of modality are also limited. In this study, we collect and propose 761 hours of Korean-based large-scale co-speech gesture dataset (KLSG) annotated with the multi-modal information, such as multi-view videos, script, emotions, etc. All corresponding data are synchronized with speech audio time. To verify the validity of KSLG dataset, we compared the results of various co-speech gesture generation tasks using KSLG and a benchmark dataset. The result shows that our dataset has similar characteristics with the benchmark dataset when training gesture generation models. A user study also suggests that our dataset contains Korean speech and behavior features.

Keywords:

Artificial Intelligence, Co-Speech Gesture Dataset, Multi-Modal Dataset, Motion Capture, Data Synchronization키워드:

인공지능, 음성 기반 행동 데이터, 멀티 모달 데이터셋, 모션 캡쳐, 데이터 동기화Ⅰ. 서 론

인공지능 기술의 발달로 음성 기반 행동 생성 분야의 발전이 많이 이루어졌다. 음성에 동반되는 발화 행동은 대표적인 비언어적 의사소통의 수단이다.[1,2] 따라서 많은 연구자는 음성과 행동의 특성 관계를 파악하려는 시도를 해오고 있다. 전통적 방법으로는 특정 음성에 많이 출몰하는 행동을 규칙 기반 방식의 연결 과정을 통해 결과를 만들어내는 방법을 제안하였다.[3-5] 이후 데이터를 활용해 음성의 특성과 행동의 특성 간의 연관성을 설계하는 방식으로 연구가 진행되어왔고[6,7] 인공지능의 발전은 단순 음성과 행동을 넘어 멀티 모달 데이터의 특성과 음성의 특성을 융합해 더욱 다양한 행동을 생성하는 방식의 접근으로 이끌었다.[8-10] 이러한 방향에 맞춰 기본적인 음성 행동 데이터셋[11,12]과 멀티 모달 데이터를 포함하는 데이터셋[17-20]이 제안되었다.

하지만 이 연구 분야에서 활용되는 데이터셋은 주로 영어 위주고 그 크기와 모달의 종류에도 한계가 있다. 음성은 발화자의 특성을 보여주는 하나의 특징이며 그 특징은 문화와 지역마다 다르게 나타난다.[23] 대부분의 음성 기반 행동 데이터셋은 영어를 기반으로 한다.[12-20] 따라서 영어 음성을 활용한 데이터로 학습한 인공지능 모델은 한국인의 특성을 잘 반영할 수 없다. 음성과 행동을 포함해서 추가적인 멀티 모달 데이터는 학습 과정에 사용되어 모델의 성능을 향상시키는 재료로 활용될 수 있다. 이러한 다양한 모달의 데이터는 전사 데이터, 감정 데이터, 표정 데이터, 영상 데이터를 포함할 수 있다. 하지만 이 모든 데이터를 한 번에 제공하는 선행 데이터는 존재하지 않는다.

발화자의 음성과 여기에 연관된 행동, 전사 등의 다양한 모달 데이터는 산업적, 연구적으로 가치가 매우 높기 때문에 이러한 데이터를 수집하는 것은 매우 중요한 문제이다. 앞서 언급한 대로 언어적 그리고 비언어적 특성을 갖는 음성과 행동은 인간 로봇 상호작용 연구 분야에서 다양한 연구[24,25]가 진행되고 있다. 특히 인간형 로봇은 사람과의 원활한 상호작용을 위해 매우 자연스러운 움직임이 요구된다. 이러한 로봇의 움직임을 재현하고 제시하기 위해 사양한 상황에서의 대규모의 학습 데이터가 필요하다. 또한 최근 늘어가는 메타버스, 가상 현실, 게임 산업 등에서 인간형 캐릭터를 활용한 콘텐츠가 적극 활용된다. 지금까지 이러한 캐릭터는 노동 집약적인 방식으로 생산되고 있었다. 이러한 문제 상황을 인공지능 기술로 해결하는 연구가 진행되고 있으며 여기에는 적절한 데이터가 필요하다.

우리는 761시간 분량의 한국어 기반 대용량 음성 행동 데이터셋(KLSG)을 제안한다. [표 1]에서 볼 수 있듯, 우리의 데이터는 선행 연구에서 발표된 데이터보다 대용량의 데이터를 다룬다. 또한, 중요한 특성으로 한국인의 음성과 행동에 초점을 맞춘 데이터를 수집하였다. 이는 한국인의 음성과 행동의 특성을 충실히 포함하는 데이터로 다른 연구들과의 큰 차별점이라고 생각한다. 또 다른 특징으로 KLSG는 1인 독백 데이터와 2인 대화 데이터를 포함한다. 한 명의 사람을 기준으로 이야기하는 독백 과정과 서로 다른 사람이 상호 작용하여 대화를 하는 과정은 다른 특성이 있다. 한국인의 발화 과정이라는 큰 틀에서 두 데이터를 수집하였고 이는 여러 방향으로 사용될 수 있다.

다양한 인적 정보를 갖는 총 486명의 한국인 연기자를 섭외하여 음성과 행동 움직임을 촬영하였고 전사 데이터, 감정 데이터, 영상 데이터, 표정 데이터를 추가로 마련하였다. 실험에 참여한 실험 대상자는 [표 3]에서처럼 성별에 따른 인원수를 비슷하게 설정하였고, 연령 또한 최대한 다양한 연령대의 참여자를 섭외하여 촬영하였다[표 5]. 발화자는 일반인과 전문 연기자 두 그룹으로 나누어 수집하였는데, 이는 일반인과 전문 연기자들의 움직임의 역동성 차이를 보완하여 움직임과 발화 과정에서의 특성이 다양하게 분포될 수 있도록 설계하였다. 12개의 발화 주제를 선정하여 다양한 상황을 제시하였고 발화 과정에서 발화자의 감정 상태를 태깅 하였다. 이는 [표 4]와 [표 6]에서 확인할 수 있다. 마지막으로 발화 타입을 두 가지(1인 독백, 2인 대화)로 나누어 데이터를 수집하였다[표 2]. 독백 상황에서의 발화 행동 및 감정 등은 2인 대화 상황에서의 그것과 차이가 있기 때문에 KLSG는 다양한 상황에서 활용될 수 있다.

수집한 데이터의 타당성을 검증하기 위해 벤치마크 데이터[12]와 이미 연구된 선행 연구[26]를 활용해 벤치마크 데이터와의 학습 경향성 및 사용성 평가를 비교하였다. 수집한 데이터의 특성이 음성 기반 행동 생성 연구 분야에서 일반적으로 활용하는 벤치마크 데이터[12]와 차이가 있는지를 검증하기 위해 동일 선행 연구 모델[26]을 활용해 비교 연구를 진행하였다. 과정에서 활용한 선행 연구 모델은 ARP라는 이름의 모델로 음성 기반 행동 생성 분야에서 널리 쓰이는 기본 모델이다. 결과적으로 학습 과정에서 확인할 수 있는 손실 함수의 경향성 및 정성 평가의 결과로 우리가 수집한 데이터가 벤치마크로 활용하는 데이터와 비슷한 성향을 갖고 있음을 확인할 수 있었다. 심지어 정성 평가 결과는 벤치마크 데이터보다 더욱 높은 점수를 받아 한국인 특성에 더욱 적합한 데이터라는 것을 확인할 수 있었다.

우리 연구의 기여점은 다음과 같다. 1) 한국어 기반 대용량 음성 행동 데이터셋을 제안함 2) 타임 코드 장비를 활용한 독자적인 행동과 음성의 동기화 과정을 제안함 3) 모션 캡쳐 데이터와 다시점 영상 카메라 간 변환 과정을 제안함

수집한 데이터는 다음 링크에서 다운로드 가능하다. https://url.kr/1jqbl

Ⅱ. 관련 연구

2-1 모션 캡쳐 데이터셋

Human3.6M[13] 는 인체 모션 데이터셋 중 가장 널리 사용되는 데이터셋 중의 하나이다. 해당 데이터셋은 5명의 여성과 6명의 남성 연기자의 360만 개 분량의 3차원 인체 관절 및 영상 데이터를 포함한다. 연기자의 모션은 10대의 모션 캡쳐 카메라와 4대의 동기화된 영상 카메라로부터 수집되며 토론하기, 사진 찍기, 통화하기 등 일상적인 사람의 동작을 포함한다.

HumanEva[14] 는 모션 캡쳐 시스템과 7대의 영상 카메라를 활용하여 3차원 관절을 수집한 데이터셋이다. 네 명의 연기자의 6가지 일반적인 동작 연기를 포함한다.

CMU Motion Capture Dataset[15] 은 카네기 멜론 대학교에서 공개한 모션 캡쳐 데이터셋으로 1인 연기자의 동작 및 2인 연기자의 상호 작용하는 동작을 모션 캡쳐 시스템을 통해 수집하였다. 연기 동작은 걷기부터 여러 가지 스포츠 동작을 포함한다. 다양한 형식(tvd, c3d, amc)의 모션 캡쳐 데이터와 저화질의 영상 파일이 제공된다. 모션 캡쳐 데이터와 영상 데이터는 시간 동기화가 맞지 않는 단점이 있다.

CMU Panoptic Studio Dataset[16] 은 모션 캡쳐 시스템을 사용하지 않고 다수의 카메라(521대)를 활용하여 삼각측량법(triangulation) 방식으로 모션 정보를 취득한 데이터셋이다. 캡쳐에 활용한 카메라는 480대의 VGA 카메라, 31대의 HD 카메라, 10대의 RGBD 카메라이다. 1인 동작부터 다수의 상호작용하는 동작을 수집하였으며 3차원 신체 관절, 얼굴 랜드마크 좌표 그리고 손 관절 정보를 포함한다. 또한 음성이 포함된 영상 데이터를 제공한다.

2-2 멀티 모달 데이터셋

MSP_AVATAR CORPUS[17]는 두 사람의 상호작용하는 장면을 수집한 멀티 모달 데이터셋이다. 이 데이터셋은 상반신 및 얼굴의 모션 캡쳐 데이터와 음성 데이터 그리고 전면에서 촬영한 영상 데이터를 포함한다. 자연스러운 연기를 위해 미리 정해둔 10가지의 대화 주제와 각 주제마다 2-5가지 시나리오를 연기자에게 제시하여 즉흥적으로 연기하도록 지시하였다. 촬영에 참여한 인원은 비 전문 연기자 6명으로 1명의 여성과 5명의 남성을 포함한다. 촬영 방식은 대화 과정에서 한 사람씩 번갈아 가며 모션 캡쳐를 진행하였다.

Talking with Hands 16.2M[18]는 두 사람이 마주 보고 대화하는 장면을 촬영한 모션 캡쳐 데이터 및 음성을 포함하는 데이터셋이다. 모션 캡쳐 슈트를 입은 두 연기자의 동작을 동시에 촬영하면서 전신 데이터뿐 아니라 손가락 모션 데이터 또한 취득한다. 총 50시간 분량으로 50명의 연기자가 제시된 주제에 대하여 자유토론하는 방식으로 촬영하였다.

Personality Dyads Corpus[19]는 2인의 대화 장면을 캡쳐한 멀티 모달 데이터셋으로 연기자 50명을 대상으로 수집하였으며 데이터의 길이는 약 1시간 분량이다.

TED Gesture Dataset[20]는 TED 강연 영상으로부터 취득한 3차원 상반신 관절, 음성, 대사 텍스트를 포함하는 데이터셋이다. 해당 데이터셋은 1000명 이상의 강연자의 동작을 포함하며 총 52.7시간 분량이다. 데이터의 취득은 상반신만 보이는 클립을 따로 분류하고 관절 추정 알고리즘을 활용하여 관절 데이터를 취득하였다.

Ⅲ. 데이터셋 개요

본 논문에서 제안하는 데이터셋은 1인 독백 및 2인이 대화하는 동작과 음성을 포함한다. 연기자들은 273명의 여성, 249명의 남성으로 전문 연기자 및 일반인으로 구성되어 있으며 10-60대의 다양한 연령대 분포를 가지고 있다. 또한, 스크립트 발화/자유 발화, 12가지의 발화 주제, 7가지의 감정 표현을 가지도록 구성하였다. 데이터 구성 항목에 따른 수량 분포는 [표 2-7]과 같다.

데이터셋은 크게 4가지의 타입으로 (1) 네 방향의 영상 데이터, (2) 인체 및 얼굴 모션 데이터, (3) 음성 데이터, (4) 발화 문장의 전사 및 각 데이터에서 생산되는 관련 메타 정보(발화자 개인 정보, 영상 데이터의 카메라 파라미터, 음성의 포맷 및 채널 수 등) 어노테이션 데이터로 구성되어 있다. 데이터는 총 761시간 분량이며, 어노테이션 데이터 8,524건을 포함한다.

Ⅳ. 데이터 수집 방법

4-1 사전준비

사전 준비란 실제 촬영이 진행되기 전에 연기자에게 발화 관련 정보를 제공하고 이를 숙지시키는 과정을 말한다. 발화 타입이 스크립트 발화의 경우 스크립트 전문을 작성하여 따라 읽도록 제시하고 자유 발화의 경우 주제 문장만을 제시하여 주제와 관련된 자유로운 발화를 하도록 지시한다. 또한, 데이터 촬영 시 원활한 진행을 위하여 촬영과 관련된 사항을 연기자에게 숙지시킨다.

4-2 촬영 환경 세팅

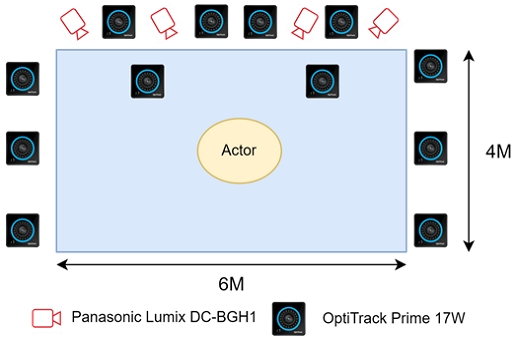

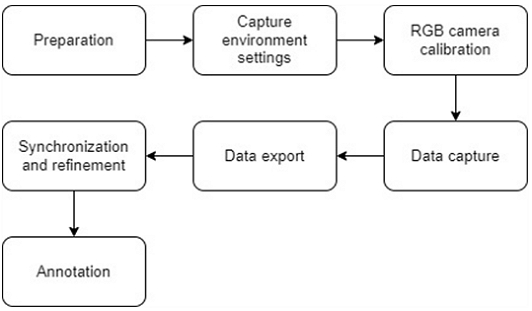

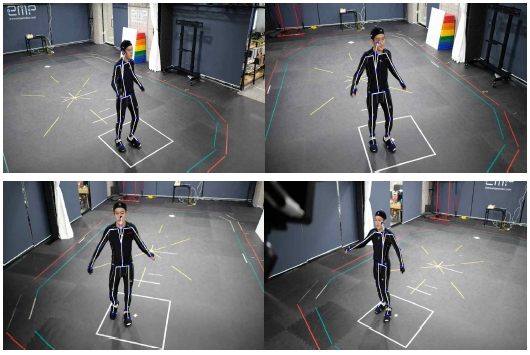

사전 준비가 완료된 후, 본 촬영을 위한 카메라 배치 및 캡쳐 슈트 위 마커 장착, 지시 화면 안정화, 타임 코드 장비 세팅 등을 진행하였다. [그림 1]과 같이 12대의 모션 캡쳐 카메라와 4대의 영상 카메라를 배치하여 캡쳐 영역을 확보하였다. 얼굴 모션 캡쳐 시 신체에 비해 상대적으로 캡쳐 영역이 작아 노이즈가 많이 발생하는 문제가 있어 연기자의 얼굴 가까운 곳에 광학식 카메라를 배치하여 캡쳐 오류를 최소화하였다. 그다음 모션 캡쳐 카메라의 위치 및 방위 정보를 구하기 위해 캘리브레이션 작업을 수행하였다.

캡쳐 대상이 되는 연기자에게는 모션 캡쳐 슈트를 착용시킨 뒤 미리 정의된 신체 및 얼굴 포인트에 마커를 부착한다. 그리고 연기자의 목소리를 녹음하기 위해 미니 사이즈의 녹음 장비를 슈트에 착용시킨 뒤 마이크는 최대한 입에 가깝도록 밀착시켰다. 그다음으로 연기자를 스튜디오 중앙으로 이동시켜 T-Pose를 취하도록 한 뒤 기본 스켈레톤을 정보를 취득하였다.

또 [그림 3]의 중간에 있는 사진처럼 연기자의 전방에 대형 디스플레이를 설치하여 발화 대사 및 지시사항을 전달하였으며, 모션 캡쳐-영상 카메라 간 시간 동기화를 위하여 타임 코드 입력 장비를 연결하고 초기화하였다.

4-3 영상 카메라 캘리브레이션

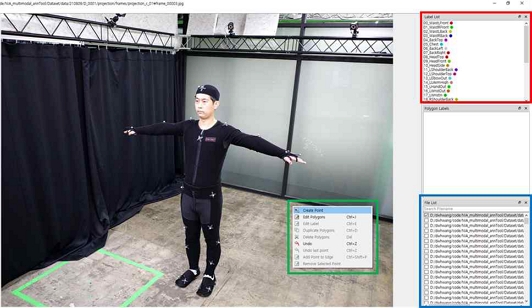

3차원 모션 캡쳐 데이터를 취득 후 영상 카메라에 투영(projection) 시키기 위해 카메라 캘리브레이션 과정을 진행했다. 이 과정은 내부 파라미터 정보를 구하고 3차원 월드 좌표계와 영상 카메라의 3차원 위치 간의 변환 행렬인 외부 파라미터 정보 계산을 포함한다. 카메라 내부 파라미터는 MATLAB에서 제공하는 캘리브레이션 툴 박스와 체커 보드 패턴을 활용하여 구하였다. 카메라 외부 파라미터는 3차원 마커 위치 좌표와 2차원 영상에서의 마커의 픽셀 좌표 쌍들로부터 opencv의 solvePnP 함수를 사용하여 취득하였다. 영상에서의 마커 위치 좌표를 수집하기 위하여 [그림 4]과 같은 툴을 제작하였다. 해당 툴을 활용해 크라우드 워커들이 마커의 위치를 어노테이션 하도록 하였다. 해당 과정은 영상 카메라 4대에 대하여 모두 동일하게 진행하였다.

4-4 데이터 촬영

데이터셋 수집을 위한 본 촬영 단계로서 모션 캡쳐, 영상 촬영, 음성 녹음을 수행한다. 매 촬영을 시작하기 전 타임 코드를 리셋 시키고 적절한 프롬프터 속도를 세팅 후 재생한다. 한 클립 분량은 5-6분으로 촬영하였다. 모션 캡쳐 촬영은 모션 캡쳐 프로그램(Motive)의 레코딩 버튼을 눌러 녹화를 진행하며 이를 데이터화한다. 모션 캡쳐 되는 스켈레톤의 움직임은 최종 PC에서 실시간으로 확인하게 되며, 오류가 확인되는 경우 재촬영을 하거나 캘리브레이션 작업을 재진행한다. 영상 촬영은 파나소닉 자체 소프트웨어를 활용하여 FHD 화질로 세팅한 후 진행한다. 음성 녹음은 연기자의 모션 슈트에 소형 마이크를 부착하여 수집되며 발화 타입이 대화인 경우 2인의 음성 파일을 각각 따로 녹음한 뒤 음성 편집 툴을 통해 한 개의 파일로 합친다.

4-5 데이터 산출

데이터 산출 작업은 촬영된 데이터를 적합한 포맷으로 추출하는 과정이다. 데이터 산출에 앞서 모션 캡쳐 데이터는 초기 품질 검사 과정을 수행한다. 추출된 모션 캡쳐 원본 데이터를 재생시켜 신체 및 얼굴 마커의 품질을 확인하고 정제 불가능한 경우 재촬영한다. 이후 원본 데이터로부터 다양한 형태의 모션 캡쳐 포맷(“csv”, “bvh”, “c3d”)로 추출한다. 영상 데이터는 파나소닉 자체 프로그램을 통해 “MOV” 포맷으로 저장되며 이후 “mp4” 포맷으로 변환한다. 녹음된 음성 파일은 “wav” 형태로 추출된다. 이렇게 산출된 데이터셋들은 지정 NAS 서버에 업로드된다.

4-6 데이터 동기화 및 정제

데이터 동기화 작업은 촬영된 모션 캡쳐 데이터와 영상 데이터, 그리고 음성 데이터의 시작과 끝 지점을 맞추는 작업이다. 이 과정은 타임 코드 입력 장비를 통하여 각 데이터에 기록된 타임스탬프 정보를 기준으로 전체 길이를 맞춘다. 모션 캡쳐 데이터는 Motive 프로그램을 통하여 시작-끝 지점을 편집하게 된다. 수집한 음성 데이터에는 타임 코드 정보를 삽입할 수 없다. 따라서 영상과 음성 데이터를 동기화하기 위해 두 데이터의 음성 파형을 맞춘다. 이후 영상 데이터에 속한 타임 코드를 음성 데이터에 적용해 길이를 맞추게 된다. 과정에서 어도비사의 프리미어 프로그램의 오토싱크 기능을 활용했다.

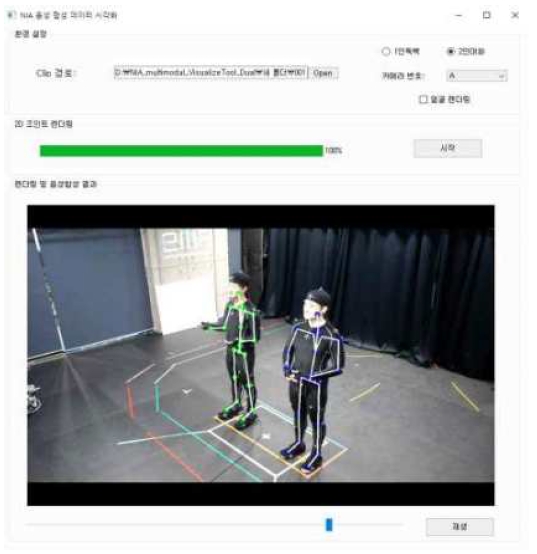

데이터 정제 과정에서는 동기화 작업이 완료된 데이터들의 시작과 끝 지점 위치와 길이 그리고 오류 유무를 체크한다. 이 작업은 [그림 5]에 제시된 시각화 소프트웨어를 통해 모션 캡쳐 데이터, 영상 데이터, 음성 데이터를 동시에 재생시켜 진행한다. 모션 캡쳐로 취득한 3차원 스켈레톤 좌표는 영상에 투영해 2차원 좌표로 시각화하여 영상과 동기화 여부를 체크한다. 음성 데이터는 영상 속 사람의 입모양과 비교하고 외부 소음 유무를 확인한다. 시각화 툴을 통하여 오류가 확인되면 각 데이터의 편집 툴을 통해 동기화 및 품질 오류를 수정하고 복구가 불가능한 경우에는 폐기한다.

4-7 데이터 어노테이션

데이터 어노테이션 작업은 음성 전사 정보, 메타 정보, 그리고 3차원 및 2차원의 신체 스켈레톤, 얼굴 마커 데이터를 라벨링 하는 과정이다. 이 데이터는 “json” 파일 포맷으로 수집한다.

음성 전사 작업에서는 크라우드 소싱 플랫폼의 라벨링 도구와 가이드라인을 기반으로 발화 내용 및 발화 관련 메타 정보를 어노테이션하게 된다. 이 작업은 [그림 6]와 같이 제시된 툴을 활용하여 크라우드 워커들이 음성 데이터를 재생시켜가며 음성 전사 작업을 진행하며 사투리 유무, 발화 주제 등의 발화와 관련된 메타 정보 또한 라벨링 한다.

수집된 어노테이션 데이터는 각자 정해진 형태에 맞춰 최종 결과 “json” 파일로 저장한다. 3차원 및 2차원의 신체 스켈레톤, 얼굴 마커 데이터는 미리 정의된 순서에 맞게 배열 형태로 어노테이션 한다. 그 외 오디오와 비디오 데이터의 메타정보, 카메라 캘리브레이션 정보, 데이터셋 메타 정보를 라벨링 한다.

Ⅴ. 캡쳐 시스템

5-1 모션 캡쳐 시스템

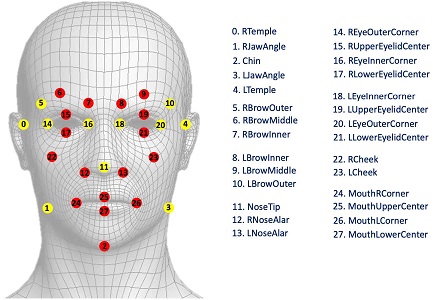

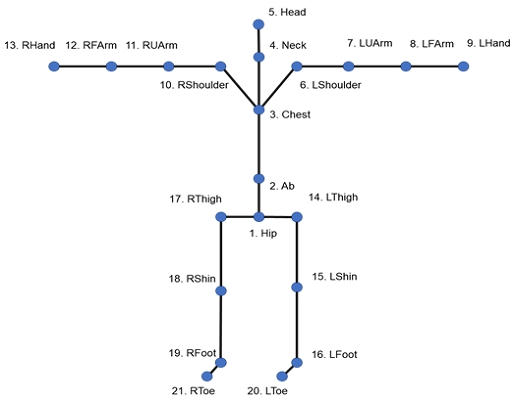

3차원 모션 데이터를 취득하기 위해 OptiTrack 사의 모션캡쳐 시스템과 Motive 소프트웨어를 이용하였다. 해당 시스템은 [그림 7]과 같이 광학식 카메라 장비, 멀티 포트 스위칭 허브, PC, 모션 캡쳐 슈트 및 마커로 구성되어 있다. 캡쳐에 사용한 OptiTrack Prime 17W 카메라는 1664x1008 화질과 360fps를 지원하며, 적외선 송/수신을 통해 마커에서 재귀 반사되는 적외선을 탐지하고 이를 통해 물체의 위치를 실시간으로 포착 후 데이터를 스위칭 허브로 전달한다. 스위칭 허브는 카메라와 PC 간의 연결 및 전원을 공급 역할을 한다. 모션 캡쳐 마커는 적외선 파장의 빛을 반사하는 스카치 재질의 테이프가 발라져 있는 부착물로 신체는 14mm, 얼굴은 3-4mm 크기를 사용하였다. 마커 부착 위치는 신체에 37개, 얼굴은 28개 부착하며 순서는 [그림 8]과 같다.

모션 캡쳐를 위한 스튜디오 환경 구성은 [그림 1]와 같다. 폭 4m, 길이 6m 실내 스튜디오에 12대의 광학식 카메라를 일정한 간격으로 배치하여 신체 및 얼굴 모션 캡쳐를 진행하였다. 얼굴 모션 캡쳐의 경우 마커의 절대 크기가 작고 얼굴 영역이 상대적으로 작아 노이즈가 다수 발생하여 연기자의 전면에 광학식 카메라를 가깝게 배치하여 캡쳐 오류를 최소화하였다.

5-2 2차원 영상 녹화 시스템

2차원 영상 데이터 수집을 위하여 연기자의 전방에 네 대의 영상 카메라를 설치하였다. 데이터 수집에 사용한 카메라는 파나소닉사의 Lumix DC-BGH1이며 최대 4K 화질, 60fps, Ethernet PoE+를 지원한다. 영상 데이터는 FHD 화질의 30fps로 수집하였으며 카메라 자체 마이크를 사용하여 발화 음성을 녹음하였다.

해당 음성은 연기자와 카메라 사이가 멀어 볼륨이 작고 노이즈가 유입이 될 수밖에 없다. 따라서 음성 데이터 수집용으로 사용하지는 않는다. 해당 음성의 파형과 카메라에 기록된 타임스탬프 정보를 활용하여 소형 마이크 장비로 녹음된 음성과 영상을 동기화를 하는데 사용된다. 영상 녹화는 파나소닉 자체 소프트웨어를 활용하였으며 “MOV” 파일 포맷으로 추출된 파일을 “avi” 포맷으로 변환하는 작업을 추가적으로 진행하였다.

5-3 음성 녹음 시스템

고품질의 음성 데이터 취득을 위해서 [그림 10]과 같은 미니 사이즈의 전지향성 마이크를 최대한 연기자의 얼굴과 가깝에 모션 캡쳐 슈트에 부착하여 녹음을 진행하였다. 녹음에 활용한 장비는 SHURE 사의 TwinPlex-TH53 제품으로 PC에 직접 연결하였으며 녹음을 위한 소프트웨어는 NCH Software 사의 RecordPad를 활용하였다.

5-4 동기화 시스템

모션 캡쳐 시스템, 영상 녹화 시스템, 음성 녹음 시스템을 동기화하는 작업은 동기 신호 발생기(Sync Generator) 장비를 활용한다. 광학식 카메라의 동기 신호 주기를 맞추고 각 시스템에 타임 코드를 입력 후 수작업으로 편집하는 방식으로 이루어진다. 모든 광학식 카메라의 동기 신호를 맞추기 위하여 OptiTrack 사의 eSync2 장비를 활용하여 각 카메라와 네트워크 장비들을 연결하였다.

또 시간 동기화를 위하여 음성 녹화 시스템을 제외한 모션 캡쳐 시스템과 영상 녹화 시스템에 타임 코드 장비를 연결하여 동기화된 시간 정보를 기록하였다. 시간 동기화를 위한 장비는 Tentacle Sync E 제품을 사용하였으며 스마트폰을 타임 코드 장비에 연결시켜 시작과 정지 제어를 하였다. 데이터 촬영 후 각 원본 데이터에 기록된 시간 정보는 시작 지점과 끝 지점을 맞추는데 활용된다. 녹음 시스템과의 시간 동기화 작업은 어도비사의 프리미어 소프트웨어의 오토싱크 기능을 활용하였다. 영상 데이터에 저장된 음성 파형과 녹음 시스템의 음성 파형을 동기화 시킨 후 시작-끝 지점 맞추도록 진행하였다.

Ⅵ. 데이터 구성

6-1 인체 및 얼굴 모션 데이터

모션 캡쳐 시스템을 통해 취득한 3차원 모션 데이터는 인체 데이터의 경우 “bvh”, “c3d”, “json” 포맷으로 저장되며 얼굴 데이터의 경우 “c3d”, “json” 포맷으로 저장된다.

“bvh”는 BioVision 사에서 개발한 모션 데이터 포맷으로 스켈레톤 정보와 모션 정보를 계층적으로 표현한다. 스켈레톤 구조는 [그림 12]와 같으며 각 프레임의 모션 데이터는 위치값 및 오일러 각도로 표현된다. “bvh” 파일은 스켈레톤 한 개에 대한 정보만을 담을 수 있기 때문에 한 클립당 1인 독백은 “bvh” 파일이 한 개, 2인 대화는 “bvh” 파일 2개를 추출하게 된다.

“c3d”는 모션 캡쳐 마커의 위치 정보를 포함하는 이진 파일 형식의 데이터이다. 텍스트 포맷보다 작은 크기를 갖으며 “bvh” 형식과는 다르게 골격이 미리 정의되지 않는다.

또 “json” 형식은 [그림 12]과 같은 구조의 스켈레톤 3차원 좌표(x, y, z)를 배열 형식으로 수집된다.

2차원 모션 데이터는 4-3에서 구한 카메라 투영 행렬로부터 3차원 모션 데이터를 네 방향의 영상 카메라에 투영시켜 취득하였다. 이 정보는 3차원 모션 배열과 동일한 순서로 2차원 좌표(x, y) 배열로 “json” 파일에 저장된다.

6-2 영상 데이터

연기자의 전신을 네 방향에서 촬영한 동기화된 영상 파일이다. 영상 길이는 5-6분이며 1920x1080 화질, “avi” 포맷으로 각 영상 파일은 약 100MB 크기를 갖는다.

6-3 음성 데이터

연기자의 발화 음성이 녹음된 파일로 “wav” 형식이다. 1인 독백 및 2인 대화 모두 한 개의 음성파일이며 5-6분 기준 약 50MB 크기를 갖는다.

6-4 어노테이션 데이터

메타 정보, 모션 정보, 전사 정보가 담긴 “json” 형식의 파일이다. 메타 정보에는 음성 및 영상 파일과 관련된 정보와 카메라의 캘리브레이션 파라미터 정보가 포함되어 있다. 모션 정보에는 3차원, 2차원의 신체 관절 및 얼굴 마커 좌표 정보가 배열 형태로 들어가 있다. 전사 정보에는 연기자의 발화 문장에 대한 정보를 포함한다. 추가로 각 발화 문장에 대해 발화자의 감정 상태, 문장의 시작 시간 및 종료 시간이 기록된다. 또한 발화자의 신상 정보가 들어간다. 여기에는 연령, 성별, 전문성 여부, 표준어 여부 등이 포함된다.

6-5 파일명 규칙

데이터셋 사용자의 편의성을 고려하여 산출 데이터셋들의 파일명 규칙을 정하였다. 파일명을 통해 독백/대화, 전문 연기자/일반인, 성별, 연령대, 연기자 번호, 클립 번호, 카메라 번호와 같은 정보를 쉽게 파악하도록 지정하였다. [표 8]은 파일명 지정 규칙이며 발화 타입이 독백 혹은 대화 인지에 따라 다소 차이가 있다. 아래는 독백과 대화에 따른 파일명 형식과 그에 따른 예시를 보여준다.

- 파일명 형식: MM_{대화/독백}_{전문 연기자/일반인}_{성별}_{연령대}_{연기자 번호}_{클립번호}_{카메라번호}

- 예시: MM_M_C_M_C_S001_001_A

- 파일명 형식: MM_{대화/독백}_{전문 연기자/일반인}_{성별1}{성별2}_{연령대1}{연령대2}_{연기자 번호1}{연기자번호2}_{클립번호}_{카메라번호}

- 예시: MM_M_C_MM_CA_S001S002_001_A

Ⅶ. 딥러닝 모델을 활용한 수집 데이터 타당성 검증

수집 데이터의 타당성을 살펴보기 위해 음성 기반 행동 생성 선행 연구[26]와 해당 분야 벤치마크 데이터셋[12]을 활용해 비교 연구를 진행했다. 우리가 수집한 데이터는 음성, 모션, 텍스트, 감정, 발화자 정보, 얼굴 표정을 아우르는 다양한 모달을 포함한다. 하지만 이 모든 모달을 포괄하는 기존 연구 분야와 벤치마크 데이터셋은 없다. 따라서 가장 기본 데이터인 음성 데이터와 행동 모션 데이터를 사용한 음성 기반 행동 생성 분야의 선행 연구[26]와 벤치마크 데이터셋[12]을 활용한다. 선행 연구의 학습 방법론을 바탕으로 벤치마크 데이터와 수집 데이터를 각각 학습하고 학습 경향성과 결과 분석을 진행해 우리가 수집한 데이터의 특성과 벤치마크 데이터의 특성을 비교한다.

7-1 음성 기반 행동 생성 분야와 기본 모델

음성 기반 행동 생성 문제는 입력으로 음성 데이터를 활용하고 그 음성에 적합한 발화자의 행동을 생성하는 생성 문제이다. 최근 딥러닝을 활용한 연구가 활발하게 진행됨에 따라 표현 학습(representation learning) 방법론을 활용해 음성과 행동의 공통 잠재 공간(latent space)을 모델링 하는 접근법들이 많이 연구되고 있다.

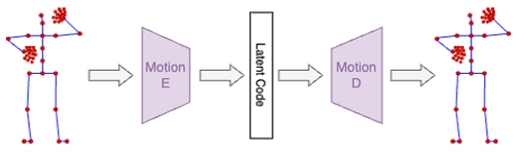

본 논문에서는 ARP[26]라 불리는 베이스라인 모델을 활용한다. 이 모델은 2019년 IVA 학회에서 발표된 논문[26]에서 제시한 모델이다. 제시하는 딥러닝 모델은 음성(Audio)에서 시작해 모션-음성 표현 정보(Representation) 그리고 행동(Pose)의 생성 과정을 거치기에 ARP라고 불린다.

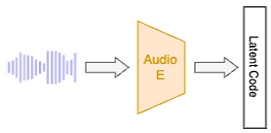

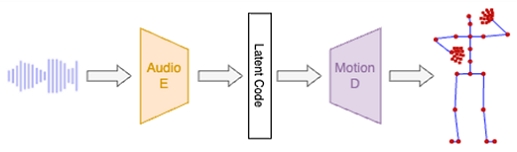

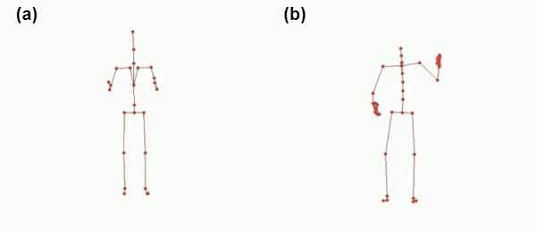

ARP 모델[26]은 Auto Encoder 구조를 갖으며 음성을 입력으로 받아 음성에 해당하는 행동 정보를 생성한다. 전체적인 구조는 [그림 16]에 묘사되어 있다. 본 네트워크는 3초가량 음성의 MFCC 특성 값을 입력으로 활용하고 전신 주요 관절의 x, y, z 3축에 해당하는 좌표가 출력으로 나온다. 해당 모델은 encoder와 decoder로 구성되며 각각의 모듈은 개별적으로 학습시킨 후 각각을 병합해서 최종 구조를 만든다. 먼저, [그림 14]에서 볼 수 있듯 입력과 출력의 형태가 같은 denoising autoencoder 구조의 자세 재건 네트워크를 설계하고 학습한다. 이때 활용하는 encoder 구조를 Motion E, decoder 구조를 Motion D라 한다. Motion E의 결과로 생성되는 latent code는 행동의 정보를 포함하는 표현력이다. 사용된 Motion D는 최종 네트워크에서 활용된다. 다음 과정으로 음성을 행동의 latent code로 사상시키는 네트워크를 학습한다. 이 과정은 [그림 15]에 도식화되어있다. 해당 네트워크는 학습 데이터베이스의 음성과 행동 쌍을 바탕으로 음성에서 행동의 latent code로 변환하는 네트워크 Audio E로 구성되어 있다. 마지막으로 [그림 15]의 Audio E와 [그림 14]의 Motion D 네트워크를 활용해 음성에서 행동으로 생성되는 [그림 16]의 최종 네트워크를 구성한다.

7-2 벤치마크 데이터

수집한 데이터의 특성을 바탕으로 이와 최대한 비슷한 특성을 갖는 벤치마크 데이터를 선정하였다. 수집 데이터의 특징은 한국어를 사용한다는 점이다.

Trinity 음성 행동 데이터[12]를 벤치마크 데이터로 활용했다. 해당 데이터는 2020년부터 시작된 음성 기반 행동 생성 분야의 저명한 대회인 GENEA 챌린지[27]에서 사용되는 데이터로 2018년 IVA 학회에서 제안되었다. 영어를 사용하는 1명의 남성 발화자가 취미, 일상생활 등 다양한 주제로 244분 동안 촬영한 데이터를 포함한다. 발화자의 행동은 53개 마커를 활용해 모션 캡쳐를 진행하였고 이후 후처리를 통해 최종적으로 56개 관절의 정보를 수집하였다. 또한 음성은 모션과 시간적으로 동기화 되도록 녹음되었다.

7-3 타깃 데이터 설정

벤치마크 데이터[12]와의 비교를 위해 수집 데이터의 일부를 활용해 학습과 평가에 활용하였다. 수집한 전체 데이터는 총 486명, 761시간의 대규모의 데이터이다. 이 데이터 중 10인, 20인, 30인 데이터를 학습 데이터로 사용하였다. 과정에서 대화 주제 및 인구 통계학적 편향 없이 고르게 분포할 수 있도록 임의로 학습 데이터를 선택하였다. 발화자 한 사람당 약 120분가량의 음성 및 행동 데이터를 갖고 있기 때문에 학습 데이터는 각각 20시간, 40시간, 60시간을 포함한다. 또한, 우리는 데이터 추가에 따른 경향을 살펴보기 위해 더 많은 수의 발화자 데이터는 적은 수의 발화자 데이터를 포함하는 방식으로 선택하였다. 예를 들어, 20인 데이터는 10인 데이터를 포함해 추가로 새로운 10인의 데이터를 포함한다.

7-4 실험 및 결과

ARP 논문에서 제안하는 학습 세팅으로 벤치마크 데이터와 선별 데이터를 학습하였다. 학습량, 모델의 구조 등은 학습의 결과에 영향을 미치는 중요한 요소이므로 이는 기존 논문에서 제안하는 값을 똑같이 활용하였다. 다만, 두 데이터의 목표 관절 개수 차이가 있어 해당 부분의 값만 다르게 설정하였다.

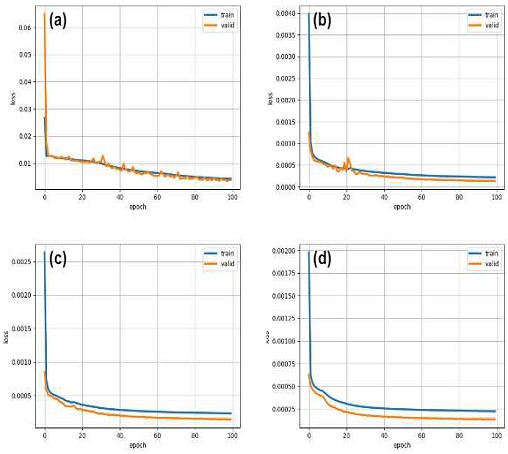

학습 과정에서 보이는 손실 함수의 경향성에서 벤치마크 데이터와 우리가 수집한 데이터의 차이는 없었다. 딥러닝 모델 학습 과정에서 생성되는 Loss 변화 양상은 학습 진행 상황을 확인할 수 있는 척도로 사용한다. 또한 서로 비슷한 특성을 갖는 데이터를 이용해 같은 환경, 동일한 네트워크를 학습 시켰을 때 Loss는 비슷한 양상을 보인다. ARP 논문[26]에서 활용하는 Loss 함수는 MSE(Mean Squared Error)로 각 관절의 정답 위치와 추론된 위치 값 사이의 차이로 정의하였다. 손실 함수는 학습 및 검증 데이터로 생성되는 두 종류로 [그림 17]의 파란 실선(학습 데이터)과 주황 실선(검증 데이터)으로 표현되어 있다. [그림 18]의 (a)는 Trinity 음성 행동 데이터의 손실 함수 그래프이다. 그리고 (b), (c), (d)는 각각 10인, 20인, 30인의 손실 함수 그래프이다. 4가지 그래프 모두 학습 데이터 및 검증 데이터에서의 그래프 경향이 같은 것을 확인할 수 있다. 검증 데이터를 이용한 상황에서 학습 인원이 증가되면서 검증 데이터 손실 그래프의 변동이 적은 것을 확인할 수 있다. 이는 많은 데이터를 학습하면서 학습이 더욱 안정적으로 진행되며 일반화 역시 좋아짐을 알 수 있다.

Loss graphs from trained networks using each dataset. (a) benchmark (b) 10 people validation data (c) 20 people validation data (d) 30 people validation data

학습된 음성 기반 행동 생성의 결과는 정량 평가로 측정하였다. 생성 문제는 입력에 대한 결정론적인 결과만 존재하는 것이 아니므로 대다수의 행동 생성 논문은 정성 평가로 결과 성능을 평가한다. 이에 따라 본 논문에서도 설문 결과를 통해 생성된 행동의 질적 판단을 진행하였다.

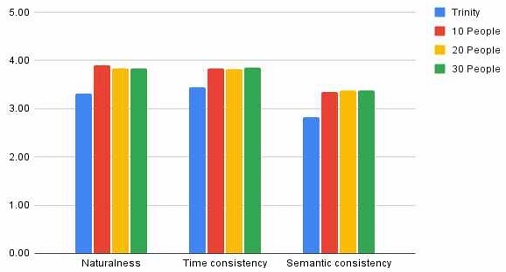

총 21명의 참여자를 대상으로 9가지 문항에 대한 7점 리커트 스케일 사용자 평가 설문을 진행하였다. 이들의 평균 나이는 31.9살이며 남성 16명, 여성 5명으로 구성되었다. 각각의 영상은 약 20초가량의 10개의 한글 음성을 활용해 추론한 결과 영상으로 설문을 진행했다. 설문의 문항은 [표 9]에 명시된 바와 같이 총 9가지 질문으로 구성된다. 구체적인 질문 항목은 [표 9]에 명시되어 있다. 한 명의 실험 참여자는 한글 음성 10개로부터 생성된 총 40개의 영상(4 모델 x 10개 영상)에 답을 한다. 참여자들이 진행한 실험 화면은 [그림 18]와 같다. 참여자는 각 질문에 대한 답변으로 ‘매우 동의하지 않음’(1점)부터 ‘매우 동의함’(7점) 중 하나를 선택한다.

실험 결과 벤치마크 데이터보다 수집 데이터에서 더 높은 정성평가 결과를 얻었다. 결과는 [그림 19]에서 확인 가능하다. '자연스러움' 평가 항목에서 볼 수 있는 Trinity의 결과는 한국 음성에 맞춰 생성된 행동 데이터가 어색했고 어울리지 않았다는 것을 의미한다. 반면 수집 데이터를 이용한 경우에 더 만족스러우며 자연스러웠음을 확인할 수 있었다. 또한 '의미 적합성'에서 상대 우위를 보여준다. 이는 한국 음성과 그에 맞는 행동이 존재하며 거기에 잘 매칭됨을 의미한다. 마찬가지로 잘 추론된 행동으로 적절한 시간 적합성이 표현되었다고 해석할 수 있다. 결과 수치의 차이는 일부 언어적인 차이에 기인한 것으로 볼 수 있지만 수집한 데이터가 그만큼 한국인의 음성과 행동을 잘 포함하고 있다고 해석할 수 있다.

정성평가 그래프 상 10인, 20인, 30인 결과에서는 뚜렷한 차이가 보이지 않는다. 검증에 활용한 ARP 모델은 다수의 발화자를 고려한 네트워크가 아니며 활용하는 벤치마크 데이터 역시 1인 발화자 데이터이다. 10인, 20인 그리고 30인까지 학습 데이터는 많아지지만 발화자 각각이 서로 다른 음성과 행동 패턴을 갖고 있다. 그런 상황에서 단독 발화자를 기반으로 한 ARP 모델이 여러 발화자의 특성을 학습하지 못했고, 단지 여러 사람이 갖고 있는 공통적인 특성만을 이용해 행동을 생성한다. 그렇기에 정성평가 그래프 상 10인, 20인, 30인 결과에서 뚜렷한 차이가 보이지 않는다. ARP 모델의 구조적 특성은 지금까지 음성 기반 행동 생성 데이터가 1인 중심의 발화 데이터이기 때문이다. 반면, 이번 과제로 수집한 데이터는 많은 사람들의 특성을 반영한 데이터로 연구적으로 활용 가치가 높다고 생각한다.

Ⅷ. 데이터셋의 잠재적 활용성

수집 데이터는 매우 다양한 활용도를 갖고 있다. 본 수집 과정에서는 동일한 특정 상황에서 발화자의 음성과 그들의 행동을 촬영했다. 또한 과정에서 얻을 수 있는 전사 데이터, 발화 감정 데이터, 얼굴 움직임 데이터, 다시점 영상 데이터를 추가로 수집하였다. 이는 지금까지 제시된 음성 기반 행동 데이터 중 가장 많은 종류의 멀티 모달 데이터를 포함하며 절대적인 수집 양도 많다. 그리고 한국인을 기반으로 수집한 데이터로 한국인의 특성을 담고 있다. 이러한 이유로 수집한 데이터는 상업적으로 그리고 연구적으로 활용될 가능성이 매우 높다.

전통적인 인간 로봇 상호작용 분야를 포함해 최근 늘어나는 가상 현실, AI 휴먼 등의 상업적 콘텐츠 분야에서 활용될 수 있다. 인간 로봇 상호작용 기술은 인간과 로봇의 자연스러운 의사소통과 적절한 상호 협력을 목표로 하는 기술이다. 로봇의 형태는 매우 다양하지만 사람형 로봇은 그 특성상 자연스러운 표현이 요구된다. 그러한 사용자의 요구에 맞춘 움직임을 인공지능 기술을 통해 제어하기 위해 대규모의 데이터가 필요하다. 특히 한국 사람의 음성 및 행동 특성을 반영한 데이터는 그 활용적 측면에서 가치가 높다고 생각한다. 또한, 비대면 상황의 증가 및 메타버스, 가상 현실 기술의 발전으로 AI 휴먼, 버츄얼 아바타 캐릭터의 사용이 많아지고 있다. 현재는 이런 컨텐츠 기반 산업에서 애니메이터의 노동 집약적 과정이 들어가는 상황이다. 추후에 캐릭터 움직임을 제어하는 과업을 인공지능 기술로 해결하는 과정에서 데이터로 활용될 수 있다고 생각한다.

또한, 음성 기반 행동 데이터 관련 분야를 넘어 타 연구 분야의 데이터로 활용할 수 있는 연구적인 가치가 있다. 제안하는 데이터는 음성과 행동뿐 아니라 그에 종속되는 여러 멀티 모달 데이터를 포함한다. 이 데이터들은 음성, 행동 데이터를 입력으로 하고 감정을 출력으로 하는 것처럼 여러 조합으로 네트워크의 입, 출력에 활용될 수 있다. 혹은 아예 개별적으로 네트워크 설계에 활용될 수 있다. 예를 들어, 관절의 좌표를 이용해 자세 추론(pose estimation) 영역에서 활용 가능하며, 얼굴 영상과 얼굴의 랜드마크 정보를 활용해 얼굴 표정 추출, 감정 추론 등의 영역에서 활용 가능하다. 그리고 음성 데이터와 사람의 신원 정보를 활용하는 음성 인식 영역에서의 데이터로 활용 가능하다.

Ⅸ. 결론

본 논문에서는 한국어를 기반으로 하는 대규모 발화 음성 행동 데이터를 수집하여 제공하였다. 수집한 데이터는 전체 761시간의 분량으로 이는 지금까지 제시된 오픈 데이터 중 가장 대규모의 데이터이다. 또한 한국인의 특성을 반영할 수 있도록 한국어를 기반으로 하였고, 1인 독백 상황과 2인 대화 상황을 모두 포함하였다. 그리고 단순 음성 및 행동 데이터뿐 아니라 전사, 감정, 다시점 영상 등 다양한 모달의 데이터를 추가로 제공하였다. 수집한 데이터의 타당성을 확인하기 위해 음성 기반 행동 생성 분야에서 널리 쓰이는 벤치마크 데이터와 동일 분야의 기본 인공지능 모델을 통해 비교 실험을 진행하였다. 결과적으로 동일한 학습 양상을 확인했고 정성평가의 결과로 한국인의 특성을 반영하고 있음을 확인할 수 있었다. 하지만 본 데이터와 데이터 수집 과정은 몇 가지 개선점을 갖고 있다. 먼저 우리는 전신 데이터를 취득하기 위해 넓은 영역에서 촬영을 진행했다. 그렇기에 상대적으로 작은 영역을 포함하는 얼굴 표정 위치 정보는 작은 움직임을 보이고 있다. 다음으로 데이터 촬영 수집 대상인 한국인의 특성으로 전신 루트의 움직임이 거의 없다. 실험 과정에서 별도의 제약은 없었지만 1인 및 2인 대화의 참여자들 대부분은 정적으로 서있는 상태로 발화하였다. 따라서 우리 데이터는 안무 추론, 역동적인 움직임을 요하는 과업에는 적합하지 않다. 하지만 앞서 언급한 것처럼 여러 연구 분야의 메인 혹은 서브 데이터셋으로 연구적인 기여를 할 수 있고 메타버스, AI 휴먼 등의 사업화 관점에서도 기여할 수 있다고 생각한다. 본 데이터는 다음 링크에서 사용 가능하다. https://url.kr/1jqblv

Acknowledgments

본 논문은 문화체육관광부 및 한국콘텐츠진흥원의 2021년 문화콘텐츠 R&D 전문인력 양성(문화기술 선도 대학원) 사업으로 수행되었음 (과제명: 버추얼 프로덕션 기반 콘텐츠 제작 기술 R&D 전문인력 양성, 과제번호: R2021040044, 기여율: 80%)

References

- Knapp, Mark L., Judith A. Hall, and Terrence G. Horgan, Nonverbal communication in human interaction, 8th ed. Cengage Learning, 2013.

-

Matsumoto, David, Mark G. Frank, and Hyi Sung Hwang, eds, Nonverbal communication: Science and applications,1st ed. Sage Publications, 2012.

[https://doi.org/10.4135/9781452244037]

-

Arfib, D., Couturier, J.M., Kessous, L. and Verfaille, V., “Strategies of mapping between gesture data and synthesis model parameters using perceptual spaces”, Organised sound, Vol. 7, No. 2, pp. 127-144, Aug 2002.

[https://doi.org/10.1017/S1355771802002054]

-

Quek, Francis, et al., "Multimodal human discourse: gesture and speech", ACM Transactions on Computer-Human Interaction (TOCHI), Vol. 9, No. 3, pp. 171-193, Sep 2002.

[https://doi.org/10.1145/568513.568514]

-

Cassell, Justine, "A framework for gesture generation and interpretation", Computer vision in human-machine interaction, pp.191-215, 1998.

[https://doi.org/10.1017/CBO9780511569937.013]

-

Sakai, Kurima, et al., "Novel speech motion generation by modeling dynamics of human speech production", Frontiers in Robotics and AI, Vol. 4, pp. 49, Oct 2017.

[https://doi.org/10.3389/frobt.2017.00049]

-

Cassell, Justine, et al., "Modeling the interaction between speech and gesture", in Proceedings of the Sixteenth Annual Conference of the Cognitive Science Society, Routledge, 2019.

[https://doi.org/10.4324/9781315789354-27]

-

Yoon, Youngwoo, et al., "Speech gesture generation from the trimodal context of text, audio, and speaker identity", ACM Transactions on Graphics (TOG), Vol. 39, No. 6, pp. 1-16, Nov 2020.

[https://doi.org/10.1145/3414685.3417838]

-

Kucherenko, Taras, et al., "Gesticulator: A framework for semantically-aware speech-driven gesture generation", in Proceedings of the 2020 International Conference on Multimodal Interaction, 2020.

[https://doi.org/10.1145/3382507.3418815]

-

Bhattacharya, Uttaran, et al., "Speech2affectivegestures: Synthesizing co-speech gestures with generative adversarial affective expression learning", in Proceedings of the 29th ACM International Conference on Multimedia, 2021.

[https://doi.org/10.1145/3474085.3475223]

-

Takeuchi, Kenta, et al., "Creating a gesture-speech dataset for speech-based automatic gesture generation", International Conference on Human-Computer Interaction, 2017.

[https://doi.org/10.1007/978-3-319-58750-9_28]

-

Ferstl, Ylva, and Rachel McDonnell, "Investigating the use of recurrent motion modelling for speech gesture generation", in Proceedings of the 18th International Conference on Intelligent Virtual Agent. 2018.

[https://doi.org/10.1145/3267851.3267898]

-

Ionescu, Catalin, et al., "Human3. 6m: Large scale datasets and predictive methods for 3d human sensing in natural environments", IEEE transactions on pattern analysis and machine intelligence, Vol. 36, No. 7, pp. 1325-1339, Dec 2013.

[https://doi.org/10.1109/TPAMI.2013.248]

-

Sigal, Leonid, Alexandru O. Balan, and Michael J. Black, "Humaneva: Synchronized video and motion capture dataset and baseline algorithm for evaluation of articulated human motion", International journal of computer vision, Vol. 81, No. 1, pp. 4-27, Mar 2010.

[https://doi.org/10.1007/s11263-009-0273-6]

- CMU Graphics Lab Motion Capture Database [internet]. Available: http://mocap.cs.cmu.edu/, .

-

Joo, Hanbyul, et al., "Panoptic studio: A massively multiview system for social motion capture", in Proceedings of the IEEE International Conference on Computer Vision, 2015.

[https://doi.org/10.1109/ICCV.2015.381]

-

Sadoughi, Najmeh, Yang Liu, and Carlos Busso, "MSP-AVATAR corpus: Motion capture recordings to study the role of discourse functions in the design of intelligent virtual agents", 11th IEEE International Conference and Workshops on Automatic Face and Gesture Recognition (FG), Vol. 7, 2015.

[https://doi.org/10.1109/FG.2015.7284885]

-

Lee, Gilwoo, et al., "Talking with hands 16.2 m: A large-scale dataset of synchronized body-finger motion and audio for conversational motion analysis and synthesis", in Proceedings of the IEEE/CVF International Conference on Computer Vision, 2019.

[https://doi.org/10.1109/ICCV.2019.00085]

- Tolins, Jackson, et al., "A multimodal motion-captured corpus of matched and mismatched extravert-introvert conversational pairs", in Proceedings of the Tenth International Conference on Language Resources and Evaluation (LREC'16), 2016.

-

Yoon, Youngwoo, et al., "Robots learn social skills: End-to-end learning of co-speech gesture generation for humanoid robots", 2019 International Conference on Robotics and Automation (ICRA), 2019.

[https://doi.org/10.1109/ICRA.2019.8793720]

- De la Torre, Fernando, et al., "Guide to the carnegie mellon university multimodal activity (cmu-mmac) database", 2009.

-

Jörg, Sophie, Jessica Hodgins, and Alla Safonova, "Data-driven finger motion synthesis for gesturing characters", ACM Transactions on Graphics (TOG), Vol. 31, No. 6, pp. 1-7, Nov 2012.

[https://doi.org/10.1145/2366145.2366208]

-

Hall, Bradford ‘J., "Theories of culture and communication", Communication theory, Vol. 2, No. 1, pp. 50-70, Feb 1992.

[https://doi.org/10.1111/j.1468-2885.1992.tb00028.x]

-

Stiefelhagen, Rainer, et al., "Natural human-robot interaction using speech, head pose and gestures", 2004 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)(IEEE Cat. No. 04CH37566), Vol. 3, 2004.

[https://doi.org/10.1109/IROS.2004.1389771]

-

Deuerlein, Christian, et al., "Human-robot-interaction using cloud-based speech recognition systems", Procedia CIRP 97, pp. 130-135, 2021.

[https://doi.org/10.1016/j.procir.2020.05.214]

-

Kucherenko, Taras, et al., "Analyzing input and output representations for speech-driven gesture generation", in Proceedings of the 19th ACM International Conference on Intelligent Virtual Agents, 2019.

[https://doi.org/10.1145/3308532.3329472]

-

Kucherenko, Taras, et al., "A large, crowdsourced evaluation of gesture generation systems on common data: The GENEA Challenge 2020", 26th international conference on intelligent user interfaces, 2021.

[https://doi.org/10.1145/3397481.3450692]

저자소개

2018년 : 한양대학교 대학원 (공학석사)

2018년~현 재: ㈜인공지능연구원, AiLIVE 사업팀 리서치 엔지니어

※관심분야 : 영상처리(Computer Vision), 인체 자세 추정(Human Pose estimation), 행동 생성(Gesture generation)

2018년 : 서울대학교 융합과학기술대학원 석.박사 통합과정 박사 수료

2018년~현 재: ㈜인공지능연구원, AiLIVE 사업팀 리서치 엔지니어

※관심분야 : 인공지능(Artificial Intelligence), 컴퓨터 비전(Computer Vision), 행동 생성(Gesture Generation)

1993년 : 서울대학교 계산통계학 학사

1995년 : 서울대학교 계산통계학 석사

2005년 : 메릴랜드대학교 칼리지파크 컴퓨터과학 박사

2013년~현 재: 부교수, 서울대학교 융합과학기술대학원

2011년~2013년: 시니어연구원, 미국 아도비 연구소(Adobe)

2005년~2011년: 연구원, 미국 제록스 팔로알토 연구소(Xerox PARC)

※관심분야 : 인간-컴퓨터 인터랙션 (HCI), 소셜 컴퓨팅 (Social Computing), 빅데이터 (Big Data), 인공지능 (Artificial Intelligence)

2001 : 서강대학교 대학원 (공학석사)

2011 : 서강대학교 대학원 (미디어공학박사)

2011년~2012년: (주)애니프레임 미디어아트팀 팀장

2012년~2018년: 네이버 커넥트재단( 구. NHN NEXT) 교수

2018년~현 재: (주)인공지능연구원 기술연구소 AiLIVE팀 리더

※관심분야 : 컴퓨터 비전(Computer Vision), 디지털 휴먼(Digital Human), 인간컴퓨터상호작용(Human Computer Interaction), 인체 자세 추정(Body Pose Estimation)