스캔 기반의 게임 캐릭터로 만든 실사형 얼굴 랜드마크 데이터세트

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

딥러닝 기술은 큰 비용을 통해 구축된 데이터로 문제를 해결한다. 특히, 사람의 얼굴에 대한 데이터는 초상권 등의 문제로 취득하기 어렵다. 본 논문에서는 실제 사람과 유사한 캐릭터를 이용하여 기존의 얼굴 랜드마크 데이터세트와 같은 성능을 보이는 데이터 수집 방법을 제안한다. 먼저, 스캔 기반의 실사형 캐릭터를 준비하고 배경 환경과 촬영 조건을 3차원 게임엔진으로 구현한다. 다음으로 얼굴 움직임의 기준이 되는 캐릭터 본을 기준 랜드마크로 변환한다. 마지막으로 다양한 각도와 환경에서 데이터를 취득하여 얼굴 랜드마크 모델에 학습시킨 뒤, 베이스라인 모델과 비교 분석한다. 실험 결과, 제안한 데이터세트로 학습한 모델은 베이스라인 모델과 비슷한 결과를 보였으며, 실제 사람을 이용하여 구축한 데이터세트보다 좋은 결과를 보였다. 이를 통해, 실사형 캐릭터 데이터세트는 다양한 표정과 각도에서 얼굴 데이터를 제약 없이 얻을 수 있고, 캐릭터 특성을 통해 랜드마크 정보도 추가적인 노동력 없이 정답을 만들 수 있어, 3차원 게임엔진을 이용한 실사형 데이터의 실효성과 확장성을 확인하였다.

Abstract

Deep learning solves problems with data built through large costs. Especially, it is difficult to obtain a person's face data due to problems such as portrait rights. In this paper, we propose a data collection method that shows the same performance as the existing facial landmark dataset using photo-realistic characters. First, a scan-based character is prepared and the background environment and camera conditions are implemented with a 3D game engine. Next, the character bone, the basis for facial movement, is converted into a reference landmark. Finally, after acquiring data from various angles and environments, training the facial landmark model, and comparing with the baseline model. From the experiment, the model trained with the proposed dataset showed similar results to the baseline model, even showed better results than our real people dataset. Through this, our dataset can obtain face data from various expressions and angles without restrictions, and landmark through character can make the correct answer without additional labor, so Effectiveness and scalability were confirmed.

Keywords:

Face Dataset, Facial landmark, Facial landmark detection, Synthetic data, Deep Learning키워드:

얼굴 데이터세트, 얼굴 랜드마크, 얼굴 랜드마크 검출, 합성데이터, 딥러닝Ⅰ. 서 론

최근 딥러닝 기반의 인공지능 기술의 발달로 여러 문제를 데이터 기반으로 해결한다. 모델의 성능은 모델과 문제의 매니폴드 간 유사도에 비례하고, 이는 많은 데이터가 요구된다. 하지만 얼굴 분야에서는 초상권 등의 개인정보의 문제로 다량의 데이터를 확보하기 쉽지 않다. 따라서 대표성을 가지는 정확한 데이터, 좋은 데이터로 데이터세트를 구축해야 한다.

지도학습에 활용되는 데이터는 주로 정답을 다수의 참여자가 함께 만드는 대중 참여 제작으로 만들어진다. 정답의 질은 각 참여자의 주관적인 판단으로 결정되는데, 정답을 매기는 지침과 해당 분야의 전문지식의 여부에 따라서 정답에 대한 신뢰도의 차이가 크게 발생한다. 예를 들어, 얼굴 랜드마크 데이터세트는 얼굴에서 특징으로 보여지는 위치를 특징점(랜드마크)으로 표시하는데, 처리하는 이미지 양과 특징점의 개수가 초기 연구에 대비하여 늘어나 세밀하고 반복적인 작업이 요구된다. 결과적으로 정확한 정답을 얻기 위해서는 많은 노동력과 비용이 소요된다.

데이터세트 구축의 문제점을 해결하는 방법으로 도메인 랜덤화(domain randomization)[1]를 이야기할 수 있다. 이는 시뮬레이션으로 다량의 가상 데이터를 만들어 모델을 학습시키는데 제안된 방법으로, 특정 문제 해결을 위한 데이터를 시뮬레이션에 기반하여 다양하고 정확한 데이터세트를 구축할 수 있다. 최근 메타버스에 대한 관심으로 가상 인간에게 사용할 수 있는 실사형 캐릭터가 게임엔진을 통해서 제공되고 있다. 그 중 메타휴먼(MetaHuman)은 실제 사람의 스캔 데이터를 이용하여 만들어진 캐릭터로 현실감의 정도가 실시간성을 목표로 하는 게임엔진임에도 매우 높다. 특히 성별, 인종, 나이와 얼굴의 모양부터 피부의 질감까지 개인정보의 문제 없이 다양하게 만들 수 있고, 다양한 캐릭터를 같은 체계 내에서 조작할 수 있어 정확하고 일관된 정답 값을 얻을 수 있다.

본 논문에서는 스캔 기반의 실사형 캐릭터를 이용한 데이터세트의 구축 방법을 제안하고, 얼굴 랜드마크 검출에 대해서 구축된 데이터세트의 효용성을 확인하여, 제안된 방법의 유용성과 확장성을 제시한다.

Ⅱ. 관련 연구

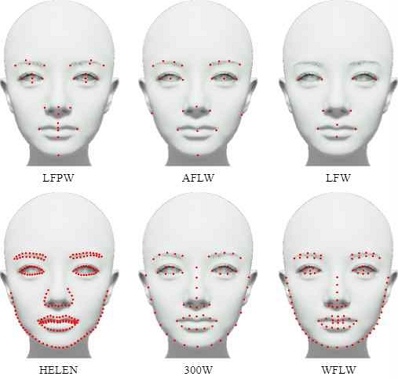

본 장에서는 기존의 얼굴 랜드마크 데이터세트와 활용 모델에 대해 설명한다. LFPW(Labeled Face Parts in the Wild)[2] 데이터세트는 랜드마크가 안 보이는 상태를 3단계로 구분하여 표현하였다. LFPW와 같은 랜드마크 분포인 COFW(Caltech Occluded Faces in the Wild)[3] 데이터세트는 손, 모자, 머리카락 등에 의해서 가려진 얼굴 특징점에 대한 분석이 추가되었다.

다수의 랜드마크 라벨링을 위해서 반자동 방식으로 라벨링 한 데이터세트도 있다. 기존 데이터세트의 얼굴 영역 해상도가 낮은 문제점을 해결하기 위해 가로 500픽셀 이상인 얼굴 영상을 모은 Helen 데이터세트가 제안되었다[4]. 이 데이터세트는 알고리즘으로 랜드마크의 초기치를 지정한 뒤 대중 참여 제작으로 데이터를 구축하였다. 300W(300 Faces-In-The- Wild)[5] 데이터세트는 형식이 다른 기존 얼굴 랜드마크 데이터세트들을 하나로 합치는 목적으로, 랜드마크 추출 알고리즘의 결과를 수동으로 선택하여 구축되었다. 다양한 환경에서 여러 감정 표현을 포함하고 있는 것이 특징이다.

딥러닝 학습에 활용될 수 있는, 1만 장 이상의 데이터세트도 존재한다. LFW(Labeled Faces in the Wild)[6] 랜드마크 데이터세트는 기존의 LFW 얼굴 인식 데이터[7]에 랜드마크를 추가하여 같은 사람의 랜드마크들이 존재한다. AFLW(Annota -ted Facial Landmarks in the Wild)[8] 데이터세트는 이미지 공유 사이트(Flickr)를 이용하여 자세, 표정, 인종, 나이, 성별 등의 특성과 다양한 환경을 포함하여 구축하였다. WFLW(Wider Facial Landmarks in-the-wild)[9] 데이터세트는 가려짐, 큰 자세 변화, 표정 여부, 화장 여부, 밝기, 번짐 등에 대한 특성이 라벨링 되어있다. 각 랜드마크에 대한 상세위치는 그림 1에, 데이터의 수량과 특징점 개수는 표 1에 정리하였다.

본 논문은 구축된 데이터세트의 활용 여부를 확인하기 위해서 얼굴 랜드마크 추출 알고리즘인 PFLD(Practical Facial Landmark Detector)를[10] 활용한다. PFLD는 2.1MB의 크기와 140fps의 처리 속도를 가진 모바일넷 기반의 빠르고 가벼운 모델로, 랜드마크뿐 아니라 얼굴의 방향도 출력한다. 본 논문에서는 실시간성에 가중치를 두고 실제 활용도가 높은 PFLD 모델을 테스트 모델로 선정하였다.

더하여 최근 연구로, 3차원 머리 메시 모델을 이용한 데이터세트를 구축하거나[11], 703개의 조밀한 랜드마크를 이용하여 조절할 수 있는 3차원 얼굴 모델을 재구성하는 연구들이 진행되고 있다[12]. 본 논문에서는 사람의 노동력으로 만들기 힘든 데이터에 대한 기초 연구로 합성데이터의 가능성을 확인해보고자 한다. 이를 위해 본 논문에서는 기존 랜드마크의 데이터세트 중 WFLW 데이터세트의 대체 목표로, PFLD 알고리즘을 학습시키고 실제 결과를 분석한다.

Ⅲ. 실사형 얼굴 데이터세트 구축

본 장에서는 실사형 얼굴 데이터세트의 구축 과정을 이야기한다. 먼저 데이터 생성에 활용된 캐릭터 준비 과정을 서술한다. 다음으로 실제 데이터가 생성되는 과정을 설명한다. 마지막으로 풀고자 하는 얼굴 랜드마크 추출에 대한 정답 정제방법을 정리한다.

3-1 캐릭터 준비

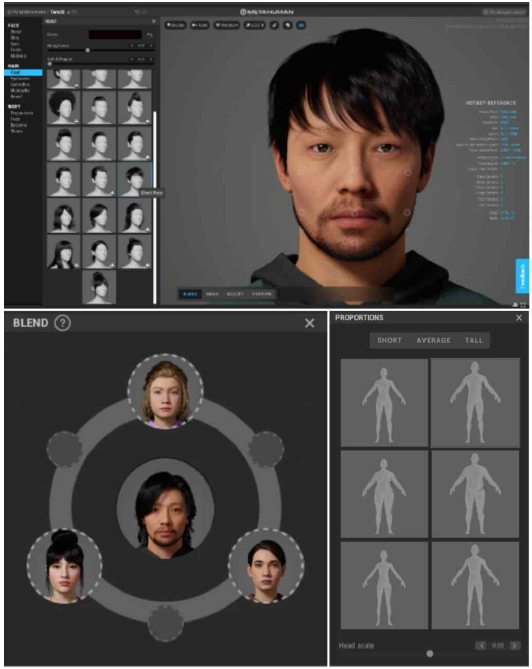

실제 사람을 대체하기 위해서 실사형 캐릭터를 이용하여 사람을 표현한다. 사용할 캐릭터는 에픽게임즈(EpicGames)의 메타휴먼 크리에이터(MetaHuman Creator)를 이용하여 생성한다. 메타휴먼 크리에이터는 사람의 보디 스캔 데이터를 기반으로 50개의 기본 캐릭터를 조합하여 언리얼엔진(Unreal Engine)에서 활용할 수 있는 새로운 캐릭터를 만들 수 있다.

메타휴먼 크리에이터는 그림 2와 같이 크게 얼굴, 체모, 보디로 나누어진 세 가지 부분을 조절하여 캐릭터를 사용자가 원하는 방향으로 수정할 수 있다. 얼굴의 경우, 그림 2의 왼쪽 아래처럼 하나의 캐릭터를 기초로, 3종의 캐릭터를 혼합하여, 손쉽게 새로운 얼굴을 만들고, 눈, 피부, 치아, 화장 등의 미세한 부분까지 조절할 수 있다. 체모의 경우, 머리카락, 눈썹, 속눈썹, 수염 등의 얼굴에 표현되는 체모에 대해 표현이 가능하다. 보디의 경우, 크게 체형과 의복으로 구성되어 있고, 체형은 키와 몸집 각각에 대해 3단계로 조절되며, 머리의 크기를 조절할 수 있다(그림 2 오른쪽 아래). 제공되는 캐릭터의 프리셋 정보는 표 2에 정리하였다. 제공되는 프리셋을 추가로 미세 조정하여 특정인을 닮도록 수정할 수 있다.

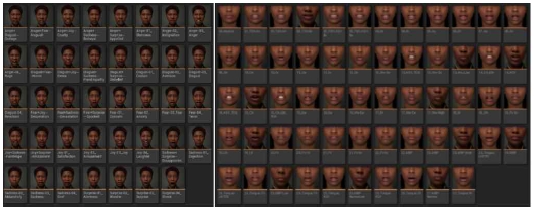

메타휴먼은 생동감 있는 캐릭터 표현을 위해 그림 3과 같이 24개의 기본 표정과 15개의 복합표정을 제공한다. 더하여 27개의 발음기호에 대한 입 모양도 제공된다. 캐릭터는 모프타깃(morphtarget)기반으로 움직이게 되는데, 메시와 텍스쳐가 동시에 조절되어 실제 사람과 같은 렌더링 결과를 보여준다. 제공된 표정을 이용하면 캐릭터의 자연스러운 표정 변화를 반영한 데이터를 취득할 수 있다.

본 논문에서 제안하는 데이터세트의 다양성을 위해, 총 30종의 캐릭터를 준비한다. 남녀 비율은 1:1로 하고 다양한 인종을 포함하도록 설계하였다. 한국인에 좀 더 특화된 결과를 얻기 위해 아시아계 캐릭터를 60%로 구성하고 흑인과 백인의 캐릭터를 각각 20%의 비율로 구성하였다. 그림 4에서 데이터 생성에 활용된 캐릭터를 확인할 수 있다.

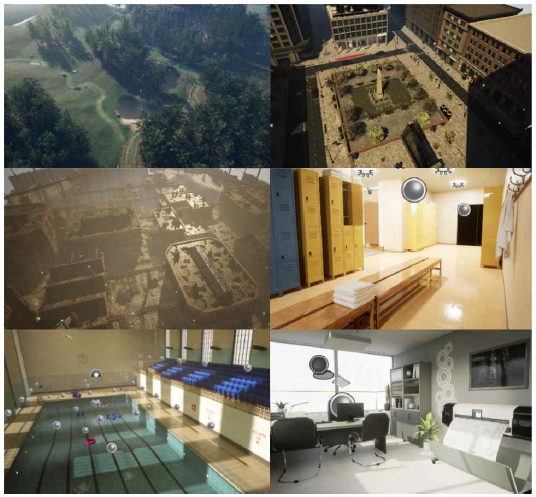

3-2 데이터 취득 환경 구성

실제 촬영 상황과 비슷하게 만들기 위해서 6종류의 환경(숲, 도시, 라커룸, 사무실, 수영장, 창고)를 이용하여 캐릭터의 배경을 선정한다. 각 환경에 대해서 실제 사람이 서 있을 수 있는 위치를 캐릭터 생성 위치를 지정하고, 캐릭터를 랜덤한 방향으로 바라보게 설정하여 다양한 배경이 나오도록 한다. 각 환경의 캐릭터 생성 위치를 최소 1개에서 최대 10개의 위치를 지정한다. 환경에 대한 각 전경은 그림 5에서 확인할 수 있다.

다양한 각도에서의 얼굴 데이터를 얻기 위해서 캐릭터 머리의 방향과 카메라의 위치를 변경하여 데이터를 취득한다. 머리의 방향은 목의 각도(ϕ0, θ0, ψ0)와 머리의 각도(ϕ1, θ1, ψ1)에 의해서 수식 (1)로 결정된다.

| (1) |

카메라의 위치는 캐릭터 머리의 중심을 원점으로 구면 좌표계(r, θ, ϕ)을 구성하고 수식 (2)의 범위 내에 생성된다. 이때, 카메라의 방향은 머리의 중심을 바라보도록 하고, 카메라의 화각은 30˚로 설정한다.

| (2) |

3-3 데이터 구축

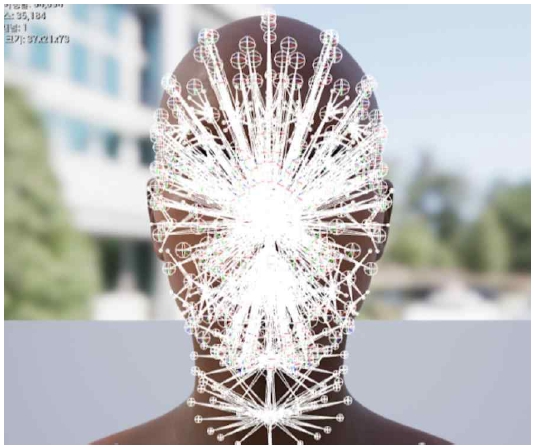

제안하는 랜드마크 데이터세트 구축을 위해서는 다양한 표정 반영뿐만 아니라 얼굴 랜드마크 정보를 캐릭터 정보로부터 추출하는 작업이 필요하다. 메타휴먼 캐릭터의 표정은 컨트롤릭(Control Rig)으로 수치화되어있고 이 값에 따라 캐릭터의 본이 이동하면서 표정이 지어진다. 따라서 캐릭터의 본은 그림 6에서 같이 얼굴 전체 메시를 움직이기 위한 기준점으로 특정 위치에 존재하게 된다. 이를 이용하여 얼굴 랜드마크 정보로 캐릭터 모델의 본을 활용한다.

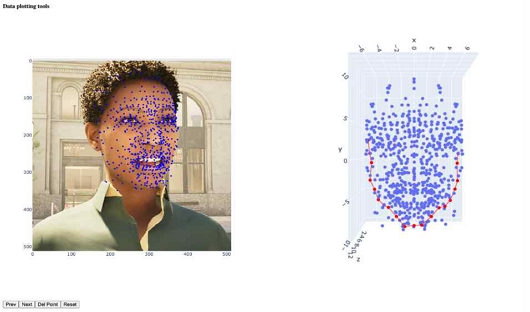

얼굴 랜드마크는 목표 랜드마크의 위치와 유사한 3차원 본의 위치를 이용한다. 본 논문에서는 WFLW 데이터세트의 형식에 기반하여 98개의 2차원 랜드마크를 캐릭터로부터 도출한다. 구체적으로 그림 7처럼 취득된 영상과 캐릭터의 본 정보를 각각 2차원과 3차원에 가시화시키고 랜드마크가 표시되는 것을 확인하여 기준이 되는 랜드마크를 변환하였다. 1대1로 변환이 안 되는 랜드마크는 변환된 랜드마크를 동일 간격으로 나누어 좌표를 계산하였다. 예를 들어 Landmark Index 3, 4는 2, 5를 연결한 직선을 삼등분하여 변환한다. 1대1로 변환된 랜드마크와 본의 관계는 표 3에 정리되어있다. 변환된 랜드마크를 가시화시킨 결과는 그림 8과 같다.

앞서 설명한 캐릭터, 환경, 랜드마크 변환정보 등을 이용하여 본 논문에서 제안하는 얼굴 랜드마크 데이터세트를 구축한다. 환경별로 약 5천 장의 데이터를 준비하는데, 총 30,055장의 얼굴과 랜드마크 데이터를 Intel i7-9700 CPU와 RTX 2060 6GB GPU로 구성된 윈도우 PC로 생성하였다. 데이터로 생성된 영상의 예시는 그림 9에 있다. 기존 얼굴 랜드마크 데이터세트와 다른 점은 3차원 캐릭터 정보를 이용하기 때문에 2차원에서 보이지 않는 곳까지 정확하게 랜드마크를 표시할 수 있다. 기존 2차원 랜드마크 데이터와 정확한 비교하기 위해서는 고개를 한쪽으로 보고 있을 때, 가려진 턱선의 랜드마크를 얼굴 윤곽선으로 변경하는 추가과정이 필요하다[12].

Ⅳ. 실험 결과

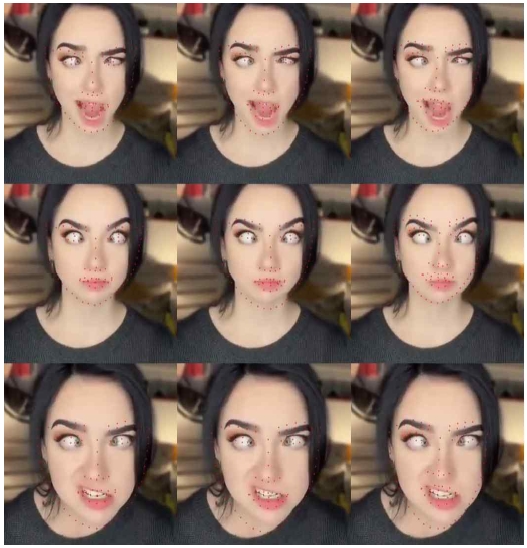

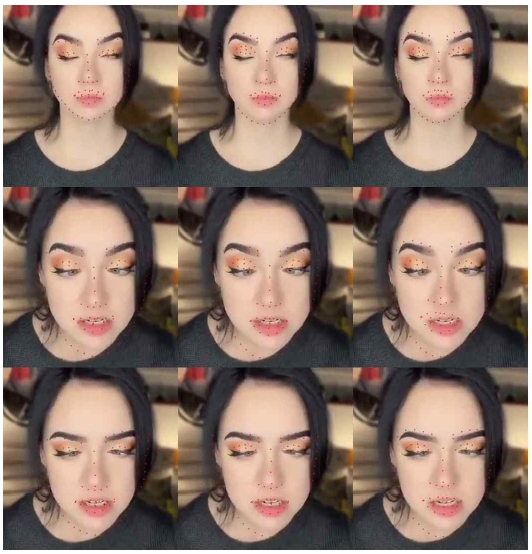

구축된 데이터세트의 검증을 위해서, 먼저 학습되지 않은 PFLD 모델을 준비한 데이터세트를 이용하여 학습시킨다. 다음으로 기존 랜드마크 데이터세트(WFLW)로 학습된 PFLD 모델을 준비하고, 시나리오 기반으로 취득된 실제 사람의 표정 데이터세트(ARKit)로 학습시킨 모델도 준비한다. 마지막으로 세 개의 모델을 실제 사람의 영상[13]을 이용하여 비교 분석한다. ARKit은 시나리오 기반으로 취득된 표정 영상을 아이폰의 ARKit으로 랜드마크 데이터를 추출한 데이터세트이며, 예시는 그림 10과 같다.

모델 학습은 Intel Xeon Silver 4214 CPU 2개와 Quadro RTX 6000 24GB GPU 4개가 장착된 우분투 워크스테이션에서 하였다. 모델의 크기가 작아서 학습 시 1개의 GPU만을 사용하였고 모델은 PyTorch 딥러닝 프레임워크로 구현하였다. 모델 학습을 위해 데이터 전처리 작업으로 표정의 강도에 따라서 표정 조건을 추가하여 데이터 목록을 만든다. 목록 전체를 학습에 활용하며, 각 데이터를 10번 증강하였다. 따라서 학습에 사용되는 데이터는 입력데이터 포함하여 11배 된 데이터가 사용된다. 데이터 증강 알고리즘으로 랜드마크의 중심을 기준 회전과 좌우 반전이 사용된다.

구체적인 PFLD 모델의 학습 방법은 논문에 제시된 방법을 이용한다. 초기 학습률은 1e-4를 사용하고, 가중치 감쇠는 1e-6을 사용한다. 가중치 업데이트 알고리즘으로 Adam 알고리즘[14]을 사용한다. 256개의 데이터를 배치로 500 epoch 학습시킨다. 또한 학습 스케줄러를 사용하여 40번 동안 로스에 개선이 없으면 학습률을 0.1배씩 줄인다. 실험에 사용된 모든 모델은 같은 방식으로 학습하였다.

준비한 데이터세트로 학습된 모델의 정량적인 평가를 위해 베이스라인 모델 학습에 활용된 검증데이터로 Normalized Mean Error(NME)를 계산하였다. 정규화는 Landmark Index 60과 72에 해당하는 눈의 바깥쪽 양 끝점의 거리를 기준으로 이용하고 정답과의 오차는 L2 norm으로 계산한다. 제안한 데이터로 학습한 모델은 베이스라인 모델의 약 78%의 성능으로 제안된 데이터세트가 유용함을 보인다. 이에 반해, ARKit 데이터로 학습된 모델은 실제 사람을 학습시켰음에도 베이스라인 모델의 32%의 매우 저조한 성능을 보인다. 상세한 수치는 표 4에 정리하였다.

다음으로 얼굴의 여러 각도와 표정 변화를 포함하는 영상을, 준비한 세 개의 모델로 추출한 랜드마크 결과를 비교한다. 그림 11-15의 1열은 WFLW 데이터로 학습한 모델, 2열은 제안하는 실사형 데이터세트로 학습시킨 모델, 3열은 ARKit 데이터세트로 학습한 모델의 결과이다. 각 실험 결과는 얼굴의 각도에 따른 랜드마크 추출 결과를 위해 정면/측면 영상을 비교하고, 얼굴의 변화 정도에 따른 랜드마크 추출 결과를 위해 일반 표정/과장된 표정/눈 감은 영상을 나누어 비교한다.

정면 얼굴인 그림 11에서는 3개의 모델 모두 윤곽선과 눈썹에서 큰 차이를 보이지 않는다. 하지만 입술과 눈의 경우 ARKit 데이터세트의 경우 정확한 위치에서 어긋나있다. 이는 그림 12의 측면 얼굴에서 더욱 두드러지는데, ARKit 데이터세트는 카메라를 정면으로 바라보고 취득된 데이터이기에 측면 얼굴에 대해서는 성능이 제한된다.

추가로 얼굴이 크게 변화하는 그림 13의 눈썹과 입 모양이 매우 크게 변하는 경우 입 모양의 형태는 ARKit이 잘 맞아 보이지만 대상의 정확한 위치를 맞추지는 못한다. 기존 데이터세트로 학습시킨 모델과 비교하였을 때, 본 논문에서 제안한 데이터세트가 목표로 하는 1열의 결과와 높은 유사도를 보여주고 있다.

눈동자까지 강하게 움직이는 그림 14의 경우, 모든 모델에서 정확한 눈동자의 위치를 따라가지 못하였다. 반면, 그림 15에서처럼 눈을 감는 경우 눈동자의 위치를 기준으로 눈의 랜드마크 간격이 줄어들어야 한다. 베이스라인 모델의 경우 이 간격이 줄어드는 반면, 다른 모델들은 감긴 눈의 여부와 상관없이 간격이 유지되는 것이 확인된다. 이는 본 기반의 데이터세트가 세밀한 움직임에 적용 안 되는 단점을 보여준다.

Ⅴ. 결론 및 향후 과제

새로운 데이터세트를 만드는 작업은 시간과 사람의 노동력 같은 비용이 크게 들어간다. 특히, 랜드마크 데이터세트와 같이 세밀하고, 사람의 눈으로 확인하기 힘든 부분까지 정답으로 만드는 경우, 작업자의 주관이 개입되어 정확하고 일관성 있는 데이터세트를 구축하기 힘들어진다.

앞서 보여준 실험을 통해서 본 논문에서 제안하는 스캔 기반의 캐릭터를 이용한 실사형 얼굴 랜드마크 데이터세트는 기존의 모델과 유사한 성능을 보여, 비용과 정확도에 대한 문제 해결 가능성을 보여주었다. 또한 다양한 얼굴과 환경 같은 여러 추가조건이 필요한 경우, 제안하는 데이터세트는 추가 캐릭터 생성과 다양한 조건에 맞추어 캐릭터와 환경을 준비하여 적은 비용으로 이를 해결할 수 있다. 하지만 ARKit 데이터세트와 같이 실제 사람을 통해서 만든 데이터세트는 추가 목적에 맞게 하려면, 재촬영과 후처리 및 라벨링 등에 대한 비용이 발생하게 된다. 이는 딥러닝 모델의 기능을 추가하거나 성능을 개선하는데 어려움이 된다.

제안하는 본 기반의 랜드마크 생성 방법은 실험 결과에서 볼 수 있듯이 동공의 위치와 눈을 감을 때 정확도가 부족함을 확인하였다. 이를 해결하기 위해서는 캐릭터의 본보다 세밀한 정보가 필요하다. 추가 연구로 캐릭터의 메시를 추출하여 메시의 정점을 기준 랜드마크로 변환하는 방법을 통해, 더 정확한 얼굴 랜드마크 생성 방법에 관한 연구를 진행 중이다.

이번 연구에서는 30개의 캐릭터를 이용하여 데이터세트를 구축하였지만, 더 많은 얼굴에 대해 학습하기 위해 다양한 얼굴 생김새를 포함하도록 추가 캐릭터를 준비할 예정이다. 또한 이미지 기반의 배경을 추가하고 안경, 목도리, 모자 같은 액세서리나 의복을 추가하여 주변에 실제 사람이 있거나, 의복에 가리는 경우도 대처할 수 있도록 만드는 후속 목표를 가지고 있다. 나아가서 얼굴 랜드마크뿐 아니라 캐릭터의 표정을 조절하는 블렌드 세입 파라미터를 이용하여 캐릭터의 표정 강도 예측에 활용되는 데이터도 추가할 예정이다.

Acknowledgments

본 논문은 문화체육관광부 및 한국콘텐츠진흥원의 2021년 문화콘텐츠 R&D 전문인력 양성(문화기술 선도 대학원) 사업으로 수행되었음 (과제명: 버추얼 프로덕션 기반 콘텐츠 제작 기술 R&D 전문인력 양성, 과제번호: R2021040044, 기여율: 80%)

References

-

J. Tobin, R. Fong, A. Ray, J. Schneider, W. Zaremba and P. Abbeel, “Domain randomization for transferring deep neural networks from simulation to the real world”, 2017 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Vancouver, BC, Canada, pp. 23-30, September 2017.

[https://doi.org/10.1109/IROS.2017.8202133]

-

P. N. Belhumeur, D. W. Jacobs, D. J. Kriegman and N. Kumar, “Localizing parts of faces using a consensus of exemplars”, In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) 2011, Colorado Springs, CO, USA, pp. 545-552, June 2011.

[https://doi.org/10.1109/CVPR.2011.5995602]

-

X. P. Burgos-Artizzu, P. Perona and P. Dollár, “Robust Face Landmark Estimation under Occlusion”, 2013 IEEE International Conference on Computer Vision (ICCV), Sydney, NSW, Australia, pp. 1513-1520, December 2013.

[https://doi.org/10.1109/ICCV.2013.191]

-

V. Le, J. Brandt, Z. Lin, L. D. Bourdev, and T. S. Huang. “Interactive facial feature localization.”, In European conference on computer vision, Firenze, Italy, pp 679–692, October 2012

[https://doi.org/10.1007/978-3-642-33712-3_49]

-

C. Sagonas, G. Tzimiropoulos, S. Zafeiriou and M. Pantic, “300 Faces in-the-Wild Challenge: The First Facial Landmark Localization Challenge”, 2013 IEEE International Conference on Computer Vision Workshops, Sydney, NSW, Australia, pp. 397-403, December 2013.

[https://doi.org/10.1109/ICCVW.2013.59]

-

M. Dantone, J. Gall, G. Fanelli and L. Van Gool, “Real-time facial feature detection using conditional regression forests”, 2012 IEEE Conference on Computer Vision and Pattern Recognition, Providence, RI, USA, pp. 2578-2585, June 2012.

[https://doi.org/10.1109/CVPR.2012.6247976]

- G. B. Huang, M. Ramesh, T. Berg, and E. Learned-Miller., “Labeled Faces in the Wild: A Database for Studying Face Recognition in Unconstrained Environments.”, University of Massachusetts, Amherst., Technical report 07–49, October 2007

-

M. Köstinger, P. Wohlhart, P. M. Roth and H. Bischof, “Annotated Facial Landmarks in the Wild: A large-scale, real-world database for facial landmark localization”, 2011 IEEE International Conference on Computer Vision Workshops, Barcelona, Spain, pp. 2144-2151, November 2011.

[https://doi.org/10.1109/ICCVW.2011.6130513]

-

W. Wu, C. Qian, S. Yang, Q. Wang, Y. Cai and Q. Zhou, “Look at Boundary: A Boundary-Aware Face Alignment Algorithm”, 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, USA, pp. 2129-2138, June 2018

[https://doi.org/10.1109/CVPR.2018.00227]

-

X. Guo, S. Li, J. Zhang, J. Ma, L. Ma, W. Liu, and H. Ling. “Pfld: A practical facial landmark detector”, arXiv preprint arXiv:1902.10859, March 2019

[https://doi.org/10.48550/arXiv.1902.10859]

-

T. Martyniuk, O. Kupyn, Y. Kurlyak, I. Krashenyi, J. Matas, & V. Sharmanska,(2022). “DAD-3DHeads: A Large-scale Dense, Accurate and Diverse Dataset for 3D Head Alignment from a Single Image”, In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, New Orleans, Louisiana, pp. 20942-20952, June 2022

[https://doi.org/10.1109/CVPR52688.2022.02027]

-

E. Wood, T. Baltrušaitis, C. Hewitt, S. Dziadzio, T. J. Cashman, J. Shotton, “Fake It Till You Make It: Face Analysis in the Wild Using Synthetic Data Alone”, In Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pp. 3681-3691, October 2021

[https://doi.org/10.1109/ICCV48922.2021.00366]

- crystal.g.katsini, “This cringy thing has been in my drafts”, Available: https://youtube.com/shorts/_H6_pMMz_uw, .

-

D. P. Kingma and J. Ba. “Adam: A method for stochastic optimization”, 3rd International Conference on Learning Representations, (ICLR) 2015, San Diego, CA, USA, Conference Track Proceedings, May 2015

[https://doi.org/10.48550/arXiv.1412.6980]

저자소개

2020년 : 국민대학교 대학원 (공학석사 – 컴퓨터공학, 컴퓨터비전)

2015년~2016년: Percolata Algorithm team Intern

2020년~현 재: (주)인공지능연구원 기술연구소 캐릭터AI팀 리서치엔지니어

※관심분야 : 컴퓨터비전(Computer vision), 얼굴 표정 이식기술(Facial expression translation), 인공지능(Artificial Intelligence)

2018년 : 아주대학교 대학원(미디어학석사)

2018년~현 재: ㈜인공지능연구원, 기술연구소 캐릭터AI팀 엔지니어

※관심분야 : 게임 디자인(Game Design), 디지털 휴먼(Digital Human), 애니메이션 리타겟팅(Animation Retargeting) 등

2022년 : 경희대학교 (공학사-환경공학)

2022년~현 재: (주)인공지능연구원 기술연구소 캐릭터AI팀 인턴

※관심분야 : 컴퓨터 비전(Computer vision), 인공지능(Artificial Intelligence) 등

2001년 : 서강대학교 대학원 (공학석사)

2011년 : 서강대학교 대학원 (미디어공학박사)

2011년~2012년: (주)애니프레임 미디어아트팀 팀장

2012년~2018년: 네이버 커넥트재단( 구. NHN NEXT) 교수

2018년~현 재: (주)인공지능연구원 기술연구소 캐릭터AI팀 리더

※관심분야 : 컴퓨터 비전(Computer Vision), 디지털 휴먼(Digital Human), 인간컴퓨터상호작용(Human Computer Interaction), 인체 자세 추정(Body Pose Estimation)