스크린 기반 무안경 VR을 위한 실시간 영상정합 시스템에 대한 연구

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

메타버스, 디지털트윈, 각종 시뮬레이션 등 가상현실 시각화에 대한 다양한 수요가 발생하고 있으나 여전히 안경형 디스플레이 장치에 의존하고 있으며, 안경형 디스플레이 장치 사용을 원하지 않거나 사용할 수 없는 환경에서도 적용 가능한 몰입형 영상 시현 장치에 대한 요구가 지속되고 있다. 본 연구에서는 스크린 기반 영상 시현 장치에서 사용자의 실제 시야각과 삼차원 콘텐츠의 가상 시야각 실시간 일치를 통해 몰입형 영상의 구현 가능성을 검증하고자 하였다. 스크린에 투영된 삼차원 콘텐츠의 가상 시야각과 스크린의 물리적 시야각을 Lidar 센서를 통해 실시간으로 추적된 사용자의 위치에 기반하여 일치시키고, 이때의 영상 결과물과 시야각 정확도를 확인하였으며, 그 결과 사용자의 위치가 변경되어도 스크린의 각도와 무관하게 실제 시야각과 유사한 영상이 시현 되는 결과를 도출하였다. 이를 통해 단독형 사격 시뮬레이터 및 각종 장비, 체험 시뮬레이터 등에 보다 극적인 시각적 효과를 제공할 수 있을 것으로 기대한다.

Abstract

Although there are various demands for virtual reality visualization such as metaverse, digital twin, and various simulations, it is still dependent on the glasses-type display device and the demand continues for an immersive image display device that can be applied even in an environment where the use of the glasses-type display device is not desired or cannot be used. In this study, we tried to verify the feasibility of realizing immersive images through real-time matching between the user's real viewing angle and the virtual viewing angle of 3D content in a screen-based image display device. The virtual viewing angle of the 3D content projected on the screen and the physical viewing angle of the screen were matched based on the user's location tracked in real time through the Lidar sensor, and the image result and the viewing angle accuracy were confirmed at this time. In the result, an image similar to the actual viewing angle was displayed regardless of the angle of the screen even if changed. Through this study, it is expected that it will be able to provide more dramatic visual effects to the stand-alone shooting simulator and various maintenance and experience simulators.

Keywords:

Realtime image warping, Glasses-free virtual reality, User's viewing angle, Tracking location, Immersive visual system키워드:

실시간 영상정합, 무안경 가상현실, 사용자 시야각, 위치추적, 몰입형 영상 시스템Ⅰ. 서 론

최근 각종 메타버스 플랫폼, 민간 및 군용 시뮬레이션, 놀이 및 전시 시설, 공장자동화 제어, 스마트농장 통제, 등 다양한 신산업환경에서 가상현실, 증강현실, 복합현실 등의 시각화, 가시화 기술을 적용하고 있으며, 필자 또한 지난 이십여 년간 현업에서 상기 언급된 산업에 각종 시각화 솔루션을 개발 적용하였고 현재도 개발에 참여하고 있지만, 여전히 사용자가 만족할만한 수준의 가상현실을 제공하는 것에는 많은 제약이 따른다고 판단된다[1].

특히 Head Mounted Display(이하 HMD) 경우 하드웨어의 비약적인 발전과 가격의 현실화를 통해 대중화를 이루었고 저비용으로 가상현실을 구현할 수 있다는 점에서 그 효과가 매우 크다고 볼 수 있겠다[2].

그러나 장비 착용의 불편함, 외부세계와의 시각적 차단으로 인한 안전사고 발생, 원경 영상과 디스플레이 장치에 대한 근접 초점으로 인한 안압 상승, 실세계와 상이한 원근 효과, 장시간 사용의 불편함 등 아직 해결해야 할 사항이 많이 잔존하며, 이러한 사유로 고비용이 적용되더라도 여전히 연구목적 또는 군사용, 대형전시시설에는 스크린 기반의 가시화 시스템을 적용하는 것이 현실이다.

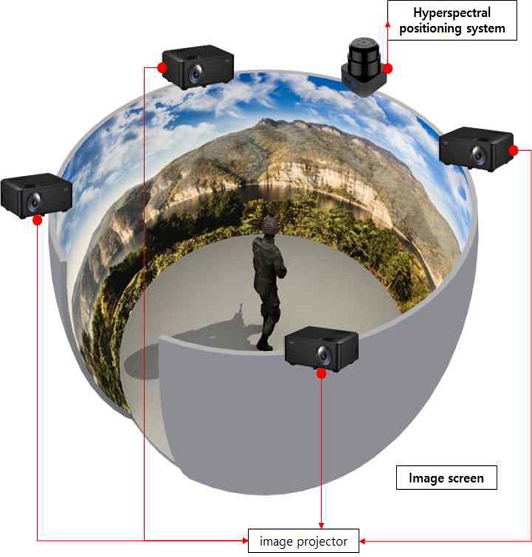

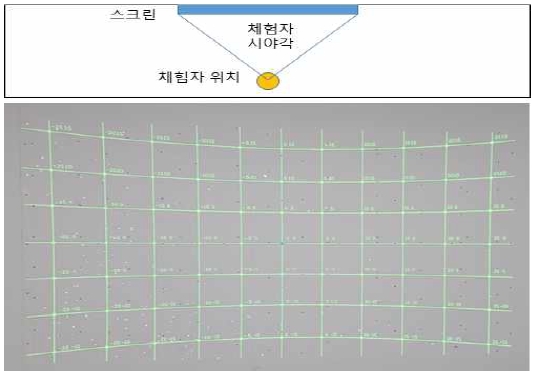

그림1은 본 연구를 통해 구현 가능한 스크린 기반 무안경 VR 시스템으로 HMD를 사용하지 않는 스크린 기반 삼차원 시뮬레이션 또는 전시 콘텐츠시스템에서 실시간으로 체험자의 위치를 추적하고 각 위치에 상응하는 체험자의 물리적 시야각과 동일한 영상을 제공하여 가상현실의 몰입감을 극대화하는 시스템이다.

이에는 영상 스크린의 물리적 설계, 영상 투사 장치의 광학설계, 삼차원 콘텐츠의 시야각 설계, 실시간 Warping and Edge-Blending 처리, 체험자의 위치추적, 지연 전달 처리 등 복합적인 요소들을 고려한 설계 및 시스템 처리가 요구되며, 이를 통해 체험자가 자신의 위치변화와 관계없이 항상 영상이 왜곡되지 않고 본인의 시야각과 일치하는 영상을 경험하게 되는 새로운 몰입형 영상 시현 방법을 제안한다.

Ⅱ. 본 론

2-1 관련연구 및 현황

영상정합, 환경 맵핑, 벡터장 기반 이미지 와핑 등 기존에도 프로젝션 맵핑 및 기하학 기반 영상 시현 기술에 대한 다양한 연구들이 존재한다[3].

하지만 기존의 영상정합과 이미지 와핑에 대한 연구들은 체험자 시점의 물리적 위치는 고정된 상황에서 투영되는 콘텐츠의 시점 각도 변화 또는 위치변화에 따른 올바른 투영 및 영상생성법과 다 곡면에 대한 실시간 표면 정합 등이 주류를 이루고 있다[4],[5].

그러나 이렇게 투영되고 보정된 영상은 특정 위치에서만 시각적 왜곡 없이 시현될 뿐 시점자, 즉 체험자의 위치가 변경되면 영상의 투영표면과 시점과의 각도가 상이해지면서 원거리의 투영 영상은 시야각(Field of view)이 확대되어 굴절되어 보이며, 근거리의 투영 영상은 시야각이 줄어들어 마치 확대된 영상을 보는 것처럼 된다. 또한 이러한 현상은 높낮이변화에 따라서도 동일한 현상이 발생한다[6].

본 연구에서는 체험자의 위치를 초분광 위치추적 장치(Lidar 센서)를 사용하여 실시간 추적하고 그에 따라 투영된 영상의 시야각을 실시간으로 변경해주는 동적 시야각 변화 와핑을 적용, 위치변화가 발생하더라도 투영된 영상에서 항상 일정한 시야각을 제공하도록 하여 기존 영상 정합 솔루션에서 발생하던 문제점을 보완, 해결하고자 한다.

본 연구의 가장 근본이 되는 기술 기반은 영상 스크린의 물리적 설계에 따른 빔프로젝터의 투사범위와 위치를 결정하는 ‘빔프로젝션 설계’와 영상 스크린의 물리적 형상에 영상 콘텐츠의 이미지가 시야각적으로 일치하도록 보정하는 즉 ‘Image Warping’에 두고 있으며, 이 기술들은 시스템을 체험하는 체험자의 위치, 시야각에 의해 그 결과물의 품질이 결정된다.

또한 이 품질에 따라 체험자(사용자)는 보다 자연스럽고 몰입감 있는 가상현실을 체험하게 된다고 볼 수 있겠으며, 본 연구에서 하고자 하는 핵심기술은 Image Warping을 체험자의 위치변경에 따라 실시간으로 변경 적용되는 Dynamic Image Warping이라 할 수 있겠다.

본 연구에서는 필자가 보유한 특허를 기반으로 연구 개발한 Image Warping 소프트웨어를 적용한다.

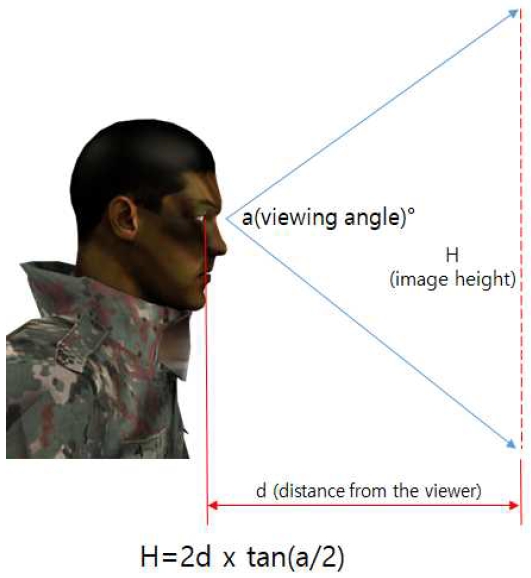

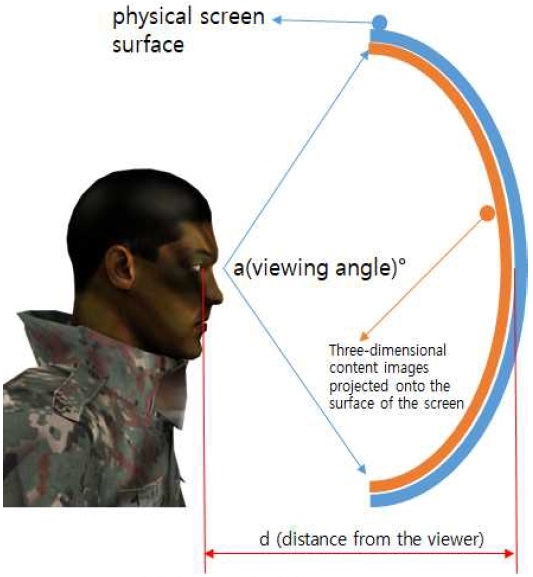

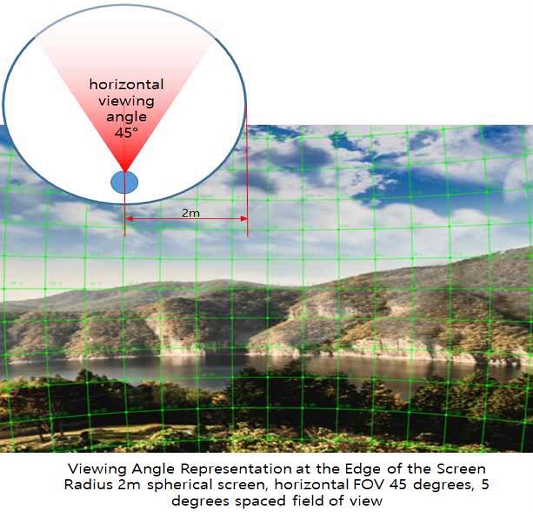

그림2와 그림3과 같이 일반적인 스크린 프로젝션 상황에서 시점(Eye point)위치로부터 결정된 시야각(Field of view)과 스크린과의 거리에 따라 스크린의 크기 즉 영상투영 범위와 각도가 결정된다. 이러한 이유로 시야각이 고정될 경우 시점과 스크린의 거리가 멀어질수록 스크린은 커져야 하고 거리가 가까워지면 스크린은 작아져야 하며, 그에 따라 투영되는 콘텐츠의 투영범위와 가상 시현 각도가 변화하여야 한다.

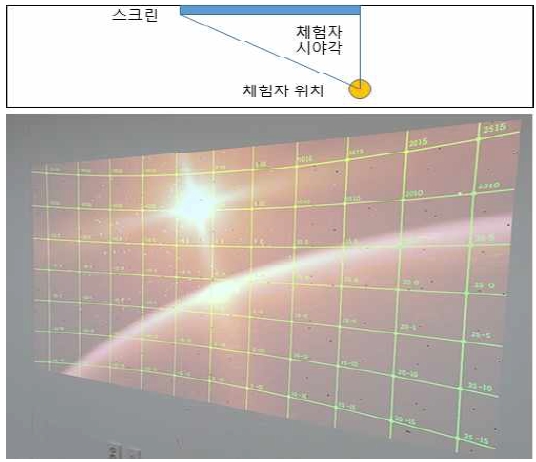

그림 4와 그림5는 실제 시점 위치와 스크린 간의 거리에 변화에 따라 투영 각도가 변화하지 않을 때 영상 왜곡 현상이 어떻게 발생하는지 보여준다.

그림과 같이 스크린에 투사된 영상이 사용자의 시선 각도에 맞추어 고르게 배치, 투사되어도 사용자의 위치가 변경됨에 따라 스크린의 물리적인 시야각이 확장됨에 따라 투사된 영상이 확장되고 확장된 시야각과 비례하여 영상이 중앙으로 집중, 굴절되는 왜곡 현상이 발생하며, 이는 실세계에서 바라보는 각도와 상이하게 된다.

본 연구에서 해소하고자 하는 것은 영상상의 각도 위치를 사용자의 위치변화에 따라 실시간으로 재배분하여 사용자가 임의의 위치에 가더라도 항상 동일한 시야각을 제공하는 것이다.

Warping 영상보정은 영상컴퓨터에서 출력되는 영상 이미지를 캡쳐하여 보정 처리 후 재출력하는 과정을 거치므로 그래픽 연산 처리에서 많은 자원을 요구한다. 그리하여 과거에는 대부분 별도의 전용 하드웨어를 제작하여 영상컴퓨터와 물리적 연동을 통해 처리하였으나, 외부 하드웨어의 이미지프로세싱 성능은 고정된 Warping 처리는 가능하나 실시간 Dynamic Image Warping을 처리하기에는 현저히 부족하다.

또한 이런 시스템구조는 영상 지연 전달(Transport delay) 성능에 영향을 주기 때문에 영상의 실시간 반응을 고려하여 Warping 기능을 제한하는 경우가 많았으며, 그런 사유로 시뮬레이션에 사용되는 스크린 프로젝션은 사용자의 시점(Eye point)을 고정하여 항상 동일한 위치에서만 시야각을 제공하는 것으로 고착되었다.

그림6은 대표적인 하드웨어 타입의 Image Warping 제품으로 군용시뮬레이션 영상 시현에 적용되던 고급 전문 장비이지만 고정된 와핑만 제공한다[7].

2010년대에 들어서서, 컴퓨터 하드웨어 성능이 향상됨에 따라 소프트웨어적으로 콘텐츠 컴퓨터의 그래픽카드에서 직접 영상 출력 신호를 가로채어(Hooking) Warping 처리하는 기술이 발달하여 더 이상 영상 지연 전달에 관한 부담은 사라졌으나 이미지프로세싱이 직접적으로 콘텐츠 컴퓨터의 성능자원을 소모하므로 영상 시현 성능(Frame rate)을 저하시키는 제한사항이 있다.

그림7은 소프트웨어 타입의 대표제품으로 각종 전시관 및 미디어 파사드 등에 널리 사용되는 범용으로 사용되고 있으나 다중채널 사용 시, 성능저하 및 상대적 시현 품질저하로 정밀영상을 시현하는 분야에서는 배제되고 있다.[8].

본 연구에서는 Dynamic Image Warping 알고리즘을 삼차원 콘텐츠에 직접 탑재하여 처리하는 방식으로 콘텐츠 개발과정에서 영상 시현 성능을 관리하면서 Dynamic Image Warping을 적용할 수 있도록 하여 영상 지연 전달과 시현 성능제한 사항을 모두 보완한다.

2-2 실시간 영상정합(Dynamic Image Warping) 구현

상기 가설을 증명하기 위한 실험용 실시간 영상정합 모듈 시스템과 소프트웨어를 개발하였으며, 본 모듈 시스템은 실험의 정확도 점검과 신속한 수정 보완을 위하여 단일 영상 출력 하에서 평면 스크린 기준으로 진행하였다.

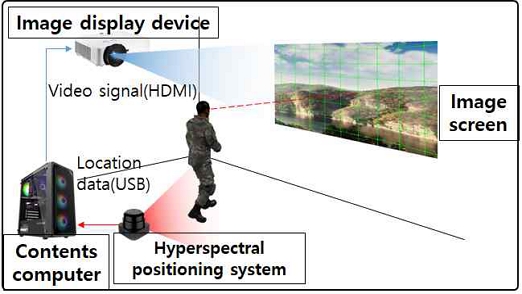

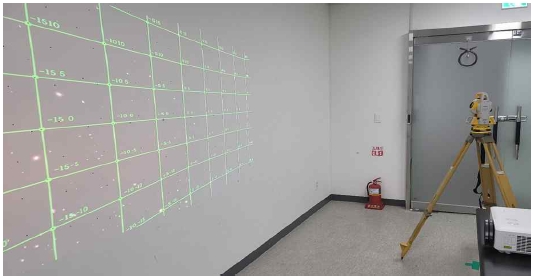

실시간 영상정합 테스트 모듈 시스템은 그림8과 같이 영상 스크린, 빔프로젝터, 초분광 위치추적 장치, 영상보정 솔루션이 탑재된 컴퓨터로 구성되며, 스크린 표면의 기하학적 각도와 영상 콘텐츠의 시야각을 측정할 수 있는 측각기를 별도 구비하였다.

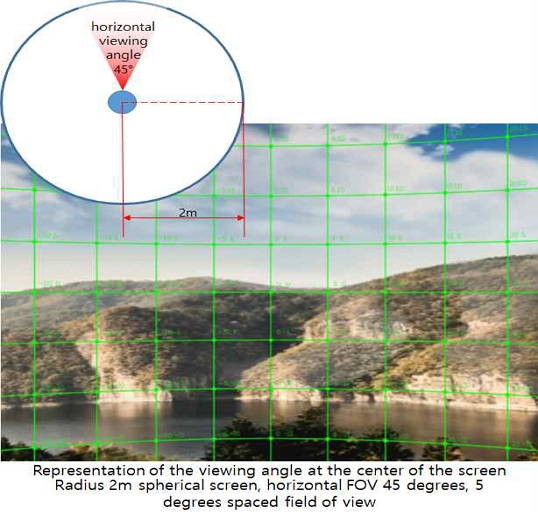

빔프로젝터를 통해 3차원 영상 콘텐츠를 평면에 투사하고 콘텐츠 상의 시야각을 확인할 수 있도록 콘텐츠 내 가상카메라의 각도별 위치를 격자로 시현 하며, 체험자 후방에 초분광 위치추적 장치(Lidar 센서)를 배치하여 체험자의 위치변화를 감지, 콘텐츠 소프트웨어에 그 정보를 전달 및 와핑 변화를 처리하도록 한다.

필자는 정밀한 모듈시험을 위해 5000 Lumen의 고휘도, 1920 x 1200 pixel(WUXGA)의 고해상도 레이져 광원 빔프로젝터를 적용하였으며, 근거리 투사와 함께 사용자의 위치변화를 크게 확보하기 위하여 투사 비율 0.81 : 1의 렌즈 비율을 적용하였다.

통상 위치추적을 위해서는 스테레오 카메라, IMU, 초음파센서 등 다양한 센서를 사용하나 감지 반응속도가 느리거나, 위치추적의 오차 누적 현상 등으로 인해 본 연구에 적용하기에는 제한이 많다.

필자는 사용자의 실시간 위치추적의 정밀도와 신속한 응답속도를 확보하기 위해 자율주행 자동차의 장애물 검출용으로 사용되는 Lidar 센서를 적용하였으며, 필자가 사용한 Lidar제품은 최대 9000Hz로 위치추적을 할 수 있으나 너무 과도한 데이터 검출 시, 콘텐츠 소프트웨어가 성능상 수용 불가하므로 90Hz로 조정하였다.

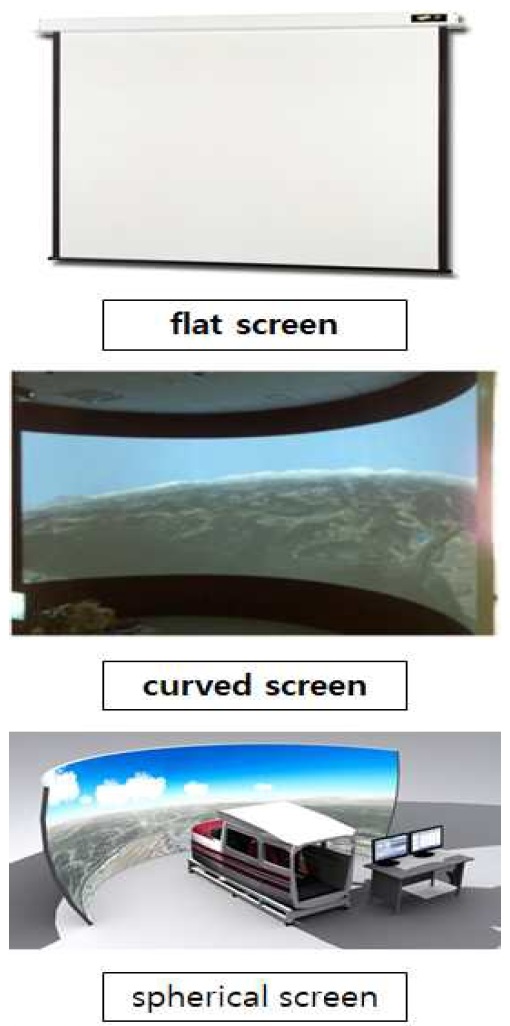

일반적으로 영상 스크린에는 그림9와 같이 평면, 곡면형, 구형 등 다양한 형태가 존재하고 몰입감에서는 구형 스크린이 가장 뛰어나나 본 실험에서는 시야각 각도 변화량 측정의 정밀도 확보를 위해 평면 스크린을 적용한다.

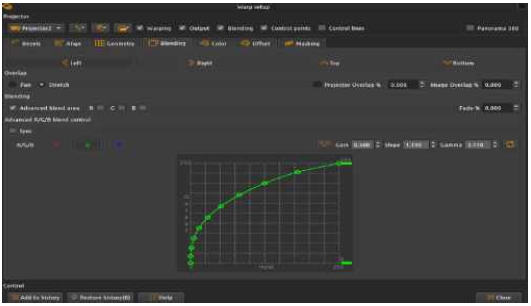

영상보정솔루션은 필자가 논 파라메틱(Non-parametic)구조 기반으로 기존 개발했던 프로그램을 수정하여 콘텐츠에 직접 적용하였다.

논 파라메틱 영상보정[9]은 전체 이미지에서 보정하고자하는 지점을 중심으로 주위의 좌표와 연계하여 타 영역에 영향을 최소화하며 보정이 가능한 알고리즘이다.

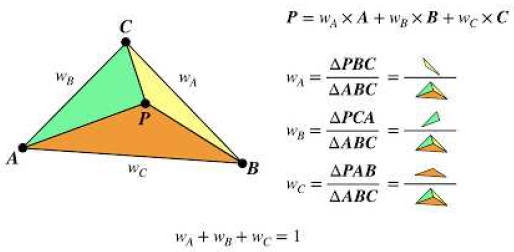

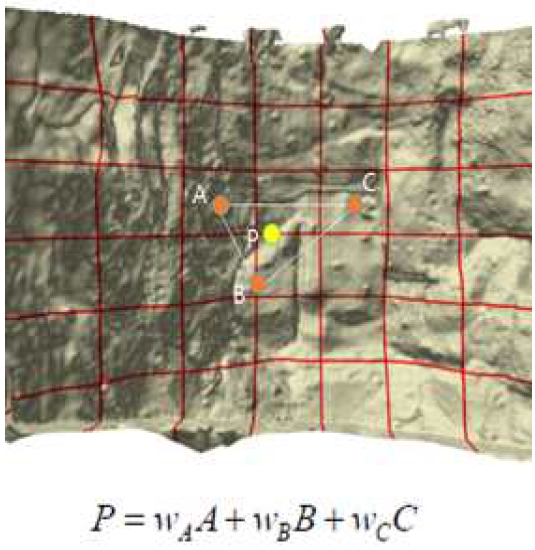

그림10의 정점 무게중심 기반 위치변경 알고리즘을 통해 그림11과 그림12처럼 기본 이미지에서 A, B, C 꼭지점 주변의 형상을 변형하여 투사면과 일치시키기 위하여 각 꼭지점을 이동하게 되며, 삼각형 꼭지점 A, B, C에 대한 무게중심은 P지점이 되고 이미지 워핑을 하여 꼭지점의 위치가 변경되면 새로운 꼭지점 A', B', C'에 의하여 생성된 무게중심 P가 P'로 이동되고 이로 인한 면적(w) 분포가 w'로 변형되며 면적에 해당하는 이미지가 변형되어 진다[9].

시험을 진행하기 위한 컴퓨터 탑재형 콘텐츠로 삼차원 공간을 표현하는 임의의 영상 콘텐츠이며, 사용자의 시점(Eye point)변경에 따라 시야각 분포를 확인할 수 있는 시야각 분포 격자 출력 기능을 포함했다.

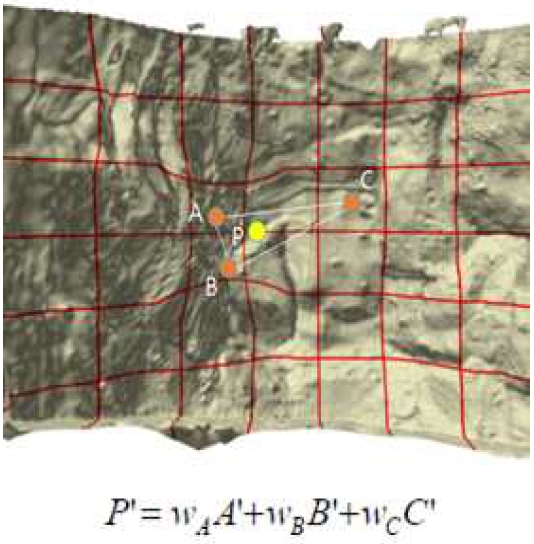

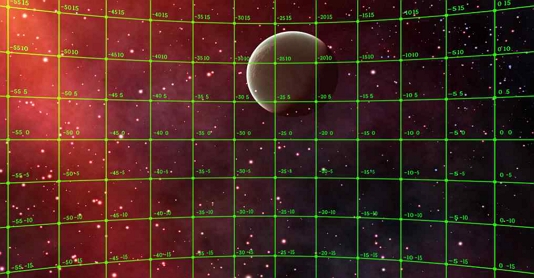

시험용 콘텐츠는 그림13과 같이 게임엔진(Unity3D) 기반으로 제작되었으며, 실시간 동적 영상으로 구성되었다.

또한 그림14와 같이 초분광 위치추적 장치(Lidar)로부터 전달된 위치정보를 기반으로 사용자의 위치변화(X, Y 평면좌표)에 따라 변화되는 시야각 분포에 적합하게 영상보정 조정점(Warping Control point)들이 실시간으로 배치되는 기능을 탑재하였다.

2-3 시험방법 및 수행

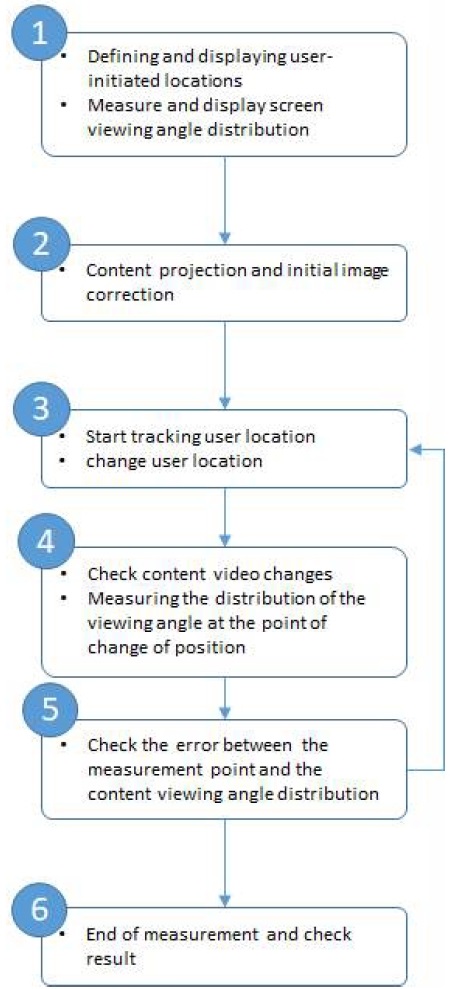

실시간 영상정합 테스트 모듈 시스템의 정상 작동 및 연구의 가설을 증명하기 위한 시험 방법 및 절차를 그림 15와 같이 수행하였다.

그림16과 같이 영상보정의 기준점, 즉 시작 시점(Eye point)를 설정하기 위해 스크린의 중앙점을 확인하고 사용자의 위치를 정의한다.

사용자의 시작 위치에 측각기를 사용자 눈높이에 맞추어 설치하고 5도 간격으로 시야각을 측정하고 마커를 표시하여 해당 각도를 시각적으로 확인할 수 있도록 한다.

이 마커들이 초기 영상보정과 각도 변화의 기준점이 된다.

컴퓨터를 실행하고 콘텐츠 투사 후 영상보정 기능(Warping)을 통해 콘텐츠에 표시되는 시야각 분포 그리드를 스크린에 표시된 해당 시야각 마커와 일치 시킨다.

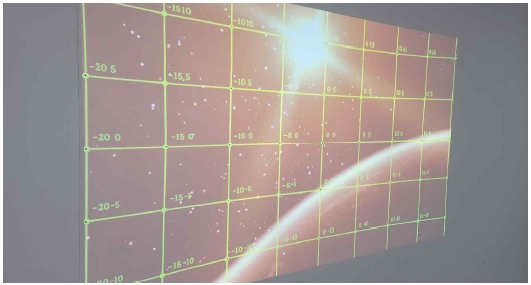

그림17에서처럼 그림16에서 스크린의 기하학적 각도에 맞추어 표시한 마커와 콘텐츠 상에 출력되는 가상카메라 각도를 일치시키는 작업을 수행하였다.

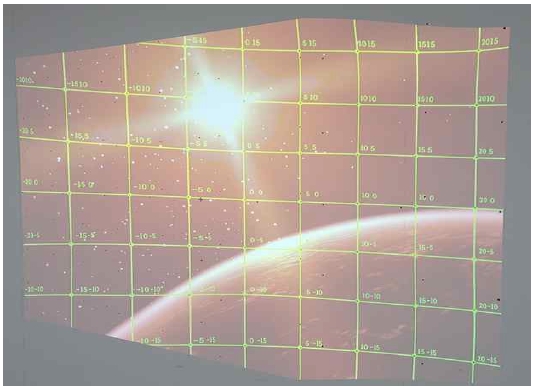

본 영상보정은 최초 초기화 보정으로 이후에는 적용하지 않아도 되며, 보정작업이 정상적으로 수행되면 투사된 영상의 시야각 격자가 초기 설정 위치에서 바라볼 때 고르게 분포되고 정사각형 형태에 가깝게 보인다.

그림18은 스크린의 기하학 좌표에 적합하게 보정된 영상 콘텐츠의 결과물을 보여준다.

초분광 위치추적 장치를 작동하고 사용자 초기위치에서 임의의 위치로 이동하되 변화량 측정을 용이하게 위하여 되도록 스크린 범위 내에서 초기위치와 멀리 이동한다.

이동 후 측각기를 설치하고 해당 위치에서 다시 시야각 분포를 측정해야 하므로 이동 위치를 표시하고 위치추적기능 중단 및 콘텐츠를 일시적으로 멈춘다.

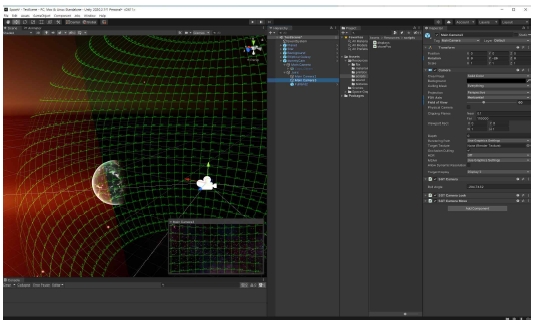

그림19에서 우측 하단의 장치가 본 연구에서 적용된 초분광 추적 장치이며, 체험자가 중앙의 초기위치에서 우측으로 이동함에 따라 체험자의 시야각에 맞추어 와핑이 변화되는 것을 보여준다.

변경 위치에서 측각기로 현재 콘텐츠에서 표시되는 시야각 분포 그리드의 각도가 실제 각도와 일치하는지 확인하고 그 오차값을 기록한다, 다만 측각기의 설치가 수동으로 이루어지므로 설치 간 발생하는 미미한 위치 오차는 무시하도록 하며, 그 근거로 본 연구에서는 사용자의 평면 위치변화에 국한하여 시험을 실행하나 실제로는 사용자의 목 움직임, 자세 변화 등에 따라 미세한 각도 변화를 가져올 수 있기 때문이다. 또한 이로 인한 각도 오차는 1도 범위 내외로 정밀측정을 하지 않고 시각적 판단만으로는 구분이 어렵다.

측정을 통하여 해당 위치에서 획득하는 각도 데이터가 콘텐츠에서 시현하는 가상카메라의 각도와 유사하다면 본 연구에서 진행하는 실시간 영상정합이 이루어진 것으로 판단할 수 있을 것이다.

그림20은 체험자의 변경된 위치에서 콘텐츠소프트웨어를 일시 정지시키고 측각기를 이용해 체험자의 위치와 시선 높이에서 각도를 측정하는 모습이다.

2-4 시험결과 및 실시간 영상정합 분석결과

상기 측정을 통해 표1.과 같은 측정 결과를 획득하였으며, 오차분석을 통해 기대했던 효과와 같이 사용자 위치변경에 따른 시야각 변경을 확인하였다. 다만 앞에서도 언급한 바와 같이 측각기 설치 간 발생하는 위치 오차와 스크린 표면의 미세한 물리적 굴곡으로 인한 0.1도 내외의 오차는 발생하였다.

표1.의 측정 결과를 통해 체험자의 위치가 이동하여도 변경된 위치에서 기존의 시야 각도와 유사한 데이터가 획득됨을 확인하였고 이것은 위치 이동 후에도 체험자가 이동 전의 시야각과 유사한 시야각을 경험하게 되는 것을 수치적으로 증명하는 것이 되고 실제 체험자가 시각적으로 체감하는 효과는 그림21에서처럼 초기위치에서 보여지는 각도 격자가 위치 이동 후에는 그림22와 같이 체험자의 시각 소실점 방향으로 모여드나 실시간 영상정합 소프트웨어의 보정을 적용하면 그림23과 같이 소실점과 무관하게 체험자에게 초기위치에서와 유사한 시야각 그리드 형태를 시현하게 되며, 콘텐츠 상에 표현되는 이미지도 소실점 방향으로 늘어지지 않고 초기위치, 즉 정면에서 볼 때 와 같이 왜곡되지 않은 이미지가 시현 되지 않음을 확인할 수 있었다.

이를 통해 본 연구에서 적용한 것처럼 실시간 정합 소프트웨어와 3차원 실시간 영상 콘텐츠를 접목하면 체험자에게 위치 이동 및 스크린의 기하학적 형상과 관계없이 실세계에서 사물을 바라보는 것과 유사한 가상공간의 시야각 효과를 제공할 수 있음과 동시에 콘텐츠 이미지 또한 왜곡되지 않음을 확인할 수 있었다.

Ⅴ. 결 론

본 연구에서는 HMD를 사용하지 않는 스크린 빔프로젝션 환경에서 VR 시각 효과를 얻기 위해서 체험자의 실시간 위치추적과 실시간 영상정합을 통한 몰입형 영상 시현 시스템을 제안하였다.

이를 증명하기 위해 실시간 영상정합 테스트 모듈 시스템과 영상보정소프트웨어 및 시험용 콘텐츠를 개발하였으며, 시험을 통해 체험자의 위치 이동 후에도 체험자에게 초기위치에서와 유사한 시야각과 왜곡되지 않는 영상을 제공함을 확인하였다.

단, 금번 시험에서는 시험의 명료함을 위해 평면 스크린에서 제한적으로 수행하였으나 향후, 곡면 및 구형 스크린 기반으로 다중 출력 영상을 시험하여 실질적이고 상업적으로도 유효한 시험을 진행해야 할 것으로 사료되며, 본 시험에서는 사용자의 X, Y 평면 위치추적만 적용하여 Z(높이)에 대한 추적은 배제하였으나 이 부분도 향후에는 추가적으로 포함해야 할 것이다.

또한 초분광 추적 장치의 과도한 위치추적 정밀성으로 인한 영상 떨림 현상이 많이 발생하였으므로 향후 고도화 과정에서는 댐핑 또는 데드존 등의 보간법을 적용하여 현상을 보완할 예정이다.

이와 같은 고도화 및 유효성 시험을 통해 상업성을 확보한다면 다양한 민관군 시뮬레이션 영상 시스템과 체험관, 전시관 등에 보다 몰입감 있는 콘텐츠시스템을 제공할 수 있을 것으로 기대한다.

References

-

J.-G. Kim et al., “A Study on the Trends of Virtual Reality Application Technology for Agricultural Education,” Protected horticulture and Plant Factory, vol. 27, no. 2. The Korean Society for Bio-Environment Control, pp. 147–157, 01-Apr-2018.

[https://doi.org/10.12791/KSBEC.2018.27.2.147]

- Kim, Gui-Jung, “Technical Trend of Mixed Reality Based Interaction Visualization,” Journal of the Korean Society of Contents, vol. 11, no. 2, pp. 30–33.

- Hyewon Seo, Frederic Cordier.(2009).Image Warping Using Vector Field Based Deformation and Its Application to Texture Mapping.Journal of KIISE : Computer Systems and Theory,36(5),404-411.

- TaeKyu Hwang, KyungHyun Yoon.(1999).Image - based Rendering using Environment Map and Warping Function.Journal of the Korean Society of Information Science,26(1B),659-661.

- K. Yang and B. Lee, “An Implementation of Real-Time Image-Surface Mapping System,” The Journal of The Institute of Internet, Broadcasting and Communication, vol. 18, no. 3, pp. 9–16, Jun. 2018.

-

Y.-I. Gil, H.-R. Seo, H.-J. Lee, and I.-J. Ko, “Development of Projector Calibration Mapping Technology for Physically Interactive Sport Game,” Journal of Korea Game Society, vol. 19, no. 5. Korea Academic Society of Games, pp. 39–52, 31-Oct-2019.

[https://doi.org/10.7583/JKGS.2019.19.5.39]

- BARCO WB1920 Image processor [Internet]. Available: https://www.barco.com/ko/product/wb1920-image-processor

- Fly Elise-ng Immersive Display PRO [Internet]. Available: https://fly.elise-ng.net/immersive-display-pro

- IMAGE PROCESSING SYSTEM FOR DISPLAYING MULTI-LAYERED BEAM PROJECTION CONTENTS ON IRREGULAR PROJECTION SURFACE AND METHOD THEREOF

저자소개

2003년 : 동의대학교 기계공학 (공학사)

2003년~2009년: ㈜도담시스템즈

2009년~2012년: ㈜한길소프트

2014년~2019년: ㈜피디케이리미티드

2019년~현 재: ㈜글림시스템즈

※관심분야 : 영상정합(Image Warping), 가상현실(VR), 시뮬레이터(Simulator) 등