전문가 평가를 활용한 정량적 음원 퀄리티 분류 시스템

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

음악 데이터를 활용한 다양한 딥러닝 활용 연구가 활발하게 진행되고 있지만, 음악의 퀄리티를 값으로 정량화하여 완성도를 평가하는 시스템은 연구되지 않고 있다. 그 이유로는 음악 전문가가 음악적 요소를 고려하여 평가한 정량화된 점수 데이터셋이 없으며, 평가한 점수 자체가 개인의 주관적 판단의 차이를 기반으로 하기 때문이다. 이런 문제점을 극복하기 위해, 본 논문에서는 실제 음원에 대하여 음악적 퀄리티를 평가하는 11가지 기준에 따라 4명의 음악 전문가별로 매긴 점수 정보를 레이블 데이터로 활용하여 정량화된 퀄리티 점수를 예측하는 새로운 딥러닝 분류 시스템을 제안한다. 연구 과정에서 전문가별 점수 데이터 전체를 하나의 데이터셋으로 구성했을 때, 뚜렷한 성능 향상을 확인했다. 전문가의 주관적 판단 과정을 딥러닝 모델로 시뮬레이션 화할 수 있다는 가능성을 제시하며, 70% 정도의 분류 정확도 성능을 확인했다.

Abstract

Research on the use of various deep learning using music data is being actively conducted, but a system for evaluating the completeness by quantifying the quality of music as a value has not been studied. The reason is that there is no score dataset which evaluated by the music expert who considers the musical elements, and the evaluation score itself is based on differences in individual subjective decision. To overcome this problem, this paper proposes a new deep learning classification system that predicts quantified quality scores by utilizing score information as label data for each of the four music experts according to 11 criteria for evaluating musical quality about actual sound sources. In the course of the study, the clear performance improvement was confirmed when the entire expert score data was composed into one dataset. It suggested the possibility of simulating expert’s decision process by using deep learning model and confirmed classification accuracy performance of about 70%.

Keywords:

Deep Learning, Classification System, Subjective Decision, Musical Elements, Quality Scores키워드:

딥러닝, 분류 시스템, 주관적 판단, 음악적 요소들, 퀄리티 점수Ⅰ. 서 론

어떤 음악의 완성도를 측정하기 위해서는 다양한 음악적 요소들을 평가하게 된다. 이때, 음악적 요소는 하나의 평가 기준이 될 수 있고, 완성도에 따라 정량화된 수치를 부여할 수 있다. 이렇게 평가 기준별로 측정한 수치를 일정 범위를 가지는 점수 체계 형태로 표현하고, 평가 기준에 따라 음악의 완성도를 평가하는 과정을 전문가 대신에 인공지능 모델로 대체함으로써 새로운 형태의 음악 퀄리티 측정 시스템으로 구축할 수 있다.

그러나, 이러한 시스템을 만들기 위해서는 음악의 완성도를 평가하는 과정과 함께 적절한 음악 데이터와 평가 점수 데이터가 필요하다. 이러한 문제점을 해결하기 위해 미발매된 데모곡 음원과 함께, 국내외에서 활동하는 4명의 작곡전문가별로 실제 곡 퀄리티 분석을 통해 11가지 음악 평가 기준에 따라 점수를 매긴 새로운 형식의 데이터를 활용했다. 완성도를 평가하는 과정은 분류 형태의 모델을 활용함으로써 모델이 자체적으로 점수 레이블 데이터를 통해 전문가의 주관적인 판단으로 매겨진 점수 분포가 비슷한 음악 데이터들 사이의 특징 정보를 학습하여 점수 분류를 통해 퀄리티를 예측하도록 구성했다. 또한, 연구 과정에서 전문가마다 주관적인 판단으로 매긴 점수 데이터를 하나의 데이터셋으로 구성하여 사용함으로써 가시적인 분류 성능 향상을 확인할 수 있었다. 본 연구에서는 위와 같은 일련의 과정을 통해 전문가의 음악적 판단 과정이 반영된 정량화된 음원 퀄리티 측정 딥러닝 시스템을 제안한다.

본 논문의 구성은 다음과 같다. 먼저, 2장에서는 오디오 데이터를 활용한 전반적인 인공지능 기반 분류 모델 관련 연구에 관하여 서술한다. 3장에서는 제안하는 퀄리티 점수 분류 시스템에 대한 전체적인 구조와 함께 사용한 모델에 대한 설명을 제시한다. 4장에서는 데이터셋 및 전처리 과정, 데이터 증강 기법을 활용한 추가 데이터 생성 방식 등과 같은 설명과 함께, 여러 형식의 분류 모델별 테스트 결과와 전문가 포함 인원별 테스트 결과를 제시한다. 또한, 인공지능 모델들을 활용한 전반적인 평가 기준별 퀄리티 점수 분류 성능과 전문가 인원 추가에 따른 주관적인 판단 과정의 시뮬레이션 화에 관한 분석을 서술한다. 마지막 5장에서는 전체적인 연구 과정에 대한 요약과 함께 새로운 향후 연구 내용에 대해서 제시한다.

Ⅱ. 관련연구

오디오 관련 연구에서 대표적으로 사용되는 인공지능 분류 모델의 종류는 크게 머신러닝과 딥러닝 분야로 나눌 수 있다. 머신러닝 분야에서는 주로 의사결정 트리 기반 모델과 SVM(support vector machine) 모델 등이 활용된다. 딥러닝 분야에서는 이미지 처리 분야에서 주로 사용되는 CNN(convolutional neural network) 기반의 모델 등이 활용된다. 위에서 제시한 모델들은 환경음 분류, 음악 장르 분류, 감정 분류 등의 오디오 분야에서 활발히 활용되고 있다.

의사결정 트리를 활용한 음악 관련 연구에서 Glaucia M. Bressan et al.은 raw audio에서 다양한 변환 과정을 통해 추출한 audio feature들을 하나의 feature vector로 표현하고, 의사결정 트리 생성 알고리즘인 CART와 C4.5 방식에 따라 음악 장르 분류를 수행했다[1]. Yan Zhang et al.은 의사결정 트리를 base 모델로 활용하는 random forest 모델을 기반으로 6개의 클래스를 분류하는 환경음 분류 모델을 제시했다[2]. 의사결정 트리를 활용한 오디오 분류의 특징은 raw audio signal에서 변환을 통해 time domain, frequency domain과 관련된 다양한 종류의 feature를 추출하고, 이것을 의사결정 트리의 attribute로써 활용한다.

SVM을 활용한 음악 관련 연구에서 Glaucia M. Bressan R. Thiruvengatanadhan은 MFCC 데이터를 활용하여 SVM 모델을 통한 음악 장르 분류와 함께, 커널 함수 종류에 따른 성능 차이 결과를 제시했다[3]. Yong Li et al.은 raw audio signal에서 얻은 다양한 audio feature 조합을 활용하여 SVM 모델을 통한 7가지 카테고리로 구성된 환경음 분류 결과를 제시했다[4]. 또한, 의사결정 트리, naive bayes, k-nearest neighbor 분류기와의 성능 비교를 통해 SVM에서 가장 높은 성능이 측정된다는 점을 제시했다. 이처럼, SVM은 적합한 결정 경계를 찾는 커널 함수와 결정 경계 조정과 관련한 파라미터를 활용하여, 고차원의 형태로 표현되는 audio feature를 이용한 분류 과정에서 의사결정 트리 모델과 비교하여 대체로 좀 더 높은 성능이 나타난다.

딥러닝 기반의 분류 모델도 음악 관련 연구에서 활발히 활용되고 있으며, 머신러닝 기반의 모델들과 비교하여 성능적인 차이가 발생한다. Hareesh Bahuleyan은 audio set 데이터를 활용한 음악 장르 분류 연구에서 SVM, 의사결정 트리와 같은 머신러닝 기반 모델과 CNN 기반의 모델 간에 분류 정확도 테스트를 진행했을 때, CNN 기반 모델에서 가장 높은 성능이 측정된다는 결과를 제시했으며, 모델의 입력으로 mel-spectrogram 데이터를 사용했다[5]. Kamalesh Palanisamy et al.은 음악 연구 분야에서의 대표적인 3가지 데이터셋으로부터 얻은 mel-spectrogram 데이터를 사용하여 ResNet, DenseNet, Inception과 같은 CNN 기반 모델을 활용한 음악 장르 분류 결과를 제시했다[6]-[9]. 이처럼, audio feature를 이미지 데이터와 같이 형식으로 활용하여 CNN 기반 분류 적용 시에 좋은 분류 성능이 확인됐다.

본 연구에서는 위와 같은 오디오 관련 연구를 기반으로 머신러닝 분야의 SVM 모델과 딥러닝 분야의 CNN 기반 모델을 분류 모델로 선정했으며, 오디오 관련 연구에서 자주 활용되는 mel-spectrogram feature를 입력 데이터로 사용했다. 기존의 연구와는 다른 전문가의 주관적 지식과 판단을 기반으로 매긴 정량적 음원 퀄리티 점수에 관한 분류에 대하여, 두 분야의 대표적인 형태의 분류 모델을 활용한 성능 비교 및 분석을 통해 본 연구에 적합한 모델을 찾는 것을 목표로 한다.

Ⅲ. 음원 퀄리티 측정 분류 시스템 제안

3-1 분류 시스템 설명

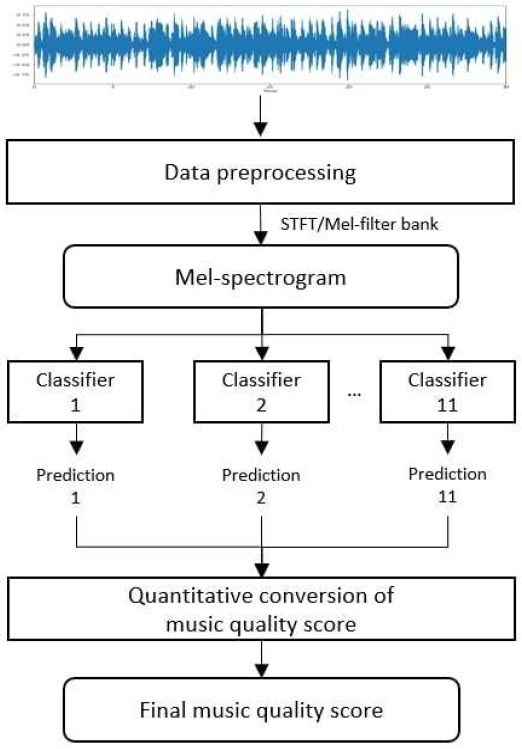

Figure 1은 본 연구에서 제안하는 음원 퀄리티 측정 분류 시스템에 대한 순서도로 다음과 같은 단계로 구성된다. 먼저, 서로 다른 재생 길이로 이뤄진 데모곡 모음에 대해서 데이터의 길이를 맞추기 위해 전처리 과정을 적용하여, 음원별로 추출된 30초 구간의 음원 데이터셋을 생성한다. 추출된 음원 signal에 대해서는 STFT(short time fourier transform)와 mel-filter bank를 적용하여 mel-spectrogram을 얻고 입력 데이터로써 활용한다. 레이블 데이터에 해당하는 전문가의 음악적 완성도 평가 점수에 대해서는 개수에 따른 클래스 불균형이 발생하지 않도록 전처리 과정을 통해 ‘1/2/3/4’과 같은 형식으로 기존의 10단계 점수 범위 체계를 4단계로 축약하고, 차등적 속성을 가지는 4개 클래스 형식의 레이블 데이터로 구성하여 target 데이터셋으로써 활용한다. 두 번째, 11가지 평가 항목별로 독립적인 클래스 분류 모델을 설정하고, 전처리를 적용한 입력 및 target 데이터셋을 적용한다. 분류 모델은 평가 항목마다 입력 데이터와 대응되는 전문가들의 음악적 점수 판정 과정이 반영된 레이블 분포를 학습하여, 결과적으로 전문가의 평가 기준에 부합하는 음원 퀄리티 클래스 예측을 목표로 한다. 분류 모델은 대략 60% 이상의 테스트 accuracy 성능이 측정될 수 있도록 학습한다. 그다음, 학습이 완료된 11가지 평가 항목별 분류기들을 사용하여 임의의 곡에서 얻은 mel-spectrogram을 입력 데이터로 적용했을 때, 음원 퀄리티 분류기마다 예측 결과로 출력되는 총 11개의 prediction을 얻는다. 이때, 분류 모델들의 prediction은 음악적 완성도가 반영된 차등적인 형태이므로, 4개 클래스와 순차적으로 대응되는 ‘25/50/75/100’와 같은 100점을 기준으로 산정된 정량화된 값으로 변환한다. 마지막으로, 사용자의 목적에 따라 평가 기준별로 가중치를 설정하고, 가중치와 정량화 값에 대해서 전체 단위에서 가중평균 방식을 적용하여 음원 퀄리티 점수 정량화 변환 과정을 활용한 100점으로 환산된 하나의 최종 음원 퀄리티 점수를 출력한다.

결과적으로, 하나의 분류기는 특정 음악적 요소에 관한 전문가의 평가 과정을 대체할 수 있으며, 출력된 최종 퀄리티 점수는 특정 음악의 종합적인 완성도 수준을 정량화된 수치로 표현할 수 있다. 위에서 제시한 일련의 과정을 하나의 시스템으로 구축하여 음악 전문가들의 주관적인 판단을 통한 평가 과정을 인공지능 모델을 통해 시뮬레이션하여 표현할 수 있다. 그러므로, 해당 시스템에서는 평가 기준별 분류기가 점수대별로 나타나는 음악의 특징 정보와 전문가의 평가 점수를 학습하여 분류 성능을 높이는 것이 핵심이다. 본 연구에서는 평가 기준별 분류기를 머신러닝과 딥러닝와 같은 2가지 분야의 모델로 구분하여 비교를 수행했다.

3-2 모델 관련 설명

머신러닝 기반의 분류 모델을 활용한 경우에는 다수의 점수 클래스 종류 중 하나의 클래스를 분류할 수 있는 multi-class 분류 방식 기반의 ensemble 모델을 적용했다. 관련 모델 중에서 분류기마다 특정 클래스 하나만을 분류할 수 있도록 구성하고, 전체 클래스 개수만큼의 분류기를 생성하여 가장 높은 확률로 판단된 1개의 클래스를 출력하는 OneVsRestClassifier를 분류 모델로 사용했다. 해당 모델에서는 분류기를 구성하는 base 모델이 필요하며, 본 연구에서는 고차원의 데이터 형식으로 표현되는 mel-spectrogram을 입력 데이터로 사용할 수 있도록 머신러닝 기반의 SVM 모델을 활용했다. 모델은 대표적인 파이썬 기반의 머신러닝 라이브러리인 scikit-learn에서 제공하는 코드를 활용했다[10]. Base model로 사용한 SVM 모델은 사용자가 조절할 수 있는 하이퍼 파라미터값에 분류 성능에 편차가 발생할 수 있다. 그러므로, 고차원의 입력 데이터에 대하여 decision boundary를 생성할 수 있도록 rbf 커널 함수를 적용했으며, support vector 형성에 영향을 미치는 C와 gamma 파라미터값을 조절하여 최적의 분류 성능을 낼 수 있도록 구성했다.

SVM 이외에도 머신러닝 기반의 ensemble 분류 모델 중에서 의사결정 트리를 base-model로 활용하는 random forest를 학습 모델로 적용했다. Random forest는 전체 학습 데이터셋에 대해서 중복을 허락하여 임의의 데이터를 샘플링하는 bootstrap 방식을 기반으로 하는 다수의 의사결정 트리를 생성하여, 트리별로 예측한 값 중에서 가장 높은 빈도를 가지는 하나의 값을 선택하는 모델이다. Random forest 모델에 대해서도 mel-spectrogram을 입력 데이터로 활용했으며, 하이퍼 파라미터를 조정하여 학습을 진행했다. 모델은 scikit-learn에서 제공하는 코드를 활용했다[10].

딥러닝 기반의 분류 모델을 활용한 경우에는 CNN 기반의 분류 모델을 적용했다. 모델의 입력 데이터로 사용하는 mel-spectrogram 데이터는 2차원 데이터 형태로 표현되며, 해당 데이터를 하나의 이미지 형태 데이터로 사용할 수 있으므로 CNN 기반의 분류 모델을 적용할 수 있다. 해당 연구에서는 대표적인 CNN 기반 모델 중, skip connection 방식을 활용하는 residual learning 기반의 ResNet 모델을 선정했으며, layer가 가장 적은 ResNet-18을 학습 모델로 활용했다. 학습 과정에서는 ResNet-18 모델의 base 구조만을 사용하여 새롭게 학습시켰다. 또한, 새로운 입출력 데이터의 형식에 맞게 입력층에서 1 channel 형태의 mel-spectrogram을 입력 데이터를 사용할 수 있도록 수정하고, 출력층에서는 softmax 함수를 통해 4개의 평가 점수 클래스를 분류할 수 있도록 출력 노드 형식을 변경했다. 모델은 딥러닝 라이브러리인 PyTorch에서 제공하는 코드를 활용했다[11].

Ⅳ. 실험 및 결과 분석

4-1 실험 데이터셋

음원에 대한 퀄리티 평가 점수 레이블 데이터셋은 실제 4명의 음악 전문가별로 11가지 평가 기준마다 1점부터 10점까지 10단계 형식으로 점수를 부여했다. 11개의 평가 기준 및 항목은 table 1에 해당하며, 크게 음향, 편곡, 보컬과 같은 3가지 항목으로 구성된다. 첫째, 음향 항목은 음원에서 소리의 크기, 배치 등의 적합성을 1번부터 5번까지의 평가 기준으로 구분하여 평가했다. 둘째, 편곡 항목은 음의 화성, 멜로디의 전개 등 곡의 연주적인 측면에서의 완성도를 6번부터 10번까지의 평가 기준으로 구분하여 평가했다. 마지막으로, 보컬 항목은 음원에서 가수의 발성과 노래에 대한 보컬 파트의 전체적인 조화 정도를 11번 항목의 평가 기준으로 구분하여 평가했다. 결과적으로, 위와 같은 3가지 항목을 통해 음원의 전반적인 음악적 완성도를 평가했다. 구체적인 평가 기준별 세부 음악 평가 요소 항목은 table 2와 같다.

전문가들의 음원 퀄리티에 대한 점수 레이블링은 먼저 10단계 형식의 점수를 ‘매우 나쁨/나쁨/보통/좋음/매우 좋음’과 같은 5구간의 척도로 구분한다. 그다음, 평가 기준별로 table 2의 항목을 기반으로 전문가 개인의 분석과 판단을 종합적으로 고려하여 척도 구간을 선정하고, 구간에 속한 세부 점수를 산정했다. 이외에도, 하나의 곡에 대한 4명의 전문가별 평가 점수는 평균과 비교하여 1점 이내의 오차를 가지도록 편차를 조정하고, 4개의 평가 점수에 대한 전문가 간 교차검증을 통해 신뢰성을 높여 학습이 원활하게 진행될 수 있도록 했다.

시스템에서 사용한 데이터는 데모곡 음원 모음으로 총 498개의 미발매된 곡에 해당하며 힙합, 댄스 등 여러 장르로 구성되어 있다. 음원의 길이는 가장 짧은 곡이 29초이고, 가장 긴 곡은 6분 18초에 해당하며 곡마다 재생 길이는 모두 다르다. 원본 음원 형식은 wav 또는 mp3 형식의 44,100Hz, stereo 타입을 가지며, 샘플링 및 전처리 과정에서 mono 타입으로 변환했다. 입력 데이터는 음원 모음에 대하여 전처리 과정을 적용한 audio feature인 mel-spectrogram을 사용했으며, 전체 입력 데이터와 레이블 데이터의 개수는 퀄리티 평가를 진행한 4명의 전문가 포함 인원에 따라 (498 * n) 개의 형태로 구성된다.

4-2 데이터셋 전처리

음원 데이터 전처리 과정에서 데이터셋을 구성하는 498개의 곡은 재생 길이가 모두 다르므로, 인공지능 모델의 입력 데이터 형태로 변환 시에 데이터 크기가 모두 다른 가변 길이 입력 문제가 발생했다. 입력 데이터의 크기가 서로 다른 경우에는 학습 과정이 원활히 진행되지 않을 수 있으며, 가장 긴 곡과 짧은 곡의 재생 시간이 5분 이상 차이가 나므로, 일반적인 패딩을 추가하는 방식은 적용할 수 없었다. 위와 같은 문제점을 해결하기 위해, 아래와 같은 방식을 적용하여 가변 길이 입력 문제를 해결했다.

Audio 관련 딥러닝 연구에서 한 음악에 대하여 특정 하이라이트 구간을 추출하는 music thumbnailing 분야가 존재한다. 추출한 하이라이트는 해당 곡의 주요 멜로디가 축약되어 표현된 구간이며, 일반적으로 곡의 후렴구 부분에 해당한다. 그러므로, 반복적인 멜로디로 구성되는 음악의 특성상, 전반적인 주요 맥락 정보를 축약된 크기로 표현할 수 있는 음원의 하이라이트 구간을 새로운 데이터로 활용했다. Yu-Siang Huang et al.은 attention 메커니즘 기반의 신경망 모델을 활용하여 pop 음악 데이터로부터 후렴구인 chorus를 하이라이트 구간으로 추출하는 방식을 제시했다[12]. 본 연구에서는 해당 논문에서 제공한 pre-trained 모델을 활용하여 음원 데이터셋으로부터 충분한 멜로디 정보를 담아내기 위해 30초 길이로 하이라이트 구간을 추출했다[13]. 하이라이트 구간에 해당하는 waveform에 대해서는 fourier transform을 기반으로 하는 변환인 STFT와 128개의 mel-filter bank를 적용하여 곡당 (1, 128, 1292) 크기의 mel-spectrogram을 추출했다. 결과적으로, (1, 128, 1292) 크기로 이뤄진 (498 * n) 개의 mel-spectrogram 데이터가 모델의 입력 데이터셋으로 구성된다.

전처리 이전 원본 음원 퀄리티 평가 점수 레이블 데이터셋은 데이터 분석 과정에서 전문가에 상관없이 대부분 점수 데이터가 80% 이상의 비율로 6점 이상에 분포하는 클래스 불균형 문제가 발생했다. 위와 같은 문제점을 해결하기 위해, 데이터 개수가 부족하고 유사한 음악적 평가를 가지는 근접한 점수 클래스끼리 묶어 클래스 종류를 줄이는 방식을 적용했다. 해당 연구에서는 기존의 10개로 구성된 점수 클래스를 1부터 4까지 형식의 차등적 클래스 레이블 형식으로 변환했으며, 평가 기준별로 4개의 클래스에 가능한 한 서로 균등한 비율로 데이터가 분배될 수 있도록 조정했다. 결과적으로, 평가 기준별로 기존의 10단계 형식의 점수 클래스에서 4단계의 클래스 레이블로 변환하는 전처리 과정을 적용했다.

추가로, 테스트 과정에서 전문가별 데이터셋으로 평가 기준별 분류 모델 학습을 진행했을 때, 전문가 1명의 주관적인 판단으로 매긴 평가 점수 데이터로는 전체적으로 분류 성능이 낮았다. 연구 과정에서 위와 같은 문제점을 해결하기 위해, 전문가 개별로 모델을 구성하는 대신에 n명의 전문가별 입력 및 레이블 데이터를 하나로 합친 합산 형태의 데이터셋을 구성하여 평가 기준별 분류 모델의 데이터로 활용했다.

4-3 증강 데이터 생성 및 추가

기존의 데모곡 음원 데이터는 총 498개가 존재하는데, 데이터셋 규모를 추가로 늘리기 위해 데이터 증강 기법을 적용했다. Zohaib Mushtaq et al.은 CNN 기반 모델을 적용하는 환경음 분류 과정에서 데이터셋에 증강 기법을 활용하는 방식을 제시했다[14]. 그러므로, 해당 논문에서 제시된 여러 기법 중에서 원본 음원의 샘플링된 데이터에 랜덤한 수치의 0.05 비율만큼 값을 더하는 잡음을 추가하는 방식을 적용했다. 위와 같은 데이터 증강 기법을 통해 데이터셋 규모를 확장할 수 있으며, 학습된 분류 모델의 좀 더 일반화된 성능을 기대할 수 있다. 레이블 데이터는 기존의 음원마다 매겨진 평가 기준별 점수 클래스를 활용했다.

본 연구에서는 원본 음원으로부터 구성된 데이터셋과 데이터 증강으로 생성된 데이터셋을 함께 포함하는 형태에 대해서도 여러 분류 모델에 대한 테스트 과정을 진행했으며, ResNet-18 모델에 대해서는 검증 데이터셋을 활용하여 학습 과정 동안에서 과적합 여부 등을 확인했다.

4-4 실험 환경 및 세팅

전체 데이터셋은 전문가 포함 인원에 따라 총 (498 * n) 개 데이터로 구성되며, 7:3의 비율로 학습 데이터셋과 테스트 데이터셋을 분리했다. 증강 데이터를 추가한 데이터셋은 전문가 포함 인원에 따라 총 (996 * n) 개 데이터로 구성되며, 6:2:2의 비율로 학습, 검증, 테스트 데이터셋 형식으로 분리했다. 머신러닝 기반의 OneVsRestClassifier 모델은 base-model로 SVM을 적용했고, 최적의 분류 성능을 측정할 수 있도록 C와 gamma 파라미터를 조정하며 학습을 진행했다. Random forest 모델은 결정 트리의 개수, 트리의 깊이 등과 같은 파라미터를 조정하여 학습을 수행했다. 딥러닝 기반의 ResNet-18 분류 모델은 증강 데이터 추가 여부에 따라 학습 epoch에 차이가 존재하며, batch size와 learning rate의 파라미터값은 각각 2와 0.0001로 적용했다. Loss function과 optimizer은 cross-entropy loss와 adam optimizer을 적용했다. 분류 모델 성능 평가 지표로는 accuracy와 AUC(area under the roc curve)를 선정했으며, AUC 수치는 multi-class 형식에서 각 클래스에 포함된 데이터 개수에 따른 가중평균을 적용한 ‘weighted’ 형태의 OVR 방식을 사용했다. 평가 기준별로 생성된 테스트 데이터셋은 학습이 완료된 분류 모델에 적용하여 성능을 측정했다.

4-5 분류 모델별 테스트 결과

Table 3은 4명의 전문가 전체로 구성된 데이터셋으로 학습한 SVM 기반 분류기, random forest, ResNet-18 모델들의 test accuracy를 table 1 평가 기준 순서별로 측정한 것이다. 전체 데이터셋은 총 1,992개의 데이터로 구성되고, 1개의 데이터는 어떤 곡에서 얻은 mel-spectrogram에 해당하며, target에 해당하는 전처리된 4단계 클래스 레이블이 존재한다. 이때, 같은 곡에 대해서도 전문가에 따라 서로 다른 평가 점수를 매길 수 있으므로, 각 데이터를 특정 전문가 개인의 의견이 반영된 하나의 독립된 데이터로써 사용될 수 있다.

전체적으로 평가 기준 종류에 따라 accuracy 성능 차이가 나타났다. 머신러닝과 딥러닝 모델 비교 측면에서는 ResNet-18 모델이 평가 기준에 상관없이 SVM 기반 분류기보다 높은 성능이 나타났지만, random forest 모델과의 비교에서는 평가 기준에 따라 성능 차이가 발생했다. 2가지 머신러닝 모델 비교 측면에서는 SVM 기반 분류기보다는 random forest 모델에서 좀 더 높은 성능이 측정됐다. SVM 기반 분류기와 random forest 모델에서는 사용자가 설정하는 하이퍼 파라미터 수치 조정에 따라 성능적 편차가 발생했다. 결론적으로, mel-spectrogram을 입력 데이터로 활용한 전문가 평가 점수 예측 분류 과정에서는 같은 평가 기준 조건이라도 SVM 기반 분류기, ResNet-18 모델, random forest 모델 모두에서 성능적 편차가 나타날 수 있다는 점을 확인했다. 또한, 인공지능 기반의 분류 모델이 어느 정도 전문가의 평가 점수에 따른 음악적 완성도와 관련한 특징 정보를 입력 데이터로부터 학습할 수 있다는 점이 나타났다.

모델에 상관없이 평가 기준별로 분류 성능은 모두 다르며 서로 간의 큰 유사성은 발견되지 않았지만, 대체로 6번부터 10번까지에 해당하는 편곡 파트와 관련된 평가 기준에서의 모델 분류 성능이 공통으로 비교적 높게 측정된 것을 확인했다.

4-6 전문가 포함 인원별 분류 테스트 결과

Table 4와 5는 전문가 포함 인원별 데이터셋 구성 및 개수 변화에 따른 평가 기준별 학습된 ResNet-18 모델의 test accuracy와 AUC 성능 수치를 비교한 결과이다. 데이터셋은 전문가마다 전체 498개의 음원에 대해서 평가 기준별로 점수를 매긴 점수 레이블 데이터와 mel-spectrogram 데이터이며, 전문가 포함 인원이 늘어날수록 두 데이터 개수는 (498 * n) 개의 형태로 비례하여 늘어난다. 전체적인 테스트 결과, 평가 기준에 상관없이 전문가 인원이 늘어날수록 test accuracy와 AUC 수치가 상승하면서 분류 성능이 향상되는 결과가 나타났다. 다른 전문가 인원이 평가한 데이터가 새롭게 포함되면서 하나의 음원에 대해서 다른 주관적인 관점으로 평가된 새로운 학습 데이터가 추가되는 효과를 가진다.

위의 결과는 단순히 학습 데이터가 개수가 증가하며, 모델 성능도 비례하여 상승하는 형태로 볼 수 있다. 하지만, 다른 측면에서는 전문가 개인의 주관적인 판단으로만 구성된 데이터셋으로는 분류 모델이 평가 기준별 판단에 필요한 feature를 제대로 학습하지 못한 상황에 해당하며, 여러 명의 전문가가 판단한 레이블 데이터셋이 학습 데이터로 추가되고 분류 성능이 상승하며, 점수 판단 과정에 있어서 객관성이 갖춰지는 과정으로도 볼 수 있다. 결론적으로, 하나의 대상에 대한 여러 주관적인 판단의 결과를 함께 학습함으로써 실제적인 판단 과정을 딥러닝 시스템으로 시뮬레이션 화하는 가능성을 제시할 수 있다. 또한, 위와 같이 새로운 데이터 추가에 따른 모델 재학습 및 성능 향상 측면에서는 CNN과 같은 딥러닝 기반의 분류 모델 선택이 좀 더 효과적일 것으로 판단된다.

테스트 결과, 음원 퀄리티 분석에서 가장 중요한 평가 기준별 분류 모델이 전문가들의 판단 과정을 학습하여 유의미한 수준의 점수 분류 성능을 나타내는 점을 확인했다. 결론적으로, 11개의 분류 모델별로 출력된 예측값들을 활용하여 다음 과정인 음원 퀄리티 점수 정량화를 적용하게 되면, 다양한 음악적 평가 요소가 고려된 새로운 음원에 대한 종합적인 음악적 완성도를 점수 형태로 정량화할 수 있다.

4-7 증강 데이터 활용 분류 테스트 결과

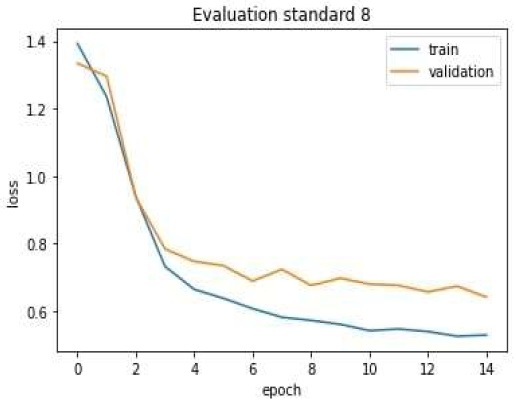

Figure 2는 증강 데이터를 추가한 데이터셋에 대해서 ResNet-18 분류 모델 학습 과정에서 학습 데이터셋과 검증 데이터셋을 활용하여, epoch에 따라 loss 값의 변화를 측정한 예시에 해당한다. 예시에 포함된 8번 평가 기준 모델의 학습 결과 이외에, 나머지 10가지 평가 기준별 분류 모델에서도 figure 2와 유사한 결과가 나타났다. 분류 모델에 따라 차이는 있지만, 대부분 학습 초중반에는 검증 데이터셋에 대한 loss가 빠르게 감소하며, 대략 10 epoch 이후의 구간부터는 loss 하락 폭이 작다. 즉, 해당 구간부터 분류 모델의 학습 데이터셋에 대한 과적합이 조금씩 확인되므로, 15 epoch 정도까지만 학습을 진행하여 최적의 분류 성능을 산출할 수 있도록 조정했다.

Table 6은 table 3에 사용된 데이터에 증강 데이터가 새롭게 추가된 데이터셋으로 학습한 SVM 기반 분류기, random forest, ResNet-18 모델들의 test accuracy를 table 1 평가 기준 순서별로 측정한 것이다. 전체 데이터셋은 총 3,984개의 데이터로 구성되며, 데이터를 6:2:2 비율로 나누어 각각 학습, 검증, 테스트 데이터셋으로 활용했다.

전체적으로, 평가 기준과 분류 모델 종류에 따라 테스트 데이터셋에 대한 accuracy 성능이 다르게 나타났다. 2가지 머신러닝 기반 모델 분류 성능 비교 측면에서는 random forest 모델보다 SVM 기반 분류기에서 전반적으로 더 높은 성능이 측정됐다. 머신러닝과 딥러닝 기반 모델 분류 성능 비교 측면에서는 평가 기준별로 차이가 있지만, ResNet-18 모델을 사용한 형태에서 대체로 더 높은 성능이 측정됐다.

증강 데이터 활용 측면에서는 새롭게 확보한 데이터가 데이터셋에 추가되면서, table 3과 비교하여 평가 기준과 분류 모델 종류에 상관없이 전반적으로 분류 성능이 향상됐다. 분류 성능이 향상된 이유로는 학습 과정에 사용될 수 있는 학습 데이터 개수가 늘어나면서, 분류 모델이 증강된 새로운 데이터로부터 더 다양한 정보를 학습할 수 있는 것으로 판단된다. 결과적으로, 데이터 증강 기법을 통한 데이터 확보가 점수 분류 모델의 성능 향상에 유의미하다는 점을 확인했다.

Ⅴ. 결 론

본 논문에서는 실제 음원에 대한 음악적 평가 기준에 따른 정량화된 퀄리티 점수를 예측하는 새로운 인공지능 모델 기반 분류 시스템을 제안했다. 이를 위해, 음악 데이터에 대한 변환 과정을 통해 audio feature를 추출했으며, 점수 레이블 데이터 전처리 과정을 적용해서 데이터 불균형 문제를 해결했다. 점수 분류 모델로는 머신러닝 기반의 SVM 모델과 random forest 모델, 딥러닝 기반의 CNN 모델을 사용했다.

측정 결과, 평가 기준에 따라 분류 성능 차이가 발생했으며, 전체적으로 대략 60에서 70% 사이의 정확도가 측정됐다. 모델별 테스트 결과에서는 3가지의 분류 모델에서 평가 기준별로 최적의 성능을 나타내는 모델이 조금씩 다를 수 있다는 점을 확인했다. 전문가 포함 인원별 테스트 결과에서는 새로운 인원이 추가됨에 따라 분류 성능이 비례하여 상승하는 결과를 확인했다. 이를 통해, 전문가 개인은 명확하지 않은 주관적인 판단을 내릴 수 있지만, 여러 전문가의 평가 정보가 계속해서 추가됨으로써 판단 과정에서 객관성이 형성될 수 있다는 새로운 가능성을 결과를 통해 확인했다. 또한, 데이터 증강 기법을 적용한 실험에서는 새로운 추가 데이터 확보를 통해 평가 기준별 퀄리티 점수 분류 모델의 성능을 향상할 수 있다는 여지를 확인했다.

마지막으로, 전문가 개인이 가진 음악적 견해를 바탕으로 내린 평가 기준별 퀄리티 점수 데이터 자체는 주관성을 가지고 있다. 그렇지만, 해당 연구에서는 현재까지는 거의 연구되지 않은 전문가의 주관적인 판단을 대변하는 새로운 형태의 레이블 데이터를 활용한 딥러닝 분류 과정을 통해 의미 있는 결과를 확인했다. 결론적으로, 본 논문에서는 제시된 일련의 과정들을 통해 전문가들의 주관적인 음악적 판단 과정을 인공지능 모델로 표현할 수 있다는 가능성을 제시했다.

향후 연구에서는 타 전문가들의 평가 항목별 점수 데이터를 추가로 확보하고, 음악 데이터로부터 음악적 요소를 잘 반영할 수 있는 audio feature를 추출하여 평가 기준마다 분류 모델의 데이터셋으로 활용한다. 그다음, 다양한 인공지능 기반 분류 모델을 적용하여 개선된 분류 성능 결과를 얻어내고자 한다. 위와 같은 과정을 통해, 기존보다 더욱 정교한 퀄리티 측정 분류 시스템을 구축할 수 있을 것이다.

Acknowledgments

본 연구는 서울시 산학연 협력사업(CT200011, 캠퍼스타운기술매칭 지원사업-음원 퀄리티 분석 인공지능)의 지원을 받아 수행되었습니다.

References

-

Bressan, Glaucia M., Beatriz CF de Azevedo, and E. A. S. Lizzi, “A decision tree approach for the musical genres classification,” Applied Mathematics & Information Sciences, Vol. 11, No. 6, pp. 1703-1713, November 2017.

[https://doi.org/10.18576/amis/110617]

-

ZHANG, Yan; LV, Dan-jv, “Selected features for classifying environmental audio data with random forest,” The Open Automation and Control Systems Journal, Vol. 7, No. 6, pp. 135-142, July 2015.

[https://doi.org/10.2174/1874444301507010135]

- THIRUVENGATANADHAN, R., “Music Classification using MFCC and SVM,” International Research Journal of Engineering and Technology, Vol. 5, No. 9, pp. 922-924, September 2018.

- Y. Li and Y. Li, “Eco-Environmental Sound Classification Based on Mathcing Pursuit and Support Vector Machine,” 2010 2nd International Conference on Information Engineering and Computer Science, pp. 1-4, 2010

- BAHULEYAN, Hareesh, “Music genre classification using machine learning techniques,” arXiv Preprint arXiv:1804.01149, , 2018.

- PALANISAMY, Kamalesh; SINGHANIA, Dipika; YAO, Angela, “Rethinking cnn models for audio classification,” arXiv Preprint arXiv:2007.11154, , 2020.

- Kaiming He, Xiangyu Zhang, Shaoqing Ren, Jian Sun, “Deep residual learning for image recognition,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pp. 770-778, 2016.

-

Gao Huang, Zhuang Liu, Laurens van der Maaten, Kilian Q. Weinberger, “Densely connected convolutional networks,” Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pp. 4700-4708, 2017.

[https://doi.org/10.1109/CVPR.2017.243]

-

C. Szegedy W. Liu, Y. Jia, P. Sermanet, S. Reed, D. Anguelov, D. Erhan, V. Vanhoucke, and A. Rabinovich, “Going deeper with convolutions,” Proceedings of the IEEE conference on computer vision and pattern recognition (CVPR), pp. 1-9, 2015.

[https://doi.org/10.1109/CVPR.2015.7298594]

- Pedregosa, Fabian, et al. "Scikit-learn: Machine learning in Python," Journal of machine Learning research, Vol. 12, No. 85, pp. 2825-2830, October 2011.

- Paszke, Adam, et al. "Pytorch: An imperative style, high-performance deep learning library," Advances in Neural Information Processing Systems, pp. 8024-8035, 2019.

-

KYu-Siang Huang, Szu-Yu Chou, and Yi-Hsuan Yang, “Pop Music Highlighter: Marking the Emotion Keypoints,” Transcations of the International Society for Music Information Retrieval, Vol. 1, No. 1, pp. 68-78, September 2018.

[https://doi.org/10.5334/tismir.14]

- Yu-Siang Huang. Pop Music Highlighter [Internet]. Available: https://github.com/remyhuang/pop-music-highlighter

-

MZ. Mushtq and S. Su, “Environmental sound classification using a regularized deep convolutional neural network with data augmentation,” Applied. Acoustic, vol. 167, pp. 107389-107401, October 2020

[https://doi.org/10.1016/j.apacoust.2020.107389]

저자소개

2021년 : 세종대학교 디지털콘텐츠학과 학사

2021년~현 재: 세종대학교 소프트웨어융합학과 석사과정

※관심분야 : 음성/오디오 신호처리, 기계학습, 딥러닝 등

2018년 : 세종대학교 디지털콘텐츠학과 학사

2022년 : 세종대학교 인공지능언어공학과 석사

2022년~현 재: 세종대학교 소프트웨어학과 박사과정

※관심분야 : 텍스트 마이닝, 자연어 처리, 딥러닝 등

1982년 : 한양대학교 공과대학 금속공학 학사

1987년 : 미국 일리노이주 서던일리노이대학교 컴퓨터 과학 학사

1990년 : 미국 일리노이주 서던일리노이대학교 컴퓨터 과학 석사

1994년 : 미국 인디아나주 인디애나 대학교 대학원 컴퓨터 과학 전공

2000년 : 미국 뉴욕주 시러큐스 대학교 대학원 컴퓨터 & 정보과학 공학 박사

2000년~2001년: 미국 펜실바니아주 외인시 소재 Bhasha, INC Technical Staff (연구원)

2002년~2003년: 아주대학교 정보통신전문대학원 BK 교수

2003년~2017년: 세종대학교 전자정보공학대학 교수

2017년~현 재: 세종대학교 소프트웨어융합대학 교수

※관심분야 : 인공지능, 지능형 시스템, 딥러닝 등