뇌파 기반의 감정 분류 및 맞춤 회화 생성에 관한 연구

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

예술 콘텐츠들을 많이 다루지 않는 비전문가들은 콘텐츠를 제작할 때 여러 가지 어려움에 맞닥뜨린다. 그것은 자신이 어떤 감정을 느끼고 있는가를 정확히 아는 것과 어떻게 콘텐츠에 표현하는가이다. 본 논문은 예술 콘텐츠, 특히 회화를 제작하는 데에 있어서, 비전문가들이 가지고 있는 어려운 점들을 해결하는 시스템을 제안한다. 사용자의 감성을 기반으로 맞춤 회화를 추천하고, 입력 사진 이미지를 추천된 회화와 같은 스타일로 변경시킨다. 이를 위해서 감정을 예측하는데 가장 효과적인 생체 정보를 이용한다. 사용자의 뇌파를 측정하여 그들의 감정 상태를 긍정-부정 비율로 찾아내고, 찾아낸 감정 상태에 가장 어울리는 회화를 미리 조사한 회화 데이터베이스로부터 추천한다. 추천된 회화와 입력 사진 이미지에 딥러닝 기반의 스타일 전이기법을 적용한다. 최종적으로 추천된 회화의 스타일이 그대로 입력 사진 이미지에 복사되어, 사용자의 감정이 그대로 반영되는 새로운 회화 이미지를 제작할 수 있게 된다. 본 연구는 페인팅 보조 툴 없이도 쉽게 회화 작품을 제작할 수 있는 장점이 있다.

Abstract

Non-professionals who do not deal with much art content face various difficulties when producing content; Knowing exactly how you feel and how you express it in content. This paper proposes a system that solves the difficulties of non-experts in producing art content, especially painting. Customized painting is recommended based on the user's emotion, and the input photo image is changed to the same style as the recommended painting. To this end, the most effective biometric information is used to predict emotions. It is recommended from a painting database that measures EEG to find their emotional state at a positive-negative ratio, and investigates the painting that best suits the found emotional state in advance. Deep learning-based style transfer techniques are applied to the recommended painting and input photo images. Finally, the recommended style of painting is copied to the input photo image as it is, so that a new painting image that reflects the user's emotions can be created. This study has the advantage of being able to easily produce painting works without a painting assistance tool.

Keywords:

Painterly rendering, Emotional computing, EEG signal, Ensemble method, Style transfer키워드:

회화적 렌더링, 감성 컴퓨팅 뇌파 신호, 앙상블 기법, 스타일 전이 기법Ⅰ. 서 론

현대 사회에서는 비전문가들이 전문가의 영역에서의 콘텐츠를 제작하는 것이 자유로워졌다. 특히 예술 분야에서는 비전문가들이 제작하는 콘텐츠들은 기술적으로 인정받기가 어려웠다. 예술작품들을 전문가들이 만들 때, 외적으로 보이는 기술적 요소들과 내적으로 내포되어 있는 정보들이 존재하는데, 이 것을 비전문가들이 따라 하기는 어렵다. 이런 콘텐츠들 중에 대표적인 것이 회화이다. 회화는 화가들이 자신이 느끼는 감정을 기반으로 여러 가지 회화적 요소들을 이용하여 표현하기 때문에, 외적으로도 내적으로도 내포하고 있는 정보들이 많이 존재한다. 관찰자들은 회화를 감상하면서, 이 두 가지 정보를 모두 받아 화가가 그림을 그릴 때 느꼈던 감정을 비슷하게 받을 수 있게 된다.

회화 콘텐츠를 제작할 수 있는 소프트웨어, 하드웨어 툴들이 많이 개발되면서, 비전문가들이 기술적 요소들은 모방하기 쉬워졌지만, 안에 내포하고 있는 감정요소들을 표현하기는 쉽지 않았다. 뿐만 아니라, 비전문가들은 자기의 감정을 정확하게 인지하고 표현하는 것이 익숙하지 않기 때문에, 감정 요소를 표현하는 것이 현재까지는 더 어려운 부분일 수밖에 없었다. 디지털 기기들이 발전함에 따라서, 맥박이나, 뇌파들을 통해서 사용자들의 감정 정보를 객관적으로 수집할 수 있게 되었다. 본 연구에서는 이렇게 수집된 감정 정보와 회화 콘텐츠를 제작할 수 있는 툴들을 융합하여, 비전문가들에게 자신들의 감성에 맞는 회화를 만드는 시스템을 제공하고자 한다.

우리는 사용자들의 뇌파를 기반으로 그들의 감성을 예측하고, 예측된 감성을 기반으로 회화를 제작해주는 시스템을 제안한다. 감성 예측 모델을 제작한다. 인간의 뇌파를 기반으로 감성을 예측하는 모델이다. 뇌파 전위 기록술(EEG; Electroencephalography)을 이용하여 사용자들의 뇌파를 측정하고 이를 기반으로 긍정과 부정의 감정을 분류하는 모델을 제작한다. 감정 분포가 다양할 수 있는 회화를 10개를 수집하여, 각각을 사용자 조사를 통해서 긍정-부정 값을 데이터베이스화한다. 사용자의 뇌파가 입력으로 들어왔을 때 제작된 모델을 기반으로 그 들의 긍정-부정 정도를 예측하고, 이를 기반으로 감정이 가장 가까운 회화를 찾는다. 이렇게 찾아진 회화를 그대로 추천하는 것이 아니라, 사용자가 가지고 있는 이미지를 찾아진 회화와 같은 스타일로 만들어 제공한다. 사용자가 가지고 있는 이미지들을 기반으로 같은 감성을 가지는 다양한 회화를 제공할 수 있기 때문에, 사용자들에게 회화에 대해 더 많은 관심을 갖도록 할 수 있다.

우리의 연구는 다음과 같은 공헌도를 가지고 있다. 첫째, 뇌파를 기반으로 사용자들의 감정을 예측하는 모델을 제작한다. 사용자에게 직접 그들이 느끼는 감정을 그대로 가져오게 되면, 자신들의 감정을 정확히 표현하기 어려운 사람들에게 얻는 정보의 신뢰도는 떨어질 수 있다. 하지만 뇌파를 기반으로 감정을 예측하게 되면, 사용자에게 설문으로 받는 정보보다 더 높은 신뢰도를 기반으로 감성 예측 모델을 제작할 수 있다. 둘째, 감성-회화를 설문으로 조사하여 데이터베이스화하였다. 회화에 감성을 매칭하여 정보화시켜놓음으로써, 후에도 쉽게 응용할 수 있도록 만들었다. 셋째, 사용자의 감성을 기반으로 회화를 제작하였다. 비전문가들의 경우 자신이 느끼는 감정을 쉽게 회화로 만들기는 쉽지 않다. 하지만, 뇌파를 기반으로 자신의 감정을 정확하게 알게 되고, 이를 기반으로 가지고 있는 이미지들을 같은 감정을 갖는 회화를 제작함으로써, 회화적 표현들이 더 이상 접근이 어렵지 않게 되었다.

Ⅱ. 관련 연구

2-1 감성 예측 연구(Emotion Estimation)

이미지를 분석하고 그 안에서 감성을 얻는 연구들은 많이 진행되어 왔다. [1]과 [2]는 분류법을 이용하여 감성을 예측하였다. [1]은 결정 트리를 이용하여 같은 성격을 갖는 사진끼리 분류하는 연구를 진행하였고, [2]의 연구는 감정을 8가지 카테고리로 나누어서, 사진에서 색상과 텍스처 등을 기준으로 주어진 사진을 8가지로 분류하였다. 분류법에서 한 단계 발전하여 기계학습을 이용하여 감성을 분류한 연구들로는 [3]-[5]가 존재한다. 이 연구들은 IAPS[6]라는 사진과 감성 정보가 매칭되어 저장되어 있는 데이터베이스를 가지고 감성 예측 모델을 제작하였다. 이미지에서 더 많은 정보들을 추출하고, 여러 가지 기계학습 기술들을 사용하면서, 감성 예측 모델은 점점 발전하여 [7]-[9]와 같은 다양한 연구들이 진행되었다. 감성 예측 모델들은 주어진 입력 데이터와 학습 모델에 따라서 모델의 방향성이 정해지기 때문에, 본 연구에서는 우리의 시스템에 맞는 학습모델을 제작하였다.

이미지에서 감성을 추출하기 위해서 정보를 얻는 연구들뿐만 아니라, 전자기기의 발전에 따라서 뇌파나 맥박과 같은 신체 정보를 통해 감성 정보를 얻는 연구들도 많이 진행되었다. [10]은 photoplethysmogram(PPG) 신호를 이용하여, 1차원 콘볼루션 신경망을 통해, 사용자의 감성을 예측해내는 연구를 진행하였다. PPG는 혈압이나 맥박 같은 정보를 얻을 수 있기 때문에 사용자의 현재 감정 상태를 얻기 쉬운 정보중 하나이다. EGG 역시 사용자의 감정 상태를 예측하기에 좋은 특징으로 사용될 요소이기 때문에, 이를 통해 다양한 연구가 진행되었다[11]-[13]. 특히 [13]은 EEG에서 감정 인식을 위해 사용할 수 있는 특징들을 추출하는 연구를 진행하였다. EEG에서 추출할 수 있는 특징 중 감정 예측에 어울리는 특징이나 학습법등에 대하여 비교 분석을 진행하였다. 우리는 EEG의 특징 중 쉽게 추출할 수 있는 정보들을 기반으로 더 발전된 기계학습법인 앙상블 알고리즘을 이용하여 감성 예측 연구를 진행하였다.

2-2 회화적 렌더링(Painterly Rendering)

회화를 제작하는 방법은 크게 두 가지로 나눌 수 있다. 하나는 스트로크 기반 렌더링이고 다른 하나는 픽셀 기반 렌더링이다. 스트로크 기반 렌더링은 Hertzmann A[14]의 연구로부터 시작되어 브러시 스트로크 단위로 회화 작품을 제작하는 방법이 대표적이다. 브러시 스트로크라는 화가가 붓질을 하는 하나의 붓 터치 단위를 기반으로, 브러시 스트로크를 캔버스 위에 붙여가면서, 회화를 만들어내는 연구이다. 여기서 발전하여, [15], [16]은 브러시 스트로크의 크기나 시작 위치 등의 세부 요소들을 파라미터와 하여 다양한 스타일의 렌더링 결과물을 제작하도록 하였다. 이런 연구들은 브러시 스트로크의 개수가 한정적이기 때문에 표현 할 수 있는 회화의 스타일이 한정적일 수밖에 없다. [17]의 연구처럼 합성 방법을 통해 다양한 브러시 스트로크를 제작하는 연구도 있었지만, 이 역시도 스트로크 데이터베이스의 개수의 한계가 존재할 수밖에 없었다.

반면 픽셀 기반 렌더링, 특히 스타일을 그대로 복사하는 스타일 전이 기법은, 어떤 입력 사진이 들어와도, 참조할 수 있는 회화만 있으면 그대로 복사할 수 있다는 장점이 존재하였다. [18]은 입력 사진에 대해서 참조하는 이미지의 색상을 복사하는 색상 전이 기법을 연구하였고, 여기서 질감, 색상 등 회화의 여러 가지 요소를 모두 고려하여 전이하는 스타일 전이 기법이 연구되어 졌다[19]. [18], [19]들은 모두 회화의 요소들을 직접 추출하여 입력 이미지에 전이하기 때문에, 고려해야 할 사항들이 많이 존재하고, 특징들을 전이하는 것에 있어서 한계점들이 존재하였다. 기계학습이 발전하면서, 이런 문제들이 많이 해결되었는데, [20], [21]이 그 대표적인 연구들이다. [20]은 이미지에서 스타일을 분리하기 어려운 단점을 콘볼루션 신경망을 이용하여 극복하였다. 콘볼루션 신경망을 통해 최적의 스타일 특징들을 회화로부터 분리하고 조작해 높은 수준으로 입력 이미지에 합성하였다. [21]은 추가로 더 많은 신경망 모델을 통해서 이미지의 스타일 전이를 시도하였다. 우리는 기존의 연구들처럼 높은 수준의 전이 기술 모델을 이용하여 사용자의 감성에 맞는 회화를 제공하는 시스템을 제안한다.

Ⅲ. 시스템

3-1 시스템 개요(System Overview)

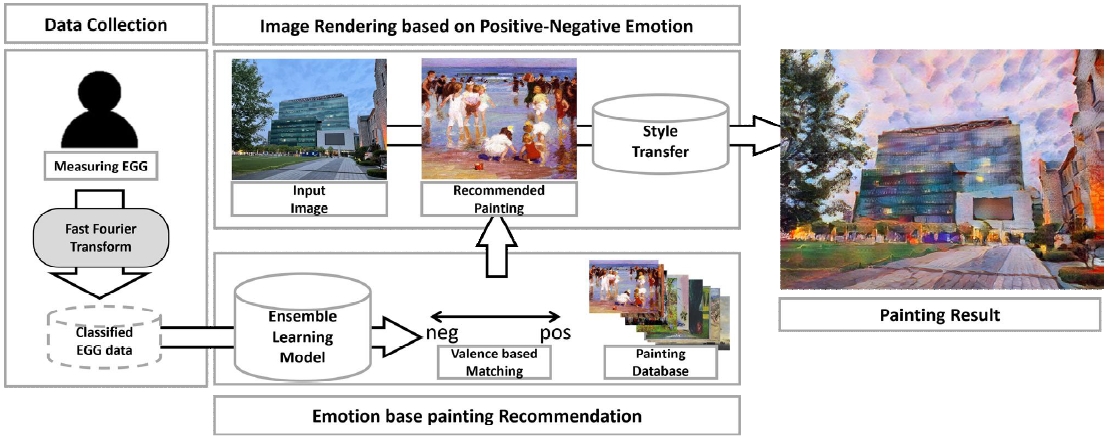

본 연구는 뇌파 전위 기록술(EEG)를 이용해 측정한 뇌파를 긍정과 부정의 감정으로 분류한 뒤 해당 감정과 유사성이 높은 명화를 추천하고, 추천된 명화를 토대로 스타일이 변환된 이미지를 생성하는 모델을 개발하였다. [그림 1]은 우리의 전체 연구 흐름을 도식화한 것이다. 데이터 수집 단계에서는 긍정 또는 부정적인 감정을 유발하는 영상을 시청하며 뇌파 측정기를 통해 뇌파의 전기적 신호인 뇌전도를 측정한 뒤 고속 푸리에 변환(FFT; Fast Fourier Transform)을 통해 주파수에 따라 8가지 대역으로 분류한다. 이렇게 얻은 뇌파는 시청한 영상에 따라 긍정 또는 부정으로 레이블링한다. 그 후 부스팅 계열의 앙상블 알고리즘인 Light Gradient Boosting Model(LightGBM)을 이용해 사용자의 감성을 분류한다. 감정 지수에 따른 명화 추천 단계에서는 측정된 감정과 사전 설문을 통해 긍정과 부정의 감정 지수가 측정된 명화 사이의 유클리디안 거리(Euclidean Distance)가 가장 가까운 명화를 추천한다. 마지막으로 이미지 렌더링 단계에서는 추천된 명화를 바탕으로 이미지의 스타일을 변환한다.

3-2 데이터 수집(Data Collection)

뇌파 신호는 SICHIRAY에서 제작한 TGAM Starter Kit Brainwave Sensor 기기를 이용해 0.01초 단위로 측정하였다. 뇌파는 20세에서 25세 사이의 남성과 여성 20명을 대상으로 긍정 또는 부정을 유발하는 영상을 시청하며 각각 3번씩 측정하였다. 피험자들은 각각 긍정을 유발하는 영상으로 평소 피험자가 평소 즐겨 보는 코미디 프로그램을 시청하였고, 부정을 유발하는 영상으로는 피험자가 부정의 감정을 느꼈던 다큐멘터리를 시청하였다. 뇌파는 영상을 시청하며 감정이 고조되었을 때 40초를 측정하였고 그 중 감정이 가장 고조된 5초에서 25초 사이에 측정된 뇌파 신호를 이용하여 분석을 진행했다.

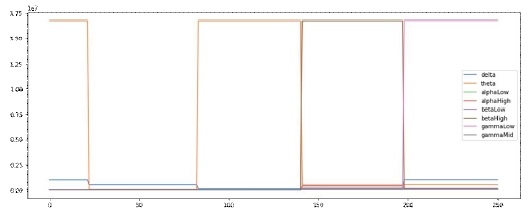

긍정을 유발하는 영상을 시청하며 수집한 뇌파는 ‘긍정’으로 레이블링하였고 부정을 유발하는 영상을 시청하며 수집한 뇌파는 ‘부정’으로 레이블링하였다. [그림 2]는 센서를 통해서 추출된 뇌파 데이터를 시각화 한 것이다. 데이터가 단조롭고, 학습의 특징으로 사용하기에는 부적절하다.

뇌의 전기적 활동을 기록하는 기술인 뇌파 전위 기록술을 통해 뇌파의 샘플링 주파수(Sampling Period)가 0.01초인 전기 신호(100Hz)를 측정했다. 푸리에 변환(Fourier Transform)의 나이퀴스트 주파수(Nyquist frequency)에 따르면, 연속 함수 또는 신호를 이산 시퀀스(Sequence)로 변환하는 샘플러에서 샘플링 주파수의 절반 이상의 주파수는 측정할 수 없기 때문이다. 즉, 뇌파 신호를 0.1Hz에서 50Hz 내의 영역에서 분석하였다.

뇌파 신호 분석 기법 중 주파수 대역별로 뇌파를 분류하는 대역 전력(Band Power) 기법과 전력 스펙트럼 밀도(Power Spectral Density)를 이용하여 주파수 대역에 따라 뇌파의 활성화 정도를 측정하였다.

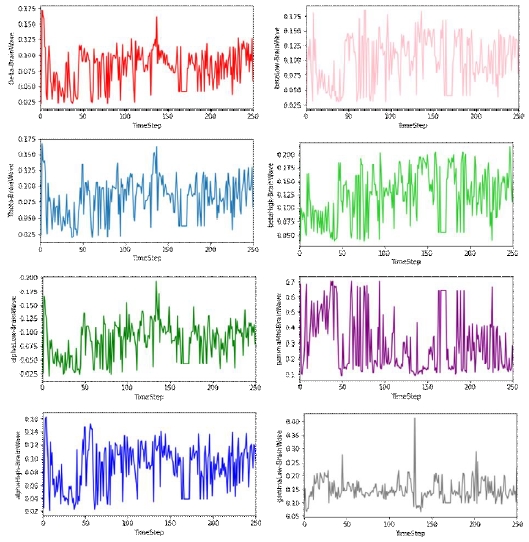

뇌파의 시간에 따른 전기적 신호를 고속 푸리에 변환(Fast Fourier Transform)[22]을 이용해 크기(Amplitude)와 주파수(Frequency)로 구성된 주파수 도메인(Frequency Domain)으로 변환하였다. 그 후 변환된 신호의 파워 스펙트럼 밀도(Power Spectral Density, PSD)를 계산한 후 주파수 대역별로 크기를 합하여 [표 1]과 같이 재분류하였다. 이 때 고속 푸리에 변환의 결과는 좌우 대칭이므로 양수의 값만 계산하였다. 고속 푸리에 변환을 거친 뇌파는 [그림 3]과 같다.

수집된 뇌파 데이터는 8:2의 비율로 학습 데이터와 평가 데이터로 나누었다. 학습을 진행할 때는 과적합(Overfitting)을 방지하기 위해 Isolation Forest[23] 알고리즘을 사용했다. Isolation Forest는 데이터 셋을 의사 결정 나무(Decision Tree) 형태로 표현해 정상 값은 루트 노드(Root Node)로부터 멀어지고 이상치는 루트 노드에 가깝게 표현해 주로 데이터의 이상치를 탐지할 때 사용된다. 우리는 Isolation Forest를 이용하여 0.2%의 비율로 이상치(Outlier)를 제거한 후 사용했다.

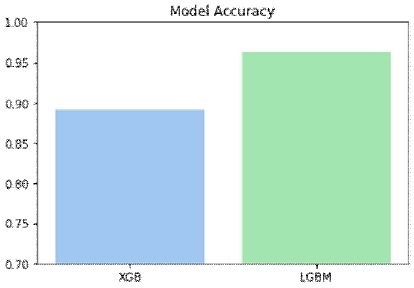

뇌파의 감성을 분류하는 모델로는 부스팅 계열 분류기를 여러 개 생성해 예측을 결합함으로써 정확한 예측을 도출하는 앙상블 알고리즘을 사용했으며 그 중 대표적인 XGBoost(Extreme Gradient Boosting)[24]와 LightGBM(Light Gradient Boosting Machine)[25]을 사용했다. XGBoost는 균형 트리 분할 방식을 사용하여 트리의 깊이를 최소화해 과적합에 강하다는 특징이 있다. 또한 LightGBM은 리프 중심 트리 분할 방식을 사용하여 학습에 소요되는 시간과 메모리가 절약되며 데이터 분포를 많이 변경하지 않아도 훈련이 덜 된 개체에 초점을 보다 잘 맞출 수 있다는 특징이 있다. 따라서 XGBoost와 LightGBM을 사용하여 뇌파의 감성을 분류하였고, 사이킷 런(Sckit-learn)에서 제공하는 GridSearchCV[26]를 사용해 하이퍼 파라미터를 학습하고 최적화하였다. 그 후 평가 데이터에서 각 모델의 정확도를 측정하였다. XGBoost는 89.09%의 정확도를 가졌고 LightGBM의 정확도는 96.36%가 나왔다. [그림 3]는 각 모델의 정확도를 비교한 그래프이다. 우리는 이 중 정확도가 높았던 LightGBM모델을 뇌파 감성 분류 모델로 선정하였다.

3-3 감정 지수에 따른 명화 추천(Emotion based Painting Recommendation)

위키아트 데이터 셋(WikiArt)[22]에서 많이 사용되는 이미지들을 선별하였다. 선별된 회화들에 사용자가 느끼는 긍정과 부정의 감정 비율을 사용자 설문을 진행했다. 회화의 데이터베이스가 많아지면 결과의 신뢰도가 높아질 수 있지만, 회화간의 감성 값이 서로 비슷하면, 하나의 회화를 추천하는데 어려움이 생길 수 있다. 따라서 우리는 선별된 회화들 중에서도 서로 변별력이 존재할 수 있는 명화 10개를 재선별 하였다. 선별된 이미지들은 [그림 5]와 같다. 각 명화별 감정 지수는 [표 2]와 같다.

10 masterpieces selected from the WikiArt dataset(From left top to right bottom, 1: “La Grande Jatte”, Georges Seurat, 1884, 2: “A Riverview with the Town of Weesp”, Salomon van Ruysdael, 1650, 3: “The Sick Child”, Edvard munch, 1907, 4: “Crimea Blooming Peach Tree”, Pyotr Konchalovsky, 1952, 5: “The Jacob's Dream ”, Marc Chagall, 1963, 6: “The Garden at Bellevue”, Edouard Manet, 1880, 7: “The Lake, Petworth, Sunset:Sample Study”, J.M.W. Turner, 1828, 8: “Ice 2”, Gerhard Richter, 1989, 9: “The scream”, Edvard Munch, 1893, 10: “Happy Days”, Edward Henry Potthast, 1920)

긍정과 부정에 대한 비율을 입력으로 학습할 명화를 추천한다. 명화 추천은 긍정-부정을 축으로 하는 좌표계에서 표현된다. 사용자가 측정한 뇌파는 LightGBM 모델을 통과하여 긍정과 부정의 비율이 산출되며 유클리디안 좌표계로 표현된다. 그 후 명화와 사용자 감성의 유사도는 수식 (1)의 유클리디안 거리를 통해 명화의 감성지수와 사용자의 감성지수의 거리가 작을수록 명화와 사용자의 감성은 유사성을 갖는다.

| (1) |

3-4 긍정-부정 감성 기반 이미지 렌더링(Image Rendering based on Positive-Negative Emotion)

입력 이미지는 사용자의 감정 지수에 따라 추천된 명화의 스타일로 변환되어 새로운 이미지로 생성된다. 유클리디안 거리 계산을 통해 추천된 명화는 AdaIN(Adaptive Instance Normalization) 스타일 변환 모델[28]을 통해 그 스타일이 학습된다. AdaIN 스타일 변환 모델은 학습 속도가 빠르며 스타일 이미지 자체를 학습하는 것이 아닌 스타일만 학습하여 보편적인 스타일로 모두 적용이 가능한 것이 특징이다. 따라서 스타일 이미지의 내용에 의존적이지 않은 스타일 변환이 가능하다.

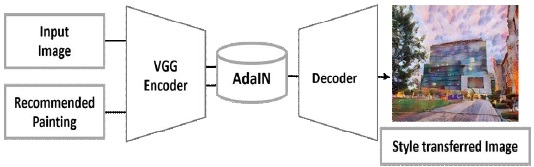

[그림 6]은 AdaIN 스타일 변환 모델의 네트워크를 도식화 한 것이다. 회화로 변환시킬 입력 이미지와 스타일을 학습할 추천된 회화는 VGG[29] 네트워크 기반의 사전 학습된 모델을 통해 인코딩을 수행하며 특징 공간상에서 AdaIN 계층(layer)에 입력된다. 수식 (2)는 AdaIN 계층의 동작을 수식으로 나타낸 것이다.

| (2) |

스타일 변환은 입력 이미지의 특징 x에서 이미지의 스타일을 정규화한 뒤 회화의 스타일 y의 표준편차를 곱한 후 평균을 더하는 방식으로 진행된다. 그 후 AdaIN 계층을 통과해 나온 데이터는 인코더와 역구조를 가지는 디코더를 통해 특징 공간에서 이미지 공간으로 디코딩되는 방법을 학습하며 추천된 회화의 스타일로 그대로 변환된 회화 이미지를 출력한다.

Ⅳ. 실험 결과

4-1 실험 환경(Experimental Environment)

실험은 Intel(R) Xeon(R) Gold 5120 CPU 16-Core 프로세서, 32GB RAM, Tesla V-100SXM2-32GB 환경에서 진행되었다. 실험은 Python 인터프리터(Interpreter) 3.6.5 버전을 이용해 진행했으며 기계학습에 대한 구현은 Pytorch 1.2.0 버전의 딥러닝 프레임워크(Framework)와 Sckit-learn 등을 이용했다.

4-2 렌더링 결과(Rendering Result)

우리는 20명의 사용자에게 뇌파검사기를 통해서 그들의 뇌파 정보를 가져오고, 가져온 정보를 기반으로 렌더링 결과를 제작해보았다. [표 3]은 그 중에서 대표 4명의 고속푸리에 변환된 뇌파와 분류된 감정 지수, 추천된 명화를 나타낸다. 사용자 번호는 긍정적인 비율 값이 작은 사람이 낮은 번호에 배정되어, 오름차순으로 나열하였다. 긍정적인 비율이 커질수록, 회화 데이터베이스 중에서도 긍정적인 비율이 높은 회화가 추천되는 것을 확인할 수 있다.

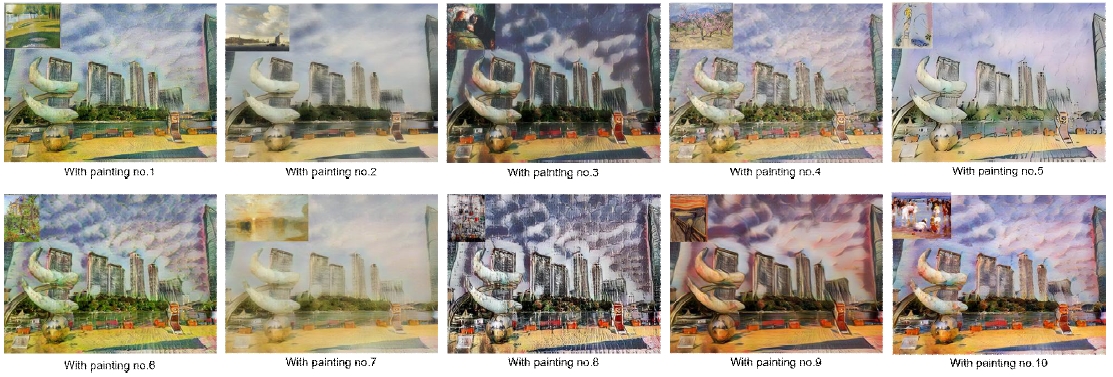

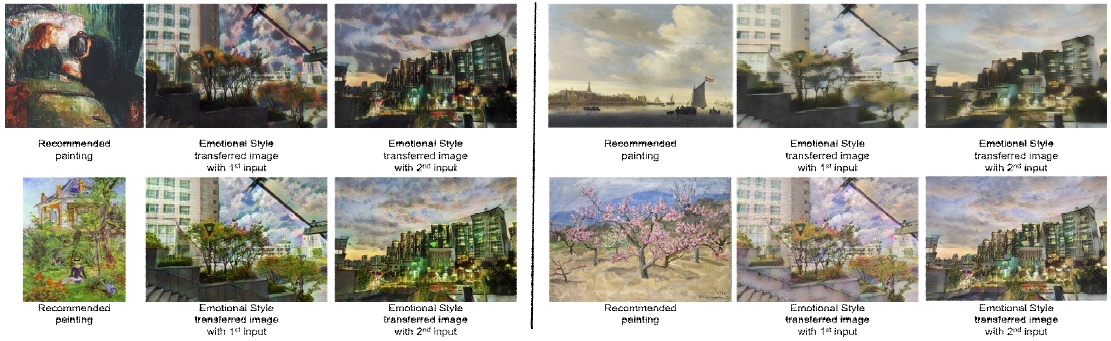

[그림 7]은 스타일 변환에 사용될 입력 이미지들이다. 다양한 결과를 확인하기 위해서, 낮 시간의 이미지와 밤 시간의 이미지를 사용하였다. 또한 풍경이 포함되어 있는 이미지와 건물만 포함된 이미지를 이용함으로써 다양한 결과를 확인할 수 있었다. [그림 8]은 사용자의 감성과 가장 유사한 명화를 [표 2]에 따라 추천하고 [그림 7]을 입력 이미지로 사용했을 때의 스타일이 변환되어 생성된 회화를 보여준다. [표 3]에서 사용자들이 예측된 감정을 기반으로 추천된 회화를 가지고 회화를 생성하였다. 생성된 회화는 입력 이미지가 바뀌더라도 스타일을 학습한 명화의 내용에 의존적이지 않으면서 명화의 스타일과 유사하도록 변환되는 것을 확인할 수 있다. [그림 9]는 [그림 7]의 세 번째 이미지에 대해서 데이터베이스인 [그림 5]의 전체 회화의 스타일을 모두 전이한 결과이다. 입력 이미지만 있으면, 다양한 스타일을 표현할 수 있는 것을 확인할 수 있다.

The result of emotional-based painterly rendering in which the recommended style of painting is transferred

Ⅴ. 결 론

본 연구는 사용자의 감정이 반영된 회화를 생성하는 시스템을 제안한다. 사용자의 감정을 판단하기 위해서 감성에 영향이 큰 생체 신호인 뇌파를 이용하였다. 뇌파 측정 센서를 이용하여 뇌파를 측정하고 측정된 뇌파를 고속 푸리에 변환을 이용하여 학습에 사용할 수 있도록 데이터화하였다. 데이터화 된 뇌파 값과 긍정-부정 감정값의 연관성을 앙상블 기법을 통해서 분석하여 감성 예측 모델을 제작하였다. 제작된 감성 예측 모델은 사용자의 뇌파가 임의로 들어왔을 때, 그들의 감정이 어느 정도 긍정적인지, 부정적인지를 예측한다. 이렇게 예측된 감정 결과에 가장 감정적으로 가까운 회화를 미리 감정 설문조사를 마친 회화-감성 데이터베이스에서 찾아 추천한다. 추천된 회화와 바꾸고 싶은 입력 이미지를 AdaIN 스타일 변환 모델을 이용하여, 입력 사진 이미지를 사용자가 원하는 감정이 표현되는 회화 형태로 바꿔주게 된다.

우리의 연구는 사용자의 감성을 나타내는 회화를 자동적으로 제작할 수 있다는 장점이 있다. 일반적으로 비전문가들은 회화와 같은 예술적 콘텐츠를 제작하는 데에는 기술적인 한계를 가지고 있다. 하지만 자신이 사진 이미지와 참고하고 싶은 회화만 있으면 쉽게 회화 작품을 만들 수 있다. 이 때 사용자의 현재 감정이 포함되기 때문에, 화가들이 그림을 그리는 것과 같은 방식으로 예술 작품을 제작할 수 있다. 뇌파 분석을 통해서 사람의 감정을 예측할 수 있는 모델을 제작하였다. 사용자의 감정을 단어 형용사로 표현하지 않고, 긍정-부정을 수치화하여 예측하기 때문에, 다른 연구 분야에도 응용할 수 있다는 장점이 있다.

우리의 연구는 몇 가지 발전 가능성이 존재한다. 감성 예측범위의 확장이다. 우리의 연구는 뇌파를 기준으로 긍정-부정의 감성축에 대해서 예측을 진행하였다. 긍정과 부정의 감성축만으로도 충분히 만족할 수 있는 결과를 얻을 수 있지만, 많이 사용되는 감성 공간[30]은 2차원으로 다른 한 축으로 흥분상태(Arousal)의 정도를 가지고 있다. 우리의 연구를 2차원으로 확장시켜 예측하는 연구를 진행한다면 더 다양한 결과를 제작하고 여러 연구에 응용이 더 용이할 것이다. 또한 뇌파의 측정에 고성능의 센서를 사용하여, 더 많은 정보를 얻을 수 있다면, 감성 예측에 더 효과적이고 더 높은 정확도를 가질 수 있을 것으로 예상된다.

References

-

R. Datta, D. Joshi, J. Li, and J.Z. Wang, “Studying aesthetics in photographic images using a computational approach”, Lecture Notes in Computer Science 3, pp.288-301, 2006.

[https://doi.org/10.1007/11744078_23]

-

J. Machajdik and A. Hanbury, “Affective Image Classification using Features inspired by Psychology and ArtTheory”, Proceedings of the 18th ACM international conference on Multimedia, New York: NY, pp. 83-92, 2010.

[https://doi.org/10.1145/1873951.1873965]

-

V. Yanulevskaya, J. C. van Gemert, K. Roth, A. K. Herbold, N. Sebe, and J. M. Geusebroek, “Emotional valence categorization using holistic image features”, 15th IEEE International conference on image processing, San Diego, 2008.

[https://doi.org/10.1109/ICIP.2008.4711701]

-

D. Joshi, R. Datta, E Fadorovskaya, Q. Luong, J. Wang, and J. Luo, “Aesthetics and emotions in images”, IEEE Signal Processing Magazine, pp.94-115, 2011.

[https://doi.org/10.1109/MSP.2011.941851]

-

S. Zhao, Y. Gau, X. Jiang, H. Yao, T. Chua, and X. Sun, “Exploring principles of art features for image emotion recognition”, Proceedings of the ACM International conference on Multimedia, Orlando Florida USA, pp. 47-56, 2014.

[https://doi.org/10.1145/2647868.2654930]

-

P. Lang, M. Bradley, and B. Cuthbert, “International affective picture system(IAPS) : Affective ratings of pictures and instruction manual”, NIMH, Center of the Study of Emotion & Attention, Florida, Technical report A-8, 2005.

[https://doi.org/10.1037/t66667-000]

-

V. J. Konecni, “Emotion in painting and art installations”, The American journal of psychology, Vol. 128, No. 3, pp.305-322, 2015.

[https://doi.org/10.5406/amerjpsyc.128.3.0305]

-

T. Rao, X. Li, H. Zhang, and M. Xu, “Multi-level region based convolutional neural network for image emotion classification”, Neurocomputing, Vol. 33, pp.429-439, 2019.

[https://doi.org/10.1016/j.neucom.2018.12.053]

- T.M. Lee, D.W. Kang, K.H. Yoon, S.H. Seo, “Emotion-based painting image display system”, Intelligent automation and soft computing, vol.26, no.1, pp.181-192, 2019.

-

M. S. Lee, Y. K. Lee, D. S. Pae, M. T. Lim, D.W. Kim, and T.K. Kang, “Fast emotion recognition based on single pulse PPG Signal with convolutional neural network”, Applied science, Vol. 9, No.16, 3355, 2019.

[https://doi.org/10.3390/app9163355]

-

D. O. Bos, “EEG-based emotion recognition”, Emotion, vol. 57, no. 7, pp. 1798-806, 2006.

[https://doi.org/10.1109/TBME.2010.2048568]

-

X. Wang, D. Nie and B. Lu, “EEG-based emotion recognition using frequency domain features and support vector machines”, Proceedings of international conference on neural information processing, Sanghai, pp. 734-743, 2011.

[https://doi.org/10.1007/978-3-642-24955-6_87]

-

R. Jenke, A. Peer, and M. Buss, “Feature extraction and selection for emotion recognition form EEG”, IEEE Transactions on affective computing, Vol. 5, Issue. 3, pp.327-339, 2014.

[https://doi.org/10.1109/TAFFC.2014.2339834]

-

A. Herzmann, “Painterly rendering with curved brush strokes of multiple sizes”, Proceedings of Siggraph 98, ACM Press, pp. 453-460, 1998.

[https://doi.org/10.1145/280814.280951]

- S. H. Seo, J. W. Seo, and K. H. Yoon, “A Painterly rendering based on stroke profile and database”, Proceedings of international symposium on computational aesthetics in graphics visualization and Imaging, pp. 9-16, 2009.

-

S. H. Seo, and K. H. Yoon, “A multi-level depiction method for painterly rendering based on visual perception cue”, Multimedia Tools and Applications, Vol. 64. Iss. 2, pp .277-292, 2013.

[https://doi.org/10.1007/s11042-012-1036-x]

-

J. Lu, C. Barnes, S. DiVerdi, and A. Finkelstein, “RealBrush: painting with examples of physical media”, ACM transactions on graphics, Vol. 32, Issue. 4, 2013.

[https://doi.org/10.1145/2461912.2461998]

-

E. Reinhard, M. Adhikhmin, B. Gooch, and P.Shirley, “Color transfer between images”, IEEE computer graphics and application, Vol. 21, Issue.5, pp.34-41, 2001.

[https://doi.org/10.1109/38.946629]

-

H. C. Lee, D.W. Kang, T.M. Lee, and K.H. Yoon, “Pixel-Based impressionistic stylization”, International journal of multimedia and ubiquitous engineering, Vol.11, No.1, pp.267-280, 2016.

[https://doi.org/10.14257/ijmue.2016.11.1.26]

-

L.A. Gatys, A.S. Ecker, and M. Bethge, “Image style transfer using convolutional neural networks”, Proceedings of the IEEE conference on computer vision and pattern recognition, Las Vegas, pp.2414-2423, 2016.

[https://doi.org/10.1109/CVPR.2016.265]

-

F. Luan, S. Paris, E. Shechtman, and K. Bala, “Deep photo style transfer”, Proceedings of the IEEE conference on computer vision and pattern recognition, Hawaii, pp.4990-4998, 2017.

[https://doi.org/10.1109/CVPR.2017.740]

-

E. O. Brigham and R.E. Morrow, “The fast Fourier transform”, Proceedings of the IEEE Spectrum, pp.63-70, 1967.

[https://doi.org/10.1109/MSPEC.1967.5217220]

- Fei Tony Liu, Kai Ming Ting and Zhi-Hua Zhou, “Isolation Forest”, Proceedings of the IEEE international conference on data mining, pp.413-422, 2008.

- Tianqi Chen and Carlos Guestrin, “XGBoost: A Scalable Tree Boosting System”, Proceedings of the 22nd ACM SIGKDD International conference on knowledge discovery and data mining, San Francisco, pp.785-794, 2016.

- G. Ke, Q. Meng, T. Finley, T. Wang, W. Chen, W. Ma, Q. Ye and T.-Y. Liu, “LightGBM: A Hightly Efficient Gradient Boosting Decision Tree”, In advances in Neural Information Processing Systems, pp. 3149-3157, 2017. https://proceedings.neurips.cc/paper/2017/file/6449f44a102fde848669bdd9eb6b76fa-Paper.pdf

- GrideSearchCV [Internet]. Available: https://scikit-learn.org/stable/modules/generated/sklearn.model_selection.GridSearchCV.html

- WikiArt [Internet]. Available: https://www.wikiart.org

-

X. Huang, and S. J. Belongie, “Arbitrary style transfer in real-time with adaptive instance normalization”, Proceedings of the IEEE international conference on computer vision, Venice, pp. 1501-1510, 2017. https://arxiv.org/abs/1703.06868v2

[https://doi.org/10.1109/ICCV.2017.167]

- K. Simonyan and A. Zisserman, “Very Deep Convolutional Networks for Large-Scale Image Recognition”, International conference on learning representations, San Diego, 2015. https://arxiv.org/abs/1409.1556

-

J. Russell, “Circumplex model of affect”, Journal of personality and social psychology, vol.39, no.6, pp. 1161-1178, 1890.

[https://doi.org/10.1037/h0077714]

저자소개

2019년~: 중앙대학교 소프트웨어학부 학사과정

※관심분야:컴퓨터비전(Computer Vision), 기계학습(Machine Learning)

2011년 : 중앙대학교 컴퓨터공학과 (공학사)

2013년 : 중앙대학교 일반대학원 (공학석사-컴퓨터그래픽스)

2019년 : 중앙대학교 일반대학원 (공학박사-컴퓨터그래픽스)

2019년~: 중앙대학교 다빈치SW교육원 특임교수

※관심분야:비사실적 렌더링(NPR), 색상 이론(Color Theory), 감성 컴퓨팅(Emotional Computing), 인공지능(Artificial Intelligence)