딥러닝 기반 도로위험객체 자동 인식 및 분류에 관한 연구

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

도로에는 낙하물, 포트홀, 로드킬 등 다양한 위험객체가 빈번하게 발생하며, 이로 인한 사고를 예방하기 위한 최선의 방법은 신속하게 검지하는 것이다. 이를 위해 전 세계적으로 모바일 앱 기반의 도로위험객체 신고 서비스가 공공과 민간 영역에서 활발히 개발·운영되고 있는 실정이다. 하지만 도로환경에서 앱을 사용하여 위험객체를 신고하는 행위는 위험하기 때문에 그 사용시간을 최소화하는 기술의 개발이 필요하다. 이에 본 연구에서는 딥러닝 기술을 활용하여 도로 이미지로부터 도로위험객체를 자동으로 인식하고 분류하는 방법을 제안 및 구현하고 성능을 검증함으로써 그 가능성을 점검하였다. 신고 이미지는 노면상태불량, 배수시설불량, 도로시설물불량, 로드킬 및 장애물의 네 개의 분류체계로 분류하였고, 딥러닝을 통해 학습된 모형(YOLO v3)은 평균 95%의 높은 검출율을 나타냈다.

Abstract

Various dangerous road objects such as potholes, falling objects, roadkills occur frequently on road, and the best way to prevent accidents from these dangers is to find them as soon as possible. A lot of mobile applications to report the road problems have been developed and in service worldwide both in public and private sectors. It is not safe, however, to report the problem using those apps in road environment, and it is necessary to develop a technology to minimize the time to make a report using the apps. For this purpose, a method to recognize and classify the road dangerous objects automatically from road images using deep learning algorithm was proposed and implemented, and the performance of the proposed model(YOLO v3) was tested, which shows 95% success rate on average to detect the four categories of road dangers including pavement, drainage, road facility, and roadkill, and demonstrates the possibility of the proposed method.

Keywords:

Recognition, Classificatioin, Deep Learning, Road Dangerous Object, YOLO키워드:

객체 인식, 객체 분류, 딥러닝, 도로위험객체, YOLOⅠ. 서 론

도로에서 발생하는 포트홀, 낙하물, 로드킬, 시설물 파손 등의 도로위험은 교통사고를 비롯한 인명 사고의 주요 원인으로, 이의 신속한 해결을 위해서는 무엇보다도 빠른 인지가 필수적이다. 이에 전 세계적으로 모바일 앱을 활용하여 이러한 문제를 도로이용자가 빠르게 신고할 수 있는 서비스를 제공 중이며[1-4], 우리나라에서는 도로이용불편 척척해결서비스 앱(CC App)이 고속도로, 국도, 지방도 등 국내 모든 도로를 대상으로 도로의 불편 또는 위험 요소를 신고하고 처리하는 서비스를 제공하고 있다[5].

Fig. 1과 같이 CC App은 위험요소를 신고하는 과정에서 도로이용자가 사진 혹은 영상을 취득한 후 해당 위험요소에 대한 세부 분류항목과 그와 관련된 상세 정보를 작성하도록 요구한다. 이러한 설계는 앱 기반 신고 서비스의 최대 장점인 신속성과 편의성을 떨어뜨릴 뿐만 아니라 도로라는 위험한 환경에 신고자를 오랜 시간 노출되게 함으로써 잠재적 사고 위험을 높이는 부정적 요소라 할 수 있다. 이는 곧 앱 이용율 저하로 이어져 신고라는 고유의 기능을 유지하기 어렵게 되는 악순환을 가져오게 된다. 따라서 CC App과 같은 앱 기반 도로 위험요소 신고 서비스의 활성화를 위해서는 신고 절차의 신속성과 정확성을 보장하는 기술적 개선이 요구되며, 이를 위해서는 사진 또는 영상으로부터 위험요소를 자동으로 추출하는 기능이 필요하다.

컴퓨터 비전(Computer Vision) 기반의 객체 검출 응용 프로그램은 주로 범용으로 수집된 이미지 데이터를 기계학습에 활용한다. 이러한 범용 이미지 데이터들 중에는 ImageNet[6], Open Image V6[7], PASCAL Visual Object Classes(VOC)[8] 및 Common Objects in Context(COCO)[9] 등이 있으며, 이들은 모두 일반 이용자가 아무런 제약 없이 사용할 수 있는 기계학습용 Open Source Image (OSI)들이다. 이러한 데이터셋에 포함된 이미지 데이터들은 차량(승용차, 트럭, 기차), 사람, 동물 (개, 고양이 등), 식물(꽃, 나무 등)등과 같이 일상에서 쉽게 접하게 되는 객체들이다.

그러나 CC App의 관심 대상인 도로노면파손, 포트홀, 로드킬, 불량 배수시설 등과 같은 도로위험요소는 소위 “쉽게 접할 수 있는 객체”들이 아니기 때문에 이러한 이미지 확보를 위해 OSI 데이터를 이용하는 것은 불가능하다.

이에 본 연구에서는 도로위험 신고 사진(이미지)로부터 위험객체를 자동으로 인식하고 분류하는 방법을 제안하고, 그 기술을 구현한 후 그 성능을 검증함으로써 그 가능성을 점검한다. 본 연구는 기존의 일상적 이미지가 아닌 도로 이용자에게 잠재적 위협이 되는 도로위험객체 이미지를 이용한 기계학습이기 때문에 연구의 독창성이 있으며, 특히 실제 시민들의 현장 불편 신고 내용의 이미지를 사용한 점에서 향후 실용화의 기반이 되는 연구라 할 수 있다.

Ⅱ. 연구방법

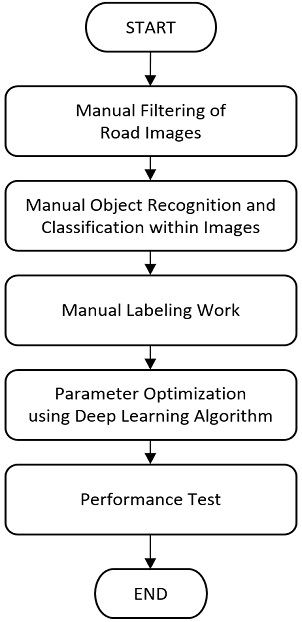

본 연구에서는 Fig. 2와 같은 도로위험객체 자동 인식 및 분류 방법을 제안하고 이에 따라 기술 구현을 수행한다. 먼저 CC App을 통해 신고된 이미지 데이터를 준비하고, 이 중 육안으로 인식이 어려운 이미지를 제거한다.

다음으로 선택된 이미지 데이터를 하나씩 보면서 도로위험객체를 육안으로 인식하고 이를 분류하는 작업을 수행한 후 별도의 툴을 이용해서 라벨링(Labeling) 작업을 수행하여 기계학습을 위해 필요한 학습용 이미지 데이터셋을 준비한다. 그 후 딥러닝 알고리즘을 이용하여 도로위험객체 인식 및 분류를 위한 기계학습을 수행하고, 성능을 검증한다.

Ⅲ. 자동 인지 및 분류 기술 구현

3-1 데이터셋 구축

앞서 언급한 바와 같이 CC App의 관심 대상은 도로에 존재하는 위험요소이기 때문에 범용으로 수집된 기존의 이미지 데이터를 활용하는 것은 불가능하다. 이에 도로위험객체 이미지 데이터 확보 문제를 해결하기 위해 본 연구에서는 CC App 서비스 이용자에 신고된 이미지 데이터를 활용하였다. 해당 데이터는 접수된 민원에 따라 1) 노면상태불량(pavement), 2) 배수시설불량(drainage), 3) 도로시설물불량(road facility), 4) 로드킬 및 장애물(roadkill), 5) 기타(미분류 항목, unclassified)으로 분류된다. 신고 이미지 데이터는 2019년 11월 28일부터 2020년 1월 10일까지 신고된 총 4,736개의 이미지 데이터를 대상으로 하였고, 이 중 이미지가 흔들리거나 너무 어두운 이미지를 제외한 후 최종적으로 2,231개 이미지 데이터를 활용하였다(Table 1).

3-2 라벨링 (Labeling)

준비된 이미지 데이터를 기계학습에 활용하기 위해 이미지 내에 검출하고자 하는 대상들의 위치에 대한 정보를 취득해야 한다. 이미지 기계학습 분야에서는 이러한 과정을 라벨링(Labeling)이라고 하는데, 학습 대상 기계가 일정 수준의 학습 정확도를 보이기전까지는 수작업으로 라벨링을 수행하는 것이 일반적이다.

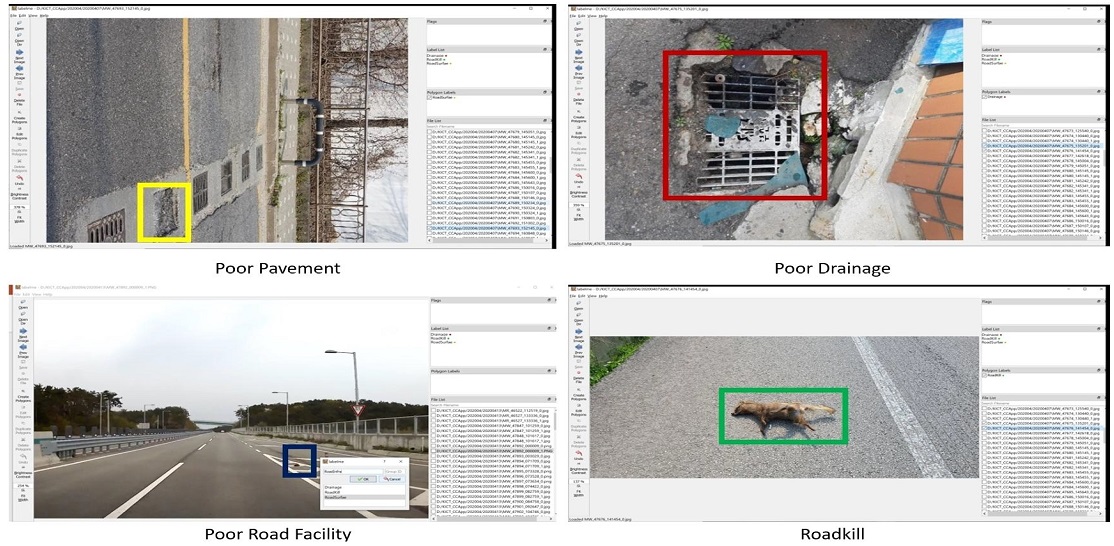

본 연구에서는 전 단계에서 준비된 이미지 데이터를 대상으로 네 가지 유형의 문제점을 찾고, Labelme 툴[10]을 활용하여 Fig. 3과 같이 해당 문제점이 보이는 위치에 사각형 경계상자 (Bounding Box)를 설정하여 라벨링을 수행하였다. 하나의 이미지에 두 개 이상의 문제점을 포함하는 경우 각각의 문제점들에 경계상자를 추가하여 설정하는 방식으로 라벨링을 수행하였다. 이러한 방식으로 모든 이미지 데이터의 라벨링을 수행한 결과, 총 2,849개의 도로위험객체를 이미지로부터 라벨링하여 기계학습용 데이터로 구축하였다. 이러한 절차를 통해 학습 및 검증을 위해 준비된 이미지 데이터의 개수가 충분히 많지는 않으나 제안된 도로위험객체 자동 인지 및 분류 방법의 가능성을 점검하기에는 적절한 수라고 판단된다.

3-3 기계 학습

라벨링 과정을 거친 이미지 데이터들은 다음 단계인 기계학습(ML, Machine Learning) 과정에 사용된다.

딥러닝 기반의 객체 검출 기술은 주로 합성곱신경망(Convolutional Neural Network; CNN)을 활용한다.

수학적으로 합성곱은 서로 다른 두개의 함수를 서로 중첩(적분)시켜 다른 함수를 생성하는 연산을 의미한다. 이러한 원리를 기계학습용 이미지에 적용하게 되는데, 합성곱이 원본 이미지를 필터링 하는 역할을 수행하게 된다. 합성신경망은 이러한 필터링 과정을 다수 반복하며, 각각의 필터링 과정이 바로 인공신경망에서 사용하는 층 (Layer)을 구성한다. 이미지 내에 존재하는 객체들은 다수의 필터링 과정을 거침으로써 객체가 가지고 있는 고유의 형태를 기계학습과정에서 보존할 수 있게 되며, 또한 이를 이용하여 다른 객체와의 차별성을 확보하게 된다. 바로 이러한 특징이 합성곱신경망 기반의 객체 검출 기법이 다른 기법들에 비해 우수한 검출 능력을 보이는 이유이다.

합성곱신경망을 기본 구조로 하는 객체인식 혹은 객체 검출 기법으로는 VGG16[11], Region-based Convolutional Neural Networks (R-CNN)[12], Fast R-CNN[13], Faster R-CNN[14], Mask R-CNN[15], 그리고 YOLO(You Only Look Once)[16] 등이 있다. 이러한 기법들 중 본 연구에서는 YOLO를 활용하여 객체 검출용 기계학습을 수행한다.

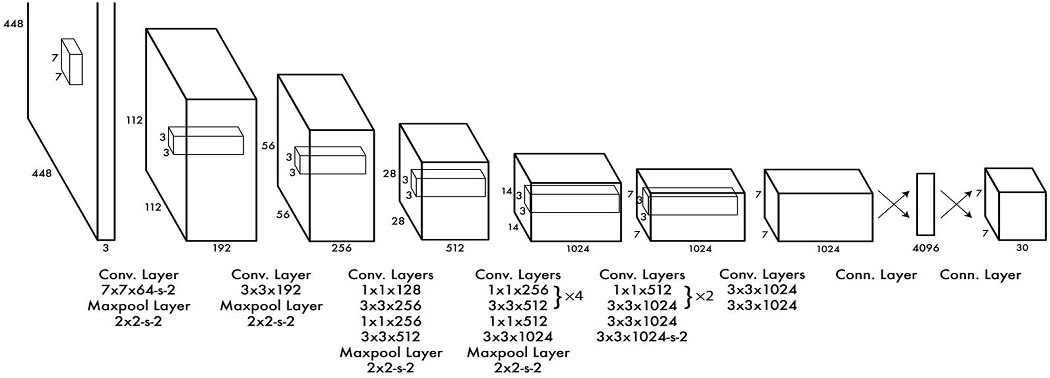

YOLO는 빠른 시간에 다수의 객체를 동시에 검출할 수 있도록 고안된 인공신경망이다[16]. 인공신경망을 구성하는 각 층(Layer)의 구조와 개수, 각 층별 사용되는 합성곱 필터 및 활성함수(Activation Function) 등과 같은 핵심 구성요소들의 속성들로 하여금 다수의 객체를 신속하고 정확하게 검출할 수 있도록 최적화 되어있다. 이러한 특성 때문에, 이미지 기반 객체 검출 구현 시, YOLO의 기본 신경망 구조를 직접 사용할 수 있기 때문에 합성곱신경망 자체를 별도로 개발할 필요가 없다. 뿐만 아니라, 필요할 경우 기존 신경망 구조를 상황에 맞게 일부 수정함으로써 객체 검출 응용프로그램의 개발에 시간과 비용을 절약할 수 있는 장점이 있다. Fig. 4는 YOLO(버전 3)의 기본 합성곱신경망 구조를 도식화해서 보여주고 있는데, 그림에서 Conv. Layer는 합성곱 필터링을 수행하는 층을 의미한다.각 층에 존재하는 합성곱 필터는 필터의 사이즈(M), 채널(C), 그리고 필터 이동치(S)로 MxMxC-s-S 로 표현된다.

즉, YOLO(v3)는 총 24개의 합성곱필터링 층으로 구성되어 있으며, 그 외에도 본 연구에서는 네 개의 통합화 층(Pooling Layer)과 두 개의 완전연결 층(Fully Connected Layer)으로 구성되어 있다. 원본 이미지 데이터는 원래 크기와 무관하게 일차적으로 448(가로)×448(세로) 크기로 변형되고 이후 Fig. 4에 나타난 과정을 거쳐 최종적으로 7×7×3크기의 다차원 벡터 혹은 텐서(Tensor)의 형태로 변환되어 학습에 이용된다.

YOLO는 총 80개의 검출 대상 객체에 대해 COCO 이미지 데이터셋[17]을 활용하여 학습된 가중치 데이터를 제공한다[16]. 그러나 앞서 언급한 바와 같이 본 연구의 관심 대상은 일상에서 흔히 접하기 어렵고 일반인들의 관심도가 상대적으로 낮으며, 교육 목적의 활용도 또한 높지 않다. 이러한 이유로, YOLO뿐만 아니라 다른 이미지 기반 객체 검출용 인공신경망 모형 등도 본 연구의 관심 대상 객체를 포함하는 학습된 가중치 데이터를 제공하는 경우는 극히 드물다. 따라서 본 연구를 수행하기 위해서는 기존의 가중치 데이터를 활용할 수 없으며, 본 연구가 필요로 하는 객체들을 검출 할 수 있도록 새로운 가중치를 학습해야 함을 의미한다. 이에, 본 연구에서는 방법론에 제시된 바와 같이 이미지 데이터셋 구축과 대상 객체 라벨링 작업 과정을 거쳐 입력 및 출력 데이터를 구축하고, 이를 YOLO v3의 인공신경망 구조에 적용하여 연구목적에 부합하도록 기계학습(ML)을 수행하였다. 이로서, 기존 YOLO v3가 제공하는 학습된 가중치와는 완전히 다른 가중치 데이터를 확보하였다. 학습과 평가는 TensorFlow 기계학습 플랫폼[18]을 기반으로 Keras[19] API를 이용하여 수행하였다. 기계학습에 사용된 하드웨어와 주요 소프트웨어 패키지의 사양은 Table 2와 같다.

Ⅳ. 성능 검증 및 결과 분석

총 2,231개 이미지 데이터 중 대략 6.5%에 해당하는 145개의 이미지 데이터들이 학습된 모형의 성능 검증용으로 무작위 선택되었다.

선택된 이미지들은 라벨링 과정 없이 학습된 모형의 입력 자료로 이용되며, 학습된 모형은 이미지로부터 도로위험객체를 인식 및 분류하고 이를 경계상자로 표시한다. 인식된 도로위험객체는 CC App 서비스의 분류기준 중 기타-미분류 항목을 제외한, 노면상태불량(S), 배수시설불량(D), 도로시설물불량(R), 로드킬 및 장애물(K)의 네 개 항목으로 구분되고, 각각 해당 경계상자 좌상단에 표기된다(Fig. 5).

학습된 모형의 성능을 검증하기 위해 다음 식과 같이 검출율 지표를 사용하였는데, 여기서 검출율(Success Rate)은 특정 도로위험객체 항목에 대하여 검증용 이미지 데이터에서 육안으로 관측된 실제 위험객체 건수(B)와 학습된 모형이 해당 객체를 정확하게 검출한 건수(A)의 비율로 정의된다. 따라서 검출율이 100%에 근사할수록 정확한 검출이 이루어졌다는 의미로 해석된다.

| 식 (1) |

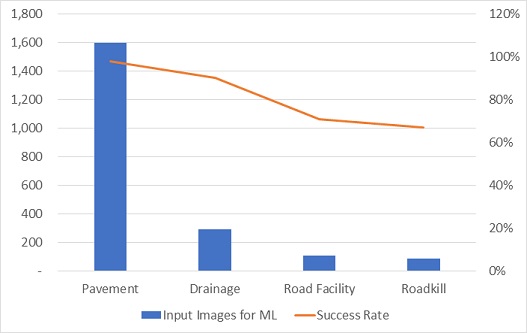

Table 3에서 볼 수 있는 것과 같이, 각 도로위험객체 항목별 검출율은 노면상태불량, 배수시설불량, 도로시설물불량, 및 로드킬 및 장애물 항목에 대하여 각각 98%,90%, 71%, 67%로 나타났으며, 전체 평균 검출율은 95%인 것으로 분석되었다.

각 도로위험객체 항목별 검출율을 상세히 분석해 본 결과, 특정 객체를 다른 객체로 잘못 검출하는 사례도 관찰되었다. 예를 들어, 98%의 검출율을 보인 노면상태불량 항목은 전체 관측건수 165건 중 실제로는 노면상태불량 항목이지만 로드킬 및 장애물 항목으로 검출한 경우가 1건, 분류항목에는 포함되어 있지 않은 경우를 검출한 경우 1건, 그리고 검출을 실패한 경우가 1건 있었다. 배수시설불량, 도로시설물불량, 로드킬 및 장애물 항목도 이와 유사한 경우가 관측되었다.

도로위험객체 항목별로 검출율과 기계학습(ML)에 사용된 이미지 데이터 개수를 비교해보면, Fig. 6에 나타난 바와 같이 검출율은 기계학습에 사용된 이미지의 개수에 비례하는 것을 확인할 수 있다. 이는 합성곱신경망 기반 객체 검출 기법의 작동원리를 고려하면 당연한 결과라 할 수 있다. 즉, 기계학습 과정은 결국 어떤 객체에 대해서 서로 다른 형태의 이미지 데이터를 계속해서 주입하고 그 객체가 가지고 있는 고유의 형태상 특성을 반복해서 각인시키는 일종의 반복학습이다.

따라서 학습 이미지 데이터가 많을수록 그 객체의 형태적 특성들이 더욱 세밀하게 학습된다고 할 수 있다.

YOLO는 다양한 형태로 모형이 개발되어 왔으며, 각각의 모형은 입력 이미지의 크기가 다르던지, 아니면 특정 디바이스에 특화된 형태로 개발된 것이다. 앞서 분석에서 사용된 YOLO 모형은 v3-416으로 입력 이미지를 416x416 해상도(resolution)로 변경하여 검출하는 반면, YOLO v3-608은 608x608 해상도의 이미지로 변경한다. 그리고 YOLO v3-Tiny는 소형 디바이스에서 구동이 가능한 버전으로, 입력 이미지의 해상도 크기는 YOLO v3-416과 동일하다. 본 연구에서는 이러한 세 가지의 서로 다른 YOLO 모형들의 검출 성능을 비교하였고, 그 결과는 Table 4와 같다. YOLO v3-416 와 YOLO v3-608은 거의 유사한 검출율을 보인 반면, YOLO v3-Tiny는 모든 문제점 항목에서 위의 두 모형에 비하여 낮은 검출율을 보였다.

v3-416과 v3-608을 비교했을 때 다른 항목에 비해 로드킬 및 낙하물 항목에서 v3-608의 성능이 낮게 나타났는데, 이는 원본 이미지의 해상도가 높지 않았기 때문인 것으로 판단된다. 따라서 입력 이미지의 해상도를 크게 하는 것이 CC App 서비스를 위해서는 크게 도움이 되지 않는 것으로 나타났다. 그리고 v3-Tiny의 검출율이 낮은 것은 어느 정도 당연한 결과이며, CC App 서비스에 해당 기능을 추가할 때 스마트폰에서 직접 검출을 하는 것보다는 서버와의 통신을 통해 이미지를 전달하고 서버에서 이를 검출한 후 스마트폰에 결과를 전송하는 방식이 유리할 것으로 판단된다.

다만, 신고자의 통신비용 등을 고려할 때 향후 추가적인 데이터 확보를 통해 v3-Tiny 버전의 검출율을 지속적으로 향상시킬 필요가 있을 것이다.

Ⅴ. 결 론

본 연구에서는 도로이용불편 신고 서비스를 통해 신고된 도로위험객체 이미지 데이터를 이용하여 딥러닝 기반의 도로위험객체 자동 인식 및 분류 모형(YOLO v3)을 구현하고, 그 성능을 검증함으로써 그 가능성을 점검하였다. 신고 이미지는 노면상태불량, 배수시설불량, 도로시설물불량, 로드킬 및 장애물의 네 개의 분류체계로 분류하였고, 딥러닝을 통해 학습된 모형은 성능 테스트 결과, 평균 95%의 높은 검출율을 나타냈다. 하지만 입력 이미지의 개수가 적은 항목인 도로시설물불량과 로드킬 및 장애물은 각각 71%, 67%의 낮은 검출율을 나타냈다. 그리고 YOLO v3 모형들 간의 성능 비교 결과, 입력 이미지의 해상도가 낮은 v3-416의 성능이 좋은 것으로 확인되었다.

본 연구의 결과에서 확인할 수 있듯이, 딥러닝 기반의 모형 개발의 핵심은 입력 이미지의 개수이기 때문에 추후 도로시설물불량과 로드킬 및 장애물 관련 신고 이미지를 확보함으로써 실제 서비스에 활용이 가능한 버전의 모형 개발이 가능할 것으로 판단된다. 또한 YOLO 모형 내 신경망 구조의 수정을 통해 보다 다양한 도로위험객체에 대한 향상된 검출 성능 확보가 가능할 것으로 기대된다. 마지막으로, 노면상태불량의 경우 포장관리(Pavement Management) 측면에서 보다 다양하게 항목을 분류하여 관리함으로써 도로관리에 도움이 될 수 있는 형태로의 발전이 필요할 것으로 판단된다.

References

- Prefeitura da Cidade do Rio de Janeiro. Central de attendimento 1746 [Internet]. Available: https://www.1746.rio/, .

- The City of Calgary, City government information and non-emergency services [Internet]. Available: https://www.calgary.ca/cfod/csc/311.html, .

- SocietyWorks. Fix My Street [Internet]. Available: https://www.fixmystreet.com/, .

- Asteria Corporation. Near Miss Accident [Internet]. Available: https://plat.io/ja/posts/plates_near_miss_incident_report_building/amp, .

-

W. H. Jeon, and I. Yang, “Development of a location-based smartphone app reporting road problems with user participation,” Journal of Digital Contents Society, Vol. 19, No. 1, pp. 1825-1832, 2018.

[https://doi.org/10.9728/dcs.2018.19.10.1825]

-

J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li and L. Fei-Fei, “ImageNet: A Large-Scale Hierarchical Image Database,” In IEEE Computer Vision and Pattern Recognition (CVPR), pp. 248-255, 2009.

[https://doi.org/10.1109/CVPR.2009.5206848]

- Google. Open Image Version 6 [Internet]. Available: https://storage.googleapis.com/openimages/web/index.html.LastAccess:2020/11/10, .

-

M. Everingham, S. M. A. Eslami, L. Van Gool, C. K. I. Williams, J. Winn, and A. Zisserman, “The PASCAL Visual Object Classes Challenge: A Retrospective,” International Journal of Computer Vision, Vol. 111, No. 1, pp. 98-136, 2015.

[https://doi.org/10.1007/s11263-014-0733-5]

- T. Y. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ramanan, P. Dollar, and C. L. Zitnick, “Microsoft COCO: Common objects in context,” In ECCV, 2014.

-

B. Russell, A. Torralba, K. Murphy, W. T. Freeman, “LabelMe: a database and web-based tool for image annotation,” International Journal of Computer Vision, Vol. 77, pp. 157-173, 2008.

[https://doi.org/10.1007/s11263-007-0090-8]

- K. Simonyan and A. Zisserman, “Very deep convolutional networks for large-scale image recognition,” arXiv preprint arXiv:1409.1556, , 2014.

-

R. Girshick, J. Donahue, T. Darrell, and J. Malik, “Rich feature hierarchies for accurate object detection and semantic segmentation,” In Proc. IEEE Conf. on computer vision and pattern recognition (CVPR), pp. 580-587, 2014.

[https://doi.org/10.1109/CVPR.2014.81]

-

R. Girshick, “Fast R-CNN,” In Proc. IEEE Intl. Conf. on computer vision, pp. 1440-1448, 2015.

[https://doi.org/10.1109/ICCV.2015.169]

- S. Ren, K. He, R. Girshick, and J. Sun, “Faster R-CNN: Towards real-time object detection with region proposal networks,” In Advances in neural information processing systems (NIPS), pp. 91-99, 2015.

- K. He, G. Gkioxari, P. Dollár, and R. Girshick, “Mask R-CNN,” In Proceedings of the IEEE international conference on computer vision, 2017.

-

J. Redmon, S. Divvala, R. Girshick, and A. Farhadi, “You only look once: Unified, real-time object detection,” In Proceedings of the IEEE conference on computer vision and pattern recognition, 2016.

[https://doi.org/10.1109/CVPR.2016.91]

- Microsoft, COCO(Common Objects in Context) [Internet], Available: https://cocodataset.org/

- Google, TensorFlow [Internet], Available: https://tensorflow.org/, .

- F. Chollet, Keras [Internet], Available: https://github.com/fchollet/keras, .

저자소개

1998년 : 연세대학교 도시공학 학사

2000년 : 연세대학교 도시공학 석사

2011년 : Univ. of California, Irvine, 박사

2000년~2006년: 현대엠엔소프트(現현대오토에버)

2011년~현 재: 한국건설기술연구원 연구위원

※관심분야:첨단교통, 자율주행, C-ITS, 도로안전, 도로시설

1999년 : 한양대학교 교통공학 학사

2001년 : 한양대학교 교통공학 석사

2016년 : 서울대학교 도시계획학 박사

2001년~현 재: 한국건설기술연구원 연구위원

※관심분야:도로안전, 무동력 교통수단, 모바일 앱, 도로시설

2000년 : 한양대학교 교통공학 학사

2007년 : University of Virginia, 석사

2010년 : University of Virginia, 박사

2011년~현 재: New Jersey Institute of Technology, USA

※관심분야:첨단교통, 자율주행, C-ITS, 도로안전, 도로시설