Transformer 기반 비윤리적 문장 탐지

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

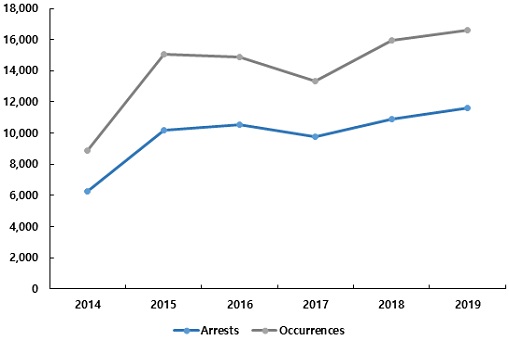

정보통신 기술의 발달은 사회관계망서비스(SNS)의 확산을 가져왔지만 심각한 사회적 문제인 악성 댓글을 야기하였다. 사이버 명예훼손ㆍ모욕 발생/검거 건수는 2014년 8,880건에서 2019년 16,633건으로 급격히 증가하였고 해당 문제를 해결하기 위한 대책이 요구된다. 그러나 IP 블랙리스트, 비속어 필터와 같은 기존의 규제만으로는 다양한 패턴을 가지는 악성 댓글을 탐지하는데 한계가 있다. 따라서 비윤리적 문장 탐지에 최적화된 인공지능 모델이 필요하다. 본 논문은 자연어 처리에서 높은 성능을 보여준 Transformer 기반 비윤리적 문장 탐지 모델을 제안한다. 해당 모델은 95.03%의 정확도를 보여주었고 비윤리적 문장 탐지 모델로 활용될 것이다. 또한, SNS의 댓글뿐만 아니라 스트리밍 서비스 등 다양한 분야에서도 적용될 것이다.

Abstract

Social network services (SNS) have spread due to the development of information and communication technology, but at the same time, they have caused serious social problems such as malicious comments. The number of arrests and incidents of cyber defamation and insults increased sharply from 8,880 in 2014 to 16,633 in 2019, and measures are required to solve the problem. However, existing regulations such as IP blacklist and slang filters make it difficult to detect malicious comments. Therefore, we need an artificial intelligence model optimized for unethical sentence detection. This paper proposes a Transformer-based unethical sentence detection model that has shown high performance in natural language processing. The model showed accuracy of 95.03% and will be utilized as an unethical sentence detection model. Also, it will be applied in various fields such as streaming services as well as comments on SNS.

Keywords:

artificial intelligence, sentence classification, natural language processing, unethical sentence, deep learning키워드:

인공지능, 문장분류, 자연어처리, 비윤리적 문장, 딥러닝Ⅰ. 서 론

정보통신 기술의 발달은 사회관계망서비스(SNS)의 확산을 가져왔다. SNS의 주요 플랫폼인 스마트폰의 이용자 수는 2010년 기준 50,767천 명에서 2019년 기준 68,893천 명으로 증가하였고 동시에 웹사이트와 SNS의 영향력이 더욱 확대되었다[1]. 사이버공간의 익명성은 개인의 사회적 참여를 확대하는 긍정적인 영향을 가져왔지만, ‘악성 댓글’이라는 사이버 폭력 문제를 야기하였다[2]. 악성 댓글은 인터넷 댓글 중 특정 집단을 대상으로 하는 악의적인 혐오 표현을 의미한다. 악성 댓글은 전 세계에서 발생하지만, 웹 사이트와 SNS의 영향력이 큰 국내에서 상대적으로 빈번하게 발생하여 심각한 사회적 문제로 대두되고 있다. [그림 1]에서 보여지듯이 사이버 명예훼손ㆍ모욕 발생/검거 건수는 2014년 8,880건에서 2019년 16,633건으로 급격히 증가하였다[3].

악성 댓글 문제를 해결하기 위한 접근법은 크게 규제적 관점과 기술적 관점에서 살펴볼 수 있다. 규제적 관점에서 국내 포털 사이트인 다음(연예 뉴스)과 네이버(연예 뉴스)는 댓글을 폐지하였고 다른 포털 사이트는 IP 블랙리스트, 비속어 키워드를 이용한 자동 치환 기능 등을 적용하였다[4]. 기술적 관점의 접근법은 크게 통계 기반의 방법과 인공지능 기반의 방법으로 구분될 수 있다. 통계 기반의 방법에서 단어의 출현빈도와 역 문헌 빈도의 가중치를 사용한 SVM 모델은 68.05%의 정확도를 보여주었으며, FFP(Feature Frequency Profile)를 활용한 RandomForest 모델은 76.50%의 정확도를 보여주었다[5,6]. 인공지능 기반의 방법은 최대한 많은 특징들을 문장에서 추출하여 이를 기반으로 악성 댓글을 분류할 수 있는 모델을 학습하는 것이다. 인공지능 기반의 연구는 악성 댓글 예측을 위해 CNN-LSTM 모델을 활용하여 80.94%의 정확도를 보여주었으며, 다른 연구는 CNN-Attention 모델을 활용하여 70.32%의 가중 평균 F1 점수를 보여주었다[7,8].

기존 악성 댓글 문제를 해결하기 위한 접근 방법은 다음과 같은 한계를 가진다.

우선, 규제적 관점의 경우 악성 댓글은 비속어, 공격적인 문장뿐만 아니라 혐오 표현이 나타난 문장도 포함되기 때문에 악성 댓글을 명확하게 분류하기 어렵다. 또한, 기존의 인공지능 모델은 자연어 처리에 특화된 모형 적용이 이루어지지 않았으며, 이로 인하여 성능과 학습 속도에 한계를 가지고 있다. 따라서 본 논문은 기존 인공지능 모델의 한계를 보완한 transformer 기반 비윤리적 문장 탐지 모델을 제안한다. Transformer 기반의 모델링은 기존의 인코디, 디코더 구조를 유지하면서 고속의 병렬 연산이 행렬곱으로 가능하다는 장점이 있습니다.

본 논문은 다음과 같이 구성되었다. 2장에서는 이론적 배경을 설명하고 비윤리적 문장 탐지와 관련된 연구를 비교 분석하였다. 3장에서는 학습에 사용된 데이터셋과 모델의 구조를 소개하고 4장에서는 모델의 성능을 평가하기 위한 실험 결과를 분석하였다. 마지막으로 5장에서는 결론 및 향후 연구에 관해 설명한다.

Ⅱ. 이론적 배경 및 선행연구 고찰

2-1 이론적 배경

자연어 처리는 인공지능의 주요 분야 중 하나로 인간의 언어 현상을 컴퓨터와 같은 기계를 이용하여 묘사할 수 있도록 하는 연구 분야이다. 자연어 처리는 음성 인식, 질의응답 시스템, 문서 요약, 번역, 감성 분석, 스팸 메일 분류 등 사회 여러 분야에서 사용된다.

자연어 처리의 통계적 언어 모델로 N-gram, Bag of Words(Bow), Document-Term Matrix(DTM), 잠재 의미 분석 등이 존재한다[9,10]. 자연어 처리의 딥러닝 언어 모델로 Convolutional Neural Network(CNN), Recurrent Neural Networks(RNN), Long Short-Term Memory(LSTM), attention, transformer, Bidirectional Encoder Representations from Transformers(BERT) 등이 주로 활용된다[11-14]. 본 연구에서 활용된 transformer는 기존의 인코더-디코더 구조를 유지함과 동시에 순차 연산을 단순 행렬곱 연산으로 변환함으로써 자연어 처리에서 높은 성능과 빠른 학습 속도를 가진다는 장점이 있다[15].

2-2 선행연구 고찰

비윤리적 문장 탐지를 위한 기존 연구는 CNN-LSTM 모델을 기반으로 문자 수준의 CNN 모델과 단어 수준의 CNN-LSTM 모델을 구축하였다[7]. Kaggle의 Cyberbulling 댓글 분류 경연 대회의 데이터셋을 이용하여 CNN 모델에서 정확도 85.97%, CNN-LSTM 모델에서 정확도 80.94%를 보여주었다. 최종적으로 두 모델을 앙상블 하여 정확도 88.66%의 모델을 구축하였다. CNN-Attention 모델을 활용한 다른 연구는 성별, 정치, 연령, 종교, 인종에 관한 차별적 표현이 포함된 연예 뉴스 댓글 데이터를 사용하였다[8]. 3개의 채널을 사용한 CNN-Attention 모델에서 70.32%로 가장 높은 가중 평균 F1 점수를 보여주었다.

Ⅲ. 연구 방법

3-1 데이터셋

‘Korean HateSpeech Dataset’은 한국 엔터테인먼트 뉴스 집계 플랫폼에서 수집한 댓글 9,381건으로 구성된다[16]. 해당 데이터셋은 7,896개의 학습 데이터셋, 471개의 검증 데이터셋, 974개의 테스트 데이터셋으로 구성된다. 댓글 데이터는 ‘gender’, ‘other’, ‘none’으로 분류되었다. 본 논문에서는 ‘gender’와 ‘other’로 분류된 댓글을 비윤리적 댓글로 분류하였다.

‘욕설 감지 데이터셋’은 커뮤니티 사이트에서 수집된 5,825건의 댓글로 구성된다[17]. 해당 데이터셋은 단순 욕설, 인종 차별적인 말, 정치적 갈등을 조장하는 말, 성적·성차별적인 말, 타인을 비하하는 말, 그 외에 불쾌감을 주거나 욕설로 판단되는 말이 포함된 댓글을 악성 댓글로 분류하였다.

AI Hub에서 제공하는 ‘인공지능 윤리연구를 위한 비정형 텍스트 데이터셋’은 비속/비윤리적 표현의 빈도수가 많은 특정 온라인 커뮤니티에서 수집된 댓글 데이터 25,000건으로 모두 악성 댓글로 분류하였다[18].

‘Chatbot_data’ 데이터셋은 다음 카페에서 수집된 댓글 23,646건으로 모두 일반 댓글로 분류하였다[19].

결측값을 제외한 최종 데이터셋은 일반 댓글 26,769건, 악성 댓글은 24,481건으로 총 51,250건의 댓글 데이터이다. 학습을 위해 일반 댓글은 0으로 악성 댓글은 1로 분류하였다. 학습 데이터로 50,222건(일반 댓글: 26,292건, 악성 댓글: 23,930건), 테스트 데이터로 1,028건(일반 댓글: 477건, 악성 댓글: 551건)을 사용하였다. 문장 데이터의 토큰화를 위해 ‘SentencePiece’ 라이브러리를 적용하였다[20].

3-2 모델구조

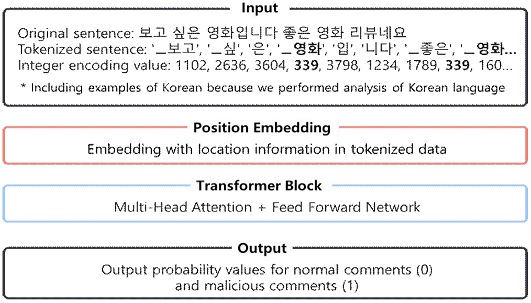

본 연구에서 사용한 transformer 모델의 인코더 부분은 입력값에 대한 위치 정보를 포함하여 임베딩하는 ‘positional embedding’과 multi-head attention 및 순방향 신경망(feedforward neural network)이 존재하는 ‘transformer block’으로 구성된다[15].

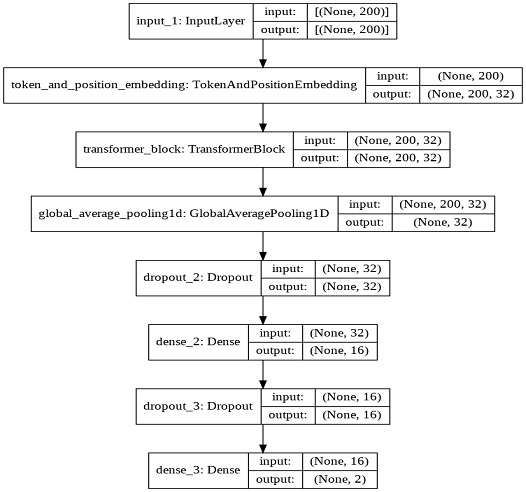

[그림 2]는 제안하는 모델의 수행 과정을 보여주며, [그림 3]은 실제 transformer 기반의 비윤리적 문장 탐지 모델의 구조를 나타낸다. ‘SentencePiece’ 라이브러리로 토큰화된 데이터는 최대 문장의 길이를 200으로 설정하여 제로 패딩을 수행하였다. 제로 패딩을 수행한 데이터셋에 인코더 부분의 transformer 모델을 적용하였다.

‘TokenAndPositionEmbedding’ 레이어에서 임베딩의 크기는 32, 말뭉치의 크기는 20,000으로 설정하였으며, ‘transformer block’ 레이어에서 순방향 신경망의 크기는 32, head는 4로 설정하였다. 히든 노드가 각각 32, 16개로 이루어진 신경망을 드롭아웃과 함께 추가하였다. 드롭아웃 비율은 모두 0.1로 설정하고 활성화 함수로 ReLU를 사용하였다. 출력 레이어에서는 활성화 함수로 softmax를 사용하여 일반 댓글과 악성 댓글의 확률값을 정규화하여 0과 1사이의 값으로 출력하였다.

제안하는 transformer 모델과 비교 대상이 되는 베이스라인 모델로 LSTM과 attention을 활용하였다. 모든 모델에서 동일하게 에폭 크기는 500, 배치 크기는 16, 검증 데이터 비율은 0.2, 옵티마이저는 Adam을 사용하였다. 성능 향상을 위한 콜백 함수로 학습과정에 early stopping 기술을 모두 적용하여 학습 횟수를 최적화 하였으며, 학습률을 조절하여 성능을 개선하는 ‘ReduceLROnPlateau’를 적용하였다[21,22].

Ⅳ. 연구결과

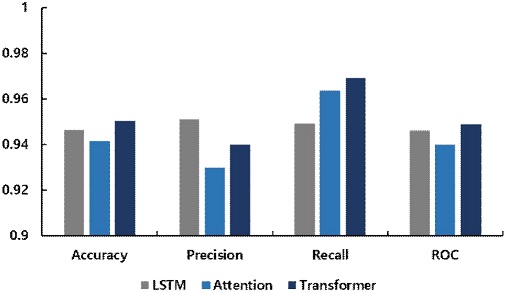

제안하는 방법의 정량적인 성능 평가를 수행하기 위하여 정확도, 정밀도, 재현율 및 the Area Under the Receiver Operating Characteristic(AUROC)를 확인하였다. [그림 4]의 성능 평가 결과에서 확인할 수 있듯이, 제안하는 transformer 기반의 모형이 LSTM 및 attention 기반의 모델과 비교하여 전반적으로 우수한 성능을 보이는 것을 확인할 수 있었다. 정확도의 경우 transformer 기반의 모델이 0.946의 성능을 가지는데 반해 LSTM과 attention 모델의 경우 각각 0.946, 0.941의 성능을 보여주었다. 하지만, 정밀도의 경우는 LSTM 모델이 0.950으로 제안하는 모델보다 성능이 높은 것을 확인할 수 있었다. 재현율의 경우는 transformer 모델의 성능이 0.970으로 LSTM 및 attention 모델의 성능인 0.949, 0.963보다 우수한 것을 확인할 수 있었다. 따라서, 정밀도와 재현율의 F1 점수를 계산하여 종합적인 성능 비교를 수행하였으며, 제안하는 transformer 기반 모델이 0.955로, LSTM 및 attention 모델의 성능인 0.949, 0.945보다 높은 성능을 가지는 것을 확인할 수 있었다. 마지막으로, AUROC 성능을 비교한 결과 역시 transformer 모델이 0.949로, LSTM 및 attention 모델의 성능인 0.946, 0.940보다 높은 성능을 가지는 것을 확인하였다.

Comparison of the performance of the proposed Transformer-based method with the existing LSTM and attention-based methods.

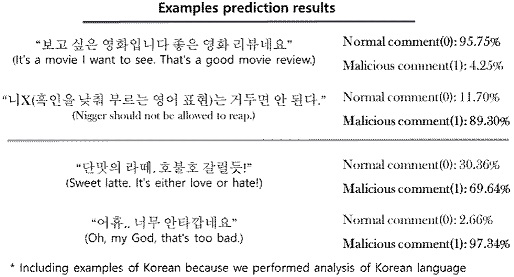

다음으로 [그림 5]와 같이 실제 테스트 데이터 데이터셋에 예측 모형을 적용하였을 때 결과를 분석해 보았다. 문장에서의 감정 표현이 비교적 명확한 문장에서는 제안하는 예측 모형이 일반 댓글과 악성 댓글을 명확히 구분하는 것을 확인할 수 있었다. 하지만, 표현이 모호하거나 중의적일 경우에는 예측에 있어 한계점을 가지는 것을 확인할 수 있었다.

Ⅴ. 결 론

본 논문에서는 비윤리적 문장 탐지를 위한 transformer 기반 모델을 제안하였다. SNS 상에 등장하는 비윤리적 문장은 다양한 형태와 규칙을 가질 수 있기 때문에 기존의 규칙 및 통계 기반의 접근 방식은 한계를 가진다. 제안하는 transformer 기반의 접근 방식은 기존 인공지능 기반의 접근 방식인 LSTM 및 attention 모델보다 정량적으로 우수한 성능을 보여주는 것을 본 연구를 통하여 확인하였다. 해당 모델은 transformer의 높은 성능과 빠른 학습 속도를 바탕으로 비윤리적 문장 탐지에 적극적으로 기여할 것이다. 또한, SNS와 댓글뿐만 아니라 유튜브, 트위치 생방송 등 스트리밍 서비스에서 활용할 수 있을 것으로 예상된다.

데이터셋의 크기가 작고 신뢰성이 다소 부족하여 모델의 예측에 부정적인 영향을 준 것으로 생각된다. 향후 더 많은 데이터셋을 확보한다면, 다양한 표현을 모델에 반영하여 개선된 성능을 확보할 수 있을 것이다.

이진 분류를 수행하였기 때문에 실제 환경에서 존재하는 인종, 지역, 성별, 나이 등 다양한 범주가 반영되지 않았다. 여러 범주에 따른 분류를 수행한다면, 후속 연구를 이끌어낼 것으로 예상된다.

Acknowledgments

본 연구는 2020년도 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구(NRF‐2020R1C1C1006007)로서, 관계부처에 감사드립니다.

References

- City/Mobile Phone Subscriber. Korean Statistical Information Service(KOSIS) [Internet]. Available: https://www.index.go.kr/potal/main/EachDtlPageDetail.do?idx_cd=2755, .

-

Lee, So-Hyun and Hee-Woong Kim. "Why people post benevolent and malicious comments online," Communications of the ACM, Vol. 58, No. 11, pp. 74-79, 2015.

[https://doi.org/10.1145/2739042]

- Police statistics. Korean National Police Agency [Internet]. Available: https://www.police.go.kr/www/open/publice/publice0204.jsp, .

- Trends and implications of blocking malicious comments using AI, Information and Communication Planning and Assessment Service. [Internet]. Available: ,https://now.k2base.re.kr/portal/issue/ovseaIssued/view.do?poliIsueId=ISUE_000000000000935&menuNo=200046&pageIndex=

- Myo-Sil Kim and Seung-Shik Kang, “A Design and Implementation of Malicious Web Log Identification System by Using SVM”, A collection of academic presentations by the Society of Information Science and Language Engineering Research, 285-289. 2006.

- HyunJung Kim, YoungMi Yoon, and ByungMun Lee, “Prediction System for Abusive Postings using Enhanced FFP”, The Journal of Korean Institute of Information Technology 9(1), 2011.1, 207-216. 2011.

- S.-J. Bu and S.-B. Cho, "Ensemble techniques of syntax-based CNN and semantic-based LSTM for unethical SNS comment classification," Proc. of Korea Business Intelligence Data Mining Conference, 2017.

- Wonseok Lee, Hyunsang Lee, “Bias & Hate Speech Detection Using Deep Learning: Multi-channel CNN Modeling with Attention,” Korea Institute of information and Communication Engineering, Vol. 24, No. 12, pp.1595-1603, 2020.

- Mikolov T, Chen K, Corrado G, Dean J. “Efficient estimation of word representations in vector space,” arXiv preprint arXiv:13013781, . 2013.

- Mikolov T, Sutskever I, Chen K, Corrado GS, Dean J, editors. “Distributed representations of words and phrases and their compositionality,” Advances in neural information processing systems, 2013.

-

Mikolov T, Karafiát M, Burget L, Černocký J, Khudanpur S, editors. “Recurrent neural network based language model,” Eleventh annual conference of the international speech communication association, 2010.

[https://doi.org/10.21437/Interspeech.2010-343]

-

LeCun Y, Boser B, Denker JS, Henderson D, Howard RE, Hubbard W, et al. “Backpropagation applied to handwritten zip code recognition,” Neural computation, Vol. 1 No. 4, pp. 541-51, 1989.

[https://doi.org/10.1162/neco.1989.1.4.541]

-

Hochreiter S, Schmidhuber J. “Long short-term memory,” Neural computation, Vol. 9, No. 8, pp. 1735-80, 1997.

[https://doi.org/10.1162/neco.1997.9.8.1735]

-

Lange S, Riedmiller M, editors. “Deep auto-encoder neural networks in reinforcement learning,” The 2010 International Joint Conference on Neural Networks (IJCNN), 2010.

[https://doi.org/10.1109/IJCNN.2010.5596468]

- Vaswani, Ashish, et al, "Attention is all you need." arXiv preprint, arXiv:1706.03762, , 2017.

- Korean HateSpeech Dataset, [Internet]. Available: https://github.com/kocohub/korean-hate-speech, .

- Curse Detection Dataset, [Internet]. Available: https://github.com/2runo/Curse-detection-data

- Unstructured Text Dataset for AI Ethics Research, [Internet]. Available: https://aihub.or.kr/keti_data_board/language_intelligence, .

- Chatbot_data, [Internet]. Available: https://github.com/songys/Chatbot_data

-

Kudo, Taku, and John Richardson, "Sentencepiece: A simple and language independent subword tokenizer and detokenizer for neural text processing," arXiv preprint, arXiv:1808.06226, , 2018.

[https://doi.org/10.18653/v1/D18-2012]

-

Yao, Y., Rosasco, L. & Caponnetto, A. “On early stopping in gradient descent learning,” Constructive Approximation, Vol. 26, pp. 289-315, 2007.

[https://doi.org/10.1007/s00365-006-0663-2]

-

Huang G, Liu Z, Van Der Maaten L, Weinberger KQ, editors. “Densely connected convolutional networks,” Proceedings of the IEEE conference on computer vision and pattern recognition, 2017.

[https://doi.org/10.1109/CVPR.2017.243]

저자소개

2021년 : 전남대학교 컴퓨터정보통신공학과 (공학사)

2018년~현 재: 전남대학교 컴퓨터정보통신공학과 학사과정

※관심분야:생명정보학(bioinformatics), 인공지능(artificial intelligence), 빅데이터(bigdata) 등

2012년 : 한국항공대학교 정보통신공학과 (공학석사)

2018년 : 한국과학기술원 바이오및뇌공학과 (공학박사)

2018년~2019년: 국민건강보험공단 빅데이터실 부연구위원

2019년~현 재: 전남대학교 ICT융합시스템공학과 조교수

※관심분야:생명정보학(bioinformatics), 인공지능(artificial intelligence), 빅데이터(bigdata) 등