VR 공간에서의 데이터 글러브를 이용한 효과적인 파지동작 인식 방안

Copyright ⓒ 2021 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

가상공간에서 현실공간에서와 같은 상호작용을 위해서는 물체를 잡는 파지동작이 매우 필수적이다. 특히 사람이 가장 많이 사용하는 손은 많은 관절로 이루어져 있어 다양한 형태로 물체를 파지 할 수 있다. 본 연구에서는 가상현실 공간에서 데이터 글러브의 손가락 관절각 정보를 이용하여 손으로 물체를 잡는 파지동작에 대한 효과적인 인식 방안을 제안한다. 이를 위해 가상현실에서의 파지동작에 의한 문제점 파악하여 다양한 파지동작에 대한 유형을 구분하였다. 또한 손가락의 관절각 정보를 이용한 빠른 파지동작 인식을 위한 수식을 도출하였다. 그리고 프로그램 개발에 의한 검증을 통해 제안된 방식이 다양한 파지동작을 인식하는 것을 확인하였다.

Abstract

In order to interact in a virtual space as in a real space, a gripping motion to hold an object is very essential. In particular, the hands that people use the most are made up of many joints, so they can hold objects in various forms. In this study, we propose an effective recognition method for the gripping motion of a hand holding an object using the finger joint angle information of the data glove in virtual reality space. To this end, the problems caused by the gripping motion in virtual reality were identified and the types of various gripping motions were classified. In addition, an equation for fast gripping motion recognition was derived using the joint angle information of the finger. And it was confirmed that the proposed method recognizes various gripping motions through verification by program development.

Keywords:

Data Gloves, Virtual Reality, Gripping Motion, Wearable Devices, Interaction키워드:

데이터 글러브, 가상현실, 파지동작, 착용기기, 상호작용Ⅰ. 서 론

최근 가상현실(VR ; Virtual Reality)은 게임, 관광, 의료, 군사 등의 다양한 분야에서 주목받고 있으며, 이로 인해 가상현실에 적용할 수 있는 컴퓨터그래픽과 하드웨어가 발전하고 있다. 또한 이를 기반으로 하는 다양한 사실감 있는 가상현실 콘텐츠가 증가되고 있다. 하지만 현실과 동일한 가상환경을 구현하는데 많은 문제점들이 발생하고 있고, 특히 실제 신체 움직임과의 동기화 문제로 인한 몰입도 저하, 멀미 유발, 현실감 저하가 나타나고 있다.

현재 신체 움직임을 가상환경에서 동기화하기 위한 다양한 웨어러블 디바이스(Wearable Devices)가 개발되고 있으며, 그 중에서도 신체 부위 중에서 가장 많은 관절을 갖는 손에 착용하여 사용하는 데이터 글러브(Data Gloves)는 표현 언어 인식, 가상현실, Biometrics, 모션 캡쳐(Motion Capture) 등의 다양한 분야에 인간–컴퓨터 인터페이스(Human-Computer Interface, HCI)로 사용자들의 다양한 요구에 따라 여러 형태로 개발되고 있다[1].

데이터 글러브는 대체로 각 손가락 관절의 움직임을 측정하여 손가락의 위치를 추적하는 방식을 사용하며, 사용하는 측정 센서에 따라 각각의 장·단점이 존재한다. 본 연구에서는 신축성 소재의 센서를 적용한 가요선(Flexible Wire) 방식의 데이터 글러브를 연구에 적용하였다. 본 연구에 적용된 데이터 글러브는 비교적 저비용에, 무게가 가볍고, 센서 간의 간섭을 최소화 할 수 있으며, 손가락의 모양을 실제와 비슷하게 계산을 하는 것이 가능하다. 또한 신축성 있는 부드러운 재질로 구성이 되어있기 때문에 사용자의 움직임을 방해하지 않는 특성을 갖는다. 하지만 사용자마다 손의 크기가 다르기 때문에 사용 전에 교정(Calibration)을 거쳐야하는 단점도 갖고 있다. 데이터 글러브는 각 손가락 관절의 변화량 또는 위치를 계산하는 것이 가능하기 때문에 측정 데이터를 기반으로 움직임에 대한 동작을 어떻게 구분할지에 대한 연구가 중요하다. 데이터와 글러브를 이용한 상호작용 및 관절각 측정을 위한 여러 연구들이 수행되고 있으며, 데이터 글러브의 관절각 측정 방법에 따라 관성측정장치(IMU ; Inertial Measurement Units) 센서 측정치[2]-[4], 가요선(Flexible Wire) 길이 또는 신호 세기 변화[5]-[7], 광학 선형 인코더(OLE ; Optical Linear Encoder)[8] 및 광섬유[9]와 같은 광학 방식, 이미지 마커 인식 방식[10] 등으로 측정된 데이터의 형식이 상이함으로 데이터 글러브에 따른 동작 인식을 연구할 필요가 있다.

본 연구에 적용된 데이터 글러브에서도 동일한 문제가 발생하여 동작 인식을 위한 연구를 수행 하였고, 그 중에 가장 많이 사용되는 동작은 파지동작이었다. 손을 이용한 파지동작에 대한 연구는 특히 로봇 손을 제작하기 위한 로봇 제어 분야 등에서 많은 연구가 진행되었다[11], [12]. 하지만 많은 연구에서 사람의 동작을 통한 소프트웨어에서의 상호작용이 아닌 손의 생김새 자체를 구현하는 방식을 채택함으로써, 다양한 손동작에 따른 상호작용에 대한 방법론이 없는 상황이다. 따라서 단순히 손모양의 추적만이 아닌, 효과적인 동작인식 방안을 연구할 필요성이 있다[13]-[17].

본 연구에서는 이를 토대로 효과적인 데이터 글러브의 손가락 관절각으로 파지동작을 인식하는 방안에 대해 제안한다. 이를 위해, 가상현실 공간에서의 파지동작 인식의 문제점을 제기하고 고려해야하는 제약사항을 제시하고, 데이터 글러브를 이용한 파지동작 인식 적용 방안에 대해 설명한다. 여기서 적용하는 데이터 글러브의 관절 위치를 설명하고, 파지동작의 유형을 분류하여 그에 따른 손가락 관절각을 이용한 파지동작 인식 방안을 설명한다. 그리고 제안한 손가락 관절각을 이용한 파지동작 인식 방안으로 구현한 가상현실 공간에서의 파지동작 인식 방법으로 분류한 파지동작 유형에 대해 모두 만족하는 것을 확인한다.

Ⅱ. 가상현실 공간에서의 파지동작 인식의 문제점

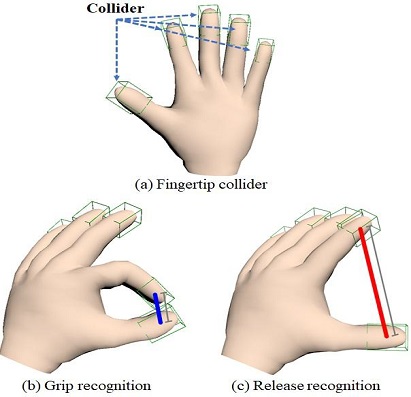

그림 1은 현재 대부분의 가상현실 콘텐츠에 적용되고 있는 파지동작 인식 방법이다. 이 방법은 (a)에서와 같이 손가락 끝에 콜라이더(Collider)를 생성하고 (b) 또는 (c)서와 같이 콜라이더의 두 지점 간의 거리를 이용하여 파지 동작 여부를 인식한다. 매우 단순한 방식 같지만 모든 손가락에 콜라이더를 적용하여 실시간 계산을 수행하게 된다면 상당히 많은 연산량을 요구하게 된다. 또한 손끝에 콜라이더를 적용하게 됨으로써 물체를 손끝으로 맞닿아 잡는 동작이외의 손 전체로 감싸 쥐는 동작들에서는 인식이 되지 않는 경우가 발생할 수 있다[18].

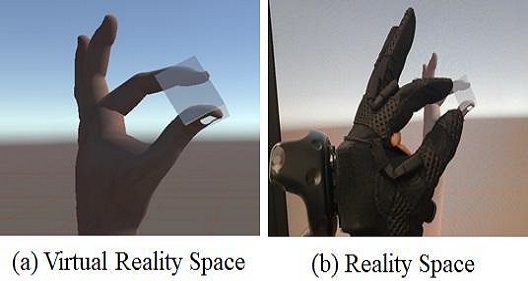

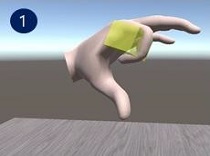

손에 의한 파지동작은 물체를 잡기 위한 동작이다. 하지만 그림 2에서와 같이 본 연구에 적용된 데이터 글러브를 이용한 가상현실 공간에서의 파지동작은 현실 공간에서와 같이 물체를 잡아도 촉감을 느낄 수가 없다. 최근 다양한 데이터 글러브가 출시되어 촉각 및 파지 역감(손가락 강제 제어) 등의 기술로 해당 문제를 해결하려 하지만 고비용, 장비 무게 등의 문제를 갖고 있다[1].

따라서, 가상현실 공간에서의 파지동작 인식을 위해서는 다음과 같은 제약사항을 고려하여야 한다.

우선 손에 파지되는 물체의 무게 및 크기를 고려하지 않는다. 다음으로 물체를 파지하였을 때와 파지하지 않았을 때의 구분이 명확히 되어야 한다. 다음으로 손 크기에 따른 데이터 글러브의 측정 정확성을 유지하기 위해서는 교정이 필요하다. 마지막으로 손바닥 위에 물체를 올려놓는 등의 동작은 파지동작으로 분류할 수 없다.

Ⅲ. 데이터 글러브를 이용한 파지동작 인식 적용 방안

3-1 적용 데이터 글러브의 관절 위치

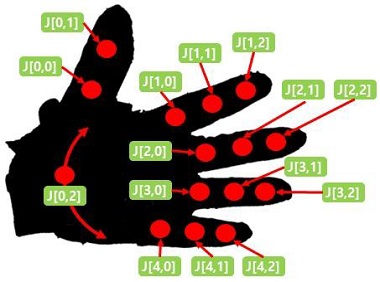

본 연구에 적용된 데이터 글러브는 그림 3과 같은 형태이며, 총 17개의 측정 정보를 이용하여 관절 움직임에 대한 관절각 데이터를 출력한다. 해당 데이터 글러브의 가장 큰 장점은 그림 3에 표시된 2번, 15번, 16번 관절각을 측정할 수 있음으로써 엄지의 끝과 다른 손가락 끝을 맞댈 수 있는 무지대향성(Opposability, 拇指對向性)을 표현할 수 있는 것이다[11].

이는 인간의 손으로 표현할 수 있는 복잡하고 다양한 파지동작을 가상현실 공간에서 표현할 수 있다는 것을 의미한다[19]. 적용된 데이터 글러브에서 총 17개의 관절각 데이터를 출력하지만 본 연구에서 사용되는 파지동작 인식을 위해서는 16번, 17번 관절각을 제외한 15개의 관절각만을 사용한다. 이는 자연스러운 손가락 움직임을 가시화하기 위해서는 16번, 17번 관절각이 필요했지만, 단순히 파지동작을 인식하기 위해서는 두 개의 관절각을 제외한 총 15개의 관절각 정보만으로 충분하기 때문이다.

3-2 파지동작의 유형

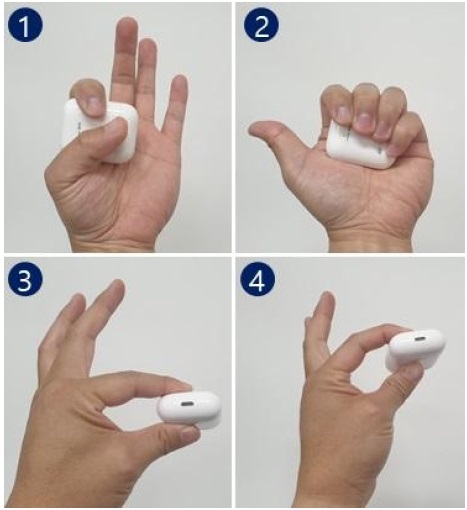

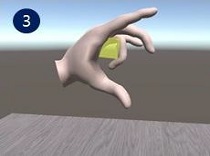

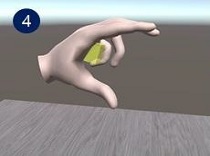

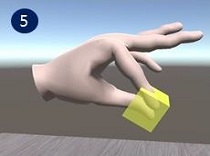

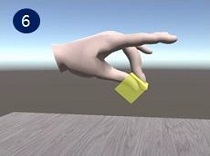

본 연구에서는 그림 4에서와 같이 물체를 잡기 위한 파지 동작의 유형을 다음과 같이 4가지로 분류하였다. 우선 엄지를 사용하는 유형(①, ③, ④)과 엄지를 사용하지 않는 유형(②)으로 분류하였고, 엄지를 사용하는 유형에서도 엄지를 제외한 손가락(검지, 중지, 약지, 소지) 관절 중에 한 개의 관절만을 움직여 파지하는 유형(③)과 한 개의 손가락에 연결된 관절을 모두 움직여 파지하는 유형(④)으로 분류하였다. 이와 같이 분류한 기준은 무지대향성의 표현이 가능한 인간의 손으로 파지 가능한 대표 동작들을 파악한 결과이며, 엄지의 사용 유무에 따라 각 손가락 관절각의 각도 변화에 의해 파지동작의 유형적인 측면에서 물체파지가 가능 것에 기인한다.

3-3 손가락 관절각을 이용한 파지동작 인식 방안

본 연구에 적용된 데이터 글러브의 파지동작을 인식하기 위해 각 손가락의 마디에 해당하는 3개의 관절각을 사용했으며 그림 5에서와 같이 5X3 행렬로 관절각 데이터를 설정하였다.

우선 엄지를 사용하는 유형을 판단하기 위해 식(1)과 같이 정의하였다.

여기서, Tang은 J행렬의 0번째 행의 0에서 3까지 열의 합으로 엄지 관절각들의 합을 나타내며, Tang 값을 이용하여 파지동작을 위한 엄지의 사용 유무를 판단한다. Tang > 45이면 엄지를 사용하는 유형으로 Tang ≤ 45이면 엄지를 사용하지 않는 유형으로 판단한다.

| (1) |

파지 동작 시에 엄지를 사용하는 판단 기준이 되는 45˚의 정의는 다음과 같다. 엄지의 관절각들은 그림 6에서와 같이 일반적으로 손 안쪽으로 각도 변화가 나타나는데 1개의 관절각이라도 최소 45˚가 되어야 나머지 손가락 중에서 엄지와 가장 근접한 첫 번째 손가락인 검지와 만날 수 있기 때문이다.

다음으로 파지동작에 대한 인식 판단은 엄지의 사용 유무에 따라 식(2)와 식(3)을 이용하였다. Tang 가 45˚ 이상으로 엄지를 사용하는 유형인 경우에 식(2)가 성립하거나, Tang가 45˚ 이하로 엄지를 사용하지 않는 유형인 경우에 식(3)이 성립하면 파지동작으로 판단한다. 여기서, Tang 은 엄지 관절들의 합, J는 배열로 설정된 각 손가락의 관절각을 의미한다.

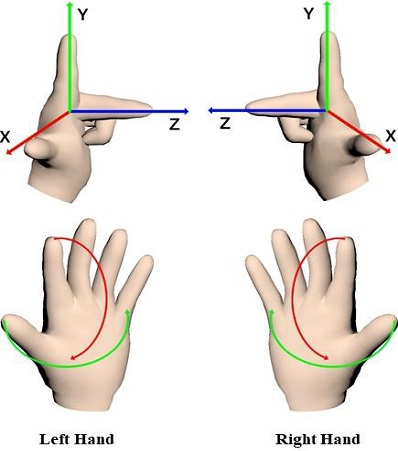

식(2)를 성립하는 판단 기준이 되는 80˚의 정의는 다음과 같다. 데이터 글러브에서 측정 가능한 엄지의 회전 가능 방향은 그림 6에서와 같이 Y축 방향으로 한정하였고 엄지를 제외한 나머지 손가락들의 관절의 회전 방향은 X축 방향으로 회전이 가능하다. 수치적으로 두 방향으로 움직이는 손가락을 교차하기 위해서는 90˚가 필요할 것 같지만 인간의 엄지는 나머지 손가락과 직교 관계가 성립하지 않으므로 시험을 통해 그림 4의 엄지를 사용하는 유형(③, ④)의 파지동작 인식률이 가장 높게 나타나는 수치인 80˚ 적용하였다.

식(3)를 성립하는 판단 기준이 되는 215˚의 정의는 다음과 같다. 엄지를 제외한 손가락을 이용하여 물체를 파지하기 위해서는 나머지 손가락 중 한 개라도 손끝이 손바닥에 근접해야 한다. 엄지를 제외한 손가락들의 마디관절의 회전 값의 합은 수치적으로 225˚이지만 시험을 통해 그림 4의 엄지를 사용하지 않는 유형(②)의 파지동작 인식률이 가장 높게 나타나는 수치인 215˚를 적용하였다.

| (2) |

| (3) |

Ⅳ. 구현 결과

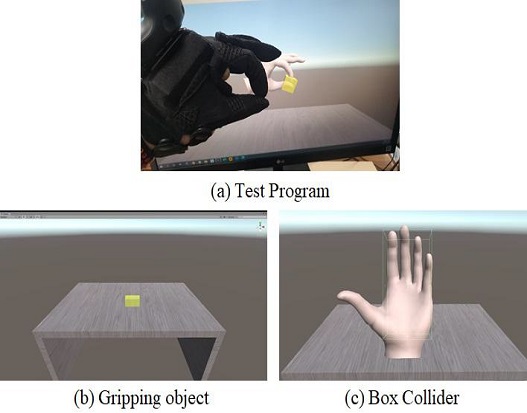

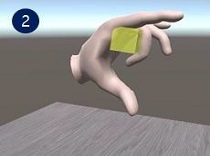

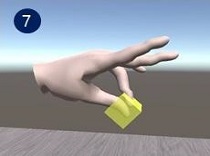

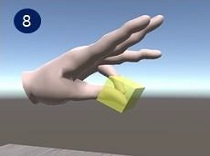

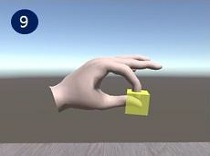

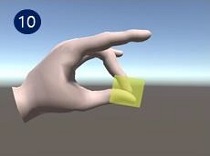

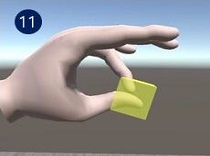

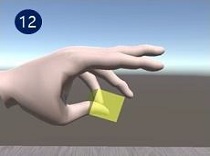

본 연구에서 제안한 손가락 관절각을 이용한 파지동작에 대한 인식 방법을 적용하기 위해 그림 7(a)와 같이 Unity를 이용하여 시험 프로그램을 구현하였으며, 그림 7(b)에서와 같은 물체를 가상현실 공간에서 파지동작 인식에 의한 파지 여부를 판단하였다.

제안된 파지동작 인식 방안에 대한 검증 동작은 총 12개 제시하였다. 이는 본 연구에서 제시한 파지동작의 유형은 총 4개이지만 엄지를 사용하는 3가지 유형에서 그림 4의 ①은 유형 구분을 위한 항목이기 때문에 제외하고 그림 4의 3가지 유형(②, ③, ④)에 대해 파지동작 인식 유형으로 선정하였다. 선정된 3가지 유형별로 엄지를 제외한 4개의 손가락(검지, 중지, 약지, 소지)의 움직임에 의한 파지동작 인식을 검증하였다.

제안된 방식에 의한 파지동작으로 물체를 파지하기 위해 3D 손 모델에 손가락별 충돌처리를 하지 않고 그림 7(c)에서와 같이 손 전체에 충돌 처리를 위한 사각형태의 콜라이더를 설정하였다. 이는 가상현실 공간에서 물체를 파지하기 위한 행동은 손을 움직여 물체에 근접하는 행동 이후에 물체를 파지할 수 있다는 인지 상태에 기인하여 파지동작을 수행하며, 손이 파지하려는 물체에 근접한 상태에서 파지동작 시에 파지동작으로 인식되는 것이 중요함으로 손 전체를 감싸는 한 개의 콜라이더를 적용하였다.

그리고 손동작으로 인해 발생하는 물리적인 상호작용(물체 이동 등)은 파지동작 인식과는 무관함으로 별도의 손과 물체 간의 상호작용을 위한 물리처리가 필요함으로 시험 프로그램 구현 시에 고려하지 않았다.

표 1은 시험 프로그램을 이용하여 본 연구에서 분류한 그림 4에 해당하는 파지동작의 유형별로 본 연구에서 제시한 파지동작 인식 방안을 적용하여 12개 동작에 대해 파지동작을 인식한 결과이다. 이와 같은 결과를 통해 본 연구에서 제안한 파지동작 인식 방안을 적용하여 수행한 12개 파지동작에서 대한 인식이 가능한 것을 확인 할 수 있었다.

Ⅴ. 결 론

본 연구는 가상현실 공간에서 데이터 글러브의 손가락 관절각 정보를 이용하여 손으로 물체를 잡는 파지동작에 대한 효과적인 인식 방안을 제시하였다. 이를 위해 가상현실에서의 파지동작에 의한 문제점 파악을 수행하였고, 다양한 파지동작에 대한 유형을 구분하였다. 이를 토대로 손가락 관절각을 이용한 파지동작 인식을 위한 수식을 도출하였고, 프로그램 개발에 의한 검증을 통해 가상현실 공간에서 제안된 방식이 다양한 파지동작을 인식하는 것을 확인하였다.

향후 본 연구에 적용된 데이터 글러브와 같은 손가락 관절각 정보를 제공하는 웨어러블 디바이스를 사용하는 콘텐츠에 제안된 방안을 적용할 경우에 최소한의 연산량으로 효과적인 파지동작 인식이 가능할 것으로 예상된다.

Acknowledgments

이 논문은 민군기술협력사업(Civil-Miltary Technology Coperation Program)으로 지원 받았음을 명시( 20-SN-GU-04)

References

-

Y.J. Bae, “A Study on Development Trends, Types and Characteristics of Smart Gloves,” Journal of Korea Fashion Design, Vol. 18, No. 1, pp. 157-173, March 2018.

[https://doi.org/10.18652/2018.18.1.10]

-

C. Mummadi, F. Leo, K. Verma, S. Kasireddy, P. Scholl, J. Kempfle, et al., "Real-Time and Embedded Detection of Hand Gestures with an IMU-Based Glove," International Journal of Molecular Sciences, Vol. 5, No. 2, June 2018.

[https://doi.org/10.3390/informatics5020028]

-

B.S. Lin, I.J. Lee, S.Y. Yang, Y.C. Lo, J. Lee, and J.L. Chen, "Design of an Inertial-Sensor-Based Data Glove for Hand Function Evaluation," International Journal of Molecular Sciences, Vol. 18, No. 5, May 2018.

[https://doi.org/10.3390/s18051545]

-

B.S. Lin, I.J. Lee, P.Y. Chiang, S.Y. Huang, and C.W. Peng, "a Modular Data Glove System for Finger and Hand Motion Capture Based on Inertial Sensors," Journal of Medical and Biological Engineering. Vol. 39, pp. 532–540, June 2019.

[https://doi.org/10.1007/s40846-018-0434-6]

-

Y. Park, J. Lee, and J. Bae, "Development of a Wearable Sensing Glove for Measuring the Motion of Fingers Using Linear Potentiometers and Flexible Wires," IEEE Transactions on Industrial Informatics, Vol. 11, No. 1, pp. 198-206, February 2015.

[https://doi.org/10.1109/TII.2014.2381932]

-

S. Lee, Y. Choi, G. Cha, M. Sung, J. Bae, Y. Choi, “Knitted Data Glove System for Finger Motion Classification,” The Journal of Korea Robotics Society, Vol. 15, No.3, pp. 240-247. August 2020.

[https://doi.org/10.7746/jkros.2020.15.3.240]

-

J. Lee, H. Kwon, J. Seo, S. Shin, J. H. Koo, C. Pang, S. Son, J. H. Kim, Y. H, Jang, D. E. Kim, and T. Lee, “Conductive Fiber‐Based Ultrasensitive Textile Pressure Sensor for Wearable Electronics,” Annals of the New York Academy of Sciences, Vol. 27, No. 15, pp. 2433-2439, Feburary 2015.

[https://doi.org/10.1002/adma.201500009]

-

K. Li, I.M. Chen, S.H. Yeo, and C.K. Lim, "Development of finger-motion capturing device based on optical linear encoder", Journal Of Rehabilitation Research And Development, Vol. 48, No. 1, pp. 69-82, January 2011.

[https://doi.org/10.1682/JRRD.2010.02.0013]

-

M. Nishiyama, and K. Watanabe, "Wearable Sensing Glove With Embedded Hetero-Core Fiber-Optic Nerves for Unconstrained Hand Motion Capture," IEEE Transactions on Instrumentation and Measurement, Vol. 58, No. 12, pp. 3995-4000, December 2009.

[https://doi.org/10.1109/TIM.2009.2021640]

-

J.N.A.L. Leijnse, P.M. Quesada, and C. W. Spoor, "Kinematic evaluation of the fingers interphalangeal joints coupling mechanism-variability flexion-extension differences triggers locking swanneck deformities anthropometric correlations," Journal of Biomechanics, Vol. 43, No. 12, pp. 2381-2393, May 2010.

[https://doi.org/10.1016/j.jbiomech.2010.04.021]

- M.S. Yang, Real-time Grasp Motion Planning for Safe Human-Robot Interaction, M.E. dissertation, Hanyang University, Seoul, Feburary 2017.

- H.G. Park, Design and Control of Anthropomorphic Robot Hand with Redundancy Thumb, M.E. dissertation, Sungkyunkwan University, Seoul, Feburary 2013.

-

S. Lee, K. Park, J. Lee, and K. Kim, "User Study of VR Basic Controller and Data Glove as Hand Gesture Inputs in VR Games," 2017 International Symposium on Ubiquitous Virtual Reality, Japan, pp. 1-3, 2017.

[https://doi.org/10.1109/ISUVR.2017.16]

-

K.B. Park, and J.Y. Lee, "Comparative Study on the Interface and Interaction for Manipulating 3D Virtual Objects in a Virtual Reality Environment," International Journal of CAD/CAM, Vol. 21, No. 1, pp. 20-30, March 2016.

[https://doi.org/10.7315/CADCAM.2016.020]

-

B.H. Lee, T. Kim, and D.H. Oh, “3D Virtual Reality Game with Deep Learning-based Hand Gesture Recognition,” Journal of the Korea Computer Graphics Society, Vol. 24, No. 5, pp. 41–48, November 2018.

[https://doi.org/10.15701/kcgs.2018.24.5.41]

- P. Kumar, J. Verma, and S. Prasad, “Hand Data Glove: A Wearable Real-Time Device for Human- Computer Interaction”, International Journal of Advanced Science and Technology, Vol. 43, January 2012.

-

X. Han, X. Miao, X. Chen, G. Jiang, and L. Niu, “Research on finger movement sensing performance of conductive gloves,” Journal of Engineered Fibers and Fabrics, Vol. 14, November 2019.

[https://doi.org/10.1177/1558925019887622]

-

A Masurovsky ,P Chojecki, D Runde, M Lafci, D Przewozny, and M Gaebler, "Controller-Free Hand Tracking for Grab-and-Place Tasks in Immersive Virtual Reality: Design Elements and Their Empirical Study," Multimodal Technologies and Interaction, Vol. 4, No. 91, pp. 1-18, December 2020.

[https://doi.org/10.3390/mti4040091]

- H. Wang, S.U. Hwang, and Y.G. Lee, “Improved Finger Bending Angles Measurements for Accurate Interactions with Virtual Objects,” International Journal of CAD/CAM, Vol. 13, No. 5, pp. 323-333, 2008.

저자소개

2015년 : 한밭대학교 대학원 (공학석사)

2018년 : 한밭대학교 대학원 (공학박사)

2005년~2009년: 아이엠테크놀로지

2009년~2020년: 에이알테크놀로지

2020년~현 재: 유토비즈

※관심분야: 확장현실(eXtended Reality), 소프트웨어공학, 컴퓨터그래픽스, 지리정보시스템(GIS) 등

2007 : 공주대학교 영상예술대학원 공학석사

2016 : 부산외국어대학교 대학원 ICT창의융합 공학박사

2012–2017 : 아이에이치테크 이사

2017–현재 : (주)유토비즈 부사장

※관심분야 : HCI, 빅데이터(Bigdata), ICT, 가상현실, 증강현실, 인터렉티브 등

2018 : 공주대학교 군사과학정보학과 공학박사

2013 : 한남대학교 국방전략대학원 국방무기체계M&S학과 공학석사

1997 : 한남대학교 전자공학과 학사

1998–2002 : 군인공제회 C&C 선임연구원

2003–2017 : M&D정보기술/ARES 개발부 이사

2017–현재 : (주)유토비즈 대표이사

※관심분야 : 국방M&S, 데이터연동, 워-게임, 가상현실, 증강현실 등