증강-가상현실 간 공간정보 및 상호작용 동기화를 이용한 협업 공간 생성

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 각 사용자가 참여하는 증강 현실과 가상 현실 사이를 연결하여 하나의 협업 공간을 생성하였다. 많은 사용자가 자신의 기기를 이용하여 공유된 가상 혹은 증강 공간에 접속하고자 하나, 다양한 증강-가상 기기가 혼재되어 있어 같은 공간에 접속하는 데 문제가 발생한다. 이를 해결하기 위하여 이 논문에서는 사용자의 객체 대상 상호작용을 같은 공간에 함께 접속한 다른 사용자와 동기화하여 같은 상태를 유지하는 공간을 정의하였다. 이것은 접속 초기에 서로의 공간을 일치시키기 위해 공유좌표계를 생성하여 이후 발생되는 모든 객체와 상호작용이 공유좌표계를 기준으로 수행됨으로써 성립된다. 따라서 현 논문에서는 공유좌표계의 설정과 상호작용을 정의하고 네트워크를 통하여 동기화되도록 하였다. 사용자는 캐릭터로 형상화하여 공간에 접속할 수 있고, 온라인에서 객체를 생성하고 공유하며 객체의 조회 및 변경, 환경 시뮬레이션과 같은 다양한 상호작용들을 수행할 수 있다. 또한 3종의 기기에서 4명 이상의 사용자와 함께 협업 공간을 구성함으로써 논문에서 제시한 공간을 검증하였다.

Abstract

This paper introduces the cooperating space that connects users who are participated with their VR (Virtual Reality) devices or AR (Augmented Reality) devices. Any interactions between the object and the user are synchronized in the cooperating space, which makes every user see the same state of the space. When the user enters the cooperating space, a shared frame that represents the origin of the space is used for synchronizing the location of objects and interactions. For communicating between heterogeneous devices such as HoloLens and Moverio, we define the shared frame and the interactions for each device, and the protocols of the network. With the systems that we build, users can create the object and share their interactions, and see the other users as the avatar. For the validation, four users participate in the proposed cooperating space with various devices such as HMD, HoloLens, Moverio.

Keywords:

augment reality, cooperating space, interactions, tele-presense, virtual reality키워드:

증강현실, 협업공간, 상호작용, 텔레프레즌스, 가상현실Ⅰ. 서 론

증강/가상 현실 기기는 가상의 객체를 탐색하고 상호작용하는 직관적인 도구이다. 현재의 증강/가상 현실 기기는 다양화 되어 사용자는 다양한 기기 중 사용하고자 하는 기기를 선택할 수 있게 되었다. 사용자는 모바일 기기, 안경 형태의 광학 투과 기기(Optical see-through) 또는 Oculus Quest와 같이 머리에 착용하는 디스플레이 기기(Head mounted display, HMD)를 이용하여 증강/가상 현실에 참여한다. 이처럼 다양한 기기를 사용하게 되면서 여러 명의 사용자가 한 공간에서 협업할 때 서로 다른 기기를 사용하는 경우가 발생한다. 따라서 다양한 기기가 참여할 수 있는 하나의 공유 공간의 필요성이 대두된다.

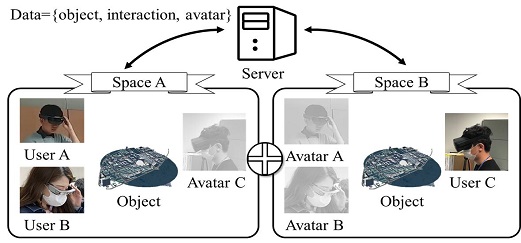

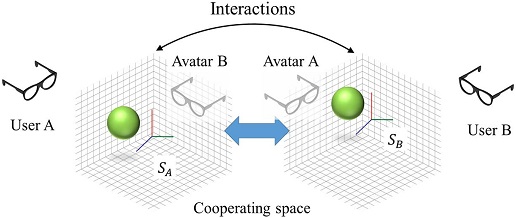

이를 위해 본 연구에서는 다양한 기기를 사용한 여러 명의 사용자가 하나의 공간에서 서로 협업하고 상호작용할 수 있도록 하는 새로운 협업 공간(cooperating space)을 제안한다. (그림 2) 이 협업 공간은 사용자가 생성하는 객체와 상호작용을 일치시켜 각 사용자들이 속한 공간에 무결성을 보장해 주었다. 이는 모든 사용자가 상호작용이 발생한 경우 이 상호작용에 대한 정보를 서로 주고받도록 함으로써 이루어지는데, 이 논문에서는 상호작용이 발생되는 위치를 유지시키기 위하여 공유 좌표계를 도입하였다. 예를 들어, 사용자가 객체를 자신의 좌표계에 증강시키면 각 사용자가 바라보는 공간에도 같은 위치에 증강되도록 해야 한다. 따라서 객체 위치의 기준이 되는 공유 좌표계가 협업 공간을 접속할 때 생성되어 모든 사용자에게 공유되고 이로부터 객체가 증강되는 위치를 계산한다. 각 기기는 기기의 특성에 따라 서로 다른 기준점을 가지게 되는데 주변 환경을 인식할 수 있는 기기는 마커를 기준점으로 하고 카메라나 센서가 없어 주변 환경을 인식하지 못하는 기기는 정의된 기준점을 사용한다. 협업 공간 내에서의 사용자 또한 공유좌표계를 기준으로 위치시킨다. 또한, 이 논문에서 제안하는 공유 좌표계에 공유되는 객체와 상호작용은 실시간성 정도에 따라 각 정보에 중요도를 상정하여 중요도에 따라 다르게 처리되도록 하였다.

다음 장에서는 관련연구를 소개하고, 3장에서는 각 기기의 공간을 통합하는 공간을 구성하는 공유좌표계와를 정의하고, 4장에서는 네트워크의 구성, 객체의 생성과 상호작용을 다룬다. 5장에서는 사용자 실험의 결과를 보이고, 마지막으로 6장은 결론을 다룬다.

Ⅱ. 관련 연구

2-1 증강 및 가상 현실에서의 협업

네트워크와 디스플레이, 이미지 프로세싱 기술의 발전에 의해 실시간으로 가상의 객체에 간섭할 수 있게 되면서 가상 현실 혹은 증강 현실에서 실시간으로 회의를 하거나 공동 작업을 진행할 수 있는 원격 협업 공간을 구성하고자 하는 시도가 계속되고 있다. 이 중 몰입형 가상 현실 협업 시스템은 오랜 시간 연구되어 현재 운영 중인 상업 소프트웨어가 다수 존재한다. MeetinVR이나 Glue, Immersed와 같이 가상 현실 헤드셋과 컨트롤러로 가상 공간에 캐릭터를 형성하여 같은 공간에서 대화하는 것을 목표로 하거나[1, 2, 3], IrisVR과 같이 가상 객체에 대해 상호작용하는 것을 목표로 한다[4]. 이는 가상 공간을 하나의 협업 공간으로 구성하여 만나는 것으로 특별한 제약 없이 사용할 수 있다.

마찬가지로 가상 객체를 현실 공간에 증강하여 협업하는 연구도 계속되어 왔다[5, 6]. 일반적으로 증강 현실 협업이라 불리는 협업은 여러 사용자가 같은 공간에 있고 객체를 증강시키는 면대면(face-to-face) 협업[7, 8, 9]이다. 원격에서 각자의 공간에 증강시키는 원격 협업[10]이 몰입형 가상 현실 협업에 비하여 어플리케이션이 적게 배포되어 있기 때문이다. 증강 현실에는 가상 현실과 달리 물리 공간을 이용할 수 있다는 장점이 있어 증강 현실 협업과 가상 현실 협업을 함께 사용할 수 있다면 각각의 장점을 활용하여 이상적인 협업 공간을 형성할 수 있을 것이다.

2-2 증강-가상 현실 간의 협업 공간

“사무실의 미래”에 대한 유명한 논문에서 서술하듯이 많은 연구자가 미래의 협업 공간은 다양한 플랫폼을 사용하는 여러 사용자의 공유 공간이 될 것이라 예측했다[11]. 그럼에도 다양한 플랫폼을 지원하는 원격 협업 시스템은 거의 없다. 원격지에서 공존감을 지원해야 하는 텔레프레즌스 환경에서 가상 현실과 증강 현실을 혼용하기 쉽지 않기 때문이다. 이 때문에 초기의 멀티 플랫폼 협업 공간은 원격 협업을 지원하지 않고 같은 공간에서 같은 물체에 대한 1인칭 시점만을 변화시키기도 하였다[12, 13].

최근에는 원격 협업에 도움을 주기 위하여 더욱 다양한 요소를 사용한다. 가상 현실 디스플레이를 착용한 전문가의 가상 객체에 대한 제스처를 영상 투과(Video see-through) 증강 현실 디스플레이를 착용한 사용자가 보도록 하여 원격 협업이 가능하도록 하는 연구[15]와 같이 제스처를 공유하기도 한다. 또한 CoVAR[16]은 시각 및 오디오 신호를 통해 협업을 강화하기도 하였다. Mini-Me[17]는 가상 현실 사용자와 증강 현실 사용자가 혼합 현실에서 원격 협업 공간을 구성할 때 시선 방향과 제스처를 효과적으로 관찰 할 수 있도록 가상 현실 사용자 아바타를 축소시키기도 하였다. 그럼에도 불구하고 가상 현실과 증강 현실 사용자가 함께 참여하는 협업은 어려운 상황이다.

이 연구는 가상 현실과 증강 현실을 연결하는 새로운 협동 공간을 제시한다. 다양한 기기를 사용하는 사용자 간의 공유 좌표계를 형성하여 각자의 공간에 형성된 가상 객체에 대한 상호작용을 정의한다. 다수의 사용자의 아바타와 사용자가 일으키는 상호작용을 실시간으로 보면서 협업하는 새로운 시스템은 원격지 사용자 간의 협업의 효율성을 높이고 “사무실의 미래”[11]에 보다 다가가는 기회가 될 것이다.

Ⅲ. 공유 공간 구성

공유 공간에 접속한 여러 대의 증강/가상 현실 기기는 하나의 서버를 통해 정보를 서로 주고받는 서버-클라이언트 형태를 가진다. 이 공유 공간은 그림 2 처럼 다른 공간에 위치한 사용자가 같은 공간에서 같은 상호작용하는 것처럼 느껴지도록 공유 좌표계를 형성하고 상호작용을 동기화 하여 하나의 공간처럼 작용하도록 한다. 또한 협업 공간에 참여한 다른 사용자를 아바타로 형상화하고 움직임을 동기화하여 같이 있는 느낌을 높여주었다.

Configuration of the cooperating space when the physical space that users are participated in is separated. With the shared frame in each space, every object and interaction are synchronized.

3-1 공유 좌표계의 정의

각 사용자는 협업 공간에 접속하였을 때 서버에 구성된 공유 좌표계를 공유 받아 다른 사용자와 공간을 공유한다. 즉, 공유 좌표계는 협업 공간이 구성되도록 사용자의 공간을 일치시켜주는 좌표가 된다. 이 때 사용자가 서버로부터 제공 받는 공유 좌표계는 사용자의 환경에 따라 분류할 수 있다. 사용자가 같은 물리적 공간에 존재하는 지 여부와 증강 현실 기기를 사용할 때 외부 환경을 인식할 수 있는 지 여부에 따라 공유 좌표계를 설정하는 방법이 나뉜다. 이 논문에서는 사용자의 환경을 세 가지 경우로 나누어 각 상황에서의 공유 좌표계 형성 방법을 제시한다.

두 사용자가 외부 환경을 인식할 수 있는 기기를 사용할 때, 같은 물리 공간 내에서 같은 객체를 본다면 그 위치는 동일해야 한다. 이는 동일한 물리적 위치에 공유 좌표계를 형성하여야 함을 의미한다. 이 논문에서는 공유 좌표계를 위치하고자 하는 물리적 공간을 표현하는 특징자(feature descriptor)를 기기 간에 공유함으로써 이를 해결한다. 공간에 처음으로 접속한 기기는 자신이 공유좌표계를 형성한 특징자를 서버에 업로드하고, 이후에 접속하는 기기는 서버에 등록된 특징자를 다운로드하여 특징자가 일치하는 외부 환경을 찾아 공유 좌표계를 설정한다. 예를 들어, 특징자는 다음과 같이 기술될 수 있다.

| (1) |

F는 사용자A의 이미지 IA 로부터 특징자fA 를 추출하는 함수이다. 이 함수는 SIFT[18] 가 될 수 있다. 사용자 B는 자신이 보는 이미지 IB로 구해진 fB와 서버에 등록된 fA를 비교하여 그곳이 같은 곳을 가리키는지 알 수 있다.

| (2) |

함수 G는 특징자 fA 와 fB를 비교하는데 보통 유클리디언 거리(Euclidean distance)를 이용한다. 이를 통해 사용자 B가 같은 물리 공간에 있다면 사용자 A 가 등록한 특징자를 이용해 같은 위치에 공유 좌표계를 설정할 수 있다.

이 연구에서는 외부 환경을 인식할 수 있는 기기로 Microsoft Hololens를 사용하였으므로 환경 인식을 통한 특징자 추출 방법으로 Hololens Toolkit을 이용하였다.

외부 환경을 인식할 수 없는 기기는 외부 환경에 대한 특징자를 정의할 수 없기 때문에 사용자의 접속 위치에 공유 좌표계를 설정한다. 대부분의 기기는 착용한 사용자의 자세를 추적할 수 있도록 하는 장치가 포함되어 있다. 기기가 지원하는 방법에 따라서 관성 측정 센서(inertial measurement unit)나 기기에 내장된 카메라를 통한 외부 움직임 측정(inside-out tracking)하여 기기의 이전 자세 대비 변화를 추적할 수 있다. 따라서 접속 직후 자세에서 공유좌표계를 설정하였다면 기기의 자세 추적 정확도만큼 물리적 공간에 위치할 수 있다. 카메라가 없는 가상 현실 헤드셋을 이용하였을 때는 공유좌표계의 위치를 접속 초기에 바라보고 있는 방향으로 설정하였다. 그 후 기기가 지원하는 자세 추적 기능을 사용하여 공유 좌표계 대비 기기의 자세를 추정하였다. 만약 기기의 외부 환경을 볼 수 있는 카메라를 장착하고 있을 때는 마커(marker)를 이용하여 초기 공유좌표계를 위치하였다.

물리적으로 같은 공간에 존재하지 않는다면 외부 환경을 인식할 수 없는 기기를 사용할 때와 같은 방법이 적용된다. 특징자의 인식이 불가능하며 다른 사용자의 모습이 보이지 않기 때문에 동일한 위치에 공유 좌표계를 형성 할 필요가 없다. 다만 공유 좌표계가 같은 높이에 위치해야 서로의 작업 통일성이 유지될 것이다. 공유 좌표계의 위치를 구면좌표계로 다룬다면 현 사용자의 위치를 원점이라고 한다면 좌표계의 위치는 바라보고 있는 방향과 바닥에서의 높이, 2개로 구성될 수 있다. 바라보고 있는 방향은 기기의 초기 자세에서 구할 수 있지만 바닥에서의 높이는 일정한 값으로 정해주었다. 이 연구에서는 서 있는 사람의 눈 높이로 설정하였고, 이는 앞의 두 가지 경우에서도 동일하게 적용된다. 즉 마커를 해당 높이에 설치하거나 특징자또한 정해진 높이에서 설정되도록 하였다.

다른 공간에서 작업할 때 서로의 몰입감을 높여주기 위해 협업하고 있는 상대방의 모습을 아바타(avatar)를 통해 형상화하는데, 상대방이 사용하는 기기에서 지원하는 정도에 따라 몸 전체(full-body) 자세를 동기화하는 전신 행동 아바타와 공유좌표계 대비 머리의 방향만을 표현해주는 단순형 아바타로 구분할 수 있다.

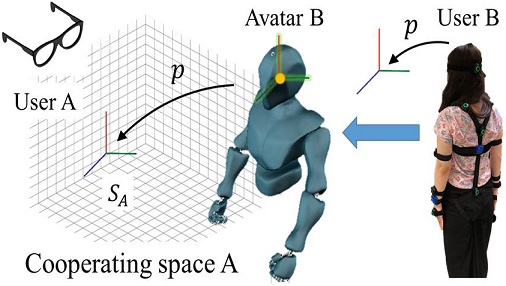

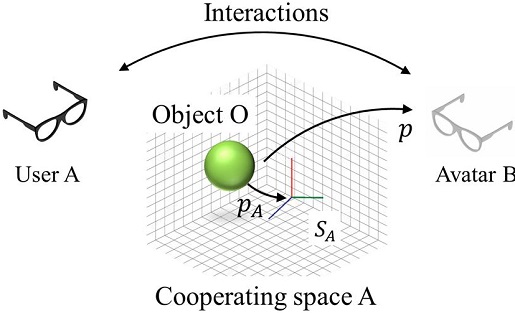

3-2 공유 좌표계의 사용

공유 좌표계가 정의가 되었다면 접속된 기기 간 정보는 이를 기준으로 기술된다. 예를 들어, 사용자 A가 생성한 객체 O는 사용자 B에게 전송되어 공유 좌표계 상의 같은 위치에 생성된다. 이러한 경우에 사용자 A가 생성한 객체O의 위치는 수식(3)과 같이 공유 프레임 SA 에 의해 기술된 값으로 표현된다.

| (3) |

수식에서 p는 생성된 객체의 위치와 회전 값을 나타낸다. SA는 사용자 A의 공간에서 바라본 공유 프레임의 변형 행렬(transformation matrix) 이다. 수식(3)에서 pA 는 생성된 객체 위치 p를 공유 프레임 SA에서 바라보았을 때의 위치가 된다. 이를 네트워크로 사용자 B에게 전달되면 사용자 B의 공유프레임 SB에서 p 만큼 떨어진 값으로 변형한다.

| (4) |

SB 는 SA 와 비슷하게 사용자 B에 설정된 공유좌표계의 변환행렬이다. 그림 3는 수식(3)에 대한 과정이 표현되어 있다.

Describing cooperating space A in Fig 1. There is the shared frame A and the object O at the position pA, and the avatar B of the user B. p that is seen from the shared frame A is transferred to the user B.

Ⅳ. 상호작용 동기화

협업 공간에서의 사용자는 객체를 생성하거나 이동, 변형 하는 등의 상호작용을 수행할 수 있다. 이는 네트워크를 통해 협업 공간에 접속한 다른 사용자와 동기화되어 같은 상황을 공유할 수 있다.

4-1 상호작용 정의

이 논문에서의 상호작용은 객체에 대한 상호작용과 공간 전체에 대한 상호작용으로 구분된다.

객체에 대한 상호작용은 객체를 생성하거나 이동, 변형, 삭제를 수행하는 것이다. 이 연구에서는 도시 모델과 이에 관련한 공간정보를 객체로써 이용하였는데, 여기서 사용자는 원하는 위치를 선택하여 도시 모델을 생성할 수 있고, 생성된 도시 모델의 위치를 이동하거나 크기를 조절하고 삭제할 수 있다. 또한 사용자는 도시 모델에 포함된 건물을 선택하여 건물에 대한 정보를 확인할 수 있다. 이러한 객체에 대한 상호작용 정보는 위치 및 상호작용 종류와 함께 서버를 통해 동기화된다.

이와 달리 공간에 대한 상호작용은 객체 전체에 적용된다. 이 연구에서 정의한 공간에 대한 상호작용은 두 가지이다. 첫 번째로 공간의 시간대를 변경할 수 있다. 사용자가 공간의 시간대를 변경할 시 가상의 태양 위치가 조절되어 도시 모델에 그림자나 석양 효과가 적용되도록 하였다. 또한 기상 효과를 조절하여 비나 눈이 내릴 수 있도록 하였다.

상호작용은 정보의 실시간성 정도에 따라 전송 우선순위를 설정하였다. 예를 들어, 객체의 생성이나 변형과 같은 정보는 일회적이고 빠른 응답을 필요로 하지 않아 우선순위가 낮다. 반면에 아바타의 움직임은 실시간성이 중요한 정보이므로 다른 정보에 비해 높은 중요도로 처리된다.

4-2 아바타

물리적으로 다른 공간에 있는 사용자는 아바타로 형상화해 서로를 볼 수 있다. 아바타는 사용자가 사용하는 기기에 따라 전신 행동 아바타와 단순형 아바타로 나뉜다. 사용자가 전신 행동 캡처 장비를 사용하는 경우에는 전신 행동 아바타가 형성되어 사용자의 행동을 실시간으로 표현한다. 아바타의 생성 위치는 중신 관절의 위치를 기준으로 하며, 기기의 공유 좌표계 대비 중심 관절의 위치를 타 사용자에게 전송하여 아바타를 생성할 수 있다. 또한 협업 공간에서 사용자의 자세와 동작을 실시간으로 아바타를 통해 확인할 수 있어 공존감을 높인다. 전신 행동 캡처 장비를 사용하지 않는 경우 착용하고 있는 증강/가상 현실 기기의 위치를 사용자의 중심 관절, 즉 머리의 움직임에 반영하여 단순형 아바타의 머리 방향을 협업 공간에서 확인할 수 있다.

4-3 네트워크 구성 및 전송

협업 공간의 네트워크는 하나의 서버와 여러 대의 증강/가상 현실 기기들의 연결을 통해 서버-클라이언트 형태로 구성된다. 서버는 사용자별 인식 번호의 부여 및 전달자(Broadcasting) 역할을 수행한다.

사용자가 서버에 처음으로 접속하면 각 사용자는 고유 인식 번호(user ID)를 부여받는다. 인식 번호는 사용자를 구별하기 위해 사용하며 해당 사용자가 일으킨 상호작용 정보와 함께 서버에 업로드 되어 다른 사용자에게 전달된다. 또한 외부 환경의 특징자 또한 서버에 업로드 하여 접속한 다른 사용자가 동일한 외부 환경을 찾아 공유 좌표계를 형성할 수 있게 해준다.

동기화되는 정보는 {인식 번호, 상호작용 정보} 의 형태로 구성된다. 상호작용 정보는 종류를 표현하는 이벤트 값(Event ID)과 추가 정보를 표현하는 인수(Argument value)로 구성되어 있다. 이벤트는 전달하고자 하는 상호작용의 종류의 수만큼 정의 되어 있어 이에 따라 값이 설정된다. 이 연구에서는 객체의 생성 및 변형과 공간에 적용되는 기상 효과 및 아바타의 움직임을 이벤트 값을 설정하여 사용하였다. 표 1에는 이벤트와 그에 대한 인수를 정리하였다.

이 연구에서는 위와 같은 정보를 하나의 메시지로 구성하여 서버를 통해 모든 사용자가 동일한 메시지를 수신하도록 하였다. 각 사용자는 메시지에 포함된 이벤트와 인수를 통해 자신의 협업 공간에 동일하게 표현되도록 함으로써 공간을 동기화한다.

Ⅴ. 실험 및 결과

이 논문에서는 종류가 다른 증강/가상 현실 기기를 착용한 다수의 사용자가 동일한 협업공간에 참여하여 객체를 통한 상호작용을 동기화하는 방법을 보였다. 우리는 실험을 통하여 이 논문에서 제안한 방법을 실제로 사용하고 확인하는 과정을 가졌다. 실험은 3가지 종류의 서로 다른 기기를 가진 4명의 사용자가 협업 공간을 형성하여 상호작용을 수행하는 상황으로 구성하였다. 실험에는 1) 혼합현실(Mixed Reality) 기기인 Microsoft의 HoloLens와 2) 가상 현실 HMD 기기인 삼성 오딧세이, 3) 증강 현실 기기인 EPSON의 Moverio를 사용하였다. 각 기기에서 사용하는 어플리케이션은 Unity를 통해 제작되었으며 카메라를 이용한 마커 탐색으로는 Vuforia 라이브러리를 사용하였다. 사용자의 움직임을 아바타에 반영하기 위한 모션 캡처 장비로 Perception neuron을 사용하였다. 이는 다수의 관성 측정 장비(IMU)로 착용자의 자세를 얻을 수 있으며 측정이 상대적으로 간편하다는 장점이 있다. 이 연구의 결과 영상은 다음 주소에서 확인할 수 있다.

https://github.com/lusina0304/cooperatingspace

5-1 실험시 객체 및 상호작용

실험에 사용할 객체와 상호작용은 사전에 설정하여 어플리케이션을 제작하였다. 생성할 객체는 도시 모델이며 실험 참가자는 자신의 물리 공간 내에 존재하는 탁자 위에 객체를 생성하도록 하였다. 이때 혼합현실 기기는 외부 환경을 인식한 후에 실험자가 선택한 위치로 부터 가장 가까운 탁자위에 객체를 생성한다. 실험 참가자는 전신형 혹은 단순형 아바타로서 협업 공간에 참여하여 생성된 도시 모델에 포함된 건물 중 하나를 선택하고 건물을 변형하는 상호작용을 다른 참가자에게 공유하였다. 또한 시간대를 변경하고 비와 눈 등의 기상효과를 일으키는 공간에 대한 상호작용을 협업 공간에 적용했다.

이 실험은 사용자가 같은 물리 공간 내에서 협업 공간에 참여하는 경우와 다른 물리 공간에서 참여하는 경우를 구분하여 서로 다른 실험 환경을 구성하여 진행되었다.

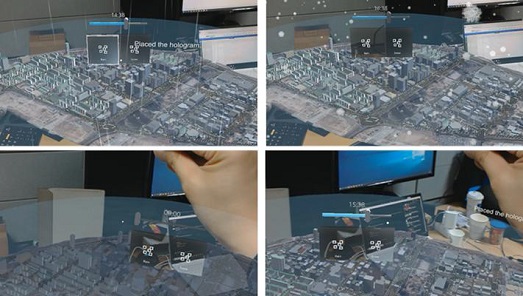

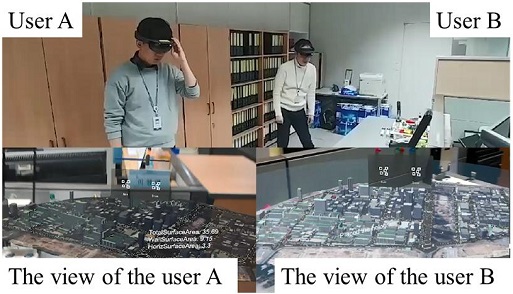

5-2 같은 물리 공간 내에서의 협업 공간

같은 물리 공간 내에서 협업 공간에 참여하는 경우에는 외부 환경을 인식할 수 있는 기기인 Hololens와 Moverio를 사용하여 실험을 진행하였다. 같은 물리 공간에 있는 2명의 참가자는 그림 6와 같이 혼합현실 기기를 착용하고 협업 공간에 접속한 뒤, 객체를 생성하여 상호작용을 진행하였다. 그림 7은 두 명의 참가자가 객체를 생성하거나 건물을 선택하는 등 다양한 상호작용을 수행하였을 때 상태가 동기화되는 것을 보여준다.

The picture of two users who are in the same physical space with interacting in the cooperation space. The bottom pictures show each view of two users.

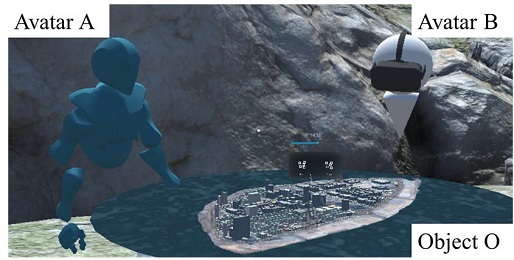

5-3 다른 물리 공간에서 가상 현실 기기를 이용한 협업 공간

다른 물리 공간에서 협업하는 경우에는 3명의 참가자가 서로 분리된 공간에서 각자 가상 현실 기기와 혼한 현실 기기를 이용하여 협업 공간에 접속하는 것으로 실험을 진행하였다. 가상 현실 기기를 통해 접속한 참가자는 각각의 아바타를 통해 협업 공간에 참여한 다른 참가자의 모습을 볼 수 있다. 전신 행동 캡처 장비를 착용한 참가자는 전신 행동 아바타로 표현되며, 그렇지 않은 참가자는 단순형 아바타로 표현되었다. (그림 8) 이 실험에서도 객체를 생성하여 상호작용을 진행하였고 그림 9은 동기화된 상호작용의 모습을 보여준다.

The examples of interactions with the controller in the virtual space. Interactions are synchronized to keep two spaces are remain the same state.

5-4 협업 공간 형성 시의 상호작용 전달

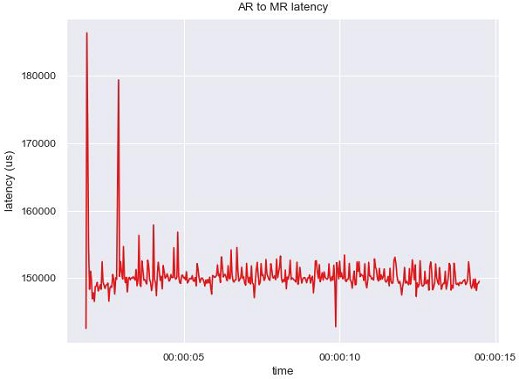

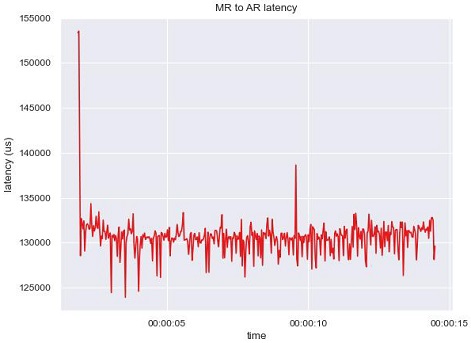

위의 실험을 진행하면서 협업 공간 내 혼합 현실 기기와 증강 현실 기기 간의 상호작용 전달 속도를 측정하였다. 이는 제안한 협업 공간의 실시간성을 보여준다. 전달 속도는 상호작용이 발생하였을 때 타 참가자가 수신하는 데까지 걸리는 지연 속도(latency)로 측정하였다.

그림 10은 증강 현실 기기로부터 혼합 현실 기기로 상호작용이 전달되는 데의 지연 속도를 나타낸다. 이는 증강 현실 기기를 착용한 참가자가 일으킨 상호작용이 서버에 업로드되어 혼합 현실 기기로 전달되는 데까지 걸리는 시간을 의미하며, 평균은 약 0.15초 이다. 이는 그림 10에 나타난 초반 접속 시간을 포함하는 값이다. 마찬가지로 그림 11은 혼합 현실 기기로부터 증강 현실 기기로 상호작용이 전달되는 데까지의 지연 속도를 나타낸다. 지연 속도의 평균은 약 0.13초로 증강 현실 기기로부터 혼합 현실 기기로의 지연 시간 평균과 유사한 값을 가진다.

Ⅵ. 결 론

본 논문은 증강/가상 현실 기기의 다양화에 맞춰 다양한 기기를 사용할 수 있는 협업 공간을 구성하고 제안한다. 이 논문에서 제시하는 협업 공간은 모든 사용자가 생성하는 객체와 상호작용을 동기화시켜 실시간 협업을 진행할 수 있게 해준다. 이를 위해 객체와 상호작용의 위치를 물리 공간 내에서 특정할 수 있도록 하는 공유좌표계를 구성하여 각 사용자에게 공유하고 상호작용이 발생할 시에 상대적인 위치를 계산하여 같은 상호작용이 일어나도록 한다. 이러한 공유 좌표계는 동일 물리 공간 존재 여부와 사용자의 기기에 따라 다르게 생성된다. 또한 사용자의 아바타를 전신 행동 아바타 또는 단순형 아바타로 협업 공간에 생성하여 공존감을 높이고, 상호작용을 할 수 있도록 한다. 이러한 상호작용은 객체에 대한 상호작용과 공간에 대한 상호작용으로 나누었고 각 상호작용이 실시간성에 영향을 주는 정도에 따라 우선순위를 적용하여 네트워크를 구성한다.

이 협업 공간은 다양한 기기를 함께 사용할 수 있도록 함으로써 원격 협업을 보다 용이하게 한다. 즉, 원격 회의 또는 스마트 오피스와 같은 원격 협업 과정에서 기기의 차이에 의한 문제를 예방할 수 있다. 또한 앞으로의 연구에 따라 보다 많은 기기에 적용되도록 할 수 있을 것이다. 스마트폰이나 태블릿 PC 등을 이용하여 협업 공간에 참여할 수 있도록 하거나 물리 공간을 이용한 상호작용을 적용하는 다양한 후속 연구를 진행할 수 있다.

Acknowledgments

본 논문은 국토교통부·산업통상자원부에서 공동 지원하는 ‘공간정보기반 실감형콘텐츠융복합 및 혼합현실제공 기술개발’ 연구의 지원을 받아 작성되었습니다. [과제명: 고정밀 3D 공간정보 기반 유무인 이동체 가상훈련 지원 기술개발 1세부 / 과제고유번호: 20DRMS-B147026-03]

References

- Glue. Universal Collaboration Platform [Internet]. Available: https://glue.work/

- MeetinVR [Internet]. Available: https://www.meetinvr.com/

- Immersed [Internet]. Available: https://immersedvr.com/

- IrisVR [Internet]. Available: https://irisvr.com/

-

Billinghurst, Mark, and Hirokazu Kato., “Collaborative augmented reality,” Communications of the ACM, 45(7), pp. 64–70, 2002.

[https://doi.org/10.1145/514236.514265]

-

Lukosch, Stephan, et al, "Collaboration in augmented reality," Computer Supported Cooperative Work (CSCW) 24.6 , pp. 515-525, 2015.

[https://doi.org/10.1007/s10606-015-9239-0]

- Butz, Andreas, et al, "Enveloping users and computers in a collaborative 3D augmented reality," Proceedings 2nd IEEE and ACM International Workshop on Augmented Reality (IWAR'99), IEEE, 1999.

-

Schmalstieg, Dieter, et al, "The studierstube augmented reality project," Presence: Teleoperators & Virtual Environments 11.1, pp. 33-54, 2002.

[https://doi.org/10.1162/105474602317343640]

- Kato, Hirokazu, et al, "Virtual object manipulation on a table-top AR environment," Proceedings IEEE and ACM International Symposium on Augmented Reality (ISAR 2000). Ieee, pp. 111-119, 2000.

-

Billinghurst, M., and Kato, H, “Collaborative mixed reality,” In Proceedings of the First International Symposium on Mixed Reality, pp. 261-284, March, 1999.

[https://doi.org/10.1007/978-3-642-87512-0_15]

-

Raskar, Ramesh, et al, "The office of the future: A unified approach to image-based modeling and spatially immersive displays," Proceedings of the 25th annual conference on Computer graphics and interactive techniques, 1998.

[https://doi.org/10.1145/280814.280861]

- Kiyokawa, Kiyoshi, Haruo Takemura, and Naokazu Yokoya, "A collaboration support technique by integrating a shared virtual reality and a shared augmented reality," IEEE SMC'99 Conference Proceedings. 1999 IEEE International Conference on Systems, Man, and Cybernetics (Cat. No. 99CH37028), Vol. 6, pp. 48-53, IEEE, 1999.

-

Billinghurst, Mark, Hirokazu Kato, and Ivan Poupyrev, "The MagicBook: a transitional AR interface," Computers & Graphics 25.5, pp. 745-753, 2001.

[https://doi.org/10.1016/S0097-8493(01)00117-0]

-

Beck, S., Kunert, A., Kulik, A., and Froehlich, B., “Immersive group-to-group telepresence,” IEEE Transactions on Visualization and Computer Graphics, 19(4), pp. 616-625, 2013.

[https://doi.org/10.1109/TVCG.2013.33]

-

Le Chénéchal, M., Duval, T., Gouranton, V., Royan, J., and Arnaldi, B.,“Vishnu: virtual immersive support for HelpiNg users an interaction paradigm for collaborative remote guiding in mixed reality,” In 2016 IEEE Third VR International Workshop on Collaborative Virtual Environments (3DCVE), pp. 9-12, IEEE, March, 2016.

[https://doi.org/10.1109/3DCVE.2016.7563559]

-

Piumsomboon, T., Lee, Y., Lee, G., and Billinghurst, M., “CoVAR: a collaborative virtual and augmented reality system for remote collaboration,” In SIGGRAPH Asia 2017 Emerging Technologies, pp. 1-2, 2017.

[https://doi.org/10.1145/3132818.3132822]

-

Piumsomboon, T., Lee, G. A., Hart, J. D., Ens, B., Lindeman, R. W., Thomas, B. H., and Billinghurst, M,. “Mini-me: An adaptive avatar for mixed reality remote collaboration,” In Proceedings of the 2018 CHI conference on human factors in computing systems, pp. 1-13, April, 2018.

[https://doi.org/10.1145/3173574.3173620]

-

David G. Lowe, “Distinctive image features from scale-invariant keypoints,” International Journal of Computer Vision, 60, 2, pp. 91-110, 2004

[https://doi.org/10.1023/B:VISI.0000029664.99615.94]

저자소개

2013년 : 광주과학기술원 (공학석사)

2019년 : 한국과학기술원 (공학박사)

2019년~현 재: 한국전자기술연구원 선임연구원

※관심분야:캐릭터 애니메이션, 증강/가상 현실

2001년 : 세종대학교 대학원 (공학석사)

2001년~현 재: 한국전자기술연구원 책임연구원

※관심분야:증강/가상 현실, 가상훈련, 시뮬레이션

2019년 : 한국과학기술원 (공학석사)

2020년~현 재: 한국전자기술연구원 연구원

※관심분야:증강/가상 현실, 텔레프레즌스