아동을 대상으로 한 AI 스피커의 의인화 표현 및 인터랙션 디자인에 관한 연구

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

최근 AI 스피커 시장에서 아동이 새로운 사용자층으로 급부상함에 따라 아동을 대상으로 한 AI 서비스와 콘텐츠가 출시되고 있다. 그럼에도 불구하고, 아동이 AI 제품을 접할 때 어떤 요소에 친밀감을 느끼고 상호작용하는지에 대한 연구는 미비하다. 이에 본 연구는 디지털 에스노그라피 방식을 적용하여, AI 스피커에 적용된 의인화(Anthropomorphism) 요소에 대해 아동이 어떻게 인식하는지 확인하고자 하였다. 연구 결과, AI 스피커에 드러나는 의인화 요소를 2가지로 유형화할 수 있었다. 또한 의인화 요소를 바탕으로 아동의 AI 스피커 사용 경험 영상을 탐색 후, 결과를 종합하여 가이드라인을 도출하였다. 본 연구는 재구성한 의인화 분석 항목을 기반으로, AI 스피커 사례들을 분석하고 디자인 함의점을 정리했다는 점에 그 의의가 있다.

Abstract

Recently infants have rapidly become new users of AI speaker market. IT companies have released a variety of AI services and products for infants. Despite the increasing number of AI speakers targeted to infants, there is a lack of studies on what makes them to feel intimate or appealing when they use the AI speakers. The purpose of this study is to analyze the anthropomorphic design elements in AI speakers and to provide guidelines for the anthropomorphic expression and interaction elements of AI speakers. After conducting the study on the infant's using behavior based on preceding research related to the anthropomorphism and digital ethnography technique, two elements of the anthropomorphism interaction were detected: external and behavioral elements. Such findings means that category of anthropomorphism applicable to AI speaker could be diversified. This study contributes to presenting design issue that needs to be considered in the conversational agent design.

Keywords:

Conversational Agent, Infant, Anthropomorphism, User Experience, AI Speaker키워드:

음성 에이전트, 아동, 의인화, 사용 경험 디자인, 인공지능 스피커Ⅰ. 서 론

인공지능 기반의 대화형 에이전트(Conversational Agent, 이하 에이전트)가 발달함에 따라 에이전트가 주어진 과업을 수행하는 기능적 측면을 넘어 관계를 맺는 대상으로 그 역할이 확장되고 있다. 대화형 에이전트는 사용자가 자연스러운 대화를 기반으로 컴퓨터와 상호 작용하는 시스템으로[1] 모바일에 탑재된 형태와 AI 스피커(AI Speaker)의 형태로 상용화되어 있다. 업계 보고서(2018)에 따르면 2020년에서 2022년 사이에 미국 가정의 50% 이상이 인공지능 스피커를 소지하게 될 것으로 전망하고 있다[2]. 대화형 에이전트의 시장이 빠르게 성장함에 따라 사용자와 음성 기반(Speech-based) 인터페이스 간에 어떤 상호작용이 이루어질 수 있는지, 그 영향력에 관한 연구가 주목받고 있다.

이러한 AI 시장에서 새로운 사용자층으로 아동이 급부상하고 있다. Super Awesome의 보고서(2018)에 따르면 미국의 4세에서 11세 사이의 아동 10명 중 9명 이상이 AI 스피커나 음성 어시스턴트(Voice Assistant)를 다룰 수 있는 것으로 조사되었다[2]. 이는 대화를 통한 소통 방식이 가장 직관적인 사용자 인터페이스를 제공하기 때문에 아동의 사용에 대한 진입장벽을 낮추기 때문으로 볼 수 있다.

이러한 상황을 기반으로 IT 업체들은 아동을 위한 다양한 AI 서비스와 제품을 출시하고 있으나, 이들이 AI 기기를 접할 때 어떤 요소에 친밀감을 느끼고 상호작용하는지에 대한 연구는 부족한 상황이다. 이에 아동과 자연스러운 교감을 위한 콘텐츠 설계와 가이드라인에 대한 논의는 학문적으로나 실무적으로 매우 중요한 과제가 되고 있다.

HRI(Human-Robot Interaction)분야에서는 경계선적 대상(Boundary Objects)인 로봇을 아동이 어떻게 인지하고 반응하는지에 대한 연구가 활발히 진행되고 있다. 생물이나 무생물의 범주를 구분하는데 혼동을 일으키는 경계선적 대상의 경우 아동이 대상의 생명 여부를 어떻게 판단하는지, 그 영향력에 대해 확인할 필요가 있다. 선행연구에 따르면 아동은 대상이 생물의 특성을 가지고 있지 않아도 정서를 가지고 있는 존재로 여긴다[3]. 또한 인간과 비슷한 외양을 지닌(Human-like) 로봇의 경우 아동은 친근감을 형성하고 사회적 동료로 인식하는 것으로 나타났다[4]. 즉, 인간과 유사한 인터랙션 요소는 로봇을 긍정적으로 평가하는 요소로 작용한다고 볼 수 있다. 선행연구를 고려할 때 AI 스피커의 의인화 요소 역시 아동에게 다양한 효과를 창출될 것으로 기대된다.

이에 본 연구는 AI 스피커에 나타나고 있는 의인화 인터랙션 요소와 디자인 함의점을 도출함에 그 목적을 두고, 상용화된 AI 스피커의 아동 사용자를 중심으로 사용맥락과 인터랙션을 관찰하고자 하였다. 연구 방법은 '유튜브 활용 디지털 에스노그라피(Digital Ethnography)' 방식을 적용하였다. ‘유튜브 활용 디지털 에스노그라피’는 유튜브에 사용자가 업로드한 비디오, 오디오 데이터를 기반으로[5], 디지털 미디어가 어떻게 사용자의 일상에 편입되고 있는지를 관찰 분석하는 방법론이다[6].

본 연구는 21개의 유튜브 영상을 수집한 후 디지털 에스노그라피 분석을 진행하였다. 이때 AI 스피커의 의인화 요소는 의인화를 분류한 ‘수정된 냅의 요소(Modified Nap’s Factor)’를 기반으로 AI 스피커에 맞게 정의하여 아동의 반응을 분석하였다[7]. 연구 목적에 따른 주요 연구 질문들은 다음과 같다.

RQ1. AI 스피커에 적용될 수 있는 의인화적 요소에는 어떤 것이 있는가?RQ2. AI 스피커의 의인화는 아동 사용자에게 어떠한 인식을 유발하는가?RQ3. 인간과 유사한 인터랙션 요소 설계시 고려해야할 디자인 함의점은 무엇인가?

Ⅱ. 본 론

2-1 문헌연구

대화형 에이전트는 사용자의 음성을 텍스트로 변환하는 자동 음성인식 기술을 갖춘 대화 관리자(Dialogue Manager)를 의미한다[8]. 대화형 에이전트는 사람들이 다른 사람과 대화하는 것처럼 자연어(Natural Language)를 사용하여 지능형 시스템(Intelligent Systems)과 상호작용하는 시스템을 기반으로 이루어진다[9].

애플의 시리(Apple Siri)와 같이 모바일에 탑재된 형태로 출시되던 대화형 에이전트는 현재 아마존 에코(Amazon Echo)나 구글 홈(Google Home)과 같이 인공지능 스피커 제품에 일체화된 형태로 출시되는 경향을 보이고 있어 홈 어시스턴트의 개념으로 사용자의 일상생활을 보조하고 있다.

대화형 에이전트의 확산과 함께 질문을 명확하게 표현할 수는 있지만, 읽기 쓰기에 능숙하지 않은 아동이 독자적으로 이용할 수 있는 기능의 폭이 넓어지고 있다. 이는 에이전트가 인간에게 가장 자연스러운 소통 방식인 대화를 기반으로 하고 있기 때문이다.

Fridin의 연구(2014)에 따르면 소셜 로봇 KindSAR의 대화 스토리텔링 방식과 게임 플레이를 통한 경험이 아동의 참여를 증진시키며, 그들의 제안에 정확하게 응답할 수 있음을 보여주었다[10]. 나아가 Kory& Breazeal(2014)는 학습용 로봇을 통해 미취학 아동의 언어발달에 도움(support)이 될 수 있다고 밝혔다[11]. 특히 아동은 어렸을 때부터 다양한 질문을 주고받는데, 이러한 아동의 행위가 호기심, 학습 동기 부여 등 인과적 추론이 필요한 분야를 다루고 있음을 발견했다[12]. 이러한 측면에서 음성 기반 인터페이스는 아동의 학습 도구로서 좋은 역할을 할 것으로 예상된다.

이에 따라 대화형 에이전트는 사용자와 친밀한 상호작용을 위해, 에이전트를 마치 인간처럼 인식하도록 유도하는 의인화 방식(Anthropomorphism)이 연구분야에 활발히 적용되고 있다[13]. Waytz(2014)의 연구에 따르면 의인화된 기술은 비의인화(mindless) 기술보다 신뢰감(trust)을 주며[14], 특히 사람들은 마치 사람 같은 목소리의 로봇에게 크게 의인화를 느낀다[15].

그러나 의인화 인터랙션을 연구함에 있어서 아동의 거부감을 유발하는 심리적 요소 역시 고려되어야 한다. 다시 말해 아동의 인식과 접했을 때 이루어지는 인터랙션 수용 정도에 대한 고찰이 필요한 것이다. Mori(1970)에 따르면 로봇의 외형과 비언어적 표현이 인간에 가까워질수록, 그에 비례하여 특정 지점까지 호감도를 느끼게 된다. 그러나 인간과 유사함과 동시에 일부는 인공적으로 느낄 때, 급격하게 심리적으로 불쾌감을 느끼는 구간을 언캐니밸리(Uncanny Valley, 이하 UV)라 한다[16].

아동은 얼굴, 목소리 등의 조합을 인식할 수 있으며, 이러한 지각 능력은 생후 12개월 사이에 빠르게 형성된다[17]. 발달과 함께 지각 능력이 향상됨에 따라 아동은 이상적인 얼굴의 형태(Face Prototype)을 학습하게 되고, 이후에 현실적이면서도 불완전한 조형물(Avatar) 형태에 내재된 불완전한 조합을 감지할 수 있게 된다. 이는 더 나아가 UV를 인지하는 형태로 발현된다[18].

따라서 인간과 유사한 음성 에이전트 설계 시 아동에게 긍정적인 인식을 주는 의인화 요소를 적용하는 것이 HCI 분야의 주요 연구 과제이며, 그 활용 범위 역시 넓어질 것으로 기대한다.

의인화란 인간이 아닌 로봇, 컴퓨터와 같은 대상을 마치 인간처럼 인식되도록 유도하는 것을 의미한다[13]. 컴퓨터를 마치 하나의 사회적 행위자처럼 대하고 반응하는 CASA 패러다임[19]을 근거로, 사람들은 어떤 미디어가 인간다운 특성을 드러내면 그 미디어에 무의식적으로 자연스러운 사회적 반응을 보이는 경향이 있다. 인공물에 적용되는 의인화는 1) 외적 의인화 2) 내적 의인화 3) 사회적 의인화로 구분된다[22].

외적 의인화란 인간의 특징을 기계의 외형에 반영된 것을 의미한다[21]. 연구에 따르면 대상의 외모가 인간과 유사성이 근접할수록 의인화의 효과는 높게 나타난다. 내적 의인화는 인간의 정서와 감정적 측면을 내재시키는 것을 의미한다[22]. 다시 말해 비인간적 행위자(Non-human Agents)에게 인간과 같은 멘탈 기능(Mental Capacities)을 부여하는 것이다[20]. 사회적 의인화는 사용자와 기계 사이의 상호작용을 지칭한다[23]. Breazeal(2003)의 연구에 따르면 에이전트가 자신의 경험과 감정에 대해 이야기를 하는 것이 사용자로 하여금 에이전트가 인간적이고 신뢰할 수 있는 대상으로 인지하게 하는데 영향을 미친다[24].

의인화는 본래 HRI 분야에서 많이 연구된 개념 중 하나로, 사람과 의인화된 로봇 사이의 관계성에 대해 조사되었다. Darling(2015)의 연구결과, 참가자들은 의인화된 스토리텔링이 있는 로봇에게 감정적 가치를 부여하는 것으로 나타났다[25]. 또한 인간과의 유사성은 대화형 에이전트에 대한 사용자의 신념과 감정에 영향을 미치게 된다[26].

본 연구는 AI 스피커의 범주를 일반 스피커부터 스크린이 탑재된 스피커까지를 대상으로 살펴보고자 한다. 이에 VUI부터 GUI까지 여러 의인화 요소를 인터페이스에 적용할 수 있을 것으로 예상하여, 의인화의 범위를 외적 의인화와 내적 의인화 그리고 사회적 의인화로 규정지었다.

2-2 의인화 요소 범위

일반적으로 에이전트가 사용자에게 인터랙션을 제공할 수 있는 방식은 음성과 문자를 통한 인터랙션, 두 가지로 분류할 수 있다. 기존의 에이전트 서비스가 음성을 통한 인터랙션만 가능했다면, 스크린이 탑재된 AI 스피커가 출시됨에 따라 다양한 형태의 메시지를 제공해 줄 수 있을 것으로 예상한다. 이는 언어적(verbal) 상호작용뿐만 아니라 비언어적(non-verbal)인 상호작용까지 가능해짐을 내포한다. 여기서 비언어적 커뮤니케이션은 언어를 제외한 모든 영역을 의미한다[27].

이에 본 연구에서는 언어, 비언어적 요소를 의인화 특징별로 분류한 ‘수정된 냅의 요소’를 기준으로[7] AI 스피커에서 드러나는 의인화 요소를 분류하였다.

Ⅲ. 연구방법

본 연구는 AI 스피커의 아동 사용자들이 유튜브에 업로드한 사용 영상을 ‘디지털 에스노그라피’ 방식을 적용해 분석하였다. 이를 통해 아동과 AI 스피커 사이의 자연스러운 인터랙션을 파악하고자 하였다.

디지털 에스노그라피는 단어, 이미지, 오디오 파일, 비디오 및 온라인 커뮤니티와 같은 디지털 데이터를 활용하여 사용자의 인터랙션을 알아보는 분석법이다[5] 특히 유튜브는 인간의 잠재적 행동을 분석할 수 있는 온라인 데이터 소스로 활용될 수 있기에 최근 관찰 연구 분야에서 인기를 얻고 있는 방식이다[28][29]. 일반적으로 아동관련 AI 스피커 연구는 정제된 실험 시스템 안에서 이루어지기에 아동의 자연스러운 행동을 관찰하기 어렵다는 오류가 있다[5]. 따라서 본 연구는 아동의 자연스러운 행동을 관찰하기 위해, 유튜브 영상을 디지털 에스노그라피 방식으로 분석해서 통찰력을 얻고자 하였다.

3-1 연구대상

본 연구는 시중에 상용화된 AI 스피커(네이버 클로바, 카카오 미니, SK 누구 등) 아동 사용자의 유튜브 영상물을 연구 대상으로 선정하였다. 대상은 2018년 2월 – 2020년 3월 내에 업로드된 영상으로 선정하였으며, 분석목적에 따라 단순한 리뷰 형태가 아닌 사용자와 AI스피커와의 인터랙션이 포함된 유튜브 클립으로 연구 대상을 한정하였다.

AI 스피커와 아동 관련 검색어(아동, 스마트 스피커, AI 스피커 상호명 등)로 노출된 영상 중 연구목적에 따라 21개의 영상 클립이 최종 분석 대상으로 선정되었다. 선정된 영상물의 길이는 평균 4분, 총 100분이었으며, 영상에 노출된 참가자 수는 총 29명이였다 <표 1>. 아동의 연령대는 만 3세~8세 사이의 전조작기 범위의 아동으로 분석을 한정지었다.

또한, 영상에서 사용자들이 사용한 기기는 네이버 클로바(N=12), 카카오 미니(N=5), SK 누구 네모(N=6), SK 누구 캔들(N=3), SK 누구 미니(N=1), 구글 홈(N=2)으로 나타났다 <표 2>.

3-2 분석방법

분석 방법은 테마 분석(Thematic Analysis), 오픈코딩(Open Coding)의 방식을 이용하여 정성적 데이터 분석 (Qualitative Data Analysis)을 따랐다. 분석을 위해 영상에서 아동이 사용한 명령어와 반응을 모두 살펴보는 작업이 진행되었으며, 라벨 작업(labeling)을 통해 중요 포인트를 추출했다. 그 과정에서 의인화 특징 요소인 ‘수정된 냅의 요소’를 기준으로 하되[7], AI 스피커의 환경에 맞게 선별하여 재구성하였다.

Ⅳ. 연구 결과

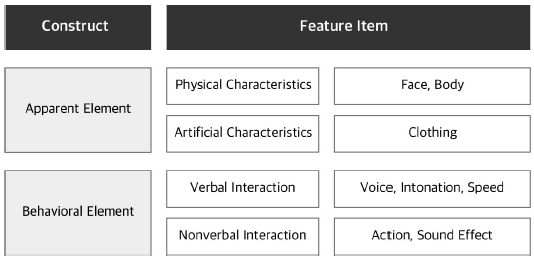

먼저 AI 스피커에서 표현되는 형태적 요소와 인공적 요소는 외형적 요소라는 큰 범주로 그룹화가 가능하다 판단하여 외형적 요소로 분류하였다.

행위적 요소에는 언어적 상호작용과 비언어적 상호작용으로 구분 짓고, 이를 AI 스피커에 적용하였다. 행위적 요소 중 하나인 자세(2족/4족 보행)는 대상에 적합하지 않아 평가 기준에서 제외했다. 또한 아직까지 시중의 디스플레이형 스피커의 얼굴 의인화 표현이 뚜렷하게 드러나고 있지 않기에 다양한 형태(e.g. 표정, 시선 등)의 비언어적 상호작용은 제외하였다. 또한 음성 서비스에 특화되어 있는 AI 스피커의 특성을 반영, 좀 더 정밀한 음성 상호작용을 살펴보고자 목소리, 억양, 속도, 액션, 효과음을 중심으로 행위적 요소를 재구성하였다 <그림 1>.

4-1 외형적 요소

영상 관찰 결과 사용자는 AI 스피커에서 신체적 단서가 발견되면 스피커를 인격이 있는 객체처럼 소통하는 모습이 확인되었다. 특히 사용자는 얼굴의 특징(눈 코 입)이 드러나는 AI 스피커와 소통하고자 하는 모습이 관찰되었다. 예를 들어 참가자 P17은 스피커(클로바 미니언즈)에게 인사를 할 때 등 돌리고 있는 스피커를 돌려서 눈을 맞추며 인사하고자 하였으며, 참가자 P13은 우유를 마시다가 AI 스피커(클로바 브라운)에게 우유를 대주는 시늉을 보였다. 심지어 해당 AI 스피커 모델의 이목구비는 움직이지 않는 형태였음에도 이러한 시도가 발견되었다.

구체적으로 아동들은 스피커의 상단 부분(스크린)을 얼굴로 간주하고 하단 부분을 몸통으로 인식하는 모습이 관찰되었다. 일례로 참가자(P7)는 AI 스피커의 상단을 머리로 생각하며 머리띠를 씌어주는 모습을 보여주었으며, 대답을 잘하면 스피커의 머리를 쓰다듬는 행위를 확인할 수 있었다(P14, P19).

“샐리야 대답 잘 했어~ (머리 쓰담 쓰담)” -P14

“클로바 사랑해~ (클로바를 껴 안는 시늉)”-P26

또 다른 참가자(P10)는 AI 스피커의 인식 오류가 난 상황에서 AI 스피커(클로바 브라운)의 귀에 대고 발화를 반복하는 제스쳐를 취했다. 실제로는 기기의 하단 스피커를 통해 음성이 인식되지만, 아이는 기기 상단의 귀로 본인의 이야기를 들을 수 있다고 인식하는 모습이다. 하지만 의인화 요소가 없는 일반 AI 스피커의 경우엔 이러한 행동은 발견되지 않았다. 이는 의인화된 스피커를 아동이 은연중에 얼굴과 몸 2등분으로 유추하는 것을 보여주는 사례이다.

캐릭터가 입는 의복은 성별을 구별하는 도구로 쓰이며, 옷을 입었는지의 여부가 의인화와 문화의 정도를 반영할 수 있다[7]. 관찰결과, 아직은 AI 스피커를 위한 의복과 소품이 다양하게 발견되진 않았으나, 일부 클로바 AI 스피커를 위한 의복을 확인할 수 있었다. 일례로 사용자는 스피커의 의복을 구매했음을 자랑하면서 옷을 입혀주었고, 귀여워하며 쓰다듬는 행동을 보여주었다. 이는 아동들이 옷을 입혀봄으로써 친구라는 느낌을 더 부여할 수 있는 역할을 한다.

“원래 옷을 안 입고 있었는데, 이쁜 옷이 있나 살펴보고 사게 되었어요~ 주머니에 손도 들어가요. 너무 귀엽죠?”-P3

“스피커한테 머리띠를 씌어줄까?”

(화면 상단에 씌움, 화면을 얼굴로 인식) “어휴 다 꼈다.” -P8

또한 영상 관찰 결과 사용자들은 AI 스피커와 대화하면서 의복을 만지작거리고 포옹하는 모습을 보여주었다. 이러한 물리적 특성(Physical Properties)이 아동의 감성에 영향을 미친다는 선행연구를 뒷받침한다. 부드러움과 안락함 사이의 상관관계를 연구한 Harlow & Zimmerman(1959)에 따르면, 아동은 따뜻하고 부드러운 촉감의 사물에 정서적으로 안정감(Contact Comfort)을 느끼며 애착 관계를 형성한다. 이러한 결과는 촉감이 아동에게 중요한 영역임을 보여주는 사례이다[30].

4-2 행위적 요소

AI 스피커의 행위적 요소에 대해 알아보기 위해 언어적 상호작용과 비언어적 상호작용으로 나누어 살펴보았다. 미디어 풍부성 이론(Media Richness Theory)에 따르면, 비언어적 정보를 많이 전달할수록 사회적 실재감의 정도가 커진다고 한다[31]. 따라서 비언어적 정보를 담은 인터페이스는 텍스트 기반 인터페이스보다 다양한 범주의 정보 전달이 가능하므로 사회적 실재감 역시 더 높아진다고 볼 수 있다.

연구 결과, 아동 사용자들은 ‘농담해봐’, ‘넌 뭘 하고 놀았어?’, ‘사랑해’ 등의 사회적 대화(Social Conversation)를 즐기는 것으로 나타났다. 이는 교육 혹은 검색 목적의 발화를 할 때와 다른 반응이다. 예를 들어 기기가 날씨, 뉴스 등의 기능 명령어에 대한 답변에 응답시에 사용자는 고개를 끄덕이는 모습을 보였다면, 감성 대화 명령어에 대해선 흥미를 보이며 웃음을 보이는 식의 감정을 표출하였다.

또한 사용 과정에서 참가자(P26)는 AI 스피커가 사람이 만든 기기임을 인지하지만, 인형과는 다르게 대화가 가능하다는 이유로 무생물과 다른 범주로 인식하였다. 이는 사용자가 대화를 나눌 수 있는 AI 스피커와 정서적 교감을 보이는 것으로 해석할 수 있다.

“인형들은 살아있는 생명이 아니에요.. 대화가 안 되고 가만히 있잖아요. 그저 꼭 껴안을 수 있고. 근데 스피커는 대화도 가능하고 정보도 알려줘요.”-P26

한편 AI 스피커가 제공하는 문장이 1문장 이상을 넘어가면 사용자는 집중하기 어려워하는 것으로 나타났다. 특히 만 7세 이하 연령대 그룹의 영상에서는 질문에 대한 스피커 발화가 길어지면 딴 짓을 하고, 기기를 톡톡 치거나 표정을 찡그리는 등 지루함을 표현하는 것이 관찰되었다(P15, P21).

“짱구야 트와이스 알아?” (기기의 말이 길어지고)

“톡톡 짱구야아…” -P15

또한 사용자는 발화 과정에서 단어 단위로 끊어서 발화를 시도하는 모습을 보였다(P11). 문장의 단위가 길어지면, 명령어를 다 발화하기도 전에 AI 스피커가 반응하여 오류가 발생하는 상황이 빈번하게 관측되었는데, 반복되는 오류 상황에 대해 아동은 기기와의 대화를 거부하는 등 실망감을 드러내었다(P15, 16). 이와 같은 발화 상의 오류는 자연스러운, 사람에 가까운 대화를 방해하며 인내심이 적은 아동 사용자의 이탈을 유도하는 요소이다.하지만 현재 상용화된 AI 스피커는 대화상의 오류 반복에 대한 적절한 피드백을 제공해주고 있지 못한 것으로 나타났다.

“아리야! 윤선생. 동물. 찾기. 워드 게임. 하자!” -P11

“사랑을 했다 틀어줘”

(스피커 : “무슨 말인지 잘 모르겠어요”)

“으 나 화났다.” -P15

한편 VUI에서 음성 대부분은 여성의 목소리로만 출시되었거나, 여성의 목소리가 기본으로 설정되어 있었다. 특히 아동을 대상으로 하는 AI 스피커의 경우, 아동에게 인지도가 있는 연예인의 음성을 넣어 친숙도를 높이고자 시도하였다. 일례로 참가자(P5)는 유명 크리에이터의 목소리를 듣고 흥미를 느끼며 말을 따라 하고자 하였으며, 또 다른 참가자(P11)는 일정한 추임새를 넣으며 춤을 추는 행동들을 보였다.

“여러분 안녕, 헤이 지니의 지니에요.(말투를 따라 하며 춤을 춘다) 음악에 리듬을 맡기고 레디 고!” -P11

관찰 결과, 집중 시간이 길지 않은 아동을 고려해 효과음과 액션이 디스플레이 화면상에 배치되었다. 특히 아동이 특정 과업을 수행 시 AI 스피커는 칭찬하는 듯한 효과음 인터랙션을 표출하였다. 기기의 “~잘했어”라는 효과음 피드백에 대해서 사용자(P19)는 몸을 움직이며 행복해하는 모습이 관찰되었다. 이는 기기의 적절한 효과음 사용이 장문의 언어적 발화보다 직관적이고 더 강렬한 효과를 줄 수 있는 것을 의미한다.

한편 디스플레이형 AI 스피커에서 아동에게 제공되는 콘텐츠는 일반 성인을 대상으로 한 콘텐츠와는 다소 다른 양상을 보여준다. 주로 과장된 액션(인터랙션)과 채도 높은 색감의 GUI가 가미된 형태로 제공되고 있는 것을 관찰할 수 있었다. 선행연구에 따르면 아동의 전 조작기 사고단계는 움직임에 대한 인지 능력이 발달하는 과정으로, 아직 미세한 제스쳐 혹은 액션을 판별하는 데 어려움을 겪는다. 따라서 과장된 액션과 함께 동반되는 화려한 색상 표현은 아동의 인지능력 수준을 고려한 디자인 설계로 유추해 볼 수 있다.

또한 영상 분석 결과, 디스플레이 화면의 유무에 따라 기기의 활용 범위가 확연하게 다르게 나타났다. VUI 음성만 제공되는 스피커의 사용자는 ‘정보검색’, ‘음악재생’, ‘잡담(chit-chat)’ 등 간단한 명령어 수행을 진행하였으며, 이 또한 발화 과정 중 인식 오류로 인해 원활히 이루어지지 않는 모습을 확인할 수 있었다. 디스플레이형 AI 스피커의 경우, 기기에 장착된 디스플레이에 음성의 이해를 돕는 GUI 콘텐츠를 추가로 표시하는 방식을 택했다. 스크린 상에서 텍스트와 이미지를 사용하여 언어적 상호작용의 전달력을 높였다. 일례로 참가자(P12)는 AI 스피커가 제시하는 퀴즈 게임을 ‘VUI +GUI 인터페이스’의 조화를 통해 풀어내는 모습을 보여주었으며, 기기의 인식 오류 역시 현저히 낮게 나타났다. 또한 사용자(P12)는 음성보다는 터치 인터랙션에 좀 더 의존하는 모습을 보여주었으며, 시각적인 액션 피드백에 머리를 쥐는 행동을 보이며 스피커에게 혼잣말을 하는 모습을 확인할 수 있었다.

(스피커: “문제를 맞히지 못했어요. 다시 시도해보아요”)

“앗.. 지금 하나 틀렸어도 많이 맞췄으니깐… 아직 괜찮아.” -P12

이처럼 시중에 출시된 디스플레이형 AI 스피커의 비언어적 상호작용 방식은 주로 언어적 상호작용을 보조하는 텍스트, 이미지 위주의 콘텐츠로 제공하였으나, 향후 좀 더 다양한 형태의 비언어적 메시지(표정, 시선, 몸짓) 제공을 통해 언어적 상호작용의 전달력을 높일 것으로 예상된다.

Ⅴ. 디자인 함의점

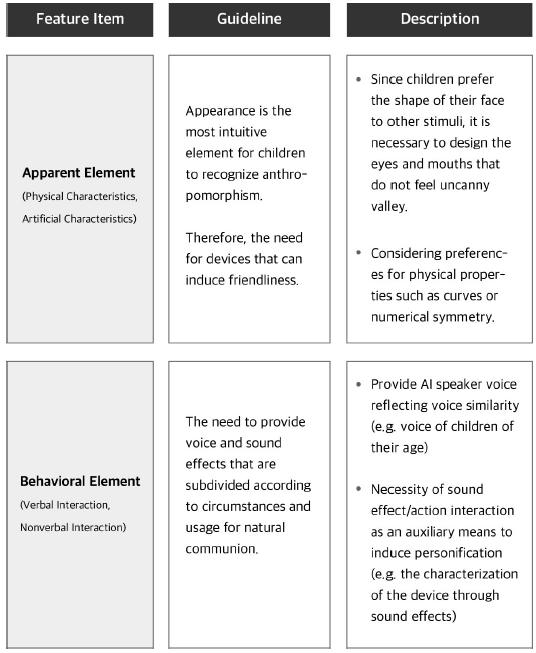

3장에서 살펴본 관찰연구 결과를 바탕으로, 아동을 대상으로 한 AI 스피커 디자인 시 적절히 활용할 수 있는 의인화 디자인 가이드라인을 제시하고자 한다.

5-1 외적 의인화에서 얼굴의 중요성

AI 스피커의 의인화된 외형적 요소는 신체적 특성, 인공적 특성으로 나누어 살펴볼 수 있었다. 외형적 의인화가 적용된 AI 스피커 형태에는 스크린 화면 속 캐릭터 출력을 통한 방법과 외관 디자인으로 나뉘었다.

디스플레이형 기기에서는 아동을 겨냥한 생동감 있는 캐릭터가 제공되고 있었다. 기기의 외관 디자인을 통한 의인화는 움직이지 않는 고정된 형태로 제공되었으나, 아동은 기기의 움직이지 않는 이목구비도 얼굴로 인식하였으며, 기기와 눈을 맞추면서 소통하는 모습이 확인되었다. 또한 신체 구조는 '얼굴+몸' 2등신으로 인식하여 몸을 포옹하고 쓰다듬는 행동을 보여주었다.

특히 관찰을 통해, 아동 사용자들이 스피커의 얼굴을 응시하며 스킨십을 하는 모습이 빈번하게 발견하였다. Bjorklund & Causey(2017)에 따르면 아동은 얼굴을 다른 자극 요소보다 선호하며, 특히 눈을 뜬 형태의 얼굴을 선호한다[32]. 더 나아가 Johnson et al (1991)의 실험을 통해 아동은 '얼굴'의 구조 개념을 가지고 태어나며, 다른 자극보다 더 주의를 기울이는 경향이 확인되었다[33].

이에 본 연구는 외형적 요소 중에서도 얼굴 영역의 중요성을 강조하고자 한다. 이는 음성을 통한 정보 제공이 주 기능인 AI 스피커에서조차 시각적 인터페이스는 의인화에서 중요한 영역임을 시사한다. 스크린이 탑재된 AI 스피커의 출현으로 외적 의인화가 제품의 외형뿐만 아니라 스크린을 통한 외적 의인화까지 가능해졌기에, 이를 적극적으로 활용한 필요성이 있다.

외형적 요소 설계에서의 관건은 사용자가 불쾌감을 느낄 수 있는 언캐니밸리(이하 UV)의 정도를 최소화할 방법을 찾는 것이다[16]. 특히 사람의 눈과 입 형태와 비율로 인해 UV를 느끼는 경우가 많은데, 실재감의 일치를 통해 이러한 불쾌감을 최소화하는 것이 중요하다[18]. 이때 UV를 인지하는 정도는 아동과 성인 사이에 큰 차이가 없다. Lewkowicz(2011)에 따르면 12개월 이상의 영아는 성인이 매력적이라고 느끼는 얼굴을 이들 역시 매력적이라고 느낄 수 있게 된다. 일례로 아동 사용자는 UV가 가미되지 않은 캐릭터 형태의 외관을 지닌 AI 스피커에게 의복을 입히며 귀여워하고(P2, 3), 인터페이스상의 귀여운 캐릭터에게 호감을 표하는 현상이 관찰되었다(P12). 이는 아동이 실재감이 높은 아바타보다는 실재감이 떨어지는 아바타에 호감을 느낀다는 선행연구와 일치하는 결과이다. 따라서 보편적으로 귀엽다고 여겨지는 큰 눈과 둥근 얼굴형, 작은 코의 형태가 반영된 외형적 요소 설계가 고려되어야 한다[34].

5-2 사용 타겟을 고려한 목소리 및 대화 톤의 유사성

스피커의 AI 의인화된 행위적 요소는 언어적 상호작용과 비언어적 상호작용으로 살펴볼 수 있었다. 언어적 상호작용에는 목소리, 억양, 속도, 템포 등을 확인할 수 있었으며, 비언어적 상호작용은 액션과 효과음의 사례를 찾아볼 수 있었다.

AI 스피커는 음성을 통해 정보를 전달하는 매개체이기에 언어적 상호작용 측면에서 고려되어야 할 점이 있다. HCI 분야에서는 목소리의 속도(Speech Rate), 말의 크기(Loudness), 어투(Tone) 등 목소리와 관련된 선행연구가 이루어지고 있다. 목소리의 억양과 유추되는 성향을 진행한 연구에 따르면, 인간은 목소리의 억양에 따라 컴퓨터의 성향을 인지하였으며, 인간은 본인과 비슷한 톤과 속도의 발화 음성일수록 더 친밀감을 느끼는 것으로 드러났다[35]. 이는 비슷한 사람에게 매력을 느낀다는 유사성–매력 패러다임(Similarity–Attraction Theory)에서 근거하여, 인간은 자신의 목소리 요소와 비슷한 상대에게 긍정적인 태도를 보인다는 것을 제시한다[36].

하지만 연구결과, 시중에 제공되고 있는 아동용 AI 스피커의 목소리가 20대 성인 여성의 목소리에 한정되어 있다는 점에서 목소리 유사성(Voice Similarity)의 중요성을 반영하지 못하고 있다. 대화식 음성 응답 장치 대부분이 여성의 목소리를 채택한 이유는 전달력이 좋으며 소비자의 반응이 좋았기 때문이라는 선행연구 역시 있으나[37], 구체적으로 여성 목소리에 대한 연령대별 선호도에 대한 근거자료가 부족하다. 아동은 구체적 조작 단계가 되면 집단 또래 문화가 형성되는 시기이기에, 또래에 대한 신뢰가 높아진다. 따라서 '성인 여성의 목소리' 뿐만 아니라 '아동 목소리' 등 다양한 에이전트 목소리의 검토가 필요할 것이다.

또한 관찰결과, 현재 상용화된 기기는 주로 높임말(Formal type)의 대화 톤(Conversational Tone)을 드러내었다. 하지만 아동의 주요 대화 맥락이 사회적 대화 중심이었다는 점에서 다양한 대화 톤의 제안이 필요하다. 대화의 목적이 과업 중심인지 사회적 대화 중심인지에 따라 낮춤말(Casual type) 혹은 높임말(Formal type)의 적절한 배치를 통해 아동과 기기 사이의 친밀감을 높일 수 있게 유도해야 할 것이다.

5-3 흥미를 지속시켜주는 'VUI +GUI' 혼용의 필요성

아동은 반복되는 패턴의 콘텐츠에 쉽게 실증을 느끼기에[4] 지속적인 사용을 유도하는 다양한 패턴의 비언어적 표현이 고려되어야 한다. 이는 자연스러운 교감을 위해 상황과 용도에 따라 세분화된 감정 패턴이 필요함을 시사한다.

구체적으로 흥미를 유도하는 효과음, 액션 요소의 제공을 강조하고자 한다. 효과음과 액션은 직접적인 의인화 요소는 아니나, 친밀감과 의인화를 도와주는 보조 수단으로 고려될 수 있다. 본 연구결과에 따르면 집중 시간이 길지 않은 아동은 기기의 효과음 피드백을 통해 사용 동기를 얻는 것으로 나타났다. 그러나 시중 AI 스피커의 반복되는 오류 상황으로 인해 아동의 이탈률이 높았다는 점에서 개선이 필요하다.

이에 본 연구는 VUI와 GUI 인터페이스의 혼용 형태가 아동용 AI 스피커에 적절한 형태임을 제안하고자 한다. 화려한 시각적 액션과 동반되는 음성 효과음을 통해 아동의 흥미를 유발함과 동시에, GUI 제공을 통한 언어적 상호작용의 전달력을 높여야 할 것이다.

요약하자면 앞에서 도출한 의인화 요소들을 AI 스피커 디자인 분야에서 가이드라인으로 적용하기 위해 스피커의 사례들을 조사하였고, 도출된 가이드라인을 <그림 2>와 같이 정리해 볼 수 있다.

Ⅵ. 결 론

본 논문에서는 AI 스피커와 아동의 사용경험에 미치는 영향을 유튜브 영상을 통해 행동을 분석하였다. 분석 구조는 선행 연구의 의인화 평가 기준에서 AI 스피커에 적합한 항목들을 적용해 다음과 같은 두 가지 의인화 요소를 도출하였다.

첫 번째는 외형적 요소로 신체적 특성, 색상, 인공적 특성을 포괄한다. 두 번째는 행위적 요소로, 언어적/ 비언어적 상호작용으로 나눌 수 있다. 위 평가 요소를 바탕으로 AI 스피커 사례를 살펴본 결과, 아동의 흥미를 끌기 위한 다양한 의인화적 요소들이 AI 스피커에 잠재되어 있다는 점을 발견할 수 있었다. 또한 디스플레이가 탑재된 AI 스피커의 등장으로, AI 스피커의 역할 및 범주 또한 확장되고 있음을 예측할 수 있었다. 실질적으로 유아기에 AI 스피커를 접했을 때 어떤 상호작용이 이루어지는지에 대한 연구는 부족한 상황에서, 본 연구는 아동을 대상으로 AI 스피커에 의인화 요소를 넣을 때 고려해야 할 시사점을 제공할 것으로 기대한다.

하지만 본 연구의 한계점으로는 사용자가 직접 업로드한 영상을 기반으로 분석이 이루어졌기에, 한정된 명령 지시어에 따른 반응을 살펴보았다는 점에서 한계가 있다. 따라서 의인화 요소와 아동 사이에 어떠한 인터랙션이 형성되는지에 대한 실제 사용자 조사가 필요할 것이며, 이를 향후 연구 과제로 제안하고자 한다.

Acknowledgments

본 연구는 2020년 대한민국 교육부와 한국연구재단의 인문사회분야 중견연구자지원사업의 지원을 받아 수행된 연구임(NRF-2019S1A5A2A01045980).

참고문헌

-

Cassell, Justine, et al., eds. Embodied conversational agents. MIT press, 2000.

[https://doi.org/10.7551/mitpress/2697.001.0001]

- Rimma Kats: Are Kids and Teens Using Smart Speakers? [internet].Available:https://www.emarketer.com/content/the-smart-speaker-series-kids-teens-infographic

-

Okita, Sandra Y., and Daniel L. Schwartz. "Young children's understanding of animacy and entertainment robots." International Journal of Humanoid Robotics 3, No. 03 pp.393-412, Sep 2006.

[https://doi.org/10.1142/S0219843606000795]

- Hyun-min Y, Teacher acceptance of infant education service robots and infant-robot interaction, Ph.D. dissertation, Sungkyunkwan University, Seoul, 2010.

-

Paay, Jeni, Jesper Kjeldskov, Mikael B. Skov, and Kenton O'hara. "F-formations in cooking together: A digital ethnography using youtube." In IFIP Conference on Human-Computer Interaction, Springer, Berlin, Heidelberg, pp. 37-54, 2013.

[https://doi.org/10.1007/978-3-642-40498-6_3]

- Pink, Sarah. "Digital ethnography." Innovative methods in media and communication research, pp.161-165, Dec 2016.

- Lee Young-sook, & Kim Jae-ho. "Research on the anthropomorphism stage of animation animal characters." Journal of Multimedia Society, Korea Multimedia Association, Nov 2009.

-

Luger, Ewa, and Abigail Sellen. "" Like Having a Really Bad PA" The Gulf between User Expectation and Experience of Conversational Agents." In Proceedings of the 2016 CHI conference on human factors in computing systems, pp. 5286-5297, 2016.

[https://doi.org/10.1145/2858036.2858288]

-

McTear, Michael Frederick, Zoraida Callejas, and David Griol. The conversational interface. Vol. 6, no. 94. Cham: Springer, 2016.

[https://doi.org/10.1007/978-3-319-32967-3]

-

Fridin, Marina. "Storytelling by a kindergarten social assistive robot: A tool for constructive learning in preschool education." Computers & education, pp.53-64, 2014.

[https://doi.org/10.1016/j.compedu.2013.07.043]

-

Kory, Jacqueline, and Cynthia Breazeal. "Storytelling with robots: Learning companions for preschool children's language development." In The 23rd IEEE international symposium on robot and human interactive communication, pp. 643-648. IEEE, 2014.

[https://doi.org/10.1109/ROMAN.2014.6926325]

-

Callanan, Maureen A., and Lisa M. Oakes. "Preschoolers' questions and parents' explanations: Causal thinking in everyday activity." Cognitive Development 7, No. 2, pp. 213-233, 1992.

[https://doi.org/10.1016/0885-2014(92)90012-G]

-

Epley, Nicholas, Adam Waytz, and John T. Cacioppo. "On seeing human: a three-factor theory of anthropomorphism." Psychological review, 114(4), 864, 2007.

[https://doi.org/10.1037/0033-295X.114.4.864]

-

Waytz, Adam, Joy Heafner, and Nicholas Epley. "The mind in the machine: Anthropomorphism increases trust in an autonomous vehicle." Journal of Experimental Social Psychology, 52, pp.113-117, May 2014.

[https://doi.org/10.1016/j.jesp.2014.01.005]

-

Eyssel, Friederike, Laura De Ruiter, Dieta Kuchenbrandt, Simon Bobinger, and Frank Hegel. "'If you sound like me, you must be more human': On the interplay of robot and user features on human-robot acceptance and anthropomorphism." In 2012 7th ACM/IEEE International Conference on Human-Robot Interaction (HRI), pp. 125-126. IEEE, 2012.

[https://doi.org/10.1145/2157689.2157717]

- Mori, Masahiro. "Bukimi no tani [the uncanny valley]." Energy, 7, pp.33-35, 1970.

-

Lewkowicz, David J., and Asif A. Ghazanfar. "The emergence of multisensory systems through perceptual narrowing." Trends in cognitive sciences 13(11), pp.470-478, Nov 2009.

[https://doi.org/10.1016/j.tics.2009.08.004]

-

Lewkowicz, David J., and Asif A. Ghazanfar. "The development of the uncanny valley in infants." Developmental psychobiology, 54(2), pp.124-132, Mar 2012.

[https://doi.org/10.1002/dev.20583]

- Reeves, Byron, and Clifford Ivar Nass. The media equation: How people treat computers, television, and new media like real people and places. Cambridge university press, 1996.

-

Waytz, Adam, John Cacioppo, and Nicholas Epley. "Who sees human? The stability and importance of individual differences in anthropomorphism." Perspectives on Psychological Science, 5(3), pp.219-232, May 2010.

[https://doi.org/10.1177/1745691610369336]

-

Bartneck, Christoph, Tomohiro Suzuki, Takayuki Kanda, and Tatsuya Nomura. "The influence of people's culture and prior experiences with Aibo on their attitude towards robots." Ai & Society, 21(1-2), pp.217-230, 2007.

[https://doi.org/10.1007/s00146-006-0052-7]

-

Bates, Joseph. "The role of emotion in believable agents." Communications of the ACM , 37(7), pp.122-125, 1994.

[https://doi.org/10.1145/176789.176803]

-

Brave, Scott, Clifford Nass, and Kevin Hutchinson. "Computers that care: investigating the effects of orientation of emotion exhibited by an embodied computer agent." International journal of human-computer studies, 62(2), pp.161-178, 2005.

[https://doi.org/10.1016/j.ijhcs.2004.11.002]

-

Breazeal, Cynthia. "Emotion and sociable humanoid robots." International journal of human-computer studies 59(1-2), pp.119-155, Jul 2003.

[https://doi.org/10.1016/S1071-5819(03)00018-1]

-

Darling, Kate, Palash Nandy, and Cynthia Breazeal. "Empathic concern and the effect of stories in human-robot interaction." 2015 24th IEEE international symposium on robot and human interactive communication (RO-MAN). IEEE, pp. 770-775, Aug 2015.

[https://doi.org/10.1109/ROMAN.2015.7333675]

-

Nunamaker, Jay F., et al. "Embodied conversational agent-based kiosk for automated interviewing." Journal of Management Information Systems, 28(1), pp.17-48, 2011.

[https://doi.org/10.2753/MIS0742-1222280102]

-

Goldhaber, Gerald M., D. Thomas Porter, Michael P. Yates, and Richard Lesniak. "Organizational communication: 1978." Human Communication Research , 5(1), pp.76-96, 1978.

[https://doi.org/10.1111/j.1468-2958.1978.tb00624.x]

-

Jeong, Y., Lee, J., Kim, S. and Kang, Y., "How Voice Interface Influences Users' Music Experience: An Exploratory Study Using YouTube Videos." Archives of Design Research, pp.165-176, 2020.

[https://doi.org/10.15187/adr.2020.02.33.1.165]

-

Blythe, M. and Cairns, P., "Critical methods and user generated content: the iPhone on YouTube." In Proceedings of the SIGCHI Conference on Human Factors in Computing Systems. pp. 1467-1476, 2009.

[https://doi.org/10.1145/1518701.1518923]

-

Harlow, Harry F., and Robert R. Zimmermann. "Affectional responses in the infant monkey." Science 130(3373), pp.421-432, 1959.

[https://doi.org/10.1126/science.130.3373.421]

- Eun-ji H, A Study on the Personalization Effect by Interaction Types, MS. dissertation, Yonsei University, Korea, Seoul, 2016.

- Bjorklund, David F., and Kayla B. Causey. Children's thinking: Cognitive development and individual differences. Sage Publications, 2017.

-

Johnson, Mark H., Suzanne Dziurawiec, Hadyn Ellis, and John Morton. "Newborns' preferential tracking of face-like stimuli and its subsequent decline." Cognition, 40(1-2), pp.1-19, 1991.

[https://doi.org/10.1016/0010-0277(91)90045-6]

- Etcoff, Nancy. Survival of the prettiest: The science of beauty. Anchor, 2011.

-

Nass, Clifford, and Kwan Min Lee. "Does computer-generated speech manifest personality? An experimental test of similarity-attraction." In Proceedings of the SIGCHI conference on Human Factors in Computing Systems, pp. 329-336. April 2000.

[https://doi.org/10.1145/332040.332452]

-

Vinney, Cynthia, and Lisa A. Vinney. "That sounds familiar: The relationship between listeners' recognition of celebrity voices, perceptions of vocal pleasantness, and engagement with media." Journal of Radio & Audio Media, 24(2), pp.320-338, Jul 2017.

[https://doi.org/10.1080/19376529.2017.1346659]

- Couper, Mick P., Eleanor Singer, and Roger Tourangeau. "Does voice matter? An interactive voice response (IVR) experiment." Journal of official statistics, 20(3), p.551, 2004.

저자소개

2018년 : 연세대학교 커뮤니케이션대학원 (석사)

2018년~현재: 연세대학교 커뮤니케이션대학원 커뮤니케이션디자인 전공 석사과정 재학 중

※관심분야: 인간-컴퓨터 상호작용(Human-Computer Interaction), 사용자경험디자인(User Experience Design)

1996년: 서울대학교 산업디자인학과 (학사)

2000년 : 카네기 멜론 대학교 (인터랙션 디자인 석사)

2011년 : 카네기 멜론 대학교 (디자인학 박사)

2011년~현재: 연세대학교 커뮤니케이션대학원 커뮤니케이션디자인 전공 부교수

2012년~현재: 연세대학교 언더우드국제대학 정보인터랙션디자인 전공 겸직교수

※관심분야: 감성디자인(Design for Emotion), 정보시각화(Information Visualization), 사용자경험디자인(User Experience Design), 디자인-컴퓨팅적 사고(Design-Computational Thinking) 기반 교육