공간에서 인터랙티브 구현을 위한 동작인식 기술 적용 연구

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구에서는 우리 주변에서 보이는 다양한 미디어 콘텐츠를 공간 안에서 사용자의 움직임을 이용한 상호작용을 검출하고, 사용자가 참여하고 함께 만들어 나갈 수 있는 연구를 진행하고자 한다. 기존에 많이 사용하던 아날로그 방식의 접촉식 입력도구들에서 벗어나 접촉하지 않고 인식하는 비접촉식 방법을 가지고 단순 인식이 아닌 복잡하고 다양한 모션을 감지해서 상호작용 시스템을 개발하고자 한다. 모션센서가 사용자의 움직임을 찾아내고 행동패턴을 분석하여 그 패턴에 따라 3D 캐릭터가 반응하면서 스토리를 이끌어나가는 구조로 이루어진다. 이를 위해서 다양한 센서에 대한 분석과 테스트를 진행하고, 최적화된 센서를 이용하여 정보를 분석하는 작업을 진행 후 이를 3D 캐릭터의 움직임과 연동하는 작업을 진행한다. 이러한 작업을 통해서 도출된 결과를 이용해서 공간 안에서 직관적이고 강건한 상호작용 작업을 진행한다.

Abstract

In this study, we intend to conduct a study in which various media contents seen around us can detect interactions using the user's movements in space, and allow users to participate and create together. It is intended to develop an interaction system by detecting complex and various motions, rather than simple recognition, with a non-contact method that recognizes without contacting away from the existing analog-type contact input tools. It consists of a structure that the motion sensor finds the user's movement and analyzes the behavior pattern, and the 3D character reacts according to the pattern to lead the story. To this end, we analyze and test various sensors, analyze the information using the optimized sensor, and then link it with the movement of the 3D character. Intuitive and robust interaction work is performed in the space using the results derived from these works.

Keywords:

Interaction, Motion, Sensor, Media, System키워드:

상호작용, 모션, 센서, 미디어, 시스템Ⅰ. 서 론

우리가 살아가는 공간은 기술의 발전에 힘입어 기술 중심의 사회에서 사용자 즉, 인간중심의 기술 개발의 사회로 변화하고 있다. 사용자의 몰입감을 증대하기 위해서 우리 주변의 영상의 품질을 높이는 연구가 지속되고 있는데, 이는 해상도의 향상을 이야기한다. Full-HD에서 4K 해상도 현재에는 8K의 해상도를 이야기하는데 이것은 이제 대형화에 따른 수치의 확장일 뿐 사용자의 시각에서는 그 차이를 뚜렷하게 확인하기는 어렵다. 영상의 화질은 현재의 기술로 충분하다고 보고 오히려 지금은 사용자가 상호작용을 통해서 보여지는 영상과 가상의 콘텐츠 등을 수단과 방법을 제어하는 부분에 대한 연구가 더 활발하게 이루어지고 있다. 상호작용이 없는 많은 콘텐츠들은 감상적인 관점밖에 나타나지 않기 때문에 점점 그 흥미를 잃고 있으며, 사용자의 몰입도도 떨어지고 있는 것이다. 자연스러운 상호작용을 위해서 다양한 방법들이 연구되고 있는데 크게 사용자의 신체를 통한 터치를 이용한 방법과 스마트폰과 카메라 등의 기기를 사용하는 방법으로 나누어진다.

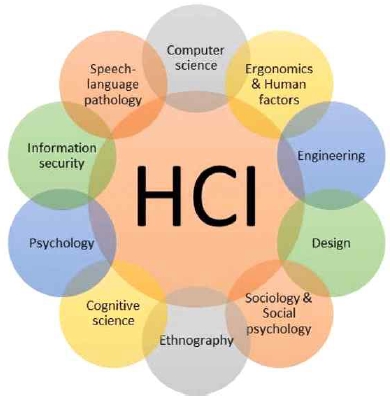

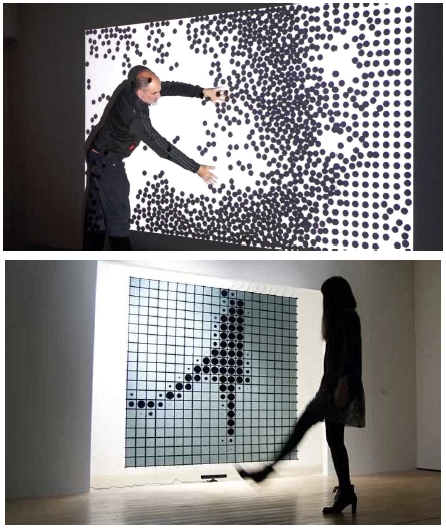

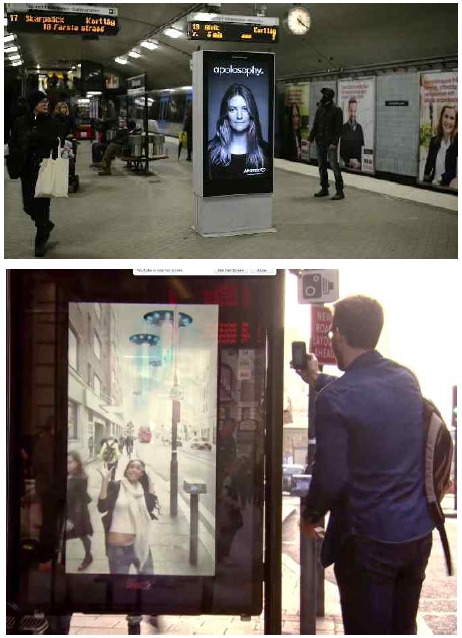

상호작용의 연구는 HCI(Human-computer interaction) 분야에서 다양한 방면에서 연구되어지고 있다. 그림 1과같이 우리 주변의 모든 분야에 사람과 기술이 연결되어 있음을 볼 수 있다[1]. 특히 사용자가 머무르는 공간에서 이루어지게 되는데 이러한 공간에서의 연구는 사용자가 참여할 수 있는 대표적인 연구 분야라고 할 수 있다. 그림 2를 보면 기존에 센서를 통한 인터랙티브 방식은 특정 공간이나 지역에서 (a)의 예제처럼 터치패널을 이용하거나 (b)와 같이 스마트폰 내부의 센서를 가지고 움직임을 감지하고 이에 그림을 그려주는 방식이었다면, (c)와 같이 현재에는 이러한 센서를 사용하지 않고 카메라의 영상만을 이용하거나 추가적인 센서를 사용하는 등의 복합 정보 기반의 인터랙티브 방식을 통해 정밀하고 다양한 정보를 분석해서 그에 상응하는 내용을 전달하고 있다[2]. 이러한 복합적인 센싱 기술은 사용자들이 쉽게 접하게 되는 전시공간에서 기술과 예술의 융합된 새로운 형태의 전시나 작품이 많이 시도되고 있다. 관람객의 움직임 행동 등에 반응해서 사용자에게 전달하고자하는 정보가 영상이나 소리, 조명 등으로 공간에서 표현된다[3]. 버스나 지하철과 같이 불특정 다수가 움직이는 공간에서 센싱을 통한 정보 전달이나, 전시 공간에서 사용자에게 전달하고자하는 정보에 맞춰 내용을 전달하는 방법에도 사용자의 신체 움직임이나 이동정보와 같이 복합적인 센싱 정보를 기반으로 정보를 전달하는 것이다[4][5]. 이처럼 카메라를 이용한 영상 기술의 발전으로 다양한 분야에서 활용하고 있다. 일상생활에서는 안전을 위한 CCTV를 이용한 특정 공간의 관리, 사용자의 움직임이나 행동을 분석하기 위한 기록, 개인적인 기록을 위한 촬영 등 광범위하게 사용되고 있다. 현재 일상생활에서 카메라를 이용한 촬영 및 분석은 보편화 되고 있고, 이를 기록하고 재생산하는 작업들로도 확대 되고 있는 것이다. 이러한 작업들은 데이터 시각화나 여러가지 정보전달의 그래픽 요소로 사용되기도 하는데 이를 위해서는 실시간으로 카메라에서 취득되는 영상 분석 및 이를 보완하기 위한 다양한 센서를 이용한 작업들로 이루어진다.

본 연구에서는 사용자가 조작하는 여러가지 방법을 상호작용이라고 정의하고, 공간에서 다양한 움직임이나 사용자의 행위에 따른 상호작용을 감지하고 이를 활용한 다양한 정보전달을 위한 기술 적용에 대한 연구를 진행하고자 한다. 상호작용을 위한 감지 방법은 크게 3가지로 정의될 수 있는데, 터치 패널을 손이나 펜등을 이용하는 방법, 스마트폰과 같은 모바일 기기의 센서를 이용하여 움직이는 속도나 방향을 분석하여 상호작용을 하는 방법, 카메라에 입력되는 시각정보인 영상을 이용하는 방법으로 나누어 볼 수 있다. 우리는 현장에서 쉽게 설치가 용이하고 움직임에 즉각적으로 반응할 수 있는 영상기반의 센서를 이용해서 연구를 진행하였다. 이를 통해서 특정공간안에서 움직임을 감지하고 판단해서 실시간으로 처리되는 결과를 영상을 통해서 사용자에게 상호작용의 결과를 보여주는 연구를 진행하고자 하는 것이다.

Ⅱ. 본 론

2-1 상호작용 관련연구

터치패널을 이용하는 기술은 다양한 방식이 존재하지만 크게 감압식, 정전식으로 나누어 볼 수 있다. 감압식은 패널을 누르는 압력을 통해서 인식하는 방식으로 터치 패널의 압력의 변화를 통해 저항 값이 변하는 데이터를 이용하는 방식이다. 정전식 터치방법은 현재 스마트폰에서 사용되는 방식으로 감압식 방식에 비해서 반응도 빠르고 터치감도 좋다. 이 방식은 손가락과 같은 전기가 흐를 수 있는 물체가 스크린에 닿으면 그 부분을 인식하고 이동을 감지해서 모션을 추적하는 방식이다.

모바일 형태의 기기를 이용한 인터랙션 방법은 일반적인 입력도구를 사용할 수 없는 공간에서 작은 기기에 적용할 수 있다. 기기의 움직임을 통한 상호작용이 이루어지므로 사용자에게 흥미를 유발 할 수 있다. 기기안의 센서를 이용하여 움직임과 이동에 대한 상호작용 정보를 취득하는 것이다. 움직임을 지속적으로 추적하면서 낮은 전력으로도 동작이 가능한 장점을 가지지만 지속적인 동작의 분석과 의도하지 않은 움직임에 의한 오차의 문제를 지닌다.

마지막으로 우리가 사용하려는 시각정보 기반의 상호작용 방법은 카메라를 이용하여 취득한 영상 데이터를 분석하여 상호작용을 구현한다. 상대적인 움직임의 추적과 분석을 통해서 인터랙션을 판단할 수 있으며, 사용자가 특별하게 하드웨어를 만지거나 제어하지 않는다. 하지만 카메라에서 물체의 깊이정보를 찾아내는데 어려움이 있어서 다수의 카메라 또는 광원을 이용한 추가 작업을 통해 이를 보완한다.

카메라를 이용한 상호작용은 다양하게 이루어지고 있는데 그림 3은 공간에서의 상호작용을 보여주는 예로서 사용자의 신체 여러 부위의 움직임에 따라서 영상이 반응하고 변화하는 것을 보여주고 있다. 아래의 그림 4는 지하철역과 버스정류장에서 상호작용이 적용된 예를 보여주는데 지하철역의 디스플레이의 경우 지하철리 들어오고 나가는 상황에서 영상안의 모델의 머리가 날리면서 실제 사람이 지하철의 이동에 영향을 받는 것을 보여주고 있다. 버스 정류소의 경우는 사용자가 화면 앞에 다가오면 3D영상이 실시간 합성되면서 사용자에게 재미를 선사한다.

위에서 이야기한 사례들에서 동작인식 기술은 전자장치 및 각종 감지기를 사용해 관객의 행위를 감지하여 그에 상응하는 결과를 보여주는 것으로 영상, 소리 등의 사람의 오감으로 느낄 수 있는 다양한 상호작용을 이끌어낸다. 이러한 작업은 사람들에게 직관적으로 다가서게 되면 어려움이 없이 친근하게 다양한 정보를 전달 할 수 있는 장점을 지니게 된다. 오늘날에 이르러 기술의 발전과 기기의 소형화에 힘입어 다양한 동작인 컨트롤러, 웨어러블 디바이스(Wearable Device), 감지기 등의 기기를 활용한 다양한 입출력 도구를 통해서 사용자에게 정보전달의 역할을 해나가고 있다. 사용자는 공간 안에서 자유로운 동작으로 기술기반의 기기나 콘텐츠들을 제어할 수 있으며, 실시간으로 상호작용의 결과를 확인할 수 있다.

2-2 사용자 동작인식 기술

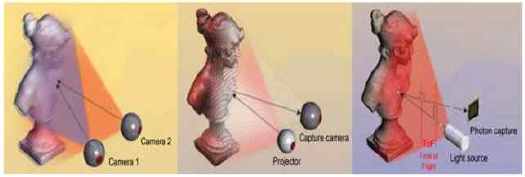

동작인식은 카메라를 이용하여 사용자의 움직임을 알아내고 추적하여 그 정보를 검출하는 작업을 의미한다. 이렇게 알아낸 영상 정보를 기반으로 컴퓨터를 이용해 원하는 작업을 진행할 수 있다. 이러한 작업은 화면을 터치하거나 아날로그적인 장치들을 움직이는 작업 등처럼 물리적인 접촉을 하지 않고 상호작용 작업을 할 수 있다. 이러한 작업을 기반으로 첨단산업, 예술, 의료, 교육 등과 같이 여러 분야에서 광범위하게 적용해서 활용할 수 있다. 이렇게 카메라 영상을 기반으로 움직임을 찾아내고 추적하는 모션캡쳐 작업을하기 위해서는 깊이정보(Depth Information)가 기반이 되는데 콘텐츠제작, 예술 작품 구현과 같이 목적에 따라서 다양한 결과물을 보여주고 있다. 이러한 깊이정보를 측정하는 기술은 그림 5와 같이 3가지로 나누어 볼 수 있는데 스테레오스코프 비전(Stereoscopic Vision), 구조광 패턴(Structured Light Pattern), TOF(Time of Flight) 방식 이다[6]-[8].

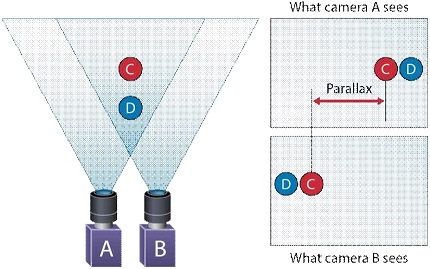

스테레오스코프 비전 방식은 가장 일반적인 방법으로 그림 6에서 A,B의 2개의 카메라를 이용해서 사람의 눈처럼 왼쪽과 오른쪽의 이미지를 만들어 내는 것이다. 왼쪽과 오른쪽에서 획득한 이미지 C,D는 보는 각도에 따른 약간의 차이가 존재한다. 계산을 통해서 이미지를 비교 분석하여 두 이미지의 변위차를 이용 깊이 정보를 추출하는 방식이다. 이러한 방법은 3D 영화에 일반적으로 상용되고 있는데 간단하게 구현할 수 있기 때문이다.

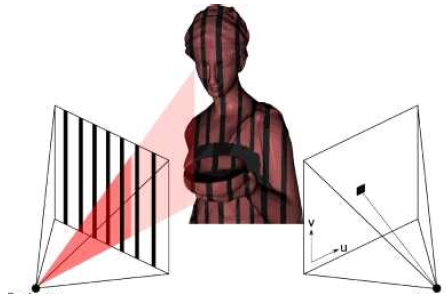

그림 7은 구조광 패턴 방식을 설명하고 있다. 구조광 패턴 방식은 찾아내고자 하는 물체에 그림 왼쪽과 같이 정해진 패턴을 뿌려주고, 이 패턴의 변화를 영상으로 분석하여 대상의 깊이 정보를 추출하는 방식이다. 구조광 패턴 방식의 3D 센서는 마이크로소프트사의 Kinect 제품에 적용되었는데, 이 제품은 μm 단위의 높은 정밀도로 측정이 가능하지만 높은 가격과 느린 속도 그리고 측정거리가 짧다.

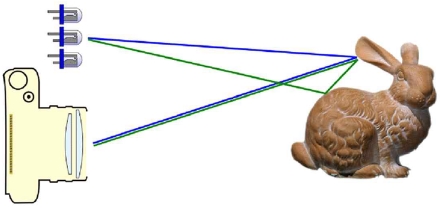

ToF(Time of Flight) 방식은 그림 8과 같은 구조로 빛이 물체에 닿고 반사되어 돌아오는 시간차를 기반으로 물체의 깊이 정보를 분석하는 방식이다. 물체에 닿고 돌아오는 시간이 빠르면 가까운 곳에, 늦으면 더 멀리 있다고 판단하여 이러한 차이를 기반으로 물체의 형태와 깊이 정보를 추출하는 것이다. ToF 방식의 센서는 마이크로소프트사의 Kinect v2이다. 장점은 인식범위가 넓고, 깊이정보를 바로 취득할 수 있다. 하지만 상대적으로 구조광 방식보다는 정밀도가 떨어진다.

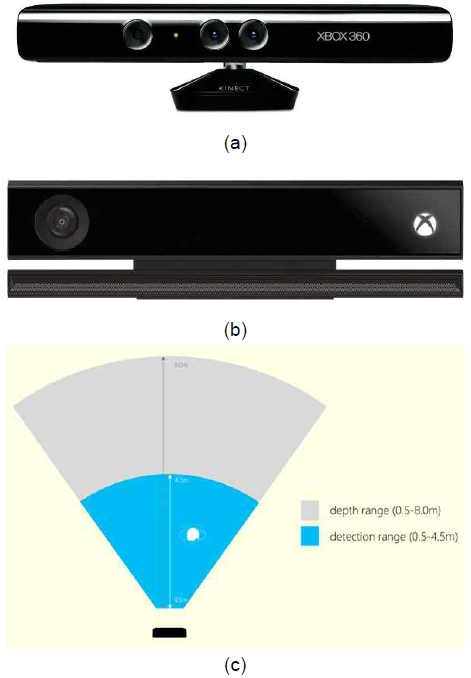

2-3 영상 기반의 센싱 장치

키넥트는 움직임을 인식하기 위해 개발된 센서로 version1과 version2 로 두 가지 버전이 존재한다[9][10]. 마이크로소프트사에서 개발되어 적외선 프로젝터, 적외선 카메라, 영상 취득용 카메라 등으로 이루어져 있다. 두 제품의 차이를 살펴보면, 키넥트 version1은 깊이정보를 구하는 기술이 앞에서 언급한 구조광 패턴 방식으로 패턴을 뿌려주고 이를 센서에서 분석하면서 왜곡된 부분에서 깊이정보를 찾아낸다. 그림 9의 (a)를 보면 제품에서 센서는 적외선 패턴을 투광하는 IR 프로젝터(왼쪽)와 그것을 읽을 IR 카메라 (오른쪽)으로 나누어 져있다. 또한 그사이에 영상을 취득하는 카메라가 탑재되어있다. 하지만 그림 7의 (b)의 키넥트 version2는 ToF(Time of Flight) 방식으로 빛이 물체에 닿고 반사되어 돌아오는 시간차를 기반으로 물체의 깊이 정보를 분석하는 방식이다. 깊이정보 센서는 외관으로는 보이지 않지만 제품 가운데 부분에 적외선 카메라(왼쪽)와 적외선을 투광하는 프로젝터(오른쪽)가 키넥트 version1처럼 탑재되어있고, 왼쪽에 영상 취득용 카메라가 탑재되어 있다. 두 제품의 큰 차이는 키넥트 version2가 키넥트 version1보다 이후에 개선된 모델이기 때문에 그림 7의 (c)와 같이 검출할 수 있는 영역과 깊이의 범위가 약 2배가량 확장되었다.

립모션은 손동작을 인식하기 위해 개발된 센서로 작은 휴대가 용이한 장치이다[11]. 그림 10의 (a)와 같이 3개의 적외선 LED가 반사되어 돌아오는 정보를 적외선 LED 사이에 있는 2개의 적외선 카메라가 스테레오 방식으로 깊이전보를 검출하는 방식이다. 적외선을 이용한 강건한 정보의 검출이 가능하다. 그림 10의 (b)와 같이 가로 609.6mm 세로 342.9mm의 영역 안에서 움직임 검출이 가능하고 0.01mm의 움직임 검출과 200FPS(Frame Per Second)로 움직임을 추적할 수 있어 높은 정밀도를 보인다.

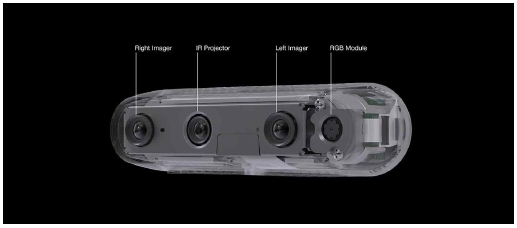

인텔사에서 개발한 리얼센스 시리즈는 키넥트 version1과 같이 구조광 패턴 방식을 기반으로 적외선을 이용해서 사물을 인지하는 센서이다[12]. 리얼센스 카메라는 그림 11과 같이 메인 카메라와 적외선 프로젝터, 적외선 카메라로 구성되어 있다. 원리는 적외선을 이용하여 사물의 형태와 거리를 감지하여 이를 기반으로 3D 데이터를 추출하고 영상촬영된 2D 이미지를 이용해서 물체의 입체적인 이미지를 보여준다.

Ⅲ. 인터랙티브 시스템

모션센서인 키넥트, 립모션, 리얼센스와 같은 카메라 기반의 장비중에서 우리는 공간에서 설치가 용이하고 다양한 움직임을 센싱할 수 있는 리얼센스를 기반으로 테스트를 진행하고자 한다. 키넥트 센서는 개발 사용된지 오랜 시간이 지나고 현재 단종된 상태이고, 립모션은 손에대한 움직임에 특화되어 있기 때문에 사람의 움직임이나 상체에 대한 센싱 부분을 고려했을 때 가장 적합한 카메라 장비로 판단되었다.

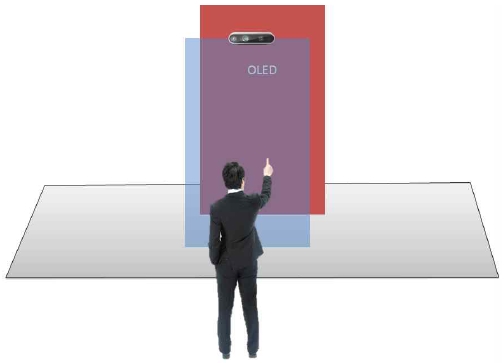

실험에서 사용된 카메라는 인텔사에서 개발한 리얼센스 시리즈중의 D435 모델을 선정해서 테스트 되었다. 이 모델은 카메라가 확보할 수 있는 시야각이 다른 모델에 비해 넓고, 측정 거리도 넓어서 다양한 환경에서 사용이 용이하다. 특히 상호작용을 위한 손의 제스쳐 인식을 위한 검출도 용이한데 손과 손가락의 위치를 총 22개의 점으로 인식가능하고 이를 기반으로 손과 손가락을 추적한다. 손가락은 손가락 마디에서 손가락 끝 사이의 관절 2개로 각각 4개의 포인트, 손바닥과 손등의 2개의 포인트로 구성된다. 이를 기반으로 제스쳐 인식인 주먹을 쥐고, 손바닥을 편상태와 손을 좌에서 우로, 우에서 좌로 움직이는 동작의 제스쳐를 감지한다. 이러한 동작을 이용해서 우리는 인터랙티브 시스템을 그림 12와 같은 환경에서 테스트를 진행하였다. 영상 출력을 위한 디스플레이 앞에 사람이 영상을 보면서 움직이는 모션에 따라 결과를 보여주는 것을 목표로 센서의 위치를 정하고 테스트를 진행하였다. 디스플레이와 사용자 사이에 유리창이 존재하는 환경을 고려하여 작업하였다.

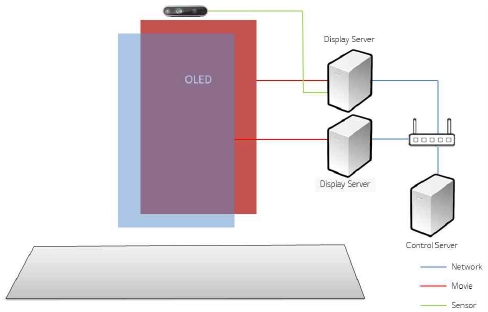

그림 13은 상호작용 시스템을 구성하기 위한 하드웨어 구성을 나타내고 있다. 다중의 디스플레이를 연동하기 위해서 네트워크 기반의 동기화 작업이 전제되어야하기 때문에 네트워크 연동과 영상의 제어를 위한 제어 서버의 역할이 필요하다. 센서의 정보를 얻어서 서로의 서버에서 특정 영역에 상호작용을 연동하였다.

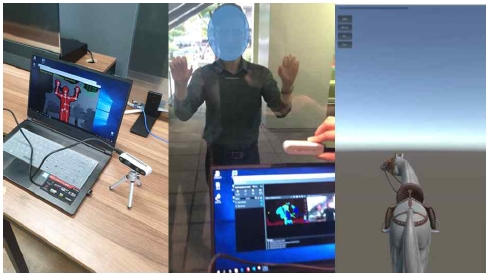

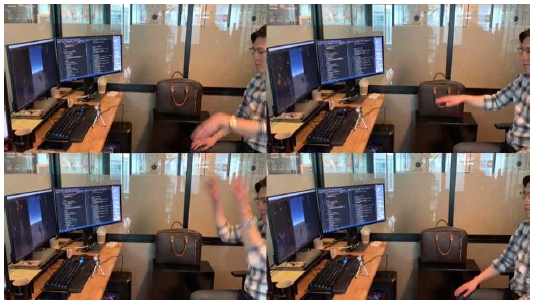

상호작용 시스템은 크게 3단계로 테스트가 진행되었다. 그림 14를 보면 1차 단계에서 센서에 대한 실내공간에서 내부 테스트를 진행하면서 실내에 설치된 유리를 사이에 두고서 투사에 대한 테스트를 진행하였다. 사용자의 신체의 움직임을 감지하고 그중 손의 움직임을 감지해서 제스쳐를 인식하는 테스트를 진행하였다. 2차 단계로는 실외환경에 사용자와 실내 환경에 카메라가 세팅되고 그사이를 유리가 있는 환경에서 인식률 테스트를 진행하였다. 유리는 두께나 코팅된 필름에 따라서 환경적인 차이를 나타내었다. 그리고 마지막 3차로는 앞에서 테스트된 결과들을 이용하여 가상의 3D 캐릭터에 모션인식에 따른 손의 제스처를 인식해서 상호작용을 테스트하는 과정으로 마무리 하였다.

카메라는 빛의 간섭과 주변 환경의 변화에 민감하게 반응하는데 이러한 부분에 대해 강건한 검출 및 추적을 진행하기 위해서 다양한 실외 환경의 테스트가 필요하다. 그림 15는 센싱 카메라의 다양한 환경 테스트를 위해서 진행한 테스트 작업으로 실내에 설치된 카메라가 실외에서 반응하는 사용자를 감지하고 인식하는 과정을 테스트 하였다. 주변의 다양한 빛의 간섭이나 주변 사람들의 이동을 통해서 그림자나 빛의 변화에 대해 간섭이 존재하는 부분을 확인하였다. 빛의 급격한 변화에 민감도를 보이는 부분에 대해서 예외 처리를 통한 정확도를 찾고자 하였고, 사용자가 겹치거나 지나가는 부분에 대한 반사에 대한 부분도 시간차를 이용해서 예외 처리를 진행하였다. 이러한 부분을 환경에 맞게 적용하여 환경에 최적화 하는 작업을 진행하였다.

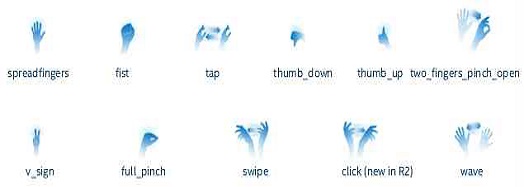

손을 이용한 제스쳐 인식은 손을 쥐고 펴는 동작에서 시작해서 다양한 설정이 존재한다. 그림 16에 제스처에 대한 정의를 나타내고 있는데, 손의 다양한 모양을 인식하는 것과 이러한 손의 움직임까지는 분류가 가능하다. 하지만 이러한 손의 움직임에 대한 기준이 필요하기 때문에 우리는 신체의 각 관절의 정보를 이용해서 몸통을 기준으로 잡고 상하좌우에 대한 손의 모션인식을 추가해서 정확한 동작 인식을 하고자 하였다.

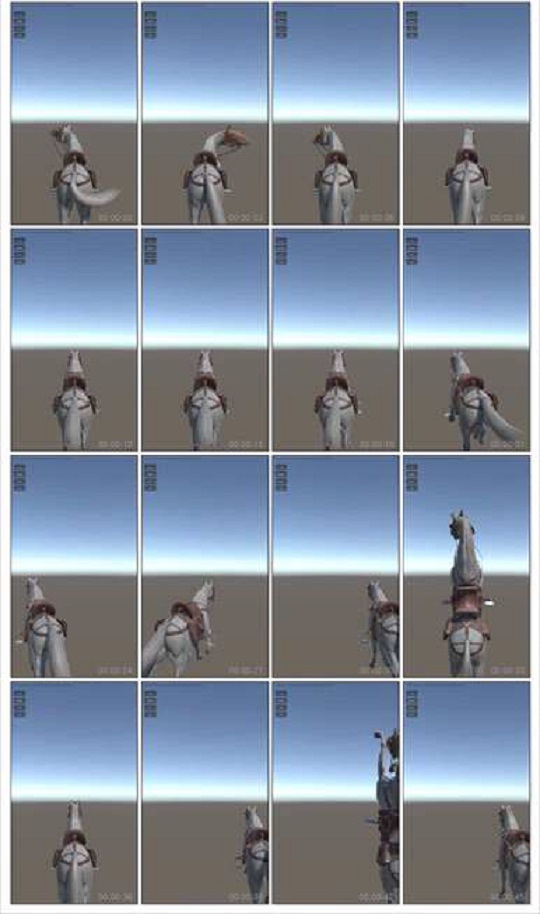

그림 17은 앞에서 이야기한 신체의 관정 정보와 손의 움직임을 이용해서 사용자가 상호작용 테스트 작업을 진행한 이미지이다. 가상의 3D 말 캐릭터는 카메라가 사용자를 인식하는 공간에서 사용자의 손의 움직임에 반응한다. 이러한 상호작용에 반응해서 3D 말 캐릭터가 모션에 따라서 왼쪽, 오른쪽, 점프의 세단계의 움직임을 나타내고, 앞으로 달려가는 가상의 공간에서 목표지점까지 무사히 도달하는 방식의 규칙을 가지고 테스트를 진행하였다. 직관적인 모션을 위해서 손을 왼쪽으로 움직이는 동작에는 왼쪽으로 이동, 손을 오른쪽으로 움직이는 동작에는 오른쪽으로 이동, 양손을 들어올리는 동작에는 점프를 하게되는 규칙을 적용하였다. 이러한 방식은 움직임이 거의 없는 사용자의 몸통과 상대적으로 움직이는 손의 움직임을 통하여 동작을 인식하는 방법으로 진행되었다. 이러한 과정을 통하여 출발지점에서 시작하여 목표지점을 향해 움직이는 과정으로 상호작용 요소에 대한 테스트로 진행하였다. 그림 18은 이러한 움직임에 반응하는 3D 말 캐릭터의 움직임을 영상으로 기입할 수 없어서 스틸 이미지로 나타낸 것이다. 화면의 가운데를 중심으로 사용자의 손의 움직임에 따라서 좌우로의 이동과 점프하는 동작에 대한 내용을 보여주고 있다.

구현된 시스템은 사용자가 핸드 모션을 통해 상호작용을 진행하기 위해서 구현되었다. 테스트에 참여한 사용자들은 특정 공간에서 실시간으로 모션에 반응하는 가상의 3D 캐릭터를 확인하면서 자신이 행동에 반응하는 캐릭터에 대해서 흥미를 가지고 테스트를 진행하였다. 하지만 테스트를 진행하는 과정에서 빛에 의한 간섭 때문에 센서의 설치 환경이 중요한 요인으로 발생하였다. 카메라 센서에 빛이 광원에 의한 순간적인 객체의 추적실패 및 지연이 생기게 되는 것으로 확인되었다. 때문에 우리는 실험 테스트 공간을 빛에 의한 간섭이 적은 공간을 선정하고 실험 환경을 구성하는 부분에 있어서도 빛을 고려해서 설치하였다. 이는 상호작용의 목적에 맞는 주변 환경을 구성하고 빛에 대한 카메라의 문제가 발생하지 않는 구성이 매우 중요한 요소라는 것을 확인하는 결과를 나타내었다.

Ⅳ. 결 론

현대사회는 새로운 기술의 개발과 더불어서 다양한 학문과 교류하고 융합하는 현상이 두드러지게 나타나고 있다. 기술이 기술에만 머무르는 것이 아니고 기술과 문화, 예술 등 기존에는 뚜렷하게 다르고 별개라고 생각했던 부분들이 하나로 융합되고 있는 것이다. 기술을 표현하기 위해서 예술적인 감각이 필요하고, 문학을 알리기 위해서 기술을 통해 재미있고 쉽게 다가갈 수 있게 만드는 것이다. 이러한 부분에서 상호작용과 관련된 기술들은 매우 두드러지게 나타나고 있는 요소라고 할 수 있는데, 사용자가 직관적으로 다가설 수 있기 때문이라고 생각된다. 기존의 기술들과 새로운 기술 더불어 하드웨어의 발달로 점점 고도화되고 소형화 되면서 우리 주변에 널리 사용되고 있는 것이다.

이번 연구에서는 사용자의 직관적인 행동을 인식하는 카메라와 이에 반응하는 영상 미디어 기반의 연구를 진행하였다. 미디어와 매일 함께하는 환경을 지니고 있는 현대인에게 단방향적인 영상 표현에만 머무르지 않고 카메라와 센서 등 다양한 매개체를 활용하여 미디어 콘텐츠를 보여주는 것은 더욱 효과적으로 정보를 전달할 수 있는 방법이 될 것이다. 이는 일방적인 전달방식을 통해 기술이나 정보를 얻게 되는 수동적 방식에서 벗어나 사용자가 디지털 콘텐츠에 직접 참여할 수 있는 상호작용 기술을 통해 나타나고 발전되고 있다. 특히, 최근에 개발 된 비 접촉식 동작인식 감지 기기들인 립모션과 리얼센스가 이러한 상호작용 방식의 대중화에 앞장서고 있다. 이러한 기술의 적용을 통해 사용자의 신체 행위를 인식하여 별도의 신체적 접촉이 있는 장비를 사용하지 않고 대상과 상호작용하는 방식의 콘텐츠는 앞으로 각광받을 대표적인 방식이라고 볼 수 있다. 이러한 기술들이 우리 생활에서 다양하게 적용되고 있기 때문에 앞으로 더 다양한 연구를 통해 다양한 환경과 공간에 적용 가능할 것으로 기대된다.

참고문헌

-

B. K. Chakraborty, D. Sarma, M. K. Bhuyan and K. F. MacDorman, "Review of constraints on vision-based gesture recognition for human–computer interaction." IET Computer Vision, Vol. 12, No. 1, pp. 3-15, Feb. 2018.

[https://doi.org/10.1049/iet-cvi.2017.0052]

-

V. Tam and L. Li, "Integrating the Kinect camera, gesture recognition and mobile devices for interactive discussion." Proceedings of IEEE International Conference on Teaching, Assessment, and Learning for Engineering (TALE) 2012, Aug. 2012.

[https://doi.org/10.1109/TALE.2012.6360362]

- S. Mann and W. P. Rosalind, "Digital Art by teamLab." Proceedings of the 2018 International Joint Workshop on Multimedia Artworks Analysis and Attractiveness Computing in Multimedia, pp. 1-1 June 2018.

- X. Wei, Y. Zhao, Z. Fan, W. Li, S. Yoakum-Stover, and A. Kaufman, "Blowing in the wind," in Proceedings of the 2003 ACM SIGGRAPH/Eurographics symposium on Computer animation, San Diego:SD, pp. 75-85, 2003.

- Unbelievable Bus Shelter [Internet]. Available : https://grandvisual.com/work/pepsi-max-bus-shelter/

- D. A. Forsyth and J. Ponce, "Computer vision: a modern approach,". Prentice Hall Professional Technical Reference, 2002.

-

H. Sarbolandi, L. Damien and K. Andreas, "Kinect range sensing: Structured-light versus Time-of-Flight Kinect.," Computer vision and image understanding, Vol. 139, pp. 1-20, 2015

[https://doi.org/10.1016/j.cviu.2015.05.006]

-

F. Heide, "Transient Convolutional Imaging," IEEE Computer Graphics and Applications, Vol. 38, No. 6, pp. 106-117, Dec. 2018.

[https://doi.org/10.1109/MCG.2018.2872646]

-

J. Jungong, S. Ling, X. Dong and S, Jamie "Enhanced computer vision with microsoft kinect sensor: A review," IEEE transactions on cybernetics, Vol. 43, No. 5, pp. 1318-1334, June 2013.

[https://doi.org/10.1109/TCYB.2013.2265378]

-

J. Zhou, L. W. Seo and C. B, Roh, "Study of KINECT based 3D Holographic and Gesture," The Journal of Digital Contents Society, Vol. 14, No. 4, pp. 411-417, Dec. 2013.

[https://doi.org/10.9728/dcs.2013.14.4.411]

-

F. Weichert, D. Bachmann, B. Rudak and D. Fisseler, "Analysis of the accuracy and robustness of the leap motion controller," Sensors, Vol. 13, No. 5, pp. 6380-6393, May 2013.

[https://doi.org/10.3390/s130506380]

-

L. Keselman, J. I. Woodfill, A. Grunnet-Jepsen and A. Bhowmik, "Intel realsense stereoscopic depth cameras," In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, Honolulu, pp. 1-10, 2017.

[https://doi.org/10.1109/CVPRW.2017.167]

저자소개

2007년: 중앙대학교 첨단영상대학원(공학석사)

2013년: 중앙대학교 첨단영상대학원(공학박사)

2007년 ~ 2014년: 세명대학교 전기공학과&전자공학과 강사

2010년 ~ 2015년: 남서울대학교 멀티미디어학과 강사

2013년 ~ 2013년: 강남대학교 컴퓨터미디어정보공학부 강사

2014년 ~ 2017년: (주)미디어앤아트 기술운영팀장

2017년 ~ 현재: 애니프레임(주) 솔루션본부 부장

관심분야:영상처리, 증강현실, 상호작용, 모션그래픽, 3D 맵핑, 미디어파사드 등

1986년 중앙대학교 전자공학과 졸업(공학석사)

1995년 중앙대학교 전자공학과 졸업(공학박사)

1986년 ~ 1987년: 현대전자

1987년 ~ 1991년: 금성통신

1995년 ~ 현 재: 세명대학교 전기공학과 교수

관심분야: 영상신호처리, 컴퓨터비전, 수리형태학, 영상정보은닉 등