VR에서 디지털 휴먼과 상호작용 시 외형 표현 단계가 사회적 실재감에 미치는 영향

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구에서는 2D 매체에 적용되었던 사회적 실재감이 미치는 영향 연구에서 비롯하여 VR이라는 뉴미디어를 이용해서 디지털 휴먼과 상호작용하는 상황에 적용시켰다. 기존 연구를 보면, 가상현실에서 아바타를 이용한 소셜 네트워크 서비스에 대해서는 연구되었지만, 아바타가 아닌 디지털 휴먼을 이용한 경우에 대해서는 연구된 바가 없다. 본 논문의 실험에서는 소셜 네트워크 서비스에서 가능한 상황을 연출하여 아바타와 디지털 휴먼에 대한 체험자의 반응을 비교하였다. 실험 결과를 통해 사회적 상호작용을 가상공간에서 체험자와 디지털 휴먼 사이에 적용할 수 있는 개념으로 확장하였다.

Abstract

Based on the studies on the effect of social presence applied to 2D media, it was applied to the situation of interacting with digital humans using a new media called VR in this study. Looking at existing studies, social network services using avatars in virtual reality (VR) have been studied, but there has been no study using digital humans. In the experiment of this study, the user's reactions for avatars and digital humans were compared by creating possible situations in social network services. From the results, the social interaction was extended to the concept that can be applied between users and digital humans in virtual space.

Keywords:

Digital Human, Human Avatar, Social Interaction, Social Presence, Virtual Reality키워드:

디지털휴먼, 인간형 아바타, 사회적 상호작용, 사회적 실재감, 가상현실Ⅰ. 서 론

페이스북(Face book)의 오큘러스 퀘스트(Oculus Quest)가 지난 5월에 출시된 후 일반인들의 VR에 대한 관심이 높아졌다. VR Intelligence에서는 XR 시장이 2020년까지 2,210억 달러로 성장할 것으로 예상하였다.[1] 이에 VR 콘텐츠의 다양화는 진행되고 있지만 대부분의 VR 콘텐츠는 1회성 체험용으로 지속적인 콘텐츠 소비를 유도할 수 없기 때문에 국내외 기업들은 체험자 간 소통을 중심으로 하는 VR 소셜 미디어 서비스(VR Social Media Service)에 주목하고 있다. [2] 페이스북 스페이스(Facebook Space), 빅스크린 VR(Big Screen VR), 렉룸(Rec room), 알트 스페이스 VR(Alt Space VR) 등과 같은 기존에 개발된 VR 소셜 미디어 서비스는 대부분 본인의 얼굴과는 다른 3D 아바타를 선택하여 이용하는 시스템으로, 체험자 간 소통 시 감정을 표현하는 데 한계가 있다. 이에 실제와 구분이 불가능한 정도의 리얼한 수준을 구현하여 사람과의 리얼한 교감을 목표로 하는 디지털 휴먼(Digital Human)과 VR 소셜 미디어 서비스에 관심이 집중되고 있다.

대표적인 소셜 미디어 서비스인 페이스북이 개발한 코덱 아바타(Codec Avatar)는 스캐너(Scanner)가 내장된 HMD를 이용하여 가상공간에서 본인과 동일한 모델로 생성되어 소통하도록 한다. 이는 페이스북이 지속적으로 강조한 타인과 물리적으로 같은 공간을 공유하는 “사회적 존재”에 대한 의미를 가지는 것을 목표로 한다. 또한, 실존 인물과 유사한 수준의 가상 아바타를 제작하여 사람들 사이의 물리적 거리를 극복하기 위해 노력하고 있다.[3]

자이언트 스텝(Ziant Step)이 발표한 국내 최초의 디지털 휴먼 ‘빈센트(Vincent)’는 인공지능과 접목시켜 사람들과 의사소통할 수 있는 수준으로 개발하여 다양한 콘텐츠에서 실시간으로 반응하는 디지털 휴먼을 구축해 나갈 것을 예고했다.[4] 또한 “디지털 휴먼의 활용 범위와 분야가 무궁무진하기 때문에 미래 콘텐츠 시장의 새로운 패러다임을 제시할 것”이라고 말했다.

이처럼 디지털 휴먼은 기술과 사람 사이의 거리, 사람과 사람 사이의 물리적 거리를 좁혀나갈 수 있는 기술로, 국내외 기업에서 수준 높은 극사실적인 고유 캐릭터 제작하여 브랜드를 대표하는 첨단 마케팅 및 홍보를 하고 있다. 하지만 디지털 휴먼을 이용한 서비스가 상용화되기까지 시간이 필요하고 장비도 간소화해야 하는 문제가 있다. 이에 기업들은 인공지능 서비스와 결합하여 AR, VR 등 그 외의 진입장벽이 낮은 매체를 이용하여 서비스하는 방향으로 제시하고 있다. 이러한 서비스의 상용화를 위해서는 체험자의 만족도나 감정, 상호작용에 대한 연구가 중요한 바탕이 된다. 기존의 연구는 3D 아바타(3D Avatar)를 이용한 VR 소셜 네트워크 서비스에 대한 내용이 대다수를 차지하고 있고, 스캔을 기반으로 제작된 디지털 휴먼에 대해서는 연구가 부족한 실정이다. 특히, VR 환경에서 움직임과 디테일한 행동 등은 실제처럼 자유롭지 않기 때문에 언어적 표현 이외의 요소들은 사용하는 데에 한계가 있다. 그 결과 VR 소셜 네트워크에서는 사회적 상호작용의 요소 중 언어적 커뮤니케이션(Communication) 외에 비 언어적 커뮤니케이션을 이용한 감정적 교류에 대한 연구가 부족하다. 이에 본 연구에서는 VR에서 체험자와 디지털 휴먼이 사회적 상호작용할 때, 그 요소 중 하나인 외형적 표현 단계가 사회적 실재감에 미치는 영향에 대해 연구하고자 한다.

본 연구에서 디지털 휴먼의 외형적 표현 단계가 사회적 실재감에 미치는 영향을 실험하는 연구 방법으로는 다음과 같다.

첫째, 외형적 표현 단계를 두 가지로 조작적 정의하기 위해 스캔을 통해 제작한 디지털 휴먼과 한국 애니메이션(Ani mation) 학회 논문의 아바타의 얼굴 묘사의 3단계에 기준하여 신체 비율이 인간 비율로 제작된 사실적인 인간형 모델을 선정하여 실험하였다.

둘째, 디지털 휴먼을 상반신 위주로 제작하여 인물의 얼굴에 집중한 연구를 진행하였다. 또한, 사회적 상호작용의 요소 중 외형적 표현 단계를 중요 요소로 생각하여 이를 중심으로 실험하였다.

셋째, 디지털 휴먼과 사실적인 인간형 모델의 실재감을 측정하기 위해 선행된 연구에서 검증된 설문 척도를 바탕으로 실험을 진행하였다.

Ⅱ. 이론적 고찰

2-1 VR과 디지털 휴먼

가상현실의 3가지 요소는 3차원의 공간성, 실시간 상호작용, 몰입감이다. 3차원의 공간성이란 체험자가 현실 공간에서 느끼는 경험과 최대한 유사하게 느낄 수 있는 공간을 의미한다. [5] 체험자는 컴퓨터가 만든 가상현실에서 현실 세계와는 다른 환경을 경험하게 되는데,[6] 상호작용을 하면서 시각, 청각 등 인간의 오감을 통해 느끼게 된다. 체험자는 자신이 바라보고 싶은 시점을 볼 수 있고, 자신이 실제로 가상의 공간에 있다고 생각하게 되는데 이를 ‘몰입’하였다고 한다. 또한, 가상현실 인터페이스를 통해 체험자는 새로운 시간적, 공간적 경험을 하면서 일방적인 체험에서 쌍방향적인 체험과 능동적 참여를 하게 된다.[7]

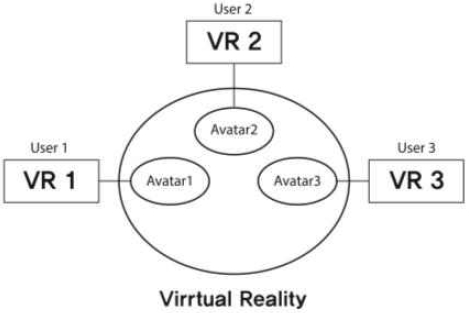

VR 소셜 네트워크는 공유 가상현실로, 네트워크를 통해 동시 접속하는 체험자가 공유하는 한 공간의 환경이다. 이 공간에서 체험자는 자신을 대신하는 아바타를 가지게 되는데 VR 소셜 네트워크의 속성인 공유 가상환경과 공존감을 아바타를 통해 경험하게 된다.[8] 체험자가 공유 가상환경에서 기존 아바타의 형태보다 사람과 유사한 디지털 휴먼을 대면하게 되면 상호작용함에 있어 다른 연구결과가 나올 것이라 생각하였고 이에 대한 연구가 필요하다고 판단하였다.

디지털 휴먼이란 기존에 제작되었던 사람 형상을 한 3D 아바타 개념에서 발전되어 액터(Actor)의 데이터를 스캔하고 고퀄리티 셰이더(High quality Shader) 기법과 향상된 지오메트리 워크플로우(Geometry Work Flow)를 통해 제작된 포토리얼리스틱 휴먼(Photorealistic Human)이다.[9] 스캔(Scan)을 기반으로 제작되기 때문에 CG 형태의 아바타보다 사실적인 표현이 가능하다. 텍스쳐(Texture) 또한 기존의 모델러(Modeler)가 포토샵(Photoshop)으로 직접 그리는 작업 방식에서 촬영으로 얻은 인물의 텍스처를 활용하는 방식을 이용하면서 리얼함을 보다 쉽게 표현할 수 있다.

디지털 휴먼은 실제 사람의 모습으로 AI와 결합하여 상황에 맞는 언어를 구사한다. 국외에서 디지털 휴먼을 개발한 사례를 보면, 사용자 경험 중심으로 발전되어 실생활에서 도움을 줄 수 있는 어시스턴트 역할을 하는 경향을 보인다.

유럽에서 디지털 휴먼을 활용한 대표 사례를 보면, 다임러(Diamler)가 개발한 ‘사라(Sarah)’의 파이낸셜 서비스(Finacial Service)와 소울머신스(Soul Machines)에 투자하여 함께 개발하고 있는 자동차 내의 디지털 어시스턴트 서비스(Digtital Assistant Service)가 있다. 두 가지 서비스는 아바타 형태보다 인간과 비슷한 리얼한 수준의 디지털 휴먼이 사용자에게 신뢰감을 줄 것이라는 가설을 바탕으로 개발되었다. 다임러 역시 디지털 휴먼 ‘사라’를 개발할 때, 관련 분야의 연구가 부족하여 이러한 가설을 바탕으로 제작하였다고 명시한 바 있다.[10]

설코(Serko)와 페이스미(FaceMe)가 함께 개발한 디지털 휴먼은 기업의 출장 및 경비 관리 서비스를 제공한다.[11] 설코는 이 디지털 휴먼과 이미 제공하고 있는 제노(Zeno) 서비스를 통합할 것이라고 예고했다. 제노 서비스는 매일 최대 20,000건의 출장 시 필요한 온라인 예약과 필요한 경비를 처리하고 매년 45억 달러의 기업 출장 지출을 관리하는 온라인 예약 도구이다. 사용자는 디지털 휴먼을 통해 자연스럽고 상호적인 대화 방식으로 출장을 계획할 수 있다.

중국 신화통신의 인공지능 아나운서는 실제 아나운서의 보도 영상에서 목소리와 입술 모양, 표정을 추출하여 딥러닝 방식으로 만들어졌다. 기사 내용을 텍스트로 입력하면 인공지능 아나운서가 사람의 목소리, 입모양을 표현하면서 뉴스를 보도하는 방식이다. 이는 TV의 뉴스 제작에 효율을 높이고 비용을 절감할 수 있다는 장점이 있다.[12]

2-2 사회적 상호작용

사회적 상호작용은 보통 인간과 인간 사이의 관계에서 일어나는 것으로, 사람이 다른 사람들에 대해 행동하고 반응하는 과정이다. 이러한 반응에는 일회적인 반응과 순환적인 반응이 있는데, 일회적인 반응은 한 방향으로 전달되는 상호작용이고, 순환적인 반응은 양방향으로 소통하는 상호작용이다. 이는 매체와 사람 사이에도 적용되는데 과거의 대중 미디어는 송신자 역할로 수동적 커뮤니케이션을 해왔지만, 미디어의 확장과 뉴미디어의 발달로 송신자, 메시지, 수신자 역할을 하는 능동적인 커뮤니케이션이 가능해졌다.[13]

사회적 상호작용의 도구에는 언어적 커뮤니케이션과 비언어적 커뮤니케이션이 있다. 언어적 커뮤니케이션은 서로 전달하는 메시지가 언어로 이루어져 있고 직접적으로 정보를 교환하는 것이 주된 목적이다. 비언어적 커뮤니케이션은 언어를 제외한 메시지를 전달하는 모든 수단으로 얼굴, 표정, 자세, 제스처, 용모, 공간, 음성 등 이 있다. [14]

BJ의 실시간 방송, 페이스북, 인스타그램 같은 플랫폼과 마찬가지로 VR 소셜 네트워크에서도 사회적 상호작용에 대한 연구는 중요시되고 있다. 페이스북 스페이스, 빅스크린 VR, 렉룸, 알트 스페이스 VR 등과 같은 VR 소셜 콘텐츠를 체험해 보면, 이들 대부분 비언어적 메시지 활용에는 제약이 있음을 알 수 있다. 알트 스페이스 VR을 제외한 나머지는 눈동자의 움직임을 감지할 수 없고 알트 스페이스 VR 조차도 아바타의 리얼함이 떨어지기 때문에 눈동자의 움직임 표현 또한 리얼한 수준에는 못 미친다. 페이스북 스페이스는 상반신의 움직임만 가능하여 제스처(Gesture)나 행동에도 제한이 있다. 언어적 메시지인 아바타의 음성은 전달이 되지만 정확한 입모양은 실시간으로 구현이 어려운 것도 VR 소셜 네트워크에서의 사회적 상호작용이 자유롭지 않은 이유 중 하나이다.

2-3 사회적 실재감

사회적 실재감은 쇼트(John Short) 등이 처음으로 제시한 개념으로, 사회적 실재감은 나와 같은 공간에 상대방이 존재하는 것처럼 느끼는 정도 및 유대관계를 감지할 수 있는 능력이다.[15] 개인은 매체가 매개된 환경에서도 커뮤니케이션으로 상대방을 지각하고, 함께 있는 듯한 친근한 느낌을 갖게 되는데, 이것을 사회적 실재감이라고 정의할 수 있다.[16] 이러한 개념은 관련 연구 초기에 TV나 라디오 같은 전통적 매체에서 적용되었는데, 다양한 디지털 미디어의 등장으로 인해 적용 범주가 확장되고 있다.

인지적 사회적 실재감은 커뮤니케이션에 참여하는 상대방의 존재를 얼마나 현저히 느끼는지와 같은 개념이라 볼 수 있다. 선행연구에서는 커뮤니케이션 상황에서 상대방의 존재에 대해 얼마나 ‘지각’하고 있는지, 그리고 상대방의 이야기를 얼마나 ‘이해’하는 지로 하위 요인을 도출하였다.[17]

‘지각’은 미디어를 통해 커뮤니케이션할 때, 대상이 존재한다고 생각하는 정도를 뜻한다. 디지털 휴먼에 대한 ‘지각’은 체험자가 HMD를 이용하여 콘텐츠를 체험할 때, 존재를 얼마나 인식했는지의 정도라고 생각할 수 있다. ‘이해’는 미디어를 통해 커뮤니케이션할 때, 메시지(Message)의 내용을 이해하였는지의 정도를 의미하고, 디지털 휴먼에 대한 ‘이해’는 가상공간에서 체험자에게 전달하는 메시지의 내용을 이해하였는지에 대한 정도를 나타낸다.

정서적 사회적 실재감은 상대방과 가상에서 사회적 상호작용을 하면서 나타나는 정서적 유대감을 말한다. [18] 선행연구에서는 정서적 유대감은 정서적 반응의 하위 요인으로 ‘친밀감’과 ‘즉시성’을 제시하였다. [17] 디지털 휴먼에 대한 ‘친밀감’은 가상공간에서 체험할 때, 대상에 대해 심리적으로 느끼는 감정과 연결된다. 이때, 디지털휴먼의 외형적인 모습도 ‘친밀감’에 영향을 미칠 것이라고 생각된다. 비오카(Frank A Biocca)가 제시한 ‘즉시성’은 친밀감과 함께 정서적 유대감을 보는 개념으로 매체에서 체험자들과 상호작용할 때의 정도를 말한다.[19] 이는 심리적 거리감에 영향을 주는데, 디지털 휴먼에 대한 ‘즉시성’은 체험자가 가상공간에서 대화하면서 대상과 심리적으로 얼마나 가깝다고 느끼는지 측정하는 개념이다.

가상현실 게임의 하나인 ‘소셜라이프(Social Life)’에서 등장하는 아바타에게 느끼는 사회적 실재감에 대한 연구 결과를 보면, 상점의 점원 역할을 하는 아바타에게 느끼는 상업적 메시지의 양식이 정보적 가치에 미치는 영향 사이에 관계를 맺어주는 것으로 나타났다.[20]

본 연구에서는 이러한 선행연구에 따라, 가상공간에서 상대와 상호작용을 하면서 생기는 인지적이며 정서적으로 연결된 심리적 상태를 설명하는 개념인 사회적 실재감에 주목하고자 한다. 또한, 사회적 실재감이 가상공간에서 체험자와 아바타의 형태보다 사람의 형상에 가까운 디지털 휴먼과 사회적 상호작용 시 커뮤니케이션에 미치는 영향을 형용할 수 있는 중요한 개념으로 본다.

Ⅲ. 연구설계

3-1 연구문제 및 가설

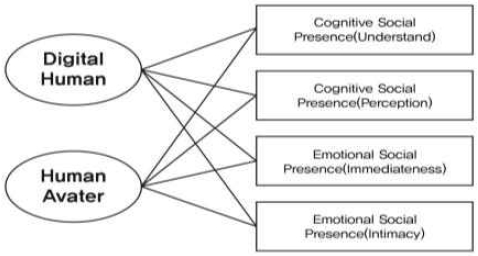

본 실험은 VR 환경에서 상호작용 시 외형적 표현 단계를 디지털 휴먼과 인간형 아바타로 나누고, 어떠한 집단이 사회적 실재감에 더 높은 영향을 미치는지 검증하는 것이 그 목적이다. 이에 다음과 같이 연구 문제와 가설을 제시한다.

연구 문제. VR에서 디지털 휴먼/인간형 아바타는 체험자의 사회적 실재감에 어떠한 영향을 미치는가?

<가설 1> 체험자가 디지털 휴먼과 상호작용할 때, 인간형 아바타보다 인지적 사회적 실재감에 높은 영향을 미칠 것이다.

<가설 2> 체험자가 디지털 휴먼과 상호작용할 때, 인간형 아바타보다 정서적 사회적 실재감에 높은 영향을 미칠 것이다.

3-2 독립변수

사실적인 인간 캐릭터의 제작에서 헤어와 피부 표현의 사실성은 시각적 리얼리티를 정의하는 가장 핵심적인 요소이다. [16] 리얼리티를 높여주는 요소는 얼굴, 눈, 헤어, 피부 등으로 얼굴 전체의 느낌을 정해주고 이를 구현할 때 정밀한 작업이 요구된다. 본 연구의 실험에서는 홍익대학교와 KT의 산학연 프로젝트를 통해 연구자가 직접 제작한 디지털 휴먼을 실험에 이용하였다. 제작한 디지털휴먼과 동일한 성별과 연령대의 인간형 아바타를 선정하였는데, 선행연구에서는 아바타의 얼굴 묘사를 ‘사실적’과 ‘보통’ ‘추상화’ 3단계로 나누어 정의하였다.[21] 이에 근거하여 인간형 아바타는 사실적 단계의 얼굴, 눈, 피부, 헤어를 가진 모델로 선정하였다.

3-3 종속변수

본 연구에서는 체험자와 디지털 휴먼의 사회적 상호작용 시 발생하는 커뮤니케이션 효과를 실험하고자 제안하는 지표는 사회적 실재감이다. 문헌 연구를 통하여 사회적 실재감의 하위 개념을 2개로 한정하였고, 그 하위개념은 인지적 사회적 실재감, 정서적 사회적 실재감이며 이들의 측정 항목을 이전의 연구들에서 사용되었던 몇몇 자술 평가 척도에 근거하여 본 연구에 맞게 재구성하였다. 인지적 사회적 실재감과 정서적 사회적 실재감의 측정 문항은 각각 4문항이며 리커트(Likert) 5점 척도로 측정되었다.

3-4 통제변수

본 실험에서 사회적 상호작용을 ‘가상공간에서 가상의 모델과 체험자가 느끼는 가상의 유대관계’로 정의하였다. 사회적 상호작용의 정도는 비언어적 커뮤니케이션이 서로 간의 감정과 사상을 표현하며 언어적 소통 그 이상의 메시지 전달 효과를 가진다는 연구 결과에 따라, 실험 시 언어적 커뮤니케이션과 비언어적 커뮤니케이션을 같이 설정하였다.[22] 비언어적 커뮤니케이션의 수단 중에 본 실험에서 디지털 휴먼을 상반신만 제작할 때 표현 가능성, VR 환경에서 제작할 때의 적합성, 실험 시 체험자에게 사회적 상호작용을 전달하는 효과성을 고려하여 얼굴과 표정, 눈짓으로 제한하였다. 행동이나 제스처는 상반신만 제작한 디지털 휴먼의 인터렉션(Interaction) 구현 부분에서 제약이 있어 제외하였고 구체적인 범위는 표 4와 같다.

사회적 상호작용을 실험하기 위한 시나리오는 디지털 휴먼, 인간형 아바타와 각각 동일한 대화를 진행하는 내용으로 기획하였다. 대화 내용은 VR 소셜 네트워크 상에서 처음 만난 사이에 흔히 나눌 수 있는 일상적인 대화로 구성하였고 비언어적 커뮤니케이션의 표정과 눈짓을 적절하게 표현하여 실재감을 더하였다. 또한, 대화하는 느낌을 주기 위해 각 질문에 피 실험자가 대답할 수 있는 시간을 10초씩 설정하였다. 구체적인 대화 내용은 표 5와 같다.

4-1 실험환경

4-1 실험환경

본 실험에서는 VR 환경에서 디지털 휴먼과 상호작용 시 사회적 실재감에 미치는 영향을 연구하고자 한다. 따라서 본 연구도 기존의 연구된 방법들을 기반으로 페이셜 모션 캡처(Facial Motion Capture) 장비와 소프트웨어를 활용하여 재구성하였다. 실험을 위한 환경은 표 6과 같다.

오큘러스 퀘스트는 2019년 페이스북에서 출시한 장비로, 기존의 데스크탑(Desktop)기반의 HMD의 한계성을 극복한 독립형 HMD이다. 기존의 HMD는 유선으로 PC를 연결해야 콘텐츠를 경험할 수 있고 무선화 솔루션(Solution)이 있지만 스마트폰(Smartphone) 기반의 HMD나 별도의 무선 어댑터를 필요로 한다. 하지만 오큘러스 퀘스트는 HMD와 2개의 Controller에 6DoF가 적용되어 체험자는 제자리에서 고개만 돌리는 것이 아니라 룸 스케일 안에서 자유롭게 움직일 수 있다. 6DoF(Degrees of Freedom)는 움직임 자유도를 말하며 3차원 공간에서의 움직임을 정의하기 위한 동작 요소이다. 6DoF는 Roll, Pitch, Yaw의 3가지 회전 동작과 Surge, Sway, Heave의 병진 동작이 있다.[23] 오큘러스 퀘스트는 Inside-Out tracking 방식으로 위치를 인식하며 기존의 것보다 가상공간과 현실의 오차가 낮아 콘텐츠 체험 시 VR 환경의 몰입감을 높일 수 있다.

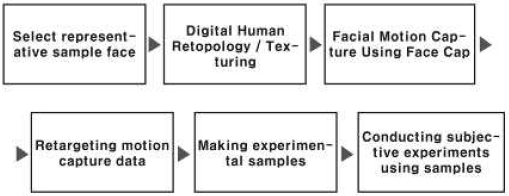

4-2 실험절차

본 연구의 절차는 아래의 그림 3과 같다. 먼저 대표 샘플 얼굴을 선정하고 디지털 휴먼의 스캔 데이터를 활용 가능하도록 리토폴로지(Retoplogy) 작업을 하였다. 다음은 리토폴로지 작업이 된 mesh에 모션 캡처 데이터 리타겟팅(Retargeting)을 위한 오토리깅(Auto Rigging) 작업을 한다. 다음은 실험의 시나리오를 구성한 후 페이셜 모션 캡처 어플리케이션을 통해 페이셜 애니메이션을 녹화한다. 오토리깅 작업을 한 모델에 녹화한 페이셜 모션 데이터를 리타겟팅하여 Maya에서 렌더링(Rendering) 한다. 마지막으로 Adobe After effect 에서 HMD에 넣을 수 있도록 최종 렌더 한 후 이를 이용하여 실험을 진행하였다.

개발된 오토리깅 툴 중에 상용화가 가장 잘 되어 있는 툴로, Maya에서 이용 가능한 무료 플러그인(Plugin)이다. 리깅(Rigging)은 리토폴로지 과정으로 정리된 3D 모델링에 뼈대(Joint)를 심고 컨트롤러(Controller)를 연결하여 애니메이션을 주기 위한 준비 과정이다. 일반적인 리깅 작업은 3D 모델링에 작업자가 직접 뼈대를 심고 웨이트(Weight)를 주어 기술적인 면이 요구되는 작업인 반면, 오토리깅(Auto Rigging)은 사람이 직접 리깅 작업을 하는 것이 아니라 인공지능 엔진(Engine)에 기존의 학습시킨 데이터를 기반으로 자동으로 리깅을 해주는 원리이다. 그러므로 플러그인 자체에서 제시하는 가이드에 따라 맞춰서 네이밍(Naming) 작업을 해야 오류 없이 작업할 수 있다. 리토폴로지 작업을 마친 디지털휴먼 모델을 프로그램 자체에서 제시한 가이드에 따라 모델링을 Head, Eyeball_R, Eyeball_L, Ears, Hair, Teeth_Top, Teeth_ bottom, Tongue로 나누고 전체를 Head로 네이밍하여 그룹으로 생성한다. 네이밍 작업이 완료되면 Advanced Skeleton 5에서 제시한 24가지의 페이스 리깅을 진행한다. 페이스 리깅의 과정은 아래 표 8과 같다. 오토리깅을 완료한 후, 총 14단계를 Bake하면 Controller가 생성된다.

Facecap은 Iphone 11 pro의 Depth Sensor를 인식하는 카메라를 이용하여 페이셜 모션 캡처하는 과정으로 App Store에서 다운로드 가능한 유료 앱이다. Iphone으로 촬영한 모션데이터를 모델링 파일(.fbx)과 음성파일(.wav) 두 가지로 형식으로 묶어서 가져올 수 있고, Maya Advanced 5로 오토 리깅하여 최종 Bake된 Mesh에 자동으로 리타겟팅 할 수 있다. 모션 캡처는 기존의 애니메이션 키(Key)를 잡는 방식이 아닌, 직접 대화 내용과 표정, 눈빛 등을 그대로 캡처하여 모델링(Modeling)에 애니메이션을 넣는 방식이다. 이 방식은 애니메이션 제작에 필요한 시간을 줄일 수 있고, 보다 사실적인 얼굴 모션이 구현 가능하다. Face cap은 50개의 블랜드 쉐입 데이터(Blend Shape Data)를 기록하여 헤드 위치 및 회전 값, 눈의 움직임, 목소리 녹음 등 이 가능하고 유니티(Unity)와 연동하여 라이브 모드도 가능하다.[24] 또한, Autodesk Maya, Lightwave 3D, Cimema 4d, Houdini, Blender 등 여러 프로그램과 호환이 가능하여 호환성과 접근성 및 가격적인 측면에서 타 아이폰 기반 모션 캡처 프로그램과 비교했을 때 가장 적합하다고 판단하였다. 또한, 본 실험에서 제작자의 애니메이션 능력에 따라 자연스럽고 실제 사람이 말하는 것 같은 정도의 사실적인 표현이 가능해지면 예측한 결과와 다른 결과를 가져올 수 있다는 점에서, 제작자의 능력을 철저히 배제시키는 모션 캡처 프로그램을 사용하였다. 실제 실험 내용을 모션 캡처하기 전에 각 모델링에 리타겟팅하여 테스트하였는데, Face cap을 이용한 리타켓팅 테스트 내용은 표 10과 같다.

Ⅴ. 연구결과

5-1 표본의 빈도분석

실험 대상자는 전공과 무관하게 연령대별로 총 26명을 선정하여 실험을 진행하였고, 설문을 통해 사회적 실재감을 평가하였다. 실험 시 편향적인 결과를 피하기 위해 VR 전문가는 대상에서 배제하였다. 표본의 빈도 분석 결과의 성별을 살펴보면, 남성은 7명으로 26.9%, 여성은 19명으로 73.1%으로 나타났다. 연령을 보면, 20대는 9명(34.6%), 30대는 9명(34.6%), 40대 8명(30.8%)으로 나타났다. VR 경험 유무는 있음은 65.4% (17명), 없음은 34.6%(9명)으로 나타났다. 인구통계학적 특성은 표 11과 같다.

5-2 신뢰도 분석

동일한 개념에 대해 측정을 반복했을 경우 동일한 측정값을 얻을 가능성이 있는지 대해서 알아보는 것을 신뢰도 검증 또는 Cronbach 알파 검증 이라고 한다. 보통 Cronbach’s Alpha 값이 0.7이상이면 신뢰도가 있다고 판단한다. 먼저 인지적 사회적 실재감의 이해를 살펴보면, 신뢰도의 값이 0.785로 보통 신뢰도를 보이고 있다. 지각을 살펴보면, 신뢰도의 값이 0.887으로 높은 신뢰도를 보이고 있다. 다음은 정서적 사회적 실재감의 즉시성을 살펴보면, 신뢰도의 값이 0.866으로 높은 신뢰도를 보이고 있다. 친밀감을 살펴보면, 신뢰도의 값이 0.944로 매우 높은 신뢰도를 보이고 있다. 대체적으로 정서적 사회적 실재감이 인지적 사회적 실재감보다 높은 신뢰도를 보이고 있다.

5-2 연구모형의 검증

디지털 휴먼과 인간형 아바타를 체험한 집단이 사회적 실재감에 미치는 영향에 대해 분석하기 위해 실험 결과를 기술 통계분석과 t-test를 사용하여 표준 차이 검정하였다.

기술 통계분석은 정규성 검정을 검토하였으며, 왜도와 첨도를 통해 파악하였다. SPSS에서 왜도는 절댓값 3 이상, 첨도는 절댓값 7 이상일 경우 자료 정규성에 문제가 있는 것으로 판단한다. 본 실험의 응답 자료는 정규성 검토 결과 일변량 정규성 가정에는 왜도와 첨도는 문제가 없는 것으로 나타났다.

<가설 1> 체험자가 디지털 휴먼과 상호작용할 때, 인간형 아바타보다 인지적 사회적 실재감에 높은 영향을 미칠 것이다.

인지적 사회적 실재감의 이해를 보면, 평균이 3.73, 표준편차가 1.012으로 나타났고 지각은 평균이 3.19, 표준편차가 1.172로 나타났다. 인지적실재감의 평균은 3.46, 표준편차가 1.010로 나타났다.

<가설 2> 체험자가 디지털 휴먼과 상호작용할 때, 인간형 아바타보다 정서적 사회적 실재감에 높은 영향을 미칠 것이다.

정서적 사회적 실재감의 즉시성을 보면, 평균이 3.57, 표준 편차가 1.094으로 나타났고 친밀감은 평균이 2.88, 표준편차가 1.301으로 나타났다. 정서적 실재감의 평균은 3.23, 표준편차가 1.124로 나타났다.

표 14의 표준 차이 검정을 보면, 인지적사회적 실재감의 이해의 디지털 휴먼 평균은 4.04, 아바타 평균은 3.42로 나타났다. 지각의 디지털 휴먼 평균은 3.60, 아바타 평균은 2.79으로 나타났다. 검정통계량을 보면, 이해에서(t= 2.281, p = .027) 값을 나타내었고 지각에서는(t= 2.624, p = .012) 값으로 이는 통계적으로 유의한 차이라고 할 수 있다.

정서적 사회적 실재감의 즉시성을 살펴보면, 디지털 휴먼의 평균은 3.85, 아바타의 평균은 3.29으로 나타났고, 친밀감을 보면, 디지털 휴먼의 평균은 3.31, 아바타의 평균은 2.46으로 나타났다. 검정통계량을 보면, 즉시성에서(t= 1.884, p = .065) 값을 나타내었고 친밀감에서는(t= 2.458, p = .017)값으로 이는 통계적으로 유의한 차이라고 할 수 있다.

Ⅵ. 결론

소셜 네트워크 가상현실 속 기존의 아바타의 형태보다 사람과 유사한 수준의 디지털 휴먼을 활용한 연구가 부족하다 판단하여 본 연구가 시작되었다. 가상현실 환경을 통하여 디지털 휴먼, 인간형 아바타와 상호작용을 경험해 보고 사회적 실재감에 대한 설문을 통해 평가하였다.

디지털 휴먼이 인지적 사회적 실재감의 지각과 정서적 사회적 실재감의 친밀감에서는 인간형 아바타보다 상대적으로 높은 점수를 보였다. 이는 리얼리티가 높은 모델과 같은 공간에 존재한다는 느낌이 강하고 정서적으로 친밀감을 느낀다는 것으로 추론해 볼 수 있다. 반면, 인지적 사회적 실재감의 이해와 정서적 사회적 실재감의 즉시성에서 디지털 휴먼과 인간형 아바타의 점수 차이가 높게 나지 않는 이유는 리얼리티를 원하는 분야의 서비스와 인간의 리얼리티가 떨어지는 것을 선호하는 서비스 분야가 나눠진다는 점을 추론해 볼 수 있다.

본 연구의 한계는 실험 대상이 디지털 휴먼과 인간형 아바타를 모두 체험하는 과정으로 진행하면서 실험을 위해 두 가지 외형 단계에 동일한 대화 내용으로 통제하였다. 동일한 대화 내용으로 인해 두 번째로 체험하는 실험의 내용을 유추해 볼 수 있다는 점에서 디지털 휴먼을 먼저 체험하고 인간형 아바타를 체험한 집단과 인간형 아바타를 먼저 체험하고 디지털 휴먼을 체험한 집단 간의 설문 결과에 차이가 있을 것으로 예상된다.

디지털 휴먼을 이용한 다양한 서비스는 대상의 존재를 인식하고 정서적 교감이 이루어지는 것이 중요한 분야이다. 특히, 디지털 휴먼의 얼굴과 표정을 비롯한 비언어적 커뮤니케이션은 교감을 위한 중요한 요소로, 이는 소셜 VR에서 소통하는 데에 있어 감정을 전달하는 방법이 된다. 얼굴과 표정은 상대방과의 친밀도를 높일 수 있으며 대화의 집중도를 높일 수 있다. 이러한 결과를 바탕으로, 후속 연구를 통해 VR에서 디지털 휴먼의 얼굴에서 상반신으로 범위를 확장하고 제스처를 이용한 비언어적 커뮤니케이션에 대해 연구하고자 한다. 나아가 VR 외의 다른 실감형 매체에서 적용되는 디지털 휴먼과 사회적 실재감의 관계를 연구하는 것도 중요한 의미를 가질 것이다.

Acknowledgments

본 연구는 2019년도 KT의 지원에 의하여 이루어진 연구로서, 관계부처에 감사드립니다.

참고문헌

- Webinar: The State of the XR Market 2019[Internet]. Available:https://www.vr-intelligence.com/webinar-state-xr-market-2019, .

-

J. Y. Kang, “A Study on Emotionally Responsive Interactive VR Films Using Wearable Band” The Journal of Digital Contents Society, Vol. 20, No. 4, pp. 707-715, April 2019.

[https://doi.org/10.9728/dcs.2019.20.4.707]

- Facebook codec Avatar[Internet]Available:http://www.vrn.co.kr/news/articleView.html?idxno=10681, .

- Ziantstep[Internet]Available:https://www.mk.co.kr/news/stockview/2019/04/205211/, .

- Virtual Reality[Internet]Available:https://ko.wikipedia.org/wiki/%EA%B0%80%EC%83%81%ED%98%84%EC%8B%A4, .

- J. S. Kim “Measures for the Job Creation in the Convergence Content Industry : Focused on the VR/AR Game Industry.” The Journal of the Korea Institute of Information and Communication Engineering, Vol.23 No. 9, pp.1110 – 1116, September 2019.

- H. T. Ho “A study of panorama VR content applicable and availability analysis for the exhibition.” MFA. Sejong University, August 2016.

-

W. S. Kim and K. Nah “A Study on the Avatar Design Characteristics of Immersive Virtual Reality - Based on Social Network-Based Virtual Reality Contents” The Journal of the Korean Society design culture, Vol. 24, No.1, pp.91-104, March 2018.

[https://doi.org/10.18208/ksdc.2018.24.1.91]

- Digital Human[Internet]Availabe:https://docs.unrealengine.com/ko/Resources/Showcases/DigitalHumans/index.html, .

- Daimler AG[Internet]Availabe:https://post.naver.com/viewer/postView.nhn?volumeNo=17573965&memberNo=17357917, .

- FaceMe[Internet]Availabe:https://www.cio.com/article/3514853/serko-and-faceme-create-world-s-first-digital-human-corporate-travel-assistant.html

- Sinwha Communication[Internet]Availabe:https://www.mk.co.kr/news/world/view/2018/11/703683/

- J. Y. Lee and H. S. Kim “A Study on the Communication Process and Resistance Culture of Webtoon : Focus on Webtoons for the Office Life.” The Animation Society of Korea, Vol. 2013, No. 12, pp.38-39, November 2013.

- J. U. Kim and J. M. park “Effects of Nonverbal Communication of Service Providers on Customers` Perception of the Service Quality”, The Journal of Marketing Management Research, Vol. 11, No. 2, pp. 153-172, April 2006.

- J. Short, E. Williams, and B. Christie, “The Social Psychology of Telecommunications,” London: John Wiley & Sons, 1976.

- H. S. Hwang, “Development of Social Presence Measurement of Mediated Social Interaction : A Case Study of Instant Messaging”, Korean Regional Communication Research Association, Vol. 7, No. 2, pp.529-561, June 2007.

-

K. I. Park and C. H. Cho, “Developing the Scale of Brand Social Presence : Focusing on Facebook”, The Korea Journal of Advertising, Vol. 26, No. 5, pp.213-214, May 2015.

[https://doi.org/10.14377/KJA.2015.7.15.213]

-

K. Shen and M. Khalifa, “Exploring Multidimensional Conceptualization of Social Presence in the Context of Online Communities, International Journal of Human-Computer Interaction, Vol. 24, No.7, pp.722-748, 2008.

[https://doi.org/10.1080/10447310802335789]

-

F. Biocca, C. Harms, and J. K. Burgoon. “Toward a more Robust Theory and Measure of Social Presence:Review and Suggested Criteria. Presence Teleoperators and Virtual Environments, Vol.12, No.5 pp456-480, 2003.

[https://doi.org/10.1162/105474603322761270]

- U. S. Jeong and H. J. Suk, “The Human Characters in 3D Animation - Visual Reality and Audience Acceptance”, The Korean Journal of animation, Vol. 8, No. 4, pp. 95-111, December 2012.

- U. S. Jeong and H. J. Suk, “The Human Characters in 3D Animation - Visual Reality and Audience Acceptance”, The Korean Journal of animation, Vol. 8, No. 4, pp. 95-111, December 2012.

- M. J. Chung and H. J. Kim, “The Effects of Service Providers' Verbal and Nonverbal Communications on Customer Satisfaction and Intention of Revisiting and Recommendation : Centering on Family Restaurants in Gwangju” The Journal of Tourism and Leisure Research, Vol. 24, No. 1, pp. 453-472, January 2012.

- K. J. Yun, J. Y. Jung, J. I Yun, W. S. Cheong, and J. G. Seo, “Design and Implementation of 6DoF supported 360VR Test Platform”, in 2018 The Korean Institute of Broadcast and Media Engineers Summer Conference, The Korean Society Of Broad Engineers, JeJu, pp.250-252, 2018.

- Face cap [Internet]Available:https://www.bannaflak.com/face-cap/, .

저자소개

2018년 ~ 현재: 홍익대학교 영상대학원 (예술학석사 과정)

2018년~2019년 : 홍익대학교 MR Media Lab 연구원

2018년~현재 : 홍익대학교 영상대학원 (예술학석사 과정)

2020년~현재 : MBC 특임사업부 VR 사업팀 사원

※관심분야:가상현실(VR), 증강현실(AR), 실감미디어 (Immersive Media), 인공지능(AI) 등

2019년 ~ 현재: 홍익대학교 영상대학원 (예술학석사 과정)

2019년~현재 : 홍익대학교 MR Media Lab 연구원

2018년~현재 : 홍익대학교 영상대학원 (예술학석사 과정)

※관심분야:가상현실(VR), 증강현실(AR), 실감미디어 (Immersive Media), 인공지능(AI) 등

2002년 : University of Southern California (M.S. degree)

2008년 : University of Florida (E.E. degree)

2003년~2005년 : 삼성전자 Digital Media연구소 선임연구원

2006년~2007년 : 미국 NSF CHREC연구소 연구원

2008년~현 재 : KT AI연구소 차세대VR Project 팀장(PM)

2019년~현 재 : 홍익대학교 영상대학원 VR/AR콘텐츠전공 겸임교수

※관심분야:가상현실(VR), 증강현실(AR), 실감미디어 (Immersive Media), 인공지능(AI) 등