CycleGAN을 이용한 Unpaired 근적외선 얼굴 이미지 생성 및 평가

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

얼굴인식은 얼굴에 비춰진 조명 변화에 따라 인식성능이 크게 좌우지만, 근적외선 카메라로 촬영한 얼굴 영상은 조명 변화에 둔감하여 얼굴인식에 사용할 수 있다. 최근에 중요한 기술로 부각된 머신러닝 방법으로 얼굴인식 성능을 개선할 수 있지만, 인식모델을 학습시키기 위한 근적외선 얼굴 이미지를 충분하게 확보하는 것이 현실적으로 어렵다. 따라서 이 연구에서는 근적외선 영상을 이용하여 조명 변화에 강한 얼굴 인식기를 만들며, 이 과정에서 머신러닝 학습에 필요한 충분한 양의 근적외선 얼굴 이미지를 확보하기 위해서 수정된 CycleGAN(Generative Adversarial Network)을 이용하여 양질의 근적외선 얼굴 이미지를 생성하는 방법을 제안한다. 일반 카메라로 취득한 다양한 얼굴 이미지로부터 근적외선 얼굴 이미지를 생성하며, 여기서 얼굴의 위치 정렬 및 밝기 조절의 전처리 과정을 수행하고, GAN 손실함수에 Perceptual 손실함수를 추가하여 생성된 이미지의 품질을 개선하였다. 제안한 방법으로 생성한 가짜(Fake) 이미지를 학습에 추가하여 사용하였을 때 얼굴인식 성능이 향상된 것을 실험에서 확인하였다.

Abstract

Since face recognition depends greatly on the light changes on the face and images taken with a near-infrared(NIR) camera are insensitive to changes in lighting, the NIR images can be used for face recognition. Although the machine learning methods which are widely used recently can improve face recognition performance, it is practically difficult to secure enough near-infrared face images for learning the recognizer. Therefore, in this paper, we make a face recognizer that is robust to light changes using near infrared images. In this process near-infrared face image is generated by using modified CycleGAN (Generative Adversarial Network) to secure sufficient amount of near-infrared face images for learning. In the process of generating near-infrared face images from various face images taken with a general camera, preprocessing of face alignment and contrast adjustment was performed, and the perceptual loss function was added to the GAN loss function to improve the quality of the generated image. Experimental results show that the fake image generated by the proposed method improves the performance of the face recognizer when used in addition to learning.

Keywords:

Face recognition, NIR(Near Infrared) face image, Face image generation, CycleGAN, etc키워드:

얼굴인식, 근적외선 얼굴 이미지, 얼굴 이미지 생성, CycleGAN, etcⅠ. 서 론

사람의 얼굴, 표정 등을 인식하기 위해서 카메라 영상을 사용한다. 일반적인 카메라는 가시광선 스펙트럼 영역 내의 빛만 찍을 수 있으므로 촬영한 영상은 조명 변화에 민감하여 조명 상태에 따라 얼굴인식 정확성이 크게 떨어질 수 있다. 반면 적외선 카메라로 촬영한 영상은 조명 변화에 둔감하며 야간에도 사물을 구분할 수 있을 정도로 조명 변화에 강한 장점이 있다.

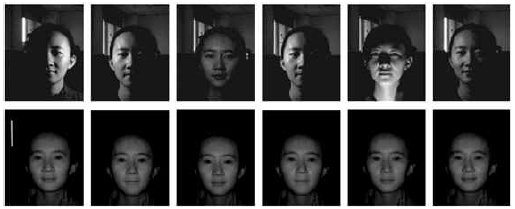

그림 1은 일반 카메라로 촬영한 이미지와 근적외선 카메라로 촬영한 이미지를 비교한다. 일반 카메라로 취득한 얼굴 이미지에서는 조명의 강도와 방향에 따라 얼굴에 식별하기 어려운 영역도 생기지만, 근적외선 카메라로 취득한 얼굴 이미지는 조명 변화에도 얼굴이 전반적으로 분명하게 보이는 강점이 있다. 이러한 강점을 이용하기 위해서 근적외선 카메라로 취득한 이미지를 얼굴인식에 활용하는 다양한 시도가 있다[1, 2].

General camera images (upper) and near-infrared camera images (lower) of various lighting changes for the same person [1]

조명 변화에 무관한 얼굴 이미지를 만들기 위해서 근적외선 카메라를 이용하지만 이를 이용해서 얼굴인식 학습에 충분한 양의 근적외선 얼굴 데이터를 만드는 것이 쉽지 않다. 따라서 이 연구에서는 이러한 문제점을 해결하기 위해서 머신러닝 기술을 이용해서 근적외선 얼굴 이미지를 가짜(Fake)로 생성하고 이를 학습에 이용하여 얼굴인식 성능을 향상시킨다.

최근 데이터 생성에 가장 많이 사용되는 머신러닝 방법인 GAN(Generative Adversarial Network)의[3] 다양한 모델 중 하나인 CycleGAN은[3,4] 쌍(Pair)이 없는 데이터를 학습 데이터로 삼아서 새로운 데이터를 생성할 수 있다. 이 연구에서는 일반적인 RGB 얼굴 이미지로부터 데이터 쌍이 없는 근적외선 얼굴 이미지를 만들기 위해서 가장 적합한 모델인 CycleGAN을 이용한다. 또한, 이 과정에서 진짜처럼 보이는 근적외선 가짜 이미지를 생성하기 위해서 Perceptual 손실함수를[5] 추가하여 학습한다. 가짜(Fake) 이미지란 GAN이 생성한 진짜(Real)처럼 보이는 가짜 이미지를 말한다.

제안하는 방법에서 기본적인 영상 전처리를 수행하여 얼굴 이미지를 정렬하고 명암 대비를 개선한 후에 제안하는 모델의 입력으로 사용한다. 얼굴 이미지 정렬은 눈에 해당하는 랜드마크(Landmark)를 찾아 이를 기반으로 얼굴을 정렬하고, 그 얼굴 영상에 히스토그램 평활화를 적용하여 명암 대비를 개선한다. 이러한 영상 전처리 과정을 수행하여 생성한 근적외선 얼굴 이미지는 그런 과정을 수행하지 않고 생성한 이미지보다 품질이 향상되는 것을 실험으로 확인할 수 있었다.

CycleGAN을 이용하여 일반적인 얼굴 이미지를 근적외선 이미지로 변환하는 기존의 연구[2]가 존재하지만, [2]에서 사용한 데이터는 일반 이미지와 근적외선 이미지를 동시에 촬영하여 쌍(Pair)으로 주어진다. 이는 이 연구에서 제안하는 쌍이 없는 데이터로부터 생성하는 연구와는 근본적인 차이가 있다.

논문의 II장은 관련 연구, III장에서는 제안하는 방법을 설명한다. IV장에서는 실험 및 결과를 정성적, 정량적 관점에서 평가하여 제시하며, 결론 및 향후 연구를 V장에서 기술한다.

Ⅱ. 관련 연구

Li 등은[1] 조명 변화에 무관하게 얼굴을 인식하기 위한 근적외선 영상 시스템을 제안하였다. 이 방법은 근적외선 이미지로부터 LBP(Local Binary Pattern) 특징을 추출하여 조명에 무관한 얼굴 표현(Representation)을 얻어낸 후 AdaBoost 방법으로 학습하여 근적외선 얼굴 이미지의 인식 정확성 및 속도를 개선하였다. 이 방법은 실내에서 촬영한 얼굴 이미지에 대해서는 높은 성능을 보이지만, 햇빛이 강한 실외에서 취득한 이미지에 대해서는 인식성능이 떨어지는 단점과 근적외선 얼굴 이미지 데이터를 충분하게 확보하는 것이 어려운 단점도 있다.

최근 급속히 발전하고 있는 머신러닝 방법을 이용하여 근적외선 얼굴 이미지를 인식하는 방법을 고려할 수 있다. 머신러닝 기반의 고성능 인식모델을 만들기 위해서는 대량의 학습 데이터가 필요하지만, 근적외선 카메라로 다양한 얼굴 데이터를 대량으로 수집하는 것이 어렵다. 따라서 이 연구에서는 부족한 근적외선 영상 데이터를 GAN[3]을 기반으로 한 머신러닝 방법을 적용하여 근적외선 이미지를 생성하는 방법을 제안하여 부족한 학습 데이터를 보완하고자 한다.

Goodfellow가 제안안 GAN은[3] Generator와 Discriminator의 두 개의 신경망으로 이루어진 생성모델이며, Generator와 Discriminator가 서로 경쟁하며 함께 개선되는 방식으로 학습이 진행된다. 그 결과 Generator는 입력으로 주어진 데이터의 분포와 비슷한 데이터를 생성할 수 있게 된다. GAN 모델들이 다양한 형태로 추가로 개발되어 사용되고 있지만[4, 5, 6], Generator와 Discriminator가 서로 경쟁하며 학습이 진행되기 때문에 학습이 불안정한 단점도 있다.

Conditional GAN을[6] 사용하여 이미지에서 이미지로 변환시키는 방법 중의 하나인 Pix2Pix는 입력 이미지와 출력 이미지의 매핑 관계를 학습한다. 그러나 Pix2Pix는 두 도메인에 속한 이미지가 쌍(Pair)으로 주어질 때만 학습이 가능한 단점이 있다. 반면 CycleGAN[4]은 쌍으로 주어지지 않은 데이터들을 학습하기 위해서 Pix2Pix와 동일한 형태의 GAN 구조를 사용하지만 Adversarial 손실함수에 Cycle consistency 손실함수를 추가하여 사용한다. 이를 통해서 CycleGAN은 한쪽 도메인에 속한 데이터를 다른 쪽 도메인의 데이터 분포가 되도록 Generator를 학습하며, 이에 대한 추가 설명은 3-4절에 포함한다.

CycleGAN에서 Cycle consistency 손실함수는 진짜 이미지와 복원된 이미지를 픽셀 단위로 비교하며 계산하지만, 픽셀 단위의 비교보다 좀 더 큰 영역을 볼 수 있는 특징(Feature) 간의 손실을 계산할 수도 있다. 이 방법은 얼굴 특징들을 보존하는 방향으로 손실을 활용하기 때문에 얼굴의 주요 특징들이 보존되는 장점이 있다[5].

Zhang 등은[2] 쌍으로 이루어진 데이터 셋을 사용하며, CycleGAN의 인코더를 얼굴 특징 추출기로 교체하고, 새로운 Pixel consistency 손실함수를 정의하여 일반 카메라 얼굴 이미지를 근적외선 얼굴 이미지로 변환하는 방법을 제안하였다. [2]에서 제안한 Pixel consistency 손실은 CycleGAN의 입력으로서 데이터 쌍을 확보하지 못한 경우에는 사용할 수 없는 한계점이 있다. 여기서 Pixel consistency 손실함수란 Real VIS(Visual) 이미지(IV), Real NIR(Near-Infrared) 이미지(IN), VIS를 NIR로 변환시키는 Generator를 G, NIR을 VIS로 변환시키는 Generator를 F라고 할 때, G(IV)와 IN의 Pixel consistency 손실, IV와 F(IN)의 Pixel consistency 손실을 더한 값을 의미한다.

CycleGAN을 이용한 얼굴 이미지 생성 과정에서, 입력되는 얼굴 이미지를 정렬시키고 명암 대비를 개선한 후 생성한 얼굴 이미지의 품질이 그렇지 않은 것보다 향상된 것을 이 연구의 실험으로 확인하였다. 여기서 사용한 얼굴 정렬은 눈 영역의 랜드마크를 검출하여 얼굴을 정렬하는[7] 것과 히스토그램 평활화를[8] 수행하여 명암 대비를 개선하는 것이다.

Ⅲ. NIR 얼굴 이미지 생성

3-1 제안 방법의 개요

논문에서 일반적인 카메라로 촬영한 이미지를 VIS(Visual), 근적외선 카메라로 촬영한 이미지를 NIR(Near-Infrared) 이미지라고 칭한다. VIS 이미지를 NIR 이미지로 변환할 때 [7]에서 제안한 방법으로 얼굴의 랜드마크를 검출하고, 이 중에서 양쪽 눈의 위치를 찾아서 그 위치를 기준으로 얼굴을 정렬시킨다[9]. 정렬된 이미지에 히스토그램 평활화를[8] 적용하여 얼굴 명도 대배를 개선한 후에 CycleGAN의 입력으로 사용한다. 반면 NIR 이미지를 VIS 이미지로 변환할 때는 랜드마크를 검출하여 찾아낸 눈 위치에 기반하여 얼굴 영역의 정렬만 수행하고, 명도 변화를 위한 히스토그램 평활화는 적용하지 않고 CycleGAN에 입력한다. NIR 이미지는 VIS 이미지와 달리 외부 조명의 변화에도 명도 변화가 적기 때문에 명도 대비를 개선하지 않는다.

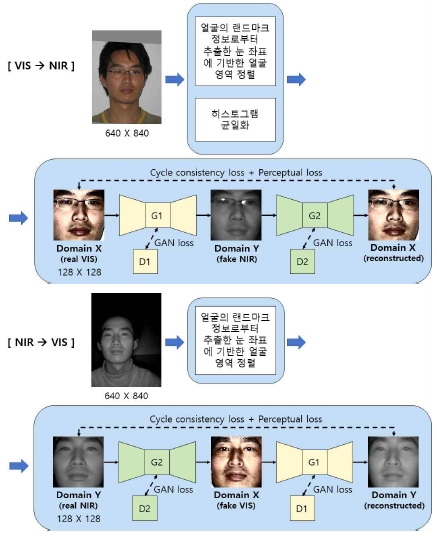

그림 2는 제안 방법의 개요로서 VIS 이미지는 도메인(Domain) X에 해당되고, NIR 이미지는 도메인 X에 해당된다. G1은 도메인 X에서 Y로 변환시키는 Generator이고, D1은 G1에 대한 Discriminator이다. G2는 도메인 Y에서 X로 매핑하는 Generator이고, D2는 G2에 대한 Discriminator이다.

3-2 눈 위치 기반 얼굴 정렬

CycleGAN의 입력 이미지에서 눈, 코, 입과 같은 얼굴의 특징적인 부분들이 어느 정도 일정한 위치로 입력하면 데이터의 일관성이 생겨 손실함수 계산 시에 이점이 있으며, 생성된 이미지의 품질이 개선될 수 있다. 따라서 이 연구에서는 얼굴을 반듯하게 정렬시킨 후 입력하고, 얼굴 정렬은 얼굴의 랜드마크에서 찾아진 양쪽 눈의 좌표를 이용하여 눈 높이를 기반으로 얼굴의 비틀어짐을 교정하는 방식으로 진행한다.

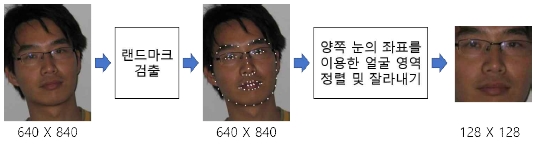

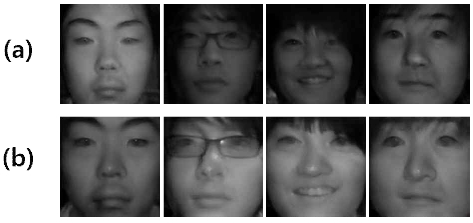

그림 3은 [7]에서 제안한 방법으로 얼굴에서 랜드마크를 찾고, 눈에 해당되는 랜드마크를 이용하여 얼굴 영역을 정렬하는 과정이다. 이를 통해 만들어진 128x128 크기로 정규화된 이미지를 CycleGAN의 입력으로 사용한다. 그림 4(a)는 얼굴을 정렬하지 않은 상태에서 얼굴 영역을 잘라낸 입력 이미지들이며, 그림 4(b)는 얼굴을 정렬한 후 자른 이미지들이다. CycleGAN의 이미지 생성을 위한 입력으로서 그림 4(b)가 더 적절하다는 것은 실험을 통해서 확인할 수 있다.

3-3 얼굴 명도 조절

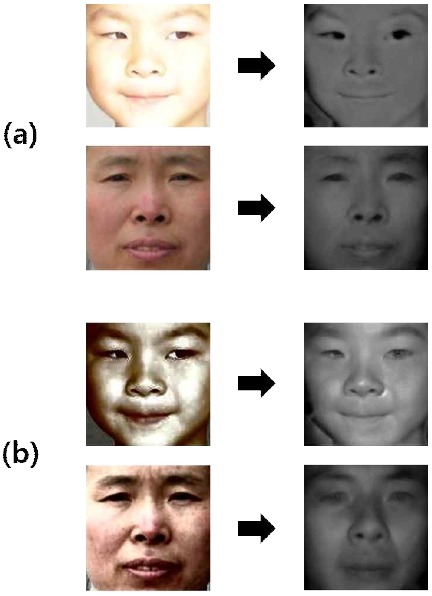

VIS 이미지는 조명이 너무 어둡거나 밝으면 명암 대비가 낮아서 얼굴의 윤곽이 제대로 나타나지 않는데, 이를 개선하기 위해서 히스토그램 평활화를 적용하면 이미지의 히스토그램 분포가 고르게 되어 명암 대비가 향상된다. 그림 5(a)는 히스토그램 평활화를 적용하지 않은 상태에서 CycleGAN으로 생성한 NIR 이미지를 보여주며, 5(b)는 히스토그램 평활화를 적용하여 얼굴의 명도 변화를 개선한 이미지로 생성한 NIR 결과 이미지를 보여준다.

히스토그램 평활화를 적용한 후 이를 학습 데이터로 사용하여 NIR 이미지를 생성한 경우 이미지가 전체적으로 자연스럽게 생성된 결과를 확인할 수 있다. 그림 5(b)의 히스토그램 평활화가 적용된 VIS 이미지는 NIR 이미지를 생성하기 위한 입력 이미지로서 사람이 보는 시각적인 면에서는 편하게 보이지 않을 수 있다.

3-4 근적외선 이미지 생성

머신러닝을 이용한 이미지 생성에서 입력 이미지와 그에 대응되는 결과 이미지가 쌍(pair)으로 주어지지 않은 경우에는 CycleGAN을[4] 이용할 수 있다. CycleGAN은 쌍이 없는 이미지들을 입력으로 받아서 Cycle consistency라는 개념을 사용하여 한쪽 도메인에 속한 데이터를 다른 쪽 도메인의 분포로 매핑하는 Generator를 학습시킨다. Cycle consistency를 언어 번역에 적용한다면 “영어를 프랑스어로 번역한 후 그것을 다시 영어로 번역하면 원본 영어 문장과 같아야 한다”라는 예로 생각할 수 있다. 원래 GAN의[2] Adversarial 손실에 Cycle consistency 손실함수를 추가하면 역함수 관계인 두 개의 Generator G1(X에서 Y로의 변환)과 G1(Y에서 X로의 변환)를 얻을 수 있다.

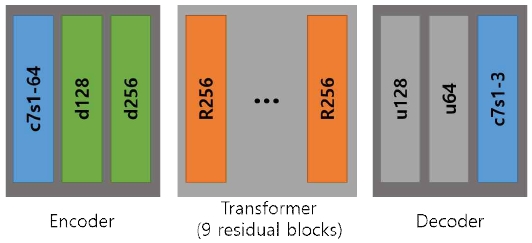

여기서는 CycleGAN의 Generator 구조는 그림 6과 같이 인코더(Encoder), 변환기(Transformer), 디코더(Decoder)로 구성되며, 여기에 9개의 Residual block[10]을 사용한다. 인코더의 c7s1-k의 의미는 필터 k개, 7x7 크기의 Stride가 1인 Convolution-InstanceNorm-ReLU 레이어, dk는 필터가 k개, 3x3 크기의 Stride가 2인 Convolution-InstanceNorm-ReLU 레이어를 의미한다. 변환기의 Rk는 필터가 k개인 3X3 Convolution layer 두 개를 포함한 Residual block을 의미하며, 디코더의 uk는 필터가 k개, Fractional-strided-Convolution-InstanceNorm-ReLU 레이어는 Stride가 1/2로 구성한다.

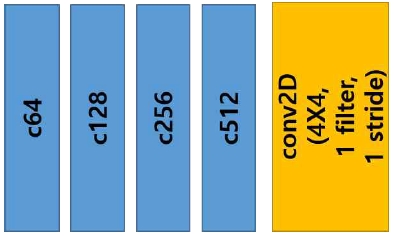

Discriminator 네트워크 구조는 그림 7과 같이 CycleGAN의 Discriminator 네트워크에 70x70 크기의 PacthGAN을[6] 사용하였으며, ck는 필터가 k개, 4x4 크기의 Stride가 2인 Convolution-InstanceNorm-LeakyReLU 레이어이고, 마지막 레이어는 출력이 1차원이 되도록 하는 Convolution layer이다.

이 연구에서의 CycleGAN은 Cycle consistency 손실에 특징(Feature) 단위로 비교하는 Perceptual 손실함수를 추가하여 생성되는 이미지의 품질을 개선하였다. 여기서 Perceptual 손실은 입력으로 주어지는 Real 이미지와 Reconstruct(Recon)된 이미지에 대하여 ImageNet 데이터 셋으로 학습되어 있는 VGG16 모델의[11] 4번째, 9번째, 16번째, 23번째 층에서 각각 Real 이미지와 Recon 이미지의 특징 간의 MSE(Mean Squared Error)를 계산한 값들의 평균을 사용하였다.

Perceptual 손실함수는 인식 단위의 손실함수로서 이는 얼굴에서 의미 있는 특징 부위들을 개선하는 역할을 한다. 이를 적용하여 눈, 코, 입 등의 특징 부위들이 전반적으로 개선되는 결과를 얻을 수 있다. 표 1에서 (a)는 전처리만 적용한 학습 이미지로 학습한 모델이 생성한 이미지들의 예이고, (b)는 전처리를 적용한 학습 이미지에 Perceptual 손실함수를 추가하여 학습한 모델이 생성한 결과 이미지들이다. 눈, 코, 입 등의 특징 부위와 얼굴의 볼 등이 전반적으로 더욱 선명하게 생성된 결과를 확인할 수 있다.

IV. 실험 및 결과

4-1 실험 데이터

실험에서는 CASIA(Chinese Academy of Sciences, Institute of Automation) NIR-VIS 2.0 얼굴 데이터를[12] 사용했다. 여기에는 NIR 얼굴 이미지와 VIS 얼굴 이미지가 포함 있으며 대부분 동양인 얼굴들이며, CASIA 데이터의 구성은 표 2와 같다. NIR에 655명의 Subject, VIS에 534명의 Subject로 구성되어 있으며, 이 중 NIR과 VIS에 모두 참여한 Subject는 530명이다. 여기서 Subject는 데이터 수집에 참가한 인원 수를 의미하며, 각 Subject 당 이미지의 최소 및 최대 장수는 표 2와 같다.

4-2 정성적 평가

비교에 사용한 CycleGAN 모델은 입력 이미지로서 얼굴 정렬만 적용한 모델 (이하 A모델), 본 논문에서 제시한 얼굴 정렬과 히스토그램 평활화의 전처리를 모두 적용한 모델 (이하 B모델), 그리고 논문에서 제안한 전처리를 적용하고 Perceptual 손실함수를 추가한 모델 (이하 C모델)의 세 종류로 구성하였다. 이 모델들을 학습할 때 데이터가 특정 인물에 대해 편향되지 않도록 이미지 수를 각 Subject 당 3장 이상 8장 이하가 되도록 랜덤하게 선택한다. 이를 통해 VIS에서 2,966장 (533 Identities), NIR에서 4,301장을 (655 Identities) 사용하였다. 여기서 Identity는 Subject와 같은 의미로서 얼굴인식 ID로 생각하면 된다. 또한, VIS 534 Subject 중에서 이미지 수가 한 장밖에 없는 Subject를 제외하여 533 Subject 2,966장을 사용하였다.

표 3의 결과에서 볼 수 있듯이 얼굴 정렬만 적용한 A모델은 세 번째, 네 번째 입력 이미지와 같이 명암 대비가 적으면 생성된 이미지가 선명하지 않고 흐리게 보이지만, 히스토그램 평활화를 적용하여 이미지의 명암 대비를 개선한 B모델과 C모델은 생성된 이미지에서 얼굴의 그림자도 자연스럽게 나타나는 것을 확인할 수 있다. 또한 B모델에 Perceptual 손실함수를 추가한 C모델은 B모델과 비교했을 때 눈, 코, 입 등의 얼굴의 주요 특징들이 더욱 선명하고 자연스럽게 생성된 것을 확인할 수 있다. 제안한 방법으로 생성한 NIR 이미지 결과가 NIR 카메라로 취득한 진짜 NIR 이미지와 전반적으로 상당히 유사함을 정성적으로 확인할 수 있다.

4-3 정량적 평가

가짜(Fake)로 생성한 NIR 이미지들이 부족한 학습 데이터를 보완할 수 있는지를 확인하기 위해서 이 데이터들을 학습에 포함하여 만든 얼굴인식 모델로 인식 결과를 비교하였다. CASIA 데이터 셋은 개인마다 식별 번호가 지정되어 있어서 이 번호를 얼굴인식 ID로 사용하였다.

CASIA의 VIS 이미지 셋과 NIR 이미지 셋에 모두 존재하는 전체 530명 중 이미지 수가 적은 10명을 제외하고 520명을 선정하여 Real NIR 이미지 중 6,456개를 학습에 사용하고, 2,889개를 테스트 데이터로 사용하였다. 또한, VIS 이미지 2,924개를 A모델, B모델, C모델에 각각 입력하여 생성한 가짜(Fake) NIR 이미지를 학습데이터에 추가하여 A, B, C모델에서는 전체 9,380개를 학습데이터로 사용하였다.

얼굴 인식기는 CASIA webface dataset[13]으로 학습되어 있는 Inception-ResNet-v1의[13] 파라미터를 전이(Transfer) 학습하여 사용하였고, 표 4와 같이 네 종류의 학습 데이터로 네 개의 모델(Real 모델, A′모델, B′모델, C′모델)을 학습시켰다.

표 5의 결과에서 Real 모델의 인식 정확도는 95.12%로서 인식성능이 좋다고 할 수 있지만, C′모델의 인식 정확도가 96.23%로 가장 높은 것을 확인할 수 있다. 따라서 논문에서 제안한 방법으로 생성한 가짜 데이터를 학습에 포함하여 사용했을 때 인식성능을 높이는 데 도움이 된 것을 확인할 수 있었다.

V. 결 론

이 연구에서는 CycleGAN을 이용하여 NIR(근적외선) 얼굴 이미지를 생성하여 이를 학습에 추가하여 사용하였을 때, 즉 부족한 학습 데이터에 가짜로 생성한 데이터를 추가하여 학습할 때, 얼굴인식 성능이 개선된 것을 확인하였다. 이 과정에서 간단한 이미지 전처리와 특징 기반의 Perceptual 손실함수를 추가하는 것이 생성한 얼굴 이미지의 품질 개선에 도움이 된다는 것도 확인하였다.

논문에서 제안한 방법은 조명 변화에도 안정적인 얼굴 인식기를 만드는 데 사용할 수 있으며, 현재는 동양인 얼굴만 포함된 데이터를 사용하였지만 다양한 인종이 혼합된 데이터를 사용하여 지역에 상관없이 조명 변화에 강인한 얼굴 이미지를 생성할 수 있는 시스템 개발로 확장할 수 있을 것이다. 또한, 극심한 고통을 포함하는 다양한 얼굴 표정 인식을[14] 위한 얼굴 데이터 생성에도 제안한 방법을 개선하여 활용하고자 한다.

Acknowledgments

본 연구는 한국연구재단의 지원으로 이루어진 연구로서 (No. NRF-2017R1D1A1B04035633) 관계부처에 감사드립니다.

참고문헌

-

S. Z. Li, R. Chu, S. Liao and L. Zhang, “Illumination invariant face recognition using near-infrared images”, IEEE Transactions on Pattern Analysis and Machine Intelligence 29(4), pp. 627-639, 2007

[https://doi.org/10.1109/TPAMI.2007.1014]

- H. Wang, L. Wang, X. Yang, L. Yu and H. Zhang, “Facial Feature Embedded CycleGAN for VIS-NIR Translation”, https://arxiv.org/pdf/1904.09464.pdf, , 2019

- I. Goodfellow and J. Pouget-Abadie, “Generative adversarial net”, Advances in Neural Information Processing Systems, pp. 2672–2680, 2014

- J. Y. Zhu and T. Park, “Unpaired image-to-image translation using cycle-consistent adversarial networks”, IEEE International Conference on Computer Vision, pp. 2223-2232, 2017

-

J. Johnson, A. Alahi and Fei-Fei Li, “Perceptual losses for real-time style transfer and super-resolution”, The 14th European Conference on Computer Vision, pp. 694-711, 2016

[https://doi.org/10.1007/978-3-319-46475-6_43]

-

P. Isola, J. Y. Zhu, T. Zhou and A. A. Efros, “Image-to-image translation with conditional adversarial networks”, IEEE Conference on Computer Vision and Pattern Recognition, 2017

[https://doi.org/10.1109/CVPR.2017.632]

-

V. Kazemi and J. Sullivan, “One Millisecond Face Alignment with an Ensemble of Regression Trees,” IEEE Conference on Computer Vision and Pattern Recognition, pp. 1867~1874, 2014

[https://doi.org/10.1109/CVPR.2014.241]

- R. Dorothy, R. Joany, R. Rathish, S. Prabha and S. Rajendran, “Image enhancement by Histogram equalization”, International Journal of Nano Corrosion Science and Engineering 2(4), 21-30, 2015

- https://github.com/bytefish/facerecognition_guide/blob/master/src/py/crop_face.py, , April 11, 2012

- K. He, X. Zhang, S. Ren and J. Sun, “Deep residual learning for image recognition”, IEEE Conference on Computer Vision and Pattern Recognition, 2016

- S. Karen and A. Zisserman, "Very deep convolutional networks for large-scale image recognition." arXiv preprint arXiv:1409.1556, , 2014

-

Li, Stan, et al. "The casia nir-vis 2.0 face database." IEEE conference on computer vision and pattern recognition workshops, 2013

[https://doi.org/10.1109/CVPRW.2013.59]

- D. Yi, Z. Lei, S. Liao and S. Z. Li, “CASIAWebface: Learning Face Representation from Scratch”, arXiv:1411.7923, , 2014

-

M. Ki and Y. Choi, “Extreme Pain Detection based on Human Facial Expressions”, Journal of Digital Contents Society, Vol. 21, No. 2, pp. 415-422, Feb. 2020

[https://doi.org/10.9728/dcs.2020.21.2.415]

저자소개

2020년 : 숙명여자대학교 컴퓨터과학과 (학사)

2020년~현 재: 삼성 SDS

※관심분야: 머신러닝(ML), 얼굴인식(Face recognition) 등

1985년 : 연세대학교 전자공학과(학사)

1986년 : University of Southern California 컴퓨터공학과(석사)

1994년 : University of Southern California 컴퓨터공학과(박사)

1994년~1997년: LG전자기술원 선임연구원

1997년~현 재: 숙명여자대학교 컴퓨터과학과 교수

※관심분야:인공지능(AI), 머신러닝(ML), 영상처리(IP), 지능형자동차(IV) 등