화면 상의 글자 움직임에 대한 청각 장애인의 비언어적 정보 인식 – 목소리의 음성 정보와 감정 정보를 기준으로

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

청각장애인은 말소리에서 느껴지는 비언어적 정보를 인식하기 어려우며, 이러한 말소리와 글자 간의 간극으로 인해 글자에 대한 흥미를 갖기 어렵다. 이와 같은 어려움을 인식하고 본 연구에서는 시각적 자극에 대한 말소리의 정보 인식을 알아보고자 하였다. 말소리의 특징을 시각적으로 묘사한 여러 글자의 움직임, 즉 키네틱 타이포그래피를 보여주고 이에 대한 청각장애인의 반응을 심층 조사하였으며 말소리의 음성과 감정 정보를 어떻게 인식하는지 알아보았다. 조사 결과로 청각장애인은 각기 다른 글자 움직임을 통해 목소리 간의 음성과 감정 차이를 분명히 인식할 수 있으며 여러 키네틱 타이포그래피 표현 중 목소리의 높고 낮음에 대한 글자의 수직적 위치 변화에서 음성 정보와 감정 정보를 가장 정확히 인식한다고 나타났다.

Abstract

Due to a difficulty in recognizing non-verbal information of a human voice, hearing impaired people feel a great gap between vocal and written language which results a lack of interest in letters. While recognizing this difficulty, this research aims to investigate on acquisition of a vocal information through visual stimulation. In-depth interview with hearing-impaired people has been proceed on acquiring auditory and emotional information after watching various expressions of kinetic typography, which visually describe different characteristics of a voice. The result came out as following; Hearing impaired people was clearly able to recognize differences in both auditory and emotional information. Moreover, they were able to distinguish different voice pitches from vertical movements of a letter most accurately among various expressions of kinetic typography.

Keywords:

Hearing-impaired people, Kinetic typography, Movement of letters, Non-verbal information, Voice키워드:

청각장애인, 키네틱 타이포그래피, 글자 움직임, 비언어적 정보, 목소리Ⅰ. 서 론

1-1 연구배경

사람들 간의 원활한 의사소통에 영향을 미치는 주 원인은 목소리와 표정, 태도와 같은 비언어적 요인들이며 이 중 목소리가 가장 큰 비중을 차지한다[1][2]. 이에 반해 목소리에 내재된 비언어적 정보를 거의 알아차리지 못하는 청각장애인의 경우 이를 대체하는 가장 보편적인 수단으로 모바일 폰이나 컴퓨터 상에 나타나는 문자를 사용한다[3].

온라인 상의 문자를 주요 소통 매체로 사용하고 있음에도 불구하고 청각장애인은 일반인에 비해 언어와 글자 사이의 간극을 더욱 크게 느낀다[4]~[6]. 이는 말소리와 글자 간의 연관성을 이해하기 어려운 이유이며 결과적으로 글자를 습득하고 사용하는데 많은 한계에 부딪힐 수 밖에 없다[5][7]. 문자에 대한 이해를 높이고 이를 일상생활에서 더욱 유연하게 사용하기 위해서는 일반인들이 대화 상에서 느낄 수 있는 정서적인 면을 경험할 수 있어야 한다. 청각장애인이 글자를 접할 때 목소리 톤이나 어투에서 느껴지는 감정과 같은 비언어적 정보를 인식할 수 있다면 글자에 대한 심리적 거리감이 줄어들고 흥미가 높아질 것으로 예상된다.

한편 타이포그래피는 글자를 시각적으로 응용하여 단순 읽기만이 아닌 보고 느끼는 부분까지 확장케 하는 분야이다[8]. 이같이 타이포그래피는 글자를 사용하여 비언어적 정보 전달이 가능한 분야로 글자 사용 환경을 더욱 흥미롭고 윤택하도록 돕는데 적합하다고 여겨진다. 특히 일반인에 비해 청각장애인은 시각 자극에 대한 감정 반응이 더욱 예민하게 나타나므로[9]~[11] 말소리에서 느껴지는 비언어적 정보를 전달하는데 매우 효과적일 것으로 예상된다. 이러한 점에도 불구하고 현재 타이포그래피 분야에서는 청각장애인을 대상으로 한 연구를 거의 찾아보기 어려운 실정이다.

청각장애인들은 일반인들과 다른 지각, 인지적 어려움이 있으므로 이들을 대상으로 한 타이포그래피 분야 연구가 단독적으로 진행되어야 하며, 이에 앞서 청각장애인들이 글자의 움직임과 같은 시각 자극만으로 말소리에서 느껴지는 비언어적 정보를 인식할 수 있는지 알아보아야 한다. 이를 위해서는 오늘날의 디지털 환경에 알맞도록 스크린 상에서 목소리의 특징을 구현하는 방법에 초점을 맞추는 것이 바람직하며 화면 상의 글자 움직임에 대한 반응을 알아보아 이후 타이포그래피 연구에 대한 기반을 마련하는 것이 시급하다.

1-2 연구목적

본 연구는 화면 상의 글자 움직임에 대한 청각장애인의 비언어적 정보 인식에 대해 알아보는데 그 목적이 있다. 말소리에서 느껴지는 비언어적 정보는 음성 정보와 감정 정보 두 가지로 나누었으며 다음과 같이 알아보았다. 첫째, 화면상의 글자 움직임을 통해 목소리의 음성 정보를 인식할 수 있는지, 인식 가능할 경우 이에 대한 특정 음성 정보는 무엇인지 알아본다. 둘째, 화면 상의 글자 움직임을 통해 목소리의 감정 정보를 인식할 수 있는지, 인식 가능한 경우 이에 대한 특정 감정 정보는 무엇인지 알아본다. 나아가 다양한 글자의 움직임 중 음성 정보와 감정 정보를 전달하는데 관련이 있는 글자의 움직임에는 무엇이 있는지 제시한다.

1-3 연구방법

본 연구는 문헌연구, 청각장애인의 읽기 환경에 대한 농학교 교사 인터뷰, 글자 움직임에 대한 청각장애인의 반응 조사로 전개된다.

문헌고찰을 통해 말소리에 내포된 비언어적 정보에는 무엇이 있는지 알아보고, 글자를 사용하여 비언어적 정보를 시각적으로 구현 할 수 있는 타이포그래피에 대해 알아본다. 또한 청각장애인의 문자 사용에서 오는 어려움과 글자 교육, 사용 환경에 대하 살펴본다.

이후 농아학교 국어 교과목을 담당하는 교사 인터뷰를 진행하여 선행연구에서 명시되었던 청각장애인의 문자 교육과 비언어적 정보 습득 방법에 관해 더욱 현실적, 구체적으로 알아본다. 이를 통해 디지털 환경에서 글자 사용의 중요성과 의사 소통 상에서 비언어적 정보 인식의 필요성을 조명한다.

마지막으로 화면상의 글자 움직임에 대한 청각 장애인의 비언어적 정보 인식을 조사한다. 목소리의 음성적 특징을 화면상에 구현한 글자의 움직임을 보여준 후 이에 대한 청각장애인의 반응을 인터뷰하여 말소리에서 느껴지는 톤, 즉 음성 정보와 감정 정보 인식에 대해 알아본다. 또한 정보 인식에 영향을 미치는 글자 움직임의 특성에 대해서도 구체적으로 조사하여 청각장애인이 타이포그래피를 활용한 시각 자극에 의해 말소리의 비언어적 정보를 구체적으로 습득할 수 있는지 살펴보고자 한다.

Ⅱ. 말소리에 내포된 비언어적 정보

의사 소통에 있어 목소리, 표정, 태도와 같은 비언어적 표현 방법이 중요한 역할을 하며 이 중 목소리는 가장 큰 비중을 차지한다[1][2]. 반면 실제 메시지 내용의 경우 7%의 영향만을 미친다[1]. 청각장애인의 경우 목소리에서 얻어지는 정보의 양이 매우 적거나 없고 주로 문자를 사용하여 소통을 하기 때문에 정서적 교류나 구체적 의사 전달이 어려울 것으로 여겨진다. 이 장에서는 목소리의 비언어적 정보인 음성 정보에는 무엇이 있는지 알아보고 이러한 목소리의 음성 정보가 감정을 인식하는데 미치는 영향에 대해 알아본다.

2-1 음성 정보

소리는 음의 높고 낮음을 나타내는 음고(pitch), 길고 짧음을 나타내는 장단(duration), 음의 세고 약함을 나타내는 음량(loudness), 음의 특색을 결정짓는 음색(timbre), 여러 개의 음이 섞여 있을 시 서로 다른 음들 간의 상호작용(sonic texture), 주변 환경에서 감지하는 소리의 위치(spatial location)와 같은 6가지 요소로 구성되며, 오랜 시간 동안 이러한 하위 요소를 기준삼아 소리의 특징을 해석해왔다[12].

음색(timbre)은 노래나 악기에서 오는 음악적 사운드를 주로 지칭하므로[13] 목소리 구성 요소로 보기에는 적합하지 않아 본 연구에서 제하기로 한다. 또한 서로 다른 음들 간의 상호작용을 나타내는 음질(sonic texture)과 공간적 맥락에서 음을 해석하는 공간위치(spatial location)는 하나의 목소리에 집중하여 이를 시각적으로 표기하는데 초점을 맞춘 본 연구와 관련이 없다. 결과적으로 사람의 목소리와 관련 있는 요소로는 음고, 장단, 음량, 세 가지로 나누어볼 수 있으며 각 요소에서 나타나는 음성적 차이로 인해 각기 다른 목소리 톤이 형성된다. 이같이 목소리에 담긴 음성적 정보는 음고, 장단, 음량과 같은 하위 요소로 구분지어볼 수 있으며 이를 기준으로 각기 다른 목소리의 특징을 높이의 정도, 길이의 정도, 세기의 정도로 해석할 수 있다.

2-2 감정 정보

목소리 하위 구성 요소인 음고, 장단, 음량의 변화를 기준으로 목소리의 음성적 특징을 인식할 수 있으며 나아가 다양한 감정을 인식할 수 있다. 목소리의 하위 구성요소와 감정 간의 밀접한 연관성은 다음의 연구결과를 통해 살펴볼 수 있다.

하보미, 허명진은 화자의 음도, 속도, 강도 정도에 따라 각기 다르게 나타나는 감정에 대해 알아보았다[14]. 목소리가 높아질수록 ‘활발하다’, ‘힘이있다’와 같은 긍정적 감정을 주로 느꼈으며 낮을수록 ‘담담하다’, ‘무뚝뚝하다’와 같은 정적인 감정을 느꼈다. 말의 속도가 느릴 경우 ‘느긋하다’, ‘부드럽다’, ‘자상하다’의 감정을, 빠를 경우 ‘성질이 급하다’와 같은 감정을 주로 느꼈다. 또한 목소리가 클수록 ‘힘이있다’, ‘딱딱하다’와 같은 감정이, 작을수록 ‘부드럽다’, ‘자상하다’, ‘느긋하다’와 같은 감정이 주를 이루었다. 이같이 목소리의 음고가 높고 음량이 클수록 더욱 동적인 감정을, 음고가 낮고 음량이 작을수록 정적인 감정을 느꼈다. 영어를 사용하는 문화권에서도 이와 유사한 연구 결과를 볼 수 있다. 목소리가 강도가 높을수록 강한 에너지(intense energy)와 연관된 감정을 인식하며, 강도가 약할수록 약한 에너지(soft energy)와 관련 있는 감정을 인식하였다. 또한 목소리가 커지고 높아질 시에 분노를, 목소리가 눈에 띄게 높아지고 단어마다 공백이 있을 시에 긴장감이나 두려움을 느꼈다[15]. 이러한 연구 결과를 통해 목소리 구성 요소에 따라 감정적 정보가 매우 다르게 인식된다는 것을 알 수 있다.

이외에도 목소리의 구성 요소는 감정 정보 전달을 하는데 있어 각기 다른 영향을 미친다는 것을 볼 수 있다. 특히 억양의 변화는 화자가 느끼는 감정에 많은 영향을 미치며 의사소통 전반에 미치는 영향 또한 매우 크다[16]. Smith 도 준언어학적 요소 중 음도, 속도, 쉼, 음질 등이 의사소통 상황에서 매우 큰 역할을 하는 요인이며 이중 높은 음도, 중간 정도의 말속도가 긍정적인 이미지 형성에 영향을 미치는 것으로 나타났다[17]. 황보명, 한의진은 말소리의 억양이 감정 전달에 큰 영향을 미친다고 주장하였다[18]. 감정의 농도가 강하게 느껴지는 말소리는 보편적으로 높이가 높고 높낮이의 변화가 급격해지는 특징이 있으며 부드러운 감정을 느끼는 말소리에서는 높낮이의 변화가 비교적 원만한 특징을 발견하였다. 이같이 목소리의 하위 구성 요소는 감정 전달에 각기 다른 영향을 미치며 이중 음고의 높고 낮음과 변화의 폭은 감정 정보를 인식하는데 밀접한 관련이 있음을 알 수 있다.

Ⅲ. 시각 정보에 대한 비언어적 정보 인식

청각장애인은 목소리의 음성과 감정 인식이 어려우므로 일반인에 비해 의사 소통에서 느끼는 비언어적 정보가 단조롭다는 어려움이 있다. 일반인들과의 의사소통에 있어 문자나 음성인식 자막 서비스를 빈번히 사용[3]하므로 문자를 통해 청각장애인이 의사소통과정에서 놓치기 쉬운 감성적 정보를 직관적으로 전달하는 방법을 간구해야 한다. 타이포그래피는 글자와 관련한 시각적인 뉘앙스와 그 연출을 통해 언어를 어떻게 전달할 것인가를 고민하는 영역1)으로 단순 읽기를 통한 정보 전달을 넘어 정서적 교감이 가능한 분야이다. 이 장에서는 타이포그래피 기반의 작업물에서 볼 수 있는 비언어적 정보 전달 방법에 대해 살펴보고 시각 정보에 대한 청각장애인들의 정보 인지 특성에 대해 알아보고자 한다.

3-1 타이포그래피 작업물에서의 비언어적 정보 인식

글자는 형태와 의미가 결합된 결정체로써 보기 위한 형태, 읽기 위한 형태라는 양면성2)이 있으며 단순 정보 전달 뿐 아니라 시각적인 응용이 가능하다는 특성이 있다. 이현주는 여러 형태의 글꼴에 대한 사용자 감성 반응을 알아보았는데 글꼴에서 나타난 형태적 특징에 따라 텍스트를 더욱 흥미롭게 느끼거나 주의를 더 기울이기도 하는 등의 감성 반응이 나타난다는 연구 결과를 제시하였다[19]. 이같이 글자 자체의 형태만으로도 각기 다른 감성 반응을 관찰할 수 있으며 글자 크기, 배치, 움직임과 같은 보다 적극적인 변화를 통해 더욱 복잡하고 구체적인 비언어적 정보 전달이 가능하다.

1990년대 나타난 타이포그래피 표현 양식 중 안상수, 601비상의 편집물에서는 소리의 크기나 운율을 표현하기 위해 글자 크기나 배치를 활용하였다. 안상수의 “보고서 보고서”는 글자를 활용한 다양하고 실험적 표현을 선도하였는데 Fig. 1에서와 같이 띄어쓰기와 마침표를 반복적으로 사용하여 텍스트 간의 연결성을 볼 수 있다. 반면 글자와 배경 색상을 반복적으로 반전시켜 내용 간 경계를 두었다. Fig. 2에서와 같이 601비상은 글자의 크기 대비를 활용하여 소리의 강약과 감정의 기복을 표현하였다.

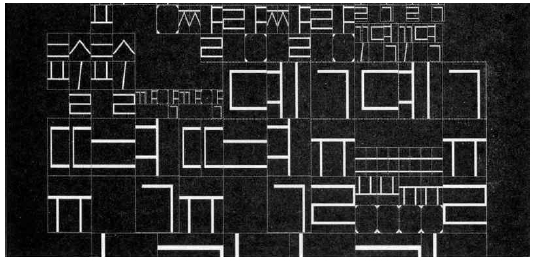

2000년대 들어서는 디지털 매체를 활용한 키네틱 타이포그래피 작업물이 다수 나타났다. 키네틱 타이포그래피는 글자의 움직임을 조작한 디스플레이를 의미하는데[20], 이는 언어의 음절·단어·문장을 단계별로 표현하는데 알맞으며 소리 크기나 박자, 속도 등을 표현하기에 적합하다[9]. 노승관은 실제 사람의 움직임에 맞추어 글자 움직임과 속도가 변화하도록 알고리즘을 설계, 도시 속 리듬감과 속도감을 표현하였다[21]. Fig. 3에서와 같이 그리드의 틀 안에서 자모 조합 규칙을 도입하였으며 이를 바탕으로 가장 기본 단위인 음소부터 음절, 단어에 이르기까지 글자 단위별로 세밀한 규칙을 설정하여 움직임을 설계하였다.

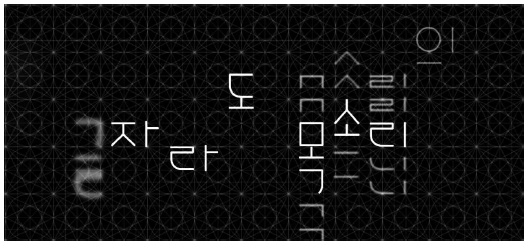

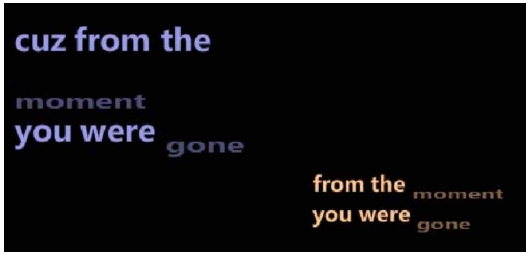

하주현은 디지털 매체를 사용하여 시간에 따른 목소리 변화를 글자의 움직임으로 표현하였다[22]. Fig. 4에서와 같이 목소리의 특징을 음고, 장단, 음색으로 구분하여 각기 다른 목소리를 표기하는 규칙을 설정하고 이를 글자 움직임에 적용하였다. 화면 상의 글자 움직임을 바탕으로 목소리의 톤과 감정을 표현하였으며 전문가 조사 결과를 통해 글자의 움직임만으로도 말소리에서 느끼는 비언어적 정보를 일부 전달할 수 있다는 가능성을 제시하였다. 이러한 연구 결과는 소리를 시각화한 글자의 움직임만으로 말소리의 비언어적 정보를 전달하는 것이 가능하다는 것을 보여주었다.

여러 타이포그래피 작업물에서 볼 수 있듯, 타이포그래피는 의미와 사고가 조형적으로 결합된 상태로써 언어와 비언어적 정보를 시각적 형태로 변환하여 전달하는 분야이다[23]. 특히 키네틱 타이포그래피는 디지털 시대에 글자를 통한 경험을 정서적 영역까지 확장하며 말소리에서 오는 변화를 더욱 유동적으로 표현할 수 있는 영역이다. 글자를 인식하는 언어적 소통과 감정을 느끼는 비언어적 소통이 동시에 가능하므로 여러 겹의 정보를 직관적으로 전달하는데 매우 적합하다고 볼 수 있다. 특히 일반인에 비해 디지털 화면 상의 시각 정보에 더욱 많이 의존하는 청각장애인[3]에게는 보다 생동감 있는 의사 소통 수단으로 매우 유익하게 활용될 수 있는 가능성을 보여준다.

3-2 디지털 화면 상에서의 청각장애인의 비언어적 정보 인식

인간의 전 감각 중 시각은 70~80%을 차지하며 일상생활에서 가장 많은 정보 처리를 담당한다[24]. 청각장애인의 경우 청각을 담당하는 뇌의 부분이 시각을 지각하는 영역으로 확장[10]되며 일반인에 비해 시각 정보를 더욱 예민하고 빠른 속도로으로 습득한다[25].

이재명은 긍정적, 부정적 감정을 표현한 글자 움직임을 청각 장애인과 일반인에게 동시에 보여준 후 이들의 반응을 조사하였다[9]. 청각장애인은 일반인에 비해 글자의 움직임에서 느끼는 감정의 정도가 매우 높았으며 긍정적 감정과 부정적 감정 간의 차이 또한 크게 느끼는 것으로 나타났다. 또한 청각장애인은 일반인에 비해 시각적 자극에 감정적으로 더욱 크게 동요하는 것으로 나타났으며, 이러한 연구 결과에 비추어 볼 때 청각 장애인은 시각물을 활용한 비언어적 정보 전달을 하는데 매우 효과적인 대상일 것으로 예상된다. 해외에서는 청각장애인을 대상으로 한 감성적 자막 연구가 진행되었다. Mori와 Fels는 청각장애인을 대상으로 노래 가사의 특징을 시각적으로 표현, Fig. 5에서와 같이 음악에서 느낄 수 있는 청각 정보를 글자 크기와 비율, 배치, 색상, 움직임과 같은 변화를 통해 표현하였다[26]. 청각장애인은 글자의 시각적 변화를 통해 음악에서 느낄 수 있는 감정 중 일부를 인식하였으며 나아가 글자의 시각적 표현에 대해 큰 흥미를 느꼈다. 이와 같이 타이포그래피는 소리에서 느낄 수 있는 음성 정보를 시각적으로 전달 할 수 있는 유용한 도구로 사용될 수 있다.

Bola 외는 청각장애인과 일반인이 시각물을 지각하는 과정을 관찰하였으며 이들의 두뇌 활동이 확연히 다르다는 것을 발견하였다[10]. 청각장애인의 경우, 시각 자극을 인식하는 과정에서 청각을 담당하는 두뇌 피질이 활성화되는 특이한 과정을 거쳤다. 이러한 청각과 시각 간의 기능적인 연결은 일반인에게서는 나타나지 않았으며 청각장애인에서만 한정적으로 나타났다. 이외에도 Finney 외는 청각장애인에게 화면 상에 나타난 점(dot)의 움직임을 시각 자극으로 제시하고 이를 바라보는 청각장애인의 뇌 활성도를 fMRI를 통해 관찰하였으며 다음과 같은 연구 결과를 제시하였다[11]. 청각장애인이 시각 자극을 인식할 시에 일반적으로 청각 정보를 담당하는 뇌 일부분이 시각 정보를 받아들이는 부분으로 활성화되는 감각 교차 지각(cross modal perception) 현상이 나타났다. 이 같은 연구 결과는 청각장애인이 일반인과는 다른 지각 체계를 가진다는 것을 증명하는 동시에 소리를 듣는 뇌 세포로 시각 정보를 인식하는 능력, 다시 말해 시각 정보를 통해 소리를 듣는 것이 가능하다는 것을 보여준다[27].

청각 장애인의 시각 감각은 일반인에 비해 더욱 활성화 되어 있으며 이러한 감각적 특성으로 인해 시각 정보 전달이 매우 효과적일 것으로 예상된다. 말소리를 시각화 한 타이포그래피를 시각 자극으로 활용한다면 대화 상에서 느낄 수 있는 비언어적 정보, 즉 말소리의 톤이나 감정에 대한 인식이 원활할 것이다. 이러한 방법은 시각적 지각이 청각 피질까지 확장되어 나타나는 청각 장애인에게 청각 상에서 느낄 수 없는 정보를 제공하고 소리를 볼 수 있는 기회를 제공할 것으로 기대된다.

Ⅳ. 청각 장애인과 글자

수화는 청각장애인이 자신의 생각이나 감정을 표현하는데 사용하는 가장 보편적인 수단이다[3]. 또한 얼굴의 표정이나 입모양으로 상대방의 기분이나 간단한 의미를 추측하기도 한다. 하지만 이러한 방식은 건청인과의 원활한 의사소통을 하는데 어려움이 있으며 사회의 일원으로 살아가는데 한계가 있다. 반면 글자는 청각장애인이 건청인들과 의사소통을 하는데 매우 중요한 역할을 하며 특히 디지털 기기 상의 문자 소통은 현대 사회에서 가장 보편적인 커뮤니케이션 수단이다[3].

이 장에서는 청각장애인의 글자 인식과 이들이 느끼는 어려움에 대해 초점을 맞춘다. 또한 서울 소재의 농학교 전공과 국어 교사와의 심층 인터뷰를 통해 글자 사용 환경과 글자 교육 현장에 대한 보다 현실적인 상황을 파악하였다.

4-1 글자 인식의 어려움

청각장애인은 일반인에 비해 말소리 인식이 매우 어렵기 때문에 소리와 글자 간의 관계성을 이해하는데 어려움을 겪는다[4][5]. 이들에게는 언어를 습득하는 것이 자연스럽고 흥미로운 과정이 아닌 제2 외국어를 배우는 것과 같이 부자연스럽고 낯설은 과정으로 접하게 된다[6].

Morford는 말소리를 들을 수 있는 건청인과 청각장애인을 대상으로 의미적으로 관련 있는 단어를 선택하는 조사를 진행하였다[6]. 건청인의 경우 청각장애인에 비해 단어를 더욱 정확하게 찾았으며 특히 소리가 서로 유사한 단어의 경우 이러한 차이가 더욱 뚜렷하게 나타났다. 이와 같이 글자와 소리를 서로 연관시킬 수 있는 능력은 글자를 인식하는데 큰 영향을 미친다. 청각장애인은 말소리와 글자 간의 상관관계를 온전히 이해하기 어렵기 때문에 글자를 접할 시 심리적 거리감을 느낄 수 밖에 없으며 많은 경우 이러한 부정적 경험이 배움의 좌절로 이어지며 글자 교육에 큰 어려움을 야기한다[4].

성인 청각장애인의 읽기 수준은 일반인에 비해 매우 낮게 나타나는데 평균적으로 영어권의 경우 고등학교 3학년 청각장애인의 읽기 능력이 만9세 아동의 수준과 같으며 우리나라의 경우 초등학교 4학년 수준과 같다[28]. 앞장에서 언급한 바와 같이 청각장애인은 시각 자극에 대한 반응이 일반인에 비해 빠르고 시각적 두뇌 활성도가 높다[25]는 지각상의 특이점이 있다. 이들은 글자를 읽지 않고 보는 방식으로 인식하기 때문에[6] 일반인과 차별된 방식으로 문자를 제시해야 하는 것이 알맞다.

4-2 글자 사용 현황

교사 인터뷰를 통해 청각장애인이 일상생활에서 접하는 글자 사용 환경과 글자 교육 현장에 대해 알아보았다. 청각장애인이 가장 보편적으로 사용하는 의사 소통 방법은 스마트폰 상의 문자 서비스이다. 이밖에도 스마트폰 앱을 활용하여 영상 통화 기능을 사용하기도 한다. 최근에는 청각장애인의 의사 소통을 지원하는 스마트폰 어플리케이션과 소프트웨어가 다수 출시되었는데 음성 인식 어플리케이션 중 구글과 국내 기업에서 개발한 소보로가 주로 사용된다. 이러한 소프트웨어는 목소리를 인식하여 화면 상 문자로 표기하는 방식으로 글자의 원활한 읽기 기능을 전제로 한다.

일상의 각종 생활 정보는 주로 TV나 컴퓨터 디지털 화면 상에서 접하는 이미지와 문자를 통해 얻는다. 하지만 한국어 문장 이해력이 낮을 시 자막으로 인한 의사 소통이 어려우므로 읽기가 미숙한 경우 제한이 있을 것으로 예상된다. 여가, 문화 생활 또한 글자 읽기에 많은 의존을 하게 되는데 자막 제공이 되는 티비 프로그램이나 영화의 경우 즐겨 시청한다. 국립국어원의 조사 자료에서 또한 디지털 화면 상에서의 글자 사용이 의사소통과 일상 정보 습득을 위한 주요 통로로 제시되었다[3].

청각장애인의 글자 교육 환경과 글자 사용 상에서 나타나는 특이점은 다음과 같다. 청각 장애가 있는 학생들의 글자 교육 자료로 시각적 자극을 활용한 영상 매체를 많이 사용한다. 이와 같은 교육용 자료는 인터넷을 통해 어렵지 않게 접할 수 있다. Fig. 6에서와 같이 주로 동화책이나 시를 접할시 수화와 글자, 배경 이미지가 삽입된 형태로 나타난다. 글자 자체에 흥미를 느끼지 못하는 학생들은 인쇄 매체에 비해 시각 자극이 풍부한 영상 매체를 더욱 선호하며 이러한 이유로 수업 환경에서 영상매체를 적극적으로 사용하는 편이다. 이같이 청각장애학생들은 복잡하고 긴 글보다는 짧고 간단한 글을 선호하며 여러 글자를 정독하는 것을 기피하는 어려움을 가지고 있다. 이를 보완하기 위해서는 읽기 수준을 향상시키고 글자 활용 범위를 확장할 필요가 있으며 다양한 읽기 매체를 통한 사전 문화 경험이 필요하다[28].

청각장애인은 말소리와 글자를 연관시키지 못하며 읽기에 대한 흥미가 건청인에 비해 떨어진다는 어려움이 있다[4]~[6]. 하지만 현재 청각장애인의 글자 교육이나 의사 소통을 지원하는 디지털 소프트웨어는 대부분 읽기 교육이나 음성 인식과 같은 기능적 부분에 초점을 맞추고 있으므로 글자에 대한 흥미와 정서적 측면을 지원하기 위한 목적의 연구 개발이 추가적으로 필요하다. 무엇보다도 글자를 통해 목소리의 톤이나 감정과 같은 비언어적 정보를 인식할 수 있다면 글자 자체에서 생동감과 재미를 느낄 수 있는 기회가 되며 글자를 대하는 인식 또한 변화할 것으로 기대된다.

Ⅴ. 화면 상의 글자 움직임에 대한 청각장애인의 비언어적 정보 인식

목소리 특징을 시각적으로 표현한 글자 움직임을 중심으로 청각장애인의 비언어적 정보 인식에 대해 알아보고자 하였으며 이를 위해 다음과 같은 방법으로 심층 인터뷰를 진행하였다.

목소리 톤이나 감정과 같은 비언어적 정보는 목소리를 구성하는 하위 요소인 음고, 장단, 음량과 밀접한 연관[14]~[16]이 있으므로 하위 요소로 나누어 조사를 진행하는 것이 바람직하다. 하주현은 Fig. 7에서 보는 바와 같이 목소리를 세가지 하위요소로 구분하여 소리의 크고 작음, 높고 낮음, 길고 짧음을 표현하였으며, 이러한 글자의 움직임이 일반인들에게 효과적으로 음성 정보와 감성 정보를 전달한다는 것을 증명하였다[22].

이와 같이 Fig. 7의 타이포그래피 영상물은 일반인을 대상으로 목소리의 비언어적 정보 전달 가능성을 검증받은 자료로써 청각장애인을 대상으로 비언어적 정보 전달 여부를 알아보는데 적합한 조건을 갖추었다고 판단하였다. 무엇보다도 언어의 음성적 특징을 묘사하여 목소리의 비언어적 정보를 전달할 수 있는 영상물은 일반인에 비해 시각 감각이 예민하고 문자 의존도가 높은 청각장애인에게 유용한 정보를 제공할 것이라 예상된다. 따라서 본 연구에서는 동일한 영상물을 사용하여 청각장애인의 음성 정보와 감정 정보 인식을 조사하고자 한다.

5-1 조사 방법

타이포그래피 영상물에 대한 청각장애인들의 음성적, 감정적 정보 인식에 대해 조사하였다. 조사에 참여한 청각장애인은 서울 소재의 농학교 전공과 재학생으로 소리를 전혀 못 듣는 심고도 난청인 한명과 매우 큰 소리에 한해 들을 수 있는 고도 난청인 한명이다.

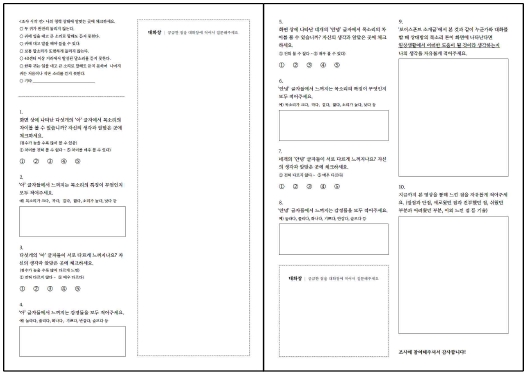

다양한 목소리의 특징을 시각적으로 표현한 글자의 움직임을 컴퓨터 스크린 상에서 보여준 후 이에 대한 음성 정보와 감정 정보의 인식에 대해 조사하였다. 일반인에 비해 읽기 능력이 저조한 조사 대상자가 어려움을 느끼지 않도록 화면 상에서 나타나는 글자의 수를 한 글자에서, 두 글자, 여러 개의 문장으로 늘려가는 방식으로 시각 자극을 구성하였다. 조사는 영상물에 대한 청각장애인의 반응을 개별적으로 알아보는 심층 인터뷰로 진행하였다. 5점 척도로 구성된 폐쇄형 질문과 이에 대한 심화된 의견을 물어보는 개방형 질문으로 Fig. 8과 같이 설문지를 구성하였다.

5-2 조사결과1: 음성 정보 인식

각기 다른 목소리를 시각화 한 다양한 글자 움직임을 보여준 후 화면 상에서 느껴지는 음성적 차이를 알아보았다. 구체적으로는 조사 대상자가 인식하는 음성적 정보에는 무엇이 있는지 알아보았다.

글자의 움직임을 보고 느낀 음성적 차이에 대한 조사 결과는 다음과 같다. 먼저 두 대상자 모두 글자의 움직임을 보는 동시에 음성적인 차이를 느꼈다. 글자 움직임 간의 차이를 5점 척도에 맞추어 조사했을시 한글자, 두글자, 문장 단위의 글자 움직임에서 음성적 차이를 느끼는데 ‘그렇다’와 ‘매우 그렇다’를 의미하는 4~5점이 나타났다. 이를 통해 청각장애인이 각기 다른 목소리를 시각적으로 표현한 화면 상의 글자 움직임에서 음성적 차이를 분명히 느낄 수 있는 것이 나타났다.

글자의 움직임에서 인식한 음성 정보에는 무엇이 있는지 알아보았다. 먼저 목소리 하위 구성 요소인 음고, 장단, 음량의 차이에 따라 음성적 정보를 다르게 인식하는 것으로 나타났다. 소리를 거의 듣지 못하는 심고도 난청인의 경우 소리의 높고 낮음을 가장 뚜렷하게 인식하였으며 짧고 긴 정도 또한 일부 인식 할 수 있었다. 이에 반해 목소리 크기 차이는 인식하지 못하였다. 소리를 미약하게나마 들을 수 있는 고도 난청인은 글자 움직임에서 큰소리와 보통 크기 목소리, 긴소리와 짧은 소리, 높은 소리와 낮은 소리 등 다양한 종류의 음성적 정보를 모두 인식할 수 있었다. 이같이 청각장애인은 목소리의 하위 요소들을 인식할 수 있었으나 잔존 청력이 있는 경우 음성 정보를 더욱 다양하게 인식할 수 있었다.

음성적 특징을 전달하는데 효과적이었던 글자의 움직임으로 두 조사대상자 모두 음의 높고 낮음을 나타내는 Fig. 7(left)의 양식을 꼽았다. 글자가 위, 아래로 이동하는 움직임에서 목소리의 특징을 가장 정확하고 분명히 느꼈다고 답하였다. 이와 같이 말소리의 특징을 나타내는 여러 글자 움직임 중 글자가 수직으로 이동하는 양식에서 특정 음성 정보를 가장 효과적으로 인식할 수 있었다.

5-3 조사결과2: 감정 정보 인식

음성 정보를 알아보는데 사용하였던 조사 방법을 동일하게 적용하여 청각장애인의 감정 반응을 알아보았다. 각기 다른 글자 움직임에서 감정적 차이를 느낄 수 있는지 질문하였으며, 보다 구체적으로는 이러한 차이를 인식할 시 느끼는 감정에 대해 살펴보았다.

글자 움직임을 보고 느낀 감정적 차이는 다음과 같다. 두 조사 대상자 모두 한글자, 두글자, 여러 문장 단위에 상관 없이 각기 다른 글자의 움직임에서 감정적 차이를 분명하게 느낀다고 답하였다. 감정적 차이를 느끼는 정도를 5점 척도로 조사했을 때 ‘그렇다’와 ‘매우 그렇다’를 의미하는 4~5점으로 답변하였다.

이에 반해 특정 감정을 인식하는데에는 한계가 있었다. 글자의 움직임을 통해 ‘반갑고 즐거운 감정’, ‘졸린 감정’, ‘놀란 감정’ 등을 느낀다고 답하였으나 반면 ‘기쁘다’와 ‘슬프다’의 감정을 어떻게 표현하는 것이 좋을지 모르겠다는 의견도 있었다. ‘기쁨’, ‘슬픔’과 같은 추상적 개념의 감정의 경우 목소리를 구현한 글자 움직임을 통해 전달하는데 한계가 있었던 것으로 여겨진다.

감정 정보를 전달하는데 효과적이었던 글자의 움직임은 다음과 같이 도출할 수 있다. 움직임이 적거나 느린 것에서 나른함, 피곤함을 느꼈으며 움직임의 폭이 크고 활발할수록 에너지가 높은 즐거운 감정, 놀란 감정을 느낄 수 있었다. 이와 같이 청각장애인은 글자의 특정 움직임에서 감정을 느끼기보다는 움직임의 정도에 따라 감정을 인식할 수 있으며 기쁨과 슬픔과 같은 추상적 개념보다는 물리적인 움직임과 연관된 감정을 주로 느낀다는 것을 알 수 있다.

Ⅴ. 결론

6-1 연구의 시사점

본 연구를 통해 청각장애인이 목소리를 시각적으로 표현한 영상물을 접하였을 시 목소리의 음성 정보와 감정 정보를 인식할 수 있는지, 인식한 정보에는 무엇이 있는지, 나아가 정보 인식을 돕는 글자의 움직임은 무엇인지에 대해 알아보았다. 조사 결과를 바탕으로 앞서 제안한 연구 목적에 대한 결론을 다음과 같이 정리하였다.

첫째, 청각장애인은 화면 상의 글자 움직임을 통해 각기 다른 목소리의 음성적 특징을 분명히 인식하였다. 이 중 소리의 높고 낮음을 가장 정확하게 인식하였으며 소리의 길고 짧음 또한 인식할 수 있었다. 잔존 청력이 남아있는 경우 음성적 차이를 더욱 세밀하게 인식할 수 있었다. 이 같은 연구 결과는 우리나라 사람들의 의사소통에서 억양, 강세, 속도 등과 같은 준언어학 요소 중 가장 빈번하게 나타나는 요인으로 억양을 꼽은 권순복의 연구 결과와 매우 유사함을 볼 수 있다[29]. 목소리의 하위 구성 요소인 음고, 장단, 음량에 따라 목소리의 음성 차이가 각기 다르게 나타났으며, 목소리의 높고 낮음의 정도에 따라 위, 아래로 이동하는 글자의 움직임에서 음성적 특징을 가장 분명하게 인식하였다.

둘째, 글자 움직임을 통해 목소리의 감정을 일부 인식하였다. 목소리 간의 감정 차이는 분명히 인식할 수 있었으나 특정 감정을 구체적으로 인식하는 것은 제한적으로 나타났다. 글자 움직임이 과격해질수록 즐겁거나 놀란 감정과 같은 동적인 감정을, 움직임이 미약할수록 졸리거나 피곤한 것과 같은 정적인 감정을 인식하였다. 특히 목소리 높낮이를 의미하는 위, 아래 위치 변화와 세기를 의미하는 글자 형태의 변화가 급격하게 나타날수록 동적인 감정을, 원만하게 나타날수록 정적인 감정을 느꼈다. 이는 억양의 변화가 급격할 시 감정의 농도에 영향을 미친다는 연구 결과[18], 목소리의 억양과 강도(intensity)가 크게 나타날 시 강한 에너지의 감정을 인식하고 강도가 약할 시에 약한 에너지의 감정을 인식한다는 연구결과[14][15]와 밀접하게 관련지어 볼 수 있다.

이와 같이 본 연구는 청각장애인이 목소리를 화면상에 구현한 글자 움직임을 통해 청각적 정보를 인식할 수 있으며 이에 대한 감정 정보를 일부 인식할 수 있다는 가능성을 제시하였다. 이러한 연구 결과는 이후 청각 장애인을 중심으로 한 타이포그래피 연구의 필요성을 조명한다는데 시사하는 바가 크다. 특히 말소리와 글자 간의 간극에서 오는 읽기의 부진, 문화·정서적 경험의 부족에서 오는 글자와의 정서적 거리감 등[4]~[6], 글자를 접할 때 청각장애인이 마주하는 어려움을 보완하는데 필요한 타이포그래피 분야 연구의 시발점이 되며 문헌적 발판을 마련한다는데 의미가 있다.

6-2 연구의 한계점 및 향후 연구방향

본 연구는 청각장애인을 대상으로 한 타이포그래피 분야의 기초 연구로써 다음과 같은 한계점을 동반한다. 먼저 일반인에 비해 읽기 수준이 낮은 청각장애인의 경우 본 연구에서 제시된 글자 움직임을 따라가며 글자를 읽는데 어려움을 겪었다. 특히 글자가 위, 아래로 이동하며 자음의 일부가 겹쳐질 시, 또는 움직임의 속도가 빨라질 시에 읽기에 많은 어려움을 호소하였다. 이는 청각장애인이 세부적 감정을 인식하는데에 부정적 영향을 미쳤으리라 예상되며 결과적으로 해당 영상물에 대해 보다 세밀한 감정을 인식하였던 일반인의 반응[22]에 비해 더욱 단조로운 반응이 나타났을 것으로 판단된다. 비록 글자 움직임에서 청각장애인의 비언어적 정보 습득이 가능한 것으로 나타났으나 읽기를 방해하지 않는 범위에서 글자 표현 양식을 보다 심도 있게 고찰할 필요가 있다. 이같이 본 연구에서는 청각장애인이 글자 움직임을 통해 비언어적 정보 인지를 할 수 있는지에 대한 여부를 알아보는데 그쳤으나, 이후에는 말소리를 묘사하는 타이포그래피의 구체적인 표현 양식을 청각장애인의 시각에서 개발해야 한다.

또한 말소리를 전달하는 글자 표현 양식을 활용하여 청각장애인의 글자 사용 영역을 확장시킬 수 있다. 본 연구의 조사 과정에서 글자의 움직임을 통해 청각 정보를 인식한 청각장애인은 기존에 무관심했던 뮤지컬, 콘서트와 같이 음악을 동반한 새로운 문화 영역에도 관심을 표현하였다. 특히 또한 소리를 미약하게나마 들을 수 있는 고도 난청인은 음성적 특징을 보다 다양하게 인식하였으므로 글자 움직임을 접할 시 더욱 구체적인 정보를 인식할 것이다. 최근에는 인공와우기나 보청기의 발달로 청각 장애인 중 청력이 남아있는 경우가 더욱 많아지고 있는 실정이므로(국립국어원, 2009) 새로운 문화 영역에 대한 실질적 적용 방법을 제시할 수 있다면 글자 습득과 같은 기능적인 면을 넘어 삶의 질을 개선하는 부분까지 긍정적인 영향을 줄 것이다.

Notes

참고문헌

-

A. Mehrabian, M. Williams, “Nonverbal concomitants of perceived and intended persuasiveness,” Journal of Personality and Social Psychology, Vol. 13 No. 1, pp.37–58. April 1969

[https://doi.org/10.1037/h0027993]

- D. Ross-Swain, “The voice advantage, “ Singular Pub Group, pp.1~800, 1991

- J. I. Kwon, B. C. Yoon, E. B. Lee, M. H. Lee, “Demographics of language use in hearing impared people,” National Institute of Korean Language, pp. 1-155, 2009

- G. S. Lee, M. G. Gook, J. H. Kim, S. J. Kim, E. J. Yoo, Educating the deaf, Hakjisa, 2004

-

L. Barca, G. Pezzulo, M. Castrataro, P. Rinaldi, MC. Caselli, “Visual word recognition in deaf readers: lexicality is modulated by communication mode,” PLoS One. Vol. 8, No. 3, March 2013

[https://doi.org/10.1371/journal.pone.0059080]

-

J. P. Morford, “When deaf signers read English: do written words activate their sign translations?,” The Journal of Cognition, Vol. 118, No. 2, pp. 286-92, November 2011

[https://doi.org/10.1016/j.cognition.2010.11.006]

- Learning english. A new reason for why the deaf may have trouble reading. [Internet] Available: https://learningenglish.voanews.com/a/a-new-reason-for-why-the-deaf-may-have-trouble-reading-119728279/115194.html, .

- H. J. Jang, J. H. Kim, “A possibility and the meaning of expansion in typography area though non-linguistic expression of type,” Bulletin of Korean Society of Basic Design & Art, Vol. 8, pp. 543-551, February 2007

- J. M. Lee, Study on kinetic-typography usage for closed captions and perception expansion for the hearing-impaired, Hongik University, pp. 1~43, December 2013

-

Ł. Bola, M. Zimmermann, P. Mostowski, K. Jednoróg, A. Marchewka, P. Rutkowski, M. Szwed, “Task-specific reorganization of the auditory cortex in deaf humans,” Proceedings of the National Academy of Sciences, Washington: DC, Vol. 114 No. 4, E600-E609; 2017

[https://doi.org/10.1073/pnas.1609000114]

-

EM1 Finney, BA Clementz, G Hickok, KR. Dobkins, “Visual stimuli activate auditory cortex in deaf subjects: evidence from MEG,” Neuroreport, Vol. 14 No. 11, pp. 1425-1427, August 2003

[https://doi.org/10.1097/00001756-200308060-00004]

- R. Burton, “The elements of music: What are they, and who cares?,” Music: Educating for life. ASME XXth National Conference Proceedings, Parkville: VIC, pp. 22-28, 2015

-

P. B. Dasgupta, “Detection and analysis of human emotions through voice and speech pattern processing,” International Journal of Computer Trends and Technology, Vol. 52 No. 1, pp. 1-3. October 2017

[https://doi.org/10.14445/22312803/IJCTT-V52P101]

- B. M. Ha, M. J. Huh, “The effect of pitch, duration, and intensity on a preception of speech,” Journal of speech-language & hearing disorders, Vol. 27 No. 3, pp. 45-54, July 2018

-

D. Kami ´nska, A. Pelikant, “Recognition of human emotion from a speech signal based on Plutchik’s Model,” Intl Journal of Electronics and Telecommunications, Vol. 58, No. 2, pp. 165–170, May 2012

[https://doi.org/10.2478/v10177-012-0024-4]

-

L. Bruckert, J. S. Liénard, A. Lacriox, M. Kreutzer, G. Leboucher, “Women use voice parameters to assess men's characteristics,“ Proceedings Biological Sciences, Vol. 7 No. 273, pp. 83-89, 2006

[https://doi.org/10.1098/rspb.2005.3265]

-

C. G. Smith, E. M. Finnegan, M. P. Karnell, P. Michael, “Resonant voice: spectral and nasendoscopic analysis,” Journal of Voice, Vol. 19 No. 4, pp. 607-622, December 2005

[https://doi.org/10.1016/j.jvoice.2004.09.004]

-

B. M. Hwang, E. J. Han, “A study of images that are reminiscent of a voice,” Journal of speech-language & hearing disorders, Vol. 24 No.4, pp. 249–257, December 2015

[https://doi.org/10.15724/jslhd.2015.24.4.023]

- H. J. Lee, “The effect of typeface non-verbality on emotional and active responses in brain : focusing on the EEG experiment of the Hangeul emotional typeface,” Hongik University, pp. 1~161, August 2018

- S. W. Hong, “A study on the history and characteristics of kinetic typography,” Journal of Institute of Natural Science, Vol.11 No.1, pp.1-10, 2004

- S. G. Noh, “Hangul and animation,” Waesolhwae, Vol. 123, pp. 137-146, December, 2014

-

J. H. Ha, “Delivering emotions through voice writing system - based on kinetic hangul typeface, ‘Voice Font’,” Design Convergence Study, Vol.17. No.5, pp. 33-48, Ocotober 2018

[https://doi.org/10.31678/SDC.72.3]

- H. J. Jang, J. H. Kim, “A possibility and the meaning of expansion in typography area through non-linguistic expression of type,” Korean Society of Basic Design & Art, Vol. 8 No. 1, pp. 541-551, August 2007

-

P. G. Yoo, H. J. Jin, Image, Salim, pp. 19-277, 2001

[https://doi.org/10.1080/08109020110072225]

-

W. Lore, S. Song, “Central and peripheral visual processing in hearing and nonhearing individuals,” Bulletin of the Psychonomic Society, Vol. 29. pp. 437-440, May 2013

[https://doi.org/10.3758/BF03333964]

-

J. L. Mori, D. I. Fels, “Seeing the music can animated lyrics provide access to the emotional content in music for people who are deaf or hard of hearing?” IEEE Toronto International Conference Science and Technology for Humanity, pp. 951-956, 2009

[https://doi.org/10.1109/TIC-STH.2009.5444362]

- From hearing loss to deaf gain [Internet] Available: http://beminor.com/detail.php?number=12323&thread=03r02r11

- P. S. Lee, S. H, Kwon, S. J. Kim, S. Y. Kim, M, H, Park, S. H. Park, E. H. Jung, Understanding and education of student with hearing loss, Hakjisa, 2015

-

S. B. Kwon, “Paralinguistic elements of voice in communication: A literature review,” Journal of speech-language & hearing disorders, Vol. 21 No. 2, pp. 1 – 22, April 2012

[https://doi.org/10.15724/jslhd.2012.21.2.001]

저자소개

2003년 : Rhode Island School of Design (Graphic Design 학사)

2009년 : Maryland Institute College of Art (Graphic Design 석사)

2017년: 홍익대학교 디자인/공예학과(시각디자인 박사)

2009년~2012년: EcoVegan LLC. 디자인 디렉터

2012년~2015년: 남서울대학교 시각정보디자인학과 교수

2015년~현 재: 국립한경대학교 디자인학과 교수

※관심분야: 타이포그래피, 그래픽 디자인, 시각언어, 지각