시각장애인을 위한 상황인지 보조 IoT 장치 및 보행자 길안내 서비스 앱 개발

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

시각장애인들의 외부활동은 여전히 자유롭지 못하여, 시각장애인의 이동의 불편함을 해소하고 외부활동 범위를 확대할 수 있는 방안 모색이 시급하다. 본 논문에서는 시각장애인 주변의 상황을 인지하여 음성으로 안내하는 IoT 장치와 길안내 앱을 제안한다. IoT 장치의 초음파 센서를 통해 주변에 물체가 존재하는지를 감지하고 물체의 위치에 따라 다른 경고음을 제공하여 물체 근접 정도를 구별한다. IoT 장치의 카메라를 통해 입력된 영상은 딥러닝으로 학습된 물체인식 알고리즘에 의해 주변에 존재하는 물체를 인식할 수 있다. 길안내 앱은 음성인식, TTS, 큰 아이콘을 사용하여 시각장애인 맞춤형 UI를 제공한다. 목적지까지의 보행자 경로를 찾아 모든 세부경로를 지도에 표시하고 음성으로 안내하며, 총 보행시간을 계산하여 함께 알려준다.

Abstract

Since the external activities of the visually impaired are still not free, it is urgent to find ways to resolve the inconvenience of movement and to expand the range of external activities. In this paper, we propose an IoT device and a navigation service application that recognizes the situation around the visual impaired and voices it. Ultrasonic sensors in the IoT device detect the presence of objects around them and provide different beeps depending on the location of the object to differentiate the object's proximity. The surrounding objects in the input image through the camera of the IoT device may be recognized by the object recognition algorithm learned by deep learning. The navigation service application provides a customized UI for the visually impaired using voice recognition, TTS, and large icons. The proposed application finds pedestrian paths to the destination, displays all detailed paths on a map, provides voice guidance, and calculates the total walking time.

Keywords:

IoT, Object recognition, Pedestrian navigation, Situation awareness, Visually impaired키워드:

사물 인터넷, 물체 인식, 보행자 길안내, 상황 인지, 시각 장애Ⅰ. 서 론

보건복지부의 시·도 장애인 등록현황 자료에 따르면, 2018년 12월 기준으로 등록된 시각장애인 수는 252,957명으로 전체 장애인 수에 약 9.7%를 차지한다[1]. 시각장애인들은 장애 특성상 시각적으로 정보를 얻는데 제약이 많고 이동을 하는데 많은 위험이 존재하기 때문에 안전한 이동을 제공할 수 있는 서비스가 필요하다[2]. 그러나 국민권익위원회에서 발표한 2015년부터 2016년까지 국민신문고에 접수된 ‘장애인 이동’ 관련 민원 932건의 분석결과를 보면, 시각장애인의 안전을 위해 설치된 점자블록, 안내표지판, 음향신호기 등 이동 안내시설의 정비 요청이 231건(24.8%)으로 가장 많았다[3]. 위의 발표내용에서 볼 수 있듯이, 시각장애인들은 여전히 외부활동에 있어서 자유로운 이동권을 보장받고 있지 못하다.

시각장애인의 이동의 불편함을 해소하고 외부활동 범위를 확대해주고자 다양한 연구가 시도되었다. 최근, 스마트 폰 화면을 보기 힘든 시각장애인을 위해 목적지까지의 최단 경로를 스마트 폰의 음성 서비스로 전달하는 길안내 서비스가 발표됐다[4]. 또한, 시각장애인의 편의성을 위해 IoT(Internet of Things) 기술과 융합한 스마트 지팡이를 사용하여 신호등과 음향 신호기를 식별하여 선택한 신호등을 동작시키거나[5], 센서를 이용하여 장애물의 위치를 파악하여 이를 피해갈 수 있도록 안내하는 디바이스가 개발됐다[6].

본 논문에서는 시각장애인이 주변 상황을 인지하여 안전하게 이동하기 위한 IoT 장치와 앱을 제안한다. 제안하는 장치와 앱은 다음과 같은 기능 제공을 목표로 개발된다.

첫째, IoT 장치는 탈부착형식의 보행보조기로써 시각장애인의 휴대성과 편리성을 보장한다.

둘째, 센서를 이용하여 가까이 또는 매우 가까이에 물체가 있음을 인지하고 신호음의 세기로 이를 구별하여 알린다.

셋째, 카메라를 이용하여 사용자 전방의 물체를 정확하고 신속하게 인식하며, 좌우 위치도 함께 알려 보행을 돕는다.

넷째, 긴급상황 발생 시 정확하게 알리기 위해, 버튼을 누르면 보호자에게 글이나 말 대신 카메라에 찍힌 영상을 보낸다.

다섯째, 목적지까지 장애물을 피한 보행자 경로를 찾고 음성으로 안내한다.

여섯째, 시각장애인의 안전을 위해 QR 코드를 이용하여 상대방을 인증한다.

Ⅱ. 관련 연구

2-1 IoT에서 딥러닝을 이용한 물체인식

IoT는 인터넷 프로토콜을 통해 사람과 사물, 사물과 사물 간의 통신을 말한다. 최근 장애인을 위한 보조 장치로써 다양한 센서를 이용하는 IoT 응용 서비스에 대한 관심이 높아지고 있다. 이런 응용 서비스는 IoT 장치의 센서 데이터를 기록하고 단순히 처리하는 것으로, 음성이나 영상 데이터를 이해하고 예측, 데이터 마이닝 및 패턴 인식과 같이 복잡한 업무를 수행할 수 있는 기술 개발이 필요하다. 특히, IoT 장치에 부착된 카메라에 입력된 영상에서 물체를 감지하고, 방향, 크기, 위치에 관계없이 물체를 인식할 수 있어야 하고, 이들이 실시간으로 이루어져야 한다. 이러한 문제를 수행하기 위해 최근에는 IoT 장치에서 기계학습, 그 중에서도 딥러닝(deep learning)을 적극적으로 활용하려는 노력이 이루어지고 있다. 그러나 실제로 모바일성의 IoT 장치는 저전력(제한된 컴퓨팅 성능과 작은 메모리 크기)이여서 IoT 장치에서 딥러닝을 수행하는 것은 한계가 있다[7].

최근 IoT 환경에서 컴퓨터 비전을 위한 딥러닝을 활용할 수 있는 몇 가지 제품이 소개되었다. 인텔은 CNN (Convolutional Neural Network)을 기반으로 비전을 에뮬레이트할 응용과 솔루션을 개발하는데 사용하는 SDK인 OpenVINO (Open Visual Inference & Neural Network Optimization)를 발표했다[8]. 마이크로소프트사와 퀄컴은 IoT 환경에서 AI에 대한 추론을 지원하는 Vision AI Developer Kit을 발표했다[9]. NVIDIA는 GPU 가속 병렬 처리 기능을 갖춘 임베디드 AI 컴퓨팅 플랫폼인 Jetson TX2 Development Kit을 발표했다[10]. 본 논문에서는 무료로 제공되고 있는 인텔의 OpenVINO를 사용하여 IoT 장치에서 딥러닝 기반의 비전 서비스를 개발한다.

2-2 보행자 경로탐색

경로탐색은 출발지에서 목표지까지 가는 경로를 찾는 문제로 대표적인 알고리즘으로 A* 알고리즘 , Dijkstra 알고리즘 등이 있다. 최근 모바일 사용이 대중화되면서, 모바일에 부착된 GPS를 통해 사용자의 현재 위치를 감지하고 그에 따라 목적지까지의 경로를 탐색하는 위치기반 내비게이션의 활용이 확대되고 있다. 국내의 대표적인 내비게이션 서비스로는 네이버 지도 API, 카카오 지도 API, Tmap API, 구글맵 API 등이 있다. 이들 서비스는 공통적으로 현재의 위치를 파악하여 실시간으로 목적지까지의 거리와 교통 상황에 고려하여 탐색된 차량용 경로를 제공한다. 그러나 차량용 경로를 제공하는 방식으로는 보행자, 특히 시각장애인을 위한 경로탐색 서비스는 적합하지 않다. 보행자는 자동차 도로가 아닌 보행자 도로를 이용해야 하며, 보행자 움직임의 자유도가 자동차보다 높고, 5-30 미터의 GPS 위치 정확도가 충분하지 않은 경우가 많기 때문이다[11]. 현재 보행자용 경로탐색 서비스는 Tmap API 에서만 제공되고 있다.

최근 보행자 중 시각적인 어려움을 갖은 사용자들의 경로탐색에 대한 연구가 활발히 이루어지고 있다. 김창기와 서정민은 삼거리나 사거리와 같은 길이 만나는 곳의 모퉁이, 건물의 각 모서리, 현관문, 센서가 설치되어 있는 곳을 노드로 지정하여 경로를 탐색하는 방법을 제안하였고 이를 이용하여 스마트 폰에서의 길안내 서비스를 구현하였다[12]. 장영건과 차주현은 스마트 폰에 내장된 GPS 센서의 오차로 인한 잘못된 보행을 방지하기 위하여 GPS의 계획된 경로로부터의 이탈이 일정 거리 이하에 있을 때만 작동하게 하는 방법으로 오차를 줄이는 경로탐색 방법을 제안하였고 이를 이용하여 스마트 폰과 헤드셋을 사용한 휴대용 길안내 서비스를 구현하였다[13]. 본 논문에서는 Tmap API를 이용하여 경로를 탐색하고, IoT의 초음파 센서와 카메라 센서를 이용하여 주변 상황을 인지하여 스마트 폰의 GPS 센서의 오차를 보완하는 방법을 제안한다.

Ⅲ. 제안하는 시스템

본 장에서는 시각장애인들이 이동시 발생하는 불편을 줄이기 위해 IoT 장치와 앱으로 구성된 시스템을 제안한다. 제안하는 시스템은 초음파 센서와 카메라 센서로 주변 상황을 인지하고 음성으로 보행자용 길안내하며 긴급연락망으로 현재의 상황의 장면을 전달할 수 있는 기능을 제공한다.

3-1 시스템 구성도

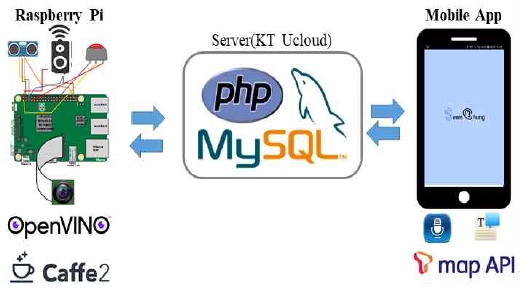

제안하는 시스템의 구성도는 그림 1과 같다. 우선 IoT 장치는 초음파 센서, 파이 카메라, 블루투스 스피커, 버튼으로 구성된 라즈베리 파이(Raspberry Pi)를 활용하여 구현된다. 초음파 센서와 파이 카메라로 주변 상황 정보를 입력받아 인접한 장애물을 감지하거나 인접한 장애물을 인식하여 스피커로 출력한다. 또한, 길안내 서비스 앱은 도착지를 입력받아 보행자 길찾기로 경로를 안내한다. 모든 입력과 안내 출력은 음성으로 이루어질 수 있다.

제안하는 시스템은 IoT 장치와 길안내 앱을 연동하기 위해 서버를 구축하였는데, 본 논문에서는 KT Ucloud의 서버를 이용하였다. 서버에는 연동을 위한 최소한의 정보만을 저장하는 데이터베이스를 설계하고, MySQL로 구현하였다. 데이터베이스는 보호자의 이름, 이메일, 전화번호 값을 포함하는 PersonInfo 라는 테이블을 갖는다. 앱에서 보호자 정보를 등록하면 서버의 데이터베이스에 저장된다. IoT 장치의 버튼을 누르면 서버에 등록된 보호자에게 연락하게 된다.

3-2 상황인지 보조 IoT 장치

라즈베리 파이의 초음파 센서를 이용하여 주변의 물체를 감지할 수 있다. 초음파 소요시간(pulse_duration)은 전송 시작(pulse_end)부터 수신 완료(pulse_start)까지 걸리는 시간으로 차이(pulse_end – pulse_start)를 이용하여 계산한다. 초음파를 이용한 물체까지의 거리는 식 (1)과 같이 계산한다.

| (1) |

여기서 초음파 속도는 340 m/s 이지만 초음파는 물체에 반사된 후 되돌아오므로 2로 나누어 170 m/s 를 적용한다.

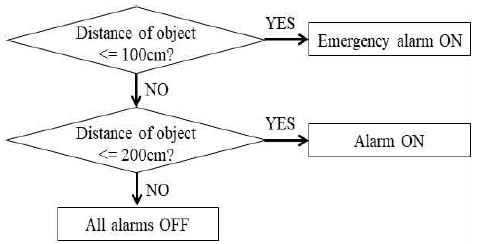

또한, 시각장애인에게 물체의 근접 정도를 구별하여 알려주기 위해, 거리에 따라 다른 소리를 블루투스 스피커로 출력한다. 즉, 그림 2에서 보여지는 것처럼, 측정 거리가 1 m 이내인 경우엔 긴박한 경고음을 울리고, 2 m 이내인 경우엔 일반 경고음을 울려 물체근접 정도를 구별하여 알린다.

본 논문에서는 라즈베리 파이에서 딥러닝 기반의 물체인식을 수행하기 위해 Caffe2의 딥러닝 프레임워크에서 OpenVINO를 이용하였다. Caffe2에서 미리 학습된 모델인 MobileNet-SSD (Single shot multibox Detector)[14]를 사용하였으며 보행 시 많이 접할 수 있는 객체인 'person', 'car', 'bicycle', 'dog', 'motorbike', 'bus' 등 22개의 객체들만을 인식하도록 하였다.

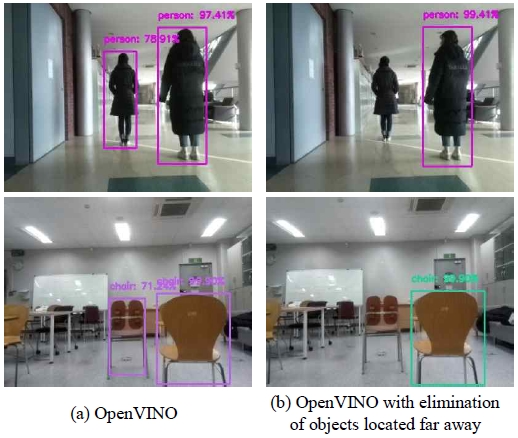

파이 카메라를 통해 동영상 프레임이 입력되면, 프레임 내에 존재하는 여러 개의 객체들을 인식한다. 이 때 인식된 각 객체를 인접 사각형(bounding box)으로 표시하고, 객체의 인식 확률(신뢰도)을 반환한다. 제안하는 시스템에서는 시각장애인의 길안내를 위한 주변 상황인지를 위해 카메라 정보를 이용하는 것이므로 동영상 프레임 내 모든 물체를 인식하는 것은 너무 많은 물체를 안내하게 되어 오히려 시각장애인들에게 혼돈을 줄 수 있다. 최소 인식 확률을 두어 상대적으로 인식 확률이 낮은 객체는 제거하고 주변의 객체만을 정확하게 인식하여 알려주는 것이 주변 상황을 파악하고 보행하는데 도움이 될 수 있다. 따라서 본 논문에서는 70%의 높은 신뢰도 이상의 객체만을 인식하도록 하였다. 그림 3(a)는 OpenVINO를 이용하여 높은 신뢰도로 인식된 결과의 예를 보여주고 있다.

또한, 제안하는 시스템은 딥러닝으로 인식된 물체들 중 상대적으로 시각장애인에게 더 가까운 물체에 대해서만 좌우의 위치를 안내한다. 그림 3(b)와 같이 상대적으로 사용자에게서 멀리 위치한 물체들은 제외하고 보행 시 먼저 만나게 될 가까이에 위치한 물체만 좌우 위치를 알려 보행에 도움을 준다. 물체의 좌우 위치는 인식된 물체의 인접사각형의 중심이 화면의 오른쪽, 중심, 왼쪽에 위치하느냐에 따라 결정된다. 즉, 입력되는 프레임의 가로길이가 400인 경우, 인접사각형의 중심의 x 좌표가 300을 초과하면 ‘오른쪽’, 100 미만이면 ‘왼쪽’을 함께 음성으로 안내한다. 예를 들어, 그림 3(b)의 위 장면에서는 “person”과 “오른쪽”이, 그림 3(b)의 아래 장면에서는 “chair”와 “오른쪽”이 안내된다.

시각장애인이 보행을 하다보면 긴급하게 도움이 필요한 경우가 발생할 수 있다. 또한, 도움을 요청할 때 시각장애인은 자신에게 벌어진 긴급한 상황을 글이나 말로 정확히 설명하는데 어려움을 겪을 수 있다.

제안하는 시스템은 시각장애인들이 보다 쉽지만 정확하게 본인의 상황을 보호자에게 알리기 위해 라즈베리 파이의 버튼만 클릭하면, 파이 카메라에 입력된 현재의 장면을 캡처하여 서버에 미리 등록해 둔 보호자의 이메일로 전송한다. 보호자는 이메일로 전달받은 사진을 통해 시각장애인의 상황을 빠르고 쉽고 파악하여 도움을 줄 수 있을 것이다.

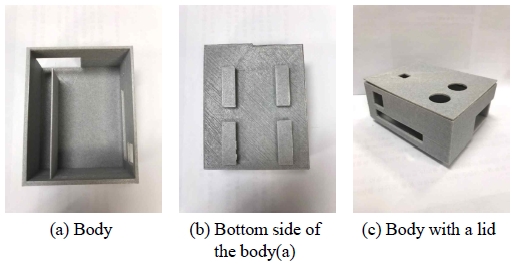

그림 4은 제안하는 IoT 장치를 담는 케이스를 보여주고 있다. 그림 4(a)는 라즈베리 파이를 담는 본체로 전원, HDMI 케이 블 등 각종 전선들이 위치할 수 있는 3개의 구멍을 가지고 있다. 그림 4(b)는 그림 4(a) 본체의 뒷면으로 옷이나 가방 등에 부착할 수 있도록 고리를 두었다. 그림 4(c)는 본체에 뚜껑을 덮은 모습을 보여주는데, 뚜껑에는 1개의 파이 카메라와 2개의 초음파 센서가 위치할 수 있는 구멍을 가지고 있다. 제안하는 IoT 장치의 케이스는 큐비콘 싱글 플러스(Cubicon 3DP-110F) 3D 프린터로 출력되었다.

3-3 보행자 길안내 서비스 앱

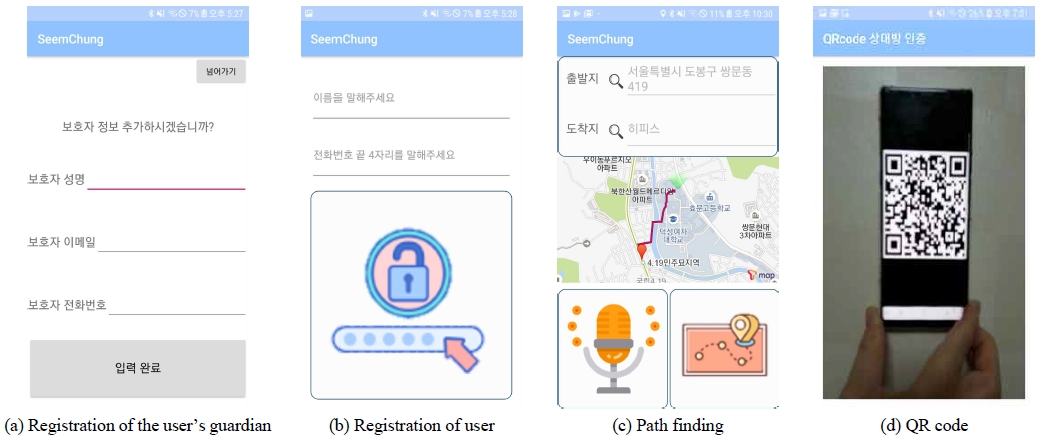

본 장에서 제안하는 시각장애인을 위한 보행자 길안내 서비스 앱은 IoT 장치와의 연동을 위해 우선 보호자를 등록하여야 한다(그림 5(a)). 3-1장에서 설명했듯이 입력된 보호자 정보는 서버의 데이터베이스에 저장되고, IoT 장치의 버튼을 누르면 서버에 저장된 보호자의 정보를 IoT 장치로 가져온다.

제안하는 앱은 사용의 편의를 위해 음성을 인터페이스로 제공하고 있다. 그림 5(b)는 사용자 정보 입력 화면으로 필요한 입력은 음성인식을 통해 전달하고 안내 내용도 TTS(Text-To-Speech)를 이용하여 음성으로 전달받는다. 제안하는 길찾기 앱은 삼성폰에서 제공하는 삼성 SVoice와 삼성 TTS API를 이용하여 구현된다.

또한 시각장애인을 위한 앱이므로 UI로 문자를 사용하기 보다는 그림 5(b)와 그림 5(c) 하단의 버튼들과 같이 큰 버튼(아이콘)을 사용하여 편의성을 높였다. 즉, “화면 하단”, “화면 하단 오른쪽”, “화면 하단 왼쪽”과 같은 안내 멘트만으로도 앱을 작동할 수 있게 된다.

제안하는 길안내 앱은 보행자 길안내를 위하여 Tmap API를 이용하여 보행자 경로를 제공한다. 우선 GPS로 위치를 추적해 사용자의 현 위치에 대한 정보를 출발지(start =p0)로 정하고 지도에 마커 표시한다. 다음으로 그림 5(c) 하단 왼쪽의 음성입력 버튼을 눌러 목적지(end =pn)를 음성인식을 이용하여 입력받는다. 그림 5(c) 하단 오른쪽의 길찾기 버튼을 눌러 출발지와 목적지를 Tmap API에 전달하면, p0,p1, ⋯ , pn-1,pn의 보행자 경로를 반환받는다. 여기서 상세 경로 pi(i = 1, ⋯, n)는 식 (2)와 같은 정보를 포함한다.

| (2) |

보행자 경로를 받은 다음, 그림 5(c)의 지도에서 보여지는 것처럼 상세 경로의 위치 li를 이용하여 지도에 폴리라인(Polyline)을 그린다. 시각장애인들에게 경로를 안내하기 위해 각 상세 경로의 명칭 ni과 거리 di를 음성으로 안내한다. 또한, 출발지에서 목적지까지의 총 보행시간은 각 상세 경로의 보행시간 ti의 합()으로 계산하여 함께 알려준다.

제안하는 길안내 앱은 시각장애인의 안전을 중시하는 서비스이므로 내가 만난 상대방이 안전한지 확인이 필요하다. 제안하는 앱은 사용자 각자에게 개인만의 QR 코드를 부여한다. 사용자가 만나고자 하는 또는 안심할 수 있는 상대방에게 미리 QR 코드를 전송한다. 그림 5(d)와 같이 상대방이 보인 QR 코드를 카메라를 통해 입력받아 자신의 QR 코드와 일치 여부를 결정하는 방법으로 상대방을 인증할 수 있다. 상대방이 안전하다고 인증되면, “맞습니다. 즐거운 시간 보내세요.”라는 음성이 출력된다. 제안하는 앱은 Google Chart API를 이용하여 QR 코드를 생성하고, Google Mobile Vision API을 이용하여 QR 코드 인식을 구현하였다.

Ⅳ. 개발 결과

본 논문에서 제안하는 IoT 장치는 Intel(R) Pentium(R) CPU G4400 3.30 GHz와 8 GB RAM 메모리 사양의 리눅스(우분투) 상에서 파이썬과 OpenCV를 이용하여 개발되었다. IoT 장비의 라즈베리 파이에서 딥러닝을 개발하기 위해서는 하드웨어 최적화를 수행하여 처리속도를 높이고 파이 CPU의 소모 부담을 덜어주어야 한다. 제안하는 IoT 장치는 인텔 Movidiu Myriad x VPU(Vision Processing Unit)에 의해 구동되는 NCS(Neural Compute Stick)를 사용하여 개발하였다.

그림 6은 제안하는 IoT 장치와 길찾기 앱을 사용하는 모습을 보여주고 있다. 그림 6의 왼쪽 그림과 같이 IoT 장치는 단독으로 몸에 부착하여 초음파 센서와 카메라를 이용하여 보행 시 주변 상황에 대한 정보를 안내받을 수 있다. 또한, 스마트 폰과 함께 길안내 앱을 사용하여 목적지까지의 경로와 소요시간을 안내받으면서 주변 상황에 대한 정보를 동시에 받을 수 있다.

Ⅴ. 결 론

본 논문에서는 시각장애인에게 보행의 편의성을 제공하기 위해 주변 상황을 파악하고 긴급한 상황에 쉽고 빠르게 대응할 수 있으며 음성 인터페이스를 제공하는 IoT 장치와 길안내 앱을 제안한다. 제안하는 방법의 차별성은 시각장애인의 길안내를 위하여 길안내 앱으로 보행자 경로를 탐색하면서, 동시에 IoT의 초음파 센서와 카메라 센서를 이용하여 주변 상황을 인지하여 스마트 폰의 GPS 센서의 오차를 보완하는 것이다. IoT 장치의 초음파 센서를 통해 주변에 물체가 존재하는지를 감지하고 물체의 위치에 따라 다른 경고음을 제공하여 물체 근접 정도를 구별한다. IoT 장치의 카메라를 통해 입력된 영상은 딥러닝으로 학습된 물체인식 알고리즘에 의해 주변에 존재하는 물체를 인식할 수 있다. 특히 사용자에 근접한 물체에 대해서는 물체의 좌우 위치도 함께 알려준다. 길안내 앱은 음성인식, TTS, 큰 아이콘을 사용하여 시각장애인 맞춤형 UI를 제공한다. 목적지까지의 보행자 경로를 찾아 모든 세부경로를 지도에 표시하고 총 보행시간을 계산하여 함께 알려준다.

향후 제안하는 IoT 장치에서의 물체인식 속도를 높이는 연구가 필요하며, 길안내 앱은 보행자의 위치가 변경될 때 자동으로 새로운 길을 찾아 안내하는 서비스를 추가할 계획이다. 이를 통해 시각장애인들이 보행 시 주변의 상황을 보다 잘 파악하여 대처할 수 있도록 서비스를 제공할 계획이다.

Acknowledgments

본 연구는 2018년도 덕성여자대학교 교내연구비 지원에 의해 이루어졌습니다.

참고문헌

- Ministry of Health and Welfare. Available: http://www.mohw.go.kr/, .

- W. Kim, Y. Lee and S. Kim, “Examination of public transit use patterns and development of high-tech walking-aid system at public transit facilities for the blink and visually impaired,” Journal of Seoul Studies, Vol. 10, No. 3, pp. 97-114, 2009.

- Anti-Corruption & Civil Rights Commission. Available: https://www.acrc.go.kr/, .

-

C.G. Kim and J.M. Seo, “A design and implementation of navigation system for visually impaired persons based on smart mobile devices,” The Journal of the Korea Contents, Vol. 15, No. 1, pp. 24-30, 2015.

[https://doi.org/10.5392/JKCA.2015.15.01.024]

- S.-J. Lee, S.-H. Kim, W.-S. Jang, J.W. Jwa and W.-W. Kim, “Smart cane for the blind interworking with sound signal generator,” The Journal of The Institute of Internet, Broadcasting and Communication, Vol. 17, No. 6, pp. 137-143, 2017.

- D.-H. Jeon, E.J. Lee, S.-W. Kang, W.-J. Lee and T.-K. Kang, “Guide device for people who are blind,” in Proceedings of The KIEE Conference, pp. 107-110, 2018.

-

J. Tang, D. Sun, S. Liu and J.-L. Gaudiot, “Enabling deep learning on IoT devices,” Computer, Vol. 50, No. 10, pp. 92-96, 2017.

[https://doi.org/10.1109/MC.2017.3641648]

- Install Intel®. Distribution of Open VINO™ toolkit for Linux with FPGA support - OpenVINO Toolkit. Available: https://docs.openvinotoolkit.org/2019_R1/_docs_install_guides_installing_openvino_linux_fpga.html/, .

- Microsoft. Vision AI DevKit. Available: https://azure.github.io/Vision-AI-DevKit-Pages/, .

- NVIDIA Jetson. The embedded platform for autonomous everything. Available: https://www.nvidia.com/en-us/autonomous-machines/embedded-systems-dev-kits-modules/

- A. Millonig and K. Schechtner, “Mobile pedestrian navigation systems wayfinding based on localisation technologies,” Research in Urbanism Series, Vol. 1, pp. 47-61, 2008.

-

C.G. Kim and J.M. Seo, “An design and implementation of navigation system for visually impaired persons based on smart mobile devices,” The Journal of the Korea Contents Association, Vol. 15, No. 1, pp. 24-30, 2015.

[https://doi.org/10.5392/JKCA.2015.15.01.024]

- Y.G. Jang and J.H. Cha, “A study of pedestrian navigation service system for visual disabilities,” Journal of Rehabilitation Welfare Engineering & Assistive Technology, Vol. 11, No. 4, pp. 315-321, 2017.

- A.G. Howard, M. Zhu, B. Chen, D. Kalenichenko, W. Wang, T. Weyand, M. Andreetto, and H. Adam, “Mobilenets: Efficient convolutional neural networks for mobile vision applications,” arXiv preprint arXiv: 1704.04861, 2017.

저자소개

2016년~현 재: 덕성여자대학교 컴퓨터공학과

※관심분야: 인공지능, 데이터베이스, 모바일

2016년~현 재: 덕성여자대학교 컴퓨터공학과

※관심분야: 데이터베이스, 소프트웨어 엔지니어링, 모바일

2016년~현 재: 덕성여자대학교 컴퓨터공학과

※관심분야: 모바일, 웹, 데이터베이스

2016년~현 재: 덕성여자대학교 컴퓨터공학과

※관심분야: 데이터베이스, 데이터 분석, 영상처리

1993년 : 덕성여자대학교 전산학과(이학사)

1996년 : 연세대학교 전산과학과(이학석사)

2001년 : 아이오와 대학교 전산학과(전산학박사)

2003년~현 재: 덕성여자대학교 컴퓨터공학과 교수

※관심분야:컴퓨터비전, 패턴인식, 영상처리, 멀티미디어 등