지역 축제지원을 위한 AR 레이더 서비스 개발

Copyright ⓒ 2020 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

최근에 지역경제 활성화를 위해 많은 지역축제가 개최되고 있으며, 축제의 효율적인 진행 및 첨단 콘텐츠 제공을 위해 ICT 융복합 기술이 접목되고 있다. 본 논문에서는 지역문화와의 접목으로 차별화된 서비스를 제공하기 위해 증강현실을 이용한 방문객의 편의와 다양한 볼거리 및 지역 상인과의 연계를 통한 AR 레이더 서비스를 제안한다. 제안된 AR 레이더 서비스는 축제방문객들에게 낯선 환경에서 주위의 시설물, 이벤트 장소, 현장 요원 위치 등의 정보를 실시간으로 제공한다. 또한, 기존의 MIU 센서 기반 모션트래킹의 정확도를 향상시키기 위하여 ARCore 기반의 영상정보를 이용한 모션트래킹으로 정확성 향상 및 디바이스간의 일관된 서비스를 구현하였다.

Abstract

Recently, many regional festivals have been held to revitalize the local economy. ICT convergence technology is being attempted to efficiently perform festivals and provide a unique experience for festival visitors. We propose AR radar service through the convenience of visitors using augmented reality and linking with various attractions and local merchants. It provides differentiated services by integrating with local culture. The proposed AR radar service provides festival visitors with real-time information on nearby facilities, event venues and field agent in Unfamiliar environments. It also improves the accuracy of conventional IMU sensor-based motion tracking. Motion tracking using ARCore based image information improves accuracy and realizes consistent service between devices

Keywords:

Augmented Reality, AR Radar, Festival Support, Motion Tracking, Mobile키워드:

증강현실, 증강현실 레이더, 축제지원, 모션트래킹, 모바일Ⅰ. 서 론

최근 정보통신기술을 기반으로 인터넷과 스마트폰을 중심으로 웹서비스와 통합되어 제공되는 관광 정보 위치정보 서비스는 실시간 내외국인 관광객에게 필요한 맞춤형 스마트 관광 서비스를 제공하고 있으며, 이를 이용하여 관광·레저 산업의 신규 콘텐츠 및 상품 발굴에 따른 경쟁력 강화와 새로운 부가가치 창출이 가능할 것으로 보인다.

지역축제 활성화로 많은 축제방문객이 지역을 방문하고 있으나 기존의 일률적인 축제들로 축제 만족도가 낮게 나타나고 있다. 방문객들은 색다른 서비스를 통해 자신의 상황에 맞는 유용한 정보를 능동적으로 제공받기를 원한다. 또한 지역상인들도 축제에 참여하기를 원하고 있어 ICT(Information & Communication Technology)를 이용한 방문객과 지역상인들을 자연스럽게 연결할 수 있는 지역축제 어플리케이션이 요구되고 있다.

종래에는 AR(Augmented Reality) 기술을 구현하기 위하여 GNSS(Global Navigation Satellite System) 및 모션트래킹 기술을 사용하였다. 그러나 AR 구현에 있어 GPS(Global Positioning System) 센서는 주변 구조물 및 날씨에 영향을 받아 수신 데이터의 불안정으로 정확도가 떨어진다. 모션트래킹의 경우 전통적인 IMU(Inertial Measurement Unit)센서로부터 수집된 데이터는 시간이 흐름에 따라 드리프트(drift)가 발생하여 성능, 정확도 및 일관성을 떨어뜨린다[1],[2]. 이는 자동 보정을 위한 센서 퓨전 알고리즘과 상당한 리소스를 필요로 한다. 따라서 본 연구에서는 이러한 단점을 극복하고자 AR 레이더 서비스를 개발하였다.

본 연구의 AR 레이더 서비스는 초기위치정보를 GPS 센서로부터 받아 구성된 영상에서 특징점을 추출하여 포인트 클라우드를 생성한다. 이를 바탕으로 카메라의 자세를 추정하는 모션트래킹을 적용하여 정합영상을 생성한다. 축제지역 방문객의 위치에서 거리별로 POI(Point of Interest)정보와 정보별 리소스 정보를 Restful API로 제공하는 AR 서버 및 ARCore의 모션트래킹기술을 적용하였다.

Ⅱ. 기존 연구

2-1 지역 축제

제례의식이나 놀이에서 시작된 축제는 현대에 와서 지역 홍보와 지역경제 부흥의 기회로 사용되면서 국내・외 많은 지역에서 다양하게 개최되고 있다[3]. 특히 지역축제 활성화 요소는 지역 정체성, 지역주민의 참여에 기여하는 시민 주체성, 축제기간 중 방문객을 지속적으로 이끄는 참여적 테마 프로그램과 같은 전문성, 경제적 부가가치로 사료되고 있다[4].

문화체육관광부는 2019년도 문화관광축제 41개를 선정하였다. 글로벌 육성 축제 5개, 대표축제 3개, 최우수축제 7개, 우수축제 10개, 유망축제 21개를 선정하여 지원하고 있으며 해마다 이들 축제를 대상으로 만족도 조사를 실시한 결과 축제의 등급이 상향될수록 높은 만족도 수준을 보이는 것으로 분석되었으며, 이는 상위등급의 축제일수록 축제 운영 및 프로그램 등이 체계적으로 진행되어 전반적인 축제에 대한 방문객의 평가가 긍정적이라고 유추해 볼 수 있다.

2-2 증강현실

가장 대중적으로 알려진 ‘포켓몬 고’의 증강현실은 현실에 디지털 콘텐츠를 합성해 유저와의 상호작용을 가능하게 하는 기술로 몰입감을 증대시키기 위한 시스템 개발 연구가 진행되기도 했다[5],[6]. 이러한 증강현실 기술은 문화 컨텐츠 분야뿐만 아니라 건설안전, 제조, 의료 등 다양한 분야에 사용되고 있다.

AR은 사용자의 움직임에 따라 새로운 영상 프레임을 생성하고 이를 디스플레이해야 하는데 사용자의 움직임이나 기타 이벤트에 따라 영상을 생성하고 이를 화면에 그려내기까지의 시간을 Motion-to-photon latency라고 부른다. 보통의 디스플레이는 동작원리상 화면을 1초에 60번 갱신하게 되고, 또한 정확한 시뮬레이션이나 부드러운 애니메이션을 위해 비슷한 속도로 혹은 그 이상으로 새로운 영상을 생성한다. 따라서, 매 프레임 영상이 생성되고 화면 갱신하는 약 1/60초 사이에 센싱, 시뮬레이션, 영상 및 기타 피드백 생성이 이루어지지 않으면 그만큼의 Latency가 생기게 되고 사용자의 경험에 악영향을 끼치게 된다.

최근 증강현실에 대한 관심이 증가하고 있고 이미지 인식기반의 AR을 이용한 대학 시설 안내 해주는 연구가 진행되었다. 이와같이 실생활의 다양한 분야에서 AR이 적용되고 있으며, 특히 지역을 대상으로 하는 투어가이드 형태로서 증강현실 기술이 적용이 시도되고 있으나 현재 일반적인 스마트폰의 경우 센서 자체의 정확도 문제로 정밀한 트래킹이 어려우며, 비전 기반의 트래킹 기술의 경우 야외 환경의 조도 변화에 대한 트래킹 알고리즘이 아직 안정화 되지 않고 있다[7].

A. M. Khan은 사용자가 스마트폰을 지니고 있는 위치에 상관없는 특징을 추출하여 Autoregressive방법을 사용하여 사용자의 행위를 인지하는 방법을 제안하였다[8].

Yu-Chieh Yang는 가속도 데이터를 FFT(Fast Fourier Transformation)한 특징만을 사용하여 사용자의 행위를 인지하는 실험을 진행하였으나 실험 결과에서 이동수단의 인지 정확도는 낮게 나왔다[9].

미국 MIT의 SENSEable City Lab에서는 사용자의 행위의 종류를 Bus, Metro, Walk, Bicycle, Train, Car, Still, Motorcycle로 나누었다. x, y, z 축의 값으로 이루어진 가속도 데이터로부터 방향성을 제거한 크기만을 사용하여 사용자의 행위를 구분하여 인식하였다[10].

이효진은 증강현실을 지하시설물 관리에 적용하고, 그 위치오차를 계산하여 지하시설물 관리에 증강현실 적용 가능성을 제시하였다[11].

최근에는 객체인식 및 추적기술로 에지의 특징을 이용하는 방법이 연구되고 있다. 이전 프레임에서의 카메라 포즈를 이용하여 3차원 모델을 현재 프레임에 투영한 후 투영된 모델 에지와 카메라 영상에서 검출된 에지 사이의 오차를 최소화함으로써 이전 프레임과 현재 프레임 사이의 미소 카메라 포즈 변화를 추정할 수 있다. 추정된 포즈 변화를 이전 프레임의 카메라 포즈에 반영하여 현재 프레임에서의 카메라 포즈를 얻을 수 있다[12].

최초의 증강현실 플랫폼으로 불리는 ARToolKit은 Kato와 Billinghurst에 의해 개발되었으며 마커(Marker)를 기반으로 그 위에 가상 물체를 올릴 수 있는 기능을 제공하였다. ARToolKit은 2015년에 DAQRI에 인수되어 오픈소스로 공개되었다, 2017년 6월 애플(Apple)은 세계개발자회의(WWDC)에서 SLAM(Simultaneous localizationand mapping) 기반 증강현실 기술인 ARKit을 발표했으며 모바일 기기 모션 트래킹, 카메라 씬 캡쳐, 씬 프로세싱, 디스플레이 기능을 결합하여 증강현실 애플리케이션 개발을 지원하고 있다.

ARKit의 SLAM 기술은 VIO(Visual Inertial Odometry)기반으로 하고 있으나, 모바일 기기의 성능상 제약 때문에, 그래프 기반의 방법보다는 칼만 필터(Kalman Filter) 기반의 방식이 많이 이용된다[13],[14]. 이 방법은 카메라로부터 들어오는 영상을 컴퓨터 비전 알고리즘을 이용하여 분석함으로써 특징점(Feature Point)을 찾고, 이를 칼만 필터에 적용하여 IMU에서 발생하는 오차를 보정한다.

구글(Google)은 애플보다 먼저 듀얼 카메라를 이용한 증강현실 기술을 준비 중이던 탱고 프로젝트의 전략을 수정하여 단일 카메라만으로도 공간을 추적할 수 있는 ARCore 기술을 발표하였다.

Ⅲ. 모션 트래킹

3-1 ARCore와 ARkit

ARCore에서는 카메라로부터 얻어 온 컬러영상에서 특징점(Feature Point)들을 추출하고 이 점들에 대한 3차원 좌표값을 가진 포인트들의 집합인 포인트 클라우드를 생성한다. 특징점은 영상에서 주변과 구분되는 특징을 잡아낼 수 있는 점으로 물체의 모서리처럼 주변과 컬러값이 확연하게 구분되는 점들이며, 칼만 필터(Kalman Filter)를 적용한다. 또한 평면 인식(Plane Detection) 기능은 중력 방향을 이용하여 평면을 찾고, 다수의 평면이 발견되면 이를 결합(Merge)함으로써 평면을 확장한다. 이외에도 모션트래킹, 주변 환경 인지 및 광원 추정 기능을 제공하고 있어 개발자들이 쉽게 증강현실 애플리케이션을 만들 수 있도록 SDK를 제공하고 있다.

모션트래킹은 연속된 카메라 영상에서 관심 객체 사이의 상대적인 포즈 변화를 추정하는 기술로 IMU 센서인 가속도 센서, GPS, 자이로스코프 등의 센서를 활용하거나 카메라를 이용하는 비전 기반의 기술을 사용한다.

모션트래킹을 구현하는 방법은 관성추적, 자기추적, GPS, 광학추적, 혼합추적 등이 있으며, 이 중 관성 추적 센서를 이용한 방법에는 측면 가속도(Lateral Acceleration)을 기록하는 가속도계(Accelerator)와 회전 가속도(Rotational Acceleration)를 기록하는 자이로스코프의 두 가지 센서가 사용된다. 표 1은 모션트래킹 방법에 대한 장·단점을 표현하였다.

최근에 발표된 ARKit과 ARCore 라이브러리를 살펴보면 비전 기술을 이용한 특징 검출로 영상 내에서 주변과 크게 구별되면서 반복되지 않은 특징을 가진 일부 특징적인 점, 에지(edge), 영역(region) 등을 찾음으로써 보다 효율적인 인식 및 추적이 가능하도록 하고 있다. 이 특징은 주로 픽셀값의 변화가 큰 지점을 찾는다.

그리고 위치정보 오차 누적 때문에 객체가 정확하게 정합되지 않는 부정합 현상을 최소화를 위해 연산 속도는 유지하면서 연산량을 줄여 성능을 향상한 방법인 SURF(Speeded Up Robust Features)를 사용해 초기 특장점을 검출하고 검출된 특징점을 추적하여 위치정보의 오차를 줄인다.

최근 딥러닝(deep learning) 기법을 활용하여 카메라 포즈와 IMU 센서 측정치 사이의 관계를 학습하여, 이전 프레임에서의 포즈와 IMU 센서 측정치로부터 현재 프레임의 포즈를 얻은 후 칼만 필터를 이용하여 비전 기반 방법(특징 추적, PnP 이용)과 결합함으로써 평면 객체의 3차원 포즈를 정확하게 추적하는 방법도 제안되었다[15].

공개된 AR 라이브러리들의 지원항목들은 표2와 같다. 향후 서비스 고도화 및 제약 사항들을 고려하여 SLAM(simultaneous localization & mapping), Cloud recognition 지원여부가 주요 고려 대상이므로 SLAM은 로봇이 3차원 공간상의 자신의 위치를 인식(Localization)하고, 동시에(Simultaneously) 공간의 3차원 지도도 만드는 것으로 이를 매핑(Mapping)한다.

Ⅳ. AR 레이더 구현 및 테스트

4-1 축제지원 AR 레이더

축제/전시의 경우 행사진행 및 동선, 기상에 따른 변수가 많은 만큼 관리의 어려움을 최소화하여야 하고 행사 중 문의사항을 최대한 빠르고 정확하게 처리하여야 한다. 특히 현장 매니저가 직접 행사를 참여해 프로그램을 관리하여 현장에서 발생하는 리스크를 최소화할 수 있도록 안전 및 현장 돌발상황에 대한 체계적이고 신속한 관리의 현실화가 요구되고 있다.

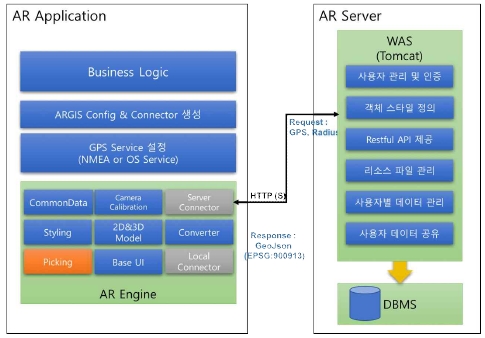

본 논문에서 제안하고 있는 AR 레이더 서비스는 방문객이 축제에서 주변 시설물 및 현장요원의 위치를 확인할 수 있도록 현재위치에서 실시간으로 주변시설물 및 축제정보를 AR 엔진으로 표출하도록 하였으며, AR 레이더 시스템은 축제 시설물/이벤트 장소의 POI(Point Of Interest)정보를 관리하는 관리 시스템, 공간정보 및 리소스 관리를 위한 AR 서버, 방문객의 위치에서 주변 정보를 AR 레이더 형태로 표현해주는 방문객 앱으로 구성된다.

AR 서버는 방문객 앱으로 요청받아 POI정보와 정보별 리소스 정보를 Restful API로 제공하여 AR 서비스 품질을 향상하도록 하였다. 방문객 앱의 AR 서비스는 장치 카메라를 기반으로 구동되며, 서비스 품질 향상을 위해 센서값 필터 및 영상 정합을 위한 주요 단말기 profile 적용하였다.

AR Engine은 Server Connector를 통해 AR-Server와 HTTP(S)프로토콜로 연결한 후 단말기의 위치와 Radius(검색반경)를 기준으로 AR-Server로부터 해당되는 공간정보, 속성정보, 스타일 정보를 GeoJson 형태로 수신한다. POI 데이터베이스로부터 수신한 공간정보, 속성정보, 스타일 정보를 바탕으로 POI 객체를 생성하여 단말기의 카메라 영상에 위치 마커 객체가 정합되어 표출되며 실시간으로 갱신되는 카메라 화면에 따라 정합되도록 한다.

디바이스의 이동, 회전 등의 움직임을 감지하여 디바이스의 변화된 포즈를 제공하는 모션트래킹을 지원하기 위해서는 얼마만큼 이동했는지에 대한 ‘위치 값’과 얼마나 회전되었는지에 대한 ‘방향값’이 필요하다. 기존 방식은 자이로스코프나 가속도계 등의 센서를 이용하나 센서에 대한 누적오차로 정확도가 크게 떨어진다.

최근에 발표된 ARkit, ARCore의 경우 비전 기반 객체 인식 및 추적을 위한 카메라 투영(projection) 행렬 계산, 영상 특징(image feature) 검출(detection)/서술(description)/매칭(matching) 등의 요소 기술을 사용하여 정확도를 향상시키고 있다.

본 연구에서는 카메라의 실시간 자세 변경에 따른 카메라 화면의 정합을 위해 ARCore 라이브러리를 이용하여 그림2와 같이 포인트 클라우드를 생성하였다.

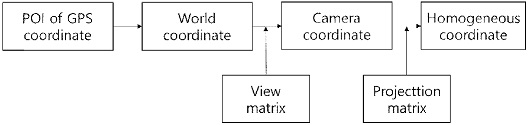

AR Radar는 가상의 공간에 서버로부터 전달받은 GPS좌표를 3차원 좌표값으로 변환하여 해당 마커를 표현할 때 사용자의 위치로부터 해당 GPS좌표까지의 거리로 산출된 뎁스(depth) 값을 이용한다.

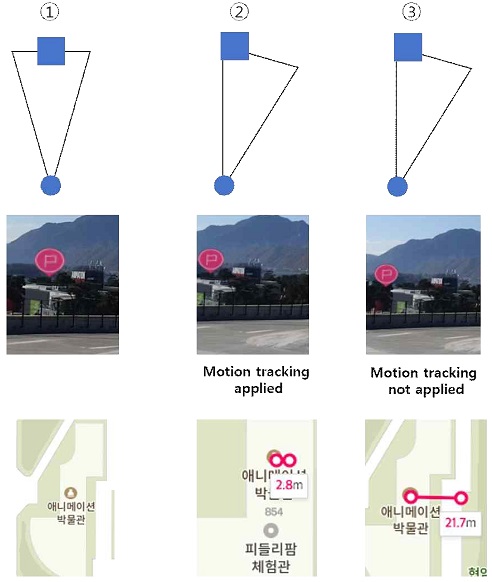

그림 3는 AR 레이더의 생성과정으로 모션 트래킹을 위한 디바이스의 움직임을 적용하기 위해서는 가상의 월드좌표 내에서 가상의 카메라가 바라보는 시점을 결정하는 뷰 매트릭스를 만들고 포인트 클라우드를 생성하여 움직이거나 회전한 현재의 포즈(pose)정보로 실제 디바이스의 움직임에 따른 변화를 적용한 것을 나타낸 것이다.

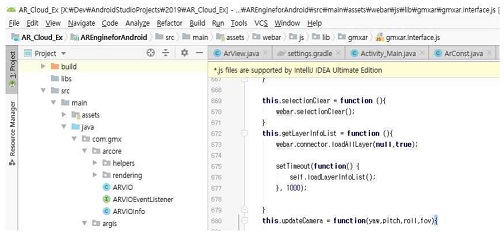

그림 4는 AR 레이더 서비스의 ARCore 라이브러리를 적용한 것을 나타낸 것이다. AR 레이더 모션트래킹 구현은 ARCore를 기반으로 디바이스 높이, 방향 등의 디바이스 포즈 정보로 구성된 ARVIO 객체와 포즈의 변경에 따른 이벤트 처리를 위한 ARVIOEventListener 그리고 이벤트에서 발생된 상대적인 디바이스 포즈 정보를 저장하는 ARVIOInfo 객체를 구현하였다. 디바이스 pose인 yaw, pitch, roll의 값을 스레드를 생성하여 3D 카메라의 매 프레임에 적용하도록 하였으며 매소드 ArConst.arView.updateCamera(info.yaw, info.pitch, info.roll, (float) info.vfov); 호출하여 모션 트래킹을 구현하였다.

그림 5는 구현된 AR 레이더 서비스를 나타낸 것이다. ⓵은 현재 위치에서 264m 떨어진 POI 지점에 마커를 생성하였다. ⓶는 오른쪽으로 30°회전한 모션트래킹을 비교한 결과로 ARCore를 적용한 마커의 위치는 2.8m의 오차를 보인 반면 IMU센서만 적용된 경우 건물의 중앙에서 21.7m만큼 벗어나 있다. 오차거리 측정방법은 목표지점인 애니메이션 박물관의 중심점으로부터 2D 지도상에서 떨어진 거리를 측정하였다.

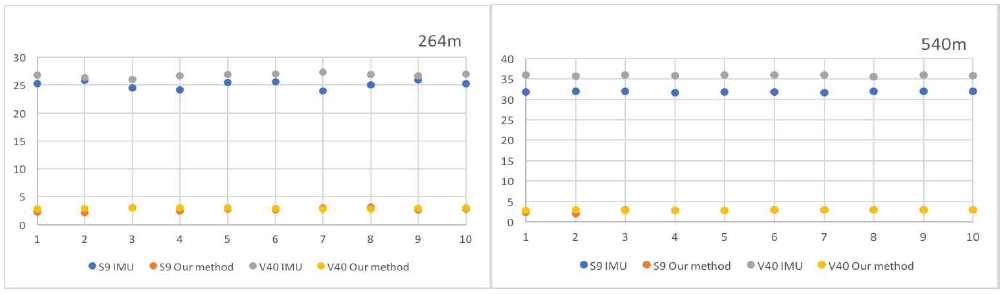

AR 레이더의 모션 트래킹 정확도 측정을 위해 각 디바이스를 트라이포드에 고정하여 3분간 안정화시킨 후 좌우로 30° 회전시켜 모션트래킹의 수행 정확도를 측정하였다. 각 디바이스에 대해 10회 반복 실험을 수행한 결과는 그림 6과 같다.

표 3은 거리별 모션트래킹 정확도로 디바이스별 최대 오차범위를 산출하였고 본 연구에서 구현된 모션트래킹을 적용하였을 경우 오차범위가 3m 이내로 거리별로 8.3% ~ 12%까지 정확도가 향상되었다.

아래의 표 4는 본 연구에서 구현된 AR 레이더로 디바이스를 상·하·좌·우로 이동하였을 때의 안정된 모션트래킹을 보여주고 있다.

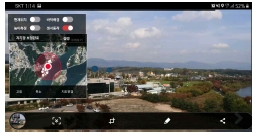

그림 6은 AR 레이더 서비스를 적용한 축제앱으로 축제 방문객에게 친숙한 UI/UX를 설계 적용하였고 축제 정보, 스탬프 투어, 비콘 서비스 등을 제공하고 있으며 AR 레이더의 뷰에서는 현재 위치에서 사용자가 도보로 가능한 거리 조절 및 카테고리별로 찾고자하는 시설물을 필터링하여 볼 수 있으며 거리에 따라 마커의 크기를 다르게 표현하였다.

Ⅴ. 결 론

본 연구에서는 지역축제 지원을 위한 ICT융합 서비스로 축제방문객이 자신의 위치에서 축제정보 및 시설물의 위치를 확인할 수 있는 AR 레이더 서비스를 구현하였다. 모션트래킹을 구현하는 방법은 IMU센서를 이용하는 방법과 영상기반의 정보를 이용하는 방법으로 나누어진다.

일반적인 GPS, 자이로스코프, 마그네틱센서 등의 하드웨어를 이용하는 방법은 스마트폰 디바이스에 따른 매우 큰 범위의 오차 결과를 보여주고 있어 사용자에게 AR에 대한 신뢰도가 매우 낮아 최근 정확도 향상에 대한 다양한 방법이 연구되고 있다.

AR 레이더 서비스에서는 ARCore에서 제공하는 모션트래킹을 적용하여 기존의 IMU센서에 비해 모션트래킹 정확도를 향상시켰다. 기존의 IMU센서의 경우 디바이스의 하드웨어에 의존적인 결과로 서비스의 일관성을 확보하기 어렵고 정확도 향상을 위해 고성능의 하드웨어를 추가해야 했으나 영상기반의 모션트래킹을 적용하여 높은 정확도와 디바이스간의 일관된 서비스를 제공할 수 있었다. 축제지역을 방문한 방문객에게 AR 레이더 서비스를 통한 방문객의 편의시설, 다양한 볼거리 정보 및 지역 상인과의 연계가 가능하도록 하였다.

본 연구에서는 축제지원 시스템의 AR 레이더에서 위치를 추정하는 다양한 방법 중 기존의 IMU의 정보만을 이용하던 방법에서 ARCore 라이브러리를 적용하여 모션트래킹 정확도를 향상시켰다. 고성능 외부 GPS 등의 하드웨어를 사용하는 방법들보다 정확도 및 사용 가능한 범위가 넓은 장점을 가지고 있다.

본 축제관리시스템을 통해 다양한 축제와 관련된 방문객들의 니즈를 정량적으로 파악하여 축제관리자, 축제 운영자, 방문객으로 수요대상을 구분하여 빅데이터를 활용한 다양한 패턴 분석 및 콘텐츠 개발과 관광지 및 맛집에 대한 정보를 추가하여 고부가가치적인 서비스 모델을 창출할 수 있다.

Acknowledgments

본 연구는 중소벤처기업부와 한국산업기술진흥원의 “지역특화산업육성(R&D, P0004928)사업의 지원을 받아 수행된 연구결과임.

참고문헌

-

G. Klein and D. Murray, "Parallel tracking and mapping for small AR workspaces," in Proc. IEEE and ACM International Symposium on Mixed and Augmented Reality, pp. 225-234, Sep. 2007.

[https://doi.org/10.1109/ISMAR.2007.4538852]

-

A. Davison, I. Reid, N. Morton and O. Stasse, "Monoslam: Real-time single camera slam," IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 29, Jan 2007

[https://doi.org/10.1109/TPAMI.2007.1049]

- Gi-Chun Seo, “A Study on the Effect of Regional Festivals on the Regional Economy,” Master’s Thesis, Chonbuk university, 2005.

- Hyun-Ji Kim, “A Study on the Development Direction of Cultural Space Contents for Local Festivals,“ Korea Society of Design Trend, Vol. 37 , pp143-153, 2012

-

Mark Billinghurst, Adrian Clark, and Gun Lee, “A Survey of Augmented Reality,“ Foundations -Computer Interaction, vol. 8, no. 2-3, pp. 73-272, 2015.

[https://doi.org/10.1561/1100000049]

- In-Kyeong. Cho and Hwa-jin, Park, “A technique ofcollision detection between virtual objects and real objects for increasing immersion of Augmented Reality system,” Journal of Digital Contents Society 10(4), 521-527. 2009

- Eun-Seok Kim, “Current Status and Prospect of Augmented Reality Applications in Cultural Heritage Field,“ Journal of Information Science, Featured Manuscript, Dec. 2016

-

A. M. Khan, Y.-K. Lee, S. Y. Lee, T. -S. Kim, ”Human Activity Recognition via An Accelerometer-Enabled-Smartphone Using Kernel Discriminant Analysis,“ Future Information Technology (FutureTech), 2010 5th International Conference on. 2010.

[https://doi.org/10.1109/FUTURETECH.2010.5482729]

- Yu-Chieh Yang, Tatsuo Toida, Chin-Ming Hong, “Transportations Prediction Using Build-in Triaxial Accelerometer in Cell Phone,” Department of Industrial Education of National Taiwan Normal University, 2010.

- Vincenzo Manzoni, Diego Maniloff, Kristian Kloeckl, Carlo Ratti, “Transportation mode identification and real-time co2 emission estimation using smartphones,” Massachusetts Institute of Technology(MIT), 2011.

- H. J. Lee, J. S. Kim, H. S. Seo, Y. S. Cho, “Development of Location based Augmented Reality System for Public Underground Facility Management,” Journal of Digital Contents Society, Vol. 19, No. 2, pp. 237-243, 2018.

- Hanhoon Park, SeoByung Guk, Jongil Park, “Model-based Camera Tracking Technology Trends,” Electronics Society, 39(2), pp 66-75, Feb. 2012.

- M. A. Shelley, “Monocular Visual Inertial Odometry on a Mobile Device,” Master’s thesis,Univesity of Munchen, 2014.

-

T. Qin, P. Li, and S. Shen, “VINS-Mono: A Robust and Versatile Monocular Visual-Inertial StateEstimator,” IEEE Transactions on Robotics, Vol.34, No.4, 2018.

[https://doi.org/10.1109/TRO.2018.2853729]

-

J. R. Rambach, A. Tewari, A. Pagani, and D. Stricker, “Learning to fuse: a deep learning approach tovisual-inertial camera pose estimation,” Proc. of ISMAR, pp. 71-76, 2016.

[https://doi.org/10.1109/ISMAR.2016.19]

저자소개

2000년 : 강원대학교 사료생산공학과(학사)

2003년 : 강원대학교 컴퓨터과학과(석사)

2008년 : 강원대학교 컴퓨터과학과(박사)

2018년~현재: ㈜프론트유 연구소장

2016년~2018년: ㈜알플레이

2011년~2016년: eLC

※관심분야: 유비쿼터스 컴퓨팅(AR), 사물인터넷(IoT) 등

1992년 : 강원대학교 전자계산학과(학사)

1995년 : 강원대학교 컴퓨터과학과(석사)

2002년 : 강원대학교 컴퓨터과학과(박사)

1997년~현재: 한림성심대학교 교수

2014년~현재: ㈜프론트유 대표이사

※관심분야: 유비쿼터스 컴퓨팅(AR), 사물인터넷(IoT), 디지털콘텐츠 등