VR 미디어 콘텐츠의 정량적 분석을 위한 감성 진단 플랫폼 개발

Copyright ⓒ 2018 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

공간기반의 VR 미디어 콘텐츠는 사용자와의 상호 감성/감각 상호작용이 중요하지만, 현재까지 이를 디자인하기 위한 연구는 부족한 실정이다. 본 논문에서는 사용자와 VR 미디어 콘텐츠의 상호작용을 정량적으로 분석하는 방안으로 생체신호를 수집하는 플랫폼을 개발하고, 수집된 생체신호를 분석하는 프로그램을 제안한다. 이를 바탕으로 VR 미디어 콘텐츠가 제작자의 의도와 얼마나 부합하는지 평가할 수 있다. 본 논문에서는 다음과 같은 내용으로 제안하는 플랫폼을 소개한다. 처음으로 플랫폼의 전체적인 구성과 생체신호 수집 센서를 설명하고, 이어서 사용자와 콘텐츠의 상호작용 정도를 분석할 수 있는 프로그램을 소개한다. 마지막으로 이 플랫폼을 사용하여 실제 VR 콘텐츠에 적용 실험을 하여 그 실효성을 평가하고 결론을 맺는다. VR 미디어 콘텐츠 제작자는 이러한 플랫폼을 사용하여 VR 콘텐츠의 품질 평가를 통한 시장성 있는 콘텐츠를 개발할 수 있을 것으로 기대된다.

Abstract

Space-based VR media content is important for emotion/sensual interaction with users, but there is insufficient research to design them. In this paper, we develop a platform for collecting bio-signals as a means of quantitatively analyzing the interaction between users and VR media contents, and propose a program to analyze collected bio-signals. Based on this, it is possible to evaluate how much the VR media content matches with the intention of the producer. In this paper, the platform is introduced as follows. It first describes the overall configuration of the platform and bio-signal acquisition sensor, and describes a program that can analyze how users interact with content. Finally, we use this platform to experiment with actual VR content, evaluate its effectiveness, and conclude. Through these platforms, VR media contents creators are expected to develop marketable contents through quality evaluation of VR contents.

Keywords:

Emotion Analysis, Evaluation Platform, Interaction Design, Quantitative Analysis, VR Media Content키워드:

감성 분석, 인터렉션 디자인, 정량적 분석, 평가 플랫폼, VR 미디어 콘텐츠Ⅰ. 서 론

최근 VR(Virtual Reality) 산업이 화두가 되면서 교육[1], 의학[2] 등 다양한 응용 분야에 VR 기술이 접목되고 있으며, 구글과 같은 거대 기업들이 VR 시장에 뛰어들어 시장 규모는 점점 증대되고 있다[3]. 여러 분야에서의 연구가 활발히 진행됨에 따라 VR 장치 및 활용 기술 또한 급속도로 발전하고 있다.[4] 하지만 VR 콘텐츠의 제작 측면에서 해상도, 프레임 속도, 색 영역, 음향, UI(User Interface) 등에 대한 업계 내 합의는 충분히 논의되지 않고 있다. 부분적으로 VR 콘텐츠제작 시 UI가 생산성에 미치는 요인연구[5], VR 콘텐츠의 품질 평가에 대한 논의[6]가 이루어지고 있지만, 여전히 관련 연구는 부족한 실정이다. 콘텐츠 제작에 관한 논의는 인간의 생체 신호를 수집하여 감정을 분석하는 Affective Computing[7]분야에 적용되어 콘텐츠 시청자의 생체신호를 수집하여 시청자의 감성을 분석하는 연구로 이어지고 있다.[8]

본 논문에서는 VR 콘텐츠의 품질 평가를 위한 방안으로 시청자의 생체신호를 수집하는 플랫폼과 수집된 생체신호의 분석을 돕는 프로그램을 제안하고자 한다. 분석된 신호는 콘텐츠제작자의 의도에 맞게 시청자의 감성이 유도되었는지 확인하고 이를 바탕으로 VR 콘텐츠의 품질을 평가한다.

본 논문의 구성은 다음과 같다. 2장에서는 본 논문에서 제시하는 플랫폼의 시스템 구성과 생체신호를 수집하는 센서에 대한 소개를 한 다음 3장에서 사용자와 콘텐츠의 상호작용 정도를 분석할 수 있는 프로그램에 대하여 설명한다. 4장에서는 플랫폼의 실효성을 검증하고, 5장에서 결론을 맺는다.

Ⅱ. 플랫폼 구성

2장에서는 VR 미디어 콘텐츠의 정량적 분석 플랫폼의 전체적인 시스템 구성과 플랫폼 내부 생체신호 수집을 위해 사용하는 센서를 설명하고자 한다.

2-1 시스템 구성

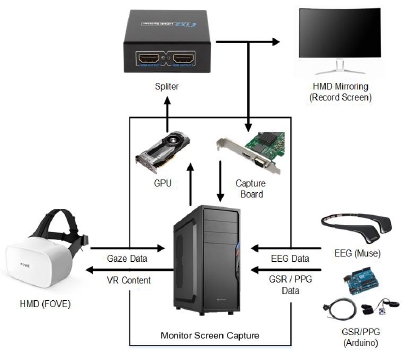

본 논문에서 제안하는 플랫폼의 시스템을 구성하기 위해서는 생체신호 센서, 화면 캡처 보드 및 화면 분배기(Spliter)가 필요하다. 먼저, 시청자가 HMD(Head Mounted Display)를 통해 보고 있는 화면을 미러링(Mirroring)하여 모니터에 출력한다. 그와 동시에 분배기와 캡처 보드를 연결하여 HMD에서 출력되는 화면을 녹화한다. 영상의 저장과 생체신호 센서는 PC 내부 프로그램의 신호에 따라 동기에 맞추어 저장하게 된다. 전체적인 시스템의 구성은 그림 1과 같다.

2-2 생체 신호 센서

제안하는 플랫폼에서 생체신호를 수집하기 위한 센서는 총 4가지로, EEG(Electroencephalography), PPG(Peripheral Plethysmograph), GSR(Galvanic Skin Resistance), Eye Tracking이다. 각 센서의 모습은 그림 2와 같다.

뇌파를 측정하기 위한 장비는 Muse를 사용한다. 이는 AF7, AF8, TP9, TP10 총 4채널을 사용하는 뇌파 측정 장비이다. 256 Hz로 샘플링 가능하며 블루투스를 이용한 무선통신을 사용한다.

피부 반응과 혈류량을 측정하기 위한 장비는 Grove-GSR Sensor와 Laxtha-RP520을 Arduino 보드에 연결하여 사용한다. 이 두 장비 100 ~ 1000Hz 내 원하는 범위의 주파수로 샘플링 가능하다.

시선 정보를 취득하기 위한 장비는 FOVE0를 사용한다. 이는 Fove 사에서 HMD 내부에 시선 추적 기능을 추가한 장비이다. 이는 시선을 추적하여 나온 시선 정보를 120 Hz로 샘플링 할 수 있으며, HMD 내부의 IMU(Inertial measurement Unit)센서를 통해 HMD의 움직임 정보를 받아올 수 있다. 이 정보는 추후 급격한 머리 운동에 대한 잡음차단 정보로 활용할 수 있다.

Ⅲ. 분석 프로그램

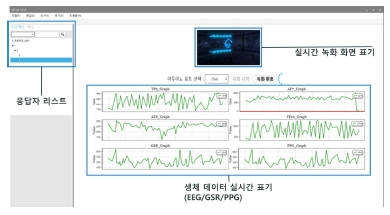

생체신호가 수집되는 과정은 그림 3과 같은 화면을 통해 관찰할 수 있다. 수집된 생체신호를 바탕으로 사용자의 감성을 분석하고 콘텐츠를 평가할 수 있는 분석 프로그램이 필요하다. 분석 프로그램의 기능은 크게 3종류로 분류된다. 첫째, 시선을 중점으로 분석하는 기능이다. 둘째는 GSR, PPG, EEG를 분석하는 부분이며, 마지막은 사전에 설정된 제작자의 의도 감성을 바탕으로 콘텐츠를 정량적으로 평가하는 기능이다.

3-1 시선 분석

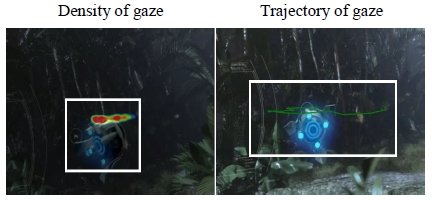

분석 프로그램에서는 VR 콘텐츠를 보며 취득한 시선 정보를 이용하여 다양한 시각화 방법을 통해 관찰할 수 있다. 또한, 제작자가 원하는 물체에 시선이 도달하였는지 정량적인 값으로 확인할 수 있다.

해당 장면에서 시청자가 어떤 영역을 집중해서 보았는지 시선 정보를 사용하여 표시한다. 시각화 방법은 두 가지로 첫 번째는 시선의 밀집 정도를 색상 변화를 통하여 시각화하는 기능이다. 시선 밀집도는 시선이 오래 머물면 붉은색으로 점점 넓은 영역에 표현되며, 시선이 거의 머물지 않은 지역은 푸른색으로 표현된다. (붉은색과 푸른색은 옵션을 통해 변경할 수 있다) 두 번째 방법은 시선의 흐름을 표시한 것으로 시선의 이동 이력에 대한 정보가 두꺼운 실선으로 표현된다. 시각화된 정보는 그림 4과 같다.

시선 정보 시각화에서 소개한 기능은 제작자가 원하는 물체를 측정자가 보았는지 그렇지 않았는지 확인할 수 있다. 하지만 이는 수동으로 매번 원하는 위치로 이동하여 시청자의 시선이 어디에 머물었는지 확인해야 하는 번거로움이 있다. 이를 자동화하는 방안으로 제작자가 보았으면 하는 객체를 설정하고 이를 추적하여 추적되는 영역 내 시선이 포함되었는지 확인한다. 제작자는 이 과정을 통해 나오는 결과를 바탕으로 본인이 시선을 유도한 객체가 얼마나 잘 유도되었는지 확인할 수 있다. 시선 집중도를 평가할 수 있는 화면은 아래의 그림5와 같다.

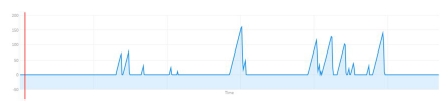

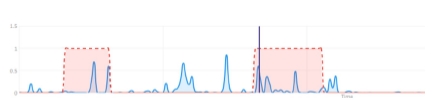

추적 프로그램에서 객체를 추적하기 위한 알고리즘은 KCF(Kernelized Correlation Filter)[7]를 사용하였다. KCF는 다른 알고리즘들에 비해 빠른 연산속도와 높인 인식률로 인해 객체 인식 분야에서 많이 사용되고 있는 알고리즘이다. 이는 베이스가 되는 객체에 대하여 특징점을 추출 및 변형하고 가상의 샘플을 모델링 함으로써 객체의 형태 변환에도 강인한 특성을 가진다. 객체와 시선의 매칭이 완료되면 결과는 그림 6의 그래프와 같다.

매칭 그래프의 결과는 가로축이 시간 세로축은 점수로 해석할 수 있다. 특정 구간에 솟아오른 영역은 제작자가 의도한 객체를 시청자가 놓치지 않고 잘 보았음을 의미한다.

3-2 감성 분석

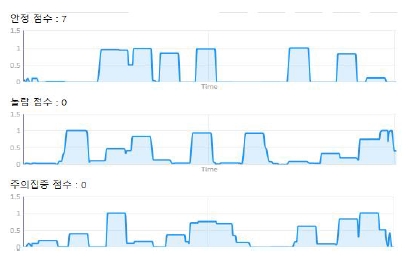

본 플랫폼에서는 기존의 설문조사 기법을 벗어나 VR 미디어 콘텐츠를 정량적으로 평가하려는 방안으로 측정자의 생체신호를 기반으로 감성 분석을 하고자 한다. 측정자의 감성을 분석하기 위해 수집된 생체신호를 선택적으로 사용하였다[9]-[14]. 분석된 감성 그래프는 아래의 그림7과 같이 그래프의 형태로 표현된다.

그림 7은 각기 다른 3가지 감성의 결과 그래프이다. 그래프의 가로는 시간 세로는 감성의 강도이다. 이 그래프를 바탕으로 제작자는 제작 의도에 맞게 측정자가 특정 감성을 느꼈는지 확인할 수 있다.

3-3 VR 콘텐츠의 정량적 분석

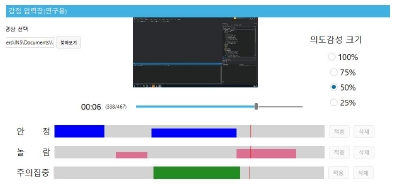

감성 분석결과를 바탕으로 측정자의 감성을 분석할 수 있다. 이를 바탕으로 VR 제작자의 의도대로 제작되었는지 정량적으로 평가할 수 있다. 미디어 콘텐츠의 정량적 평가를 위해서는 제작자의 의도 감성 구간 설정이 필요하다. 콘텐츠의 제작 의도는 제작자만이 알고 있으므로 이 부분에 관해서는 제작자가 정확하고 정밀하게 설정해야 신뢰성 있는 분석결과를 얻을 수 있다. 의도 감성을 설정할 수 있는 편집 도구는 아래의 그림 8과 같다.

설정된 의도 감성을 바탕으로 의도 감성 그래프가 생성되며, 그 결과는 아래의 그림 9와 같이 측정자의 감성과 함께 표시된다.

위의 그래프로 콘텐츠제작자는 본인이 의도한 구간에서 시청자들이 실제로 해당 감성을 느꼈는지 시간별로 확인할 수 있다. 이 두 그래프를 바탕으로 시간별 점수가 아닌 하나의 감성 당 하나의 점수로 산출하는 것도 가능하다. 산출되는 점수는 두 가지로 의도 감성 영역 내의 점수와 영역 외의 점수로 볼 수 있다. 영역 내의 점수는 콘텐츠가 제작자의 의도에 맞게 설계되었는지 판단할 수 있는 지표이며, 영역 외의 점수는 의도하지 않았지만 유발된 감성으로서, 이는 좋은 영향을 끼칠 수 있고 나쁜 영향을 끼칠 수 있는 잠재적인 값이다.

Ⅳ. 플랫폼 실효성 검증

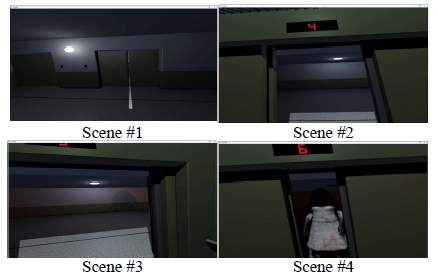

현재 VR 콘텐츠를 보며 수집한 생체신호를 정량적으로 분석하는 어떠한 방법론도 제시되고 있지 않기 때문에 플랫폼의 우수성과 실효성을 객관적 지표로 검증하는 데 어려움이 있다. 따라서 본 논문에서는 제안하는 플랫폼을 간접적으로나마 실효성을 검증해보고자 한다. VR 플랫폼의 성능을 평가하는 방법으로 측정자에게 놀람 감성을 유발하는 공포 영상[15]을 보여준 후 실제로 귀신이 등장하는 시점에 시청자가 놀랐는지 감성 분석 그래프를 통해 확인한다. 20대 성인 남녀 5명을 대상으로 실험하였으며, 이들의 평균 놀람 감성 그래프를 관찰한다. 아래의 그림10은 영상에서 놀람 감성을 유발하는 구간을 보인 것이다.

그림 10의 장면들은 제작자의 관점에서 놀람 감성을 유발하였을 것이라 판단되는 장면 4개를 선정한 것이다. 귀신이 등장하는 장면이 나오는 구간에서의 놀람 감성을 관찰한 결과는 아래의 그림 11과 같다.

그림 11의 붉은색 그래프는 5명의 평균 감성을 나타내는 그래프이다. 실험 결과 실제 놀람을 유발하는 장면에서 놀람 감성 그래프가 큰 값을 가지는 것을 확인하였다. 이러한 결과를 바탕으로 제작자는 본인이 원하는 구간에서 시청자들이 실제 느끼고 있는 감성을 확인하고, 콘텐츠를 보완 가능할 것으로 보인다.

Ⅴ. 결 론

본 논문에서는 측정자의 생체신호를 수집하고, 이를 바탕으로 감성을 분석하여 VR 미디어 콘텐츠를 평가하는 플랫폼을 제시하였다. 이는 측정자가 느끼는 감성이 제작자의 의도와 얼마나 일치하는지를 분석하여 콘텐츠를 평가할 수 있도록 하기 위함이다. 이러한 분석결과를 바탕으로 VR 미디어 콘텐츠 제작자는 시청자들에 맞춤형 고품질 VR 콘텐츠를 개발 가능할 것으로 보인다. 또한, 콘텐츠에 대한 고객 반응 및 만족도 측정을 통해 제작자와 기업의 신뢰도 및 시장 경쟁력을 강화할 수 있을 것으로 보인다. 하지만 제안하는 플랫폼의 감성을 분석할 시 사용되는 센서의 개수 부족과 단순한 감성 평가 알고리즘으로 인해 높은 신뢰성을 가진 결과를 산출하는 데 어려움이 있다. 이는 추후 멀티모달 신호 분석 알고리즘을 개선하면 고품질의 결과를 산출할 수 있을 것으로 보인다.

Acknowledgments

본 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2017년도 문화기술 연구개발 지원사업으로 수행되었습니다.

References

-

Kelly, A. M., Oyewole, O., Adrienne, H. I., & James, D. I., "Through the eyes of a bystander: The promise and challenges of VR as a bullying prevention tool,", in Proceeding of 2016 IEEE Virtual Reality, Greenville: SC, p229-230, March), (2016.

[https://doi.org/10.1109/vr.2016.7504737]

-

Lizeth, V. M., Byron, P. G., Gerardo, T., Alvaro, U. Q., & Norman, J., "VR central venous access simulation system for newborns,", in Proceeding of 2014 IEEE Virtual Reality, Minneapolis: MN, p121-122, April), (2014.

[https://doi.org/10.1109/vr.2014.6802081]

- The Statistics Portal, The Worldwide Virtual Reality Market Is Set To Be Huge [Internet], Available: https://www.statista.com/chart/6677/the-worldwide-virtual-reality-market-is-set-to-be-huge/.

- Lim, E.S., Yun, S.Y., Ko, Y.S., Jung, H.Y., and Choi, H.S., “Implementation of a Low-cost Virtual Reality System Using Smart Phone”, Journal of Digital Contents Society, 19(7), p1237-1244, July), (2018.

- Max, K., Goshiro, Y., Takafumi, T., Christian, S., Hirokazu, K., & Steven, F., "Evaluating Positional Head-Tracking in Immersive VR for 3D Designers,", in Proceeding of 2016 IEEE International Symposium on Mixed and Augmented Reality, Merida, p192-193, February), (2017.

- Pierre, P. R., "Virtually Perfect: Factors Affecting the Quality of a VR Experience and the need for a VR Content Quality Standard,", in Proceeding of SMPTE 2016 Annual Technical Conference and Exhibition, Los Angeles: CA, p1-20, January), (2017.

- Picard, R., Affective Computing, MIT press, (1997).

- Youtube, Eye-Brain wave based VR Ingerface technology. [Internet], Available:https://www.youtube.com/watch?v=dzJj2yz V6E8&t=1369s Oct, 1), (2018.

-

Henriques, J. F., Caseiro, R., Martins, P., & Batista, J., “High-Speed Tracking with Kernelized Correlation Filters”, The Journal of IEEE Transaction on Pattern Analysis and Machine Intelligence, 37(3), p583-596, March), (2015.

[https://doi.org/10.1109/tpami.2014.2345390]

- Cahn, B. R., & Polich, J., Polich, Meditation states and traits: EEG, ERP, and neuroimaging studies, in Psychological bulletin, p180-211, (2006).

- Npj Science of Learning, Surprise responses in the human brain demonstrate statistical learning under high concurrent cognitive demand [Internet], Available:https://www.nature.com/articles/npjscilearn20166.

- Nature Reviews Neuroscience, Visual attention: Insights from brain imaging. [Internet], Available:https://www.nature.com/articles/35039043.

- Dillen, L. F. V., Heslenfeld, D. J., & Koole, S. L., “Tuning down the emotional brain: An fMRI study of the effects of cognitive load on the processing of affective images”, The journal of NeuroImage, 45(4), p1212-1219, May), (2009.

- Dharmawan, Z., Analysis of Computer Games Player Stress Level Uisng EEG Data. in Delft University of Technology, Netherlands, August), (2007.

- YouTube, Elevator Horror VR. [Internet], Available: https://www.youtube.com/watch?v=thKcdt2vAqY.

저자소개

2014년 ∼ 2017년 : 서경대학교 컴퓨터공학과 (공학학사)

2018년 ∼ 현 재 : 서경대학교 전자컴퓨터공학과 (석사과정)

※관심분야: 디지털 영상처리, 컴퓨터 비전

1982년 : 고려대학교 (공학학사)

1984년 : 고려대학교 (공학석사)

1990년 : 고려대학교 전기공학 (공학박사)

1983년 ~ 1985년: 동양정밀공업(OPC) 중앙연구소 연구원

1986년 ~ 1988년: 삼성종합기술원 선임연구원

1989년 ~ 1991년: ZyMOS 한국지사 FAE

1995년 ~ 현 재: 서경대학교 컴퓨터공학과 부교수

※관심분야: 디지털 영상처리, 영상신호처리(ISP), 영상/비디오시스템