로케이션 매핑 영상 콘텐츠 서비스 플랫폼 개발

Copyright ⓒ 2018 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

지난 수년간 지오태깅된 영상 콘텐츠에 대한 연구는 촬영위치와 방향 데이터를 기반으로 가시영역 모델(view frustum)을 정의하였고, 효율적으로 검색하기 위한 색인 및 질의 검색기법을 연구해왔다. 기존 가시영역 모델이 정적인 가시거리 값을 사용하고 있는 한계를 가지고 있으며 영상 콘텐츠를 지도위에 표시하는 단편적인 서비스만을 제공하고 있다. 이 논문에서는 촬영위치자세 데이터를 획득할 수 있는 방법을 제시하고, 공간객체 데이터를 이용하여 가시거리가 변경될 수 있는 가시영역 모델을 제안한다. 또한, 영상 콘텐츠를 촬영한 현장에서 더욱 실감나게 매핑할 수 있도록 영상정합 기법을 접목한 증강현실 서비스를 설명한다.

Abstract

In recent years, In recent years, research on geo-tagged image contents has defined a view frustum based on filming location and direction data and has studied indexes and various query search techniques for efficient search. The existing view frustum model has a limit of using the static visible distance and provides a simple service that displays the huge image contents on the digital map. We show a method to acquire filming location and attitude data and propose a view frustum model that can change the visible distance using geospatial object data. In addition, we describe the augmented reality service that combines the image matching technique so that it can be mapped in the scene where the image contents are captured.

Keywords:

Attitude, Augmented Reality, Geo-tagging, Location, Mapping키워드:

지오태깅, 위치, 자세, 매핑, 증강현실Ⅰ. 서론

인터넷의 급속한 발전으로, 데이터를 공유하는 사용자들이 점점 늘어나고 있으며, 멀티미디어를 생성하고 전송하는 일이 더 쉬워지고 있다. 또한, 고해상도 카메라와 지자기센서, 위성 항법 장치 (GNSS; Global Navigation Satellite System) 수신모듈과 같은 다양한 센서들을 장착한 스마트 기기가 보급되면서 언제 어디서나 콘텐츠를 구축할 수 있는 환경이 제공되고 있다. 플리커(Flickr)와 같은 소셜 이미지 공유 서비스는 웹을 통해 엄청난 양의 사진과 비디오 콘텐츠를 모으고 있다. 이중에서 많은 양의 콘텐츠들이 촬영시의 위치정보, 즉 위도와 경도값을 포함하고 있다. 플리커의 경우, 2009년 기준으로 전체 업로드된 사진들 중 약 3.3%에 해당하는 1억 개 이상의 사진이 위치정보를 포함하고 있다[1].

위치정보가 포함(geo-tagging, 지오태깅)된 콘텐츠에 대한 연구는 내용기반 검색 (CBIR; Content-Based Image Retrieval) 연구 분야와 함께 전통적인 공간정보 분야에서도 활발히 진행 중이다. 내용기반 검색은 색상, 질감 및 모양과 같은 시각적 특징을 기반으로 영상을 색인하여 검색을 수행하는 기법을 사용하였다[2]. 위치와 방향정보를 가진 영상에 대한 검색은 영상과 별개로 저장되는 메타데이터를 대상으로 하며, 대표적인 기법은 포인트 질의(point query), 영역질의(range query), 방향기반 질의(directional query) 등의 기법에 대해 연구해 오고 있다[3]. 이 기법은 촬영위치와 방향과 같은 메타데이터를 색인으로 생성하여 신속하게 검색할 수 있도록 하였다.

현재 위치와 방향정보를 기반으로 검색된 영상 콘텐츠는 스마트 기기에서 제공하는 개방형 지도 위에 마커 혹은 썸네일 등으로 제공되고 있다. 반면, “이 사진을 찍을 당시 촬영자는 어떤 자세로 찍었을까?” 혹은 “이 촬영 장면을 촬영한 장소에서 재생하고 싶다”와 같은 요구는 해결해 주지 못하고 있다. 이러한 서비스의 한 예로는, 현재 드라마나 영화 촬영 장소를 방문하는 경우, 장면의 이미지와 설명을 안내판에 설치해 홍보하고 있는데, 이 안내판을 스마트 기기를 통해 생생하게 재생하는 것이다. 즉, 드라마 촬영지에서 촬영 장면을 1)촬영위치자세 메타데이터를 대상으로 후보 콘텐츠를 검색하고, 2)보고자 하는 콘텐츠와 스마트 기기의 카메라로 입력되는 실시간 배경을 정합하여, 해당 콘텐츠를 플레이하는 서비스이다.

Ⅱ. 관련연구

이 장에서는 지속적으로 급증하고 있는 지오태깅된 이미지와 동영상들을 효과적으로 관리하고, 축척된 대용량의 영상 콘텐츠를 모바일 사용자에게 위치기반의 서비스로 제공하기 위한 최근 연구들을 요약한다. 디지털 기기를 이용하여 촬영위치 및 자세 데이터를 획득하는 연구, 위치 및 방향 데이터에 대한 색인기법과 질의 방법에 대한 연구 등을 포함하였다.

지난 수년간 지오태깅된 영상 콘텐츠에 대한 연구가 광범위하게 수행되어 왔다. 사진과 동영상의 메타데이터에 대한 대부분의 연구에서는 촬영당시의 위치(위도, 경도), 방향, 장소 이름 등만 다루었다[4]-[7]. 촬영위치 메타데이터를 사용하여 2D이미지에 대한 다양한 검색 작업을 제공할 수 있지만 촬영자세를 기록한 데이터가 없어 더 지능적인 검색 서비스를 사용할 수 없는 한계가 존재한다.

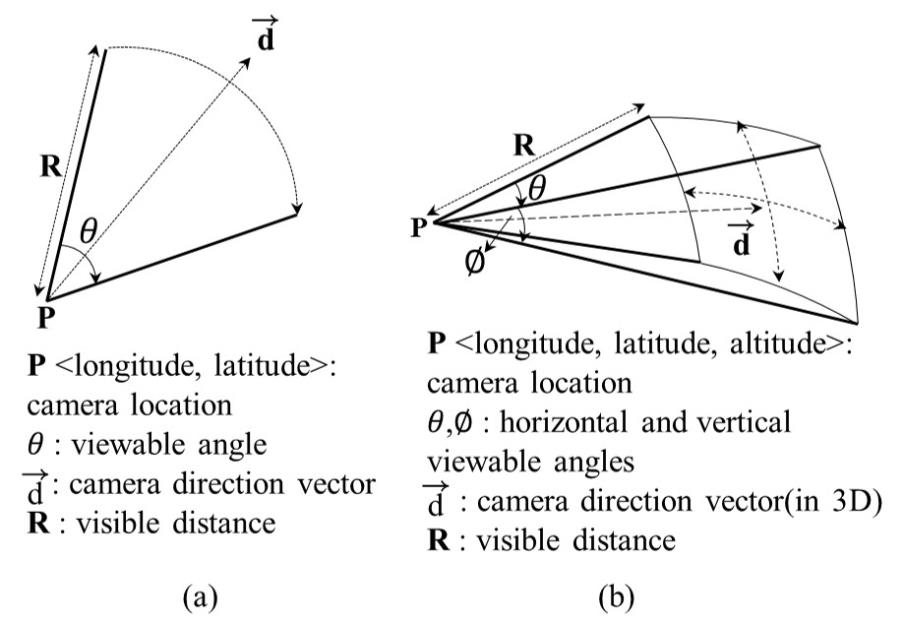

촬영방향 데이터와 시야각 정보를 이용하여 그림 1과 같이 가시영역(view frustum)을 정의하고, 다양한 질의를 제공하여 더욱 적절한 영상을 검색해 주는 기법을 연구해 오고 있다[8]-[10]. 더 나아가 촬영위치자세 정보를 효과적으로 제공하기 위해 위치와 방향데이터에 대한 색인 기법을 연구하였다[11]-[14]. 이 연구들에서 정의한 가시영역 모델(FOVScene)을 결정하는 데이터 중에서 가시거리(visible distance)를 구하는 방식은 촬영되는 빌딩의 높이와 이미지센서의 높이, 초점거리 값으로 계산[9]하였기 때문에, 실제 카메라로 입력되는 장면 속에 포함된 객체들이 어떤 배치와 가시선을 가지느냐에 따른 가려짐을 고려하지 않은 단점을 가지고 있다. 또한, 검색 결과를 단순히 디지털 지도위에 올려놓는 수준의 인터페이스만을 제공하고 있는 한계를 가지고 있다.

이 논문의 구성은 다음과 같다. 제3장에서는 로케이션 매핑을 위한 사진과 동영상의 촬영위치자세 메타데이터를 정하고 가시영역 모델을 정의한다. 제4장에서는 로케이션 매핑 영상 콘텐츠의 촬영위치자세 데이터에 대한 교환형식을 정의하고, 촬영위치자세를 획득하기 위해 제작한 부착장비에 대해서 기술한다. 또한, 구축한 로케이션 매핑 영상 콘텐츠를 검색하는 방법과 서비스 시나리오를 포함한 시스템 개발 내용을 기술한다. 마지막으로 제5장에서 이 연구에 대한 결론을 정리한다.

Ⅲ. 로케이션 매핑 영상 콘텐츠 모델

이 연구에서의 로케이션 매핑 영상 콘텐츠는 정지영상, 동영상 및 360도 영상을 포함한다. 이 영상 콘텐츠들은 기본적으로 이미지 파일로 촬영기기에 저장되는 동시에 촬영시에 어디에서, 어떤 자세로, 어떤 속성을 가진 장비로 촬영을 했는지를 나타내는 촬영위치자세 메타데이터를 기록하였다. 또한, 이 메타데이터로부터 방향성을 가진 공간모델을 정의하였다.

3-1 로케이션 매핑 영상 콘텐츠 메타데이터

로케이션 매핑 영상 콘텐츠 메타데이터는 촬영시의 위치정보, 촬영방향, 촬영자세정보와 이미지센서 크기와 촬영시의 기기설정 값 등을 포함한다.

촬영위치정보는 로케이션 매핑 영상 콘텐츠에 대한 공간검색을 위해 저장되는데, 최근 대부분의 디지털 기기는 GPS 신호를 수신하여 위치를 자동 태깅하는 기능을 대부분 제공하고 있다. 촬영방향값은 진북방향을 기본으로 0도~360도 값으로 기록하였는데, 공간검색을 확장하여 촬영하는 방향에 대한 검색 조건을 만족하는 영상을 찾기 위해 이용하였다. 촬영위치정보와 방향값은 4장에서 설명한 것처럼, 디지털카메라에 부착할 수 있는 모듈을 제작하여 획득하였다. 촬영자세정보는 카메라가 어떤 자세로 촬영을 하였는지를 계산하기 위해 3축 회전값으로 정의하였다. 롤(roll)은 이동방향인 종축(longitudinal axis) 주위로의 회전 또는 진동 값이고, 피치(pitch)는 이동 방향에 대해 수직의 수평면에 있는 횡축(lateral axis) 주위의 회전값을 의미하며, 요(yaw)는 이동방향에 대해 수직의 수직면에 있는 세로축(vertical axis) 주위의 회전값이다. 촬영 가시영역을 생성하기 위해서 시야각 (FOV; Field Of View) 데이터가 필요하다. 이 시야각을 계산하기 위해서는 카메라의 이미지센서의 크기와 초점거리(focal length)가 요구된다. 초점거리는 렌즈와 이미지센서와의 거리를 나타내며, 이 연구에서는 제조사양을 조사하여 이미지의 센서 크기와 초점거리를 기록하였다. 이 연구에서 사용한 EOS 6D의 이미지센서는 가로, 세로가 각각 35.8mm, 23.9mm 이며, 초점거리는 24.0mm 이다.

피사체를 촬영하는 경우, 보통의 경우 카메라를 가로 또는 세로 방향으로 세워서 촬영한다. 어떤 방향으로 촬영하느냐에 따라 시야각이 달라질 수 있기 때문에 회전정보를 기록하였다. 즉, 카메라의 조작에 따라 가로(landscape)와 세로(portrait) 형태의 영상으로 촬영될 수 있기 때문에 이 모드(orientation) 값을 활용하였다. 이 값들은 영상과 함께 EXIF(Exchangeable Image File Format) 에 저장되는데, 이 포맷은 일본 전자산업진흥협회에서 개발한 표준이다.

3-2 로케이션 매핑 영상 콘텐츠 모델

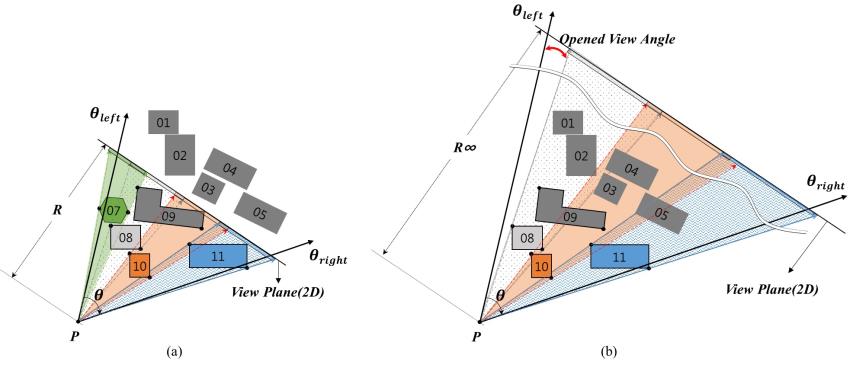

로케이션 매핑 영상 콘텐츠 메타데이터로부터 만들어지는 부채꼴 모양인 방향성을 가진 공간모델을 가시영역 (VF; View Frustum)이라고 정의하였다. 이 모델은 앞서 설명한 FOVScene 모델을 기반으로 하였다. 이 연구에서는 가시영역 모델을 촬영기기를 통해 입력되는 공간이 건물과 같은 물체에 얼마나 가려지느냐에 따라, 두 가지 형태를 가지는 것으로 정의하였다. 이 두 형태의 차이는 카메라가 위치한 곳에서 촬영방향에 직교하는 가시평면(view plane)으로 건물과 시설물 같은 객체를 투영하는 경우, 시야각의 모든 가시평면이 가려지는지 혹은 열린 공간이 있는지에 따라 결정하도록 하였다. 이것은 가시영역이 만들어지는 크기는 가시거리에 의해서 결정되기 때문이다. 투사평면이 모두 가려지는 경우를 닫힌 가시영역(closedVF)이고, 그 외의 경우는 열린 가시영역(openedVF)으로 정의하였다.

그림 2에서 시야각(θ)내에 포함되어 촬영되는 시설물들은 가시거리가 계산되기 전인 가상의 가시영역 내에 포함되는 객체들이다. 카메라의 위치(P)에서 촬영방향으로부터 입력되는 화면에는 각 객체가 점유하는 가시각(visible angle)을 가지고 있다. 이 가시각들을 가시평면으로 투영해보면, 촬영화면의 시야각의 일부 혹은 전체에 포개지게 된다. 이 때 순차적으로 투영하면서 가시각들의 합집합이 촬영 시야각과 같거나 포함하는 경우가 발생할 수 있다. 그림 2의 (a)가 이와 같은 경우를 나타낸 것으로, 가시거리가 R로 결정된다. 반면, 그림 2에서 (b)에는 (a)에 있던 객체(07)가 없는 경우다. 이 경우는 가상의 가시영역에 모든 객체를 투영한다고 해도 가시각들의 합집합이 촬영 시야각보다 작아서 열린 가시각(opened visible angle)이 발생한다. 이 경우는 가시거리를 결정할 수 없기 때문에, 가상의 가시영역을 설정하였던 디폴트 가시거리를 부여한다.

두 모델은 촬영하는 장소에 건물의 유무, 지형의 형태, 촬영 상하의 방향 등에 구분이 어려울 수 있다. 예를 들면, 촬영기기를 바닥이나 하늘 방향으로 향하거나, 지형을 고려할 정도의 지형을 배경으로 하는 경우 등이 해당한다. 따라서 이 연구에서는 2차원 공간상에 표현할 수 있는 가시영역으로 제한하여 촬영 영상의 가시영역을 대상으로 연구하였다.

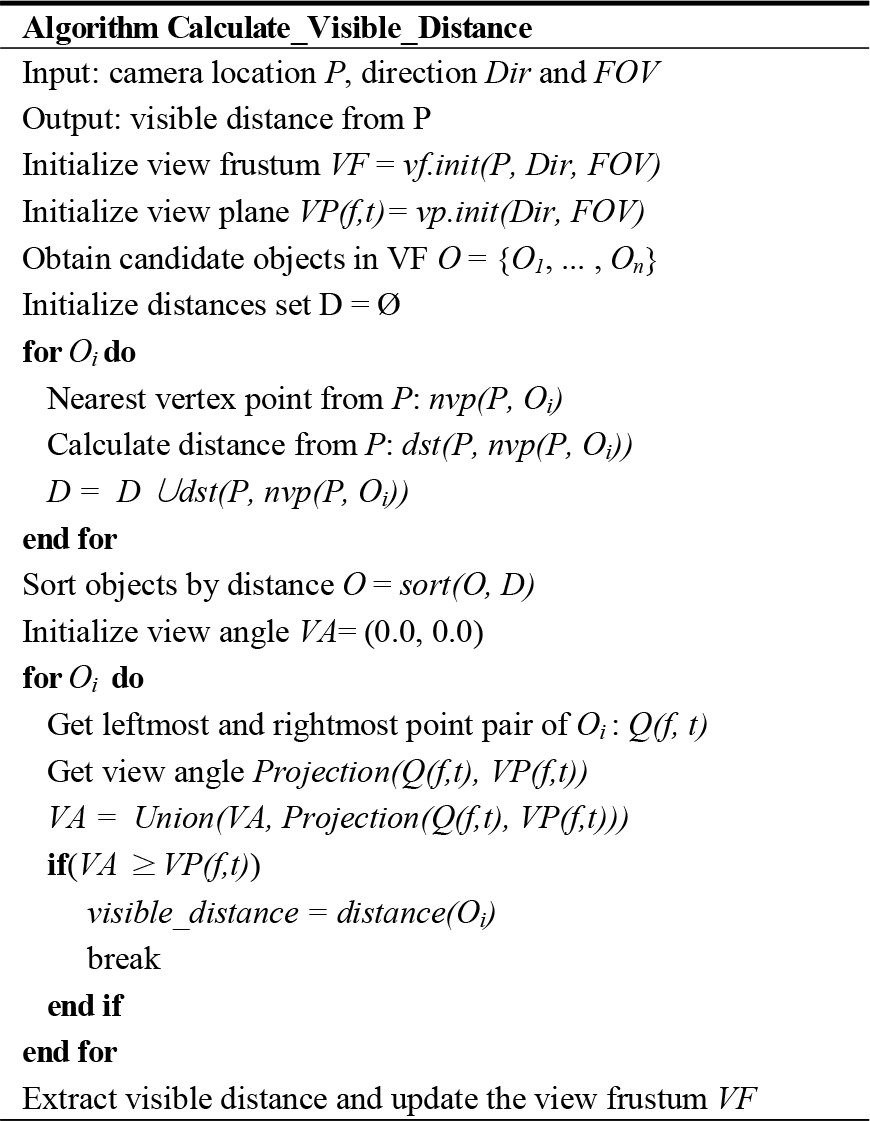

위에서 설명한 가시영역을 구하기 위한 가시거리를 계산하는 알고리즘은 그림 3과 같다. 주어진 촬영장소의 위치와 방향 그리고 시야각이 주어진다. 초기 설정한 임의의 가시거리(약 1km)와 이 값들로부터 가시영역과 가시평면의 범위를 계산할 수 있다. 초기 가시영역과 교차(intersect)하는 객체들을 공간데이터베이스로부터 조회한다. 각 객체의 꼭지점 중에서 촬영위치와 가장 가까운 점을 구하고 거리를 계산한다. 후보 객체들에 대해 모두 최단거리를 구한 후, 거리가 가까운 순으로 객체들을 정렬한다. 거리순으로 정렬된 객체들에 대해 촬영위치에서 가시선(line of sight)에 해당하는 최단 좌측과 우측 점을 구한다. 이 최단 좌우측점이 이루는 가시각을 가시평면에 투영한다. 정렬된 객체들을 순차적으로 투영하면서 가시각들을 합집합 연산을 수행한다. 각 단계에서 합쳐진 가시각이 초기의 가시평면의 법위와 같거나 포함하는 경우 반복수행을 마치고, 마지막 객체까지의 거리를 계산하여 가시거리를 수정한다. 이 갱신된 가시거리를 가지고 가시영역을 수정한다.

Ⅳ. 로케이션 매핑 영상 콘텐츠 서비스 플랫폼

로케이션 매핑 영상 콘텐츠 활용하기 위해서는 촬영 시의 위치와 자세정보를 획득하는 것이 필요하다. 이를 위해 이 연구에서는 탈부착이 가능한 위치 및 자세정보 기록 장비를 제작하였다. 정지영상은 물론, 동영상과 360도 영상을 촬영한 영상의 위치, 자세정보를 기록하도록 장비를 제작하였다. 정지 및 동영상 콘텐츠를 촬영하는 디지털 카메라에 부착할 수 있도록 소형의 부착장비를 제작하였고, 드론과 결합하여 광범위한 공간과 360도 영상 콘텐츠를 촬영할 수 있도록 별도의 장비도 제작하였다.

스마트폰, 패드 등 모바일 기기를 이용해 로케이션 매핑 영상 콘텐츠를 촬영하는 경우에는 모바일 기기에 내장된 센서들로부터 획득한 위·경도 좌표와 자세정보를 활용하였으며, 전용 앱을 통해 영상 콘텐츠를 촬영하도록 하였다.

이 연구에서는 영상 콘텐츠 및 촬영자세 정보를 저장·관리하고 촬영위치, 촬영방향, 영상의 형태 등 사용자의 질의 조건에 해당하는 영상 콘텐츠를 조회, 검색하는 기능을 제공하였으며, 영상의 촬영자세 정보를 조건으로 검색한 영상을 카메라로 입력되는 실시간 영상에 오버레이 하여 매핑할 수 있는 알고리즘을 개발하였다.

4-1 로케이션 매핑 영상 콘텐츠 구축 시스템 개발

3장에서 정의한 로케이션 매핑 영상 콘텐츠 구축 모델을 기반으로 교환포맷 및 메타데이터 스키마를 설계하였다. 이어서 모바일 기기와 통합센서 기반의 소형부착장비를 이용해 촬영한 영상의 촬영위치, 자세 정보를 기록하는 시스템을 개발하였다.

정지영상의 촬영위치, 촬영자세 데이터를 서브시스템 간에 교환하기 위한 형식을 아래 예제와 같이 정의하였으며, 서브시스템 간에는 JSON 형식으로 전달할 수 있도록 하였다.

{ "GPS": { "latitude": 37.265213, "longitude": 127.038071, "altitude": 51.90, "direction": 220.11 }, "AHRS": { "roll": 1.85, "pitch": 5.04, "yaw": 220.11 }, "CAMERA": { "DateTimeOriginal": "2015:10:09 20:57:11", "Orientation": 1, "FocalLength": 28.00, "DigitalZoomRatio": 1.00, "ScenceCaptureType": 0, "FOV": 75.3806, "CCD": { "width": 36.00, "height": 24.00 } } } |

시야각은 이미지 센서의 폭길이와 초점거리 값을 이용하여 아래 식(1)과 같이 구하여 기록하였다.

| (1) |

동영상과 360도 영상 콘텐츠의 촬영위치자세는 정지영상과 유사하다. 정지영상은 한 컷에 대한 위치자세정보를 기록하기 때문에, 이를 반복하는 배열형태로 정의하였다. 동영상이 시작하는 시점에서 각 프레임별로 위치자세를 기록하였고, 키값 중에 DataNo는 프레임순서를 의미한다.

{ "ContentType": 2, "DateTimeOriginal": "2017:01:04 15:53:11", "CCDWidth": 35.8, "CCDHeight": 23.9, "LoggingRate": 30, "MetaData": [{ "DataNo": 1, "SyncStartTime": 0, "GPSLatitude": 36.379593, "GPSLongitude": 127.36781, "GPSAltitude": 60.8, "GPSImgDirection": 287.51, "Roll": 0.28, "Pitch": 1.93, "Yaw": 287.51, "Orientation": 1, "FocalLength": 26, "DigitalZoomRatio": 1, "FOV": 79.234795 }, { "DataNo": 2, "SyncStartTime": 29, "GPSLatitude": 36.379593, "GPSLongitude": 127.36781, "GPSAltitude": 60.8, "GPSImgDirection": 287.85, "Roll": 0.22, "Pitch": 2.63, "Yaw": 287.85, "Orientation": 1, "FocalLength": 26, "DigitalZoomRatio": 1, "FOV": 79.234795 },{ ...(중략) }] } |

촬영위치자세 데이터를 획득하기 위해 디지털 카메라에 부착 가능한 기록 장치를 제작하였다. 사진을 촬영할 때, 즉 셔터를 누르면 촬영위치와 자세 데이터가 카메라의 스트로브 신호를 이용하여 동시에 기록하도록 구성하였다.

그림 3은 이 소형부착장비의 설계와 인쇄회로기판 (PCB; Printed Circuit Board) 및 구성 부품과 부착한 모습을 보여준다. 소용량의 리튬폴리머 전지를 전원으로 이용하는 장비 특성상 소비전류(35 mA)가 적고, 크기가 작으며 제작에 이용이 용이한 패치안테나 일체형 위성 항법 장치모듈을 이용하였다. 이 모듈은 GPS와 GLONASS를 지원하며, 위성기반보강시스템 (SBAS; Satellite Based Augmentation System)을 이용한 위치보정을 통해 2.5 m의 정확도를 가지고 있다. 또한 자세값 획득을 위해 MEMS기반 InvenSense사의 MPU-9150을 이용하여 자이로 센서와 가속도 센서를 이용하였다.

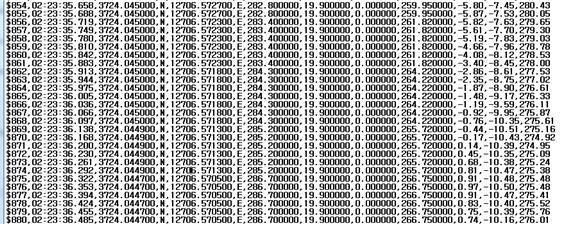

소형부착장비로 기록한 촬영위치, 자세 원시 데이터 값은 정지영상과 동영상이 모두 같은 형식으로 기록된다. 정지영상인 경우는 촬영하는 한 장면에 대한 자세정보가 기록되고, 동영상은 매 프레임에 해당하는 자세정보가 기록되도록 하였다.

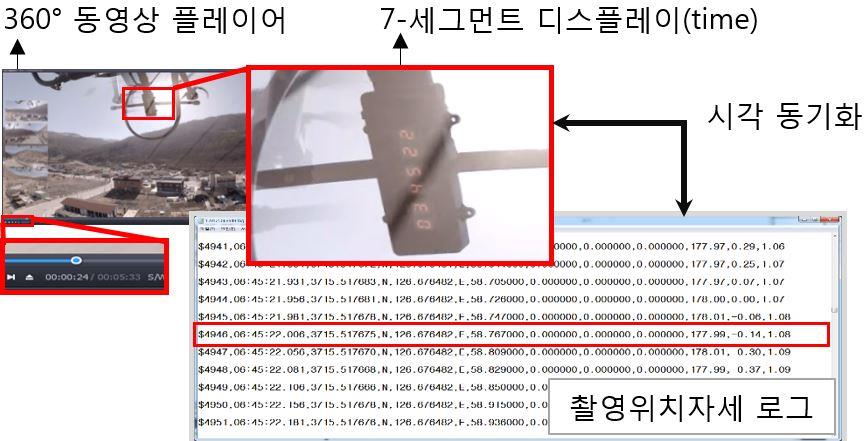

그림 4는 부착장비에 기록된 촬영위치, 자세의 예이다. 기록된 로그는 순서대로 순서, 촬영시간, 위도, 남북기준(N/S), 경도, 동서기준(W/E), 고도(geoid), 고도(geoidal), 나침판의 편차(magnetic variation), 궤도각(track angle), 롤(roll), 피치(pitch), 요(yaw) 값을 의미한다.

이 연구에서 촬영기기로 이용한 Canon EOS 6D의 경우 비디오 촬영 시 스트로브 신호를 유발하지 않기 때문에 IR (Infrared, 적외선) 신호를 이용하여 동영상 녹화의 시작 및 종료 시간과 동기화하였다. 다음 그림과 같이 촬영 위치와 자세는 동영상의 모든 프레임에 대해 기록하도록 하였다.

360도 파노라마 영상을 촬영하고 위치자세 데이터를 획득하기 위한 부착장비에는 6개의 카메라, 자세방위장치(AHRS; Attitude and Heading Reference System), 위성 항법 장치, 임베디드 컴퓨터 등을 포함하였다. 이 연구에서는 촬영한 360도 파노라마 영상을 고프로 옴니(GoPro Omni) 카메라를 이용하였다. 자세방위장치로는 촬영자세 3축(roll, pitch, yaw) 방향 값을 측정하기 위한 부품은 VectorNAV사의 모듈을 사용하였으며, 장비의 촬영 당시의 위치좌표를 획득하는 위성항법장치 부품으로는 GlobalTop Technology의 Titan-3 GNSS Module을 사용하였다. 임베디드 컴퓨터는 위치자세 데이터를 저장하고 지상국 제어 프로그램을 운영하기 위해 MIO-2263 보드를 통합하였다. 그림 5는 위에서 기술한 모듈들을 조립한 360도 영상의 촬영위치자세 기록 장비 사진이다.

그림 6은 드론에 촬영위치자세 기록장비와 360도 카메라 세트를 결합하여 촬영하는 모습과 기록된 영상의 예이다. Wi-Fi를 통해 지상 제어시스템(PC)과 촬영위치자세 기록장비가 통신하도록 제작하였다. 지상국의 제어 프로그램으로 센서의 초기화, 기록 및 종료를 원격으로 제어할 수 있다. 촬영위치자세 기록 부착장비에는 PC 모듈이 있어, 획득한 위치자세 데이터를 파일로 기록하고 저장한다. 이후에 FTP 등을 이용하여 이 데이터 파일을 서버나 제어 시스템으로 다운로드하여 이용하였다.

360-degree camera attached to the drone and equipment to acquire filming attitudes(left) and 360-degree videos(right)

파노라마 영상의 제작 방법은 전용 프로그램인 Autopano Video Pro[15]를 활용하였다. 6개의 고프로 Hero4에 기록된 각각의 비디오 영상을 동기화하는 작업(synchronization), 파노라마 동영상을 정합시키는 과정(stitch), 손 떨림을 보정하는 과정(stab), 색깔 보정과 렌더링 작업을 수행하여 파노라마 영상을 완성하였다.

그림 7은 촬영위치자세 기록 장비의 PC에 기록하는 콘솔 화면(좌)과 지상국의 제어 프로그램 UI(우)를 나타낸 것이다.

360도 카메라의 촬영 개시는 원격 제어장치로 제어가 가능하다. 반면, 촬영위치자세 장비가 로그를 기록하도록 시작하는 방법은 장비의 버튼을 누름으로써 이루어진다. 즉, 두 장비가 기록하는 데이터의 시각 동기화가 필요하다. 이 연구에서는 카메라의 원격 제어장치의 신호를 촬영위치자세 장비가 이용할 수 없음을 파악하였다. 해결방법으로, 그림 7과 같이 촬영위치자세 장비에서 획득하는 위성항법장치의 시각을 이용하였다. 수신하는 시각을 표시할 수 있는 7-세그먼트 디스플레이를 설치하였고, 이 디스플레이를 카메라가 녹화하도록 위치시켰다. 이 시각이 촬영위치자세 로그에 기록되기 때문에, 파노라마 영상 플레이어에 표시되는 시각과 로그의 시각을 비교하여 수작업으로 동기화하였다.

4-2 로케이션 매핑 영상 콘텐츠 서비스 시스템

로케이션 매핑 영상 콘텐츠를 저장·관리하고 일반 사용자에게 다양한 기능을 제공하기 위해, 촬영위치자세 데이터에 대한 방향위치 공간연산 기능을 개발하였다. 이 연구에서는 정지영상과 동영상 그리고 360도 파노라마 영상을 관리하기 때문에 콘텐츠 타입별로 파일 시스템에 저장하고 썸네일, 영상 포맷 변환 등의 기능을 수행하는 서비스 시스템을 개발하였다. 다양한 로케이션 매핑 영상 콘텐츠에 대한 접근을 위해 오픈 API를 개발하였다. 또한, 구축한 콘텐츠를 스마트폰과 같은 단말을 통해서, 촬영한 위치에서 증강현실 서비스를 제공 받을 수 있는 기능을 개발하였다.

위치방향기반 영상 콘텐츠 검색 API는 검색하려는 경위도 값과 반경, 검색하려는 방향 값을 입력하면, 엔진은 입력 위치와 방향, 시야각을 계산하여 가시부피를 생성하고, 공간연산을 통해 이 가시부피에 포함되는 정지영상을 검색한 결과를 반환한다. 같은 방법으로, 버퍼기반 동영상 검색 API에 위치, 반경 값을 엔진으로 요청을 하면, 엔진은 입력 위치와 반경을 기반으로 버퍼를 설정하여 공간검색을 수행한다.

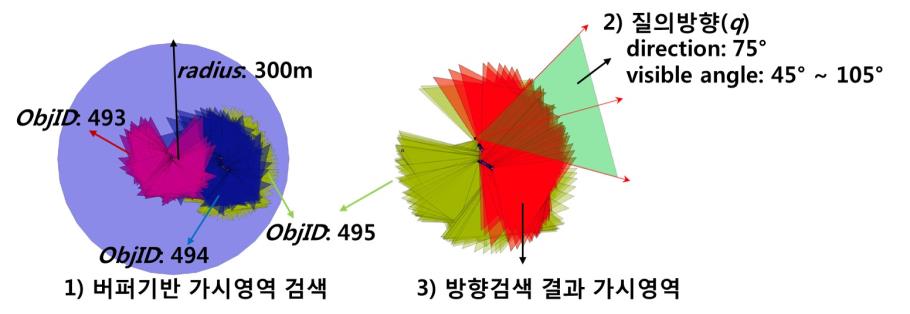

그림 8에서 왼쪽은 버퍼기반 동영상 검색 API 결과를 그래픽으로 표현한 것으로, 각 동영상의 매 프레임을 표시한 가시영역을 확인할 수 있다. 특정 위치에서 반경 300 m 에 존재하는 동영상 콘텐츠를 검색한 결과이다. 식별자(ObjID)가 493~495인 동영상이 이 질의에 해당하는 동영상임을 알 수 있다. 오른쪽 그림은 단말 위치에서 방위 75도 방향으로, 시야각이 60도의 가시영역에 해당되는 동영상 프레임을 검색한 화면으로, 식별자가 495를 가진 동영상의 모든 가시영역들과 질의 방향(q)을 가시화 한 것이다. 붉은색으로 나타낸 것이 검색 결과에 해당하는 프레임들이다.

표 2는 이 연구에서 개발한 서비스 시스템의 주요 오픈 API에 설명한 것이다. 이 외에도 각 콘텐츠에 대한 업로드, 수정, 삭제, 목록조회, 상세조회 기능 등을 제공한다.

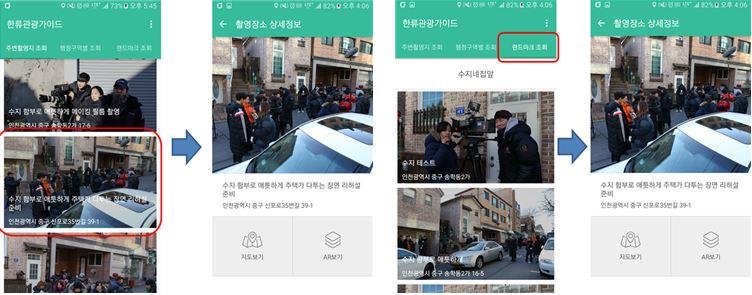

사용자 위치기반으로, 그림 9와 같이 주변의 증강현실 서비스가 가능한 콘텐츠를 조회하고, 체험존 진입을 안내하였으며 해당 지점에서 과거의 제작장면 영상 콘텐츠를 증강현실로 시각화해 체험할 수 있도록 기술을 개발하였다. 이때 영상 콘텐츠에 매핑된 촬영위치자세 정보를 이용하고, 영상 내 특징점을 추출, 매칭하는 방식으로 증강현실 시각화 기술을 개발하였다.

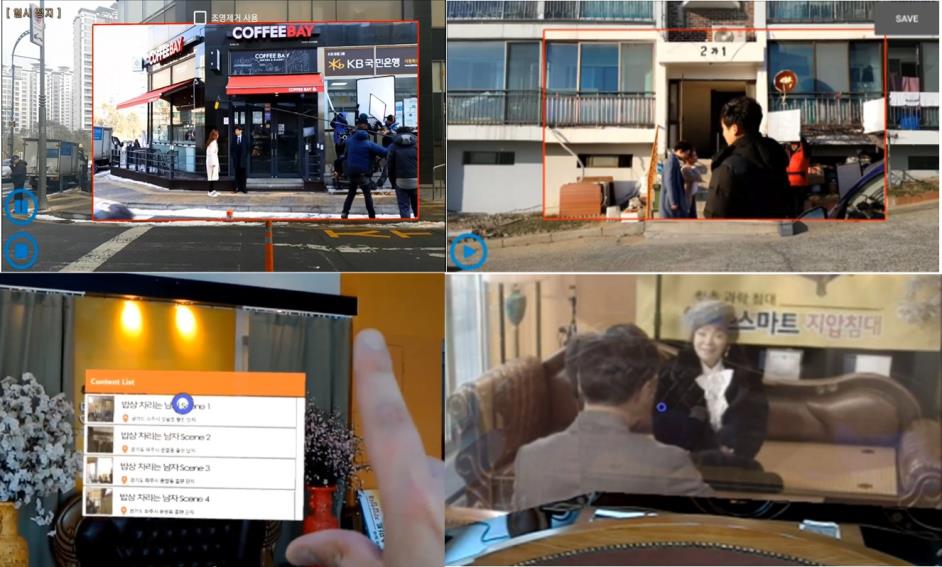

증강현실 시각화는 크게 특징점 추출과 매칭 단계로 구분하였다. 참조영상(서비스될 콘텐츠 영상)과 입력영상(사용자의 실시간 카메라 영상) 각각에 대하여 특징점을 추출하고, 이들 특징점 간의 매칭을 수행하여 실시간 카메라 영상 위에 제작 장면 영상 콘텐츠를 증강현실 시각화 하였다.

그림 9와 같이, 기본적으로 행정구역별 조회, 랜드마크별 조회, 사용자 위치 중심 인근 콘텐츠 조회 기능을 제공하였다. 행정구역별 콘텐츠 조회 기능의 경우 사용자 모바일 기기의 위치정보를 이용해 사용자가 위치한 또는 주변의 행정구역 목록과 구역별 콘텐츠 목록을 제공한다. 랜드마크별 콘텐츠 조회 기능은 사용자 주변의 관광지, 주요시설 등 랜드마크 목록과 랜드마크별 콘텐츠 목록을 제공한다. 사용자 위치 인근 콘텐츠 조회 기능은 사용자 위치를 중심으로 1km 반경 내의 콘텐츠를 조회하여 200m 단위로 구분해 콘텐츠 목록을 제공하도록 API를 개발하였다. 사용자가 임의의 콘텐츠를 선택할 경우 상세정보를 볼 수 있다.

사용자 유도 및 안내 기능은 사용자 모바일 기기의 위치자세와 콘텐츠의 위치자세를 분석하여 해당 콘텐츠를 체험할 수 있는 위치와 자세로 사용자를 유도하고 안내하는 기능을 포함시켰다.

그림 10은 실시간 카메라 화면에 콘텐츠의 위치를 마커 형태로 표시하고, 콘텐츠까지의 방향을 화살표 그래픽으로 표시하여 콘텐츠 위치까지 사용자를 유도하는 화면이다. 콘텐츠의 촬영위치자세를 3차원의 가시부피 그래픽 형태로 표시하여 최종적으로 사용자를 콘텐츠 체험 가능한 자세로 유도하였다.

그림 11은 사용자의 모바일 기기에 영상정합 증강현실 시각화를 실시한 화면이다. 증강현실로 시각화하는 동안에는 콘텐츠로부터의 거리, 사용자 위치, 모바일 기기의 자세가 변화해도 계속해서 영상정합이 유지될 수 있도록 실시간으로 매칭과 트래킹을 수행하도록 개발하였다. 그림 12는 동영상(상)과 360도 파노라마 영상(하)에 대한 증강현실 시각화 서비스 화면이다.

Ⅴ. 결론

이 논문에서는 촬영위치자세 메타데이터와 화면 내에 존재하는 공간객체들의 배치와 가려짐 등을 고려한 가시거리로부터 닫힌 가시영역 모델과 열린 가시영역 모델을 정의하였다. 다양한 위치방향기반의 로케이션 매핑 영상 콘텐츠를 이용하기 위해, 정지영상, 동영상 및 360도 파노라마의 영상과 각각의 촬영위치자세 로그를 기록할 수 있는 부착장비를 제작하였다.

이 연구에서 구축한 로케이션 매핑 영상 콘텐츠에 대해 사용자의 위치와 모바일 단말의 방향 조건을 만족하는 영상을 검색할 수 있는 API를 개발하였다. 또한, 촬영현장을 체험할 수 있도록 영상정합 기법을 접목한 증강현실 서비스를 개발하였다.

로케이션 매핑 영상 콘텐츠 서비스 플랫폼을 활용하면, 추억을 담은 사진, 혹은 드라마나 영화의 장면을 현장에서 보다 실감있는 증강현실 서비스를 제공 받을 수 있을 것으로 기대된다.

Acknowledgments

이 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2017년도 문화기술연구개발지원사업 연구결과 및 충북대 학술진흥재단의 연구비지원로 수행되었음

References

- 100M geotagged photos (plus). http://code.flickr.net/2009/02/04/100000000-geotagged-photos-plus/ .

-

Smeulders, A.W.M., Worring, M., Santini, S., Gupta, A., and Jain, R., “Content-based image retrieval at the end of the early years,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 22, No. 12, pp. 1349–1380, 2000.

[https://doi.org/10.1109/34.895972]

-

H. Ma, S. A. Ay, R. Zimmermann, and S. H. Kim., “Large-scale geo-tagged video indexing and queries,” GeoInformatica, Vol. 18, No. 4, pp. 671-697, October 2014.

[https://doi.org/10.1007/s10707-013-0199-6]

-

Toyama, K., Logan, R., Roseway, A., and Anandan, P., “Geographic location tags on digital images,” in Proceeding of the 11th ACM International Conference on Multimedia, Berkeley:CA, pp.156–166, 2003.

[https://doi.org/10.1145/957013.957046]

- Lee, Y.H. and Rhee, S.B., “ Efficient Photo Image Retrieval System Based on Combination of Smart Sensing and Visual Descriptor,” Intelligent Automation & Soft Computing, Vol. 21, No. 1, pp. 39-50, May 2014.

-

Jaffe, A., Naaman, M., Tassa, T., and Davis, M., “Generating summaries and visualization for large collections of geo-referenced photographs,” In Proceeding of the 8th ACM International Workshop on Multimedia Information Retrieval, Santa Barbara:CA, pp. 89-98, 2006.

[https://doi.org/10.1145/1178677.1178692]

- Yang, D.S. and Lee, Y.H., “Mobile Image Retrieval Using Integration of Geo-sensing and Visual Descriptor,” In Proceeding of the 15th International Conference on Network-Based Information Systems, Melbourne, pp. 742-748, 2012.

- Arslan Ay, S., Zimmermann, R.b, and Kim, S.H., “Viewable scene modeling for geospatial video search,” in Proceeding of the 16th ACM international conference on Multimedia, Vancouver, pp. 309–318, 2008.

-

Cai, Y., Lu, Y., Kim, S.H., Nocera, L., and Shahabi, C., “Querying geo-tagged videos for vision applications using spatial metadata," Eurasip Journal on Image and Video Processing, Vol. 2017, No. 1, December 2017.

[https://doi.org/10.1186/s13640-017-0165-6]

- Kim, S.H., Lu, Y., Constantinou, G., Shahabi, C., Wang, G., and Zimmermann, R., “MediaQ: Mobile multimedia management system,” in Proceeding of the 5th ACM Multimedia Systems Conference, Singapore, pp. 224-235, 2014.

-

Lee, D., Oh, J., Loh, W.-K., and Yu, H. “GeoVideoIndex: Indexing for georeferenced videos,” Information Sciences, Vol. 374, pp. 210-223, December 2016.

[https://doi.org/10.1016/j.ins.2016.09.014]

-

Kim, Y., Kim, J., and Yu, H., “GeoTree: Using spatial information for georeferenced video search,” Knowledge-Based Systems, Vol. 61, pp. 1-12, May 2014.

[https://doi.org/10.1016/j.knosys.2014.01.026]

-

Lu, Y., Shahabi, C., Kim, and S.H., “Efficient indexing and retrieval of large-scale geo-tagged video databases,” GeoInformatica, Vol. 20, No. 4, pp. 829-857, October 2016.

[https://doi.org/10.1007/s10707-016-0250-5]

-

Alfarrarjeh, A., Shahabi, C., Kim, S.H., “Hybrid indexes for spatial-visual search”, in Proceedings of the Thematic Workshops of ACM Multimedia 2017, co-located with MM 2017, Mountain View:CA, pp. 75-83, October 2017.

[https://doi.org/10.1145/3126686.3126763]

- Autopano Video, http://www.kolor.com/autopano-video/.

1997년 : 충북대학교 컴퓨터과학과 (이학사)

2000년 : 충북대학교 전산학과 대학원 (이학석사)

2000년~현재: 한국전자통신연구원 책임연구원

※관심분야: 시공간 데이터베이스, 데이터 마이닝, 데이터베이스, LBS, GIS

1999년 : 서울대학교 자원공학과(학사)

2001년 : 서울대학교 지구환경시스템공학부(석사)

2005년 : 서울대학교 지구환경시스템공학부(박사)

2005년~현재: 한국전자통신연구원 책임연구원

※관심분야: GIS, 웹 매쉬업, 증강현실, 가상현실

1976년 : 숭실대학교 전산학과 (이학사)

1980년 : 연세대학교 대학원 전산전공 (공학석사)

1988년 : 연세대학교 대학원 전산전공 (공학박사)

1976년~1986년: 육군군수 지원사 전산실(ROTC 장교), 한국전자통신연구원(연구원), 한국방송통신대학교 전산학과(조교수)

1989년~1991년: Univ. of Arizona Research Staff

1986년~현재: 충북대학교 전기전자 컴퓨터공학부 교수

※관심분야: 시간 데이터베이스, 시공간 데이터베이스, Temporal GIS, 지식기반 정보검색 시스템, 유비쿼터스 컴퓨팅 및 스트림데이터 처리, 데이터 마이닝, 데이터베이스, 보안, 바이오 인포메틱스