Neural Blend Shapes를 활용한 버추얼 아바타 리깅 및 스키닝 자동화

Copyright ⓒ 2025 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

버추얼 아바타 제작은 단순히 3D 모델 제작뿐만 아니라 노동집약적인 리깅 및 스키닝 프로세스가 포함되며, 상당한 수작업과 전문 지식이 필요하다. 본 연구에서는 Neural Blend Shapes를 활용하여 리깅 및 스키닝 프로세스를 자동화하여 품질 저하 없이 효율성을 향상시키는 접근 방식을 제안한다. 딥러닝 알고리즘을 활용하여 아바타에 맞춰 관절 및 뼈를 생성하고 스키닝 작업까지 자동화하여 사용 가능한 수준의 아바타를 빠르게 완성할 수 있다. 결과적으로 본 연구를 통해 아바타 생성 파이프라인에 드는 비용을 절감하고 소요 시간을 가속화 할 뿐만 아니라 접근성을 높여 게임, 버추얼 콘텐츠, 가상환경 등 버추얼 아바타를 활용하는 분야에 실질적으로 기여할 것으로 기대된다.

Abstract

Creating a virtual avatar involves not just the creation of a 3D model but also a labor-intensive rigging and skinning process that demands substantial manual effort and expertise. This study proposes an approach that improves efficiency without compromising quality by automating the rigging and skinning process using neural blend shapes. Leveraging deep learning algorithms, the system generates joints and bones tailored to the avatar and even the skinning process is automated, enabling rapid production of avatars ready for practical use. As a result, this study is expected to substantially contribute to fields that utilize virtual avatars, such as games, virtual contents, and virtual environments, by reducing the cost of the avatar creation pipeline and accelerating the turnaround time, and increasing accessibility.

Keywords:

Deep Learning, Rigging, Virtual Avatar, Skinning, Automation키워드:

딥러닝, 리깅, 버추얼 아바타, 스키닝, 자동화Ⅰ. 서 론

실사용이 가능할 정도의 버추얼 아바타 제작은 게임, 가상 현실(VR; virtual reality), 증강 현실(AR; augmented reality), 영화 같은 시각 효과를 포함한 여러 분야에서 중요한 작업이다. 특히 소통이 필요한 몰입형 환경에서는 단순히 아바타 메시의 완성도를 넘어 얼굴 표정이나 신체의 움직임에서 나타나는 변형의 완성도가 중요하다[1]. 이런 완성도는 아바타의 골격과 움직이는 메커니즘을 정의하는 리깅과 아바타의 메시를 리그에 연결하여 아바타 표면이 자연스럽게 변형되도록 하는 스키닝이라는 두 가지 주요 단계에서 결정된다[2].

일반적으로 이 단계들은 상당히 노동집약적이다. 숙련된 아티스트가 관절을 수동으로 배치하고 스키닝 웨이트를 페인팅하고 결과를 확인하며 실제 적용되는 변형을 조정하여 실제와 같은 움직임을 구현해야 한다. 그러나 최근 메타버스의 대두와 몰입형 기술의 발전으로 고품질 아바타에 대한 수요가 증가함에 따라 수동 리깅 및 스키닝의 한계가 더욱 분명해지는 추세이다[3].

기계 학습, 특히 신경망의 발전으로 컴퓨터 그래픽의 복잡한 작업을 자동화할 수 있는 새로운 가능성이 열렸다[4]-[8]. 이러한 맥락에서 Neural Blend Shapes는 리깅 및 스키닝 프로세스를 단순화하고 개선하는 유망한 접근 방식을 제시한다. 기존의 얼굴 표정으로 인한 변형을 정의하는 데 사용되는 Blend Shapes[9]를 신경망을 통해 아바타 형상, 관절 배치 및 동작에 의한 변형 간의 관계를 학습시킨다[10]. 3D 모델의 대규모 데이터 세트로 네트워크를 학습시켜 다양한 신체 유형과 애니메이션 스타일에 적응할 수 있는 리그 및 스킨 모델을 생성할 수 있어 수동 개입의 필요성이 줄어든다.

하지만 원본 Neural Blend Shapes는 간단한 3D 모델의 리깅, 스키닝에서는 빠르고 좋은 품질의 결과를 얻을 수 있지만 버추얼 아바타 같은 복잡한 모델에 적용하기에는 여전히 제한적이다.

본 논문의 목표는 Neural Blend Shapes를 개선하여 버추얼 아바타에 대해 사용가능한 수준의 리깅, Blend Shapes 생성 및 스키닝을 자동화하여 보다 효율적이고 확장 가능한 버추얼 아바타 생성 파이프라인을 가능하게 하는 프레임워크를 제안한다. 이를 통해 리깅 및 스키닝과 관련된 수작업 단계를 제거하면서 결과 아바타의 품질을 유지하거나 향상시키면서도 상당한 시간을 절약할 수 있다.

다음 섹션에서는 자동화된 리깅 및 스키닝의 기존 기술을 검토하고 버추얼 아바타 제작에서 신경망의 역할을 논의하며 접근 방식을 자세히 제시한다. 또한 효율성, 적응성 및 현실성 측면에서 장점을 강조하면서 기존 방법과 비교하여 시스템 성능을 평가한다.

Ⅱ. Neural Blend Shapes 개요

2-1 배경 및 관련 작업

리깅 및 스키닝은 3D 캐릭터 생성의 중요한 단계이지만 노동집약적인 프로세스다. 게임, 가상 현실, 증강 현실 등 대화형 및 몰입형 경험에 대한 수요가 증가함에 따라 보다 효율적이고 확장 가능한 솔루션이 필요하다. 이 섹션에서는 전통적인 리깅 및 스키닝 기술, 기존 자동화 노력, 현장에서 신경망의 역할에 대한 개요를 제공하고 Neural Blend Shapes를 사용하여 제안된 방법의 토대를 마련한다.

리깅은 모델의 움직임을 결정하는 아바타의 골격 구조를 정의하는 작업이고 스키닝은 아바타가 움직일 때 자연스럽게 변형되도록 아바타의 메시를 이 골격에 연결하는 작업이다. 리깅과 스키닝은 전문성과 정확성이 요구되는 수동적이고 시간 소모적인 작업이다.

리깅에는 캐릭터의 몸체 내에 관절을 배치하여 뼈를 시뮬레이션하고 역운동학(IK; inverse kinematics) 및 순운동학(FK; forward kinematics) 시스템을 정의하여 움직임을 제어하는 작업이 포함된다[11]. 이 과정에서 작업자가 직접 조작해보며 다양한 동작을 시뮬레이션하는 작업이 필요하다.

스키닝에는 아바타 메시의 각 정점에 가중치를 할당하여 각 관절이 주변 피부에 얼마나 많은 영향을 미치는지 결정하는 작업이 포함된다[12]. 웨이트 페인팅이라고 불리는 이 과정은 아티스트가 극단적인 포즈에서도 변형이 자연스럽게 보이도록 해야 한다.

이러한 전통적인 방법을 사용하면 최종 결과를 세밀하게 제어할 수 있지만, 아티스트는 단일 아바타를 리깅하고 스키닝하는 데 며칠 또는 몇 주를 소비해야 하므로 대규모 프로젝트에 대한 제작 규모를 조정하거나 빠르게 반복되어야 하는 프로세스를 어렵게 만든다[13].

이런 부담을 완화하기 위해 다양한 자동화 기술이 개발되었다. 자동화 기술의 접근 방식은 크게 알고리즘을 통한 기하학 기반 방법과 데이터 기반 방법으로 나눌 수 있다.

기하학 기반 방법은 아바타 메시와 스켈레톤 사이의 기하학적 특성을 기반으로 리깅, 스키닝 자동화를 달성하고자 한다. Pinocchio는 다양한 메시에 맞게 일반화된 스켈레톤의 크기를 입력된 메시에 맞게 조절한 뒤 메시의 정점과 스켈레톤 사이에 대응을 설정한다. 이후 열 평형(heat equilblium) 개념을 차용하여 적절한 스키닝 웨이트를 계산한다[14]. 이와 비슷하지만 열 개념을 빛(glow)으로 다르게 해석하여 성능을 개선한 예도 있다[15]. 탄성 에너지에서 영감을 받아 에너지 함수를 응용하여 스키닝 웨이트를 계산하는 방식은 효율적으로 더 역동적인 결과를 얻어낼 수 있다[16]. 구멍이 뚫려있거나 교차되는 부분이 있는 등 처리하기 까다로운 메시의 경우 메시를 복셀화하여 뼈에서 메시 정점까지의 측지선(공간 상에서 가장 짧은 경로)을 기반으로 스키닝 웨이트를 계산하는 접근도 연구되었다[17]. 다양한 접근이 있고 기여한 부분에도 차이가 있지만 이 방법들 모두 관절과 정점 사이의 거리(메시의 기하학적 정보)를 사용하여 스키닝 웨이트를 계산한다.

기하학 기반 자동화는 수동 리깅, 스키닝 작업보다는 효율적이지만 독특한 아바타 형태나 복잡한 아바타, 극심한 스킨 변형을 처리하는 데 필요한 유연성이 부족한 경우가 많다. 또한 결과에는 여전히 수동 개선이 필요하므로 완전 자동화된 파이프라인이라 볼 수 없다.

일반적으로 데이터 기반 방법은 아바타 메시와 메시의 스키닝 가중치 샘플들로 구성된 대규모 데이터 세트로 학습된 기계 학습 모델을 사용하여 입력된 메시의 스키닝 웨이트를 예측하는 접근 방식이다. 특히 딥러닝은 복잡한 데이터 패턴을 인식하는 데 탁월해 3D 메시 및 스켈레톤과 같은 고차원 입력과 관련된 작업에서 의미있는 결과를 얻을 수 있다[18].

NeuroSkinning은 데이터 기반 접근 방식으로 오토 스키닝을 구현하려 한 초기 시도 중 하나이다. 이 연구에서는 스키닝 웨이트가 부여된 3D 메시 데이터 세트로 그래프 합성곱 신경망(GCN; graph convolutional network)을 학습시켜 입력된 아바타의 스키닝 웨이트를 계산한다. 신경망의 각 노드는 메시 정점의 기하학적 특징과 스켈레톤과의 관계성과 관련된 특징을 가진다. 다만 학습 데이터에서 모든 스켈레톤을 대표할 수 있는 스켈레톤에 의존하여 입력 데이터가 이에 맞지 않는다면 적절하지 않을 수 있다[19].

RigNet은 NeuroSkinning과 유사하지만 그래프 신경망(GNN; graph neural network)을 사용하는데 내부적으로 몇 가지 모듈로 나뉘어 리깅, 스키닝이 진행된다. 관절 예측 모듈은 재귀, 적응적 군집화를 사용하여 메시 정점의 위치변화를 기반으로 관절 위치를 결정한다. 스키닝의 경우 각 노드의 메시 정점에서 측지선을 기준으로 가까운 k개의 뼈에 대해서만 스키닝 가중치를 계산한다. 이를 통해 NeuroSkinning에서의 대표 스켈레톤에 의존하는 문제를 어느정도 해소할 수 있지만 여전히 복잡한 스켈레톤에서 어려움을 겪는다[20].

기존의 Blend Shapes는 사전 설정된 모습 간 보간을 통해 다양한 얼굴 표정과 변형을 정의하는 데 사용되었다[9]. 신경망을 이용하여 이러한 Blend Shapes를 아바타의 폴리곤과 골격 움직임을 기반으로 얼굴 표정이 아닌 스킨 변형에 대해 생성할 수 있으며 이를 Neural Blend Shapes라 부른다[10]. 신경망은 골격 움직임과 이로 인한 스킨 변형 사이의 관계를 학습할 수 있어 Blend Shapes를 이용하여 수동 개입 없이 부드럽고 자연스러운 애니메이션을 생성할 수 있다.

3D 캐릭터 생성에 신경망을 적용하는 것은 아직 초기 단계이지만 리깅 및 스키닝 프로세스에 혁신을 가져올 가능성이 있다. Blend Shapes 기술과 딥러닝을 결합하면 더욱 자연스럽게 변형되고 다양한 동작에 더 잘 반응하는 아바타를 생성할 수 있어 아바타 생성에 대한 확장 가능한 솔루션을 제공한다.

2-2 문제 설명

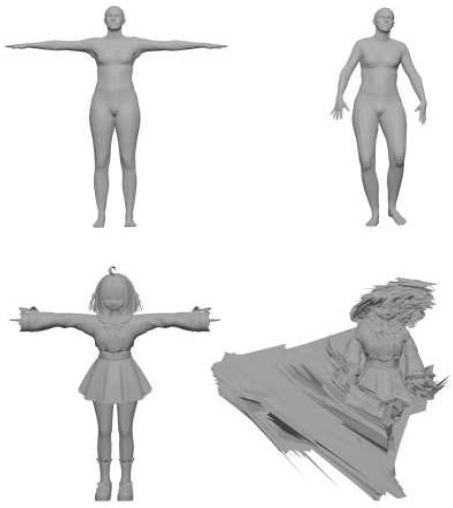

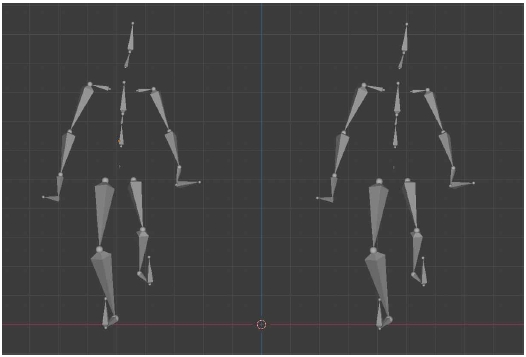

Neural Blend Shapes 원본에서 이미 여러 3D 메시에 대해 리깅 및 스키닝 자동화를 성공한 사례를 보여주지만 버추얼 아바타 같은 복잡한 모델에 대해서는 원본에서 제공하는 미리 학습된 모델로는 그림 1에서 볼 수 있듯 실사용이 가능할 만한 결과를 얻기 힘들다.

Original Neural Blend Shapes’ results. From top left to right, the T-pose of a simple mesh, the result of applying Neural Blend Shapes to a simple mesh, the T-pose of a complex mesh and the result of applying Neural Blend Shapes to a complex mesh

본 논문에서는 이 문제를 해결하기 위해 학습 모델의 네트워크 구조 수정, 학습 데이터 추가, 하이퍼파라미터 최적화 등 다양한 방법을 연구하여 Neural Blend Shapes를 개선하고 최종적으로 고품질의 버추얼 아바타의 리깅, 스키닝 프로세스 자동화를 목표로 한다.

2-3 학습 모델 설명

Neural Blend Shapes를 사용하여 리깅 및 스키닝 프로세스를 자동화하기 위한 기술 프레임워크를 제시한다. 방법론은 데이터 세트 생성, 네트워크 아키텍처, 학습 프로세스, 자동화 파이프라인 네 가지 주요 영역으로 나뉜다. 각 하위 섹션에서는 효율적이고 확장 가능한 방식으로 완벽하게 조작되고 스킨이 적용된 아바타를 생성하도록 시스템을 설계하는 방법에 대한 세부 정보를 제공한다.

• 데이터 세트 생성 및 준비

리깅 및 스키닝 자동화를 위한 신경망 학습의 주요 구성 요소는 다양한 아바타 유형, 신체 형상 및 골격 변형을 캡처하는 포괄적인 데이터 세트이다. 학습 모델은 학습 과정 대부분이 간접 지도 학습(indirect supervision)방식으로 학습되기 때문에 실제 리그, 스키닝 웨이트, Blend Shapes에 대한 정보는 필요로 하지 않는다. 대신 초기에는 해당 정보들이 제공되는 SMPL(skinned multi-person linear model) 데이터 세트[21], Garment 데이터 세트[22]를 통해 지도 학습(direct supervision)이 이루어지고 이후 3D 메시들의 초기포즈인 T-pose를 기준점으로 관절의 회전과 그로 인한 스킨의 변형을 학습한다.

기존의 데이터 세트는 SMPL 데이터 세트, Garment 데이터 세트 및 옷을 입지 않은 Mixamo[23] 아바타들로 구성되어있지만, 버추얼 아바타에 적용하기 위해 VRoid Hub[24], Booth[25]에서 유사한 스타일의 아바타들을 구해 데이터 세트에 포함하였다.

• 데이터 전처리

본 연구는 새로운 스타일의 아바타들을 데이터 세트에 추가했기 때문에 해당 아바타들에 대해 기존 논문에서의 전처리 과정과 더불어 추가적인 작업을 수행하였다.

우선, 일종의 데이터 증강 효과를 목적으로, 새로운 아바타들을 데이터 세트에 추가하고 가능한 경우 의상과 머리카락 부분을 제거한 상태로 따로 추가하였다.

또한 데이터 세트 준비에 있어 중요한 부분은 정점 간 연결이 끊어진 부분이 없어야 한다는 점인데, 새로 구한 아바타들의 경우 이목구비, 머리카락, 손톱 등의 신체 부분과 의상, 액세서리 등의 요소들을 따로 작업하고 그룹화하여 제공된 경우가 많았다. 이를 해결하기 위해 정점 간 연결이 끊어진 부분들을 이어주고 모델링 프로그램으로 정점 정렬을 진행하였다. 본 연구에선 Blender를 사용하였다.

그 외 기존에 사용된 표 1의 전처리 단계를 적용한다.

제안하는 방법의 핵심은 신경망을 통해 아바타의 기하학적 특징과 골격의 움직임을 기반으로 Blend Shapes를 자동으로 생성하는 것이다. 네트워크 아키텍처는 지역적이거나 전역적인 변형을 모두 캡처하도록 설계되어 시스템이 다양한 아바타의 복잡한 움직임을 정확하게 모델링할 수 있어야 한다.

• 네트워크 입력

네트워크 입력은 리깅, 스키닝을 하고자 하는 아바타의 3D 메시의 초기 포즈인 T-pose를 입력한다. 정규화 기능을 사용할 수 있지만 SMPL 3D 메시 샘플에 크기를 맞춰 직접 정규화하여 입력하는 것도 가능하다.

• 네트워크 출력

네트워크의 출력은 정해진 뼈대 개수를 기반으로 아바타에 맞춰진 스켈레톤과 특정 움직임이나 표정에 대해 아바타 메시에 적용되는 변형을 나타내는 Blend Shaeps 세트, 이를 기반으로 계산된 스키닝 웨이트이다. 이러한 Blend Shapes는 스켈레톤 애니메이션에 반응하여 아바타의 형상을 조정하여 부드럽고 사실적인 변형을 만드는 데 사용된다.

• 네트워크 아키텍처

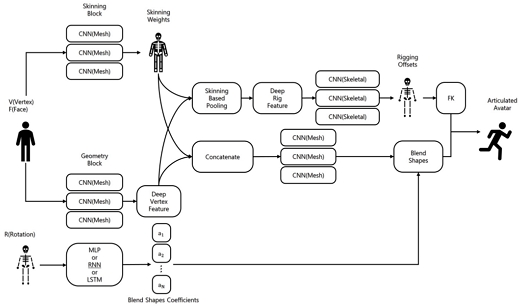

네트워크는 두 개의 분기로 나눌 수 있다. 네트워크 아키텍처를 간소화한 그림 2에서 위쪽 분기는 합성곱 신경망(CNN; convolutional neural network)으로 시작하여 입력 메시에서 기하학적 특징을 추출하는 여러 레이어로 구성된다. 해당 분기에서 아바타 리그 조정에 사용되는 리깅 편차값과 스키닝 가중치를 계산한다.

아래쪽 분기는 학습 데이터로 주어지는 애니메이션의 주요 골격 회전값 정보를 통해 Blend Shapes 생성에 필요한 상수값을 계산한다. 이때, 골격의 움직임과 메시 변형 사이의 복잡한 관계를 학습하기 위해 완전 연결 레이어(FCL; fully connected layer)를 사용한다. 기본적으로 다중 퍼셉트론(MLP; multi-layer perceptron)을 사용하지만, 애니메이션의 시계열 데이터로서의 특성을 더 활용할 수 있는 순환 신경망(RNN; recurrent neural network), 장단기 메모리(LSTM; long short-term memory)를 사용할 수도 있다. 이 경우 이전 프레임의 회전값 정보를 포함하여 인코딩되어 입력값으로 사용한다. 본 연구에서는 이 부분에서 기존 MLP 대신 RNN을 활용하여 연구를 진행하였다.

• 손실 함수(Loss function)

네트워크는 표 2의 손실 함수들을 학습에 활용한다.

학습 과정은 광범위한 아바타와 움직임을 일반화하는 신경망의 능력을 개발하는 데 있어 중요한 단계이다.

• 학습 설정

훈련은 신경망이 데이터의 기본 패턴을 학습할 수 있도록 여러 에포크에 걸쳐 수행되며, 수렴을 가속화하고 학습 프로세스를 안정화하기 위해 배치 정규화를 적용한다.

학습률, 배치 크기, 에포크 수와 같은 주요 하이퍼파라미터는 성능을 극대화하도록 최적화한다. 본 연구는 초기 학습률을 2e-5로 설정하였으며, 학습 데이터가 300개를 넘지 않는 비교적 작은 데이터 세트이기 때문에 배치 크기는 8, 에포크는 최대 10000회로 설정하였다. 풀링 방식은 맥스 풀링을 사용하였다. 또한, 과적합을 방지하기 위해 조기 중지를 사용하고, 일반화를 개선하기 위해 드롭아웃 레이어를 사용한다.

• 모델 학습 과제 및 해결방안

모델 학습 과정에서 발생 가능한 문제들과 그에 대한 해결방안은 표 3에 서술하였다.

Ⅲ. 학습 모델 평가

버추얼 아바타의 리깅 및 스키닝을 자동화하기 위해 수정된 Neural Blend Shapes 학습 모델 접근 방식의 결과를 제시한다. 모델을 수정하기 전 기존 방법, 이미 실제로 사용되고 있는 다른 자동화 모델과 비교하고 제안된 시스템의 계산 성능을 분석하여 처리 시간, 적응성 및 변형 정확도 측면에서 효율성을 보여준다.

3-1 수동 리깅, 스키닝과 비교

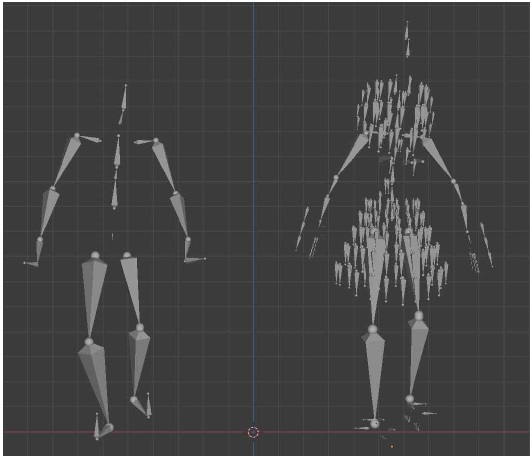

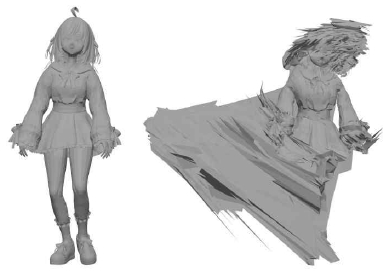

그림 3의 본 연구에서의 자동 리깅 결과와 직접 작업한 리깅의 결과를 비교해보면 뚜렷한 차이를 확인할 수 있다. 수동 리깅의 경우, 사용하는 리그 개수의 제한이 없어 신체 표현뿐만 아니라 머리카락, 의상, 액세서리 등 특수한 부분에 대해 원하는 방식으로 표현이 가능하다. 반면, 자동 리깅의 경우 신체 움직임에 대한 표현에는 큰 문제가 없지만 머리카락, 의상 등에서의 움직임이 수동 작업에 비해 어색한 느낌을 줄 수 있다.

Rigging results. From left to right, rigging result of modified Neural Blend Shapes and manual rigging result

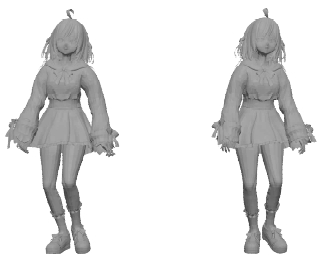

그림 4의 수동 스키닝의 경우, 작업 과정에서 앞서 언급한 특수한 부분들의 스키닝 웨이트를 따로 설정하지 않아 결과에서 큰 차이를 보이지 않는다. 다만 이러한 요소들을 전문적인 아티스트가 작업했다면 세밀한 요소들이 잘 표현된 리그에 맞게 스키닝 웨이트를 설정하여 자동 리깅, 스키닝 결과에 비해 풍부하고 다양한 표현이 가능할 것이다.

Skinning results. From left to right, skinning result of modified Neural Blend Shapes and manual skinning result

소요 시간은 직접 작업한 결과물은 초심자 기준으로 약 9시간 이상 소요되었고, 자동 프로세스의 경우 평균적으로 약 56초가 소요되었다. 수동 작업의 경우 숙련도나 작업자의 컨디션 등 변수가 많지만 이를 고려해도 상당한 차이가 있다고 판단할 수 있다.

3-2 기존 Neural Blend Shapes 모델과 비교

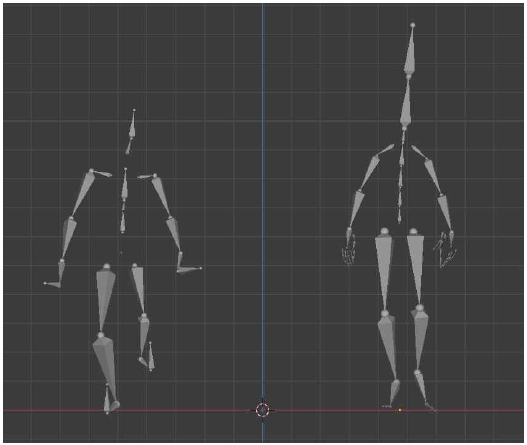

그림 5에서 확인할 수 있는 수정된 모델의 자동 리깅의 결과는 기존 모델의 결과와 큰 차이를 보이지 않으며, 유사한 스켈레톤이 생성된다.

Automatic rigging results. From left to right, rigging result of modified Neural Blend Shapes and rigging result of original Neural Blend Shapes

반면 스키닝의 경우 그림 6과 같이 기존 Neural Blend Shapes 모델에 반해 수정된 모델을 통해 정상적인 결과를 얻은 것을 확인할 수 있다. 기존 방식은 출력 직후의 모습으로는 실사용이 불가능한 상태이지만, 학습 모델을 수정한 이후 출력으로는 충분히 활용할 만한 품질의 결과를 얻을 수 있다.

Automatic skinning results. From left to right, skinning result of modified Neural Blend Shapes and skinning result of original Neural Blend Shapes

자동화 프로세스 소요 시간 비교 결과 45프레임 애니메이션 생성에 있어 기존의 Neural Blend Shapes 모델은 평균 약 38초의 시간이 소요되었다. 수정된 학습 모델은 동일 조건으로 약 56초의 시간이 소요되었다.

3-3 Mixamo 자동화 모델과 비교

Mixamo의 자동 리깅과 Neural Blend Shapes 수정 모델의 자동 리깅 결과를 비교한 그림 7에서 차이가 있는 것을 확인할 수 있다. 다만 모델에서 학습된 스켈레톤의 일반화된 형태가 다른 것이고 결과로 출력되는 애니메이션의 형태가 큰 차이를 보이지는 않는다.

Automatic rigging results. From left to right, rigging result of modified Neural Blend Shapes and rigging result of Mixamo

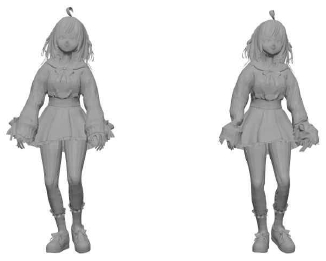

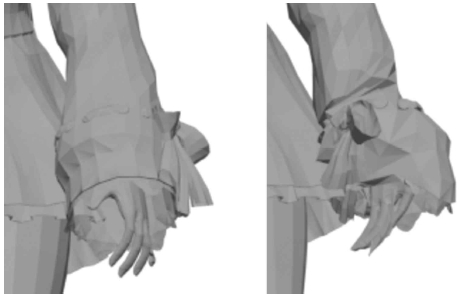

자동 스키닝의 경우 그림 8에서 보이듯 두 모델 모두 전체적으로 실사용이 가능한 정도의 스키닝 결과를 얻을 수 있다. 하지만 세부적인 부분에서 약간의 차이가 발생한다.

Automatic skinning results. From left to right, skinning result of modified Neural Blend Shapes and skinning result of Mixamo

그림 9와 같이 Mixamo의 경우 의상에 덮인 손목 부분에서 결함이 발생하는 것을 확인할 수 있다. 이는 Mixamo 모델은 신체의 주요 지점들을 직접 지정한 뒤 리깅, 스키닝 프로세스가 진행되기 때문에 발생한다. 주요 지점 중 손목을 지정해야 하는데, 이때 손목 부분에 의상이 덮여있기 때문에 의상인 부분까지 손목으로 인식되어 발생하는 현상이다.

Wrist part of the automatic skinning results. From left to right, skinning result of modified Neural Blend Shapes and skinning result of Mixamo

Neural Blend Shapes 학습 모델의 경우 별도의 지정 없이도 주요 관절 위치를 예측할 수 있고 Blend Shapes를 생성하여 활용하기 때문에 이런 부분이 자연스럽게 처리된다.

자동화 프로세스 소요 시간 비교 결과 45프레임 애니메이션 생성에 있어 Neural Blend Shapes를 수정한 학습 모델은 약 56초의 시간이 소요되었다. Mixamo의 경우 리깅, 스키닝 프로세스만 측정했을 때 동일 조건으로 약 32초의 시간이 소요되었다. 그러나 Mixamo에서 제공하는 자동 리깅, 스키닝 방식은 프로그램이 필요로 하는 주요 관절 부분을 직접 지정해야하고 웹에서 제공하는 서비스이기 때문에 시간적인 변수가 존재한다.

3-4 평가

수동 리깅, 스키닝과의 비교 결과 품질면에서 수동 작업이 우세한 것을 확인할 수 있다. 특히 신체를 제외한 의상, 머리카락, 장신구 등의 표현에 있어 자세하고 풍부한 표현의 가능성에서 차이를 보인다. 다만 시간적 측면에서는 개인차를 고려해도 자동화 프로세스가 큰 차이로 우세함을 확인할 수 있다.

기존 모델과의 비교 결과 기존 모델이 거의 동일한 품질의 리깅 결과를 보여주며 프로세스 처리 속도에 있어 장점을 가지지만 스키닝 품질에 있어 수정된 모델이 큰 장점을 가지는 것을 확인할 수 있다.

Mixamo와의 비교 결과 두 출력 모두 실사용이 가능한 정도의 품질을 가지지만 세부적인 부분에서 Neural Blend Shapes를 수정한 모델의 출력이 더 안정적인 것을 확인할 수 있다. 자동화 프로세스 처리 속도에 있어 Mixamo가 빠르지만 추가적인 수동 조정에 필요한 시간과 인터넷 상태의 변수가 있기 때문에 안정적으로 결과를 얻을 수 있는 수정된 Neural Blend Shapes 모델이 우위를 가진다.

결론적으로 수정된 Neural Blend Shapes 접근 방식은 버추얼 아바타에 대한 리깅 및 스키닝 프로세스에서 효율성을 의미있게 향상시킨다는 것을 보여준다. 리깅, 스키닝 시간을 줄이고 변형의 오류를 낮추며 높은 애니메이션 품질을 유지한다.

Ⅳ. Neural Blend Shapes 평가

결과의 의미를 탐색하고 수정된 Neural Blend Shapes 접근 방식이 아바타 리깅 및 스키닝의 기존 문제를 어떻게 해결하는지 검토한다. 이러한 접근 방식의 장점과 한계를 확인하고 게임, VR/AR, 디지털 콘텐츠 제작 등 다양한 분야에서 효율성과 적용성을 더욱 높일 수 있는 향후 작업 방향을 제안한다.

4-1 리깅 및 스키닝을 위한 Neural Blend Shapes의 장점

수정된 Neural Blend Shapes 접근 방식은 기존의 수동 및 자동 리깅, 스키닝 기술에 비해 몇 가지 주요 이점을 제공한다.

신경망의 특징으로는 단순히 실제 스키닝 웨이트를 학습하여 예측하는 것이 아닌 골격의 회전과 스킨의 변형 사이의 관계를 간접지도 방식으로 학습하여 Neural Blend Shapes를 예측하고 이를 스키닝 웨이트와 함께 활용하여 스키닝이 진행되기 때문에 더 세밀하고 부드러운 애니메이션 생성이 가능하다.

모델 비교 섹션에서 볼 수 있듯이 시간적 측면에서 리깅 및 스키닝에 필요한 시간이 충분히 단축되어 효율성을 향상할 수 있다. 사실적인 변형을 달성하기 위해 수동 조정이 필요한 기존 방법과 달리 이 접근 방식은 최소한의 개선 또는 개선 없이 짧은 시간 안에 자연스럽고 안정적인 애니메이션을 생성한다.

또한 다양한 아바타 스타일을 처리할 수 있는 유연성을 보여준다. 다양한 유형의 데이터 세트를 훈련함으로써 모델은 학습하지 않은 아바타에도 효과적으로 일반화되므로 여러 종류의 캐릭터 디자인이 필요한 콘텐츠 제작자에게 유용한 도구가 될 수 있다.

궁극적으로 이 접근 방식은 노동집약적인 리깅 및 스키닝 단계를 자동화함으로써 캐릭터 아티스트와 애니메이터가 캐릭터 디자인 개선, 애니메이션 개선과 같은 창의적인 작업에 집중할 수 있도록 한다. 결과적으로 Neural Blend Shapes를 사용하면 더욱 효율적인 워크플로우에 기여할 수 있어 더 많은 반복과 빠른 실험이 가능해진다.

4-2 접근 방식의 한계

Neural Blend Shapes 방법은 상당한 이점을 제공하지만 특정 상황에서 영향을 미칠 수 있는 몇 가지 제한 사항이 존재한다.

우선 성능적 측면에서 신경망의 성능은 학습 데이터 세트의 품질과 다양성에 크게 좌우된다. 데이터 세트에 특정 신체 유형, 극단적인 자세 또는 고유한 스타일이 부족한 경우 데이터 증강 과정을 거쳐도 그러한 사례를 정확하게 일반화하는 데 어려움을 겪을 수 있다. 일관된 성능을 달성하려면 데이터 세트에 광범위한 유형의 아바타가 포함되어 있는지 확인하는 것이 중요하다.

또한 신경망 학습 단계에서 고해상도 메시 또는 복잡한 신체 구조에 대해 작업할 때 상당한 계산 비용이 필요하다. 이러한 초기 비용은 강력한 하드웨어에 액세스할 수 없는 소규모 스튜디오나 독립 제작자에게 어려움을 줄 수 있다. 다만 훈련이 끝난 이후의 개별 아바타를 처리하기 위한 계산 요구 사항은 상대적으로 낮다.

마지막으로 비율이 과장되거나 의인화되지 않은 아바타, 인간형이 아닌 아바타의 경우 문제에 직면할 수 있다. 이러한 독특한 경우에는 원하는 변형 결과를 얻기 위해 학습의 기반이 될 수 있는 아바타의 실제 스켈레톤, 스키닝 웨이트 정보 및 사용자 지정 Blend Shapes가 필요할 수 있다.

4-3 산업 응용에 대한 시사점

Neural Blend Shapes 방법은 여러 산업, 특히 대화형 및 몰입형 미디어에 초점을 맞춘 산업 전반에 걸쳐 작업 흐름을 변화시킬 수 있는 잠재력을 가지고 있다.

소셜 미디어와 가상 세계 혹은 메타버스 환경의 경우 해당 분야가 확장됨에 따라 사용자가 쉽게 맞춤 설정할 수 있는 개인화된 버추얼 아바타에 대한 수요가 증가하고 있다. 자동화된 리깅 및 스키닝 프로세스를 통해 사용자는 맞춤형 아바타를 쉽고 빠르게 생성할 수 있으며 가상 공간에서 더 폭넓은 접근성과 개인화를 지원한다.

또한 종종 수백 개의 고유한 캐릭터를 생성해야 하는 게임 제작에서 이 접근 방식의 효율성과 확장성은 큰 장점이 될 수 있다. 자동화된 리깅 및 스키닝을 통해 게임 개발자는 수동 설정에 소요되는 시간을 줄이고 게임플레이 요소와 시각적 디자인을 개선하는 데 더 많은 시간을 할애할 수 있다.

VR 및 AR 애플리케이션에는 실시간으로 수행할 수 있는 현실적이고 반응성이 뛰어난 아바타가 필요한 경우가 많다. Neural Blend Shapes를 통해 달성된 빠른 처리 시간과 고품질 변형 덕분에 몰입형 상호 작용과 자연스러운 캐릭터 움직임이 필수적인 VR/AR 환경에 적합하다.

영화와 애니메이션의 경우 아티스트의 세밀한 수동 리깅 및 스키닝이 필요할 수 있지만 배경 캐릭터나 군중 시뮬레이션의 경우 Neural Blend Shapes를 사용하여 작업 흐름을 간소화할 수 있다. 보조 캐릭터의 작업을 자동화하여 주요 캐릭터와 중요한 장면에 더 많은 리소스를 할당할 수 있다.

4-4 향후 작업

확인할 수 있었던 제한 사항들을 기반으로 Neural Blend Shapes 접근 방식을 개선하고 적용 범위를 넓히기 위한 향후 연구에 대한 몇 가지 방향을 제시한다.

우선 아바타 유형에 대한 일반화를 개선하기 위해 향후 더 많은 특수 캐릭터나 비인간형 캐릭터를 포함하도록 학습 데이터 세트를 구성하는 데 중점을 둘 수 있다. 다양한 신체 유형, 자세 및 스타일 요소를 포괄적으로 다루기 위해 합성 데이터 생성 및 증강 기술을 사용할 수 있다.

과장되거나 비현실적인 변형을 처리하는 모델의 능력을 향상시키는 것 또한 주요 탐구 영역이다. 애니메이션 스타일 변형을 위한 특정 손실 기능과 같은 기술의 도입을 통해 비현실적인 환경에서 스타일 요구 사항을 충족하는 사용자 정의 애니메이션을 생성할 수 있다.

학습에 필요한 계산 리소스를 줄이는 방법을 연구하여 충분한 하드웨어가 준비되지 않은 경우에도 Neural Blend Shapes 접근 방식을 더 쉽게 이용할 수 있도록 개선한다. 모델 가지치기(Pruning), 지식 증류 기법(Knowledge Distillation), ENAS(Efficient Neural Architecture Search)와 같은 기술을 사용하여 네트워크를 최적화하고 하드웨어 요구 사항을 줄일 수 있다.

나아가 산업적 측면으로 대화형 미디어가 발전함에 따라 아바타 변형을 적응적으로 조정하는 기능이 도움이 될 수 있다. 향후 연구에서는 사용자 입력을 기반으로 Blend Shapes를 동적으로 조정하여 실시간 설정에서 아바타의 반응성과 몰입도를 향상시키는 기술을 탐구할 수 있다.

Ⅴ. 결 론

본 연구는 Neural Blend Shapes를 사용하여 가상 아바타의 리깅 및 스키닝 프로세스를 자동화하는 혁신적인 접근 방식을 제시한다. 이 작업은 캐릭터 애니메이션의 주요 과제를 다루며 기존 방법에 비해 리깅 및 스키닝의 효율성, 확장성, 품질을 향상시키는 솔루션을 제공한다. 본 연구의 시스템은 다양한 3D 메시 데이터 세트에 대해 훈련된 신경망을 활용하여 다양한 신체 유형, 골격 구조 및 애니메이션 스타일에 적응하는 Blend Shaepes를 생성하여 수동 개입의 필요성을 최소화한다.

리깅 및 스키닝의 자동화는 캐릭터 애니메이션에 의존하는 산업에 있어 중요한 발전이다. 시간 절약만으로도 게임 체인저가 되어 더 적은 리소스로 더 많은 콘텐츠를 제작할 수 있다. 또한 리깅과 스키닝 결과의 품질을 높여 수작업과 자동화 시스템 사이의 품질 격차를 해소하여 소규모 팀과 개인 제작자를 위한 고급 캐릭터 애니메이션의 접근성을 향상시킨다.

이 방법은 또한 버추얼 콘텐츠, 게임 등에서의 실시간 상호 작용 등 더 넓은 영역에 영향을 미칠 수 있는 잠재력을 가지고 있다. 가상 및 증강 현실 플랫폼이 성장함에 따라 반응성이 뛰어나고 개인화된 아바타에 대한 필요성이 더욱 시급해질 것이다. Neural Blend Shapes는 이러한 요구를 충족할 수 있는 효율적이고 확장 가능한 방법을 제공한다.

캐릭터 생성의 미래는 자동화에 의해 발전될 가능성이 높으며, 이 논문은 캐릭터 생성 프로세스의 가장 복잡한 부분 중 하나인 리깅 및 스키닝을 자동화하기 위해 신경망을 적용하는 방법을 보여줌으로써 미래에 기여한다. Neural Blend Shapes는 딥러닝과 기존 애니메이션 기술을 통합하여 리깅 및 스키닝 문제에 대한 강력하고 유연하며 확장 가능한 솔루션을 제공하여 향후 더욱 혁신적인 개발을 위한 발판을 마련한다.

Acknowledgments

본 연구는 과학기술정보통신부 및 정보통신기획평가원의 정보통신방송혁신인재양성(메타버스융합대학원)사업 연구 결과로 수행되었습니다(IITP-2024-RS-2024-00425383).

References

-

C. Kyrlitsias and D. Michael-Grigoriou, “Social Interaction with Agents and Avatars in Immersive Virtual Environments: A Survey,” Frontiers in Virtual Reality, Vol. 2, 786665, January 2022.

[https://doi.org/10.3389/frvir.2021.786665]

- E. Got, Developement of an Automatic Skinning System, Master’s Thesis, Universitat Politècnica de Catalunya, Barcelona, Spain, October 2019.

-

S. Bian, L. You, and J. J. Zhang, “Recent Developments in Skin Deformation for Character Animation,” in Proceedings of the 10th International Conference on Computer Graphics Theory and Applications (GRAPP 2015), Berlin, Germany, pp. 122-129, March 2015.

[https://doi.org/10.5220/0005272001220129]

-

B. Mildenhall, P. P. Srinivasan, M. Tancik, J. T. Barron, R. Ramamoorthi, and R. Ng, “NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis,” Communications of the ACM, Vol. 65, No. 1, pp. 99-106, January 2022.

[https://doi.org/10.1145/3503250]

-

S. Lombardi, J. Saragih, T. Simon, and Y. Sheikh, “Deep Appearance Models for Face Rendering,” ACM Transactions on Graphics (TOG), Vol. 37, No. 4, 68, August 2018.

[https://doi.org/10.1145/3197517.3201401]

-

D. Ulyanov, A. Vedaldi, and V. Lempitsky, “Deep Image Prior,” International Journal of Computer Vision, Vol. 128, No. 7, pp. 1867-1888, July 2020.

[https://doi.org/10.1007/s11263-020-01303-4]

-

T. R. Shaham, T. Dekel, and T. Michaeli, “SinGAN: Learning a Generative Model from a Single Natural Image,” in Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV), Seoul, pp. 4569-4579, October-November 2019.

[https://doi.org/10.1109/ICCV.2019.00467]

-

T. Karras, S. Laine, and T. Aila, “A Style-Based Generator Architecture for Generative Adversarial Networks,” IEEE Transactions on Pattern Analysis and Machine Intelligence, Vol. 43, No. 12, pp. 4217-4228, December 2021.

[https://doi.org/10.1109/TPAMI.2020.2970919]

- Autodesk Maya. What are Blend Shapes? [Internet]. Available: https://download.autodesk.com/global/docs/maya2013/en_us/index.html?url=files/Blend_Shape_deformer_What_are_blend_shapes_.htm,topicNumber=d30e325232, .

-

P. Li, K. Aberman, R. Hanocka, L. Liu, O. Sorkine-Hornung, and B. Chen, “Learning Skeletal Articulations with Neural Blend Shapes,” ACM Transactions on Graphics (TOG), Vol. 40, No. 4, 130, August 2021.

[https://doi.org/10.1145/3450626.3459852]

- University of Silicon Valley. The Reality of 3D Character Model Rigging for Animation [Internet]. Available: https://usv.edu/blog/3d-character-model-rigging-animation/, .

- Pluralsight. Understanding Skinning: A Vital Step for Any Rigging Project [Internet]. Available: https://www.pluralsight.com/blog/film-games/understanding-skinning-vital-step-rigging-project, .

-

J.-Y. Baek, “A Study of Use of Auto Rigging Tool to Increase Effectiveness of 3D Animation Production,” Cartoon and Animation Studies, No. 49, pp. 247-265, December 2017.

[https://doi.org/10.7230/KOSCAS.2017.49.247]

-

I. Baran and J. Popović, “Automatic Rigging and Animation of 3D Characters,” ACM Transactions on Graphics (TOG), Vol. 26, No. 3, 72-es, July 2007.

[https://doi.org/10.1145/1276377.1276467]

-

R. Wareham and J. Lasenby, “Bone Glow: An Improved Method for the Assignment of Weights for Mesh Deformation,” in Proceedings of the 5th International Conference on Articulated Motion and Deformable Objects (AMDO 2008), Port d’Andratx, Spain, pp. 63-71, July 2008.

[https://doi.org/10.1007/978-3-540-70517-8_7]

-

L. Kavan and O. Sorkine, “Elasticity-Inspired Deformers for Character Articulation,” ACM Transactions on Graphics (TOG), Vol. 31, No. 6, 196, November 2012.

[https://doi.org/10.1145/2366145.2366215]

-

O. Dionne and M. de Lasa, “Geodesic Binding for Degenerate Character Geometry Using Sparse Voxelization,” IEEE Transactions on Visualization and Computer Graphics, Vol. 20, No. 10, pp. 1367-1378, October 2014.

[https://doi.org/10.1109/TVCG.2014.2321563]

- deepsense.ai. How to Perform Self-Supervised Learning on High-Dimensional Data [Internet]. Available: https://deepsense.ai/how-to-perform-self-supervised-learning-on-high-Dimensional-data/, .

-

L. Liu, Y. Zheng, D. Tang, Y. Yuan, C. Fan, and K. Zhou, “NeuroSkinning: Automatic Skin Binding for Production Characters with Deep Graph Networks,” ACM Transactions on Graphics (TOG), Vol. 38, No. 4, 114, August 2019.

[https://doi.org/10.1145/3306346.3322969]

-

Z. Xu, Y. Zhou, E. Kalogerakis, C. Landreth, and K. Singh, “RigNet: Neural Rigging for Articulated Characters,” ACM Transactions on Graphics (TOG), Vol. 39, No. 4, pp. 58:1-58:14, August 2020.

[https://doi.org/10.1145/3386569.3392379]

-

M. Loper, N. Mahmood, J. Romero, G. Pons-Moll, and M. J. Black, “SMPL: A Skinned Multi-Person Linear Model,” ACM Transactions on Graphics (TOG), Vol. 34, No. 6, 248, November 2015.

[https://doi.org/10.1145/2816795.2818013]

-

B. Bhatnagar, G. Tiwari, C. Theobalt, and G. Pons-Moll, “Multi-Garment Net: Learning to Dress 3D People from Images,” in Proceedings of the 2019 IEEE/CVF International Conference on Computer Vision (ICCV), Seoul, pp. 5419-5429, October-November 2019.

[https://doi.org/10.1109/ICCV.2019.00552]

- Mixamo. Mixamo Characters [Internet]. Available: https://www.mixamo.com/#/?page=1&type=Character, .

- VRoid Hub. VRoid Hub Characters [Internet]. Available: https://hub.vroid.com/en, .

- BOOTH. BOOTH 3D Models [Internet]. Available: https://booth.pm/ja/browse/3D%E3%83%A2%E3%83%87%E3%83%AB?max_price=0, .

저자소개

2018년~현 재: 경희대학교 소프트웨어융합대학 소프트웨어융합학과 학사과정

※관심분야:게임 개발, 메타버스

2002년:University of Dundee (UK), Electronic Imaging. BA (Honours)

2004년:University of Dundee (UK), Electronic Imaging. MSc (이학석사)

2010년:University of Dundee (UK), Electronic Imaging. (게임학), PhD (이학박사)

2004년~2007년: University of Dundee, Lecturer

2007년~2010년: KAIST 엔터테인먼트 공학연구소, 연구원 (기능성 게임랩)

2010년~2012년: KAIST 문화기술대학원, Digital Art & Entertainment Track 초빙교수 (게임)

2012년~2013년: 서울대학교 차세대융합기술연구원, 게임융합미디어연구센터 센터장

2013년~2024년: 경희대학교 디지털콘텐츠학과 교수

2024년~현 재: 경희대학교 일반대학원 메타버스학과 교수

※관심분야:기능성 게임, 게임화, 게임문화, VR/AR 콘텐츠