다중 잠재벡터를 적용하여 학습 안정성을 높인 GAN

Copyright ⓒ 2025 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

현재 다양한 분야에서 사용되는 생성 모델인 GAN은 학습 안정성이 낮다는 근본적인 문제를 갖고 있어서 이를 극복하기 위한 많은 연구가 수행되어왔다. 그러나 아직 완벽한 해결방법은 존재하지 않아 학습 안정성을 높이기 위한 연구가 최근까지 이어오고 있다. 본 연구에서는 GAN의 생성망에 다중 잠재 벡터 개념을 도입하여 학습 안정성을 높이는 방법을 제안한다. 제안한 방법의 성능을 측정하기 위하여 MNIST, FashionMNIST, CIFAR-10 데이터셋을 이용하여 다중 잠재벡터를 사용하지 않은 GAN과 결과를 비교하였다. Vanilla GAN과 Deep Convolutional GAN을 이용하여 실험한 결과 다중 잠재벡터를 적용한 GAN의 학습 안정성이 평균 약 68%, 최대 426%가 증가 되었다. 다만 제안한 방법으로 생성한 이미지의 품질의 경우 대부분 지표에서 좋아졌으나 FID와 Recall 지표에서는 약간 저하됐다.

Abstract

Generative adversarial network (GAN), a generative model currently used in various fields, has a fundamental problem of low learning stability, and substantial research has been conducted to overcome this problem. However, there is no perfect solution yet and research on improving learning stability is ongoing. The proposed method in this study aims to improve the learning stability by introducing the concept of multiple latent vectors into the generative network of GANs. To measure the performance of the proposed method, the results were compared with those of GAN without multiple latent vectors on the CIFAR-10, FashionMNIST, and MNIST datasets. Experimental results using Vanilla GAN and Deep Convolutional GAN showed that the learning stability of GAN applying multiple latent vectors increased by an average of about 68% and a maximum of 426%. In most indexes, except Recall and FID, the quality of images generated by the proposed method improved.

Keywords:

Generative Adversarial Networks, Learning Stability, Mode Collapsing, Multiple Latent Vector, Generator키워드:

생성적 적대 신경망, 학습 안정성, 모드 붕괴, 다중 잠재 벡터, 생성망Ⅰ. 서 론

2014년 생성적 적대 신경망(GAN; Generative Adversarial Networks)이 발표된 이후 이미지 생성을 비롯한 음성, 영상 등 다양한 분야에 응용되어 왔다[1],[2]. 그러나 초기 GAN은 학습이 불안정한 문제로 학습이 되지 않는 경우가 많았으며 생성한 이미지의 품질 또한 좋지 않았다. 이후 GAN에 합성곱 연산을 사용한 심층 합성곱 생성적 적대 신경망(DCGAN; Deep Convolutional Generative Adversarial Networks)이 등장하며 상당 부분 학습 안정성이 개선되었고 생성한 이미지 품질도 향상되었다[2]. 그 결과로 DCGAN에 기반한 다양한 파생 모델이 등장하며 생성망 분야 연구가 활성화되었다[3]-[5]. 그러나 DCGAN 이후의 모델들도 여전히 학습이 불안정한 경우가 많아서 학습 안정성을 높이기 위한 다양한 연구들이 수행되었다[6]-[8].

WGAN (Wasserstein GAN) 과 LSGAN (Least Squares GAN)에서는 GAN이 사용하는 Cross Entropy의 문제점인 그라디언트 소멸을 해결하기 위해 각각 Wasserstein Distance와 Least Square를 손실 함수로 사용하였다[6],[7]. 또한 PGGAN (Progressive Growing of GAN)에서는 고해상도 이미지 생성을 위해 저해상도 이미지에서 시작해 점점 해상도를 높여 학습하는 전략을 취한다[8]. 그러나 이런 다양한 연구에도 불구하고 GAN의 학습 불안정성이나 모드 붕괴(mode collapsing)는 근본적으로 해결되지 않은 상황으로 GAN의 응용을 제한하고 있다.

본 연구에 앞서 제안된 방법은 이러한 문제를 다양한 GAN 모델에서 일반적으로 완화할 수 있도록 기존의 GAN 구조를 거의 변경하지 않으면서 추가적인 방법으로 학습 안정성을 높이는 방법을 고안하였다[9]. 해당 연구에서는 GAN의 생성망이 안정적으로 학습되고 모드 붕괴가 적게 일어나도록 잠재벡터를 다수 사용하여 GAN의 생성망을 학습시킨다. 즉, 기존에는 하나의 잠재벡터로 생성된 이미지로 학습하는 데 비하여 여러 개의 잠재벡터로 생성된 이미지를 평균 내서 평균 이미지를 이용하여 학습한다. 다만 이때 잠재벡터가 너무 넓게 분포하면 매니폴드 형성이 어려울 것이기 때문에 작은 표준편차를 이용하여 다수 개의 잠재벡터를 형성한다.

앞서 제안된 STGAN (Statistical Training GAN)이 얼마나 학습 안정성을 높여주는지 측정하기 위하여 다양한 실험을 설계하여 기존의 GAN과 비교 검증하였다. 성능 비교는 동일한 하이퍼 파라미터와 초기 가중치 하에서 다중 잠재벡터를 적용했을 때 학습 안정성이 얼마나 높아지는지를 측정하였다. 학습 안정성은 특정 학습 에포크 후에 학습 결과를 저자가 직접 눈으로 확인하여 학습이 제대로 수행되었는지를 판별하는 방법으로 측정하였다. 이때 모드 붕괴가 일어나 특정한 학습 데이터만 생성하거나 학습 데이터와 다른 이미지를 만들거나 아니면 이미지 전체가 단색으로 나오는 경우 등은 학습이 실패한 것으로 간주한다. 또한 생성한 이미지의 품질을 정량적으로 비교 평가하기 위하여 FID (Fréchet Inception Distance)와 PRDC (Precision, Recall, Density, Coverage) 평가 척도를 이용하여 실험하였다.

제 2장에서는 다양한 생성모델과 그의 개선을 다룬 연구, 생성모델의 평가지표에 대해서, 제 3장에서는 제안된 STGAN 모델의 구조, 실험과정 및 분석을, 마지막 제 4장에서는 본 연구의 의의, 향후 연구방안 등을 다룬다.

Ⅱ. GAN의 개선

2-1 생성 모델

GAN은 생성망(Generator)과 판별망(Discriminator)의 경쟁을 통하여 생성망이 학습 이미지와 유사한 이미지를 만들도록 하는 생성 모델이다[1]. 생성망은 잠재벡터를 입력받아 학습 이미지와 유사한 것을 만들며, 판별망은 학습 이미지와 생성망이 만든 가짜 이미지를 판별하도록 학습된다. 이를 통하여 생성망이 만든 가짜 이미지는 점점 더 학습 이미지와 유사한 것을 만들게 된다. 그러나 생성망과 판별망의 학습 균형이 맞지 않으면 생성망이 제대로 학습되지 않는 문제가 발생하며, 학습되더라도 특정 데이터만 학습하는 모드 붕괴(mode collapsing)가 발생한다. 생성망과 판별망의 학습 균형을 맞추는 것은 생성망과 판별망의 신경망 구조, 학습률, 학습 횟수 등 다양한 것에 영향을 받기 때문에 매우 어려운 문제로 현재까지도 완벽하게 해결되지 않은 상황이다.

DCGAN은 GAN에 합성 곱 구조를 적용하여 학습 불균형 문제를 개선하여 대부분 상황에서 안정적으로 학습할 수 있게 되었다[2]. 하지만 여전히 학습 불균형 문제는 존재하며 개선의 여지가 남아 있다.

2-2 학습 안정성을 높이기 위한 생성 모델

WGAN은 GAN이 사용하는 Cross-Entropy의 그라디언트 소멸(Vanishing Gradient) 문제를 해결한 Wasserstein Distance를 손실 함수로 사용하여 학습 불안정 문제의 해결을 시도했다[6]. 립시츠 연속성(Lipschitz Continuity) 조건을 만족하게 하려고 Weight Clipping을 사용하였지만, 해당 값에 민감해지는 한계를 가진다. 또한, moment-based optimizer인 Adam에서는 불안정한 문제가 있다.

LSGAN은 그라디언트 소멸 문제 등을 해결하기 위해 Least Square를 손실 함수로 사용하여 추가로 학습 안정성을 달성하고 보다 학습 데이터와 유사한 이미지를 만들 수 있었으나 여전히 학습이 불안정한 문제를 갖고 있다[7].

PGGAN은 고해상도의 이미지 생성을 위해 고안되었으며, 이를 위해 저해상도의 이미지로부터 고해상도로 점점 해상도를 높이는 방법을 통해 처음부터 고해상도 이미지로 학습하는 것보다 적은 자원을 가지고 안정적으로 학습한다[8]. 또한, 생성망과 판별망의 격차를 조절하기 위해 학습률과 특징 벡터를 조정하였다.

이러한 다양한 새로운 GAN 모델에도 불구하고 여전히 학습 안정성이 낮은 것이 GAN 적용의 최대 문제로 대두되고 있다.

2-3 평가 지표

GAN이 학습되는지도 중요하지만 얼마나 실제와 유사하면서도 다양한 이미지를 생성하는가도 GAN 평가에 매우 중요하다. GAN이 생성한 이미지의 품질을 평가하는데 사용하는 지표를 설명한다.

FID점수는 이미지 품질에 대한 정량적인 지표로, IS (Inception Score) 점수의 한계를 극복하고자 만들어졌다[10]. 대상 영역의 실제 이미지 집합과 생성된 이미지 집합의 평균과 공분산을 계산하고, 두 다변수 가우시안 분포(multidimensional Gaussian) 사이의 거리를 Wasserstein-2 거리로도 알려진 Fréchet 거리를 이용해 측정한다. 결과적으로 이 값은 낮을수록 좋으며, 낮을수록 생성된 이미지의 품질이 좋다는 것을 의미한다.

Precision 점수 및 Recall 점수는 모델의 정확도와 재현율에 대한 정량적 지표로, Precision은 분류 모델의 결과가 Positive 것 중 실제로 Positive인 것의 비율을, Recall은 실제로 Positive인 것 중 분류 모델이 Positive으로 판정한 것의 비율로 계산된다[11]. 결과적으로, Precision 점수는 참인 결과가 얼마나 정확한지, Recall 점수는 실제로 참인 것을 얼마나 잘 포함했는지를 나타낸다.

Density 점수 및 Coverage 점수는 각각 Fidelity와 Diversity에 대한 정량적 지표로, Density는 Precision에, Coverage는 Recall에 대응된다[12]. Precision과 Recall이 이상치에 민감한 문제를 해결하기 위해 도입되었다. Precision, Recall, Density, Coverage는 모두 클수록 생성된 이미지 품질이 좋음을 나타낸다.

Ⅲ. STGAN

3-1 STGAN의 구조

GAN의 학습을 안정화하려는 다양한 시도에도 불구하고 아직 이 문제를 완전히 해결한 모델은 없는 상황이다. 본 연구에 앞서 제안된 연구에서는 지금까지 개발된 다양한 GAN에 약간의 변형을 통하여 학습 안정성에 도움이 되는 방법을 고안하였다. 이를 위하여 생성망이 잠재벡터를 한번 샘플링하여 이미지를 생성하는 방법을 변형하여 다수의 잠재벡터를 샘플링하여 생성된 다수 이미지의 평균을 판별망의 fake 이미지로 사용하는 방법을 고안하였다[9].

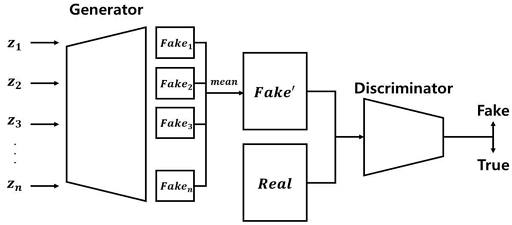

그림 1은 STGAN의 구조를 보여준다. 기본 GAN 구조와 다르게 생성망의 입력으로 사용되는 잠재벡터 z를 가우시안 분포로 샘플링된 다수의 zi를 사용하여 가짜 이미지를 만들고 이러한 가짜 이미지들을 평균하여 하나의 가짜 이미지를 만든다. 이렇게 하면 다수의 잠재벡터로 생성된 이미지들의 평균을 기준으로 생성망이 학습되기 때문에 생성망의 잠재 벡터 공간이 더 빠르게 학습되어 판별망과의 학습 불균형 문제가 완화되고 특정 학습 데이터만 집중적으로 생성되는 모드 붕괴 현상이 완화되며 다양한 이미지를 생성할 수 있다. 이때 z를 샘플링하는 가우시안 분포의 분산이 너무 작으면 기본 GAN과의 차이가 작고 너무 크면 수렴하는데 더 오랜 시간이 필요하다. 본 연구에서는 다양한 분산에서의 실험을 수행하였다.

3-2 실험 방법

실험에 사용한 모델은 VGAN[1] 및 DCGAN[2]이며 데이터셋은 MNIST (Modified National Institute of Standards and Technology), FashionMNIST, 그리고 CIFAR-10 (Canadian Institute For Advanced Research-10)를 사용하였다. 다중 잠재벡터를 적용한 모델은 STVGAN (Statistical Training Vanilla Generative Adversarial Networks) 및 STDCGAN (Statistical Training Deep Convolutional Generative Adversarial Networks)으로 표기한다. 학습 안정성은 정성적인 구분에 기반하여 ‘이미지 생성이 성공한 경우/전체 생성 이미지’로 검증하였다. 또한, 이미지 품질의 비교에는 이미지 생성이 성공한 경우의 이미지로 FID 및 PRDC score를 구하여 이용하였다.

학습에 사용한 learning rate는 0.0002로 설정하였으며 잠재벡터를 가우시안 샘플링할 때 사용한 분산 σ는 0.00001과 0.1 사이의 값으로 사용하였다. 또 다른 하이퍼파라미터인 seed는 10부터 100까지 10단위로 하여 실험하였다. 또한, VGAN은 epoch 300, DCGAN은 epoch 500 동안의 결과를 통해 학습 안정성 및 이미지 품질을 비교하였다.

3-3 학습 안정성의 비교

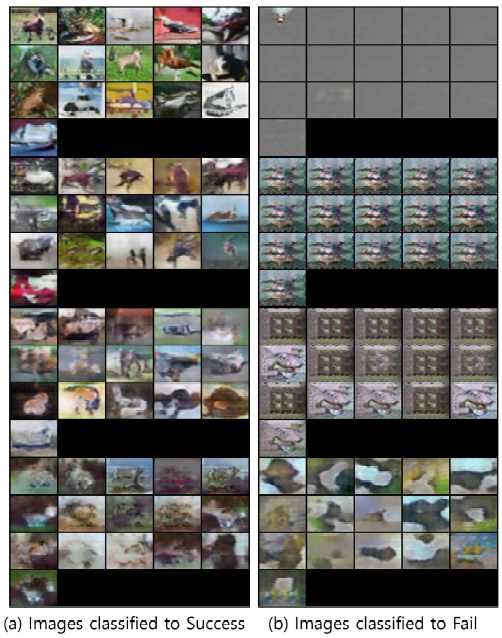

본 연구에서 학습 안정성을 ‘이미지 생성이 성공한 경우/전체 생성 이미지’로 수치화하였는데, 이때 ‘이미지 생성이 성공한 경우‘는 그림 2에서 (a)와 같은 경우이다. 반면 ’이미지 생성 실패‘는 (b)와 같은 경우이다. 그림 2의 (b)에서 보듯이 이미지가 전혀 나오지 않거나 특정 이미지가 반복되거나 학습 데이터에 없는 데이터를 생성하는 경우에 해당한다.

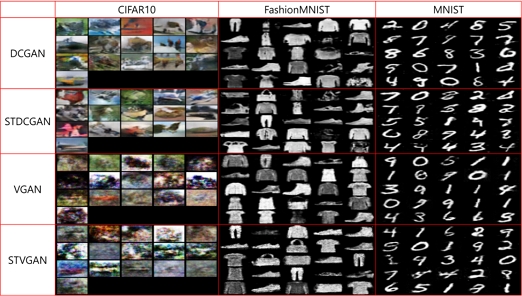

그림 3은 CIFAR-10, FashionMNIST 및 MNIST 데이터셋에서 각 모델이 성공적으로 이미지를 생성한 것을 보여준다. 학습이 성공한 경우 모든 모델이 학습 데이터와 유사한 품질의 이미지를 생성하는 것을 볼 수 있으며 전체적으로 DCGAN 과 STDCGAN이 VGAN이나 STVGAN보다 정교한 이미지를 생성하는 것을 볼 수 있다.

제안된 방법에서 잠재벡터 zi를 샘플링하는 개수 n(z)와 가우시안 표준편차 σ에 따른 성능을 측정하기 위하여 다양한 실험을 하였다.

실험은 방법별로 seed 10~100까지 10씩 증가하는 10개의 seed를 사용하였으며 n(z)는 5, 7, 50의 3개 수치를 사용하였는데, 이는 n(z)의 증가에 따라 일관되게 학습 안정성이 향상되는 효과가 있는지 확인하기 위함이다.

본 실험을 통해 얻은 결론은 다음과 같다. 가장 중요한 사실은 파라미터에 따라 정도의 차이는 있으나, 모든 경우에서 DCGAN보다 STDCGAN의 학습 안정성이 높다는 것이다. 두 번째로 알 수 있었던 것은 특정 σ에서 최대의 안정성이 나온다는 것이다.

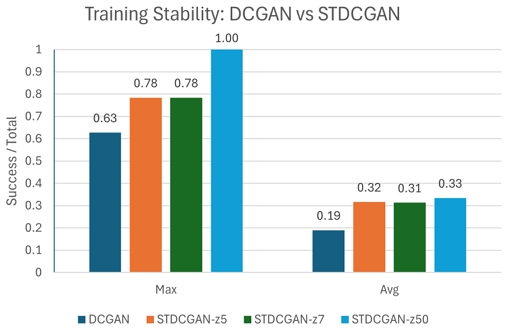

그림 4는 DCGAN과 비교했을 때 STDCGAN의 최고 성능을 그래프로 나타낸 것이다. 비록 최고성능이 실험 별로 다른 파라미터에서 발생했지만 좋은 파라미터를 선택한 경우 얻을 수 있는 최고성능을 보여준다. 실험결과 DCGAN에 비해 STDCGAN의 학습 안정성이 평균적으로 약 68%(0.19 → 0.33), 최대 426%(0.19 → 0.63) 향상됨을 확인하였다. 그림에서 z5, z7, z50은 zi를 샘플링하는 개수 n(z)가 5, 7, 50일 때를 의미한다.

3-4 이미지 품질의 비교

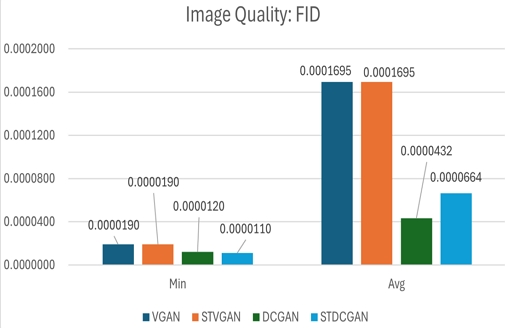

본 연구에서 모델이 생성한 이미지의 품질은 FID와 PRDC 수치 두 종류로 평가하며 실험에서 보인 수치를 요약하면 그림 5, 6과 같다. 그림 5는 모든 데이터셋(CIFAR-10, FashionMNIST, MNIST)에서 학습된 모든 모델(VGAN, STVGAN, DCGAN, STDCGAN)의 FID 최소 및 평균 수치를, 그림 6은 PRDC 최소 및 평균 수치를 나타낸다.

그림 5에서 보여주듯이 FID 수치에서는 기존 GAN과 STVGAN 모두 평균 0.0001695, 최소 0.000019 으로 오차범위 내에서 동일한 값을 가졌다. 반면 기존 DCGAN의 0.0000432 대비 STDCGAN은 0.0000664로 평균적으로는 약 50% 높은 FID 수치를 보였으나, 최소 수치로 비교하면 STDCGAN은 0.000011로 DCGAN의 0.000012대비 약 90%정도로 오히려 더 작은 FID를 보였다. 이러한 결과는 FID 측면에서 제안한 방법이 평균적으로 약간의 성능 하락이 있으나 문제 될 정도는 아니며 파라미터에 따라서 더 좋을 수도 있음을 보여준다.

그림 6에서 보여주듯이 Precision 측면에서는 제안 모델 대 기존 모델의 성능 비가 최대 1.73, 평균 1.02로, 이는 제안모델이 최대 73%, 평균 2% 더 나은 성능을 보였음을 뜻한다. Recall 측면에서는 제안 모델 대 기존 모델의 성능 비가 최대 1.94, 평균 0.97로 최상의 경우 94% 더 나은 성능을 보였으나, 평균적으로는 약 3% 저하된 성능을 보였음을 나타낸다. Density 측면에서는 제안 모델 대 기존 모델의 성능 비가 최대 2.13, 평균 1.05로 이는 제안모델이 최대 113%, 평균 5% 더 나은 성능을 보였음을 의미한다. Coverage 측면에서는 제안 모델 대 기존 모델의 성능 비가 최대 1.53 평균 1.02로 이는 제안모델이 최대 53%, 평균 2% 더 나은 성능을 보였음을 나타낸다.

결론적으로 이미지 품질 측면에서는 대부분의 성능이 향상되었으나, FID와 Recall 측면에서는 평균적으로는 약간 저하된 성능을 보였다고 정리할 수 있다. 이러한 결과는 본 논문에서 제안한 방법이 학습 안정성을 높이면서도 생성되는 이미지의 품질이 기존 방법에 비하여 저하되지 않고 실험 설정에 따라서 더 좋아질 수 있음을 보인 것으로 의미 있다고 하겠다.

Ⅳ. 결 론

본 연구에서는 GAN의 학습 안정성을 개선하기 위하여 다중 잠재벡터를 생성망에 사용하는 방법을 제안하고 효과를 검증하였다. Vanilla GAN과 DCGAN에 제안한 방법을 구현하고 MNIST, FashionMNIST, CIFAR10 데이터셋을 사용하여 학습 안정성과 생성 이미지 품질 성능을 실험하였다. 실험결과 학습 안정성이 향상됨을 관찰하였으며 또한 생성된 이미지의 품질 측면에서도 기존 방법과 유사하거나 약간 향상된 결과를 보았다. 본 논문에서 제안한 방법은 다양한 GAN에 쉽게 추가해서 적용할 수 있는 방법으로 기존 모델 학습 안정성 향상에 기여할 것으로 기대된다. 앞으로 최근에 개발된 GAN 에 적용하여 성능을 분석하는 것이 필요하다.

Acknowledgments

본 연구는 한성대학교 학술연구비 지원과제입니다.

본 논문의 내용은 2022년 한국디지털콘텐츠학회 추계학술대회에서 발표한 “GAN의 학습 안정성과 성능향상을 위한 다중 잠재 벡터를 이용한 통계적 학습” 연구를 확장하여 실험하고 분석하여 작성하였습니다.

References

-

I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, ... and Y. Bengio, “Generative Adversarial Networks,” Communications of the ACM, Vol. 63, No. 11, pp. 139-144, November 2020.

[https://doi.org/10.1145/3422622]

-

A. Radford, L. Metz, and S. Chintala, “Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks,” arXiv:1511.06434, , November 2015.

[https://doi.org/10.48550/arXiv.1511.06434]

- X. Chen, Y. Duan, R. Houthooft, J. Schulman, I. Sutskever, and P. Abbeel, “InfoGAN: Interpretable Representation Learning by Information Maximizing Generative Adversarial Nets,” in Proceedings of the 30th International Conference on Neural Information Processing Systems (NIPS ’16), Barcelona, Spain, pp. 2180-2188, December 2016.

-

Y. Saatchi and A. G. Wilson, “Bayesian GAN,” arXiv:1705.09558, , 2017.

[https://doi.org/10.48550/arXiv.1705.09558]

-

H. Zhang, T. Xu, H. Li, S. Zhang, X. Wang, X. Huang, and D. Metaxas, “StackGAN: Text to Photo-Realistic Image Synthesis with Stacked Generative Adversarial Networks,” in Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV), Venice, Italy, pp. 5908-5916, October 2017.

[https://doi.org/10.1109/ICCV.2017.629]

- M. Arjovsky, S. Chintala, and L. Bottou, “Wasserstein Generative Adversarial Networks,” in Proceedings of the 34th International Conference on Machine Learning (ICML ’17), Sydney, Australia, pp. 214-223, August 2017.

-

X. Mao, Q. Li, H. Xie, R. Y. K. Lau, Z. Wang, and S. P. Smolley, “Least Squares Generative Adversarial Networks,” in Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV), Venice, Italy, pp. 2813-2821, October 2017.

[https://doi.org/10.1109/ICCV.2017.304]

-

T. Karras, T. Aila, S. Laine, and J. Lehtinen, “Progressive Growing of GANs for Improved Quality, Stability, and Variation,” arXiv:1710.10196v3, , February 2018.

[https://doi.org/10.48550/arXiv.1710.10196]

- H. B. Kim and S. H. Jung, “Statistical Learning Using Multiple Latent Vectors for Improving Learning Stability and Performance of GANs,” in Proceedings of the Korean Society for Digital Contents Autumn General Conference and University Student Paper Competition, Suwon, pp. 61-62, November 2022.

-

M. Heusel, H. Ramsauer, T. Unterthiner, B. Nessler, and S. Hochreiter, “GANs Trained by a Two Time-Scale Update Rule Converge to a Local Nash Equilibrium,” arXiv:1706.08500, , 2017.

[https://doi.org/10.48550/arXiv.1706.08500]

-

D. M. W. Powers, “Evaluation: From Precision, Recall and F-Measure to ROC, Informedness, Markedness & Correlation,” arXiv:2010.16061, , October 2020.

[https://doi.org/10.48550/arXiv.2010.16061]

- M. F. Naeem, S. J. Oh, Y. Uh, Y. Choi, and J. Yoo, “Reliable Fidelity and Diversity Metrics for Generative Models,” in Proceedings of the 37th International Conference on Machine Learning (ICML ’20), Online, pp. 7176-7185, July 2020.

저자소개

2016년:한성대학교 사회과학부 벤처경영 (경영학사), IT융합공학부 지능시스템 (공학사)

2023년~현 재: 경희대학교 대학원 인공지능학과 석사과정

※관심분야:인공지능(AI), 설명가능한 인공지능(XAI), 비디오 캡셔닝(Video Captioning)

2022년~현 재: 한성대학교 IT융합공학부 사이버보안/정보시스템트랙 학사과정

※관심분야:정보보안(Information Security), 양자컴퓨팅(Quantum Computing), 인공지능(AI) 등

1988년:한양대학교 전자공학과 (공학사)

1991년:KAIST 전기및전자공학과 (공학석사)

1995년:KAIST 전기및전자공학과 (공학박사)

1996년~현 재: 한성대학교 AI응용학과 교수

※관심분야:인공지능, 의료/바이오 인공지능, 문화기술