NeRF와 3DGS를 사용한 공간 스캔 데이터의 영상화 작업을 위한 소프트웨어 활용성 비교 연구

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

근래의 디지털콘텐츠 제작 환경은 3D 스캔을 포함한 다양한 방식으로 3D 모델 데이터들을 생성하는 방식들이 등장해 여러 영역에서 활발하게 사용되고 있다. 최근 등장한 심층 신경망으로 정보를 학습해 3D 정보를 계산하는 방식인 NeRF(Neural Radiance Field)와 가우시안을 사용해 3D를 구현하는 3DGS(3D Gaussian Splatting ) 방식은 모바일 기기에서 촬영한 적은 수의 사진이나 영상만으로도 빠르게 3D 데이터를 생성하고 렌더할 수 있어 최근 주목받고 있다. 본 연구에서는 기존의 포토그래메트리와 라이다 스캔과 함께, NeRF와 3DGS를 사용해 실제 생성한 데이터들을 비교하고 이를 3DS MAX와 기타 프로그램들을 사용해 이미지로 렌더하는 프로세스들을 비교 분석하였다. 향 후 관련 기술들이 3D 제작프로그램에 본격적으로 지원된다면 실사 영상을 포함한 다양한 분야에서 효율적인 제작이 가능할 것이다.

Abstract

In recent digital content production, various methods for generating three-dimensional (3D) model data, including 3D scanning, have emerged and are being actively utilized across multiple fields. Newly introduced techniques, such as neural radiance field (NeRF), which calculates 3D information by learning through deep neural networks, and 3D Gaussian splatting (3DGS), which implements 3D Gaussians, have garnered considerable attention for their ability to quickly generate and render 3D data using only a small number of photos or videos taken from mobile devices. In this study, we compared and analyzed the actual data generated using NeRF and 3DGS with those obtained using traditional photogrammetry and light detection and ranging (LiDAR) scanning, further examining the processes of rendering images using 3D Studio MAX and other programs. Full support of these related 3D production technologies in the future will enable efficient production in various fields, including live-action video.

Keywords:

3D Scan, NeRF, 3DGS, Point Cloud, Contents Design키워드:

3D 스캔, 포인트 클라우드, 콘텐츠 디자인Ⅰ. 서 론

근래의 디지털콘텐츠 제작 환경은 3D 모델링 전문가들이 오랜 시간을 거쳐 3D 모델을 직접 폴리곤 메시로 제작하던 방식에서 벗어나 3D 스캔 및 다양한 방식으로 3D 모델 데이터를 생성하는 방식들이 등장해 다방면에서 활용되고 있다. 특히 이러한 3D 스캔 데이터들은 현실의 객체와 환경을 3D 데이터화 할 수 있는 이점이 있기 때문에 건축, 확장현실 스튜디오, 디지털 트윈, 실사 촬영과 게임 영역 등 다양한 분야의 제작 환경에서 차츰 사용도가 넓어지는 중이다.

2024년 8월 개최된 2024 언리얼 페스트 서울에서 언리얼의 리얼리티 캡쳐를 사용한 디지털 트윈과 VFX 적용 사례들이 소개되었으며[1], 메타는 디지털 트윈을 위해 3D 객체를 재구성하는 기술인 리얼리티 랩의 카탈로그를 내놓았다[2].

3D 스캔의 대표적인 방식은 레이저와 라이다(LiDAR) 스캔과 포토그래메트리 방식이 있는데, 고가의 장비를 사용하여 전문 스튜디오 공간에서 스캔하여 고품질의 데이터를 얻어내는 방법 외에도 모바일 기기에 장착된 라이다나 ToF 센서를 활용하여 간단한 3D 스캔을 할 수 있는 어플리케이션과 관련 기술들이 공개되면서 이와 관련한 연구들도 활발히 진행되고 있다. 더불어 최근 인공지능 학습 관련 기술이 빠르게 발전하면서 적은 양의 2D 이미지 혹은 영상으로도 쉽게 3D 모델을 제작할 수 있는 NeRF 방식과 가우시안을 사용해 빠르게 렌더할 수 있는 3DGS 방식이 등장해 이를 활용한 연구가 새로운 방법으로 주목받고 있다[3],[4].

그동안의 3D 스캔에서 생성된 데이터는 주로 고밀도의 포인트 클라우드와 폴리곤 메시 데이터들로, 이 경우 일반적으로 3D 프로그램에서 직접 제작한 메시 모델보다 포인트와 버텍스의 양이 압도적으로 많고 스캔의 오류 등을 직접 편집하거나 텍스쳐 맵을 정리해야 하는 문제가 있다. 결국 콘텐츠에 적용하기 위해서는 폴리곤 메시들을 줄이거나 재구성하는 리메시와 리토폴로지 작업을 거쳐야 하며 텍스쳐 맵 역시 사진 데이터를 기반으로 새롭게 제작해야 한다.

NeRF와 3DGS의 방식은 레이저나 라이다, 포토그래메트리 방식보다 밀도가 훨씬 적은 포인트들로도 가우시안을 사용해 밀도가 채워진 것처럼 보이도록 하며 3D 모델의 생성 없이 2D 이미지를 바로 표현할 수 있는 장점이 있어 일반 대중들도 쉽게 접근할 수 있는 플랫폼들이 생겨나고 있다. 이러한 플랫폼의 데이터들이 실제 어떠한 수준으로 데이터가 추출되고, 추출된 데이터를 콘텐츠 제작에 직접 활용하기 위해 어떠한 프로그램과 연동하여 데이터를 가공할 수 있는지 살펴볼 필요가 있다.

본 연구에서는 콘텐츠의 배경이 될 수 있는 실제 공간을 위주로 촬영한 영상과 사진 이미지들을 사용하여 NeRF 플랫폼에서 3D 데이터로 추출하고, 라이다 및 포토그래메트리를 적용한 데이터와 비교 및 실제 3D Max 및 기타 프로그램과의 활용성을 비교 분석해 보고자 한다.

Ⅱ. 이론 및 선행연구 검토

2-1 포토그래메트리 스캔

사진을 바탕으로 측량하는 포토그래메트리(Photogrammetry) 방법은 피사체를 둘러싸고 여러 각도에서 촬영된 여러 장의 중첩된 사진을 바탕으로 광학 및 투영 기하학을 사용하여 3D 모델을 생성하는 방법이다. 카메라와 피사체 간의 거리와 사진 속 포인트들의 위치를 바탕으로 3D 좌표와 컬러 값을 추출한다. 드론으로 촬영하거나 DSLR로 촬영한 고해상도의 사진들을 사용해 2D 이미지에서 3D 데이터로 추출할 수 있다는 점이 장점이다. 사진 간의 상대적인 차이를 바탕으로 추출하므로 정확한 크기를 알 수 없고 사진에 보이지 않는 부분이나 정밀한 형태들을 파악하기 힘들어 정확도가 떨어질 수 있다. 또한 조명이나 재질 상태에 따라 왜곡이 발생할 수 있으며 고해상도의 수많은 이미지를 처리할 경우 많은 시간이 소요된다. 이렇게 생성한 데이터를 폴리곤으로 변환시킬 때 폴리곤 수는 500만개에서 2천200만개 사이가 된다.

2-2 레이저와 라이다(LiDAR) 스캔

3D 스캐너의 경우 피사체에 빛의 패턴을 투사하고 표면에 보이는 왜곡된 패턴을 분석하여 입체 표현의 형태를 스캔하는 구조화광(Structured light) 방식 혹은 초당 수천에서 수만개의 레이저를 발사하여 피사체의 표면에서 반사되는 각도를 측정하여 거리를 계산하는 레이저 방식, ToF(Time of Flight) 측정 방식으로 적외선 레이저를 발사한 이후 물체에 반사돼 돌아오는 시간을 측정, 거리로 변환하는 라이다(LiDAR) 등 여러 방법이 사용되고 있다. 이 방식은 피사체의 정밀한 형태와 절대적인 크기에 대한 정보도 정확하게 측정 가능하며 데이터 생성 속도도 빠르기 때문에 복잡한 구조물도 스캔할 수 있다. 빛 또는 레이저가 닿을 수 있는 범위에 따라 스캔 가능 거리와 장비의 사양이 달라진다. 전문적인 3D 스캐너의 가격이 천만원 이상의 고가이고 전용 소프트웨어를 통해 후처리되기 때문에 접근성이 좋지 않다. 이 데이터를 폴리곤으로 변환시킬 때 폴리곤 수는 천5백만 개가량에 이를 수 있다[3].

이 중 라이다(LiDAR)는 2020년 애플의 아이폰과 아이패드 등에 소량화된 센서가 탑재되어 모바일에서도 3D 스캔이 가능하도록 상용화하였으며, 전문적인 3D 스캐너만큼 정밀함이 떨어지고 레이저에 비하면 탐지거리가 짧으며 라이다 센서 자체가 날씨와 태양광의 영향을 받는 등의 한계가 있지만 모바일 기기만으로 사물을 빠르게 3D 스캔할 수 있어 접근성이 좋다.

2-3 포인트 클라우드

앞서의 포토메트리와 3D 스캔 방식을 통해 취득한 3D 공간 좌표 정보들은 포인트 클라우드(Point Cloud)와 메시(Mesh)로 생성된다. 포인트 클라우드는 좌표(position), 색(color), 법선 벡터 정보 등을 포함한 점의 집합이며 3차원 공간에 점을 군집시켜서 3차원 객체를 표현하는 데이터 구조이다. 포인트 클라우드는 각 점의 좌표와 색에 대한 정보만 가지고 있어도 객체를 표현할 수 있기 때문에 그 구조가 메시에 비해서 단순하여 가공 및 분석이 쉽다는 장점이 있다. 또한 포인트 클라우드가 단순한 구조로 실사의 3차원 객체 생성에 유리하기 때문에 3D 스캐너, 라이다 등 실사의 물체를 스캔하여 3차원 객체 정보를 생성하는 복원 기술에서는 포인트 클라우드 포맷이 주로 사용된다[4].

포인트 클라우드에서 생성된 포인트들을 정점(vertex)으로 전환하여 삼각형으로 연결한 면(face)으로 구성한 메쉬 형태로도 데이터를 추출할 수 있는데 일반적인 3D 모델보다 매우 많은 정점을 가진 매우 높은 수의 폴리모델이 생성되게 된다.

2-4 NeRF와 3DGS

NeRF(Neural Radiance Fields)는 3차원 물체나 공간의 체적 렌더링에 필요한 체적 밀도 σ와 색 c를 출력하는 심층 신경망이다. Ben Mildenhall et al.이 처음 NeRF의 개념을 발표하였으며[5], NeRF는 그림 1에서 처럼 이미지를 통해서 학습된 이미지를 바탕으로 레이(Ray)를 추적하는 방법을 적용해 3차원 점과 방향뿐만 아니라 그 사이의 임의의 위치와 방향이 주어져도 학습된 결과를 고려한 연속적(continuous)이고 의미 있는 값을 도출한다[6].

또한 3D 객체를 2차원의 이미지로 렌더링하기 위해서 메시는 객체의 표면만을 렌더링하고(surface rendering), 포인트 클라우드는 객체의 내부까지 렌더링하는 볼륨 렌더링(volume rendering)이 가능한데 NeRF는 표면 렌더링과는 다르게 실제 3D 공간을 재구성할 때 포인트 클라우드와 유사한 형태의 3D 공간에 위치 정보와 투명도, 색상을 가진 픽셀 포인트를 배치하여 공간의 포인트 밀도와 색상에 주력하며 재건하기 때문에 저용량의 3D 데이터로도 고품질의 2D 이미지를 생성할 수 있다. NeRF의 장점은 앞선 포토그래메트리 방식보다 훨씬 적은 양의 이미지와 저해상도의 영상으로도 학습을 통해 보이지 않는 부분까지 포함한 3D 모델을 생성할 수 있으며 볼륨 렌더를 통해 2D 이미지로 빠르게 렌더할 수 있다는 점이다. 하지만 학습을 통해 이미지 속에 보이지 않은 부분을 생성할 경우 정확한 정보가 없으므로 실제와 다른 형태로 만들어질 수 있고, 빠르게 렌더한 이미지와 영상 생성만 가능하고 실제 3D 모델은 생성되지 않는다. 다른 방법으로 메시로 추출한 표면이 기존의 3D 스캔보다는 투박하고 매끄럽지 않기 때문에 3D 모델링 이후 후처리가 필수적이다[7]. 개발 초기의 NeRF는 이미지를 학습시키는 데 걸리는 시간이 하루 가까이 걸렸지만, 최근에는 기술의 발전으로 30분에서 한 시간 남짓으로 계산 시간이 단축되었다.

3DGS(3D Gaussian Splatting)는 3D 장면을 위치와 색 정보를 담은 3D 가우시안(Gaussian) 덩어리로 표현하는 방식이다. Bernhard Kerbl et al.은 그림 2처럼 NeRF와 유사한 방식을 사용하여 카메라에 촬영된 이미지나 영상을 기반으로 밀도가 낮은 SfM(Structure-from-Motion) 포인트를 추출하고 이를 3D 가우시안 세트들로 표현할 수 있는 방식을 발표하였는데[8], 3D 포인트 위치에 가우시안의 색, 투명도, 크기 정보까지 포함하여 생성하게 되어 포인트 클라우드보다 밀도가 낮은 정보들로도 고품질의 이미지로 훨씬 빠르고 효율적으로 표현할 수 있고 NeRF보다 속도가 빨라 실시간 렌더가 가능하여서 최근 주목받는 방식이다.

2-5 연구동향

3D 스캔과 포인트클라우드 관련한 연구는 다양한 분야에서 꾸준히 진행되어 왔다. 기술적 개선을 연구한 논문 외에 콘텐츠의 활용 분야와 관련한 연구로는 논문[9]처럼 3D 스캔으로 실제 유물이나 건축물들을 3D로 복원하거나, 고해상도 이미지로 촬영할 수 있는 여러 대의 카메라로 동시에 촬영하여 실제 인물의 볼류매트릭 캡쳐를 생성하여 하이 폴리 모델을 생성하거나[10] 3D 프린팅하는 연구[11], 논문[12]와 같이 실제 인형을 3D 스캔한 데이터를 바탕으로 애니메이션용 폴리곤 모델을 제작하는 연구, 프로그램에서 전용 스튜디오를 활용하여 이러한 볼류매트릭 캡쳐를 프레임별로 캡쳐하여 영상을 제작하는 볼류매트릭 비디오에 관한 연구[13], 디지털트윈[14]이나 XR 관련하여[15] 3D 스캔 데이터를 사용하려는 연구들을 찾아볼 수 있다.

Hou and Kim은 포토그래메트리 방식의 리얼리티 캡쳐 프로그램으로 건물 외관을 스캔할 때 건물의 투명한 유리창을 더욱 정확하게 스캔하기 위하여 원본 사진을 보정 및 후처리하여 생성된 결과를 비교하였다[16].

Yoo et al.은 실내 공간구조를 추정하기 위하여 RGB-D 카메라를 이용해 실제 실내 공간을 스캔하여 포인트 클라우드를 생성하고 바닥 면의 모서리를 포함한 공간구조를 복원하였다[17].

Yang and You는 메타버스 제작 목적으로 포토그래메트리 방식을 포함한 리얼리티 캡쳐 등의 3차원 재구성 소프트웨어를 사용하여 실내 공간을 3D 스캔한 뒤 Open 3D 기반의 프로그램으로 메시를 정합하고 마야 프로그램 내의 UV 기능으로 맵을 수동 정리하고 교차 편광 촬영으로 텍스쳐를 개선하여 메타버스 프로젝트로 불러오는 파이프라인을 제안하였다[18].

NeRF의 경우 학습 속도 개선, 혹은 원본과 비교하여 복원력의 정량적인 수치를 개선하거나 그 외 기술적 연구한 논문들이 주를 이루며 실제 콘텐츠 제작을 위한 관점에서 생성된 데이터들에 관한 연구는 아직 많이 이뤄지지 않은 상황이다.

Ⅲ. 연구 방법

본 연구에서는 먼저 실제 공간을 선택해 영상과 이미지들로 촬영한 뒤 NeRF 플랫폼에 업로드하여 데이터 처리 과정과 생성된 데이터들을 비교하였다.

현재 공개된 NeRF 생성 데이터의 경우 주로 조형물이나 가구처럼 하나의 객체를 중심에 두고 원형으로 둘러싸듯이 이동하면서 촬영한 영상과 이미지를 바탕으로 만들어진 사례들이 대부분이다. NeRF 방식의 경우 영상 속에 찍힌 이미지들을 분석하여 카메라의 동선 및 객체의 형태를 추출하기 때문에 카메라의 위치를 이동하며 촬영하는 것이 제일 최적이고 카메라의 각도를 회전시킬 때는 제대로 된 공간 추적이 이루어지지 않는다.

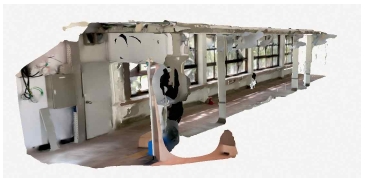

실험 공간은 홍익대학교 제4 강의동의 복도로 한쪽 벽면은 창문이 있어 자연광과 창문 밖 야외공간의 처리 등을 비교할 수 있고, 복도와 연결된 전체 공간을 어디까지 인식하는지 비교하기 위해 선택하였다. 대중적으로 접근이 쉬운 모바일 기기만으로 촬영이 가능한지를 보기 위해 24년 8월 갤럭시 폴드5의 0.6배 광각 렌즈로 영상과 사진을 촬영하였다. 먼저 복도를 앞으로 느리게 전진했다가 옆으로 이동한 후 다시 뒤로 후진하는 동선으로 HD 크기 30fps의 41초 길이 MP4 영상 A를 촬영하였고, 똑같은 동선으로 이동하되 일정 간격을 두고 촬영 버튼을 눌러 촬영한 4000*3000px, jpg 포맷의 연속 사진 세트 36장을 사용하였다(표 1 참고).

The Photo image and capture of video and for test. Yellow arrow shoes movement path while taking video

NeRF와 3DGS 생성은 대중적인 포맷의 결과물을 다운받을 수 있도록 제공하는 대표적인 플랫폼인 ‘루마 에이아이(Luma AI, https://lumalabs.ai/interactive-scenes)’의 Interactive Scene capture 기능과 ‘폴리캠(Polycam, https://poly.cam/)의 Gaussian Splat Creator 기능을 사용하였다. 두 플랫폼 모두 웹사이트와 iOS, 안드로이드 앱을 제공하여 PC와 모바일에서 업로드 가능하며 클라우드를 통해 데이터를 처리한 뒤 사이트에서 생성된 데이터를 바로 보거나 다운받을 수 있도록 오픈 서비스를 제공하고 있다.

또한 비교군으로 폴리캠에서 함께 제공하고 있는 라이다 스캔 기능을 사용하여 같은 공간을 아이패드 프로로 스캔하여 데이터를 생성하였으며, 앞서 촬영한 연속 이미지를 Photogrammetry Creator 기능으로도 생성하였다.

이후 포인트 클라우드와 메시로 생성되어 여러 포맷으로 다운받은 데이터들을 3DS Max를 중심으로 3D 프로그램에서 처리할 경우의 프로세스와, 메시랩(MeshLab)과 리캡 프로(Recap Pro), 슈퍼스플랫(SuperSplat)에서의 편집 프로세스, 렌더 결과물을 비교하였다.

Ⅳ. Nerf 데이터 비교

4-1 Nerf 플랫폼 별 데이터 생성 비교

실험 영상과 이미지를 루마 에이아이(LUMA AI)와 폴리캠(polycam) 사이트에 업로드한 결과 학습을 완성하는 데에 대략 40~50분의 시간이 소요된 후 씬이 생성되었다.

루마 에이아이는 최소 10장 이상의 이미지부터 생성 가능하다고 안내하나 이미지 세트 중 일부를 삭제한 14장의 이미지를 업로드했을 때 영상 구성에 실패하였고 27장의 경우는 구성에 성공했으며 영상과 이미지 모두 최대 5기가바이트까지 업로드할 수 있다. 폴리캠은 최소 20장부터 1000장, 영상은 최소 15초부터 최대 16기가바이트까지 업로드할 수 있다고 안내하고 있다. 안정적인 생성을 위해서는 둘 다 최소 20장 이상의 이미지가 필요하다고 볼 수 있다.

두 사이트 모두 웹사이트 내의 Web GL library와 뷰어를 통해 표 2에서처럼 3DGS 형식으로 생성된 장면을 확인할 수 있으며 장면 안에서 시점을 이동하거나 회전하며 장면을 탐색할 수 있다. 표 2의 뷰어에서 보이는 공간의 가장자리 모습을 보거나 표 3에서처럼 공간의 정면과 후면을 비교했을 때, 후면은 이미지에 보이지 않는 영역이 많으므로 가우시안의 밀도가 적어 산개된 모습으로 보이지만 복도 내부를 포함한 주요 공간 내부는 실제 사진을 그대로 옮긴 것과 유사하게 보이도록 가우시안이 형성되는 것을 확인할 수 있다. NeRF는 이미지에 보이는 점을 위주로 상대적인 위치를 파악하기 때문에 카메라를 회전하여 보이지 않는 뒷면까지 촬영하면 제대로 공간을 파악하지 못한다. 이 경우 뒷면을 위주로 별도의 영상이나 사진을 촬영해 생성해야 한다.

표 2와 표 3에서처럼 영상 A와 사진 세트들로 생성한 결과물을 비교하였을 때, 촬영한 시각의 일조량 차이와 해상도에 따라 사진과 영상의 채도와 명도에 차이가 있는데, 이 채도와 선명도가 생성된 데이터의 컬러 값에 반영되어 원본과 동일한 채도와 명도로 데이터들이 생성되었다. 사진과 영상으로 생성한 데이터의 품질 차이는 가우시안으로 표현되는 웹 뷰어 상에서는 유의미한 차이가 보이지 않았다. 생성된 포인트 클라우드 및 메시의 형태와 수치 등 세부적인 데이터는 4-2항목에서 기술할 예정이다.

실험 대상인 복도 공간의 한쪽 면은 창문으로 구성되어 있는데, 영상으로 생성한 데이터는 표 4에서 보는 것처럼 창문 너머로 보이는 나무 등 실외 환경까지 일정한 거리를 두고 가우시안으로 생성되었으며 창문은 뚫려 있는 형태로 구현되었다. 이미지들을 학습하여 형태를 추론하기 때문에 이러한 실제 공간 너머의 환경까지 일부 생성할 수 있는 것이 NeRF와 3DGS의 장점이다. 반면에 사진으로 생성한 데이터는 창문 밖에 보이는 풍경이 창문에 그림처럼 붙어있는 것처럼 생성되었다.

좀 더 세부적인 비교를 위해 창문 방향을 위주로 촬영한 영상 B(1080×1920px, 21초, MP4 영상)와, 영상 A를 프레임별로 캡쳐한 36장의 이미지들을 추가로 생성하여 표 4처럼 비교한 결과, 영상 B의 경우에도 창문 밖의 나무 등이 일정 거리를 두고 생성되었으며, 영상 A를 프레임마다 캡쳐한 36장의 jpg 이미지로 생성한 결과물에도 동일하게 나무와 실외의 모습이 생성되었다. 또한 비교군으로 생성한 포토그래메트리에서도 영상 A로 생성한 데이터는 외부의 모습이 메시로 생성된 것을 볼 수 있는데, 이는 이미지에서 보이는 모습을 바탕으로 3D를 생성하는 포토그래메트리와 NeRF 방식의 특성상 투명하거나 반사되는 재질을 인식하지 못하는 단점으로 지적되어 오던 현상이다. 하지만 지금 창문의 경우는 외부 환경의 나무 등 객체들의 거리감과 입체감까지 표현되어 더욱 실제적인 공간감을 구현할 수 있다. 더불어 웹상에서 메시를 바탕으로 렌더되는 포토그래메트리와 달리 3DGS의 가우시안은 색상과 투명도를 뭉뚱그리듯이 표현할 수 있기 때문에 영상 B와 영상 A의 일부 창문에서는 창문이 완전히 빈 공간이 아닌 불투명한 재질로 다소 표현됨을 확인하였다. 36장의 캡쳐한 이미지와 영상이 동일하게 생성됨에 따라 영상과 이미지의 여부는 데이터 자체의 생성에는 큰 영향을 미치지 않는 것을 볼 수 있다.

반면에 사진 세트로 생성한 데이터는 NeRF와 폴로그래메트리 모두 유리창에 그림이 붙어있는 듯한 형태로 생성되었으며 이렇게 다른 형태로 생성된 이유는 포토그래메트리를 바탕으로 한 Hou and Kim[16]의 선행연구를 참고하여 볼 때 상대적으로 사진 원본 속 창문이 좀 더 뿌옇게 촬영된 영향으로 NeRF에서도 비슷한 결과가 나올 수 있음을 유추해 볼 수 있다. 라이다로 스캔한 데이터 역시 직접적인 물체와의 거리를 센서로 계산하기 때문에 유리창에 그림이 붙어있는 듯한 형태로 생성되었다.

외부환경의 거리감과 입체감 생성을 비교하기 위하여 야외에서 촬영한 영상 C를 사용하여 루마 에이아이와 폴리캠에서 표 5처럼 3DGS를 생성하였다. 영상 C는 세로 비율인 1080×1920px 크기로 복도형식의 길을 따라 앞뒤로 이동하여 0.6배 줌으로 촬영한 영상이다. 이 데이터의 경우 촬영장소와 가까운 근경은 물론 멀리 보이는 건물들도 실제 공간의 거리와 비슷한 간격을 두고 가우시안들이 형성되었다. 다만 폴리캠에서는 하늘의 일부분이 구름처럼 조각난 형태로 생성되었으며 다른 실험데이터와 마찬가지로 영상에서 잘 보이지 않는 뒷면 방향은 밀도가 적은 산개된 형태로 구현되었다. 먼 거리의 원경까지 포함해 상대적으로 큰 크기의 전체 공간을 빠르게 생성할 수 있지만 그만큼 콘텐츠 편집 시에는 메꿔야 할 빈 공간이 많고 콘텐츠의 조명과 환경 설정에 따라 하늘 부분은 삭제해야 할 것이다. 야외 환경에서는 그만큼 고려해야 할 변수들이 많아 향후 별도의 연구가 필요하다.

이렇게 생성된 데이터들을 루마 에이아이와 폴리캠 모두 여러 가지 포맷으로 다운로드할 수 있도록 서비스를 제공하고 있다. 루마 에이아이는 하이, 미듐, 로우 폴리로 수준 별로 GLTF와 OBJ, USDZ 오브젝트를, 장면 자체로는 포인트 클라우드를 PLY로 다운받을 수 있으며, 3DGS는 언리얼 용 플러그인과 함께 3DGS 정보가 포함된 PLY 파일을 .zip 파일의 형태로, 그 외 360 파노라마 이미지를 다운받을 수 있다.

폴리캠의 경우는 메시를 OBJ, GLTF, FBX, DAE, STL, USDZ의 포맷으로, 포인트 클라우드는 Splat PLY, 일반 PLY, LAS, PTS, XYZ, DXF의 형태로, 그 외 영상과 블루 프린트, 일반 이미지를 다운받을 수 있도록 제공하고 있다.

데이터의 비교를 위해서 폴리캠에서 제공하는 포토그래메트리(https://poly.cam/tools/photogrammetry) 기능과 라이다 스캔(https://poly.cam/tools/3d-lidar-scanner) 기능을 사용하여 데이터를 생성하였다.

표 6에서 보는 것처럼 두 데이터들은 메시의 형태로 텍스쳐 맵이 적용된 모습으로 폴리캠의 웹 GL 라이브러리 상에서 확인할 수 있으며, 마찬가지로 뷰어에서 생성된 장면을 축소 확대, 회전, 시점 이동하는 것이 가능하다.

포토그래메트리를 사용해 생성한 메시도 NeRF의 데이터처럼 이미지에 보이지 않는 영역이 포함된 뒷면 시점은 메시 형태가 뭉개지거나, 텍스쳐맵 역시 크게 왜곡된 형태로 생성된 것을 확인할 수 있다.

NeRF와 포토그래메트리 방식 모두 먼저 이미지나 영상을 촬영한 후 플랫폼에 업로드해 데이터를 생성하는 방식이라면 라이다 스캔 방식은 라이다 센서가 장착된 모바일 기기에서 앱의 촬영 화면을 열고 그림 3처럼 직접 스캔이 되는 영역을 실시간으로 확인하면서 다양한 방향 별로 스캔할 수 있고 스캔이 끝나면 바로 데이터가 생성된다. 따라서 앞선 방식과 다르게 공간의 뒷면도 직접 스캔할 수 있어 비교데이터 중 가장 정확한 뒷면의 형태를 생성할 수 있었다. 폴리캠에서는 블루 프린트 이미지를 다운받을 수 있는데 라이다 스캔한 데이터에는 피트와 인치 기준으로 측정된 수치가 표시되어 있다.

4-2 생성된 데이터의 소프트웨어 처리 비교

NeRF와 3DGS는 3D로 추출한 정보를 빠르게 2D 이미지로 렌더하여 보여주는 기술들로, 앞선 데이터들은 루마 에이아이와 폴리캠 사이트의 웹 뷰어를 통해서 가우시안으로 재구성된 화면을 실시간으로 회전하며 제어하며 확인한 결과이다. 수 있다. 콘텐츠를 위해서는 별도의 카메라워크를 설정한 영상으로 추출하여 다른 영상과 합성하는 방식을 사용한다. 하지만 스캔한 3D 데이터들을 직접 편집하거나 콘텐츠 속 장면에 적용하기 위해서는 3D 모델을 3D 제작프로그램으로 가져와 편집할 수 있어야 한다. 현재의 플랫폼들은 3D 모델 데이터들을 추출하여 다운받게 제공하고 있으므로 이러한 데이터가 현재의 3D 프로그램에서 어떻게 불러와 활용할 수 있는지를 비교해 보려 한다.

표 3에서 보듯이 NeRF를 사용해 생성한 데이터들은 포토그래메트리와 라이다 스캔 데이터보다 상대적으로 적은 수치의 포인트들로 생성된 것을 확인할 수 있다. 즉 좀 더 작은 수의 이미지와 영상으로도 효율적으로 데이터를 생성할 수 있다.

본 논문에서는 3D 데이터의 편집과 가공에 기본적으로 사용되는 3D 프로그램 중 autodesk 사의 3D MAX를 기준으로 포인트클라우드, 메시, 3DGS의 형식에 따라 생성된 데이터와 관련한 편집 기능을 비교해 보았다.

포인트 클라우드 데이터는 주로 PLY나 LAS 등의 포맷이 사용된다. 3DS MAX는 2022년 버전부터 3D 스캔으로 생성한 포인트 클라우드 오브젝트를 프로그램 내에서 불러와 작업할 수 있도록 지원하고 있으며 블렌더도 포인트 클라우드 데이터를 불러올 수 있도록 지원하고 있다.

마야는 포인트 클라우드 객체를 직접 불러올 수 있도록 지원하고 있지 않지만 바이프로스트(Bifrost)와 같은 생성 시뮬레이션 효과의 일부로 제한적으로나마 포인트 클라우드 데이터를 활용하는 것이 가능하다.

4-1항목에서 생성한 데이터 중 PLY로 출력한 파일을 3DS MAX에서 열어본 결과, 표 6처럼 3DGS를 포함한 PLY 파일들은 포인트 클라우드 오브젝트로 인식되어 불러올 수 있었지만, RGB 색상 데이터는 인식하지 못하였다. 그리고 영상으로 생성한 폴리캠의 Splat Ply 파일을 제외하고는 전체 environment Dome이 포인트 클라우드로 함께 생성되어 불필요한 많은 개수의 포인트로 인식되었다.

루마 에이아이에서 생성한 일반 PLY 파일은 아무 정보가 없는 빈 객체로 불러와지는 오류가 발생했지만, 폴리캠에서 생성한 PLY 파일은 RGB 정보도 그대로 인식한 채로 포인트클라우드 객체로 불러올 수 있었다. 포인트 클라우드의 텍스쳐 정보는 포인트의 RGB 값에 담겨 있기 때문에 해당 파일을 사용하여 포인트의 편집과 렌더 결과를 비교해보기로 하였다.

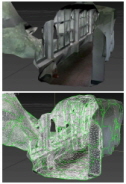

불러와진 포인트 클라우드 오브젝트의 부분을 맥스 내에서 수동 편집하는 기능은 없으며, limit box 파라미터를 사용해서 필요한 부분만큼 영역을 설정해서 크롭하는 것은 가능하였다. 맥스에서 포인트 클라우드 데이터를 불러올 때 자동으로 RCP 파일이 해당 경로에 함께 생성되었는데, 이 파일은 오토데스크의 3D 스캔 데이터 편집 프로그램인 리캡 프로(Recap Pro)의 프로젝트 파일이다. 해당 프로그램에서는 리얼리티 캡쳐와 3D 스캔 데이터로 생성한 포인트 클라우드를 가져오거나 객체를 개별 라벨링하고 포인트 클라우드와 메시로 각각 변환해 주는 기능을 포함하고 있다.

NeRF로 생성한 데이터를 리캡에서 가져올 경우 맥스에서 본 화면과 동일하게 포인트 클라우드와 RGB 정보를 인식해 가져오게 된다. 그림 4처럼 폴리캠의 LAS 파일을 불러와 프로그램의 포인트 선택과 삭제 기능을 사용해 불필요하게 생성된 포인트들을 편집할 수 있었다.

해당 프로그램에서는 오토데스크 클라우드와 플렉스코인(Flex coin)을 사용하여 포인트 클라우드를 메시로 변환하는 기능도 제공하는데, NeRF로 생성한 데이터를 변환한 결과, 그림 5처럼 RGB 데이터와 텍스쳐가 없는 폴리곤 메시 객체만으로 생성되었다.

오픈소스 프로그램인 메시랩(Meslab)에서도 폴리캠의 PLY 파일을 가져왔을 때 RGB 값을 포함하여 인식하였고, 이 프로그램에서도 포인트들을 영역으로 일부 선택하여 삭제하는 기능을 제공한다. 보통 메시랩은 포인트 클라우드의 개수를 최적화하여 줄이는 기능을 주로 사용하는데 실험의 NeRF 데이터는 밀도가 낮아 포인트의 수를 줄일 필요가 없었다.

메시랩에서도 포인트 클라우드를 메시로 변환하는 기능을 제공하지만, 마찬가지로 텍스쳐는 함께 변환되지 않는다.

NeRF로 생성하거나 포인트 클라우드에서 변환한 메시 객체는 상대적으로 단순한 형태의 객체로 생성되고 텍스쳐 맵까지 변환되지 않기 때문에, RGB 값을 가진 포인트 클라우드 데이터를 그대로 가공하는 것이 더 효율적이라 볼 수 있다.

다음으로, 필요 없는 포인트들을 정리한 포인트 클라우드를 3DS MAX로 불러와서 조명을 적용한 뒤 렌더한 결과를 확인하였다. 실험 장소는 복도라 복도 끝부분이 뭉뚱그려진 형태로 제대로 스캔 되지 않기 때문에 복도 끝부분을 스캔한 데이터를 추가로 가져와 연결하듯이 배치하였다. 포인트 클라우드의 재질을 설정하고 디스플레이 포인트와 렌더링 디테일 레벨 수치를 조절하여 포인트들의 픽셀을 좀 더 큰 크기로 복셀화시킨 후, 일반적인 3D 제작 방식으로 생성된 정수기와 물통 모델을 복도에 배치하였다. 이후 HDRI light와 quad light를 적용한 뒤 아놀드 렌더러를 통해 이미지를 그림 6처럼 렌더하였다.

그림 6에서 보듯이 각 포인트는 복셀화되어 큰 입자로 렌더되어 공간으로 구현되었고, 내부를 정리한 창틀 사이로 외부의 조명과 복도 내부의 보조 조명 등이 복도 공간과 추가한 객체에 함께 그림자와 함께 적용되었다.

이처럼 메시가 아닌 포인트 클라우드 데이터만으로 맥스와 같은 프로그램에서 생성한 데이터를 가져오고 간단한 편집과 렌더한 결과물을 확인할 수 있다.

앞선 플랫폼에서 함께 다운받은 메시 객체들은 텍스쳐 맵이 함께 생성되어 있다. 표 3에서 보듯이, 메시로 다운받은 객체는 루마 에이아이의 경우, 모든 포인트가 변환되지 않고 대부분이 삭제되어 일부 부분만 메시 오브젝트로 생성되었으며, 폴리캠의 경우 폴리 면과 버텍스 포인트들이 단순하게 뭉그러진 객체가 생성되기 때문에, 데이터와 필요한 상황에 따라서 포인트 클라우드와 병행하여 편집하거나, 포인트 클라우드 데이터를 바탕으로 세세한 부분은 수동으로 재구성하여야 한다. 라이다 스캔으로 생성한 데이터와 비교할 경우, 포토그래메트리와 너프 데이터는 실제 실측이 아닌 상대적인 크기로 생성되기 때문에 그림 7처럼 상대적으로 작은 크기로 생성된 것을 확인할 수 있다.

앞선 4-1 항목의 뷰어에서 살펴본 화면은 루마 에이아이와 폴리캠 사이트의 웹 뷰어를 통해서 3DGS를 불러와 확인한 결과들이다. NeRF와 3DGS는 3D 모델의 구성 없이 이미지로 빠르게 렌더하는 기술이므로 웹뷰어로 제공하는 것이 일반적이다. 이러한 3DGS는 새롭게 등장한지 얼마 되지 않은 형식이기에 일반적인 3D 제작프로그램에서는 데이터를 불러오거나 편집하는 기능을 아직 지원하지 않고 있다.

먼저 루마 에이아이는 언리얼에서 플러그인을 설치한 뒤 다운받은 데이터 중 Gaussian Splat 데이터를 열어서 그림 8처럼 확인할 수 있다. 언리얼에서는 내부 편집 기능 없이 영역 크롭의 형식으로 데이터 정리가 가능한데, 현재로는 3DGS의 형태를 살린 채로 작업이 가능한 유일한 콘텐츠 제작 플랫폼이다.

폴리캠의 경우는 그림 9처럼 웹 브라우저 안에서 필요한 영역을 큐브나 실린더의 형태로 포함하여 크롭 인/크롭 아웃할 수 있는 기능을 제공하고 있다. 그리고 다운 가능한 파일 중 Splat PLY 파일을 오픈소스 형태의 폴리 캔버스의 슈퍼스플랫 브라우저(https://playcanvas.com/supersplat/editor/)에서 그림 10처럼 열어서 3DGS의 형태로 확인할 수 있다. 슈퍼스플랫에서는 사각형 영역으로 위치 수정과 회전, 선택한 영역 만큼의 포인트를 크롭하거나 브러시로 불필요한 포인트들을 삭제하는 간단한 편집 기능을 제공하고 있다. 루마 에이아이의 데이터 역시 슈퍼스플랫을 사용하여 불필요한 가우시안을 삭제하는 편집이 가능하다. 편집한 데이터는 3DGS 데이터로 다시 언리얼로 불러올 수 있다.

3DGS의 강점은 가우시안을 통해 빠르게 3D 모델과 텍스쳐를 볼륨의 형태로 빠르게 형상화하여 렌더로 보여줄 수 있다는 점이다. 하지만 아직은 일부 플러그인이나 사이트에서만 포인트의 삭제 등 매우 제한된 편집만을 수행할 수 있고 포인트와 가우시안의 세부적인 편집이 불가능하며, 언리얼을 제외한 3D 제작 프로그램에서는 가우시안이 적용된 형태를 다시 구현할 수 없기 때문에, 결국 일반적인 3D 제작 공정에서 데이터를 사용하기 위해서는 모델을 다시 수동으로 재구성하는 리메시 과정이 필요하고 그에 맞춰 텍스쳐맵 편집까지 수행해야 한다. 3DS MAX나 마야, 블렌더 등 보편화된 3D 프로그램에서 3DGS의 렌더된 형태를 유지한 채로 불러와 렌더하거나 좀 더 다양한 편집이 가능하다면 더욱 본격적인 데이터의 활용이 가능해질 것이다.

Ⅴ. 결 론

본 연구는 2D 이미지를 사용하여 3D 모델을 생성하는 새로운 NeRF와 3DCG 방식의 대중적인 활용을 위해 모바일 기기로 촬영한 영상과 사진으로 3DGS와 포인트클라우드, 메시 등 다양한 형태의 결과물을 추출하였고, 이 데이터들의 생성방식과 3DS MAX를 포함한 3D 프로그램에서의 활용도를 비교분석하였다.

현재의 콘텐츠 작업 과정에서 이러한 NeRF와 3DGS 데이터를 활용하기 위해서는 플러그인 설치 후 언리얼 엔진에서 3DGS 데이터를 그대로 가져오거나, 맥스 프로그램에서 포인트 클라우드 형태로 가져와 포인트를 복셀화시켜 렌더하는 방법이 가능하다. 3DGS 데이터의 편집의 경우 슈퍼스플랫에서 가우시안 삭제가 가능하며, 포인트 클라우드는 오토데스크의 리캡 프로에서 포인트들을 삭제하고 편집할 수 있다.

메시 데이터를 생성하기 위해서는 다운받은 메시를 바로 쓰는 것보다 포인트 클라우드 데이터나 다운받은 메시를 기반으로 수동으로 새로 메시를 제작하여야 한다.

원하는 공간의 크기에 따라 복잡한 공간은 개별로 공간을 촬영하여 제작한 데이터를 합쳐서 재배치하고 전체 공간을 재구성하는 작업이 필요할 것이다.

현 논문에서는 자연광이 들어오는 실내공간을 촬영한 영상 원본을 기준으로 플랫폼 별로, 데이터 형태 별 비교가 이루어졌지만, 다양한 형태의 실내 공간, 야외 공간 등의 변수에 따라 데이터들의 처리와 효율적 데이터 생성에 대한 연구를 기대해 볼 수 있다.

앞으로 3D 스캔 관련한 기술들이 빠르게 발전하는 만큼 NeRF와 3DGS 외에도 새롭게 등장하는 다양한 형식의 3D 데이터들은 복잡한 스캔 장비와 스캔 과정 없이 영상과 이미지 만으로 쉽게 데이터를 생성할 수 있고, 빠른 렌더 결과물을 산출할 수 있어 실시간 렌더 등 3D 콘텐츠 제작의 다양한 분야에서 활용할 가능성이 많을 것으로 기대된다.

하지만 3D 제작 프로그램에서는 이러한 다양한 3D 데이터들을 편집하거나 적용하는 방법에 아직 많은 한계가 있어서, 현재는 결국 수동으로 대부분의 데이터를 다시 재구성해주어야 한다. 현재 디지털 트윈과 XR 등 현실 기반의 3D 데이터 수요가 늘고 있고, USD 등 여러 프로그램을 통합적으로 관리하는 통합플랫폼 관련한 기술이 등장하고 있는 추세이기 때문에, 3DGS 데이터의 입출력과 편집 관련은 머지않은 시기에 추가될 것으로 예상된다. 해당 분야가 현재 활발한 기술 연구가 이루어지는 만큼 향후 3D 제작 기술과 그 프로그램의 진화가 빠르게 이루어지고 있다. 실제 콘텐츠 제작 과정에서 이러한 다양한 데이터들을 직접 편집하고 제작에 활용할 수 있는 다양한 방법이나 제작 프로세스에 대한 후속 연구들이 이루어져야 할 것이다.

Acknowledgments

본 연구는 문화체육관광부 및 한국콘텐츠진흥원의 2024년도 문화체육관광 연구개발사업으로 수행되었음(과제명: Near Real 4D Nerf 기반의 VFX시스템 ‘WITH’ 개발 인력 양성, 과제번호 : RS-2024-00349479, 기여율: 100%)

References

- Gameshot. Unreal Fest 2024, Opening with Great Success [Internet]. Available: https://www.gameshot.net/common/con_view.php?code=GA66ceaefc17b5f, .

- Meta. Introducing the Digital Twin Catalog from Reality Labs Research [Internet]. Available: https://ai.meta.com/blog/digital-twin-catalog-3d-reconstruction-shopify-reality-labs-research/, .

-

Y. J. Kim, “Polygon Reduction Study of 3D Character Face Model,” The Korean Journal of Animation, Vol. 14, No. 3, pp. 138-152, September 2018.

[https://doi.org/10.51467/ASKO.2018.09.14.3.138]

-

Y. Choi, J.-B. Jeong, and E.-S. Ryu, “Efficient Conversion Method of Dynamic Point Cloud for Generating Dynamic Mesh,” Journal of Broadcast Engineering, Vol. 28, No. 5, pp. 633-645, September 2023.

[https://doi.org/10.5909/JBE.2023.28.5.633]

-

B. Mildenhall, P. P. Srinivasan, M. Tancik, J. T. Barron, R. Ramamoorthi, and R. Ng, “NeRF: Representing Scenes as Neural Radiance Fields for View Synthesis,” in Proceedings of the 16th European Conference on Computer Vision (ECCV 2020), Glasgow, UK, pp. 405-421, August 2020.

[https://doi.org/10.1007/978-3-030-58452-8_24]

- J. H. Choi and S. R. Choi, “NeRF Principles and Technology Trends,” ICROS, Vol. 28, No. 4, pp. 27-36, December 2022.

-

E. Son and Y. Kim, “Analysis of 3D Model Generation and Object Editing Techniques Using NeRF,” Journal of the Korea Institute of Information and Communication Engineering, Vol. 27, No. 8, pp. 1012-1015, August 2023.

[https://doi.org/10.6109/jkiice.2023.27.8.1012]

-

B. Kerbl, G. Kopanas, T. Leimkühler, and G. Drettakis, “3D Gaussian Splatting for Real-Time Radiance Field Rendering,” ACM Transactions on Graphics, Vol. 42, No. 4, 139, August 2023.

[https://doi.org/10.1145/3592433]

- J.-Y. Oh and C.-S. Kim, “A Study on the Usefulness of Photogrammetry through 3D Recording of the Rock-Carved Standing Buddha in Singyeong-ri, Hongseong,” MUNHWAJAE: Korean Journal of Cultural Heritage Studies, Vol. 50, No. 3, pp. 30-43, September 2017.

-

M. S. Oh, G. H. Han, S. K. Park, and Y.-H. Seo, “A Study on Analysis of Graphics Pipeline for 4D Volumetric Capturing: Focusing on Actual Production Cases,” Design Research, Vol. 6, No. 3, pp. 9-18, September 2021.

[https://doi.org/10.46248/kidrs.2021.3.9]

-

J. Kim, “A Study on the Application of Displacement Map in 3D Printing Using Photogrammetry,” Journal of Communication Design, No. 75, pp. 85-96, April 2021.

[https://doi.org/10.25111/jcd.2021.75.06]

-

S. Park, H. Chang, J. Lee, M. Pyo, S. Kwon, and S. Lee, “A Study of Character Animation Production Using 3D Scanner and Application in Broadcasting,” Asia-Pacific Journal of Multimedia Services Convergent with Art, Humanities, and Sociology, Vol. 5, No. 3, pp. 65-74, June 2015.

[https://doi.org/10.35873/ajmahs.2015.5.3.007]

-

S. Lee and W. H. Choi, “Research on Utilizing Volumetric Studio for XR Content Production,” The Journal of the Convergence on Culture Technology, Vol. 9, No. 5, pp. 849-857, September 2023.

[https://doi.org/10.17703/JCCT.2023.9.5.849]

-

H. Y. Son, H. S. Park, and H. J. Kang, “Digital Twin Color Study Based on Geo-Spatial Information 3D Modeling - Focusing on the Former Chungcheongnam-do Office in Daejeon, the Governor’s Official Residence, and the Official Residence,” Journal of Korea Society of Color Studies, Vol. 37, No. 4, pp. 27-38, November 2023.

[https://doi.org/10.17289/jkscs.37.4.202311.27]

-

J. Kim, J. W. Park, and T. Yoo, “A Study on Immersive Content Production and Storytelling Methods Using Photogrammetry and Artificial Intelligence Technology,” Journal of Broadcast Engineering, Vol. 27, No. 5, pp. 654-664, September 2022.

[https://doi.org/10.5909/JBE.2022.27.5.654]

-

Z.-D. Hou and K.-H. Kim, “Study on the Creation of Realistic 3D Models of Building Glass through the Combination of Photogrammetry and Image Editing Software,” Journal of Digital Contents Society, Vol. 22, No. 10, pp. 1551-1558, October 2021.

[https://doi.org/10.9728/dcs.2021.22.10.1551]

-

J. Yoo, T. Yoo, and S. Seo, “AI-Based 3D Spatial Structure Estimation Using Indoor Floor Point Cloud,” Journal of Digital Contents Society, Vol. 23, No. 6, pp. 1013-1020, June 2022.

[https://doi.org/10.9728/dcs.2022.23.6.1013]

-

H.-M. Yang and T.-K. You, “Metaverse Production Pipeline Based on 3D Space Capture Technology,” Journal of Digital Contents Society, Vol. 24, No. 5, pp. 1071-1082, May 2023.

[https://doi.org/10.9728/dcs.2023.24.5.1071]

저자소개

2010년:이화여자대학교 대학원 (디자인학석사)

2021년:이화여자대학교 대학원 (디자인학박사-영상디자인)

2013년~2015년: 주)그래피직스 인터렉티브 기획 대리

2016년~2017년: 고글텍 디자인 팀장

2022년~2023년: 주)라드몰 메타버스팀 팀장

2019년~현 재: 중앙대학교 시각디자인전공 강사

2023년~현 재: 백석문화대학교 웹툰애니메이션학부 겸임교수

2024년~현 재: 홍익대학교 산학협력단 연구교수

※관심분야:뉴미디어디자인, XR 등

2017년:한국예술종합학교 영상원 멀티미디어영상과 (예술학사)

2017년~2018년: 와이낫미디어

2020년~2023년: 나인컨셉 스튜디오

2023년~현 재: 홍익대학교 영상·커뮤니케이션대학원 영상디자인 석사과정

※관심분야:모션그래픽, 오프닝 타이틀 등