배 병해충 이미지 분류를 위한 딥러닝 최적 모델 선택에 관한 연구

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

농산물 수출 증가에 따라 수출국과 수입국에서 병해충 검역이 강화되고 있다. 농산물에서 병해충이 발견되면 전량이 수거되거나 폐기되므로, 수확 후 선별 과정에서 병해충을 탐지하는 것이 중요하다. 본 연구는 배의 선별 과정에서 정상 배와 병해충 배를 효과적으로 분류할 최적의 딥러닝 모델을 선택하는 것을 목표로 한다. 이를 위해 공개된 정상 배 이미지와 유사한 환경에서 배 병해충 이미지를 수집하여 데이터셋을 구축하였다. 연구에서는 CNN 계열 모델(ResNet, MobileNet, EfficientNet, ConvNext)과 Transformer 계열 모델(ViT)을 비교하고, 수집한 배 병해충 이미지 데이터셋을 사용하여 성능을 평가하였다. 또한 표준 학습 파라미터와 데이터 증강 기법을 비교 실험하였다. 평가 지표로는 정확도와 Grad-CAM을 사용하여 모델을 분석하였다. 실험 결과, ResNet101 모델이 정확도와 Grad-CAM 결과를 확인했을 때 배 병해충 분류에서 가장 우수한 성능을 보인 것을 확인하였다.

Abstract

With the increase in agricultural exports, pest and disease quarantine measures have been strengthened globally. Upon detection of pests or diseases in agricultural products, the entire shipment must be recalled or discarded. Therefore, detecting pests during the post-harvest sorting process is critical. This study aims to identify the optimal deep-learning model for classifying healthy and pest-infested pears during sorting. To achieve this, a dataset was created by collecting images of pest-infested pears under conditions similar to publicly available healthy pear images. The study compares CNN-based models (ResNet, MobileNet, EfficientNet, ConvNext) and a transformer-based model (ViT) using the dataset. Standard learning parameters and data augmentation techniques were also evaluated. Accuracy and Grad-CAM were used to analyze model performance. The results indicate that ResNet101 achieved the best performance based on accuracy and Grad-CAM.

Keywords:

Pear Pests and Diseases, Deep Learning Models, Image Classification, Quarantine, Data Augmentation키워드:

배 병해충, 딥러닝 모델, 이미지 분류, 검역, 데이터 증강Ⅰ. 서 론

중앙아시아에서 기원한 배는 크게 서양배와 동양배로 구분한다. 그림 1과 같이 서양배는 미국, 유럽 등 서구권에서 주로 재배하는데 녹색 껍질이 많고 대개 표주박 모양을 띤다. 수확 후 저온 저장한 뒤 상온에서 익히는 후숙 과정을 거쳐 먹거나, 가공용으로 사용된다. 반면 우리나라에서 재배하는 대부분의 배는 동양배로 껍질이 갈색을 띠며 모양이 동글동글하고, 성숙하면 바로 먹을 수 있다. 아삭하고 단맛이 강하며 과즙이 많다.

우리나라의 2020년도 과실류의 수출액은 총 3억6천만백만$이며, 과실류 중 수출액이 가장 높은 배의 수출량은 2012년 이후 계속해서 증가 추세를 보이고 있다[1]. 생산량에서 수출이 차지하는 비중도 2010년 7%에서 2019년 16%까지 확대되었다[2]. 배의 주요 수출 국가는 대만과 미국이며 최근에는 홍콩, 베트남 등 동남아시아로도 시장을 확대하고 있다. 하지만 배 수입 국가들이 비관세장벽인 검역을 강화하면서 현지에서 문제가 발생할 경우 정박 지연과 폐기 또는 회수 비용 등을 모두 수출자가 부담하게 되고, 최악으로는 한국산 배 전체에 대한 수입금지 조치도 발생할 수 있기 때문에 검역이 매우 중요하다. 예를 들어 대만 같은 경우에는 복숭아심식나방 분포국가의 생과실 수입 금지 입법, 2013년 배 가루깍지벌레 검출 문제화 사건 등이 있으며, 미국 같은 경우에도 국내에 상주하는 미국 검역관이 사전에 지정한 나주 등 국내 13개 수출단지에서 까다로운 절차를 거쳐 검역증을 발부받아야 대미 수출이 가능하다[3],[4].

따라서 농가에서 수확된 배를 수출단지의 선별 과정에서 배의 병해충을 정확히 판별하여 수출용 배에 검역 문제가 발생하지 않도록 하는 것이 중요하다. 기존의 수작업 선별 및 검역 방식에서는 시간과 비용이 많이 소모되며, 작업시간이 늘어날수록 배 병해충 분류 정확도가 감소하게 된다. 이에 따라, 최근에 이미지 분류에 뛰어난 성능을 보이는 딥러닝 이미지 분류 모델을 활용한 정상 배 및 병해충 배 분류를 연구하고자 한다. 이를 위해 먼저, 공개된 정상 배 이미지와 유사한 환경에서 배 병해충 이미지를 수집하여 데이터셋을 구축하고, CNN 계열의 모델인 ResNet, MobileNet, EfficientNet, ConvNext와 Transformer 계열의 모델인 ViT를 비교 분석하여, 배 병해충 이미지 분류를 위한 딥러닝 최적 모델 선택에 관한 연구를 수행한다.

본 논문의 기여는 다음과 같다.

- - 수출용 배 검역을 위한 배 병해충 이미지 데이터셋 구축

- - 구축된 배 병해충 데이터셋을 활용한 배 병해충 이미지 분류를 위한 딥러닝 모델 성능 비교

- - 수출용 배 검역에 활용될 수 있는 배 병해충 이미지 분류를 위한 딥러닝 최적 모델 제안

본 논문은 2장에서 배 병해충 이미지 분류와 관련된 연구를 살펴보고, 3장에서 제시하는 배 병해충 이미지 데이터셋 구축 및 배 병해충 이미지 딥러닝 분류 모델에 설명하고, 4장에서는 실험을 통해 배 병해충 이미지 분류를 위한 딥러닝 최적 모델을 제안한다.

Ⅱ. 관련 연구

본 논문의 수출용 배 검역을 위한 정상 배 이미지 및 배 병해충 이미지 분류를 위한 딥러닝 최적 모델 제안을 위해서 과일 분류 연구, 병해충 분류 연구 및 배 병해충 분류 연구에 대해서 관련 연구로 연구 방법과 데이터셋에 대해 논의한다.

2-1 과일 분류 연구

색감과 질감 특징을 이용한 과일 인식은 과일 인식을 위해 색상과 질감 특징을 결합한 컴퓨터 비전 방식으로 제안하였고, 자체적으로 수집한 15가지 과일 2,653장의 이미지를 사용하여 평가하였다[5]. 또한 자체적으로 초분광 영상을 수집하고 전처리하여 추출된 특징으로 심층 신경망인 VGG16 모델을 활용하여, 파프리카 잎의 생육 상태를 분류하는 기법을 제시한 연구[6]도 존재한다. EfficientNet과 MixNet을 이용한 자동화된 과일 인식은 EfficientNet과 MixNet이라는 최신 딥러닝 모델을 ImageNet 사전 학습된 가중치를 사용하여 공개데이터셋인 Fruits-360 데이터셋으로 학습하고 성능을 비교하였다[7]. 농작물 이미지 판별 모델에 대한 연구는 7개의 사전 훈련된 이미지 분류 모델을 파인튜닝(Fine-Tuning)하여 농작물 이미지와 비농작물 이미지를 구분하는 모델을 만들었으며, 데이터셋은 CIFAR100, LSUN, AI-Hub 공개데이터셋을 사용하였다[8].

2-2 병해충 분류 연구

Multi-Tasking U-net 기반 파프리카 병해충 진단은 U-net 모델을 확장한 Multi-Tasking U-net을 구현하여 파프리카 정상 잎, 응애 피해 잎, 흰가루병 피해 잎 진단을 하였으며, 자체적으로 데이터셋을 수집하였다[9]. 자동 잎 병해충 인식을 위한 이미지 프로세싱 기술 최신 동향에서는 농작물 병해충 인식을 위한 이미지 처리 기술의 최신 발전을 다룬 종합적인 리뷰 논문으로, RGB 이미지를 활용한 병해충 인식에 중점을 두고 있으며 합성곱 신경망 모델(Convolutional Neural Network)을 활용한 다양한 연구 결과를 비교하였다. 대부분은 PlantVillage 데이터셋과 같은 공개된 데이터셋을 사용하였다[10]. 딥러닝을 활용한 과일나무 병해충 인식 및 정확한 농약 살포를 위한 임베디드 드론 시스템은 과일 나무에서 발생하는 병해충을 정확하게 인식하고, 이를 기반으로 농약을 효율적으로 살포할 수 있는 시스템을 제안한다. Tiny-YOLOv3 모델을 활용하여 병해충을 실시간으로 인식하고, 이를 바탕으로 농약 살포 경로를 최적화한다. 자체적으로 인터넷과 과수원에서 700장의 해충이미지를 수집하였다[11]. 심층 CNN 기반 구조를 이용한 토마토 작물 병해충 분류 모델에서는 공개된 PlantVillage 데이터셋의 토마토 병해충 및 정상 상태의 토마토 잎 이미지를 사용해 ResNet, Xception, DenseNet의 합성곱 신경망 모델로 병해충 분류를 하였다[12]. 하이퍼스펙트럼 이미지를 기반으로 한 대추 표면 결함 탐지 시스템 개발에서는 468~950nm의 파장 범위를 갖는 하이스펙트럼 시스템을 사용하여 서포트 벡터 머신(SVM)과 인공 신경망(ANN)을 사용하여 대추 표면 결함을 분류하였다. 데이터는 대만의 과수원에서 대추 표면 결함에 대한 하이퍼스펙트럼 이미지를 자체적으로 수집하였다[13]. 지식 그래프와 딥러닝 기반 병해충 탐지 및 인식 시스템은 리치와 롱안 과일에서 발생하는 병해충을 자동으로 탐지하고 인식하는 시스템을 제안한다. 라즈베리파이를 통해 이미지를 처리하고 딥러닝 모델인 VGG16을 사용하여 병해충을 인식한다. 데이터셋은 자체 시스템을 통해 직접 수집된 데이터와 농업 전문가들이 라벨링한 고품질의 대규모 이미지 데이터셋을 사용하였다[14]. 딥러닝 기반 감귤 병해충 인식을 위한 자동 분류 서비스 시스템에서는 20,000개의 자체 수집한 고해상도 감귤 병해충 이미지를 수집하여 VGGNet과 ViT를 포함한 다섯 가지 사전학습된 딥러닝 모델을 전이학습하여 감귤 병해충 인식을 수행하였다[15]. 망고 과일 병해충 인식에 대한 비교 연구는 직접 인도네시아의 망고 농장에서 수집된 망고 과일 이미지를 가지고 VGG16, ResNet50을 포함한 5개 합성곱 신경망 모델을 가지고 망고 과일 병해충 인식을 수행하였다[16]. 개선된 ViT 방법을 기반으로 한 농작물 병해충 이미지 인식에서는 농작물 병해충 공개 데이터셋을 활용하여 Vision Transformer (ViT)를 학습하고, 병해충 인식을 수행하였다[17]. 경량 딥러닝 모델을 활용한 감귤 병해충 진단 및 최적화에서는 MobileNetV3 Small 모델을 경량화하여 감귤 병해충 진단 모델을 개발하고, 이를 모바일 및 임베디드 디바이스에서 실행할 수 있도록 하였다. 감귤 병해충 데이터는 공공 데이터셋을 기반으로 하였고 데이터 불균형 문제를 해결할 수 있는 방법을 제시하였다[15].

2-3 배 병해충 분류 연구

딥러닝의 SU-net을 이용한 배 화상병 예찰 연구에서는 직접 회전익 드론에 RGB 카메라를 장착하여 고도 10~12m에서 화상병 발생 과수의 영상을 촬영하여 데이터를 확보하고, 이를 U-net의 확장 모델인 SU-net으로 분석하였다[19]. 농업 영상 AI 데이터, 농산물 품질(QC) 이미지는 대한민국 농산물 중 시설재배 품목을 제외한 소비량이 많은 청과품목을 선정하여 크기, 형태, 색태 등을 확인 가능한 이미지 촬영을 하였고, InceptionV3를 통해 데이터셋 활용을 검증하였다[20]. 합성곱 신경망을 이용한 사과와 배의 6대 병해 인식 개선 방법에서는 사과와 배에서 발생하는 6가지 병해의 실제 현장 이미지를 K-최근접 이웃(KNN)[21]. 농작물 병증 분할을 위한 Mask R-CNN 및 Detection Transformer의 성능 비교에서는 배의 과수화상병, 검은별무늬병, 잎검은점병의 병증을 공공데이터와 자체수집한 데이터를 통해서 Mask R-CNN과 DETR 모델을 활용하여 성능을 비교하였다[22]. 가시광-근적외선 분광법을 이용한 '야리' 배의 병해충 탐지를 위한 온라인 딥러닝 모델 구축은 자체 수집된 960개의 야리 배에서 가시광-근적외선 분광법을 이용하여 샘플을 추출하고, CBAM을 이용하여 배 병해충 탐지를 수행하였다[23]. 과수화상병 이미지 수집 관리 시스템 구현에서는 사과와 배에 치명적인 영향을 미치는 과수화상병을 직접 이미지 수집, 검수, 데이터 어노테이션을 하고, 딥러닝 모델 학습에 필요한 데이터셋으로 구축할 수 있는 시스템을 구현하였다[24].

관련 연구를 조사한 결과, 수출용 배 검역을 위한 배 병해충 이미지 데이터셋을 활용한 연구는 없는 것을 확인하였고, 특히 대한민국 주요 수출 품목인 동양배에 대한 데이터셋이 부족한 것을 확인할 수 있었다. 따라서 기존에 연구된 다양한 딥러닝 모델 중 기본 모델부터 가장 최신의 모델 알고리즘을 결합한 합성곱 신경망을 배 병해충 데이터에 학습시켜 최적의 배 병해충 분류 모델을 찾고자 한다.

Ⅲ. 배 병해충 이미지 분류를 위한 딥러닝 모델

3-1 데이터셋

배 병해충 이미지 분류를 위한 딥러닝 모델 성능 비교 및 최적 모델을 제안하기 위해서 가장 중요한 점은 좋은 배 병해충 이미지 데이터셋을 구축하는 것이다.

정상 배 이미지는 공공데이터 AI-HUB의 농산물 품질(QC) 이미지를 사용하였다. 공개데이터셋에는 “추황”과 “신고” 품종의 배가 특, 상, 보통으로 라벨링되어 있으며 그림 2와 같다. “추황”배 이미지 10,584장, “신고”배 이미지 10,584장 총 21,168장의 정상 배 이미지를 확보하였다.

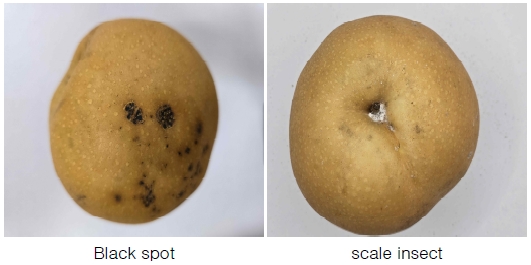

배 병해충 이미지는 그림 3과 같이 순천 선과장으로부터 선별 과정에서 비상품으로 판정받은 배 200박스를 구매하여 동양배 연구소 전문가로부터 비상품 배를 각각의 병해충별로 박스로 분류하였다.

이후 농산물 품질(QC) 공공데이터와 같은 조건을 최대한 반영하기 위하여 그림 4와 같이 촬영 환경을 구축하고 배를 정면, 측면, 상부로 촬영하고, 뒤집어서 촬영하여 총 6부분의 배를 촬영하였다. 배 병해충이 더 있다면 배의 각도를 조절하여 모든 배 병해충 이미지를 확보하도록 하였다.

촬영된 배 병해충은 그림 5와 같으며, 목표로 설정한 공공데이터 AI-HUB 농산물 품질(QC) 이미지처럼 병해충 배가 이미지의 중심에 있으며 배경이 하얀색이다.

최종적으로 수집된 배 병해충 이미지는 흑성병 1,824장, 과피얼룩 52장, 복숭아순나방 67장, 복숭아심식나방 54장, 배 깍지벌레 370장, 잎말이나방류 63장, 과피흑변 30장, 기타(배나무이, 생육장애 등) 7,866장의 총 8가지 클래스로 구성된다. 구축된 정상 배 1개 클래스와 배 병해충 8개 클래스 총 9개 클래스를 딥러닝 모델 학습 및 테스트에 활용하기 위해 9:1의 비율로 설정하였다. 표 1은 딥러닝 모델 학습 및 테스트에 활용되는 배 병해충 이미지 데이터셋의 구체적인 표이다.

3-2 배 병해충 이미지 분류를 위한 딥러닝 모델

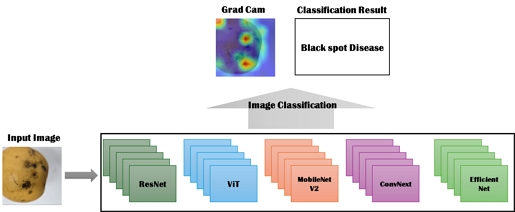

배 병해충 이미지 분류를 위한 딥러닝 모델로는 합성곱 신경망 계열의 모델과 최근 어텐션(Attention) 매커니즘으로으로 구성된 트랜스포머(Transformer) 계열의 모델이 대표적이다. 본 논문에서 사용하는 합성곱 신경망 계열의 모델로는 합성곱 신경망 모델의 기준인 숏컷(Short-Cut) 연결층을 제안한 ResNet[25]과 합성곱 신경망 모델에서 역병목 네트워크를 제안하여 경량화된 모델을 제시한 MobileNet[26], 합성곱 신경망의 입력, 모델 크기, 채널을 효과적으로 사용하여 이미지 분류 성능을 높인 EfficientNet[27], 그리고 트랜스포머가 주류가 된 상태에서 컨벌루션 필터와 합성곱 신경망을 효과적으로 사용하여 여전히 이미지 분류에서 합성곱 신경망이 좋은 성능을 보이는 것을 확인시켜준 ConvNext[28] 모델을 사용한다. 트랜스포머 계열의 모델로는 이미지를 패치로 나누어 토큰화시켜 어텐션 매커니즘을 잘 활용할 수 있도록 한 Vision Transformer(ViT)[29]를 사용한다.

모든 배 병해충 이미지 분류를 위한 딥러닝 모델에 사용되는 손실 함수(Loss functoin)는 9개의 클래스를 분류하는 다중 클래스 분류 문제에 적절한 교차-엔트로피 손실 함수(Cross-Entropy Loss)를 사용한다. 다음은 교차-엔트로피 손실 함수의 수식이다. 여기서 C는 클래스의 수, yi는 실제 정답 값, pi는 모델이 예측한 해당 클래스의 확률이다.

| (1) |

배 병해충 이미지 분류 딥러닝 모델 성능을 비교하기 위한 평가 지표로는 정확도와 Grad-CAM[30] 및 어텐션 맵(Attention Map)을 활용한다. 정확도는 이미지 분류에서 가장 기본적이고 널리 사용되는 평가지표 중 하나로 딥러닝 모델이 전체 샘플 중에서 올바르게 분류된 샘플의 비율을 계산한다. Grad-CAM은 합성곱 신경망을 사용한 이미지 분류 모델에서 중요한 특징 및 영역을 시각화하는데 사용되는 기술로 모델의 마지막 합성곱 층에 그래디언트(gradient)를 계산하여 각 그래디언트는 특징 맵(feature map) 채널별 가중치로 변환되고, 계산된 가중치를 이용해 마지막 합성곱 층의 특징맵에 가중합을 구하여 class activation map(CAM)을 생성하고, 이를 입력 이미지 위에 겹쳐서 보여준다. 트랜스포머 계열인 ViT 모델은 합성곱 층이 없기 때문에 마지막 인코더 블락에서 클래스 토큰이 입력 패치에 대해 주목하는 정도를 어텐션 맵 형태로 계산하고 이를 입력 이미지의 공간적 크기와 일치하도록 변환해서 겹쳐서 보여준다.

그림 6은 배 병해충 이미지 분류를 위한 딥러닝 모델을 딥러닝 모델별로 학습하고 테스트하는 전체 구성을 보여준다. 각각의 모델은 동일한 컴퓨팅 환경, 데이터셋, 하이퍼파라미터를 사용한다.

Ⅳ. 실험 및 결과

4-1 실험 환경

모든 딥러닝 모델 실험은 NVIDIA A100 80GB 단일 GPU에서 파이토치 프레임워크 기반으로 진행되었다. 모든 딥러닝 모델은 ImageNet 데이터셋[18]으로 사전학습된 가중치를 가지고 있는 딥러닝 모델을 사용하였다. 따라서 사전학습 가중치가 공개된 해당 딥러닝 모델은 대부분 사용하였다. ResNet은 ResNet50, ResNet101, ResNet200을, MobileNetV2는 MobileNetV2_100, MobileNetV2_140을 EfficientNet은 EfficientNet_b0부터 b4까지 사용하였다. ViT 이후부터 모델은 small, base, large로 모델 크기와 파라미터를 각각에 맞춰서 공개하는데, ConvNext는 nano, tiny, small를 사용하였고, ViT는 tiny, small, base, large를 활용하였다.

실험 모델의 하이퍼파라미터 설정은 표 2와 같이 모두 동일하게 적용하였다. 표 2에서 중요하게 볼 것은 데이터 증강 부분을 일반적인 데이터 증강 뿐만 아니라 mixup[31], cutmix[32]를 사용하였고, 그 외에 최신 딥러닝 모델 학습 메커니즘으로 label smoothing, drop path 등을 사용하였다.

4-2 실험 결과

배 병해충 이미지 분류를 위한 딥러닝 모델 성능 비교 결과는 표 3과 같다. ResNet 계열의 모델이 평균 99.49%의 가장 높은 정확도를 보여줬으며, 이어서 MobileNetV2 계열의 모델이 다음으로 평균 99.07%의 정확도를 보였다. EfficientNet 계열의 모델과 ViT계열의 모델은 평균적으로 비슷한 정확도를 보였고, Convnext계열의 모델은 가장 낮은 정확도를 보였다. 단일 배 병해충 이미지 분류 딥러닝 모델을 뽑으면 ResNet101 모델이 99.59%로 가장 높은 정확도를 보였다.

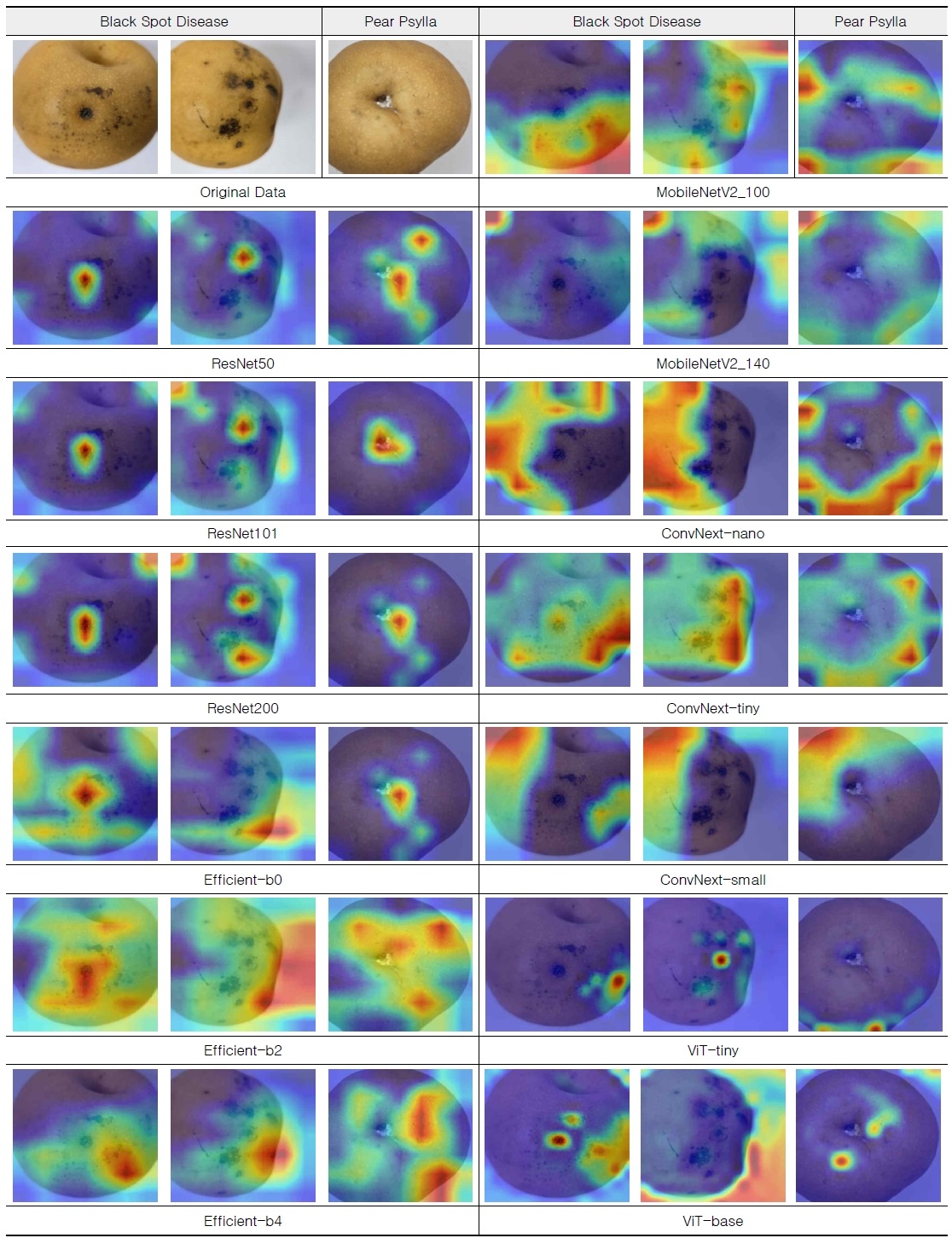

정확도와 더불어 딥러닝 모델의 의사결정 과정의 투명성과 사용자의 해석가능성을 확보하기 위해 병해충 클래스 중 상대적으로 데이터 수가 많은 흑성병 이미지 2장과 배 깍지벌레 이미지 1장를 선택하여 Grad-CAM 및 어텐션맵 결과 비교하였다. 3장에서 설명한 대로 합성곱 신경망 계열일 경우에는 Grad-CAM, 트랜스포머 계열일 경우에는 어텐션맵을 통해 배 병해충 이미지 분류 딥러닝 모델별로 입력 테스트 이미지의 어느 부분을 집중하는지 시각화하였다. 그림 7은 Grad-CAM과 어텐션 맵을 통해 흑성병 이미지 2장과 배 깍지벌레 이미지 1장에 대한 시각화 결과이다. 빨간색으로 표현될수록 더 집중하고 있는 것이고, 파란색은 집중하지 않는 것을 표현한다.

먼저 흑성병 시각화 결과를 비교해보면 가장 높은 정확도를 보인 ResNet-101 모델은 Grad-CAM 시각화결과 다른 딥러닝 모델들보다 병해충 영역이 활성화 되어있다. 반면에 2번째로 높은 정확도를 보여준 MobileNetV2_140 모델은 흑성병 또는 깍지벌레 보다는 배경에 더 집중한 시각화 결과를 보였다. 이는 높은 정확도를 보였지만 MobileNetV2_140은 다른 특징을 보고 배 병해충 이미지를 분류했다고 볼 수 있다. 따라서 이는 좋은 모델이 아니라고 할 수 있다. ConvNext와 EfficientNet은 정확도도 ResNet 계열 또는 MobileNetV2 계열보다 1% 낮았으며, Grad-CAM 결과도 배 병해충 부분을 정확히 탐지하지 못하였다.

ViT의 경우 최종 레이어를 어텐션 맵으로 시각화하여 합성곱 신경망 모델들과 시각화를 비교하였다. ViT의 경우 작은 사이즈의 모델이 더 나은 시각화 결과를 보였다. 이는 데이터셋의 규모가 크지 않아 파라미터가 큰 모델을 사용한 경우 데이터셋에 대한 과적합이 일어난 것으로 생각된다.

Ⅴ. 결 론

본 연구에서는 농가에서 수확된 배를 수출단지의 선별 과정에서 정확하게 병해충을 판별하여, 수출용 배에 검역 문제가 발생하지 않도록 하기 위한 딥러닝 모델을 활용한 배 병해충 이미지 분류 방법을 연구하였다. 기존의 수작업 선별 및 검역 방식은 시간과 비용이 많이 소모되며, 작업 시간이 늘어날수록 분류 정확도가 감소하는 문제가 있다. 이에 따라 이미지 분류에 뛰어난 성능을 보이는 딥러닝 모델을 활용한 정상 배와 병해충 배 총 9종의 분류를 목표로 하였다.

공개된 정상 배 이미지와 유사한 환경에서 배 병해충 이미지를 수집하여 데이터셋을 구축한 후, 합성곱 신경망 계열 모델인 ResNet, MobileNet, EfficientNet, ConvNext와 Transformer 계열 모델인 ViT를 비교 분석하였다. 실험 결과, ResNet 계열의 모델이 가장 높은 정확도를 보였으며, MobileNetV2 계열이 그 뒤를 이었다. EfficientNet과 ViT 계열은 평균적으로 비슷한 정확도를 보였고, ConvNext 계열은 가장 낮은 정확도를 기록하였다. 그 중 단일 정확도가 가장 높은 모델은 ResNet101로 99.59%의 높은 정확도를 보였다. 또한, Grad-CAM과 어텐션 맵을 활용하여 각 딥러닝 모델이 배 병해충 이미지 분류 시 어느 부분에 집중하는지 시각화하였다. 그 결과, ResNet 계열 모델은 흑성병 및 깍지벌레 이미지에서 다른 모델들보다 더 정확하게 병해충을 집중하여 탐지하였고, MobileNetV2_140 모델은 배경에 더 집중하는 경향을 보였다. ConvNext와 EfficientNet은 상대적으로 낮은 정확도와 함께 병해충을 정확히 탐지하지 못한 결과를 보였다. ViT 모델은 작은 사이즈의 모델이 더 나은 시각화 결과를 보였으며, 이는 데이터셋의 규모가 작아 과적합이 발생한 것으로 추측된다.

따라서, 본 연구에서는 ResNet101 모델이 배 병해충 이미지 분류에 가장 우수한 성능을 보였음을 확인하였다. 향후 수출용 배 선별 과정에서 배 병해충 자동 선별 시스템에 적용 가능한 최적의 모델로 활용될 것이다.

Acknowledgments

이 논문은 과학기술정보통신부와 정보통신산업진흥원으로부터 ‘2024년 지역디지털기초체력지원(전남_SW서비스)(S-2001-24-1008)’과 2023년도 정부(교육부)의 재원으로 한국연구재단의 지원을 받아 수행된 기초연구사업(No. RS-2023-00 274651) 및 과학기술정보통신부·광주광역시가 공동 지원한 '인공지능 중심 산업융합 집적단지 조성사업'으로 지원을 받아 수행된 연구 결과입니다.

References

-

K. S. Shim and K. H. Kang, “The Study of Management Improvement and Export-Vitalization of Agricultural products export producer -Focusing on Pear Export Farmhouse-,” The e-Business Studies, Vol. 22, No. 5, pp. 169-181, October 2021.

[https://doi.org/10.20462/TeBS.2021.10.22.5.169]

-

J.-I. Kang, S.-H. Kim, and H.-P. Moon, “Analysis of Determinants of Export of Six Major Fruit,” Korean Journal of Food Marketing Economics, Vol. 39, No. 1, pp. 47-62, March 2022.

[https://doi.org/10.47085/KJFME.39.1.3]

- S.-H. Lee and W.-S.Kim, Strategies to Promote Pear Exports, Korea Rural Economic Institute, Seoul, E04-2015, pp. 315-339, February 2015.

- KBS News. Easing of Pear Export Quarantine Raises Concerns among Farmers [Internet]. Available: https://news.kbs.co.kr/news/pc/view/view.do?ncd=8036319, .

- S. Arivazhagan, R. N. Shebiah, S. S. Nidhyanandhan, and L. Ganesan, “Fruit Recognition Using Color and Texture Features,” Journal of Emerging Trends in Computing and Information Sciences, Vol. 1, No. 2, pp. 90-94, October 2010.

-

K-.I. Choi, H.-M. Noh, S.-H. Jeong, and C.-J. Yoo, “Classification of Growth Conditions in Crops Using Hyperspectral Images and Deep Neural Network: Case Study of Paprika Leaf,” Journal of Korean Institute of Information Technology, Vol. 17, No. 12, pp. 1-12, December 2019.

[https://doi.org/10.14801/jkiit.2019.17.12.1]

-

L. T. Duong, P. T. Nguyen, C. Di Sipio, and D. Di Ruscio, “Automated Fruit Recognition Using EfficientNet and MixNet,” Computers and Electronics in Agriculture, Vol. 171, 105326, April 2020.

[https://doi.org/10.1016/j.compag.2020.105326]

- R. Zheng, H. Yin, Y. H. Gu, and S. J. Yoo, “A Study on the Crop Image Discrimination Model,” in Proceedings of 2021 Autumn Conference of IEIE, Incheon, pp. 753-756, November 2021.

- S. J. Kim and H. S. Kim, “Multi-Tasking U-net Based Paprika Disease Diagnosis,” Smart Media Journal, Vol. 9, No. 1, pp. 16-22, March 2020.

-

L. C. Ngugi, M. Abelwahab, and M. Abo-Zahhad, “Recent Advances in Image Processing Techniques for Automated Leaf Pest and Disease Recognition - A Review,” Information Processing in Agriculture, Vol. 8, No. 1, pp. 27-51, March 2021.

[https://doi.org/10.1016/j.inpa.2020.04.004]

-

C.-J. Chen, Y.-Y. Huang, Y.-S. Li, Y.-C. Chen, C.-Y. Chang, and Y.-M. Huang, “Identification of Fruit Tree Pests with Deep Learning on Embedded Drone to Achieve Accurate Pesticide Spraying,” IEEE Access, Vol. 9, pp. 21986-21997, February 2021.

[https://doi.org/10.1109/ACCESS.2021.3056082]

-

S.-K. Kim and J.-G. Ahn, “Tomato Crop Diseases Classification Models Using Deep CNN-based Architectures,” Journal of the Korea Academia-Industrial Cooperation Society, Vol. 22, No. 5, pp. 7-14, May 2021.

[https://doi.org/10.5762/KAIS.2021.22.5.7]

-

Q. T. Pham and N.-S. Liou, “The Development of On-Line Surface Defect Detection System for Jujubes Based on Hyperspectral Images,” Computers and Electronics in Agriculture, Vol. 194, 106743, March 2022.

[https://doi.org/10.1016/j.compag.2022.106743]

-

D. J. Zhu, L. Z. Xie, B. X. Chen, J. B. Tan, R. F. Deng, Y. Zheng, ... and W. H. I. Andrew, “Knowledge Graph and Deep Learning Based Pest Detection and Identification System for Fruit Quality,” Internet of Things, Vol. 21, 100649, April 2023.

[https://doi.org/10.1016/j.iot.2022.100649]

-

H. Jeong, S.-W. Park, and C.-B. Sim, “Diagnosis and Optimization of Citrus Pests Using a Lightweight Deep Learning Model,” Journal of Korea Multimedia Society, Vol. 27, No. 3, pp. 464-472, March 2024.

[https://doi.org/10.9717/kmms.2024.27.3.464]

-

K. Kusrini, A. Setyanto, I. M. A. Agastya, H. Priantoro, and S. Pariyasto, “A Comparative Study of Mango Fruit Pest and Disease Recognition,” TELKOMNIKA (Telecommunication Computing Electronics and Control), Vol. 20, No. 6, pp. 1264-1275, December 2022.

[https://doi.org/10.12928/telkomnika.v20i6.21783]

-

X. Fu, Q. Ma, F. Yang, C. Zhang, X. Zhao, F. Chang, and L. Han, “Crop Pest Image Recognition Based on the Improved ViT Method,” Information Processing in Agriculture, Vol. 11, No. 2, pp. 249-259, June 2024.

[https://doi.org/10.1016/j.inpa.2023.02.007]

-

J. Deng, W. Dong, R. Socher, L.-J. Li, K. Li, and F.-F. Li, “Imagenet: A Large-Scale Hierarchical Image Database,” in Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition, Miami: FL, pp. 248-255, June 2009.

[https://doi.org/10.1109/CVPR.2009.5206848]

- H. J. Kim, H. K. Noh, and T. H. Kang, “Study on Fire Blight Forecasting Using Separable SU-Net of Deep Learning,” in Proceedings of the KSAM & ARCs 2020 Autumn Conference, Online, p. 228, October 2020.

- Y.-W. Cho, “Agricultural Image AI Data: Agricultural Product Quality (QC) Images,” Magazine of the Korean Society of Agricultural Engineers, Vol. 63, No. 3, pp. 17-25, August 2021.

-

Y. H. Gu, H. Yin, D. Jin, R. Zheng, and S. J. Yoo, “Improved Multi-Plant Disease Recognition Method Using Deep Convolutional Neural Networks in Six Diseases of Apples and Pears,” Agriculture, Vol. 12, No. 2, 300, February 2022.

[https://doi.org/10.3390/agriculture12020300]

- D. Jin, H. Yin, R. Zheng, J. Lee, Y. Gu, and S. Yoo, “Performance Comparison of Mask R-CNN and Detection Transfomer for the Crop Disease Segmentation,” in Proceedings of 2022 The Korean Institute of Next Generation Computing (KINC) Spring Conference, Jeju, pp. 211-215, May 2022.

-

Y. Hao, C. Zhang, X. Li, and Z. Lei, “Establishment of Online Deep Learning Model for Insect-Affected Pests in “Yali” Pears Based on Visible-Near-Infrared Spectroscopy,” Frontiers in Nutrition, Vol. 9, 1026730, October 2022.

[https://doi.org/10.3389/fnut.2022.1026730]

- R. Zheng, J. M. Lee, D. Jin, H. Yin, S. J. Yoo, and Y. H. Gu, “Implementation of Fire Blight Image Collection and Management System,” in Proceedings of 2023 Summer Annual Conference of IEIE, Jeju, pp. 2122-2126, June 2023.

- M. Tan and Q. Le, “EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks,” in Proceedings of the 36th International Conference on Machine Learning (ICML 2019), Long Beach: CA, pp. 6105-6114, June 2019.

-

K. He, X. Zhang, S. Ren, and J. Sun, “Deep Residual Learning for Image Recognition,” in Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Las Vegas: NV, pp. 770-778, June 2016.

[https://doi.org/10.1109/CVPR.2016.90]

-

A. Dosovitskiy, L. Beyer, A. Kolesnikov, D. Weissenborn, X. Zhai, T. Unterthiner, ... and N. Houlsby, “An Image Is Worth 16x16 Words: Transformers for Image Recognition at Scale,” arXiv:2010.11929v2, , June 2021.

[https://doi.org/10.48550/arXiv.2010.11929]

-

Z. Liu, H. Mao, C.-Y. Wu, C. Feichtenhofer, T. Darrell, and S. Xie, “A ConvNet for the 2020s,” in Proceedings 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans: LA, pp. 11966-11976, June 2022.

[https://doi.org/10.1109/CVPR52688.2022.01167]

-

M. Sandler, A. Howard, M. Zhu, A. Zhmoginov, and L.-C. Chen, “MobileNetV2: Inverted Residuals and Linear Bottlenecks,” in Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City: UT, pp. 4510-4520, June 2018.

[https://doi.org/10.1109/CVPR.2018.00474]

- L. Carratino, M. Cissé, R. Jenatton, and J.-P. Vert, “On Mixup Regularization,” Journal of Machine Learning Research, Vol. 23, pp. 1-31, 2022.

-

S. Yun, D. Han, S. Chun, S. J. Oh, Y. Yoo, and J. Choe, “CutMix: Regularization Strategy to Train Strong Classifiers with Localizable Features,” in Proceedings of 2019 IEEE/CVF International Conference on Computer Vision (ICCV), Seoul, pp. 6022-6031, October-November 2019.

[https://doi.org/10.1109/ICCV.2019.00612]

저자소개

2022년:전남대학교 (공학학사)

2017년~2022년: 전남대학교 전자컴퓨터공학부 공학학사

2022년~현 재: 전남대학교 지능전자컴퓨터공학과 석사과정

※관심분야:인공지능, 비전 트랜스포머, 지도학습

2020년:호치민시티 과학대학교 (이학학사)

2023년:전남대학교 (공학석사)

2015년~2020년: 호치민시티 과학대학교 수학과 이학 학사

2021년~2023년: 전남대학교 ICT융합시스템공학과 석사과정

2023년~현 재: 전남대학교 지능전자컴퓨터공학과 박사과정

※관심분야:시계열 데이터 분석, 머신러닝, 딥러닝

1986년:서울대학교 (공학학사)

1988년:서울대학교 대학원 (공학석사)

1994년:서울대학교 대학원 (공학박사-전자공학)

1982년~1986년: 서울대학교 전자공학과 공학학사

1986년~1988년: 서울대학교 전자공학과 공학석사

1988년~1994년: 서울대학교 전자공학과 공학박사

1995년~현 재: 전남대학교 전자컴퓨터공학과 교수

※관심분야:디지털 신호처리, 영상 처리, 음성 신호처리, 머신러닝, 딥러닝

2018년:호치민시티 과학대학교 (이학학사)

2024년:전남대학교 (공학박사)

2016년~2018년: 호치민시티 과학대학교 수학 및 컴퓨터과학 학사

2018년~2024년: 전남대학교 ICT융합시스템공학과 공학박사

2024년~현 재: ㈜에이아이시드 책임연구원

※관심분야:자연어 처리, 영상 처리, 머신러닝, 딥러닝

2018년:전남대학교 대학원 (공학석사)

2023년:전남대학교 대학원 (공학박사-전자공학)

2016년~2018년: 전남대학교 전자공학과 공학석사

2018년~2023년: 전남대학교 전자공학과 공학박사

2023년~현 재: 전남대학교산학협력단 박사후연구원

※관심분야:디지털 신호처리, 영상 처리, 머신러닝, 딥러닝