현실기반 가상 장면 합성 응용에 관한 연구

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

본 연구는 현실 장면의 관계 및 배치 구조를 기반으로 다양한 구조의 가상 장면을 생성하기 위한 응용 방법을 제안한다. 제안하는 방법은 현실 공간의 기하학적 분석과 의미론적 해석으로 구성된 장면 합성 프레임워크를 사용하여 현실 공간에 대한 정확한 분석 과정을 수행한다. 그리고 현실 공간과 동기화된 가상 장면을 생성하고 다양한 가상 장면 합성을 위한 객체와 객체, 객체와 레이아웃간의 관계 분석을 수행한다. 그리고 동기화된 가상 샘플 장면으로부터 동적계획법을 통한 객체 배치 과정을 수행함으로써 다양한 실내 장면 합성결과를 생성한다. 이를 기반으로, 일반적인 실내 공간인 침실, 공구 작업 공간인 크리에이티브 스튜디오 현실 공간을 기반으로 다양한 가상 장면 합성결과를 생성한다. 가상 장면 합성 응용을 위한 장면 합성 프레임워크와 객체 배치 과정에서의 성능을 평가하고, 합성결과를 토대로 전문가 의견을 수렴하였다. 이러한 과정을 통하여, 제안하는 방법의 응용 및 활용 가능성을 검증하였다.

Abstract

This paper proposes a method for generating virtual scenes with various structures based on the relationship and arrangement structure of real scenes. The proposed method performs an accurate analysis process on a real space by using a scene synthesis framework consisting of geometric analysis and semantic interpretation of real space. Then, it generates a virtual scene synchronized with real space and performs relationship analysis between objects and objects and between objects and layouts to synthesize various virtual scenes. In addition, it generates various indoor scene synthesis results by performing the object arrangement through dynamic programming from synchronized virtual sample scenes. Based on this, various virtual scene synthesis results are generated based on a bedroom, a typical indoor space, and a creative studio, a tool workspace, in real space. The performance of the scene synthesis framework and object arrangement for the virtual scene synthesis application were evaluated, and expert opinions were collected based on the synthesis results. Through this process, the application and usability of the proposed method were verified.

Keywords:

Scene Synthesis, Virtual Scene, Object Arrangement, Dynamic Programming, Mixed Reality키워드:

장면 합성, 가상 장면, 객체 배치, 동적 계획법, 혼합현실Ⅰ. 서 론

현실 세계의 디지털화는 컴퓨터 그래픽스 기술의 발전과 더불어 가상현실, 혼합현실 등을 아우르는 확장현실 기술에 관한 관심이 높아지면서 빠른 속도로 진행되고 있다. 도시, 풍경 등 실외 환경은 물론 박물관, 전시장, 복합 문화 공간 등과 같은 실내 환경까지 디지털화가 다양하게 이루어지는 상황이다. 이는 접근성 또는 경제적 문제 등의 제약으로 인하여 현실 세계에서 직접 방문하기 어려운 상황에서 필요성이 증가하고 있다. 이러한 이유로 인하여 디지털 트윈을 기반으로 현실 세계와 가상 공간을 함께 탐색할 수 있는 기술과 현실과 동기화된 가상 장면을 표현하는 방법들이 연구되기도 한다.

가상 장면 생성은 실제로 존재하지 않는 환경을 생성하거나 실제를 기반으로 조작 또는 변형된 장면을 제작하는 과정으로 영화나 게임과 같은 엔터테인먼트 분야, 교육을 포함한 미디어 분야는 물론 건축, 제작 등 다양한 산업 분야에서 현실과 유사한 가상 장면을 통해 시각적인 몰입과 집중을 높이는 핵심 기술이다. 실내외 장면의 구조와 패턴, 재질 등을 다루는 장면 합성 연구는 규칙 기반 방법과 절차적 생성을 기반으로 장면 생성에 관한 구조화된 접근 방식을 제공하였다. 도시와 같은 정형화된 구조를 가지는 실외 장면이나 풍경과 같이 식물로 구성된 장면 등 복잡하거나 독특한 특징을 지닌 실외 장면을 생성하기 위한 절차적 기법이 연구되었다[1]-[3]. 실내 장면은 장면을 구성하는 가구, 구조물 등을 자동으로 배치하는 과정에서 장면의 구성, 동선, 관계 등을 비용함수로 정의하고 확률적 메타 알고리즘 또는 최적해 알고리즘 등을 활용한 전역 최적화 기법 등을 연구하였다[4]-[6]. 최근에는 딥러닝을 활용한 학습 기법으로 autoregressive transformer[7], MCTS (Monte Carlo tree search) based dueling double deep Q-Network[8], 그리고 generative recursive auto-encoders[9] 등이 연구되었다. 하지만, 장면 생성 및 장면 합성에 관한 연구들은 주어진 상황 또는 가상으로 표현되는 새로운 장면 생성에 초점을 맞추고 있을 뿐 현실 세계의 디지털화 개념에서 현실을 기반으로 하는 가상 장면 생성은 고려하지 않는다는 연구 목표의 차이가 존재한다. 현실 세계의 물리적 공간을 실시간으로 감지하고 이를 기반으로 현실 세계 사용자가 보행 가능한 영역에 맞춰서 가상 공간을 표현하는 연구[10]가 진행되기도 하였다. 하지만, 가상현실 사용자가 효과적이고 정확한 행동, 상호작용을 위해 필요한 현실 정보만을 고려할 뿐 현실을 기반으로 가상 장면을 구성하는 객체, 유형, 관계 등을 정교하게 동기화하고 있지 않다.

본 연구는 현실을 기반으로 하는 가상 장면 생성에 관한 응용하는 새로운 방법을 제안함을 목표로 한다. 현실기반 가상 장면 생성은 주어진 현실 공간과 구조, 배치, 관계 등이 정확하게 동기화된 가상 장면을 생성하는 것으로, 규칙, 문법, 알고리즘을 통해 가상의 그래픽 장면 생성만을 고려하는 방법과는 차이가 있다. 따라서, 제안하는 방법은 우선 현실 세계를 정교하게 분석하여 현실 공간의 3차원 기하학적 정보와 공간을 구성하는 객체의 특징과 유형을 분석한다. 그리고 이를 기반으로 현실과 정확하게 동기화되는 가상 장면을 생성한다. 다음으로, 생성된 가상 장면의 응용을 위한 새로운 방법으로 동적 계획법을 활용한 객체 재배치 구조를 통해 인테리어, 홈스타일링 등과 같은 실내 건축 디자인의 한 분야로의 응용 방향을 제시한다. 마지막으로, 현실기반 가상 장면 합성까지의 시간을 측정하고 생성 결과를 토대로 전문가 의견을 반영함으로써 제안하는 방법의 활용성과 성능을 검증한다.

Ⅱ. 관련연구

가상환경에서 주어진 상황을 이해하고 연출에 부합하는 분위기나 배경을 경험하는데 필요한 중요한 요소로서 장면 생성에 관한 연구 및 방법은 핵심 기술 중 하나이다. 이와 관련하여, 절차적 모델링[3], 문법(grammar)[11] 또는 이미지 기반 방법[12] 등 도시, 건축, 조경 등 다양한 실외 공간 및 장면을 자동으로 생성하는 연구들이 진행되었다. Kim et al.[13]은 다수의 나무로 구성된 실외 지형을 자동으로 생성하기 위한 수학적 기법을 기반으로 한 새로운 방법을 제안하였다. 또한, 미로 생성 알고리즘을 활용하여 독특한 구조의 미로 지형장면을 생성하는 연구도 이루어지고 있다[14].

실내 가상 장면과 달리 실내 장면은 레이아웃, 객체의 배치 및 관계 등을 고려하여 장면의 전체적인 구조를 결정하는 방법을 연구하기도 한다. 실외 장면과 다르게 실내는 기존에 존재하지 않은 새로운 객체(건물, 식물 등)를 생성하는 것이 아닌 기존에 존재하는 객체의 구조나 배치를 고려하기 때문에 장면 합성이라는 용어를 주로 사용한다. 이와 관련하여, Yu et al.[4]은 객체와 객체 사이의 관계, 레이아웃과의 배치 구조 등을 비용함수로 정의하고, 마코프 체인 몬테카를로(Markov chain Monte Carlo, MCMC) 기반의 메트로폴리스-해스팅스(Metropolis-Hastings) 샘플링 기법의 최적해 알고리즘을 통해 자연스러운 장면 합성결과를 생성하는 연구를 진행하였다. 또한, 유전 알고리즘(genetic algorithm)을 활용하여 실내 가상 장면을 구성하는 가구 객체를 자동으로 배치하고, 미적, 인체공학적, 기능적 규칙을 인테리어 디자인 가이드라인에 따라 비용함수로 정의하여 최적화하는 시스템을 제안하였다[6]. 더 나아가, 실내 장면에서의 가구 배치 속도를 향상하면서 동시에 미적 규칙을 유지하는 방법으로 탐욕적 비용 최소화 방법을 연구하기도 하였다[5]. 실내 장면 합성과 관련하여 최근 연구들은 기계학습 기반의 응용 연구들로 발전되고 있다. 순방향 신경망(Feed-Forward Neural Network) 등과 같은 인공신경망 모델 및 생성적 적대 신경망(Generative Adversarial Network, GAN), 변이형 오토 인코더(Variational Auto-Encoder, VAE) 등 생성형 모델을 통해 실제와 같은 장면 합성 생성에 딥러닝 응용 기법 등이 활용되고 있다[15],[16]. 이와 관련하여, Paschalidou et al.[7]은 방의 유형과 평면도를 주면 자연스러운 실내 장면 합성결과를 생성하는 새로운 autoregressive transformers인 ATISS를 제안하였다. 또한, Sun et al.[8]은 실내 장면을 탐색하는 인간의 행동에 관점에서 활동을 수행하기에 충분한 공간적 확보를 고려하는 방법으로 강화학습을 통한 인간 인식 실내 장면 최적화 방법을 연구하였다. 이외에도, non-autoregressive transformer를 통해 주어진 실내 장면 레이아웃에서 효율적 객체 분포를 정의하고, 세분화한 최적화 과정을 통해 개체를 최적의 위치로 조정하는 방법을 제안하기도 하였다[17]. 하지만, 실내외 장면 생성 및 합성에 관한 연구는 생성된 장면 결과에 집중하고 있어 응용의 측면에서의 연구는 다소 부족한 상황이다.

실내 장면 합성과 관련된 대부분의 연구는 가상의 구조, 객체, 배치 등을 고려하여 생성된 완전한 가상 장면이기 때문에 현실과의 연결성이 없다. 이와 다르게, 현실 세계의 물리적 공간 정보를 탐색하여 현실에 기반을 둔 가상 장면을 생성하는 연구들도 진행되었다. 가상현실 사용자가 보이지 않는 물리적 공간을 걸을 수 있도록 현실 공간의 걷기 가능한 공간에 대한 물리적 장애물을 감지하고, 이를 미리 가상 구조물로 표현하는 VRoamer를 제시하였다[10]. 또한, 3차원으로 실내 장면을 캡처하고 역시 걸을 수 있는 영역을 매핑하여 생성된 가상환경에서 보행이 가능한 가상 공간을 절차적으로 생성하는 Oasis를 제안하기도 하였다[18]. 현실 세계의 물리적 공간 정보를 기반으로 하는 연구들은 주로 가상현실에 참여하는 사용자가 체험하는 현실 공간에서 물리적 충돌, 위험을 줄여 안전하면서 몰입감 높은 경험을 제공하는 것이 중요한 목적이다. 즉, 현실 세계의 장면보다는 생성된 가상 공간, 장면이 중요하며 가상 장면의 질적 표현 향상 또는 응용, 활용보다는 현실 공간의 물리적 장애물 등을 감지하여 대응시키는 쪽에 초점이 맞추어져 있다.

현실에 기반하여 생성되는 가상 장면의 응용 관점에서 현실을 기반으로 하는 증강현실과 가상 장면으로 표현되는 가상현실을 결합하면서 현장 사용자와 원격 사용자가 비대칭 협업 가상환경을 통해 물리적 공간과 디지털 트윈을 동시에 탐색할 수 있는 방향을 제시하기도 하였다[19]. 본 연구는 새로운 관점에서 현실을 기반으로 동기화되어 생성된 가상 장면 합성결과를 응용하는 방향을 제시하고자 한다. 이를 위해, 현실을 기반으로 가상 장면을 생성하는 장면 합성 프레임워크를 기반으로 동적 계획법을 통해 다양한 객체 배치, 구조를 자동화하는 방법을 통해 인테리어, 홈스타일링 등의 방향을 새롭게 모색하고자 한다.

Ⅲ. 현실 공간 분석

본 연구는 실내 공간 디자인으로의 응용 관점에서 현실기반 가상 장면 합성 방법을 활용함을 목적으로 한다. 현실을 기반으로 생성된 가상 장면과 이를 토대로 공간을 구성하는 객체의 구조, 배치를 자동으로 다양화하여 사용자에게 제시함으로써 인테리어, 홈 스타일링 등 응용 가능성을 확인하고자 한다. 이를 위해 우선, 현실 공간에 대한 정확한 분석을 수행한다. 이는 Na and Kim[20]이 제안한 장면 합성 프레임워크를 활용한다. 장면 합성 프레임워크에서 현실 공간 분석을 위한 기기로 마이크로소프트 홀로렌즈 2를 사용하며, 개발도구는 Scene Understanding SDK와 Azure AI Custom Vision을 활용한다.

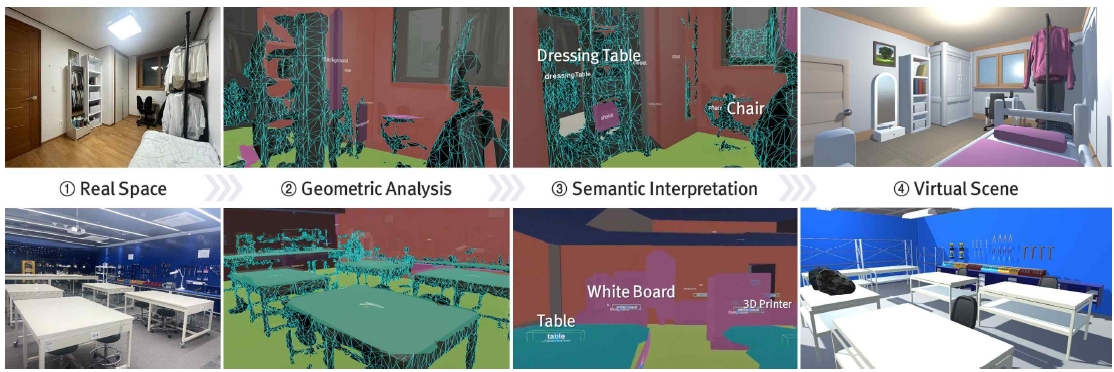

장면 합성 프레임워크의 현실 공간 분석 과정은 크게 두 가지로 구분된다. 첫 번째 과정은 기하학적 분석이다. 현실 공간에 대한 3차원 모델 (메쉬) 정보를 분석하는 과정으로 Scene Understanding SDK를 통해 현실 공간에 대한 기하학적 정보를 탐색한다. 현실 공간에 매핑된 메시를 포함하여 벽, 바닥 등으로 구분되는 객체가 색으로 구분되어 3차원 구조로 분류 및 표현된다.

다음으로 객체의 의미론적 해석이다. 기하학적 분석 과정은 현실 공간의 3차원 기하 정보를 분석하는 과정일 뿐 장면을 구성하는 객체의 종류, 유형까지는 알 수 없다. 따라서, 기하학적 분석만으로는 가상 장면을 정확히 동기화하기 어렵다. 이러한 이유로, 장면을 구성하는 객체가 무엇인지 정확히 판단하는 과정이 필요하다. 장면 합성 프레임워크는 Azure AI Custom Vision을 통해 현실 공간을 구성하는 객체를 인식 및 분류하는 과정을 제공한다. 본 연구는 현실 공간으로서 일반적인 공간으로 침실을 독특한 공간으로 공구 작업 공간인 크리에이티브 스튜디오를 설정한다. 각 공간을 구성하는 객체를 인식 및 분류하기 위하여 사전에 핵심 객체를 카테고리별로 구분하는 과정이 필요하다. 표 1은 본 연구에서 활용한 두 공간을 구성하는 객체 카테고리를 정리한 것이다.

그리고 각 객체를 인식하기 위한 커스텀 비전 학습 데이터를 구축하여 마이크로스프트 홀로렌즈 2 기기를 통해 촬영된 현실 공간의 이미지를 입력 데이터로 하여 객체 추론 결과를 전송받게 된다. 그리고 기하학적 분석을 통해 정리된 3차원 메시에 추론된 객체 유형을 대응시킴으로써 현실 공간을 구성하는 객체의 3차원 정보와 유형 (종류) 정보를 추출한다. 마지막으로 추출된 정보를 토대로 가상 장면을 생성한다.

이때 작업 대부분은 자동으로 수행하지만, 현실과 가상의 동기화 정확도 향상을 위하여 레이아웃, 객체 변환 정보의 미세 조정 등은 수작업으로 진행하는 과정을 거치게 된다. 그림 1은 장면 합성 프레임워크를 통해 기하학적 분석과 의미론적 해석 과정을 거쳐 현실 공간 분석에서 가상 장면 생성까지의 과정을 나타낸 것이다.

Ⅳ. 가상 장면 합성

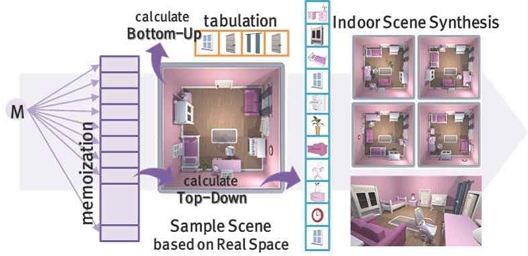

다음은 분석된 현실 공간의 3차원 기하 정보와 분류된 객체 유형을 고려하여 현실과 동기화된 가상 장면을 생성하고, 이를 기반으로 다양한 장면 합성결과를 생성하는 과정이다. 본 연구는 Cho and Kim[21]의 동적계획법 기반의 실내 장면 합성 방법을 토대로 다양한 가상 장면 연출을 위한 객체 배치 과정을 구현한다. 동적계획법은 복잡한 문제를 작은 하위 문제로 나누어 해결하는 알고리즘 설계 기법이다. 따라서, 장면을 구성하는 객체 각각의 위치, 방향을 결정하는 문제를 하향식(Top-Down)과 상향식(Bottom-Up) 구조로 나누어 정의한다.

하향식 방법은 전체 장면을 구성하는 객체에 대한 구조, 정보를 토대로 객체를 각각 해석하는 문제 해결 구조이다. 현실 공간 분석을 통해 동기화된 장면으로부터 객체와 레이아웃과의 관계를 나타내는 사전 관계(prior relationship)와 계층 관계를 갖는 객체들(예, 책상과 의자 등) 사이의 쌍별 관계(pairwise relationship)가 하향식 방법의 대표적 속성이다. 상향식 방법은 작은 하위 문제들로부터 시작하여 점진적으로 큰 문제의 해를 구하는 방식이다. 따라서 객체 단위의 작은 하위 문제들로 해석이 필요한 속성인 객체와 객체 사이의 충돌 여부를 판단하는 접근성(accessibility)이 여기에 해당한다. 하향식 방법의 사전 관계와 쌍별 관계 그리고 상향식 방법의 접근성에 관한 판단은 Yu et al.[4]의 비용함수를 기반으로 Cho and Kim[21]이 재정의한 수식을 통해 수행한다. 식 (1)은 하향식 비용함수 (,)와 상향식 비용함수 ()를 정리한 것이다. 여기서, 는 사전 관계, 계층 관계, 그리고 접근성에 관한 각각의 비용 값()에 대한 가중치로 0.01에서 0.1 사이의 값으로 설정한다.

| (1) |

객체의 현재 상태를 판단하는 비용함수를 토대로 장면 합성을 위한 객체 배치는 선택, 탐색, 수렴 그리고 행동으로 구성된 4단계 과정을 통해 진행된다. 동적계획법을 활용한 객체 배치는 기존의 확률적 최적해 기법과 달리 장면을 구성하는 전체 객체를 한 번에 연산하는 방식이 아닌 객체별로 하나씩 배치를 진행하는 구조이다. 따라서, 객체 배치 순서가 장면 합성결과를 생성하기까지의 성능(배치 시간) 또는 정확도(자연스러움)에 영향을 미칠 수 있다. 이를 위해 첫 번째 선택 과정은 중요도를 고려하여 정의한다. 중요도의 우선순위는 사용자가 상황에 따라 변경 및 조정이 가능하다. 제안하는 연구에서는 기존의 방법[21]에서의 우선순위를 변경하여, 쌍별 관계를 갖는 객체 중 자식 객체를 제외하고 큰 객체를 우선으로 하여 선택하도록 한다. 즉, 큰 가구를 중심으로 공간을 하나씩 채워가는 구조이다.

다음은 탐색으로, 탐색 단계에서는 식 (1)을 활용하여 현재 객체의 비용 값을 계산한다. 그리고 계산된 비용 값을 토대로 정의된 수렴 조건과의 비교를 통해 객체 배치를 진행할 것인지 아닌지를 판단한다. 이는 임계값을 기준으로 수렴 여부를 판단하는데, 본 연구는 접근성 0.02, 거리는 0.002, 회전 각은 1°를 임계값으로 설정한다. 임계값은 수렴의 속도와 배치의 정확도를 결정하는 중요한 요인이다. 제안하는 연구는 빠른 결과를 유도하기보다는 현실기반의 가상 장면을 응용하는 방향에 초점을 맞추고 있으므로 생성되는 가상 장면의 정확도나 효율적인 배치의 측면에서 접근하고 있다. 따라서, 이러한 목적에 맞게 임계값을 조절하면서 이상적인 값을 설정하였다. 마지막은 행동이다. 현재 객체가 수렴 조건을 만족하지 못하면 탐색 된 비용 값을 고려하여 이동과 회전을 수행하여 다른 위치로의 변환이 수행된다. 이동은 정규분포와 현재 객체의 비용 값을 가중치로 하여 계산되고, 회전은 4방향으로의 회전을 수행한다. 행동이 진행되는 과정에서 수렴 조건을 만족하면 다음 객체를 선택하고, 장면을 구성하는 모든 객체가 배치될 때까지 4단계의 과정을 반복하게 된다. 그림 2는 동적계획법을 기반으로 현실 공간 분석을 통해 생성된 가상 장면을 샘플 장면으로 하여 실내 장면합성결과를 생성하는 전체적인 과정을 나타낸다. 그림 3은 이를 기반으로 객체 단위로 객체를 배치하는 과정의 예를 보여주고 있다.

Ⅴ. 실험 및 분석

제안하는 현실기반 가상 장면 합성 응용을 위한 현실 공간 분석과 실내 가상 장면 합성에 관한 개발환경 구축은 Unity 2020.3.12.f1(64bit)과 2022.3.6.f1(64bit)[22]를 기반으로 C# 스크립트 언어를 사용하여 구현하였다. 현실 공간 분석은 마이크로스프트 홀로렌즈 2 장비를 활용하여 Mixed Reality Toolkit (MRTK) 2[23], Scene Understanding SDK[24] 그리고 Azure AI Custom Vision[25]를 통해 기하학적 분석과 의미론적 해석을 통한 현실 공간 분석을 진행한다. 이 과정에서 개발 도구의 호환성으로 인하여 다른 버전의 유니티 엔진을 활용하였다. 개발환경 및 실험을 위한 PC는 현실 공간 분석의 경우 Intel Core i7-10875H, 16GB RAM, 그리고 a GeForce RTX 2060 GPU를 가상 장면 생성은 AMD Ryzen9 (Zen4) 7945HX (2.5Hz), 32GB RAM, 그리고 a Geforce GTX 4070 Laptop GPU를 탑재하고 있다.

본 연구에서 제시하고자 하는 응용 관점에서 결과를 확인한다. 현실기반의 장면을 토대로 대응되는 가상 장면을 제작한 결과를 확인하였다. 그림 4는 이를 나타낸 것으로 현실 공간을 분석하고 이를 기반으로 동기화된 가상 장면과 함께 이를 토대로 동적계획법을 통해 새롭게 배치된 장면 합성결과를 보여주고 있다. 실험의 목적은 제안하는 과정을 통해 재배치된 생성 결과를 토대로 인테리어, 홈 스타일링 등과 같은 실내 건축의 한 분야로 활용함을 목적으로 하고 있다. 본 연구는 일반적인 실내 공간 중 하나로 침실과 독특한 작업 공간으로 공구 작업 공간인 크리에이티브 스튜디오를 선택하여, 동기화된 가상 장면을 생성하였다. 그리고 다양한 배치 결과를 토대로 사용자에게 다양한 내부 구조 변경 결과를 자동으로 확인할 수 있도록 함으로써 오늘의 집과 같은 인테리어 배치 앱을 활용하여 수작업으로 결과를 확인하는 것과 비교하여 편리하게 응용할 수 있을 것으로 기대하였다. 제안하는 가상 장면 합성 응용을 위해 본 연구에서 사용하는 장면 합성 프레임워크는 마이크로소프트 홀로렌즈 2를 활용하며 현실 공간 탐색 및 객체 분류, 객체 분류 정보를 활용한 객체 자동 배치, 그리고 미세 조정과 보정 작업의 단계별 작업 과정을 통해 진행된다. 본 연구는 그림 4와 같이 실험 공간으로 침실과 크리에이티브 스튜디오를 현실 공간으로 하여 가상 장면을 생성하였고, 현실 공간으로부터 대응되는 가상 장면 생성까지 평균 20분 내외의 시간이 소요됨을 단계별 작업 과정 시간을 측정하여 확인하였다. 구체적으로, 마이크로소프트 홀로렌즈 2를 활용하여 현실 공간에 대한 기하학적 정보를 분석하고 Azure AI Custom Vision을 통해 객체의 의미론적 해석 작업을 하는데 최대 평균 8분 이내의 시간이 소요됨을 알 수 있다. 침실의 경우는 크리에이티브 스튜디오와 비교하여 상대적으로 적은 공간 규모와 객체 수로 구성되어 있으므로 전체적으로 평균 6분(현실 공간 탐색 및 객체 분류: 2분 내외) 이내로 적은 시간이 소요된다. 결과적으로, 수작업을 포함한 가상 장면 생성을 위한 시간은 최대 10분 이상이 소요되는데 이는 본 연구에서 활용한 유니티 엔진과 그래픽 디자인 작업의 이해도, 숙련도와 비례하기 때문에 작업 시간을 단축할 수 있을 것이다.

Results of proposed reality-based virtual scene synthesis application: (a) real space (bedroom and creative studio), (b) indoor scene synthesis results

Wang et al.[26]이 제안한 PointShopAR은 본 연구와 유사하게 현실 공간을 분석하여 가상환경을 구성한다. 공간 규모는 크리에이티브 스튜디오와 비슷한 규모로 평균 10m ⨉ 10m 실험 공간을 활용하였다. 그리고, 현실 공간 탐색부터 장면 완성까지 평균 21분 26초(최대 38분 48초)가 소요되는 것으로 나타났다. 하지만, PointShopAR은 장면을 구성하는 객체의 의미론적 해석 없이 단순히 현실 공간의 3차원 기하학적 정보를 계산하여 메시 정보만으로 장면을 구성한다. 따라서, 공간을 구성하는 객체의 특징, 유형을 확인할 수 없어 장면 합성 응용을 위해서는 추가적인 작업이 요구되고, 결국 많은 작업 시간을 필요로 하는 문제가 발생한다. 또한, 장면 스캔을 위한 별도의 시간이 요구되는 등 본 연구에서 사용하는 장면 합성 프레임워크와 비교하여 현실기반 가상 장면 합성 응용을 위한 현실 공간 분석의 목적으로 활용하기에는 명확한 단점이 존재함을 확인할 수 있다.

표 2는 본 연구에서 실험으로 진행한 침실과 크리에이티브 스튜디오 공간을 토대로 실험 환경과 장면 합성결과 생성까지의 평균 시간을 나타낸 것이다. 공간의 규모와 현실 공간을 구성하는 객체 수에 따라 전체적인 작업 시간을 예측할 수 있을 것이다. 다만, 현재의 공간은 사각형의 실내 구조만을 고려하고 있고, 한정된 목적의 공간만을 다루고 있어 실험 결과를 일반화할 수는 없다. 따라서, 거실, 욕실을 비롯한 일반화된 실내 공간과 함께 실험실과 같은 특정 목적을 가지는 여러 공간을 다양하게 구성하여 작업 시간을 측정하고, 일반 사용자와 디자이너 전문가의 작업 시간을 비교 분석함으로써 일반화된 결과를 도출할 수 있는 실험이 필요하다.

Experimental environment and performance results of reality-based virtual scene synthesis application

다음은 동적계획법을 활용하여 객체 배치를 진행하는 과정에서의 성능을 비교 분석한다. 표 3은 비교 실험 결과를 나타낸 것으로, Yu et al.[4]이 제안한 MCMC (Markov chain Monte Carlo) 기반 메트로폴리스 헤이스팅스(Metropolis-Hastings) 샘플링을 활용한 담금질 기법(Simulated Annealing)을 통한 객체 배치의 최적해 기법과 본 연구에서 객체 배치를 위해 활용한 동적계획법과 배치 진행 시간을 비교하였다. 제안하는 동적계획법을 활용한 객체 배치 소요 시간은 객체 수가 10개 미만인 침실의 경우 평균 1.5초 이내, 객체 수가 20개 내외인 크리에이티브 스튜디오의 경우 평균 7.2초가 기록된 반면 장면을 구성하는 전체 객체의 관계를 동시에 계산하여 배치하는 기존 연구의 경우는 최소 25배 이상의 시간이 소요되는 것으로 나타났다. 이를 토대로 가상 장면 합성 응용을 위해 동적계획법을 활용한 객체 재배치 과정이 응용에 있어 효율적인 구조를 가짐을 확인할 수 있었다.

마지막은 생성된 가상 장면 합성 응용 결과에 관한 활용성에 대한 평가이다. 생성된 다양한 장면 합성 생성 결과를 토대로 그래픽 디자이너, 건설/건축 분야의 그래픽스 개발자로 구성된 3명의 전문가 [27],[28]의 의견을 취합하였다. 설문 문항은 다음과 같이 3가지로 구성된다.

- 1. 가상 장면 합성응용 결과가 실질적으로 활용 가능한 수준의 결과를 포함하고 있는지 이유와 함께 적어주시오.

- 2. 객체 배치 과정에서 가장 중요하게 고려해야 할 요인은 무엇이라고 생각하는지 적어주시오.

- 3. 본 연구와 같은 가상 장면 합성응용 시스템이 있다면 활용하실 의향이 있는지 이유와 함께 적어주시오.

설문 결과는 기본적으로 “가구나 공간 구성을 고민하는 사용자에게 좋은 참고자료가 될 수 있을 것”이라는 의견을 주었다. 활용 가능한 수준의 결과를 포함하고 있는지에 관한 질문에서는 “생성된 장면 중 일부는 활용성에 측면에서 유의미한 결과를 나타내는 것도 포함하고 있다”는 의견도 있었다. 특히, “생각하지 못한 배치 결과를 확인할 수 있었다”는 점과 함께 “다양하고 많은 장면 합성 참고자료를 빠른 시간 안에 확인할 수 있는 것이 큰 장점”이 될 수 있어 활용 의향에 긍정적인 의견을 주는 부분에 대해서 주목할 수 있었다. 따라서, 제안하는 응용 방법을 통해 다양한 장면 합성결과를 인테리어의 참고자료, 건축 분야에서 모델하우스의 실내 구조를 고려하는 기초 자료 등으로 활용할 수 있을 것이다. 하지만, 배치 과정에서 중요하게 고려해야 할 요인에 관한 답변으로 “심미적 요인, 사용자의 의견 등의 반영되지 못하는 한계”, “동선에서 비효율적이거나 불편한 구조를 갖는 결과도 포함하고 있다”는 지적이 있었다. 동적계획법을 활용한 개체 배치는 장면을 구성하는 전체 객체를 동시에 배치하는 기존의 최적해 기법[4]-[6]과는 다르게 객체 단위로 진행된다. 이는 사용자의 편집과 개입을 할 수 있는 구조로 되어 있어 지적한 한계나 문제를 일부분 해결할 수 있을 것으로 기대한다.

Ⅵ. 한계 및 토론

제안하는 현실기반 가상 장면 합성 응용을 확인하기 위해 활용한 현실 공간은 침실과 크리에이티브 스튜디오로 제한적인 장면을 담고 있으며, 주제별로 하나의 공간만을 대상으로 하였다. 다양한 콘셉트와 주제의 현실 공간을 고려하고 이를 기반으로 가상 장면 합성결과를 생성함으로써 제안하는 연구의 활용 분야와 가능성을 폭넓게 확인하는 과정이 필요할 것으로 생각한다. 따라서, 침실을 포함한 거실, 부엌, 서재 등 일반적인 실내 공간을 포함하여 실험실, 사무실, 식당 등 목적을 가진 특정 공간 등을 다양하게 고려하여 정량적, 정성적 실험을 진행하고자 한다.

본 연구는 Na and Kim[20]의 장면 합성 프레임워크와 Cho and Kim[21]의 동적계획법 기반 실내 장면 합성방법을 토대로 현실 공간을 기반으로 한 가상 장면 응용 방향을 제시함을 목적으로 하였다. 이 과정에서 제안하는 응용 방법에서의 정량적 실험에 있어 기존 연구, 기술들과의 목적의 차이로 인하여 직접적인 비교 실험이 어려운 한계가 있어 제한적인 실험이 이루어진 문제가 있었다. 제안하는 연구의 응용 분야로 인테리어, 홈 스타일링과 같은 실내 건축의 한 분야로 활용하는 것을 제안하는 만큼 향후 이케아 플레이스[29], 에이스룸[30]과 같은 상용 서비스와의 유용성을 비교 분석할 수 있는 설문 실험을 보완할 계획이다.

제안하는 현실기반 가상 장면 합성 응용은 현실 공간과 정확하게 동기화된 가상 장면을 생성하고, 이를 토대로 현실 공간의 구조, 배치를 가상 장면을 통해 다양하게 변경하여 현실 공간이 변경될 수 있는 새로운 장면을 사용자에게 제시한다. 전문가의 의견을 토대로 다양한 장면 합성결과를 필요로 하는 산업 분야나 소비자의 참고자료로 활용할 수 있을 것으로 판단하였다. 구체적으로, 가구 배치를 고민하는 인테리어, 홈 스타일링과 함께 건설 분야에서 모델하우스의 실내 구조, 가구 배치를 다양하게 제시하거나 제조 분야에서의 디지털 트윈을 기반으로 스마트 공장을 구축하는 과정에서 공장 내 장비의 구조나 패턴을 제시하는 방향으로도 응용 가능할 것으로 기대한다. 이와 관련하여, 제안하는 응용 방법이 다양한 산업 분야에 활용될 수 있도록 다양한 실험 결과와 함께 기술적 성능 평가, 전문가 집단 대상의 설문 평가 등을 수행함으로써 구체적인 활용 방향을 제시해 나갈 계획이다.

이밖에도 제안하는 현실기반 가상 장면 합성 응용 방법의 기술적 성능에 관한 추가적인 실험들로 현실 공간을 분석하여 가상 장면을 자동으로 생성하는 과정에서의 오차, 오류 등에 정량적 실험과 동적계획법 기반 객체 배치를 통하여 많은 수의 실내 장면 합성결과를 생성하는데 필요한 조건, 시간 등에 대한 평가 실험을 진행하여 다양한 산업 분야에서 현실적으로 활용 가능할 수 있는 방향을 제시해 나갈 것이다.

Ⅶ. 결 론

본 연구는 현실을 기반으로 정교하게 대응되는 가상 장면을 생성하고 이를 기반으로 다양한 산업 분야에 응용 가능한 하나의 방법으로 실내 장면 합성기술을 활용한다. 이러한 목적을 달성하기 위하여 우선, 장면 합성 프레임워크를 통한 정확한 현실 공간 분석을 수행한다. 본 연구에서 활용한 장면 합성 프레임워크는 현실 공간에 대한 3차원 기하학적 분석과 공간을 구성하는 객체의 유형을 인식 및 분류하는 의미론적 해석과정으로 구성된다. 이를 통해 현실 공간을 구성하는 객체의 정확한 정보를 토대로 동기화된 가상 장면을 생성한다. 생성된 가상 장면을 응용하는 하나의 방법으로 본 연구는 인테리어, 홈 스타일링 등 실내 건축 디자인을 구체적인 예로 설정하였다. 장면을 구성하는 객체(가구, 소품 등)를 자동으로 재배치하는 과정을 통해 많은 수의 다양한 장면 합성결과를 빠르고 효과적으로 생성하도록 한다. 이를 위해, 본 연구는 동적계획법을 활용한 실내 장면 합성방법을 활용하였다. 이는 동적계획법의 하향식, 상향식 문제 해결을 장면 합성의 구조에 적용하여 해석하는 알고리즘이다. 장면을 구성하는 객체의 배치 과정을 객체별 비용 값을 계산하여 해석하는 방법으로 선택, 탐색, 수렴 그리고 행동의 4단계 과정을 통해 순차적으로 실행하여 장면 합성결과를 도출한다. 본 연구에서는 침실과 크리에이티브 스튜디오 두 현실 공간을 설정하고, 다양한 장면 합성결과를 실험을 통해 확인하였다. 현실 공간을 기반으로 동기화된 가상 장면을 정확히 생성하기까지의 소요 시간과 생성된 가상 장면으로부터 새로운 배치의 장면 합성결과를 계산하는 소요 시간을 측정하였다. 장면 합성 프레임워크의 성능은 침실은 평균 6분, 크리에이브티브 스튜디오는 평균 20분 정도의 시간이 소요되며, 동적계획법을 통한 하나의 실내 장면 배치를 수행하기까지는 침실은 평균 1.5초, 크리에이티브 스튜디오는 평균 7.2초의 시간이 기록되었다. 기존의 연구들과 비교하여 활용성이 높은 성능을 보임을 확인하였다. 또한, 합성 결과를 토대로 전문가의 의견을 고려하였을 때 다양한 장면 합성결과를 참고자료로 하여 필요로 하는 사용자에게 적절하게 제공한다면 좋은 기초 정보가 될 수 있을 것으로 판단하였다.

본 연구에서 제시하고자 하는 최종목표는 현실 공간과 정교하게 대응되어 생성된 가상 장면을 토대로 장면 합성기술을 통해 다양한 가상 장면을 생성하고 이를 현실을 기반으로 하는 다양한 산업 분야에 응용할 수 있는 새로운 방향을 제시하고자 하는 것이다. 하지만, 생성된 장면 합성결과를 토대로 인테리어, 건축, 그래픽 디자인 등 관련 분야의 전문가 의견과 설문을 기반으로 한 통계적 유의미성과 객관적 분석을 반영하지는 못하였다. 따라서, 향후 관련 분야 전문가들의 의견을 반영하여 체계적인 분석을 수행할 수 있도록 UEQ (User Experience Questionnaire)[31] 등과 같은 설문지를 활용한 통계 분석 및 전문가 평가를 수행할 계획이다. 또한, 본 연구에서 제시한 침실, 크리에이티브 스튜디오 외에 다양한 현실 공간을 주제로 하여 실험을 진행하고자 한다.

Acknowledgments

본 연구는 한성대학교 학술연구비 지원과제 임

References

-

C. A. Vanegas, I. Garcia-Dorado, D. G. Aliaga, B. Benes, and P. Waddell, “Inverse Design of Urban Procedural Models,” ACM Transactions on Graphics, Vol. 31, No. 6, 168, November 2012.

[https://doi.org/10.1145/2366145.2366187]

-

J. Kim and H. Cho, “Efficient Modeling of Numerous Trees by Introducing Growth Volume for Real-Time Virtual Ecosystems,” Computer Animation & Virtual Worlds, Vol. 23, No. 3-4, pp. 155-165, May-August 2012.

[https://doi.org/10.1002/cav.1438]

-

Y. I. H. Parish and P. Müller, “Procedural Modeling of Cities,” in Proceedings of the 28th Annual Conference on Computer Graphics and Interactive Techniques (SIGGRAPH ’01), Los Angeles: CA, pp. 301-308, August 2001.

[https://doi.org/10.1145/383259.383292]

-

L.-F. Yu, S.-K. Yeung, C.-K. Tang, D. Terzopoulos, T. F. Chan, and S. J. Osher, “Make it Home: Automatic Optimization of Furniture Arrangement,” ACM Transactions on Graphics, Vol. 30, No. 4, 86, July 2011.

[https://doi.org/10.1145/2010324.1964981]

-

P. Kán and H. Kaufmann, “Automatic Furniture Arrangement Using Greedy Cost Minimization,” in Proceedings of 2018 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Tuebingen/Reutlingen, Germany, pp. 491-498, March 2018.

[https://doi.org/10.1109/VR.2018.8448291]

-

P. Kán and H. Kaufmann, “Automated Interior Design Using a Genetic Algorithm,” in Proceedings of the 23rd ACM Symposium on Virtual Reality Software and Technology (VRST ’17), Gothenburg, Sweden, 25, November 2017.

[https://doi.org/10.1145/3139131.3139135]

- D. Paschalidou, A. Kar, M. Shugrina, K. Kreis, A. Geiger, and S. Fidler, “ATISS: Autoregressive Transformers for Indoor Scene Synthesis,” in Proceedings of the 35th International Conference on Neural Information Processing Systems (NIPS ’21), Online, pp. 12013-12026, December 2001.

-

J.-M. Sun, J. Yang, K. Mo, Y.-K. Lai, L. Guibas, and L. Gao, “HAISOR: Human-Aware Indoor Scene Optimization via Deep Reinforcement Learning,” ACM Transactions on Graphics, Vol. 43, No. 2, 15, April 2024.

[https://doi.org/10.1145/3632947]

-

M. Li, A. G. Patil, K. Xu, S. Chaudhuri, O. Khan, A. Shamir, ... and H. Zhang, “GRAINS: Generative Recursive Autoencoders for INdoor Scenes,” ACM Transactions on Graphics, Vol. 38, No. 2, 12, April 2019.

[https://doi.org/10.1145/3303766]

-

L.-P. Cheng, E. Ofek, C. Holz, and A. D. Wilson, “VRoamer: Generating On-the-Fly VR Experiences while Walking Inside Large, Unknown Real-World Building Environments,” in Proceedings of 2019 IEEE Conference on Virtual Reality and 3D User Interfaces (VR), Osaka, Japan, pp. 359-366, March 2019.

[https://doi.org/10.1109/VR.2019.8798074]

-

P. Wonka, M. Wimmer, F. Sillion, and W. Ribarsky, “Instant Architecture,” ACM Transactions on Graphics, Vol. 22, No. 3, pp. 669-677, July 2003.

[https://doi.org/10.1145/882262.882324]

-

J. Xiao, T. Fang, P. Tan, P. Zhao, E. Ofek, and L. Quan, “Image-Based Façade Modeling,” ACM Transactions on Graphics, Vol. 27, No. 5, 161, December 2008.

[https://doi.org/10.1145/1409060.1409114]

-

J. Kim, D. Kim, and H. Cho, “Procedural Modeling of Trees Based on Convolution Sums of Divisor Functions for Real-Time Virtual Ecosystems,” Computer Animation & Virtual Worlds, Vol. 24, No. 3-4, pp. 237-246, May-August 2013.

[https://doi.org/10.1002/cav.1506]

-

K. Jeong, J. Lee, and J. Kim, “A Study on New Virtual Reality System in Maze Terrain,” International Journal of Human–Computer Interaction, Vol. 34, No. 2, pp. 129-145, 2018.

[https://doi.org/10.1080/10447318.2017.1331535]

-

P. Purkait, C. Zach, and, I. Reid, “SG-VAE: Scene Grammar Variational Autoencoder to Generate New Indoor Scenes,” in Proceedings of the 16th European Conference on Computer Vision (ECCV 2020), Glasgow, UK, pp. 155-171, August 2020.

[https://doi.org/10.1007/978-3-030-58586-0_10]

-

Z. Zhang, Z. Yang, C. Ma, L. Luo, A. Huth, E. Vouga, and Q. Huang, “Deep Generative Modeling for Scene Synthesis via Hybrid Representations,” ACM Transactions on Graphics, Vol. 39, No. 2, 17, April 2020.

[https://doi.org/10.1145/3381866]

-

C. Song, J. Wang, S. Chen, H. Li, Z. Jiang, and B. Yang, “Non-Autoregressive Transformer with Fine-Grained Optimization for User-Specified Indoor Layout,” Engineering Applications of Artificial Intelligence, Vol. 133, Part B, 108024, July 2024.

[https://doi.org/10.1016/j.engappai.2024.108024]

-

M. Sra, S. Garrido-Jurado, and P. Maes, “Oasis: Procedurally Generated Social Virtual Spaces from 3D Scanned Real Spaces,” IEEE Transactions on Visualization and Computer Graphics, Vol. 24, No. 12, pp. 3174-3187, December 2018.

[https://doi.org/10.1109/TVCG.2017.2762691]

-

E. Schott, E. B. Makled, T. J. Zoeppig, S. Muehlhaus, F. Weidner, W. Broll, and B. Froehlich, “UniteXR: Joint Exploration of a Real-World Museum and Its Digital Twin,” in Proceedings of the 29th ACM Symposium on Virtual Reality Software and Technology (VRST ’23), Christchurch, New Zealand, 25, October 2023.

[https://doi.org/10.1145/3611659.3615708]

- G. Na and J. Kim, “Design of Scene Synthesis Framework for Collaborative XR Environment,” in Proceeding of 2024 Conference on Korea Computer Graphics Society (KCGS 2024), Gyeongju, pp. 58-59, July 2024.

- Y. Cho and J. Kim, “Fast and Intuitive Indoor Scene Synthesis via Dynamic Programming,” in Proceeding of 2024 Conference on Korea Computer Graphics Society (KCGS 2024), Gyeongju, pp. 79-80, July 2024.

- Unity Technologies. Unity Engine [Internet]. Available: https://unity3d.com/, .

- GitHub. Mixed Reality Toolkit (MRTK) v2 [Internet]. Available: https://github.com/microsoft/MixedRealityToolkit-Unity, .

- Microsoft. Scene Understanding SDK [Internet]. Available: https://learn.microsoft.com/en-us/windows/mixed-reality/design/scene-understanding, .

- Microsoft. Azure Custom Vision [Internet]. Available: https://learn.microsoft.com/en-us/windows/mixed-reality/develop/unity/tutorials/mr-azure-310, .

-

Z. Wang, C. Nguyen, P. Asente, and J. Dorsey, “PointShopAR: Supporting Environmental Design Prototyping Using Point Cloud in Augmented Reality,” in Proceedings of the 2023 CHI Conference on Human Factors in Computing Systems (CHI ’23), Hamburg, Germany, 34, April 2023.

[https://doi.org/10.1145/3544548.3580776]

- Andromeda Studio. Official Website [Internet]. Available: http://www.studioandro.com/, .

- TENELEVEN. Official Website [Internet]. Available: https://www.1011.co.kr/, .

- Google Play. IKEA Application [Internet]. Available: https://play.google.com/store/apps/details?id=com.ingka.ikea.app&hl=ko&pli=1, .

- Google Play. ACEROOM Application [Internet]. Available: https://play.google.com/store/apps/details?id=com.acebed.aceroom&hl=ko, .

- Team UEQ. User Experience Questionnaire [Internet]. Available: https://www.ueq-online.org/, .

저자소개

2006년:동국대학교 컴퓨터·멀티미디어공학부 (공학사)

2008년:동국대학교 영상대학원 멀티미디어학과 (예술공학석사)

2012년:동국대학교 영상대학원 멀티미디어학과 (공학박사)

2012년~2014년: 동국대학교 영상문화콘텐츠연구원 전임연구원

2014년~2019년: 부산가톨릭대학교 소프트웨어학과 조교수

2019년~현 재: 한성대학교 컴퓨터공학부 부교수

※관심분야:컴퓨터그래픽스(Computer Graphics), 가상현실(Virtual Reality), 증강현실(Augmented Reality), 실감형 미디어(Immersive Media), 게임 공학(Game Engineering) 등

2023년: 한성대학교 디지털콘텐츠·가상현실트랙 공학사

2024년: 한성대학교 일반대학원 컴퓨터공학과 석사

※관심분야:가상현실(Virtual Reality), 증강현실(Augmented Reality), 실감형콘텐츠(Immersive Contents) 등