딥러닝 기반 시·촉각 혼합 현실 정합 방법에 관한 연구

Copyright ⓒ 2024 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

가상 현실을 현실 세계의 햅틱 장치 위에 정밀하게 정합하는 것은 몰입감 있는 시·촉각 혼합 현실을 제공하는 데 매우 중요하다. 기존의 방법들은 추가적인 장비가 필요하여 시스템의 부피가 크고 사용성에 제한사항이 있다. 본 논문에서는 추가적인 외부 장비를 사용하지 않고 머리 착용형 디스플레이(HMD)와 햅틱 장치에서 제공하는 정보를 활용한 심층 신경망 기반의 가상현실 정합 방법을 제안한다. 햅틱 장치를 기준으로 나누어진 6개의 구역에서 각각 하나씩 벡터를 추출한 뒤, 제안하는 네트워크 모델을 활용해 햅틱 장치의 base의 6 자유도를 추정한다. 실험 결과 위치에 대한 최대 거리오차는 15.4 mm, 최대 회전 오차가 5.17 °였다. 제안하는 방법은 가상현실 정합을 위해 추가적인 장비를 사용하지 않고 햅틱 장치의 6 자유도를 추정할 수 있으며 시각과 촉각이 결합된 다양한 혼합 현실 기반 응용 프로그램 개발에 활용될 수 있다.

Abstract

Precisely aligning virtual reality with real-world haptic devices is essential for creating an immersive mixed reality experience that integrates both visual and tactile sensations. Traditional methods that rely on additional equipment lead to bulky systems with limited usability. This paper proposes a deep neural network-based method for virtual reality alignment that leverages data from a head-mounted display (HMD) and haptic devices, eliminating the need for external equipment. Vectors are extracted from six regions relative to the haptic device and input into a network model to estimate the device's six degrees of freedom. Experimental results demonstrate a maximum positional error of 15.4 mm and a maximum rotational error of 5.17°. This method accurately estimates the 6 DoF of the haptic device without the need for additional alignment equipment and can be applied in the development of various mixed reality applications.

Keywords:

Haptic, Augmented Reality, Virtual Reality, Alignment, Deep Learning키워드:

햅틱, 증강현실, 가상현실, 정합, 딥러닝Ⅰ. 서 론

최근 들어 머리 착용형 디스플레이(HMD; head mounted display) 장치의 발달로 가상현실(VR; virtual reality)과 증강현실(AR; augmented reality)에 햅틱 장치를 활용하여 가상 물체와 상호작용을 제공하는 혼합현실을 활용한 응용 프로그램이 많이 개발되고 있다[1]-[4]. 혼합현실에서는 사용자는 실제 혹은 가상환경 속에서 현실세계에 있는 햅틱 장치를 통해 가상 물체와 상호작용 할 수 있다. 하지만 햅틱 장치 위로 가상현실을 정교하게 정합하지 않는다면 사용자의 강성 인식에 영향을 미치게 된다[5]. 이러한 인지 강성 왜곡 현상은 사용자가 시뮬레이션에서 의도된 가상 객체의 강성을 더 딱딱하게 혹은 더 말랑하게 느끼게 만든다. 특히 의료 훈련 시뮬레이션과 같이 햅틱 감각이 중요한 시뮬레이션에서 발생하는 인지 강성 왜곡 현상은 의도된 강성과 다른 강성을 사용자에게 전달하여 훈련 및 시뮬레이션의 효과를 떨어뜨리게 된다[6].

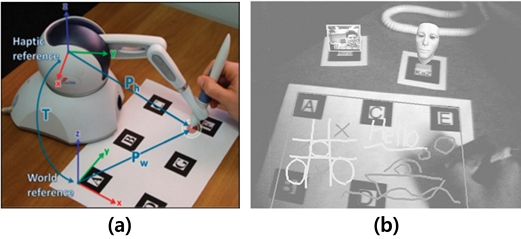

가상현실을 햅틱 장치에 정확하게 정합하기 위해 여러 방법들이 제안되었다. 제조업체의 컨트롤러 또는 HMD가 제공하는 컨트롤러의 상대 좌표를 참조하여 손 추적 기능을 사용하는 방법이 제안되었다[7]. 하지만 해당 방법은 제조업체가 필요한 기능을 제공하는 경우에만 사용할 수 있다. 또한 사용자의 손 모양, 크기에 따라 정확한 추적이 이루어지지 않아 정합의 정밀도를 저해한다. QR 코드, 외부 카메라, 외부 자석 추적기 등을 사용하여 HMD와 객체를 추적하는 방법도 제안되었다[8],[9](그림 1). 이러한 접근 방식은 시스템의 부피가 증가하고 조명이나 폐색과 같은 노이즈가 발생하면 정합의 정확도가 낮아져 사용이 어렵다는 한계가 있다. 또한 정합을 위해 마커를 대상 객체에 부착할 수 없는 경우에는 사용하기 어렵다.

Align method using marker. (a) Align the haptic device using markers[8], (b) Visualize virtual objects at the marker's location by tracking the marker's position[9]

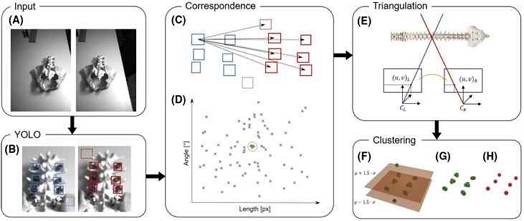

마커를 사용할 때 발생하는 문제점을 극복하고자 CNN (convolution neural network) 기반의 객체 탐지 기술을 사용한 HoloYolo가 제안되었다[10](그림 2). 그러나 이 방법은 촬영한 이미지를 활용하여 2차원 이미지 내에 객체 탐지가 먼저 이루어지기 때문에 입력 이미지의 해상도에 따라 추정 정확도가 달라지는 문제가 있다. 또한 2차원 이미지 내에 객체 탐지가 정확하게 이루어지지 않았을 경우 3차원 공간 내의 객체 위치 추정에도 영향을 미치게 된다는 한계점이 있다.

HoloYolo’s align method. Using images captured by the two front cameras of the HoloLens for object detection and rendering virtual screws at the detected locations[10]

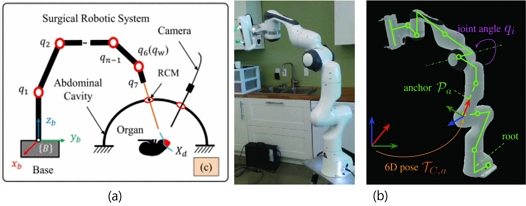

로봇이나 햅틱 장치의 기구학을 이용한 정합 방법도 제안되었다. 로봇 위에 가상현실을 정합하기 위해서는 로봇의 자세를 정확히 추정해야 한다. 로봇 base의 위치를 광학 추적을 통해 추정한 후 로봇의 기구학을 사용하여 로봇을 재구성하는 방법이 제안되었으며[11](그림 3. (a)), 카메라로 촬영한 RGB 이미지를 사용해서 로봇의 base와 로봇의 관절의 각도를 추정하여 가상환경에 렌더링하는 방법이 제안되었다[12](그림 3. (b)). 하지만 기구학을 이용하는 방법들은 로봇이나 햅틱 장치의 마디와 관절에 대한 정보를 제조사에서 제공하는 경우에만 사용할 수 있으며, 소프트 액추에이터가 포함된 햅틱 인터페이스에 적용하기 어렵다.

Align method using kinematics. (a) using kinematic after base estimation[11] (b) estimate kinematic from image[12]

본 논문에서는 외부 마커나 기구학을 사용하지 않고 증강현실을 위한 신경망 기반 정합 방법을 제안한다. 제안하는 방법은 사용자로부터 가상현실에서의 HMD의 위치, HMD가 제공하는 손 추적을 통해 얻은 손가락 끝단의 위치와 햅틱 장치 좌표계 기준 햅틱 장치 펜의 6 자유도 위치로 구성된 6개의 벡터를 입력으로 받는다. 네트워크 모델은 입력으로부터 햅틱 장치 base를 추정한다.

본 논문에서는 2장에서 네트워크 모델 설계에 대해 설명하고, 3장에서는 네트워크 모델 학습을 위한 데이터 생성법에 대해 설명하며, 4장에서는 실험에 대해서 설명한다.

Ⅱ. 딥러닝 기반 가상현실 정합 방법

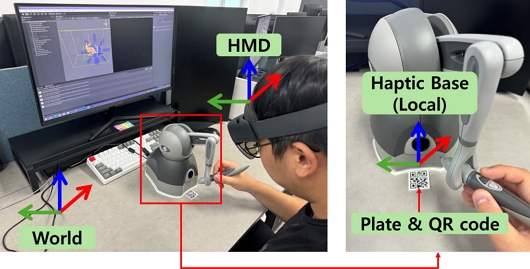

제안하는 방법은 그림 4와 같이 3개의 좌표계를 사용한다. 가상현실 전역 좌표계, 햅틱 장치의 base를 기준으로 하는 지역 좌표계와 사용자의 HMD 좌표계를 사용한다. 가상현실을 햅틱 장치 위에 정확하게 정합하기 위해서는 전역 좌표계 기준 HMD 장치와 햅틱 장치 base의 6 자유도 정보가 필요하다. 제안하는 방법은 다음과 같은 아이디어를 기반으로 설계되었다. 사용자가 그림 4와 같이 햅틱 장치의 펜을 잡고 조작할 때 사용자의 손가락은 펜의 특정 위치에 고정된다. 사용자는 손가락을 햅틱 장치 펜의 동일한 위치에 유지하며 펜의 특정 버튼을 눌러 네트워크 모델에 벡터 입력을 제공한다. 손가락 끝단과 펜의 상대적 위치는 고정되어 있으므로 HMD를 사용하여 사용자 손가락 끝단의 위치를 추정했을 때 HMD 좌표계 기준에서의 손가락 끝의 위치를 HMD 좌표계 기준에서의 햅틱 장치 펜의 위치로 간주할 수 있다. 이후, 햅틱 장치 base로부터 측정된 펜의 위치를 네트워크 모델을 사용해 햅틱 장치의 base의 6 자유도를 추정할 수 있다. 본 논문은 가상현실 좌표계 기준 HMD의 위치, 손가락 끝의 위치, 그리고 햅틱 장치 base에 대한 펜의 6 자유도를 사용하여 햅틱 장치 base의 6 자유도를 추정하는 네트워크 모델을 제안한다.

The coordinate system configuration of the mixed reality interface used for data generation, left. The relative position of the fingertip and pen, the QR code, and the image of the produced plate on the right.

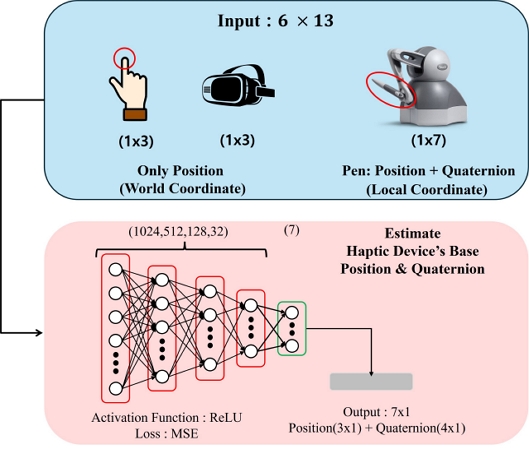

사용자의 입력으로부터 햅틱 장치 base의 6 자유도를 추정하기 위해서는 6개의 벡터 입력이 필요하다. 본 논문에서는 외부 장치나 기구학을 사용하지 않고 사용자의 입력으로부터 햅틱 장치 base의 6 자유도를 추정하는 네트워크 모델을 설계한다. 하나의 벡터 입력에는 world 좌표계 기준 HMD의 위치(3×1)와 손가락 끝단의 위치(3×1), 그리고 햅틱 장치 좌표계 기준 펜의 위치(3×1)와 쿼터니언으로 표현된 회전(4×1)에 대한 정보가 포함된다. 쿼터니언의 경우 4 자유도 이지만 벡터 크기가 1이어야 한다는 구속조건이 있으므로 결과적으로 3 자유도의 3차원 공간에서의 회전을 나타낸다. 총 6개의 벡터를 하나로 연결하여 78×1의 입력데이터가 네트워크 모델의 입력으로 사용된다.

네트워크 모델은 순차 모델을 사용해서 설계하였다. 총 5개의 fully connected layer로 구성되어 있으며. 5개의 레이어는 모두 dense layer를 사용했다. 첫번째 레이어부터 순서대로 1024, 512, 128, 32, 7의 출력 차원을 가진다. 가장 첫 번째 레이어는 78×1의 크기의 입력을 받으며, 마지막 레이어를 제외한 4개의 레이어에는 활성 함수 ReLU가 적용되어 있으며 마지막 레이어는 출력을 위한 레이어로 햅틱 장치 base의 위치와 쿼터니언으로 표현된 회전을 출력한다.

네트워크 학습 시 손실함수로는 평균 제곱 오차 (MSE; mean squared error)를 사용하였으며, 네트워크 모델의 최적화를 위해 adam optimizer를 사용하였다. 또한 네트워크 모델의 과적합 현상을 방지하기 위해 early stopping을 적용하였다. MSE 값 0.000001 m 를 기준으로 하여 해당 기준보다 5 에포크 (epoch)동안 개선이 되지 않는 경우 학습을 조기 종료한다. 네트워크 모델의 구조는 그림 5와 같다.

Ⅲ. 데이터 수집 및 학습 데이터 생성

3-1 데이터 수집

네트워크 모델을 학습시키기 위해서는 입력데이터와 함께 햅틱 장치의 6 자유도 정보에 대한 정답 값이 필요하다. HoloLens2의 공간 인식 기능을 사용하여 HMD의 위치와 손가락 끝단의 위치를 가상 현실 world 좌표계를 기준으로 측정 가능하다. 또한 햅틱 장치의 기능을 사용하여 햅틱 장치 local 좌표계 기준 펜의 6 자유도 정보를 얻을 수 있다.

훈련데이터를 생성하기 위해 대량의 벡터와 정답 값을 수집했다. 수집된 데이터에서 6개의 벡터를 조합하여 훈련 및 검증에 사용한다. 하나의 벡터에는 햅틱 장치 local 좌표계 기준 펜의 6 자유도(7×1), world 좌표계 기준 HMD의 위치(3×1), 손가락 끝단의 위치(3×1)에 대한 정보가 포함되어 13×1의 크기를 가진다. 사용자가 펜을 잡고 움직이면 벡터를 주기적으로 샘플링한다.

본 논문에서는 world 좌표계에서 햅틱 장치 base의 6 자유도 정답 값을 수집하기 위하여 Hololens2에서 제공하는QR 코드 추적 기능을 사용하였다. QR 코드와 햅틱 장치 간의 상대적 위치를 고정하기 위해 3D 프린터를 사용하여 판을 설계하고 출력하여 사용하였다 (그림 4). 판에 햅틱 장치와 QR 코드를 부착한 후, HoloLens2를 사용해 QR 코드를 캡처하여 world 좌표계에서 햅틱 장치 base의 6 자유도를 추정하였다. QR 코드와 햅틱 장치 간의 고정된 관계를 활용하여 햅틱 장치를 QR 코드 좌표에 맞추어 world 좌표계에서 정합하였다. QR 코드를 캡처하여 위치를 고정하고, 펜을 이동하면서 0.1초 간격으로 샘플링하여 데이터를 수집했다.

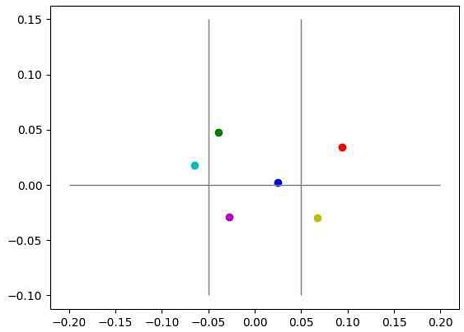

사용자가 Unity와 연동된 HMD를 착용하면 가상 현실의 world 좌표계에서 HMD의 위치는 원점에서 시작한다. 따라서 world 좌표계에서 HMD의 위치와 손가락 끝단의 위치는 주로 원점 근처에서 수집되기 때문에 원점에서 멀어질 수록 추정의 정확도가 감소하게 된다. 이러한 문제를 해결하기 위해 world 좌표계에서 수집된 위치 데이터에 편향을 주어 데이터 증강을 수행했다. x 및 z축에는 –0.2 ~ 0.2범위 내에서 0.1 m 간격으로 편향을 추가한다. y축에는 0 ~ 0.2의 범위 내에서 0.1 m 간격으로 편향을 추가하였다.

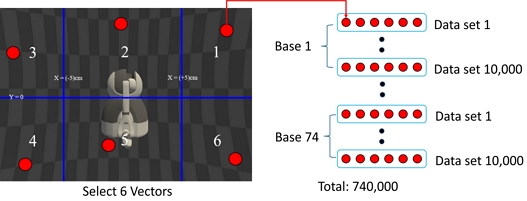

3-2 학습 데이터 생성

햅틱 장치 base의 6 자유도를 추정하기 위해서는 6개의 벡터가 필요하며 하나의 입력 데이터는 6개의 벡터를 연결하여 구성한다. 6개의 벡터를 선택할 때 고르게 분포가 되어있는 벡터들을 선택하기 위해 햅틱 장치 local 좌표계 기준으로 x축 –5, +5의 2개의 기준과 y축 0을 기준으로 하여 6개의 구역으로 나누어 각 구역에서 하나의 벡터를 선택한다 (그림 6). 또한 각 벡터에 포함된 햅틱 장치 local 좌표계 기준 펜의 위치 사이의 간격이 6 cm 이상인 벡터들을 선택하게 하여 고르게 분포된 6개의 벡터를 추출한다. 추출한 벡터들은 그림 6의 구역의 번호 순서대로 연결되어 하나의 1 × 78 크기의 입력 데이터를 생성한다. 총 74개의 햅틱 장치 base의 정답 값 당 10,000개의 입력 데이터를 생성하여 총 740,000 × 78 크기의 데이터 셋을 생성한다.

Ⅳ. 네트워크 모델 성능 평가 실험

4-1 실험 환경

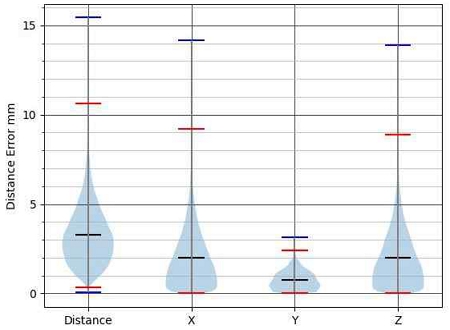

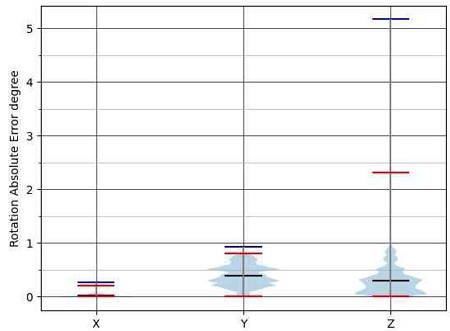

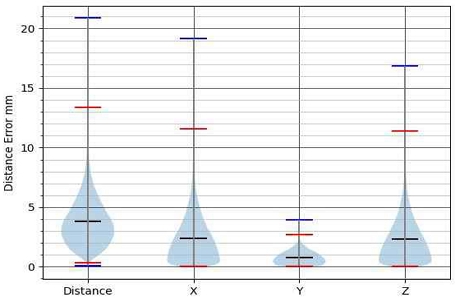

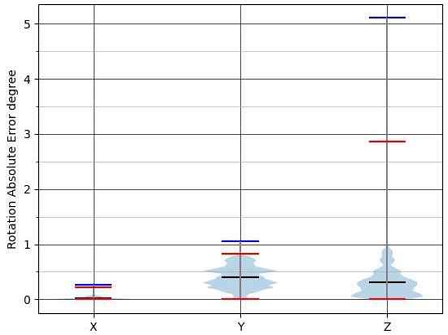

데이터 수집, 네트워크 모델 설계 및 네트워크 모델 테스트 과정은 모두 Windows 10 운영체제와 NVIDIA RTX 3050에서 수행되었다. HMD장치는 Hololens2가 사용되었고, 햅틱 장치는 Touch 3D가 사용되었다. 펜의 6 자유도를 제외한 모든 수집 데이터는 Unity를 사용한 가상 환경 world 좌표계를 사용하였다. 펜의 6 자유도는 햅틱 장치의 local 좌표계를 사용하였다. 실험 결과의 시각화를 진행한 각 그래프에서 검은 색 선은 평균을 파란색 선은 최소와 최댓값을 빨간색 선은 결과값 중 0.001%와 0.999%를 의미한다.

4-2 네트워크 모델 성능 평가

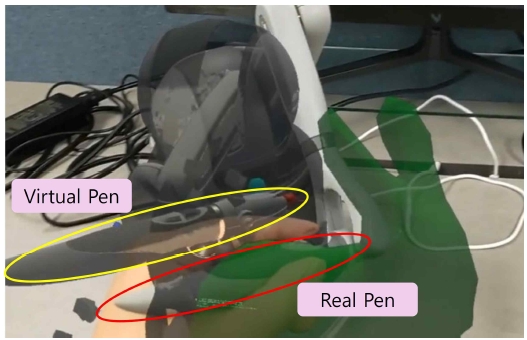

생성한 740,000개의 데이터는 네트워크 학습과 테스트를 위해 4:1의 비율로 나누었다. 학습한 네트워크를 사용하여 현실 세계의 햅틱 장치 위에 가상의 햅틱 장치를 정합한 결과는 그림 7과 같다.

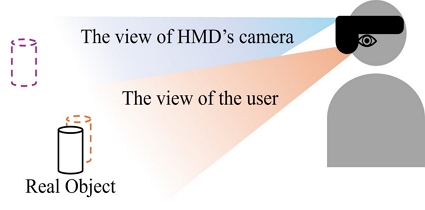

그림 7에서 정합이 잘 이루어지지 않은 것처럼 보이지만 이는 실험 결과를 촬영할 때 HMD의 카메라를 사용하기 때문에 발생하는 현상이다. 그림 8에서와 같이 HMD를 착용한 사용자는 정합이 되어있는 장면을 보게 되지만 실제 사용자의 눈의 위치나 각도와 차이가 있는 HMD의 카메라를 사용해서 촬영이 이루어지기 때문에 사용자의 시야와 HMD에 장착된 카메라 시야의 차이가 발생하게 된다. 이에 따라 촬영된 사진에서 실제 햅틱 장치와 정합이 이루어진 가상의 햅틱 장치가 정합이 이루어지지 않은 모습으로 보인다.

네트워크 모델을 테스트한 결과 위치에 대한 거리 오차의 평균은 3.28 mm였다. 또한 각 축별 거리 오차의 평균은 x축, y축, z축 순서대로 1.98 mm, 0.764 mm, 2.01 mm였다 (그림 9). 회전 오차에 대한 값은 오차의 크기를 분석하기 위해 0 ° ~ 180 ° 사이의 값으로 변환하여 분석을 진행하였다. 각 축별 회전 오차의 평균은 x축, y축, z축 순서대로 0.0273 °, 0.393 °, 0.302 °였다 (그림 10).

4-3 벡터의 구역이 중복된 경우 성능 평가

사용자가 6개의 벡터 입력을 줄 때 구역이 겹치는 경우가 발생할 수 있다. 구역이 겹친 벡터가 입력 데이터에 존재하는 경우 네트워크 모델의 성능에 미치는 영향을 판단하기 위해 그림과 같이 구역을 겹쳐 데이터를 추출하여 입력 데이터 셋을 생성하여 실험을 진행하였다. 입력 데이터 셋은 1개의 구역만 중복되어 있으며, 구역의 중복과 관계없이 구역의 순서는 유지하였다 (그림 11).

실험 결과 위치에 대한 거리 오차의 평균은 3.83 mm였다. 각 축별 거리 오차의 평균은 x축, y축, z축 순서대로 2.38 mm, 0.781 mm, 2.30 mm였다 (그림 12). 각 축별 회전 오차의 평균은 x축, y축, z축 순서대로 0.0272 °, 0.396 °, 0.314 °였다 (그림 13). 구역이 겹치지 않은 경우의 결과와 비교를 위해 거리 오차, 각 축별 거리 오차, 각 축별 회전 오차의 평균을 표 1에 정리하였다. 제안한 방법은 거리오차에서 사용자의 실수로 입력이 겹친 경우에도 오차가 16.8% 증가한 결과를 보여준다. 따라서 사용자의 실수로 입력 구역이 겹친 경우에도 오차가 크게 증가하지 않음을 볼 수 있다.

Ⅴ. 결 론

본 논문에서는 마커, 외부 트래커 또는 외부 카메라를 사용하지 않고 햅틱 장치 베이스의 6 자유도를 추정하기 위한 딥러닝 기반 네트워크 모델을 제안하였다. 제안한 방법은 사용자로부터 6개의 입력 벡터를 받아 하나의 벡터로 처리하여 네트워크 모델에 입력으로 전달하게 되고 햅틱 장치 base의 6자유도 위치를 추정한다. 모델의 정확도 실험 결과는 위치에 대한 거리 오차 1.54 cm 이내, 회전 오차 5.17 ° 이내임을 보여주었다. 또한 사용자의 실수로 인해 구역이 겹쳐진 입력의 경우 위치에 대한 거리 오차의 평균은 3.83 mm 였다. 이는 구역이 겹치지 않았을 때의 값인 3.28 mm 보다 0.55 mm 증가한 값으로 기존 오차 대비 16.8 % 증가한 오차를 보여준다. 제안한 방법을 사용해 가상현실을 정합할 때 사용자의 실수로 인해 입력이 겹치더라도 큰 성능 저하를 보이지 않는다. 또한 제안된 방법은 외부 트래커에 의존하지 않으므로 손 추적 기능이 있는 HMD 및 바닥 고정형 햅틱 장치 혹은 로봇에 적용하여 다양한 혼합현실 기반 응용 프로그램 개발에 활용될 수 있다.

Acknowledgments

본 연구는 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원(No. 2022R1F1A1072309, 50%), 정보통신기획평가원의 지원을 받아 수행된 지역지능화혁신인재양성사업(IITP-2024-RS-2022-00156287, 30%) 및 전남대학교 학술연구비(과제번호: 2022-2596, 20%) 지원으로 수행되었음.

References

-

I. Bortone, M. Barsotti, D. Leonardis, A. Crecchi, A. Tozzini, L. Bonfiglio, and A. Frisoli, “Immersive Virtual Environments and Wearable Haptic Devices in Rehabilitation of Children with Neuromotor Impairments: A Single-blind Randomized Controlled Crossover Pilot Study,” Journal of NeuroEngineering and Rehabilitation, Vol. 17, 144, October 2020.

[https://doi.org/10.1186/s12984-020-00771-6]

-

J. Jose, R. Unnikrishnan, D. Marshall, and R. R. Bhavani, “Haptic Simulations for Training Plumbing Skills,” in Proceedings of 2014 IEEE International Symposium on Haptic, Audio and Visual Environments and Games (HAVE), Richardson: TX, pp. 65-70, October 2014.

[https://doi.org/10.1109/HAVE.2014.6954333]

-

J. Li, C. Yang, L. Ding, B. You, W. Li, X. Zhang, and H. Gao, “Trilateral Shared Control of a Dual-User Haptic Tele-Training System for a Hexapod Robot with Adaptive Authority Adjustment,” IEEE Transactions on Automation Science and Engineering, June 2024.

[https://doi.org/10.1109/TASE.2024.3410522]

-

U. Radhakrishnan, L. Kuang, K. Koumaditis, F. Chinello, and C. Pacchierotti, “Haptic Feedback, Performance and Arousal: A Comparison Study in an Immersive VR Motor Skill Training Task,” IEEE Transactions on Haptics, Vol. 17, No. 2, pp. 249-262, April-June 2024.

[https://doi.org/10.1109/TOH.2023.3319034]

-

A. Widmer and Y. Hu, “Effects of the Alignment between a Haptic Device and Visual Display on the Perception of Object Softness,” IEEE Transactions on Systems, Man, and Cybernetics - Part A: Systems and Humans, Vol. 40, No. 6, pp. 1146-1155, November 2010.

[https://doi.org/10.1109/TSMCA.2010.2045370]

-

C.-G. Lee, I. Oakley, E.-S. Kim, and J. Ryu, “Impact of Visual-Haptic Spatial Discrepancy on Targeting Performance,” IEEE Transactions on Systems, Man, and Cybernetics: Systems, Vol. 46, No. 8, pp. 1098-1108, August 2016.

[https://doi.org/10.1109/TSMC.2015.2468675]

-

I. Soares, R. B. Sousa, M. Petry, and A. P. Moreira, “Accuracy and Repeatability Tests on HoloLens 2 and HTC Vive,” Multimodal Technologies and Interaction, Vol. 5, No. 8, 47, August 2021.

[https://doi.org/10.3390/mti5080047]

-

U. Eck, F. Pankratz, C. Sandor, G. Klinker, and H. Laga, “Precise Haptic Device Co-Location for Visuo-Haptic Augmented Reality,” IEEE Transactions on Visualization and Computer Graphics, Vol. 21, No. 12, pp. 1427-1441, December 2015.

[https://doi.org/10.1109/TVCG.2015.2480087]

-

H. Kato and M. Billinghurst, “Marker Tracking and HMD Calibration for a Video-Based Augmented Reality Conferencing System,” in Proceedings of the 2nd IEEE and ACM International Workshop on Augmented Reality (IWAR ’99), San Francisco: CA, pp. 85-94, October 1999.

[https://doi.org/10.1109/IWAR.1999.803809]

-

M. von Atzigen, F. Liebmann, A. Hoch, D. E. Bauer, J. G. Snedeker, M. Farshad, and P. Fürnstahl, “HoloYolo: A Proof-of-Concept Study for Marker-Less Surgical Navigation of Spinal Rod Implants with Augmented Reality and On-Device Machine Learning,” The International Journal of Medical Robotics and Computer Assisted Surgery, Vol. 17, No. 1, pp. 1-10, February 2021.

[https://doi.org/10.1002/rcs.2184]

-

J. Fu, M. C. Palumbo, E. Iovene, Q. Liu, I. Burzo, A. Redaelli, ... and E. De Momi, “Augmented Reality-Assisted Robot Learning Framework for Minimally Invasive Surgery Task,” in Proceedings of 2023 IEEE International Conference on Robotics and Automation (ICRA), London, UK, pp. 11647-11653, May-June 2023.

[https://doi.org/10.1109/ICRA48891.2023.10160285]

-

Y. Labbé, J. Carpentier, M. Aubry, and J. Sivic, “Single-view Robot Pose and Joint Angle Estimation Via Render & Compare,” in Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville: TN, pp. 1654-1663, June 2021.

[https://doi.org/10.1109/CVPR46437.2021.00170]

- H. Yong and M. Kim, “Deep Neural Network Based Alignment Method for Trackless Visuo-Haptic Mixed Reality,” in Proceedings of the 38th ICROS Annual Conference, Samcheok, pp. 405-406, June 2023.

저자소개

2019년~현 재: 전남대학교 컴퓨터정보통신공학과(학사)

2022년~현 재: VHMR 학부연구생

※관심분야:컴퓨터 비전(Coumputer vision), 혼합 현실(Mixed reality), 증강현실(Augmented reality), 시뮬레이션(Simulation), 인공지능

2022년~2024년: VHMR 학부연구생

2019년~현 재: 전남대학교 컴퓨터정보통신공학과(학사)

※관심분야:컴퓨터 비전(Coumputer vision), 혼합 현실(Mixed reality), 증강현실(Augmented reality), 시뮬레이션(Simulation), 인공지능

2010년:부산대학교 기계공학부(학사)

2012년:한국과학기술원 기계항공시스템공학부(석사)

2019년:한국과학기술원 기계공학과(박사)

2019년: 한국과학기술원 연수연구원

2019년~2021년: Imperial College London, Research Associate

2022년~현 재: 전남대학교 컴퓨터정보통신공학과 조교수

※관심분야:가상현실(Virtual reality), 증강현실(Augmented reality), 햅틱(Haptic)