유아용 인공지능 동반자의 사회적 특성 연구

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

인공지능 동반자 기술은 자연스러운 상호작용과 대화기술을 통해 사용자와 정서적 관계를 형성하는 사회적 동반자로 진화하고 있다. 본 연구는 유아와 음성 대화로 상호작용하는 인공지능 동반자의 사회적 역할을 조명하며, 유아용 인공지능 동반자의 사회적 특성 및 구현 기능을 도출하고자 하였다. 문헌 검토를 통해 인공지능 동반자 기술의 혜택과 위험 요소를 검토하여 유아의 동반자로서 인공지능 기술이 지향해야 하는 사회적 특성을 도출하였다. 이어서 사례분석을 토대로 사회적 특성별 구현 기능을 구체화하였다. 연구 결과, 유아용 인공지능 동반자의 사회적 특성은 포용적ㆍ윤리적 대화기술, 유아친화적 외형ㆍ상호작용, 감정반응ㆍ정서지원, 건전한 관계형성, 동기부여ㆍ설득기술, 개인화ㆍ연속성의 6개 특성으로 구체화 되었으며 특성을 구현하는 세부 기능이 도출되었다. 사회적 특성을 바탕으로 구현된 인공지능 동반자와의 상호작용을 통해 유아는 사회적 교류 방식을 학습하여 사회정서적 역량을 향상할 수 있으며 건강한 발달과 성장을 돕는 정서적 지원을 제공받을 수 있다.

Abstract

The evolving field of AI companion technology is increasingly focused on creating sociable companions capable of forming emotional connections with users through natural interactions. This study investigates the social roles of AI companions in voice conversation with children, aiming to identify their social features and implementation functions. Through a literature review, we explore the benefits and risks of AI companions, highlighting the desired social features that these companions should exhibit when interacting with children. A case study further refined the implementation functions. Our findings identify six key social features for AI companions: inclusive and ethical conversation technology, child-friendly appearance and interactions, emotional response and support, fostering healthy relationships, motivational and persuasive techniques, and personalization with continuity. Interaction with AI companions offers children opportunities to hone communication skills and enhance social-emotional competencies, while providing emotional support that promotes healthy growth and development.

Keywords:

AI Companion for Children, Social Companion, Social Feature, Conversational AI technology, Socio-Technical Theory키워드:

유아용 인공지능 동반자, 사회적 동반자, 사회적 특성, 대화형 인공지능 기술, 사회기술이론Ⅰ. 서 론

인공지능 동반자란 일정 수준의 지능과 자율성, 사회적 기술 및 의사소통 능력을 보유하여 사용자와 장기적 관계를 구축하고 유지하는 광범위한 장치와 상호작용의 집합을 의미한다[1],[2]. 인공지능 동반자는 검색 서비스, 알림 설정, 날씨 확인, 노래 재생, 콘텐츠 추천 등 폭넓은 생활 서비스를 제공하며, 나아가 인간의 자연스러운 상호작용을 모방하는 대화형 인공지능 기술을 통해 사용자와 정서적 관계를 형성하는 사회적 동반자로 진화하고 있다[3],[4]. 특히, 거대 언어모델 및 생성형 기술과의 접목으로 인해 대화형 인공지능 기술의 세계 시장 규모가 2023년 107억 달러에서 2028년 298억 달러에 이를 것으로 예상되며[5], 사람의 감정을 분석하는 감성 컴퓨팅 기술의 발달과 함께 인공지능 동반자의 연구영역 또한 사용자의 감정을 이해하고 공감하여 친구처럼 자연스럽게 대화할 수 있는 사회적 상호작용 기술을 개발하기 위한 노력이 이어지고 있다[1].

인공지능 동반자는 활용목적, 외형, 체화(embodied) 여부 등을 기준으로 가상 대화 에이전트, 인공지능 어시스턴트, 디지털 컴패니언, 소셜 로봇 등 다양한 명칭으로 지칭된다. 사람, 동물 등의 형태로 체화되어 인간을 모방한 의사소통 능력과 감정을 표현하며[4],[6], 사용자 상태와 대화 맥락을 판단하고 상황에 적합한 매력적인 상호작용을 제공함에 따라 사용자와 긴밀하고 개인화된 관계적 역할을 형성한다. 인공지능 동반자는 지능화되고 사회정서적인 상호작용을 통해 사용자와 연속적이며 장기적인 관계를 구축하며, 이는 단기적 문제해결을 위한 텍스트 기반 대화 매체인 챗봇 시스템과 차별화되는 부분이라고 할 수 있다.

유아용 인공지능 동반자는 생활 모니터링, 건강 관리, 치료, 교육ㆍ학습, 놀이 및 여가 등 서비스를 제공하며 유해정보 차단, 미디어 노출 감소, 놀이 기반 학습 등의 효익을 제공한다. 유아용 인공지능 동반자는 유아의 사회적 신호와 언어, 또는 비언어적 행동을 포착하고 감지하여 그에 따라 반응하거나, 저연령층의 불완전한 음성과 자연어를 유연하게 인식하여 친화적인 방식으로 유아와 상호작용할 수 있다. 또한 대화 친구 또는 상호작용 매체로써 유아가 자신의 감정과 경험을 더욱 쉽게 표현하도록 유도할 수 있으며, 사회적 불안과 긴장을 완화하고, 심리상태와 건강을 진단하고 치료하거나, 대인 상호작용을 중재하고 참여를 강화하도록 동기를 부여하는 수단으로 활용되곤 한다[4],[7]. 이에 따라 ‘나’는 누구이며 무엇인가를 깨닫고 타인 및 사회적 존재와의 상호작용을 통해 자신과 타인의 정서를 본격적으로 인식하고 표현하기 시작하는 만 3~5세가량의 영유아 시기에 있어, 인공지능 동반자와의 교류는 유아의 감정표현 능력과 사회정서적 역량을 향상하고 건강한 발달과 성장을 돕는 정서적 지원을 제공할 수 있다.

이러한 배경에서 본 연구는 유아용 인공지능 동반자의 개념적 범위를 만 3~5세가량의 유아와 일상적인 환경에서 음성 대화를 통해 상호작용하며, 사회정서적 지원을 제공하여 유아의 발달과 성장을 돕는 사회적 동반자로 가정하였으며, 유아용 인공지능 동반자가 사회적 동반자로 기능하는 데 필요한 사회적 특성 및 구현 기능을 도출하는 것을 목적으로 하였다. 연구목적을 달성하기 위하여 본 연구는 다음과 같은 순서로 진행되었다.

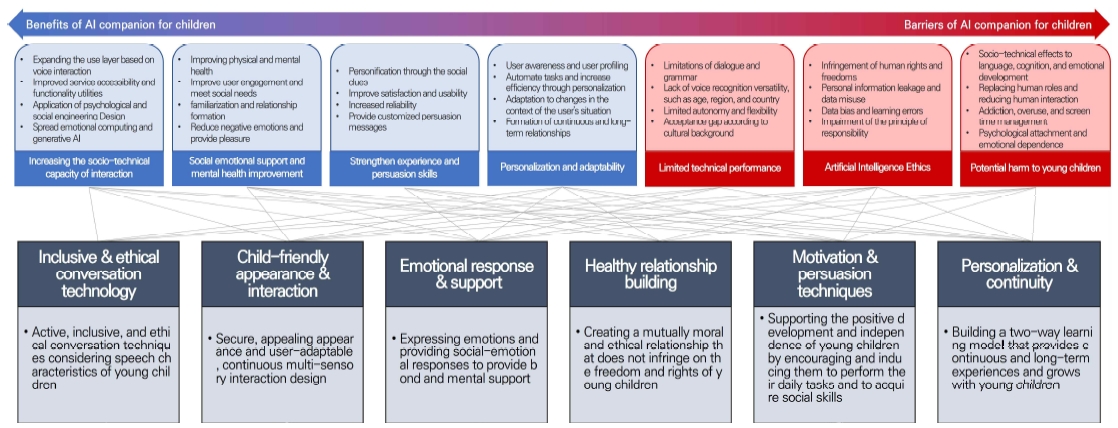

첫째, 문헌 검토를 통해 유아용 인공지능 동반자의 사회적 특성을 정의하였다. 인공지능 동반자가 유아의 사회적 동반자로서 기능하기 위한 가치 설계 과정으로써 사회적 특성을 정의하기 위해 인공지능 동반자 기술의 혜택과 위험 요소를 식별하였다. 인공지능 동반자 기술의 사회기술적 역량 향상에 따른 기능적 혜택을 검토하였으며 인공지능 윤리 등 유아용 인공지능 동반자 활용에 경계가 필요한 위험 요소를 도출하였다. 이후 식별된 혜택 및 위험 요소를 바탕으로 유아용 인공지능 동반자의 사회적 특성을 6개 영역으로 도출하였다.

문헌 검토 범위는 인공지능 대화 에이전트, 소셜 로봇, 디지털 컴패니언, 로봇 펫, 스마트토이 등 유아용 인공지능 동반자의 관련 기술에 대한 포괄적 접근을 취하며, 인공지능 동반자의 사회적 특성에 관련된 분야별 의제를 반영하고자 관련 기술에 대한 기능적 혜택, 위험 요소 및 윤리적 요구사항 등을 제시한 문헌을 대상으로 하였다. 검토 내용 내 개인정보보호 등 윤리 이슈를 일부 포괄하나 연구의 범위가 인공지능 동반자의 사회적 기능에 한정됨에 따라 데이터 처리기술, 보안, 비용 등의 의제는 다루지 아니하였다.

둘째, 사례분석을 통해 유아용 인공지능 동반자의 사회적 특성에 따른 구현 기능을 구체화하였다. 사례분석의 대상은 유아와 음성 대화 상호작용이 가능하고 사회정서적 지원에 특화된 목적성을 가진 인공지능 동반자이며, 분석의 자료로써 매뉴얼, 시연 영상, 사용자 리뷰, 특허문서 등을 수집하였다. 문헌 검토를 통해 6개 특성 15개 기능에 대한 분석의 틀을 작성하였으며 사례분석을 통해 유아용 인공지능 동반자의 사회적 특성 및 구현 기능을 구체화하였다.

Ⅱ. 이론적 고찰

2-1 사회기술이론(socio-technical theory)

4차 산업혁명으로 명명된 현대 시대는 인간과 기계가 협력하고 상호작용하며 공생하는 복잡한 시스템 환경이다. 인간과 기계의 상호작용은 사회기술적 변화에 의해 지배되는 중요한 관계로 인간을 보다 효과적으로 돕기 위한 지원을 제공한다. 하지만 새로운 상호작용 기술에 대한 높은 기대에도 불구하고 많은 실패가 공존하는 것이 사실이다. 복잡한 시스템 환경에서 무분별하게 기술을 도입하는 것은 사회학적 문제를 유발하기 때문에 기술을 설계하고 구현하는 과정에 사용자의 행동과 인식 문제를 고려할 필요가 있으며, 이러한 사고는 사회기술이론의 정착으로 이어졌다[8].

이는 인간과 기술 사이의 상호작용에 관한 접근으로 새로운 기술과 변화를 구현하기 위하여 기계의 내부 요소만이 아닌 인간적 요소와 사회적, 기술적, 조직적 요소 간의 복잡한 상호관계를 고려하는 발상에 근거한다. 사회기술이론은 하드웨어, 데이터, 인터페이스 등 기술적 요소와 인적요소, 프로세스, 규칙과 문화, 제도 및 정책 등 사회 시스템 전반에 대한 포괄적이며 다학제적 관점을 바탕으로 신기술이 채택되고 사용되는 방식에 대한 이해와 기술의 복잡한 가치 형성과정의 유용한 프레임워크로 작용한다. 특히 신기술에 대한 기대와 실제 채택 사이의 변동성을 설명하고, 새로운 기술 도입을 위한 장벽을 사전에 식별하여 신기술의 이점의 가치와 채택 장벽 사이의 격차를 해소하는 통찰력을 제공한다[9].

2-2 인공지능 동반자

인공지능 동반자는 인간의 자연어와 대화를 매체로 복잡한 정보를 교환하고 효과적으로 처리하여 발화의 의도를 이해하고 적절한 답변과 행동을 취해 사용자를 돕는 기술이다[10]. 이는 음성인식, 자연어 처리, 기계학습, 딥러닝, 대화 처리기술을 단일 플랫폼으로 결합한 것으로[11], 최근 생성형 인공지능 기술이 다양한 분야에서 활용됨에 따라 인공지능 동반자 또한 복잡한 질의에 실시간 응답하고 맞춤형 제안을 제공하는 사용자 인터페이스로 활용되고 있다. 특히 고도화된 추론 능력과 내부 지식 기반을 통해 질의에 최적화된 응답을 자동 작성하며, 지속적인 학습을 거쳐 처리할 수 있는 대화의 범위가 넓어지는 확장성을 보유한다는 강점을 가진다[12].

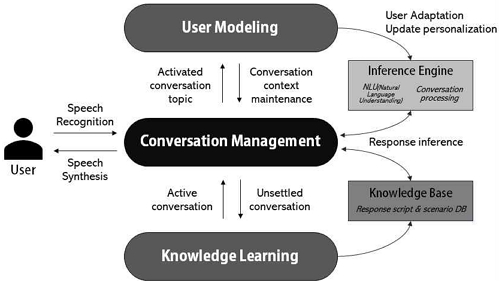

인공지능 동반자는 일반적으로 대화 관리, 지식 학습, 사용자 모델링, 추론 엔진과 지식 구조로 구성된다[13]. 대화 관리 모듈은 대화를 분석하여 적절한 응답을 제공하고, 지식 학습 모듈은 대화 관리 모듈에서 처리되지 못한 발화내용과 정보를 획득하고 새로운 응답을 생성하며, 사용자 모델링 모듈은 발화의도를 분석하고 추론 엔진을 갱신하여 사용자에 적응된 응답 추론을 가능하게 한다. 추론 엔진은 발화내용을 분석하여 사용자 의도를 파악하고, 지식 구조에는 대화 시나리오와 응답 스크립트가 저장·관리된다(그림 1).

2-3 유아용 인공지능 동반자의 기능적 혜택

인공지능 동반자는 단순한 질의응답 도구가 아닌 장기적이며 감정적 투자를 일으키는 상호의존적 매체로 발전하고 있다. 인공지능 동반자 기술의 발전에 따른 주요 기능적 혜택은 다음과 같다. 첫째, 인공지능 동반자의 기능은 작업 중심 패러다임에서 상호작용 중심으로 이동하고 있다. 인공지능 동반자 기술은 강화된 상호작용을 통해 작업 능률과 사용자 경험을 향상하거나, 상호작용 자체를 핵심 기능으로 하도록 사회기술적 역량이 증가하고 있다. 초기 인공지능 동반자는 제한적인 상호작용을 바탕으로 작업을 단순 보조하거나 자동화하여 사용자의 신체활동을 돕는 기능적 역할에 주목했으나, 자연어 처리 기술의 발달 및 감성 컴퓨팅, 알고리즘 및 학습모델 고도화 등 동반자 기능이 향상됨에 따라 보다 사회적·관계적 역할을 수행하도록 기능의 영역이 확장되고 있다[1],[4].

둘째, 인공지능 동반자의 강화된 사회적 상호작용은 사용자에게 기능적 효익만이 아닌 정서적 지원 효과를 제공한다. 대표적인 사례로 소셜 로봇은 인간을 모방한 행동규범 및 매력적인 외양을 활용하여 사용자와 상호작용하며, 사용자 참여 증가, 감정 완화, 인지된 사회적 지원 증가, 삶의 질 향상 등 정신건강 개선에 기여하는 것으로 알려져 있다[7]. 이와 관련하여 Hurst et al.[14]은 소셜로봇과 상호작용한 자폐아동이 감정 조절, 자존감, 대화·우정 기술, 눈맞춤 등에 있어 개선을 보이는 것을 보고한 바 있다.

셋째, 강력한 상호작용 기술로 의인화(personification)된 인공지능 동반자는 사용자 경험을 확장하고 강력한 설득기술을 제공한다. 의인화란 비인간 개체에 인간적 모습을 부여하거나 인간을 모방한 상호작용 요소들을 적용하여 사용자들이 개체에 인간을 투영하고 상호작용할 수 있도록 만드는 것으로 정의된다[15]. 인공지능 동반자가 더 인간적이고 상호작용적일수록 사용자 신뢰도가 증가하는 경향이 있으며, 인공지능 동반자를 비서, 동료, 가족, 친구 등의 형태로 의인화하여 인식한 사용자 집단이 단순히 장치로 취급한 집단보다 더 긍정적인 평가를 보이는 것으로 알려져 있다[1].

넷째, 연속적이며 장기적 경험을 형성한다. 인공지능 동반자의 개인화 기술은 단기 기억만이 가능한 챗봇 시스템과 차별화된 사회적 역량을 보유한다. 예를 들어, 네이버 클로바(CLOVA) 케어콜은 인공지능이 돌봄 대상과의 대화 내역 중 관리가 필요한 중요 정보(부상, 병원 예약 정보 등)를 자동으로 식별하고 기억하여 다음 대화에서 이를 질문하고 대상의 건강 상태를 자동으로 갱신, 추적하는 연속적이며 사용자 맞춤화된 건강 모니터링을 가능하게 한다. 또한 Sony사의 대표 동반자 로봇인 Aibo는 사전 프로그래밍 된 명령에만 반응하는 구모델의 한계를 극복하고자 사용자의 표정과 목소리, 일과 패턴을 기억하고 학습하여 사용자에게 맞춤화된 독자적인 성격을 구축해나가는 신규 동반자 모델을 선보인 바 있다.

2-4 유아용 인공지능 동반자의 위험 요소 및 해결 과제

인공지능 기술에 대한 기대가 증가하고 있음에도 인공지능 기술의 유아 대상 활용에는 아직 큰 우려가 제기되고 있다. 첫째, 거대 언어모델 및 생성형 기술의 빠른 확산에도 불구하고 인공지능 동반자 기술은 음성인식 및 대화맥락 파악 측면에서 아직 제한된 성능을 보인다. 특히 성인과 달리 발음구조와 언어능력이 제한된 유아용 인공지능 동반자는 한층 더 높은 수준의 판단 능력을 요구받는다. 실제로 관련 연구에서 유아 음성인식의 정확도가 성인 대비 절반에 그치는 것으로 보고된 바 있다[16]. 이에 포괄적, 범용적인 인공지능 대화모델을 구축하기 위해 국가, 지역(사투리), 연령, 발달수준 등 다양한 발화 스펙트럼에 관한 연구가 이루어지고 있으며, 관련 사례로써 구글 대화 어시스턴트는 연령 및 어휘발달 수준을 사전에 그룹화하여 그룹별 대화모델을 설계, 발화자의 연령 및 언어발달 수준을 측정하여 맞춤형 대화모델을 제공한다.

둘째, 인공지능 개발과 데이터 활용 전 주기에서의 윤리 훼손에 관한 우려가 제기되고 있다. 많은 이들이 인간 권리와 자유 침해, 개인정보의 유출 및 오용, 알고리즘 편향과 오류, 책임 원칙의 훼손 등 인공지능의 무분별한 사용이 낳는 위험을 경계해야 함을 주장하고 있다. 윤리적이며 책임 있는 인공지능에 대한 선행적 이해와 체계적 계획이 반영되지 않을 경우, 인공지능이 정제되지 않은 대화를 학습하여 인종적·성적 차별 발언을 하거나, 욕설이나 비속어를 사용하는 등 의도되지 않은 문제가 발생할 수 있다. 인공지능에 의해 보편적 가치가 훼손되지 않도록 법적·제도적·기술적 조치를 마련할 필요성이 증가함에 따라 전 세계적으로 인공지능 윤리 담론이 형성되고 있다. 예를 들어, 과학기술정보통신부는 인공지능 윤리기준을 마련하여 인공지능의 개발·활용 원칙을 인권 보장, 프라이버시 보호, 다양성 존중, 침해금지, 공공성, 연대성, 데이터 관리, 책임성, 안전성, 투명성 등으로 제시하였다. 또한 유니세프, 세계경제포럼 등 취약계층인 어린이와 청소년을 위한 범국가적 인공지능 가이드라인이 개발되고 있으며, 유아의 발달과 차별 없는 행복을 지원하는 인공지능의 원칙을 포용성, 공정성, 책임성, 안전성 등으로 제시하고 있다.

셋째, 인공지능이 유아의 사회정서 발달에 미치는 예측 불가한 잠재적 영향에 관한 우려가 존재한다. 인공지능과의 장기적 상호작용이 유아에게 어떤 영향을 미치는지 충분히 알려지지 않았으며, 정서지능이 발달하는 시기의 영유아에게 불완전한 감정적 상호작용을 지속적으로 노출하는 것에 대한 경각심이 요구된다[17]. 인공지능이 인간의 직업을 대체하는 것에 대한 경계가 확산되는 것과 같이 인공지능 대화 서비스가 인간 사이의 상호작용을 감소시킬 것이라는 우려 또한 제기되고 있다[18]. 또한 유아의 스마트기기에 대한 과사용·중독 문제가 불거지는 가운데 인공지능 동반자를 전통적인 미디어와 어떻게 구분하고, 스크린 타임을 어떻게 정의하여 체계적으로 관리할 것인가에 대한 고민이 필요하다[19].

2-5 유아용 인공지능 동반자의 사회적 특성 도출

기술을 사용함으로써 얻어지는 혜택과 희생은 기술의 수용을 직·간접적으로 결정하는 가치를 형성하며[20], 제품과 서비스의 가치는 예상되는 이익을 강화하고 고통을 최소화하는 방향으로 설계되었을 때 가장 극대화될 수 있다[21]. 본 연구는 유아용 인공지능 동반자의 혜택 및 위험 요소에 대한 고찰을 기반으로 유아의 일상생활을 지원하고 사회정서 발달을 촉진하는 유아용 인공지능 동반자의 사회적 특성을 다음과 같이 정의하고자 한다(그림 2).

첫째, 유아용 인공지능 동반자는 유아의 발화특징을 고려하여 능동적이고 포용적이며 윤리적인 대화기술을 보유해야 한다. 유아의 발화 특성과 오류에 유연하게 대응하도록 연령별 어휘사전, 대화 맥락 분석에 근거하여 음성인식 정확도를 향상하고 지속적으로 학습한다. 대화 출력단계에서 연령별 단어사전에 근거한 쉬운 어휘를 활용하고, 불명확한 어휘와 발음에 대해 유아에게 개선방안을 제안하는 것이 권장된다. 또한 유아를 보호하기 위해 사회적 규범을 준수하는 윤리적이며 보수적인 대화모델을 구축할 필요가 있다. 특히 생성형 대화모델의 활용이 증가함에 따라 공격성 언어 탐지, 부적절한 대화주제의 블랙리스트화, 학습데이터 편향성 제거 등을 통한 윤리적 대화모델에 대한 수요는 더욱 높아질 것이다.

둘째, 안전하고 호소력 있는 외형과 유아의 특성에 쉽게 적응가능하며 연속적인 다감각적 상호작용을 구현해야 한다. 일반적으로 인공지능 동반자가 로봇 등의 형태로 실체화되는 경우가 가상의 모델보다 사용자 수용에 긍정적 영향을 미친다[24]. 특히 외형적 요소는 유아가 인공지능 동반자를 친근하게 받아들이는 데 중요한 역할을 하므로[25], 인공지능 동반자의 외형 설계 시 유아의 선호를 비롯한 경험적 데이터를 충분히 반영해야 한다[19]. 외형은 유아에게 편안하고 친근하며 안전하도록 공인된 안전기준을 준수해야 하며 섬유 등 사용자친화적인 소재를 활용하는 것이 권장된다.

또한 계속해서 새로운 자극을 찾는 유아의 지속적 참여를 유도하기 위해 상호작용 유지전략을 수립해야 한다. 대화가 일시 중단된 상황을 완화하고 장기적인 사용을 유도하도록 인사하기, 감정 표현하기, 응답을 유도하는 짧고 순환적인 질문하기, 사용자 발화내용 모방하기 등 일상적이며 전략적인 상호작용 설계가 필요하다[26]. 이때 시·청각, 촉각(행동) 등 유아의 다양한 감각을 자극하는 방식이 고려될 수 있다.

셋째, 경청, 공감, 이해 등 감정 상호작용을 통해 유대감을 형성하며 사회정서적 지원을 제공한다. 특히 유아는 적극적인 상호작용이 가능한 생명체와 함께 있을 때 관심도와 참여도를 높일 수 있으므로 눈 마주치기, 인사하기, 미소 짓기, 자세 변화하기 등 인간을 모방한 사회적 단서를 활용하거나[3],[25], 유머를 사용하거나 유아의 과거와 미래에 관해 이야기하는 등 관계적 의사소통을 구현하는 것이 효과적이다[2]. 또한 경청하기, 되묻기, 공감하기, 위로하기 등 유아의 감정상태 및 대화맥락에 맞게 동적으로 반응하는 공감기술[27]은 유아와 감정적·공감적 연결을 형성하는 데 도움이 될 수 있다. 이러한 인공지능 동반자의 감정반응은 감정인식·관리 시스템으로 관리되어 사용자의 상태에 적응하는 유동적인 시스템으로 구현될 수 있으며 시스템의 적응성이 높을수록 사용자의 상황적 맥락에 더욱 민감하게 반응할 수 있다[6].

넷째, 유아와 동반자는 상호도덕적이며 윤리적인 건전한 관계를 형성하도록 계획되어야 한다. 앞서 논의한 특성들은 유아의 자립과 행복한 일상을 돕고 건강한 사회정서 발달을 이루는데 기여하는 원칙 아래에 구현되어야 한다. 따라서 동반자의 성격, 성별, 음성특성, 말투 등 대화모델 페르소나와 동반자의 외형은 유아의 가치관 형성 및 정서 발달에 해가 되지 않도록 중립적이며 긍정적으로 설계되어야 한다. 또한 사회기술 및 인간적 행위를 모방하는 인공지능 동반자는 보호자, 친구 등 유아의 인간관계를 대체하는 것이 아닌, 부족한 부분을 보완하고 보조하는 목적성을 가져야 한다[18]. 따라서 인공지능 동반자의 역할 목표와 범위를 사전에 명확히 설정하고 가장 효과적으로 사용하는 방법을 모색해야 하며 동반자의 사용범위, 유아와의 적정 상호작용 수준과 권장 접촉시간을 면밀하게 검토하여 사용 지침으로써 제공해야 한다.

다섯째, 유아의 일과 수행 및 사회기술 습득을 장려·유도할 수 있는 동기부여 및 설득기술을 보유해야 한다. 사전에 수립된 사회적 관계와 신뢰성이 설득에 핵심적인 역할을 한다[2]. 인공지능 동반자는 유아와의 사회적 관계 속에서 유아의 정서적 상황과 요구에 대응하는 맞춤형 조언을 제공하고, 유아가 이에 반응하여 일과를 수행할 시 적절한 정서적 지지 반응과 보상을 제공해야 한다[25].

여섯째, 유아를 식별하거나 기억하여 연속적이며 장기적인 경험을 제공한다. 개인화 기술은 대화에 설득력을 제공하고 사용자 맞춤 서비스를 추천하는 데 효과적이며 서비스에 대한 신뢰성과 사용의도를 향상할 수 있다. 유아를 위한 인공지능 동반자는 유아의 건강한 발달을 돕기 위해 사용자와 장기적이며 연속적인 관계를 구축하여 유아와 함께 성장하는 유아-동반자 양방향 학습모델을 지향해야 한다[19]. 개인화 기술은 대화 문맥 기억, 맞춤형 대화, 사용 데이터 모니터링, 콘텐츠 추천 등 사용 데이터 분석을 통한 기능적 개인화 외에도 사용자의 이름 불러주기, 대화내용·관심주제 기억하기 등 개인정보와 사용 데이터 이력을 기억하여 대화에서 반복적으로 활용하는 정서적 개인화로도 구현될 수 있다.

Ⅲ. 유아용 인공지능 동반자 사례분석

3-1 사례 수집 방법

본 사례분석의 대상은 유아를 사회정서적으로 지원하는 인공지능 동반자로, 세부적인 사례 선정 기준은 다음과 같다.

첫째, 음성 인터페이스 기반 상호작용 및 대화식 의사소통이 가능하다. 음성을 녹음·재생하거나 서비스를 음성명령어로 단순 구동하는 방식의 단방향 서비스 사례는 제외하였다.

둘째, 사회정서적 지원 관련 서비스를 제공한다. 유아의 사회정서 발달수준을 진단하거나, 사회정서적 상호작용 및 지원을 제공하는 사례를 선별하고자 하였으며 코딩 로봇과 같이 관련성이 적은 교육·학습영역에 특화된 사례는 제외하였다.

셋째, 인공지능 학습모델을 탑재하여 사용 데이터를 학습하고 추적·관리한다. 화자를 식별하지 않고 데이터가 관리되지 않거나, 일회성 서비스에 한정된 사례는 제외하였다.

넷째, 로봇, 인형, 장난감 등 다양한 형태로 체화되어 유아와 물리적인 상호작용이 가능하다. 모바일 어플리케이션 등을 경유한 가상의 인공지능 대화 서비스는 범위에서 제외하였다.

다섯째, 최근 5년 이내 시장에 공개된 사례를 대상으로 하였다. 제품 매뉴얼, 홍보물 및 시연 영상, 실사용자 리뷰, 특허문서 등 사례에 관한 풍부한 정보를 수집하기 위하여 시장에 공개되어 소비자가 접근이 가능한 사례로 한정하였으며 연구개발 단계인 사례는 제외하였다.

위 기준을 토대로 연구자 판단에 의한 편의추출방식을 활용하여 사례를 선정하였다. 국내외 온라인 쇼핑 플랫폼을 중심으로 “AI companion”, “social robot”, “interactive smart robot”, “social companion robot”, “for children” 등 키워드를 조합하여 사례를 조사했으며, 선정 기준에 부합하며 유아의 사회정서적 지원에 특화된 대표 사례를 국내 1건, 해외 1건 도출하였다. 두 사례 모두 유아의 사회정서 지원 및 대화기반 상호작용을 수행함과 동시에 일부 대칭적이며 상호보완적인 특성을 가진 것으로 판단되어 본 사례분석 대상으로 최종 선정하였다. 선정된 사례는 다음과 같다(그림 3).

Moxie (2020)는 생성형 인공지능 및 컴퓨터 비전을 통해 신뢰할 수 있는 사회정서적 상호작용을 실현한 최초의 유아용 인공지능 동반자를 표방한다. 대화형 인공지능 외에 신체언어, 눈 맞춤, 감정·행동 분석, 콘텐츠 추천 등에 특화된 전용 플랫폼이 내장되어 놀이 기반 학습을 통해 감정으로 어려움을 겪는 유아를 지원하도록 설계되었다.

Cati (2023)는 3~7세 아동을 위한 인공지능 대화친구이다. 멀티턴 방식의 유아용 인공지능 챗봇이 내장되어 다양한 주제로 유아와 대화하여 친밀도를 높일 수 있다. 특히 유아의 언어, 정서, 창의력, 사회성 발달에 도움을 주도록 누리과정 기반의 교육 콘텐츠를 접목한 대화 서비스를 제공한다.

3-2 사례분석의 틀

이론적 고찰 단계에서 논의한 유아용 인공지능 동반자의 사회적 특성에 따른 구현 기능을 분석한다. 분석 기준은 문헌에서 활용된 기준을 준용하거나 조합하여 새로이 구축하였다. 모든 사례분석의 과정은 사례분석의 틀에 근거하여 연구자 2인의 자료 분류, 내용 정제, 교차 검토 및 합의를 통해 이루어졌다. 사례분석의 틀 및 분석 기준은 다음과 같다(표 1).

먼저, 포용적·윤리적 대화기술은 음성인식, 어휘, 대화 시나리오 구성 등 유아 발화특징을 고려한 대화모델 설계와 공격성 언어 탐지 및 학습방지 전략을 분석한다.

유아친화적 외형·상호작용은 동반자의 외관 형태, 소재 등의 유아친화적 외형 특성과 시·청각, 촉각 및 기타 감각을 자극하는 상호작용 방식과 상호작용이 발생하는 상황 조건을 조사하며, 음성인식 오류·발화의도 해석불가·침묵 등 상호작용 중단 상황에 대한 대처방식을 검토한다.감정반응·정서지원은 표정, 눈 마주치기, 인사하기, 미소짓기 등 인간을 모방하는 사회적 단서의 활용 방식과 유머, 유아의 감정 및 상태 확인 등 관계적 대화기술, 경청하기, 되묻기, 공감하기, 위로 하기 등 공감적 대화기술로 구성된다.

건전한 관계형성은 동반자의 음성특징, 성별설정 등 페르소나의 중립성을 조사하며, 그 외 인간의 역할을 대체하지 아니하는 목적 수립, 유아의 자유와 건전한 발달을 침해하지 않는 사용범위 설계로 구성된다.

동기부여·설득기술은 유아에게 제공되는 학습, 조언, 미션 등 사회정서적 지원을 위한 대화·콘텐츠 유형과 이와 연계된 동기부여 및 보상 체계를 조사한다.

마지막으로 개인화·연속성은 대화 문맥 유지, 맞춤형 콘텐츠, 반복작업 최적화 등 기능적 개인화와 사용자 이름, 관심주제·대화내용 기억하기 등 정서적 개인화 사례를 조사한다.

Ⅳ. 분석결과

4-1 유아용 인공지능 동반자의 사회적 특성 분석

포용적·윤리적 대화기술 특성의 첫 번째 항목인 유아 발화특징을 고려한 대화모델 설계의 관점에서, Moxie는 GPT-powered 대화형 인공지능을 탑재하여 거대 언어모델을 통해 상대적으로 폭넓은 대화 수용성을 보유하며, 연계된 아동 어휘사전(Merriam-Webster’s Dictionary for Children)을 활용하여 소통하도록 설계되었다.

이에 반해 Cati는 규칙기반 대화 시나리오를 통해 500개의 대화 주제 및 8,000개 문장을 사전 커리큘럼화하여 제공함에 따라 대화 주제의 수용 범위는 상대적으로 협소한 것으로 파악되었다. 반면 유아가 답변 시에만 마이크가 활성화되어 외부 소리를 차단하며, 유아에게 특화된 챗봇 엔진을 통해 부정확한 발음을 인식하고 발음 실수 패턴을 수집하여 음성인식 효율을 높이고자 하였다. 유아가 비구조화된 문장을 발화하여도 단어들의 조합을 통해 대화를 유지함으로써 언어발달 정도가 상이한 유아를 위한 맞춤형 대화를 제공한다.

공격성 언어 탐지 및 학습방지 전략의 관점에서 Moxie는 자체 대화 필터링 소프트웨어로 금지 주제 및 부적절한 콘텐츠를 줄이거나 제거하며, 죽음, 우울, 슬픔, 폭력 등 민감 주제에 대한 응답 반응을 모니터링하고 지속 업데이트하고 있다.

유아친화적 외형 특성의 관점에서, Moxie는 내구성이 강한 곡선형 실루엣을 가진 로봇 외형을 바탕으로 시각(표정 디스플레이), 청각 외에 머리, 귀, 팔, 손가락 등을 움직여 다감각적 상호작용을 제공하도록 설계되었다. 또한 카메라로 표정과 신체언어를 추적하여 반응하는 상호작용을 제공한다.

반면 Cati는 섬유 외피로 된 공룡 모양의 봉제 인형 외형으로, 내부에 블루투스 스피커가 내장되어 있어 효과음, 동요, 동화 읽어주기 등 청각 중심 상호작용에 특화되어 있으며 소리 크기와 동기화되어 움직이는 행동적 상호작용을 지원한다. 상대적으로 적은 상호작용 범위를 가지나 외피를 손쉽게 탈착할 수 있는 애착인형 컨셉을 지향하여 저연령 대상의 안전성과 내구성을 획득하고자 하였다.

상호작용 방식 및 발생조건의 관점에서, Moxie는 대기모드 종료(“Hello Moxie!”), 활동 중단(“Moxie, please go to sleep”), 음성인식 중단(“Moxie, earmuffs”) 및 재개(“Moxie, please listen to me”) 등 다양한 상황별 상호작용을 제어하는 음성명령어를 제공한다. 또한 사전 정의된 대화 주제 외에도 주변 사물을 인식하여 일상적 대화 주제로 활용할 수 있다. 예를 들어, 유아가 메고 있는 가방을 인식하여 가방의 내용물이 무엇인지 질문하며 책의 그림을 보고 감상을 남기고 유아의 의견을 묻기도 한다.

반면 Cati는 전용 어플리케이션을 통해 전반적인 상호작용을 제어한다. 대화를 개시하기 위해 동반자와 블루투스로 연결된 어플리케이션을 활성화하여야 하며, 사전 정의된 대화 주제 및 콘텐츠를 선택하여 유아에게 제공한다.

상호작용 중단 상황에 대한 대처방식의 관점에서, 두 사례 모두 동반자 주도적이며 능동적 대화를 통해 대화의 끊김을 방지하는 전략을 사용한다. Moxie는 역질문 장치(“what do you think about that?”), 대화 종료 및 화제전환 장치("I think we've talked about [ X ] enough, let's move on")를 활용하여 대화의 흐름을 유지하거나 자연스럽게 화제를 전환한다. Cati는 동반자 주도형 대화 모델로 동반자가 유아의 이름을 부르면서 대화를 시작한다. 음성인식에 실패했을 때 맥락에 맞는 대안적 응답을 제공하거나 자연스럽게 다른 이야기로 넘어가 대화를 계속 유도하는 방식으로 설계되었다.

사회적 단서의 활용 관점에서 두 사례 모두 웃음, 하품, 자세 변화 등 사회적 단서를 활용하여 살아 있는 생명체와 같이 체화된 동반자를 지향하며, 특히 이는 Moxie의 사례에서 두드러지게 나타났다. Moxie는 이목구비를 형상화한 얼굴 디스플레이를 통해 미소, 슬픔 등 10여 가지의 표정과 감정을 표현할 수 있으며 유아의 얼굴을 인식하여 다양한 각도에서 눈을 마주친다. 대화 중에 주변을 둘러보거나 고개를 숙이고 팔을 움직이는 등 지속적 움직임을 통해 생동감을 부여한다.

관계적 대화기술의 관점에서 Moxie는 정서지원에 특화된 사례로 유아의 참여도, 눈 마주침, 상호작용 기여도, 미소, 사회적 언어 활용, 관계적 언어사용, 긍·부정 언어사용 등 다양한 행동지표를 관리하며, 유아가 감정을 처리하고 표현하는 방식을 지도한다. 예를 들어, 슬픔을 수용하고 처리하는 방법을 지도하기 위해 긍정적인 감정을 가지는 방법을 알려주고 명상, 호흡 운동을 제안한 뒤 편안한 음악을 연주한다.

Cati의 경우 전용 어플리케이션을 통해 칭찬하기, 속마음 듣기, 유치원에서 있었던 일 물어보기 등 일상에 밀접한 대화 주제를 선택하고, 유아의 답변에 대응하는 반응을 선택하여 출력할 수 있다. 또한 함께 동화를 듣고 서로 의견과 대화를 나누는 관계적 상호작용을 지원한다.

공감적 대화기술의 관점에서, 두 사례 모두 발화내용을 일부 반복하거나 되묻고, 탄성, 맞장구 등 음성효과를 사용하며 Moxie는 다양한 표정을 디스플레이에 출력하는 공감적 상호작용을 제공한다. 한편 Moxie의 일부 사용자들은 동반자가 사용자의 대화를 중간에 끊거나 침묵하여 동반자가 유아를 ‘경청’하지 않는다고 보고하였다. 반면 Cati는 동반자의 질문이 끝난 뒤 효과음을 활용해 유아가 답변하는 적정 시점을 알려주어 대화의 중첩과 인식 오류를 억제하도록 설계되었다.

페르소나의 중립성 관점에서 Moxie는 성별중립적이며 호기심 많은 성격으로 로봇 연구실에서 개발되어 인간의 친구가 되는 방법을 배우는 임무를 맡은 로봇이라는 설정을 가진다. Cati는 우주선을 타고 지구에 놀러 온 공룡이라는 설정으로 인종적 특성을 배제하였으며, 애니메이션 전문 성우 목소리로 구현된 밝고 경쾌하며 중성적인 음성 특성을 보유한다.

인간의 역할을 대체하지 않은 목적 수립 및 비침해적 사용범위 설계의 관점에서, 두 사례 모두 동반자가 유아의 대인 상호작용을 줄이거나 대체하지 않도록 평균 하루 20분의 상호작용 시간을 권장한다. Moxie는 유아가 동반자에 집착하거나 중독되지 않아야 하며, 가족·친구와의 대인 상호작용을 유도할 수 있도록 동반자 사용 시간을 의도적으로 통제하는 원칙 아래에 설계되었다. Cati 또한 유아가 동반자와의 경험을 가족, 친구와 공유하며 직접 대화를 나눌 수 있도록 하루 20분~1시간, 주 3~4회의 상호작용을 권장한다.

사회정서적 지원을 위한 대화·콘텐츠 유형을 살펴본 결과, Moxie는 사회정서교육 표준에 기반을 둔 대화 주제 및 이와 관련된 일일 활동 미션을 제공한다. 예를 들어 ‘감정 이해하기’ 주제의 경우 타인의 표정 식별하기, 자신과 타인의 감정 식별하기, 다양한 감정 이해하기 등을 목표로 동반자에게 감정에 따른 인간의 표정 알려주기, 동반자와 함께 게임하기, 슬픔이 어떤 느낌인지 그려보기와 같은 활동 미션을 제공한다.

Cati는 누리과정 기반의 체계적 커리큘럼에 따라 유아에게 교육적 대화를 제공한다. 대화 주제는 동물, 공룡 등 유아 관심도가 높은 주제로 구성되며 일일 활동 미션을 제공하여 성장 시기별로 알아야 하는 사회적 규칙을 습득하도록 한다. 그 외 동화·동요 콘텐츠를 제공하며, 다양한 의성어, 의태어, 표현을 통해 유아의 정서와 창의력 발달을 지원한다.

동기부여 및 보상 체계의 관점에서, Moxie는 유아의 성장을 기록하고 보고하며 목표 달성을 격려하고 행동 전략을 명시적으로 알려주는 목표지향적 모델을 지향한다. 예를 들어, ‘친구 사귀기’ 주제의 경우 동반자와의 대화를 통해 배운 우정 기술을 다른 사람들에게 연습하는 활동 미션을 제공한다. 또한 Moxie는 유아가 동반자를 통해 배운 것을 일상생활에 적용할 수 있도록 부모가 취할 수 있는 지원 활동을 제안한다. 예를 들어 ‘감정 이해하기’ 주제의 활동 미션을 수행한 유아의 부모에게 TV 프로그램이나 영화 등장인물의 표정에 대해 유아가 감정에 이름을 붙여보도록 지시하는 것을 권장한다.

Cati는 유아가 흥미를 잃지 않도록 대화 중간에 호기심을 자극하는 퀴즈를 제공하고 유아의 답변에 따라 칭찬하거나 정답을 알려주며 이와 연계된 대화를 이어 나간다. 예를 들어 사자 소리를 들려주고 아이가 호랑이라고 답하면 Cati는 “사자 소리가 호랑이와 비슷하지?”라고 반응하며 사자에 대한 지식 정보를 전달한다. 또한 Cati는 기상, 취침, 식사 예절, 청결 등 사회 규범을 습득하고 올바른 습관을 형성하도록 유도한다. 예를 들어 ‘정리정돈’과 관련된 주제는 유아가 장난감을 스스로 정리할 수 있도록 유도하는 대화문으로 구성된다.

두 사례 모두 단일 사용자 대상 개인화 서비스를 제공한다. 기능적 개인화의 관점에서 Moxie는 사용자 적응형 알고리즘을 통해 사용자에 대한 지식을 유지하여 개인화된 상호작용 모델을 구성하고 최적의 훈련 계획을 제안한다.

Cati는 특정한 대화 주제 안에서 연속성 있는 양방향 대화를 제공한다. 수집된 유아의 정보를 대화에 활용하고, 대화가 반복될수록 유아의 대화 선호를 고려한 맞춤 콘텐츠를 제안한다. 또한 Cati는 유아가 고유하게 사용하는 단어를 개인화 사전으로 관리한다. 예를 들어, ‘아이스크림’이라는 단어를 유아가 ‘아꿍’이라고 표현한다고 설정할 수 있으며, Cati는 유아가 ‘아꿍’이라고 발음했을 때 ‘아이스크림’이라고 이해하고, ‘아꿍’ 단어를 활용해서 대화를 주고받는다[28].

또한 Moxie의 전용 어플리케이션은 대화를 분석하여 유아의 사회정서적 발달 수준을 지속적으로 추적·관리한다. 육하원칙에 따라 질문에 답하기, 친구 만들기 등 사회적 영역, 추론, 예측, 독해 등 인지적 영역, 자신과 타인의 감정 이해하기, 자기 조절하기 등 정서적 영역에 해당하는 대화를 분석하여 유아의 발달과 능력에 대한 지속적인 통찰력을 제공한다.

Cati는 전용 어플리케이션을 통해 유아가 수행한 미션 이력을 비롯하여 Cati와의 상호작용 내역을 조회할 수 있다. Cati와의 상호작용 과정에서 수집되는 유아의 발화 데이터를 통해 유아의 주 사용단어, 표준어 사용 빈도 등 언어 패턴을 파악할 수 있으며, 분석된 내용을 통해 부모가 유아의 표준어 구사 능력과 발달 수준 등을 파악할 수 있도록 지원한다[28].

정서적 개인화의 관점에서, 두 사례 모두 전용 어플리케이션을 통해 대화 주제를 조정하고 활동 내역을 관리할 수 있으며 개인화를 위한 정보를 수집·활용한다. Moxie의 경우 어플리케이션에 유아의 일정(치과가기, 병원가기 등)을 입력하여 Moxie가 해당 주제에 관해 대화하도록 할 수 있으며, Cati 또한 유아 이름과 가족정보, 관심주제 등을 사전 설정하여 관련 대화를 실행하도록 설계되었다.

4-2 소결

사례분석 내용을 토대로 유사 요인의 병합 및 용어 정제를 통해 유아용 인공지능 동반자의 사회적 특성에 대응하는 구현 기능을 도출하였다(표 2). 예를 들어, 아동친화적 대화를 위한 아동 어휘사전 활용, 유아의 발음 실수 패턴을 수집하는 챗봇엔진 등의 사례는 ‘포용적·윤리적 대화기술’ 특성의 ‘부정확한 발음 인식을 위한 연령별 어휘사전·말뭉치 관리 체계’ 기능으로 병합되었다. 도출된 구현 기능은 다음과 같다.

첫째, 포용적·윤리적 대화기술은 유아 발화특징을 고려한 대화모델 설계와 공격성 언어 탐지 및 학습방지 전략을 바탕으로 구현된다. 부정확한 발음 인식을 위해 연령별 어휘 스펙트럼을 반영한 단어사전과 말뭉치 관리·갱신 체계를 지식 구조상에 탑재하여야 한다. 유아가 불완전한 문장을 발화하더라도 단어를 조합하고 맥락을 분석하여 최적의 추론을 하는 포용적 대화 모델이 운영되어야 한다. 지식 구조는 일상생활과 관련된 대화 시나리오가 저장·관리된다. 대화 시나리오는 짧고 간결한 질문으로 구성되며, 대화 관리 모듈은 질문 출력이 종료된 후 유아에게 응답 타이밍 신호를 적절히 제공하여 음성인식 효율을 높이는 전략을 활용해야 한다.

공격성 언어 탐지 및 학습방지를 위하여 대화 관리 모듈은 공격성 언어 필터링 기술이 내장되어야 한다. 죽음, 슬픔, 폭력 등 민감 주제에 대응하는 대화 시나리오를 사전 설계해야 하며 이는 지속적인 모니터링을 통해 학습·갱신되어야 한다.

둘째, 유아친화적 외형·상호작용은 유아친화적 외형 특성, 상호작용 방식 및 발생 조건, 대화 유지장치를 바탕으로 구현된다. 유아용 인공지능 동반자의 외형은 오염에 강하며 안전하고 내구성이 높은 소재와 형태로 체화되어야 한다. 동반자 상호작용 방식은 유아 신체언어 및 사용환경에 반응·적응하는 시·청각 및 행동적 상호작용으로 제공되며, 모든 상호작용은 시작, 종료, 일시 정지 등을 조절할 수 있는 제어장치(전용 음성명령어 등)가 부여된다. 이러한 전반적 상호작용은 상황 조건에 따라 사용자(유아, 보호자) 주도적, 또는 동반자 주도적으로 설계될 수 있다.

또한 음성인식 오류 및 대화 중단 상황을 대처하기 위해 대화 유지장치를 마련해야 한다. 어휘와 사용자 모델링 정보를 통해 맥락을 추론하고, 추가 질문, 역질문 등의 능동적 대화를 통해 추론에 필요한 정보를 보강하며, 발화 의도가 파악되지 않거나 화제의 변경이 필요한 경우 자연스럽게 화제를 전환할 수 있는 대화 시나리오가 지식 구조에 내장되어야 한다.

셋째, 감정반응·정서지원은 사회적 단서 설계, 관계적 대화 설계 및 공감적 대화 설계를 바탕으로 구현된다. 유아와의 상호작용에서 표정, 웃음, 하품, 자세 변화 등 언어적·비언어적인 사회적 단서를 제공한다. 동반자 외형의 의인화 정도에 따라 사회적 표현의 방식은 달라질 수 있다.

유아와 장기적 관계를 형성하기 위해 유아가 지금 어떤 감정을 느끼고 있는지, 어떠한 상태인지 물어보는 관계적 대화가 필요하다. 유아의 일상생활에 관해 묻거나, 특정 주제에 대한 의견을 교환하는 대화가 이루어지고, 이러한 대화들을 통해 수집된 유아 정보들은 사용자 모델링에도 활용될 수 있다.

공감적 대화를 위해 유아와 대화할 때 맞장구를 쳐주거나, 되묻는 등 공감과 경청의 신호를 제공해야 한다. 대화 중첩을 방지하기 위해 유아가 발화하고 있을 때는 충분한 응답 대기시간을 가지고 반응하도록 설계한다. 동반자가 유아의 발화에 경청하지 않는다는 느낌이 들지 않도록 주의해야 한다.

넷째, 건전한 관계 형성은 중립적이며 긍정적인 외형 및 대화모델 페르소나 설계, 인간의 역할을 대체하지 아니하는 목적 설계, 유아의 자유 및 건전한 발달을 침해하지 않는 사용범위 설계를 바탕으로 구현된다. 건전한 관계 형성을 위해서는 중립적인 생물 또는 무생물의 형태와 밝고 경쾌하며 중성적 음성을 보유하도록 설계한다. 또한 긍정적인 성향의 대화 모델을 적용하여 친근함과 호기심을 자극할 수 있도록 한다.

인공지능 동반자는 유아가 사람과 맺을 수 있는 관계를 대체하는 것이 아닌, 가족·친구와의 상호작용을 지원해주는 역할을 해야 한다. 예를 들어 유아는 동반자와 상호작용하며 친구와 친해지기 위한 대화 기술을 연습할 수 있다. 더불어, 유아의 자유와 건전한 발달을 침해하지 않도록 권장 사용 시간과 사용범위를 설계하는 것이 필요하다. 관련 사례에선 사용 시간을 하루 20~60분, 주 3~4회 수준으로 제한하는 것을 권장하고 있으며, 인공지능 동반자의 접촉시간과 상호작용 범위를 조절하여 유아가 동반자와의 관계에 집착하거나 중독되지 않도록 사전에 마련된 기준을 제공해야 한다.

다섯째, 동기부여·설득기술은 사회정서 지원 대화·콘텐츠 설계와 동기부여 및 보상체계를 바탕으로 구현된다. 대화 주제 및 콘텐츠는 국가표준 및 교육 커리큘럼을 기반으로 체계적으로 설계되며 동반자의 지식 구조를 구성할 때 유아교육 전문가를 비롯하여 다학제적 참여와 검증이 필요하다.

유아의 집중도와 참여를 높여 지속적인 상호작용이 가능하도록 동기부여 및 보상 체계가 수립되어야 한다. 유아가 목표를 달성하도록 격려하고 행동전략을 명시적으로 알려주는 대화 시나리오와 콘텐츠를 설계한다. 또한 집중 가능 시간이 짧은 유아를 위해 흥미 유도장치를 마련해야 한다. 퀴즈를 제공하고 유아의 대답에 따라 칭찬과 정답을 알려주거나, 유아가 상호작용 및 활동을 수행할 때 부모가 취할 수 있는 행동 가이드를 제공하여 유아의 목표 달성을 지원하도록 할 수 있다.

여섯째, 개인화·연속성은 기능적 개인화와 정서적 개인화를 바탕으로 구현된다. 기능적 개인화를 위해 사전에 이름, 가족관계, 일정, 선호 대화 주제 등 개인화 정보를 입력하여 사용자 정보를 모델링하는 데 활용할 수 있으며, 대화에서 분석 가능 요소들을 추출하고 지표화하여 언어사용 패턴, 사회정서 발달 수준 등 개인 데이터를 지속해서 추적·관리한다.

또한 이름 불러주기, 대화내용 기억하기 등 정서적 개인화를 통해 유아와의 친밀성을 높일 수 있다. 대화에서 수집되는 개별특성에 대한 지식을 기억하고 유지하여 개인화된 상호작용 모델을 구성한다. 대화를 반복할수록 고도화되는 상호작용을 기반으로 인공지능 동반자는 유아가 선호하는 대화 주제 및 콘텐츠를 제공하며 장기적인 관계를 형성할 수 있다.

Ⅴ. 결 론

본 연구는 유아용 인공지능 동반자의 사회적 역할을 조명하였으며, 유아용 인공지능 동반자의 사회적 특성을 포용적·윤리적 대화기술, 유아친화적 외형·상호작용, 감정반응·정서지원, 건전한 관계형성, 동기부여·설득기술, 개인화·연속성으로 제안하고 특성별 구현 기능을 구체화하였다.

연구의 시사점은 다음과 같다. 사례분석 결과 유아용 인공지능 동반자의 대화 및 상호작용 기술은 현재 기능적 한계가 존재하며, 거대 언어모델을 접목하거나 수백 개의 대화 시나리오를 통해 다양한 대화 주제를 확보하였음에도 대화가 일방적으로 진행되거나 제한되어 있다고 느끼는 사용자 평가를 다수 발견하였다. 이는 조사된 사례 모두 동반자가 먼저 질의를 하는 동반자 주도식 대화방식을 취하며, 성인 대상 서비스가 지향하는 자유로운 대화와 달리 교육·정서지원에 특화되며 윤리적 침해를 방지하기 위해 보수적인 대화 주제를 설정한 것에 근거한 결과로 보인다. 향후 고도화된 대화 및 상호작용 기술을 확보하기 위하여 지속적 인공지능 모델 학습, 데이터 모니터링, 다학제적 협력을 통해 대화 주제와 시나리오를 다양화하고 윤리성을 강화하기 위한 노력이 이어져야 할 것이다.

또한 개인화·연속성의 측면에서 유아가 성장할수록 흥미를 빠르게 잃어 서비스의 지속적 사용이 어렵다는 사용자 인식을 발견하였다. 유아용 인공지능 동반자의 서비스 지속가능성을 강화하기 위하여 장기 기억 능력과 사용자 모델링, 맞춤형 콘텐츠 및 유아의 성장에 대응하는 대화 시나리오를 확보하여 학습을 통해 유아와 함께 성장하고 지속 상호작용할 수 있는 적응형 서비스 모델이 구현되어야 할 것이다.

더불어 유아용 인공지능 동반자는 사람의 역할을 온전히 대체하지 않도록 유아와 건전한 관계를 형성하고, 부모의 개입 영역을 보존하며 중재자 역할을 수행할 것으로 기대된다. 다양한 정보를 관리·제어하는 어플리케이션을 통해 유아와 부모를 연결할 수 있으며 조언과 보조적 지도 콘텐츠를 통해 부모의 양육 부담을 덜고 유아의 건강한 발달을 지원할 수 있다.

한편, 본 연구에는 다음과 같은 한계가 있다. 먼저, 사례 조사범위가 제한되어 실존하는 모든 사례를 포괄할 수 없으며, 대상의 특수성으로 인해 사례분석이 협소한 범위로 수행되어 연구 결과를 일반화하는 것에 제한이 있다. 또한 분석자료가 공개 정보와 문건을 기준으로 함에 따라 실제 기술적 구조와 이격이 있을 수 있다.

연구의 한계에도 불구하고 본 연구는 유아용 인공지능 동반자가 유아의 사회적 동반자로서 정착하기 위한 기본 전략과 기초연구자료를 도출하였다는 것에 의의가 있다. 이에 본 연구를 토대로 다음과 같은 후속 연구를 제안하고자 한다.

첫째, 인공지능 동반자의 사회적 특성이 실제 기술수용에 미치는 영향을 검토해야 한다. 사용용이성, 유용성, 사용의도 등 기술수용의 변수와 사회적 특성 사이의 영향관계를 검토하고, 유아 사용자의 특수성을 바탕으로 풍부한 데이터와 사례를 포함한 실험환경 기반 실증적 연구를 수행하여 유아용 인공지능 동반자의 확산을 위한 전략을 구체화할 필요가 있다.

둘째, 인공지능 동반자와의 장기적 상호작용으로 발생하는 유아의 정서 발달 변화에 관한 종단적 연구가 수행되어야 한다. 유아에게 안전한 동반자 상호작용 기술 개발을 위해 인공지능 동반자와의 일상적 접촉과 동반자의 사회적 특성이 유아의 생활과 성장 및 발달에 미치는 긍정적, 부정적 영향에 대한 중·장기적 추적조사가 수행되어야 할 것이다.

셋째, 유아용 인공지능 동반자의 지속 발전가능한 서비스 모델을 구축할 필요가 있다. 연속적이며 유아와 함께 성장하는 양방향 학습모델을 구축하기 위하여 지속가능한 서비스 개발 및 평가 기준이 정립되어야 한다. 윤리적이며 실증적 결과를 얻기 위해 엔지니어링, 유아교육, 심리 발달, 서비스 디자인 등 전문 지식영역의 융합과, 다양한 연령과 발달상태의 유아, 보호자, 교사 등 사용자 참여가 수반되어야 할 것이다.

향후 본 연구를 기초자료로 유아의 사회적 동반자로서 기능하는 인공지능 동반자 기술 개발 및 활용에 관한 후속 연구가 이어지길 기대하는 바이다.

Acknowledgments

이 성과는 2023년 한국인터넷정보학회 추계학술발표대회에 제출한 논문을 고도화한 것이며, 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. RS-2023-00251378).

References

-

R. Chaturvedi, S. Verma, R. Das, and Y. K. Dwivedi, “Social Companionship with Artificial Intelligence: Recent Trends and Future Avenues,” Technological Forecasting and Social Change, Vol. 193, 122634, August 2023.

[https://doi.org/10.1016/j.techfore.2023.122634]

-

D. Benyon and O. Mival, “Introducing the Companions Project: Intelligent, Persistent, Personalised Interfaces to the Internet,” in Proceedings of the 21st British HCI Group Annual Conference on People and Computers: HCI...But Not as We Know It - Volume 2, Lancaster, UK, pp. 193-194, September 2007.

[https://doi.org/10.14236/ewic/HCI2007.36]

-

J. Feine, U. Gnewuch, S. Morana, and A. Maedche, “A Taxonomy of Social Cues for Conversational Agents,” International Journal of Human-Computer Studies, Vol. 132, pp. 138-161, December 2019.

[https://doi.org/10.1016/j.ijhcs.2019.07.009]

-

J. Kim, K. Merrill Jr., and C. Collins, “AI as a Friend or Assistant: The Mediating Role of Perceived Usefulness in Social AI vs. Functional AI,” Telematics and Informatics, Vol. 64, 101694, November 2021.

[https://doi.org/10.1016/j.tele.2021.101694]

- MarketsandMarkets. Conversational AI Market Size, Industry Share Forecast 2028 [Internet]. Available: https://www.marketsandmarkets.com/Market-Reports/conversational-ai-market-49043506.html, .

-

A. Rogge, “Defining, Designing and Distinguishing Artificial Companions: A Systematic Literature Review,” International Journal of Social Robotics, Vol. 15, No. 9-10, pp. 1557-1579, October 2023.

[https://doi.org/10.1007/s12369-023-01031-y]

-

S. Rasouli, G. Gupta, E. Nilsen, and K. Dautenhahn, “Potential Applications of Social Robots in Robot-Assisted Interventions for Social Anxiety,” International Journal of Social Robotics, Vol. 14, No. 5, pp. 1167-1198, July 2022.

[https://doi.org/10.1007/s12369-021-00851-0]

-

M. Sony and S. Naik, “Industry 4.0 Integration with Socio-Technical Systems Theory: A Systematic Review and Proposed Theoretical Model,” Technology in Society, Vol. 61, 101248, May 2020.

[https://doi.org/10.1016/j.techsoc.2020.101248]

-

S. Chai and M. Kim, “A Socio-Technical Approach to Knowledge Contribution Behavior: An Empirical Investigation of Social Networking Sites Users,” International Journal of Information Management, Vol. 32, No. 2, pp. 118-126, April 2012.

[https://doi.org/10.1016/j.ijinfomgt.2011.07.004]

-

J. F. Allen, D. K. Byron, M. Dzikovska, G. Ferguson, L. Galescu, and A. Stent, “Toward Conversational Human-Computer Interaction,” AI Magazine, Vol. 22, No. 4, 27, December 2001.

[https://doi.org/10.1609/aimag.v22i4.1590]

- Innopolis Foundation, Conversational Artificial Intelligence (AI) Market, Author, Daejeon, Global Market Trend Report, March 2021.

- Y. Kim, Microsoft’s B2B Product Portfolio Armed with AI, National Information Society Agency, Daegu, Digitalservice Issue Report 2023-4, pp. 12-20, April 2023.

- J.-H. Hong, Intelligent Conversational Agent Using Compound Artificial Intelligence Modules, Master’s Thesis, Yonsei University, Seoul, February 2004.

-

N. Hurst, C. Clabaugh, R. Baynes, J. Cohn, D. Mitroff, and S. Scherer. “Social and Emotional Skills Training with Embodied Moxie,” arXiv:2004.12962, , April 2020.

[https://doi.org/10.48550/arXiv.2004.12962]

-

S. Lee, “The Effect of Perceived Anthropomorphic Characteristics on Continuous Usage Intention of Artificial Intelligence Voice Speaker: Based on the Integrated Adoption Model,” The Journal of the Korea Contents Association, Vol. 21, No. 11, pp. 41-55, November 2021.

[https://doi.org/10.5392/JKCA.2021.21.11.041]

-

S. B. Lovato, A. M. Piper, and E. A. Wartella, “Hey Google, Do Unicorns Exist?: Conversational Agents as a Path to Answers to Children’s Questions,” in Proceedings of the 18th ACM International Conference on Interaction Design and Children (IDC ’19), Boise: ID, pp. 301-313, June 2019.

[https://doi.org/10.1145/3311927.3323150]

-

D. Black, “Machines with Faces: Robot Bodies and the Problem of Cruelty,” Body & Society, Vol. 25, No. 2, pp. 3-27, June 2019.

[https://doi.org/10.1177/1357034X19839122]

-

L. Hung, C. Liu, E. Woldum, A. Au-Yeung, A. Berndt, C. Wallsworth, ... and H. Chaudhury, “The Benefits of and Barriers to Using a Social Robot PARO in Care Settings: A Scoping Review,” BMC Geriatrics, Vol. 19, 232, August 2019.

[https://doi.org/10.1186/s12877-019-1244-6]

-

L. Chandra Kruse, K. Bergener, K. Conboy, J. E. Lundström, A. Maedche, S. Sarker, ... and C. E. Tømte, “Understanding the Digital Companions of Our Future Generation,” Communications of the Association for Information Systems, Vol. 52, pp. 465-479, 2023.

[https://doi.org/10.17705/1CAIS.05218]

-

H.-W. Kim, H. C. Chan, and S. Gupta, “Value-Based Adoption of Mobile Internet: An Empirical Investigation,” Decision Support Systems, Vol. 43, No. 1, pp. 111-126, February 2007.

[https://doi.org/10.1016/j.dss.2005.05.009]

- A. Osterwalder, Y. Pigneur, G. Bernarda, and A. Smith, Value Proposition Design: How to Create Products and Services Customers Want, Hoboken, NJ: Wiley, 2014.

-

R. Rawassizadeh, T. Sen, S. J. Kim, C. Meurisch, H. Keshavarz, M. Mühlhäuser, and M. Pazzani, “Manifestation of Virtual Assistants and Robots into Daily Life: Vision and Challenges,” CCF Transactions on Pervasive Computing and Interaction, Vol. 1, No. 3, pp. 163-174, November 2019.

[https://doi.org/10.1007/s42486-019-00014-1]

-

I. Papadopoulos, C. Koulouglioti, R. Lazzarino, and S. Ali, “Enablers and Barriers to the Implementation of Socially Assistive Humanoid Robots in Health and Social Care: A Systematic Review,” BMJ Open, Vol. 10, No. 1, e033096, January 2020.

[https://doi.org/10.1136/bmjopen-2019-033096]

-

K. Merrill Jr., J. Kim, and C. Collins, “AI Companions for Lonely Individuals and the Role of Social Presence,” Communication Research Reports, Vol. 39, No. 2, pp. 93-103, 2022.

[https://doi.org/10.1080/08824096.2022.2045929]

- H. Jung, Y. Song, J. Song, J. Lee, and J. E. Lee, A Study on the Development of Read to a Robot for Children Based on Artificial Intelligence, National Library for Children and Young Adults, Seoul, September 2020.

-

R. Gockley, A. Bruce, J. Forlizzi, M. Michalowski, A. Mundell, S. Rosenthal, ... and J. Wang, “Designing Robots for Long-Term Social Interaction,” in Proceedings of 2005 IEEE/RSJ International Conference on Intelligent Robots and Systems, Edmonton, Canada, pp. 1338-1343, August 2005.

[https://doi.org/10.1109/IROS.2005.1545303]

-

L. Zhou, J. Gao, D. Li, and H.-Y. Shum, “The Design and Implementation of Xiaoice, An Empathetic Social Chatbot,” Computational Linguistics, Vol. 46, No. 1, pp. 53-93, March 2020.

[https://doi.org/10.1162/coli_a_00368]

- Catius Inc., Method and Apparatus for Providing Speech Based Conversation Service, Author, Seoul, Patent No. 1024750380000, Korea, December 2022.

저자소개

2014년:한양대학교 실내건축디자인학과 (이학사)

2022년:한양대학교 실내건축디자인학과 (이학박사)

2023년~현 재: 차세대융합기술연구원 선임연구원

※관심분야:스마트시티, 지능공간디자인, 사용자중심디자인 등

2015년:성균관대학교 심리학과 (심리학 학사)

2017년:성균관대학교 인터랙션사이언스 (인터랙션사이언스학 석사)

2023년~현 재: 차세대융합기술연구원 연구원

※관심분야:인공지능 에이전트, 인간-컴퓨터 상호작용(HCI)

2011년:연세대학교 정보대학원 (정보시스템 석사)

2015년:연세대학교 정보대학원 (정보시스템 박사)

2016년~2021년: 서울디지털재단

2021년~현 재: 차세대융합기술연구원 도시데이터혁신연구실 실장

※관심분야:도시정보학(Urban Computing), 데이터과학 등