목적 지향 대화 시스템을 위한 어댑터 기반 학습 방법

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

최근에는 목적 지향 대화 시스템의 성능 향상을 위해 Hyper-Scale의 Transformer기반의 사전 학습된 언어 모델을 사용하고 있다. 하지만 사전 학습된 언어 모델의 크기가 증가함에 따라 Fine-tuning을 진행할 때 문제점이 발생한다. 언어 모델의 Fine-tuning 과정은 전체 파라미터를 학습하기 때문에 크기가 증가하면 학습 시간이 오래 소요된다. 또한 충분한 저장 공간이 필요하다. 본 연구는 이러한 문제점을 해결하기 위해 Transformer 기반의 언어 모델에 해당하는 파라미터는 학습하지 않고 이후 Adapter, LoRA의 구조를 결합해 대화 지식을 효율적으로 학습하는 방법을 제안한다. 제안 모델의 성능 평가는 목적 지향 대화 시스템에서 주로 쓰이는 벤치마크 데이터 셋인 Multi-WOZ 2.0 데이터를 사용했다. 실험결과 기존 모델의 Fine-tuning에 비해 8%의 파라미터로 학습을 진행했음에도 불구하고 제안모델은 기존 모델과 2% 오차범위 내의 비슷한 성능을 보였다. 따라서 학습시간과 저장공간의 효율성이 비약적으로 향상되었음을 증명하였다.

Abstract

Recently, pretrained hyperscale language models based on Transformer architectures have been used to improve the performance of task oriented dialogue systems. However, as the size of pretrained language models increases, problems typically arise with fine-tuning. Because fine tuning processes for language models require learning the entire parameter set, training takes longer as the size of a model increases, and storage space requirements also increase accordingly. To solve these problems, in this study, we propose a method to reduce the number of parameters of a language model and allow it to learn more efficiently. The proposed approach enables more efficient learning of conversational knowledge by combining an adapter and low-rank adaptation (LoRA) without learning parameters corresponding to Transformer-based language models. We evaluated the performance of an implementation of the proposed approach using the MultiWOZ 2.0 benchmark dataset, which is commonly used to evaluate the performance of task-oriented dialogue systems. The results show that despite learning with 8% fewer parameters compared to fine-tuning an existing model, the proposed method showed similar performance within the 2% error range. These results demonstrate that the efficiency of the proposed model improved dramatically in terms of learning time and storage space requirements.

Keywords:

Natural Language Processing, Task-Oriented Dialogue System, Adapter, Fine-Tuning, Training Efficiency키워드:

자연어 처리, 목적 지향 대화 시스템, 어댑터, 미세 조정, 학습 효율성.Ⅰ. 서 론

목적 지향 대화 시스템(Task-oriented dialogue system)은 특정 업무를 달성하기 위해 시스템이 대화를 통해 사용자에게 도움을 주는 것을 목적으로 하는 자연어 처리의 주된 분야이다. 시스템은 주로 식당 검색, 호텔 예약, 일정 관리 등 다양한 목적에 활용될 수 있다. 또한 해당 도메인의 데이터베이스 정보를 바탕으로 사용자의 질문에 대한 답변을 한다. 전통적인 목적 지향 대화 시스템은 자연어 이해 모듈(NLU; Natural Language Understanding), 대화 상태 추적 모듈(DST; Dialogue State Tracking), 대화 정책 학습 모듈(POL; Dialogue Policy Learning), 자연어 생성 모듈(NLG; Natural Language Generation)이 연결된 파이프라인 구조를 갖는다[1]. 하지만 파이프라인 구조의 목적 지향 대화 시스템은 독립적인 모듈 간의 오류가 전파되고 새로운 도메인에 대해서 적응이 어려운 문제점이 존재한다. 이처럼 파이프라인 구조의 문제점을 해결하기 위해 최신 연구들은 독립적인 모듈을 Pre-trained language model을 활용해 하나로 통합한 구조들을 제안했다[2]-[4]. 그러나 사전 학습된 언어 모델을 사용하여 목적 지향 대화 시스템을 풀 때 언어 모델의 파라미터의 수가 수 백 억 개까지 증가하기 때문에 다음과 같은 문제점이 발생한다.

첫째. 사전 학습된 언어 모델을 Fine-tuning할 때 전체 파라미터를 업데이트하기 때문에 파라미터 수가 많을수록 학습 시간이 오래 소요된다.

둘째. Hyper-scale의 사전 학습된 언어 모델을 위한 Fine-tuning은 파라미터의 수가 많을수록 학습된 모델의 저장 공간이 필요하다.

본 연구에서 제안하는 시스템은 Hyper-scale의 사전 학습된 언어 모델을 효율적으로 학습하기 위해 Adapter 기반 학습 방법을 사용한 새로운 목적 지향 대화 시스템을 제안한다. Adapter 기반 학습 방법은 사전 학습된 언어 모델 내부에 추가적인 학습 가능한 Layer를 추가한다. 기존의 사전 학습된 언어 모델 파라미터를 학습하지 않고 추가된 Layer만 학습해 Fine-tuning과 비슷한 성능을 얻는 학습 방법이다.

제안한 시스템은 Adapter[5]와, LoRA[6]의 구조를 시스템에 추가해 대화 지식을 효과적으로 학습하는 구조를 제시한다. 이와 같이 학습된 목적 지향 대화 시스템의 성능 평가를 위해 벤치마크 데이터 세트인 Multi-WOZ 2.0[7]를 사용한다. 베이스라인은 T5[8] 기반으로 대화 영역에 대한 지식을 대량으로 학습한 PPTOD[2]를 사용한다.

제안 모델은 전체 파라미터를 학습하는 Fine-tuning 방법보다 8%의 파라미터만을 학습 과정에서 학습했다. 그 결과 효율적인 측면에서는 학습 시간은 18.4%가 향상되었으며 저장 공간을 92.2%를 절약할 수 있다. 또한 성능의 측면에서는 기존 모델의 파라미터를 8%밖에 사용했음에도 불구하고 제안 모델은 Fine-tuning과 비교하여 오차 범위 2% 내의 성능을 유지한다.

Ⅱ. 관련 연구

2-1 Pre-Trained Language Model

자연어처리 분야에서는 Transformer의 등장 이후 전이 학습을 Transformer 기반의 언어 모델에 적용하기 위해 대용량의 코퍼스로부터 언어의 문법 및 어휘를 학습한다. 사전 학습된 언어 모델을 사용하기 위해 일반적으로 Fine-tuning 방법을 사용하며 자연어 처리의 모든 작업에서 좋은 성능을 도출한다.

Transformer의 인코더 기반의 모델(BERT[9], RoBERTa[10], DeBERTa[11])은 자연어 이해 작업을 위해 Fine-tuning을 진행하며 높은 성능을 보여준다. 또한 BERT(110M) - RoBERTa(125M) - DeBERTa(1.5B)의 순서로 모델의 파라미터가 증가한다.

Transformer의 디코더 기반의 모델(GPT-1[12], GPT-2[13], GPT-3[14], LaMDA[15], OPT[16])는 자연어 생성을 위해 Fine-tuning을 진행하며 높은 성능을 보여준다. 또한 GPT-1(117M) - GPT-2(1.5B) - GPT-3 (175B)의 순서로 모델의 파라미터가 증가하고 있으며 LaMDA(137B), OPT(175B) 또한 거대한 파라미터를 가진다.

Transformer의 인코더 디코더 기반의 모델(BART[17], T5[8])은 자연어 이해와 자연어 생성이 필요한 번역이나 요약 작업 등에 Fine-tuning 후 사용한다. 이때 사용하는 BART(400M), T5(11B)도 모델의 파라미터가 증가하는 문제점이 있다.

2-2 Task-Oriented Dialogue System

사전 학습된 언어 모델 등장 전 목적 지향 대화 시스템은 전통적인 방식인 LSTM+CNN을 사용한 구조[18]와 Seq2Seq 구조[19]-[21], 강화학습을 적용한 연구가 있다. Seq2Seq 구조를 사용한 Sequicity[19], 단일 도메인 대화 시스템을 다중 도메인으로 확장한 DAMD[20], Semi supervised learning을 시도한 LABES-S2S[21]가 있다. 강화 학습 적용한 연구로는 JOUST[22], LAVA[23], DORA[24], SUMBT+LaRL[25], CASPI [26]가 있다. 사전 학습된 언어 모델 등장 이후, 인코더 구조에 대한 연구는 BERT와 GRU를 적용한 DoTS[27]가 있다. 디코더 구조에 대한 연구는 다음과 같다. SimpleTOD[3]는 Domain adaptation을 위해 특수 토큰과 Delexicalization[28]을 사용하였으며 SOLOIST[29]는 Negative data sample을 만들어 Contrastive learning[30]을 적용한 학습 방법을 제안했다. UBAR[31]는 기본적으로 모든 대화 기록을 사용해 하나의 답변을 얻는 전통적인 방식에서 turn 단위의 기록을 사용해 하나의 답변을 얻을 수 있는 방법론을 제안했다. 인코더-디코더 구조에 대한 연구는 다음과 같다. MinTL[32] BART, T5를 목적 지향 대화 시스템에 적용하였으며 PPTOD[2]는 T5를 사용하였으며 목적 지향 대화 시스템에 하위 태스크 특성에 맞춘 접두어를 학습 시킨 모델이며 MTTOD[4]는 T5를 사용하였으며 보조 loss로 Span prediction을 적용했다. GALAXY[33]는 UniLM을 사용하였으며 여러 데이터 셋에 통일되지 않은 화행을 ISO 규범으로 정의하여 데이터를 학습시켜서 적용했다.

2-3 Adapter Based Learning Methods

Adapter 기반의 학습 방법은 사전 학습된 언어 모델의 내부에 학습 가능한 Bottleneck 구조의 Layer을 추가한다. 이후 사전 학습된 언어 모델의 파라미터는 학습하지 않고 추가한 Layer만 학습을 진행한다. [5]는 Adapter의 개념을 자연어 처리에 처음 적용했다. 이러한 Adapter의 구조는 기존의 Fine-tuning과 비슷한 성능을 달성했다. [34]는 기계 번역에 도메인 Adapter라는 개념을 적용했다. AdapterFusion[35]은 Pfeiffer Adapter라 불리는 구조와 Adapter를 병렬적으로 사용 후 병합하는 방법을 제안했다. MAD-X[36]는 다중 언어 모델 학습에 효과적인 Language Adapter와 Task Adapter, Invertible Adapter를 제안했다. LoRA[6]는 Fine-tuning 시에 사전 학습된 언어 모델 안의 Attention weights update 과정을 분해하고 이 과정을 Adapter에 적용해서 Weight update 과정을 대신하는 방법을 제안했다. [37]는 여러 Adapter들을 자연어처리의 여러 하위 태스크에 실험하여 Adapter들의 효과적인 구조를 제안했다. UniPELT[38]는 PELT 방법을 하위 모듈로 통합하고 게이팅 메커니즘을 통해 현재 데이터 또는 작업 설정에 가장 적합한 방법을 활성화하는 통합 프레임워크를 제안했다.

Ⅲ. 제안 방법

본 논문은 Adapter 기반 학습 방법을 이용한 Transformer 기반 End-to-end 목적 지향 대화 시스템을 제안한다.

3-1 Adapter

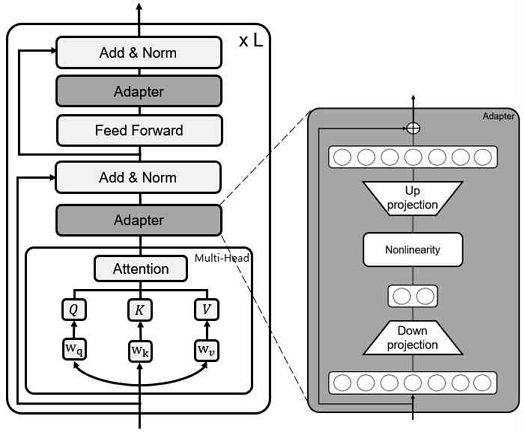

Adapter는 사전 학습된 언어 모델 안의 Attention layer와 Feed forward layer를 통과해 나오는 Hidden state의 정보를 효과적으로 압축해서 다음 Layer로 전달해 주기 위해 그림 1과 같이 Transformer의 Layer 안에 Adapter라는 학습 가능한 Bottleneck 구조를 추가한다. Houlsby adapter는 Transformer의 하나의 Layer 안에 두 개의 Adapter를 Attention layer와 Feed forward layer를 뒤에 각각 추가한다. Pfeiffer adapter는 Transformer의 하나의 Layer 안에 한 개의 Adapter를 마지막 Feed forward network 뒤에 Add & Norm을 진행 후 추가한다. Adapter layer는 1번 수식과 같이 입력으로 들어오는 Hidden state를 하위 차원으로 투영하는 Down projection을 실행하는 Wdown, Non-linearity activation function인 f, Hidden state의 원래 차원으로 투영하는 Up projection을 실행하는 Wup, Residual network인 r 로 구성되어 있다.

이 식에서 Dhidden은 Hidden size이며 Dbottle은 Bottleneck size이다. 이러한 Adapter가 결합된 사전 학습된 언어 모델은 학습 시 언어 모델에 해당되는 전체 파라미터를 파라미터는 학습하지 않고 Adapter 구조만 학습한다.

| (1) |

3-2 LoRA

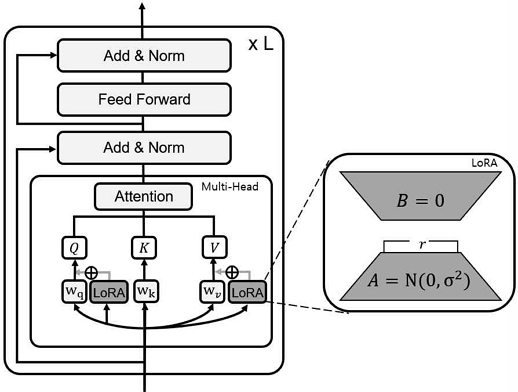

LoRA는 그림 2와 같이 Transformer의 Weight update과정을 두 개의 하위 행렬로 분해하여 Transformer안에 추가한다. LoRA는 수식 2와 같이 기존의 사전 학습된 언어 모델이 가지고 있는 Weight를 W0, Fine-tuning을 진행할 때 추가적으로 업데이트가 이루어지는 Weight를 ΔW 라하고, ΔW를 A와 B의 행렬로 분해한다. 사전 학습된 언어 모델의 Weight matrix는 , LoRA의 하위 행렬로 분해한 Weight matrix는 W0 + ΔW = ΔW + BA, 이다. 또한 ΔW = BA 를 로 조정한다. 여기서 α는 r의 상수이다. 이 스케일링은 r을 변경할 때 파라미터를 다시 조정할 필요성을 줄이는 데 도움을 준다[39].

| (2) |

여기서 A는 He initialization[40]로 초기화되는 Down projection layer이며 B는 0으로 초기화된 Up projection layer이다.

3-3 End-to-End Dialogue Modeling

제안한 시스템은 T5 기반의 대화 영역에 대한 지식을 대량으로 학습한 PPTOD를 Adapter 기반의 학습 방법을 적용해 대화 지식을 효과적으로 학습할 수 있는 구조로 이루어져 있다. 이 시스템의 성능 평가는 Multi-WOZ 2.0 data에 대해 이루어진다. 제안한 시스템의 학습 방법은 Maximum likelihood method에 따라 학습되므로 D = (X, Y), D 는 Data, x = Source, y = Target 일 때, Loss는 3번 수식과 같다.

| (3) |

Ⅳ. 실험

본 논문에서는 제안한 모델을 평가하기 위해 Multi-WOZ 2.0을 목적 지향 대화 시스템의 Benchmark task인 End-to-end dialogue modelling[41]에 대해 평가한다. Baseline은 대화 영역에 대한 지식을 대량으로 학습한 T5 기반의 언어 모델인 PPTOD를 사용하였으며 시스템의 구조에 따른 비교실험을 진행한다. 모델의 평가지표는 Automatic evaluation metrics[6]를 따른다. Inform은 시스템이 올바른 엔티티를 제공했는지 여부를 측정하고 Success는 요청된 모든 정보에 응답했는지 여부를 측정한다. BLEU[42]는 시스템의 생성된 응답이 얼마나 잘 생성되는지 여부를 측정한다. Combined score = (Inform+Success) × 0.5 + BLEU는 [43]에서 제안된 성능 평가 지표이다.

4-1 Adapter 종류에 대한 실험

본 실험은 다양한 구조의 Adapter들에 대해 성능을 평가한다. 표 1은 Houlsby adapter, Pfeiffer adapter, LoRA에 대해 각각 실험했으며 대화 지식을 미리 학습한 PPTOD에 결합하여 성능을 비교한다. LoRA는 식 (2)에 해당하는 r = 32로 실험을 진행했다. PPTOD-small은 T5의 모든 파라미터를 Fine-tuning한 결과이다. Adapter 기반의 학습 방법들은 T5의 파라미터를 학습하지 않고 Adapter layer만 학습을 진행한다. 표 1에 따르면 최종적으로 LoRA가 제일 높은 성능을 도출했다. 따라서 LoRA가 Houlsby adapter(H.Adapter), Pfeiffer adapter(P.Adapter)보다 대화 지식을 언어 모델 내부에서 잘 전달하는 구조로 구성된 것을 볼 수 있다. 따라서 제안 모델은 LoRA를 채택한다.

4-2 LoRA r 에 대한 실험

Pre-trained language model은 학습하는 파라미터가 많을 수록 성능이 증가한다[14]. 따라서 본 실험은 LoRA의 학습하는 파라미터 수가 증가할 때 성능을 비교한다. 표 2는 식 (2)의 LoRA의 r 에 대한 실험이다. LoRA의 r 이 증가할수록 LoRA의 학습하는 파라미터(Param) 수가 증가한다. LoRA의 파라미터 수가 증가할수록 성능이 오르는 것을 확인할 수 있었으며, r이 128일 때, 성능이 가장 높은 것을 확인할 수 있었다. 따라서 LoRA의 r값이 128일 때, 제안 모델로 사용한다.

4-3 Efficiency에 대한 실험

본 실험은 Adapter의 종류에 따른 효율성에 대한 실험이다. 표 3에 따르면 기존 시스템인 PPPTOD-small에 비해 LoRA를 결합한 시스템은 MultiWOZ 2.0에 대해서 파라미터(Param)를 7.8%만 사용했음에도 불구하고 학습 시간(T.T) 18.4%이 개선되었다. 또한 저장 공간(S.S) 또한 92% 절약할 수 있다. 제안한 시스템은 학습할 때 사전 학습된 언어모델의 Weight update 없이 원본 그대로 사용한다. 그러므로 Adapter에 해당하는 구조만 저장하므로 저장 공간을 효율적으로 사용할 수 있다. 또한 Adapter기반의 방법을 사용하면 Fine-tuning과 비교해 학습되는 파라미터의 수의 감소에 따른 학습 시간 감소와 저장 공간의 감소를 얻을 수 있다.

Ⅴ. 결 론

본 논문은 Adapter 기반의 학습 방법을 적용한 새로운 T5 기반의 End-to-end 목적 지향 대화 시스템을 제안한다. 이 시스템은 대화 지식을 효율적으로 학습하기 위해 LoRA를 결합했다. 실험 결과 성능의 측면에서는 기존 베이스라인 모델과 비교해 오차범위 2% 이내의 Fine-tuning과 비슷한 성능이 도출되었다. 효율의 측면에서는 기존 베이스라인 모델보다 8%의 파라미터만 사용했음에도 18.4%의 학습속도 향상 및 저장 공간을 92%를 절약하는 결과를 얻었다. 추후에는 Adapter 기반의 학습 방법을 다양하게 적용해서 발전된 효과를 입증할 예정이다.

Acknowledgments

이 성과는 2023년도 정부(과학기술정보통신부)의 재원으로 한국연구재단의 지원을 받아 수행된 연구임(No. NRF-2022R1A2C1005316).

References

-

S. J. Young, “Probabilistic Methods in Spoken–Dialogue Systems,” Philosophical Transactions of the Royal Society of London. Series A: Mathematical, Physical and Engineering Sciences, Vol. 358, No. 1769, pp. 1389-1402, April 2000.

[https://doi.org/10.1098/rsta.2000.0593]

-

Y. Su, L. Shu, E. Mansimov, A. Gupta, D. Cai, Y.-A. Lai, and Y. Zhang, “Multi-task Pre-training for Plug-and-play Task-oriented Dialogue System,” in Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics, Dublin, Ireland, pp. 4661-4676, May 2022.

[https://doi.org/10.18653/v1/2022.acl-long.319]

- E. Hosseini-Asl, B. McCann, C.-S. Wu, S. Yavuz, and R. Socher, “A Simple Language Model for Task-oriented Dialogue,” in Proceedings of NeurlPS 2020 (Advances in Neural Information Processing Systems 33), Online, pp. 20179-20191, December 2020.

-

Y. Lee, “Improving End-to-end Task-oriented Dialog System with a Simple Auxiliary Task,” in Proceedings of EMNLP 2021 (Findings of the Association for Computational Linguistics), Punta Cana, Dominican Republic, pp. 1296-1303, November 2021.

[https://doi.org/10.18653/v1/2021.findings-emnlp.112]

- N. Houlsby, A. Giurgiu, S. Jastrzebski, B. Morrone, Q. de Laroussilhe, A. Gesmundo, ... and S. Gelly, “Parameter-efficient Transfer Learning for NLP,” in Proceedings of the 36th International Conference on Machine Learning, Long Beach: CA, pp. 2790-2799, June 2019.

-

E. J. Hu, Y. Shen, P. Wallis, Z. Allen-Zhu, Y. Li, S. Wang, ... and W. Chen, “LoRA: Low-rank Adaptation of Large Language Models,” arXiv:2106.09685, , October 2021.

[https://doi.org/10.48550/arXiv.2106.09685]

-

P. Budzianowski, T.-H. Wen, B.-H. Tseng, I. Casanueva, S. Ultes, O. Ramadan, and M. Gasic, “MultiWOZ - A Large-scale Multi-domain Wizard-of-oz Dataset for Task-oriented Dialogue Modelling,” in Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, Brussels, Belgium, pp. 5016-5026, November 2018.

[https://doi.org/10.18653/v1/D18-1547]

- C. Raffel, N. Shazeer, A. Roberts, K. Lee, S. Narang, M. Matena, ... and P. J. Liu, “Exploring the Limits of Transfer Learning with a Unified Text-to-text Transformer,” The Journal of Machine Learning Research, Vol. 21, No. 1, pp. 5485-5551, January 2020.

-

J. Devlin, M.-W. Chang, K. Lee, and K. Toutanova, “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding,” in Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies Volume 1 (Long and Short Papers), Minneapolis: MN, pp. 4171-4186, June 2019.

[https://doi.org/10.18653/v1/N19-1423]

-

Y. Liu, M. Ott, N. Goyal, J. Du, M. Joshi, D. Chen, ... and V. Stoyanov, “RoBERTa: A Robustly Optimized BERT Pretraining Approach,” arXiv:1907.11692, , July 2019.

[https://doi.org/10.48550/arXiv.1907.11692]

-

P. He, X. Liu, J. Gao, and W. Chen, “DeBERTa: Decoding-enhanced BERT with Disentangled Attention,” arXiv:2006.03654, , June 2020.

[https://doi.org/10.48550/arXiv.2006.03654]

- A. Radford, K. Narasimhan, T. Salimans, and I. Sutskever, “Improving Language Understanding by Generative Pre-training,” 2018.

- A. Radford, J. Wu, R. Child, D. Luan, D. Amodei, and I. Sutskever, “Language Models Are Unsupervised Multitask Learners,” 2019.

- T. Brown, B. Mann, N. Ryder, M. Subbiah, J. D. Kaplan, P. Dhariwal, ... and D. Amodei, “Language Models Are Few-Shot Learners,” in Proceedings of NeurlPS 2020 (Advances in Neural Information Processing Systems 33), Online, pp. 1877-1901, December 2020.

-

R. Thoppilan, D. De Freitas, J. Hall, N. Shazeer, A. Kulshreshtha, H.-T. Cheng, ... and Q. Le, “LaMDA: Language Models for Dialog Applications,” arXiv:2201.08239, , February 2022.

[https://doi.org/10.48550/arXiv.2201.08239]

-

S. Zhang, S. Roller, N. Goyal, M. Artetxe, M. Chen, S. Chen, ... and L. Zettlemoyer, “OPT: Open Pre-trained Transformer Language Models,” arXiv:2205.01068, , June 2022.

[https://doi.org/10.48550/arXiv.2205.01068]

-

M. Lewis, Y. Liu, N. Goyal, M. Ghazvininejad, A. Mohamed, O. Levy, ... and L. Zettlemoyer, “BART: Denoising Sequence-to-sequence Pre-training for Natural Language Generation, Translation, and Comprehension,” in Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics, Online, pp. 7871-7880, July 2020.

[https://doi.org/10.18653/v1/2020.acl-main.703]

-

T.-H. Wen, D. Vandyke, N. Mrksic, M. Gasic, L. M. Rojas-Barahona, P.-H. Su, ... and S. Young, “A Network-based End-to-end Trainable Task-oriented Dialogue System,” arXiv:1604.04562, , April 2017.

[https://doi.org/10.48550/arXiv.1604.04562]

-

W. Lei, X. Jin, M.-Y. Kan, Z. Ren, X. He, and D. Yin, “Sequicity: Simplifying Task-oriented Dialogue Systems with Single Sequence-to-sequence Architectures,” in Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics, Melbourne, Australia, pp. 1437-1447, July 2018.

[https://doi.org/10.18653/v1/P18-1133]

-

Y. Zhang, Z. Ou, and Z. Yu, “Task-oriented Dialog Systems That Consider Multiple Appropriate Responses under the Same Context,” in Proceedings of the 34th AAAI Conference on Artificial Intelligence, New York: NY, pp. 9604-9611, February 2020.

[https://doi.org/10.1609/aaai.v34i05.6507]

-

Y. Zhang, Z. Ou, M. Hu, and J. Feng, “A Probabilistic End-to-end Task-oriented Dialog Model with Latent Belief States towards Semi-supervised Learning,” in Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), Online, pp. 9207-9219, November 2020.

[https://doi.org/10.18653/v1/2020.emnlp-main.740]

-

B.-H. Tseng, Y. Dai, F. Kreyssig, and B. Byrne, “Transferable Dialogue Systems and User Simulators,” in Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), Online, pp. 152-166, August 2021.

[https://doi.org/10.18653/v1/2021.acl-long.13]

-

N. Lubis, C. Geishauser, M. Heck, H.-C. Lin, M. Moresi, C. van Niekerk, and M. Gasic, “LAVA: Latent Action Spaces via Variational Auto-encoding for Dialogue Policy Optimization,” in Proceedings of the 28th International Conference on Computational Linguistics, Barcelona, Spain, pp. 465-479, December 2020.

[https://doi.org/10.18653/v1/2020.coling-main.41]

-

H. Jeon and G. G. Lee, “DORA: Towards Policy Optimization for Task-oriented Dialogue System with Efficient Context,” Computer Speech & Language, Vol. 72, 101310, March 2022.

[https://doi.org/10.1016/j.csl.2021.101310]

-

H. Lee, S. Jo, H. Kim, S. Jung, and T.-Y. Kim, “SUMBT+LaRL: Effective Multi-domain End-to-end Neural Task-oriented Dialog System,” IEEE Access, Vol. 9, pp. 116133-116146, August 2021.

[https://doi.org/10.1109/ACCESS.2021.3105461]

-

G. S. Ramachandran, K. Hashimoto, and C. Xiong, “[CASPI] Causal-aware Safe Policy Improvement for Task-oriented Dialogue,” in Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), Dublin, Ireland, pp. 92-102, May 2022.

[https://doi.org/10.18653/v1/2022.acl-long.8]

-

H. Jeon and G. G. Lee, “Domain State Tracking for a Simplified Dialogue System,” arXiv:2103.06648, , March 2021.

[https://doi.org/10.48550/arXiv.2103.06648]

-

T.-H. Wen, M. Gasic, N. Mrksic, P.-H. Su, D. Vandyke, and S. Young, “Semantically Conditioned LSTM-based Natural Language Generation for Spoken Dialogue Systems,” in Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing, Lisbon, Portugal, pp. 1711-1721, September 2015.

[https://doi.org/10.18653/v1/D15-1199]

-

B. Peng, C. Li, J. Li, S. Shayandeh, L. Liden, and J. Gao, “Soloist: Building Task Bots at Scale with Transfer Learning and Machine Teaching,” Transactions of the Association for Computational Linguistics, Vol. 9, pp. 807-824, August 2021.

[https://doi.org/10.1162/tacl_a_00399]

-

S. Chopra, R. Hadsell, and Y. LeCun, “Learning a Similarity Metric Discriminatively, with Application to Face Verification,” in Proceedings of 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR ’05), San Diego: CA, pp. 539-546, June 2005.

[https://doi.org/10.1109/CVPR.2005.202]

-

Y. Yang, Y. Li, and X. Quan, “UBAR: Towards Fully End-to-end Task-oriented Dialog System with GPT-2,” in Proceedings of the 35th AAAI Conference on Artificial Intelligence, Online, pp. 14230-14238, February 2021.

[https://doi.org/10.1609/aaai.v35i16.17674]

-

Z. Lin, A. Madotto, G. I. Winata, and P. Fung, “MinTL: Minimalist Transfer Learning for Task-oriented Dialogue Systems,” in Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), Online, pp. 3391-3405, November 2020.

[https://doi.org/10.18653/v1/2020.emnlp-main.273]

-

W. He, Y. Dai, Y. Zheng, Y. Wu, Z. Cao, D. Liu, ... and Y. Li, “GALAXY: A Generative Pre-trained Model for Task-oriented Dialog with Semi-supervised Learning and Explicit Policy Injection,” in Proceedings of the 36th AAAI Conference on Artificial Intelligence, Online, pp. 10749-10757, February 2022.

[https://doi.org/10.1609/aaai.v36i10.21320]

-

A. Bapna and O. Firat, “Simple, Scalable Adaptation for Neural Machine Translation,” in Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP), Hong Kong, China, pp. 1538-1548, November 2019.

[https://doi.org/10.18653/v1/D19-1165]

-

J. Pfeiffer, A. Kamath, A. Ruckle, K. Cho, and I. Gurevych, “AdapterFusion: Non-destructive Task Composition for Transfer Learning,” in Proceedings of the 16th Conference of the European Chapter of the Association for Computational Linguistics: Main Volume, Online, pp. 487-503, April 2021.

[https://doi.org/10.18653/v1/2021.eacl-main.39]

-

J. Pfeiffer, I. Vulic, I. Gurevych, and S. Ruder, “MAD-X: An Adapter-based Framework for Multi-task Cross-lingual Transfer,” in Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), Online, pp. 7654-7673, November 2020.

[https://doi.org/10.18653/v1/2020.emnlp-main.617]

-

J. He, C. Zhou, X. Ma, T. Berg-Kirkpatrick, and G. Neubig, “Towards a Unified View of Parameter-efficient Transfer Learning,” arXiv:2110.04366, , February 2022.

[https://doi.org/10.48550/arXiv.2110.04366]

-

Y. Mao, L. Mathias, R. Hou, A. Almahairi, H. Ma, J. Han, ... and M. Khabsa, “UniPELT: A Unified Framework for Parameter-efficient Language Model Tuning,” in Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics, Dublin, Ireland, pp. 6253-6264, May 2022.

[https://doi.org/10.18653/v1/2022.acl-long.433]

- G. Yang and E. J. Hu, “Tensor Programs IV: Feature Learning in Infinite-width Neural Networks,” in Proceedings of the 38th International Conference on Machine Learning, Online, pp. 11727-11737, July 2021.

-

K. He, X. Zhang, S. Ren, and J. Sun, “Delving Deep into Rectifiers: Surpassing Human-level Performance on ImageNet Classification,” in Proceedings of 2015 IEEE International Conference on Computer Vision (ICCV), Santiago, Chile, pp. 1026-1034, December 2015.

[https://doi.org/10.1109/ICCV.2015.123]

-

T. Nekvinda and O. Dusek, “Shades of BLEU, Flavours of Success: The Case of MultiWOZ,” in Proceedings of the 1st Workshop on Natural Language Generation, Evaluation, and Metrics (GEM 2021), Online, pp. 34-46, August 2021.

[https://doi.org/10.18653/v1/2021.gem-1.4]

-

K. Papineni, S. Roukos, T. Ward, and W.-J. Zhu, “Bleu: A Method for Automatic Evaluation of Machine Translation,” in Proceedings of the 40th Annual Meeting on Association for Computational Linguistics (ACL ’02), Philadelphia: PA, pp. 311-318, July 2002.

[https://doi.org/10.3115/1073083.1073135]

-

S. Mehri, T. Srinivasan, and M. Eskenazi, “Structured Fusion Networks for Dialog,” in Proceedings of the 20th Annual SIGdial Meeting on Discourse and Dialogue, Stockholm, Sweden, pp. 165-177, September 2019.

[https://doi.org/10.18653/v1/W19-5921]

저자소개

2023년:가천대학교 대학원 (공학석사)

2021년~현 재: 가천대학교 AI・소프트웨어학과 석사과정

※관심분야:자연어처리(Natural language processing), 챗봇(Chat-bot), 목적 지향 대화시스템(Task-oriented dialogue system) 등

2012년:서강대학교 대학원 (공학박사-컴퓨터공학)

2012년~2016년: 서강대학교 연구교수

2016년~현 재: 가천대학교 AI・소프트웨어학과 부교수

※관심분야:자연어처리(Natural language processing), 음성 대화 처리(Speech dialogue processing), 정보 검색(Information retrieval), 기계독해(Machine reading comprehension), 기계번역(Machine translation) 등