3차원 포인트 클라우드를 위한 데이터 강화 방법

Copyright ⓒ 2023 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

포인트 클라우드는 3차원 컴퓨터 비전 연구에 가장 많이 사용된다. 하지만 딥러닝 네트워크에 적용될 수 있는 단일 데이터 세트의 샘플 수는 상대적으로 적다. 데이터 강화는 데이터 희소성을 보상하기 위한 표준 방법이지만 최근 몇 년 동안 이런 방법을 탐구하는 문헌은 적다. 본 논문은 하나의 포인트 클라우드 강화 네트워크를 제안한다. 이는 새로운 데이터 강화 네트워크이며 샘플을 자동으로 최적화하고 강화시킨다. 제안한 네트워크는 원래의 네트워크를 강화하여 포인트 클라우드의 전역 특징 및 국부 특징을 모두 고려하여 실제에 가까운 샘플을 생성한다. 또한 샘플 인식 능력이 있으며, 적대적 학습 전략을 사용하여 데이터 강화 네트워크와 분류기 네트워크를 공동으로 최적화하여 분류기에 가장 맞는 강화 샘플을 생성한다. 실험을 통해 제안한 네트워크의 효율성을 증명하며 분류 네트워크의 인식 및 분류 성능을 향상시킨다.

Abstract

Point clouds are most frequently used in 3D computer vision research. However, the number of samples in a single data set that can be applied to deep learning networks is relatively small. Data augment is a standard method for compensating for data sparsity, however, there is little literature exploring this method in recent years. In this study, we propose a point cloud augmentation network; this is a novel data augmentation network, and the network automatically optimizes and enhances point cloud samples. The proposed network enhances the original network to generate realistic samples by considering both global and local features of the point cloud. The proposed network has the sample-aware capability and uses an adversarial learning strategy to jointly optimize the network and the classifier network to generate augmented samples that best fit the classifier. We proved the efficiency of the proposed network through experiments and improve the recognition and classification performance of the classification network.

Keywords:

Data augmentation, Deep learning, GAN, Object classification, Point cloud키워드:

데이터 강화, 딥러닝, 적대적 네트워크, 객체 분류, 포인트 클라우드Ⅰ. 서 론

최근 3D 포인트 클라우드 처리를 위한 딥러닝 네트워크 개발에 대한 관심이 높아지고 있다. 명확한 격자 구조의 이미지와 달리 포인트 클라우드는 다양한 3D 객체를 전역적으로 나타내는 고유한 구조가 없는 정렬되지 않은 포인트 집합이다. 이런 구조의 데이터 처리 및 학습의 난이도는 매우 높으며 최근 연구자들은 3차원 포인트 클라우드에 적용된 딥러닝 네트워크 개발은 많아지고 있다[1]-[4]. 네트워크의 학습 및 훈련은 통상 학습 데이터의 다양성에 의존한다. 하지만 Open Images 데이터 세트 및 MS COCO 데이터 세트 등 수백만 데이터를 갖는 데이터 세트와 달리 포인트 클라우드 데이터 세트는 통상 데이터 및 라벨이 적다[5],[6]. 제한된 데이터 양과 다양성은 과적합(overfitting) 문제를 일으킬 수 있으며 네트워크의 일반화 능력에 더 영향을 미칠 수 있다.

현재 데이터 강화(Data Augmentation)는 훈련 데이터의 다양성을 인위적으로 확대하여 과적합을 피하고 네트워크의 일반화 능력을 향상시키 위한 일반적인 방법이다. 하지만 포인트 클라우드에 대한 데이터 강화 방법 연구는 많지 않다. 포인트 클라우드에 자주 적용된 데이터 강화방법은 전역 회전, 크기 조절, 평행 이동 및 잡음 추가 등 전통적 방법뿐이다[1],[2].

전통적인 데이터 강화는 대부분의 포인트 클라우드 인식 프레임워크의 일반화 능력을 개선하는 데 도움이 되지 않는다. Chen 등은 PointMixup를 제안했다[7]. PointMixup는 Mixup 기술을 포인트 클라우드에 적용하는 프레임워크 이다[8]. 이는 두 개의 포인트 클라우드 샘플 사이를 보간하고 소프트 라벨을 사용하여 혼합 클래스의 비율을 예측한다. Kim 등이 제안한 PointWOLF는 포인트 클라우드에 여러 개의 앵커 포인트를 배치하여 포인트 클라우드의 로컬 변형을 구현한 다음 앵커 포인트를 중심으로 부드러운 로컬 변환을 생성하여 포인트 클라우드 데이터를 강화시킨다[9]. Li 등은 하나의 3D 포인트 클라우드 자동 강화 네트워크인 PointAugment를 제안했다[10].

2D 이미지에 대한 데이터 강화방법과 달리 PointAugment는 단일의 샘플에 적용된 강화 함수를 학습한다. 강화 함수는 포인트 클라우드의 포인트 간의 상호관계, 샘플의 형상변화 및 포인트 이동을 같이 고려한다. 그 외 PointAugment는 엔드 투 엔트(end-to-end) 방식으로 적대적 학습 방법을 통해 네트워크를 최적화한다. 분류기의 손실 함수 피드백으로 강화기는 포인트 클라우드 내부의 데이터 변화를 증강하여 더욱 강화된 샘플을 얻을 수 있으며, 분류기도 강화된 데이터로 분류 능력을 더욱 향상시킬 수 있다. 이런 교체 과정은 분류기 및 강화기의 성능을 향상시킬 뿐만 아니라 최적화할 수 있다. 반면에 PointAugment는 단순한 다층 퍼셉트론(Multi- layer perceptron; MLP)을 사용하여 포인트 클라우드에서 특징을 추출한다. 이 방법은 포인트 클라우드의 글로벌 특징을 추출할 때 효과적이지만 포인트 클라우드의 포인트 사이의 지역 특징을 고려할 수 없다. 포인트 클라우드는 고유한 위치, 색상 및 기타 특성을 가진 많은 개별 포인트로 구성된다. 이런 포인트 사이는 복잡한 상호관계가 있을 수 있다. 단순한 MLP는 포인트 간의 상호관계를 고려하지 않고 단일 포인트의 특징에만 집중하기 때문에 이러한 지역 특징을 캡처할 수 없다. 따라서 PointAugment가 단순한 MLP를 사용하여 포인트 클라우드에서 특징을 추출하는 경우 포인트 클라우드의 지역 특징을 최대적으로 활용할 수 없다.

이 문제를 해결하기 위해 개선된 네트워크를 제안한다. 제안하는 네트워크는 기존 네트워크의 포인트 클라우드 특징 추출 방식을 개선하여 포인트 클라우드 특징 추출 시 전역 특징과 국부 형상 특징을 모두 고려할 수 있어 원본보다 분류하기 어려운 복잡한 샘플을 생성할 수 있다. 본 논문에서는 제안한 네트워크를 이용하여 ModelNet40 데이터 세트에 실험을 진행했다[11]. 실험을 통해 제안한 네트워크가 포인트 클라우드 데이터 세트 다양성을 향상시키고 분류기의 분류 성능을 강화함을 증명하고자 한다.

본 논문은 다음과 같이 구성된다. II장은 제안한 포인트 클라우드 데이터 강화 네트워크의 아키텍처를 소개한다. III장은 제안된 아키텍처를 실험하고 결과를 제공한다. 마지막으로 IV장에서 결론을 다룬다.

Ⅱ. 본 론

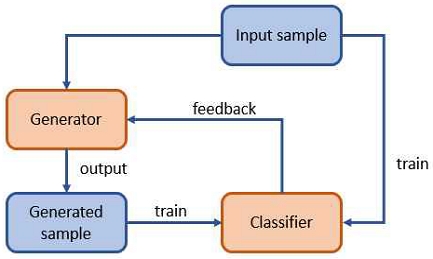

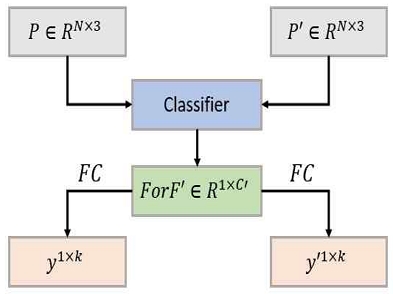

본 논문에서 제안한 포인트 클라우드 강화 네트워크의 전체 아키텍처는 그림 1과 같다. 제안한 네트워크는 주로 생성기(Generator) 와 분류기(Classifier)로 구성된다.

2-1 생성기(Generator)

본 논문에 제안한 생성기의 샘플 강화방법은 식(1)과 같다:

| (1) |

그중에 P∈R3×N는 한 셋의 3D 포인트 클라우드 샘플이며, M는 포인크 클라우드 샘플에 적용된 형상변환이다. D는 샘플에 첨부된 위치변환이다. 생성기는 훈련 가능하다. 생성기는 하나의 특정한 함수를 생성하여 각 입력 샘플을 강화한다. 본 논문은 P'을 생성기의 출력 샘플로 표시한다.

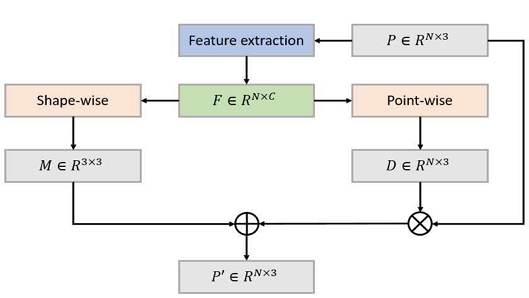

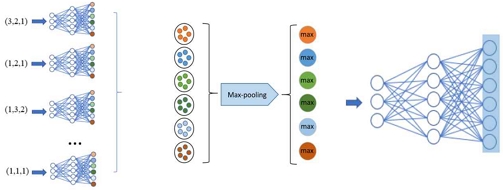

생성기의 전체 아키텍처는 그림 2와 같다. 먼저 특징 추출 유닛을 이용하여 입력 샘플 P의 모든 N개 포인트의 특징 F∈RN×C를 추출한다. C는 특징 채널의 수량이다. 그 다음 특징 F를 강화 함수의 입력으로 한다. 특징 F에 shape-wise 회귀함수를 적용하면 형상 변환 M∈R3×3이 생성된다. 또한 특징 F에 point-wise 회귀함수를 적용하면 위치 변환 D∈RN×3이 생성된다. 형상 변환 M은 식(1)의 크기 조정 및 3차원 회전 매트릭스를 학습한다. 즉 3차원 공간의 회전 및 크기 조정이다. D는 글로벌 포인트별의 이동 및 지터링을 학습한다.

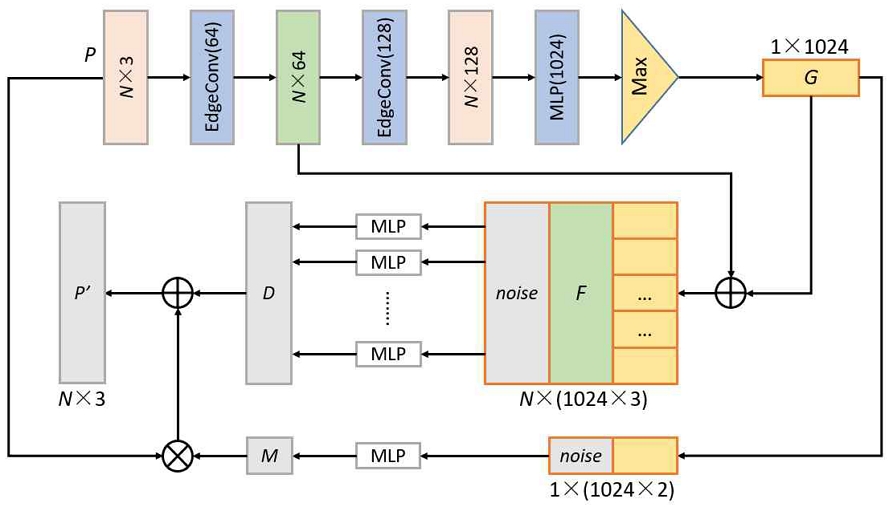

본 논문에 개선된 생성기의 세부 설계는 그림 3과 같다. 개선된 부분은 특징추출 알고리즘이다. 입력 포인트의 초기 크기는 N×3이며, N은 포인트의 개수, 3은 포인트의 초기 채널 수이다(x, y, z). 두 개의 EdgeConv 특징 추출 유닛을 통해 포인트의 특징 채널을 128로 확장한다[12]. 그 다음 다중 계층 퍼셉트론(Multi-layer perceptron; MLP)로 각 포인트의 최종 특징 F∈RN×1024를 추출한다. 샘플의 전역 특징 G∈R1×1024를 추출하기 위해 대칭 함수 maxpooling를 이용한다. 이제 전역 특징 G는 형상 변환 M 및 위치 변환 D를 생성할 수 있다. 먼저 1024채널의 가우시안 분포 잡음을 생성하여 전역 특징 G와 서로 연결한다. 그 다음 MLP를 적용하면 회전 및 크기 조정 매트릭스 M을 생성할 수 있다. 또한 전역 특징 G를 샘플의 포인트 개수 N배 곱하면 첫 번째 EdgeConv로 추출한 특징 F의 크기와 매칭한다. 매칭한 다음 가우시안 잡음과 서로 연결하여 최종 MLP를 통해 D를 얻을 수 있다. 마지막에 강화된 샘플 P'을 얻는다.

포인트 클라우드의 특징을 추출하기 위해 EdgeConv 유닛을 이용한다. MLP는 각 포인트 자신의 특징만 추출하는 것보다 EdgeConv는 에지 특징(edge feature)을 얻을 수 있기 때문에 포인트 클라우드의 국부 형상 특징을 추출한다.

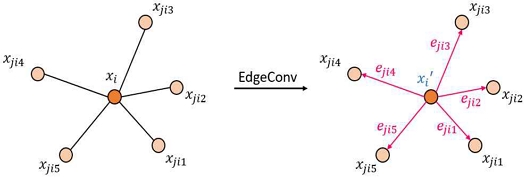

EdgeConv의 구조는 그림 4와 같다. 하나의 K 채널을 갖는 포인트 클라우드 X=x1,...,xn ⊆ RK가 주어진다. K는 일반적으로 포인트의 x, y, z축의 좌표이며, 즉 K=3이다. 또한 포인트 클라우드의 국부 구조를 표시하기 위해 하나의 방향 그래프(directed graph)Γ=(V,E)가 주어진다. 그중에 정점은 V={1,...,n}이며, 에지는 E ⊆ V×V이다. 하나의 KNN 그래프(K-nearest neighbor graph)를 만들고 방향 그래프 Γ를(그림 4) 표시하기 위해 이하 개념을 정의한다.

1. 정점 및 에지: 포인트 xi 주변 가장 가까운 k 개의 포인트 xji1,...,xjik는 정점이며, 그의 에지는 (i,ji1),...,(i,jik)이다.

2. 에지 특징 함수: 에지 특징 함수는 eij =hθ(xi,xj)로 정의한다. 그중에 hθ : RK×RF→RF’는 학습 가능한 파라미터 θ로 구성된 비선형 함수이다.

3. 특징 집합 함수: 이는 에지 특징 함수의 집합이다. 특징 집합 함수의 정의는 다음과 같다.

| (2) |

전역 특징 및 국부 특징 모두 고려하면 정점 및 에지의 특징을 모두 추출한다. 그래서 hθ는 이하 형태로 표현한다:

| (3) |

hθ는 MLP로 표현할 수 있다. 마지막에 특징 집합 함수로 에지 특징을 모인다.

| (4) |

2-2 분류기(Classifier)

그림 5는 분류기의 아키텍처를 보여준다. 분류기는 포인트 클라우드 처리 네트워크를 기반으로 하며, 오리지널 포인트 클라우드 P 및 강화된 포인트 클라우드 P'를 각각 단독 입력으로 한다. 입력으로 각 포인트 클라우드의 라벨 y 및 y'를 예측한다. 분류기의 선택은 다양하며 현재 존재한 임의의 포인트 클라우드 처리 네트워크는 모두 분류기로 할 수 있다. 실험 부분에는 분류기가 생성기와 같이 배치할 때 분류기의 분류 및 예측 성능을 더 향상시킬 수 있다는 것을 보여준다.

본 논문의 실험 부분에 사용하는 분류기는 포인트넷(PointNet)이다[1]. 포인트넷은 전형적인 포인트 클라우드 처리 알고리즘으로 대표성이 있다. 나중에 게안된 많은 포인트 클라우드 처리 알고리즘은 포인트넷을 기반으로 했다. 포인트넷은 Qi 등이 설계한 정렬되지 않은 포인트들을 직접 사용하는 딥러닝 프레임워크이다. 포인트넷의 구조는 그림 6에 나와 있다. 포인트넷은 기본적으로 세 가지 구성 요소를 가진다: 지역 특징 추출 레이어, 모든 지역 특징에서 정보를 요약하는 대칭 함수 및 다양한 학습 작업을 위해 전역 특징을 정렬하는 전역 특징 추출 레이어이다. 포인트 크라우드는 3D 점 집합으로 표시되며, 각 점은 (x,y,z) 좌표와 추가 특징 채널을 포함하는 벡터이다.

다층 퍼셉트론(MLP)은 포인트 클라우드 내의 원래 3D 포인트들을 매우 높은 차원으로 확장시킨다. 이렇게 함으로써 3D 포인트의 지역적인 특징을 출력할 수 있다. 포인트넷 모델에서는 각 점의 특성이 공유된다. 이 공유를 기반으로 고차원 점들의 특징은 다르게 된다. 포인트 클라우드의 모든 지역 특징을 고려하여, 한 차원의 값들을 지역 특징 차원의 포인트넷 로컬 고유값 집합으로 통합시킨다. 따라서 포인트넷은 대칭 함수를 사용하여 각 집합에 대해 대표값을 선택하여 포인트 클라우드의 전역 특징을 포함하는 출력으로 사용할 수 있다.

이 단계 n×1 최대 풀링 연산자를 사용하여 구현되며, n은 포인트의 개수이다. 이 기술은 포인트 클라우드 표현의 불규칙한 분포 문제를 해결했다. 전역 특징이 추출된 후, 이러한 전역적인 특징은 MLP가 객체 분류 및 의미적 분할과 같은 다른 목표를 달성하기 위해 사용된다.

포인트넷은 네트워크로서 학습 속도가 빠를 뿐만 아니라 예측 정확도 상대적 높고, 아키텍처가 간단하고, 코드를 실현하기 쉬운 장점이 있다. 우리는 포인트넷 알고리즘의 모든 파라미터를 수정할 필요없이 직접 분류기로서 실험을 하여 강화 네트워크의 유효성을 판별할 수 있다.

2-3 훈련 절차

전체 네트워크의 학습 기간 내에 교체로 분류기 및 생성기의 파라미터를 갱신 및 최적화한다. 입력 샘플 P가 주어지면, 먼저 생성기를 사용하여 강화 샘플 P'를 생성한다. 그다음 분류기를 그대로 유지하고 손실 함수를 계산하여 생성기의 학습 가능한 파라미터를 갱신한다. 생성기가 갱신되면 G를 유지하고 새로운 강화 샘플 P'를 생성한다. 그다음 P와 P'를 각각 분류기에 입력해서 네트워크 손실 L(P) 및 L(P')를 얻는다. 얻은 손실을 통해 분류기의 학습 가능한 파라미터를 갱신한다. 이런 엔드 투 엔트(end-to-end) 방식으로 생성기 및 분류기의 갱신 및 최적화를 실현하게 된다.

본 논문은 분류기의 형상 분류결과를 통해 제안된 데이터 강화 네트워크를 평가한다. 또한 제안된 강화 네트워크를 사용하지 않는 분류결과 및 PointAugment를 이용한 분류결과를 비교해서 제안된 네트워크를 평가한다.

Ⅲ. 실 험

본 논문에서 제안한 포인트 클라우드 강화 네트워크에 대한 실험을 위해 먼저 실험에 관한 세부사항을 소개하고, 그 다음 실험에 사용되는 데이터 세트 및 분류 네트워크를 소개한다.

전체 네트워크의 코드는 PyTorch로 실험되었으며, 학습 플랫폼은 I9-9900K 및 NVIDIA RTX2080Ti GPU 이다. 생성기는 학습율 0.001인 아담 옵티마이저(Adam optimizer)를 사용했다. 분류기에 대한 변수 설치는 분류기의 코드 및 논문에 있는 원래 설치를 사용한다. 전체 학습 횟수는 200이고 batch는 24로 설정한다.

본 논문은 합성 데이터 세트를 이용하여 형상 분류 실험을 수행했다. 사용하는 데이터 세트는 ModelNet40이다. 이 데이터 세트의 훈련 데이터는 9840 개의 CAD 모델이 있으며, 테스트 데이터는 2468 개의 CAD 모델이 있는 총 40 중류의 범용하는 3D 종합 기준 데이터 세트이다.

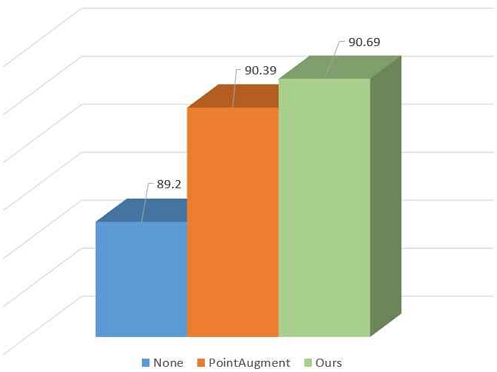

그림 7은 실험 결과를 제시했다. 실험 결과는 기준 데이터 세트 ModelNet40에 단독 분류기 분류실험 및 Point-Augment를 이용하는 분류실험, 그리고 본 논문에 제안한 강화 네트워크를 이용하는 분류실험을 진행할 때 나타난 전체 형상 분류 정확도(%)이다. 결과를 보면 제안한 네트워크를 이용하는 분류기의 형상 분류 정확도는 가장 높다는 것을 알 수 있다. 이 결과는 분류기만 이용한 실험 결과보다 1.5% 더 높고, 또한 PointAugment을 이용하는 분류기 실험 결과보다 여전히 0.3% 더 높다.

Comparing the overall shape classification accuracy (%) on ModelNet40 dataset based on PointNet classifier

표 1은 실험 중 제안된 네트워크와 PointAugment 간 생성기 손실, 분류기 손실 및 훈련 시간을 비교한 것이다. 표에서 볼 수 있듯이 제안된 네트워크는 포인트 클라우드의 지역 특징에 대한 민감도가 높기 때문에 생성된 샘플의 다양성이 PointAugment보다 더 크다. 그래서 분류기의 일반화 능력도 향상되었다. 따라서 제안된 네트워크의 생성기 손실과 분류기 손실은 PointAugment보다 더 낮다. 훈련 시간 측면에서는, 제안된 네트워크는 대략 4시간 30분이 걸리고, Point- Augment는 약 4시간이 소요된다. PointAugment의 훈련 시간은 제안한 네트워크보다 짧지만, 제안한 네트워크의 개선과 향상을 고려하면 추가 30분 정도의 훈련 시간은 수용 가능하다.

Ⅳ. 결 론

본 논문은 하나의 포인트 클라우드 데이터 세트 강화 네트워크를 제안했다. 제출한 네트워크는 샘플 인식 능력이 있으며, 적대적 학습 전략을 사용하여 데이터 강화 네트워크와 분류기 네트워크를 공동으로 최적화하여 분류기에 가장 맞는 강화 샘플을 생성한다. 생성기는 분류기의 피드백을 기반으로 개선할 수 있고 분류기는 더 다양한 훈련 샘플을 처리하며 분류 성능을 향상시킨다. 또한 EdgeConv를 이용하여 생성기의 샘플 특징추출 기능을 강화하여 포인트 클라우드 샘플의 국부 특징을 추출하고 더욱 복잡한 샘플을 생성하게 한다. ModelNet40 데이터 세트를 이용하여 실험을 진행했다. 제안한 네트워크는 기존의 데이터 강화 방법보다 분류기 성능을 더욱 향상시킬 수 있으며 실험을 통해 데이터 강화 효율성을 증명했다. 향후에는 객체 분류 데이터뿐만 아니라, 객체 분할용 데이터 샘플 생성에 대해 실험을 진행하도록 한다.

Acknowledgments

이 논문은 2018년도 정부(교육부) 재원으로 한국연구재단 기초연구사업의 지원을 받아 수행된 연구임(NRF-2018R1D1A1B07048868).

References

-

C. R. Qi, H. Su, K. Mo, and L. J. Guibas, “Pointnet: Deep learning on point sets for 3D classification and segmentation,” 2017 IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA, pp. 77-85, July 2017.

[https://doi.org/10.1109/CVPR.2017.16]

-

C. R. Qi, H. Su, and L. J. Guibas, “PointNet++: Deep hierarchical feature learning on point sets in a metric space,” Conference and Workshop on Neural Information Processing Systems (NeurIPS), Long Beach, CA, USA, pp. 5099-5108, December 2017.

[https://doi.org/10.48550/arXiv.1706.02413]

-

W. Zheng, W. Tang, L. Jiang, and C.-W. Fu, “SE-SSD: Self-ensembling single-stage object detector from point cloud,” 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Nashville, TN, USA, pp. 3555-3562, June 2021.

[https://doi.org/10.1109/CVPR46437.2021.01426]

-

Y. Liu, B. Fan, S. Xiang, and C. Pan, “Relation-shape convolutional neural network for point cloud analysis,” 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, pp. 8887-8896, June 2019.

[https://doi.org/10.1109/CVPR.2019.00910]

-

A. Kuznetsova, H. Rom, N. Alldrin, J. Uijlings, I. Krasin, J. Pont-Tuset, ... and V. Ferrari, “The open images dataset V4: Unified image classification, object detection, and visual relationship detection at scale,” International Journal of Computer Vision, Vol. 128, No. 7, pp. 1956-1981, March 2020.

[https://doi.org/10.1007/s11263-020-01316-z]

-

T.-Y. Lin, M. Maire, S. Belongie, J. Hays, P. Perona, D. Ramanan, ... and C. L. Zitnick, “Microsoft COCO: Common objects in context,” European Conf. on Computer Vision (ECCV), Zurich, Switzerland, pp. 740-755, September 2014.

[https://doi.org/10.1007/978-3-319-10602-1_48]

-

Y. Chen, V. T. Hu, E. Gavves, T. Mensink, P. Mettes, P. Yang, and C. G. M. Snoek, “Pointmixup: Augmentation for point clouds,” European Conf. on Computer Vision (ECCV), Glasgow, UK, pp. 330-345, August 2020.

[https://doi.org/10.1007/978-3-030-58580-8_20]

-

H. Zhang, M. Cisse, Y. N. Dauphin, and D. Lopez-Paz, “mixup: Beyond Empirical Risk Minimization,” Int. Conf. Learning Representations (ICLR), Vancouver, BC, Canada, pp. 1-13, May 2018.

[https://doi.org/10.48550/arXiv.1710.09412]

-

S. Kim, S. Lee, D. Hwang, J. Lee, S. J. Hwang, and H. J. Kim, “Point cloud augmentation with weighted local transformations,” IEEE/CVF International Conference on Computer Vision (ICCV), Montreal, QC, Canada, pp. 548-557, October 2021.

[https://doi.org/10.1109/ICCV48922.2021.00059]

-

R. Li, X. Li, P.-A. Heng, and C.-W. Fu, “PointAugment: An auto-augmentation framework for point cloud classification,” IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA, pp. 6378-6387, June 2020.

[https://doi.org/10.1109/CVPR42600.2020.00641]

-

Z, Wu., S. Song, A. Khosla, F. Yu, L. Zhang, X. Tang, and J. Xiao, “3D ShapeNets: A deep representation for volumetric shapes,” IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Boston, MA, USA, pp. 1912-1920, June 2015.

[https://doi.org/10.1109/CVPR.2015.7298801]

-

Y. Wang, Y. Sun, Z. Liu, S. E. Sarma, M. M. Bronstein, and J. M. Solom, “Dynamic graph CNN for learning on point clouds,” ACM Transactions on Graphics, Vol. 38, No. 5, pp. 1-12, October 2019.

[https://doi.org/10.1145/3326362]

저자소개

2017년 : 전남대학교 전자컴퓨터공학과 (공학석사)

2020년~현 재 : 전남대학교 전자컴퓨터공학과 (박사과정)

※관심분야:라이다 기반 객체 검출, 자동차 자율주행 등.

1992년 : 한국과학기술원 전기 및 전자공학과 (공학석사)

1999년 : 한국과학기술원 전기 및 전자공학과 (공학박사)

1999년~2004년: 한국전자통신연구원(ETRI)

2004년~현 재: 전남대학교 전자공학과 교수

※관심분야:광통신, Access network, QoS, 라이다 기반 객체검출 등