증강현실 얼굴인식기술을 활용한 한.중.일 탈 문화 체험 콘텐츠 설계 및 제작

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

한.중.일 문화는 많은 유사성과 독창성을 가지고, 오랜 기간 밀접한 관계를 맺으며 교류해왔다. 최근 몇 년간 COVID-19의 영향은 해외 문화교류에 많은 제약을 주었고, 이로 인하여 화상을 통한 회의나, 방송, 콘텐츠와 같은 비대면 방식이 이를 대신하게 되었다. 4차 산업혁명의 영향으로 가상현실, 증강현실에 대한 기술발전과 수요가 늘면서, 문화유산의 개발과 교류를 위한 콘텐츠의 다양한 연구와 개발이 진행되고 있는데, 대부분 문화유산의 정보 전달에 국한되어 있고, 사용자 요구에 맞는 상호작용이 가능한 실감형 콘텐츠는 여전히 부족하다. 증강현실은 가상현실과는 다르게, 대부분 스마트폰에서 구동 가능하여, 누구나 쉽게 이용할 수 있다. 이에 본 연구에서는 증강현실 기술을 활용하여 누구나 쉽게 이용할 수 있는 실감형 문화체험 콘텐츠를 제작하고, 경험을 공유함으로써 실감형 콘텐츠 확산에 도움이 되고자 한다.

Abstract

The cultures of Korea, China and Japan are unique, but have always been closely related, sharing and influencing each other. Due to the recent COVID-19 pandemic, the cultural interaction between the three countries has been limited for the past few years. Hence non face-to-face methods of communication such as video conferencing, broadcasting and publishing content have replaced traditional methods. During the Fourth Industrial Revolution, the demand for virtual reality (VR), augmented reality (AR) has been increasing, therefore a lot of research and development for traditional cultural content and cultural exchange is being undertaken. However, the content being developed is mostly limited to only the sharing of information, and there is a lack of interactive cultural content to meet user demand. Unlike virtual reality, augmented reality can be easily used by anyone with a smartphone. Therefore, in this study, we intend to develop realistic, culturally interactive content using AR technology that anyone can use, and share our experience to expand development of realistic content.

Keywords:

Augmented reality, Face recognition, Mask, Cultural experience, Digital contents키워드:

증강현실, 얼굴인식, 가면, 문화체험, 디지털콘텐츠Ⅰ. 서 론

한.중.일 각국은 오랜 기간 역사, 문화적으로 밀접한 상관관계를 맺으며 교류해왔고, 문화적으로 많은 유사성을 보이지만, 각각 독창성을 가지고 발전 해왔다. 일반적으로 전통 가면극에 많이 사용되고 있는 탈도 이와 비슷한데, 역사적으로 많은 유사한 발전 과정을 보이지만, 각각 보편적, 민족적, 역사적 특성에 따라 가면극에 맞는 형태와 조형 등의 독창성을 가지고 있다. 최근 몇 년간 COVID-19의 영향으로 관광산업이 위축되고, 한.중.일 문화교류에도 많은 제한이 있어, 화상을 통한 회의나, 방송, 콘텐츠와 같은 비대면 방식이 이를 대신하게 되었다. 문화유산의 개발 및 교류를 위한 콘텐츠의 다양한 연구 및 개발도 진행되고 있는데, 가상현실, 증강현실을 활용하여, 훼손된 문화유산을 남은 정보를 가지고 복원하거나, 직접 경험하기 어려운 문화재를 가상현실상에서 체험할 수 있도록 제공하기도 하며, 증강현실 기술을 활용하여 현존하는 문화재에 가상 정보를 덧입혀 보여주기도 한다[1]. 이처럼 사용자와의 상호작용과 실제와 같은 경험이 가능한 콘텐츠를 실감형 콘텐츠라고 하는데, 사용자가 실제와 같은 느낌을 받을 수 있도록, 환경을 구성하고, 상호작용에 대한 요소를 만드는 것은 무엇보다 중요하다. 하지만, 대부분의 문화유산 콘텐츠는 외형을 보여주는 형태로 제공되고 있어, 새로운 방향이 필요하고, 사용자 요구에 맞는 콘텐츠는 여전히 부족한 실정이다[2]. 콘텐츠제작에 있어, 가상현실은 오큘러스와 같은 HMD(Head Mounted Display)장비 등을 사용하여 메타버스 플랫폼 등에서 복잡한 가상세계를 표현하는 반면, 증강현실은 대부분 스마트폰에서 구현되어, 사용자가 쉽게 접할 수 있기 때문에, 증강현실 콘텐츠에 대한 수요는 점차 증가하고 있다. 증강현실 콘텐츠 사용자는 기존의 일반적인 콘텐츠에서처럼 키보드, 마우스 등과 같은 입력장치를 이용하여 콘텐츠를 조작하는 것이 아니라, 현실 세계에 덧입혀진 3차원 객체를 바로 체험함으로써 콘텐츠와의 상호작용이 가능한 부분이 특징이고, 하드웨어의 발전으로 인하여 증강현실 콘텐츠도 멀티미디어 기기에서 단순히 보고 드는 형태를 벗어나 직접 체험이 가능한 능동적인 형태로 나날이 발전하고 있다[3]. 기술 면에서는 크게 마커 방식과 마커리스 방식으로 나눌 수 있는데, 마커리스 방식 중 최근 주목할 만한 기술은 얼굴인식 분야다. 과거에 비해 빠르게 발전하고 있고, 이를 활용한 다양한 콘텐츠가 나오고 있는데, 대부분 사진, 채팅앱 등에서 재미를 위한 얼굴변형 등의 기능으로 활용되고 있다. 이에 본 연구에서는 증강현실 얼굴인식기술을 활용한 한.중.일 각국에 탈 문화를 가지고, 누구나 쉽게 이용할 수 있는 문화체험 콘텐츠를 제작하여, 각국의 문화적 이해를 돕고, 제작 경험을 공유함으로써, 증강현실 콘텐츠를 제작하고자 할 때, 제작 방향에 도움이 되는 것을 목표로 하였다.

Ⅱ. 관련연구

2-1 한.중.일 탈 문화

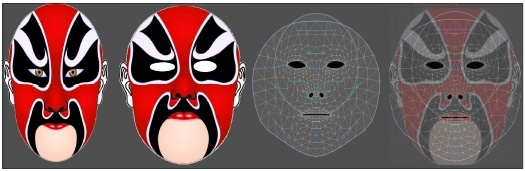

한·중·일의 탈 문화를 이해하려면 먼저, 탈을 가장 많이 사용하는 가면극을 보면 알 수 있는데, 한·중·일의 가면극은 역사적으로 매우 유사한 방향으로 발전해 왔다. 가면극은 크게 마을 주민들이 전해 계승한 가면극과 전문가들 계승한 가면극이 있다. 한.중.일 각국은 한자문화권에서 불교와 유교 등 공동의 문화유산 속에서 각각에 맞는 문화로 발전해 나갔다. 각국의 전통 색은 목(나무), 화(불), 토(흑), 금(쇠), 수(물)의 음양오행을 바탕으로 흑, 백, 황, 적, 청의 5가지 색으로 대표되는 공통점을 보이는데, 상징과 의미는 역사적, 문화적 특징에 맞춰 각각 다르게 표현돼왔다. 한국 탈은 불균형한 좌우대칭의 특징이 있다. 해학성을 표현하기 위해 대부분 표정은 과장되게 표현된다. 따라서 놀란 표정과 웃는 표정이 많고, 비정상적으로 입이 틀어졌거나, 눈이 짝짝이와 같은 표현이 많다. 이는 지배층을 희극적으로 표현하기 위한 서민의 의도였다. 그림 1과 같이 한국 탈은 불균형이라는 미학적 특징을 가지고 있으며, 색채는 빨간색, 검은색, 노란색, 주황색, 흰색으로 구성되고, 부드럽고 자연스러운 채색의 특징을 가지고 있다. 중국 탈의 특징은 검은색, 빨간색이 긍정을 의미하며, 강직하고 힘이 넘치는 품격의 인물을 나타내는 상징색이며, 그림 2와 같이 무채색을 최고의 경이로운 색으로 여기는 종교 관념이 반영돼 있다. 빨간색, 분홍색, 검은색, 흰색, 노란색, 자주색, 녹색, 금색, 은색, 회색 등, 다양하고 역동적인 채색의 특징을 가지고 있다. 일본 탈의 특징은 빨간색은 강함, 정의, 과격, 용기, 젊음 용기를 표현하고, 흰색에 빨간색 선을 그려 넣어 부끄럽고 화난 것을 표현한다. 빨간색은 긍정적인 의미만 있는 것이 아니라, 온몸을 빨갛게 칠하여 악인을 표현하기도 하는데, 그림 3과 같이 빨간색이 상징하는 것은 형태에 따라 그 의미가 다름을 알 수 있다. 색채는 흰색, 빨간색, 적황색으로 섬세하게 표현하며, 얼굴뿐만 아니라, 몸통까지 분장으로 표현하는 특징을 가지고 있다 [4],[5].

2-2 증강현실 얼굴인식기술

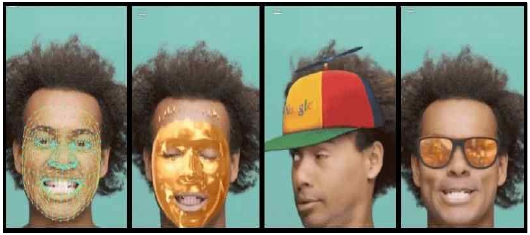

증강현실은 항공기 제작사인 보잉사가 항공기를 조립하기 위한 작업으로 실제에 가상을 중첩하는 과정에서 소개됐다[6]. 현실 세계에 가상의 물체를 합성하고, 사용자와 가상의 물체와 상호작용을 실시간 가능하게 하는 것을 말하며, 사용자는 현실과 가상의 물체가 덧입혀진 증강된 세계에서 가상의 물건 등과 상호작용할 수 있다[7]. 일반적으로 공간의 구성은 실공간과 가상공간으로 나눌 수 있는데, 실공간은 현재 우리가 사는 공간을 말하며, 가상공간은 3차원의 좌표로 만들어진 가상의 물체가 있는 공간을 말한다. 그리고, 이 두 공간을 결합한 증강된 공간으로 나눌 수 있다[8]. 가상현실은 3차원 그래픽으로 구성된 가상세계에서만 사용자가 체험 활동이 가능하지만, 증강현실은 현실 세계와 가상의 객체를 결합한 형태로 체험을 할 수 있어 현실감이 좋다[9]. 현재 게임, 교육, 예술 등의 여러 분야에서 활용되고 있고, 최근에는 증강현실 기술을 활용하여 현실 세계의 사물과 공간을 가상의 세계에 복제하여 연동하고 상호작용하는 디지털 트윈에도 많이 활용되고 있다[10]. 증강현실 기술은 크게 그림 4와 같이 마커 방식과 마커리스 방식으로 나뉜다. 마커 방식은 이미지를 활용하여 특이점이라고 하는 특정 패턴을 인식하는 방식으로 카메라 화면으로부터 등록한 마커 이미지를 감지하여 인식되는 경우, 마커 이미지에 가상의 물체를 위치시키는 기술을 말하며, 가상의 물체가 현실 세계와 유기적으로 결합하기 위해서는 마커에 특이점이 많은 이미지를 사용하는 것이 중요하다[11]. 마커리스 방식은 카메라에 보이는 영상을 직접 판별하여 정보를 획득하고 물체를 인식하여 가상의 물체를 위치시키는 방식을 말한다[12]. 마커리스 방식의 한 종류인 얼굴인식기술은 그림 5와 같이 카메라의 실시간 영상을 Raw Data로 추출하여 얼굴의 특징점을 검출하고 얼굴을 정규화한 뒤에 얼굴을 인식한다[13]. 최근에는 ARCore, ARKit, ARFoundation, Vuforia 등과 같은 개발도구가 지원되어 다양한 분야에서 쉽게 활용이 가능해졌다. 개발도구에는 얼굴인식 기능뿐 아니라 그림 6과 같이 몸을 인식하는 기능도 가능해지고 있다. 얼굴인식은 플랫폼 및 개발도구에 따라 표 1과 같이 지원하는 범위가 다른데, ARCore 얼굴인식의 경우는 얼굴 표면에 대한 정보와 왼쪽 이마, 오른쪽 이마, 코 위치에 대한 정보를 얻을 수 있어, 해당 부분에 가상의 물체를 위치시켜 표현할 수 있다[14]. 일반적으로 AR-SDK(Software Development Kit)라고 하는 증강현실 개발도구는 Window, Android, IOS(iPhone Os)와 같은 플랫폼에 맞춰, 설계가 되어있기 때문에, 증강현실 콘텐츠를 제작할 때에는 플랫폼별 제작을 각각 따로 해야 한다. 이는 개발비와 제작 기간의 증가로 이어진다. 최근 콘텐츠제작업체에서 많이 사용되고 있는 Unity Engine은 처음에 멀티플랫폼을 지원하는 게임제작 엔진으로 출발하여, 게임뿐만 아닌 다양한 콘텐츠에 활용되는 통합 콘텐츠제작 도구로 확대되고 있다[15]. Unity Engine은 내부 프레임워크에서 별도의 작업 없이 플랫폼별 개발이 가능하며, 증강현실개발 도구인 ARFoundation을 지원하고. 필요한 에셋들을 바로 다운로드 가능한 에셋스토어가 있어, 다양한 플랫폼에서 빠르게 개발할 수 있다[16],[17].

2-3 문화 관련 콘텐츠 앱 등록 현황

최근 구글플레이에 등록되어있는 문화 관련 콘텐츠를 “문화”, “한중일”, “문화유산”, “문화교류”, “얼굴인식”과 같은 키워드로 검색하였다. 표 2와 같이 검색 키워드별 노출된 앱 중에서 문화 관련 콘텐츠의 대략 1~8종, AR/VR 콘텐츠는 최대 2종으로 빈도가 낮으며, 대부분 지역 문화유산의 홍보 및 행사 알림과 같은 앱이고, 문화교류를 위한 콘텐츠는 등록된 경우가 없고, 얼굴인식 콘텐츠의 경우 10종으로 검색 노출이 많지 않았고, 재미를 위한 콘텐츠가 대다수였다.

그림 7은 대부분의 등록되어있는 일반적인 문화 앱을 나타내며, AR 과학문화유산 콘텐츠의 경우 마커 방식으로 문화체험이 가능한 콘텐츠이지만, 등록된 마커 이미지가 있어야 구동이 된다.

Ⅲ. 한.중.일 탈 문화 체험 콘텐츠 설계

3-1 콘텐츠 설계

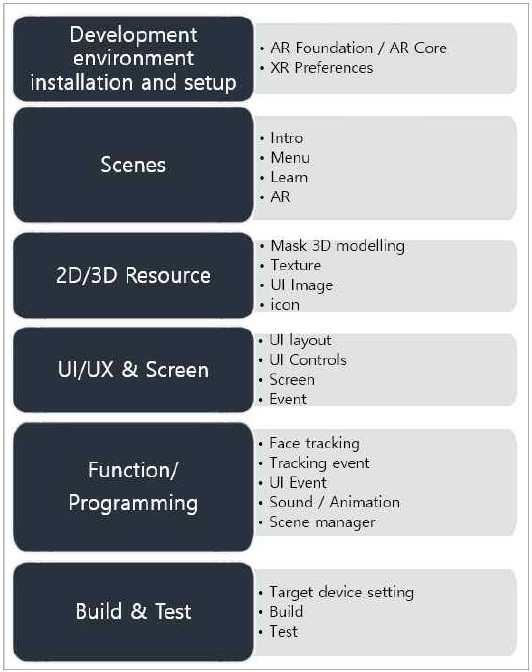

현재까지 대부분의 증강현실 콘텐츠는 마커 기반의 교육용 콘텐츠가 대부분이고 증강현실에 대한 수요가 많음에도 불구하고 다양한 분야의 적용은 더디게 진행되고 있다. 본 연구에서는 한.중.일 탈을 사용자의 얼굴에 직접 체험하는 마커리스 방식의 한 종류인 얼굴인식 증강현실 콘텐츠제작을 위해, IOS(iPhone Os), Android 등의 다양한 플랫폼에서 동작이 가능한 Unity Engine과 ARFoundation을 사용하였다. ARFoundation은 Unity Engine이 지원하는 미들웨어 형태의 AR-SDK(Software Development Kit)로써 실행 파일 빌드 시, 선택에 따라 내부에서 ARCore, ARkit 등과 같은 형태로 자동 변환되어 처리된다. 콘텐츠는 크게 한.중.일 탈 문화에 대한 정보를 배울 수 있는 부분과 체험하는 부분으로 나눠서 구현하였고, 각 국가별 전통의 탈을 구현하는데, 한국과 일본의 경우 목재나 종이로 만들어진 전통 탈을 사용하기 때문에 3D모델링 형태로 제작하였고, 중국의 경우 극히 짧은 시간에 가면을 바꾸는 천의 형태의 가면을 사용하기 때문에 2D 형태의 2차원 좌표인 UV를 사용하여 제작을 진행하였다. 콘텐츠 제작과정은 그림 8과 같이 개발환경을 설정하고, 각 콘텐츠 장면을 구성하고, 콘텐츠에 필요한 리소스를 제작한 뒤, 얼굴 감지 등과 같은 기능구현. 이벤트 처리, 연출에 대한 프로그래밍을 진행하고 최종 테스트를 진행하였다.

3-2 콘텐츠와 UI (user interface) 흐름도

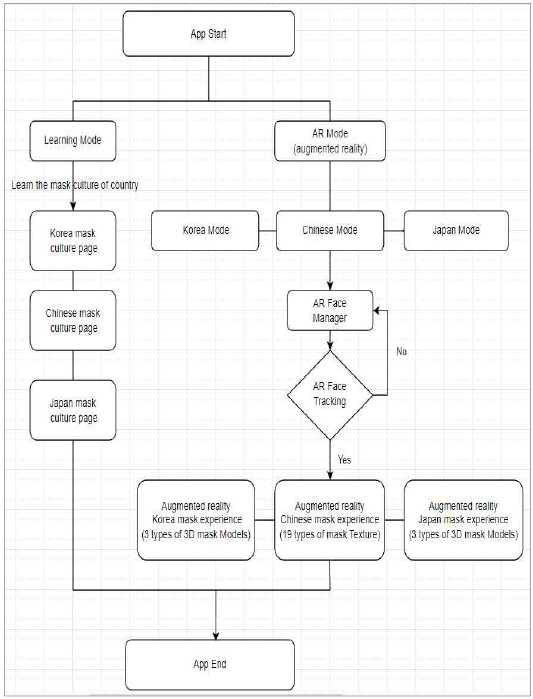

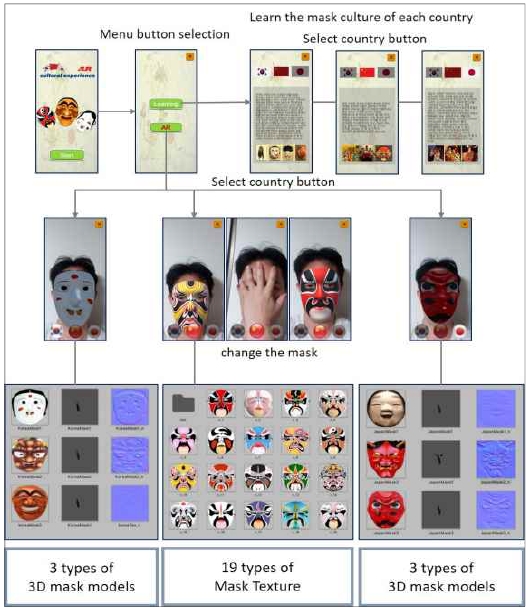

그림 9는 콘텐츠 흐름을 나타내고, 각 요소에 대한 정의는 다음과 같다.

- (1) App Start : 앱 시작

- (2) Learning Mode : 국가별 탈의 특징 학습

- - Korean mask Culture page : 한국 탈 문화 학습

- - Chinese mask Culture page : 중국 탈 문화 학습

- - Japan mask Culture page : 일본 탈 문화 학습

- (3) AR Mode(Augmented reality): 국가별 증강현실

- - Korean Mode : 3가지 탈 체험(여인, 먹중, 양반)

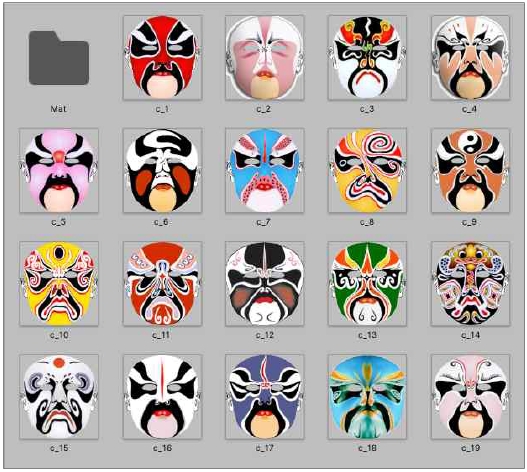

- - Chinese Mode : 19가지 변검 패턴 체험

- - Japan Mode : 3가지 탈 체험(오니, 텐구, 노멘)

- (4) AR Face Manager : 얼굴인식 카메라 작동

- (5) AR Face Tracking

- - 카메라 영상으로부터 얼굴 탐지

- - 얼굴 탐지가 성공하면 선택된 국가에 맞게 탈을 증강 시킴

- (6) AR Korean mask visualization experience

- - 얼굴인식 증강현실 한국의 탈 체험

- (7) AR Chinese mask visualization experience

- - 얼굴인식 증강현실 중국의 탈 체험

- (8) AR Japan mask visualization experience

- - 얼굴인식 증강현실 일본의 탈 체험

- (9) App End : 앱 종료.

Ⅳ. 구현

4-1 증강현실 얼굴인식기술의 개발환경

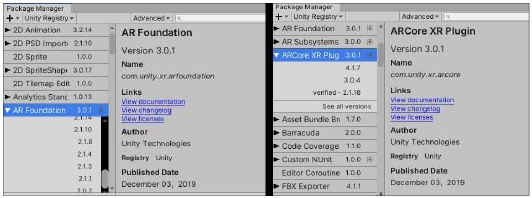

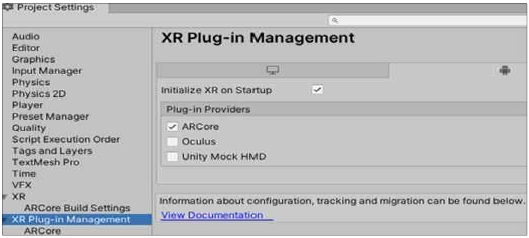

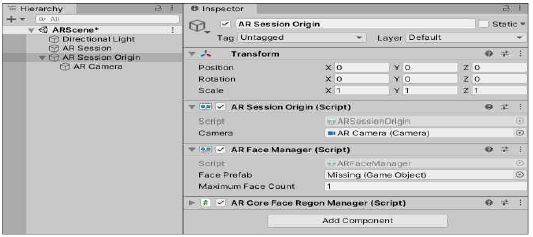

Android에서 얼굴인식 증강현실 콘텐츠를 제작하기 위해서는 그림 11과 같이 Unity Engine의 특별한 기능들을 추가 설치하기 위한 Package Manager에서 ARCore와 ARKit의 플랫폼 미들웨어 역할을 하는 ARFoundation을 설치해야 한다. 설치 이후에는 증강현실에 대한 설정이 필요한데, 그림 12와 같이 Project Settings 항목에서 XR Plug-in Management 항목의 ARCore 체크로 설정할 수 있다. 그림 13과 같이 AR 전체를 관리하고 감독하는 AR Session 객체와 AR Session에서 원점을 탐지해 알려주는 AR Session Origin 객체를 추가한다. 증강현실은 가상의 카메라가 아닌 실제 장치의 카메라를 사용하기 때문에, 기존 Scene의 가상 카메라인 Main Camera를 삭제하고, 실제 카메라 장치인 AR Camera의 Tag 항목에서 MainCamera로 설정하여 변경해야 한다. 설정 완료 후 AR Face Manager Component를 추가하여, 얼굴인식 기능을 부여 부여했다.

4-2 탈 텍스쳐와 3D 모델링

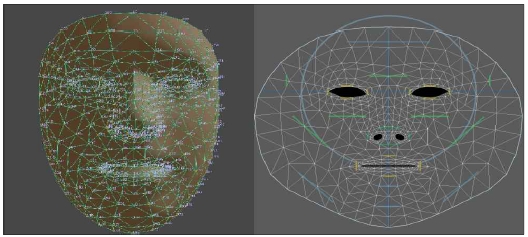

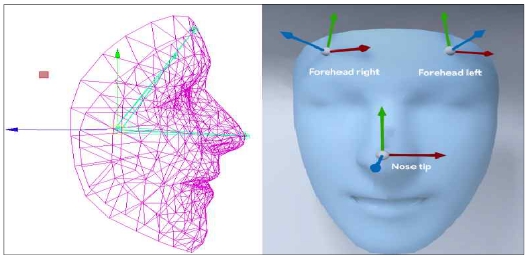

증강현실 개발도구인 ARCore의 얼굴인식 기능은 그림 14와 같이 468개의 점으로 구성된 3D 얼굴 메쉬와 재질을 표현하기 위한 2D 정식 얼굴 텍스쳐를 제공함으로써 제작의 기준을 제공한다. 재질에 해당하는 2D 텍스쳐는 3D 얼굴 메쉬에 입혀질 이미지이기 때문에 원본 이미지를 그대로 사용하지 않고 정식 얼굴 텍스쳐에 맞춰 눈, 코, 입의 기준에 따라 제작해야 한다. 그림 15는 원본 이미지를 정사각형 형태로 맞춘 뒤, 정식 얼굴 텍스쳐 UV 기준에 눈, 코, 입을 조정하여 제작한 예시이다. 얼굴 탐지 시에 해당 기준에 맞춰진 UV 좌표가 탐지된 얼굴의 한점과 1대1 매칭되어 얼굴의 표정이 변화하면, 사용자의 피부처럼 정점이 같이 이동되어 연출된다. 이와 더불어 탈과 같은 3D 가상의 물체를 특정 부위에 위치시키고자 할 때는 ARCore인 경우 그림 16과 같이 왼쪽 이마, 오른쪽 이마, 코의 위치를 감지하여 알려줌으로써 해당 위치에 탈을 위치시킬 수 있다. 본 콘텐츠에서는 코의 위치에 탈을 위치시켜 연출하였다.

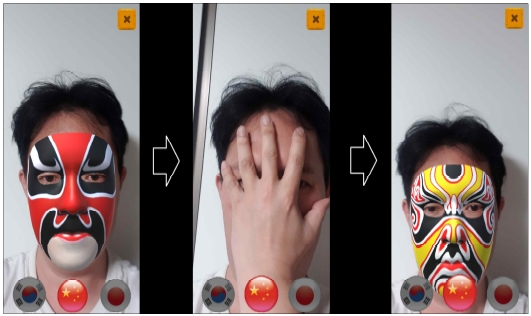

4-3 얼굴인식 구현

표 3과 같이 증강현실 얼굴인식 기능을 구현하기 위해서는 얼굴 탐지 시 이벤트 처리가 가능하도록 이벤트 함수를 등록해야 하는데, 본 콘텐츠에서는 OnDetectFaceRegion() 함수를 만들어 등록하였다. Android에서만 제공하는 기능을 사용하기 위해서, subsystem이라고 하는 기능을 호출하여 Unity Engine에서 맞는 형태로 ARCoreFaceSubsystem과 같은 형태로 변환해서 가져와야 한다. 한국과 일본은 목재나 종이로 만들어진 전통 탈을 사용하기 때문에, 그림 17과 같이 3D 모델링을 하고, 재질에 질감을 극대화하기 위하여, 노멀 텍스쳐를 사용하여 표현하였다. 반면에 중국은 천으로 된 가면을 사용하기 때문에, 그림 18과 같은 형태로 텍스쳐를 19개 구성하고, 얼굴의 표정 변화를 위해 486개의 점으로 구성된 UV 좌표를 얼굴에 맞춰 하나하나 보정 하였다. 한.중.일 각국의 탈의 모양과 표현방법이 달라, 기능 함수를 따로 분리하여, 얼굴이 감지되면 자동으로 시스템 내부에서 호출되도록 하였다. 한국과 일본의 경우는 탈을 사용하기 때문에, 카메라로부터 실제 감지된 코의 위치 기준으로 현재 선택된 3D모델링 된 가상의 탈을 코의 위치에 배치되도록 구현하였고, 중국과 같이 천으로 된 가면을 사용하는 경우 등록된 19개의 가면 중 현재 선택된 가면을 손으로 가리거나 머리를 숙였다가 올리는 동작으로 변검 체험이 가능하도록 구현하였다. 자연스럽게 변검이 연출 되도록, 탐지 실패 시에 현재 선택되어있는 가면 텍스쳐의 인덱스를 증가시켜 다른 텍스쳐로 교체함으로써 구현하였으며, 증강현실 체험 모드를 진행하는 중에 국가 변경 등의 이벤트가 발생하면, 얼굴인식은 계속 진행되는 상황이기 때문에, 바로 변경되지 않는 문제가 발생 되는데, 탐지 기능을 0.005초 동안 잠시 껐다가 켜서 이 문제를 해결하였다.

4-4 구현 결과

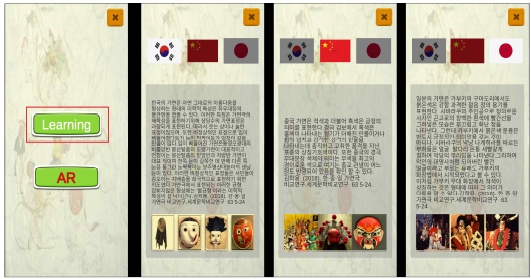

안드로이드 빌드 후, apk를 기기에 넣고, 테스트를 진행하였다. 실행 후에 메뉴 화면에서 그림 19와 같이 학습 모드 버튼을 클릭하면 각 국가의 탈 문화에 대한 특징을 배워볼 수 있었고, 국기를 클릭하면 해당 국가가 선택되었다. 중국 탈과 같이 천으로 구성된 경우, 그림 20처럼 486개의 정점이 실제 얼굴에 1:1 매핑 되어, 표정 변화에 따라 반응을 하였고, 한국과 일본의 탈은 천으로 구성된 중국의 탈과는 다르게, 그림 21과 같이 코의 위치를 기준으로 3D 가상의 탈이 나타났고, 간단히 가면을 벗는 동작 등으로 다른 가면으로 바꿀 수 있었다. 그림 22와 같이 중국의 탈 역시 손바닥으로 얼굴을 가렸다가 떼는 동작으로 중국 가면극에서 많이 연출되는 변검을 체험할 수 있었다. 전통 배경음을 통해 친근하게 콘텐츠를 접할 수 있었고, 추후 확장성을 고려하여 설계됐기 때문에, 다른 국가를 더 추가하거나 탈의 종류를 늘리는 것도, 쉽게 할 수 있었다.

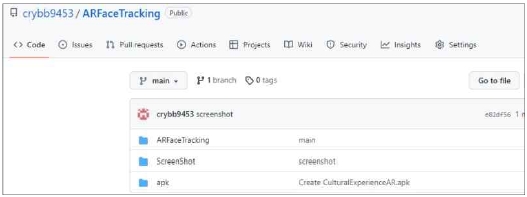

그림 23은 해당 콘텐츠 소스와 실행 파일을 콘텐츠 제작자들이 소스관리 용도로 많이 사용하고 있는 GitHub에 직접 업로드한 내용이다. 아래 주소에서 다운로드 후 해당 콘텐츠의 소스를 보거나, 실행해 볼 수 있다.

Ⅴ. 결 론

본 연구에서는 한.중.일 문화교류에 있어, 최근 주목할 만한 마커리스 방식의 증강현실인 얼굴인식기술을 활용하여, 한.중.일 탈 문화체험 콘텐츠를 설계하고 제작함으로써, 한.중.일 각국의 문화적 특성을 학습하고 체험하며, 이해를 돕고자 했다. 일방적인 정보만을 전달하는 콘텐츠보다 증강현실로 체험하는 실감형 콘텐츠로 정보 전달 면에서 효과적임을 느낄 수 있었다. IOS(iPhone Os) 대비 안드로이드의 얼굴인식기술은 이마, 코 등의 제한적 기능만 가능하다. 제작하는 과정에서 한.중.일 각국의 특성에 맞는 탈을 제작 기준에 맞춰 3D모델링하고, 2D텍스쳐의 UV를 조정하는 등의 작업은 매우 까다로웠다. 증강현실이 구동되는 동안 다른 국가로 전환 시 예외 처리 등과 체감을 위한 환경 구성 및 연출에 대한 설계에 많은 시간이 필요했다. 디자인 면에서도 조금 더 사실과 같은 그래픽 표현이 부족하였고, 한.중.일 각국의 역사 연대별 탈 문화의 발전 및 변천 과정을 토대로 내용이 구현되었으면, 조금 더 문화를 이해하는데, 도움이 되었을 것이라고, 생각된다. 향후 연구에서는 해당 부분을 보완할 예정이며, 사용성에 대한 평가 및 효과에 대한 분석을 진행할 예정이다. 이에 본 연구에서 진행된 콘텐츠 소스와 실행 파일을 웹사이트에 공유하였다. 제작 경험을 공유함으로써, 향후 증강현실을 활용한 실감형 콘텐츠를 제작하고자 할 때, 제작 방향에 도움이 되고, 다양한 분야에서 사용자 요구에 맞는 콘텐츠제작 및 확산에 기여 하고자 한다.

Acknowledgments

이 논문은 2021학년도 영산대학교 교내연구비의 지원에 의하여 이루어진 것임

References

-

J. Y. Kang, “Production of Realistic Contents of National Intangible Cultural Properties Using Augmented Reality Technology - Focusing on National Intangible Cultural Property No. 2 ‘Yangju Byeolsandae Nori’”,Journal of Digital Contents Society, Vol. 23, No. 5, pp. 773-779, 2022.

[https://doi.org/10.9728/dcs.2022.23.5.773]

-

Y. J. Cho, J. H. Kim, J. H. Oh and I. Y. Chung,“Development of zoo tourism application ‘AniSearch’ using augmented reality technology”,Journal of Digital Contents Society, Vol. 19, No. 10, pp. 1833-1841, 2018.

[https://doi.org/10.9728/dcs.2018.19.10.1833]

-

J. Y. Chun,“A Study on Digital Heritage Content Development for Augmented Reality based Culture and Arts Education in the Fourth Industrial Revolution”, Journal of Digital Contents Society, Vol. 20, No. 12, pp. 2357-2366, 2019.

[https://doi.org/10.9728/dcs.2019.20.12.2357]

- K. H. Kim, and Y. N. Lee,“A comparative study of the color of mask makeup in oriental traditional plays - Focusing on Korean, Chinese, and Japanese mask plays”, Fashion and Knitwear, Vol. 6, No. 2, pp. 1-12, 2008.

-

H. Y. Kim, “A comparative study of Korean, Chinese, and Japanese mask plays”, Comparative Study of World Literature, 63, pp. 5-24, 2018.

[https://doi.org/10.33078/COWOL63.01]

- S. J. R.yu, “Development of foreign language education contents based on augmented reality: utilization of Korean and French fairy tales”, Story and Image Telling, 20, pp. 123-150, 2020.

-

T. S. Kang, D. Y. Lee and J. M. Kim, “Augmented reality based digital fashion content production using CLO 3D and Vuforia”, Journal of the Korea Computer Graphics Society, Vol. 26, No. 3, pp. 21-29, 2020.

[https://doi.org/10.15701/kcgs.2020.26.3.21]

- T. E. Kim, “A study on the production of children's children's books by applying augmented reality technology”, Journal of the Korean Digital Content Society, Vol. 18, No. 3, pp. 435-442, 2017.

-

T. J. Choi, J. H. Kim and C. J. Lee, “Model house content production using augmented reality”, Journal of the Korea Entertainment Industry Association, Vol. 11, No. 1, pp. 257-264, 2017.

[https://doi.org/10.21184/jkeia.2017.01.11.1.257]

- K. S. Shin, S. K. Yeom and Y. J. Park, “Development of an augmented reality-based IoT control platform using markers”,Journal of the Korean Information and Communication Society, Vol. 25, No. 8, pp. 1053-1059, 2021.

- C. Park and W. B. Lee,“A method for improving the recognition rate of augmented reality marker images. Journal of Convergence Information”, Former Journal of Small and Medium Business Convergence Association, Vol. 12, No. 1, pp. 1-6, 2022.

-

H. I. Jeong and H. Y. Jeong,“Augmented reality interaction reinforcement study using Leap Motion”,Journal of the Korean Entertainment Industry Association, Vol. 14, No. 3, pp. 133-138, 2020.

[https://doi.org/10.21184/jkeia.2020.4.14.3.133]

-

D. J. Kim,“Implementation of multi-channel network platform based on augmented reality facial emotion sticker using deep learning”, Journal of Digital Contents Society, Vol. 19, No. 7, pp. 1349-1355, 2018.

[https://doi.org/10.9728/dcs.2018.19.7.1349]

- Augmented-faces[Internet]. Available: https://developers.google.com/ar/develop/augmented-faces

-

H. H. Kim and H. W. Jeong,,“MARKERLESS method augmented reality game development using Unity and KUDAN engine - Focusing on the development case of ‘Our Neighborhood Hero’”, Journal of Digital Convergence, Vol. 15, No. 4, pp. 421-426, 2017.

[https://doi.org/10.14400/JDC.2017.15.4.421]

- Unity-Technologies.ARFoundation[Internet]. Available: https://unity.com/kr/unity/features/arfoundation/, 2022.02.22

- UnityTechnologies[Internet].Available: https://unity.com/, 2022.02.22

저자소개

2002년 : 용인대학교 전산통계학과 졸업 (이학사)

2019년 : 광운대학교 스마트융합대학원 게임학과 졸업(게임학석사)

2007년~2014년 : ㈜핫독스튜디오 개발이사

2015년~2017년 : ㈜버드레터 개발이사

2017년~2018년 : ㈜스노우픽셀 개발이사

2020년~현 재 : 영산대학교 게임VR학부 부교수

2017년 : 한국게임학회 우수논문상 수상

※관심분야 : 게임, 실감콘텐츠(VR/AR), 융합콘텐츠