다중 객체 추적 기술을 활용한 지능형 실내 위치정보 분석 시스템 설계

Copyright ⓒ 2022 The Digital Contents Society

This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-CommercialLicense(http://creativecommons.org/licenses/by-nc/3.0/) which permits unrestricted non-commercial use, distribution, and reproduction in any medium, provided the original work is properly cited.

초록

다중 물체 추적 기술은 영상 데이터 내에서 특정한 물체 여러 개를 동시에 추적하는 기술로 최근의 딥러닝 기술의 비약적인 발전에 힘입어 다양한 분야로 활용 영역을 넓혀 가고 있다. 본 연구에서는 MOT를 실내 환경에 활용하여 자동으로 객체를 탐지하고 탐지된 위치를 효율적으로 저장, 분석할 수 있는 지능형 실내 환경 이동객체 위치 데이터 수집 및 분석 시스템을 제안한다. 본 시스템의 주요 특징 중 하나는 대상 환경에 따라 다양한 MOT 모델 중 하나를 선택하여 실내 공간에서 물체 위치 정보를 수집할 수 있다는 것이다. 이에, 객체 밀집도 및 공간 복잡도가 높은 실내 환경에서도 정확한 물체 인식 및 추적을 수행하는 MOT의 선택을 위해, 밀집도 변화 및 객체의 행동에 따른 MOT 모델들의 성능을 비교하였다. 제안하는 시스템은 공간 데이터베이스 쿼리를 이용하여 위치정보 기반의 객체 간 상호작용 및 관계 분석을 가능하게 함으로써 다양한 응용 서비스 구축에 활용될 수 있다.

Abstract

Multi-Object Tracking (MOT) is a technology that tracks multiple targets and infers their trajectories across a multiple-camera network, which recently has gained considerable attention because of its wide range of applications. In this study, we propose a MOT-based system that collects and analyzes the location data of moving targets in indoor environments. The proposed system allows flexible coupling with various MOT models that can optimally operate in the target environment. Thus, it is necessary to select an appropriate MOT that performs accurate object detection and tracking in indoor environments where the object density and spatial complexity are high. To this end, we conduct extensive experiments to compare the performance of recently proposed state-of-the-art MOT models for various density levels and object behavior models. One of the significant advantages of our system includes being able to analyze interactions and relationships between objects based on location information using spatial database queries, and thus poses high potential to be utilized in various application services.

Keywords:

Multi-object tracking, Spatial database, Ground projection, Indoor moving object analysis, Indoor Localization키워드:

다중 객체 추적, 공간 데이터베이스, 지면 투영, 실내 이동객체 분석, 실내 측위Ⅰ. 서 론

다중 물체 추적 기술 (MOT: multi-object tracking)은 영상 데이터 내에서 특정한 물체 여러 개를 동시에 추적하는 기술로, 컴퓨터 비전 분야에서 활발하게 연구가 이루어지고 있는 분야 중 하나이다. 안전 분야에 대한 높아지는 사회적 관심과 4차 산업혁명 시대 산업의 스마트화에 대한 높은 수요로 인해, 최근 실내외 환경에서 위치정보 활용 서비스에 대한 수요가 증가함으로써 MOT의 활용영역은 점차 증대하고 있다[1,2].

자율 주행[1] 등과 같이 매우 정밀한 객체의 위치정보가 요구되거나, 밀집도와 공간 복잡도가 높은 실내 환경 등에서 MOT를 활용한 응용 서비스를 제공하고자 할 경우는 MOT의 높은 인식 정확도 등의 성능 보장이 전제되어야 한다. 하지만, MOT는 3차원 물리 공간의 절대 좌표가 아닌 2차원 영상 내의 좌표를 제공하는 태생적인 한계로 원근감 정보 파악이 쉽지 않아, 정확한 실내 위치 정보 파악을 필요로 할 경우는 활용이 어렵다. 또한, 실외에 비해 객체들의 밀집도가 높고 공간 구성이 다양한 실내 환경에서의 성능에 대한 검증은 최신 제안된 MOT 모델들도 아직 미흡한 상황이다.

본 연구에서는 대규모 실내 위치 데이터 수집 및 분석에 활용될 수 있는 지능형 실내 위치 데이터 수집 시스템을 제안한다. 제안 시스템에는 (1) MOT를 이용해 인식한 사람의 바운딩 박스 (bounding box) 좌표를 평면 투영 (ground projection)하여 목표 지도 (target map)의 평면 좌표로 변환 과정, (2) 공간 데이터베이스에 저장 후 다양한 쿼리를 처리하는 공간 연산 (spatial operation) 수행을 포함한다.

기존의 실내 측위 연구는 Wi-Fi 기반의 Fingerprinting 기술을 주로 사용하며, 이 경우 라디오 맵 구축이라는 선행 작업이 필요하다. 따라서 새로운 공간에 적용할 경우 추가적인 라디오 맵 구축은 불가피하다. 또한 객체가 Wi-Fi 사용이 가능한 기기를 소지해야 된다는 제약이 있다. 하지만 제안하는 카메라 기반 실내 측위는 카메라 설치 및 지면 투영을 위한 참조 포인트만 얻으면 되기 때문에 새로운 공간에 대해 빠른 적용이 가능하며 객체가 기기를 소지하지 않아도 된다는 장점이 있다.

제안하는 시스템에서 선행되는 실내 환경에서의 MOT 사용은 객체가 비교적 동일한 행동(걷기)을 하는 실외에 비해 행동의 유형이 다양하고, 객체 간 가림 현상 및 제한된 영역 내 높은 밀집도 때문에 객체 추적 성능 저하로 이어질 수 있다. 따라서 대상 공간에서의 밀집도 변화 및 객체의 행동에 따른 MOT 모델들의 성능 비교를 통해 제안하는 시스템에 MOT의 성능이 미치는 영향을 분석한다.

본 논문의 구성은 다음과 같다. 2장에서는 제안하는 시스템의 구조와 세부 구성 요소에 대해 설명하고, 3장에서는 제안 시스템을 이용한 실제 데이터 수집 실험 내용을 소개한다. 4장에서는 제안 시스템의 활용도를 보이기 위해 수집된 정보를 자동으로 시각화한 결과를 보이고, 5장에서는 MOT 모델 성능 비교를 통해 제안하는 시스템에서 MOT 성능의 중요성을 보여준다. 끝으로, 6장에서는 결론 및 향후 연구 방향을 제시한다.

Ⅱ. 시스템 소개

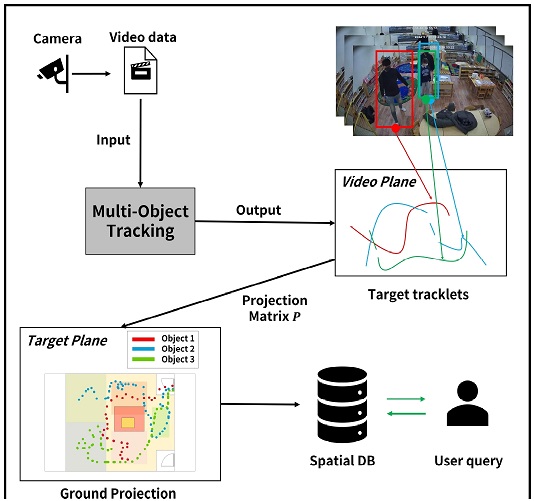

그림 1은 제안하는 시스템의 전체 구조를 나타내고 있다. 본 시스템은 카메라로부터 영상데이터 수집 후 MOT 실행으로 객체(사람)의 이동경로 위치 좌표 생성 (tracklet), 위치 좌표를 목표 지도에 지면 투영, 데이터베이스 저장 과정을 거친 후, 사용자의 공간 쿼리를 통해 객체 분석이 진행된다. 자세한 내용은 세부 장에서 소개를 한다.

2-1 다중 객체 추적

제안하는 시스템의 첫 프로세스는 MOT 기술을 활용해 입력으로 제공되는 영상에서 위치 정보를 추출하는 것이다. 본 연구의 초점은 객체 인식 및 추적 알고리즘 자체가 아닌, MOT를 활용한 결과를 이용하는 것으로, 제안하는 시스템에서 MOT 모델은 높은 성능을 달성한 YOLOX 기반의 ByteTrack[7]을 사용하였다. ByteTrack은 바운딩 박스를 신뢰도 점수 (confidence score)가 낮은 개체에 대해 한 번 더 매칭을 진행하는 방식으로 아이디 스위칭 (ID switching)을 감소시키고 추적 성능을 높인 모델이다.

MOT의 표준 결괏값은 전체 영상에 대해 추적된 타겟의 프레임 인덱스, 객체 아이디, 바운딩 박스 좌표 정보를 나타낸다. 우리는 타겟의 위치 좌표를 얻기 위해 MOT의 결괏값인 바운딩 박스의 좌상단 좌표 (xlefttop, ylefttop), 넓이 w, 높이 h를 활용하여 발자취 좌표인 (xfoot, yfoot)을 수식 1 과 같이 계산하여 사용한다.

| (1) |

2-2 지면 투영

2-1에서 계산된 좌표들은, 위에서 아래를 바라보는 방향으로 투영하는 Bird-Eye View[4] 또는 Top-View Transformation[5]로 불리는 지면 투영 변환을 이용해 비디오 평면상 위치 좌표를 목표 공간 지도(map)상의 좌표로 변환을 한다. 이때, 비디오 평면과 투영할 목표 공간 이미지 각각에 서로 대응하는 4개의 참조 지점을 지정해야 한다. 이후 지정된 4개의 참조 좌표 쌍을 이용하여 투영 행렬 P를 얻은 후 지면 투영 연산에 사용하게 된다.

보통 카메라의 왜곡 현상으로 인해 얻어진 영상을 그대로 사용할 경우 지면 투영 과정에서 실제 위치 좌표와의 오차가 생기게 된다. 따라서 초기 설정에서 카메라 캘리브레이션을 통한 보정 작업이 선행된다.

2-3 공간 정보 데이터베이스

공간 정보는 목표 지도상에서 특정 구역에 대한 좌표 집합을 의미한다. 이러한 정보는 객체가 해당 공간에 위치하는지, 얼마나 머물렀는지 등 다양한 분석에 활용이 가능하다. 공간 정보는 공간 데이터베이스의 기능을 활용할 수 있도록 POLYGON과 POINT 타입으로 데이터베이스에 저장된다.

또한 데이터베이스에는 시간에 따라 객체의 위치 분석이 이루어질 수 있도록 시간 정보가 저장된다. 영상의 시작 시간을 넣으면 영상의 프레임 속도를 기반으로 계산한 프레임 사이의 시간 간격을 오프셋으로 처리하여 매 프레임에 대한 시간을 추가 필드로 삽입하게 된다. 데이터베이스의 업데이트는 모든 객체에 대해 지면 투영이 이루어진 이후 일괄적으로 진행되며, 공간 정보는 별도로 업데이트가 가능하다. 데이터베이스는 표 1을 통해 구성 요소를 확인할 수 있다.

2-4 공간 쿼리 사용

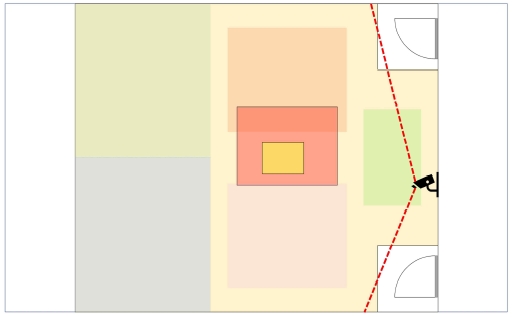

앞선 과정을 통해 데이터베이스에 저장된 객체의 투영 좌표는 공간 쿼리를 활용하여 위치 분석에 사용된다. 위치 분석은 특정 시간, 특정 공간에 따른 객체의 공간 내 존재 유무 및 위치 정보를 얻는 것을 의미하며, 이러한 정보들을 기반으로 객체 간 동선 유사도, 특정 공간 밀집도, 이동량 분석 등 다양한 활용이 가능하다. 공간 데이터베이스는 공간 및 비 공간 데이터를 저장하는 데이터베이스 시스템으로서 쿼리 언어를 사용하여 공간 데이터 타입, 공간 인덱스, 공간 쿼리 등의 공간 분석 방법을 제공한다[6]. 예를 들어 그림 2의 좌하단에 위치한 파란색 영역에 대해 공간 정보를 저장했다면, 선행된 MOT 및 지면투영 과정을 통해 저장된 객체의 위치 좌표, 시간 값을 활용하여 객체가 해당 공간 내에 위치한 시간 및 빈도수를 공간 쿼리를 통해 얻을 수 있다. 본 시스템에서는 시간-공간에 대한 다양한 쿼리를 처리를 가능하게 구현하였다.

Ⅲ. 실험 환경

제안 시스템의 활용성을 평가하기 위해, 실제 카메라를 이용한 영상 촬영 및 데이터 수집, 분석을 수행하였다.

실험은 가구가 배치 되어있는 가로 9m, 세로 7m의 실내 공간에서 진행되었으며, 실험공간을 입구를 제외하고, 사각지대 없이 전체적으로 촬영할 수 있도록 카메라를 설치하였다. 영상 녹화에는 와이즈넷의 NVR (Network Video Recorder) 키트 제품인 SNK-B73047BW 제품을 사용하였다.

공간 데이터베이스는 오픈소스 RDBMS인 MariaDB 10.3.34 버전을 사용했으며, 추가로 쿼리문의 실행 속도를 향상시키기 위해 쿼리문에서 자주 사용하는 정보들인 비디오 ID와 프레임 번호를 인덱스로 설정하여 보다 빠르게 실행될 수 있도록 하였다.

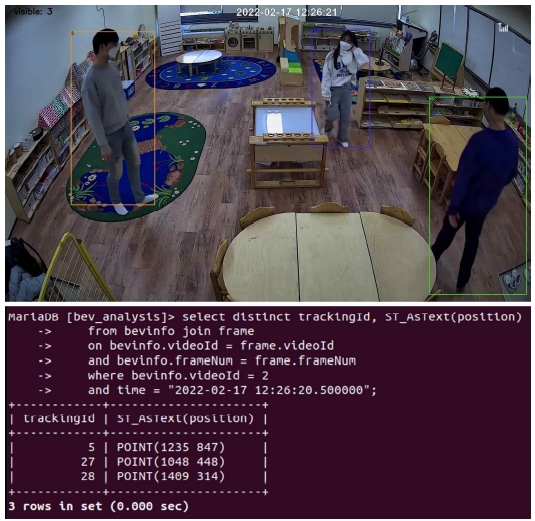

본 실험에서는 3명의 피실험자가 약 15분 간 자유롭게 이동하는 영상을 5분 단위로 자른 3개의 영상을 사용하였다. 그림 4에서 보이듯, 영상은 Full HD (1920x1080) 해상도에서 초당 20프레임으로 1번 비디오는 오후 12시 17분에서 22분, 2번 비디오는 22분부터 27분, 3번 비디오는 27분부터 32분까지의 모습이 담겨있다.

Ⅳ. 실험 결과 및 MOT 모델 성능 비교 분석

4-1 실험 결과

실험은 영상 데이터에 대해 얻어진 지면 투영된 객체들의 위치 데이터를 기반으로 공간 쿼리를 테스트 했다.

첫 번째로, MOT로 인식된 ID에 대해 특정 시간을 선택하는 쿼리로 해당되는 레코드에 대한 좌표를 도출했다. 영상의 촬영 시점 중 12시 26분 20초 50에 인식된 인물들의 ID와 좌표를 추출할 수 있도록 표 2와 같은 쿼리를 작성하였고, 그 결과로 ID 5, 27, 28을 인식하고 해당 위치를 반환한다. 그림 3은 표 2의 쿼리문을 실제로 실행한 결과이며 해당 시점에서 얻어진 MOT 결과 프레임(그림 3 상단)과 동일한 ID를 출력하였다.

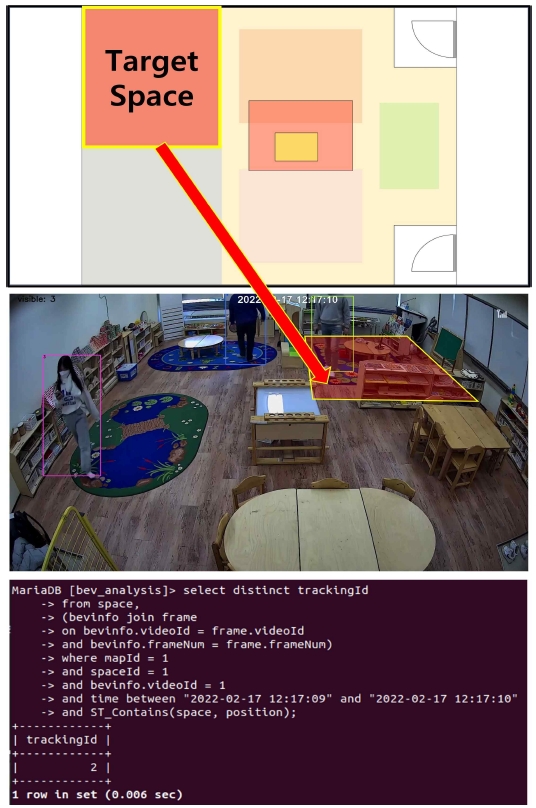

다음은 타겟 공간에 머문 비율, 거리에 기반한 특정 ID 간의 교류 판단을 분석할 수 있는 타겟 공간 정보 분석에 대한 테스트를 진행한 결과이다. 영상 데이터에서 12시 17분 9초에서 10초 사이에 특정 공간에 위치했던 ID를 추출할 수 있도록 표 3과 같은 쿼리를 작성했으며, 그림 5는 그 결과를 보여주고 있다. 피실험자 3명은 ID 1, 2, 3으로 인식하였으며, 타겟 공간의 경우 그림 4의 목표 지도에서 왼쪽 상단의 목표 영역에 해당한다. 정해진 시점에서 해당 공간을 지나간 ID는 2번이었으며, 1, 3번은 지나지 않았음을 알 수 있다.

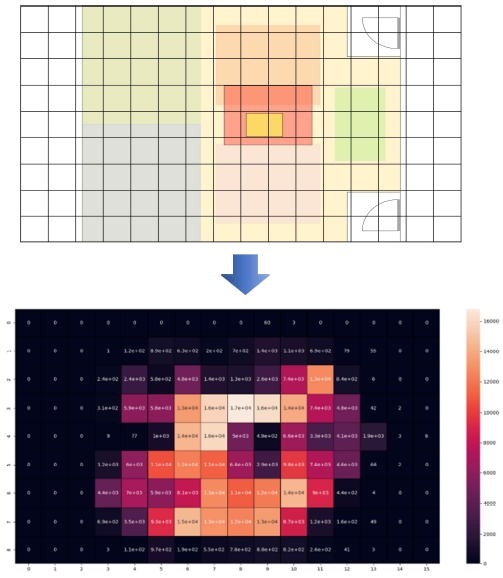

추가적으로, 본 시스템은 공간 정보의 시각화/도식화에도 활용이 가능하다. 그림 5는 목표 지도를 16x9로 분할하여 전체 데이터세트에 대해 얻은 모든 객체의 이동경로 열지도를 보여주며, 이는 특정 공간의 활용도 분석 등에 사용될 수 있다.

4-2 MOT 모델 성능 분석

제안하는 시스템은 영상 내 다수의 사람에 대한 추적 정보를 1차적으로 MOT를 통해 얻어오기 때문에 MOT 성능이 좋을수록 더 정확한 분석이 가능하다. 하지만 실내 환경에서는 공간의 규모 제약으로 인해 이동 객체의 밀집도가 높아질수록 Re-ID 및 추적에 어려움이 있다.

따라서 4-2장에서는 시스템에 적용한 ByteTrack[7]과 추가적으로 FastMOT[3], FairMOT[8] 까지 총 3가지 MOT모델의 성능을 비교해 봄으로써 시스템에 MOT의 성능이 미치는 영향을 분석한다.

성능 분석에 사용된 모델 중 하나인 FairMOT는 기존의 anchor 기반 물체 검출 및 특징 불공평, 차원 이슈 등으로 인한 Re-ID 성능이 저하를 anchor-free 방식으로 해결하여 이전 연구 대비 큰 성능 향상을 보여줬다. FastMOT는 YOLOv4를 기반으로 하며 더 빠른 처리를 위해 특정 프레임 수마다 탐지기와 특징 추출기를 실행하고, 이 과정에서 처리되지 않는 프레임은 KLT (Kanade-Lucas-Tomasi Feature Tracker) 알고리즘을 통해 효율적으로 채워 카메라가 움직이는 경우에도 높은 정확도를 보여준다[4].

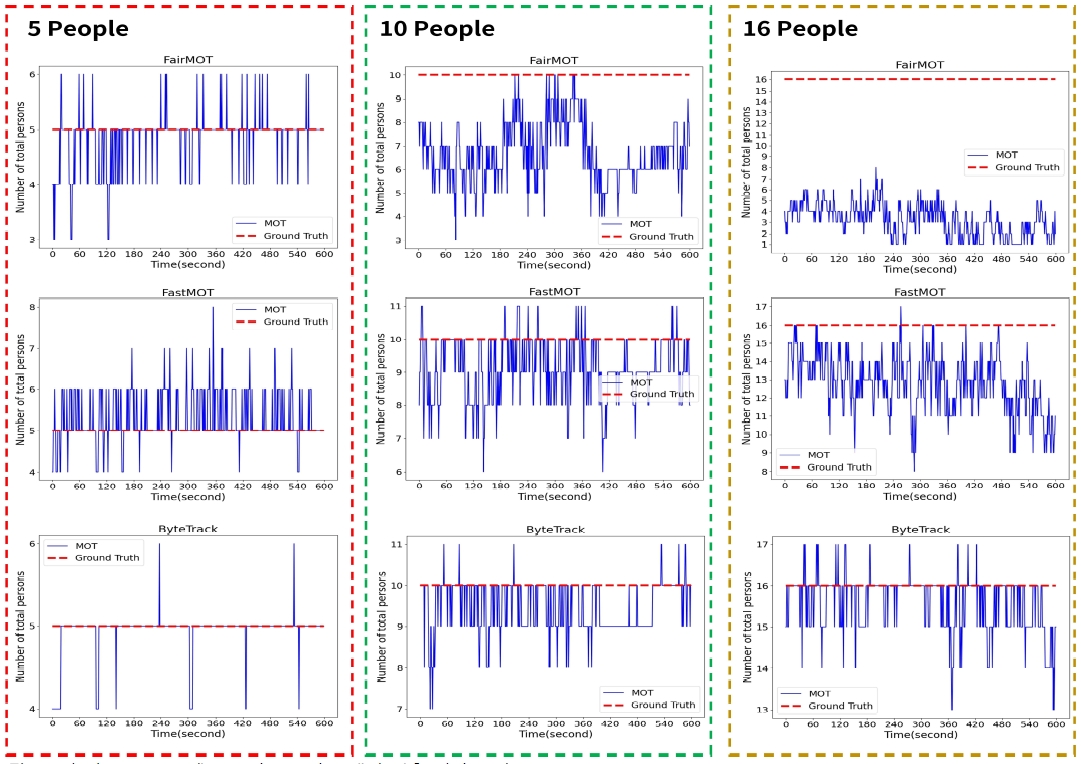

그림 6, 7은 세 가지 모델에 같은 공간에 대해서 10분의 시간 동안 테스트한 영상을 사용했을 때 결과를 보여준다. 각 행에 대한 그래프는 같은 모델을 의미하며 열은 등장하는 사람의 수를 5, 10, 16명으로 늘려가며 밀집도 변화에 대한 성능 그래프를 보여준다.

먼저 그림 6은 시간에 대한 검출된 객체 수를 나타내고 있다. 실제 이동 객체 수(Ground Truth)는 빨간 그래프에 해당되며 MOT 모델에 의해 검출된 객체는 파란색 그래프로 나타난다.

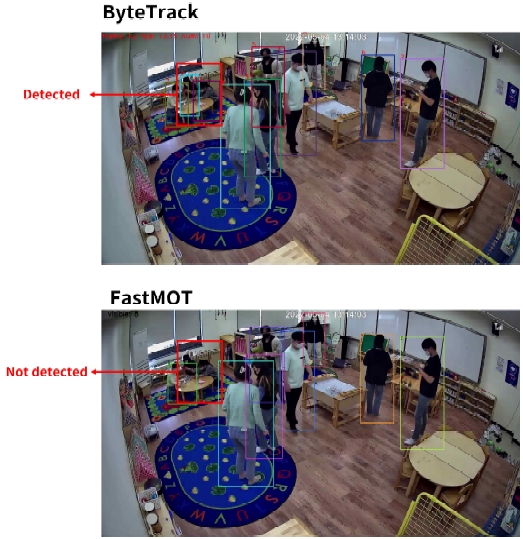

세 모델 모두 밀집도가 가장 낮은 5명에 비해 밀집도가 늘어날수록 미탐(false negative)이 증가하는 경향을 확인할 수 있다. 특히 FairMOT에서 가장 이러한 경향이 가장 두드러지게 나타나며, 이는 세 모델 중 서로 다른 객체들이 겹쳐지는 가림(occlusion) 현상으로 인한 검출 실패에 가장 취약하며 객체의 다양한 행동(앉거나 눕는 행동)에 대해 검출 학습이 되어있지 않기 때문이다. FastMOT도 마찬가지로 ByteTrack에 비해 걷기 이외의 행동에 대한 객체 검출 성능이 떨어지는 것이 확인되며, 그림 8에서는 이러한 객체의 행동에 따른 미탐 문제를 보여주고 있다. ByteTrack은 최신 모델인 만큼 전체적으로 GT에 가까운 검출 성능을 보이고 있으며, 오탐(false positive), 미탐 또한 두 모델에 비해 적다. 하지만 다른 두 모델과 마찬가지로 밀집도가 높아질수록 추적 성능이 저하됨을 알 수 있다.

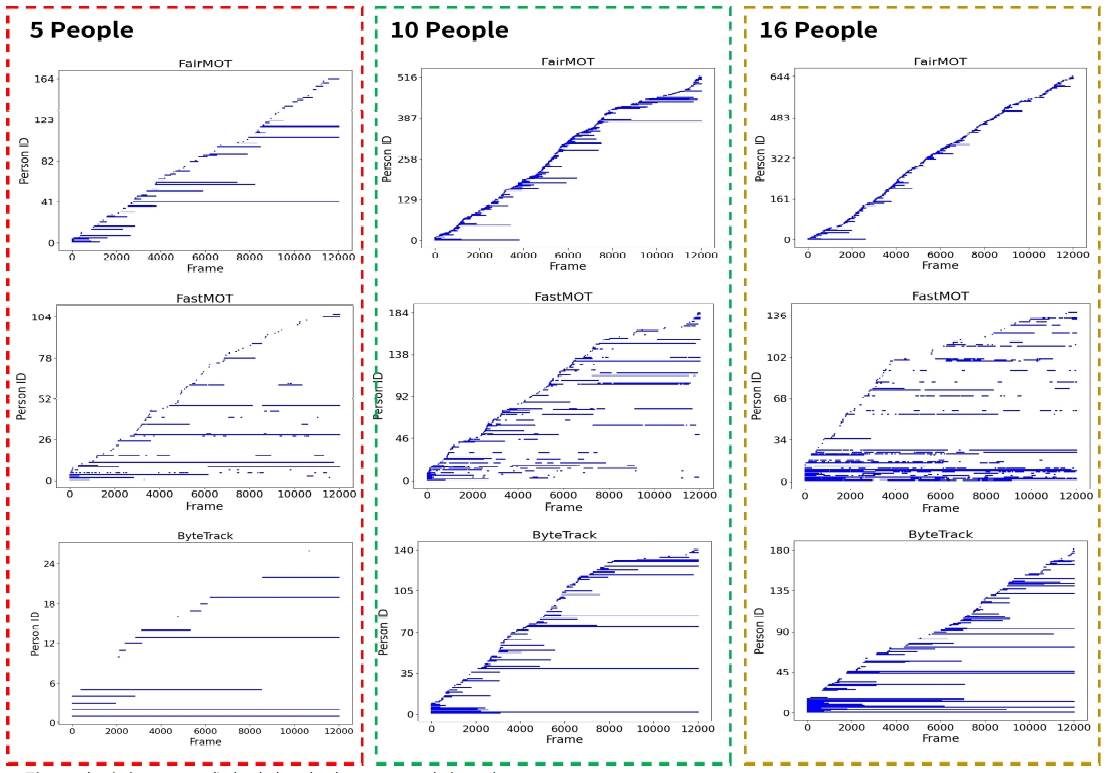

그림 7은 모델의 Re-ID 성능을 확인할 수 있는 그래프로, 각각의 모델에 대해 프레임 인덱스마다 추적되는 객체 ID를 보여준다. 가장 이상적인 그래프에서는 객체 ID 값이 영상에 등장하는 인원 수 만큼 모든 프레임에 걸쳐서 나타나야 한다. 하지만 그림 7의 모든 실험에 대한 그래프에서는 추적되는 객체의 자취 단편화 (trajectory fragmentation)로 인해 ID 스위치가 발생하여 더 많은 수의 객체 ID 값이 나타나는 것을 확인할 수 있다. 밀집도가 낮은 5명에 대한 테스트에서는 ByteTrack이 상대적으로 적은 ID 스위치를 보이며 Re-ID가 모든 프레임에 걸쳐 잘 진행되는 객체도 확인이 된다. 반면 FairMOT, FastMOT는 ID 값이 100을 넘어가며 빈번한 ID 스위치가 일어나는 것을 확인할 수 있다. 또한 세 모델 모두 밀집도가 높아질수록 ID 스위치 문제가 심각해지는 것을 확인할 수 있다.

Ⅴ. 결 론

본 논문에서는 다중 물체 추적 기술과 공간 데이터베이스를 이용한 실내 위치 데이터 분석 시스템을 제안했다. 제안한 시스템을 이용하면 녹화된 영상만으로 공간 쿼리를 활용하여 객체의 위치 분석이 가능하며, 특정 공간, 시간에 대해 객체의 존재 유무 확인 및 공간 내 특정 영역의 방문 빈도를 확인할 수 있다.

우리가 제안하는 시스템은 MOT 성능에 큰 영향을 받기 때문에 MOT 프레임워크에서 Re-ID 등이 정상적으로 이루어지지 않거나, 장애물로 인해 인식되지 않는 경우 분석에 어려움이 발생할 수 있다. 우리는 널리 사용되는 최신 MOT 기술을 포함한 3가지 모델의 성능을 비교하여 제한된 크기의 실내 환경이 현재 MOT 기술에 미치는 영향을 확인했으며, 이를 통해 SOTA (state-of-the-art)를 달성한 최신 MOT 기술을 사용하더라도 밀집도가 높은 실내 환경에서는 가림 혹은 사각지대로 인한 미탐 문제와 더불어 극심한 ID 스위치 문제가 있음을 보였다. 따라서 더욱 정확한 객체 추적을 위해서는 여러 대의 카메라를 사용하여 다양한 각도에서의 시야를 확보하는 것이 중요하며, 각각의 카메라에서 얻어진 로컬한 객체의 자취 정보를 하나의 글로벌 정보로 매칭하는 것이 필요하다.

추후 연구에서는 앞서 설명한 다중 카메라 환경에서 얻어지는 데이터를 하나의 글로벌한 데이터로 매칭하여 제안한 시스템의 객체 분석정보 신뢰도를 높일 예정이다. 또한 현재 시스템은 개별 객체에 대한 분석만을 지원하고 있으나 앞서 2.4에서 언급한 위치 정보 기반 객체 간의 관계 분석 등 더 다양한 기능을 지원할 예정이다.

Acknowledgments

본 연구는 2020년도 대한민국 교육부와 한국연구재단의 일반공동연구지원사업의 지원을 받아 수행된 연구입니다(NRF-2020S1A5A2A03041734).

References

-

L. Wen et al., "VisDrone-MOT2019: The Vision Meets Drone Multiple Object Tracking Challenge Results," 2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW), Seoul, pp. 189-198, 2019.

[https://doi.org/10.1109/iccvw54120.2021.00318]

-

Kyujin Shim, Sungjoon Yoon, Kangwook Ko, Changick Kim, "Multi-Target Multi-Camera Vehicle Tracking for City-Scale Traffic Management," 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), pp. 4188-4195, 2021.

[https://doi.org/10.1109/CVPRW53098.2021.00473]

-

Yukai Yang (Alexis), Weiyun Jiang, Philipp, ning-du, sopsos, & Asad. (2021). GeekAlexis/FastMOT: v2.0.0 (v2.0.0). Zenodo.

[https://doi.org/10.5281/zenodo.5179709]

-

Ammar Abbas, Syed, and Andrew Zisserman, "A geometric approach to obtain a bird's eye view from an image," Proceedings of the IEEE/CVF International Conference on Computer Vision Workshops, Seoul, pp. 0-0, 2019.

[https://doi.org/10.1109/ICCVW.2019.00504]

-

Lin, Chien-Chuan and Ming-Shi Wang, “A Vision Based Top-View Transformation Model for a Vehicle Parking Assistant,” Sensors, Vol. 12, No. 4, pp. 4431-4446, 2012.

[https://doi.org/10.3390/s120404431]

-

Lijing Zhang and Xuanhui He, "Research on query technology in spatial database," 2010 Second Pacific-Asia Conference on Circuits, Communications and System, Beijing, pp. 319-322, 2010.

[https://doi.org/10.1109/PACCS.2010.5626595]

- Zhang, Yifu, et al. "Bytetrack: Multi-object tracking by associating every detection box," arXiv preprint arXiv:2110.06864, 2021.

-

Zhang, Yifu, et al. "Fairmot: On the fairness of detection and re-identification in multiple object tracking," International Journal of Computer Vision, Vol. 129, No. 11, pp. 3069-3087, 2021.

[https://doi.org/10.1007/s11263-021-01513-4]

저자소개

2022년 : 가천대학교 소프트웨어학과 (공학사)

2022년~현 재: 가천대학교 대학원 AI·소프트웨어학과 석사과정

※관심분야 : 무선네트워크, 와이파이 센싱(Wi-Fi Sensing), 딥러닝 모델 경량화, 컴퓨터 비전 등

2019년~현 재 : 가천대학교 AI·소프트웨어학부 재학중

※관심분야 : 무선네트워크, 와이파이 센싱(Wi-Fi Sensing), 모바일 컴퓨팅 등

2020년~현 재 : 가천대학교 AI·소프트웨어학부 재학중

※관심분야 : 무선네트워크, 와이파이 센싱(Wi-Fi Sensing), 백엔드 등

2008년 : 서울대학교 대학원 (공학박사-무선통신)

2008년~2011년: University of Michigan 박사후 연구원

2011년~현 재: 가천대학교 AI·소프트웨어학부 부교수

※관심분야 : 모바일컴퓨팅, 무선통신시스템, 인공지능

2015년 : 스탠포드대학원 발달‧교육심리과정(철학박사-유아발달)

2015년~현 재: 가천대학교 유아교육학과 부교수

※관심분야 : 유아교육정책, 유아교육 공간, 사회정서발달 등